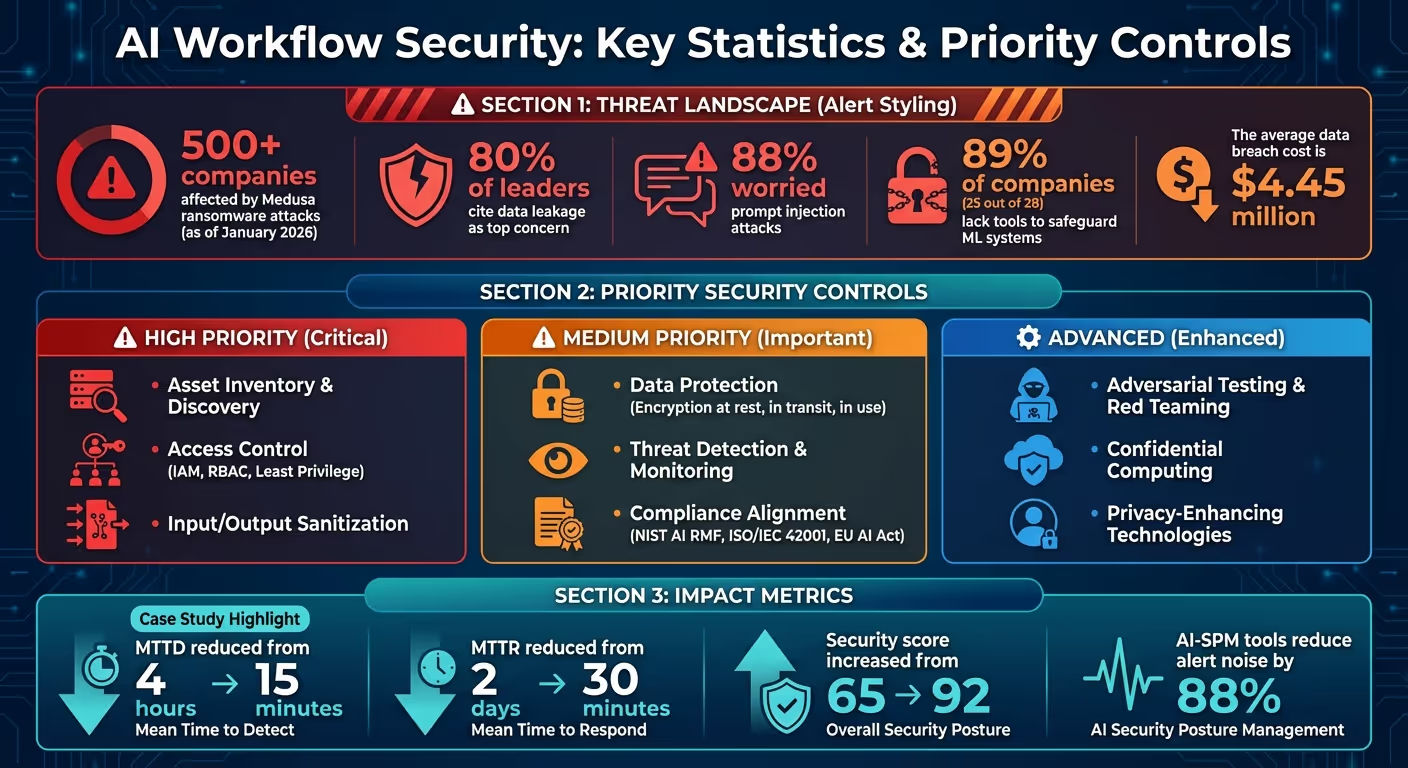

Los flujos de trabajo de IA conllevan riesgos únicos: las filtraciones de datos, el uso indebido de la identidad y las vulnerabilidades de la cadena de suministro son solo el comienzo. A partir de enero de 2026, más 500 empresas ya se han enfrentado Medusa ransomware ataques, lo que pone de relieve la urgente necesidad de reforzar las defensas. Con 80% de los líderes citando la filtración de datos como su principal preocupación y 88% preocupado por los ataques de inyección inmediata, proteger sus sistemas de IA ya no es opcional, es esencial.

Al centrarse en estas estrategias, puede reducir las vulnerabilidades, garantizar el cumplimiento y generar confianza en sus sistemas de IA. Comience con controles de alto impacto, como el cifrado y la gestión del acceso, y luego escale con herramientas automatizadas y técnicas avanzadas.

Estadísticas de seguridad y controles de prioridad del flujo de trabajo de IA 2026

Proteger los flujos de trabajo de la IA no es tan sencillo como proteger los sistemas de software tradicionales. La IA funciona como aplicaciones, procesadores de datos y responsables de la toma de decisiones, lo que significa que la responsabilidad de gestionar los riesgos se distribuye entre varios equipos, en lugar de recaer en un solo grupo de seguridad. Para abordar esta complejidad, las organizaciones deben centrarse en tres principios clave: marcos que prioricen la gobernanza, colaboración interfuncional y prácticas de seguridad flexibles que puedan adaptarse a la evolución de los modelos. Analicemos estos principios y su función a la hora de crear flujos de trabajo de IA seguros.

La gobernanza es la columna vertebral de la seguridad de la IA, ya que determina quién tiene acceso a los sistemas, cuándo pueden acceder a ellos y qué medidas tomar cuando surgen problemas. Un marco de seguridad basado en el ciclo de vida debe cubrir todas las etapas de los flujos de trabajo de la IA, desde la obtención de datos y la formación de modelos hasta la implementación y las operaciones en tiempo real. La asignación de funciones claras (como autor, aprobador y editor) ayuda a definir las responsabilidades y garantiza la rendición de cuentas.

Un elemento crítico de este marco es seguimiento de linaje y procedencia. Lineage captura metadatos para conjuntos de datos, transformaciones y modelos, mientras que la procedencia registra los detalles de la infraestructura y las firmas criptográficas. Si un entorno de entrenamiento se ve comprometido, estos registros permiten identificar rápidamente los modelos afectados y volver a versiones seguras.

«El linaje y la procedencia contribuyen a la gestión de datos y a la integridad del modelo, y forman la base de la gobernanza del modelo de IA».

- Google SAIF 2.0

Para minimizar aún más los riesgos, aplique el principio de privilegios mínimos en todos los componentes, incluidos los modelos, los almacenes de datos, los puntos finales y los flujos de trabajo. La información confidencial, como los números de tarjetas de crédito, debe eliminarse de los conjuntos de datos de capacitación para reducir la exposición en caso de que se produzca una infracción. Utilice herramientas para clasificar la confidencialidad de los datos e implemente el control de acceso basado en roles (RBAC), garantizando que los sistemas de inteligencia artificial accedan solo a los datos necesarios para sus tareas.

Una vez establecida la gobernanza, el siguiente paso es fomentar la colaboración entre los equipos para abordar los riesgos específicos de la IA.

Los desafíos de seguridad de la IA van más allá de los límites tradicionales, ya que una sola interacción puede implicar el uso indebido de la identidad, la filtración de datos y las vulnerabilidades de la cadena de suministro. Esto hace que la colaboración entre varios equipos sea esencial. Los equipos de operaciones de seguridad (SecOps), DevOps y MLOps, gobierno, riesgo y cumplimiento (GRC), los científicos de datos y los líderes empresariales desempeñan funciones fundamentales.

Para mejorar la rendición de cuentas, designe a una persona que esté al día para que apruebe los despliegues y supervise el cumplimiento de las normas éticas. Centralice las alertas relacionadas con la IA, como los problemas de latencia o los intentos de acceso no autorizados, en su centro de operaciones de seguridad para agilizar la supervisión. Además, imparte formación especializada a los equipos de seguridad y desarrollo sobre las amenazas específicas de la IA, como el envenenamiento de datos, los intentos de jailbreak y el robo de credenciales a través de las interfaces de IA.

Si bien la colaboración refuerza las políticas, las prácticas de seguridad ágiles garantizan que estas medidas sigan siendo eficaces a medida que evolucionan los sistemas de IA.

Los modelos de IA son dinámicos y, a menudo, cambian su comportamiento con el tiempo. Esto hace que las medidas de seguridad estáticas sean inadecuadas. Las prácticas de seguridad ágiles introducen ciclos de retroalimentación rápidos que alinean la mitigación de riesgos y la respuesta a los incidentes con la naturaleza iterativa del desarrollo de la IA. Al integrar la seguridad en las operaciones de inteligencia artificial y aprendizaje automático, los equipos pueden aprovechar las mejores prácticas de aprendizaje automático, DevOps e ingeniería de datos.

«Adapte los controles para obtener bucles de retroalimentación más rápidos. Dado que es importante para la mitigación y la respuesta a los incidentes, haga un seguimiento de sus activos y oleoductos».

- Google Cloud

La automatización de las comprobaciones de seguridad en las canalizaciones de CI/CD es un paso crucial. Herramientas como Jenkins, GitLab CI, o Tuberías Vertex AI puede ayudar a validar los modelos e identificar las vulnerabilidades antes de la implementación. Las simulaciones contradictorias habituales, como la combinación de modelos generativos y no generativos, pueden descubrir problemas como la inyección rápida o la inversión de modelos que las revisiones estáticas podrían pasar por alto. Se deben implementar pasarelas de IA centralizadas para monitorear la actividad de los agentes en tiempo real. Por último, realice evaluaciones de riesgos periódicas para anticiparse a las amenazas emergentes y garantizar que sus medidas de seguridad sigan siendo eficaces.

Los datos representan una vulnerabilidad crítica en los sistemas de aprendizaje automático. Una sola violación o un conjunto de datos comprometido pueden provocar el envenenamiento de los modelos, la filtración de información confidencial o la interrupción de los ciclos de formación. Según Microsoft, el envenenamiento de datos representa el riesgo de seguridad más grave en el aprendizaje automático actual debido a la ausencia de métodos de detección estandarizados y al uso generalizado de conjuntos de datos públicos no verificados. Para proteger su capa de datos, es fundamental implementar tres estrategias principales: el cifrado en cada etapa, el seguimiento meticuloso de la procedencia y unos canales de formación reforzados. En conjunto, estas medidas proporcionan una defensa sólida contra posibles amenazas.

El cifrado es esencial para proteger los datos en todos los estados: en reposo, en tránsito y durante su uso. Para los datos en reposo, utilice claves de cifrado administradas por el cliente (CMEK) en plataformas como KMS en la nube o COMO KMS para mantener el control sobre el almacenamiento en depósitos, bases de datos y registros de modelos. Para los datos en tránsito, aplique el TLS 1.2 como estándar mínimo, y se recomienda el TLS 1.3 para obtener el nivel más alto de seguridad. Utilice siempre HTTPS para las llamadas de API a los servicios de inteligencia artificial y aprendizaje automático e implemente balanceadores de cargas HTTPS para proteger las transferencias de datos.

Para cargas de trabajo delicadas, considere la posibilidad de implementar máquinas virtuales blindadas o informática confidencial, que proporcionan aislamiento basado en hardware para proteger los datos incluso durante el procesamiento activo. Esto garantiza que los datos de formación permanezcan seguros, incluso los de los proveedores de la nube. Además, firme digitalmente los paquetes y contenedores y utilice la autorización binaria para garantizar que solo se desplieguen imágenes verificadas.

Políticas de control de servicio o claves de condición de IAM (p. ej., SageMaker: tecla KMS de volumen) puede hacer cumplir el cifrado al impedir la creación de cuadernos o trabajos de formación sin el cifrado habilitado. Para la formación distribuida, habilite el cifrado del tráfico entre contenedores para proteger los datos que se mueven entre los nodos. Para reducir aún más los riesgos, utilice VPC Service Perimeters y Private Service Connect, lo que garantiza que el tráfico de inteligencia artificial y aprendizaje automático permanece alejado de la Internet pública y minimiza la exposición a posibles ataques.

El seguimiento del origen y la integridad de los datos es fundamental para detectar la manipulación y verificar la precisión. El hash criptográfico, como el SHA-256, genera huellas digitales únicas para los conjuntos de datos en cada etapa. Cualquier cambio no autorizado en los datos alterará el valor del hash, lo que indicará inmediatamente una posible corrupción o interferencia.

«La mayor amenaza de seguridad en el aprendizaje automático actual es el envenenamiento de datos debido a la falta de detecciones y mitigaciones estándar en este ámbito, combinada con la dependencia de conjuntos de datos públicos no confiables o no seleccionados como fuentes de datos de capacitación».

- Microsoft

El registro ETL/ELT automatizado puede capturar metadatos en cada paso. Los sistemas equipados con catálogos de datos y herramientas automatizadas de administración de metadatos crean registros detallados del origen y las transformaciones de los datos, lo que ofrece un registro auditable para garantizar el cumplimiento y la seguridad. En el caso de los conjuntos de datos críticos, mantenga un seguimiento detallado de la procedencia y, al mismo tiempo, utilice metadatos agregados para las transformaciones menos importantes a fin de equilibrar el rendimiento y la eficiencia del almacenamiento.

Frameworks como SALSA (Niveles de cadena de suministro para artefactos de software) y herramientas como Tienda Sigstore puede proteger la cadena de suministro del software de IA al proporcionar la procedencia verificable de todos los artefactos. Además, los sistemas de detección de anomalías pueden supervisar la distribución diaria de los datos y alertar a los equipos sobre los sesgos o desviaciones en la calidad de los datos de entrenamiento. Para reducir aún más los riesgos, mantén el control de versiones, lo que te permitirá volver a las versiones anteriores del modelo y aislar el contenido conflictivo para volver a capacitarlo.

Los procesos de formación requieren un control de versiones y una auditabilidad estrictos, lo que se puede lograr con herramientas como MLFlow o DVC. Los sensores deben monitorear la distribución de los datos a diario para detectar cualquier variación, sesgo o desviación que pueda indicar una intoxicación de datos. Todos los datos de entrenamiento deben validarse y desinfectarse antes de usarlos.

Las defensas avanzadas, como el rechazo en caso de impacto negativo (RONI), pueden identificar y eliminar las muestras de entrenamiento que degradan el rendimiento del modelo. Las cargas de trabajo de formación deben funcionar en entornos aislados mediante nubes privadas virtuales (VPC), IP privadas y perímetros de servicio para mantenerlas alejadas del tráfico público de Internet. Asigne cuentas de servicio con los privilegios mínimos a las canalizaciones de MLOps, restringiendo su acceso a registros y depósitos de almacenamiento específicos.

Para conjuntos de datos confidenciales, emplee técnicas de privacidad diferencial o anonimización de datos. La reducción de las funciones, que consolida varios vectores de funciones en una sola muestra, puede reducir el espacio de búsqueda para los ataques adversarios. Guarda con regularidad los estados del modelo como puntos de control para permitir las auditorías y las anulaciones, garantizando la integridad del flujo de trabajo durante todo el ciclo de vida del modelo de IA. En conjunto, estas medidas protegen el proceso de formación, protegen contra posibles amenazas y garantizan la fiabilidad de los sistemas de IA.

Tras proteger los datos y los canales de formación, el siguiente paso consiste en controlar quién (o qué) puede interactuar con los modelos de IA. Esta capa de defensa es crucial para proteger los sistemas sensibles. La autenticación confirma la identidad, mientras que la autorización determina las acciones que la identidad puede realizar. Muchas violaciones de las API no se producen porque los atacantes eludan la autenticación, sino porque los controles de autorización son débiles y permiten a los usuarios autenticados acceder a recursos que no deberían. Refuerce sus defensas implementando medidas de autenticación sólidas y de autorización precisas para limitar el acceso a sus modelos de IA.

Las claves de API estáticas están desactualizadas y deben reemplazarse por enfoques modernos como OAuth 2.1 con PKCE (clave de prueba para el intercambio de código), TLS mutuo (mTLS) e identidades administradas nativas de la nube. OAuth 2.1 con PKCE minimiza la exposición de las credenciales al utilizar tokens de corta duración en lugar de contraseñas. El TLS mutuo, por otro lado, garantiza que tanto el cliente como el servidor se autentiquen mutuamente con certificados digitales, lo que elimina los secretos compartidos. Las identidades gestionadas de forma nativa en la nube permiten a los servicios autenticarse con otros recursos sin incluir las credenciales en el código, lo que reduce el riesgo de filtraciones accidentales.

Para el acceso basado en roles, implemente el RBAC (control de acceso basado en roles) para asignar permisos en función de roles predefinidos, como «científico de datos» o «auditor modelo», garantizando que los usuarios solo tengan acceso a lo que necesitan. Para escenarios más dinámicos, el ABAC (control de acceso basado en atributos) puede conceder permisos en función de los atributos del usuario, el contexto de la solicitud (por ejemplo, la hora o la ubicación) y la sensibilidad de los recursos. Las funciones especializadas adaptadas a las tareas de la IA (como una «función de evaluación» para las pruebas en entornos aislados o una «función de acceso perfeccionada» para los modelos propietarios) reducen aún más el riesgo de acceso con privilegios excesivos.

Para protegerse contra los ataques de denegación de servicio y el uso indebido de las API, límite de velocidad es esencial. Los algoritmos tipo token bucket pueden imponer velocidades de estado estacionario y límites de ráfaga, respondiendo con el protocolo HTTP 429 «Demasiadas solicitudes» cuando se superan los umbrales. Implemente un Firewall de aplicaciones web (WAF) para filtrar los ataques comunes basados en HTTP, como la inyección de SQL y las secuencias de comandos entre sitios, antes de que lleguen a los puntos finales de su modelo.

Prevenir Autorización a nivel de objeto roto (BOLA), clasificado como el principal riesgo de seguridad de las API por OWASP, requiere el uso de identificadores de recursos opacos como los UUID en lugar de números secuenciales. Esto hace que a los atacantes les resulte más difícil adivinar los datos de otros usuarios y acceder a ellos. Además, desinfecta y valida todas las entradas del lado del servidor, incluidas las generadas por modelos de IA, para protegerte de los ataques de inyección inmediata. Automatice la rotación de las claves y los certificados de API con administradores secretos para limitar la oportunidad de que las credenciales se vean comprometidas. Para mantener la supervisión, utilice un control meticuloso de las versiones y supervise los registros de acceso para detectar anomalías.

El control de versiones de los artefactos del modelo es esencial para crear un registro de auditoría y permitir una reversión rápida si una versión del modelo presenta vulnerabilidades o se desvía. Del mismo modo que los controles de acceso protegen los datos, la supervisión de las versiones del modelo garantiza la integridad operativa. Combine soluciones de almacenamiento de artefactos, como Amazon S3, con Eliminar MFA para garantizar que solo los usuarios con autenticación multifactor puedan eliminar permanentemente las versiones del modelo. Revise periódicamente los registros de la API y del modelo para detectar actividades inusuales, como los inicios de sesión desde ubicaciones inesperadas, las llamadas frecuentes que podrían indicar que se están robando datos o los intentos de acceder a identificadores de objetos no autorizados.

Gestione activamente su inventario de IA para evitar las «implementaciones huérfanas»: modelos de prueba o obsoletos que se dejan accesibles en producción sin medidas de seguridad actualizadas. Herramientas como Azure Resource Graph Explorer o Microsoft Defender for Cloud pueden ofrecer visibilidad en tiempo real de todos los recursos de IA de todas las suscripciones. En el caso de los flujos de trabajo que requieren un alto nivel de seguridad, implemente componentes de aprendizaje automático en una nube privada virtual (VPC) aislada sin acceso a Internet, utilizando puntos de enlace o servicios de VPC como AWS PrivateLink para garantizar que el tráfico permanezca interno.

Incluso con controles de acceso sólidos, pueden surgir amenazas en los flujos de trabajo de la IA. Para proteger completamente estos sistemas, la supervisión y la detección rápida son capas esenciales de defensa. Al complementar las medidas de acceso y autenticación, la supervisión proactiva refuerza los flujos de trabajo internos y ayuda a identificar posibles incidentes de seguridad antes de que se conviertan en infracciones graves. Una encuesta de Microsoft realizada a 28 empresas reveló que el 89% (25 de 28) carecía de las herramientas necesarias para proteger sus sistemas de aprendizaje automático. Este déficit expone los flujos de trabajo a riesgos como el envenenamiento de datos, la extracción de modelos y la manipulación contradictoria.

Comprender cómo se comportan los sistemas de IA es clave para descubrir las amenazas que las herramientas de seguridad tradicionales podrían pasar por alto. Detección estadística de deriva rastrea los cambios en la distribución de entrada y la entropía de salida, marcando los casos en los que un modelo opera fuera de sus parámetros entrenados. Por ejemplo, una caída en la confianza del modelo por debajo de un umbral definido puede indicar la presencia de entradas fuera de distribución. Del mismo modo, la compresión de características (es decir, comparar las predicciones de un modelo sobre las entradas originales con las «reducidas») puede revelar ejemplos contradictorios cuando hay un desacuerdo significativo entre ambas.

Además de monitorear los resultados del modelo, las métricas operativas, como los picos de latencia, el uso inusual de las API y el consumo irregular de recursos de CPU/GPU, pueden indicar ataques como los intentos de denegación de servicio (DoS) o los esfuerzos de extracción de modelos. Un caso notable ocurrió en septiembre de 2025, cuando FineryMarkets.com implementó una canalización de DevSecOps basada en inteligencia artificial que incluía la detección de anomalías en el tiempo de ejecución. Esta innovación redujo el tiempo medio de detección (MTTD) de 4 horas a solo 15 minutos y el tiempo medio de reparación (MTTR) de 2 días a 30 minutos, lo que elevó su puntuación de seguridad de 65 a 92. Estos resultados destacan la importancia de una detección de anomalías y una evaluación de vulnerabilidades coherentes.

Las evaluaciones de seguridad rutinarias pueden descubrir riesgos específicos de la IA que las herramientas estándar podrían pasar por alto, como la inyección rápida, la inversión de modelos y la filtración de datos. Estos análisis son cruciales para validar la integridad del modelo, ya que ayudan a detectar puertas traseras integradas o cargas maliciosas en archivos como .pt o .pl antes de que se ejecuten. El trabajo en equipo con IA Red va un paso más allá al simular ataques del mundo real, incluidos los intentos de fuga de jailbreak, contra modelos de IA. La automatización de estos procesos mediante procesos que incluyen la verificación del hash y el análisis estático garantiza la integridad del modelo antes de la implementación. Además, escanear los cuadernos y el código fuente en busca de credenciales codificadas o claves de API expuestas es vital para proteger los flujos de trabajo.

La supervisión continua es esencial para identificar errores de configuración, credenciales expuestas y vulnerabilidades de infraestructura en todo el proceso. Los registros inmutables deben capturar las interacciones críticas para ayudar a responder a los incidentes y garantizar el cumplimiento. Herramientas como Centro de comando de seguridad o Microsoft Defender for Cloud puede automatizar la detección y la solución de los riesgos en las implementaciones de IA generativa. El seguimiento de los flujos de datos y las transformaciones puede ayudar a identificar el acceso no autorizado o los intentos de envenenamiento de datos, mientras que la integración del análisis de dependencias en el proceso de CI/CD garantiza que solo los artefactos examinados lleguen a la producción. Para aumentar la seguridad, los mecanismos de apagado automatizados se pueden configurar para que se activen cuando las operaciones superen los límites de seguridad predefinidos, lo que ofrece una protección contra las amenazas críticas.

Cuando se trata de garantizar la integridad de sus flujos de trabajo de IA, incorporar medidas de seguridad en los procesos de desarrollo e implementación no es negociable. En estas etapas suelen aparecer las vulnerabilidades, por lo que es fundamental diseñar la seguridad en los procesos desde el principio, en lugar de añadirlas a último momento. Al tratar los modelos como programas ejecutables, puedes minimizar el riesgo de que las compilaciones comprometidas afecten a las operaciones posteriores. He aquí un análisis detallado de la protección de las canalizaciones de CI/CD y la adopción de prácticas seguras durante el desarrollo y la implementación.

Para proteger sus canalizaciones de CI/CD, cada compilación debe realizarse en un entorno aislado y temporal. Esto se puede lograr utilizando imágenes de ejecución efímeras que se inicializan, ejecutan y terminan con cada compilación, lo que evita cualquier riesgo persistente derivado de las compilaciones comprometidas. Para establecer la confianza, genera atestaciones firmadas criptográficamente para cada artefacto. Estas certificaciones deben vincular el artefacto con su flujo de trabajo, repositorio, confirmación de SHA y evento desencadenante. Solo se deben implementar los artefactos verificados mediante estos controles. Piense en estas firmas como recibos a prueba de manipulaciones, que garantizan que solo los artefactos seguros lleguen a la producción.

La administración de los secretos es otro paso fundamental. Evite codificar las credenciales de forma rígida en su código fuente o en los cuadernos de Jupyter. En su lugar, usa herramientas como Bóveda de HashiCorp o Administrador de secretos de AWS para inyectar secretos a través de variables de entorno o tokens OIDC. Para aumentar la seguridad de la red, separe sus entornos de desarrollo, ensayo y producción con controles de servicio de VPC y grupos de trabajadores privados para evitar la filtración de datos durante las compilaciones.

Marcos de IA como PyTorch, TensorFlow, y JAX sirven como dependencias tanto en tiempo de construcción como en tiempo de ejecución. Cualquier vulnerabilidad dentro de estas bibliotecas puede comprometer directamente sus modelos. Automatice el análisis de vulnerabilidades integrando herramientas como Google Artifact Analysis en su proceso de CI/CD para comprobar si hay problemas conocidos tanto en las imágenes de los contenedores como en los paquetes de aprendizaje automático. Dado que los modelos pueden actuar como código ejecutable, trátelos con la misma precaución que aplicaría a los programas de software. Por ejemplo, formatos de serialización estándar como .pt o .pl puede albergar malware que se activa durante la deserialización.

«Los modelos no son fáciles de inspeccionar... Es mejor tratar los modelos como programas, de forma similar al código de bytes interpretado en tiempo de ejecución». - Google

Además, los modelos y conjuntos de datos de terceros no validados pueden presentar riesgos importantes. El nuevo estándar AI Bill of Materials (AIBOM) ayuda a catalogar modelos, conjuntos de datos y dependencias, ofreciendo la transparencia necesaria para el cumplimiento y la gestión de riesgos. Haga cumplir siempre el principio del mínimo privilegio limitando las tareas de formación e inferencia únicamente a los depósitos de almacenamiento de datos y los recursos de red específicos que requieren.

Una vez implementadas las prácticas de desarrollo seguras, el siguiente paso es centrarse en restringir la implementación de producción para proteger su entorno operativo.

La automatización del proceso de implementación es clave para reducir los errores humanos y evitar el acceso no autorizado. Las mejores prácticas modernas incluyen la implementación de una política de no acceso humano a los datos, las aplicaciones y la infraestructura de producción. Todas las implementaciones deben realizarse a través de canalizaciones automatizadas y aprobadas.

«La fase de producción introduce políticas estrictas de no acceso humano para los datos, las aplicaciones y la infraestructura de producción. Todo el acceso a los sistemas de producción debe automatizarse mediante procesos de implementación aprobados». - AWS Prescriptive Guidance

Mantener un aislamiento estricto entre los entornos de desarrollo, preparación y producción es otro paso crucial. Esto evita que los modelos no validados contaminen los sistemas de producción. Además, aplique la limpieza del registro de artefactos para eliminar las versiones intermedias o no aprobadas, manteniendo solo las versiones validadas listas para su implementación. En caso de emergencia, establezca procedimientos innovadores que exijan una aprobación explícita y un registro exhaustivo para garantizar la rendición de cuentas durante las crisis. Los controles periódicos durante la formación permiten auditar la evolución de un modelo y ofrecen la posibilidad de volver a un estado seguro en caso de que surja un problema de seguridad.

Después de proteger sus canales de desarrollo e implementación, el siguiente paso crucial es garantizar que sus flujos de trabajo de IA se alineen con los estándares regulatorios y las políticas internas. Dado que el cumplimiento normativo se está convirtiendo en una preocupación cada vez mayor para muchos líderes, establecer un marco claro es vital, no solo para evitar riesgos legales, sino también para mantener la confianza de los clientes. Naturalmente, este marco se basa en los procesos seguros analizados anteriormente.

El entorno regulatorio de la seguridad de la IA está evolucionando rápidamente, lo que exige que las organizaciones estadounidenses supervisen varios marcos simultáneamente. Una referencia clave es la Marco de gestión de riesgos de IA del NIST (AI RMF 1.0), que proporciona orientación voluntaria para gestionar los riesgos para las personas y la sociedad. Publicada en julio de 2024, incluye una guía complementaria y un perfil de IA generativa (NIST-AI-600-1) para abordar desafíos únicos, como las alucinaciones y los problemas de privacidad de los datos. Además, el Guía conjunta de la CISA/NSA/FBI, publicado en mayo de 2025, ofrece una hoja de ruta completa para proteger el ciclo de vida de la IA, desde el desarrollo hasta la operación.

A escala mundial, ISO/IEC 42001:2023 se ha convertido en el primer estándar internacional de sistemas de gestión para la IA. Siguiendo el modelo de la ISO 27001, proporciona una estructura familiar para los equipos de cumplimiento que ya administran los sistemas de seguridad de la información. Esta norma cubre áreas como la gobernanza de datos, el desarrollo de modelos y la supervisión operativa, por lo que es particularmente útil para abordar las preocupaciones de los comités de riesgos y los clientes empresariales. Para las organizaciones que operan en los mercados europeos, el cumplimiento de la Ley de IA de la UE (en particular el artículo 15 sobre precisión y solidez), DORA para servicios financieros, y NIS2 para los proveedores de servicios esenciales también es crucial.

«La ISO 42001 es un marco estructurado que gestiona la seguridad, la gobernanza y la gestión de riesgos de la IA, y es esencial para las organizaciones que buscan implementar herramientas y sistemas de IA de manera responsable». - BD Emerson

Una de las principales ventajas de adoptar un marco unificado como la ISO/IEC 42001 es su capacidad de alinearse con múltiples regulaciones simultáneamente, lo que reduce los esfuerzos de cumplimiento redundantes y mejora la eficiencia operativa. Establecer un Consejo de Ética de IA - compuesto por ejecutivos, expertos legales y profesionales de la IA - proporciona la supervisión necesaria para evaluar los proyectos de alto riesgo y garantizar la alineación con estos marcos. La incorporación de estos estándares en su flujo de trabajo refuerza tanto la seguridad como la escalabilidad, complementando las medidas anteriores.

Los registros de auditoría detallados son indispensables para el cumplimiento normativo y la respuesta a los incidentes. Sus registros deben capturar todos los aspectos de las interacciones de la IA, incluida la versión del modelo utilizada, la solicitud específica enviada, la respuesta generada y los metadatos de usuario relevantes. Esta visibilidad de principio a fin es fundamental para responder a las consultas normativas o investigar los incidentes.

Para preservar la integridad de estos registros, utilice WORM (escribe una vez, lee muchos) almacenamiento para proteger las salidas de registro y los datos de sesión. Los registros de auditoría también deben documentar el linaje de los datos, es decir, rastrear el origen, las transformaciones y las licencias de los conjuntos de datos, así como los parámetros e hiperparámetros del modelo. Este nivel de transparencia respalda los requisitos normativos, como responder a las solicitudes de «derecho a borrar» en virtud de las leyes de protección de datos.

Las revisiones periódicas de las políticas son igualmente importantes. Realice estas revisiones al menos una vez al año o siempre que se produzcan cambios normativos importantes, como las actualizaciones del Ley de IA de la UE o NIS2. Actuar Evaluaciones de impacto del sistema de IA (AISIA) periódicamente o después de cambios importantes para evaluar los efectos sobre la privacidad, la seguridad y la equidad. Estas evaluaciones deben revisarse con tu junta ética multidisciplinaria de IA para garantizar la rendición de cuentas. En conjunto, un registro sólido y las revisiones periódicas crean una base sólida para la gobernanza y la gestión de incidentes.

Los flujos de trabajo de IA exigen planes de respuesta a incidentes especializados que aborden las amenazas exclusivas de los sistemas de IA. Entre ellos se incluyen riesgos como la intoxicación por modelos, la inyección inmediata, los ataques adversos y los efectos nocivos provocados por las alucinaciones. Estos escenarios requieren estrategias de detección y remediación personalizadas, distintas de las que se utilizan en los incidentes de ciberseguridad tradicionales.

Desarrolle guías específicas para la IA que describan claramente las rutas y responsabilidades de escalamiento. Por ejemplo, si un modelo genera resultados sesgados, el manual debe especificar quién investiga los datos de la capacitación, quién se comunica con las partes interesadas y qué condiciones justifican la anulación del modelo. Incluya procedimientos para gestionar las solicitudes de datos de los interesados, como verificar si los datos de una persona se utilizaron en la formación modelo cuando ejercían su «derecho al olvido».

Es esencial probar estos planes. Realice ejercicios prácticos con equipos interdisciplinarios para simular escenarios realistas de incidentes de IA. Estos ejercicios ayudan a identificar las brechas procesales y a mejorar la coordinación del equipo antes de que ocurra una crisis real. Además, configure los modelos de IA para que no pasen a un estado «cerrado» o seguro a fin de evitar la exposición accidental de los datos durante las fallas del sistema. Al integrar guías específicas para la IA con los protocolos de automatización existentes, puede mantener la continuidad operativa y, al mismo tiempo, mejorar su arquitectura de seguridad general.

Para los equipos que operan con recursos limitados, proteger los flujos de trabajo de IA puede parecer una tarea abrumadora. Sin embargo, al adoptar un enfoque gradual y automatizado, puede crear un marco de seguridad sólido con el tiempo. En lugar de intentar implementar todas las medidas a la vez, céntrese primero en los controles de alto impacto, utilice la automatización para aligerar la carga de trabajo e introduzca gradualmente técnicas más avanzadas a medida que se amplíen sus capacidades.

El primer paso es abordar las vulnerabilidades más críticas. Comience con el descubrimiento y el inventario de los activos. Los modelos, conjuntos de datos y puntos finales de IA que no se rastrean pueden crear puntos débiles que los atacantes podrían aprovechar. Herramientas como Azure Resource Graph Explorer pueden ayudar a identificar y catalogar todos los recursos de IA de forma eficaz.

A continuación, implemente la gestión de acceso e identidad (IAM) con el principio de privilegio mínimo. Al usar identidades administradas y aplicar una gobernanza de datos estricta, como la clasificación de conjuntos de datos confidenciales, puede lograr una protección sólida sin costos significativos.

Otro paso esencial es asegurar las entradas y salidas. Implemente medidas como el filtrado rápido y la desinfección de las salidas para bloquear los ataques por inyección y evitar la filtración de datos. La supervisión centralizada también es fundamental: utilice la detección de anomalías en tiempo real y un registro exhaustivo para rastrear las interacciones de la IA, incluidas las indicaciones, las respuestas y los metadatos de los usuarios.

«Proteger la IA consiste en restaurar la claridad en entornos en los que la responsabilidad puede difuminarse rápidamente. Se trata de saber dónde existe la IA, cómo se comporta, qué se le permite hacer y cómo sus decisiones afectan a la empresa en general». - Brittany Woodsmall y Simon Fellows, Darktrace

Con estos controles fundamentales implementados, la automatización cambia las reglas del juego para los equipos con ancho de banda limitado.

La automatización es un poderoso aliado para los equipos con recursos limitados, ya que reduce el esfuerzo manual necesario para mantener las medidas de seguridad. Las herramientas de gestión de la postura de seguridad de la IA (AI-SPM) pueden mapear automáticamente las canalizaciones y los modelos de IA, identificar las rutas verificadas de las vulnerabilidades y reducir el ruido de las alertas hasta en un 88%. Esto es especialmente útil para los equipos pequeños que no pueden analizar manualmente miles de alertas.

Las plataformas de gobierno, riesgo y cumplimiento (GRC) proporcionan otro nivel de eficiencia. Estas herramientas centralizan el registro, la gestión de riesgos y la supervisión de las políticas. Muchas plataformas de GRC incluyen plantillas prediseñadas para marcos como el NIST AI RMF o la ISO 42001, lo que le ahorra la molestia de crear políticas desde cero. Las alertas automatizadas también pueden avisar a los administradores sobre acciones riesgosas, como el reentrenamiento no programado de modelos o la exportación de datos poco habitual.

La integración del escaneo automatizado de vulnerabilidades en las canalizaciones de CI/CD ayuda a detectar errores de configuración antes de que lleguen a la producción. Las firmas digitales en los conjuntos de datos y las versiones de los modelos garantizan además una cadena de custodia a prueba de manipulaciones, lo que elimina la necesidad de una verificación manual. Teniendo en cuenta que el coste medio de una filtración de datos es de 4,45 millones de dólares, estas herramientas automatizadas ofrecen un valor significativo a los equipos pequeños.

Una vez que las tareas básicas estén automatizadas, podrá introducir gradualmente mejoras de seguridad más sofisticadas.

Tras establecer una base sólida, es hora de introducir medidas de seguridad avanzadas. Empieza con pruebas contradictorias, como los ejercicios en equipo rojo, para descubrir las posibles debilidades de tus modelos de IA. Con el tiempo, puedes adoptar tecnologías que mejoren la privacidad (PET), como la privacidad diferencial, para proteger los conjuntos de datos confidenciales.

«Los equipos pequeños deben comenzar con controles básicos como la gobernanza de datos, el control de versiones de modelos y los controles de acceso antes de expandirse a técnicas avanzadas». - SentinelOne

Las herramientas de aplicación de políticas impulsadas por la IA son otro paso adelante. Estas herramientas pueden marcar automáticamente las políticas de acceso mal configuradas, las rutas de datos no cifradas o las herramientas de IA no autorizadas, a menudo denominadas «IA oculta». A medida que evolucionen sus flujos de trabajo, considere la posibilidad de implementar la gestión de identidades no humanas (NHI). Esto implica tratar a los agentes de IA autónomos como trabajadores digitales, con cuentas de servicio únicas y credenciales que rotan con regularidad.

La creación de un flujo de trabajo de IA seguro exige supervisión continua, transparencia y una estrategia de defensa de varios niveles. Comience por establecer políticas claras y asignar responsabilidades, y luego concéntrese en obtener una visión integral de sus activos. Refuerce sus defensas con medidas técnicas como el cifrado, los controles de acceso y los sistemas de detección de amenazas. Abordar estas prioridades por fases ayuda a abordar las vulnerabilidades más apremiantes de manera eficaz.

Los datos subrayan la urgencia de estas medidas: el 80% de los líderes están preocupados por la filtración de datos, mientras que el 88% se preocupa por la pronta inyección. Además, en enero de 2026, más de 500 organizaciones habían sido víctimas de los ataques del ransomware Medusa.

Para actuar con decisión, priorice las medidas de alto impacto que produzcan resultados inmediatos. Comience por lo esencial, como el descubrimiento de activos, los estrictos controles de acceso y la desinfección de las entradas y salidas: estas medidas fundamentales ofrecen una protección sólida sin requerir grandes recursos. A continuación, reduzca el esfuerzo manual adoptando herramientas de automatización, como los sistemas de gestión de posturas de seguridad con inteligencia artificial y las plataformas GRC, para mantener una supervisión y una gobernanza coherentes. A medida que su marco de seguridad evolucione, incorpore prácticas avanzadas, como las pruebas contradictorias, la computación confidencial para las GPU y la asignación de identidades únicas a los agentes de IA. En conjunto, estos pasos crean un entorno de IA sólido y escalable.

«La seguridad es un esfuerzo colectivo que se logra mejor a través de la colaboración y la transparencia». - OpenAI

Proteger los flujos de trabajo de los modelos de IA exige una estrategia exhaustiva para proteger los datos, el código y los modelos en cada etapa de su ciclo de vida. Para empezar, priorice las prácticas de datos seguras: cifre los conjuntos de datos tanto cuando estén almacenados como durante la transmisión, aplique controles de acceso estrictos y examine cuidadosamente los datos de terceros o de código abierto antes de incorporarlos a sus flujos de trabajo.

Durante el desarrollo, evita insertar información confidencial, como contraseñas, directamente en tu código. En su lugar, confíe en herramientas seguras de administración de secretos y realice revisiones periódicas del código para identificar vulnerabilidades o dependencias riesgosas.

Cuando se trata de entrenar o ajustar modelos, adopte principios de confianza cero aislando los recursos informáticos y manteniéndose alerta ante riesgos como el envenenamiento de datos o las entradas contradictorias. Una vez que su modelo esté completo, almacénelo en repositorios seguros, cifre su peso para evitar el acceso no autorizado y verifique su integridad de forma rutinaria.

Para los puntos finales de inferencia, implemente requisitos de autenticación, establezca límites de uso para evitar el abuso y valide las entradas entrantes para bloquear posibles ataques. La vigilancia continua es clave: supervise la actividad de inferencia de forma continua, mantenga registros detallados y prepárese con planes de respuesta para hacer frente a amenazas como el robo de modelos o los problemas de rendimiento inesperados. Si sigue estos pasos, puede establecer una defensa sólida para sus flujos de trabajo de IA.

Los equipos pequeños pueden empezar por elaborar políticas de seguridad sencillas que aborden cada etapa del ciclo de vida de la IA, desde la recopilación de datos hasta su eliminación final. Adoptar un enfoque de confianza cero es crucial: implemente protocolos de autenticación, exija el acceso con privilegios mínimos y confíe en los controles de acceso basados en roles mediante herramientas en la nube integradas para mantener bajos los gastos. Las medidas simples, como firmar las confirmaciones de Git, pueden crear un registro de auditoría inalterable, mientras que la realización de evaluaciones de riesgo trimestrales ligeras permite a los equipos detectar las vulnerabilidades de forma temprana.

Aproveche las herramientas gratuitas o de código abierto para optimizar los esfuerzos de seguridad. Utilice la validación y el saneamiento de las entradas para evitar los ataques adversarios, proteja las API mediante la autenticación basada en tokens y la limitación de velocidad, y configure canales automatizados para detectar problemas como el envenenamiento de datos o la pérdida de rendimiento. Un modelo ligero de establecimiento de marcas de agua puede proteger la propiedad intelectual, y un marco sólido de gestión de datos garantiza que los conjuntos de datos se etiqueten, cifren y controlen correctamente. Estas medidas prácticas sientan las bases para una seguridad sólida sin la necesidad de contar con cuantiosos recursos financieros.

Para garantizar la seguridad de los datos en los flujos de trabajo de IA, comience con un enfoque seguro desde el diseño, centrándose en proteger la información en cada etapa, desde la recopilación inicial hasta el despliegue final. Utilice cifrado para proteger los datos tanto en reposo (por ejemplo, AES-256) como durante la transmisión (por ejemplo, TLS 1.2 o superior). Implemente controles de acceso estrictos guiándose por el principio de privilegio mínimo, de modo que solo los usuarios y sistemas autorizados puedan interactuar con datos confidenciales. Las políticas de acceso basadas en roles o atributos pueden ser particularmente eficaces para mantener estas restricciones.

Proteja las canalizaciones de datos aislando las redes, validando las entradas y registrando todos los movimientos de datos para detectar anticipadamente actividades inusuales. Aproveche herramientas de linaje de datos para rastrear el origen y el uso de los conjuntos de datos, lo que contribuye al cumplimiento de normativas como el RGPD y la CCPA. Los análisis periódicos en busca de información confidencial, como la información de identificación personal (PII), y la aplicación de técnicas como la redacción o la tokenización pueden reducir aún más los riesgos. La supervisión en tiempo real, combinada con alertas de seguridad automatizadas, permite identificar y responder rápidamente a las posibles amenazas.

Incorporar automatización impulsada por políticas en sus flujos de trabajo para simplificar las medidas de seguridad. Esto incluye el aprovisionamiento del almacenamiento cifrado, la aplicación de la segmentación de la red y la incorporación de las comprobaciones de cumplimiento directamente en los procesos de implementación. Complemente estas defensas técnicas con políticas organizativas, como capacitar a los equipos sobre prácticas seguras de datos, establecer cronogramas de retención claros y desarrollar planes de respuesta ante incidentes adaptados a los riesgos relacionados con la IA. En conjunto, estas medidas proporcionan una protección integral durante todo el ciclo de vida de la IA.