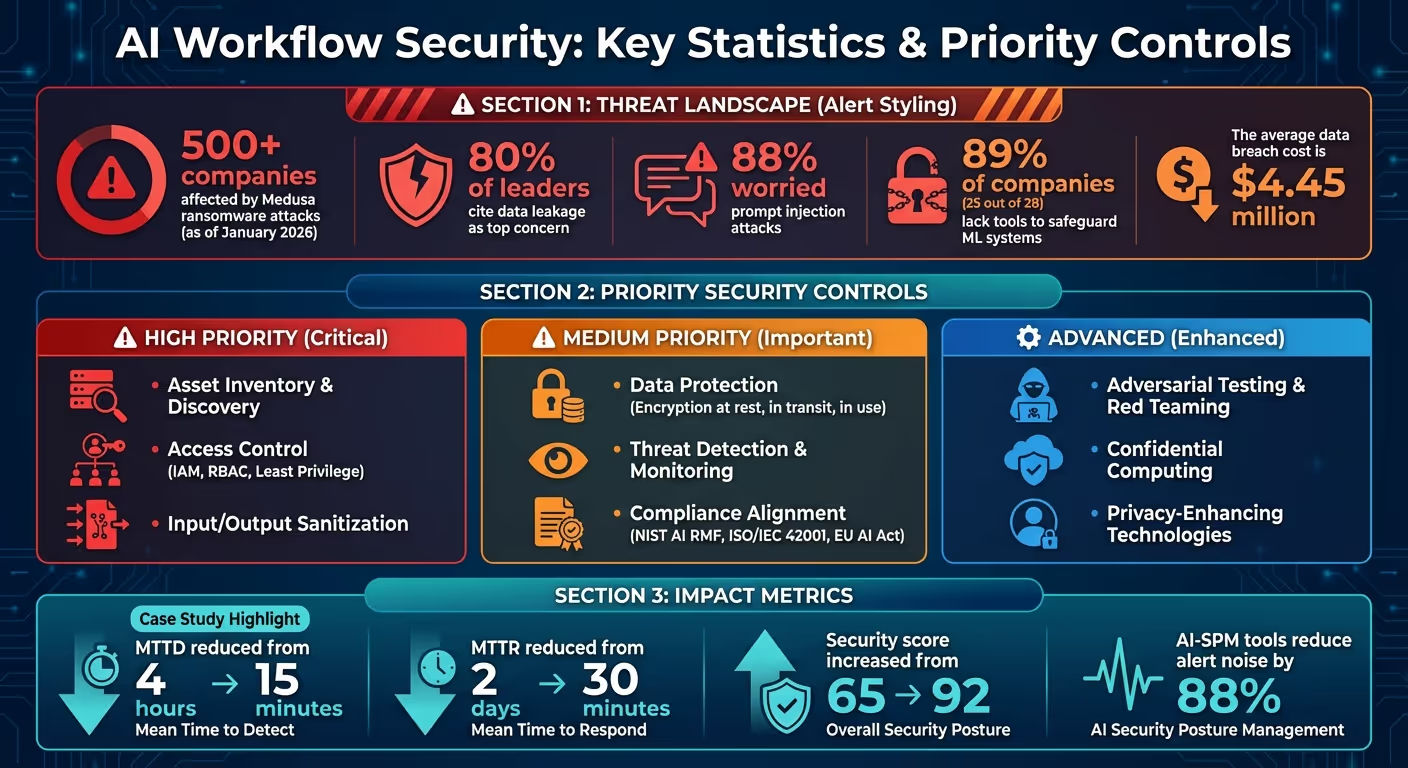

تأتي عمليات سير عمل الذكاء الاصطناعي بمخاطر فريدة - تسرب البيانات وإساءة استخدام الهوية ونقاط الضعف في سلسلة التوريد ليست سوى البداية. اعتبارًا من يناير 2026، انتهى 500 شركة واجهت بالفعل برنامج ميدوسا رانسوم وير الهجمات، مما يسلط الضوء على الحاجة الملحة لدفاعات أقوى. مع 80% من القادة مستشهدين بتسرب البيانات باعتباره مصدر قلقهم الرئيسي و 88% نظرًا لقلقك بشأن هجمات الحقن الفوري، لم يعد تأمين أنظمة الذكاء الاصطناعي أمرًا اختياريًا - إنه ضروري.

من خلال التركيز على هذه الاستراتيجيات، يمكنك تقليل نقاط الضعف وضمان الامتثال وبناء الثقة في أنظمة الذكاء الاصطناعي الخاصة بك. ابدأ بعناصر تحكم عالية التأثير مثل التشفير وإدارة الوصول، ثم قم بالتوسع باستخدام الأدوات الآلية والتقنيات المتقدمة.

إحصاءات أمن سير العمل بالذكاء الاصطناعي وضوابط الأولوية 2026

إن تأمين عمليات سير عمل الذكاء الاصطناعي ليس بالأمر السهل مثل حماية أنظمة البرامج التقليدية. يعمل الذكاء الاصطناعي كتطبيقات ومعالجي بيانات وصناع قرار، مما يعني أن مسؤولية إدارة المخاطر موزعة بين فرق متعددة بدلاً من أن تقع على عاتق مجموعة أمان واحدة. لمعالجة هذا التعقيد، يجب على المؤسسات التركيز على ثلاثة مبادئ رئيسية: أطر الحوكمة أولاً، والتعاون متعدد الوظائف، والممارسات الأمنية المرنة التي يمكن أن تتكيف مع تطور النماذج. دعونا نحلل هذه المبادئ ودورها في بناء تدفقات عمل آمنة للذكاء الاصطناعي.

الحوكمة هي العمود الفقري لأمن الذكاء الاصطناعي، حيث تحدد من لديه حق الوصول إلى الأنظمة، ومتى يمكنه الوصول إليها، والإجراءات التي يجب اتخاذها عند ظهور المشاكل. يجب أن يغطي إطار الأمان المستند إلى دورة الحياة كل مرحلة من مراحل سير عمل الذكاء الاصطناعي، بدءًا من مصادر البيانات والتدريب النموذجي وحتى النشر والعمليات في الوقت الفعلي. يساعد تعيين أدوار واضحة - مثل المؤلف والمعتمد والناشر - على تحديد المسؤوليات وضمان المساءلة.

عنصر حاسم في هذا الإطار هو تتبع النسب والمصدر. يلتقط Lineage البيانات الوصفية لمجموعات البيانات والتحويلات والنماذج، بينما يسجل المصدر تفاصيل البنية التحتية والتوقيعات المشفرة. في حالة تعرض بيئة التدريب للخطر، تتيح هذه السجلات التعرف بسرعة على النماذج المتأثرة والعودة إلى الإصدارات الآمنة.

«يساهم النسب والمصدر في إدارة البيانات وسلامة النموذج، ويشكلان الأساس لحوكمة نموذج الذكاء الاصطناعي.»

- جوجل سيف 2.0

لتقليل المخاطر بشكل أكبر، قم بتطبيق مبدأ أقل الامتيازات عبر جميع المكونات، بما في ذلك النماذج ومخازن البيانات ونقاط النهاية وعمليات سير العمل. يجب تجريد المعلومات الحساسة، مثل أرقام بطاقات الائتمان، من مجموعات بيانات التدريب لتقليل التعرض في حالة حدوث خرق. استخدم الأدوات لتصنيف حساسية البيانات وتنفيذ التحكم في الوصول المستند إلى الأدوار (RBAC)، مما يضمن وصول أنظمة الذكاء الاصطناعي إلى البيانات اللازمة لمهامها فقط.

بمجرد تطبيق الحوكمة، فإن الخطوة التالية هي تعزيز التعاون بين الفرق لمعالجة المخاطر الخاصة بالذكاء الاصطناعي.

تمتد تحديات أمن الذكاء الاصطناعي إلى ما وراء الحدود التقليدية، حيث قد يتضمن التفاعل الفردي إساءة استخدام الهوية وتسريب البيانات ونقاط الضعف في سلسلة التوريد. هذا يجعل التعاون بين الفرق المختلفة أمرًا ضروريًا. تلعب فرق العمليات الأمنية (SecOps) و DevOps/MLOPs وفرق الحوكمة والمخاطر والامتثال (GRC) وعلماء البيانات وقادة الأعمال أدوارًا محورية.

لتعزيز المساءلة، قم بتعيين شخص على اطلاع دائم للموافقة على عمليات النشر ومراقبة الالتزام بالمعايير الأخلاقية. قم بتجميع التنبيهات المتعلقة بالذكاء الاصطناعي - مثل مشكلات وقت الاستجابة أو محاولات الوصول غير المصرح بها - داخل مركز عمليات الأمان الخاص بك للإشراف المبسط. بالإضافة إلى ذلك، قم بتوفير تدريب متخصص لفرق الأمن والتطوير على التهديدات الخاصة بالذكاء الاصطناعي، مثل تسمم البيانات ومحاولات الهروب من السجن وسرقة بيانات الاعتماد من خلال واجهات الذكاء الاصطناعي.

في حين أن التعاون يعزز السياسة، تضمن ممارسات الأمان الرشيقة أن تظل هذه التدابير فعالة مع تطور أنظمة الذكاء الاصطناعي.

تتميز نماذج الذكاء الاصطناعي بالديناميكية، وغالبًا ما تغير سلوكها بمرور الوقت. هذا يجعل التدابير الأمنية الثابتة غير كافية. تقدم ممارسات الأمان الرشيقة حلقات ردود فعل سريعة تعمل على مواءمة التخفيف من المخاطر والاستجابة للحوادث مع الطبيعة التكرارية لتطوير الذكاء الاصطناعي. من خلال دمج الأمان في عمليات الذكاء الاصطناعي/التعلم الآلي، يمكن للفرق الاستفادة من أفضل ممارسات التعلم الآلي وعمليات التطوير وهندسة البيانات.

«قم بتكييف عناصر التحكم لحلقات التغذية الراجعة بشكل أسرع. نظرًا لأنه مهم للتخفيف من حدة الحوادث والاستجابة لها، يمكنك تتبع أصولك وعمليات تشغيل خطوط الأنابيب.»

- جوجل كلاود

تعد أتمتة عمليات الفحص الأمني داخل خطوط أنابيب CI/CD خطوة حاسمة. أدوات مثل جنكينز، جيت لاب CI، أو خطوط أنابيب فيرتيكس للذكاء الاصطناعي يمكن أن تساعد في التحقق من صحة النماذج وتحديد الثغرات الأمنية قبل النشر. يمكن أن تكشف عمليات المحاكاة العدائية المنتظمة - مثل النماذج التوليدية وغير التوليدية ذات الفريق الأحمر - عن مشكلات مثل الحقن الفوري أو انعكاس النموذج الذي قد تتجاهله المراجعات الثابتة. يجب نشر بوابات الذكاء الاصطناعي المركزية لمراقبة نشاط الوكيل في الوقت الفعلي. أخيرًا، قم بإجراء تقييمات المخاطر المتكررة للبقاء في صدارة التهديدات الناشئة وضمان بقاء إجراءاتك الأمنية فعالة.

تمثل البيانات ثغرة خطيرة في أنظمة التعلم الآلي. يمكن أن يؤدي خرق واحد أو مجموعة بيانات مخترقة إلى نماذج مسمومة أو تسريب معلومات حساسة أو دورات تدريبية معطلة. وفقًا لمايكروسوفت، يشكل تسمم البيانات أخطر المخاطر الأمنية في التعلم الآلي اليوم بسبب عدم وجود طرق كشف موحدة والاعتماد الواسع على مجموعات البيانات العامة التي لم يتم التحقق منها. لحماية طبقة البيانات الخاصة بك، من الضروري تنفيذ ثلاث استراتيجيات أساسية: التشفير في كل مرحلة، وتتبع المصدر الدقيق، وخطوط التدريب المحصنة. توفر هذه الإجراءات معًا دفاعًا قويًا ضد التهديدات المحتملة.

التشفير ضروري لحماية البيانات في جميع الولايات - أثناء الراحة وأثناء النقل وأثناء الاستخدام. بالنسبة للبيانات المتبقية، استخدم مفاتيح التشفير المُدارة من قبل العملاء (CMEKs) من خلال منصات مثل كلاود كيه إم إس أو أوس كم للحفاظ على التحكم في التخزين في المجموعات وقواعد البيانات وسجلات النماذج. بالنسبة للبيانات التي يتم نقلها، قم بتطبيق TLS 1.2 كحد أدنى من المعايير، مع التوصية باستخدام TLS 1.3 للحصول على أعلى مستوى من الأمان. استخدم دائمًا HTTPS لاستدعاءات API لخدمات AI/ML، وقم بنشر موازنات تحميل HTTPS لتأمين عمليات نقل البيانات.

بالنسبة لأحمال العمل الحساسة، فكر في نشر الحوسبة السرية أو الأجهزة الافتراضية المحمية، التي توفر عزلًا قائمًا على الأجهزة لحماية البيانات حتى أثناء المعالجة النشطة. وهذا يضمن بقاء بيانات التدريب آمنة، حتى من موفري السحابة. بالإضافة إلى ذلك، قم بتوقيع الحزم والحاويات رقميًا، واستخدم المصادقة الثنائية لضمان نشر الصور التي تم التحقق منها فقط.

سياسات التحكم في الخدمة أو مفاتيح شروط IAM (على سبيل المثال، صانع الحكمة: مفتاح التحكم في الصوت) يمكنه فرض التشفير عن طريق منع إنشاء أجهزة الكمبيوتر المحمولة أو المهام التدريبية دون تمكين التشفير. بالنسبة للتدريب الموزع، قم بتمكين تشفير حركة المرور بين الحاويات لحماية البيانات التي تنتقل بين العقد. لتقليل المخاطر بشكل أكبر، استخدم محيط خدمة VPC وخدمة Private Service Connect، مما يضمن بقاء حركة مرور AI/ML خارج الإنترنت العام وتقليل التعرض للهجمات المحتملة.

يعد تتبع أصل البيانات وسلامتها أمرًا بالغ الأهمية لاكتشاف التلاعب والتحقق من الدقة. تقوم تجزئة التشفير، مثل SHA-256، بإنشاء بصمات رقمية فريدة لمجموعات البيانات في كل مرحلة. ستؤدي أي تغييرات غير مصرح بها على البيانات إلى تغيير قيمة التجزئة، مما يشير على الفور إلى حدوث تلف أو تدخل محتمل.

«أكبر تهديد أمني في التعلم الآلي اليوم هو تسمم البيانات بسبب الافتقار إلى الاكتشافات القياسية وإجراءات التخفيف في هذا المجال، جنبًا إلى جنب مع الاعتماد على مجموعات البيانات العامة غير الموثوق بها/غير المنظمة كمصادر لبيانات التدريب.»

- مايكروسوفت

يمكن لتسجيل ETL/ELT الآلي التقاط البيانات الوصفية في كل خطوة. تقوم الأنظمة المجهزة بكتالوجات البيانات وأدوات إدارة البيانات الوصفية الآلية بإنشاء سجلات مفصلة لأصول البيانات والتحولات، مما يوفر مسارًا قابلًا للتدقيق للامتثال والأمان. بالنسبة لمجموعات البيانات الهامة، حافظ على التتبع التفصيلي للمصدر، مع استخدام البيانات الوصفية المجمعة للتحولات الأقل أهمية لتحقيق التوازن بين الأداء وكفاءة التخزين.

أطر مثل السالسا (مستويات سلسلة التوريد للقطع الأثرية للبرامج) وأدوات مثل سيغستور يمكن تأمين سلسلة توريد برامج الذكاء الاصطناعي من خلال توفير مصدر يمكن التحقق منه لجميع القطع الأثرية. بالإضافة إلى ذلك، يمكن لأنظمة اكتشاف الأعطال مراقبة التوزيع اليومي للبيانات وتنبيه الفرق إلى الانحرافات أو الانجرافات في جودة بيانات التدريب. لتقليل المخاطر بشكل أكبر، حافظ على التحكم في الإصدار، مما يسمح لك بالعودة إلى إصدارات النماذج السابقة وعزل المحتوى العدائي لإعادة التدريب.

تتطلب خطوط أنابيب التدريب تحكمًا صارمًا في الإصدار وقابلية التدقيق، وهو ما يمكن تحقيقه باستخدام أدوات مثل إم إل فلو أو دي في سي. يجب أن تراقب أجهزة الاستشعار توزيع البيانات يوميًا للإبلاغ عن أي اختلافات أو انحرافات أو انجرافات قد تشير إلى تسمم البيانات. يجب التحقق من صحة جميع بيانات التدريب وتعقيمها قبل الاستخدام.

يمكن للدفاعات المتقدمة مثل Reject-on-Negative-Impact (RONI) تحديد وإزالة عينات التدريب التي تؤدي إلى تدهور أداء النموذج. يجب أن تعمل أعباء العمل التدريبية في بيئات معزولة باستخدام السحابة الافتراضية الخاصة (VPCs) وعناوين IP الخاصة ومحيط الخدمة لإبقائها بعيدة عن حركة الإنترنت العامة. قم بتعيين حسابات الخدمة الأقل امتيازًا لخطوط أنابيب MLOPS، مما يقيد وصولها إلى مجموعات تخزين وسجلات محددة.

بالنسبة لمجموعات البيانات الحساسة، استخدم الخصوصية التفاضلية أو تقنيات إخفاء هوية البيانات. يمكن أن يؤدي الضغط على الميزات، الذي يدمج متجهات ميزات متعددة في عينة واحدة، إلى تقليل مساحة البحث للهجمات العدائية. احفظ حالات النموذج بانتظام كنقاط تفتيش لتمكين عمليات التدقيق والتراجع، مما يضمن تكامل سير العمل طوال دورة حياة نموذج الذكاء الاصطناعي. تعمل هذه الإجراءات بشكل جماعي على تأمين عملية التدريب والحماية من التهديدات المحتملة وضمان موثوقية أنظمة الذكاء الاصطناعي.

بعد تأمين البيانات وخطوط التدريب الخاصة بك، تتضمن الخطوة التالية التحكم في من - أو ماذا - يمكنه التفاعل مع نماذج الذكاء الاصطناعي الخاصة بك. هذه الطبقة الدفاعية ضرورية في حماية الأنظمة الحساسة. تؤكد المصادقة الهوية، بينما يحدد التفويض الإجراءات التي يمكن أن تقوم بها الهوية. تحدث العديد من خروقات واجهة برمجة التطبيقات (API) ليس لأن المهاجمين يتجاوزون المصادقة، ولكن بسبب ضوابط التفويض الضعيفة التي تسمح للمستخدمين المصادق عليهم بالوصول إلى الموارد التي لا ينبغي لهم الوصول إليها. عزز دفاعاتك من خلال تنفيذ مصادقة قوية وإجراءات ترخيص دقيقة للحد من الوصول إلى نماذج الذكاء الاصطناعي الخاصة بك.

مفاتيح API الثابتة قديمة ويجب استبدالها بأساليب حديثة مثل OAuth 2.1 مع PKCE (مفتاح الإثبات لتبادل التعليمات البرمجية) و TLS المتبادل (mTLS) والهويات المُدارة من السحابة الأصلية. يقلل OAuth 2.1 مع PKCE من التعرض لبيانات الاعتماد باستخدام الرموز قصيرة الأجل بدلاً من كلمات المرور. من ناحية أخرى، تضمن Mutual TLS مصادقة كل من العميل والخادم لبعضهما البعض بشهادات رقمية، مما يزيل الأسرار المشتركة. تسمح الهويات المُدارة من السحابة الأصلية للخدمات بالمصادقة مع الموارد الأخرى دون تضمين بيانات الاعتماد في التعليمات البرمجية، مما يقلل من مخاطر التسريبات العرضية.

للوصول المستند إلى الأدوار، قم بتطبيق RBAC (التحكم في الوصول المستند إلى الأدوار) لتعيين الأذونات استنادًا إلى الأدوار المحددة مسبقًا مثل «عالم البيانات» أو «Model Auditor»، مما يضمن وصول المستخدمين إلى ما يحتاجون إليه فقط. بالنسبة للسيناريوهات الأكثر ديناميكية، يمكن لـ ABAC (التحكم في الوصول المستند إلى السمات) منح الأذونات استنادًا إلى سمات المستخدم وسياق الطلب (مثل الوقت أو الموقع) وحساسية الموارد. الأدوار المتخصصة المصممة خصيصًا لمهام الذكاء الاصطناعي - مثل «دور التقييم» لاختبار وضع الحماية أو «دور الوصول الدقيق» للنماذج الاحتكارية - تقلل بشكل أكبر من مخاطر الوصول المفرط.

للحماية من هجمات رفض الخدمة وإساءة استخدام واجهة برمجة التطبيقات، تحديد المعدل أمر ضروري. يمكن لخوارزميات مجموعة الرموز فرض معدلات الحالة المستقرة وحدود الاندفاع، والاستجابة بـ HTTP 429 «عدد كبير جدًا من الطلبات» عند تجاوز الحدود الدنيا. نشر ملف جدار حماية تطبيقات الويب (WAF) لتصفية الهجمات الشائعة المستندة إلى HTTP، مثل إدخال SQL والبرمجة النصية عبر المواقع، قبل أن تصل إلى نقاط النهاية النموذجية الخاصة بك.

منع ترخيص مستوى الكائن المكسور (BOLA)، تم تصنيفها على أنها أكبر مخاطر أمان API من قبل OWASP، وتتطلب استخدام معرفات موارد غير شفافة مثل UUIDs بدلاً من الأرقام المتسلسلة. هذا يجعل من الصعب على المهاجمين تخمين بيانات المستخدمين الآخرين والوصول إليها. بالإضافة إلى ذلك، قم بتعقيم جميع المدخلات من جانب الخادم والتحقق من صحتها، بما في ذلك تلك التي تم إنشاؤها بواسطة نماذج الذكاء الاصطناعي، للدفاع ضد هجمات الحقن الفوري. قم بأتمتة تدوير مفاتيح وشهادات API مع المديرين السريين للحد من فرصة الحصول على بيانات الاعتماد المخترقة. للحفاظ على الإشراف، استخدم الإصدار الدقيق وراقب سجلات الوصول بحثًا عن الحالات الشاذة.

يعد التحكم في الإصدار لعناصر النموذج أمرًا ضروريًا لإنشاء مسار تدقيق وتمكين عمليات التراجع السريعة إذا أظهر إصدار النموذج نقاط ضعف أو انحرافًا. تمامًا كما تحمي عناصر التحكم في الوصول البيانات، تضمن إصدارات نماذج المراقبة السلامة التشغيلية. قم بإقران حلول تخزين القطع الأثرية، مثل أمازون إس 3، مع حذف وزارة الخارجية للتأكد من أن المستخدمين المصادق عليهم متعددي العوامل فقط يمكنهم حذف إصدارات النماذج نهائيًا. قم بمراجعة سجلات API والنماذج بانتظام لاكتشاف النشاط غير المعتاد، مثل عمليات تسجيل الدخول من مواقع غير متوقعة، أو المكالمات المتكررة التي قد تشير إلى التجريف، أو محاولات الوصول إلى معرفات الكائنات غير المصرح بها.

قم بإدارة مخزون الذكاء الاصطناعي الخاص بك بنشاط لتجنب «عمليات النشر اليتيمة» - اختبر النماذج أو التي تم إيقافها والتي تُترك متاحة في الإنتاج دون إجراءات أمنية محدثة. يمكن لأدوات مثل Azure Resource Graph Explorer أو Microsoft Defender for Cloud توفير رؤية في الوقت الفعلي لجميع موارد الذكاء الاصطناعي عبر الاشتراكات. بالنسبة لعمليات سير العمل التي تتطلب درجة عالية من الأمان، قم بنشر مكونات التعلم الآلي في سحابة افتراضية خاصة معزولة (VPC) بدون اتصال بالإنترنت، باستخدام نقاط نهاية VPC أو خدمات مثل AWS PrivateLink لضمان بقاء حركة المرور داخلية.

حتى مع وجود ضوابط وصول قوية، لا يزال من الممكن ظهور التهديدات في عمليات سير عمل الذكاء الاصطناعي. لتأمين هذه الأنظمة بشكل كامل، تعمل المراقبة والكشف السريع كطبقات أساسية للدفاع. من خلال استكمال إجراءات الوصول والمصادقة، تعمل المراقبة الاستباقية على تعزيز سير العمل الداخلي، مما يساعد على تحديد الحوادث الأمنية المحتملة قبل أن تتحول إلى انتهاكات خطيرة. وجدت دراسة استقصائية أجرتها Microsoft على 28 شركة أن 89٪ (25 من أصل 28) تفتقر إلى الأدوات اللازمة لحماية أنظمة التعلم الآلي الخاصة بها. يؤدي هذا النقص إلى تعريض عمليات سير العمل لمخاطر مثل تسمم البيانات واستخراج النماذج والتلاعب العدائي.

إن فهم كيفية تصرف أنظمة الذكاء الاصطناعي الخاصة بك هو المفتاح للكشف عن التهديدات التي قد تغفلها أدوات الأمان التقليدية. كشف الانجراف الإحصائي يتتبع التغييرات في توزيع المدخلات وانتروبيا المخرجات، ويحدد الحالات التي يعمل فيها النموذج خارج معاييره المدربة. على سبيل المثال، يمكن أن يشير انخفاض ثقة النموذج إلى ما دون عتبة محددة إلى وجود مدخلات خارج التوزيع. وبالمثل، فإن الضغط على الميزات - مقارنة تنبؤات النموذج بشأن المدخلات الأصلية مقابل المدخلات «المضغوطة» - يمكن أن يكشف عن أمثلة عدائية عندما يكون هناك خلاف كبير بين الاثنين.

بالإضافة إلى مراقبة مخرجات النموذج، يمكن للمقاييس التشغيلية مثل ارتفاع زمن الوصول والاستخدام غير المعتاد لواجهة برمجة التطبيقات والاستهلاك غير المنتظم لموارد وحدة المعالجة المركزية/وحدة معالجة الرسومات أن تشير إلى هجمات مثل محاولات رفض الخدمة (DoS) أو جهود استخراج النموذج. حدثت حالة بارزة في سبتمبر 2025، عندما قام موقع Finerymarkets.com بتنفيذ خط أنابيب DevSecOps المستند إلى الذكاء الاصطناعي والذي يتميز باكتشاف الأخطاء في وقت التشغيل. أدى هذا الابتكار إلى تقليل متوسط وقت الاكتشاف (MTTD) من 4 ساعات إلى 15 دقيقة فقط ومتوسط وقت المعالجة (MTTR) من يومين إلى 30 دقيقة، مما عزز درجة الأمان الخاصة بهم من 65 إلى 92. تسلط هذه النتائج الضوء على أهمية الاكتشاف المتسق للشذوذ وتقييمات الثغرات الأمنية.

يمكن أن تكشف تقييمات الأمان الروتينية عن المخاطر الخاصة بالذكاء الاصطناعي التي قد تفوتها الأدوات القياسية، مثل الحقن الفوري وانعكاس النموذج وتسرب البيانات. تعد عمليات الفحص هذه ضرورية للتحقق من سلامة النموذج، مما يساعد على اكتشاف الأبواب الخلفية المضمنة أو الحمولات الضارة في ملفات مثل .pt أو .pkl قبل أن يتم إعدامهم. يأخذ فريق AI Red هذه الخطوة إلى الأمام من خلال محاكاة هجمات العالم الحقيقي، بما في ذلك محاولات كسر الحماية، على نماذج الذكاء الاصطناعي. تضمن أتمتة هذه العمليات من خلال خطوط الأنابيب التي تتضمن التحقق من التجزئة والتحليل الثابت سلامة النموذج قبل النشر. بالإضافة إلى ذلك، يعد مسح دفاتر الملاحظات وشفرة المصدر للحصول على بيانات اعتماد مشفرة أو مفاتيح API المكشوفة أمرًا حيويًا لتأمين سير العمل.

تعد المراقبة المستمرة ضرورية لتحديد التكوينات الخاطئة وبيانات الاعتماد المكشوفة ونقاط الضعف في البنية التحتية عبر خط الأنابيب بأكمله. يجب أن تلتقط السجلات غير القابلة للتغيير التفاعلات الهامة للمساعدة في الاستجابة للحوادث وضمان الامتثال. أدوات مثل مركز القيادة الأمنية أو يمكن لـ Microsoft Defender for Cloud أتمتة اكتشاف المخاطر ومعالجتها في عمليات نشر الذكاء الاصطناعي التوليدية. يمكن أن يساعد تتبع تدفقات البيانات والتحولات في تحديد الوصول غير المصرح به أو محاولات تسمم البيانات، بينما يضمن تضمين مسح التبعية داخل خط أنابيب CI/CD أن القطع الأثرية التي تم فحصها فقط هي التي تصل إلى الإنتاج. ولمزيد من الأمان، يمكن تكوين آليات إيقاف التشغيل التلقائي لتنشيطها عندما تتجاوز العمليات حدود الأمان المحددة مسبقًا، مما يوفر أمانًا من الفشل ضد التهديدات الخطيرة.

عندما يتعلق الأمر بضمان سلامة عمليات سير عمل الذكاء الاصطناعي، فإن تضمين تدابير الأمان في عمليات التطوير والنشر أمر غير قابل للتفاوض. غالبًا ما تكون هذه المراحل هي المكان الذي تتسلل فيه الثغرات الأمنية، لذلك من الضروري تصميم الأمان في خطوط الأنابيب الخاصة بك منذ البداية، بدلاً من إضافتها كفكرة لاحقة. من خلال التعامل مع النماذج كبرامج قابلة للتنفيذ، يمكنك تقليل مخاطر البنيات المخترقة التي تؤثر على العمليات النهائية. فيما يلي نظرة فاحصة على تأمين خطوط أنابيب CI/CD واعتماد ممارسات آمنة أثناء التطوير والنشر.

لحماية خطوط أنابيب CI/CD الخاصة بك، يجب أن تتم كل عملية بناء في بيئة مؤقتة ومعزولة. يمكن تحقيق ذلك باستخدام صور سريعة الزوال تعمل على تهيئة وتنفيذ وإنهاء كل إصدار، مما يمنع أي مخاطر باقية من البنيات المخترقة. لإنشاء الثقة، قم بإنشاء شهادات موقعة بشكل مشفر لكل قطعة أثرية. يجب أن تربط هذه الشهادات الأداة بسير العمل، ومستودعها، وارتكاب SHA، والحدث المثير. يجب نشر القطع الأثرية التي تم التحقق منها من خلال عناصر التحكم هذه فقط. فكر في هذه التوقيعات على أنها إيصالات مانعة للعبث، مما يضمن وصول القطع الأثرية الآمنة فقط إلى الإنتاج.

إدارة الأسرار هي خطوة حاسمة أخرى. تجنب بيانات اعتماد الترميز الثابت في شفرة المصدر أو دفاتر Jupyter. بدلاً من ذلك، استخدم أدوات مثل خزينة هاشي كورب أو مدير أسرار AWS لحقن الأسرار من خلال متغيرات البيئة أو رموز OIDC. لمزيد من أمان الشبكة، قم بفصل بيئات التطوير والتشغيل والإنتاج باستخدام عناصر تحكم خدمة VPC ومجموعات العمال الخاصة لمنع تسرب البيانات أثناء عمليات الإنشاء.

أطر الذكاء الاصطناعي مثل PyTorch، تينسورفلو، و جاكسس بمثابة تبعيات لوقت الإنشاء ووقت التشغيل. يمكن لأي ثغرات أمنية داخل هذه المكتبات أن تعرض نماذجك للخطر بشكل مباشر. قم بأتمتة مسح الثغرات الأمنية من خلال دمج أدوات مثل Google Artifact Analysis في خط أنابيب CI/CD للتحقق من صور الحاوية وحزم التعلم الآلي بحثًا عن المشكلات المعروفة. نظرًا لأن النماذج يمكن أن تعمل كتعليمات برمجية قابلة للتنفيذ، تعامل معها بنفس الحذر الذي ستطبقه على البرامج. على سبيل المثال، تنسيقات التسلسل القياسية مثل .pt أو .pkl يمكن أن تحتوي على برامج ضارة تنشط أثناء إلغاء التسلسل.

«لا يمكن فحص النماذج بسهولة... من الأفضل التعامل مع النماذج كبرامج، على غرار رمز البايت الذي يتم تفسيره في وقت التشغيل.» - Google

بالإضافة إلى ذلك، يمكن أن تؤدي النماذج ومجموعات البيانات التابعة لجهات خارجية التي لم يتم التحقق منها إلى مخاطر كبيرة. يساعد معيار AI Bill of Materials الناشئ (AIBOM) على فهرسة النماذج ومجموعات البيانات والتبعيات، مما يوفر الشفافية اللازمة للامتثال وإدارة المخاطر. احرص دائمًا على تطبيق مبدأ أقل الامتيازات من خلال قصر مهام التدريب والاستدلال على مجموعات تخزين البيانات المحددة وموارد الشبكة التي تتطلبها فقط.

بمجرد تطبيق ممارسات التطوير الآمنة، فإن الخطوة التالية هي التركيز على تقييد نشر الإنتاج لحماية بيئتك التشغيلية.

تعد أتمتة عملية النشر أمرًا أساسيًا لتقليل الخطأ البشري ومنع الوصول غير المصرح به. تشمل أفضل الممارسات الحديثة تنفيذ سياسة عدم وصول الإنسان لبيانات الإنتاج والتطبيقات والبنية التحتية. يجب أن تتم جميع عمليات النشر من خلال خطوط الأنابيب الآلية المعتمدة.

«تقدم مرحلة الإنتاج سياسات صارمة لمنع وصول الإنسان إلى بيانات الإنتاج والتطبيقات والبنية التحتية. يجب أن تتم جميع عمليات الوصول إلى أنظمة الإنتاج تلقائيًا من خلال خطوط أنابيب النشر المعتمدة.» - إرشادات AWS الوصفية

يعد الحفاظ على العزلة الصارمة بين بيئات التطوير والتدريج والإنتاج خطوة مهمة أخرى. هذا يمنع النماذج غير المصادق عليها من تلويث أنظمة الإنتاج. بالإضافة إلى ذلك، قم بفرض تنظيف سجل القطع الأثرية لإزالة الإصدارات غير المعتمدة أو المتوسطة، مع الاحتفاظ فقط بالإصدارات التي تم التحقق من صحتها جاهزة للنشر. بالنسبة لحالات الطوارئ، يجب وضع إجراءات «كسر الزجاج» التي تتطلب الموافقة الصريحة والتسجيل الشامل لضمان المساءلة أثناء الأزمات. تسمح نقاط التفتيش المنتظمة أثناء التدريب بتدقيق تطور النموذج وتوفر القدرة على العودة إلى حالة آمنة في حالة ظهور مشكلة أمنية.

بعد تأمين خطوط التطوير والنشر الخاصة بك، فإن الخطوة الحاسمة التالية هي ضمان توافق تدفقات عمل الذكاء الاصطناعي مع المعايير التنظيمية والسياسات الداخلية. نظرًا لأن الامتثال التنظيمي أصبح مصدر قلق متزايد للعديد من القادة، فإن إنشاء إطار واضح أمر حيوي - ليس فقط لتجنب المخاطر القانونية ولكن أيضًا للحفاظ على ثقة العملاء. يعتمد هذا الإطار بشكل طبيعي على العمليات الآمنة التي تمت مناقشتها سابقًا.

تتطور البيئة التنظيمية لأمن الذكاء الاصطناعي بسرعة، مما يتطلب من المنظمات الأمريكية مراقبة أطر عمل متعددة في وقت واحد. المرجع الرئيسي هو إطار NIST لإدارة مخاطر الذكاء الاصطناعي (AI RMF 1.0)، الذي يوفر التوجيه الطوعي لإدارة المخاطر التي يتعرض لها الأفراد والمجتمع. تم إصداره في يوليو 2024، ويتضمن دليل التشغيل المصاحب وملف تعريف الذكاء الاصطناعي التوليدي (NIST-AI-600-1) لمواجهة التحديات الفريدة مثل الهلوسة ومخاوف خصوصية البيانات. بالإضافة إلى ذلك، فإن التوجيه المشترك بين وكالة المخابرات المركزية ووكالة الأمن القومي ومكتب التحقيقات الفيدرالي، الذي نُشر في مايو 2025، يقدم خارطة طريق شاملة لحماية دورة حياة الذكاء الاصطناعي، من التطوير إلى التشغيل.

على نطاق عالمي، ISO/IEC 42001:2023 أصبح أول معيار دولي لنظام الإدارة للذكاء الاصطناعي. تم تصميمه على غرار ISO 27001، وهو يوفر هيكلًا مألوفًا لفرق الامتثال التي تدير بالفعل أنظمة أمن المعلومات. يغطي هذا المعيار مجالات مثل إدارة البيانات وتطوير النماذج والمراقبة التشغيلية، مما يجعله مفيدًا بشكل خاص لمعالجة مخاوف لجان المخاطر وعملاء المؤسسة. بالنسبة للمؤسسات العاملة في الأسواق الأوروبية، فإن الامتثال لـ قانون الاتحاد الأوروبي للذكاء الاصطناعي (لا سيما المادة 15 المتعلقة بالدقة والمتانة)، دورا للخدمات المالية، و نيس2 لمقدمي الخدمات الأساسية أمر بالغ الأهمية أيضًا.

«ISO 42001 هو إطار منظم يتعامل مع أمن الذكاء الاصطناعي والحوكمة وإدارة المخاطر، وهو ضروري للمؤسسات التي تسعى إلى نشر أدوات وأنظمة الذكاء الاصطناعي بشكل مسؤول.» - BD Emerson

تتمثل إحدى الميزات الرئيسية لاعتماد إطار موحد مثل ISO/IEC 42001 في قدرته على التوافق مع اللوائح المتعددة في وقت واحد، مما يقلل من جهود الامتثال الزائدة ويحسن الكفاءة التشغيلية. إنشاء مجلس أخلاقيات الذكاء الاصطناعي - التي تضم المديرين التنفيذيين والخبراء القانونيين وممارسي الذكاء الاصطناعي - توفر الرقابة اللازمة لتقييم المشاريع عالية المخاطر وضمان التوافق مع هذه الأطر. يؤدي دمج هذه المعايير في سير العمل إلى تعزيز كل من الأمان وقابلية التوسع، مما يكمل التدابير السابقة.

لا غنى عن مسارات التدقيق التفصيلية للامتثال التنظيمي والاستجابة للحوادث. يجب أن تسجل سجلاتك كل جانب من جوانب تفاعلات الذكاء الاصطناعي، بما في ذلك إصدار النموذج المستخدم، والمطالبة المحددة المقدمة، والاستجابة التي تم إنشاؤها، والبيانات الوصفية للمستخدم ذات الصلة. تعد هذه الرؤية الشاملة أمرًا بالغ الأهمية للرد على الاستفسارات التنظيمية أو التحقيق في الحوادث.

للحفاظ على سلامة هذه السجلات، استخدم WORM (اكتب مرة واحدة، اقرأ العديد) التخزين لتأمين مخرجات التسجيل وبيانات الجلسة. يجب أن توثق مسارات التدقيق أيضًا نسب البيانات - تتبع الأصل والتحولات وترخيص مجموعات البيانات، بالإضافة إلى معايير النموذج والمعايير الفائقة. يدعم هذا المستوى من الشفافية المتطلبات التنظيمية، مثل الاستجابة لطلبات «الحق في المحو» بموجب قوانين حماية البيانات.

الاستعراضات المنتظمة للسياسات مهمة بنفس القدر. قم بإجراء هذه المراجعات سنويًا على الأقل أو عند حدوث تغييرات تنظيمية مهمة، مثل التحديثات على قانون الاتحاد الأوروبي للذكاء الاصطناعي أو نيس2. نفذ تقييمات تأثير نظام الذكاء الاصطناعي (AISIA) بشكل دوري أو بعد تغييرات كبيرة لتقييم التأثيرات على الخصوصية والأمان والإنصاف. يجب مراجعة هذه التقييمات مع مجلس أخلاقيات الذكاء الاصطناعي متعدد التخصصات لضمان المساءلة. يعمل التسجيل القوي والمراجعات المنتظمة معًا على إنشاء أساس قوي للحوكمة وإدارة الحوادث.

تتطلب عمليات سير عمل الذكاء الاصطناعي خططًا متخصصة للاستجابة للحوادث تعالج التهديدات الفريدة لأنظمة الذكاء الاصطناعي. وتشمل هذه المخاطر مثل التسمم النموذجي والحقن الفوري والهجمات العدائية والنواتج الضارة التي تسببها الهلوسة. تتطلب مثل هذه السيناريوهات استراتيجيات اكتشاف ومعالجة مصممة خصيصًا، تختلف عن تلك المستخدمة في حوادث الأمن السيبراني التقليدية.

قم بتطوير كتيبات اللعب الخاصة بالذكاء الاصطناعي والتي تحدد بوضوح مسارات التصعيد والمسؤوليات. على سبيل المثال، إذا كان النموذج ينتج مخرجات متحيزة، فيجب أن يحدد دليل التشغيل من يقوم بالتحقيق في بيانات التدريب، ومن يتواصل مع أصحاب المصلحة، وما هي الشروط التي تستدعي التراجع عن النموذج. قم بتضمين إجراءات للتعامل مع طلبات موضوع البيانات، مثل التحقق مما إذا كانت بيانات الفرد قد استخدمت في التدريب النموذجي عندما يمارس «حقه في النسيان».

اختبار هذه الخطط أمر ضروري. قم بإجراء تمارين الطاولة مع فرق متعددة الوظائف لمحاكاة سيناريوهات حوادث الذكاء الاصطناعي الواقعية. تساعد هذه التمارين في تحديد الثغرات الإجرائية وتحسين تنسيق الفريق قبل حدوث أزمة حقيقية. بالإضافة إلى ذلك، قم بتكوين نماذج الذكاء الاصطناعي لتفشل في حالة «مغلقة» أو آمنة لمنع التعرض العرضي للبيانات أثناء فشل النظام. من خلال دمج كتيبات التشغيل الخاصة بالذكاء الاصطناعي مع بروتوكولات التشغيل الآلي الحالية، يمكنك الحفاظ على استمرارية التشغيل مع تحسين بنية الأمان الشاملة.

بالنسبة للفرق التي تعمل بموارد محدودة، قد يبدو تأمين سير عمل الذكاء الاصطناعي وكأنه مهمة شاقة. ومع ذلك، من خلال اتباع نهج تدريجي وآلي، يمكنك إنشاء إطار أمان قوي بمرور الوقت. بدلاً من محاولة تنفيذ كل إجراء في وقت واحد، ركز على عناصر التحكم عالية التأثير أولاً، واستخدم الأتمتة لتخفيف عبء العمل، وأدخل تقنيات أكثر تقدمًا تدريجيًا مع توسع قدراتك.

الخطوة الأولى هي معالجة نقاط الضعف الأكثر أهمية. ابدأ باكتشاف الأصول والمخزون. يمكن لنماذج الذكاء الاصطناعي غير المتعقبة ومجموعات البيانات ونقاط النهاية إنشاء نقاط ضعف قد يستغلها المهاجمون. يمكن لأدوات مثل Azure Resource Graph Explorer المساعدة في تحديد جميع موارد الذكاء الاصطناعي وفهرستها بشكل فعال.

بعد ذلك، قم بتطبيق إدارة الهوية والوصول (IAM) بمبدأ أقل الامتيازات. من خلال استخدام الهويات المُدارة وفرض حوكمة صارمة للبيانات، مثل تصنيف مجموعات البيانات الحساسة، يمكنك تحقيق حماية قوية دون تكاليف كبيرة.

خطوة أساسية أخرى هي تأمين المدخلات والمخرجات. استخدم تدابير مثل التصفية السريعة وتعقيم المخرجات لمنع هجمات الحقن ومنع تسرب البيانات. تعد المراقبة المركزية أمرًا بالغ الأهمية أيضًا - استخدم اكتشاف الأخطاء في الوقت الفعلي والتسجيل الشامل لتتبع تفاعلات الذكاء الاصطناعي، بما في ذلك المطالبات والاستجابات والبيانات الوصفية للمستخدم.

«إن تأمين الذكاء الاصطناعي يتعلق باستعادة الوضوح في البيئات التي يمكن أن تتلاشى فيها المساءلة بسرعة. يتعلق الأمر بمعرفة مكان وجود الذكاء الاصطناعي، وكيف يتصرف، وما يُسمح له بفعله، وكيف تؤثر قراراته على المؤسسة الأوسع.» - بريتاني وودسمول وسيمون فيلوز، Darktrace

ومع وجود عناصر التحكم الأساسية هذه، تصبح الأتمتة بمثابة تغيير لقواعد اللعبة بالنسبة للفرق ذات النطاق الترددي المحدود.

تُعد الأتمتة حليفًا قويًا للفرق ذات الموارد المحدودة، مما يقلل الجهد اليدوي المطلوب للحفاظ على الإجراءات الأمنية. يمكن لأدوات إدارة وضع الأمان بالذكاء الاصطناعي (AI-SPM) رسم خطوط أنابيب ونماذج الذكاء الاصطناعي تلقائيًا، وتحديد مسارات الاستغلال التي تم التحقق منها، وخفض ضوضاء التنبيه بنسبة تصل إلى 88٪. هذا مهم بشكل خاص للفرق الصغيرة التي لا يمكنها التدقيق يدويًا في آلاف التنبيهات.

توفر منصات الحوكمة والمخاطر والامتثال (GRC) طبقة أخرى من الكفاءة. تعمل هذه الأدوات على تركيز التسجيل وإدارة المخاطر والإشراف على السياسة. تتضمن العديد من منصات GRC قوالب معدة مسبقًا لأطر مثل NIST AI RMF أو ISO 42001، مما يوفر عليك عناء إنشاء سياسات من البداية. يمكن للتنبيهات الآلية أيضًا إخطار المسؤولين بالإجراءات الخطرة، مثل إعادة تدريب النماذج غير المجدولة أو عمليات تصدير البيانات غير العادية.

يساعد دمج المسح الآلي لنقاط الضعف الأمنية في خطوط أنابيب CI/CD على اكتشاف التكوينات الخاطئة قبل أن تصل إلى مرحلة الإنتاج. كما تضمن التوقيعات الرقمية على مجموعات البيانات وإصدارات النماذج وجود سلسلة حراسة واضحة للعبث، مما يلغي الحاجة إلى التحقق اليدوي. وبالنظر إلى أن متوسط تكلفة خرق البيانات يبلغ 4.45 مليون دولار، فإن هذه الأدوات الآلية توفر قيمة كبيرة للفرق الصغيرة.

بمجرد أن تتم المهام الأساسية تلقائيًا، يمكنك إجراء تحسينات أمنية أكثر تعقيدًا تدريجيًا.

بعد إنشاء أساس متين، حان الوقت لإدخال تدابير أمنية متقدمة. ابدأ بالاختبارات العدائية، مثل تمارين الفريق الأحمر، للكشف عن نقاط الضعف المحتملة في نماذج الذكاء الاصطناعي الخاصة بك. وبمرور الوقت، يمكنك اعتماد تقنيات تحسين الخصوصية (PETS)، مثل الخصوصية التفاضلية، لحماية مجموعات البيانات الحساسة.

«يجب أن تبدأ الفرق الصغيرة بضوابط أساسية مثل إدارة البيانات وإصدار النماذج وضوابط الوصول قبل التوسع إلى التقنيات المتقدمة.» - SentinelOne

أدوات تطبيق السياسة القائمة على الذكاء الاصطناعي هي خطوة أخرى إلى الأمام. يمكن لهذه الأدوات الإبلاغ تلقائيًا عن سياسات الوصول التي تم تكوينها بشكل خاطئ أو مسارات البيانات غير المشفرة أو أدوات الذكاء الاصطناعي غير المصرح بها - والتي يشار إليها غالبًا باسم «Shadow AI». مع تطور عمليات سير العمل الخاصة بك، فكر في تنفيذ إدارة الهوية غير البشرية (NHI). يتضمن ذلك معاملة وكلاء الذكاء الاصطناعي المستقلين كعمال رقميين، مكتملين بحسابات خدمة فريدة وبيانات اعتماد يتم تدويرها بانتظام.

يتطلب إنشاء سير عمل آمن للذكاء الاصطناعي الإشراف المستمر والشفافية واستراتيجية الدفاع متعددة الطبقات. ابدأ بوضع سياسات واضحة وتعيين المساءلة، ثم ركز على الحصول على رؤية شاملة لأصولك. عزز دفاعاتك من خلال الإجراءات الفنية مثل التشفير وضوابط الوصول وأنظمة اكتشاف التهديدات. تساعد معالجة هذه الأولويات على مراحل في معالجة نقاط الضعف الأكثر إلحاحًا بشكل فعال.

تؤكد البيانات على إلحاح هذه الإجراءات: 80٪ من القادة قلقون بشأن تسرب البيانات، بينما 88٪ قلقون بشأن الحقن الفوري. بالإضافة إلى ذلك، وقعت أكثر من 500 منظمة ضحية لهجمات Medusa ransomware اعتبارًا من يناير 2026.

للتصرف بشكل حاسم، حدد أولويات الخطوات عالية التأثير التي تحقق نتائج فورية. ابدأ بالأساسيات مثل اكتشاف الأصول وضوابط الوصول الصارمة وتعقيم المدخلات والمخرجات - توفر هذه الإجراءات التأسيسية حماية قوية دون الحاجة إلى موارد واسعة النطاق. بعد ذلك، قلل الجهد اليدوي من خلال اعتماد أدوات التشغيل الآلي مثل أنظمة إدارة الوضع الأمني بالذكاء الاصطناعي ومنصات GRC للحفاظ على المراقبة والحوكمة المتسقة. مع تطور إطار الأمان الخاص بك، قم بدمج الممارسات المتقدمة مثل الاختبار العدائي والحوسبة السرية لوحدات معالجة الرسومات وتخصيص هويات فريدة لوكلاء الذكاء الاصطناعي. تعمل هذه الخطوات بشكل جماعي على بناء بيئة ذكاء اصطناعي قوية وقابلة للتطوير.

«الأمن هو جهد جماعي يتم تحقيقه على أفضل وجه من خلال التعاون والشفافية». - OpenAI

يتطلب تأمين عمليات سير عمل نماذج الذكاء الاصطناعي استراتيجية شاملة لحماية البيانات والتعليمات البرمجية والنماذج في كل مرحلة من مراحل دورة حياتها. للبدء، حدد أولويات ممارسات البيانات الآمنة: تشفير مجموعات البيانات عند تخزينها وأثناء الإرسال، وفرض ضوابط وصول صارمة، وفحص أي بيانات تابعة لجهة خارجية أو مفتوحة المصدر بعناية قبل دمجها في عمليات سير العمل الخاصة بك.

أثناء التطوير، تجنب تضمين معلومات حساسة مثل كلمات المرور مباشرة في التعليمات البرمجية. بدلاً من ذلك، اعتمد على أدوات الإدارة السرية الآمنة وقم بإجراء مراجعات منتظمة للكود لتحديد نقاط الضعف أو التبعيات الخطرة.

عندما يتعلق الأمر بالتدريب أو ضبط النماذج، اعتمد مبادئ انعدام الثقة من خلال عزل موارد الحوسبة والبقاء يقظين للمخاطر مثل تسمم البيانات أو المدخلات العدائية. بمجرد اكتمال النموذج الخاص بك، قم بتخزينه في مستودعات آمنة، وقم بتشفير أوزانه لمنع الوصول غير المصرح به، وتحقق بشكل روتيني من سلامته.

بالنسبة إلى نقاط النهاية للاستدلال، قم بتنفيذ متطلبات المصادقة وتعيين حدود الاستخدام لمنع إساءة الاستخدام والتحقق من صحة المدخلات الواردة لحظر الهجمات المحتملة. اليقظة المستمرة هي المفتاح - راقب نشاط الاستدلال باستمرار، واحتفظ بسجلات مفصلة، وكن مستعدًا لخطط الاستجابة لمواجهة التهديدات مثل سرقة النماذج أو مشكلات الأداء غير المتوقعة. باتباع هذه الخطوات، يمكنك إنشاء دفاع قوي لسير عمل الذكاء الاصطناعي الخاص بك.

يمكن للفرق الصغيرة أن تبدأ بصياغة سياسات أمنية مباشرة تعالج كل مرحلة من مراحل دورة حياة الذكاء الاصطناعي - من جمع البيانات إلى التخلص منها في نهاية المطاف. اعتماد نهج انعدام الثقة أمر بالغ الأهمية: تنفيذ بروتوكولات المصادقة وفرض الوصول الأقل امتيازًا والاعتماد على عناصر التحكم في الوصول القائمة على الأدوار باستخدام أدوات السحابة المضمنة للحفاظ على انخفاض النفقات. يمكن للتدابير البسيطة، مثل توقيع التزامات Git، إنشاء مسار تدقيق غير قابل للتغيير، بينما يسمح إجراء تقييمات المخاطر الفصلية الخفيفة للفرق باكتشاف نقاط الضعف مبكرًا.

استفد من الأدوات المجانية أو مفتوحة المصدر لتبسيط جهود الأمان. استخدم التحقق من صحة الإدخال وتعقيمه لصد الهجمات العدائية، وتأمين واجهات برمجة التطبيقات باستخدام المصادقة القائمة على الرموز وتحديد المعدل، وإعداد خطوط أنابيب آلية لاكتشاف مشكلات مثل تسمم البيانات أو انحراف الأداء. يمكن للعلامة المائية النموذجية الخفيفة أن تحمي الملكية الفكرية، ويضمن إطار إدارة البيانات القوي وضع علامات على مجموعات البيانات وتشفيرها وتتبعها بشكل صحيح. تضع هذه الخطوات العملية الأساس لأمن قوي دون الحاجة إلى موارد مالية ضخمة.

لضمان أمان البيانات في عمليات سير عمل الذكاء الاصطناعي، ابدأ بـ نهج آمن حسب التصميم، مع التركيز على حماية المعلومات في كل مرحلة - من التجميع الأولي إلى النشر النهائي. استخدم التشفير لحماية البيانات أثناء الراحة (على سبيل المثال، AES-256) وأثناء الإرسال (على سبيل المثال، TLS 1.2 أو أعلى). نفذ ضوابط وصول صارمة مسترشدًا بمبدأ أقل الامتيازات، بحيث يمكن للمستخدمين والأنظمة المصرح لهم فقط التفاعل مع البيانات الحساسة. يمكن أن تكون سياسات الوصول القائمة على الأدوار أو السمات فعالة بشكل خاص في الحفاظ على هذه القيود.

قم بتأمين خطوط أنابيب البيانات عن طريق عزل الشبكات والتحقق من صحة المدخلات وتسجيل جميع حركات البيانات لاكتشاف النشاط غير المعتاد مبكرًا. الرافعة المالية أدوات نسب البيانات لتتبع أصل مجموعات البيانات واستخدامها، مما يساعد على الامتثال للوائح مثل GDPR و CCPA. يمكن أن تؤدي عمليات المسح المنتظمة للمعلومات الحساسة، مثل معلومات التعريف الشخصية (PII)، وتطبيق تقنيات مثل التنقيح أو الترميز إلى تقليل المخاطر بشكل أكبر. تتيح المراقبة في الوقت الفعلي المقترنة بتنبيهات الأمان الآلية التعرف السريع على التهديدات المحتملة والاستجابة لها.

دمج التشغيل الآلي القائم على السياسة في عمليات سير العمل الخاصة بك لتبسيط الإجراءات الأمنية. يتضمن ذلك توفير التخزين المشفر وفرض تجزئة الشبكة وتضمين فحوصات التوافق مباشرةً في عمليات النشر. استكمل هذه الدفاعات الفنية بالسياسات التنظيمية، مثل تدريب الفرق على ممارسات البيانات الآمنة، ووضع جداول استبقاء واضحة، وتطوير خطط الاستجابة للحوادث المصممة خصيصًا للمخاطر المتعلقة بالذكاء الاصطناعي. توفر هذه التدابير معًا حماية شاملة طوال دورة حياة الذكاء الاصطناعي.