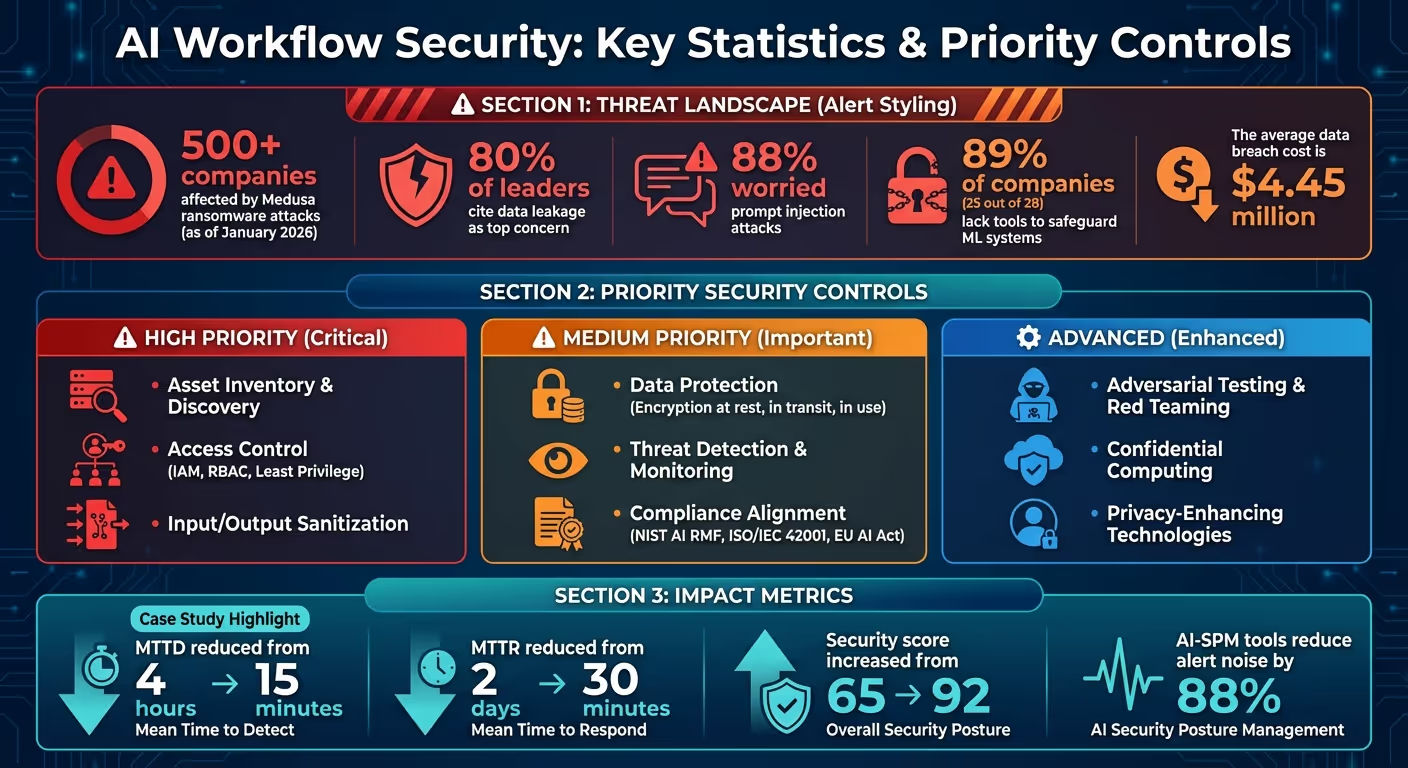

Les flux de travail basés sur l'IA comportent des risques uniques : les fuites de données, les abus d'identité et les vulnérabilités de la chaîne d'approvisionnement ne sont que le début. En janvier 2026, plus de 500 entreprises ont déjà affronté Ransomware Medusa attaques, soulignant le besoin urgent de renforcer les défenses. Avec 80 % des dirigeants citant les fuites de données comme leur principale préoccupation et 88 % Inquiet des attaques par injection rapide, la sécurisation de vos systèmes d'IA n'est plus une option, mais une nécessité.

En vous concentrant sur ces stratégies, vous pouvez réduire les vulnérabilités, garantir la conformité et renforcer la confiance dans vos systèmes d'IA. Commencez par des contrôles à fort impact tels que le chiffrement et la gestion des accès, puis évoluez avec des outils automatisés et des techniques avancées.

Statistiques de sécurité des flux de travail d'IA et contrôles prioritaires 2026

La sécurisation des flux de travail d'IA n'est pas aussi simple que la protection des systèmes logiciels traditionnels. L'IA fonctionne comme des applications, des processeurs de données et des décideurs, ce qui signifie que la responsabilité de la gestion des risques est répartie entre plusieurs équipes au lieu d'être confiée à un seul groupe de sécurité. Pour faire face à cette complexité, les entreprises doivent se concentrer sur trois principes clés : des cadres axés sur la gouvernance, une collaboration interfonctionnelle et des pratiques de sécurité flexibles qui peuvent s'adapter à l'évolution des modèles. Décrivons ces principes et leur rôle dans la création de flux de travail d'IA sécurisés.

La gouvernance est l'épine dorsale de la sécurité de l'IA, car elle permet de déterminer qui a accès aux systèmes, quand ils peuvent y accéder et quelles mesures prendre en cas de problème. Un cadre de sécurité basé sur le cycle de vie doit couvrir chaque étape des flux de travail d'IA, de l'approvisionnement des données à la formation des modèles, en passant par le déploiement et les opérations en temps réel. L'attribution de rôles clairs, tels que l'auteur, l'approbateur et l'éditeur, permet de définir les responsabilités et de garantir la responsabilisation.

Un élément essentiel de ce cadre est suivi de la lignée et de la provenance. Le lignage capture les métadonnées des ensembles de données, des transformations et des modèles, tandis que la provenance enregistre les détails de l'infrastructure et les signatures cryptographiques. Si un environnement de formation est compromis, ces enregistrements permettent d'identifier rapidement les modèles concernés et de revenir à des versions sécurisées.

« La généalogie et la provenance contribuent à la gestion des données et à l'intégrité des modèles, et constituent la base de la gouvernance des modèles d'IA. »

- Google SAIF 2.0

Pour minimiser davantage les risques, appliquez le principe du moindre privilège à tous les composants, y compris les modèles, les magasins de données, les points de terminaison et les flux de travail. Les informations sensibles, telles que les numéros de cartes de crédit, doivent être supprimées des ensembles de données de formation afin de réduire l'exposition en cas de violation. Utilisez des outils pour classer la sensibilité des données et mettre en œuvre un contrôle d'accès basé sur les rôles (RBAC), en veillant à ce que les systèmes d'IA n'accèdent qu'aux données nécessaires à leurs tâches.

Une fois la gouvernance en place, l'étape suivante consiste à favoriser la collaboration entre les équipes pour faire face aux risques spécifiques à l'IA.

Les défis de sécurité liés à l'IA dépassent les limites traditionnelles, car une seule interaction peut impliquer une utilisation abusive de l'identité, des fuites de données et des vulnérabilités de la chaîne d'approvisionnement. La collaboration entre les différentes équipes est donc essentielle. Les équipes chargées des opérations de sécurité (SecOps), du DevOps/MLOPS, de la gouvernance, des risques et de la conformité (GRC), les data scientists et les chefs d'entreprise jouent tous un rôle central.

Pour renforcer la responsabilisation, désignez une personne chargée d'approuver les déploiements et de contrôler le respect des normes éthiques. Centralisez les alertes liées à l'IA, telles que les problèmes de latence ou les tentatives d'accès non autorisées, dans votre centre des opérations de sécurité pour une supervision rationalisée. En outre, offrez une formation spécialisée aux équipes de sécurité et de développement sur les menaces spécifiques à l'IA, telles que l'empoisonnement des données, les tentatives de jailbreak et le vol d'informations d'identification via des interfaces d'IA.

Alors que la collaboration renforce les politiques, les pratiques de sécurité agiles garantissent que ces mesures restent efficaces à mesure que les systèmes d'IA évoluent.

Les modèles d'IA sont dynamiques et modifient souvent leur comportement au fil du temps. Cela rend les mesures de sécurité statiques inadéquates. Les pratiques de sécurité agiles introduisent des boucles de feedback rapides qui alignent l'atténuation des risques et la réponse aux incidents avec la nature itérative du développement de l'IA. En intégrant la sécurité à AI/ML Ops, les équipes peuvent tirer parti des meilleures pratiques en matière d'apprentissage automatique, de DevOps et d'ingénierie des données.

« Adaptez les commandes pour accélérer les boucles de feedback. Parce que c'est important pour l'atténuation et la réponse aux incidents, suivez vos actifs et l'évolution de votre pipeline. »

- Google Cloud

L'automatisation des contrôles de sécurité dans les pipelines CI/CD est une étape cruciale. Des outils tels que Jenkins, GitLab CI, ou Canalisations Vertex AI peut aider à valider les modèles et à identifier les vulnérabilités avant le déploiement. Des simulations contradictoires régulières, telles que l'association de modèles génératifs et non génératifs, peuvent révéler des problèmes tels que l'injection rapide ou l'inversion de modèle que les évaluations statiques peuvent ignorer. Des passerelles d'IA centralisées devraient être déployées pour surveiller l'activité des agents en temps réel. Enfin, effectuez des évaluations des risques récurrentes pour garder une longueur d'avance sur les menaces émergentes et vous assurer que vos mesures de sécurité restent efficaces.

Les données constituent une vulnérabilité critique des systèmes d'apprentissage automatique. Une seule faille ou un ensemble de données compromis peut entraîner l'empoisonnement de modèles, la fuite d'informations sensibles ou la perturbation des cycles de formation. Selon Microsoft, l'empoisonnement des données représente le risque de sécurité le plus grave dans le domaine de l'apprentissage automatique aujourd'hui en raison de l'absence de méthodes de détection normalisées et du recours généralisé à des ensembles de données publics non vérifiés. Pour protéger votre couche de données, il est essentiel de mettre en œuvre trois stratégies fondamentales : le chiffrement à chaque étape, un suivi méticuleux de la provenance et des pipelines de formation renforcés. Ensemble, ces mesures constituent une défense robuste contre les menaces potentielles.

Le chiffrement est essentiel pour protéger les données dans tous les états : au repos, en transit et en cours d'utilisation. Pour les données au repos, utilisez des clés de chiffrement gérées par le client (CMEK) via des plateformes telles que Cloud KMS ou AWS KMS pour garder le contrôle du stockage dans les compartiments, les bases de données et les registres de modèles. Pour les données en transit, appliquez TLS 1.2 comme norme minimale, le TLS 1.3 étant recommandé pour le plus haut niveau de sécurité. Utilisez toujours le protocole HTTPS pour les appels d'API aux services AI/ML et déployez des équilibreurs de charge HTTPS pour sécuriser les transferts de données.

Pour les charges de travail sensibles, envisagez de déployer une informatique confidentielle ou des machines virtuelles blindées, qui fournissent une isolation matérielle pour protéger les données même pendant le traitement actif. Cela garantit la sécurité des données de formation, même auprès des fournisseurs de cloud. En outre, signez numériquement les packages et les conteneurs, et utilisez l'autorisation binaire pour vous assurer que seules des images vérifiées sont déployées.

Politiques de contrôle des services ou clés de condition IAM (par exemple, SageMaker : Volume KMS Key) peuvent appliquer le chiffrement en empêchant la création de blocs-notes ou de tâches de formation sans que le chiffrement soit activé. Pour la formation distribuée, activez le chiffrement du trafic inter-conteneurs afin de protéger les données circulant entre les nœuds. Pour réduire davantage les risques, utilisez les périmètres de service VPC et Private Service Connect, afin de garantir que le trafic AI/ML reste hors de l'Internet public et de minimiser l'exposition aux attaques potentielles.

Le suivi de l'origine et de l'intégrité des données est essentiel pour détecter les falsifications et en vérifier l'exactitude. Le hachage cryptographique, tel que le SHA-256, génère des empreintes numériques uniques pour les ensembles de données à chaque étape. Toute modification non autorisée des données modifiera la valeur de hachage, signalant immédiatement une corruption ou une interférence potentielle.

« La plus grande menace de sécurité dans le domaine de l'apprentissage automatique aujourd'hui est l'empoisonnement des données dû à l'absence de détections et de mesures d'atténuation standard dans ce domaine, combinée à la dépendance à l'égard d'ensembles de données publics non fiables ou non sélectionnés comme sources de données de formation. »

- Microsoft

La journalisation ETL/ELT automatisée permet de capturer des métadonnées à chaque étape. Les systèmes équipés de catalogues de données et d'outils de gestion automatisée des métadonnées créent des enregistrements détaillés sur l'origine et la transformation des données, offrant ainsi une piste vérifiable en matière de conformité et de sécurité. Pour les ensembles de données critiques, maintenez un suivi détaillé de la provenance, tout en utilisant des métadonnées agrégées pour les transformations moins importantes afin d'équilibrer les performances et l'efficacité du stockage.

Des frameworks tels que SLSA (Niveaux de chaîne d'approvisionnement pour les artefacts logiciels) et des outils tels que Sigstore peut sécuriser la chaîne d'approvisionnement des logiciels d'IA en fournissant la provenance vérifiable de tous les artefacts. En outre, les systèmes de détection des anomalies peuvent surveiller la distribution quotidienne des données et alerter les équipes en cas de biais ou de dérives dans la qualité des données de formation. Pour atténuer davantage les risques, maintenez le contrôle des versions, ce qui vous permet de revenir aux versions précédentes des modèles et d'isoler le contenu contradictoire pour une nouvelle formation.

Les pipelines de formation nécessitent un contrôle de version et une auditabilité stricts, ce qui peut être réalisé à l'aide d'outils tels que Débit ML ou DVC. Les capteurs doivent surveiller quotidiennement la distribution des données pour détecter toute variation, distorsion ou dérive susceptible d'indiquer un empoisonnement des données. Toutes les données d'entraînement doivent être validées et nettoyées avant utilisation.

Les défenses avancées telles que Reject-on-Negative-Impact (RONI) peuvent identifier et supprimer les échantillons d'entraînement qui dégradent les performances du modèle. Les charges de travail de formation doivent fonctionner dans des environnements isolés utilisant des clouds privés virtuels (VPC), des adresses IP privées et des périmètres de service pour les éloigner du trafic Internet public. Attribuez des comptes de service dotés du moindre privilège aux pipelines MLOps, en limitant leur accès à des compartiments de stockage et à des registres spécifiques.

Pour les ensembles de données sensibles, utilisez des techniques de confidentialité différentielles ou d'anonymisation des données. La compression des caractéristiques, qui regroupe plusieurs vecteurs de caractéristiques en un seul échantillon, peut réduire l'espace de recherche pour les attaques contradictoires. Enregistrez régulièrement les états des modèles en tant que points de contrôle pour permettre des audits et des annulations, garantissant ainsi l'intégrité du flux de travail tout au long du cycle de vie du modèle d'IA. Ces mesures sécurisent collectivement le processus de formation, protègent contre les menaces potentielles et garantissent la fiabilité des systèmes d'IA.

Après avoir sécurisé vos données et vos pipelines de formation, l'étape suivante consiste à contrôler qui, ou quoi, peut interagir avec vos modèles d'IA. Cette couche de défense est cruciale pour protéger les systèmes sensibles. L'authentification confirme l'identité, tandis que l'autorisation détermine les actions que l'identité peut effectuer. De nombreuses violations d'API ne se produisent pas parce que les attaquants contournent l'authentification, mais en raison de contrôles d'autorisation faibles qui permettent aux utilisateurs authentifiés d'accéder à des ressources auxquelles ils ne devraient pas accéder. Renforcez vos défenses en mettant en œuvre une authentification robuste et des mesures d'autorisation précises pour limiter l'accès à vos modèles d'IA.

Les clés d'API statiques sont obsolètes et devraient être remplacées par des approches modernes telles que OAuth 2.1 avec PKCE (Proof Key for Code Exchange), Mutual TLS (mTLS) et des identités gérées natives du cloud. OAuth 2.1 avec PKCE minimise l'exposition aux informations d'identification en utilisant des jetons de courte durée au lieu de mots de passe. Le protocole TLS mutuel, quant à lui, garantit que le client et le serveur s'authentifient mutuellement à l'aide de certificats numériques, éliminant ainsi les secrets partagés. Les identités gérées natives du cloud permettent aux services de s'authentifier auprès d'autres ressources sans intégrer d'informations d'identification dans le code, ce qui réduit le risque de fuites accidentelles.

Pour l'accès basé sur les rôles, implémentez le RBAC (Role-Based Access Control) pour attribuer des autorisations en fonction de rôles prédéfinis tels que « Data Scientist » ou « Model Auditor », en veillant à ce que les utilisateurs n'aient accès qu'à ce dont ils ont besoin. Pour des scénarios plus dynamiques, ABAC (Attribute-Based Access Control) peut accorder des autorisations en fonction des attributs de l'utilisateur, du contexte de la demande (par exemple, heure ou lieu) et de la sensibilité des ressources. Les rôles spécialisés adaptés aux tâches d'IA, tels qu'un « rôle d'évaluation » pour les tests en sandbox ou un « rôle d'accès affiné » pour les modèles propriétaires, réduisent encore le risque d'accès trop privilégié.

Pour vous protéger contre les attaques par déni de service et les utilisations abusives des API, limitation de débit est essentiel. Les algorithmes de bucket de jetons peuvent appliquer des taux stables et des limites de rafale, en répondant par le protocole HTTP 429 « Too Many Requests » lorsque les seuils sont dépassés. Déployez un Pare-feu pour applications Web (WAF) pour filtrer les attaques HTTP courantes, telles que l'injection SQL et les scripts intersites, avant qu'elles n'atteignent les points de terminaison de votre modèle.

Prévenir Autorisation de niveau pour objets cassés (BOLA), classée comme le principal risque de sécurité des API par l'OWASP, nécessite l'utilisation d'identifiants de ressources opaques tels que les UUID au lieu de numéros séquentiels. Il est donc plus difficile pour les attaquants de deviner et d'accéder aux données des autres utilisateurs. En outre, nettoyez et validez toutes les entrées côté serveur, y compris celles générées par les modèles d'IA, pour vous défendre contre les attaques par injection rapide. Automatisez la rotation des clés et des certificats d'API avec les gestionnaires de secrets afin de limiter les opportunités de compromission des informations d'identification. Pour maintenir la surveillance, utilisez un contrôle de version méticuleux et surveillez les journaux d'accès pour détecter les anomalies.

Le contrôle de version des artefacts de modèle est essentiel pour créer une piste d'audit et permettre des annulations rapides si une version du modèle présente des vulnérabilités ou des dérives. Tout comme les contrôles d'accès protègent les données, la surveillance des versions des modèles garantit l'intégrité opérationnelle. Associez des solutions de stockage d'artefacts, telles que Amazon S3, avec Supprimer MFA pour garantir que seuls les utilisateurs authentifiés à plusieurs facteurs peuvent supprimer définitivement les versions des modèles. Consultez régulièrement les journaux des API et des modèles pour détecter les activités inhabituelles, telles que les connexions depuis des emplacements inattendus, les appels fréquents susceptibles d'indiquer un scraping ou les tentatives d'accès à des identifiants d'objets non autorisés.

Gérez activement votre inventaire d'IA pour éviter les « déploiements orphelins » : des modèles de test ou obsolètes restent accessibles en production sans mesures de sécurité mises à jour. Des outils tels qu'Azure Resource Graph Explorer ou Microsoft Defender for Cloud peuvent fournir une visibilité en temps réel de toutes les ressources d'IA sur l'ensemble des abonnements. Pour les flux de travail nécessitant une sécurité élevée, déployez des composants d'apprentissage automatique dans un cloud privé virtuel (VPC) isolé sans accès à Internet, en utilisant des points de terminaison VPC ou des services tels qu'AWS PrivateLink pour garantir que le trafic reste interne.

Même avec des contrôles d'accès robustes en place, des menaces peuvent toujours survenir dans les flux de travail d'IA. Pour sécuriser pleinement ces systèmes, la surveillance et la détection rapide constituent des niveaux de défense essentiels. En complétant les mesures d'accès et d'authentification, la surveillance proactive renforce les flux de travail internes, aidant à identifier les incidents de sécurité potentiels avant qu'ils ne dégénèrent en violations graves. Une enquête menée par Microsoft auprès de 28 entreprises a révélé que 89 % (25 sur 28) ne disposaient pas des outils nécessaires pour protéger leurs systèmes d'apprentissage automatique. Cette lacune expose les flux de travail à des risques tels que l'empoisonnement des données, l'extraction de modèles et la manipulation contradictoire.

Comprendre le comportement de vos systèmes d'IA est essentiel pour découvrir les menaces que les outils de sécurité traditionnels peuvent ignorer. Détection de dérive statistique suit l'évolution de la distribution en entrée et de l'entropie en sortie, en signalant les cas où un modèle fonctionne en dehors de ses paramètres entraînés. Par exemple, une baisse de la confiance du modèle en dessous d'un seuil défini peut indiquer la présence d'entrées hors distribution. De même, la compression des caractéristiques, c'est-à-dire la comparaison des prédictions d'un modèle sur les entrées d'origine par rapport aux entrées « compressées », peut révéler des exemples contradictoires en cas de désaccord significatif entre les deux.

Outre la surveillance des sorties des modèles, les mesures opérationnelles telles que les pics de latence, l'utilisation inhabituelle des API et la consommation irrégulière des ressources du CPU/GPU peuvent signaler des attaques telles que des tentatives de déni de service (DoS) ou des efforts d'extraction de modèles. Un cas notable s'est produit en septembre 2025, lorsque FineryMarkets.com a mis en œuvre un pipeline DevSecOps piloté par l'IA et doté d'une détection des anomalies d'exécution. Cette innovation a réduit leur temps moyen de détection (MTTD) de 4 heures à seulement 15 minutes et leur temps moyen de correction (MTTR) de 2 jours à 30 minutes, augmentant ainsi leur score de sécurité de 65 à 92. Ces résultats soulignent l'importance d'une détection cohérente des anomalies et d'évaluations de vulnérabilité.

Les évaluations de sécurité de routine peuvent mettre en évidence les risques spécifiques à l'IA que les outils standard pourraient ignorer, tels que l'injection rapide, l'inversion de modèle et les fuites de données. Ces analyses sont cruciales pour valider l'intégrité du modèle, en aidant à détecter les portes dérobées intégrées ou les charges utiles malveillantes dans des fichiers tels que .pt ou .pkl avant leur exécution. L'IA Red Teaming va encore plus loin en simulant des attaques réelles, y compris des tentatives de jailbreak, sur des modèles d'IA. L'automatisation de ces processus via des pipelines qui incluent la vérification du hachage et l'analyse statique garantit l'intégrité du modèle avant le déploiement. En outre, l'analyse des blocs-notes et du code source à la recherche d'informations d'identification codées en dur ou de clés d'API exposées est essentielle pour sécuriser les flux de travail.

Une surveillance continue est essentielle pour identifier les erreurs de configuration, les informations d'identification exposées et les vulnérabilités de l'infrastructure sur l'ensemble du pipeline. Les journaux immuables devraient capturer les interactions critiques pour faciliter la réponse aux incidents et garantir la conformité. Des outils tels que Centre de commande de sécurité ou Microsoft Defender for Cloud peut automatiser la détection et la correction des risques dans les déploiements génératifs d'IA. Le suivi des flux et des transformations de données peut aider à identifier les accès non autorisés ou les tentatives d'empoisonnement des données, tandis que l'intégration de l'analyse des dépendances dans le pipeline CI/CD garantit que seuls les artefacts approuvés sont mis en production. Pour plus de sécurité, des mécanismes d'arrêt automatique peuvent être configurés pour être activés lorsque les opérations dépassent les limites de sécurité prédéfinies, offrant ainsi une sécurité intégrée contre les menaces critiques.

Lorsqu'il s'agit de garantir l'intégrité de vos flux de travail d'IA, l'intégration de mesures de sécurité dans les processus de développement et de déploiement n'est pas négociable. Ces étapes sont souvent celles où les vulnérabilités apparaissent. Il est donc essentiel de concevoir la sécurité de vos pipelines dès le départ, plutôt que de les ajouter après coup. En traitant les modèles comme des programmes exécutables, vous pouvez minimiser le risque que des versions compromises affectent les opérations en aval. Voici un aperçu de la sécurisation des pipelines CI/CD et de l'adoption de pratiques sûres lors du développement et du déploiement.

Pour protéger vos pipelines CI/CD, chaque construction doit avoir lieu dans un environnement isolé temporaire. Cela peut être réalisé à l'aide d'images de course éphémères qui s'initialisent, s'exécutent et se terminent à chaque build, évitant ainsi tout risque persistant lié à des builds compromis. Pour établir la confiance, générez des attestations signées cryptographiquement pour chaque artefact. Ces attestations doivent relier l'artefact à son flux de travail, à son référentiel, à son SHA de validation et à son événement déclencheur. Seuls les artefacts vérifiés par le biais de ces contrôles doivent être déployés. Considérez ces signatures comme des reçus infalsifiables, garantissant que seuls les artefacts sécurisés parviennent à la production.

La gestion des secrets est une autre étape cruciale. Évitez de coder en dur les informations d'identification dans votre code source ou dans vos blocs-notes Jupyter. Utilisez plutôt des outils tels que Coffre-fort HashiCorp ou Gestionnaire de secrets AWS pour injecter des secrets via des variables d'environnement ou des jetons OIDC. Pour renforcer la sécurité du réseau, séparez vos environnements de développement, de préparation et de production à l'aide de VPC Service Controls et de pools de travailleurs privés afin d'empêcher l'exfiltration de données lors des builds.

Frameworks d'IA tels que PyTorch, TensorFlow, et JAX servent à la fois de dépendances au moment de la construction et à l'exécution. Toute vulnérabilité au sein de ces bibliothèques peut directement compromettre vos modèles. Automatisez l'analyse des vulnérabilités en intégrant des outils tels que Google Artifact Analysis à votre pipeline CI/CD afin de vérifier à la fois les images de conteneurs et les packages d'apprentissage automatique pour détecter les problèmes connus. Étant donné que les modèles peuvent agir comme du code exécutable, traitez-les avec la même prudence que vous appliqueriez aux programmes logiciels. Par exemple, les formats de sérialisation standard tels que .pt ou .pkl peut héberger des malwares qui s'activent lors de la désérialisation.

« Les modèles ne sont pas facilement inspectables... Il est préférable de traiter les modèles comme des programmes, de la même manière que le bytecode interprété lors de l'exécution. » - Google

En outre, des modèles et des ensembles de données tiers non validés peuvent présenter des risques importants. La nouvelle norme AI Bill of Materials (AIBOM) permet de cataloguer les modèles, les ensembles de données et les dépendances, offrant ainsi la transparence nécessaire à la conformité et à la gestion des risques. Appliquez toujours le principe du moindre privilège en limitant les tâches de formation et d'inférence aux seuls compartiments de stockage de données et aux ressources réseau spécifiques dont ils ont besoin.

Une fois les pratiques de développement sécurisées mises en place, l'étape suivante consiste à restreindre le déploiement en production afin de protéger votre environnement opérationnel.

L'automatisation du processus de déploiement est essentielle pour réduire les erreurs humaines et empêcher tout accès non autorisé. Les meilleures pratiques modernes incluent la mise en œuvre d'une politique interdisant l'accès humain aux données de production, aux applications et à l'infrastructure. Tous les déploiements doivent être effectués par le biais de pipelines automatisés approuvés.

« La phase de production introduit des politiques strictes interdisant l'accès humain aux données de production, aux applications et à l'infrastructure. Tous les accès aux systèmes de production doivent être automatisés par le biais de pipelines de déploiement approuvés. » - AWS Prescriptive Guidance

Le maintien d'un isolement strict entre les environnements de développement, de préparation et de production constitue une autre étape cruciale. Cela empêche les modèles non validés de contaminer les systèmes de production. En outre, appliquez le nettoyage du registre des artefacts pour supprimer les versions non approuvées ou intermédiaires, en ne gardant que les versions validées prêtes pour le déploiement. En cas d'urgence, établissez des procédures « brise-vitre » nécessitant une approbation explicite et une journalisation complète afin de garantir la responsabilisation en cas de crise. Des points de contrôle réguliers pendant la formation permettent d'auditer l'évolution d'un modèle et permettent de revenir à un état sécurisé en cas de problème de sécurité.

Après avoir sécurisé vos pipelines de développement et de déploiement, la prochaine étape cruciale consiste à vous assurer que vos flux de travail d'IA sont conformes aux normes réglementaires et aux politiques internes. La conformité réglementaire devenant une préoccupation croissante pour de nombreux dirigeants, il est essentiel d'établir un cadre clair, non seulement pour éviter les risques juridiques, mais également pour conserver la confiance des clients. Ce cadre s'appuie naturellement sur les processus sécurisés évoqués précédemment.

L'environnement réglementaire pour la sécurité de l'IA évolue rapidement, obligeant les organisations américaines à surveiller plusieurs cadres simultanément. Une référence clé est le Cadre de gestion des risques liés à l'IA du NIST (AI RMF 1.0), qui fournit des conseils volontaires pour la gestion des risques pour les individus et la société. Publié en juillet 2024, il comprend un manuel complémentaire et un profil d'IA génératif (NIST-AI-600-1) pour relever des défis uniques tels que les hallucinations et les problèmes de confidentialité des données. En outre, le Directives conjointes CISA/NSA/FBI, publié en mai 2025, propose une feuille de route complète pour protéger le cycle de vie de l'IA, du développement à l'exploitation.

À l'échelle mondiale, NORME ISO/IEC 42001:2023 est devenue la première norme internationale de système de management pour l'IA. Inspiré de la norme ISO 27001, il fournit une structure familière aux équipes de conformité qui gèrent déjà des systèmes de sécurité de l'information. Cette norme couvre des domaines tels que la gouvernance des données, le développement de modèles et la surveillance opérationnelle, ce qui la rend particulièrement utile pour répondre aux préoccupations des comités des risques et des entreprises clientes. Pour les organisations opérant sur les marchés européens, la conformité à la Loi sur l'IA de l'UE (notamment l'article 15 sur la précision et la robustesse), DORA pour les services financiers, et NIS2 pour les prestataires de services essentiels est également crucial.

« La norme ISO 42001 est un cadre structuré qui gère la sécurité, la gouvernance et la gestion des risques liés à l'IA. Il est essentiel pour les organisations qui cherchent à déployer des outils et des systèmes d'IA de manière responsable. » - BD Emerson

L'un des principaux avantages de l'adoption d'un cadre unifié tel que la norme ISO/IEC 42001 est sa capacité à s'aligner simultanément sur plusieurs réglementations, ce qui réduit les efforts de conformité redondants et améliore l'efficacité opérationnelle. Mise en place d'un Comité d'éthique de l'IA - composé de cadres, d'experts juridiques et de praticiens de l'IA - assure la supervision nécessaire pour évaluer les projets à haut risque et garantir l'alignement sur ces cadres. L'intégration de ces normes dans votre flux de travail renforce à la fois la sécurité et l'évolutivité, en complément des mesures précédentes.

Des pistes d'audit détaillées sont indispensables à la conformité réglementaire et à la réponse aux incidents. Vos journaux doivent capturer tous les aspects des interactions avec l'IA, y compris la version du modèle utilisée, l'invite spécifique soumise, la réponse générée et les métadonnées utilisateur pertinentes. Cette visibilité de bout en bout est essentielle pour répondre aux demandes réglementaires ou enquêter sur des incidents.

Pour préserver l'intégrité de ces enregistrements, utilisez WORM (écrire une fois, lire plusieurs fois) stockage pour sécuriser les sorties de journalisation et les données de session. Les pistes d'audit devraient également documenter le lignage des données, c'est-à-dire suivre l'origine, les transformations et les licences des ensembles de données, ainsi que les paramètres et les hyperparamètres des modèles. Ce niveau de transparence répond aux exigences réglementaires, telles que la réponse aux demandes de « droit à l'effacement » en vertu des lois sur la protection des données.

Les examens réguliers des politiques sont tout aussi importants. Effectuez ces examens au moins une fois par an ou chaque fois que des modifications réglementaires importantes surviennent, telles que des mises à jour de la Loi sur l'IA de l'UE ou NIS2. Exécuter Évaluations de l'impact des systèmes d'IA (AISIA) périodiquement ou après des changements majeurs pour évaluer les effets sur la confidentialité, la sécurité et l'équité. Ces évaluations doivent être examinées avec votre comité d'éthique multidisciplinaire en matière d'IA afin de garantir la responsabilisation. Ensemble, une journalisation robuste et des examens réguliers constituent une base solide pour la gouvernance et la gestion des incidents.

Les flux de travail d'IA exigent des plans de réponse aux incidents spécialisés qui répondent aux menaces propres aux systèmes d'IA. Il s'agit notamment de risques tels que l'empoisonnement des modèles, l'injection rapide, les attaques contradictoires et les effets nocifs causés par des hallucinations. De tels scénarios nécessitent des stratégies de détection et de correction personnalisées, distinctes de celles utilisées dans les incidents de cybersécurité traditionnels.

Développez des manuels spécifiques à l'IA qui décrivent clairement les voies d'escalade et les responsabilités. Par exemple, si un modèle génère des résultats biaisés, le manuel doit spécifier qui étudie les données de formation, qui communique avec les parties prenantes et quelles conditions justifient l'annulation du modèle. Incluez des procédures pour traiter les demandes des personnes concernées, par exemple pour vérifier si les données d'une personne ont été utilisées dans le cadre d'une formation modèle lorsqu'elle exerce son « droit à l'oubli ».

Il est essentiel de tester ces plans. Réalisez des exercices sur table avec des équipes interfonctionnelles pour simuler des scénarios réalistes d'incidents liés à l'IA. Ces exercices permettent d'identifier les lacunes procédurales et d'améliorer la coordination des équipes avant qu'une véritable crise ne survienne. En outre, configurez les modèles d'IA pour qu'ils ne passent pas à un état « fermé » ou sécurisé afin d'éviter toute exposition accidentelle des données lors de défaillances du système. En intégrant des playbooks spécifiques à l'IA aux protocoles d'automatisation existants, vous pouvez maintenir la continuité opérationnelle tout en améliorant votre architecture de sécurité globale.

Pour les équipes dont les ressources sont limitées, la sécurisation des flux de travail basés sur l'IA peut sembler une tâche ardue. Cependant, en adoptant une approche progressive et automatisée, vous pouvez créer un cadre de sécurité robuste au fil du temps. Au lieu d'essayer de mettre en œuvre chaque mesure en même temps, concentrez-vous d'abord sur les contrôles à fort impact, utilisez l'automatisation pour alléger la charge de travail et introduisez progressivement des techniques plus avancées au fur et à mesure que vos capacités se développent.

La première étape consiste à corriger les vulnérabilités les plus critiques. Commencez par la découverte et l'inventaire des actifs. Les modèles d'IA, les ensembles de données et les points de terminaison non suivis peuvent créer des points faibles que les attaquants pourraient exploiter. Des outils tels qu'Azure Resource Graph Explorer peuvent aider à identifier et à cataloguer efficacement toutes les ressources d'IA.

Ensuite, implémentez la gestion des identités et des accès (IAM) selon le principe du moindre privilège. En utilisant des identités gérées et en appliquant une gouvernance stricte des données, telle que la classification des ensembles de données sensibles, vous pouvez obtenir une protection efficace sans coûts importants.

Une autre étape essentielle consiste à sécuriser les entrées et les sorties. Déployez des mesures telles que le filtrage rapide et la désinfection des sorties pour bloquer les attaques par injection et empêcher les fuites de données. La surveillance centralisée est également essentielle : utilisez la détection des anomalies en temps réel et une journalisation complète pour suivre les interactions de l'IA, y compris les invites, les réponses et les métadonnées des utilisateurs.

« Sécuriser l'IA, c'est rétablir la clarté dans des environnements où la responsabilité peut rapidement s'estomper. Il s'agit de savoir où l'IA existe, comment elle se comporte, ce qu'elle est autorisée à faire et comment ses décisions affectent l'ensemble de l'entreprise. » - Brittany Woodsmall et Simon Fellows, Darktrace

Une fois ces contrôles fondamentaux en place, l'automatisation change la donne pour les équipes dont la bande passante est limitée.

L'automatisation est un puissant allié pour les équipes aux ressources limitées, car elle réduit l'effort manuel requis pour maintenir les mesures de sécurité. Les outils de gestion de la posture de sécurité de l'IA (AI-SPM) peuvent automatiquement cartographier les pipelines et les modèles d'IA, identifier les chemins d'exploitation vérifiés et réduire le bruit des alertes jusqu'à 88 %. Cela est particulièrement utile pour les petites équipes qui ne peuvent pas passer au crible manuellement des milliers d'alertes.

Les plateformes de gouvernance, de gestion des risques et de conformité (GRC) offrent une autre couche d'efficacité. Ces outils centralisent la journalisation, la gestion des risques et la supervision des politiques. De nombreuses plateformes GRC incluent des modèles prédéfinis pour des frameworks tels que NIST AI RMF ou ISO 42001, ce qui vous évite d'avoir à créer des politiques à partir de zéro. Les alertes automatisées peuvent également informer les administrateurs des actions risquées, telles qu'une reconversion imprévue du modèle ou des exportations de données inhabituelles.

L'intégration de l'analyse automatique des vulnérabilités dans les pipelines CI/CD permet de détecter les erreurs de configuration avant qu'elles ne soient mises en production. Les signatures numériques sur les ensembles de données et les versions des modèles garantissent en outre une chaîne de contrôle inviolable, éliminant ainsi le besoin de vérification manuelle. Étant donné que le coût moyen d'une violation de données est de 4,45 millions de dollars, ces outils automatisés apportent une valeur significative aux petites équipes.

Une fois les tâches de base automatisées, vous pouvez progressivement apporter des améliorations de sécurité plus sophistiquées.

Après avoir établi une base solide, il est temps de mettre en place des mesures de sécurité avancées. Commencez par des tests contradictoires, tels que des exercices d'équipe rouge, pour découvrir les faiblesses potentielles de vos modèles d'IA. Au fil du temps, vous pouvez adopter des technologies améliorant la confidentialité (PET), telles que la confidentialité différentielle, pour protéger les ensembles de données sensibles.

« Les petites équipes devraient commencer par des contrôles fondamentaux tels que la gouvernance des données, la gestion des versions des modèles et les contrôles d'accès avant de passer à des techniques avancées. » - SentinelOne

Les outils d'application des politiques pilotés par l'IA constituent une autre avancée. Ces outils peuvent signaler automatiquement des politiques d'accès mal configurées, des chemins de données non chiffrés ou des outils d'IA non autorisés, souvent appelés « IA fantôme ». À mesure que vos flux de travail évoluent, envisagez de mettre en œuvre la gestion des identités non humaines (NHI). Cela implique de traiter les agents d'IA autonomes comme des travailleurs numériques, dotés de comptes de service uniques et d'informations d'identification régulièrement renouvelées.

La création d'un flux de travail d'IA sécurisé exige une supervision continue, de la transparence et une stratégie de défense à plusieurs niveaux. Commencez par établir des politiques claires et attribuez des responsabilités, puis concentrez-vous sur l'obtention d'une vue d'ensemble de vos actifs. Renforcez vos défenses grâce à des mesures techniques telles que le chiffrement, les contrôles d'accès et les systèmes de détection des menaces. Aborder ces priorités par étapes permet de s'attaquer efficacement aux vulnérabilités les plus pressantes.

L'urgence de ces mesures est soulignée par les données : 80 % des dirigeants sont préoccupés par les fuites de données, tandis que 88 % craignent une injection rapide. En outre, plus de 500 organisations ont été victimes d'attaques du rançongiciel Medusa en janvier 2026.

Pour agir de manière décisive, priorisez les mesures à fort impact qui donnent des résultats immédiats. Commencez par des éléments essentiels tels que la découverte des actifs, des contrôles d'accès stricts et la désinfection des entrées et des sorties. Ces mesures fondamentales offrent une protection solide sans nécessiter de ressources importantes. Ensuite, réduisez les efforts manuels en adoptant des outils d'automatisation tels que les systèmes de gestion de la posture de sécurité de l'IA et les plateformes GRC afin de maintenir une surveillance et une gouvernance cohérentes. À mesure que votre infrastructure de sécurité évolue, intégrez des pratiques avancées telles que les tests contradictoires, l'informatique confidentielle pour les GPU et l'attribution d'identités uniques aux agents d'IA. Ensemble, ces étapes permettent de créer un environnement d'IA robuste et évolutif.

« La sécurité est un effort collectif qu'il est préférable d'atteindre grâce à la collaboration et à la transparence. » - OpenAI

La sécurisation des flux de travail des modèles d'IA nécessite une stratégie complète pour protéger les données, le code et les modèles à chaque étape de leur cycle de vie. Pour commencer, donnez la priorité aux pratiques de sécurisation des données : chiffrez les ensembles de données à la fois lorsqu'ils sont stockés et pendant leur transmission, appliquez des contrôles d'accès stricts et contrôlez soigneusement toutes les données tierces ou open source avant de les intégrer à vos flux de travail.

Pendant le développement, évitez d'intégrer des informations sensibles telles que des mots de passe directement dans votre code. Utilisez plutôt des outils sécurisés de gestion des secrets et effectuez régulièrement des révisions de code pour identifier les vulnérabilités ou les dépendances risquées.

Lorsqu'il s'agit de former ou de peaufiner des modèles, adoptez principes de confiance zéro en isolant les ressources informatiques et en restant vigilant face aux risques tels que l'empoisonnement des données ou les entrées contradictoires. Une fois votre modèle terminé, stockez-le dans des référentiels sécurisés, chiffrez son poids pour empêcher tout accès non autorisé et vérifiez régulièrement son intégrité.

Pour les points de terminaison d'inférence, implémentez les exigences d'authentification, définissez des limites d'utilisation pour éviter les abus et validez les entrées entrantes pour bloquer les attaques potentielles. Une vigilance continue est essentielle : surveillez en permanence les activités d'inférence, tenez à jour des journaux détaillés et soyez prêt à élaborer des plans de réponse pour faire face à des menaces telles que le vol de modèles ou des problèmes de performances inattendus. En suivant ces étapes, vous pouvez établir une défense robuste pour vos flux de travail d'IA.

Les petites équipes peuvent commencer par élaborer des politiques de sécurité simples qui couvrent chaque étape du cycle de vie de l'IA, de la collecte des données à leur élimination finale. Adopter un approche Zero Trust est crucial : mettre en œuvre des protocoles d'authentification, appliquer l'accès au moindre privilège et s'appuyer sur des contrôles d'accès basés sur les rôles à l'aide d'outils cloud intégrés pour réduire les dépenses. Des mesures simples, telles que la signature de commits Git, peuvent créer une piste d'audit immuable, tandis que la réalisation d'évaluations trimestrielles légères des risques permet aux équipes de détecter les vulnérabilités à un stade précoce.

Tirez parti d'outils gratuits ou open source pour rationaliser les efforts de sécurité. Utilisez la validation et la désinfection des entrées pour repousser les attaques adverses, sécurisez les API à l'aide d'une authentification basée sur des jetons et d'une limitation de débit, et configurez des pipelines automatisés pour détecter des problèmes tels que l'empoisonnement des données ou la dérive des performances. Le filigrane de modèles légers peut protéger la propriété intellectuelle, et un cadre solide de gouvernance des données garantit que les ensembles de données sont correctement balisés, chiffrés et suivis. Ces mesures pratiques jettent les bases d'une sécurité renforcée sans avoir besoin de ressources financières importantes.

Pour garantir la sécurité des données dans les flux de travail d'IA, commencez par approche sécurisée dès la conception, en mettant l'accent sur la sauvegarde des informations à chaque étape, de la collecte initiale au déploiement final. Utiliser chiffrement pour protéger les données à la fois au repos (par exemple, AES-256) et pendant la transmission (par exemple, TLS 1.2 ou supérieur). Mettre en œuvre contrôles d'accès stricts guidé par le principe du moindre privilège, de sorte que seuls les utilisateurs et systèmes autorisés peuvent interagir avec des données sensibles. Les politiques d'accès basées sur les rôles ou les attributs peuvent être particulièrement efficaces pour maintenir ces restrictions.

Sécurisez les pipelines de données en isolant les réseaux, en validant les entrées et en enregistrant tous les mouvements de données afin de détecter rapidement les activités inhabituelles. Effet de levier outils de lignage de données pour retracer l'origine et l'utilisation des ensembles de données, contribuant ainsi à la conformité aux réglementations telles que le RGPD et le CCPA. L'analyse régulière des informations sensibles, telles que les informations personnelles identifiables (PII), et l'application de techniques telles que la rédaction ou la tokenisation peuvent réduire davantage les risques. La surveillance en temps réel associée à des alertes de sécurité automatisées permet d'identifier et de répondre rapidement aux menaces potentielles.

Incorporer automatisation pilotée par des politiques dans vos flux de travail afin de rationaliser les mesures de sécurité. Cela inclut le provisionnement d'un stockage chiffré, l'application de la segmentation du réseau et l'intégration de contrôles de conformité directement dans les processus de déploiement. Complétez ces défenses techniques par des politiques organisationnelles, telles que la formation des équipes aux pratiques de sécurisation des données, la définition de calendriers de conservation clairs et l'élaboration de plans de réponse aux incidents adaptés aux risques liés à l'IA. Ensemble, ces mesures fournissent une protection complète tout au long du cycle de vie de l'IA.