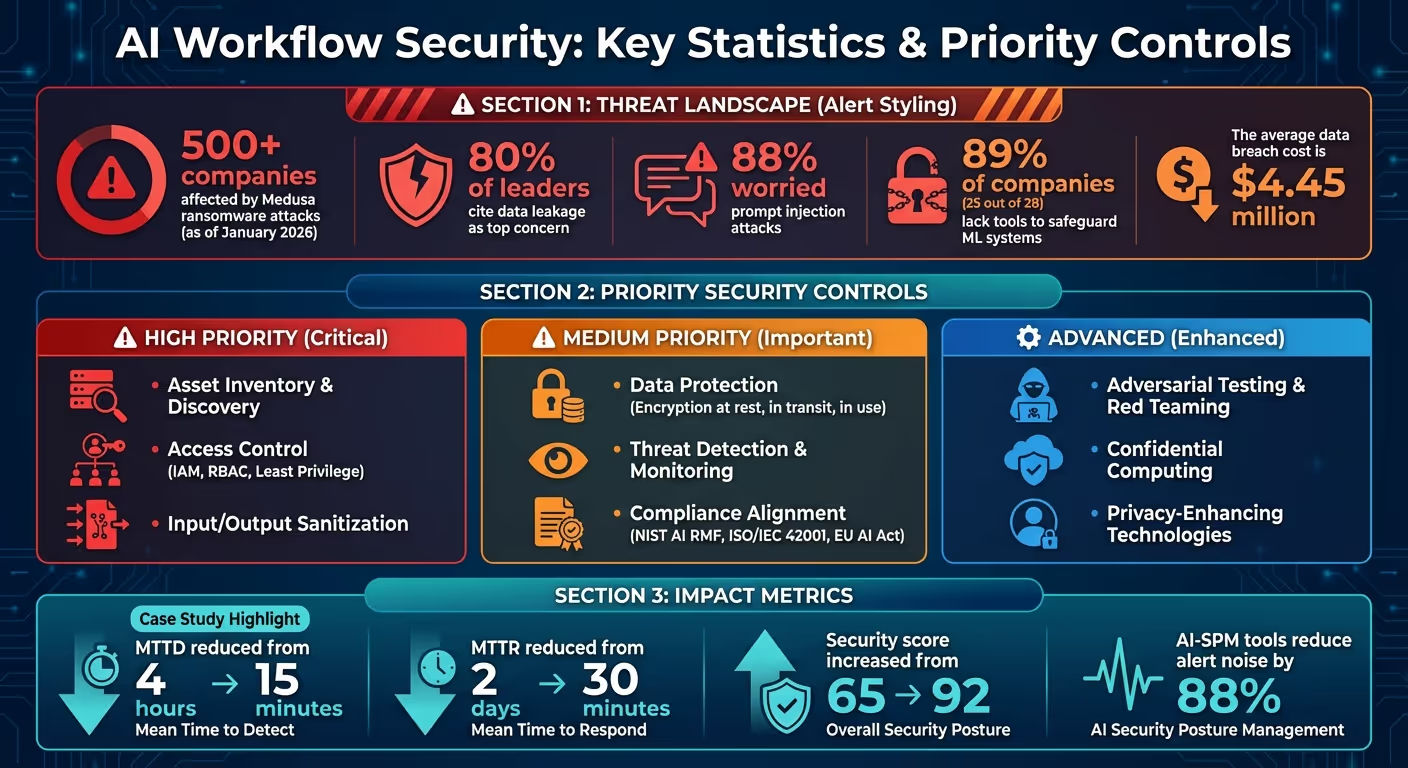

AI वर्कफ़्लो अद्वितीय जोखिमों के साथ आते हैं - डेटा लीक, पहचान का दुरुपयोग, और आपूर्ति श्रृंखला की कमजोरियाँ बस शुरुआत हैं। जनवरी 2026 तक, खत्म हो गया 500 कंपनियां पहले ही सामना कर चुके हैं मेडुसा रैंसमवेयर हमले, मजबूत सुरक्षा की तत्काल आवश्यकता को उजागर करते हैं। साथ में 80% नेता डेटा रिसाव को उनकी शीर्ष चिंता के रूप में उद्धृत करते हुए और 88% शीघ्र इंजेक्शन हमलों के बारे में चिंतित, अपने AI सिस्टम को सुरक्षित करना अब वैकल्पिक नहीं है - यह आवश्यक है।

इन रणनीतियों पर ध्यान केंद्रित करके, आप कमजोरियों को कम कर सकते हैं, अनुपालन सुनिश्चित कर सकते हैं और अपने AI सिस्टम में विश्वास बना सकते हैं। एन्क्रिप्शन और एक्सेस प्रबंधन जैसे उच्च-प्रभाव वाले नियंत्रणों से शुरुआत करें, फिर स्वचालित टूल और उन्नत तकनीकों के साथ स्केल करें।

AI वर्कफ़्लो सुरक्षा सांख्यिकी और प्राथमिकता नियंत्रण 2026

AI वर्कफ़्लो को सुरक्षित करना उतना सरल नहीं है जितना कि पारंपरिक सॉफ़्टवेयर सिस्टम की सुरक्षा करना। AI एप्लिकेशन, डेटा प्रोसेसर और निर्णय लेने वालों के रूप में काम करता है, जिसका अर्थ है कि जोखिमों के प्रबंधन की ज़िम्मेदारी एक ही सुरक्षा समूह के साथ आराम करने के बजाय कई टीमों में फैली हुई है। इस जटिलता को दूर करने के लिए, संगठनों को तीन प्रमुख सिद्धांतों पर ध्यान देना चाहिए: गवर्नेंस-फर्स्ट फ्रेमवर्क, क्रॉस-फ़ंक्शनल सहयोग, और लचीली सुरक्षा पद्धतियां जो मॉडल के विकसित होने के साथ अनुकूलित हो सकती हैं। आइए इन सिद्धांतों और सुरक्षित AI वर्कफ़्लो बनाने में उनकी भूमिका के बारे में बताते हैं।

शासन एआई सुरक्षा की रीढ़ है, जो यह निर्धारित करता है कि सिस्टम तक किसके पास पहुंच है, वे उन्हें कब एक्सेस कर सकते हैं, और समस्याएं आने पर क्या कार्रवाई करनी है। जीवन चक्र-आधारित सुरक्षा ढांचे में AI वर्कफ़्लो के हर चरण को शामिल किया जाना चाहिए, जिसमें डेटा सोर्सिंग और मॉडल प्रशिक्षण से लेकर परिनियोजन और रीयल-टाइम ऑपरेशन शामिल हैं। स्पष्ट भूमिकाएँ सौंपना - जैसे कि लेखक, अनुमोदनकर्ता, और प्रकाशक - जिम्मेदारियों को परिभाषित करने और जवाबदेही सुनिश्चित करने में मदद करता है।

इस ढांचे का एक महत्वपूर्ण तत्व है वंशावली और उत्पत्ति ट्रैकिंग। वंशावली डेटासेट, ट्रांसफ़ॉर्मेशन और मॉडल के लिए मेटाडेटा कैप्चर करती है, जबकि प्रोवेंस इंफ्रास्ट्रक्चर विवरण और क्रिप्टोग्राफ़िक हस्ताक्षर लॉग करता है। यदि किसी प्रशिक्षण वातावरण से समझौता किया जाता है, तो इन रिकॉर्ड से प्रभावित मॉडल की तुरंत पहचान करना और सुरक्षित संस्करणों पर वापस लौटना संभव हो जाता है।

“वंशावली और उत्पत्ति डेटा प्रबंधन और मॉडल अखंडता में योगदान करते हैं, और एआई मॉडल गवर्नेंस की नींव बनाते हैं।”

- गूगल सैफ 2.0

जोखिमों को और कम करने के लिए, मॉडल, डेटा स्टोर, एंडपॉइंट और वर्कफ़्लो सहित सभी घटकों में कम से कम विशेषाधिकार के सिद्धांत को लागू करें। उल्लंघन की स्थिति में जोखिम को कम करने के लिए प्रशिक्षण डेटासेट से संवेदनशील जानकारी, जैसे क्रेडिट कार्ड नंबर, को हटा दिया जाना चाहिए। डेटा संवेदनशीलता को वर्गीकृत करने और भूमिका-आधारित अभिगम नियंत्रण (RBAC) को लागू करने के लिए टूल का उपयोग करें, यह सुनिश्चित करते हुए कि AI सिस्टम केवल अपने कार्यों के लिए आवश्यक डेटा तक पहुँचें।

एक बार शासन लागू हो जाने के बाद, अगला कदम एआई-विशिष्ट जोखिमों को दूर करने के लिए टीमों के बीच सहयोग को बढ़ावा देना है।

AI सुरक्षा चुनौतियां पारंपरिक सीमाओं से परे हैं, क्योंकि एकल इंटरैक्शन में पहचान का दुरुपयोग, डेटा लीक और आपूर्ति श्रृंखला की कमजोरियां शामिल हो सकती हैं। यह विभिन्न टीमों के बीच सहयोग को आवश्यक बनाता है। सिक्योरिटी ऑपरेशंस (SECOPS), DevOps/MLOPS, गवर्नेंस, रिस्क एंड कंप्लायंस (GRC) टीमें, डेटा साइंटिस्ट और बिजनेस लीडर सभी महत्वपूर्ण भूमिका निभाते हैं।

जवाबदेही बढ़ाने के लिए, तैनाती को मंजूरी देने और नैतिक मानकों के पालन की निगरानी करने के लिए मानव-इन-द-लूप नामित करें। सुव्यवस्थित निगरानी के लिए अपने सुरक्षा संचालन केंद्र के भीतर AI से संबंधित अलर्ट - जैसे कि विलंबता समस्याएं या अनधिकृत पहुँच प्रयास - को केंद्रीकृत करें। इसके अतिरिक्त, AI इंटरफेस के माध्यम से डेटा विषाक्तता, जेलब्रेक के प्रयास, और क्रेडेंशियल चोरी जैसे AI-विशिष्ट खतरों पर सुरक्षा और विकास टीमों के लिए विशेष प्रशिक्षण प्रदान करें।

जबकि सहयोग नीति को मजबूत करता है, चुस्त सुरक्षा पद्धतियां यह सुनिश्चित करती हैं कि एआई सिस्टम के विकसित होने पर ये उपाय प्रभावी बने रहें।

AI मॉडल गतिशील होते हैं, जो अक्सर समय के साथ अपना व्यवहार बदलते हैं। इससे स्थैतिक सुरक्षा उपाय अपर्याप्त हो जाते हैं। चुस्त सुरक्षा पद्धतियां तेजी से फीडबैक लूप पेश करती हैं जो जोखिम शमन और घटना प्रतिक्रिया को एआई विकास की पुनरावृत्त प्रकृति के साथ संरेखित करती हैं। AI/ML Ops में सुरक्षा एम्बेड करके, टीमें मशीन लर्निंग, DevOps और डेटा इंजीनियरिंग की सर्वोत्तम प्रथाओं से आकर्षित हो सकती हैं।

“तेज़ फ़ीडबैक लूप के लिए नियंत्रण अनुकूलित करें। क्योंकि यह शमन और घटना की प्रतिक्रिया के लिए महत्वपूर्ण है, इसलिए अपनी संपत्ति और पाइपलाइन रन को ट्रैक करें.”

- गूगल क्लाउड

CI/CD पाइपलाइनों के भीतर सुरक्षा जांच को स्वचालित करना एक महत्वपूर्ण कदम है। जैसे टूल जेनकींस, गिटलैब सीआई, या वर्टेक्स एआई पाइपलाइन मॉडल को मान्य करने और तैनाती से पहले कमजोरियों की पहचान करने में मदद कर सकता है। नियमित एडवर्सरियल सिमुलेशन - जैसे कि रेड-टीमिंग जनरेटिव और नॉन-जेनरेटिव मॉडल - प्रॉम्प्ट इंजेक्शन या मॉडल इनवर्जन जैसी समस्याओं को उजागर कर सकते हैं जिन्हें स्थिर समीक्षाएं अनदेखा कर सकती हैं। वास्तविक समय में एजेंट गतिविधि की निगरानी के लिए केंद्रीकृत AI गेटवे को तैनात किया जाना चाहिए। अंत में, उभरते खतरों से आगे रहने के लिए आवर्ती जोखिम आकलन करें और यह सुनिश्चित करें कि आपके सुरक्षा उपाय प्रभावी रहें।

डेटा मशीन लर्निंग सिस्टम में एक महत्वपूर्ण भेद्यता का प्रतिनिधित्व करता है। एक बार उल्लंघन या खराब डेटासेट के कारण ज़हरीले मॉडल हो सकते हैं, संवेदनशील जानकारी लीक हो सकती है या प्रशिक्षण चक्र बाधित हो सकता है। माइक्रोसॉफ्ट के मुताबिक, डेटा पॉइजनिंग आज मशीन लर्निंग में सबसे गंभीर सुरक्षा जोखिम है मानकीकृत पहचान विधियों की अनुपस्थिति और असत्यापित सार्वजनिक डेटासेट पर व्यापक निर्भरता के कारण। अपनी डेटा लेयर को सुरक्षित रखने के लिए, तीन मुख्य रणनीतियों को लागू करना आवश्यक है: हर चरण में एन्क्रिप्शन, सटीक उत्पत्ति ट्रैकिंग, और फोर्टिफाइड ट्रेनिंग पाइपलाइन। साथ में, ये उपाय संभावित खतरों से मज़बूत बचाव प्रदान करते हैं।

सभी राज्यों में डेटा की सुरक्षा के लिए एन्क्रिप्शन आवश्यक है - आराम से, ट्रांज़िट में और उपयोग के दौरान। आराम से डेटा के लिए, जैसे प्लेटफ़ॉर्म के माध्यम से ग्राहक-प्रबंधित एन्क्रिप्शन कुंजी (CMEK) का उपयोग करें क्लाउड केएमएस या एडब्ल्यूएस किलोमीटर बाल्टी, डेटाबेस और मॉडल रजिस्ट्रियों में भंडारण पर नियंत्रण बनाए रखने के लिए। ट्रांज़िट में डेटा के लिए, TLS 1.2 को न्यूनतम मानक के रूप में लागू करें, जिसमें TLS 1.3 को उच्चतम स्तर की सुरक्षा के लिए अनुशंसित किया गया है। AI/ML सेवाओं पर API कॉल के लिए हमेशा HTTPS का उपयोग करें, और डेटा ट्रांसफ़र को सुरक्षित करने के लिए HTTPS लोड बैलेंसर तैनात करें।

संवेदनशील वर्कलोड के लिए, गोपनीय कंप्यूटिंग या शील्डेड वीएम को तैनात करने पर विचार करें, जो सक्रिय प्रोसेसिंग के दौरान भी डेटा की सुरक्षा के लिए हार्डवेयर-आधारित अलगाव प्रदान करते हैं। यह सुनिश्चित करता है कि प्रशिक्षण डेटा सुरक्षित रहे, यहां तक कि क्लाउड प्रदाताओं से भी। इसके अतिरिक्त, पैकेज और कंटेनर पर डिजिटल रूप से हस्ताक्षर करें, और यह सुनिश्चित करने के लिए कि केवल सत्यापित छवियां ही तैनात की गई हैं, बाइनरी प्राधिकरण का उपयोग करें।

सेवा नियंत्रण नीतियां या IAM स्थिति कुंजियां (उदाहरण के लिए, सेज मेकर: वॉल्यूम केएमएस कुंजी) एन्क्रिप्शन सक्षम किए बिना नोटबुक या प्रशिक्षण नौकरियों के निर्माण को रोककर एन्क्रिप्शन को लागू कर सकता है। वितरित प्रशिक्षण के लिए, नोड्स के बीच स्थानांतरित होने वाले डेटा को सुरक्षित रखने के लिए इंटर-कंटेनर ट्रैफ़िक एन्क्रिप्शन सक्षम करें। जोखिमों को और कम करने के लिए, VPC सेवा परिधि और निजी सेवा कनेक्ट का उपयोग करें, यह सुनिश्चित करते हुए कि AI/ML ट्रैफ़िक सार्वजनिक इंटरनेट से दूर रहे और संभावित हमलों के जोखिम को कम किया जाए।

छेड़छाड़ का पता लगाने और सटीकता की पुष्टि करने के लिए डेटा की उत्पत्ति और अखंडता को ट्रैक करना महत्वपूर्ण है। क्रिप्टोग्राफ़िक हैशिंग, जैसे कि SHA-256, हर चरण में डेटासेट के लिए अद्वितीय डिजिटल फ़िंगरप्रिंट बनाता है। डेटा में कोई भी अनधिकृत परिवर्तन हैश वैल्यू को बदल देगा, जो तुरंत संभावित भ्रष्टाचार या हस्तक्षेप का संकेत देगा।

“आज मशीन लर्निंग में सबसे बड़ा सुरक्षा खतरा डेटा पॉइजनिंग है, क्योंकि इस क्षेत्र में मानक पहचान और शमन की कमी है, साथ ही प्रशिक्षण डेटा के स्रोतों के रूप में अविश्वास/अनसुलझे सार्वजनिक डेटासेट पर निर्भरता भी है।”

- माइक्रोसॉफ्ट

स्वचालित ETL/ELT लॉगिंग हर चरण में मेटाडेटा कैप्चर कर सकती है। डेटा कैटलॉग और स्वचालित मेटाडेटा प्रबंधन टूल से लैस सिस्टम डेटा उत्पत्ति और परिवर्तनों का विस्तृत रिकॉर्ड बनाते हैं, जो अनुपालन और सुरक्षा के लिए ऑडिटेबल ट्रेल प्रदान करते हैं। महत्वपूर्ण डेटासेट के लिए, प्रदर्शन और संग्रहण दक्षता को संतुलित करने के लिए कम महत्वपूर्ण परिवर्तनों के लिए एकत्रित मेटाडेटा का उपयोग करते समय विस्तृत प्रोवेंस ट्रैकिंग बनाए रखें।

फ्रेमवर्क जैसे साल्सा (सॉफ़्टवेयर कलाकृतियों के लिए आपूर्ति-श्रृंखला स्तर) और उपकरण जैसे सिगस्टोर सभी कलाकृतियों के लिए सत्यापन योग्य उत्पत्ति प्रदान करके AI सॉफ़्टवेयर आपूर्ति श्रृंखला को सुरक्षित कर सकता है। इसके अतिरिक्त, विसंगति का पता लगाने वाली प्रणालियां दैनिक डेटा वितरण की निगरानी कर सकती हैं और टीमों को डेटा गुणवत्ता के प्रशिक्षण में गड़बड़ी या बहाव के प्रति सचेत कर सकती हैं। जोखिमों को और कम करने के लिए, संस्करण नियंत्रण बनाए रखें, जिससे आप पिछले मॉडल संस्करणों पर वापस जा सकते हैं और फिर से प्रशिक्षण के लिए प्रतिकूल सामग्री को अलग कर सकते हैं।

प्रशिक्षण पाइपलाइनों के लिए सख्त संस्करण नियंत्रण और ऑडिटेबिलिटी की आवश्यकता होती है, जिसे जैसे उपकरणों का उपयोग करके प्राप्त किया जा सकता है एमएलफ्लो या डीवीसी। डेटा पॉइजनिंग का संकेत देने वाले किसी भी बदलाव, तिरछी या बहाव को चिह्नित करने के लिए सेंसर को प्रतिदिन डेटा वितरण की निगरानी करनी चाहिए। उपयोग करने से पहले सभी प्रशिक्षण डेटा को सत्यापित और सैनिटाइज़ किया जाना चाहिए।

रिजेक्ट-ऑन-नेगेटिव-इम्पैक्ट (RONI) जैसे एडवांस डिफेंस मॉडल के प्रदर्शन को खराब करने वाले प्रशिक्षण नमूनों की पहचान कर सकते हैं और उन्हें हटा सकते हैं। प्रशिक्षण कार्यभार को वर्चुअल प्राइवेट क्लाउड (VPC), निजी IP और सेवा परिधि का उपयोग करके अलग-अलग वातावरण में संचालित किया जाना चाहिए ताकि उन्हें सार्वजनिक इंटरनेट ट्रैफ़िक से दूर रखा जा सके। MLOPS पाइपलाइनों को कम-से-कम विशेषाधिकार सेवा खाते असाइन करें, जिससे विशिष्ट स्टोरेज बकेट और रजिस्ट्रियों तक उनकी पहुंच सीमित हो जाए।

संवेदनशील डेटासेट के लिए, डिफरेंशियल प्राइवेसी या डेटा एनोनिमाइज़ेशन तकनीकों का उपयोग करें। फ़ीचर स्क्वीज़िंग, जो एक ही नमूने में कई फ़ीचर वैक्टर को समेकित करता है, प्रतिकूल हमलों के लिए खोज स्थान को कम कर सकता है। ऑडिट और रोलबैक को सक्षम करने के लिए नियमित रूप से मॉडल स्टेट्स को चेकपॉइंट के रूप में सहेजें, जिससे AI मॉडल जीवनचक्र के दौरान वर्कफ़्लो की अखंडता सुनिश्चित हो सके। ये उपाय सामूहिक रूप से प्रशिक्षण प्रक्रिया को सुरक्षित करते हैं, संभावित खतरों से बचाते हैं और AI सिस्टम की विश्वसनीयता सुनिश्चित करते हैं।

आपके डेटा और प्रशिक्षण पाइपलाइनों को सुरक्षित करने के बाद, अगले चरण में यह नियंत्रित करना शामिल है कि कौन - या क्या - आपके AI मॉडल के साथ इंटरैक्ट कर सकता है। संवेदनशील प्रणालियों की सुरक्षा के लिए रक्षा की यह परत महत्वपूर्ण है। प्रमाणीकरण पहचान की पुष्टि करता है, जबकि प्राधिकरण उन क्रियाओं को निर्धारित करता है जो पहचान कर सकती है। कई API उल्लंघन इसलिए नहीं होते हैं क्योंकि हमलावर प्रमाणीकरण को दरकिनार कर देते हैं, बल्कि कमज़ोर प्राधिकरण नियंत्रणों के कारण होते हैं, जो प्रमाणीकृत यूज़र को उन संसाधनों तक पहुँचने की अनुमति नहीं देते हैं जो उन्हें नहीं करना चाहिए. अपने AI मॉडल तक पहुंच को सीमित करने के लिए मजबूत प्रमाणीकरण और सटीक प्राधिकरण उपायों को लागू करके अपने बचाव को मजबूत करें।

स्टेटिक API कुंजियाँ पुरानी हैं और उन्हें PKCE (कोड एक्सचेंज के लिए प्रूफ कुंजी), म्यूचुअल TLS (MTL), और क्लाउड-नेटिव प्रबंधित पहचान के साथ OAuth 2.1 जैसे आधुनिक तरीकों से बदला जाना चाहिए। PKCE के साथ OAuth 2.1 पासवर्ड के बजाय अल्पकालिक टोकन का उपयोग करके क्रेडेंशियल एक्सपोज़र को कम करता है। दूसरी ओर, म्यूचुअल TLS, यह सुनिश्चित करता है कि क्लाइंट और सर्वर दोनों एक-दूसरे को डिजिटल प्रमाणपत्र के साथ प्रमाणित करें, साझा किए गए रहस्यों को हटा दें। क्लाउड-नेटिव प्रबंधित पहचान सेवाओं को कोड में क्रेडेंशियल्स एम्बेड किए बिना अन्य संसाधनों के साथ प्रमाणित करने की अनुमति देती हैं, जिससे आकस्मिक लीक का खतरा कम हो जाता है।

भूमिका-आधारित पहुंच के लिए, “डेटा साइंटिस्ट” या “मॉडल ऑडिटर” जैसी पूर्वनिर्धारित भूमिकाओं के आधार पर अनुमतियां असाइन करने के लिए RBAC (रोल-बेस्ड एक्सेस कंट्रोल) को लागू करें, यह सुनिश्चित करते हुए कि यूज़र के पास केवल उनकी ज़रूरत की चीज़ों तक पहुंच हो। अधिक गतिशील परिदृश्यों के लिए, ABAC (एट्रिब्यूट-आधारित एक्सेस कंट्रोल) उपयोगकर्ता विशेषताओं, अनुरोध संदर्भ (जैसे, समय या स्थान), और संसाधन संवेदनशीलता के आधार पर अनुमतियां दे सकता है। AI कार्यों के अनुरूप विशिष्ट भूमिकाएं - जैसे सैंडबॉक्स परीक्षण के लिए “मूल्यांकन भूमिका” या मालिकाना मॉडल के लिए “फाइन-ट्यून की गई एक्सेस भूमिका” - अति-विशेषाधिकार प्राप्त पहुंच के जोखिम को और कम करती हैं।

सेवा से इनकार करने वाले हमलों और API के दुरुपयोग से बचाने के लिए, दर सीमित करना आवश्यक है। टोकन बकेट एल्गोरिदम थ्रेसहोल्ड पार होने पर HTTP 429 “बहुत सारे अनुरोध” के साथ जवाब देते हुए स्थिर-स्थिति दरों और बर्स्ट सीमाओं को लागू कर सकते हैं। a को परिनियोजित करें वेब अनुप्रयोग फ़ायरवॉल (WAF) सामान्य HTTP-आधारित हमलों, जैसे कि SQL इंजेक्शन और क्रॉस-साइट स्क्रिप्टिंग को फ़िल्टर करने के लिए, इससे पहले कि वे आपके मॉडल एंडपॉइंट तक पहुँचें।

रोकथाम ब्रोकन ऑब्जेक्ट लेवल ऑथराइज़ेशन (BOLA), OWASP द्वारा शीर्ष API सुरक्षा जोखिम के रूप में रैंक किया गया है, इसके लिए अनुक्रमिक संख्याओं के बजाय UUID जैसे अपारदर्शी संसाधन पहचानकर्ताओं का उपयोग करने की आवश्यकता होती है। इससे हमलावरों के लिए अन्य यूज़र के डेटा का अनुमान लगाना और उस तक पहुंचना कठिन हो जाता है। इसके अतिरिक्त, शीघ्र इंजेक्शन हमलों से बचाव के लिए, AI मॉडल द्वारा जेनरेट किए गए सभी इनपुट सहित सर्वर-साइड सभी इनपुट को सैनिटाइज़ और वैलिडेट करें। समझौता किए गए क्रेडेंशियल्स के लिए अवसर की खिड़की को सीमित करने के लिए गुप्त प्रबंधकों के साथ API कुंजियों और प्रमाणपत्रों के रोटेशन को स्वचालित करें। निगरानी बनाए रखने के लिए, सावधानीपूर्वक वर्जनिंग का उपयोग करें और विसंगतियों के लिए एक्सेस लॉग की निगरानी करें।

यदि कोई मॉडल संस्करण कमजोरियों या बहाव को प्रदर्शित करता है, तो ऑडिट ट्रेल बनाने और रैपिड रोलबैक को सक्षम करने के लिए मॉडल कलाकृतियों के लिए संस्करण नियंत्रण आवश्यक है। जिस तरह एक्सेस नियंत्रण डेटा की सुरक्षा करते हैं, उसी तरह मॉडल संस्करणों की निगरानी करना परिचालन अखंडता को सुनिश्चित करता है। आर्टिफैक्ट स्टोरेज सॉल्यूशंस को पेयर करें, जैसे कि अमेज़ॅन S3, साथ में MFA हटाएँ यह सुनिश्चित करने के लिए कि केवल बहु-कारक प्रमाणीकृत उपयोगकर्ता मॉडल संस्करणों को स्थायी रूप से हटा सकते हैं। असामान्य गतिविधि का पता लगाने के लिए नियमित रूप से API और मॉडल लॉग की समीक्षा करें, जैसे कि अप्रत्याशित स्थानों से लॉगिन, बार-बार कॉल करना जो स्क्रैपिंग का संकेत दे सकती हैं, या अनधिकृत ऑब्जेक्ट आईडी तक पहुंचने का प्रयास।

“अनाथ तैनाती” से बचने के लिए अपनी AI इन्वेंट्री को सक्रिय रूप से प्रबंधित करें - अद्यतन सुरक्षा उपायों के बिना उत्पादन में उपलब्ध छोड़े गए मॉडल का परीक्षण या बहिष्कृत मॉडल। क्लाउड के लिए एज़्योर रिसोर्स ग्राफ़ एक्सप्लोरर या माइक्रोसॉफ्ट डिफेंडर जैसे टूल सभी सब्सक्रिप्शन के दौरान सभी AI संसाधनों में रीयल-टाइम दृश्यता प्रदान कर सकते हैं। उच्च सुरक्षा की आवश्यकता वाले वर्कफ़्लो के लिए, VPC एंडपॉइंट या AWS PrivateLink जैसी सेवाओं का उपयोग करके यह सुनिश्चित करने के लिए कि ट्रैफ़िक आंतरिक बना रहे, VPC एंडपॉइंट या AWS PrivateLink जैसी सेवाओं का उपयोग करके एक अलग वर्चुअल प्राइवेट क्लाउड (VPC) में मशीन लर्निंग घटकों को तैनात करें, जिसमें इंटरनेट एक्सेस नहीं है।

यहां तक कि मजबूत पहुंच नियंत्रण के साथ, एआई वर्कफ़्लो के भीतर अभी भी खतरे पैदा हो सकते हैं। इन प्रणालियों को पूरी तरह से सुरक्षित करने के लिए, निगरानी और तेजी से पता लगाना रक्षा की आवश्यक परतों के रूप में काम करता है। पहुंच और प्रमाणीकरण उपायों को लागू करके, सक्रिय निगरानी आंतरिक वर्कफ़्लो को मजबूत करती है, जिससे संभावित सुरक्षा घटनाओं की पहचान करने में मदद मिलती है, इससे पहले कि वे गंभीर उल्लंघनों में बदल जाएं। 28 कंपनियों के एक Microsoft सर्वेक्षण में पाया गया कि 89% (28 में से 25) के पास अपने मशीन लर्निंग सिस्टम की सुरक्षा के लिए आवश्यक उपकरणों की कमी थी। इस कमी के कारण वर्कफ़्लो को डेटा पॉइजनिंग, मॉडल एक्सट्रैक्शन और प्रतिकूल हेरफेर जैसे जोखिमों के संपर्क में लाया जाता है।

यह समझना कि आपके AI सिस्टम कैसे व्यवहार करते हैं, उन खतरों को उजागर करने के लिए महत्वपूर्ण है जिन्हें पारंपरिक सुरक्षा उपकरण अनदेखा कर सकते हैं। सांख्यिकीय बहाव का पता लगाना इनपुट वितरण और आउटपुट एन्ट्रॉपी में परिवर्तन को ट्रैक करता है, ऐसे उदाहरणों को फ़्लैग करता है जहां एक मॉडल अपने प्रशिक्षित मापदंडों के बाहर काम करता है। उदाहरण के लिए, एक निर्धारित सीमा के नीचे मॉडल के आत्मविश्वास में गिरावट आउट-ऑफ-डिस्ट्रीब्यूशन इनपुट की उपस्थिति का संकेत दे सकती है। इसी तरह, फीचर को निचोड़ना - मूल बनाम “निचोड़ा हुआ” इनपुट पर मॉडल की भविष्यवाणियों की तुलना करना - दोनों के बीच महत्वपूर्ण असहमति होने पर प्रतिकूल उदाहरण प्रकट कर सकता है।

मॉडल आउटपुट की निगरानी के अलावा, ऑपरेशनल मेट्रिक्स जैसे लेटेंसी स्पाइक्स, असामान्य API उपयोग, और अनियमित CPU/GPU संसाधन खपत, इनकार-ऑफ-सर्विस (DoS) प्रयासों या मॉडल निष्कर्षण प्रयासों जैसे हमलों का संकेत दे सकते हैं। सितंबर 2025 में एक उल्लेखनीय मामला सामने आया, जब FineryMarkets.com ने रनटाइम विसंगति का पता लगाने वाली AI- संचालित DevSecOps पाइपलाइन को लागू किया। इस नवाचार ने उनके मीन टाइम टू डिटेक्ट (MTTD) को 4 घंटे से घटाकर सिर्फ 15 मिनट और उनके मीन टाइम टू रेमेडिएट (MTTR) को 2 दिन से घटाकर 30 मिनट कर दिया, जिससे उनका सुरक्षा स्कोर 65 से 92 हो गया। इस तरह के परिणाम लगातार विसंगति का पता लगाने और भेद्यता आकलन के महत्व को उजागर करते हैं।

नियमित सुरक्षा मूल्यांकन से एआई-विशिष्ट जोखिमों को उजागर किया जा सकता है जो मानक उपकरण छूट सकते हैं, जैसे कि शीघ्र इंजेक्शन, मॉडल इनवर्जन और डेटा लीकेज। ये स्कैन मॉडल की अखंडता को मान्य करने, जैसे फ़ाइलों में एम्बेडेड बैकडोर या दुर्भावनापूर्ण पेलोड का पता लगाने में मदद करने के लिए महत्वपूर्ण हैं . पीटी या . पीकेएल इससे पहले कि उन्हें निष्पादित किया जाए। AI रेड टीमिंग AI मॉडल पर जेलब्रेकिंग प्रयासों सहित वास्तविक दुनिया के हमलों का अनुकरण करके इसे एक कदम आगे ले जाती है। पाइपलाइनों के माध्यम से इन प्रक्रियाओं को स्वचालित करना जिसमें हैश सत्यापन और स्थैतिक विश्लेषण शामिल है, तैनाती से पहले मॉडल की अखंडता सुनिश्चित करता है। इसके अतिरिक्त, वर्कफ़्लो को सुरक्षित करने के लिए हार्डकोडेड क्रेडेंशियल्स या एक्सपोज़्ड API कुंजियों के लिए नोटबुक और सोर्स कोड को स्कैन करना महत्वपूर्ण है।

संपूर्ण पाइपलाइन में गलत कॉन्फ़िगरेशन, उजागर क्रेडेंशियल्स और बुनियादी ढांचे की कमजोरियों की पहचान करने के लिए निरंतर निगरानी आवश्यक है। अपरिवर्तनीय लॉग को घटना की प्रतिक्रिया में सहायता करने और अनुपालन सुनिश्चित करने के लिए महत्वपूर्ण इंटरैक्शन को कैप्चर करना चाहिए। जैसे टूल सिक्योरिटी कमांड सेंटर या क्लाउड के लिए माइक्रोसॉफ्ट डिफेंडर जनरेटिव एआई परिनियोजन में जोखिमों का पता लगाने और उन्हें दूर करने को स्वचालित कर सकता है। डेटा प्रवाह और परिवर्तनों को ट्रैक करने से अनधिकृत पहुंच या डेटा पॉइजनिंग प्रयासों की पहचान करने में मदद मिल सकती है, जबकि CI/CD पाइपलाइन के भीतर डिपेंडेंसी स्कैनिंग को एम्बेड करने से यह सुनिश्चित होता है कि केवल सत्यापित कलाकृतियां ही उत्पादन में जगह बना सकें। अतिरिक्त सुरक्षा के लिए, स्वचालित शटडाउन तंत्र को तब सक्रिय करने के लिए कॉन्फ़िगर किया जा सकता है, जब ऑपरेशन पूर्वनिर्धारित सुरक्षा सीमाओं से अधिक हो जाते हैं, जो गंभीर खतरों से सुरक्षित रहते हैं।

जब आपके AI वर्कफ़्लो की अखंडता सुनिश्चित करने की बात आती है, तो सुरक्षा उपायों को विकास और परिनियोजन प्रक्रियाओं में एम्बेड करना गैर-परक्राम्य है। ये चरण अक्सर ऐसे होते हैं, जहां कमजोरियां सामने आती हैं, इसलिए बाद के विचार के रूप में उन्हें जोड़ने के बजाय, शुरुआत से ही अपनी पाइपलाइनों में सुरक्षा को डिज़ाइन करना आवश्यक है। मॉडल को एक्जीक्यूटेबल प्रोग्राम मानकर, आप डाउनस्ट्रीम ऑपरेशंस को प्रभावित करने वाले कमज़ोर बिल्ड के जोखिम को कम कर सकते हैं। यहां CI/CD पाइपलाइनों को सुरक्षित रखने और विकास और परिनियोजन के दौरान सुरक्षित प्रथाओं को अपनाने पर करीब से नज़र डाली गई है।

आपकी CI/CD पाइपलाइनों की सुरक्षा के लिए, प्रत्येक निर्माण एक अस्थायी, पृथक वातावरण में होना चाहिए। इसे एपेमेरल रनर इमेज का उपयोग करके प्राप्त किया जा सकता है, जो प्रत्येक बिल्ड के साथ इनिशियलाइज़, एक्जीक्यूट और टर्मिनेट करती हैं, जिससे समझौता किए गए बिल्ड से किसी भी लंबे जोखिम को रोका जा सकता है। विश्वास स्थापित करने के लिए, प्रत्येक आर्टिफ़ैक्ट के लिए क्रिप्टोग्राफ़िक रूप से हस्ताक्षरित सत्यापन जनरेट करें। इन प्रमाणपत्रों को आर्टिफैक्ट को उसके वर्कफ़्लो, रिपॉजिटरी, कमिट SHA और ट्रिगरिंग इवेंट से जोड़ना चाहिए। केवल इन नियंत्रणों के माध्यम से सत्यापित कलाकृतियों को ही तैनात किया जाना चाहिए। इन हस्ताक्षरों को टैम्पर-प्रूफ रसीदें समझें, यह सुनिश्चित करते हुए कि केवल सुरक्षित कलाकृतियां ही उत्पादन तक पहुंचें।

रहस्यों को प्रबंधित करना एक और महत्वपूर्ण कदम है। अपने सोर्स कोड या जुपिटर नोटबुक्स में हार्डकोडिंग क्रेडेंशियल्स से बचें। इसके बजाय, जैसे टूल का उपयोग करें हाशिकॉर्प वॉल्ट या एडब्ल्यूएस सीक्रेट मैनेजर पर्यावरण चर या OIDC टोकन के माध्यम से रहस्यों को इंजेक्ट करने के लिए। अतिरिक्त नेटवर्क सुरक्षा के लिए, बिल्ड के दौरान डेटा की निकासी को रोकने के लिए VPC सेवा नियंत्रण और निजी वर्कर पूल के साथ अपने विकास, मंचन और उत्पादन वातावरण को अलग करें।

एआई फ्रेमवर्क जैसे PyTorch, टेंसरफ़्लो, और जैक्स बिल्ड-टाइम और रन-टाइम निर्भरता दोनों के रूप में काम करते हैं। इन लाइब्रेरी में मौजूद कोई भी कमज़ोरी सीधे आपके मॉडल से समझौता कर सकती है। ज्ञात समस्याओं के लिए कंटेनर इमेज और मशीन लर्निंग पैकेज दोनों की जांच करने के लिए अपनी CI/CD पाइपलाइन में Google Artifact Analysis जैसे टूल को एकीकृत करके भेद्यता स्कैनिंग को स्वचालित करें। चूंकि मॉडल निष्पादन योग्य कोड के रूप में कार्य कर सकते हैं, इसलिए उनके साथ वही सावधानी बरतें जो आप सॉफ़्टवेयर प्रोग्रामों पर लागू करेंगे। उदाहरण के लिए, मानक क्रमांकन प्रारूप जैसे . पीटी या . पीकेएल डिसेरियलाइज़ेशन के दौरान सक्रिय होने वाले मैलवेयर को आश्रय दे सकता है।

“मॉडल आसानी से निरीक्षण करने योग्य नहीं होते हैं... मॉडल को प्रोग्राम के रूप में मानना बेहतर है, जैसा कि रनटाइम पर व्याख्या किए गए बाइटकोड के समान है।” - Google

इसके अतिरिक्त, अमान्य तृतीय-पक्ष मॉडल और डेटासेट महत्वपूर्ण जोखिम पेश कर सकते हैं। उभरता हुआ AI बिल ऑफ़ मैटेरियल्स (AIBOM) मानक कैटलॉग मॉडल, डेटासेट और निर्भरता में मदद करता है, जो अनुपालन और जोखिम प्रबंधन के लिए आवश्यक पारदर्शिता प्रदान करता है। प्रशिक्षण और अनुमान नौकरियों को केवल उन विशिष्ट डेटा स्टोरेज बकेट और नेटवर्क संसाधनों तक सीमित करके कम से कम विशेषाधिकार के सिद्धांत को लागू करें जिनकी उन्हें आवश्यकता है।

एक बार सुरक्षित विकास पद्धतियां लागू हो जाने के बाद, अगला कदम आपके परिचालन वातावरण की सुरक्षा के लिए उत्पादन परिनियोजन को प्रतिबंधित करने पर ध्यान केंद्रित करना है।

परिनियोजन प्रक्रिया को स्वचालित करना मानवीय त्रुटि को कम करने और अनधिकृत पहुंच को रोकने के लिए महत्वपूर्ण है। आधुनिक सर्वोत्तम प्रथाओं में उत्पादन डेटा, एप्लिकेशन और अवसंरचना के लिए नो-ह्यूमन-एक्सेस पॉलिसी लागू करना शामिल है। सभी परिनियोजन स्वीकृत, स्वचालित पाइपलाइनों के माध्यम से होने चाहिए।

“उत्पादन चरण उत्पादन डेटा, एप्लिकेशन और बुनियादी ढांचे के लिए सख्त नो-ह्यूमन-एक्सेस नीतियों का परिचय देता है। स्वीकृत परिनियोजन पाइपलाइनों के माध्यम से उत्पादन प्रणालियों तक सभी पहुंच को स्वचालित किया जाना चाहिए।” - AWS प्रिस्क्रिप्टिव गाइडेंस

विकास, मंचन और उत्पादन वातावरण के बीच सख्त अलगाव बनाए रखना एक और महत्वपूर्ण कदम है। यह अमान्य मॉडल को उत्पादन प्रणालियों को दूषित करने से रोकता है। इसके अतिरिक्त, केवल मान्य संस्करणों को परिनियोजन के लिए तैयार रखते हुए, अनधिकृत या मध्यवर्ती संस्करणों को हटाने के लिए आर्टिफैक्ट रजिस्ट्री क्लीनअप लागू करें। आपात स्थितियों के लिए, संकटों के दौरान जवाबदेही सुनिश्चित करने के लिए स्पष्ट अनुमोदन और व्यापक लॉगिंग की आवश्यकता वाली “ब्रेक-ग्लास” प्रक्रियाएं स्थापित करें। प्रशिक्षण के दौरान नियमित चेकपॉइंट मॉडल के विकास के ऑडिट की अनुमति देते हैं और सुरक्षा समस्या उत्पन्न होने पर सुरक्षित स्थिति में वापस आने की क्षमता प्रदान करते हैं।

आपके विकास और परिनियोजन पाइपलाइनों को सुरक्षित करने के बाद, अगला महत्वपूर्ण कदम यह सुनिश्चित करना है कि आपके AI वर्कफ़्लो को विनियामक मानकों और आंतरिक नीतियों के साथ संरेखित किया जाए। चूंकि विनियामक अनुपालन कई नेताओं के लिए चिंता का विषय बनता जा रहा है, इसलिए एक स्पष्ट ढांचा स्थापित करना महत्वपूर्ण है - न केवल कानूनी जोखिमों से बचने के लिए बल्कि ग्राहकों का विश्वास बनाए रखने के लिए भी। यह ढांचा स्वाभाविक रूप से पहले चर्चा की गई सुरक्षित प्रक्रियाओं पर आधारित है।

AI सुरक्षा के लिए विनियामक वातावरण तेजी से विकसित हो रहा है, जिसके लिए अमेरिकी संगठनों को एक साथ कई ढांचे की निगरानी करने की आवश्यकता है। एक प्रमुख संदर्भ यह है कि NIST AI रिस्क मैनेजमेंट फ्रेमवर्क (AI RMF 1.0), जो व्यक्तियों और समाज के लिए जोखिमों के प्रबंधन के लिए स्वैच्छिक मार्गदर्शन प्रदान करता है। जुलाई 2024 में रिलीज़ हुई, इसमें मतिभ्रम और डेटा गोपनीयता संबंधी चिंताओं जैसी अनोखी चुनौतियों का समाधान करने के लिए एक सहयोगी प्लेबुक और एक जनरेटिव AI प्रोफ़ाइल (NIST-AI-600-1) शामिल है। इसके अतिरिक्त, CISA/NSA/FBI संयुक्त मार्गदर्शन, मई 2025 में प्रकाशित, विकास से लेकर संचालन तक, AI जीवनचक्र की सुरक्षा के लिए एक व्यापक रोडमैप प्रदान करता है।

वैश्विक स्तर पर, आईएसओ/आईईसी 42001:2023 AI के लिए पहला अंतर्राष्ट्रीय प्रबंधन प्रणाली मानक बन गया है। ISO 27001 के अनुसार बनाया गया, यह पहले से ही सूचना सुरक्षा प्रणालियों का प्रबंधन करने वाली अनुपालन टीमों के लिए एक परिचित संरचना प्रदान करता है। इस मानक में डेटा गवर्नेंस, मॉडल डेवलपमेंट और ऑपरेशनल मॉनिटरिंग जैसे क्षेत्र शामिल हैं, जो इसे जोखिम समितियों और एंटरप्राइज़ क्लाइंट्स की चिंताओं को दूर करने के लिए विशेष रूप से उपयोगी बनाते हैं। यूरोपीय बाजारों में काम करने वाले संगठनों के लिए, इसका अनुपालन यूरोपीय संघ एआई अधिनियम (विशेष रूप से सटीकता और मजबूती पर अनुच्छेद 15), डोरा वित्तीय सेवाओं के लिए, और निस2 आवश्यक सेवा प्रदाताओं के लिए भी महत्वपूर्ण है।

“ISO 42001 AI सुरक्षा, शासन और जोखिम प्रबंधन को संभालने वाला एक संरचित ढांचा है, और यह उन संगठनों के लिए आवश्यक है जो AI टूल और सिस्टम को जिम्मेदारी से तैनात करना चाहते हैं।” - बीडी इमर्सन

ISO/IEC 42001 जैसे एकीकृत ढांचे को अपनाने का एक प्रमुख लाभ यह है कि यह एक साथ कई नियमों के साथ संरेखित करने की क्षमता, निरर्थक अनुपालन प्रयासों को कम करता है और परिचालन दक्षता में सुधार करता है। एक की स्थापना एआई एथिक्स बोर्ड - जिसमें अधिकारी, कानूनी विशेषज्ञ और AI व्यवसायी शामिल हैं - उच्च जोखिम वाली परियोजनाओं का मूल्यांकन करने और इन ढांचे के साथ संरेखण सुनिश्चित करने के लिए आवश्यक निरीक्षण प्रदान करता है। इन मानकों को अपने वर्कफ़्लो में शामिल करने से सुरक्षा और स्केलेबिलिटी दोनों मजबूत होते हैं, जो पहले के उपायों के पूरक हैं।

विनियामक अनुपालन और घटना की प्रतिक्रिया के लिए विस्तृत ऑडिट ट्रेल्स अपरिहार्य हैं। आपके लॉग में AI इंटरैक्शन के हर पहलू को कैप्चर करना चाहिए, जिसमें इस्तेमाल किया गया मॉडल संस्करण, सबमिट किया गया विशिष्ट संकेत, जेनरेट किया गया प्रतिसाद और प्रासंगिक उपयोगकर्ता मेटाडेटा शामिल हैं। विनियामक पूछताछ का जवाब देने या घटनाओं की जांच करने के लिए इस तरह की शुरू से अंत तक दृश्यता महत्वपूर्ण है।

इन अभिलेखों की अखंडता को बनाए रखने के लिए, उपयोग करें वर्म (एक बार लिखें, कई पढ़ें) लॉगिंग आउटपुट और सेशन डेटा को सुरक्षित करने के लिए स्टोरेज। ऑडिट ट्रेल्स को डेटा वंशावली का दस्तावेजीकरण भी करना चाहिए - डेटासेट की उत्पत्ति, परिवर्तन और लाइसेंस पर नज़र रखने के साथ-साथ मॉडल मापदंडों और हाइपरपैरामीटर्स को भी ट्रैक करना चाहिए। पारदर्शिता का यह स्तर विनियामक आवश्यकताओं का समर्थन करता है, जैसे कि डेटा सुरक्षा कानूनों के तहत “मिटाने का अधिकार” अनुरोधों का जवाब देना।

नियमित पॉलिसी समीक्षाएं भी उतनी ही महत्वपूर्ण होती हैं। इन समीक्षाओं को कम से कम सालाना या जब भी महत्वपूर्ण विनियामक परिवर्तन होते हैं, जैसे कि अपडेट यूरोपीय संघ एआई अधिनियम या निस2। परफॉर्म करें AI सिस्टम इम्पैक्ट असेसमेंट (AISIA) गोपनीयता, सुरक्षा और निष्पक्षता पर प्रभावों का मूल्यांकन करने के लिए समय-समय पर या बड़े बदलावों के बाद जवाबदेही सुनिश्चित करने के लिए इन आकलनों की समीक्षा आपके बहु-विषयक AI एथिक्स बोर्ड के साथ की जानी चाहिए। साथ मिलकर, मजबूत लॉगिंग और नियमित समीक्षाएं शासन और घटना प्रबंधन के लिए एक मजबूत आधार तैयार करती हैं।

AI वर्कफ़्लो विशेष घटना प्रतिक्रिया योजनाओं की मांग करते हैं जो AI सिस्टम के लिए अद्वितीय खतरों का समाधान करती हैं। इनमें मॉडल पॉइजनिंग, प्रॉम्प्ट इंजेक्शन, प्रतिकूल हमले और मतिभ्रम के कारण होने वाले हानिकारक आउटपुट जैसे जोखिम शामिल हैं। ऐसे परिदृश्यों के लिए अनुकूलित पहचान और उपचार रणनीतियों की आवश्यकता होती है, जो पारंपरिक साइबर सुरक्षा घटनाओं में इस्तेमाल की जाने वाली रणनीतियों से अलग होती हैं।

एआई-विशिष्ट प्लेबुक विकसित करें जो स्पष्ट रूप से वृद्धि पथ और जिम्मेदारियों को रेखांकित करती हैं। उदाहरण के लिए, यदि कोई मॉडल पक्षपाती आउटपुट उत्पन्न करता है, तो प्लेबुक को यह निर्दिष्ट करना चाहिए कि प्रशिक्षण डेटा की जांच कौन करता है, हितधारकों के साथ कौन संवाद करता है, और किन स्थितियों में मॉडल को वापस लाने की गारंटी दी जाती है। डेटा विषय अनुरोधों को संभालने के लिए प्रक्रियाएँ शामिल करें, जैसे कि यह सत्यापित करना कि क्या किसी व्यक्ति के डेटा का उपयोग मॉडल प्रशिक्षण में किया गया था, जब वे अपने “भूल जाने के अधिकार” का उपयोग करते हैं।

इन योजनाओं का परीक्षण करना आवश्यक है। यथार्थवादी AI घटना परिदृश्यों का अनुकरण करने के लिए क्रॉस-फ़ंक्शनल टीमों के साथ टेबलटॉप अभ्यास करें। ये अभ्यास प्रक्रियात्मक कमियों की पहचान करने और वास्तविक संकट आने से पहले टीम के समन्वय को बेहतर बनाने में मदद करते हैं। इसके अतिरिक्त, सिस्टम विफलताओं के दौरान आकस्मिक डेटा जोखिम को रोकने के लिए AI मॉडल को “बंद” या सुरक्षित स्थिति में विफल होने के लिए कॉन्फ़िगर करें। AI-विशिष्ट प्लेबुक को मौजूदा ऑटोमेशन प्रोटोकॉल के साथ एकीकृत करके, आप अपने संपूर्ण सुरक्षा आर्किटेक्चर को बढ़ाते हुए परिचालन निरंतरता बनाए रख सकते हैं।

सीमित संसाधनों के साथ काम करने वाली टीमों के लिए, AI वर्कफ़्लो को सुरक्षित करना एक कठिन काम की तरह लग सकता है। हालांकि, चरणबद्ध और स्वचालित दृष्टिकोण अपनाकर, आप समय के साथ एक मजबूत सुरक्षा ढांचा बना सकते हैं। हर उपाय को एक साथ लागू करने का प्रयास करने के बजाय, पहले उच्च प्रभाव वाले नियंत्रणों पर ध्यान दें, काम का बोझ हल्का करने के लिए स्वचालन का उपयोग करें, और जैसे-जैसे आपकी क्षमताओं का विस्तार होता है, धीरे-धीरे अधिक उन्नत तकनीकों को पेश करें।

पहला कदम सबसे महत्वपूर्ण कमजोरियों को दूर करना है। एसेट डिस्कवरी और इन्वेंट्री से शुरुआत करें। अनट्रैक किए गए AI मॉडल, डेटासेट और एंडपॉइंट कमज़ोर स्पॉट बना सकते हैं जिनका हमलावर फायदा उठा सकते हैं। एज़्योर रिसोर्स ग्राफ़ एक्सप्लोरर जैसे टूल सभी AI संसाधनों को प्रभावी ढंग से पहचानने और सूचीबद्ध करने में मदद कर सकते हैं।

इसके बाद, कम से कम विशेषाधिकार के सिद्धांत के साथ पहचान और पहुंच प्रबंधन (IAM) को लागू करें। प्रबंधित पहचानों का उपयोग करके और सख्त डेटा गवर्नेंस लागू करके, जैसे कि संवेदनशील डेटासेट को वर्गीकृत करना, आप महत्वपूर्ण लागतों के बिना मजबूत सुरक्षा प्राप्त कर सकते हैं।

एक अन्य आवश्यक कदम इनपुट और आउटपुट को सुरक्षित करना है। इंजेक्शन हमलों को रोकने और डेटा रिसाव को रोकने के लिए शीघ्र फ़िल्टरिंग और आउटपुट सैनिटाइज़ेशन जैसे उपायों को लागू करें। केंद्रीकृत निगरानी भी महत्वपूर्ण है - संकेतों, प्रतिक्रियाओं और उपयोगकर्ता मेटाडेटा सहित AI इंटरैक्शन को ट्रैक करने के लिए रीयल-टाइम विसंगति का पता लगाने और व्यापक लॉगिंग का उपयोग करें।

“AI को सुरक्षित करना उन वातावरणों में स्पष्टता बहाल करने के बारे में है जहाँ जवाबदेही जल्दी धुंधली हो सकती है। यह जानने के बारे में है कि AI कहाँ मौजूद है, यह कैसे व्यवहार करता है, इसे क्या करने की अनुमति है और इसके निर्णय व्यापक उद्यम को कैसे प्रभावित करते हैं।” - ब्रिटनी वुडस्मॉल और साइमन फैलो, डार्कट्रेस

इन मूलभूत नियंत्रणों के साथ, ऑटोमेशन सीमित बैंडविड्थ वाली टीमों के लिए गेम-चेंजर बन जाता है।

स्वचालन संसाधनों की कमी वाली टीमों के लिए एक शक्तिशाली सहयोगी है, जो सुरक्षा उपायों को बनाए रखने के लिए आवश्यक मैन्युअल प्रयास को कम करता है। AI सुरक्षा आसन प्रबंधन (AI-SPM) उपकरण स्वचालित रूप से AI पाइपलाइनों और मॉडलों को मैप कर सकते हैं, सत्यापित शोषण पथों की पहचान कर सकते हैं, और चेतावनी के शोर को 88% तक कम कर सकते हैं। यह उन छोटी टीमों के लिए विशेष रूप से मूल्यवान है जो हजारों अलर्टों को मैन्युअल रूप से पार नहीं कर सकती हैं।

शासन, जोखिम और अनुपालन (GRC) प्लेटफ़ॉर्म दक्षता की एक और परत प्रदान करते हैं। ये उपकरण लॉगिंग, जोखिम प्रबंधन और नीति निरीक्षण को केंद्रीकृत करते हैं। कई GRC प्लेटफ़ॉर्म में NIST AI RMF या ISO 42001 जैसे फ्रेमवर्क के लिए पूर्व-निर्मित टेम्पलेट शामिल हैं, जो आपको शुरुआत से ही नीतियां बनाने की परेशानी से बचाते हैं। स्वचालित अलर्ट व्यवस्थापकों को जोखिम भरी कार्रवाइयों के बारे में भी सूचित कर सकते हैं, जैसे कि अनिर्धारित मॉडल रीट्रेनिंग या असामान्य डेटा निर्यात।

स्वचालित भेद्यता स्कैनिंग को CI/CD पाइपलाइनों में एकीकृत करने से उत्पादन में आने से पहले गलत कॉन्फ़िगरेशन को पकड़ने में मदद मिलती है। डेटासेट और मॉडल संस्करणों पर डिजिटल हस्ताक्षर आगे चलकर हिरासत की श्रृंखला से छेड़छाड़ सुनिश्चित करते हैं, जिससे मैन्युअल सत्यापन की आवश्यकता समाप्त हो जाती है। डेटा उल्लंघन की औसत लागत $4.45 मिलियन को ध्यान में रखते हुए, ये स्वचालित उपकरण छोटी टीमों के लिए महत्वपूर्ण मूल्य प्रदान करते हैं।

एक बार बुनियादी कार्य स्वचालित हो जाने के बाद, आप धीरे-धीरे अधिक परिष्कृत सुरक्षा संवर्द्धन कर सकते हैं।

एक ठोस आधार स्थापित करने के बाद, उन्नत सुरक्षा उपायों को पेश करने का समय आ गया है। अपने AI मॉडल में संभावित कमजोरियों को उजागर करने के लिए एडवर्सरियल टेस्टिंग से शुरुआत करें, जैसे कि रेड टीम एक्सरसाइज। समय के साथ, आप संवेदनशील डेटासेट की सुरक्षा के लिए, गोपनीयता बढ़ाने वाली तकनीकों (PET) को अपना सकते हैं, जैसे कि डिफरेंशियल प्राइवेसी।

“उन्नत तकनीकों का विस्तार करने से पहले छोटी टीमों को डेटा गवर्नेंस, मॉडल वर्जनिंग और एक्सेस कंट्रोल जैसे मूलभूत नियंत्रणों से शुरुआत करनी चाहिए।” - SentinelOne

एआई-संचालित नीति प्रवर्तन उपकरण एक और कदम आगे हैं। ये उपकरण गलत कॉन्फ़िगर की गई एक्सेस नीतियों, अनएन्क्रिप्टेड डेटा पथ या अनधिकृत AI टूल को स्वचालित रूप से फ़्लैग कर सकते हैं - जिन्हें अक्सर “शैडो AI” कहा जाता है। जैसे-जैसे आपके वर्कफ़्लो विकसित होते हैं, गैर-मानवीय पहचान (NHI) प्रबंधन को लागू करने पर विचार करें। इसमें स्वायत्त AI एजेंटों को डिजिटल कर्मचारी मानना, अद्वितीय सेवा खातों और नियमित रूप से रोटेट किए गए क्रेडेंशियल्स के साथ काम करना शामिल है।

सुरक्षित AI वर्कफ़्लो बनाने के लिए निरंतर निरीक्षण, पारदर्शिता और बहुस्तरीय रक्षा रणनीति की आवश्यकता होती है। स्पष्ट नीतियां स्थापित करके और जवाबदेही निर्धारित करके शुरुआत करें, फिर अपनी संपत्ति के बारे में व्यापक दृष्टिकोण प्राप्त करने पर ध्यान दें। एन्क्रिप्शन, एक्सेस कंट्रोल और खतरे का पता लगाने वाले सिस्टम जैसे तकनीकी उपायों से अपनी सुरक्षा को मजबूत करें। इन प्राथमिकताओं को चरणों में हल करने से सबसे अधिक दबाव वाली कमजोरियों से प्रभावी ढंग से निपटने में मदद मिलती है।

इन उपायों की तात्कालिकता को डेटा द्वारा रेखांकित किया गया है: 80% नेता डेटा रिसाव के बारे में चिंतित हैं, जबकि 88% शीघ्र इंजेक्शन के बारे में चिंता करते हैं। इसके अतिरिक्त, जनवरी 2026 तक 500 से अधिक संगठन मेडुसा रैंसमवेयर हमलों के शिकार हो चुके हैं।

निर्णायक रूप से कार्य करने के लिए, तत्काल परिणाम देने वाले उच्च प्रभाव वाले कदमों को प्राथमिकता दें। संपत्ति की खोज, सख्त पहुंच नियंत्रण, और इनपुट्स और आउटपुट के सैनिटाइजेशन जैसी जरूरी चीजों से शुरुआत करें - ये मूलभूत उपाय व्यापक संसाधनों की आवश्यकता के बिना मजबूत सुरक्षा प्रदान करते हैं। इसके बाद, लगातार निगरानी और शासन बनाए रखने के लिए AI सिक्योरिटी पोस्चर मैनेजमेंट सिस्टम और GRC प्लेटफॉर्म जैसे ऑटोमेशन टूल को अपनाकर मैन्युअल प्रयास को कम करें। जैसे-जैसे आपका सुरक्षा ढांचा विकसित होता है, एडवर्सरियल टेस्टिंग, GPU के लिए गोपनीय कंप्यूटिंग और AI एजेंटों को विशिष्ट पहचान प्रदान करने जैसी उन्नत प्रथाओं को शामिल करें। ये कदम सामूहिक रूप से एक मजबूत और स्केलेबल AI वातावरण का निर्माण करते हैं।

“सुरक्षा एक सामूहिक प्रयास है जिसे सहयोग और पारदर्शिता के माध्यम से प्राप्त किया जाता है।” - OpenAI

AI मॉडल वर्कफ़्लो को सुरक्षित करने के लिए उनके जीवनचक्र के हर चरण में डेटा, कोड और मॉडल की सुरक्षा के लिए एक संपूर्ण रणनीति की आवश्यकता होती है। शुरू करने के लिए, सुरक्षित डेटा प्रथाओं को प्राथमिकता दें: संग्रहीत और ट्रांसमिशन के दौरान डेटासेट को एन्क्रिप्ट करें, सख्त एक्सेस नियंत्रण लागू करें, और किसी भी तीसरे पक्ष या ओपन-सोर्स डेटा को अपने वर्कफ़्लो में शामिल करने से पहले उसकी सावधानीपूर्वक जांच करें।

डेवलपमेंट के दौरान, पासवर्ड जैसी संवेदनशील जानकारी को सीधे अपने कोड में एम्बेड करने से बचें। इसके बजाय, सुरक्षित गुप्त-प्रबंधन टूल पर भरोसा करें और कमजोरियों या जोखिम भरी निर्भरता की पहचान करने के लिए नियमित कोड समीक्षा करें।

जब ट्रेनिंग या फाइन-ट्यूनिंग मॉडल की बात आती है, तो अपनाएं जीरो-ट्रस्ट सिद्धांत कंप्यूट संसाधनों को अलग करके और डेटा विषाक्तता या प्रतिकूल इनपुट जैसे जोखिमों के प्रति सतर्क रहकर। एक बार जब आपका मॉडल पूरा हो जाए, तो उसे सुरक्षित रिपॉजिटरी में स्टोर करें, अनधिकृत पहुंच को रोकने के लिए इसके वज़न को एन्क्रिप्ट करें, और नियमित रूप से इसकी अखंडता को सत्यापित करें।

अनुमान के समापन बिंदुओं के लिए, प्रमाणीकरण आवश्यकताओं को लागू करें, दुरुपयोग को रोकने के लिए उपयोग सीमा निर्धारित करें, और संभावित हमलों को रोकने के लिए आने वाले इनपुट को मान्य करें। सतर्कता जारी रखना महत्वपूर्ण है - अनुमान गतिविधि की लगातार निगरानी करें, विस्तृत लॉग बनाए रखें, और मॉडल चोरी या अप्रत्याशित प्रदर्शन समस्याओं जैसे खतरों को दूर करने के लिए प्रतिक्रिया योजनाओं के साथ तैयार रहें। इन चरणों का पालन करके, आप अपने AI वर्कफ़्लो के लिए एक मज़बूत सुरक्षा स्थापित कर सकते हैं।

छोटी टीमें सीधी सुरक्षा नीतियों को तैयार करके शुरू कर सकती हैं, जो AI जीवनचक्र के हर चरण को संबोधित करती हैं - डेटा इकट्ठा करने से लेकर उसके अंतिम निपटान तक। एक को अपनाना जीरो-ट्रस्ट दृष्टिकोण महत्वपूर्ण है: प्रमाणीकरण प्रोटोकॉल लागू करें, कम से कम विशेषाधिकार प्राप्त पहुंच लागू करें, और खर्चों को कम रखने के लिए अंतर्निहित क्लाउड टूल का उपयोग करके भूमिका-आधारित एक्सेस नियंत्रण पर भरोसा करें। सरल उपाय, जैसे कि Git कमिट पर हस्ताक्षर करना, एक अपरिवर्तनीय ऑडिट ट्रेल बना सकता है, जबकि हल्के तिमाही जोखिम आकलन करने से टीमों को कमजोरियों का जल्द पता चल जाता है।

सुरक्षा प्रयासों को कारगर बनाने के लिए मुफ़्त या ओपन-सोर्स टूल का लाभ उठाएं। प्रतिकूल हमलों को रोकने के लिए इनपुट सत्यापन और सैनिटाइजेशन का उपयोग करें, टोकन-आधारित प्रमाणीकरण और दर-सीमा का उपयोग करके API को सुरक्षित करें, और डेटा पॉइजनिंग या परफ़ॉर्मेंस ड्रिफ्ट जैसी समस्याओं को पकड़ने के लिए स्वचालित पाइपलाइन सेट करें। लाइटवेट मॉडल वॉटरमार्किंग बौद्धिक संपदा की सुरक्षा कर सकती है, और एक ठोस डेटा-गवर्नेंस फ्रेमवर्क यह सुनिश्चित करता है कि डेटासेट को ठीक से टैग, एन्क्रिप्ट और ट्रैक किया जाए। ये व्यावहारिक कदम भारी वित्तीय संसाधनों की आवश्यकता के बिना मजबूत सुरक्षा के लिए आधार तैयार करते हैं।

AI वर्कफ़्लो में डेटा सुरक्षा सुनिश्चित करने के लिए, a से शुरुआत करें सुरक्षित-दर-डिज़ाइन दृष्टिकोण, प्रारंभिक संग्रह से लेकर अंतिम परिनियोजन तक - हर चरण में जानकारी की सुरक्षा पर ध्यान केंद्रित करना। उपयोग करें एन्क्रिप्शन आराम से (जैसे, AES-256) और ट्रांसमिशन के दौरान (जैसे, TLS 1.2 या उच्चतर) डेटा की सुरक्षा के लिए। इम्प्लीमेंट करें सख्त पहुँच नियंत्रण कम से कम विशेषाधिकार के सिद्धांत द्वारा निर्देशित, इसलिए केवल अधिकृत यूज़र और सिस्टम ही संवेदनशील डेटा के साथ इंटरैक्ट कर सकते हैं। इन प्रतिबंधों को बनाए रखने में भूमिका-आधारित या विशेषता-आधारित एक्सेस नीतियां विशेष रूप से प्रभावी हो सकती हैं।

असामान्य गतिविधि का जल्द पता लगाने के लिए नेटवर्क को अलग करके, इनपुट को मान्य करके और सभी डेटा आंदोलनों को लॉग करके डेटा पाइपलाइनों को सुरक्षित करें। लिवरेज डेटा-वंशावली उपकरण डेटासेट की उत्पत्ति और उपयोग का पता लगाने के लिए, GDPR और CCPA जैसे नियमों के अनुपालन में सहायता करना। संवेदनशील जानकारी के लिए नियमित स्कैन, जैसे कि व्यक्तिगत रूप से पहचाने जाने योग्य जानकारी (PII), और संपादन या टोकन जैसी तकनीकों को लागू करने से जोखिमों को और कम किया जा सकता है। स्वचालित सुरक्षा अलर्टों के साथ वास्तविक समय की निगरानी करने से संभावित खतरों की त्वरित पहचान करने और उनका जवाब देने में मदद मिलती है।

निगमित करें नीति-संचालित स्वचालन सुरक्षा उपायों को कारगर बनाने के लिए अपने वर्कफ़्लो में शामिल करें। इसमें एन्क्रिप्ट किए गए स्टोरेज का प्रावधान करना, नेटवर्क सेगमेंटेशन लागू करना, और अनुपालन जांच को सीधे परिनियोजन प्रक्रियाओं में एम्बेड करना शामिल है। इन तकनीकी सुरक्षा को संगठनात्मक नीतियों के साथ लागू करें, जैसे कि सुरक्षित डेटा प्रथाओं पर टीमों को प्रशिक्षित करना, स्पष्ट अवधारण शेड्यूल सेट करना, और AI से संबंधित जोखिमों के अनुरूप घटना-प्रतिक्रिया योजना विकसित करना। साथ में, ये उपाय AI जीवनचक्र के दौरान व्यापक सुरक्षा प्रदान करते हैं।