La administración de modelos de aprendizaje automático (ML) es compleja y requiere herramientas que simplifiquen la implementación, la supervisión y el control de versiones. En esta guía se destacan las cinco principales plataformas de IA: Aprendizaje automático de Microsoft Azure, Inteligencia artificial Vertex de Google Cloud, Amazon SageMaker, Cara abrazada, y Prompts.ai - cada uno diseñado para abordar desafíos únicos en los flujos de trabajo de ML. Esto es lo que necesita saber:

Cada plataforma satisface necesidades específicas, desde la rentabilidad hasta la escalabilidad. A continuación se muestra una comparación rápida que le ayudará a decidir.

Elija la plataforma que se adapte a sus objetivos técnicos, infraestructura y presupuesto. Comience poco a poco con proyectos piloto para evaluar la compatibilidad antes de escalar.

Aprendizaje automático de Microsoft Azure es una plataforma basada en la nube diseñada para abordar los desafíos de administrar los modelos de aprendizaje automático (ML). Es compatible con todas las etapas del ciclo de vida del aprendizaje automático y, al mismo tiempo, se integra a la perfección con el ecosistema más amplio de herramientas y servicios de Microsoft.

Azure ML simplifica todo el ciclo de vida del modelo con un registro centralizado que rastrea automáticamente el linaje del modelo, incluidos los conjuntos de datos, el código y los hiperparámetros. Sus canalizaciones automatizadas gestionan todo, desde la preparación de los datos hasta la implementación, lo que garantiza una transición fluida entre las etapas.

La plataforma brilla seguimiento de experimentos, gracias a su integración con MLFlow integrada. Esta función permite a los científicos de datos registrar métricas, parámetros y artefactos automáticamente, lo que facilita la comparación de versiones de modelos y la reproducción de experimentos exitosos. También es compatible Pruebas A/B en producción, lo que permite la implementación gradual y, al mismo tiempo, monitorea el rendimiento en tiempo real.

Más allá del seguimiento de los archivos del modelo, Azure ML proporciona control de versiones para configuraciones de entorno, objetivos de procesamiento y ajustes de implementación. Esto garantiza que los modelos se puedan reproducir de forma fiable en todas las etapas de desarrollo. Además, la función de instantáneas captura todos los detalles de un experimento, incluidos el código, las dependencias y las versiones de los datos.

Esta administración integral del ciclo de vida convierte a Azure ML en una opción sólida para implementaciones escalables y una integración perfecta en los flujos de trabajo existentes.

Azure ML se adapta a las diferentes necesidades informáticas con su función de escalado automático, que ajusta los recursos de forma dinámica, desde el entrenamiento de un solo nodo hasta los clústeres de GPU distribuidos, sin necesidad de modificar el código. Esta flexibilidad es especialmente beneficiosa para las organizaciones que gestionan diversas cargas de trabajo de aprendizaje automático.

La plataforma se integra sin problemas con Azure DevOps y GitHub, lo que permite a los equipos automatizar los flujos de trabajo de integración y entrega continuas (CI/CD). Por ejemplo, se pueden activar canalizaciones para volver a entrenar los modelos siempre que haya nuevos datos disponibles o se confirmen cambios en el código. Además, Azure ML se conecta directamente con Power BI para obtener información útil y Análisis de Azure Synapse para el procesamiento de datos, creando un ecosistema cohesivo de datos e IA.

Azure ML también admite despliegue multinube, lo que permite que los modelos entrenados en Azure se desplieguen en otras plataformas de nube o incluso en infraestructuras locales. Esta capacidad ayuda a las organizaciones a evitar la dependencia de un proveedor y, al mismo tiempo, a mantener una administración uniforme de los modelos en los diferentes entornos.

Azure ML ofrece una modelo de precios de pago por uso, con cargos separados para el procesamiento, el almacenamiento y los servicios específicos. Los costos de procesamiento oscilan entre aproximadamente De 0,10 USD por hora para las instancias de CPU a más de 3,00 USD por hora para las GPU de gama alta. Para cargas de trabajo predecibles, las instancias reservadas pueden ofrecer ahorros de hasta el 72%.

Para ayudar a administrar los costos, Azure ML incluye administración automática de cómputos, que cierra los recursos inactivos y escala el uso en función de la demanda. La plataforma también proporciona herramientas detalladas de seguimiento de costos y presupuestación, que permiten a los equipos establecer límites de gastos y recibir alertas cuando se acercan a esos umbrales.

Los costos de almacenamiento suelen ser 0,02 a 0,05$ por GB al mes, aunque las organizaciones que mueven grandes conjuntos de datos entre regiones deben tener en cuenta los posibles gastos de transferencia de datos.

Microsoft respalda Azure ML con amplios recursos, que incluyen documentación detallada, laboratorios prácticos y programas de certificación a través de Microsoft Learn. La plataforma se beneficia de los foros comunitarios activos y recibe actualizaciones trimestrales con nuevas funciones.

Para las empresas, Microsoft ofrece opciones de soporte sólidas, que incluyen asistencia técnica las 24 horas del día, los 7 días de la semana, tiempos de respuesta garantizados y acceso a gestores de éxito de clientes especializados. Las organizaciones también pueden aprovechar servicios de consultoría profesional para diseñar e implementar flujos de trabajo de aprendizaje automático adaptados a sus necesidades.

Azure ML admite marcos populares como PyTorch, TensorFlow y Scikit-learn y ofertas aceleradores de soluciones prediseñados para tareas como la previsión de la demanda y el mantenimiento predictivo. Estas herramientas están diseñadas para agilizar los flujos de trabajo y hacer que la administración de modelos de aprendizaje automático sea más eficiente.

Google Cloud Vertex AI reúne las funciones de administración de modelos de aprendizaje automático en una sola plataforma, fusionando los puntos fuertes de AutoML y AI Platform. Está diseñado para simplificar los flujos de trabajo de aprendizaje automático y, al mismo tiempo, ofrecer escalabilidad y rendimiento a nivel empresarial.

Vertex AI proporciona una plataforma ML unificada que agiliza todo el ciclo de vida del modelo, desde la preparación de los datos hasta la implementación. Es Registro de modelos rastrea las versiones, el linaje y los metadatos, lo que facilita la comparación y la evaluación del rendimiento del modelo a lo largo del tiempo.

La plataforma incluye herramientas de monitoreo continuo para rastrear el rendimiento de la producción y alertar a los equipos sobre problemas como la pérdida de datos. Es compatible formación personalizada con marcos como TensorFlow, PyTorch y XG Boost, a la vez que ofrece Opciones de AutoML para aquellos que prefieren una solución sin código. ¿Con orquestación de oleoductos, los equipos pueden crear flujos de trabajo reproducibles que se ejecutan automáticamente o bajo demanda, lo que garantiza procesos consistentes. El Tienda de funciones mejora aún más la confiabilidad al administrar y ofrecer funciones de manera uniforme en todos los entornos de capacitación e implementación, lo que reduce el riesgo de discrepancias.

Estas capacidades facilitan que los equipos escalen sus esfuerzos e se integren sin problemas en los flujos de trabajo existentes.

Basada en la sólida infraestructura de Google, Vertex AI admite configuraciones de máquinas personalizadas e instancias reemplazables, lo que ofrece un equilibrio entre rendimiento y costo. Sus capacidades de escalado automático permiten realizar transiciones fluidas de configuraciones de entrenamiento de un solo nodo a configuraciones de entrenamiento distribuidas.

La IA de Vertex se integra sin esfuerzo con el ecosistema de datos de Google Cloud, que incluye BigQuery, Cloud Storage y Dataflow. El Banco de trabajo Vertex AI proporciona ordenadores portátiles Jupyter gestionados con entornos preconfigurados, mientras Tuberías Vertex AI simplifica la creación y el despliegue de flujos de trabajo de aprendizaje automático mediante Canalizaciones de Kubeflow.

A modo de inferencia, la plataforma ofrece puntos finales de predicción en línea con balanceo y escalado de carga automáticos, así como predicción de lotes opciones para gestionar las tareas de inferencia a gran escala de manera eficiente en los recursos distribuidos.

Vertex AI opera según un modelo de precios de pago por uso, con cargos separados por entrenamiento, predicción y almacenamiento. Los costos dependen de factores como el tipo de instancia, las necesidades de rendimiento y la duración del uso. Ofrece varias opciones que permiten ahorrar costos, como descuentos por uso continuo, instancias reemplazables para cargas de trabajo tolerantes a errores y descuentos por compromiso de uso para patrones de uso predecibles. Las herramientas integradas de monitoreo de costos ayudan a los equipos a administrar sus presupuestos de manera eficaz.

Google proporciona amplios recursos para los usuarios de Vertex AI, que incluyen documentación detallada, laboratorios prácticos y programas de certificación a través de Google Cloud Skills Boost. La plataforma se beneficia de una comunidad de desarrolladores dinámica y de actualizaciones frecuentes para mantenerse al día con los últimos avances.

Los usuarios empresariales tienen acceso a soporte las 24 horas del día, los 7 días de la semana, con tiempos de respuesta garantizados en función de la gravedad del problema. Los servicios profesionales también están disponibles para ayudar a las organizaciones a diseñar e implementar estrategias de aprendizaje automático, especialmente para despliegues a gran escala.

Vertex AI es compatible con los marcos de código abierto más utilizados y se integra con herramientas como MLFlow y TensorBoard para el seguimiento y la visualización de experimentos. Además, el AI Hub de Google ofrece modelos previamente entrenados y plantillas de canalización, lo que permite a los equipos acelerar el desarrollo de casos de uso comunes del aprendizaje automático. Los foros y plataformas comunitarios, como Stack Overflow, mejoran aún más el sistema de soporte, mientras que las publicaciones continuas de Google sobre investigaciones y mejores prácticas garantizan que los equipos estén informados sobre las nuevas tendencias del aprendizaje automático.

Amazon SageMaker es la plataforma integral de aprendizaje automático de AWS diseñada para ayudar a los científicos de datos e ingenieros de aprendizaje automático a crear, entrenar e implementar modelos a escala. Basado en la infraestructura global de AWS, SageMaker combina potentes herramientas para la administración de modelos con opciones de implementación escalables, lo que lo convierte en la solución ideal para las empresas.

SageMaker proporciona un conjunto completo de herramientas para administrar todo el ciclo de vida de los modelos de aprendizaje automático. En el centro se encuentra el Registro de modelos de SageMaker, un centro centralizado donde los equipos pueden catalogar, versionar y rastrear el linaje de sus modelos. Este repositorio incluye metadatos y métricas de rendimiento, lo que simplifica las comparaciones de versiones y permite reversiones rápidas cuando es necesario.

Con Estudio SageMaker, los usuarios pueden acceder a los cuadernos de Jupyter, realizar un seguimiento de los experimentos y depurar los flujos de trabajo, todo en un solo lugar. Mientras tanto, Experimentos de SageMaker registra automáticamente las ejecuciones de entrenamiento, los hiperparámetros y los resultados, lo que agiliza el proceso de seguimiento y refinamiento de los modelos.

Para garantizar que los modelos funcionen bien en la producción, Monitor de modelos SageMaker vigila la calidad, la desviación y el sesgo de los datos, emitiendo alertas cuando el rendimiento disminuye o cuando los datos entrantes se desvían significativamente. Canalizaciones de SageMaker automatiza todo el flujo de trabajo, desde el procesamiento de datos hasta la implementación, lo que garantiza la coherencia y la confiabilidad durante todo el proceso de desarrollo.

SageMaker destaca por su capacidad para escalar los recursos de manera eficiente. Al aprovechar la infraestructura elástica de AWS, puede gestionar incluso las cargas de trabajo de aprendizaje automático más exigentes. La plataforma admite formación distribuida en varias instancias, lo que simplifica el procesamiento paralelo para conjuntos de datos grandes y modelos complejos. Con Empleos de formación de SageMaker, los recursos pueden escalar desde una sola instancia hasta cientos de máquinas, lo que permite aprovisionar y liberar automáticamente los recursos según sea necesario.

La integración con otros servicios de AWS hace que SageMaker sea aún más potente. Por ejemplo, el Tienda de funciones de SageMaker actúa como un repositorio centralizado para las funciones de aprendizaje automático, lo que garantiza la coherencia entre el entrenamiento y la inferencia y, al mismo tiempo, permite la reutilización de funciones en todos los proyectos.

Para el despliegue, Terminales de SageMaker proporcionan inferencias en tiempo real con escalado automático en función de los patrones de tráfico. La plataforma también admite terminales multimodelo, lo que permite que varios modelos se ejecuten en un único punto final para maximizar la eficiencia de los recursos y reducir los costos. Para el procesamiento por lotes, Transformación por lotes de SageMaker gestiona de manera eficiente grandes trabajos de inferencia mediante recursos informáticos distribuidos.

SageMaker utiliza el modelo de pago por uso de AWS, con cargos independientes para la formación, el alojamiento y el procesamiento de datos. Los costos de formación dependen del tipo de instancia y de la duración, con Instancias puntuales ofreciendo hasta un 90% de ahorro en comparación con las tarifas bajo demanda.

Para cargas de trabajo predecibles, Planes de ahorro ofrecen descuentos de hasta el 64% para un uso comprometido. Para optimizar aún más los costos, Recomendador de inferencias de SageMaker prueba varios tipos de instancias y configuraciones, lo que ayuda a los equipos a encontrar la configuración de implementación más rentable sin sacrificar el rendimiento.

Terminales equipados con escalado automático asegúrese de que los usuarios solo paguen por los recursos informáticos que necesitan. Los recursos se reducen durante los períodos de poco tráfico y aumentan a medida que aumenta la demanda. Además, SageMaker proporciona herramientas para el seguimiento y la presupuestación, lo que permite a los equipos controlar mejor sus gastos de aprendizaje automático.

Los usuarios de Amazon SageMaker se benefician de una gran cantidad de recursos, que incluyen documentación detallada, tutoriales prácticos y Universidad de aprendizaje automático de AWS, que ofrece cursos y certificaciones gratuitos. La plataforma cuenta con el respaldo de una vibrante comunidad de desarrolladores y actualizaciones frecuentes que se alinean con los últimos avances en aprendizaje automático.

Para clientes empresariales, Soporte de AWS ofrece asistencia por niveles, que va desde asistencia telefónica las 24 horas del día, los 7 días de la semana para problemas críticos, hasta orientación general durante el horario laboral. Además, Servicios profesionales de AWS proporciona ayuda de consultoría e implementación para proyectos de aprendizaje automático complejos o a gran escala.

SageMaker admite marcos de código abierto populares como TensorFlow, PyTorch, Scikit-learn, y XG Boost a través de contenedores prediseñados, al tiempo que permite contenedores personalizados para necesidades especializadas. El Blog de aprendizaje automático de AWS comparte regularmente las mejores prácticas, estudios de casos y guías técnicas detalladas. Foros y eventos comunitarios como AWS re:Invent brindan más oportunidades para aprender y establecer contactos, tanto para principiantes como para profesionales experimentados.

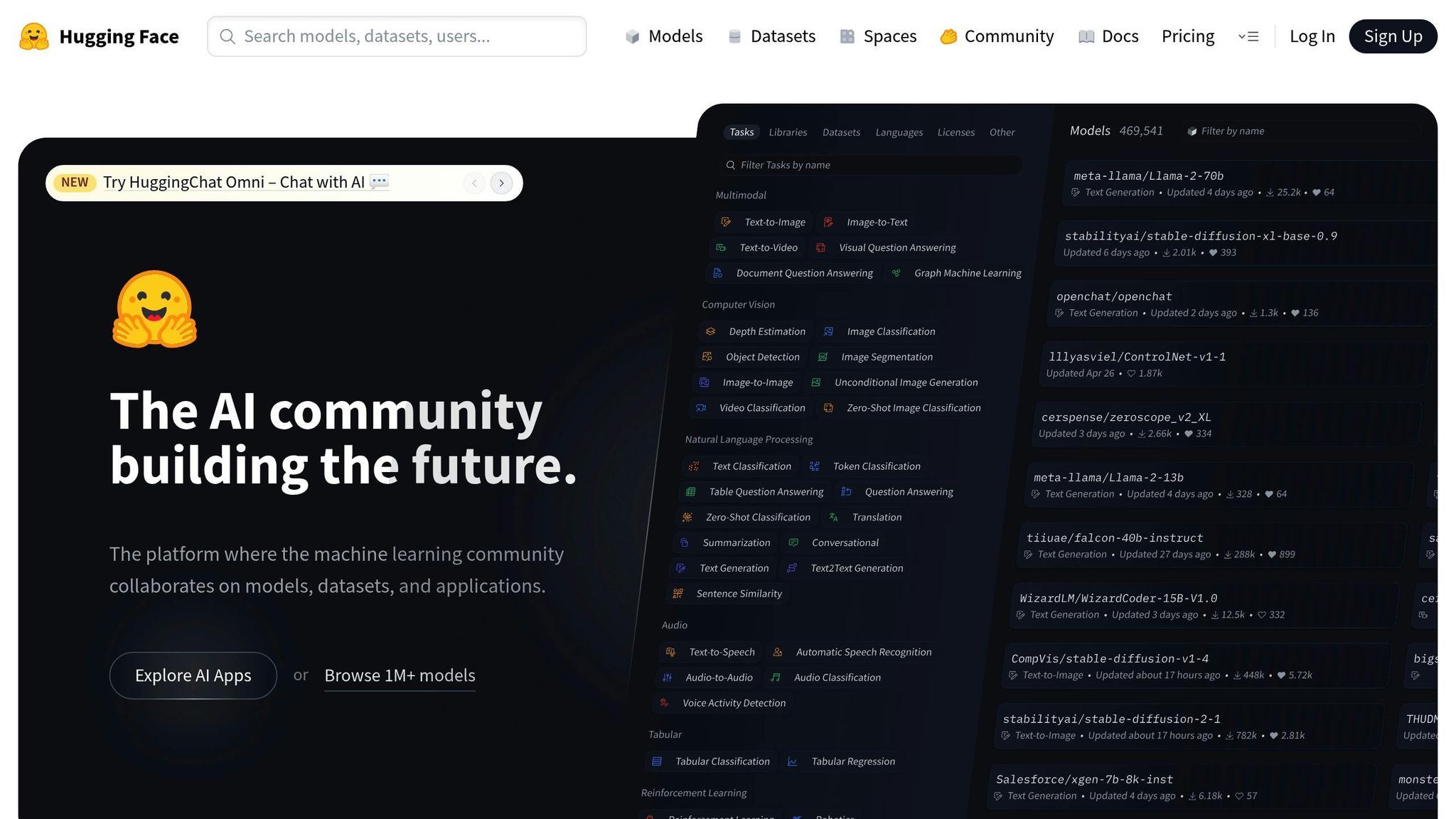

Hugging Face ofrece a los usuarios un conjunto completo de herramientas de aprendizaje automático. Si bien originalmente se centraba en el procesamiento del lenguaje natural, ha ampliado sus capacidades para incluir la visión artificial, el procesamiento de audio y las aplicaciones multimodales. Esta evolución la ha convertido en una plataforma de referencia para administrar e implementar modelos de aprendizaje automático.

El Hugging Face Hub actúa como un repositorio centralizado para modelos, conjuntos de datos y demostraciones interactivas previamente entrenados. Cada repositorio de modelos incluye una tarjeta modelo detallada que describe el proceso de capacitación, los posibles casos de uso, las limitaciones y las consideraciones éticas, lo que garantiza la transparencia en cada etapa del ciclo de vida del modelo. La biblioteca Hugging Face Transformers simplifica aún más los flujos de trabajo, ya que permite a los usuarios cargar, ajustar y actualizar modelos sin esfuerzo mediante el control de versiones basado en GIT.

En lo que respecta a la implementación, los puntos finales de inferencia de Hugging Face ofrecen una solución perfecta. Estos terminales gestionan el escalado automático, la supervisión de la CPU y la GPU y proporcionan métricas de rendimiento junto con el registro de errores. Esta configuración ayuda a los equipos a evaluar el rendimiento de los modelos en escenarios del mundo real, lo que garantiza una transición fluida del desarrollo a la producción.

Hugging Face ofrece una sólida escalabilidad a través de su biblioteca Accelerate, que admite el entrenamiento distribuido en varias GPU y máquinas. Se integra a la perfección con los marcos de aprendizaje profundo más populares, como PyTorch, TensorFlow y JAX, lo que lo hace adaptable a diversos flujos de trabajo. Además, la biblioteca de conjuntos de datos brinda acceso a una amplia gama de conjuntos de datos, además de herramientas para el preprocesamiento y la transmisión, lo que ayuda a optimizar las canalizaciones de datos.

Para mostrar modelos y recopilar comentarios, Hugging Face Spaces es una característica destacada. Utiliza herramientas como Gradio o Streamlit, los usuarios pueden crear demostraciones y aplicaciones interactivas con facilidad. Estas demostraciones se pueden integrar en flujos de trabajo de integración continua, lo que simplifica la participación y la iteración de las partes interesadas.

Hugging Face prospera gracias a su vibrante comunidad de código abierto, donde los usuarios comparten activamente modelos, conjuntos de datos y aplicaciones. La plataforma también ofrece un curso educativo gratuito que abarca desde los conceptos básicos de los transformadores hasta técnicas avanzadas de ajuste. Para los clientes empresariales, Hugging Face ofrece repositorios de modelos privados, funciones de seguridad mejoradas y soporte dedicado, lo que permite a las organizaciones gestionar modelos propietarios y, al mismo tiempo, aprovechar las potentes herramientas de la plataforma.

Hugging Face funciona en un modelo freemium. Las personas y los equipos pequeños pueden acceder a los repositorios públicos y a las funciones de la comunidad sin costo alguno. Para aquellos que necesitan una implementación gestionada, almacenamiento adicional o soporte avanzado, la plataforma ofrece planes de pago con precios personalizados según los requisitos y niveles de uso específicos.

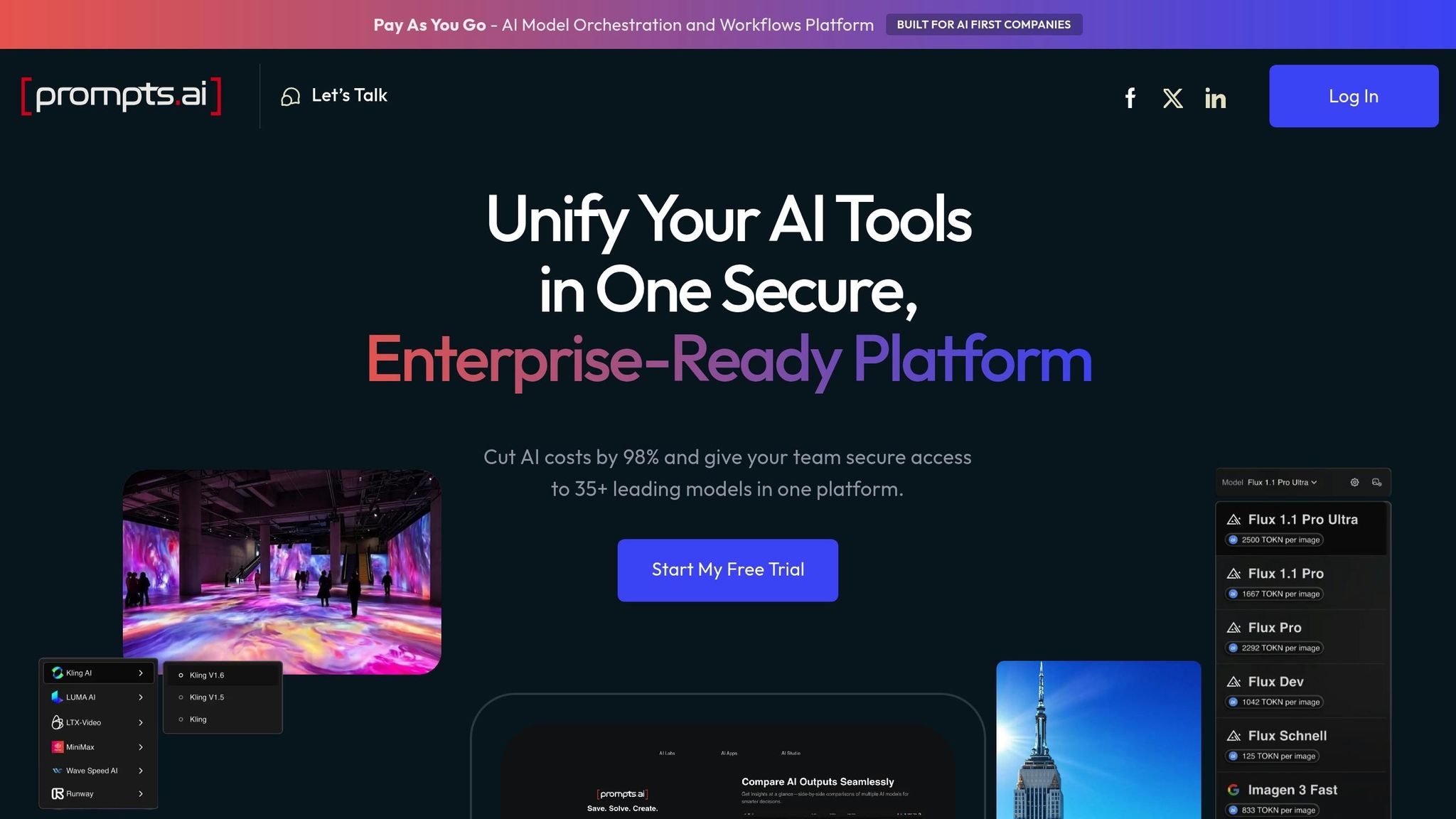

Prompts.ai reúne más de 35 modelos lingüísticos de gran tamaño en una plataforma segura y optimizada. Diseñado específicamente para gestión rápida y LLMOP, proporciona un entorno listo para la producción para administrar y optimizar las solicitudes.

Prompts.ai ofrece un conjunto completo de herramientas para administrar todo el ciclo de vida de los modelos, con un enfoque en control de versiones y seguimiento rápidos. Permite a los usuarios versionar las instrucciones, deshacer los cambios y garantizar la reproducibilidad mediante sistemas avanzados de control de versiones.

La plataforma cuenta con monitoreo automatizado para rastrear métricas clave como la precisión de la predicción, la latencia y la deriva de los datos. Los usuarios pueden configurar alertas personalizadas para abordar rápidamente los problemas o anomalías de rendimiento, lo que garantiza un funcionamiento fluido incluso en entornos de producción. Esta supervisión es particularmente útil para hacer frente a desafíos como el rápido cambio de rumbo y mantener un rendimiento constante.

Por ejemplo, una empresa de análisis de la salud de EE. UU. usó Prompts.ai para reducir los tiempos de implementación de los modelos en un 40% y, al mismo tiempo, mejorar la precisión del seguimiento. Esto se tradujo en mejores resultados para los pacientes y en unos informes de cumplimiento más eficientes.

Estas herramientas de ciclo de vida están diseñadas para soportar despliegues escalables y confiables.

Prompts.ai se integra sin esfuerzo con los marcos de aprendizaje automático más populares, que incluyen TensorFlow, PyTorch y scikit-learn, así como las principales plataformas en la nube, como AWS, Azure y Google Cloud. Admite despliegues escalables con escalado automático para escenarios de alta demanda y funciona con sistemas de orquestación de contenedores como Kubernetes.

Al consolidar la selección de modelos, los flujos de trabajo rápidos, la administración de costos y las comparaciones de rendimiento en una sola plataforma, Prompts.ai elimina la necesidad de utilizar varias herramientas. Este enfoque unificado puede reducir los costos del software de inteligencia artificial hasta en un 98% y, al mismo tiempo, mantener la seguridad y el cumplimiento a nivel empresarial.

Prompts.ai va más allá de las capacidades técnicas al fomentar la colaboración. Ofrece funciones como espacios de trabajo compartidos, controles de acceso basados en funciones y comentarios integrados en artefactos modelo, lo que facilita que los científicos de datos y los ingenieros de aprendizaje automático colaboren de forma eficaz. Estas herramientas garantizan la transparencia y el trabajo en equipo durante todo el ciclo de vida del desarrollo del modelo.

La plataforma también proporciona amplios recursos, que incluyen documentación completa, foros de usuarios y soporte directo. Los clientes empresariales se benefician de administradores de cuentas dedicados y de un soporte prioritario para gestionar implementaciones complejas. Además, Prompts.ai apoya una comunidad de usuarios activa donde los miembros pueden intercambiar las mejores prácticas y buscar el asesoramiento de expertos.

Prompts.ai funciona con un sistema de crédito TOKN de pago por uso. Los planes personales comienzan sin costo alguno y se escalan a 29 o 99 dólares al mes, mientras que los planes empresariales oscilan entre 99 y 129 dólares por miembro y mes. El modelo de facturación basado en el uso de la plataforma evita los compromisos a largo plazo, ya que los planes anuales ofrecen un descuento del 10%.

Esta estructura de precios es particularmente atractiva para las organizaciones con sede en EE. UU. que buscan flexibilidad y control de costos. Las herramientas FinOps en tiempo real de Prompts.ai brindan una visibilidad total de los gastos y conectan cada token utilizado con resultados comerciales medibles.

Esta sección reúne los puntos fuertes y los desafíos de cada plataforma para ayudar a refinar su estrategia de administración de modelos de aprendizaje automático (ML). Al comparar sus funciones, puede alinear su elección con sus necesidades, presupuesto y objetivos técnicos específicos.

Aprendizaje automático de Microsoft Azure destaca para las organizaciones que ya están integradas en el ecosistema de Microsoft. Su integración con herramientas como Office 365 y Power BI garantiza un flujo de trabajo optimizado. Sin embargo, estos beneficios son escasos, ya que los costos pueden aumentar rápidamente, especialmente para los equipos más pequeños. Además, la curva de aprendizaje de la plataforma puede resultar empinada para quienes no estén familiarizados con Azure.

Inteligencia artificial Vertex de Google Cloud brilla con sus avanzadas capacidades de AutoML y su estrecha relación con la investigación de IA de vanguardia de Google. Ofrece un excelente soporte para TensorFlow y herramientas sólidas de análisis de datos. Dicho esto, su dependencia de los marcos de Google limita la flexibilidad y su estructura de precios puede resultar confusa y, en ocasiones, generar cargos inesperados.

Amazon SageMaker ofrece una escalabilidad sin igual y un conjunto completo de herramientas para administrar todo el ciclo de vida del aprendizaje automático. Su modelo de pago por uso atrae a las organizaciones que se preocupan por su presupuesto, y el amplio ecosistema de AWS proporciona una gran cantidad de recursos. Sin embargo, la complejidad de la plataforma y la posibilidad de depender de un solo proveedor pueden plantear desafíos, especialmente para quienes se inician en el aprendizaje automático basado en la nube.

Cara abrazada ha transformado el intercambio de modelos y la colaboración con su amplia biblioteca de modelos previamente entrenados y una comunidad dinámica. Se destaca en el procesamiento del lenguaje natural (PNL), respaldado por una documentación clara y accesible. Por el lado negativo, carece de algunas funciones de nivel empresarial, lo que podría ser motivo de preocupación para las organizaciones con necesidades estrictas de gobernanza de datos.

Las fortalezas y debilidades de cada plataforma reflejan su enfoque de la administración del ciclo de vida, la escalabilidad y el soporte a los usuarios.

Prompts.ai se distingue por su capacidad para reducir los costos (hasta un 98%) y, al mismo tiempo, consolidar el acceso a varios de los principales modelos lingüísticos de gran tamaño en una plataforma única y segura. Este enfoque no solo reduce los gastos operativos, sino que también simplifica la administración al minimizar los gastos administrativos.

Sin embargo, es importante tener en cuenta que Prompts.ai se centra principalmente en modelos lingüísticos de gran tamaño. Las organizaciones que necesitan herramientas especializadas para la visión artificial o algoritmos de aprendizaje automático tradicionales pueden necesitar integrar recursos adicionales. Al ser una plataforma relativamente nueva, es posible que aún no esté a la altura de las amplias funciones empresariales de los proveedores más establecidos. Dicho esto, su compromiso con la seguridad y el cumplimiento de nivel empresarial sigue evolucionando rápidamente.

La plataforma también fomenta la colaboración al crear una comunidad de ingenieros rápidos y ofrecer una incorporación y una formación integrales. Este enfoque orientado al trabajo en equipo garantiza que los científicos de datos, los ingenieros de aprendizaje automático y las partes interesadas de la empresa puedan colaborar de manera eficaz y, al mismo tiempo, cumplir con estrictos estándares de gobierno y seguridad.

Las estructuras de costos varían significativamente entre estas plataformas. Los proveedores tradicionales como AWS y Google, si bien cuentan con muchos recursos, a veces pueden generar gastos imprevistos. Por el contrario, Prompts.ai ofrece un modelo de precios transparente diseñado para evitar sorpresas en la facturación, lo que lo convierte en una excelente opción para las organizaciones que buscan escalar sus operaciones de IA sin aumentar los costos.

El soporte y la documentación también son diferentes. Si bien plataformas como AWS y Google proporcionan vastos recursos, el enorme volumen de información puede abrumar a los usuarios. Prompts.ai, por otro lado, ofrece documentación específica, foros de usuarios y soporte personalizado diseñado específicamente para flujos de trabajo rápidos de ingeniería y LLM, lo que garantiza que los usuarios tengan la orientación que necesitan sin una complejidad innecesaria.

La selección de la plataforma de IA adecuada se reduce a comprender sus necesidades específicas, la infraestructura existente y las restricciones presupuestarias. Cada plataforma analizada ofrece distintas ventajas adaptadas a los diferentes casos de uso, por lo que es esencial sopesar cuidadosamente las ventajas y desventajas.

Aprendizaje automático de Microsoft Azure es una opción sólida para las empresas que ya han invertido en el ecosistema de Microsoft, gracias a su perfecta integración con herramientas como Office 365 y Power BI. Inteligencia artificial Vertex de Google Cloud brilla para los equipos que hacen hincapié en la investigación de la IA y dependen en gran medida de TensorFlow. Amazon SageMaker es una excelente opción para las organizaciones que requieren una amplia escalabilidad y una gestión integral del ciclo de vida del aprendizaje automático. Mientras tanto, Cara abrazada ha establecido un nuevo estándar en el procesamiento del lenguaje natural con su amplia biblioteca de modelos y su comunidad activa. Para las empresas que utilizan grandes flujos de trabajo basados en modelos lingüísticos, Prompts.ai ofrece una administración optimizada y un ahorro de costos de hasta un 98% al ofrecer acceso a más de 35 LLM líderes a través de una interfaz única y unificada.

Estos conocimientos pueden ayudar a guiar sus pruebas piloto e informar su estrategia de IA a largo plazo. Las empresas con ecosistemas de nube establecidos suelen inclinarse por Azure ML o SageMaker, mientras que las instituciones de investigación y los equipos de colaboración pueden encontrar más atractivo el entorno de Hugging Face. Para las empresas que se centran en la rentabilidad en la gestión de la LLM, los precios transparentes y el enfoque unificado de Prompts.ai lo convierten en una opción atractiva.

A medida que las plataformas de IA siguen evolucionando, es crucial alinear su elección con las necesidades inmediatas y los objetivos futuros. Los proyectos piloto son una forma eficaz de probar la compatibilidad antes de comprometerse con una plataforma en particular.

En última instancia, la mejor plataforma es la que permite a su equipo implementar, monitorear y escalar los modelos de aprendizaje automático de manera eficiente, sin salirse del presupuesto y cumplir con los estándares de cumplimiento. Al adaptar las capacidades de la plataforma a sus desafíos específicos, puede crear una base sólida para una implementación y una gestión eficaces de la IA.

La elección de una plataforma de IA para gestionar los modelos de aprendizaje automático requiere una consideración cuidadosa de varios factores. Comience por identificar las necesidades específicas de su organización. ¿Necesita predicciones en tiempo real, procesamiento por lotes o una combinación de ambos? Asegúrese de que la plataforma ofrezca las funciones de servicio en las que confía, como puntos finales de baja latencia o flujos de trabajo programados, para satisfacer estas demandas.

A continuación, evalúe qué tan bien se integra la plataforma con sus herramientas y marcos existentes. La compatibilidad perfecta con su sistema de aprendizaje automático actual es crucial para evitar interrupciones durante la transición del desarrollo del modelo a la implementación. Además, piense en las opciones de implementación (ya sea que se centre en los entornos de nube, los dispositivos periféricos o una configuración híbrida) y elija una plataforma que se adapte a estos requisitos sin salirse de sus planes de escalabilidad y presupuesto.

Al abordar estos factores, puede encontrar una plataforma que satisfaga sus necesidades técnicas y, al mismo tiempo, mantenga las operaciones eficientes y rentables.

Las estructuras de precios de las plataformas de IA que gestionan modelos de aprendizaje automático (ML) suelen depender de factores como uso, funciones disponibles, y opciones de escalabilidad. Muchas plataformas basan sus tarifas en el consumo de recursos, como las horas de procesamiento, la capacidad de almacenamiento o la cantidad de modelos implementados. Otras ofrecen planes escalonados adaptados a diferentes necesidades, que van desde proyectos a pequeña escala hasta operaciones empresariales de gran tamaño.

Al elegir una plataforma, es fundamental evaluar sus necesidades específicas: la frecuencia con la que planea entrenar los modelos, la escala de la implementación y sus requisitos de monitoreo. Asegúrate de revisar los posibles costes adicionales, como las tarifas por las funciones premium o la superación de los límites de recursos, para evitar sorpresas en tu presupuesto.

Al incorporar una plataforma de IA a tu configuración tecnológica actual, el primer paso es identificar los desafíos que pretendes resolver. Ya sea para mejorar las interacciones con los clientes o para optimizar los flujos de trabajo, tener un enfoque claro guiará sus esfuerzos. A partir de ahí, elabora una estrategia detallada que incluya tus objetivos, las herramientas que necesitarás y un plan para gestionar y supervisar los datos.

Asegúrese de que sus datos internos estén en buen estado: organizados, de fácil acceso y confiables. Esto podría implicar la consolidación de las fuentes de datos y la implementación de prácticas de gobierno sólidas. No pases por alto las consideraciones éticas, como abordar los prejuicios y garantizar la equidad, y piensa en cómo estos cambios podrían afectar a tu equipo. Prioriza tus casos de uso, realiza pruebas exhaustivas en la plataforma y prepara un plan de gestión de cambios sólido. Este enfoque reflexivo le permitirá integrar la IA sin problemas y, al mismo tiempo, mantener bajo control los posibles riesgos.