मशीन लर्निंग (ML) मॉडल को प्रबंधित करना जटिल है, इसके लिए ऐसे टूल की आवश्यकता होती है जो परिनियोजन, निगरानी और संस्करण नियंत्रण को सरल बनाते हैं। इस गाइड में पांच प्रमुख AI प्लेटफार्मों पर प्रकाश डाला गया है - माइक्रोसॉफ्ट एज़्योर मशीन लर्निंग, गूगल क्लाउड वर्टेक्स एआई, अमेज़ॅन सेजमेकर, हगिंग फेस, और Prompts.ai - प्रत्येक को ML वर्कफ़्लो में अद्वितीय चुनौतियों का समाधान करने के लिए डिज़ाइन किया गया है। यहां बताया गया है कि आपको क्या जानना चाहिए:

प्रत्येक प्लेटफ़ॉर्म लागत दक्षता से लेकर स्केलेबिलिटी तक, विशिष्ट आवश्यकताओं को पूरा करता है। निर्णय लेने में आपकी मदद करने के लिए नीचे एक त्वरित तुलना दी गई है।

ऐसा प्लेटफ़ॉर्म चुनें जो आपके तकनीकी लक्ष्यों, बुनियादी ढांचे और बजट के अनुरूप हो। स्केलिंग से पहले अनुकूलता का मूल्यांकन करने के लिए पायलट प्रोजेक्ट के साथ छोटी शुरुआत करें।

माइक्रोसॉफ्ट एज़्योर मशीन लर्निंग एक क्लाउड-आधारित प्लेटफ़ॉर्म है जिसे मशीन लर्निंग (ML) मॉडल के प्रबंधन की चुनौतियों से निपटने के लिए डिज़ाइन किया गया है। यह Microsoft के टूल और सेवाओं के व्यापक इकोसिस्टम के साथ समेकित रूप से एकीकृत करते हुए ML जीवनचक्र के हर चरण का समर्थन करता है।

Azure ML पूरे मॉडल जीवनचक्र को एक के साथ सरल बनाता है केंद्रीकृत रजिस्ट्री जो स्वचालित रूप से मॉडल वंशावली को ट्रैक करता है, जिसमें डेटासेट, कोड और हाइपरपैरामीटर शामिल हैं। इसकी स्वचालित पाइपलाइनें डेटा तैयार करने से लेकर परिनियोजन तक सब कुछ प्रबंधित करती हैं, जिससे चरणों के बीच सहज बदलाव सुनिश्चित होता है।

मंच चमकता है प्रयोग ट्रैकिंग, इसके अंतर्निहित MLFlow एकीकरण के लिए धन्यवाद। यह सुविधा डेटा वैज्ञानिकों को स्वचालित रूप से मेट्रिक्स, मापदंडों और कलाकृतियों को लॉग करने की अनुमति देती है, जिससे मॉडल संस्करणों की तुलना करना और सफल प्रयोगों को पुन: पेश करना आसान हो जाता है। यह सपोर्ट भी करता है उत्पादन में A/B परीक्षण, रीयल-टाइम प्रदर्शन की निगरानी करते हुए क्रमिक रोलआउट को सक्षम करना।

मॉडल फ़ाइलों को ट्रैक करने के अलावा, Azure ML संस्करण नियंत्रण प्रदान करता है पर्यावरण कॉन्फ़िगरेशन, गणना लक्ष्य, और परिनियोजन सेटिंग। यह सुनिश्चित करता है कि मॉडल को विकास के चरणों में मज़बूती से पुन: पेश किया जा सके। इसके अतिरिक्त, स्नैपशॉट सुविधा एक प्रयोग के हर विवरण को कैप्चर करती है, जिसमें कोड, निर्भरता और डेटा संस्करण शामिल हैं।

इस तरह का व्यापक जीवनचक्र प्रबंधन Azure ML को स्केलेबल परिनियोजन और मौजूदा वर्कफ़्लो में सहज एकीकरण के लिए एक मजबूत विकल्प बनाता है।

Azure ML इसके साथ अलग-अलग कम्प्यूटेशनल जरूरतों को पूरा करता है ऑटो-स्केलिंग सुविधा, जो कोड संशोधनों की आवश्यकता के बिना, सिंगल-नोड प्रशिक्षण से वितरित GPU क्लस्टर तक संसाधनों को गतिशील रूप से समायोजित करता है। यह लचीलापन विभिन्न ML वर्कलोड को संभालने वाले संगठनों के लिए विशेष रूप से फायदेमंद है।

प्लेटफ़ॉर्म आसानी से एकीकृत हो जाता है Azure DevOps और GitHub, टीमों को निरंतर एकीकरण और वितरण (CI/CD) वर्कफ़्लो को स्वचालित करने में सक्षम बनाता है। उदाहरण के लिए, जब भी नया डेटा उपलब्ध होता है या कोड परिवर्तन किए जाते हैं, तो मॉडल को फिर से प्रशिक्षित करने के लिए पाइपलाइनों को ट्रिगर किया जा सकता है। इसके अतिरिक्त, Azure ML सीधे किससे जुड़ता है कार्रवाई योग्य जानकारी के लिए Power BI और एज़्योर सिनैप्स एनालिटिक्स डेटा प्रोसेसिंग के लिए, एक समेकित डेटा और AI पारिस्थितिकी तंत्र का निर्माण करना।

Azure ML भी समर्थन करता है मल्टी-क्लाउड परिनियोजन, एज़्योर पर प्रशिक्षित मॉडल को अन्य क्लाउड प्लेटफ़ॉर्म या यहां तक कि ऑन-प्रिमाइसेस इन्फ्रास्ट्रक्चर पर तैनात करने की अनुमति देता है। यह क्षमता संगठनों को अलग-अलग परिवेशों में लगातार मॉडल प्रबंधन बनाए रखते हुए वेंडर लॉक-इन से बचने में मदद करती है।

एज़्योर एमएल एक प्रदान करता है पे-एज़-यू-गो प्राइसिंग मॉडल, कंप्यूट, स्टोरेज और विशिष्ट सेवाओं के लिए अलग-अलग शुल्कों के साथ। गणना की लागत लगभग से लेकर होती है सीपीयू इंस्टेंस के लिए $0.10 प्रति घंटे से हाई-एंड जीपीयू के लिए $3.00 प्रति घंटे से अधिक। पूर्वानुमेय कार्यभार के लिए, आरक्षित उदाहरण 72% तक की बचत प्रदान कर सकते हैं।

लागतों को प्रबंधित करने में मदद करने के लिए, Azure ML में शामिल हैं स्वचालित गणना प्रबंधन, जो निष्क्रिय संसाधनों को बंद कर देता है और मांग के आधार पर उपयोग को बढ़ाता है। प्लेटफ़ॉर्म विस्तृत लागत ट्रैकिंग और बजट टूल भी प्रदान करता है, जिससे टीमें खर्च करने की सीमा निर्धारित कर सकती हैं और उन थ्रेसहोल्ड तक पहुंचने पर अलर्ट प्राप्त कर सकती हैं।

भंडारण लागत आम तौर पर होती है $0.02-$0.05 प्रति जीबी प्रति माह, हालांकि क्षेत्रों के बीच बड़े डेटासेट को स्थानांतरित करने वाले संगठनों को संभावित डेटा ट्रांसफर खर्चों के प्रति सचेत रहना चाहिए।

Microsoft व्यापक संसाधनों के साथ Azure ML का समर्थन करता है, जिसमें Microsoft Learn के माध्यम से विस्तृत दस्तावेज़ीकरण, व्यावहारिक प्रयोगशालाएँ और प्रमाणन कार्यक्रम शामिल हैं। प्लेटफ़ॉर्म सक्रिय सामुदायिक फ़ोरम से लाभान्वित होता है और इसे प्राप्त करता है नई सुविधाओं के साथ त्रैमासिक अपडेट।

उद्यमों के लिए, Microsoft मजबूत समर्थन विकल्प प्रदान करता है, जिसमें 24/7 तकनीकी सहायता, गारंटीकृत प्रतिक्रिया समय और समर्पित ग्राहक सफलता प्रबंधकों तक पहुंच शामिल है। संगठन इसका फ़ायदा भी उठा सकते हैं पेशेवर परामर्श सेवाएँ उनकी आवश्यकताओं के अनुरूप एमएल वर्कफ़्लो को डिज़ाइन और कार्यान्वित करने के लिए।

Azure ML लोकप्रिय ढांचे का समर्थन करता है जैसे PyTorch, TensorFlow, और स्किकिट-लर्न और ऑफ़र पूर्व-निर्मित समाधान त्वरक मांग पूर्वानुमान और भविष्य कहनेवाला रखरखाव जैसे कार्यों के लिए। ये टूल वर्कफ़्लो को सरल बनाने और ML मॉडल प्रबंधन को अधिक कुशल बनाने के लिए डिज़ाइन किए गए हैं।

Google Cloud Vertex AI मशीन लर्निंग मॉडल प्रबंधन सुविधाओं को एक ही प्लेटफ़ॉर्म में लाता है, जो AutoML और AI प्लेटफ़ॉर्म की खूबियों को मिलाता है। इसे एंटरप्राइज़-स्तरीय स्केलेबिलिटी और प्रदर्शन प्रदान करते हुए ML वर्कफ़्लो को सरल बनाने के लिए डिज़ाइन किया गया है।

वर्टेक्स एआई एक प्रदान करता है एकीकृत ML प्लेटफ़ॉर्म जो डेटा तैयार करने से लेकर परिनियोजन तक, पूरे मॉडल जीवनचक्र को सुव्यवस्थित करता है। यह है मॉडल रजिस्ट्री संस्करणों, वंशावली और मेटाडेटा को ट्रैक करता है, जिससे समय के साथ मॉडल के प्रदर्शन की तुलना करना और उसका मूल्यांकन करना आसान हो जाता है।

प्लेटफ़ॉर्म में उत्पादन प्रदर्शन को ट्रैक करने और डेटा ड्रिफ्ट जैसे मुद्दों के प्रति टीमों को सचेत करने के लिए निरंतर निगरानी उपकरण शामिल हैं। यह सपोर्ट करता है कस्टम ट्रेनिंग TensorFlow, PyTorch, और जैसे फ्रेमवर्क के साथ XGBoost, जबकि पेशकश भी करते हैं AutoML विकल्प उन लोगों के लिए जो नो-कोड समाधान पसंद करते हैं। साथ में पाइपलाइन ऑर्केस्ट्रेशन, टीमें प्रतिलिपि प्रस्तुत करने योग्य वर्कफ़्लो बना सकती हैं जो लगातार प्रक्रियाओं को सुनिश्चित करते हुए स्वचालित रूप से या ऑन-डिमांड चलते हैं। द फ़ीचर स्टोर प्रशिक्षण और परिनियोजन वातावरण में समान रूप से सुविधाओं का प्रबंधन और सेवा करके विश्वसनीयता को बढ़ाता है, जिससे विसंगतियों का जोखिम कम होता है।

इन क्षमताओं से टीमों के लिए अपने प्रयासों को बढ़ाना और मौजूदा वर्कफ़्लो में निर्बाध रूप से एकीकृत करना आसान हो जाता है।

Google के मजबूत बुनियादी ढांचे पर निर्मित, Vertex AI कस्टम मशीन कॉन्फ़िगरेशन और प्रीमेप्टिबल इंस्टेंस का समर्थन करता है, जो प्रदर्शन और लागत के बीच संतुलन प्रदान करता है। इसकी ऑटो-स्केलिंग क्षमताएं सिंगल-नोड से डिस्ट्रिब्यूटेड ट्रेनिंग सेटअप में सहज बदलाव की अनुमति देती हैं।

Vertex AI Google Cloud के डेटा इकोसिस्टम के साथ आसानी से एकीकृत हो जाता है, जिसमें शामिल हैं BigQuery, क्लाउड स्टोरेज, और डेटाफ़्लो। द वर्टेक्स एआई वर्कबेंच पूर्व-कॉन्फ़िगर किए गए वातावरण के साथ प्रबंधित जुपिटर नोटबुक प्रदान करता है, जबकि वर्टेक्स एआई पाइपलाइन का उपयोग करके एमएल वर्कफ़्लो के निर्माण और परिनियोजन को सरल बनाता है क्यूबफ्लो पाइपलाइन।

अनुमान के लिए, प्लेटफ़ॉर्म प्रदान करता है ऑनलाइन भविष्यवाणी के समापन बिंदु स्वचालित लोड संतुलन और स्केलिंग के साथ-साथ बैच की भविष्यवाणी वितरित संसाधनों में बड़े पैमाने पर अनुमान कार्यों को कुशलतापूर्वक संभालने के विकल्प।

वर्टेक्स एआई पे-एज़-यू-गो प्राइसिंग मॉडल पर काम करता है, जिसमें प्रशिक्षण, भविष्यवाणी और स्टोरेज के लिए अलग-अलग शुल्क लगते हैं। लागत उदाहरण के प्रकार, प्रदर्शन की ज़रूरतों और उपयोग की अवधि जैसे कारकों पर निर्भर करती है। यह कई लागत-बचत विकल्प प्रदान करता है, जिसमें निरंतर उपयोग छूट, गलती-सहनशील वर्कलोड के लिए प्रीमेप्टिबल इंस्टेंस और पूर्वानुमेय उपयोग पैटर्न के लिए प्रतिबद्ध उपयोग छूट शामिल हैं। एकीकृत लागत निगरानी उपकरण टीमों को अपने बजट को प्रभावी ढंग से प्रबंधित करने में मदद करते हैं।

Google Vertex AI उपयोगकर्ताओं के लिए व्यापक संसाधन प्रदान करता है, जिसमें Google Cloud Skills Boost के माध्यम से विस्तृत दस्तावेज़ीकरण, हैंड्स-ऑन लैब और प्रमाणन कार्यक्रम शामिल हैं। प्लेटफ़ॉर्म को एक जीवंत डेवलपर समुदाय से लाभ मिलता है और नवीनतम प्रगति के साथ जुड़े रहने के लिए लगातार अपडेट किए जाते हैं।

एंटरप्राइज़ उपयोगकर्ताओं के पास समस्या की गंभीरता के आधार पर गारंटीकृत प्रतिक्रिया समय के साथ 24/7 सहायता तक पहुंच है। पेशेवर सेवाएँ भी उपलब्ध हैं, ताकि संगठनों को ML रणनीतियों को डिज़ाइन करने और लागू करने में मदद मिल सके, खासकर बड़े पैमाने पर तैनाती के लिए।

Vertex AI व्यापक रूप से उपयोग किए जाने वाले ओपन-सोर्स फ्रेमवर्क का समर्थन करता है और प्रयोग ट्रैकिंग और विज़ुअलाइज़ेशन के लिए MLFlow और TensorBoard जैसे टूल के साथ एकीकृत करता है। इसके अतिरिक्त, Google का AI हब पूर्व-प्रशिक्षित मॉडल और पाइपलाइन टेम्पलेट प्रदान करता है, जिससे टीमें सामान्य ML उपयोग के मामलों के लिए विकास में तेजी ला सकती हैं। स्टैक ओवरफ़्लो जैसे सामुदायिक फ़ोरम और प्लेटफ़ॉर्म सहायता प्रणाली को और बढ़ाते हैं, जबकि Google के अनुसंधान और सर्वोत्तम प्रथाओं के प्रकाशन यह सुनिश्चित करते हैं कि टीमें मशीन लर्निंग में उभरते रुझानों के बारे में सूचित रहें।

Amazon SageMaker AWS का ऑल-इन-वन मशीन लर्निंग प्लेटफ़ॉर्म है जिसे डेटा वैज्ञानिकों और ML इंजीनियरों को बड़े पैमाने पर मॉडल बनाने, प्रशिक्षित करने और तैनात करने में मदद करने के लिए डिज़ाइन किया गया है। AWS के वैश्विक बुनियादी ढांचे पर निर्मित, SageMaker स्केलेबल परिनियोजन विकल्पों के साथ मॉडल प्रबंधन के लिए शक्तिशाली टूल को जोड़ता है, जिससे यह उद्यमों के लिए एक उपयोगी समाधान बन जाता है।

SageMaker मशीन लर्निंग मॉडल के संपूर्ण जीवनचक्र को प्रबंधित करने के लिए उपकरणों का एक पूरा सूट प्रदान करता है। इसके मूल में यह है सेजमेकर मॉडल रजिस्ट्री, एक केंद्रीकृत हब जहां टीमें अपने मॉडलों की वंशावली को सूचीबद्ध, संस्करण और ट्रैक कर सकती हैं। इस रिपॉजिटरी में मेटाडेटा और परफ़ॉर्मेंस मेट्रिक्स, वर्शन तुलनाओं को सरल बनाना और ज़रूरत पड़ने पर क्विक रोलबैक को सक्षम करना शामिल है।

साथ में सेजमेकर स्टूडियो, उपयोगकर्ता जुपिटर नोटबुक तक पहुंच सकते हैं, प्रयोगों को ट्रैक कर सकते हैं और वर्कफ़्लो को डिबग कर सकते हैं। इस बीच, सेजमेकर प्रयोग ट्रैकिंग और रिफाइनिंग मॉडल की प्रक्रिया को सुव्यवस्थित करते हुए स्वचालित रूप से प्रशिक्षण रन, हाइपरपैरामीटर और परिणाम लॉग करता है।

यह सुनिश्चित करने के लिए कि मॉडल उत्पादन में अच्छा प्रदर्शन करें, सेजमेकर मॉडल मॉनिटर डेटा की गुणवत्ता, बहाव और पूर्वाग्रह पर नज़र रखता है, प्रदर्शन में गिरावट आने पर या आने वाले डेटा में काफी विचलन होने पर अलर्ट जारी करता है। सेजमेकर पाइपलाइन डेटा प्रोसेसिंग से लेकर परिनियोजन तक, संपूर्ण वर्कफ़्लो को स्वचालित करता है, जिससे विकास प्रक्रिया के दौरान स्थिरता और विश्वसनीयता सुनिश्चित होती है।

SageMaker संसाधनों को कुशलता से स्केल करने की अपनी क्षमता के लिए सबसे अलग है। AWS के इलास्टिक इन्फ्रास्ट्रक्चर का लाभ उठाकर, यह सबसे अधिक मांग वाले ML वर्कलोड को भी संभाल सकता है। प्लेटफ़ॉर्म सपोर्ट करता है वितरित प्रशिक्षण कई उदाहरणों में, बड़े डेटासेट और जटिल मॉडल के लिए समानांतर प्रसंस्करण को सरल बनाना। साथ में सेजमेकर ट्रेनिंग जॉब्स, संसाधनों को एक उदाहरण से सैकड़ों मशीनों तक बढ़ाया जा सकता है, स्वचालित रूप से आवश्यकतानुसार संसाधनों का प्रावधान और रिलीज किया जा सकता है।

अन्य AWS सेवाओं के साथ एकीकरण SageMaker को और भी शक्तिशाली बनाता है। उदाहरण के लिए, सेजमेकर फ़ीचर स्टोर मशीन लर्निंग सुविधाओं के लिए एक केंद्रीकृत भंडार के रूप में कार्य करता है, जो परियोजनाओं में सुविधाओं के पुन: उपयोग को सक्षम करते हुए प्रशिक्षण और अनुमान के बीच स्थिरता सुनिश्चित करता है।

परिनियोजन के लिए, सेजमेकर एंडपॉइंट्स ट्रैफ़िक पैटर्न के आधार पर स्वचालित स्केलिंग के साथ रीयल-टाइम अनुमान प्रदान करें। प्लेटफ़ॉर्म भी समर्थन करता है मल्टी-मॉडल एंडपॉइंट्स, संसाधन दक्षता को अधिकतम करने और लागत को कम करने के लिए कई मॉडलों को एक ही एंडपॉइंट पर चलाने की अनुमति देता है। बैच प्रोसेसिंग के लिए, सेजमेकर बैच ट्रांसफ़ॉर्म वितरित कंप्यूटिंग संसाधनों का उपयोग करके बड़े अनुमान कार्यों को कुशलता से संभालता है।

SageMaker प्रशिक्षण, होस्टिंग और डेटा प्रोसेसिंग के लिए अलग-अलग शुल्कों के साथ AWS के पे-एज़-यू-गो मॉडल का उपयोग करता है। प्रशिक्षण की लागत उदाहरण के प्रकार और अवधि पर निर्भर करती है, जिसमें स्पॉट इंस्टेंस ऑन-डिमांड दरों की तुलना में 90% तक की बचत की पेशकश।

पूर्वानुमेय कार्यभार के लिए, सेविंग प्लान प्रतिबद्ध उपयोग के लिए 64% तक की छूट प्रदान करें। लागतों को और अधिक अनुकूलित करने के लिए, सेजमेकर इंफ़रेंस रिकमेंडर विभिन्न इंस्टेंस प्रकारों और कॉन्फ़िगरेशन का परीक्षण करता है, जिससे टीमों को प्रदर्शन का त्याग किए बिना सबसे अधिक लागत प्रभावी परिनियोजन सेटअप खोजने में मदद मिलती है।

एंडपॉइंट्स से लैस स्वचालित स्केलिंग सुनिश्चित करें कि यूज़र केवल उन कंप्यूट संसाधनों के लिए भुगतान करें जिनकी उन्हें आवश्यकता है। कम ट्रैफ़िक अवधि के दौरान संसाधन कम हो जाते हैं और मांग बढ़ने पर उनमें तेज़ी आती है। इसके अतिरिक्त, SageMaker ट्रैकिंग और बजट बनाने के लिए टूल प्रदान करता है, जिससे टीमों को अपने ML खर्च पर बेहतर नियंत्रण मिलता है।

Amazon SageMaker उपयोगकर्ताओं को संसाधनों की अधिकता से लाभ होता है, जिसमें विस्तृत दस्तावेज़ीकरण, व्यावहारिक ट्यूटोरियल और AWS मशीन लर्निंग यूनिवर्सिटी, जो मुफ्त पाठ्यक्रम और प्रमाणपत्र प्रदान करता है। प्लेटफ़ॉर्म एक जीवंत डेवलपर समुदाय द्वारा समर्थित है और लगातार अपडेट किए जाते हैं जो मशीन लर्निंग में नवीनतम प्रगति के साथ संरेखित होते हैं।

एंटरप्राइज़ ग्राहकों के लिए, AWS सपोर्ट महत्वपूर्ण मुद्दों के लिए 24/7 फ़ोन सहायता से लेकर व्यावसायिक घंटों के दौरान सामान्य मार्गदर्शन तक, स्तरीय सहायता प्रदान करता है। इसके अतिरिक्त, AWS व्यावसायिक सेवाएँ बड़े पैमाने पर या जटिल एमएल परियोजनाओं के लिए परामर्श और कार्यान्वयन सहायता प्रदान करता है।

SageMaker जैसे लोकप्रिय ओपन-सोर्स फ्रेमवर्क का समर्थन करता है टेंसरफ़्लो, PyTorch, स्किकिट-लर्न, और XGBoost पूर्व-निर्मित कंटेनरों के माध्यम से, जबकि विशिष्ट आवश्यकताओं के लिए कस्टम कंटेनरों की अनुमति भी दी जाती है। द AWS मशीन लर्निंग ब्लॉग नियमित रूप से सर्वोत्तम प्रथाओं, केस स्टडी और गहन तकनीकी गाइड को साझा करता है। सामुदायिक फ़ोरम और इवेंट जैसे AWS फिर से: आविष्कार करें शुरुआती और अनुभवी पेशेवरों दोनों के लिए समान रूप से सीखने और नेटवर्किंग के लिए और अवसर प्रदान करें।

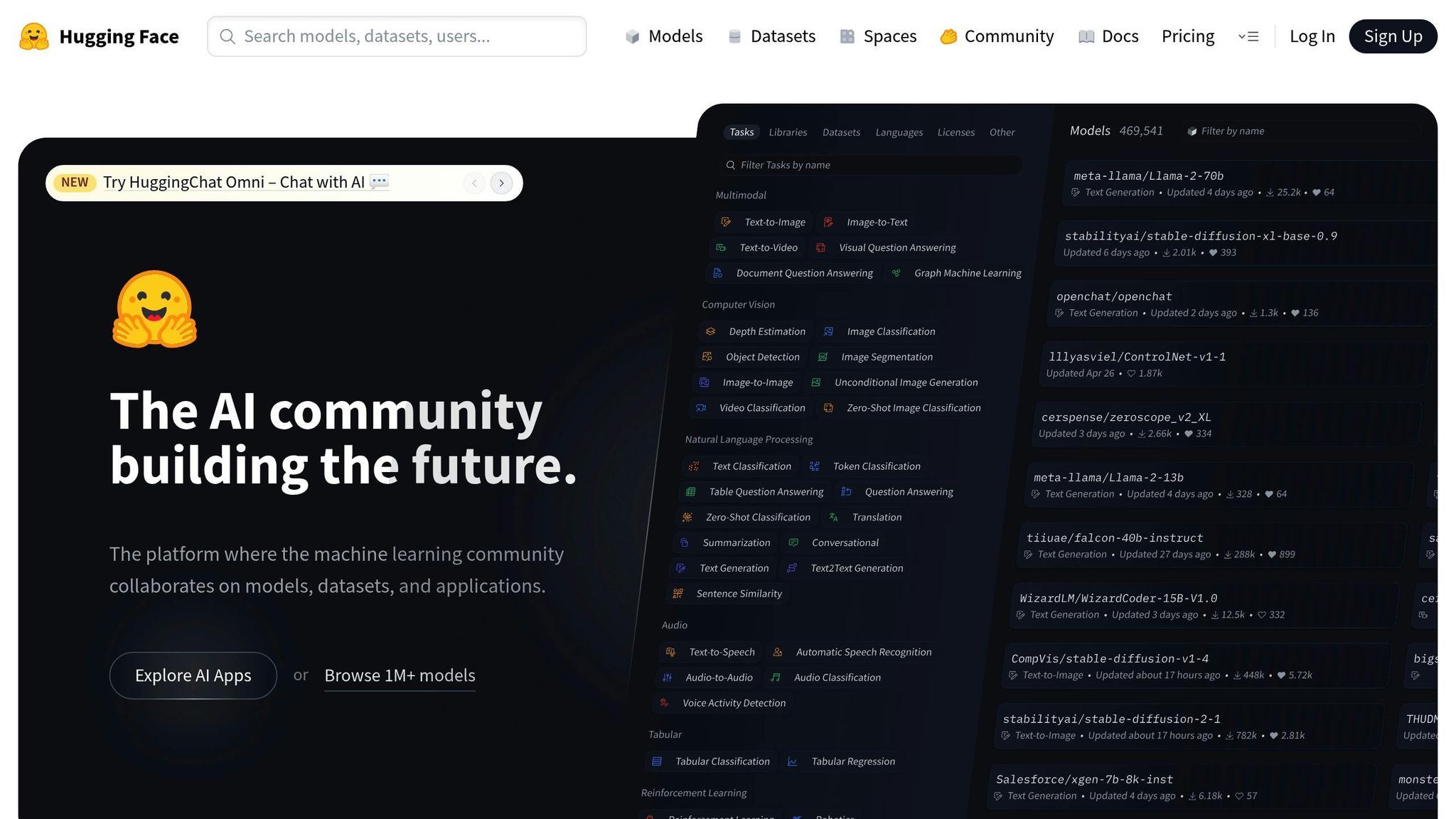

हगिंग फेस उपयोगकर्ताओं को मशीन लर्निंग टूल का एक व्यापक सूट प्रदान करता है। हालांकि यह मूल रूप से प्राकृतिक भाषा प्रसंस्करण पर केंद्रित था, लेकिन इसने कंप्यूटर विज़न, ऑडियो प्रोसेसिंग और मल्टीमॉडल अनुप्रयोगों को शामिल करने के लिए अपनी क्षमताओं का विस्तार किया है। इस विकास ने इसे मशीन लर्निंग मॉडल के प्रबंधन और तैनाती के लिए एक लोकप्रिय मंच बना दिया है।

हगिंग फेस हब पूर्व-प्रशिक्षित मॉडल, डेटासेट और इंटरैक्टिव डेमो के लिए एक केंद्रीकृत रिपॉजिटरी के रूप में कार्य करता है। प्रत्येक मॉडल रिपॉजिटरी में एक विस्तृत मॉडल कार्ड शामिल होता है, जो प्रशिक्षण प्रक्रिया, संभावित उपयोग के मामलों, सीमाओं और नैतिक विचारों को रेखांकित करता है, जिससे मॉडल के जीवनचक्र के हर चरण में पारदर्शिता सुनिश्चित होती है। हगिंग फेस ट्रांसफ़ॉर्मर्स लाइब्रेरी वर्कफ़्लो को और सरल बनाती है, जिससे यूज़र GIT-आधारित संस्करण नियंत्रण का उपयोग करके मॉडल को आसानी से लोड, फाइन-ट्यून और अपडेट कर सकते हैं।

जब परिनियोजन की बात आती है, तो हगिंग फेस इन्फरेंस एंडपॉइंट एक सहज समाधान प्रदान करते हैं। ये एंडपॉइंट ऑटोमैटिक स्केलिंग, CPU/GPU मॉनिटरिंग को हैंडल करते हैं और एरर लॉगिंग के साथ-साथ परफॉरमेंस मेट्रिक्स भी प्रदान करते हैं। यह सेटअप टीमों को यह मूल्यांकन करने में मदद करता है कि मॉडल वास्तविक दुनिया के परिदृश्यों में कैसा प्रदर्शन करते हैं, जिससे विकास से उत्पादन तक सहज बदलाव सुनिश्चित होता है।

हगिंग फेस अपनी एक्सेलेरेट लाइब्रेरी के माध्यम से मजबूत स्केलेबिलिटी प्रदान करता है, जो कई जीपीयू और मशीनों में वितरित प्रशिक्षण का समर्थन करता है। यह लोकप्रिय डीप लर्निंग फ्रेमवर्क जैसे कि PyTorch, TensorFlow, और के साथ सहज रूप से एकीकृत होता है जैक्स, जो इसे विविध वर्कफ़्लोज़ के अनुकूल बनाता है। इसके अतिरिक्त, डेटासेट लाइब्रेरी डेटासेट की एक विस्तृत श्रृंखला तक पहुंच प्रदान करती है, जो प्रीप्रोसेसिंग और स्ट्रीमिंग के लिए टूल के साथ पूर्ण होती है, जिससे डेटा पाइपलाइनों को अनुकूलित करने में मदद मिलती है।

मॉडल दिखाने और फीडबैक इकट्ठा करने के लिए, हगिंग फेस स्पेस एक असाधारण विशेषता है। जैसे टूल का उपयोग करना ग्रैडियो या स्ट्रीमलाइट, उपयोगकर्ता आसानी से इंटरैक्टिव डेमो और एप्लिकेशन बना सकते हैं। इन डेमो को निरंतर एकीकरण वर्कफ़्लो में एकीकृत किया जा सकता है, जिससे हितधारकों की सहभागिता और पुनरावृत्ति को सरल बनाया जा सकता है।

हगिंग फेस अपने जीवंत ओपन-सोर्स समुदाय पर पनपता है, जहां यूज़र सक्रिय रूप से मॉडल, डेटासेट और एप्लिकेशन साझा करते हैं। प्लेटफ़ॉर्म एक निःशुल्क शैक्षिक पाठ्यक्रम भी प्रदान करता है जिसमें ट्रांसफ़ॉर्मर्स की मूल बातें से लेकर उन्नत फ़ाइन-ट्यूनिंग तकनीकों तक सब कुछ शामिल है। एंटरप्राइज़ क्लाइंट्स के लिए, हगिंग फेस निजी मॉडल रिपॉजिटरी, बेहतर सुरक्षा सुविधाएँ और समर्पित सहायता प्रदान करता है, जिससे संगठनों को प्लेटफ़ॉर्म के शक्तिशाली टूल का लाभ उठाते हुए मालिकाना मॉडल का प्रबंधन करने में मदद मिलती है।

हगिंग फेस एक फ्रीमियम मॉडल पर काम करता है। व्यक्ति और छोटी टीमें बिना किसी लागत के सार्वजनिक रिपॉजिटरी और सामुदायिक सुविधाओं का उपयोग कर सकती हैं। जिन लोगों को प्रबंधित परिनियोजन, अतिरिक्त संग्रहण या उन्नत सहायता की आवश्यकता होती है, उनके लिए प्लेटफ़ॉर्म विशिष्ट आवश्यकताओं और उपयोग स्तरों के अनुसार अनुकूलित मूल्य निर्धारण के साथ सशुल्क प्लान प्रदान करता है।

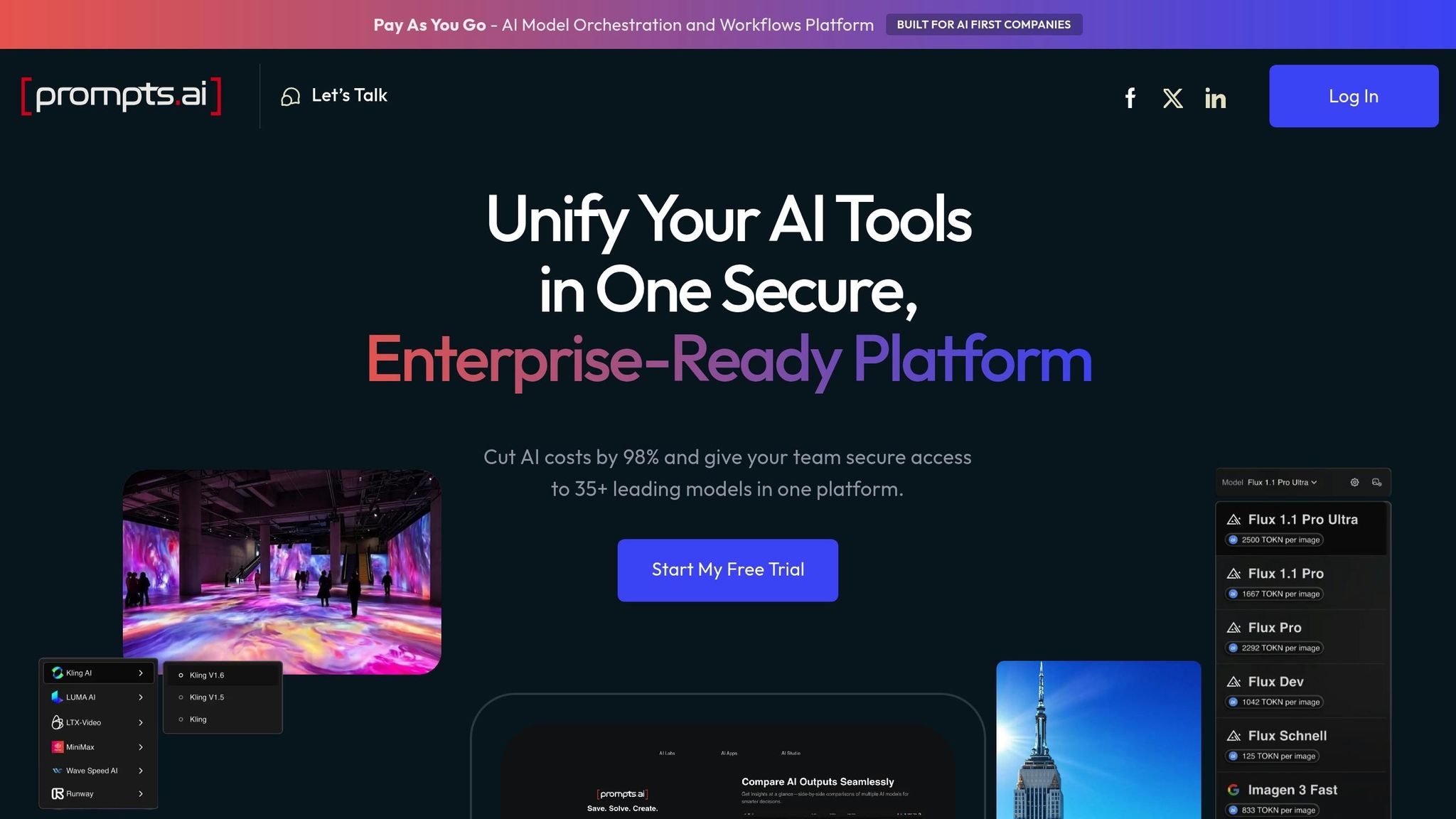

Prompts.ai 35 से अधिक बड़े भाषा मॉडल को एक सुरक्षित, सुव्यवस्थित प्लेटफ़ॉर्म में लाता है। विशेष रूप से किसके लिए बनाया गया शीघ्र प्रबंधन और LLMOps, यह प्रॉम्प्ट के प्रबंधन और अनुकूलन के लिए उत्पादन के लिए तैयार वातावरण प्रदान करता है।

Prompts.ai मॉडल के संपूर्ण जीवनचक्र के प्रबंधन के लिए उपकरणों का एक पूरा सूट प्रदान करता है, जिस पर ध्यान दिया जाता है प्रॉम्प्ट वर्जनिंग और ट्रैकिंग। यह उपयोगकर्ताओं को संस्करण प्रॉम्प्ट करने, परिवर्तनों को वापस लाने और उन्नत संस्करण नियंत्रण प्रणालियों के माध्यम से पुनरुत्पादन सुनिश्चित करने की अनुमति देता है।

प्लेटफ़ॉर्म में पूर्वानुमान सटीकता, विलंबता और डेटा बहाव जैसे प्रमुख मैट्रिक्स को ट्रैक करने के लिए स्वचालित निगरानी की सुविधा है। उपयोगकर्ता प्रदर्शन समस्याओं या विसंगतियों को शीघ्रता से हल करने के लिए कस्टम अलर्ट कॉन्फ़िगर कर सकते हैं, जिससे उत्पादन वातावरण में भी सुचारू संचालन सुनिश्चित होता है। यह निगरानी विशेष रूप से त्वरित बहाव जैसी चुनौतियों से निपटने और लगातार प्रदर्शन बनाए रखने के लिए उपयोगी है।

उदाहरण के लिए, अमेरिका में एक हेल्थकेयर एनालिटिक्स कंपनी ने सटीकता ट्रैकिंग में सुधार करते हुए मॉडल परिनियोजन समय में 40% की कटौती करने के लिए Prompts.ai का उपयोग किया। इससे रोगी को बेहतर परिणाम मिले और अनुपालन रिपोर्टिंग अधिक कुशल हुई।

ये जीवनचक्र उपकरण स्केलेबल और विश्वसनीय तैनाती का समर्थन करने के लिए डिज़ाइन किए गए हैं।

Prompts.ai लोकप्रिय मशीन लर्निंग फ्रेमवर्क के साथ आसानी से एकीकृत हो जाता है, जिसमें शामिल हैं TensorFlow, PyTorch, और scikit-learn, साथ ही AWS, Azure और Google Cloud जैसे प्रमुख क्लाउड प्लेटफ़ॉर्म। यह उच्च मांग वाले परिदृश्यों के लिए ऑटोस्केलिंग के साथ स्केलेबल तैनाती का समर्थन करता है और कंटेनर ऑर्केस्ट्रेशन सिस्टम जैसे कंटेनर ऑर्केस्ट्रेशन सिस्टम के साथ काम करता है कुबेरनेट्स।

मॉडल चयन, शीघ्र वर्कफ़्लो, लागत प्रबंधन और प्रदर्शन तुलनाओं को एक ही प्लेटफ़ॉर्म में समेकित करके, Prompts.ai कई टूल की आवश्यकता को समाप्त करता है। एंटरप्राइज़-स्तरीय सुरक्षा और अनुपालन को बनाए रखते हुए, यह एकीकृत दृष्टिकोण AI सॉफ़्टवेयर की लागत को 98% तक कम कर सकता है।

Prompts.ai सहयोग को बढ़ावा देकर तकनीकी क्षमताओं से आगे निकल जाता है। यह इस तरह की सुविधाएँ प्रदान करता है साझा कार्यस्थान, भूमिका-आधारित अभिगम नियंत्रण, और एकीकृत टिप्पणी के ऊपर मॉडल कलाकृतियाँ, जिससे डेटा वैज्ञानिकों और एमएल इंजीनियरों के लिए प्रभावी ढंग से सहयोग करना आसान हो जाता है। ये उपकरण मॉडल विकास जीवनचक्र के दौरान पारदर्शिता और टीम वर्क सुनिश्चित करते हैं।

प्लेटफ़ॉर्म व्यापक संसाधन भी प्रदान करता है, जिसमें व्यापक दस्तावेज़ीकरण, उपयोगकर्ता फ़ोरम और प्रत्यक्ष समर्थन शामिल हैं। एंटरप्राइज़ ग्राहकों को समर्पित खाता प्रबंधकों और जटिल कार्यान्वयनों को संभालने के लिए प्राथमिकता समर्थन से लाभ होता है। इसके अतिरिक्त, Prompts.ai एक सक्रिय उपयोगकर्ता समुदाय का समर्थन करता है, जहां सदस्य सर्वोत्तम प्रथाओं का आदान-प्रदान कर सकते हैं और विशेषज्ञ की सलाह ले सकते हैं।

Prompts.ai पे-एज़-यू-गो TOKN क्रेडिट सिस्टम पर काम करता है। व्यक्तिगत योजनाएँ बिना किसी लागत के शुरू होती हैं और $29 या $99 प्रति माह तक होती हैं, जबकि व्यावसायिक योजनाएँ $99 से $129 प्रति सदस्य/माह तक होती हैं। प्लेटफ़ॉर्म का उपयोग-आधारित बिलिंग मॉडल लंबी अवधि की प्रतिबद्धताओं से बचता है, जिसमें वार्षिक योजनाओं में 10% की छूट दी जाती है।

यह मूल्य निर्धारण संरचना विशेष रूप से अमेरिका स्थित संगठनों के लिए आकर्षक है जो लचीलेपन और लागत नियंत्रण की तलाश में हैं। Prompts.ai के रियल-टाइम FinOps टूल खर्च में पूरी दृश्यता प्रदान करते हैं, उपयोग किए जाने वाले प्रत्येक टोकन को मापने योग्य व्यावसायिक परिणामों से जोड़ते हैं।

यह अनुभाग आपकी मशीन लर्निंग (ML) मॉडल प्रबंधन रणनीति को परिष्कृत करने में मदद करने के लिए प्रत्येक प्लेटफ़ॉर्म की ताकत और चुनौतियों को एक साथ लाता है। उनकी विशेषताओं की तुलना करके, आप अपनी पसंद को अपनी विशिष्ट आवश्यकताओं, बजट और तकनीकी लक्ष्यों के साथ संरेखित कर सकते हैं।

माइक्रोसॉफ्ट एज़्योर मशीन लर्निंग माइक्रोसॉफ्ट इकोसिस्टम में पहले से एम्बेडेड संगठनों के लिए एक स्टैंडआउट है। Office 365 और Power BI जैसे टूल के साथ इसका एकीकरण एक सुव्यवस्थित वर्कफ़्लो सुनिश्चित करता है। हालांकि, ये लाभ प्रीमियम पर आते हैं, क्योंकि लागत तेजी से बढ़ सकती है, खासकर छोटी टीमों के लिए। इसके अतिरिक्त, Azure से अपरिचित लोगों के लिए प्लेटफ़ॉर्म की सीखने की अवस्था कठिन हो सकती है।

गूगल क्लाउड वर्टेक्स एआई अपनी उन्नत AutoML क्षमताओं और Google के अत्याधुनिक AI अनुसंधान के साथ घनिष्ठ संबंधों के साथ चमकता है। यह TensorFlow और मजबूत डेटा एनालिटिक्स टूल के लिए उत्कृष्ट समर्थन प्रदान करता है। हालांकि, Google फ़्रेमवर्क पर इसकी निर्भरता लचीलेपन को सीमित करती है, और इसकी कीमत संरचना भ्रमित करने वाली हो सकती है, जिससे कभी-कभी अप्रत्याशित शुल्क भी लग सकते हैं।

अमेज़ॅन सेजमेकर संपूर्ण एमएल जीवनचक्र के प्रबंधन के लिए अद्वितीय स्केलेबिलिटी और उपकरणों का एक व्यापक सूट प्रदान करता है। इसका पे-एज़-यू-गो मॉडल बजट के प्रति जागरूक संगठनों को आकर्षित करता है, और व्यापक AWS इकोसिस्टम संसाधनों का खजाना प्रदान करता है। हालांकि, प्लेटफ़ॉर्म की जटिलता और वेंडर लॉक-इन की संभावना चुनौतियां पैदा कर सकती है, खासकर उन लोगों के लिए जो क्लाउड-आधारित एमएल में नए हैं।

हगिंग फेस ने पूर्व-प्रशिक्षित मॉडलों की अपनी व्यापक लाइब्रेरी और एक जीवंत समुदाय के साथ मॉडल साझाकरण और सहयोग को बदल दिया है। यह प्राकृतिक भाषा प्रसंस्करण (NLP) में उत्कृष्ट है, जो स्पष्ट और सुलभ दस्तावेज़ों द्वारा समर्थित है। नकारात्मक पक्ष यह है कि इसमें कुछ एंटरप्राइज़-स्तरीय सुविधाओं का अभाव है, जो सख्त डेटा गवर्नेंस आवश्यकताओं वाले संगठनों के लिए चिंता का विषय हो सकता है।

प्रत्येक प्लेटफ़ॉर्म की ताकत और कमजोरियां जीवनचक्र प्रबंधन, स्केलेबिलिटी और उपयोगकर्ता सहायता के प्रति उनके दृष्टिकोण को दर्शाती हैं।

Prompts.ai एक ही, सुरक्षित प्लेटफ़ॉर्म में कई प्रमुख बड़े भाषा मॉडल तक पहुंच को समेकित करते हुए - 98% तक - लागत में कटौती करने की अपनी क्षमता के साथ खुद को अलग करता है। यह दृष्टिकोण न केवल परिचालन खर्चों को कम करता है, बल्कि प्रशासनिक ओवरहेड को कम करके प्रबंधन को भी सरल बनाता है।

हालांकि, यह ध्यान रखना महत्वपूर्ण है Prompts.ai मुख्य रूप से बड़े भाषा मॉडल पर केंद्रित है। कंप्यूटर विज़न या पारंपरिक ML एल्गोरिदम के लिए विशेष टूल की आवश्यकता वाले संगठनों को अतिरिक्त संसाधनों को एकीकृत करने की आवश्यकता हो सकती है। अपेक्षाकृत नए प्लेटफ़ॉर्म के रूप में, यह अभी तक अधिक स्थापित प्रदाताओं की व्यापक एंटरप्राइज़ सुविधाओं से मेल नहीं खा सकता है। हालांकि, एंटरप्राइज़-ग्रेड सुरक्षा और अनुपालन के प्रति इसकी प्रतिबद्धता तेज़ी से विकसित हो रही है।

प्लेटफ़ॉर्म शीघ्र इंजीनियरों के समुदाय का निर्माण करके और व्यापक ऑनबोर्डिंग और प्रशिक्षण प्रदान करके सहयोग को भी बढ़ावा देता है। यह टीमवर्क-उन्मुख दृष्टिकोण यह सुनिश्चित करता है कि सख्त शासन और सुरक्षा मानकों का पालन करते हुए डेटा वैज्ञानिक, एमएल इंजीनियर और व्यावसायिक हितधारक प्रभावी ढंग से सहयोग कर सकें।

इन प्लेटफार्मों में लागत संरचनाएं काफी भिन्न होती हैं। AWS और Google जैसे पारंपरिक प्रदाता संसाधनों से भरपूर होते हुए भी कभी-कभी अप्रत्याशित खर्च कर सकते हैं। इसके विपरीत, Prompts.ai बिलिंग सरप्राइज़ को रोकने के लिए डिज़ाइन किया गया एक पारदर्शी मूल्य निर्धारण मॉडल प्रदान करता है, जिससे यह उन संगठनों के लिए एक उत्कृष्ट विकल्प बन जाता है जो बिना किसी लागत के अपने AI संचालन को स्केल करना चाहते हैं।

समर्थन और दस्तावेज़ीकरण भी भिन्न होते हैं। हालांकि AWS और Google जैसे प्लेटफ़ॉर्म विशाल संसाधन प्रदान करते हैं, लेकिन जानकारी की भारी मात्रा उपयोगकर्ताओं को परेशान कर सकती है। Prompts.aiदूसरी ओर, केंद्रित दस्तावेज़ीकरण, उपयोगकर्ता फ़ोरम और विशेष रूप से शीघ्र इंजीनियरिंग और एलएलएम वर्कफ़्लो के लिए डिज़ाइन किए गए अनुरूप समर्थन प्रदान करता है, यह सुनिश्चित करता है कि उपयोगकर्ताओं को अनावश्यक जटिलता के बिना आवश्यक मार्गदर्शन मिले।

सही AI प्लेटफ़ॉर्म का चयन करने से आपकी विशिष्ट ज़रूरतों, मौजूदा बुनियादी ढाँचे और बजटीय बाधाओं को समझने में मदद मिलती है। चर्चा किया गया प्रत्येक प्लेटफ़ॉर्म अलग-अलग उपयोग के मामलों के अनुरूप अलग-अलग लाभ प्रदान करता है, जिससे ट्रेड-ऑफ़ को सावधानी से तौलना आवश्यक हो जाता है।

माइक्रोसॉफ्ट एज़्योर मशीन लर्निंग Microsoft इकोसिस्टम में पहले से निवेश किए गए उद्यमों के लिए एक मजबूत विकल्प है, जिसका श्रेय Office 365 और Power BI जैसे उपकरणों के साथ सहज एकीकरण होता है। गूगल क्लाउड वर्टेक्स एआई उन टीमों के लिए चमकता है जो AI अनुसंधान पर जोर देती हैं और TensorFlow पर बहुत अधिक भरोसा करती हैं। अमेज़ॅन सेजमेकर व्यापक स्केलेबिलिटी और एंड-टू-एंड मशीन लर्निंग जीवनचक्र प्रबंधन की आवश्यकता वाले संगठनों के लिए एक उत्कृष्ट विकल्प है। इस बीच, हगिंग फेस ने अपने विशाल मॉडल लाइब्रेरी और सक्रिय समुदाय के साथ प्राकृतिक भाषा प्रसंस्करण में एक नया मानक स्थापित किया है। बड़े भाषा मॉडल वर्कफ़्लो को नेविगेट करने वाले व्यवसायों के लिए, Prompts.ai एकल, एकीकृत इंटरफ़ेस के माध्यम से 35 से अधिक प्रमुख एलएलएम तक पहुंच प्रदान करके सुव्यवस्थित प्रबंधन और 98% तक लागत बचत प्रदान करता है।

ये अंतर्दृष्टि आपके पायलट परीक्षण को निर्देशित करने और आपकी दीर्घकालिक AI रणनीति को सूचित करने में मदद कर सकती हैं। स्थापित क्लाउड इकोसिस्टम वाले उद्यम अक्सर Azure ML या SageMaker की ओर बढ़ते हैं, जबकि शोध संस्थानों और सहयोगी टीमों को हगिंग फेस का वातावरण अधिक आकर्षक लग सकता है। LLM प्रबंधन में लागत दक्षता पर केंद्रित व्यवसायों के लिए, Prompts.ai का पारदर्शी मूल्य निर्धारण और एकीकृत दृष्टिकोण इसे एक आकर्षक विकल्प बनाते हैं।

चूंकि AI प्लेटफ़ॉर्म का विकास जारी है, इसलिए अपनी पसंद को तत्काल ज़रूरतों और भविष्य के लक्ष्यों दोनों के साथ संरेखित करना महत्वपूर्ण है। किसी विशेष प्लेटफ़ॉर्म पर काम करने से पहले संगतता का परीक्षण करने के लिए पायलट प्रोजेक्ट एक प्रभावी तरीका है।

आखिरकार, सबसे अच्छा प्लेटफ़ॉर्म वह है जो आपकी टीम को बजट के भीतर रहते हुए और अनुपालन मानकों को पूरा करते हुए मशीन लर्निंग मॉडल को कुशलतापूर्वक तैनात करने, मॉनिटर करने और स्केल करने का अधिकार देता है। अपनी अनूठी चुनौतियों के साथ प्लेटफ़ॉर्म क्षमताओं का मिलान करके, आप प्रभावी AI परिनियोजन और प्रबंधन के लिए एक ठोस आधार बना सकते हैं।

अपने मशीन लर्निंग मॉडल को प्रबंधित करने के लिए AI प्लेटफ़ॉर्म चुनने के लिए कई कारकों पर सावधानीपूर्वक विचार करने की आवश्यकता होती है। अपने संगठन की खास ज़रूरतों को ध्यान में रखकर शुरुआत करें। क्या आपको रीयल-टाइम पूर्वानुमान, बैच प्रोसेसिंग या दोनों के संयोजन की आवश्यकता है? इन मांगों को पूरा करने के लिए सुनिश्चित करें कि प्लेटफ़ॉर्म उन सर्विंग सुविधाओं की पेशकश करता है जिन पर आप भरोसा करते हैं, जैसे कि कम-विलंबता एंडपॉइंट या शेड्यूल किए गए वर्कफ़्लो।

इसके बाद, यह आकलन करें कि प्लेटफ़ॉर्म आपके मौजूदा टूल और फ़्रेमवर्क के साथ कितनी अच्छी तरह एकीकृत है। जब आप मॉडल डेवलपमेंट से डिप्लॉयमेंट में बदलाव करते हैं, तो रुकावटों से बचने के लिए आपके मौजूदा ML स्टैक के साथ सहज संगतता महत्वपूर्ण है। इसके अतिरिक्त, परिनियोजन विकल्पों के बारे में सोचें - चाहे आपका ध्यान क्लाउड वातावरण, एज डिवाइस या हाइब्रिड सेटअप पर हो - और ऐसा प्लेटफ़ॉर्म चुनें जो आपके बजट और स्केलेबिलिटी योजनाओं के भीतर रहते हुए इन आवश्यकताओं के अनुरूप हो।

इन कारकों को संबोधित करके, आप एक ऐसा प्लेटफ़ॉर्म पा सकते हैं जो संचालन को कुशल और लागत प्रभावी रखते हुए आपकी तकनीकी ज़रूरतों को पूरा करता हो।

AI प्लेटफ़ॉर्म के लिए मूल्य निर्धारण संरचनाएं जो मशीन लर्निंग (ML) मॉडल को संभालती हैं, अक्सर ऐसे कारकों पर निर्भर करती हैं जैसे उपयोग, उपलब्ध सुविधाएं, और स्केलेबिलिटी विकल्प। कई प्लेटफ़ॉर्म अपने शुल्कों को संसाधनों की खपत पर आधारित करते हैं, जैसे कि गणना के घंटे, स्टोरेज क्षमता, या तैनात किए गए मॉडल की संख्या। अन्य अलग-अलग ज़रूरतों के अनुरूप टियर प्लान प्रदान करते हैं, जिनमें छोटे पैमाने की परियोजनाओं से लेकर बड़े उद्यम संचालन तक शामिल हैं।

प्लेटफ़ॉर्म चुनते समय, अपनी विशिष्ट आवश्यकताओं का आकलन करना आवश्यक है - आप कितनी बार मॉडल को प्रशिक्षित करने की योजना बनाते हैं, परिनियोजन का पैमाना और आपकी निगरानी आवश्यकताएं। अपने बजट में किसी आश्चर्य से बचने के लिए, किसी भी संभावित अतिरिक्त लागत, जैसे कि प्रीमियम सुविधाओं के लिए शुल्क या संसाधन सीमा से अधिक की समीक्षा करना सुनिश्चित करें।

अपने मौजूदा तकनीकी सेटअप में AI प्लेटफ़ॉर्म लाते समय, पहला कदम उन चुनौतियों को इंगित करना है जिन्हें आप हल करना चाहते हैं। चाहे वह ग्राहकों से बातचीत बढ़ाना हो या वर्कफ़्लो को सुव्यवस्थित करना हो, स्पष्ट फ़ोकस रखने से आपके प्रयासों में मार्गदर्शन मिलेगा। वहां से, एक विस्तृत रणनीति तैयार करें जिसमें आपके उद्देश्य, आपके लिए आवश्यक उपकरण और डेटा को संभालने और निगरानी करने की योजना शामिल हो।

सुनिश्चित करें कि आपका आंतरिक डेटा अच्छी स्थिति में है - व्यवस्थित, उपयोग करने में आसान और भरोसेमंद। इसमें डेटा स्रोतों को समेकित करना और मजबूत शासन पद्धतियों को लागू करना शामिल हो सकता है। नैतिक विचारों को नज़रअंदाज़ न करें, जैसे कि पूर्वाग्रह को दूर करना और निष्पक्षता सुनिश्चित करना, और इस बारे में सोचें कि ये बदलाव आपकी टीम को कैसे प्रभावित कर सकते हैं। अपने उपयोग के मामलों को प्राथमिकता दें, प्लेटफ़ॉर्म पर व्यापक परीक्षण चलाएं, और एक ठोस परिवर्तन प्रबंधन योजना तैयार करें। यह विचारशील दृष्टिकोण आपको संभावित जोखिमों को नियंत्रण में रखते हुए AI को सुचारू रूप से एकीकृत करने की अनुमति देगा।