La gestion des modèles d'apprentissage automatique (ML) est complexe et nécessite des outils qui simplifient le déploiement, la surveillance et le contrôle des versions. Ce guide met en lumière cinq plateformes d'IA de premier plan : Apprentissage automatique Microsoft Azure, Google Cloud Vertex AI, Amazon SageMaker, Visage étreignant, et Prompts.ai - chacun étant conçu pour relever les défis uniques des flux de travail de machine learning. Voici ce que vous devez savoir :

Chaque plateforme répond à des besoins spécifiques, qu'il s'agisse de rentabilité ou d'évolutivité. Vous trouverez ci-dessous une comparaison rapide pour vous aider à prendre une décision.

Choisissez la plateforme qui correspond à vos objectifs techniques, à votre infrastructure et à votre budget. Commencez modestement avec des projets pilotes pour évaluer la compatibilité avant la mise à l'échelle.

Apprentissage automatique Microsoft Azure est une plateforme basée sur le cloud conçue pour relever les défis liés à la gestion des modèles d'apprentissage automatique (ML). Il prend en charge chaque étape du cycle de vie du machine learning tout en s'intégrant parfaitement à l'écosystème plus large d'outils et de services de Microsoft.

Azure ML simplifie l'ensemble du cycle de vie des modèles grâce à registre centralisé qui suit automatiquement le lignage des modèles, y compris les ensembles de données, le code et les hyperparamètres. Ses pipelines automatisés gèrent tout, de la préparation des données au déploiement, garantissant ainsi des transitions fluides entre les étapes.

La plateforme brille suivi des expériences, grâce à son intégration MLflow intégrée. Cette fonctionnalité permet aux data scientists d'enregistrer automatiquement les métriques, les paramètres et les artefacts, ce qui facilite la comparaison des versions des modèles et la reproduction des expériences réussies. Il prend également en charge Tests A/B en production, permettant des déploiements progressifs tout en surveillant les performances en temps réel.

Au-delà du suivi des fichiers de modèles, Azure ML fournit un contrôle de version pour configurations de l'environnement, cibles de calcul et paramètres de déploiement. Cela garantit que les modèles peuvent être reproduits de manière fiable à tous les stades de développement. En outre, la fonction de capture instantanée capture tous les détails d'une expérience, y compris le code, les dépendances et les versions des données.

Cette gestion complète du cycle de vie fait d'Azure ML un choix judicieux pour les déploiements évolutifs et l'intégration transparente dans les flux de travail existants.

Azure ML s'adapte aux différents besoins de calcul grâce à ses fonction de mise à l'échelle automatique, qui ajuste les ressources de manière dynamique, de la formation sur un seul nœud aux clusters GPU distribués, sans nécessiter de modifications de code. Cette flexibilité est particulièrement bénéfique pour les organisations qui gèrent diverses charges de travail de machine learning.

La plateforme s'intègre parfaitement à Azure DevOps et GitHub, permettant aux équipes d'automatiser les flux de travail d'intégration et de livraison continues (CI/CD). Par exemple, des pipelines peuvent être déclenchés pour réentraîner les modèles chaque fois que de nouvelles données sont disponibles ou que des modifications de code sont validées. De plus, Azure ML se connecte directement à Power BI pour des informations exploitables et Azure Synapse Analytics pour le traitement des données, créant un écosystème cohérent de données et d'IA.

Azure ML prend également en charge déploiement multicloud, permettant aux modèles formés sur Azure d'être déployés sur d'autres plateformes cloud ou même sur une infrastructure sur site. Cette fonctionnalité permet aux entreprises d'éviter la dépendance vis-à-vis des fournisseurs tout en maintenant une gestion cohérente des modèles dans différents environnements.

Azure ML propose une modèle de tarification à l'utilisation, avec des frais distincts pour le calcul, le stockage et des services spécifiques. Les coûts de calcul varient d'environ 0,10 USD par heure pour les instances CPU et plus de 3 USD par heure pour les GPU haut de gamme. Pour des charges de travail prévisibles, les instances réservées peuvent permettre de réaliser des économies allant jusqu'à 72 %.

Pour vous aider à gérer les coûts, Azure ML inclut gestion automatique des calculs, qui arrête les ressources inutilisées et adapte l'utilisation en fonction de la demande. La plateforme fournit également des outils détaillés de suivi des coûts et de budgétisation, permettant aux équipes de fixer des limites de dépenses et de recevoir des alertes à l'approche de ces seuils.

Les coûts de stockage sont généralement 0,02 à 0,05$ par Go et par mois, bien que les organisations qui transfèrent de grands ensembles de données entre les régions doivent être conscientes des dépenses potentielles liées au transfert de données.

Microsoft soutient Azure ML grâce à de nombreuses ressources, notamment une documentation détaillée, des ateliers pratiques et des programmes de certification via Microsoft Learn. La plateforme bénéficie de forums communautaires actifs et reçoit mises à jour trimestrielles avec de nouvelles fonctionnalités.

Pour les entreprises, Microsoft propose des options de support robustes, notamment une assistance technique 24h/24 et 7j/7, des temps de réponse garantis et l'accès à des responsables de la réussite client dédiés. Les organisations peuvent également tirer parti services de conseil professionnels pour concevoir et mettre en œuvre des flux de travail ML adaptés à leurs besoins.

Azure ML prend en charge les frameworks populaires tels que PyTorch, TensorFlow et SciKit Learn et offres accélérateurs de solutions prédéfinis pour des tâches telles que la prévision de la demande et la maintenance prédictive. Ces outils sont conçus pour rationaliser les flux de travail et rendre la gestion des modèles de machine learning plus efficace.

Google Cloud Vertex AI réunit les fonctionnalités de gestion des modèles d'apprentissage automatique sur une plateforme unique, fusionnant les atouts d'AutoML et d'AI Platform. Il est conçu pour simplifier les flux de travail de machine learning tout en offrant une évolutivité et des performances au niveau de l'entreprise.

Vertex AI fournit une plateforme ML unifiée qui rationalise l'ensemble du cycle de vie du modèle, de la préparation des données au déploiement. C'est Registre des modèles suit les versions, le lignage et les métadonnées, ce qui facilite la comparaison et l'évaluation des performances des modèles au fil du temps.

La plateforme comprend des outils de surveillance continue pour suivre les performances de production et alerter les équipes en cas de problèmes tels que la dérive des données. Il prend en charge formation personnalisée avec des frameworks tels que TensorFlow, PyTorch et XG Boost, tout en proposant Options AutoML pour ceux qui préfèrent une solution sans code. Avec orchestration des pipelines, les équipes peuvent créer des flux de travail reproductibles qui s'exécutent automatiquement ou à la demande, garantissant ainsi la cohérence des processus. Le Boutique de fonctionnalités améliore encore la fiabilité en gérant et en diffusant les fonctionnalités de manière uniforme dans les environnements de formation et de déploiement, réduisant ainsi le risque d'écarts.

Ces fonctionnalités permettent aux équipes de déployer plus facilement leurs efforts et de s'intégrer parfaitement aux flux de travail existants.

S'appuyant sur l'infrastructure robuste de Google, Vertex AI prend en charge des configurations de machines personnalisées et des instances préemptives, offrant ainsi un équilibre entre performances et coûts. Ses fonctionnalités de mise à l'échelle automatique permettent des transitions fluides entre des configurations de formation à nœud unique et distribuées.

Vertex AI s'intègre sans effort à l'écosystème de données de Google Cloud, notamment BigQuery, Cloud Storage et Dataflow. Le Pupitre de travail Vertex AI fournit des ordinateurs portables Jupyter gérés avec des environnements préconfigurés, tandis que Canalisations Vertex AI simplifie la création et le déploiement de flux de travail ML à l'aide de Canalisations Kubeflow.

À titre d'inférence, la plateforme propose points de terminaison de prédiction en ligne avec équilibrage de charge et dimensionnement automatiques, ainsi que prédiction par lots options pour gérer efficacement les tâches d'inférence à grande échelle sur des ressources distribuées.

Vertex AI fonctionne selon un modèle de tarification à l'utilisation, avec des frais distincts pour la formation, les prévisions et le stockage. Les coûts dépendent de facteurs tels que le type d'instance, les besoins en termes de performances et la durée d'utilisation. Il propose plusieurs options permettant de réduire les coûts, notamment des remises d'utilisation durable, des instances préemptives pour les charges de travail tolérantes aux pannes et des remises d'utilisation engagées pour des modèles d'utilisation prévisibles. Les outils intégrés de suivi des coûts aident les équipes à gérer efficacement leurs budgets.

Google fournit de nombreuses ressources aux utilisateurs de Vertex AI, notamment une documentation détaillée, des ateliers pratiques et des programmes de certification via Google Cloud Skills Boost. La plateforme bénéficie d'une communauté de développeurs dynamique et de mises à jour fréquentes pour rester en phase avec les dernières avancées.

Les utilisateurs professionnels ont accès à une assistance 24h/24 et 7j/7 avec des temps de réponse garantis en fonction de la gravité du problème. Des services professionnels sont également disponibles pour aider les organisations à concevoir et à mettre en œuvre des stratégies de machine learning, en particulier pour les déploiements à grande échelle.

Vertex AI prend en charge les frameworks open source largement utilisés et s'intègre à des outils tels que MLflow et TensorBoard pour le suivi et la visualisation des expériences. En outre, l'AI Hub de Google propose des modèles pré-entraînés et des modèles de pipeline, permettant aux équipes d'accélérer le développement pour les cas d'utilisation courants du machine learning. Les forums communautaires et les plateformes tels que Stack Overflow améliorent encore le système d'assistance, tandis que les publications continues de Google sur les recherches et les meilleures pratiques permettent aux équipes de rester informées des tendances émergentes en matière d'apprentissage automatique.

Amazon SageMaker est la plateforme d'apprentissage automatique tout-en-un d'AWS conçue pour aider les data scientists et les ingénieurs ML à créer, former et déployer des modèles à grande échelle. Construit sur l'infrastructure mondiale d'AWS, SageMaker associe de puissants outils de gestion des modèles à des options de déploiement évolutives, ce qui en fait une solution incontournable pour les entreprises.

SageMaker fournit une suite complète d'outils permettant de gérer l'ensemble du cycle de vie des modèles d'apprentissage automatique. Au cœur se trouve le Registre des modèles SageMaker, un hub centralisé où les équipes peuvent cataloguer, modifier et suivre la lignée de leurs modèles. Ce référentiel inclut des métadonnées et des mesures de performance, simplifiant les comparaisons de versions et permettant des annulations rapides en cas de besoin.

Avec SageMaker Studio, les utilisateurs peuvent accéder aux blocs-notes Jupyter, suivre les expériences et déboguer les flux de travail en un seul endroit. Entre-temps, Expériences SageMaker enregistre automatiquement les cycles d'entraînement, les hyperparamètres et les résultats, rationalisant ainsi le processus de suivi et d'affinement des modèles.

Pour garantir le bon fonctionnement des modèles en production, Moniteur modèle SageMaker surveille la qualité, la dérive et les biais des données, en émettant des alertes lorsque les performances diminuent ou lorsque les données entrantes divergent de manière significative. Canalisations SageMaker automatise l'ensemble du flux de travail, du traitement des données au déploiement, en garantissant cohérence et fiabilité tout au long du processus de développement.

SageMaker se distingue par sa capacité à faire évoluer les ressources de manière efficace. En tirant parti de l'infrastructure élastique d'AWS, il peut gérer les charges de travail de machine learning les plus exigeantes. La plateforme prend en charge formation distribuée sur plusieurs instances, simplifiant ainsi le traitement parallèle pour les grands ensembles de données et les modèles complexes. Avec Offres d'emploi de SageMaker Training, les ressources peuvent passer d'une instance unique à des centaines de machines, en provisionnant et en libérant automatiquement les ressources selon les besoins.

L'intégration avec d'autres services AWS rend SageMaker encore plus puissant. Par exemple, le Boutique de fonctionnalités SageMaker agit comme un référentiel centralisé pour les fonctionnalités d'apprentissage automatique, garantissant la cohérence entre la formation et l'inférence tout en permettant la réutilisation des fonctionnalités entre les projets.

Pour le déploiement, Endpoints SageMaker fournissent une inférence en temps réel avec une mise à l'échelle automatique basée sur les modèles de trafic. La plateforme prend également en charge points de terminaison multimodèles, permettant à plusieurs modèles de fonctionner sur un seul terminal afin d'optimiser l'efficacité des ressources et de réduire les coûts. Pour le traitement par lots, Transformation par lots SageMaker gère efficacement les gros travaux d'inférence à l'aide de ressources informatiques distribuées.

SageMaker utilise le modèle de paiement à l'utilisation d'AWS, avec des frais distincts pour la formation, l'hébergement et le traitement des données. Les coûts de formation dépendent du type et de la durée de l'instance, avec Instances ponctuelles offrant jusqu'à 90 % d'économies par rapport aux tarifs à la demande.

Pour des charges de travail prévisibles, Plans d'épargne offrent des remises allant jusqu'à 64 % pour une utilisation engagée. Pour optimiser davantage les coûts, SageMaker Inference Recommender teste différents types d'instances et configurations, aidant ainsi les équipes à trouver la configuration de déploiement la plus rentable sans sacrifier les performances.

Endpoints équipés de mise à l'échelle automatique assurez-vous que les utilisateurs ne paient que pour les ressources informatiques dont ils ont besoin. Les ressources diminuent pendant les périodes de faible trafic et augmentent à mesure que la demande augmente. En outre, SageMaker fournit des outils de suivi et de budgétisation, permettant aux équipes de mieux contrôler leurs dépenses en matière de machine learning.

Les utilisateurs d'Amazon SageMaker bénéficient d'une multitude de ressources, notamment une documentation détaillée, des didacticiels pratiques et Université d'apprentissage automatique AWS, qui propose des cours et des certifications gratuits. La plateforme est soutenue par une communauté de développeurs dynamique et des mises à jour fréquentes qui s'alignent sur les dernières avancées en matière d'apprentissage automatique.

Pour les clients professionnels, Assistance AWS propose une assistance à plusieurs niveaux, allant de l'assistance téléphonique 24 heures sur 24, 7 jours sur 7 pour les problèmes critiques à des conseils généraux pendant les heures de bureau. En outre, Services professionnels AWS fournit des conseils et une aide à la mise en œuvre pour des projets de ML complexes ou à grande échelle.

SageMaker prend en charge les frameworks open source populaires tels que TensorFlow, PyTorch, SciKit Learn, et XG Boost grâce à des conteneurs préfabriqués, tout en permettant des conteneurs personnalisés pour des besoins spécifiques. Le Blog AWS sur l'apprentissage automatique partage régulièrement les meilleures pratiques, des études de cas et des guides techniques approfondis. Forums et événements communautaires tels que AWS re:Invent offrent de nouvelles opportunités d'apprentissage et de réseautage, destinées aussi bien aux débutants qu'aux professionnels chevronnés.

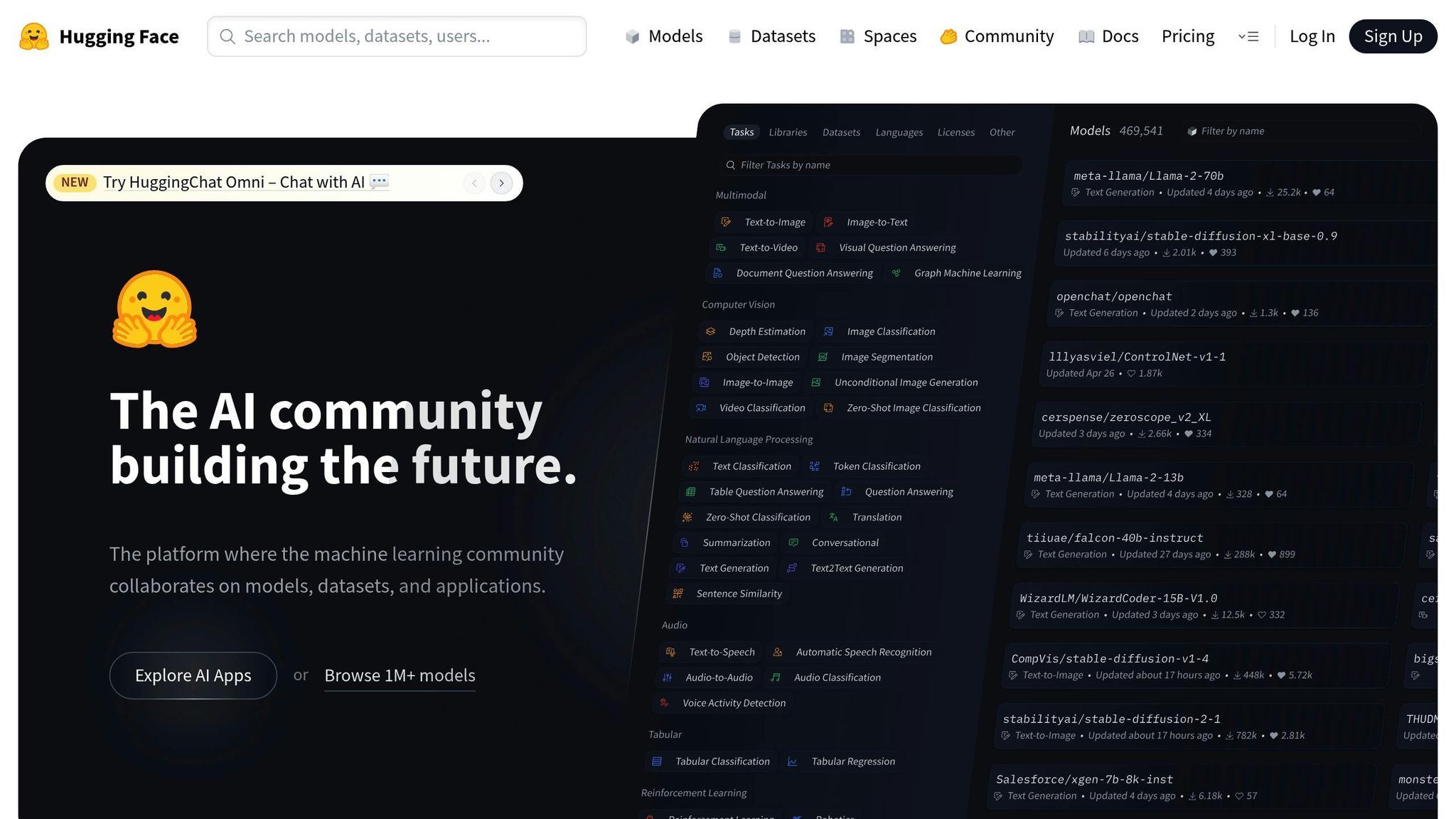

Hugging Face fournit aux utilisateurs une suite complète d'outils d'apprentissage automatique. Alors qu'il se concentrait à l'origine sur le traitement du langage naturel, il a étendu ses capacités pour inclure la vision par ordinateur, le traitement audio et les applications multimodales. Cette évolution en a fait une plateforme incontournable pour la gestion et le déploiement de modèles d'apprentissage automatique.

Le Hugging Face Hub fait office de référentiel centralisé pour les modèles pré-entraînés, les ensembles de données et les démonstrations interactives. Chaque référentiel de modèles comprend une fiche modèle détaillée qui décrit le processus de formation, les cas d'utilisation potentiels, les limites et les considérations éthiques, garantissant la transparence à chaque étape du cycle de vie du modèle. La bibliothèque Hugging Face Transformers simplifie davantage les flux de travail, permettant aux utilisateurs de charger, d'affiner et de mettre à jour des modèles sans effort à l'aide du contrôle de version basé sur GIT.

En matière de déploiement, les points de terminaison Hugging Face Inference constituent une solution fluide. Ces terminaux gèrent la mise à l'échelle automatique, la surveillance du CPU/GPU et fournissent des mesures de performance en plus de la journalisation des erreurs. Cette configuration aide les équipes à évaluer les performances des modèles dans des scénarios réels, garantissant ainsi des transitions fluides entre le développement et la production.

Hugging Face offre une évolutivité robuste grâce à sa bibliothèque Accelerate, qui prend en charge la formation distribuée sur plusieurs GPU et machines. Il s'intègre parfaitement aux frameworks d'apprentissage en profondeur populaires tels que PyTorch, TensorFlow et JAX, ce qui le rend adaptable à divers flux de travail. En outre, la bibliothèque Datasets donne accès à une vaste gamme de jeux de données, ainsi qu'à des outils de prétraitement et de streaming, ce qui permet d'optimiser les pipelines de données.

Pour présenter des modèles et recueillir des commentaires, Hugging Face Spaces est une fonctionnalité hors pair. À l'aide d'outils tels que Gradio ou Streamlit, les utilisateurs peuvent créer facilement des démonstrations et des applications interactives. Ces démonstrations peuvent être intégrées dans des flux de travail d'intégration continue, simplifiant ainsi l'engagement et l'itération des parties prenantes.

Hugging Face prospère grâce à sa communauté open source dynamique, où les utilisateurs partagent activement des modèles, des ensembles de données et des applications. La plateforme propose également un cours éducatif gratuit couvrant tout, des bases des transformateurs aux techniques avancées de réglage. Pour les entreprises clientes, Hugging Face fournit des référentiels de modèles privés, des fonctionnalités de sécurité améliorées et un support dédié, permettant aux organisations de gérer des modèles propriétaires tout en tirant parti des puissants outils de la plateforme.

Hugging Face fonctionne sur un modèle freemium. Les individus et les petites équipes peuvent accéder gratuitement aux référentiels publics et aux fonctionnalités communautaires. Pour ceux qui ont besoin d'un déploiement géré, d'un stockage supplémentaire ou d'une assistance avancée, la plateforme propose des forfaits payants dont les prix sont personnalisés en fonction des exigences et des niveaux d'utilisation spécifiques.

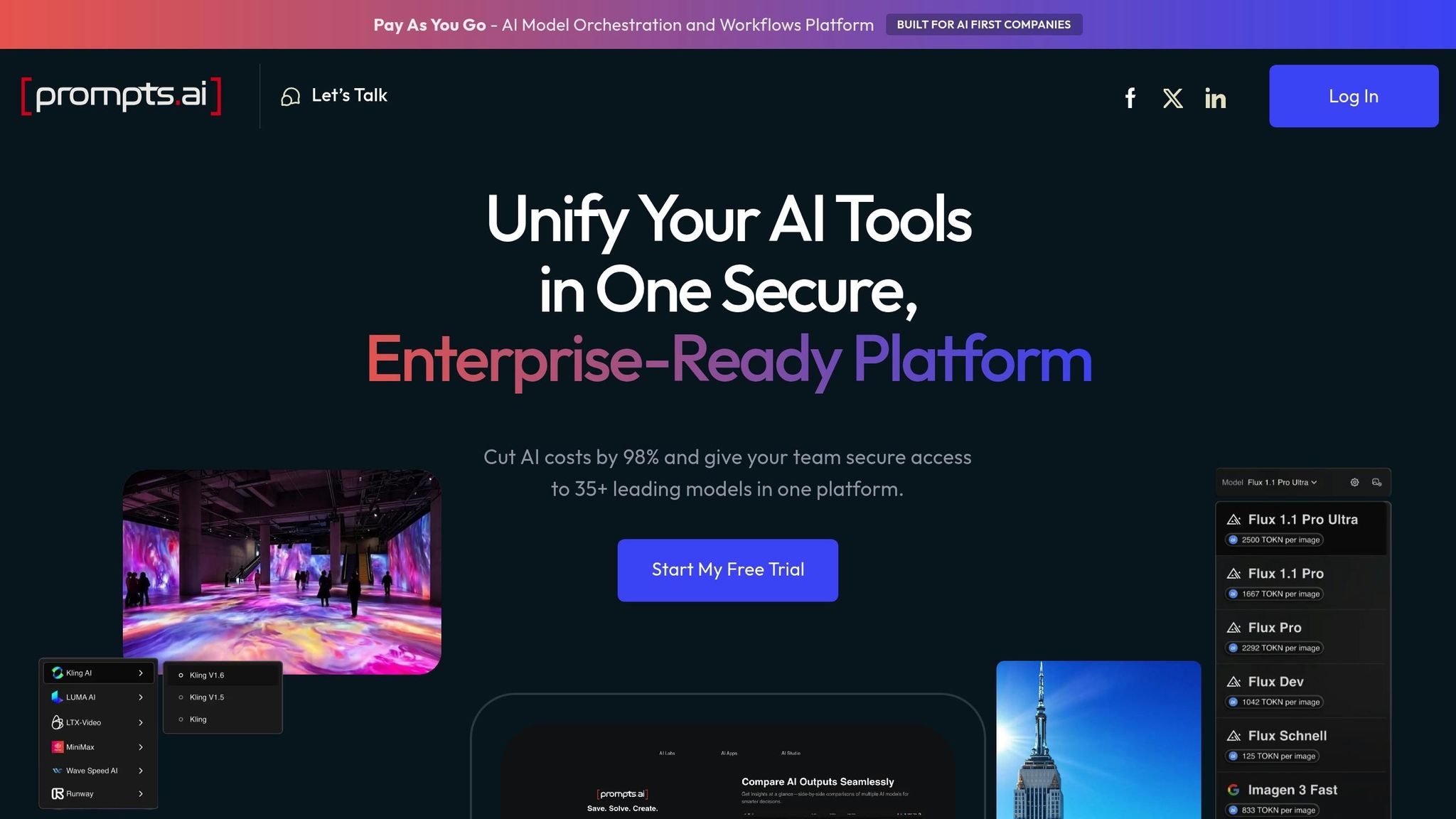

Prompts.ai regroupe plus de 35 grands modèles de langage au sein d'une plateforme sécurisée et rationalisée. Conçu spécifiquement pour gestion rapide et LLMOP, il fournit un environnement prêt pour la production permettant de gérer et d'optimiser les invites.

Prompts.ai fournit une suite complète d'outils pour gérer l'ensemble du cycle de vie des modèles, en mettant l'accent sur gestion et suivi rapides des versions. Il permet aux utilisateurs de lancer des instructions de version, d'annuler les modifications et de garantir la reproductibilité grâce à des systèmes de contrôle de version avancés.

La plateforme propose une surveillance automatisée pour suivre des indicateurs clés tels que la précision des prévisions, la latence et la dérive des données. Les utilisateurs peuvent configurer des alertes personnalisées pour résoudre rapidement les problèmes de performances ou les anomalies, garantissant ainsi un fonctionnement fluide, même dans les environnements de production. Cette surveillance est particulièrement utile pour relever des défis tels que la dérive rapide et le maintien de performances constantes.

Par exemple, une société d'analyse du secteur de la santé aux États-Unis a utilisé Prompts.ai pour réduire les délais de déploiement des modèles de 40 % tout en améliorant le suivi de la précision. Cela a conduit à de meilleurs résultats pour les patients et à des rapports de conformité plus efficaces.

Ces outils de cycle de vie sont conçus pour prendre en charge des déploiements évolutifs et fiables.

Prompts.ai s'intègre sans effort aux frameworks d'apprentissage automatique les plus courants, notamment TensorFlow, PyTorch et scikit-learn, ainsi que les principales plateformes cloud telles qu'AWS, Azure et Google Cloud. Il prend en charge les déploiements évolutifs avec mise à l'échelle automatique pour les scénarios à forte demande et fonctionne avec des systèmes d'orchestration de conteneurs tels que Kubernetes.

En consolidant la sélection des modèles, les flux de travail rapides, la gestion des coûts et les comparaisons de performances sur une seule plateforme, Prompts.ai élimine le besoin de recourir à de multiples outils. Cette approche unifiée peut réduire les coûts des logiciels d'IA jusqu'à 98 %, tout en maintenant la sécurité et la conformité au niveau de l'entreprise.

Prompts.ai va au-delà des capacités techniques en favorisant la collaboration. Il propose des fonctionnalités telles que espaces de travail partagés, contrôles d'accès basés sur les rôles et commentaires intégrés sur maquettes d'artefacts, permettant aux data scientists et aux ingénieurs ML de collaborer plus efficacement. Ces outils garantissent la transparence et le travail d'équipe tout au long du cycle de développement des modèles.

La plateforme fournit également de nombreuses ressources, notamment une documentation complète, des forums d'utilisateurs et une assistance directe. Les entreprises clientes bénéficient de gestionnaires de comptes dédiés et d'une assistance prioritaire pour gérer les implémentations complexes. En outre, Prompts.ai soutient une communauté d'utilisateurs active où les membres peuvent échanger les meilleures pratiques et demander des conseils d'experts.

Prompts.ai fonctionne sur un système de crédit TOKN par paiement à l'utilisation. Les forfaits personnels commencent gratuitement et s'échelonnent à 29$ ou 99$ par mois, tandis que les forfaits professionnels vont de 99$ à 129$ par membre et par mois. Le modèle de facturation basé sur l'utilisation de la plateforme permet d'éviter les engagements à long terme, les forfaits annuels offrant une réduction de 10 %.

Cette structure tarifaire est particulièrement intéressante pour les organisations basées aux États-Unis qui recherchent flexibilité et contrôle des coûts. Les outils FinOps en temps réel de Prompts.ai offrent une visibilité complète des dépenses, en connectant chaque jeton utilisé à des résultats commerciaux mesurables.

Cette section rassemble les points forts et les défis de chaque plateforme afin de vous aider à affiner votre stratégie de gestion des modèles d'apprentissage automatique (ML). En comparant leurs caractéristiques, vous pouvez adapter votre choix à vos besoins spécifiques, à votre budget et à vos objectifs techniques.

Apprentissage automatique Microsoft Azure se démarque pour les organisations déjà intégrées à l'écosystème Microsoft. Son intégration à des outils tels qu'Office 365 et Power BI garantit un flux de travail rationalisé. Ces avantages sont toutefois importants, car les coûts peuvent augmenter rapidement, en particulier pour les petites équipes. De plus, la courbe d'apprentissage de la plateforme peut être abrupte pour ceux qui ne connaissent pas Azure.

Google Cloud Vertex AI se distingue par ses fonctionnalités avancées d'AutoML et ses liens étroits avec la recherche de pointe de Google en matière d'IA. Il offre un excellent support pour TensorFlow et de puissants outils d'analyse de données. Cela dit, sa dépendance à l'égard des frameworks de Google limite sa flexibilité, et sa structure tarifaire peut prêter à confusion, entraînant parfois des frais imprévus.

Amazon SageMaker offre une évolutivité inégalée et une suite complète d'outils pour gérer l'ensemble du cycle de vie du machine learning. Son modèle de paiement à l'utilisation convient aux entreprises soucieuses de leur budget, et le vaste écosystème AWS fournit une multitude de ressources. Cependant, la complexité de la plateforme et son potentiel de dépendance vis-à-vis des fournisseurs peuvent poser des défis, en particulier pour les débutants en matière de machine learning basée sur le cloud.

Visage étreignant a transformé le partage de modèles et la collaboration grâce à sa vaste bibliothèque de modèles pré-entraînés et à une communauté dynamique. Il excelle dans le traitement du langage naturel (NLP), soutenu par une documentation claire et accessible. En revanche, il ne dispose pas de certaines fonctionnalités au niveau de l'entreprise, ce qui peut être une source de préoccupation pour les organisations ayant des besoins stricts en matière de gouvernance des données.

Les forces et les faiblesses de chaque plateforme reflètent son approche de la gestion du cycle de vie, de l'évolutivité et de l'assistance aux utilisateurs.

Prompts.ai se distingue par sa capacité à réduire les coûts (jusqu'à 98 %) tout en consolidant l'accès à plusieurs grands modèles linguistiques de premier plan sur une seule plateforme sécurisée. Cette approche permet non seulement de réduire les dépenses opérationnelles, mais aussi de simplifier la gestion en minimisant les frais administratifs.

Cependant, il est important de noter que Prompts.ai se concentre principalement sur les grands modèles linguistiques. Les organisations qui ont besoin d'outils spécialisés pour la vision par ordinateur ou d'algorithmes de machine learning traditionnels peuvent avoir besoin d'intégrer des ressources supplémentaires. En tant que plate-forme relativement nouvelle, elle ne correspond peut-être pas encore aux fonctionnalités d'entreprise étendues des fournisseurs plus établis. Cela dit, son engagement en faveur d'une sécurité et d'une conformité de niveau professionnel continue d'évoluer rapidement.

La plateforme favorise également la collaboration en créant une communauté d'ingénieurs rapides et en proposant une intégration et une formation complètes. Cette approche axée sur le travail d'équipe garantit que les data scientists, les ingénieurs ML et les parties prenantes de l'entreprise peuvent collaborer efficacement tout en respectant des normes de gouvernance et de sécurité strictes.

Les structures de coûts varient considérablement d'une plateforme à l'autre. Les fournisseurs traditionnels tels qu'AWS et Google, bien que riches en ressources, peuvent parfois entraîner des dépenses imprévues. En revanche, Prompts.ai propose un modèle de tarification transparent conçu pour éviter les surprises en matière de facturation, ce qui en fait un excellent choix pour les organisations qui cherchent à développer leurs opérations d'IA sans augmenter les coûts.

Le support et la documentation diffèrent également. Alors que des plateformes comme AWS et Google fournissent de vastes ressources, le volume d'informations peut submerger les utilisateurs. Prompts.ai, d'autre part, propose une documentation ciblée, des forums d'utilisateurs et une assistance personnalisée spécialement conçue pour accélérer les flux de travail d'ingénierie et de LLM, garantissant aux utilisateurs les conseils dont ils ont besoin sans complexité inutile.

Choisir la bonne plateforme d'IA revient à comprendre vos besoins spécifiques, votre infrastructure existante et vos contraintes budgétaires. Chaque plateforme discutée offre des avantages distincts adaptés à différents cas d'utilisation, il est donc essentiel de bien évaluer les compromis.

Apprentissage automatique Microsoft Azure est un choix judicieux pour les entreprises qui ont déjà investi dans l'écosystème Microsoft, grâce à son intégration fluide avec des outils tels qu'Office 365 et Power BI. Google Cloud Vertex AI brille pour les équipes qui mettent l'accent sur la recherche en IA et qui s'appuient fortement sur TensorFlow. Amazon SageMaker est une excellente option pour les organisations qui ont besoin d'une évolutivité étendue et d'une gestion du cycle de vie de bout en bout de l'apprentissage automatique. Entre-temps, Visage étreignant a établi une nouvelle norme en matière de traitement du langage naturel grâce à sa vaste bibliothèque de modèles et à sa communauté active. Pour les entreprises qui utilisent des flux de travail basés sur des modèles linguistiques de grande envergure, Prompts.ai assure une gestion rationalisée et permet d'économiser jusqu'à 98 % des coûts en donnant accès à plus de 35 LLM de premier plan via une interface unique et unifiée.

Ces informations peuvent vous aider à orienter vos tests pilotes et à éclairer votre stratégie d'IA à long terme. Les entreprises dotées d'écosystèmes cloud bien établis sont souvent attirées par Azure ML ou SageMaker, tandis que les instituts de recherche et les équipes collaboratives peuvent trouver l'environnement de Hugging Face plus attrayant. Pour les entreprises qui mettent l'accent sur la rentabilité de la gestion LLM, la tarification transparente et l'approche unifiée de Prompts.ai en font une option intéressante.

Alors que les plateformes d'IA continuent d'évoluer, il est essentiel d'aligner votre choix sur les besoins immédiats et les objectifs futurs. Les projets pilotes constituent un moyen efficace de tester la compatibilité avant de passer à une plateforme en particulier.

En fin de compte, la meilleure plateforme est celle qui permet à votre équipe de déployer, de surveiller et de faire évoluer efficacement des modèles d'apprentissage automatique, tout en respectant le budget et les normes de conformité. En adaptant les fonctionnalités de la plateforme à vos défis uniques, vous pouvez créer une base solide pour un déploiement et une gestion efficaces de l'IA.

Le choix d'une plateforme d'IA pour gérer vos modèles d'apprentissage automatique nécessite une prise en compte attentive de plusieurs facteurs. Commencez par identifier les besoins spécifiques de votre organisation. Avez-vous besoin de prévisions en temps réel, d'un traitement par lots ou d'une combinaison des deux ? Assurez-vous que la plateforme propose les fonctionnalités de service sur lesquelles vous comptez, telles que des points de terminaison à faible latence ou des flux de travail planifiés, pour répondre à ces demandes.

Ensuite, évaluez dans quelle mesure la plateforme s'intègre à vos outils et frameworks existants. Une compatibilité parfaite avec votre stack de machine learning actuel est cruciale pour éviter les interruptions lors de la transition entre le développement du modèle et le déploiement. Pensez également aux options de déploiement, que vous vous concentriez sur les environnements cloud, les appareils périphériques ou une configuration hybride, et choisissez une plateforme qui répond à ces exigences tout en respectant votre budget et vos plans d'évolutivité.

En tenant compte de ces facteurs, vous pouvez trouver une plateforme qui répond à vos besoins techniques tout en maintenant l'efficacité et la rentabilité des opérations.

Les structures tarifaires des plateformes d'IA qui gèrent des modèles d'apprentissage automatique (ML) dépendent souvent de facteurs tels que usage, fonctionnalités disponibles, et options d'évolutivité. De nombreuses plateformes basent leurs tarifs sur la consommation de ressources, comme les heures de calcul, la capacité de stockage ou le nombre de modèles déployés. D'autres proposent des plans échelonnés adaptés à différents besoins, allant des projets à petite échelle aux opérations de grandes entreprises.

Lors du choix d'une plateforme, il est essentiel d'évaluer vos besoins spécifiques, notamment la fréquence à laquelle vous prévoyez d'entraîner les modèles, l'ampleur du déploiement et vos exigences en matière de surveillance. Veillez à examiner tous les coûts supplémentaires potentiels, tels que les frais liés aux fonctionnalités premium ou le dépassement des limites de ressources, afin d'éviter les surprises dans votre budget.

Lorsque vous intégrez une plateforme d'IA à votre configuration technologique actuelle, la première étape consiste à identifier les défis que vous souhaitez résoudre. Qu'il s'agisse d'améliorer les interactions avec les clients ou de rationaliser les flux de travail, une orientation claire guidera vos efforts. À partir de là, élaborez une stratégie détaillée qui inclut vos objectifs, les outils dont vous aurez besoin et un plan de gestion et de suivi des données.

Assurez-vous que vos données internes sont en bon état, organisées, faciles d'accès et fiables. Cela peut impliquer de consolider les sources de données et de mettre en place de solides pratiques de gouvernance. Ne négligez pas les considérations éthiques, telles que la lutte contre les préjugés et la garantie de l'équité, et réfléchissez à la manière dont ces changements pourraient affecter votre équipe. Hiérarchisez vos cas d'utilisation, effectuez des tests complets sur la plateforme et préparez un plan de gestion du changement solide. Cette approche réfléchie vous permettra d'intégrer l'IA en douceur tout en maîtrisant les risques potentiels.