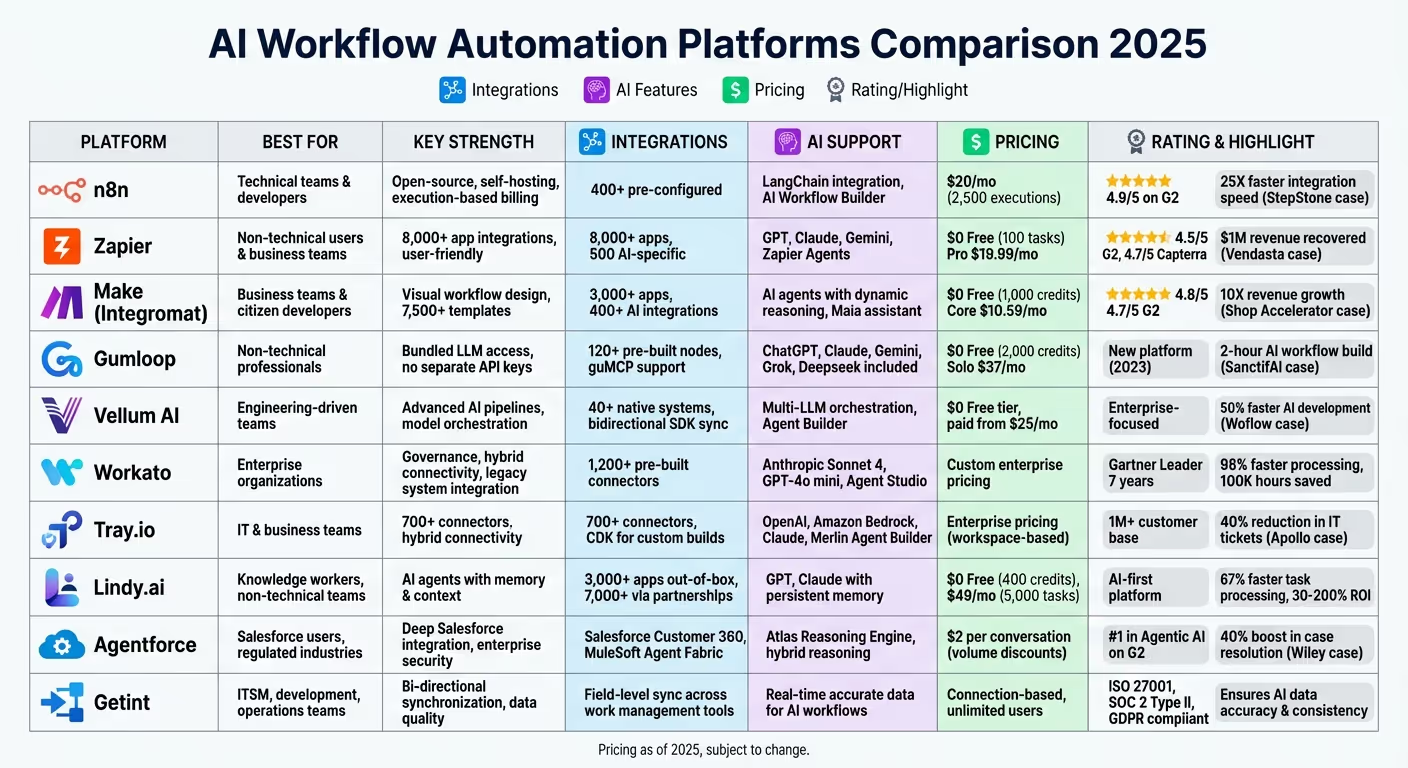

Les systèmes de flux de travail basés sur l'IA transforment le mode de fonctionnement des entreprises en combinant automatisation et prise de décision avancée. Ce guide examine les principales plateformes qui intègrent Modèles linguistiques étendus (LLM) pour traiter des tâches telles que la gestion des données non structurées, le support informatique et l'automatisation des ventes. Voici un bref aperçu :

Ces plateformes répondent à divers besoins, des petites équipes aux entreprises, en proposant des outils permettant de gagner du temps, de réduire les coûts et d'améliorer l'efficacité. Découvrez ci-dessous leurs fonctionnalités, leurs tarifs et leurs cas d'utilisation pour trouver la solution la mieux adaptée à votre organisation.

Comparaison des systèmes de flux de travail IA : fonctionnalités, prix et meilleurs cas d'utilisation

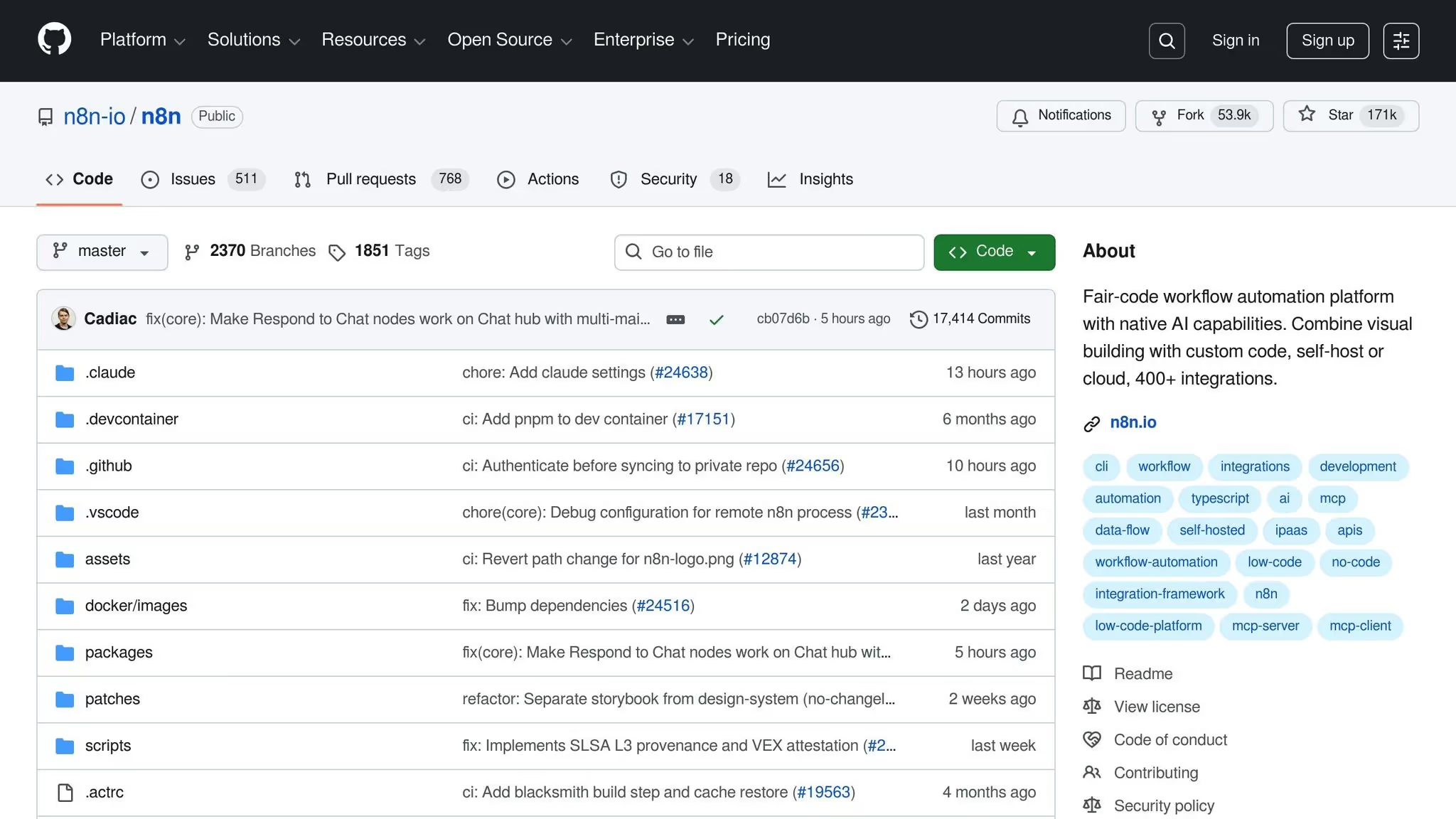

n8n est une plateforme d'automatisation des flux de travail open source qui trouve un équilibre entre la précision du codage et la rapidité de la conception visuelle. Avec plus de 170 000 étoiles sur GitHub et une communauté florissante de 200 000 membres, il s'agit de l'une des principales solutions de flux de travail alimentées par l'IA. Capable d'exécuter jusqu'à 220 flux de travail par seconde sur une seule instance, n8n est conçu pour gérer les opérations les plus exigeantes.

Avec plus de 400 intégrations préconfigurées et un nœud de requête HTTP polyvalent pour n'importe quelle API REST, n8n fournit une boîte à outils robuste pour l'automatisation. Une caractéristique remarquable est sa Déclencheur de serveur MCP, permettant à des systèmes d'IA externes de lancer directement des flux de travail n8n, offrant ainsi un niveau d'adaptabilité architecturale difficile à trouver ailleurs. En outre, les utilisateurs peuvent accéder à plus de 1 700 modèles de flux de travail, ce qui facilite le démarrage des projets.

En 2024, Luka Pilic, responsable technique du marché chez StepStone, a expliqué comment n8n avait transformé ses opérations :

« Nous avons accéléré de 25 fois l'intégration des sources de données du marché. Il me faut au maximum 2 heures pour connecter des API et transformer les données dont nous avons besoin. Vous ne pouvez pas le faire aussi vite dans le code. »

En tirant parti de n8n, StepStone a réduit les tâches qui prenaient auparavant deux semaines à seulement deux heures, démontrant ainsi l'efficacité de la plateforme dans la gestion d'intégrations complexes.

n8n intègre Chaîne Lang pour permettre aux utilisateurs de créer des applications d'IA modulaires, des agents en plusieurs étapes et des chaînes transparentes pour les flux de travail. Il propose des nœuds d'IA spécialisés pour travailler avec les LLM, les magasins vectoriels et les chargeurs de documents, ce qui en fait un excellent choix pour créer des systèmes RAG (Retrieval-Augmented Generation). Le Générateur de flux de travail IA simplifie le développement en permettant aux utilisateurs de créer, d'affiner et de déboguer des flux de travail à l'aide du langage naturel.

En 2024, SanctiFai, un leader de la collaboration homme-IA, a créé son premier flux de travail basé sur l'IA en seulement 2 heures, un processus qui aurait pris trois fois plus de temps avec Python pour LangChain. Cette rapidité a permis aux chefs de produit de concevoir et de tester des flux de travail sans avoir besoin d'une assistance technique approfondie, même au sein d'une équipe de plus de 400 employés.

n8n propose de puissantes fonctionnalités de personnalisation grâce à son Nœud de code, prenant en charge JavaScript et Python pour les transformations personnalisées. Pour les configurations auto-hébergées, les utilisateurs peuvent améliorer les fonctionnalités en ajoutant des bibliothèques npm ou Python. La plateforme prend également en charge les interventions « humaines au courant », permettant aux équipes d'introduire des étapes d'approbation ou des dérogations manuelles avant l'exécution des actions d'IA, ce qui est essentiel pour maintenir la conformité et la sécurité.

Dennis Zahrt, directeur de la prestation de services informatiques mondiaux chez Delivery Hero, a souligné l'impact de n8n sur ses opérations :

« Nous avons constaté des améliorations d'efficacité considérables depuis que nous avons commencé à utiliser n8n pour la gestion des utilisateurs. C'est simple à utiliser. »

En mettant en œuvre un flux de travail ITOps unique, Delivery Hero a économisé 200 heures par mois grâce à une gestion automatisée des utilisateurs.

n8n est conçu pour équipes techniques et développeurs qui ont besoin du contrôle du codage combiné à la rapidité des flux de travail visuels. Ses capacités d'auto-hébergement le rendent particulièrement attrayant pour des secteurs tels que la finance et la santé, où la confidentialité des données est essentielle. Les équipes DevOps et informatiques utilisent n8n pour des tâches telles que la réponse aux incidents, la surveillance de l'infrastructure et la gestion des utilisateurs, tandis que les équipes marketing et opérationnelles s'y appuient pour exécuter des campagnes complexes pilotées par l'IA sans encourir de coûts élevés à chaque étape.

n8n emploie un modèle de facturation basé sur l'exécution, facturant par flux de travail terminé plutôt que par étape individuelle. Cette approche peut entraîner des économies importantes pour les utilisateurs qui gèrent des flux de travail complexes.

Avec un Évaluation de 4,9/5 étoiles sur G2, n8n est réputé pour son adaptabilité et sa rentabilité, ce qui en fait un choix fiable pour la mise à l'échelle des flux de travail d'automatisation.

Zapier se distingue en tant que plateforme d'automatisation largement utilisée, connectant plus de 8 000 applications et alimentant plus de 350 millions de tâches d'IA fin 2025. C'est un excellent choix pour les équipes qui recherchent des solutions d'automatisation rapides et conviviales.

Zapier se connecte à un vaste écosystème de plus de 8 000 applications, dont près de 500 intégrations spécifiques à l'IA. Une caractéristique clé est Zapier MCP (Model Context Protocol), qui agit comme un pont, permettant à des plateformes d'IA telles que ChatGPT, Claude et Cursor d'effectuer plus de 30 000 actions au sein du réseau Zapier. Cela élimine le besoin de configurations d'API personnalisées, permettant aux utilisateurs de déclencher des flux de travail avec leurs outils d'IA préférés de manière fluide.

La plateforme prend également en charge Sources de connaissances, en extrayant le contexte des données internes stockées dans des outils tels que Google Drive, Notion et Confluence. Cela garantit que les réponses générées par l'IA sont fondées sur les informations spécifiques de votre organisation, évitant ainsi les sorties génériques.

En avril 2025, Vendasta a mis en œuvre un système d'enrichissement du plomb piloté par l'IA et conçu par le spécialiste des opérations marketing Jacob Sirrs. Ce flux de travail capture les prospects à partir de formulaires, les enrichit à l'aide d'Apollo et Clay et exploite l'IA pour résumer les données avant de les acheminer vers les équipes commerciales. Le système s'est rétabli 1 million de dollars de revenus potentiels et enregistré 282 jours ouvrables par an.

Zapier s'intègre aux principaux LLM, offrant un accès intégré à des modèles tels que GPT d'OpenAI, Claude d'Anthropic, Gemini de Google et Azure OpenAI. Les utilisateurs peuvent utiliser gratuitement des modèles tels que GPT-4o mini et Gemini 2.0 Flash ou connecter leurs propres clés API pour d'autres modèles. La plateforme comprend un Assistant rapide, qui affine les instructions pour des sorties LLM optimisées grâce à un indicateur de puissance intégré.

Agents Zapier aller plus loin dans l'automatisation en permettant à l'IA de gérer des tâches complexes nécessitant beaucoup de recherche, en offrant des capacités de prise de décision dynamiques et contextuelles.

Par exemple, en avril 2025, Remote.com a lancé un service d'assistance informatique basé sur l'IA dirigé par Marcus Saito, responsable de l'informatique et de l'automatisation de l'IA. Le système traite les demandes provenant de Slack et des e-mails, les catégorise et les hiérarchise à l'aide de l'IA, et les résout 27,5 % de tous les billets de manière autonome. Soutenant un effectif de 1 700 employés avec seulement trois membres du personnel informatique, le système a permis d'économiser 500 000$ de coûts d'embauche annuels.

« Zapier donne à notre équipe de trois l'impression d'être une équipe de dix personnes. » - Marcus Saito, responsable de l'automatisation informatique et de l'IA, Remote

Offres Zapier Copilote, un assistant d'IA capable de concevoir des systèmes multiproduits complets en fonction d'instructions en langage naturel. Les utilisateurs décrivent simplement leurs besoins et Copilot génère des flux de travail, des formulaires, des chatbots, etc. Pour visualiser des processus complexes, Toile Zapier permet aux équipes de cartographier les flux de travail pilotés par l'IA, d'identifier les goulots d'étranglement et de s'aligner sur l'exécution avant de créer.

Pour ceux qui ont besoin d'une personnalisation avancée, Fonctions Zapier permet aux utilisateurs d'exécuter des scripts Python, y compris des bibliothèques telles que Pandas, NumPy et TensorFlow, dans les flux de travail. De plus, la plateforme prend en charge l'humain au courant flux de travail via l'intégration de Slack, permettant des étapes d'approbation manuelles avant l'exécution des actions d'IA.

En avril 2025, Okta a mis en œuvre un robot d'escalade basé sur Slack et dirigé par le directeur principal Korey Marciniak. Ce système a rationalisé l'escalade des affaires, réduisant le temps passé par ticket de 10 minutes. Actuellement, 13 % de toutes les escalades d'Okta Workforce Identity sont gérés par cette automatisation.

Zapier est conçu pour utilisateurs non techniques et équipes commerciales qui souhaitent automatiser les flux de travail sans avoir besoin d'assistance technique. Il est particulièrement apprécié des équipes chargées du marketing, des opérations et de la réussite client qui ont besoin d'orchestrer des flux de travail basés sur l'IA dans de nombreuses applications. Les outils en langage naturel de la plateforme la rendent idéale pour les chefs de produit et les spécialistes des opérations qui souhaitent tester et déployer des automatisations en quelques heures plutôt qu'en quelques semaines.

Zapier fonctionne sur modèle de facturation basé sur les tâches, où chaque action d'un flux de travail compte comme une tâche. Les niveaux de tarification sont les suivants :

Avec un Évaluation de 4,5/5 sur G2 et 4.7/5 sur Capterra, Zapier est réputé pour sa facilité d'utilisation et son vaste répertoire d'applications, bien que les coûts puissent augmenter en cas de volumes de tâches élevés.

Faites-vous démarquer des plateformes d'automatisation en combinant l'intégration de l'IA à une conception visuelle intuitive des flux de travail, rationalisant ainsi les opérations comme jamais auparavant. Cette plateforme permet aux utilisateurs de créer des flux de travail pilotés par l'IA en temps réel, en connectant plus de 3 000 applications prédéfinies et en proposant plus de 400 intégrations spécifiques à l'IA. Il s'agit notamment d'outils bien connus tels qu'OpenAI (ChatGPT, Sora, DALL-E, Whisper), Anthropic Claude, Google Vertex AI (Gemini), Azure OpenAI et Perplexity AI.

Make propose plus de 30 000 actions possibles dans son écosystème, avec une utilisation de l'IA dans les flux de travail qui devrait quadruple tout au long de 2024. Sa vaste bibliothèque de plus de 7 500 modèles prédéfinis accélère considérablement le déploiement. L'une des principales caractéristiques est la Protocole de contexte modèle (MCP), un serveur hébergé dans le cloud qui connecte en toute sécurité les services internes et externes. Cela permet aux utilisateurs d'accéder à Make scenarios depuis n'importe quelle interface d'IA sans avoir à gérer l'infrastructure.

Par exemple, Téléclinique, un fournisseur de télésanté allemand, a fait appel à Make pour développer ses activités. Sous la direction de Philipp Weidenbach, responsable des opérations, la plateforme a permis de réduire la friction des processus, de réduire les coûts et de libérer l'équipe d'assistance des tâches répétitives.

« Make nous a vraiment aidés à développer nos opérations, à simplifier nos processus, à réduire les coûts et à soulager notre équipe d'assistance. » - Philipp Weidenbach, responsable des opérations, Teleclinic

Grâce à ces intégrations, Make permet aux utilisateurs d'en faire plus grâce à leurs flux de travail pilotés par l'IA.

Make permet aux utilisateurs de créer Des agents d'IA capables de raisonner de manière dynamique, allant au-delà des systèmes rigides basés sur des règles. Ces agents peuvent intégrer les scénarios Make existants en tant qu'outils modulaires, en effectuant des tâches telles que les contrôles d'inventaire ou les passations de commandes. La plateforme propose également Maia, un assistant d'intelligence artificielle qui simplifie la résolution des erreurs et la création de scénarios grâce à des commandes en langage naturel, réduisant ainsi considérablement le temps de développement.

Une autre caractéristique remarquable est le L'humain dans la boucle application, qui garantit un examen manuel des sorties générées par l'IA avant qu'elles ne soient poursuivies. Cette fonctionnalité permet d'éviter les inexactitudes et de maintenir la cohérence du contenu destiné aux clients. En outre, Make fournit des outils avancés de manipulation des données et une logique conditionnelle pour un contrôle précis des flux de travail.

Le canevas visuel de Make offre aux utilisateurs un contrôle total sur leurs flux de travail, leur permettant de concevoir des scénarios modulaires adaptés à leurs besoins. Les utilisateurs peuvent définir le comportement des agents à l'aide d'instructions globales, définir des règles spécifiques et intégrer l'une des plus de 3 000 applications disponibles. Pour les équipes ayant des exigences uniques, Make prend en charge les connexions API personnalisées, permettant une intégration fluide de systèmes propriétaires.

Shop Accelerator Martech a obtenu des résultats transformateurs avec Make. Selon Cayden Phipps, COO, certains clients ont vu leurs revenus augmenter de 10x grâce aux automatisations pilotées par l'IA de la plateforme.

« Make apporte une efficacité sans précédent au sein de notre entreprise d'une manière que nous n'aurions jamais imaginée. C'est avoir un employé supplémentaire (ou 10) pour une fraction du coût. » - Cayden Phipps, COO, Shop Accelerator Martech

Make est conçu pour équipes commerciales et développeurs citoyens qui cherchent à créer des automatisations avancées sans avoir besoin d'expertise en programmation. Son interface visuelle conviviale s'adresse aux responsables des opérations, aux spécialistes du marketing et aux responsables de produits qui ont besoin d'itérer rapidement. Les organisations qui souhaitent une automatisation centralisée entre les services trouveront des fonctionnalités telles que Créer une grille inestimable pour fournir une vision claire de leur paysage d'automatisation.

Faites usage d'un modèle de tarification basé sur le crédit, où les opérations consomment des crédits en fonction de leur complexité. La plateforme propose cinq niveaux de tarification :

Avec un Évaluation de 4.8/5 sur Capterra (404 commentaires) et 4.7/5 sur G2 (238 avis), Make est apprécié pour sa facilité d'utilisation et sa polyvalence. Cependant, certains utilisateurs mentionnent une courbe d'apprentissage abrupte et une interface qui peut sembler dépassée par rapport aux nouvelles plateformes natives d'IA.

Gumloop est une plateforme d'automatisation alimentée par l'IA conçue pour permettre aux équipes de tirer parti de grands modèles de langage (LLM) sans expertise en matière de codage. Lancé en 2023, Gumloop a déjà automatisé plus de 400 millions de tâches, gagnant la confiance de grandes marques comme Instacart, Webflow et Shopify. Sa force réside dans le fait qu'il offre des fonctionnalités de niveau entreprise tout en restant convivial pour les professionnels non techniques. Cette approche permet une intégration fluide entre divers systèmes d'entreprise.

Offres Gumloop Plus de 120 nœuds prédéfinis pour connecter des outils professionnels largement utilisés tels que Salesforce, Apollo, Gmail, Slack et Airtable. Pour encore plus de flexibilité, sa fonctionnalité GumCP permet l'intégration à toute application prenant en charge un serveur MCP. Les automatisations peuvent être déclenchées via des webhooks, des API REST ou des SDK, tandis que le routeur AI de la plateforme détermine intelligemment les prochaines étapes en fonction du contexte.

L'une des caractéristiques les plus remarquables de Gumloop est sa prise en charge de plusieurs LLM, notamment ChatGPT, Claude, Gemini, Grok et Deepseek. Ces modèles sont disponibles dans le cadre d'un seul abonnement, ce qui élimine les tracas liés à la gestion de clés d'API distinctes. En outre, le Proxy IA Cette fonctionnalité permet aux organisations d'acheminer les demandes via leurs propres proxys, tout en gardant le contrôle de la gestion des clés d'API.

Gumloop simplifie l'intégration des modèles d'IA grâce à des outils tels que Gummie, un assistant d'intelligence artificielle qui aide les utilisateurs à créer des automatisations et à corriger les erreurs à l'aide de commandes en langage naturel. Les utilisateurs peuvent décrire leurs flux de travail en anglais clair et Gummie génère automatiquement la structure de nœuds nécessaire. Tous les forfaits payants incluent l'accès à des LLM avancés tels que GPT o3-pro, Claude 4 Sonnet et Gemini 2.5 Pro sans frais supplémentaires pour les modèles individuels.

« Gumloop a joué un rôle essentiel en aidant toutes les équipes d'Instacart, y compris celles sans compétences techniques, à adopter l'IA et à automatiser leurs flux de travail, ce qui a considérablement amélioré notre efficacité opérationnelle. » - Fidji Simo, PDG d'Instacart

Pour les développeurs, CV fonctionnalité (Cmd/Ctrl + Shift + Entrée) rationalise les tests en permettant aux utilisateurs d'accéder directement à des nœuds spécifiques, ce qui permet d'économiser du temps et des crédits.

Le canevas visuel de Gumloop facilite la création de flux de travail complexes. Les utilisateurs peuvent glisser-déposer des éléments pour créer des flux de travail, grâce à la technologie modulaire Sous-flux disponibles pour être réutilisées dans tous les projets. Pour les flux de travail comportant plus de 10 à 15 nœuds, leur division en sous-flux améliore l'organisation et facilite la maintenance. Le Interfaces Cette fonctionnalité transforme les flux de travail en applications conviviales, permettant aux membres de l'équipe d'interagir avec les automatisations sans avoir à comprendre la logique sous-jacente.

« Gumloop permet de gagner du temps au sein d'une organisation. Il met les outils entre les mains de personnes qui comprennent une tâche et leur permet de l'automatiser complètement. » - Bryant Chou, cofondateur de Webflow

Les fonctionnalités supplémentaires incluent une extension Chrome pour enregistrer les actions du navigateur sur des sites sans API et la possibilité de créer des nœuds personnalisés, permettant aux organisations d'intégrer des outils et des bases de données propriétaires de manière fluide.

Gumloop est conçu pour professionnels non techniques tels que les spécialistes du marketing, les fondateurs, les responsables des ressources humaines, les équipes commerciales et le personnel du support client. Il excelle dans l'automatisation de tâches telles que la prospection commerciale, la surveillance des tendances marketing, la synchronisation des données opérationnelles en temps réel et le tri des demandes d'assistance client. Les équipes d'Albert ont particulièrement profité de l'accessibilité de la plateforme.

« Grâce à Gumloop, n'importe quel membre de l'équipe peut désormais identifier un processus manuel et le transformer en flux de travail automatisé sans écrire une seule ligne de code. » - David Phelps, vice-président des études, Albert

Gumloop utilise une structure de tarification basée sur le crédit avec quatre niveaux :

Si les utilisateurs apprécient l'interface épurée de la plateforme et son puissant assistant d'IA, certains remarquent que la courbe d'apprentissage peut être plus abrupte par rapport aux outils d'automatisation plus traditionnels. En tant que nouvelle plateforme, l'interface utilisateur de Gumloop continue d'évoluer à mesure que de nouvelles fonctionnalités sont introduites.

Vellum AI est une plateforme robuste conçue pour rationaliser le déploiement d'agents d'IA et d'applications LLM à grande échelle. C'est architecture de flux de contrôle donne la priorité à la définition de séquences d'opérations par rapport à de simples transformations de données. Cela permet des fonctionnalités avancées telles que les boucles, la récursivité, le fork d'état et l'exécution parallèle, des fonctionnalités clés pour créer des systèmes d'IA autonomes capables de gérer des actions en plusieurs étapes sur diverses plateformes.

Vellum s'intègre parfaitement à plus de 40 systèmes natifs à l'aide d'une structure de nœuds extensible. Il s'agit notamment Nœuds d'API pour effectuer des requêtes HTTP, Nœuds d'exécution de code pour exécuter une logique Python ou TypeScript personnalisée, et Nœuds de recherche pour connecter des flux de travail à des index de documents. La plateforme prend également en charge synchronisation bidirectionnelle entre son éditeur visuel et les SDK TypeScript/Python, permettant aux ingénieurs et aux utilisateurs non techniques de collaborer facilement.

Cette approche collaborative permet aux ingénieurs de gérer une logique complexe tandis que les utilisateurs non techniques modifient les instructions directement dans l'interface. Toutes les mises à jour se rechargent instantanément à chaud, garantissant des transitions fluides entre les environnements. Par exemple, Woflow a tiré parti de Vellum pour accélérer le développement de l'IA de 50 %, en découplant les mises à jour des cycles de publication, comme l'a noté le directeur technique Jordan Nemrow en 2025. Ces capacités d'intégration, combinées à une orchestration flexible des modèles, font de Vellum un choix exceptionnel pour les équipes qui créent des pipelines de génération retrieval-augmentée (RAG) et d'autres flux de travail d'IA.

Vélins orchestration indépendante du modèle permet aux équipes d'utiliser plusieurs LLM, comme ceux d'OpenAI, d'Anthropic, de Google, d'IBM et de Meta, au sein d'un seul flux de travail. Cette flexibilité permet aux équipes d'associer des modèles peu coûteux pour des tâches plus simples, comme la catégorisation, à des modèles à haut raisonnement pour des résultats plus complexes, le tout sans jongler avec plusieurs intégrations d'API. La plateforme inclut également un langage naturel Créateur d'agents, qui transforme les descriptions en anglais clair en flux de travail prêts à être utilisés en production.

« Nous avons multiplié par deux notre calendrier de 9 mois et avons atteint une précision à toute épreuve grâce à notre assistant virtuel. Vellum a contribué à rendre nos données exploitables et fiables. » - Max Bryan, vice-président de la technologie et du design

Pour les environnements de production, Vellum propose Évaluations pour des tests rigoureux, des annulations en un clic pour le contrôle des versions et une observabilité complète pour suivre les entrées, les sorties et les mesures de performance. GravityStack a utilisé ces fonctionnalités pour réduire les délais de révision des contrats de crédit de 200 % pour une institution financière en 2025. Cette approche souligne l'engagement de Vellum à créer des flux de travail interopérables et intelligents.

Vellum fournit Sous-flux de travail, des composants réutilisables qui rationalisent la logique et assurent la cohérence entre les équipes. Pour les processus critiques, tels que les approbations légales ou financières, L'humain au cœur de la boucle cette fonctionnalité interrompt les flux de travail, permettant une révision manuelle avant de continuer. En outre, Différence rapide permet aux équipes de comparer les changements de version, garantissant ainsi la sécurité des mises à jour, du développement à la production.

La plateforme prend en charge des options de déploiement flexibles, notamment des configurations cloud, VPC privé, hybrides et sur site, ainsi que des environnements isolés pour une sécurité maximale. Les fonctionnalités professionnelles telles que le contrôle d'accès basé sur les rôles (RBAC), le SSO/SCIM, les pistes d'audit et les flux de travail d'approbation répondent aux exigences strictes en matière de conformité et de résidence des données.

Le vélin est conçu pour équipes interfonctionnelles, permettant aux ingénieurs, aux chefs de produit, aux responsables des opérations et aux analystes commerciaux de collaborer efficacement sur des projets d'IA. Il excelle dans des applications telles que les chatbots de support client, l'automatisation de l'examen juridique et documentaire, les flux de travail de conformité et les assistants virtuels de santé. Par exemple, Miri Health a utilisé Vellum pour développer un chatbot de bien-être alimenté par l'IA, permettant aux parties prenantes non techniques de contribuer activement au développement des produits.

« Vellum a permis de valider rapidement les idées d'IA et de se concentrer sur celles qui comptent le plus. L'équipe produit peut créer des POC avec peu ou pas d'assistance en une semaine ! » - Pratik Bhat, chef de produit senior, AI Product

Les secteurs tels que la finance, la santé, le droit, la vente au détail, les technologies de l'éducation et les organisations du secteur public bénéficient le plus de la gouvernance de niveau entreprise et des capacités d'itération rapide de l'IA de Vellum.

Vellum propose une niveau gratuit pour les tests initiaux, avec des forfaits payants à partir de 25$ par mois. Les plans d'entreprise sont disponibles avec une tarification personnalisée pour les organisations qui ont besoin d'une gouvernance avancée, d'une conformité SOC 2 ou HIPAA et d'options de déploiement flexibles. Les tarifs varient en fonction de l'utilisation et de la taille de l'équipe, les entreprises clientes bénéficiant d'une assistance dédiée et de contrats de niveau de service personnalisés.

Workato est une puissante plateforme d'intégration conçue pour l'automatisation au niveau de l'entreprise, offrant Connectivité universelle pour relier des outils SaaS modernes, des ERP sur site, des entrepôts de données et même des systèmes existants plus anciens. Avec plus de 1 200 connecteurs prédéfinis pour des plateformes telles que Salesforce, Workday, SAP, ServiceNow, Snowflake et Redshift, il fournit une solution complète aux entreprises qui gèrent des écosystèmes technologiques complexes. Reconnu comme leader dans le Magic Quadrant de Gartner consacré à la plateforme d'intégration en tant que service (iPaaS) pendant sept années consécutives, Workato a prouvé sa fiabilité et son évolutivité dans les environnements d'entreprise. Ci-dessous, nous explorons les fonctionnalités remarquables de la plateforme.

Workato's Enterprise MCP (Model Context Protocol) agit comme une couche d'orchestration, permettant aux agents d'IA d'effectuer des tâches avec une précision contextuelle tout en garantissant la sécurité et l'auditabilité. Ce système fait la distinction entre deux types de fonctionnalités d'IA : Copilotes, qui utilisent l'IA générative pour créer et documenter des flux de travail, et IA agentique, des agents autonomes développés dans Agent Studio pour gérer des flux de travail en plusieurs étapes. La passerelle MCP expose en toute sécurité les API et les flux de travail à de grands modèles de langage (LLM), permettant aux agents d'IA d'interagir avec les systèmes de l'entreprise tout en maintenant des contrôles de gouvernance stricts tels que l'authentification, la limitation du débit et la surveillance de la conformité.

Le AI par Workato Le connecteur utilitaire s'intègre parfaitement à Anthropic (Sonnet 4) et OpenAI (GPT-4o mini) pour des tâches telles que l'analyse de texte, la classification, la synthèse et la traduction. Il prend également en charge OpenAI, Claude, Llama et Ollama pour des actions telles que l'achèvement du chat et la génération d'intégration. Studio d'agent fournit un environnement low-code pour créer, tester et déployer des agents d'IA, appelés « Genies », personnalisés pour les besoins commerciaux, tels que l'intégration des ressources humaines, la réinitialisation des mots de passe informatiques et les études commerciales. Pour maintenir la conformité, Workato applique la résidence des données, en veillant à ce que le traitement des données d'IA soit effectué dans le centre de données de la région source aux États-Unis ou dans la zone EMEA. Ces fonctionnalités d'IA aident les entreprises à simplifier et à accélérer les processus les plus complexes.

Workato est conçu pour répondre aux besoins des équipes commerciales et informatiques. Les utilisateurs professionnels bénéficient d'accélérateurs sans code, tandis que les équipes informatiques peuvent tirer parti des outils de gouvernance robustes de la plateforme et du SDK Connector. Les entreprises ont déclaré traiter les demandes de relocalisation de leurs employés 98 % plus rapidement et économiser plus de 100 000 heures grâce à l'automatisation.

« Les utilisateurs professionnels adoptent rapidement Workato et deviennent les champions de l'autonomisation des équipes. » - Mohit Rao, responsable de l'automatisation intelligente

Workato suit une structure tarifaire basée sur des forfaits, dont les détails sont disponibles par le biais d'un contact commercial direct. Les fonctionnalités d'IA sont incluses dans certains forfaits, avec des limites tarifaires spécifiques en fonction du niveau de client. La plate-forme est conçue avec une sécurité de niveau professionnel, avec la conformité à la norme SOC 2 Type II, à la norme ISO 27001 et au RGPD pour garantir la protection et la fiabilité des données.

Tray.io est une puissante plateforme d'intégration équipée de plus de 700 connecteurs et d'outils avancés d'orchestration de l'IA, destinée à la fois aux utilisateurs professionnels et aux développeurs. Avec une base de clients de plus d'un million, elle a obtenu le titre d' « iPaaS prêt pour l'IA ». L'une des caractéristiques les plus remarquables est le Créateur d'agents Merlin, un outil sans code qui permet aux utilisateurs de créer et de déployer des agents d'IA capables d'analyser les données de l'entreprise et d'effectuer des tâches sur des plateformes populaires telles que Salesforce, HubSpot, Workday et NetSuite.

Tray.io Passerelle pour agents donne aux équipes informatiques une supervision centralisée des serveurs et des outils MCP (Model Context Protocol), garantissant une gouvernance et une transparence solides à mesure que les capacités d'IA se développent. La plateforme fournit des connexions natives aux principaux modèles linguistiques de grande taille, notamment OpenAI (GPT), Amazon Bedrock et Claude Sonnet 4.5. C'est Connectivité hybride Cette fonctionnalité relie en toute sécurité les bases de données locales et les systèmes existants aux flux de travail dans le cloud sans les exposer à l'Internet public. Les développeurs peuvent également tirer parti du Connector Development Kit (CDK) pour créer ou importer des intégrations à l'aide de TypeScript ou OpenAPI. Ces outils constituent l'épine dorsale des capacités d'intégration et d'IA de Tray.io.

Tray.io s'appuie sur ses atouts d'intégration avec Palette AI, permettant aux équipes de prototyper rapidement des flux de travail optimisés par l'IA et de s'adapter aux dernières avancées du modèle de langage large (LLM) en quelques minutes. La plateforme utilise Tableaux vectoriels et Mémoire et connaissance fonctionnalités permettant d'ancrer les agents d'IA dans les données de l'entreprise, garantissant des réponses précises et contextuelles. Par exemple, Apollo, un client de Tray.io, a réduit le volume de tickets informatiques de près de 40 % en déployant un agent IA intégré à la plateforme. Pour protéger les informations sensibles, Merlin Guardian Cette fonctionnalité permet le chiffrement, la tokenisation et la rédaction, tout en maintenant la conformité aux normes SOC 1, SOC 2 Type 2, GDPR, HIPAA et CCPA.

Tray.io est conçu à la fois pour les équipes informatiques qui donnent la priorité à la gouvernance et à la sécurité et pour les équipes commerciales des départements tels que les ventes, le marketing, les ressources humaines et les finances qui bénéficient d'une automatisation sans code. Les équipes des opérations fiscales utilisent la plateforme pour rationaliser les processus d'approvisionnement en espèces, tandis que les équipes des ressources humaines intègrent des outils tels que Workday, Greenhouse et BambooHR pour améliorer le suivi des candidats. Les équipes produit peuvent intégrer des intégrations directement dans leur logiciel, ce qui permet aux clients de connecter des systèmes sans quitter l'application. Le Centre d'agents simplifie encore le processus en proposant des composants et des sources de données réutilisables pour accélérer la création d'agents d'IA personnalisés.

Tray.io suit un modèle de tarification d'entreprise basé sur les espaces de travail et le volume de tâches. Il prend en charge l'hébergement régional aux États-Unis, dans l'UE et dans la région Asie-Pacifique pour répondre aux exigences de résidence des données. De plus, son Exécution élastique cette fonctionnalité garantit une mise à l'échelle automatique pendant les pics d'utilisation, éliminant ainsi la nécessité d'une gestion manuelle des serveurs.

Lindy.ai aborde l'automatisation des flux de travail avec une nouvelle perspective, en s'appuyant sur Agents d'IA qui apprennent et s'adaptent au lieu de s'en tenir à des règles fixes et préprogrammées. Conçu pour les équipes non techniques et les travailleurs du savoir, qui consacrent souvent près de 40 % de leur temps à des tâches répétitives, Lindy.ai se distingue en proposant aux agents mémoire persistante et contexte. Cela signifie qu'ils peuvent prendre des décisions plus intelligentes sur la base d'interactions antérieures, même lorsqu'ils sont confrontés à des entrées inattendues, contrairement aux outils d'automatisation traditionnels qui peuvent échouer dans de tels scénarios.

Lindy.ai se connecte parfaitement à plus de 3 000 applications dès la sortie de la boîte et s'étend jusqu'à Plus de 7 000 intégrations dans plus de 1 600 applications via des connecteurs natifs, des partenariats Pipedream, des API et des webhooks. Sa caractéristique la plus remarquable est collaboration entre plusieurs agents, où des agents spécialisés en IA travaillent ensemble au sein de ce que Lindy appelle des « sociétés d'agents ». Par exemple, un agent peut rechercher un prospect, un autre rédige un e-mail et un troisième met à jour le CRM, le tout fonctionnant de manière synchronisée. Le Fonction de pilote automatique ajoute une autre couche de flexibilité en permettant aux agents d'utiliser leurs propres « ordinateurs virtuels dans le cloud » pour gérer des tâches qui ne sont pas directement intégrées aux API. Ce vaste écosystème d'intégration améliore la capacité de Lindy.ai à rationaliser les flux de travail sur différentes plateformes.

Lindy.ai exploite la puissance de grands modèles de langage tels que GPT et Claude pour traiter des données non structurées et gérer des entrées imprévisibles qui perturberaient généralement les systèmes basés sur des règles. Cette approche axée sur l'IA peut réduire les temps de traitement des tâches en 67 % et fournir aux organisations un 30 à 200 % de retour sur investissement dès la première année. Ces agents fonctionnent davantage comme des assistants humains, pensant et s'adaptant en temps réel. Leur polyvalence se reflète dans des applications telles que l'enrichissement des prospects, la hiérarchisation des tickets d'assistance client en fonction du sentiment et de l'urgence, les flux de travail de recrutement et les tâches opérationnelles telles que la gestion des e-mails ou la prise de notes de réunion.

Lindy.ai facilite la personnalisation grâce à un créateur d'agents intuitif. Les utilisateurs peuvent créer des agents à l'aide de simples instructions en langage naturel ou d'un éditeur visuel par glisser-déposer, ce qui le rend particulièrement convivial pour les personnes non techniques. La plateforme respecte des normes de conformité strictes, notamment SOC 2, HIPAA, GDPR, PIPEDA et SOX, ce qui en fait un choix fiable pour les secteurs tels que la santé et la finance qui traitent des données sensibles.

Lindy.ai propose une plan gratuit qui comprend 400 crédits par mois. Pour ceux qui ont besoin de plus, le plan payant commence à 49$ par mois, couvrant jusqu'à 5 000 tâches. Cette structure tarifaire garantit l'accessibilité aux petites équipes et aux professionnels individuels qui cherchent à automatiser efficacement les tâches répétitives.

Agentforce s'intègre directement à Salesforce Customer 360, apportant des fonctionnalités d'IA avancées pour rationaliser les flux de travail dans les domaines des ventes, du service, du marketing et du commerce. Alimenté par le moteur de raisonnement Atlas, il simplifie les processus complexes en les divisant en étapes gérables, en évaluant les stratégies d'exécution et en effectuant de manière autonome des tâches en plusieurs étapes. Sa connexion étroite avec Salesforce garantit une automatisation sécurisée et efficace adaptée aux besoins des entreprises.

Agentforce étend ses fonctionnalités au-delà de Salesforce en utilisant MuleSoft Agent Fabric et des connecteurs API, permettant une communication fluide avec les systèmes existants et les bases de données externes. Avec Data 360, les données structurées et non structurées peuvent être unifiées pour la génération augmentée par extraction (RAG) sans dupliquer les données, ce qui permet d'économiser du temps et des ressources. La sécurité est une priorité absolue, l'Einstein Trust Layer offrant des fonctionnalités telles que la détection de la toxicité, la conservation zéro des données et la mise à la terre dynamique pour protéger les informations sensibles de l'entreprise lors des interactions avec les grands modèles linguistiques (LLM). La plateforme prend également en charge le Model Context Protocol (MCP), une norme ouverte qui facilite le partage sécurisé du contexte entre divers agents, modèles et outils.

Agentforce associe des flux de travail déterministes à la flexibilité des LLM grâce à son approche de raisonnement hybride. Les développeurs peuvent définir une logique métier étape par étape à l'aide d'un « script d'agent », tandis que les LLM gèrent les éléments conversationnels, garantissant ainsi la fiabilité des opérations critiques. Selon Salesforce, cette approche permet aux entreprises de créer des agents d'IA 16 fois plus rapidement que les méthodes traditionnelles. Wiley, la maison d'édition, a enregistré une véritable réussite, qui a enregistré une augmentation de 40 % du nombre de cas résolus pendant la rentrée scolaire en septembre 2024 en utilisant Agentforce pour gérer l'accès aux comptes de routine et les demandes de paiement.

Conçu à la fois pour les administrateurs Salesforce utilisant peu de code et pour les développeurs professionnels, Agentforce est suffisamment polyvalent pour servir des secteurs tels que la santé, la banque, la vente au détail et la finance. En automatisant les tâches répétitives et chronophages, il aide les entreprises à gagner du temps pour des tâches à plus forte valeur ajoutée. Par exemple, les prestataires de santé peuvent l'utiliser pour traiter les demandes des patients, les banques peuvent rationaliser les demandes des clients, les détaillants peuvent obtenir des informations sur les campagnes et les équipes financières peuvent détecter les fraudes de manière plus efficace. Parmi les principaux utilisateurs, citons OpenTable, qui s'appuie sur Agentforce pour aider les restaurants et les clients, et Saks Global, qui l'utilise pour améliorer les expériences personnalisées de vente au détail de luxe.

Agentforce fonctionne selon un modèle de tarification basé sur la consommation, à partir de 2$ par conversation, avec des remises sur volume disponibles pour les grandes entreprises. Pour aider les entreprises à explorer ses fonctionnalités, Salesforce propose Salesforce Foundations en tant que module complémentaire à 0$ pour l'édition Enterprise et les versions supérieures, y compris des crédits pour les 1 000 premières conversations. Les options de tarification sont flexibles, avec des choix tels que la facturation par conversation ou les licences par utilisateur. Agentforce a également été reconnue comme la meilleure plateforme d'IA agentique sur G2, consolidant ainsi sa réputation sur le marché.

Getint se distingue en priorisant données synchronisées de haute qualité, la pierre angulaire de l'efficacité des agents d'IA. Alors que de nombreuses plateformes se concentrent principalement sur les déclencheurs et les actions d'automatisation, Getint emprunte une voie différente, en mettant l'accent synchronisation bidirectionnelle à travers la gestion du travail, l'ITSM et les outils de développement. Cela garantit que les problèmes, les incidents, les changements et les tâches restent parfaitement alignés sur tous les systèmes, créant ainsi une base solide pour des intégrations fluides et des performances d'IA fiables.

Réaliser des livraisons synchronisation bidirectionnelle au niveau du champ, en gérant sans effort des structures de données complexes et des champs personnalisés. Contrairement aux outils qui reposent sur l'automatisation unidirectionnelle, Getint va plus loin et garantit une synchronisation complète des objets complexes. Cela est particulièrement important pour les agents d'IA opérant dans des environnements d'outils fragmentés. La sécurité est une priorité absolue, avec la conformité à la norme ISO 27001, à la norme SOC 2 Type II et au RGPD, ainsi que le cryptage AES-256 pour les données au repos et le statut Cloud Fortified pour renforcer la confiance.

La plateforme joue un rôle crucial dans les flux de travail pilotés par l'IA en garantissant des données précises en temps réel - indispensable pour les grands modèles de langage (LLM). Lorsque les agents d'IA s'appuient sur des données provenant de plusieurs systèmes, des incohérences ou des informations obsolètes peuvent entraîner de mauvaises décisions, voire des hallucinations. Getint élimine ces risques en gardant les données synchronisées et complètes du point de vue contextuel, garantissant ainsi que les flux de travail d'IA reposent sur une base de données fiable et de haute qualité.

Getint est conçu pour les équipes ITSM, de développement, d'exploitation et de PMO qui ont besoin de plus qu'une automatisation de base. Il est particulièrement utile pour les équipes qui ont besoin d'un alignement transparent des problèmes, des incidents et des tâches sur l'ensemble des systèmes, afin de garantir qu'aucune perte de contexte n'est perdue lors des intégrations.

Getint complète ses capacités techniques avec tarification basée sur la connexion qui inclut un nombre illimité d'utilisateurs. Ce modèle prévisible simplifie la budgétisation des déploiements à l'échelle de l'entreprise, car les équipes peuvent se développer sans craindre une augmentation des coûts par utilisateur.

Les différentes plateformes apportent des atouts uniques, souvent influencés par des facteurs tels que les compétences techniques, le budget et les besoins d'intégration. Zapier se distingue par son impressionnante bibliothèque de près de 8 000 intégrations d'applications et son interface intuitive sans code, ce qui en fait le choix idéal pour les équipes non techniques. Cependant, ses coûts peuvent augmenter de manière significative à mesure que l'utilisation augmente.

D'autre part, des plateformes comme n8n et Marque (Integromat) répondre aux besoins des utilisateurs qui accordent la priorité à la personnalisation. Ces outils offrent des options d'auto-hébergement et des générateurs de flux de travail visuels, offrant aux développeurs la flexibilité d'aller au-delà des connecteurs prédéfinis. Pour les équipes travaillant sur des flux de travail à forte intensité d'IA, Gumloop simplifie la gestion des API en regroupant un accès premium à des LLM tels qu'OpenAI et Anthropic dans son abonnement.

Pour les entreprises, Travaillez à met fortement l'accent sur la gouvernance et l'intégration fluide avec les systèmes existants, bien que la tarification nécessite généralement une consultation directe. Pendant ce temps, des plateformes spécialisées comme Vélin AI et Lindy.ai répondre à des besoins de niche. Par exemple, Lindy.ai propose des agents d'IA prédéfinis conçus pour gérer des tâches répétitives telles que le tri des e-mails.

Lorsque vous choisissez un système de flux de travail basé sur l'IA, il est essentiel d'aligner votre sélection sur l'expertise technique, le budget et les exigences de conformité de votre équipe. Zapier est une option exceptionnelle pour les équipes sans code, offrant une connectivité avec plus de 8 000 applications. Cependant, à mesure que l'utilisation augmente, les coûts peuvent augmenter de manière significative. Pour les équipes qui ont besoin de plus de contrôle et de capacités d'auto-hébergement, n8n offre de la flexibilité et des options d'hébergement abordables, ce qui en fait un choix solide.

Les entreprises des secteurs réglementés, tels que la banque ou la santé, devraient se concentrer sur des plateformes dotées de solides fonctionnalités de gouvernance et de conformité. Travaillez à et Plateau .io brillent dans les configurations hybrides, en offrant une connectivité sécurisée sur site. D'autre part, Vélin AI s'adresse aux équipes dirigées par l'ingénierie, en proposant des outils pour une surveillance complète des pipelines et une expérimentation rapide.

Pour les équipes fortement tributaires des flux de travail basés sur l'IA, Gumloop simplifie les opérations en intégrant un accès LLM premium à son abonnement, éliminant ainsi les tracas liés à la gestion de plusieurs clés d'API. Si vous travaillez avec un budget plus serré, Fabriquer vaut la peine d'être explorée. Il propose plus de 7 500 modèles à partir de 10,59$ par mois, mais sa maîtrise peut nécessiter plus de temps que les autres options. Enfin, pour des besoins spécifiques tels que le tri des e-mails ou l'automatisation de tâches répétitives, Lindy.ai fournit des agents d'IA prédéfinis, avec des plans Pro à partir de 49,99 $/mois.

Lors de la sélection d'un système de flux de travail basé sur l'IA, il est important de se concentrer sur les fonctionnalités qui amélioreront l'efficacité et s'aligneront sur les objectifs de votre organisation. Commencez par capacités d'intégration - le système doit se connecter sans effort à vos outils, sources de données et modèles d'IA actuels, garantissant une automatisation fluide et un flux de données ininterrompu.

Tout aussi important est adaptabilité. La plateforme doit être capable de s'adapter à l'évolution des entrées ou des conditions, afin de prendre en charge des flux de travail dynamiques et en constante évolution.

Ne négligez pas automatisation, sécurité et gestion des coûts. Un système haut de gamme comprendra des fonctionnalités d'automatisation avancées, des protocoles de sécurité robustes pour protéger vos données et des outils pour surveiller et gérer efficacement les dépenses.

Enfin, pensez à expérience utilisateur et évolutivité. Une interface intuitive simplifie l'adoption par les équipes, tandis que l'évolutivité permet au système de gérer des charges de travail croissantes et de répondre aux demandes futures. En vous concentrant sur ces aspects, vous serez mieux équipé pour choisir une solution qui renforce les processus pilotés par l'IA et qui correspond à vos objectifs à long terme.

Plateformes de flux de travail IA telles que n8n et Zapier desservez différents publics en donnant la priorité à la convivialité et aux coûts de manière unique. n8n se distingue par sa conception visuelle flexible et ses fonctionnalités de personnalisation avancées, ce qui en fait un choix incontournable pour les utilisateurs techniques ou les équipes gérant des flux de travail plus complexes. Il prend également en charge l'auto-hébergement, ce qui permet aux utilisateurs de mieux contrôler leurs données et leur infrastructure, un avantage majeur pour ceux qui sont à l'aise avec les configurations techniques.

Zapier, en revanche, privilégie la simplicité et l'accessibilité. Son interface conviviale connecte des milliers d'applications avec un minimum d'effort, ce qui en fait une excellente option pour les utilisateurs non techniques qui souhaitent une automatisation rapide et sans tracas.

En matière de tarification, n8n utilise un modèle basé sur l'exécution des flux de travail et propose un auto-hébergement gratuit, ce qui peut être un choix rentable pour gérer des flux de travail complexes ou à grande échelle. Zapier, d'autre part, utilise une structure tarifaire basée sur les tâches avec des niveaux d'abonnement prévisibles. Bien que ces niveaux soient simples, les coûts peuvent augmenter de manière significative à mesure que le nombre de tâches exécutées augmente.

En substance, n8n est idéal pour ceux qui apprécient la personnalisation et l'évolutivité, tandis que Zapier se distingue par sa facilité d'utilisation et son processus de configuration simple.

Pour les grandes entreprises, il est crucial de choisir un système de flux de travail basé sur l'IA qui s'intègre parfaitement à des opérations complexes. Opus se distingue comme une solution de premier plan, offrant une plateforme de niveau d'entreprise adaptée à des secteurs tels que la santé, la banque et l'énergie. En mettant l'accent sur un déploiement rapide, une conformité stricte et une automatisation sécurisée, il est parfaitement adapté à la gestion efficace de flux de travail à grande échelle.

Une autre option remarquable est IBM Watsonx Orchestrate, conçu pour une intégration fluide entre divers outils et modèles d'IA. Il prend en charge l'orchestration multi-agents tout en répondant aux besoins critiques de l'entreprise tels que la gouvernance, l'évolutivité et l'observabilité.

Pour les organisations qui jonglent avec plusieurs outils d'IA, MuleSoft Tissue Agent propose un contrôle et une supervision centralisés. Il simplifie l'orchestration de systèmes d'IA disparates, garantissant à la fois efficacité et conformité. Ces plateformes répondent aux demandes complexes des grandes entreprises en offrant la sécurité, l'adaptabilité et l'automatisation intelligente nécessaires à leur réussite.