Los flujos de trabajo de aprendizaje automático pueden ser complejos y, a menudo, se ven atascados por la administración de dependencias y el seguimiento de experimentos. Las herramientas especializadas simplifican este proceso y aumentan la automatización, la eficiencia y la reproducibilidad. Flujo de aire Apache, Metaflow, Kubeflow, y MLFlow son cuatro opciones sobresalientes, cada una de las cuales aborda diferentes etapas del ciclo de vida del aprendizaje automático. Esto es lo que necesita saber:

Cada herramienta responde a una necesidad específica y, al combinarlas, se puede lograr una eficiencia aún mayor. Por ejemplo, el emparejamiento MLFlow con Kubeflow permite un seguimiento y una orquestación de modelos sin problemas. Comience con la herramienta que se adapte a su flujo de trabajo actual y, a continuación, amplíe a medida que aumenten sus necesidades.

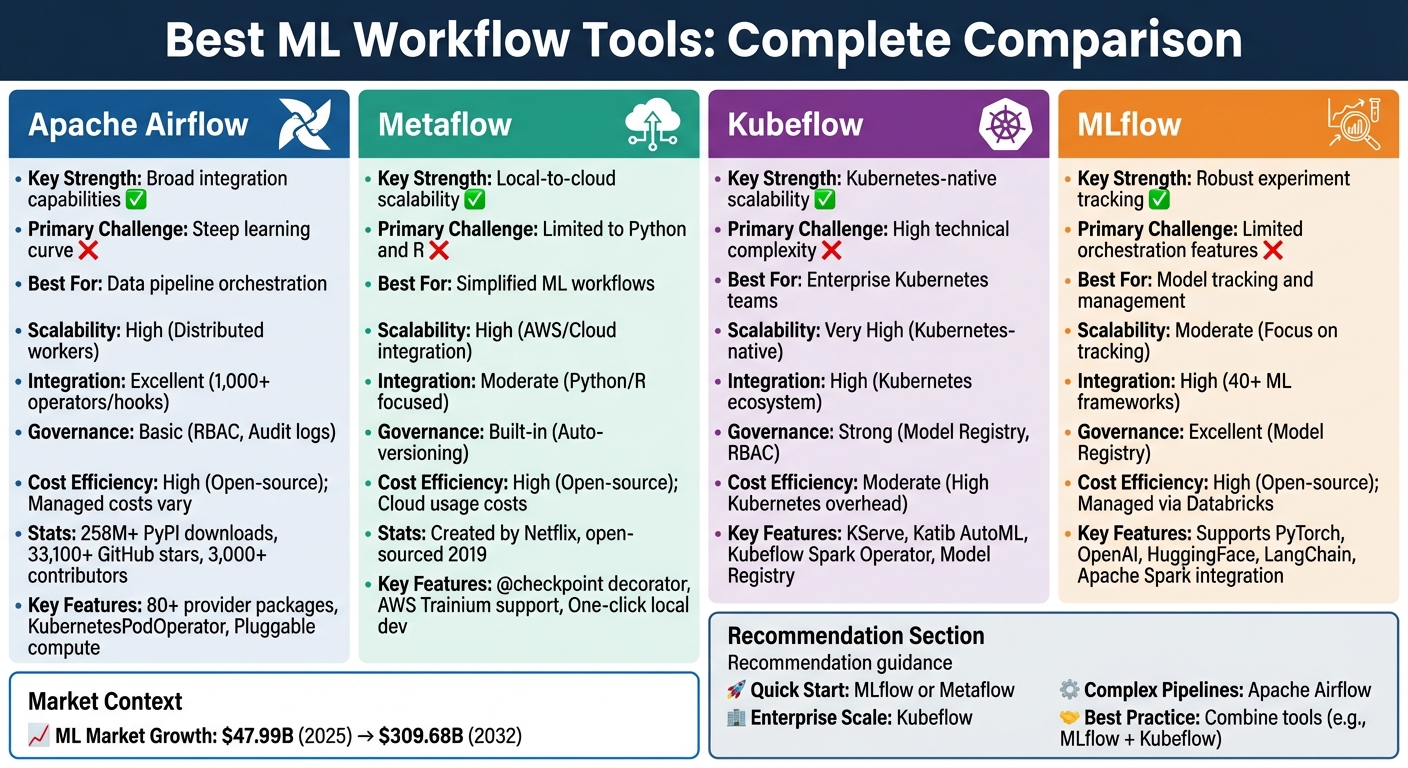

Comparación de herramientas de flujo de trabajo de aprendizaje automático: Apache Airflow frente a Metaflow frente a Kubeflow frente a MLFlow

Apache Airflow se ha convertido en el elección preferida para orquestar las canalizaciones de datos en varias plataformas. Como proyecto de la Apache Software Foundation, cuenta con estadísticas impresionantes: más de 258 millones de descargas de PyPI, más de 33 100 estrellas de GitHub y contribuciones de más de 3000 desarrolladores. Su marco nativo de Python permite a los científicos de datos convertir sin problemas los scripts de aprendizaje automático existentes en flujos de trabajo orquestados mediante herramientas sencillas como @task decorador. Este enfoque minimiza la necesidad de realizar grandes cambios en el código y, al mismo tiempo, aumenta la automatización y la reproducibilidad.

Una de las características más destacadas de Airflow es su paquetes de proveedores - una colección de más de 80 módulos que simplifican las conexiones a servicios de terceros. Estos paquetes incluyen operadores, enlaces y sensores prediseñados, lo que facilita la integración con las principales plataformas, como AWS, GCP y Azure. Para los flujos de trabajo de aprendizaje automático, Airflow se conecta con herramientas como MLFlow, SageMaker y Azure ML. También es compatible con los LLMOP y los procesos de generación aumentada por recuperación (RAG) mediante integraciones con bases de datos vectoriales como Weaviate, Pinecone, Qdrant y PGVector. Características como la Operador PoD de Kubernetes y @task .external_python_operator permiten que las tareas se ejecuten en entornos aislados, lo que añade flexibilidad.

«Apache Airflow se encuentra en el corazón de la pila moderna de MLOps. Como es independiente de las herramientas, Airflow puede orquestar todas las acciones de cualquier herramienta de MLOps que tenga una API». - Astronomer Docs

Este amplio marco de integración subraya la capacidad de Airflow para adaptarse a diversos flujos de trabajo.

El diseño modular de Airflow garantiza que pueda gestionar cargas de trabajo de cualquier tamaño. Utiliza colas de mensajes para gestionar un número ilimitado de trabajadores, lo que lo hace escalable desde un único portátil hasta grandes sistemas distribuidos. Es cómputo conectable Esta función permite a los equipos transferir las tareas que consumen muchos recursos a clústeres externos, como Kubernetes, Spark, Databricks o instancias de GPU en la nube. El KubernetesExecutor mejora aún más la escalabilidad al asignar recursos de forma dinámica y poner en marcha los módulos de procesamiento según sea necesario. Esto garantiza que las organizaciones solo paguen por lo que utilizan, lo que mantiene la eficiencia de la administración de los recursos.

Si bien la naturaleza de código abierto de Airflow elimina las tarifas de licencia, su dependencia de Docker y Kubernetes puede generar mayores costos de configuración y mantenimiento. La gestión de las dependencias y la superación de su empinada curva de aprendizaje se citan con frecuencia como desafíos. Noah Ford, científico de datos sénior, comentó:

«El flujo de aire se inicia y se mantiene fuerte, lo que hace que sea desmotivador empezar».

Los servicios gestionados, como Astronomer, que ofrece una prueba de 14 días y 20 dólares en créditos gratuitos, pueden ayudar a reducir las cargas de infraestructura. Además, la consolidación de varias herramientas en una sola capa de orquestación puede optimizar las operaciones y reducir los costos generales al eliminar la necesidad de sistemas independientes.

Metaflow, creado originalmente por Netflix y de código abierto en 2019, es un marco diseñado para simplificar la vida de los científicos de datos. Se destaca por permitir a los usuarios crear flujos de trabajo de forma local en sus ordenadores portátiles y escalarlos sin problemas a la nube sin necesidad de realizar ajustes en el código. Esta facilidad de uso se ha traducido en resultados tangibles: el equipo de ciencia de datos de CNN, por ejemplo, logró probar el doble de modelos en el primer trimestre de 2021 en comparación con todo el año anterior tras adoptar Metaflow [1]. Su diseño de flujo de trabajo optimizado lo convierte en una opción sólida para escalar en entornos de alta demanda.

Cuando se trata de manejar modelos complejos, Metaflow realmente brilla. Es compatible con la creación de nubes en plataformas como AWS (EKS, Batch), Azure (AKS) y Google Cloud (GKE), lo que permite una asignación precisa de recursos para cada paso del flujo de trabajo mediante decoradores sencillos. Para quienes trabajan con modelos lingüísticos de gran tamaño, incluso ofrece soporte nativo para el hardware de AWS Trainium. El @checkpoint El decorador garantiza que el progreso se guarde durante los trabajos prolongados, lo que evita la frustración de volver a empezar después de un fracaso. Una vez que los flujos de trabajo estén listos para la producción, Metaflow puede exportarlos a orquestadores robustos como AWS Step Functions o Kubeflow, que son capaces de gestionar millones de ejecuciones.

Metaflow también destaca por su capacidad de integración con una amplia gama de herramientas y bibliotecas. Está diseñado para funcionar a la perfección con cualquier biblioteca de aprendizaje automático basada en Python, incluidas PyTorch, HuggingFace y XGBoost. Para la administración de datos, se conecta de forma nativa a AWS S3, Azure Blob Storage y Google Cloud Storage. Es compatible con Python y R, y atiende a una amplia gama de usuarios. Además, la integración con ultravioleta La herramienta garantiza una resolución rápida de las dependencias, ya sea que trabaje localmente o en la nube, una característica esencial cuando se escala en varias instancias. El equipo de ingeniería de Realtor.com aprovechó estas capacidades para reducir considerablemente el tiempo necesario para la transición de los modelos de la fase de investigación a la producción, lo que supuso un ahorro de meses [2].

Metaflow garantiza que cada flujo de trabajo, experimento y artefacto se versione automáticamente, lo que convierte la reproducibilidad en una función integrada. También se integra sin problemas con los marcos de seguridad y gobierno empresariales existentes, y ofrece API dedicadas para administrar los secretos. Esto proporciona una visibilidad y un cumplimiento completos de los flujos de trabajo de aprendizaje automático, alineándose con los requisitos de nivel empresarial.

Como herramienta de código abierto, Metaflow elimina las tarifas de licencia, lo que la convierte en una opción económica para equipos de todos los tamaños. Su entorno de desarrollo local con un solo clic reduce el tiempo dedicado a la configuración de la infraestructura, mientras que la capacidad de probar los flujos de trabajo localmente antes de implementarlos en la nube ayuda a evitar gastos innecesarios. Con la asignación granular de recursos, solo paga por el hardware necesario en cada paso, lo que evita el desperdicio que conlleva el sobreaprovisionamiento. Además, su entorno Sandbox integrado en el navegador permite a los usuarios experimentar con las funciones de la nube sin comprometer inmediatamente los recursos de infraestructura. Estas funciones rentables convierten a Metaflow en una opción atractiva para crear flujos de trabajo de aprendizaje automático eficientes y listos para la producción.

Kubeflow es una plataforma creada específicamente para los flujos de trabajo de aprendizaje automático (ML), diseñada para funcionar sin problemas con Kubernetes. A diferencia de los orquestadores de uso general, ofrece herramientas adaptadas a tareas como el ajuste de hiperparámetros y la generación de modelos. Su base de Kubernetes garantiza la flexibilidad, lo que le permite ejecutarse en Google Cloud, AWS, Azure o incluso en configuraciones locales. Esta portabilidad lo hace ideal para equipos que operan en diversos entornos. Al centrarse en las necesidades específicas de la ML, Kubeflow ofrece una escalabilidad e integración adecuadas para flujos de trabajo complejos, como se describe a continuación.

Kubeflow aprovecha la capacidad de Kubernetes para escalar de manera eficiente, lo que lo hace ideal para los flujos de trabajo de aprendizaje automático a gran escala. Cada paso de una canalización se ejecuta como una tarea independiente y en contenedores, lo que permite la ejecución automática en paralelo mediante un grafo acíclico dirigido (DAG). El componente Trainer de la plataforma admite el entrenamiento distribuido en marcos como PyTorch, HuggingFace, DeepSpeed, JAX y XGBoost. A modo de inferencia, KServe maneja modelos de IA tanto generativos como predictivos con un rendimiento escalable. Los usuarios pueden especificar los requisitos de CPU, GPU y memoria para las tareas, mientras que los selectores de nodos dirigen los trabajos de entrenamiento intensivo a los nodos equipados con GPU y asignan tareas más ligeras a instancias rentables que solo utilizan CPU. Además, la función de almacenamiento en caché de Kubeflow evita las ejecuciones redundantes cuando las entradas permanecen inalteradas, lo que ahorra tiempo y recursos computacionales.

El diseño modular de Kubeflow integra herramientas para cada fase del ciclo de vida del aprendizaje automático. Para el desarrollo, los cuadernos Kubeflow ofrecen entornos Jupyter basados en la web que se ejecutan directamente en Kubernetes Pods. Katib facilita el ajuste de hiperparámetros y AutoML, ya que utiliza la función de detener anticipadamente las pruebas con bajo rendimiento. El procesamiento de datos se optimiza con el Kubeflow Spark Operator, que ejecuta las aplicaciones de Spark como cargas de trabajo nativas de Kubernetes. Para los usuarios de ordenadores portátiles, la herramienta Kale simplifica la conversión de los cuadernos Jupyter en Kubeflow Pipelines sin necesidad de realizar ajustes manuales. El registro de modelos funciona como un repositorio central para administrar las versiones y los metadatos de los modelos, lo que facilita la experimentación y la implementación. Se puede acceder a todos estos componentes a través del panel central de Kubeflow, que proporciona una interfaz unificada para administrar el ecosistema. Con las herramientas de gobierno integradas, Kubeflow garantiza un seguimiento claro de los modelos y un rendimiento uniforme en todos los flujos de trabajo.

Kubeflow ofrece un seguimiento y una visualización sólidos de las definiciones de canalización, las ejecuciones, los experimentos y los artefactos de aprendizaje automático, lo que garantiza un linaje claro desde los datos sin procesar hasta los modelos implementados. El registro de modelos actúa como un centro central para las versiones y los metadatos de los modelos, manteniendo la coherencia en todas las iteraciones. Los flujos de trabajo se compilan en archivos IR YAML independientes de la plataforma, lo que permite moverse sin problemas entre los entornos de Kubernetes sin necesidad de realizar ajustes importantes. Esta coherencia permite realizar transiciones fluidas entre los entornos de desarrollo, puesta en escena y producción.

Como plataforma de código abierto, Kubeflow elimina los costos de licencias, dejando solo los gastos de la infraestructura subyacente de Kubernetes. Su función de almacenamiento en caché reduce los costos de procesamiento al evitar volver a ejecutar los pasos de procesamiento o entrenamiento de datos cuando las entradas permanecen inalteradas. La capacidad de parada temprana de Katib ahorra aún más recursos al finalizar antes las pruebas de ajuste de hiperparámetros con bajo rendimiento. Para los equipos con necesidades más sencillas, Kubeflow Pipelines se puede instalar como una aplicación independiente, lo que reduce la carga de recursos en el clúster. Además, la capacidad de Kubeflow de ejecutar varios componentes del flujo de trabajo simultáneamente garantiza una utilización óptima de los recursos, minimizando el tiempo de inactividad y maximizando la eficiencia.

MLFlow es una plataforma de código abierto diseñada para agilizar el ciclo de vida del aprendizaje automático (ML) y abarca todo, desde el seguimiento de experimentos hasta el empaquetado y la implementación de modelos. Gracias a su perfecta integración con GitHub y a su compatibilidad con más de 40 marcos (incluidos PyTorch, OpenAI, HuggingFace y LangChain), se ha convertido en la solución ideal para los equipos de aprendizaje automático. Con licencia Apache-2.0, MLFlow está disponible para autohospedarse o como un servicio gestionado a través de Databricks. A continuación, analizamos su escalabilidad, sus capacidades de integración, sus funciones de gobierno y sus ventajas de costos, que complementan las herramientas mencionadas anteriormente.

De MLFlow Servidor de seguimiento garantiza que se capturen todos los parámetros, métricas y artefactos de las ejecuciones distribuidas, manteniendo un linaje de datos claro. Gracias a su integración nativa con Apache Spark, la plataforma gestiona conjuntos de datos a gran escala y capacitaciones distribuidas sin esfuerzo, lo que la hace ideal para los equipos que gestionan cargas de trabajo de datos importantes. Para la producción, Servicio de modelos Mosaic AI admite predicciones en tiempo real con funciones como actualizaciones sin tiempo de inactividad y división del tráfico para comparar modelos (por ejemplo, «Champion» contra «Challenger»). Además, las canalizaciones de inferencia por lotes y por streaming ofrecen soluciones rentables para escenarios de alto rendimiento en los que no se requiere una latencia ultrabaja. Con alias de modelo en Unity Catalog, las canalizaciones pueden cargar dinámicamente la última versión validada del modelo sin modificar el código.

MLFlow se destaca por combinar la escalabilidad con amplias opciones de integración. Es compatible con los flujos de trabajo tradicionales de aprendizaje automático, aprendizaje profundo e inteligencia artificial generativa. La plataforma está diseñada para proveedores de grandes modelos lingüísticos (LLM), como OpenAI, Anthropic, Gemini y AWS Bedrock, y se integra con herramientas de orquestación como LangChain, Llamaindex, dSpy, AutoGen y CrewAI. El 4 de noviembre de 2025, MLFlow añadió Soporte de OpenTelemetry, lo que permite una integración perfecta con las herramientas de supervisión empresarial. Es Puerta de enlace de IA proporciona una interfaz centralizada para gestionar las interacciones entre varios proveedores de LLM, lo que simplifica las operaciones en las plataformas en la nube. Para mejorar aún más su capacidad de observación, el 23 de diciembre de 2025 MLFlow introdujo la compatibilidad con todos los paquetes de LLM de TypeScript, lo que subraya su alineación con los flujos de trabajo de inteligencia artificial modernos.

De MLFlow Registro de modelos ofrece un seguimiento centralizado de las versiones de los modelos, el linaje y las transiciones del desarrollo a la producción. Para cada experimento, la plataforma registra las versiones del código, los parámetros, las métricas y los artefactos, lo que garantiza la reproducibilidad en todos los equipos y entornos. Para las aplicaciones de IA generativa, MLFlow incluye herramientas para rastrear y evaluar los flujos de trabajo de LLM, lo que proporciona una mayor visibilidad de los sistemas complejos. Los modelos se empaquetan en un formato estandarizado que garantiza un comportamiento uniforme en todos los entornos de implementación, mientras que los gráficos de dependencias documentan automáticamente las características y funciones necesarias para la inferencia.

La naturaleza de código abierto de MLFlow elimina las tarifas de licencia, dejando la infraestructura como el costo principal de las configuraciones autohospedadas. Los equipos pueden optar por el control total con el autoalojamiento o reducir las exigencias operativas eligiendo el alojamiento gestionado, que incluso incluye un nivel gratuito. Las capacidades de inferencia por lotes y streaming de la plataforma ofrecen alternativas asequibles a la entrega en tiempo real para tareas de alto rendimiento. Al centralizar el seguimiento de los experimentos y la gestión de modelos, MLFlow minimiza los esfuerzos redundantes, lo que ayuda a los equipos a evitar la repetición de experimentos o perder el rastro de las versiones de los modelos, lo que ahorra tiempo y recursos computacionales en el proceso.

Cuando se trata de herramientas de flujo de trabajo para gestionar las canalizaciones de aprendizaje automático, cada opción aporta sus propias ventajas y desventajas. He aquí un análisis más detallado de cómo se comparan algunas herramientas populares:

Flujo de aire Apache destaca por su capacidad para conectar una amplia gama de sistemas mediante su amplia biblioteca de operadores y ganchos. Esto lo convierte en la opción ideal para los procesos complejos de ingeniería de datos que admiten modelos de aprendizaje automático. Sin embargo, carece de funciones integradas específicas para el aprendizaje automático, como el seguimiento de modelos o el registro de modelos, lo que puede ser un inconveniente. Además, los usuarios suelen encontrar que su curva de aprendizaje es empinada. Si bien su arquitectura de trabajadores distribuidos ofrece una escalabilidad excelente, la administración de la infraestructura puede resultar compleja.

Metaflow se centra en la simplicidad y gestiona automáticamente el control de versiones de datos y experimentos para que los equipos no tengan que preocuparse por la administración de la infraestructura. Se integra sin problemas con los servicios de almacenamiento y computación de AWS, lo que permite a los científicos de datos concentrarse en el desarrollo de Python. ¿La desventaja? Sus capacidades de integración son más limitadas y se adaptan principalmente a los flujos de trabajo de Python y R.

Kubeflow está diseñado para ofrecer escalabilidad, aprovechando su diseño nativo de Kubernetes y el apoyo de la comunidad de Kubernetes. Ofrece herramientas para todo el ciclo de vida de la IA, como KServe para el servicio de modelos y un registro de modelos para el control de versiones. Sin embargo, la plataforma exige una gran experiencia en Kubernetes, lo que puede ser un desafío para los equipos sin conocimientos de ingeniería especializados. Además, la sobrecarga de infraestructura suele ser mayor.

MLFlow se destaca en la gestión del ciclo de vida del aprendizaje automático, ya que ofrece un seguimiento de experimentos de primer nivel y compatibilidad con más de 40 marcos, incluidos PyTorch y TensorFlow. Su registro de modelos y sus estándares de empaquetado garantizan la reproducibilidad en todos los entornos. Dicho esto, aunque es fantástico para el seguimiento, MLFlow no se centra tanto en organizar canalizaciones complejas, ya que a menudo es necesario combinarlo con otra herramienta, como Airflow o Kubeflow, para el movimiento avanzado de datos.

En última instancia, la elección de la herramienta adecuada depende de las necesidades y prioridades específicas de su proceso de aprendizaje automático.

La selección de la herramienta de flujo de trabajo de aprendizaje automático más adecuada depende en gran medida de la experiencia de su equipo y de los recursos disponibles. Si te centras en un desarrollo rápido sin ingeniería pesada, Metaflow ofrece una forma eficiente de pasar de la experimentación local a la implementación en la nube. Para los equipos que priorizan las soluciones que se preocupan por el presupuesto y el seguimiento efectivo de los experimentos, MLFlow se destaca como una opción confiable y de código abierto. Su flexibilidad en todos los marcos y sus sólidas funciones de control de versiones la convierten en la opción ideal para administrar modelos.

Para las organizaciones que ya utilizan Kubernetes, Kubeflow proporciona escalabilidad y portabilidad nativas, lo que lo convierte en un sólido competidor para las implementaciones de nivel empresarial. Sin embargo, su complejidad y su pronunciada curva de aprendizaje pueden plantear desafíos para los equipos más pequeños con capacidades de ingeniería limitadas. A pesar de ello, la preparación de Kubeflow para la producción se ha demostrado en numerosas implementaciones a gran escala.

Desde el punto de vista de la orquestación, Flujo de aire Apache sigue siendo una herramienta versátil y madura para integrar varios sistemas. Si bien su complejidad a menudo requiere un mantenimiento dedicado, muchos equipos de producción encuentran valor en combinar herramientas en lugar de confiar en una sola. Por ejemplo, combinar MLFlow para el seguimiento de experimentos con Kubeflow para la orquestación es una estrategia popular, ya que permite flujos de trabajo que aprovechan los puntos fuertes de cada herramienta. Este enfoque multiherramienta garantiza la flexibilidad y la eficiencia, especialmente a medida que los flujos de trabajo de aprendizaje automático se vuelven más complejos.

Dado que se espera que el mercado del aprendizaje automático se dispare desde De 47.990 millones de dólares en 2025 a 309,68 mil millones de dólares en 2032, es fundamental elegir herramientas que se integren bien y se adapten a sus necesidades. Para los equipos con recursos limitados, empezar con MLFlow o Metaflow puede minimizar los costos y, al mismo tiempo, ofrecer funciones esenciales como el seguimiento y el control de versiones. A medida que aumentan sus requisitos, se pueden agregar herramientas de orquestación más avanzadas sin interrumpir la configuración actual, lo que permite una evolución fluida de su flujo de trabajo.

Apache Airflow y Kubeflow tienen diferentes propósitos y se adaptan a necesidades distintas, especialmente cuando se trata de administrar flujos de trabajo y canalizaciones de aprendizaje automático.

Flujo de aire Apache es una plataforma basada en Python diseñada para orquestar, programar y supervisar los flujos de trabajo. Destaca en la gestión de una amplia gama de tareas de automatización, incluidas las canalizaciones de datos, con su arquitectura escalable y su interfaz fácil de usar. Si bien Airflow no está diseñado específicamente para el aprendizaje automático, su versatilidad le permite integrarse sin problemas en las infraestructuras existentes y respaldar las operaciones relacionadas con la aprendizaje automático, además de otras necesidades de automatización.

Kubeflow, por el contrario, está diseñado específicamente para los flujos de trabajo de aprendizaje automático en entornos de Kubernetes. Ofrece un ecosistema modular diseñado para soportar todo el ciclo de vida de la IA, desde la orquestación de los procesos hasta el entrenamiento y la implementación de modelos. Al centrarse en la portabilidad, la escalabilidad y la integración con tecnologías nativas de la nube, Kubeflow es especialmente adecuado para gestionar procesos de aprendizaje automático de principio a fin en entornos en contenedores.

En esencia, Airflow es una herramienta de orquestación flexible que aborda un amplio espectro de tareas, mientras que Kubeflow está diseñado específicamente para los flujos de trabajo de aprendizaje automático, ya que proporciona herramientas especializadas para cada etapa del ciclo de vida del aprendizaje automático en las configuraciones de Kubernetes.

Metaflow simplifica el proceso de llevar los flujos de trabajo de aprendizaje automático de un ordenador personal a la nube al ofrecer un marco coherente y fácil de usar. Permite a los científicos de datos crear y probar flujos de trabajo en sus máquinas locales y, a continuación, realizar la transición a plataformas en la nube sin problemas, sin necesidad de revisar su código.

La plataforma facilita la asignación de recursos como CPU, memoria y GPU para gestionar conjuntos de datos más grandes o permitir el procesamiento en paralelo. Se integra sin esfuerzo con los principales proveedores de nube, incluidos AWS, Azure y Google Cloud, lo que permite pasar sin problemas de los entornos de desarrollo local a los de producción. Ya sea que se ejecute localmente, localmente o en la nube, Metaflow garantiza que los flujos de trabajo sean escalables y confiables, lo que reduce la complejidad y aumenta la eficiencia.

Los equipos suelen combinarse MLFlow y Kubeflow para aprovechar sus funciones complementarias y crear un flujo de trabajo de aprendizaje automático más optimizado. MLFlow se especializa en el seguimiento de experimentos, la gestión de versiones de modelos y la supervisión de las etapas de implementación, garantizando que los modelos sigan siendo reproducibles y estén bien documentados. Por otro lado, Kubeflow ofrece una plataforma escalable nativa de Kubernetes diseñada para orquestar y administrar los canales de aprendizaje automático, que abarca todo, desde la capacitación hasta el servicio y la supervisión.

La integración de estas herramientas permite a los equipos simplificar la transición de la experimentación a la producción. De MLFlow las fortalezas en el seguimiento y la gestión de modelos se alinean perfectamente con De Kubeflow infraestructura sólida, que proporciona automatización, escalabilidad y eficiencia operativa mejoradas. Esta combinación es especialmente adecuada para los equipos que buscan una solución integral y flexible para gestionar todo el ciclo de vida del aprendizaje automático.