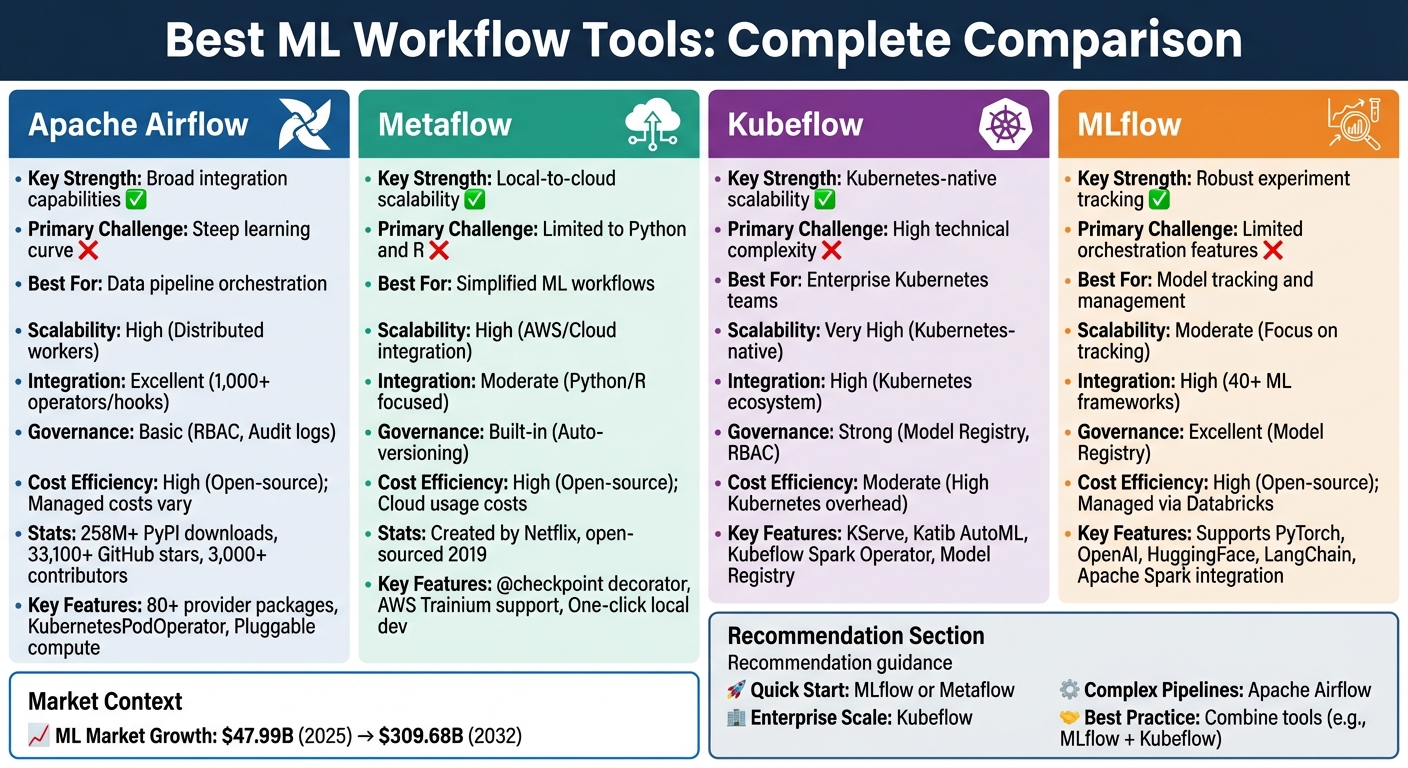

मशीन लर्निंग वर्कफ़्लो जटिल हो सकते हैं, जो अक्सर निर्भरता प्रबंधन और प्रयोग ट्रैकिंग के कारण फंस जाते हैं। विशिष्ट उपकरण इस प्रक्रिया को सरल बनाते हैं, जिससे स्वचालन, दक्षता और प्रजनन क्षमता बढ़ती है। अपाचे एयरफ्लो, मेटाफ़्लो, क्यूबफ्लो, और एमएलफ्लो चार स्टैंडआउट विकल्प हैं, जिनमें से प्रत्येक एमएल जीवनचक्र के विभिन्न चरणों को संबोधित करता है। यहां बताया गया है कि आपको क्या जानना चाहिए:

प्रत्येक उपकरण एक विशिष्ट आवश्यकता को पूरा करता है, और उनके संयोजन से और भी अधिक दक्षता प्राप्त हो सकती है। उदाहरण के लिए, पेयरिंग एमएलफ्लो साथ क्यूबफ्लो निर्बाध मॉडल ट्रैकिंग और ऑर्केस्ट्रेशन को सक्षम बनाता है। उस टूल से शुरू करें जो आपके मौजूदा वर्कफ़्लो के साथ संरेखित हो, फिर जैसे-जैसे आपकी ज़रूरतें बढ़ती हैं, इसका विस्तार करें।

मशीन लर्निंग वर्कफ़्लो टूल तुलना: अपाचे एयरफ़्लो बनाम मेटाफ़्लो बनाम क्यूबफ़्लो बनाम एमएलफ्लो

अपाचे एयरफ्लो बन गया है गो-टू चॉइस विभिन्न प्लेटफार्मों पर डेटा पाइपलाइनों को ऑर्केस्ट्रेट करने के लिए। Apache Software Foundation प्रोजेक्ट के रूप में, इसमें प्रभावशाली आंकड़े हैं: 258 मिलियन से अधिक PyPI डाउनलोड, 33,100 से अधिक GitHub स्टार, और 3,000 से अधिक डेवलपर्स के योगदान। इसका पायथन-नेटिव फ्रेमवर्क डेटा वैज्ञानिकों को सरल टूल जैसे सरल टूल का उपयोग करके मौजूदा मशीन लर्निंग स्क्रिप्ट को ऑर्केस्ट्रेटेड वर्कफ़्लो में आसानी से बदलने में सक्षम बनाता है @task डेकोरेटर। यह दृष्टिकोण स्वचालन और पुनरुत्पादन को बढ़ावा देते हुए व्यापक कोड परिवर्तनों की आवश्यकता को कम करता है।

Airflow की एक ख़ास विशेषता यह है प्रदाता पैकेज - 80 से अधिक मॉड्यूल का संग्रह जो तृतीय-पक्ष सेवाओं से कनेक्शन को सरल बनाता है। इन पैकेजों में पूर्व-निर्मित ऑपरेटर, हुक और सेंसर शामिल हैं, जिससे AWS, GCP, और Azure जैसे प्रमुख प्लेटफार्मों के साथ एकीकृत करना आसान हो जाता है। मशीन लर्निंग वर्कफ़्लो के लिए, Airflow MLFlow, SageMaker, और Azure ML जैसे टूल से जुड़ता है। यह वेक्टर डेटाबेस जैसे कि वीविएट, पाइनकोन, क्यूड्रेंट और पीजीवेक्टर के साथ एकीकरण के माध्यम से एलएलएमओपी और रिट्रीवल-ऑगमेंटेड जेनरेशन (आरएजी) पाइपलाइनों का भी समर्थन करता है। जैसी सुविधाएँ कुबेरनेट स्पोड ऑपरेटर और @task .external_python_operator लचीलेपन को जोड़ते हुए कार्यों को अलग-अलग वातावरण में चलाने की अनुमति दें।

“अपाचे एयरफ्लो आधुनिक MLOps स्टैक के केंद्र में स्थित है। क्योंकि यह टूल एग्नोस्टिक है, एयरफ्लो किसी भी MLOps टूल में सभी क्रियाओं को ऑर्केस्ट्रेट कर सकता है जिसमें API हो।” - एस्ट्रोनॉमर डॉक्स

यह व्यापक एकीकरण ढांचा एयरफ्लो की विविध वर्कफ़्लो के अनुकूल होने की क्षमता को रेखांकित करता है।

Airflow का मॉड्यूलर डिज़ाइन यह सुनिश्चित करता है कि यह किसी भी आकार के वर्कलोड को संभाल सके। यह असीमित संख्या में श्रमिकों को प्रबंधित करने के लिए संदेश कतारों का उपयोग करता है, जिससे यह एक लैपटॉप से बड़े वितरित सिस्टम तक स्केलेबल हो जाता है। यह है प्लग करने योग्य कंप्यूट यह सुविधा टीमों को कुबेरनेट्स, स्पार्क, डेटाब्रिक्स या क्लाउड जीपीयू इंस्टेंस जैसे बाहरी समूहों में संसाधन-भारी कार्यों को ऑफलोड करने देती है। KubernetesExecutor संसाधनों को गतिशील रूप से आवंटित करके, आवश्यकतानुसार कंप्यूट पॉड्स को स्पिन करके स्केलेबिलिटी को और बढ़ाता है। यह सुनिश्चित करता है कि संगठन संसाधन प्रबंधन को कुशल बनाए रखते हुए, केवल उन्हीं चीज़ों के लिए भुगतान करें, जो वे उपयोग करते हैं।

जबकि Airflow की ओपन-सोर्स प्रकृति लाइसेंस शुल्क को समाप्त करती है, डॉकर और कुबेरनेट्स पर इसकी निर्भरता से सेटअप और रखरखाव की लागत बढ़ सकती है। निर्भरता को प्रबंधित करना और सीखने की तीव्र अवस्था को नेविगेट करना अक्सर चुनौतियों के रूप में उद्धृत किया जाता है। नूह फोर्ड, वरिष्ठ डेटा वैज्ञानिक, ने टिप्पणी की:

“एयरफ्लो शुरू होता है और कठोर रहता है, जिससे इसे शुरू करना निराशाजनक हो जाता है।”

एस्ट्रोनॉमर जैसी प्रबंधित सेवाएं, जो 14-दिवसीय परीक्षण और $20 मुफ्त क्रेडिट प्रदान करती हैं, बुनियादी ढांचे के बोझ को कम करने में मदद कर सकती हैं। इसके अतिरिक्त, एक ही ऑर्केस्ट्रेशन लेयर में कई टूल को समेकित करने से ऑपरेशन को सरल बनाया जा सकता है और अलग-अलग सिस्टम की आवश्यकता को समाप्त करके समग्र लागत को कम किया जा सकता है।

मेटाफ़्लो, जिसे मूल रूप से नेटफ्लिक्स द्वारा बनाया गया था और 2019 में ओपन-सोर्स किया गया था, डेटा वैज्ञानिकों के जीवन को सरल बनाने के लिए डिज़ाइन किया गया एक ढांचा है। इससे यूज़र अपने लैपटॉप पर स्थानीय स्तर पर वर्कफ़्लो बना सकते हैं और कोड एडजस्टमेंट की आवश्यकता के बिना उन्हें क्लाउड पर आसानी से स्केल कर सकते हैं। उपयोग में इस आसानी ने मूर्त परिणाम दिए हैं - उदाहरण के लिए, CNN की डेटा साइंस टीम, Metaflow [1] को अपनाने के बाद पूरे पिछले वर्ष की तुलना में 2021 की पहली तिमाही में दोगुने मॉडल का परीक्षण करने में कामयाब रही। इसका सुव्यवस्थित वर्कफ़्लो डिज़ाइन इसे उच्च मांग वाले वातावरण में स्केलिंग के लिए एक मजबूत विकल्प बनाता है।

जब जटिल मॉडलों को संभालने की बात आती है, तो मेटाफ्लो वास्तव में चमकता है। यह AWS (EKS, Batch), Azure (AKS), और Google Cloud (GKE) जैसे प्लेटफार्मों पर क्लाउड बर्स्टिंग का समर्थन करता है, जिससे साधारण डेकोरेटर के माध्यम से प्रत्येक वर्कफ़्लो चरण के लिए सटीक संसाधन आवंटन की अनुमति मिलती है। बड़े भाषा मॉडल के साथ काम करने वालों के लिए, यह AWS ट्रेनियम हार्डवेयर के लिए मूल समर्थन भी प्रदान करता है। द @checkpoint डेकोरेटर यह सुनिश्चित करता है कि लंबी नौकरियों के दौरान प्रगति बचाई जाए, जिससे असफलताओं के बाद फिर से शुरू होने की निराशा को रोका जा सके। एक बार वर्कफ़्लो उत्पादन के लिए तैयार हो जाने के बाद, मेटाफ़्लो उन्हें AWS स्टेप फ़ंक्शंस या क्यूबफ़्लो जैसे मजबूत ऑर्केस्ट्रेटर को निर्यात कर सकता है, जो लाखों रनों का प्रबंधन करने में सक्षम हैं।

Metaflow टूल और लाइब्रेरी की एक विस्तृत श्रृंखला के साथ एकीकृत करने की अपनी क्षमता में भी उत्कृष्टता प्राप्त करता है। इसे किसी भी पायथन-आधारित मशीन लर्निंग लाइब्रेरी के साथ निर्बाध रूप से काम करने के लिए डिज़ाइन किया गया है, जिसमें PyTorch, HuggingFace और XGBoost शामिल हैं। डेटा प्रबंधन के लिए, यह मूल रूप से AWS S3, Azure Blob Storage और Google Cloud Storage से जुड़ता है। यह Python और R दोनों का समर्थन करता है, जो उपयोगकर्ताओं की एक विस्तृत श्रृंखला को पूरा करता है। इसके अतिरिक्त, इसके साथ एकीकरण यूवी उपकरण त्वरित निर्भरता समाधान सुनिश्चित करता है, चाहे वह स्थानीय रूप से काम कर रहा हो या क्लाउड में - कई उदाहरणों में स्केलिंग करते समय एक आवश्यक विशेषता। Realtor.com की इंजीनियरिंग टीम ने इन क्षमताओं का लाभ उठाया, ताकि मॉडल को शोध से उत्पादन में बदलने में लगने वाले समय को काफी कम किया जा सके, जिससे उनकी समय सीमा में महीनों की कटौती की जा सके [2]।

मेटाफ़्लो सुनिश्चित करता है कि प्रत्येक वर्कफ़्लो, प्रयोग और आर्टिफ़ैक्ट को स्वचालित रूप से संस्करणित किया जाए, जिससे प्रतिलिपि प्रस्तुत करने की क्षमता एक अंतर्निहित सुविधा बन जाती है। यह मौजूदा एंटरप्राइज़ सुरक्षा और गवर्नेंस फ़्रेमवर्क के साथ भी आसानी से एकीकृत हो जाता है, जो रहस्यों को प्रबंधित करने के लिए समर्पित API प्रदान करता है। यह एंटरप्राइज़-ग्रेड आवश्यकताओं के अनुरूप मशीन लर्निंग वर्कफ़्लो के लिए पूर्ण दृश्यता और अनुपालन प्रदान करता है।

एक ओपन-सोर्स टूल के रूप में, मेटाफ़्लो लाइसेंस शुल्क को समाप्त करता है, जिससे यह सभी आकारों की टीमों के लिए एक किफायती विकल्प बन जाता है। इसका एक क्लिक का स्थानीय विकास वातावरण इंफ्रास्ट्रक्चर सेटअप पर लगने वाले समय को कम करता है, जबकि क्लाउड पर तैनात करने से पहले स्थानीय स्तर पर वर्कफ़्लो का परीक्षण करने की क्षमता अनावश्यक खर्चों से बचने में मदद करती है। बारीक संसाधन आवंटन के साथ, आप ओवर-प्रोविजनिंग के साथ आने वाले कचरे से बचते हुए, प्रत्येक चरण में केवल आवश्यक हार्डवेयर के लिए भुगतान करते हैं। इसके अतिरिक्त, इसका इन-ब्राउज़र सैंडबॉक्स वातावरण यूज़र को इंफ्रास्ट्रक्चर संसाधनों को तुरंत प्रतिबद्ध किए बिना क्लाउड सुविधाओं के साथ प्रयोग करने की अनुमति देता है। लागत के प्रति सचेत रहने वाली ये विशेषताएं मेटाफ़्लो को कुशल, उत्पादन-तैयार मशीन लर्निंग वर्कफ़्लो बनाने के लिए एक आकर्षक विकल्प बनाती हैं।

Kubeflow एक प्लेटफ़ॉर्म है जिसे विशेष रूप से मशीन लर्निंग (ML) वर्कफ़्लो के लिए बनाया गया है, जिसे Kubernetes के साथ निर्बाध रूप से काम करने के लिए डिज़ाइन किया गया है। सामान्य प्रयोजन के ऑर्केस्ट्रेटर के विपरीत, यह हाइपरपैरामीटर ट्यूनिंग और मॉडल सर्विंग जैसे कार्यों के अनुरूप टूल प्रदान करता है। इसका कुबेरनेट्स फ़ाउंडेशन लचीलापन सुनिश्चित करता है, जिससे यह Google Cloud, AWS, Azure या यहां तक कि ऑन-प्रिमाइसेस सेटअप पर भी चल सकता है। यह पोर्टेबिलिटी इसे विविध परिवेशों में काम करने वाली टीमों के लिए आदर्श बनाती है। ML-विशिष्ट ज़रूरतों पर अपना ध्यान केंद्रित करने के साथ, Kubeflow जटिल वर्कफ़्लो के लिए उपयुक्त स्केलेबिलिटी और इंटीग्रेशन प्रदान करता है, जैसा कि नीचे बताया गया है।

Kubeflow कुबेरनेट्स की कुशलता से स्केल करने की क्षमता का लाभ उठाता है, जिससे यह बड़े पैमाने पर ML वर्कफ़्लो के लिए उपयुक्त है। पाइपलाइन का प्रत्येक चरण एक स्वतंत्र, कंटेनरीकृत कार्य के रूप में चलता है, जो निर्देशित एसाइक्लिक ग्राफ़ (DAG) के माध्यम से स्वचालित समानांतर निष्पादन को सक्षम करता है। प्लेटफ़ॉर्म का ट्रेनर घटक PyTorch, HuggingFace, DeepSpeed, JAX, और XGBoost जैसे फ्रेमवर्क में वितरित प्रशिक्षण का समर्थन करता है। अनुमान के लिए, KServe स्केलेबल प्रदर्शन के साथ जनरेटिव और प्रेडिक्टिव AI मॉडल दोनों को संभालता है। उपयोगकर्ता कार्यों के लिए CPU, GPU और मेमोरी आवश्यकताओं को निर्दिष्ट कर सकते हैं, जबकि नोड चयनकर्ता GPU से लैस नोड्स के लिए गहन प्रशिक्षण कार्य को रूट करते हैं और लागत प्रभावी CPU-केवल उदाहरणों के लिए हल्के कार्य असाइन करते हैं। इसके अतिरिक्त, जब इनपुट अपरिवर्तित रहते हैं, तो Kubeflow की कैशिंग सुविधा अनावश्यक निष्पादन को रोकती है, जिससे समय और कम्प्यूटेशनल संसाधनों दोनों की बचत होती है।

Kubeflow का मॉड्यूलर डिज़ाइन ML जीवनचक्र के हर चरण के लिए टूल को एकीकृत करता है। विकास के लिए, क्यूबफ्लो नोटबुक्स वेब-आधारित जुपिटर वातावरण प्रदान करते हैं जो सीधे कुबेरनेट्स पॉड्स में चल रहे हैं। कैटिब ऑटोएमएल और हाइपरपैरामीटर ट्यूनिंग की सुविधा देता है, जिससे अंडरपरफ़ॉर्मिंग ट्रायल को रोकने के लिए शुरुआती स्टॉपिंग का उपयोग किया जाता है। डेटा प्रोसेसिंग को क्यूबफ्लो स्पार्क ऑपरेटर के साथ सुव्यवस्थित किया जाता है, जो स्पार्क अनुप्रयोगों को देशी कुबेरनेट्स वर्कलोड के रूप में चलाता है। नोटबुक उपयोगकर्ताओं के लिए, केल टूल मैन्युअल समायोजन की आवश्यकता के बिना जुपिटर नोटबुक को क्यूबफ्लो पाइपलाइन में परिवर्तित करने को सरल बनाता है। मॉडल रजिस्ट्री मॉडल संस्करणों और मेटाडेटा के प्रबंधन, प्रयोग और परिनियोजन को कम करने के लिए एक केंद्रीय रिपॉजिटरी के रूप में कार्य करती है। इन सभी घटकों को क्यूबफ्लो सेंट्रल डैशबोर्ड के माध्यम से एक्सेस किया जा सकता है, जो इकोसिस्टम के प्रबंधन के लिए एक एकीकृत इंटरफ़ेस प्रदान करता है। बिल्ट-इन गवर्नेंस टूल के साथ, Kubeflow स्पष्ट मॉडल ट्रैकिंग और सभी वर्कफ़्लो में लगातार प्रदर्शन सुनिश्चित करता है।

Kubeflow पाइपलाइन परिभाषाओं, रनों, प्रयोगों और ML कलाकृतियों की मजबूत ट्रैकिंग और विज़ुअलाइज़ेशन प्रदान करता है, जिससे कच्चे डेटा से परिनियोजित मॉडल तक एक स्पष्ट वंशावली सुनिश्चित होती है। मॉडल रजिस्ट्री मॉडल संस्करणों और मेटाडेटा के लिए एक केंद्रीय केंद्र के रूप में कार्य करती है, जो सभी पुनरावृत्तियों में स्थिरता बनाए रखती है। वर्कफ़्लोज़ को प्लेटफ़ॉर्म-न्यूट्रल IR YAML फ़ाइलों में संकलित किया जाता है, जिससे बड़े समायोजन की आवश्यकता के बिना कुबेरनेट्स वातावरण के बीच सहज आवाजाही सक्षम होती है। यह स्थिरता विकास, मंचन और उत्पादन परिवेशों में सहज बदलावों का समर्थन करती है।

एक ओपन-सोर्स प्लेटफ़ॉर्म के रूप में, Kubeflow लाइसेंस की लागत को समाप्त करता है, जिससे केवल अंतर्निहित Kubernetes अवसंरचना का खर्च निकल जाता है। जब इनपुट अपरिवर्तित रहते हैं, तो इसकी कैशिंग सुविधा डेटा प्रोसेसिंग या प्रशिक्षण चरणों के पुन: निष्पादन से बचकर गणना लागत को कम करती है। कैटिब की शुरुआती स्टॉपिंग क्षमता खराब प्रदर्शन करने वाले हाइपरपैरामीटर ट्यूनिंग परीक्षणों को जल्दी समाप्त करके संसाधनों को और बचाती है। सरल ज़रूरतों वाली टीमों के लिए, क्यूबफ्लो पाइपलाइन को एक स्टैंडअलोन एप्लिकेशन के रूप में स्थापित किया जा सकता है, जिससे क्लस्टर पर संसाधन लोड कम हो जाता है। इसके अतिरिक्त, Kubeflow की एक साथ कई वर्कफ़्लो घटकों को चलाने की क्षमता इष्टतम संसाधन उपयोग, निष्क्रिय समय को कम करने और दक्षता को अधिकतम करने को सुनिश्चित करती है।

MLFlow एक ओपन-सोर्स प्लेटफ़ॉर्म है जिसे मशीन लर्निंग (ML) जीवनचक्र को कारगर बनाने के लिए डिज़ाइन किया गया है, जिसमें ट्रैकिंग प्रयोगों से लेकर पैकेजिंग और मॉडल को तैनात करने तक सब कुछ शामिल है। PyTorch, OpenAI, HuggingFace, और LangChain सहित 40 से अधिक फ्रेमवर्क के साथ सहज GitHub एकीकरण और संगतता के साथ - यह ML टीमों के लिए एक पसंदीदा समाधान बन गया है। Apache-2.0 के तहत लाइसेंस प्राप्त, MLFlow सेल्फ-होस्टिंग के लिए या डेटाब्रिक्स के माध्यम से प्रबंधित सेवा के रूप में उपलब्ध है। नीचे, हम इसकी स्केलेबिलिटी, इंटीग्रेशन क्षमताओं, गवर्नेंस सुविधाओं और लागत लाभों का पता लगाते हैं, जो पहले चर्चा किए गए टूल के पूरक हैं।

एमएलफ्लो ट्रैकिंग सर्वर यह सुनिश्चित करता है कि वितरित रन से सभी मापदंडों, मैट्रिक्स और कलाकृतियों को कैप्चर किया जाए, जिससे एक स्पष्ट डेटा वंशावली बनी रहे। के साथ इसके मूल एकीकरण के कारण अपाचे स्पार्क, प्लेटफ़ॉर्म बड़े पैमाने पर डेटासेट को संभालता है और प्रशिक्षण को आसानी से वितरित करता है, जिससे यह महत्वपूर्ण डेटा वर्कलोड का प्रबंधन करने वाली टीमों के लिए आदर्श बन जाता है। उत्पादन के लिए, मोज़ेक एआई मॉडल सर्विंग मॉडल (जैसे, “चैंपियन” बनाम “चैलेंजर”) की तुलना करने के लिए शून्य-डाउनटाइम अपडेट और ट्रैफ़िक स्प्लिटिंग जैसी सुविधाओं के साथ रीयल-टाइम भविष्यवाणियों का समर्थन करता है। इसके अतिरिक्त, बैच और स्ट्रीमिंग अनुमान पाइपलाइन उच्च-थ्रूपुट परिदृश्यों के लिए लागत प्रभावी समाधान प्रदान करती हैं, जहां अल्ट्रा-लो लेटेंसी की आवश्यकता नहीं होती है। के साथ मॉडल उपनाम यूनिटी कैटलॉग में, पाइपलाइन बिना किसी कोड संशोधन के नवीनतम मान्य मॉडल संस्करण को गतिशील रूप से लोड कर सकती हैं।

MLFlow व्यापक एकीकरण विकल्पों के साथ स्केलेबिलिटी लाने में उत्कृष्टता प्राप्त करता है। यह पारंपरिक ML, डीप लर्निंग और जनरेटिव AI वर्कफ़्लोज़ का समर्थन करता है। प्लेटफ़ॉर्म को OpenAI, एंथ्रोपिक, जेमिनी और AWS बेडरॉक जैसे बड़े भाषा मॉडल (LLM) प्रदाताओं के लिए तैयार किया गया है, और यह LangChain, LLaMaindex, dSpy, AutoGen, और CreWai जैसे ऑर्केस्ट्रेशन टूल के साथ एकीकृत है। 4 नवंबर, 2025 को, MLFlow ने जोड़ा OpenTelemetry समर्थन, एंटरप्राइज़ मॉनिटरिंग टूल के साथ सहज एकीकरण को सक्षम करना। यह है एआई गेटवे विभिन्न एलएलएम प्रदाताओं के बीच बातचीत के प्रबंधन के लिए एक केंद्रीकृत इंटरफ़ेस प्रदान करता है, जो क्लाउड प्लेटफार्मों पर संचालन को सरल बनाता है। अपनी अवलोकन क्षमता को और बढ़ाते हुए, MLFlow ने 23 दिसंबर, 2025 को प्रत्येक टाइपस्क्रिप्ट LLM स्टैक के लिए समर्थन की शुरुआत की, जो आधुनिक AI वर्कफ़्लो के साथ इसके संरेखण को रेखांकित करता है।

एमएलफ्लो मॉडल रजिस्ट्री मॉडल संस्करणों, वंशावली, और विकास से उत्पादन तक के बदलावों की केंद्रीकृत ट्रैकिंग प्रदान करता है। प्रत्येक प्रयोग के लिए, प्लेटफ़ॉर्म कोड संस्करण, मापदंडों, मैट्रिक्स और कलाकृतियों को लॉग करता है, जिससे टीमों और परिवेशों में प्रजनन क्षमता सुनिश्चित होती है। जनरेटिव AI अनुप्रयोगों के लिए, MLFlow में LLM वर्कफ़्लो का पता लगाने और उनका मूल्यांकन करने के लिए टूल शामिल हैं, जो जटिल प्रणालियों में अधिक दृश्यता प्रदान करते हैं। मॉडल को एक मानकीकृत प्रारूप में पैक किया जाता है, जो परिनियोजन वातावरण में सुसंगत व्यवहार सुनिश्चित करता है, जबकि निर्भरता ग्राफ़ स्वचालित रूप से अनुमान के लिए आवश्यक सुविधाओं और कार्यों का दस्तावेजीकरण करते हैं।

MLFlow की ओपन-सोर्स प्रकृति लाइसेंसिंग शुल्क को समाप्त कर देती है, जिससे बुनियादी ढांचे को स्व-होस्ट किए गए सेटअप के लिए प्राथमिक लागत के रूप में छोड़ दिया जाता है। टीमें सेल्फ-होस्टिंग के साथ पूर्ण नियंत्रण का विकल्प चुन सकती हैं या प्रबंधित होस्टिंग चुनकर परिचालन संबंधी मांगों को कम कर सकती हैं, जिसमें एक निःशुल्क टियर भी शामिल है। प्लेटफ़ॉर्म की बैच और स्ट्रीमिंग अनुमान क्षमताएं उच्च-थ्रूपुट कार्यों के लिए रीयल-टाइम सर्विंग के लिए किफायती विकल्प प्रदान करती हैं। प्रयोग ट्रैकिंग और मॉडल प्रबंधन को केंद्रीकृत करके, MLFlow अनावश्यक प्रयासों को कम करता है, जिससे टीमों को दोहराए जाने वाले प्रयोगों से बचने या मॉडल संस्करणों का ट्रैक खोने से बचने में मदद मिलती है - इस प्रक्रिया में समय और कम्प्यूटेशनल संसाधनों दोनों की बचत होती है।

जब एमएल पाइपलाइनों के प्रबंधन के लिए वर्कफ़्लो टूल की बात आती है, तो प्रत्येक विकल्प अपनी ताकत और ट्रेड-ऑफ लाता है। कुछ लोकप्रिय टूल कैसे ढेर हो जाते हैं, इस पर करीब से नज़र डालें:

अपाचे एयरफ्लो ऑपरेटरों और हुक की व्यापक लाइब्रेरी का उपयोग करके सिस्टम की एक विस्तृत श्रृंखला को जोड़ने की अपनी क्षमता के लिए सबसे अलग है। यह इसे जटिल डेटा इंजीनियरिंग पाइपलाइनों के लिए एक पसंदीदा विकल्प बनाता है जो ML मॉडल का समर्थन करती हैं। हालांकि, इसमें मॉडल ट्रैकिंग या मॉडल रजिस्ट्री जैसी अंतर्निहित ML-विशिष्ट सुविधाओं का अभाव है, जो एक खामी हो सकती है। इसके अतिरिक्त, यूज़र अक्सर इसकी सीखने की अवस्था को कठिन पाते हैं। हालांकि इसका डिस्ट्रीब्यूटेड वर्कर आर्किटेक्चर उत्कृष्ट स्केलेबिलिटी प्रदान करता है, लेकिन बुनियादी ढांचे का प्रबंधन जटिल हो सकता है।

मेटाफ़्लो सरलता पर ध्यान केंद्रित करता है, स्वचालित रूप से प्रयोग और डेटा संस्करण को संभालता है, इसलिए टीमों को बुनियादी ढांचे के प्रबंधन के बारे में चिंता करने की ज़रूरत नहीं है। यह AWS स्टोरेज और कंप्यूट सेवाओं के साथ आसानी से एकीकृत हो जाता है, जिससे डेटा वैज्ञानिक पायथन के विकास पर ध्यान केंद्रित कर सकते हैं। नकारात्मक पक्ष? इसकी एकीकरण क्षमताएं अधिक सीमित हैं, जो मुख्य रूप से पायथन और आर वर्कफ़्लो को पूरा करती हैं।

क्यूबफ्लो स्केलेबिलिटी के लिए बनाया गया है, जो इसके कुबेरनेट्स-मूल डिज़ाइन और कुबेरनेट्स समुदाय के समर्थन का लाभ उठाता है। यह संपूर्ण AI जीवनचक्र के लिए टूल प्रदान करता है, जैसे कि मॉडल सर्विंग के लिए KServe और संस्करण नियंत्रण के लिए मॉडल रजिस्ट्री। हालांकि, प्लेटफ़ॉर्म महत्वपूर्ण कुबेरनेट्स विशेषज्ञता की मांग करता है, जो विशिष्ट इंजीनियरिंग कौशल के बिना टीमों के लिए एक चुनौती हो सकती है। इसके अतिरिक्त, इंफ्रास्ट्रक्चर ओवरहेड अक्सर अधिक होता है।

एमएलफ्लो ML जीवनचक्र के प्रबंधन में उत्कृष्टता प्राप्त करता है, जो PyTorch और TensorFlow सहित 40 से अधिक फ्रेमवर्क के साथ शीर्ष स्तरीय प्रयोग ट्रैकिंग और संगतता प्रदान करता है। इसके मॉडल रजिस्ट्री और पैकेजिंग मानक पूरे वातावरण में प्रजनन क्षमता सुनिश्चित करते हैं। हालांकि, यह ट्रैकिंग के लिए शानदार है, MLFlow जटिल पाइपलाइनों को ऑर्केस्ट्रेट करने पर उतना ध्यान केंद्रित नहीं करता है, जिसे अक्सर उन्नत डेटा मूवमेंट के लिए Airflow या Kubeflow जैसे किसी अन्य टूल के साथ पेयर करने की आवश्यकता होती है।

आखिरकार, सही टूल चुनना आपकी विशिष्ट एमएल पाइपलाइन की जरूरतों और प्राथमिकताओं पर निर्भर करता है।

सबसे उपयुक्त मशीन लर्निंग वर्कफ़्लो टूल का चयन करना काफी हद तक आपकी टीम की विशेषज्ञता और उपलब्ध संसाधनों पर निर्भर करता है। यदि आपका ध्यान भारी इंजीनियरिंग के बिना त्वरित विकास पर है, मेटाफ़्लो स्थानीय प्रयोग से क्लाउड परिनियोजन में संक्रमण का एक कुशल तरीका प्रदान करता है। बजट के प्रति सचेत समाधानों और प्रभावी प्रयोग ट्रैकिंग को प्राथमिकता देने वाली टीमों के लिए, एमएलफ्लो एक विश्वसनीय, ओपन-सोर्स विकल्प के रूप में सामने आता है। सभी फ्रेमवर्क में इसका लचीलापन और मजबूत वर्जनिंग फीचर्स इसे मॉडल मैनेज करने के लिए एक पसंदीदा विकल्प बनाते हैं।

पहले से ही कुबेरनेट्स का उपयोग करने वाले संगठनों के लिए, क्यूबफ्लो देशी स्केलेबिलिटी और पोर्टेबिलिटी प्रदान करता है, जिससे यह एंटरप्राइज़-स्तरीय तैनाती के लिए एक मजबूत दावेदार बन जाता है। हालांकि, इसकी जटिलता और सीखने की तीव्र अवस्था सीमित इंजीनियरिंग क्षमताओं वाली छोटी टीमों के लिए चुनौतियां खड़ी कर सकती है। इसके बावजूद, कई बड़े पैमाने पर तैनाती में Kubeflow की उत्पादन तत्परता साबित हुई है।

ऑर्केस्ट्रेशन की तरफ, अपाचे एयरफ्लो विभिन्न प्रणालियों को एकीकृत करने के लिए एक बहुमुखी और परिपक्व उपकरण बना हुआ है। हालांकि इसकी जटिलता के लिए अक्सर समर्पित रखरखाव की आवश्यकता होती है, लेकिन कई प्रोडक्शन टीमें केवल एक पर निर्भर रहने के बजाय उपकरणों के संयोजन में मूल्य पाती हैं। उदाहरण के लिए, ऑर्केस्ट्रेशन के लिए Kubeflow के साथ प्रयोग ट्रैकिंग के लिए MLFlow को पेयर करना एक लोकप्रिय रणनीति है, जो प्रत्येक टूल की खूबियों को भुनाने वाले वर्कफ़्लो को सक्षम करती है। यह मल्टी-टूल दृष्टिकोण लचीलापन और दक्षता सुनिश्चित करता है, खासकर जब मशीन लर्निंग वर्कफ़्लो अधिक जटिल हो जाते हैं।

मशीन लर्निंग के बाजार में तेजी आने की उम्मीद के साथ 2025 में $47.99 बिलियन से 2032 तक $309.68 बिलियन हो गया, ऐसे उपकरण चुनना जो आपकी ज़रूरतों के साथ अच्छी तरह से एकीकृत हों और बड़े पैमाने पर हों, महत्वपूर्ण है। सीमित संसाधनों वाली टीमों के लिए, MLFlow या Metaflow से शुरुआत करके, ट्रैकिंग और वर्जनिंग जैसी आवश्यक सुविधाएँ प्रदान करते हुए लागत को कम किया जा सकता है। जैसे-जैसे आपकी आवश्यकताएं बढ़ती हैं, आपके मौजूदा सेटअप को बाधित किए बिना अधिक उन्नत ऑर्केस्ट्रेशन टूल जोड़े जा सकते हैं, जिससे आपके वर्कफ़्लो का निर्बाध विकास हो सकता है।

Apache Airflow और Kubeflow अलग-अलग उद्देश्यों को पूरा करते हैं और अलग-अलग ज़रूरतों को पूरा करते हैं, खासकर जब वर्कफ़्लो और मशीन लर्निंग पाइपलाइन के प्रबंधन की बात आती है।

अपाचे एयरफ्लो एक पायथन-आधारित प्लेटफ़ॉर्म है जिसे ऑर्केस्ट्रेटिंग, शेड्यूलिंग और वर्कफ़्लो की निगरानी के लिए डिज़ाइन किया गया है। यह अपने स्केलेबल आर्किटेक्चर और यूजर-फ्रेंडली इंटरफेस के साथ डेटा पाइपलाइन सहित ऑटोमेशन कार्यों की एक विस्तृत श्रृंखला को संभालने में चमकता है। हालांकि एयरफ्लो मशीन लर्निंग के लिए विशेष रूप से तैयार नहीं किया गया है, लेकिन इसकी बहुमुखी प्रतिभा इसे मौजूदा इन्फ्रास्ट्रक्चर में समेकित रूप से एकीकृत करने और अन्य स्वचालन आवश्यकताओं के साथ-साथ एमएल-संबंधित संचालन का समर्थन करने की अनुमति देती है।

क्यूबफ्लो, इसके विपरीत, विशेष रूप से कुबेरनेट्स वातावरण में मशीन लर्निंग वर्कफ़्लो के लिए बनाया गया है। यह पाइपलाइन ऑर्केस्ट्रेशन से लेकर मॉडल प्रशिक्षण और परिनियोजन तक, संपूर्ण AI जीवनचक्र का समर्थन करने के लिए डिज़ाइन किया गया एक मॉड्यूलर इकोसिस्टम प्रदान करता है। पोर्टेबिलिटी, स्केलेबिलिटी और क्लाउड-नेटिव तकनीकों के साथ एकीकरण पर अपना ध्यान देने के साथ, क्यूबफ्लो कंटेनरीकृत वातावरण में एंड-टू-एंड एमएल पाइपलाइनों के प्रबंधन के लिए विशेष रूप से उपयुक्त है।

संक्षेप में, एयरफ्लो एक लचीला ऑर्केस्ट्रेशन टूल है जो कार्यों के व्यापक स्पेक्ट्रम को संबोधित करता है, जबकि क्यूबफ्लो मशीन लर्निंग वर्कफ़्लो के लिए उद्देश्य-निर्मित है, जो कुबेरनेट्स सेटअप के भीतर एमएल जीवनचक्र के हर चरण के लिए विशेष उपकरण प्रदान करता है।

मेटाफ़्लो एक समेकित और उपयोग में आसान फ्रेमवर्क की पेशकश करके मशीन लर्निंग वर्कफ़्लो को पर्सनल कंप्यूटर से क्लाउड तक ले जाने की यात्रा को सरल बनाता है। यह डेटा वैज्ञानिकों को अपनी स्थानीय मशीनों पर वर्कफ़्लो बनाने और उनका परीक्षण करने, फिर अपने कोड को ओवरहाल करने की आवश्यकता के बिना, निर्बाध रूप से क्लाउड प्लेटफ़ॉर्म पर ट्रांज़िशन करने का अधिकार देता है।

प्लेटफ़ॉर्म संसाधनों को आवंटित करना आसान बनाता है जैसे सीपीयू, मेमोरी और जीपीयू बड़े डेटासेट को संभालने या समानांतर प्रसंस्करण को सक्षम करने के लिए। यह AWS, Azure, और Google Cloud सहित प्रमुख क्लाउड प्रदाताओं के साथ आसानी से एकीकृत हो जाता है, जिससे स्थानीय विकास से उत्पादन वातावरण में आसानी से बदलाव किया जा सकता है। चाहे स्थानीय स्तर पर, ऑन-प्रिमाइसेस या क्लाउड में चल रहा हो, मेटाफ़्लो सुनिश्चित करता है कि वर्कफ़्लो स्केलेबल और विश्वसनीय दोनों हों, जिससे दक्षता में वृद्धि करते हुए जटिलता कम हो।

टीमें अक्सर गठबंधन करती हैं एमएलफ्लो और क्यूबफ्लो उनकी पूरक सुविधाओं का उपयोग करने और अधिक सुव्यवस्थित मशीन लर्निंग वर्कफ़्लो बनाने के लिए। एमएलफ्लो प्रयोगों पर नज़र रखने, मॉडल संस्करणों को प्रबंधित करने और परिनियोजन चरणों की देखरेख करने में माहिर हैं, यह सुनिश्चित करते हैं कि मॉडल प्रतिलिपि प्रस्तुत करने योग्य और अच्छी तरह से प्रलेखित रहें। दूसरी ओर, क्यूबफ्लो मशीन लर्निंग पाइपलाइनों को व्यवस्थित करने और प्रबंधित करने के लिए डिज़ाइन किया गया एक स्केलेबल, कुबेरनेट्स-नेटिव प्लेटफ़ॉर्म प्रदान करता है, जिसमें प्रशिक्षण से लेकर सेवा और निगरानी तक सब कुछ शामिल है।

इन उपकरणों को एकीकृत करने से टीमों को प्रयोग से उत्पादन तक संक्रमण को आसान बनाने में मदद मिलती है। एमएलफ्लो ट्रैकिंग और मॉडल प्रबंधन में ताकत पूरी तरह से मेल खाती है क्यूबफ्लो मजबूत बुनियादी ढांचा, उन्नत स्वचालन, मापनीयता और परिचालन दक्षता प्रदान करता है। यह संयोजन विशेष रूप से उन टीमों के लिए उपयुक्त है जो मशीन लर्निंग के संपूर्ण जीवनचक्र के प्रबंधन के लिए लचीला, शुरू से अंत तक समाधान चाहती हैं।