Les flux de travail d'apprentissage automatique peuvent être complexes et souvent entravés par la gestion des dépendances et le suivi des expériences. Des outils spécialisés simplifient ce processus en augmentant l'automatisation, l'efficacité et la reproductibilité. Flux d'air Apache, Métaflow, Kubeflow, et Débit ML sont quatre options remarquables, chacune abordant différentes étapes du cycle de vie du machine learning. Voici ce que vous devez savoir :

Chaque outil répond à un besoin spécifique, et leur combinaison permet de gagner en efficacité. Par exemple, le jumelage Débit ML avec Kubeflow permet un suivi et une orchestration fluides des modèles. Commencez par l'outil qui s'adapte à votre flux de travail actuel, puis développez-le en fonction de vos besoins.

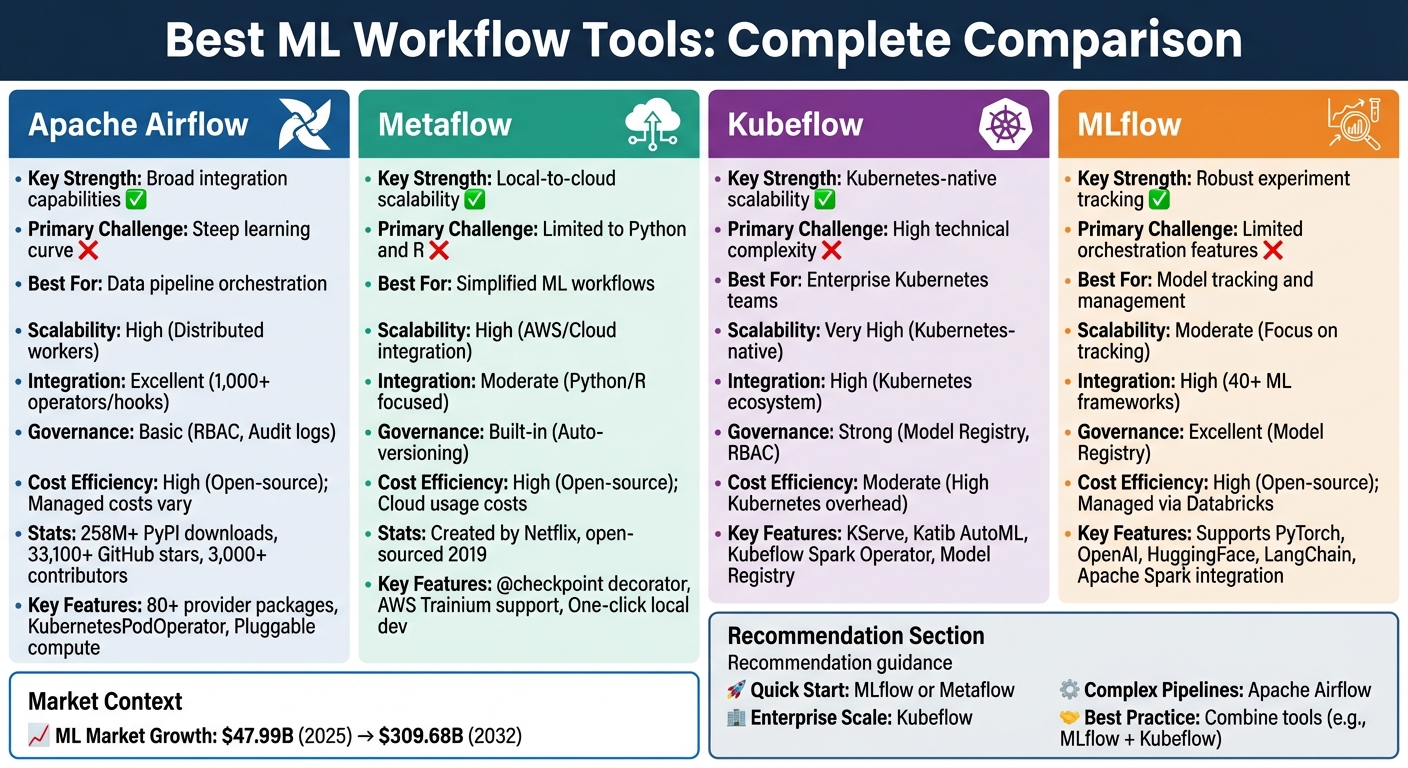

Comparaison des outils de flux de travail d'apprentissage automatique : Apache Airflow contre Metaflow contre Kubeflow contre MLflow

Apache Airflow est devenu le choix incontournable pour orchestrer des pipelines de données sur différentes plateformes. En tant que projet de l'Apache Software Foundation, il possède des statistiques impressionnantes : plus de 258 millions de téléchargements PyPI, plus de 33 100 étoiles GitHub et les contributions de plus de 3 000 développeurs. Son framework natif Python permet aux data scientists de transformer de manière fluide les scripts d'apprentissage automatique existants en flux de travail orchestrés à l'aide d'outils simples tels que @task décorateur. Cette approche minimise le besoin de modifications importantes du code tout en améliorant l'automatisation et la reproductibilité.

L'une des caractéristiques les plus remarquables d'Airflow est sa packages pour les fournisseurs - une collection de plus de 80 modules qui simplifient les connexions à des services tiers. Ces packages incluent des opérateurs, des hooks et des capteurs prédéfinis, ce qui facilite l'intégration aux principales plateformes telles qu'AWS, GCP et Azure. Pour les flux de travail d'apprentissage automatique, Airflow se connecte à des outils tels que MLflow, SageMaker et Azure ML. Il prend également en charge les LLMOP et les pipelines de génération augmentée par extraction (RAG) grâce à des intégrations avec des bases de données vectorielles telles que Weaviate, Pinecone, Qdrant et PgVector. Des fonctionnalités telles que Opérateur Kubernetes et @task .external_python_operator permettent aux tâches de s'exécuter dans des environnements isolés, ce qui accroît la flexibilité.

« Apache Airflow est au cœur du stack MLOps moderne. Comme il est indépendant des outils, Airflow peut orchestrer toutes les actions dans n'importe quel outil MLOps doté d'une API. » - Astronomer Docs

Ce cadre d'intégration complet souligne la capacité d'Airflow à s'adapter à divers flux de travail.

La conception modulaire d'Airflow lui permet de gérer des charges de travail de toutes tailles. Il utilise des files d'attente de messages pour gérer un nombre illimité de travailleurs, ce qui le rend évolutif, d'un seul ordinateur portable à de grands systèmes distribués. C'est ordinateur enfichable Cette fonctionnalité permet aux équipes de décharger des tâches gourmandes en ressources vers des clusters externes tels que Kubernetes, Spark, Databricks ou des instances GPU cloud. Le KubernetesExecutor améliore encore l'évolutivité en allouant dynamiquement les ressources et en activant des modules de calcul selon les besoins. Cela garantit que les organisations ne payent que pour ce qu'elles utilisent, tout en maintenant une gestion des ressources efficace.

Bien que la nature open source d'Airflow élimine les frais de licence, sa dépendance à Docker et Kubernetes peut entraîner une augmentation des coûts de configuration et de maintenance. La gestion des dépendances et la gestion de cette courbe d'apprentissage abrupte sont souvent citées comme des défis. Noah Ford, data scientist senior, a fait la remarque suivante :

« Le flux d'air commence et reste fort, ce qui rend le démarrage démotivant. »

Des services gérés tels qu'Astronomer, qui propose un essai de 14 jours et 20$ de crédits gratuits, peuvent contribuer à réduire la charge d'infrastructure. En outre, la consolidation de plusieurs outils en une seule couche d'orchestration permet de rationaliser les opérations et de réduire les coûts globaux en éliminant le besoin de systèmes distincts.

Metaflow, créé à l'origine par Netflix et open source en 2019, est un framework conçu pour simplifier la vie des data scientists. Il se distingue en permettant aux utilisateurs de créer des flux de travail localement sur leurs ordinateurs portables et de les adapter facilement au cloud sans avoir à ajuster le code. Cette facilité d'utilisation s'est traduite par des résultats tangibles : l'équipe de science des données de CNN, par exemple, a réussi à tester deux fois plus de modèles au premier trimestre 2021 par rapport à l'année précédente grâce à l'adoption de Metaflow [1]. Sa conception rationalisée des flux de travail en fait un choix judicieux pour évoluer dans des environnements à forte demande.

Metaflow brille vraiment lorsqu'il s'agit de gérer des modèles complexes. Il prend en charge le cloud bursting sur des plateformes telles qu'AWS (EKS, Batch), Azure (AKS) et Google Cloud (GKE), permettant une allocation précise des ressources pour chaque étape du flux de travail grâce à de simples décorateurs. Pour ceux qui travaillent avec de grands modèles linguistiques, il propose même un support natif pour le matériel AWS Trainium. Le @checkpoint Le décorateur garantit que les progrès sont enregistrés lors de longs travaux, évitant ainsi la frustration de recommencer après des échecs. Une fois que les flux de travail sont prêts pour la production, Metaflow peut les exporter vers des orchestrateurs robustes tels qu'AWS Step Functions ou Kubeflow, capables de gérer des millions d'exécutions.

Metaflow excelle également dans sa capacité à s'intégrer à un large éventail d'outils et de bibliothèques. Il est conçu pour fonctionner parfaitement avec n'importe quelle bibliothèque d'apprentissage automatique basée sur Python, notamment PyTorch, HuggingFace et XGBoost. Pour la gestion des données, il se connecte nativement à AWS S3, Azure Blob Storage et Google Cloud Storage. Il prend en charge Python et R, s'adressant à un large éventail d'utilisateurs. En outre, l'intégration avec uv Cet outil garantit une résolution rapide des dépendances, que vous travailliez localement ou dans le cloud, une fonctionnalité essentielle lors de la mise à l'échelle de plusieurs instances. L'équipe d'ingénierie de Realtor.com a tiré parti de ces fonctionnalités pour réduire considérablement le temps nécessaire à la transition des modèles de la recherche à la production, réduisant ainsi leur calendrier de plusieurs mois [2].

Metaflow garantit que chaque flux de travail, chaque expérience et chaque artefact sont versionnés automatiquement, faisant de la reproductibilité une fonctionnalité intégrée. Il s'intègre également parfaitement aux cadres de sécurité et de gouvernance existants de l'entreprise, en proposant des API dédiées à la gestion des secrets. Cela garantit une visibilité et une conformité complètes pour les flux de travail d'apprentissage automatique, conformément aux exigences des entreprises.

En tant qu'outil open source, Metaflow élimine les frais de licence, ce qui en fait un choix économique pour les équipes de toutes tailles. Son environnement de développement local en un clic réduit le temps consacré à la configuration de l'infrastructure, tandis que la possibilité de tester les flux de travail localement avant le déploiement dans le cloud permet d'éviter des dépenses inutiles. Grâce à l'allocation granulaire des ressources, vous ne payez que pour le matériel nécessaire à chaque étape, évitant ainsi le gaspillage lié au surprovisionnement. En outre, son environnement Sandbox intégré au navigateur permet aux utilisateurs d'expérimenter les fonctionnalités du cloud sans engager immédiatement de ressources d'infrastructure. Ces fonctionnalités économiques font de Metaflow une option intéressante pour créer des flux de travail d'apprentissage automatique efficaces et prêts pour la production.

Kubeflow est une plateforme spécialement conçue pour les flux de travail d'apprentissage automatique (ML), conçue pour fonctionner parfaitement avec Kubernetes. Contrairement aux orchestrateurs à usage général, il propose des outils adaptés à des tâches telles que le réglage des hyperparamètres et la diffusion de modèles. Sa base Kubernetes garantit la flexibilité, lui permettant de fonctionner sur Google Cloud, AWS, Azure ou même sur des configurations sur site. Cette portabilité en fait la solution idéale pour les équipes opérant dans des environnements divers. En se concentrant sur les besoins spécifiques du ML, Kubeflow offre une évolutivité et une intégration adaptées aux flux de travail complexes, comme indiqué ci-dessous.

Kubeflow tire parti de la capacité de Kubernetes à évoluer efficacement, ce qui le rend parfaitement adapté aux flux de travail ML à grande échelle. Chaque étape d'un pipeline s'exécute comme une tâche conteneurisée indépendante, permettant une exécution parallèle automatique via un graphe acyclique dirigé (DAG). Le composant Trainer de la plateforme prend en charge la formation distribuée sur des frameworks tels que PyTorch, HuggingFace, DeepSpeed, JAX et XGBoost. À des fins d'inférence, KServe gère à la fois des modèles d'IA génératifs et prédictifs avec des performances évolutives. Les utilisateurs peuvent spécifier les exigences en matière de processeur, de GPU et de mémoire pour les tâches, tandis que les sélecteurs de nœuds acheminent les tâches de formation intensives vers les nœuds équipés d'un GPU et attribuent des tâches plus légères à des instances économiques utilisant uniquement des processeurs. En outre, la fonction de mise en cache de Kubeflow empêche les exécutions redondantes lorsque les entrées restent inchangées, ce qui permet d'économiser du temps et des ressources de calcul.

La conception modulaire de Kubeflow intègre des outils pour chaque phase du cycle de vie du machine learning. Pour le développement, Kubeflow Notebooks propose des environnements Jupyter basés sur le Web qui s'exécutent directement dans les Kubernetes Pods. Katib facilite le réglage de l'AutoML et des hyperparamètres, en utilisant un arrêt précoce pour mettre fin aux essais peu performants. Le traitement des données est rationalisé grâce à Kubeflow Spark Operator, qui exécute les applications Spark en tant que charges de travail Kubernetes natives. Pour les utilisateurs d'ordinateurs portables, l'outil Kale simplifie la conversion des blocs-notes Jupyter en Kubeflow Pipelines sans nécessiter de réglages manuels. Le registre des modèles sert de référentiel central pour gérer les versions et les métadonnées des modèles, en faisant le lien entre l'expérimentation et le déploiement. Tous ces composants sont accessibles via le tableau de bord central de Kubeflow, qui fournit une interface unifiée pour la gestion de l'écosystème. Grâce à des outils de gouvernance intégrés, Kubeflow garantit un suivi clair des modèles et des performances cohérentes entre les flux de travail.

Kubeflow offre un suivi et une visualisation robustes des définitions des pipelines, des exécutions, des expériences et des artefacts de machine learning, garantissant ainsi un lignage clair entre les données brutes et les modèles déployés. Le registre des modèles fait office de centre pour les versions et les métadonnées des modèles, garantissant ainsi la cohérence entre les itérations. Les flux de travail sont compilés dans des fichiers YAML IR indépendants de la plate-forme, ce qui permet une migration fluide entre les environnements Kubernetes sans nécessiter d'ajustements majeurs. Cette cohérence favorise des transitions fluides entre les environnements de développement, de préparation et de production.

En tant que plateforme open source, Kubeflow élimine les coûts de licence, ne laissant que les dépenses liées à l'infrastructure Kubernetes sous-jacente. Sa fonction de mise en cache réduit les coûts de calcul en évitant la réexécution des étapes de traitement des données ou de formation lorsque les entrées restent inchangées. La capacité d'arrêt précoce de Katib permet d'économiser davantage de ressources en mettant fin rapidement aux essais de réglage des hyperparamètres peu performants. Pour les équipes dont les besoins sont simples, Kubeflow Pipelines peut être installé en tant qu'application autonome, ce qui réduit la charge de ressources sur le cluster. En outre, la capacité de Kubeflow à exécuter plusieurs composants de flux de travail simultanément garantit une utilisation optimale des ressources, une réduction des temps d'inactivité et une efficacité maximale.

MLflow est une plateforme open source conçue pour rationaliser le cycle de vie de l'apprentissage automatique (ML), couvrant tout, du suivi des expériences à l'emballage et au déploiement de modèles. Grâce à son intégration transparente à GitHub et à sa compatibilité avec plus de 40 frameworks, dont PyTorch, OpenAI, HuggingFace et LangChain, elle est devenue une solution incontournable pour les équipes de machine learning. Sous licence Apache-2.0, MLflow est disponible pour l'auto-hébergement ou en tant que service géré via Databricks. Nous explorons ci-dessous son évolutivité, ses capacités d'intégration, ses fonctionnalités de gouvernance et ses avantages en termes de coûts, qui complètent les outils décrits précédemment.

MLFlow Serveur de suivi garantit la capture de tous les paramètres, métriques et artefacts des séries distribuées, tout en maintenant un lignage de données clair. Grâce à son intégration native avec Apache Spark, la plateforme gère sans effort des ensembles de données à grande échelle et des formations distribuées, ce qui la rend idéale pour les équipes qui gèrent des charges de travail de données importantes. Pour la production, Service de modèles Mosaic AI prend en charge les prévisions en temps réel grâce à des fonctionnalités telles que les mises à jour sans interruption et la division du trafic pour comparer les modèles (par exemple, « Champion » et « Challenger »). En outre, les pipelines d'inférence par lots et en streaming offrent des solutions rentables pour les scénarios à haut débit où une latence très faible n'est pas requise. Avec alias de modèle dans Unity Catalog, les pipelines peuvent charger dynamiquement la dernière version du modèle validé sans aucune modification de code.

MLflow excelle dans la combinaison de l'évolutivité et de nombreuses options d'intégration. Il prend en charge les flux de travail traditionnels de machine learning, d'apprentissage en profondeur et d'IA générative. La plateforme est conçue pour les fournisseurs de grands modèles linguistiques (LLM) tels qu'OpenAI, Anthropic, Gemini et AWS Bedrock, et s'intègre à des outils d'orchestration tels que LangChain, LLamaIndex, dSpy, AutoGen et CrewAI. Le 4 novembre 2025, MLflow a ajouté Support d'OpenTelemetry, permettant une intégration fluide avec les outils de surveillance de l'entreprise. C'est Passerelle IA fournit une interface centralisée pour gérer les interactions entre les différents fournisseurs de LLM, simplifiant ainsi les opérations sur les plateformes cloud. Améliorant encore son observabilité, MLflow a introduit la prise en charge de chaque stack TypeScript LLM le 23 décembre 2025, soulignant ainsi son alignement sur les flux de travail d'IA modernes.

MLFlow Registre des modèles offre un suivi centralisé des versions des modèles, de leur généalogie et des transitions entre le développement et la production. Pour chaque expérience, la plateforme enregistre les versions de code, les paramètres, les métriques et les artefacts, garantissant ainsi la reproductibilité entre les équipes et les environnements. Pour les applications d'IA génératives, MLflow inclut des outils permettant de suivre et d'évaluer les flux de travail LLM, offrant ainsi une meilleure visibilité sur les systèmes complexes. Les modèles sont regroupés dans un format standardisé qui garantit un comportement cohérent dans tous les environnements de déploiement, tandis que les graphiques de dépendance documentent automatiquement les caractéristiques et les fonctions requises pour l'inférence.

La nature open source de MLflow élimine les frais de licence, faisant de l'infrastructure le coût principal des configurations auto-hébergées. Les équipes peuvent opter pour un contrôle total grâce à l'auto-hébergement ou réduire les exigences opérationnelles en choisissant l'hébergement géré, qui inclut même un niveau gratuit. Les fonctionnalités d'inférence par lots et en streaming de la plateforme offrent des alternatives abordables au service en temps réel pour les tâches à haut débit. En centralisant le suivi des expériences et la gestion des modèles, MLflow minimise les efforts redondants, aidant les équipes à éviter de répéter les expériences ou de perdre la trace des versions des modèles, ce qui permet d'économiser du temps et des ressources de calcul dans le processus.

En ce qui concerne les outils de flux de travail pour gérer les pipelines de machine learning, chaque option présente ses avantages et ses inconvénients. Voici un aperçu de la situation de certains outils populaires :

Flux d'air Apache se distingue par sa capacité à connecter un large éventail de systèmes grâce à sa vaste bibliothèque d'opérateurs et de crochets. Cela en fait un choix incontournable pour les pipelines d'ingénierie de données complexes qui prennent en charge les modèles ML. Cependant, il ne dispose pas de fonctionnalités intégrées spécifiques au ML, telles que le suivi des modèles ou un registre de modèles, ce qui peut être un inconvénient. De plus, les utilisateurs trouvent souvent que sa courbe d'apprentissage est abrupte. Bien que son architecture de travail distribuée offre une excellente évolutivité, la gestion de l'infrastructure peut devenir complexe.

Métaflow met l'accent sur la simplicité, la gestion automatique des expériences et la gestion des versions des données, afin que les équipes n'aient pas à se soucier de la gestion de l'infrastructure. Il s'intègre parfaitement aux services de stockage et de calcul AWS, permettant aux data scientists de se concentrer sur le développement de Python. L'inconvénient ? Ses capacités d'intégration sont plus limitées et concernent principalement les flux de travail Python et R.

Kubeflow est conçu pour être évolutif, en tirant parti de sa conception native de Kubernetes et du soutien de la communauté Kubernetes. Il propose des outils pour l'ensemble du cycle de vie de l'IA, tels que KServe pour le service de modèles et un registre de modèles pour le contrôle des versions. Cependant, la plateforme exige une expertise Kubernetes significative, ce qui peut représenter un défi pour les équipes dépourvues de compétences techniques spécialisées. De plus, les frais d'infrastructure sont souvent plus élevés.

Débit ML excelle dans la gestion du cycle de vie du machine learning, offrant un suivi des expériences de haut niveau et une compatibilité avec plus de 40 frameworks, dont PyTorch et TensorFlow. Son registre des modèles et ses normes d'emballage garantissent la reproductibilité dans tous les environnements. Cela dit, bien qu'il soit fantastique pour le suivi, MLflow ne se concentre pas autant sur l'orchestration de pipelines complexes, nécessitant souvent une association avec un autre outil comme Airflow ou Kubeflow pour un transfert de données avancé.

En fin de compte, le choix du bon outil dépend des besoins et des priorités spécifiques de votre pipeline de machine learning.

Le choix de l'outil de flux de travail d'apprentissage automatique le plus adapté dépend en grande partie de l'expertise de votre équipe et des ressources disponibles. Si vous vous concentrez sur un développement rapide sans ingénierie lourde, Métaflow offre un moyen efficace de passer de l'expérimentation locale au déploiement dans le cloud. Pour les équipes qui donnent la priorité à des solutions respectueuses de leur budget et à un suivi efficace des expériences, Débit ML se distingue comme une option open source fiable. Sa flexibilité entre les différents frameworks et ses fonctionnalités de versionnage robustes en font un choix incontournable pour la gestion des modèles.

Pour les organisations qui utilisent déjà Kubernetes, Kubeflow offre une évolutivité et une portabilité natives, ce qui en fait un candidat sérieux pour les déploiements au niveau de l'entreprise. Cependant, sa complexité et sa courbe d'apprentissage abrupte peuvent poser des défis aux petites équipes aux capacités d'ingénierie limitées. Malgré cela, la préparation à la production de Kubeflow a été prouvée lors de nombreux déploiements à grande échelle.

Du côté de l'orchestration, Flux d'air Apache reste un outil polyvalent et mature pour intégrer différents systèmes. Bien que sa complexité nécessite souvent une maintenance dédiée, de nombreuses équipes de production trouvent qu'il est intéressant de combiner les outils plutôt que de s'en remettre à un seul. Par exemple, associer MLflow pour le suivi des expériences à Kubeflow pour l'orchestration est une stratégie populaire, permettant des flux de travail qui capitalisent sur les points forts de chaque outil. Cette approche multi-outils garantit flexibilité et efficacité, en particulier à mesure que les flux de travail d'apprentissage automatique deviennent de plus en plus complexes.

Alors que le marché de l'apprentissage automatique devrait monter en flèche à partir de 47,99 milliards de dollars en 2025 à 309,68 milliards de dollars d'ici 2032, il est essentiel de choisir des outils qui s'intègrent bien et qui s'adaptent à vos besoins. Pour les équipes aux ressources limitées, commencer par MLflow ou Metaflow peut minimiser les coûts tout en fournissant des fonctionnalités essentielles telles que le suivi et la gestion des versions. À mesure que vos besoins augmentent, des outils d'orchestration plus avancés peuvent être ajoutés sans perturber votre configuration existante, ce qui permet une évolution fluide de votre flux de travail.

Apache Airflow et Kubeflow ont des objectifs différents et répondent à des besoins distincts, notamment en matière de gestion des flux de travail et des pipelines d'apprentissage automatique.

Flux d'air Apache est une plateforme basée sur Python conçue pour orchestrer, planifier et surveiller les flux de travail. Il se distingue dans la gestion d'un large éventail de tâches d'automatisation, y compris les pipelines de données, grâce à son architecture évolutive et à son interface conviviale. Bien qu'Airflow ne soit pas spécifiquement conçu pour l'apprentissage automatique, sa polyvalence lui permet de s'intégrer parfaitement aux infrastructures existantes et de prendre en charge les opérations liées au ML, ainsi que d'autres besoins d'automatisation.

Kubeflow, en revanche, est spécialement conçu pour les flux de travail d'apprentissage automatique au sein des environnements Kubernetes. Il propose un écosystème modulaire conçu pour prendre en charge l'ensemble du cycle de vie de l'IA, de l'orchestration du pipeline à la formation et au déploiement des modèles. En mettant l'accent sur la portabilité, l'évolutivité et l'intégration aux technologies natives du cloud, Kubeflow est particulièrement bien adapté à la gestion de pipelines ML de bout en bout dans des environnements conteneurisés.

Airflow est essentiellement un outil d'orchestration flexible qui prend en charge un large éventail de tâches, tandis que Kubeflow est spécialement conçu pour les flux de travail d'apprentissage automatique, fournissant des outils spécialisés pour chaque étape du cycle de vie du machine learning dans les configurations Kubernetes.

Metaflow simplifie le transfert des flux de travail d'apprentissage automatique d'un ordinateur personnel vers le cloud en proposant une structure cohérente et facile à utiliser. Il permet aux data scientists de créer et de tester des flux de travail sur leurs machines locales, puis de passer à des plateformes cloud de manière fluide, sans avoir à remanier leur code.

La plateforme facilite l'allocation de ressources telles que Processeurs, mémoire et GPU pour gérer des ensembles de données plus importants ou permettre un traitement parallèle. Il s'intègre facilement aux principaux fournisseurs de cloud, notamment AWS, Azure et Google Cloud, ce qui permet de passer en douceur des environnements de développement locaux aux environnements de production. Qu'ils soient exécutés localement, sur site ou dans le cloud, Metaflow garantit que les flux de travail sont à la fois évolutifs et fiables, réduisant ainsi la complexité tout en augmentant l'efficacité.

Les équipes se combinent souvent Débit ML et Kubeflow pour exploiter leurs fonctionnalités complémentaires et créer un flux de travail d'apprentissage automatique plus rationalisé. Débit ML se spécialise dans le suivi des expériences, la gestion des versions des modèles et la supervision des étapes de déploiement, en veillant à ce que les modèles restent reproductibles et bien documentés. D'autre part, Kubeflow propose une plateforme évolutive native de Kubernetes conçue pour orchestrer et gérer les pipelines d'apprentissage automatique, couvrant tout, de la formation à la diffusion et à la surveillance.

L'intégration de ces outils permet aux équipes de simplifier le passage de l'expérimentation à la production. MLFlow les points forts en matière de suivi et de gestion des modèles correspondent parfaitement à Kubeflow infrastructure robuste, offrant une automatisation, une évolutivité et une efficacité opérationnelle améliorées. Cette combinaison est particulièrement adaptée aux équipes qui recherchent une solution flexible de bout en bout pour gérer l'ensemble du cycle de vie de l'apprentissage automatique.