Los ecosistemas de IA están transformando las operaciones empresariales al unificar herramientas, modelos y flujos de trabajo en plataformas centralizadas. A partir de 2026, las empresas que utilizan estos sistemas informan de un Aumento de la productividad del 64% y Aumento del 81% en la satisfacción laboral, al tiempo que reduce los costos y mejora la gobernanza. Con más de 11.000 modelos de IA disponibles, plataformas como Microsoft Foundry, Inteligencia artificial de Google Vertex, y Plataforma de datos de IA de Oracle dominan el mercado, lo que permite una integración perfecta, un cumplimiento automatizado y flujos de trabajo escalables.

Los ecosistemas unificados de IA eliminan las ineficiencias, mejoran la seguridad y ofrecen resultados mensurables. Ya sea que automaticen los flujos de trabajo o administren los costos, estas plataformas están transformando la forma en que las empresas implementan la IA a escala. Ahora es el momento de simplificar su estrategia de IA y aprovechar todo su potencial.

Los ecosistemas de IA unificados reúnen el acceso, la gobernanza y la automatización de modelos en un sistema centralizado, lo que elimina las ineficiencias de las herramientas desconectadas. Este enfoque unificado permite una integración perfecta y una supervisión más sólida.

Estos ecosistemas brindan acceso a miles de modelos de IA e integraciones prediseñadas a través de marcos estandarizados. Por ejemplo, el Servicio Azure AI Agent ofrece más de 1.400 conectores mediante Aplicaciones Azure Logic, lo que permite la integración con herramientas como Jira, SAVIA, y ServiceNow. Esto funciona con el Protocolo de contexto modelo (MCP), que garantiza una conectividad fluida.

La orquestación de múltiples agentes lleva la integración un paso más allá, ya que permite a los agentes funcionar como supervisores, enrutadores o planificadores. Las plataformas admiten el desarrollo visual y el basado en código, lo que hace que la implementación sea más rápida y eficiente. Mediante el uso de modelos semánticos u ontologías, estos sistemas pueden interpretar y gestionar operaciones complejas de forma eficaz.

Las plataformas unificadas vienen equipadas con herramientas de gobierno que automatizan los procesos de cumplimiento y hacen cumplir las políticas de seguridad en todas las interacciones de la IA. Los paneles centralizados ofrecen información en tiempo real sobre la actividad de los agentes, el seguimiento de las sesiones y las métricas de rendimiento. El control de acceso basado en roles (RBAC) se integra perfectamente con marcos de identidad como Microsoft Entra ID, SAML y Active Directory, lo que garantiza una gestión coherente de los permisos.

Las medidas de seguridad, como los filtros de contenido para detectar salidas dañinas y las defensas contra los ataques de inyección cruzada (XPIA), protegen aún más las operaciones. Ethan Sena, director ejecutivo de IA e ingeniería de nube de Bristol Myers Squibb, destacó las ventajas de estas funciones:

«Azure AI Agent Service nos brinda un conjunto sólido de herramientas que aceleran nuestro viaje hacia la IA generativa en toda la empresa... Al aprovechar el servicio, podemos desviar nuestro tiempo de ingeniería del desarrollo personalizado y respaldar los factores diferenciadores que nos importan».

Las organizaciones también pueden adoptar «Bring Your Own Storage» (BYOS) y redes privadas virtuales (VNet) para mantener el tráfico de datos seguro y cumplir con las normas reglamentarias. Esta combinación de gobierno e integración garantiza operaciones seguras y fluidas.

La orquestación automatiza todo el ciclo de vida de la IA, desde la implementación del modelo hasta las canalizaciones de datos y las plantillas de flujo de trabajo. Los marcos estandarizados, como los gráficos acíclicos dirigidos (DAG), ayudan a crear flujos de trabajo repetibles, lo que reduce el esfuerzo manual y garantiza la coherencia.

Las plataformas asignan de forma dinámica los recursos informáticos, a menudo utilizando Kubernetes, para adaptarse a las cambiantes demandas en tiempo real. La orquestación basada en la tecnología Human-in-the-Loop (HITL) introduce puntos de control en los que es necesaria la supervisión humana de los procesos delicados. Estas eficiencias se traducen directamente en mejores resultados empresariales.

Por ejemplo, Marcus Saito, director de automatización de TI e IA de Remote.com, implementó un servicio de asistencia basado en inteligencia artificial que resuelve el 28% de las solicitudes de 1.700 empleados de todo el mundo. Del mismo modo, Okta reduzca los tiempos de escalamiento del soporte de 10 minutos a solo segundos al automatizar el 13% de los escalamientos de casos.

Ritika Gunnar, IBM, director general de datos e inteligencia artificial, resumió la importancia de estas capacidades:

«La orquestación, la integración y la automatización son las armas secretas que harán que los agentes pasen de la novedad a la operación».

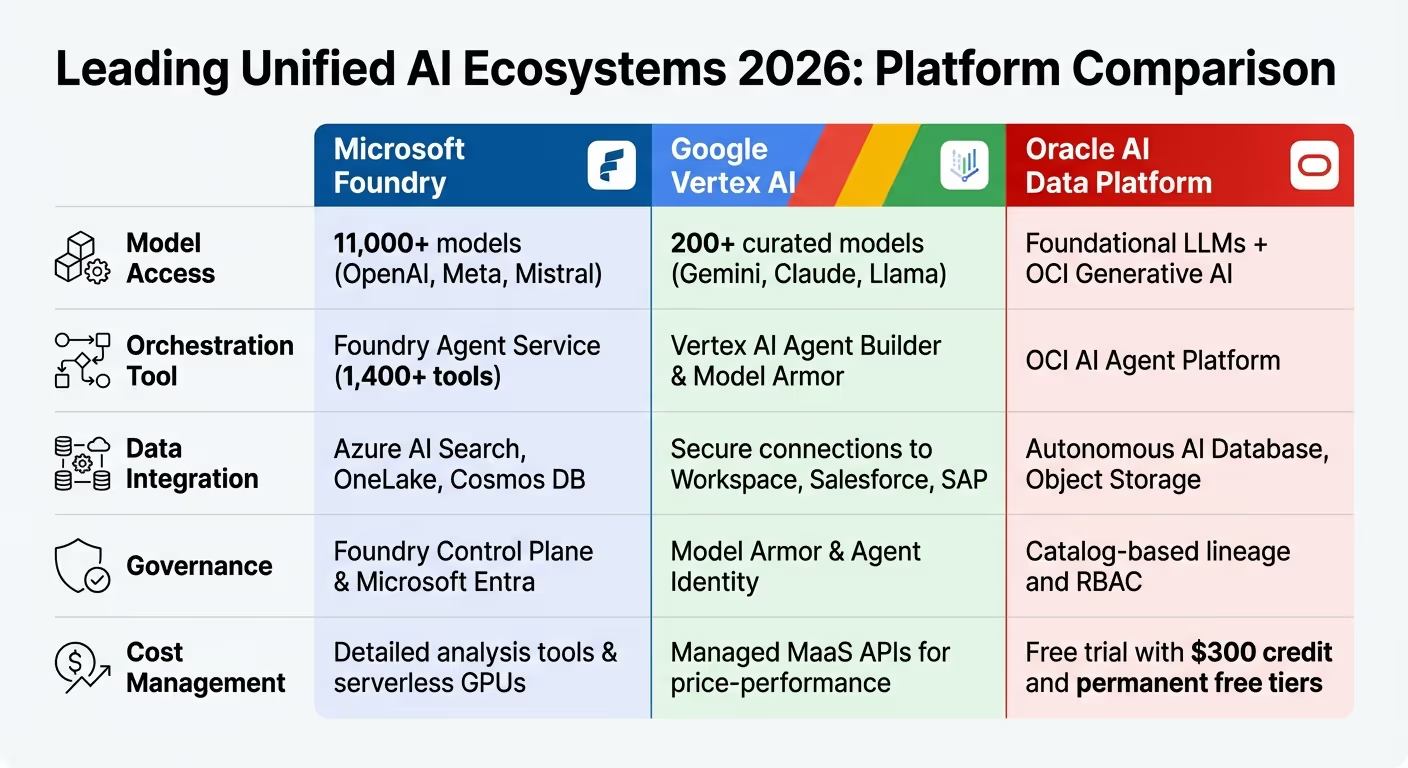

Principales plataformas de IA unificada para 2026: Microsoft Foundry frente a Google Vertex AI frente a Oracle AI

Para 2026, el panorama de la IA habrá cambiado drásticamente, y las plataformas evolucionarán mucho más allá de los sistemas básicos de chatbot. Microsoft Foundry, Inteligencia artificial de Google Vertex, y Plataforma de datos de IA de Oracle ahora dominan la escena e impulsan a agentes autónomos capaces de planificar, ejecutar y colaborar en los flujos de trabajo empresariales. Estas plataformas cuentan con contratos de API unificados, lo que permite a los desarrolladores cambiar de proveedor sin problemas, como IA abierta, Llama y Mistral sin necesidad de reescribir el código. Con un fuerte enfoque en la gobernanza y la fundamentación de los datos, abordan los problemas de fragmentación discutidos anteriormente.

La capa «Gold Medallion» de Oracle garantiza que los agentes de IA accedan solo a datos empresariales gobernados y de alta calidad para minimizar errores como las alucinaciones. Vertex AI Model Garden de Google ofrece una selección selecta de más de 200 modelos listos para la empresa, mientras que Microsoft Foundry se conecta a un impresionante catálogo de más de 1400 herramientas. Los paneles centralizados, como los paneles de control «Operativo», ahora proporcionan a las empresas una visión completa de sus operaciones de inteligencia artificial y permiten hacer un seguimiento del estado, el rendimiento y la seguridad de los agentes en miles de implementaciones. Esta sólida base se refleja en la comparación entre estas plataformas en áreas clave.

He aquí un análisis más detallado de cómo estas plataformas líderes se comparan en términos de acceso a modelos, herramientas de orquestación, gobierno y administración de costos:

Microsoft Foundry permite a los usuarios explorar su plataforma de forma gratuita, y los precios se aplican solo en el momento de la implementación en función de los modelos consumidos y el uso de la API. Inteligencia artificial de Google Vertex emplea formación sin servidor y cobra a los usuarios por los recursos informáticos durante los trabajos personalizados. Mientras tanto, Nube de Oracle ofrece un crédito de 300 dólares para una prueba de 30 días y niveles gratuitos permanentes para servicios como OCI Speech and Vision.

Estas plataformas ya han generado resultados transformadores en todos los sectores, lo que demuestra su potencial para racionalizar las operaciones y aumentar el ROI.

«Contar con nuestra infraestructura y nuestra base de inteligencia artificial en Microsoft es una ventaja competitiva para Carvana. Nos permite funcionar con rapidez, adaptarnos al mercado e innovar con menos complejidad».

«La gobernanza y la observabilidad de Microsoft Foundry proporcionan lo que las empresas de KPMG necesitan para tener éxito en una industria regulada».

Estos ejemplos ilustran cómo los ecosistemas de IA unificados pueden impulsar la eficiencia, reducir los costos y ofrecer retornos mensurables, lo que los hace indispensables para las empresas que desean escalar de manera segura y efectiva.

Las plataformas unificadas dependen de algo más que la orquestación de modelos: requieren una infraestructura de datos sólida para impulsar la automatización inteligente. La orquestación exitosa de la IA depende de contar con sistemas confiables que brinden información precisa y oportuna. Para 2026, muchas organizaciones habrán superado los lagos de datos básicos y habrán adoptado arquitecturas medallón y Arquitecturas Lakehouse para transformar los datos sin procesar en activos confiables y listos para consultas. El medallón dorado de Oracle garantiza que los agentes de IA accedan solo a datos verificados y de alta calidad. Del mismo modo, Almacenamiento de objetos OCI gestiona los enormes volúmenes de datos no estructurados que requieren las canalizaciones de IA. En conjunto, estos avances proporcionan una base perfecta para la orquestación nativa de la IA en todos los ecosistemas.

La evolución de flujos de trabajo rígidos y basados en reglas a Orquestación nativa de IA ha modificado la forma en que se gestionan los flujos de datos. En lugar de confiar en reglas estáticas, las plataformas modernas ahora usan arquitecturas basadas en eventos, donde eventos empresariales específicos (como subir un documento o completar una transacción) activan automáticamente los agentes o flujos de trabajo de IA según sea necesario. Este enfoque reactivo elimina los cuellos de botella y permite que diferentes partes del sistema escalen de forma independiente. La guía prescriptiva de AWS refleja este cambio:

«La orquestación ya no se basa solo en reglas, sino en la interpretación de la intención, la selección de herramientas y la ejecución autónoma».

Los modelos semánticos desempeñan un papel fundamental a la hora de mantener a los agentes de IA alineados en todos los departamentos al servir como una única fuente de información veraz. Estos modelos definen con precisión los términos específicos de la empresa, como «cliente empresarial» o «objetivos del tercer trimestre», lo que garantiza una interpretación coherente de los datos en toda la organización. Databricks destaca la importancia de esta base:

«Una capa semántica unificada proporciona definiciones empresariales coherentes en todas las herramientas y usuarios. Esta base semántica proporciona a la IA un conocimiento profundo de los datos empresariales y los conceptos empresariales exclusivos de cada organización».

La transmisión de eventos se basa en esta coherencia al habilitar capacidad de respuesta en tiempo real. En lugar de basarse en el sondeo de bases de datos o en los trabajos por lotes, los agentes de IA supervisan los flujos de eventos y responden de inmediato cuando se alcanzan ciertos umbrales, ya sea ajustando los precios en función de los niveles de inventario o activando alertas de reabastecimiento. Este enfoque basado en eventos también desvincula la lógica de la IA de los sistemas de backend mediante capas de barrera como el Model Context Protocol (MCP). Esta separación permite a los desarrolladores actualizar las bases de datos o las API sin interrumpir los flujos de trabajo de orquestación.

Los gráficos de conocimiento y los marcos de identidad compartida mejoran aún más la gobernanza de los datos en toda la empresa al garantizar una interpretación semántica coherente. Los gráficos de conocimiento hacen más que almacenar datos; representan la decisiones y relaciones dentro de una organización, integrando la lógica, los datos y las acciones en una capa semántica interpretable tanto por los humanos como por la IA. PalantirLa Ontología ilustra este concepto:

«La ontología está diseñada para representar las decisiones de una empresa, no solo los datos».

Estos gráficos funcionan como autobús operativo, utilizando los SDK para conectar sistemas en toda la organización. Permiten la sincronización bidireccional entre las herramientas de modelado y los catálogos de datos, lo que garantiza que las actualizaciones de un sistema se reflejen en todas las herramientas y agentes conectados.

Marcos de identidad compartida complementan estos sistemas manteniendo permisos consistentes a medida que los datos se mueven entre las herramientas. Plataformas como Centro de identidad de AWS IAM proporcionan una administración de acceso dinámica, integrándose con los sistemas SAML y Active Directory existentes para aplicar permisos basados en roles, clasificaciones o propósitos. Este enfoque centralizado garantiza que los agentes de IA operen dentro de estrictos límites de seguridad y cumplimiento, incluso cuando los flujos de trabajo abarcan varios modelos y fuentes de datos.

A medida que las cargas de trabajo de IA continúan expandiéndose en 2026, la administración de los costos se ha vuelto tan importante como la optimización del rendimiento. Los ecosistemas unificados se han incorporado FinOps impulsadas por agentes, donde los agentes de IA supervisan miles de millones de señales de costes en tiempo real. Estos agentes identifican las ineficiencias, como los recursos de GPU inactivos, los clústeres sobreaprovisionados o la salida innecesaria de datos, e inician automáticamente flujos de trabajo correctivos dentro de los límites de las políticas predefinidos. Según un estudio de IBM, las empresas que adoptan agentes FinOps basados en inteligencia artificial han logrado reducir los costos de la nube entre un 20 y un 40%. Por ejemplo, una institución financiera global redujo el tiempo de inactividad de las GPU en aproximadamente un 35% mediante la asignación automática de los recursos y la planificación de los recursos.

Este cambio está impulsado por herramientas que combinan consultas en lenguaje natural con un seguimiento preciso de los recursos. Plataformas como Desarrollador de Amazon Q, Copiloto de Azure, y Gemini Cloud Assist permiten a los equipos explorar los factores de costos de manera conversacional. Estas herramientas proporcionan información detallada sobre el uso de la GPU, los períodos de inactividad y el consumo basado en tokens, y abarcan tanto los modelos propietarios como los proveedores de terceros, como OpenAI, Antrópico, y CoHERE. Karan Sachdeva, líder de desarrollo empresarial global de IBM, explica:

«Las FinOps tradicionales se crearon para los paneles de control y las decisiones tomadas por humanos... Los agentes de IA van más allá de la presentación de informes. Observan, analizan y actúan».

Este nivel de seguimiento de los recursos permite a las organizaciones lograr una supervisión de los costos en tiempo real.

Las plataformas centralizadas consolidan los datos de facturación en un único sistema, lo que elimina las ineficiencias de los informes de costos fragmentados. Estas plataformas proporcionan información inmediata sobre qué modelos, equipos o proyectos están generando gastos. Con simulación de costes basada en fichas, los equipos pueden estimar el impacto financiero de cambiar de GPT-3.5 a GPT-4 o aumentar el uso en porcentajes específicos antes de comprometer recursos. Por ejemplo, BP usado Administración de costos de Microsoft reducir los costos de la nube en un 40%, aun cuando su uso general casi se duplicó, según John Maio, arquitecto jefe de plataformas de Microsoft de BP.

Estas plataformas también supervisan los modelos personalizados, que incurren en tarifas de alojamiento por hora incluso cuando están inactivos. Las implementaciones inactivas durante más de 15 días se marcan automáticamente. Para lograr cargas de trabajo predecibles, muchas organizaciones están pasando de los precios de pago por uso a niveles de compromiso, con lo que se aseguran tarifas fijas que pueden reducir los costos hasta en un 72% en el caso de las instancias reservadas y en un 90% en el de las instancias puntuales. Lograr esta precisión a menudo depende de etiquetado clave-valor en todos los recursos, como etiquetar los entornos con etiquetas como Entorno = «Producción», lo que permite realizar consultas de costes más rápidas y precisas al utilizar asistentes de IA.

Sin embargo, el seguimiento de los costos es solo una parte de la ecuación: es esencial conectar el gasto con resultados comerciales medibles.

La visibilidad de los costos por sí sola no es suficiente para medir el éxito. Las plataformas líderes utilizan modelos del costo total de propiedad (TCO) para dividir los gastos de la IA en seis categorías: servicio de modelos (inferencia), capacitación y ajuste, alojamiento en la nube, almacenamiento de datos, configuración de aplicaciones y soporte operativo. Este nivel de detalle permite a las juntas de revisión de la arquitectura evaluar los proyectos en función del costo, el rendimiento, la gobernanza y el riesgo. Los sistemas con muchos recursos, como los modelos de razonamiento y los agentes, solo se implementan cuando ofrecen un valor medible.

Las organizaciones sofisticadas también están adoptando clasificación y enrutamiento inteligentes estrategias. Las consultas rutinarias se dirigen a los modelos de lenguaje pequeño (SLM), mientras que solo las tareas complejas se trasladan a modelos avanzados más caros. Este enfoque puede reducir las llamadas a modelos grandes en un 40% sin comprometer la calidad. Procesar un millón de conversaciones mediante un SLM cuesta entre 150 y 800 dólares, en comparación con los 15 000 a 75 000 dólares de un LLM tradicional, lo que supone una reducción de costes de hasta 100 veces. Dr. Jerry A. Smith, jefe de los laboratorios de inteligencia artificial y sistemas inteligentes de Modo Create, capta este cambio a la perfección:

«El cambio a los SLM no está impulsado por la ideología o la elegancia técnica. Lo impulsa la hoja de cálculo del director financiero».

Este enfoque financiero también influye en las decisiones de infraestructura. Las organizaciones están desplegando cargas de trabajo en un arquitectura híbrida de tres niveles: nube pública para flexibilidad y experimentación, sistemas locales para inferencias predecibles de gran volumen (rentables cuando los gastos en la nube superan entre el 60 y el 70% de los sistemas locales equivalentes) y computación perimetral para tareas que requieren tiempos de respuesta inferiores a 10 ms. La alineación de la infraestructura con los resultados clave (como la satisfacción del cliente, los ingresos por transacción o el tiempo de comercialización) garantiza que las inversiones en inteligencia artificial no solo reduzcan los costos, sino que también generen resultados significativos.

El futuro de los ecosistemas unificados de IA está dando un audaz paso adelante con agentes autónomos. No se trata solo de herramientas que siguen instrucciones, sino que están diseñadas para comprender el contexto, evaluar los objetivos y tomar medidas deliberadas en sistemas de back-end complejos. Esta evolución cambia el papel de la IA, pasando de tareas simples de conversación a ejecutar procesos intrincados de varios pasos que antes requerían la participación humana. A finales de 2025, el 35% de las organizaciones ya utilizaban la IA de agencia, y otro 44% se preparaba para el despliegue. El impacto financiero lo dice todo: las empresas que se basan en la IA generan entre 25 y 35 veces más ingresos por empleado en comparación con sus homólogas tradicionales. Esta transformación allana el camino para una integración más profunda, a medida que examinamos el papel de los agentes autónomos en estos ecosistemas.

Ampliando las discusiones anteriores sobre la orquestación unificada, agentes autónomos están ahora en el centro de la toma de decisiones en tiempo real. Al actuar como un «sistema nervioso» para los ecosistemas, estos agentes conectan sin problemas las herramientas, la memoria y los datos para permitir acciones inmediatas e informadas. Por ejemplo, en diciembre de 2025, una empresa mundial de bienes de consumo rediseñó sus procesos de innovación mediante el despliegue de metaagentes para supervisar a los agentes trabajadores, lo que redujo los tiempos de ciclo en un 60%. Kate Blair, directora de experiencias de incubación y tecnología de IBM Research, destacó la importancia de este cambio:

«En 2026 es cuando estos patrones saldrán del laboratorio y pasarán a la vida real».

Las organizaciones están adoptando autonomía graduada mediante un «Protocolo de confianza» de cuatro niveles. Estos niveles incluyen el modo sombrío (el agente hace sugerencias), la autonomía supervisada (se requiere la aprobación humana), la autonomía guiada (supervisión humana) y la autonomía total (sin participación humana). En enero de 2026, Lockheed Martin consolidó 46 sistemas de datos independientes en una plataforma integrada, reduciendo sus herramientas de datos e inteligencia artificial a la mitad. Esta nueva base ahora impulsa una «fábrica de inteligencia artificial», en la que 10 000 ingenieros utilizan marcos de trabajo basados en agencias para gestionar flujos de trabajo sofisticados. Los resultados son sorprendentes: los agentes autónomos pueden acelerar los procesos empresariales entre un 30 y un 50% y reducir las tareas de bajo valor para los empleados entre un 25 y un 40%. Para aprovechar todo el potencial de estos agentes, el desarrollo de estándares abiertos se está convirtiendo en una prioridad.

Un desafío clave es garantizar que los agentes de diferentes proveedores puedan trabajar juntos sin problemas, lo que ha impulsado la creación de protocolos abiertos. El Protocolo de contexto modelo (MCP), introducida inicialmente por Anthropic y ahora gobernada por la Fundación Linux, permite a los agentes de IA integrarse con herramientas y fuentes de datos externas. Del mismo modo, el de Google Cloud Agente 2 Agente (A2A) El protocolo utiliza HTTP y JSON-RPC 2.0 para permitir la comunicación directa entre agentes independientes en todas las plataformas. Oracle también ha contribuido con su Especificación de agente abierto (especificación del agente), un marco declarativo que garantiza que los agentes y los flujos de trabajo sean portátiles en diferentes sistemas. Sungpack Hong, vicepresidente de investigación de IA de Oracle, explica:

«Agent Spec es una especificación declarativa independiente del marco diseñada para hacer que los agentes y flujos de trabajo de IA sean portátiles, reutilizables y ejecutables en cualquier marco compatible».

Estos protocolos se están unificando bajo órganos de gobierno neutrales para evitar la dependencia de los proveedores. Un sorprendente 93% de los ejecutivos cree que será fundamental tener en cuenta la soberanía de la IA en sus estrategias de aquí a 2026. Sin embargo, menos del 33% de las organizaciones han implementado la interoperabilidad y la escalabilidad necesarias para que la IA de agencia prospere. La aparición de Sistemas operativos agenciales (AOS) - tiempos de ejecución estandarizados que supervisan la orquestación, la seguridad, el cumplimiento y la administración de recursos para los enjambres de agentes: representan un paso importante hacia la preparación de los sistemas autónomos para la producción. Dado que el 96% de las organizaciones planea implementar agentes para optimizar los sistemas y automatizar los procesos principales, la carrera por establecer estándares universales se está intensificando.

Para las empresas que buscan escalar la IA sin sucumbir a una complejidad abrumadora, los ecosistemas de IA unificados ofrecen una solución poderosa. Estas plataformas desmantelan los silos que durante mucho tiempo han obstaculizado las iniciativas de inteligencia artificial, y permiten una colaboración fluida entre departamentos y funciones. La evolución de los chatbots básicos a los agentes proactivos capaces de organizar flujos de trabajo de varios pasos está generando resultados tangibles. Como se destacó anteriormente, estos flujos de trabajo orquestados aumentan la eficiencia, reducen las tareas de bajo valor entre un 25 y un 40% y aceleran los procesos empresariales entre un 30 y un 50%.

Lo que realmente cambia las reglas del juego está en la orquestación. Al unificar los modelos, los datos y la gobernanza en un sistema cohesivo, estas plataformas permiten a la IA ir más allá de responder a las consultas y empezar a ejecutar procesos complejos de principio a fin. Este enfoque no solo acelera las operaciones, sino que también reduce la necesidad de equipos grandes, lo que allana el camino para una gestión ágil del flujo de trabajo en organizaciones enteras.

Un número creciente de ejecutivos (el 88% para ser exactos) está aumentando sus presupuestos de IA para aprovechar las capacidades de las agencias, lo que alimenta la demanda de estándares de interoperabilidad. La introducción de marcos de autonomía graduales, que van desde el modo sombra hasta la autonomía total, proporciona un camino estructurado para que las organizaciones escalen la IA de manera responsable y eficaz.

Para 2026, las empresas líderes no solo automatizarán las tareas, sino que reimaginarán los flujos de trabajo para que estén impulsados intrínsecamente por la IA. Dado que el 78% de las organizaciones ya utilizan la IA en al menos un área empresarial, y Gartner previendo que el 60% de las operaciones de TI integrarán agentes de IA para 2028, ha llegado el momento de adoptar ecosistemas de IA unificados. Actuar pronto garantiza una ventaja competitiva en un panorama cada vez más centrado en la IA.

El cambio de herramientas fragmentadas a plataformas unificadas aborda tanto las necesidades operativas inmediatas como las innovaciones futuras. Estos ecosistemas están redefiniendo los flujos de trabajo, lo que permite la excelencia operativa y una transformación escalable. Para las empresas que desean mantenerse a la vanguardia, adoptar plataformas de IA unificadas ya no es opcional, sino esencial.

Los ecosistemas unificados de IA ofrecen a las empresas un entorno integrado en el que los datos, las herramientas y las aplicaciones funcionan en armonía, lo que elimina la molestia de tener que hacer malabares con sistemas desconectados. Al traer modelos lingüísticos grandes y otras herramientas de IA en una sola plataforma, las empresas pueden evitar la dependencia de un proveedor, simplificar las personalizaciones y acelerar sus flujos de trabajo.

Estos ecosistemas ofrecen ahorros cuantificables de tiempo y recursos al reducir los ciclos de desarrollo hasta en un 70%, reducir los tiempos de evaluación en un 40% y acortar los plazos de lanzamiento de los flujos de trabajo impulsados por la IA. A mayor escala, esto significa ganancias financieras sustanciales, ya que permite ahorrar cientos de miles de dólares en costos operativos y, al mismo tiempo, impulsar el crecimiento de los ingresos. Todo esto se logra sin comprometer la seguridad de nivel empresarial ni la gobernanza de los datos. Tratar la IA como una infraestructura central permite a las empresas innovar más rápido, aumentar la productividad y ampliar las soluciones para satisfacer sus necesidades únicas.

Los agentes de IA autónomos actúan como asistentes virtuales que interpretan la intención del usuario, la dividen en tareas gestionables y las ejecutan sin problemas en diversas herramientas y sistemas dentro de una plataforma de IA unificada. Al gestionar las API, las interfaces web y las aplicaciones internas, simplifican los complejos flujos de trabajo, lo que permite a los usuarios automatizar los procesos con comandos sencillos, sin necesidad de conocimientos técnicos avanzados.

La base de su funcionalidad es un motor de orquestación central, que asigna tareas de forma dinámica al agente o modelo de IA más apropiado. Esto garantiza que las tareas se gestionen de manera eficiente, con retrasos mínimos y con las herramientas adecuadas para el trabajo. La capa de orquestación también refuerza la gobernanza al monitorear los resultados, mantener el contexto y evitar complicaciones innecesarias, manteniendo los flujos de trabajo confiables y escalables.

Estos agentes van más allá de la automatización de tareas repetitivas; también abordan procesos complejos de toma de decisiones. Esto permite a las organizaciones ahorrar tiempo, minimizar los errores y aumentar la productividad. Al integrar soluciones impulsadas por la IA a gran escala, las empresas pueden liberar a los empleados para que puedan centrarse en un trabajo estratégico y de alto impacto.

La gobernanza y el cumplimiento son esenciales para mantener las plataformas de IA unificadas seguras, éticas y alineadas con las regulaciones del sector. Al integrar políticas para la gestión de datos, la supervisión de modelos y los registros de auditoría automatizados, estas plataformas pueden garantizar la transparencia y la responsabilidad en las decisiones impulsadas por la IA, al tiempo que cumplen con estándares como el RGPD, la HIPAA o la normativa financiera.

Una gobernanza sólida sirve como una barrera protectora contra desafíos como los sesgos no deseados, las vulnerabilidades de seguridad y las infracciones normativas. Funciones como el acceso basado en roles, el seguimiento del linaje de datos y la supervisión de modelos permiten a las organizaciones mantener el control sobre sus flujos de trabajo de inteligencia artificial. Estas herramientas no solo protegen los datos confidenciales, sino que también generan confianza, simplifican la adopción de la plataforma y garantizan un rendimiento constante y fiable.