Les écosystèmes d'IA transforment les opérations commerciales en unifiant les outils, les modèles et les flux de travail au sein de plateformes centralisées. En 2026, les entreprises utilisant ces systèmes signalent une 64 % d'augmentation de la productivité et Hausse de 81 % de la satisfaction au travail, tout en réduisant les coûts et en améliorant la gouvernance. Avec plus de 11 000 modèles d'IA disponibles, des plateformes comme Microsoft Foundry, Google Vertex AI, et Plateforme de données Oracle AI dominent le marché en permettant une intégration fluide, une conformité automatisée et des flux de travail évolutifs.

Les écosystèmes d'IA unifiés éliminent les inefficacités, améliorent la sécurité et fournissent des résultats mesurables. Qu'il s'agisse d'automatiser les flux de travail ou de gérer les coûts, ces plateformes redéfinissent la façon dont les entreprises déploient l'IA à grande échelle. Le moment est venu de simplifier votre stratégie d'IA et d'exploiter tout son potentiel.

Les écosystèmes d'IA unifiés réunissent l'accès aux modèles, la gouvernance et l'automatisation au sein d'un système centralisé, éliminant ainsi l'inefficacité des outils déconnectés. Cette approche unifiée permet une intégration fluide et une supervision renforcée.

Ces écosystèmes donnent accès à des milliers de modèles d'IA et à des intégrations prédéfinies via des frameworks standardisés. Par exemple, le Service d'agent Azure AI propose plus de 1 400 connecteurs via Applications Azure Logic, permettant l'intégration avec des outils tels que Jira, SÈVE, et ServiceNow. Ceci est alimenté par Protocole de contexte du modèle (MCP), qui garantit une connectivité fluide.

L'orchestration multi-agents va encore plus loin dans l'intégration, en permettant aux agents de fonctionner en tant que superviseurs, routeurs ou planificateurs. Les plateformes prennent en charge à la fois le développement visuel et le développement basé sur le code, ce qui rend le déploiement plus rapide et plus efficace. En utilisant des modèles sémantiques ou des ontologies, ces systèmes peuvent interpréter et gérer efficacement des opérations complexes.

Les plateformes unifiées sont équipées d'outils de gouvernance qui automatisent les processus de conformité et appliquent les politiques de sécurité dans toutes les interactions avec l'IA. Les tableaux de bord centralisés fournissent des informations en temps réel sur l'activité des agents, le suivi des sessions et les mesures de performance. Le contrôle d'accès basé sur les rôles (RBAC) s'intègre parfaitement aux frameworks d'identité tels que Identifiant Microsoft Entra, SAML et Active Directory, garantissant une gestion cohérente des autorisations.

Les mesures de sécurité, telles que les filtres de contenu pour détecter les sorties nuisibles et les défenses contre les attaques par injection croisée (XPIA), renforcent la sécurité des opérations. Ethan Sena, directeur exécutif de l'IA et de l'ingénierie du cloud chez Bristol Myers Squibb, a souligné les avantages de ces fonctionnalités :

« Azure AI Agent Service nous fournit un ensemble robuste d'outils qui accélèrent notre transition vers l'IA générative à l'échelle de l'entreprise... En tirant parti de ce service, nous sommes en mesure de réduire notre temps d'ingénierie au détriment du développement personnalisé et de soutenir les facteurs de différenciation qui comptent pour nous. »

Les organisations peuvent également adopter le « Bring Your Own Storage » (BYOS) et les réseaux privés virtuels (VNET) pour assurer la sécurité du trafic de données et le rendre conforme aux normes réglementaires. Cette combinaison de gouvernance et d'intégration garantit des opérations fluides et sécurisées.

L'orchestration automatise l'ensemble du cycle de vie de l'IA, du déploiement des modèles aux pipelines de données et aux modèles de flux de travail. Les cadres standardisés, tels que les graphes acycliques dirigés (DAG), permettent de créer des flux de travail reproductibles, de réduire les efforts manuels et de garantir la cohérence.

Les plateformes allouent dynamiquement les ressources de calcul, souvent en utilisant Kubernetes, pour s'adapter à l'évolution des demandes en temps réel. L'orchestration HITL (Human-in-the-Loop) introduit des points de contrôle où une supervision humaine est requise pour les processus sensibles. Ces gains d'efficacité se traduisent directement par de meilleurs résultats commerciaux.

Par exemple, Marcus Saito, responsable de l'informatique et de l'automatisation de l'IA chez Remote.com, a mis en place un service d'assistance basé sur l'IA qui résout 28 % des tickets pour 1 700 employés dans le monde entier. De même, Okta réduisez les temps d'escalade du support de 10 minutes à quelques secondes en automatisant 13 % des remontées de dossiers.

Ritika Gunnar, IBM, directeur général des données et de l'IA, a résumé l'importance de ces fonctionnalités :

« L'orchestration, l'intégration et l'automatisation sont les armes secrètes qui permettront aux agents de passer de la phase de nouveauté à celle de fonctionnement. »

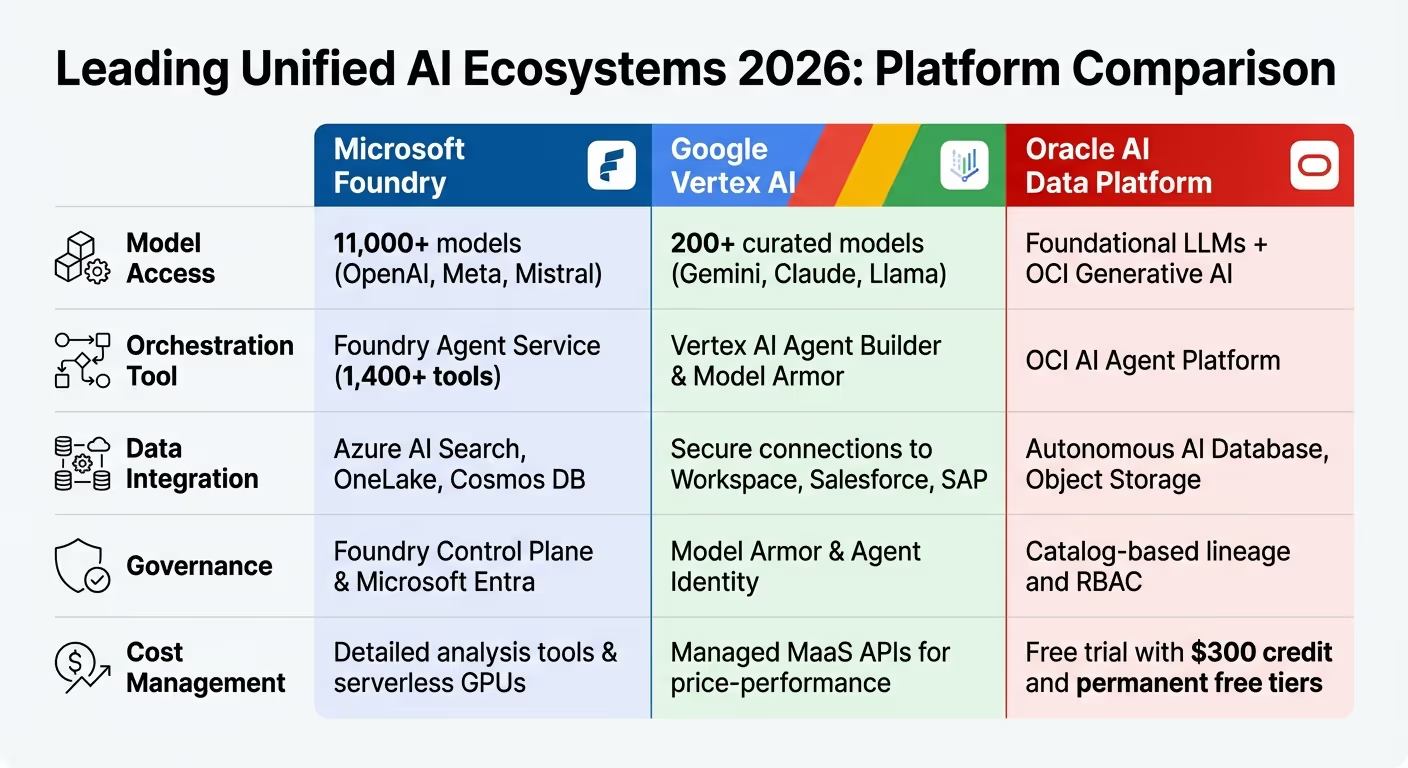

Principales plateformes d'IA unifiée 2026 : Microsoft Foundry contre Google Vertex AI contre Oracle AI

D'ici 2026, le paysage de l'IA a radicalement changé, les plateformes évoluant bien au-delà des systèmes de chatbot de base. Microsoft Foundry, Google Vertex AI, et Plateforme de données Oracle AI dominent désormais la scène, pilotant des agents autonomes capables de planifier, d'exécuter et de collaborer au sein des flux de travail de l'entreprise. Ces plateformes proposent des contrats d'API unifiés, permettant aux développeurs de passer facilement d'un fournisseur à un autre, comme IA ouverte, Llama et Mistral sans nécessiter de réécritures de code. En mettant l'accent sur la base des données et la gouvernance, ils abordent les problèmes de fragmentation abordés précédemment.

La couche « Gold Medallion » d'Oracle garantit que les agents IA n'ont accès qu'à des données d'entreprise gérées de haute qualité afin de minimiser les erreurs telles que les hallucinations. Le Vertex AI Model Garden de Google propose une sélection de plus de 200 modèles prêts à l'emploi pour les entreprises, tandis que Microsoft Foundry se connecte à un impressionnant catalogue de plus de 1 400 outils. Les tableaux de bord centralisés, tels que les tableaux de bord « Operate », fournissent désormais aux entreprises une vue complète de leurs opérations d'IA, en suivant l'état de santé, les performances et la sécurité des agents sur des milliers de déploiements. Cette base solide se reflète dans la façon dont ces plateformes se comparent dans des domaines clés.

Voici un aperçu de la situation de ces principales plateformes en termes d'accès aux modèles, d'outils d'orchestration, de gouvernance et de gestion des coûts :

Microsoft Foundry permet aux utilisateurs d'explorer sa plateforme gratuitement, la tarification étant appliquée uniquement au moment du déploiement en fonction des modèles consommés et de l'utilisation de l'API. Google Vertex AI utilise une formation sans serveur, facturant aux utilisateurs les ressources de calcul lors de tâches personnalisées. Entre-temps, Cloud Oracle propose un crédit de 300$ pour un essai de 30 jours et des niveaux gratuits permanents pour des services tels que OCI Speech et Vision.

Ces plateformes ont déjà produit des résultats transformateurs dans tous les secteurs, démontrant leur potentiel de rationalisation des opérations et d'augmentation du retour sur investissement.

« Le fait de disposer de notre infrastructure et de notre base d'IA sur Microsoft constitue un avantage concurrentiel pour Carvana. Cela nous permet de fonctionner rapidement, de nous adapter au marché et d'innover avec moins de complexité. »

« La gouvernance et l'observabilité de Microsoft Foundry fournissent aux entreprises de KPMG ce dont elles ont besoin pour réussir dans un secteur réglementé. »

Ces exemples illustrent comment les écosystèmes d'IA unifiés peuvent améliorer l'efficacité, réduire les coûts et générer des rendements mesurables, ce qui les rend indispensables pour les entreprises qui souhaitent évoluer de manière sécurisée et efficace.

Les plateformes unifiées ne se limitent pas à l'orchestration des modèles : elles ont besoin d'une infrastructure de données solide pour permettre une automatisation intelligente. Une orchestration réussie de l'IA repose sur des systèmes fiables qui fournissent des informations précises et opportunes. D'ici 2026, de nombreuses organisations auront dépassé les lacs de données de base en adoptant architectures de médaillons et Architectures lacustres pour transformer les données brutes en actifs fiables et prêts à être utilisés pour les requêtes. La couche médaillée d'or d'Oracle garantit que les agents IA n'accèdent qu'à des données vérifiées de haute qualité. De même, Stockage d'objets OCI gère les énormes volumes de données non structurées requis par les pipelines d'IA. Ensemble, ces avancées fournissent une base fluide pour l'orchestration native de l'IA dans tous les écosystèmes.

L'évolution des flux de travail rigides et basés sur des règles vers Orchestration native à l'IA a redéfini la façon dont les flux de données sont gérés. Au lieu de s'appuyer sur des règles statiques, les plateformes modernes utilisent désormais architectures pilotées par les événements, où des événements commerciaux spécifiques, tels que le téléchargement d'un document ou la réalisation d'une transaction, déclenchent automatiquement des agents ou des flux de travail IA selon les besoins. Cette approche réactive élimine les goulots d'étranglement et permet aux différentes parties du système d'évoluer indépendamment. AWS Prescriptive Guidance reflète cette évolution :

« L'orchestration n'est plus seulement une question de règles, mais d'interprétation des intentions, de sélection d'outils et d'exécution autonome. »

Les modèles sémantiques jouent un rôle essentiel dans le maintien de l'alignement des agents d'IA dans tous les services en constituant une source unique de vérité. Ces modèles définissent avec précision des termes spécifiques à l'entreprise, tels que « client d'entreprise » ou « objectifs du troisième trimestre », garantissant une interprétation cohérente des données dans l'ensemble de l'organisation. Databricks souligne l'importance de cette fondation :

« Une couche sémantique unifiée fournit des définitions métier cohérentes pour tous les outils et tous les utilisateurs. Cette base sémantique confère à l'IA une connaissance approfondie des données d'entreprise et des concepts commerciaux propres à chaque organisation. »

La diffusion d'événements s'appuie sur cette cohérence en permettant réactivité en temps réel. Au lieu de se fier à des sondages dans les bases de données ou à des tâches par lots, les agents IA surveillent les flux d'événements et réagissent immédiatement lorsque certains seuils sont atteints, qu'il s'agisse d'ajuster les prix en fonction des niveaux de stock ou de déclencher des alertes de réapprovisionnement. Cette approche axée sur les événements dissocie également la logique de l'IA des systèmes backend à l'aide de couches barrières telles que le Model Context Protocol (MCP). Cette séparation permet aux développeurs de mettre à jour les bases de données ou les API sans perturber les flux de travail d'orchestration.

Les graphes de connaissances et les cadres d'identité partagés améliorent encore la gouvernance des données à l'échelle de l'entreprise en garantissant une interprétation sémantique cohérente. Les graphes de connaissances ne se contentent pas de stocker des données ; ils représentent décisions et relations au sein d'une organisation, en intégrant la logique, les données et les actions dans une couche sémantique interprétable à la fois par les humains et par l'IA. Palantird'Ontology illustre ce concept :

« L'ontologie est conçue pour représenter les décisions prises dans une entreprise, et pas simplement les données. »

Ces graphiques fonctionnent comme bus opérationnel, à l'aide de kits de développement logiciel (SDK) pour connecter les systèmes de l'entreprise. Ils permettent une synchronisation bidirectionnelle entre les outils de modélisation et les catalogues de données, garantissant ainsi que les mises à jour d'un système sont répercutées sur tous les outils et agents connectés.

Cadres d'identité partagés compléter ces systèmes en maintenant des autorisations cohérentes au fur et à mesure que les données se déplacent entre les outils. Des plateformes comme Centre d'identité AWS IAM fournissent une gestion dynamique des accès, en s'intégrant aux systèmes SAML et Active Directory existants pour appliquer des autorisations basées sur les rôles, les classifications ou les objectifs. Cette approche centralisée garantit que les agents d'IA opèrent dans des limites de sécurité et de conformité strictes, même lorsque les flux de travail couvrent plusieurs modèles et sources de données.

Alors que les charges de travail liées à l'IA continuent d'augmenter en 2026, la gestion des coûts est devenue tout aussi importante que l'optimisation des performances. Les écosystèmes unifiés ont adopté FinOps piloté par des agents, où les agents d'IA surveillent des milliards de signaux de coûts en temps réel. Ces agents identifient les problèmes d'efficacité tels que les ressources GPU inactives, les clusters surprovisionnés ou les sorties de données inutiles, et lancent automatiquement des flux de travail correctifs dans les limites de politiques prédéfinies. Selon une étude menée par IBM, les entreprises qui adoptent des agents FinOps basés sur l'IA ont enregistré des réductions des coûts liés au cloud de 20 à 40 %. Par exemple, une institution financière mondiale a réduit le temps d'inactivité du GPU d'environ 35 % grâce à un redimensionnement et à une planification automatisés des ressources.

Cette évolution est alimentée par des outils qui combinent requêtes en langage naturel avec un suivi précis des ressources. Des plateformes comme Développeur Amazon Q, Copilote Azure, et Gemini Cloud Assist permettre aux équipes d'explorer les inducteurs de coûts de manière conversationnelle. Ces outils fournissent des informations détaillées sur l'utilisation du GPU, les périodes d'inactivité et la consommation basée sur les jetons, couvrant à la fois les modèles propriétaires et les fournisseurs tiers tels qu'OpenAI, Anthropique, et Cohère. Karan Sachdeva, responsable du développement commercial mondial chez IBM, explique :

« Le FinOps traditionnel a été conçu pour les tableaux de bord et les décisions prises par des humains... Les agents d'IA vont au-delà de la simple production de rapports. Ils observent, analysent et agissent. »

Ce niveau de suivi des ressources permet aux organisations de contrôler les coûts en temps réel.

Les plateformes centralisées consolident les données de facturation dans un système unique, éliminant ainsi les inefficacités liées à la fragmentation des rapports de coûts. Ces plateformes fournissent des informations immédiates sur les modèles, les équipes ou les projets qui génèrent des dépenses. Avec simulation des coûts basée sur des jetons, les équipes peuvent estimer l'impact financier du passage du GPT-3.5 au GPT-4 ou de l'augmentation de l'utilisation de pourcentages spécifiques avant d'engager des ressources. Par exemple, BP utilisé Gestion des coûts Microsoft pour réduire les coûts du cloud de 40 %, alors même que leur utilisation globale a presque doublé, selon John Maio, architecte en chef de la plateforme Microsoft de BP.

Ces plateformes surveillent également les modèles personnalisés, qui entraînent des frais d'hébergement horaires, même lorsqu'ils sont inactifs. Les déploiements inactifs depuis plus de 15 jours sont automatiquement signalés. Pour des charges de travail prévisibles, de nombreuses entreprises abandonnent la tarification à l'utilisation au profit de niveaux d'engagement, garantissant des frais fixes qui peuvent réduire les coûts jusqu'à 72 % pour les instances réservées et 90 % pour les instances ponctuelles. L'obtention de cette précision repose souvent sur marquage clé-valeur à travers les ressources, telles que l'étiquetage des environnements avec des balises telles que Environnement="Production », permettant des requêtes de coûts plus rapides et plus précises lors de l'utilisation d'assistants intelligents.

Cependant, le suivi des coûts n'est qu'une partie de l'équation : il est essentiel de relier les dépenses à des résultats commerciaux mesurables.

La visibilité des coûts ne suffit pas à elle seule à mesurer le succès. Les principales plateformes utilisent la modélisation du coût total de possession (TCO) pour répartir les dépenses liées à l'IA en six catégories : service de modèles (inférence), formation et ajustement, hébergement cloud, stockage des données, configuration des applications et support opérationnel. Ce niveau de détail permet aux comités de révision de l'architecture d'évaluer les projets en fonction des coûts, des performances, de la gouvernance et des risques. Les systèmes à ressources élevées, tels que les modèles de raisonnement et les agents, ne sont déployés que lorsqu'ils apportent une valeur mesurable.

Les organisations sophistiquées adoptent également triage et routage intelligents stratégies. Les requêtes de routine sont dirigées vers des modèles de langage de petite taille (SML), tandis que seules les tâches complexes sont redirigées vers des modèles frontières plus coûteux. Cette approche permet de réduire les appels vers les grands modèles de 40 % sans compromettre la qualité. Le traitement d'un million de conversations par le biais d'un SLM coûte entre 150 et 800 dollars, contre 15 000 à 75 000 dollars pour les LLM traditionnels, soit une réduction des coûts pouvant atteindre 100 fois. Dr Jerry A. Smith, responsable des laboratoires d'IA et de systèmes intelligents chez Mode Create, reflète parfaitement ce changement :

« Le passage aux SLM n'est pas motivé par l'idéologie ou l'élégance technique. Il est piloté par la feuille de calcul du directeur financier. »

Cette orientation financière influence également les décisions en matière d'infrastructure. Les organisations déploient des charges de travail sur un architecture hybride à trois niveaux: cloud public pour la flexibilité et l'expérimentation, systèmes sur site pour une inférence prévisible à haut volume (rentable lorsque les dépenses liées au cloud dépassent 60 à 70 % par rapport aux systèmes sur site équivalents) et informatique de pointe pour les tâches nécessitant des temps de réponse inférieurs à 10 ms. L'alignement de l'infrastructure sur les principaux résultats, tels que la satisfaction des clients, le chiffre d'affaires par transaction ou les délais de commercialisation, garantit que les investissements dans l'IA permettent non seulement de réduire les coûts, mais également d'obtenir des résultats significatifs.

L'avenir des écosystèmes d'IA unifiés franchit une étape audacieuse avec agents autonomes. Il ne s'agit pas simplement d'outils qui suivent des instructions, ils sont conçus pour comprendre le contexte, évaluer les objectifs et prendre des mesures délibérées sur des systèmes backend complexes. Cette évolution fait évoluer le rôle de l'IA, qui passe de simples tâches conversationnelles à l'exécution de processus complexes en plusieurs étapes qui nécessitaient autrefois une intervention humaine. Fin 2025, 35 % des organisations tiraient déjà parti de l'IA agentique, et 44 % se préparaient à le déployer. L'impact financier en dit long : les entreprises basées sur l'IA génèrent 25 à 35 fois plus de revenus par employé que leurs homologues traditionnelles. Cette transformation ouvre la voie à une intégration plus poussée, alors que nous examinons le rôle des agents autonomes au sein de ces écosystèmes.

S'appuyant sur les discussions précédentes sur l'orchestration unifiée, agents autonomes sont désormais au cœur de la prise de décisions en temps réel. Agissant comme un « système nerveux » pour les écosystèmes, ces agents connectent de manière fluide les outils, la mémoire et les données pour permettre des actions immédiates et éclairées. Par exemple, en décembre 2025, une entreprise mondiale de biens de consommation a repensé ses processus d'innovation en déployant des méta-agents pour superviser les agents des travailleurs, réduisant ainsi les temps de cycle de 60 %. Kate Blair, directrice de l'incubation et des expériences technologiques chez IBM Research, a souligné l'importance de ce changement :

« C'est en 2026 que ces modèles vont sortir du laboratoire et entrer dans la vraie vie. »

Les organisations adoptent autonomie graduée via un « protocole de confiance » à quatre niveaux. Ces niveaux incluent le mode Shadow (l'agent fait des suggestions), l'autonomie supervisée (approbation humaine requise), l'autonomie guidée (supervision humaine) et l'autonomie totale (aucune implication humaine). En janvier 2026, Lockheed Martin a consolidé 46 systèmes de données distincts en une seule plateforme intégrée, réduisant de moitié ses outils de données et d'IA. Cette nouvelle base alimente désormais une « usine d'IA », dans laquelle 10 000 ingénieurs utilisent des cadres agentiques pour gérer des flux de travail sophistiqués. Les résultats sont frappants : les agents autonomes peuvent accélérer les processus métier de 30 % à 50 % et réduire de 25 % à 40 % les tâches à faible valeur ajoutée pour les employés. Pour exploiter tout le potentiel de ces agents, le développement de standards ouverts devient une priorité.

L'un des principaux défis consiste à faire en sorte que les agents de différents fournisseurs puissent travailler ensemble de manière fluide, ce qui a conduit à la création de protocoles ouverts. Le Protocole de contexte modèle (MCP), initialement introduit par Anthropic et désormais régi par le Fondation Linux, permet aux agents d'IA de s'intégrer à des outils et à des sources de données externes. De même, Google Cloud Agent 2 Agent (A2A) Le protocole utilise HTTP et JSON-RPC 2.0 pour permettre une communication directe entre des agents indépendants sur toutes les plateformes. Oracle a également contribué avec son Spécification de l'agent ouvert (spécification de l'agent), un cadre déclaratif qui garantit la portabilité des agents et des flux de travail sur différents systèmes. Sungpack Hong, vice-président de la recherche sur l'IA chez Oracle, explique :

« Agent Spec est une spécification déclarative indépendante du framework conçue pour rendre les agents et les flux de travail d'IA portables, réutilisables et exécutables sur n'importe quel framework compatible. »

Ces protocoles sont en cours d'unification au sein d'organes directeurs neutres afin d'éviter toute dépendance vis-à-vis des fournisseurs. 93 % des dirigeants pensent qu'il sera essentiel de prendre en compte la souveraineté de l'IA dans leurs stratégies d'ici 2026. Pourtant, moins de 33 % des organisations ont mis en œuvre l'interopérabilité et l'évolutivité nécessaires au développement de l'IA agentique. L'émergence de Systèmes d'exploitation agentiques (AOS) - des environnements d'exécution standardisés qui supervisent l'orchestration, la sécurité, la conformité et la gestion des ressources pour les essaims d'agents - marque une étape importante vers la mise en production de systèmes autonomes. Alors que 96 % des organisations prévoient de déployer des agents pour optimiser les systèmes et automatiser les processus de base, la course à l'établissement de normes universelles s'intensifie.

Pour les entreprises qui souhaitent faire évoluer l'IA sans succomber à une complexité écrasante, les écosystèmes d'IA unifiés constituent une solution puissante. Ces plateformes démantèlent les silos qui ont longtemps entravé les initiatives d'IA, permettant une collaboration fluide entre les départements et les fonctions. L'évolution des chatbots basiques vers des agents proactifs capables d'orchestrer des flux de travail en plusieurs étapes donne des résultats tangibles. Comme indiqué précédemment, ces flux de travail orchestrés améliorent l'efficacité, réduisent les tâches à faible valeur de 25 % à 40 % et accélèrent les processus métier de 30 % à 50 %.

Ce qui change vraiment la donne, c'est l'orchestration. En unifiant les modèles, les données et la gouvernance au sein d'un système cohérent, ces plateformes permettent à l'IA d'aller au-delà de la réponse aux requêtes et de commencer à exécuter des processus complexes de bout en bout. Cette approche permet non seulement d'accélérer les opérations, mais également de réduire le recours à de grandes équipes, ouvrant ainsi la voie à une gestion agile des flux de travail dans l'ensemble des organisations.

Un nombre croissant de dirigeants (88 % pour être exact) augmentent leurs budgets d'IA pour exploiter les capacités des agences, alimentant ainsi la demande de normes d'interopérabilité. L'introduction de cadres d'autonomie gradués, allant du mode fantôme à l'autonomie totale, fournit aux organisations une voie structurée pour faire évoluer l'IA de manière responsable et efficace.

D'ici 2026, les grandes entreprises ne se contenteront pas d'automatiser les tâches, elles réimagineront les flux de travail pour qu'ils soient intrinsèquement pilotés par l'IA. Avec 78 % des organisations qui exploitent déjà l'IA dans au moins un domaine d'activité et Gartner selon les prévisions selon lesquelles 60 % des opérations informatiques intégreront des agents d'IA d'ici 2028, le moment est venu d'adopter des écosystèmes d'IA unifiés. Agir tôt garantit un avantage concurrentiel dans un environnement de plus en plus centré sur l'IA.

Le passage d'outils fragmentés à des plateformes unifiées répond à la fois aux besoins opérationnels immédiats et aux innovations futures. Ces écosystèmes redéfinissent les flux de travail, favorisant l'excellence opérationnelle et une transformation évolutive. Pour les entreprises qui souhaitent garder une longueur d'avance, l'adoption de plateformes d'IA unifiées n'est plus une option, mais une nécessité.

Les écosystèmes d'IA unifiés offrent aux entreprises un environnement intégré dans lequel les données, les outils et les applications fonctionnent en harmonie, évitant ainsi de jongler avec des systèmes déconnectés. En apportant grands modèles de langage et d'autres outils d'IA sur une seule plateforme, les entreprises peuvent éviter de se retrouver dans une dépendance vis-à-vis des fournisseurs, simplifier les personnalisations et accélérer leurs flux de travail.

Ces écosystèmes permettent de réaliser des économies de temps et de ressources mesurables en réduisant les cycles de développement jusqu'à 70 %, en réduisant les temps d'évaluation de 40 % et en raccourcissant les délais de lancement des flux de travail pilotés par l'IA. À plus grande échelle, cela se traduit par des gains financiers substantiels, permettant d'économiser des centaines de milliers de dollars en coûts opérationnels tout en stimulant la croissance des revenus. Tout cela est réalisé sans compromettre la sécurité ou la gouvernance des données de niveau entreprise. Considérer l'IA comme une infrastructure de base permet aux entreprises d'innover plus rapidement, d'augmenter leur productivité et de faire évoluer leurs solutions pour répondre à leurs besoins uniques.

Les agents d'IA autonomes agissent comme des assistants virtuels qui interprètent les intentions des utilisateurs, les décomposent en tâches gérables et les exécutent de manière fluide sur divers outils et systèmes au sein d'une plateforme d'IA unifiée. En gérant les API, les interfaces Web et les applications internes, ils simplifient les flux de travail complexes, permettant aux utilisateurs d'automatiser les processus à l'aide de commandes simples, sans compétences techniques avancées.

Au cœur de leurs fonctionnalités se trouve un moteur d'orchestration central, qui attribue dynamiquement les tâches à l'agent ou au modèle d'IA le plus approprié. Cela garantit que les tâches sont gérées efficacement, avec un minimum de retards et avec les bons outils pour la tâche. La couche d'orchestration renforce également la gouvernance en surveillant les résultats, en maintenant le contexte et en évitant les complications inutiles, tout en garantissant la fiabilité et l'évolutivité des flux de travail.

Ces agents vont au-delà de l'automatisation de tâches répétitives ; ils s'occupent également de processus décisionnels complexes. Cela permet aux entreprises de gagner du temps, de minimiser les erreurs et d'augmenter leur productivité. En intégrant des solutions pilotées par l'IA à grande échelle, les entreprises peuvent libérer les employés pour qu'ils puissent se concentrer sur des tâches stratégiques à fort impact.

La gouvernance et la conformité sont essentielles pour garantir la sécurité, l'éthique et la conformité des plateformes d'IA unifiées avec les réglementations du secteur. En intégrant des politiques de gestion des données, de supervision des modèles et de pistes d'audit automatisées, ces plateformes peuvent garantir la transparence et la responsabilité des décisions pilotées par l'IA, tout en respectant des normes telles que le RGPD, la HIPAA ou les réglementations financières.

Une gouvernance solide constitue une barrière protectrice contre les défis tels que les biais involontaires, les failles de sécurité et les violations de la réglementation. Des fonctionnalités telles que l'accès basé sur les rôles, le suivi du lignage des données et la surveillance des modèles permettent aux organisations de garder le contrôle de leurs flux de travail d'IA. Ces outils permettent non seulement de protéger les données sensibles, mais aussi de renforcer la confiance, de simplifier l'adoption des plateformes et de garantir des performances constantes et fiables.