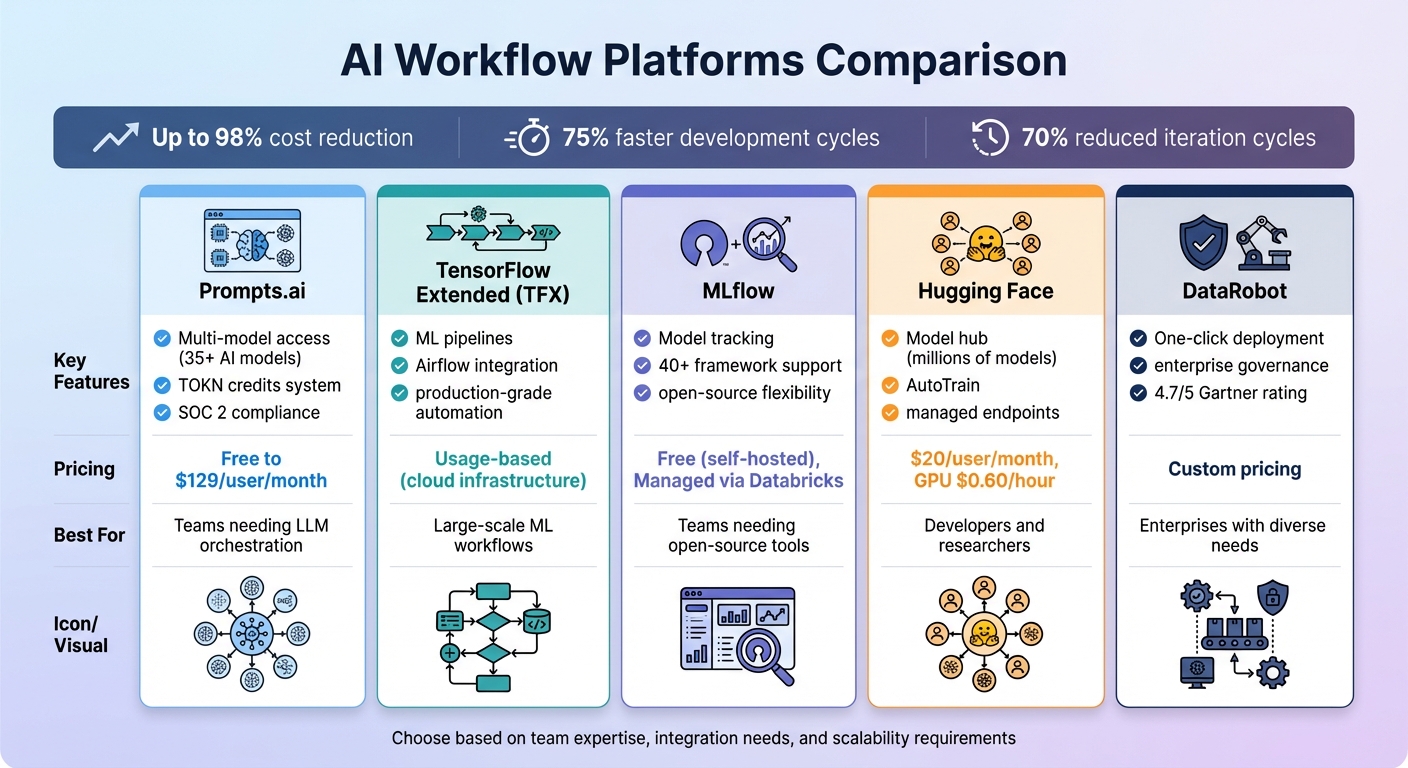

Las empresas se ven abrumadas por las herramientas de IA desconectadas, el aumento de los costos y los riesgos de seguridad. Las plataformas de flujo de trabajo de IA resuelven este problema al unificar las herramientas, automatizar las tareas y optimizar los procesos. Con reducción de costos de hasta un 98% y Ciclos de desarrollo un 75% más rápidos, estas plataformas agilizan las operaciones y, al mismo tiempo, mantienen la seguridad y la flexibilidad. A continuación se muestran cinco plataformas destacadas para gestionar los flujos de trabajo de la IA:

Comparación rápida:

Cada plataforma ofrece puntos fuertes únicos, desde el ahorro de costes hasta la escalabilidad, lo que garantiza una solución personalizada para cualquier desafío de la IA.

Comparación de plataformas de flujo de trabajo de IA: características, precios y mejores casos de uso

Prompts.ai reúne el acceso a más de 35 modelos de IA principales, incluidos GPT, Claude, LLama y Géminis - en una interfaz segura y optimizada. En lugar de tener que hacer malabares con múltiples suscripciones e inicios de sesión, los equipos pueden comparar los resultados de varios modelos lingüísticos de gran tamaño, lo que facilita la identificación del que mejor se adapta a tareas específicas. Esta solución integral elimina la fragmentación que suele provocar el uso de demasiadas herramientas en todos los departamentos, lo que allana el camino para una automatización, escalabilidad y colaboración fluidas.

Con Prompts.ai, los usuarios obtienen acceso a más de 35 modelos de IA sin la molestia de administrar cuentas separadas o integraciones de API. Este sistema unificado permite realizar solicitudes simultáneas, lo que permite a los equipos evaluar la calidad, la velocidad y la relevancia de los distintos modelos en tiempo real. Los planes empresariales van un paso más allá al ofrecer flujos de trabajo interoperables, que permiten a las organizaciones crear procesos escalables y repetibles. Por ejemplo, un modelo puede gestionar las consultas de los clientes, mientras que otro se centra en el análisis de datos, todo ello dentro del mismo ecosistema.

Prompts.ai convierte las tareas de IA manuales y puntuales en flujos de trabajo automatizados que funcionan las 24 horas del día. Estos flujos de trabajo se integran sin esfuerzo con herramientas como Slack, Gmail, y Trello, optimizando la productividad. Por ejemplo, Steven Simmons redujo las semanas de renderizado 3D y redacción de propuestas a un solo día. Del mismo modo, el arquitecto Ar. June Chow utiliza la función de comparación de LLM en paralelo de la plataforma para experimentar con conceptos de diseño creativos y abordar proyectos complejos con facilidad.

Los planes empresariales de la plataforma incluyen espacios de trabajo y opciones de colaboración ilimitados, lo que la hace ideal para equipos grandes. Funciones como TOKN Pooling y Storage Pooling permiten a los equipos compartir recursos de forma eficaz, mientras que la gobernanza centralizada garantiza la total visibilidad y responsabilidad de todas las actividades de IA. Prompts.ai también inició su proceso de auditoría tipo 2 del SOC 2 el 19 de junio de 2025 e integra los marcos de cumplimiento de la HIPAA y el GDPR, abordando las necesidades de seguridad y protección de datos a nivel empresarial. Los equipos pueden implementar nuevos modelos, añadir miembros e iniciar flujos de trabajo en menos de 10 minutos.

El sistema de crédito TOKN de Prompts.ai transforma los gastos fijos mensuales de software en gastos flexibles y basados en el uso, lo que ayuda a los usuarios a optimizar los costos. La plataforma pretende reducir los gastos relacionados con la IA hasta en un 98% al consolidar más de 35 herramientas independientes en una sola. Las opciones de precios van desde el plan Pay As You Go gratuito con créditos limitados hasta el plan Business Elite, de 129$ por miembro y mes, que incluye 1 millón de créditos TOKN y herramientas creativas avanzadas. Frank Buscemi, director ejecutivo y CCO, destaca cómo la plataforma ha simplificado la creación de contenido y ha automatizado los flujos de trabajo estratégicos, lo que ha permitido a su equipo centrarse en proyectos creativos de alto nivel en lugar de en tareas repetitivas.

TensorFlow Extended (TFX) es un plataforma integral diseñada para implementar canalizaciones de aprendizaje automático (ML) de nivel de producción, que abarca todo, desde la validación de datos hasta la entrega de modelos. Si bien se basa principalmente en TensorFlow, TFX admite flujos de trabajo que incluyen otros marcos, como PyTorch, Scikit-learn, y XG Boost mediante la contenedorización. Esta flexibilidad permite a los equipos gestionar proyectos con marcos mixtos sin problemas, especialmente en entornos como Vertex AI. Su estructura integral allana el camino para una automatización simplificada en diversas configuraciones.

TFX simplifica todo el ciclo de vida del aprendizaje automático con su arquitectura adaptable. Automatiza los flujos de trabajo mediante componentes prediseñados como ExampleGen, StatisticsGen, Transform, Trainer, Evaluator y Pusher. Estos componentes se integran con orquestadores como Flujo de aire Apache, Canalizaciones de Kubeflow, y Apache Beam, lo que facilita la integración de TFX en entornos empresariales. Por ejemplo, en octubre de 2023, Spotify utilizaron los agentes TFX y TF para simular los comportamientos de escucha con el fin de reforzar el aprendizaje, mejorando sus sistemas de recomendación musical en función de las interacciones de los usuarios. Del mismo modo, Vodafone adoptó TensorFlow Data Validation (TFDV) en marzo de 2023 para supervisar la gobernanza de los datos en todas sus operaciones de telecomunicaciones globales.

«Cuando los flujos de trabajo se definen como código, son más fáciles de mantener, versionar, comprobar y colaborar». - Google Developers

TFX está diseñado para escalar y utiliza Apache Beam para el procesamiento de datos distribuidos en plataformas como Flujo de datos de Google Cloud, Apache Flink, y Apache Spark. También se integra con herramientas empresariales como Vertex AI Pipelines y Vertex AI Training, lo que permite a los equipos procesar conjuntos de datos masivos y entrenar modelos en varios nodos con aceleración por GPU. El ecosistema Kubeflow, que con frecuencia impulsa las canalizaciones de TFX, ha tenido una adopción significativa, con más de 258 millones de descargas de PyPI y 33 100 estrellas de GitHub. Además, ML Metadata (MLMD) rastrea el linaje de los modelos y los historiales de ejecución de las canalizaciones, registrando automáticamente los artefactos y parámetros para garantizar la transparencia y la trazabilidad. Esta escalabilidad convierte a TFX en una potente herramienta para unificar flujos de trabajo complejos de aprendizaje automático en un sistema eficiente.

TFX ayuda a las organizaciones a gestionar los costes mediante el almacenamiento en caché para evitar volver a ejecutar componentes redundantes, lo que ahorra recursos informáticos durante la formación iterativa. Para equipos que trabajan en Google Cloud, los datos de facturación se pueden exportar a BigQuery, lo que permite un análisis detallado de los costos de los distintos tramos de oleoductos. El diseño modular de la plataforma también proporciona flexibilidad: los equipos pueden usar bibliotecas independientes como TFDV o TFT sin tener que implementar todo el sistema TFX, lo que permite adaptar la plataforma a sus necesidades específicas.

MLFlow es una herramienta versátil de código abierto que conecta más de 40 marcos de IA, incluidos PyTorch, TensorFlow, scikit-learn, IA abierta, Hugging Face y Cadena LANG. Como parte del Fundación Linux, permite a los equipos ejecutar flujos de trabajo de forma local, local o en las principales plataformas de nube. Con más de 20 000 estrellas de GitHub y más de 50 millones de descargas mensuales, MLFlow se ha convertido en una solución ampliamente adoptada para gestionar los flujos de trabajo de la IA. Sus capacidades de integración sin fisuras forman la base de sus funciones avanzadas.

MLFlow 3 simplifica el seguimiento de modelos con su URI de modelo unificado (modelos:/<model_id>), lo que permite la gestión del ciclo de vida en varias etapas. Los desarrolladores pueden usar las API de Python, REST, R y Java para registrar parámetros, métricas y artefactos de casi cualquier entorno. Para los flujos de trabajo de IA generativa (GenAI), MLFlow se integra con más de 30 herramientas, que incluyen Antrópico, Géminis, Bedrock, Índice Llama, y Tripulación AI. Además, sus capacidades de rastreo se alinean con las de OpenTelemetry, lo que garantiza que los datos de observabilidad de la IA se adapten sin problemas a los sistemas de monitoreo empresarial existentes.

MLFlow elimina la complejidad de la gestión del flujo de trabajo con sus funciones de automatización. El mlflow.autolog () function y Model Registry agilizan el registro de métricas y automatizan las transiciones de versiones de la fase de ensayo a la producción. En el caso de las aplicaciones GenAI, MLFlow captura todo el proceso de ejecución (incluidas las solicitudes, las recuperaciones y las llamadas a las herramientas), lo que facilita la depuración automática de los flujos de trabajo.

MLFlow admite la escalabilidad al separar el Backend Store, que usa bases de datos SQL como PostgreSQL o MySQL para los metadatos, del Artifact Store, que administra archivos de gran tamaño a través de servicios como Amazon S3, Azure Blob Storage o Google Cloud Storage. En el caso de los archivos modelo de gran tamaño, las subidas en varias partes dividen los artefactos en fragmentos de 100 MB, sin pasar por el servidor de seguimiento para mejorar la velocidad y la eficiencia de la carga. Los equipos pueden implementar las instancias del servidor de seguimiento en el «modo exclusivo para artefactos» y utilizar consultas similares a las de SQL para localizar rápidamente modelos de alto rendimiento, como precisión métrica > 0.95.

MLFlow está disponible de forma gratuita bajo la licencia Apache-2.0 para despliegues autohospedados. Para quienes buscan una solución gestionada, hay disponible una versión gratuita, con opciones de nivel empresarial ofrecidas a través de Databricks. Gestionar modelos grandes de manera eficiente, lo que permite MLFLOW_ENABLE_PROXY_MULTIPART_UPLOAD permite la carga directa al almacenamiento en la nube, lo que reduce la carga del servidor y los costos de procesamiento. Al combinar la gestión unificada de modelos con la automatización y la infraestructura escalable, MLFlow aborda de forma eficaz los principales desafíos de los flujos de trabajo de IA modernos.

Hugging Face sirve como un centro central para el desarrollo de la IA y ofrece millones de modelos, conjuntos de datos y aplicaciones de demostración (Spaces). Con más de 50 000 organizaciones integradas, incluidas gigantes como Google, Microsoft, Amazon y Meta - la plataforma hace hincapié en un enfoque impulsado por la comunidad para promover la IA. Como se indica en su documentación:

«Ninguna empresa, incluidos los titanes de la tecnología, podrá «resolver la IA» por sí sola; la única forma de lograrlo es compartiendo conocimientos y recursos con un enfoque centrado en la comunidad».

El amplio repositorio de Hugging Face garantiza una compatibilidad perfecta entre una variedad de modelos de IA. Bibliotecas clave como Transformadores y Difusores proporcionan modelos PyTorch de vanguardia, mientras Transformers.js permite la ejecución del modelo directamente en los navegadores web. Con un único token de API de Hugging Face, los usuarios obtienen acceso a más de 45 000 modelos de más de 10 socios de inferencia, incluidos AWS, Azure y Google Cloud, con las tarifas estándar de los proveedores. La plataforma también se integra con bibliotecas especializadas como Asteroid y ESPNet, así como con marcos de LLM ampliamente utilizados, como LangChain, LlamaIndex y CrewAI. Herramientas como Óptimo mejorar el rendimiento del modelo para hardware como AWS Trainium y Google TPU, al mismo tiempo IZQUIERDA (Ajuste preciso con eficiencia de parámetros) y Acelera simplifique la formación en diversas configuraciones de hardware.

Hugging Face agiliza el ajuste del modelo a través de su función AutoTrain, que automatiza el proceso mediante API y una interfaz fácil de usar, lo que elimina la necesidad de una codificación manual exhaustiva. Los webhooks a nivel de repositorio permiten a los usuarios activar acciones externas cuando se actualizan modelos, conjuntos de datos o Spaces. Para el desarrollo de agentes de IA, agentes de humo La biblioteca de Python ayuda a organizar herramientas y gestionar tareas complejas. Los terminales de inferencia totalmente gestionados facilitan la implementación de modelos en la producción, mientras que el marco Hub Jobs automatiza y programa las tareas de aprendizaje automático mediante API o una interfaz visual. En conjunto, estas herramientas de automatización permiten flujos de trabajo escalables y listos para la empresa.

Hugging Face ofrece funciones de nivel empresarial como Inicio de sesión único (SSO), registros de auditoría y grupos de recursos, lo que facilita a los equipos grandes la colaboración y, al mismo tiempo, mantienen el cumplimiento. La plataforma utiliza la tecnología Xet para almacenar y versionar archivos de gran tamaño de forma eficiente en repositorios basados en Git, lo que agiliza la administración de grandes conjuntos de datos y modelos. Los equipos pueden agrupar cuentas, asignar funciones granulares para el control de acceso y centralizar la facturación de los conjuntos de datos, los modelos y los espacios. Además, la plataforma admite conjuntos de datos en más de 8000 idiomas y proporciona terminales de inferencia totalmente gestionados e integrados con los principales proveedores de nube.

El plan de equipo comienza en 20$ por usuario al mes, incluidas funciones como el inicio de sesión único, los registros de auditoría y los grupos de recursos. El uso de la GPU tiene un precio de 0,60 USD por hora, y los proveedores de inferencia cobran a los usuarios directamente según sus tarifas estándar, sin recargos adicionales por parte de Hugging Face. En el caso de las aplicaciones de demostración, ZeroGPU Spaces asigna las GPU NVIDIA H200 de forma dinámica y en tiempo real, lo que elimina la necesidad de un hardware permanente y costoso. Los precios personalizados están disponibles para las empresas que requieren seguridad avanzada, soporte dedicado y controles de acceso mejorados.

DataRobot es una plataforma de IA integral diseñada para gestionar todo, desde la experimentación hasta la implementación en producción. Con una calificación de 4,7/5 en Gartner Peer Insights y una tasa de recomendación de los usuarios del 90%, también ha sido reconocida como líder en el Cuadrante Mágico de Gartner sobre plataformas de ciencia de datos y aprendizaje automático. La plataforma se centra en la integración, la automatización y la escalabilidad, lo que facilita la gestión de las complejidades de los flujos de trabajo de la IA. Tom Thomas, vicepresidente de estrategia de datos, análisis e inteligencia empresarial de FordDirect, comentó:

«Lo que nos parece realmente valioso de DataRobot es el momento de valorar. DataRobot nos ayuda a implementar soluciones de inteligencia artificial en el mercado en la mitad del tiempo que solíamos hacerlo antes».

El registro independiente de modelos de DataRobot proporciona una administración centralizada para los paquetes modelo de cualquier fuente. Es compatible tanto con los modelos de lenguaje grande (LLM) como con los modelos de lenguaje pequeño (SLM) de código abierto y patentados, independientemente del proveedor. Con integraciones nativas para plataformas como Copo de nieve, AWS, Azure y Google Cloud, la plataforma garantiza conexiones perfectas con los sistemas tecnológicos existentes. Su interfaz de usuario NextGen ofrece flexibilidad tanto para el desarrollo como para la gobernanza, y permite a los usuarios alternar entre una interfaz gráfica y herramientas programáticas como la API REST o los paquetes de clientes de Python. Esta integración perfecta sienta las bases para la automatización avanzada en los flujos de trabajo futuros.

DataRobot simplifica el proceso desde el desarrollo hasta la producción con un solo clic, la creación de puntos finales de API y la configuración automática de la supervisión. Su orquestación informática dinámica elimina la molestia de administrar manualmente los servidores: los usuarios especifican sus necesidades informáticas y el sistema se encarga del aprovisionamiento y la distribución de la carga de trabajo. Ben DuBois, director de análisis de datos de Norfolk Iron & Metal, hizo hincapié en sus beneficios:

«Lo principal que DataRobot aporta a mi equipo es la capacidad de iterar rápidamente. Podemos probar cosas nuevas y ponerlas en producción rápidamente. Esa flexibilidad es clave, especialmente cuando se trabaja con sistemas antiguos».

La plataforma también genera documentación de cumplimiento automáticamente, abordando los estándares regulatorios y de gobierno modelo. Los contenedores de «casos de uso» ayudan a mantener los proyectos organizados y listos para ser auditados, garantizando que los flujos de trabajo permanezcan estructurados en todos los entornos empresariales.

DataRobot facilita la administración de una amplia gama de modelos, desde docenas hasta cientos, a través de un sistema centralizado. Soporta la implementación en infraestructuras gestionadas de SaaS, VPC o locales. Por ejemplo, una empresa energética global logró un ROI de 200 millones de dólares en más de 600 casos de uso de IA, mientras que uno de los cinco principales bancos del mundo obtuvo un ROI de 70 millones de dólares gracias a más de 40 aplicaciones de IA en toda la organización. Thibaut Joncquez, director de ciencia de datos de Turó, destacó las capacidades de estandarización de la plataforma:

«No hay nada más integrado, fácil de usar, estandarizado y todo en uno como DataRobot. DataRobot nos proporcionó un marco estructurado para garantizar que todos tengan el mismo estándar».

La plataforma reúne a diversos equipos (científicos de datos, desarrolladores, TI e InfoSec) al ofrecer herramientas visuales e interfaces programáticas. Sus «aceleradores de IA» prediseñados aceleran la transición de la experimentación a la producción. Al unificar los flujos de trabajo, automatizar los procesos complejos y escalar sin esfuerzo, DataRobot ayuda a las organizaciones a lograr capacidades de inteligencia artificial de nivel empresarial con facilidad.

Las plataformas de flujo de trabajo de IA están cambiando la forma en que las organizaciones pasan de experimentos aislados a sistemas totalmente operativos. Al adoptar la plataforma adecuada, las empresas pueden acelerar considerablemente los ciclos de desarrollo; algunas afirman que reducen el tiempo necesario para crear flujos de trabajo basados en agencias 75% y reduciendo los ciclos de iteración en 70% con plataformas de IA dedicadas. Estas eficiencias conducen a lanzamientos más rápidos y a una mejor rentabilidad de la inversión.

La clave de estos avances radica en tres ventajas principales: interoperabilidad, automatización, y escalabilidad. Las plataformas que se integran con varios modelos y tecnologías existentes evitan la dependencia de los proveedores y los costos impredecibles. Las capas de orquestación garantizan la confiabilidad del sistema y optimizan los procesos de recuperación, lo que permite a los equipos centrarse en sus objetivos principales. Para los equipos interdepartamentales, las herramientas, como los espacios de trabajo compartidos y los generadores visuales, ayudan a cerrar la brecha entre los usuarios técnicos y los no técnicos, mientras que las funciones de gobierno, como los registros de auditoría y los controles de acceso basados en roles, garantizan que los flujos de trabajo permanezcan seguros y cumplan con las normas.

Elegir la plataforma adecuada es fundamental para aprovechar estos beneficios. Opte por soluciones que se ajusten a la experiencia de su equipo, que ofrezcan interfaces sin código para usuarios sin conocimientos técnicos y opciones basadas en API para desarrolladores. Busque plataformas con funciones de observabilidad sólidas, como el seguimiento a nivel de nodo, las métricas de costos y los registros con capacidad de búsqueda, para identificar y resolver rápidamente los problemas de producción. Las organizaciones que aprovechan las asociaciones externas o las herramientas especializadas de IA de bajo código han visto duplicar las tasas de éxito en la transición de los proyectos piloto a los de producción, en lugar de los que dependen únicamente de los recursos internos.

Las cifras hablan por sí solas: las empresas que utilizan la automatización de la IA informan hasta un 35% más de productividad y Ahorro de costes del 25 al 50%. Como explica Andrés García, director de tecnología:

«Para mí, como CTO, invertir en una automatización comprobada permite a los equipos innovar. No quiero que mi equipo establezca conexiones, supervise o registre cuando ya existe una infraestructura».

Comience con tareas repetitivas de gran volumen, como el enriquecimiento de datos, para lograr ganancias rápidas. Asegúrese de que la plataforma se integre a la perfección con sus sistemas SaaS y heredados existentes, como 46% de los equipos de productos citan la mala integración como el principal obstáculo para la adopción de la IA. Una plataforma que simplifica la complejidad en lugar de aumentarla garantiza que su equipo pueda centrarse en impulsar la innovación y ofrecer resultados empresariales significativos.

Las plataformas de flujo de trabajo de IA ofrecen una forma inteligente de reducir los gastos al reunir herramientas, modelos y canalizaciones de datos en un sistema unificado de pago por uso. En lugar de tener que hacer malabares con varias licencias para distintos modelos de IA, los usuarios acceden a más de 35 modelos a través de una única plataforma y solo pagan por la potencia informática que realmente utilizan. Este enfoque elimina el desperdicio de recursos y garantiza que ninguna capacidad permanezca inactiva.

Con herramientas de control y seguimiento de costos en tiempo real, los usuarios obtienen total transparencia en sus gastos. Junto con la automatización integrada, estas funciones minimizan las tareas manuales y ayudan a evitar costos innecesarios en la nube. En conjunto, estas eficiencias pueden generar ahorros de costos de hasta 98% en comparación con las ineficiencias de administrar configuraciones fragmentadas de múltiples proveedores.

Prompts.ai está diseñado para simplificar la forma en que los equipos gestionan y coordinan varios modelos lingüísticos de gran tamaño (LLM) en un entorno único y seguro. Con acceso a más de 35 modelos de primer nivel, que incluyen GPT-5, Claudio, y Grok-4, los usuarios pueden cambiar fácilmente de un modelo a otro o usarlos simultáneamente, sin la molestia de administrar cuentas o API independientes.

La plataforma incluye seguimiento de costos en tiempo real y un sistema de crédito flexible de pago por uso, que facilita a los equipos mantener los gastos bajo control y, al mismo tiempo, reducir los costos relacionados con la IA. La seguridad de nivel empresarial garantiza que los datos permanezcan protegidos, mientras que las herramientas de automatización integradas eliminan la complejidad del diseño, las pruebas y la implementación de los flujos de trabajo de LLM. Prompts.ai ofrece una forma eficiente y simplificada para que las organizaciones aumenten la productividad y fomenten la colaboración en sus iniciativas de inteligencia artificial.

Las plataformas de flujo de trabajo de IA ponen un gran énfasis en seguridad y conformidad, que incorpora funciones como el control de acceso basado en funciones (RBAC), registros de auditoría detallados y medidas de protección de la privacidad de los datos. Estas capacidades permiten a las organizaciones rastrear quién interactúa con los modelos, cuándo lo hace y qué datos están involucrados, lo que garantiza la responsabilidad en cada paso.

Para proteger la información confidencial, estas plataformas suelen emplear cifrado - tanto para los datos en reposo como durante el tránsito, junto con entornos aislados y medidas automatizadas de limpieza de datos. También se adhieren a políticas organizativas estrictas para regular las conexiones con proveedores externos, lo que minimiza el riesgo de que se compartan datos sin autorización. Las barreras basadas en políticas y los registros a prueba de manipulaciones mejoran aún más el cumplimiento de la normativa y, al mismo tiempo, promueven la transparencia operativa.

En conjunto, estas medidas crean un marco seguro y confiable que permite a las organizaciones escalar sus flujos de trabajo de IA con confianza y, al mismo tiempo, cumplir con los estándares de privacidad y cumplimiento.