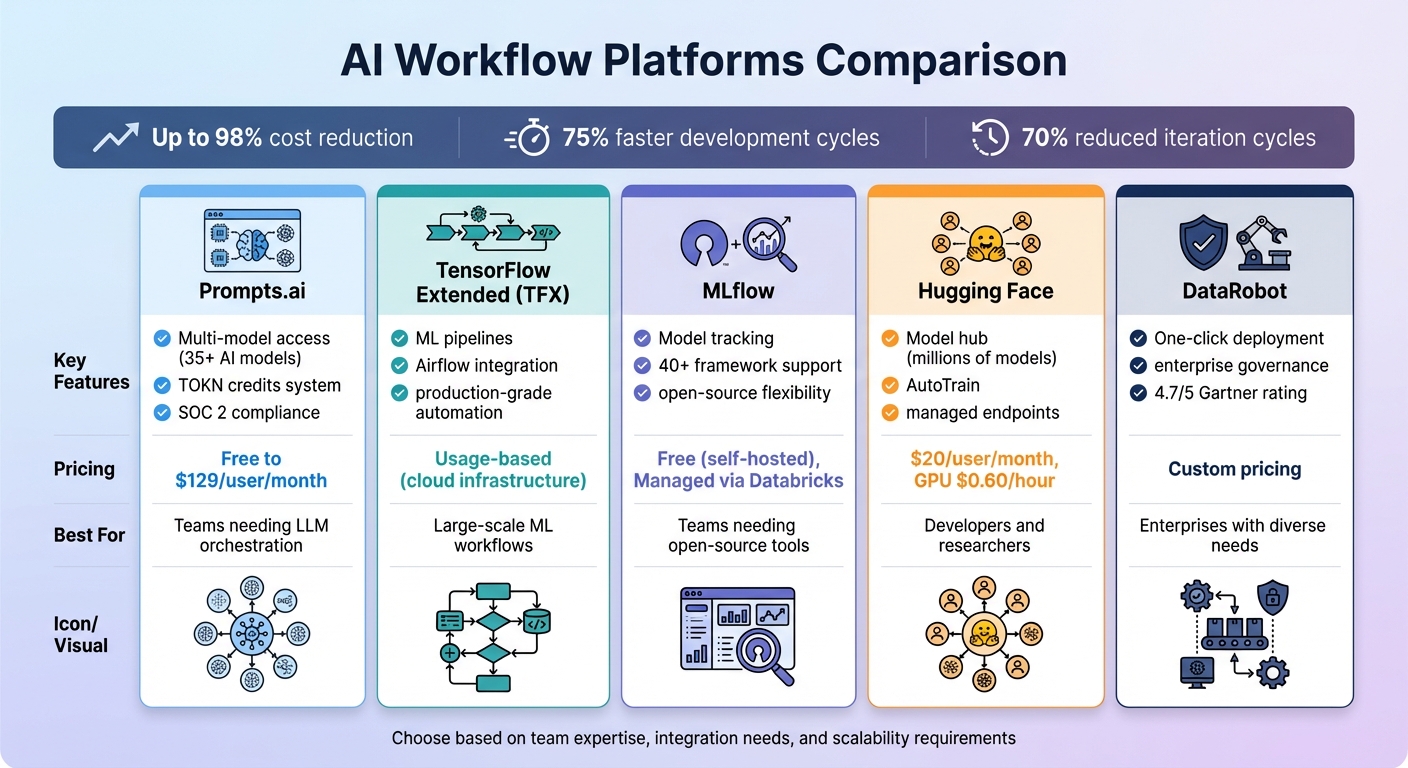

断开的人工智能工具、不断上涨的成本和安全风险使企业不堪重负。AI 工作流程平台通过统一工具、自动化任务和优化流程来解决这个问题。和 最多可降低 98% 的成本 和 开发周期缩短了 75%,这些平台简化了操作,同时保持了安全性和灵活性。以下是五个用于管理 AI 工作流程的出色平台:

快速对比:

每个平台都具有独特的优势,从节省成本到可扩展性,确保为任何人工智能挑战提供量身定制的解决方案。

AI 工作流程平台比较:功能、定价和最佳用例

Prompts.ai 汇集了对超过 35 个顶级 AI 模型的访问权限,包括 GPT、Claude、LLaMa 和 双子座 -整合到一个安全和简化的界面中。团队无需兼顾多个订阅和登录,而是可以并排比较各种大型语言模型的输出,从而更容易确定最适合特定任务的版本。这种多合一的解决方案消除了通常由于跨部门使用过多工具而导致的碎片化,为无缝自动化、可扩展性和协作铺平了道路。

使用 Prompts.ai,用户可以访问超过 35 个 AI 模型,无需管理单独的账户或 API 集成。这个统一的系统允许同步提示,使团队能够实时评估各模型的质量、速度和相关性。业务计划通过提供互操作工作流程更进一步,使组织可以创建可扩展、可重复的流程。例如,一种模型可以处理客户查询,而另一种模型则侧重于数据分析,所有这些都位于同一个生态系统中。

Prompts.ai 将一次性手动的 AI 任务转化为全天候运行的自动化工作流程。这些工作流程可以毫不费力地与诸如此类的工具集成 Slack, Gmail的,以及 Trello,简化生产力。例如,史蒂芬·西蒙斯将长达数周的三维渲染和提案写作缩短到只有一天。同样,建筑师 Ar.June Chow 使用该平台的并行 LLM 比较功能来尝试创意设计概念并轻松处理复杂的项目。

该平台的商业计划包括无限的工作空间和协作选项,非常适合大型团队。代币池和存储池等功能允许团队有效地共享资源,而集中式治理可确保所有人工智能活动的完全可见性和问责性。Prompts.ai 还从 2025 年 6 月 19 日开始了其 SOC 2 类型 2 审计流程,并整合了 HIPAA 和 GDPR 的合规框架,以满足企业级安全和数据保护需求。团队可以在不到 10 分钟的时间内部署新模型、添加成员和启动工作流程。

Prompts.ai 的 TOKN 信用系统将每月固定的软件支出转换为灵活的、基于使用量的支出,帮助用户优化成本。该平台声称通过将超过35种不同的工具合并为一个工具,可将人工智能相关费用减少多达98%。定价选项包括有限积分的免费即用即付计划和每位会员每月129美元的商业精英计划,其中包括1,000,000个TOKN积分和高级创意工具。首席执行官兼首席运营官弗兰克·布西米重点介绍了该平台如何简化内容创建和自动化策略工作流程,使他的团队能够专注于高水平的创意项目,而不是重复的任务。

TensorFLOW 扩展 (TFX) 是一个 专为部署生产级机器学习 (ML) 管道而设计的端到端平台,涵盖了从数据验证到模型服务的所有内容。虽然 TFX 主要围绕 TensorFlow 构建,但它支持包括其他框架的工作流程,例如 PyTorch, Scikit-learn,以及 XGBoost 通过容器化。这种灵活性使团队能够无缝管理混合框架项目,尤其是在诸如此类的环境中 顶点人工智能。其全面的结构为简化不同设置的自动化铺平了道路。

TFX 凭借其适应性强的架构简化了整个 ML 生命周期。它使用 ExampleGen、StatisticsGen、Transform、Trainer、Evaluator 和 Pusher 等预建组件实现工作流程自动化。这些组件与协调器集成,例如 阿帕奇气流, Kubeflow 管道,以及 阿帕奇光束,从而可以轻松地将 TFX 嵌入到企业环境中。例如,在 2023 年 10 月, Spotif 利用 TFX 和 TF-Agents 模拟聆听行为以进行强化学习,基于用户互动增强了他们的音乐推荐系统。同样, 沃达丰 2023 年 3 月采用了 TensorFlow 数据验证 (TFDV) 来监督其全球电信业务的数据治理。

“当工作流程被定义为代码时,它们就会变得更具可维护性、版本控制性、可测试性和协作性。”-Google Developers

TFX 专为扩展而构建,利用 Apache Beam 进行跨平台的分布式数据处理,例如 谷歌云数据流, 阿帕奇 Flink,以及 阿帕奇火花。它还集成了Vertex AI Pipelines和Vertex AI训练等企业工具,使团队能够处理海量数据集并通过GPU加速在多个节点上训练模型。经常为TFX管道提供支持的Kubeflow生态系统已被广泛采用,PyPI的下载量超过2.58亿,GitHub明星33,100个。此外,机器学习元数据 (MLMD) 跟踪模型谱系和管道执行历史记录,自动记录工件和参数,以确保透明度和可追溯性。这种可扩展性使 TFX 成为将复杂的机器学习工作流程统一为高效系统的强大工具。

TFX 通过使用缓存来避免重新执行冗余组件,从而帮助组织管理成本,从而在迭代训练期间节省计算资源。适用于正在运行的团队 谷歌云,账单数据可以导出到 Bigquery,允许对单个管道运行进行详细的成本分析。该平台的模块化设计还提供了灵活性:团队无需部署整个 TFX 系统即可使用 TFDV 或 TFT 等独立库,从而根据他们的特定需求定制平台。

mlFlow 是一款多功能的开源工具,可连接 40 多个人工智能框架,包括 PyTorch、TensorFlow、scikit-learn、 OpenAI,拥抱脸,以及 LangChain。作为其中的一部分 Linux 基础,它允许团队在本地、本地或跨主要云平台运行工作流程。MLFlow拥有超过2万名GitHub明星和超过5000万次的月下载量,已成为管理人工智能工作流程的广泛采用的解决方案。其无缝集成功能构成了其高级功能的基础。

mlFlow 3 使用其统一的模型 URI 简化了模型跟踪 (型号:/<model_id>),支持各个阶段的生命周期管理。开发人员可以使用 Python、REST、R 和 Java API 来记录几乎任何环境中的参数、指标和工件。对于生成式人工智能 (GenAI) 工作流程,mlFlow 集成了 30 多种工具,包括 人类,双子座,基岩, llaMaindex,以及 CrewAI。此外,其跟踪功能与 OpenTelemetry 一致,可确保 AI 可观测性数据顺利融入现有的企业监控系统。

MLFlow 凭借其自动化功能消除了工作流程管理的复杂性。这个 mlflow.autolog () 功能和模型注册表简化了指标记录,并自动完成了从试运行到生产的版本过渡。对于 GenAI 应用程序,MLFlow 可捕获整个执行过程,包括提示、检索和工具调用,从而更轻松地自动调试工作流程。

MLFlow通过将使用PostgreSQL或MySQL等SQL数据库作为元数据的后端存储与通过亚马逊S3、Azure Blob Store或谷歌云存储等服务管理大文件的神器商店分离来支持可扩展性。对于海量模型文件,分段上传会绕过跟踪服务器将构件分成 100 MB 的区块,从而提高上传速度和效率。团队可以在 “仅限工件模式” 下部署跟踪服务器实例,并使用类似 SQL 的查询来快速定位高性能模型,例如 指标。精度 > 0.95。

MLFlow根据Apache-2.0许可证免费提供,用于自托管部署。对于那些寻求托管解决方案的人,可以使用免费版本,并通过Databricks提供企业级选项。要高效处理大型模型,启用 MLFLOW_ENABLE_PROXY_MULTIPART_UPLOAD 允许直接上传到云存储,减少服务器负载并降低计算成本。通过将统一的模型管理与自动化和可扩展基础架构相结合,mlFlow 有效地解决了现代 AI 工作流程的关键挑战。

Hugging Face 是 AI 开发的中心中心,提供数百万个模型、数据集和演示应用程序(空间)。有超过 50,000 个组织加入,包括谷歌、微软、亚马逊等巨头 Meta -该平台强调以社区为导向的方法来推进人工智能。正如他们的文档中所述:

“包括科技巨头在内的任何一家公司都无法自己'解决人工智能'问题——我们实现这一目标的唯一方法是以社区为中心的方式共享知识和资源”。

Hugging Face 的庞大存储库可确保各种人工智能模型的无缝兼容性。密钥库,例如 变压器 和 扩散器 提供尖端的 PyTorch 模型,而 Transformers.js 允许直接在 Web 浏览器中执行模型。用户只需一个 Hugging Face API 代币,即可访问来自 10 多个推理合作伙伴的 45,000 多个模型,其中包括 AWS、Azure和谷歌云——按提供商的标准费率计算。该平台还集成了Asteroid和ESPNet等专业库,以及广泛使用的LLM框架,例如LangChain、LlaMainDex和CrewaI。诸如此类的工具 最佳 增强 AWS Trainium 和谷歌 TPU 等硬件的模型性能,同时 左边 (参数高效微调)和 加速 简化有关不同硬件设置的培训。

Hugging Face通过其AutoTrain功能简化了模型微调,该功能通过API和用户友好的界面自动完成流程,无需进行大量的手动编码。存储库级 Webhook 允许用户在更新模型、数据集或空间时触发外部操作。对于 AI 代理开发, 烟雾剂 Python 库有助于编排工具和管理复杂任务。完全托管的推理端点使将模型部署到生产环境中变得简单,而 Hub Jobs 框架则通过 API 或可视化界面自动执行和安排机器学习任务。这些自动化工具共同支持可扩展、企业就绪的工作流程。

Hugging Face 提供企业级功能,例如 单点登录 (SSO)、审计日志和资源组,使大型团队可以轻松协作,同时保持合规性。该平台使用 Xet 技术在基于 Git 的存储库中对大文件进行高效存储和版本控制,从而简化了对大量模型和数据集的管理。团队可以对账户进行分组,为访问控制分配精细的角色,并对数据集、模型和空间进行集中计费。此外,该平台支持超过8,000种语言的数据集,并提供与主要云提供商集成的完全托管的推理端点。

团队计划开始于 每位用户每月 20 美元,包括 SSO、审计日志和资源组等功能。GPU 的使用定价为 每小时 0.60 美元,推理提供商直接按标准费率向用户收费,Hugging Face不增加加价。对于演示应用程序,ZeroGPU Spaces 会实时动态分配 NVIDIA H200 GPU,从而无需永久的高成本硬件。自定义定价适用于需要高级安全性、专用支持和增强访问控制的企业。

DataRobot 是一个全面的人工智能平台,旨在处理从实验到生产部署的所有事情。它在Gartner Peer Insights上获得了4.7/5的评分和90%的用户推荐率,在Gartner数据科学和机器学习平台魔力象限中也被公认为领导者。该平台专注于集成、自动化和可扩展性,使其更容易驾驭复杂的人工智能工作流程。FordDirect数据战略、分析和商业智能副总裁汤姆·托马斯分享说:

“我们发现 DataRobot 真正有价值的是实现价值的时间。DataRobot 帮助我们在市场上部署人工智能解决方案的时间是以前的一半。”

DataRobot 的模型无关注册表为来自任何来源的模型包提供集中管理。无论提供商是谁,它都支持开源和专有的大型语言模型(LLM)和小型语言模型(SLM)。通过对诸如此类的平台进行原生集成 雪花、AWS、Azure和谷歌云,该平台可确保与现有技术堆栈的无缝连接。其下一代用户界面为开发和管理提供了灵活性,允许用户在图形界面和编程工具(如 REST API 或 Python 客户端包)之间切换。这种无缝集成为未来工作流程中的高级自动化奠定了基础。

DataRobot 通过一键部署、创建 API 端点和自动配置监控,简化了从开发到生产的过程。其动态计算编排消除了手动管理服务器的麻烦——用户可以指定自己的计算需求,系统负责配置和工作负载分配。诺福克钢铁公司数据分析总监本·杜波依斯强调了它的好处:

“DataRobot 为我的团队带来的主要优势是快速迭代的能力。我们可以尝试新事物,快速将其投入生产。这种灵活性是关键,尤其是在使用旧系统时。”

该平台还自动生成合规文档,以解决模型治理和监管标准问题。“用例” 容器有助于保持项目井然有序并做好审计准备,确保企业环境中的工作流程保持结构化。

DataRobot 使您可以通过集中式系统轻松管理从数十到数百种的各种模型。它支持跨托管的 SaaS、VPC 或本地基础设施进行部署。例如,一家全球能源公司在600多个人工智能用例中实现了2亿美元的投资回报率,而一家排名前五的全球银行通过该组织的40多个人工智能应用程序实现了7000万美元的投资回报率。Thibaut Joncquez,数据科学总监 Turo,重点介绍了该平台的标准化能力:

“没有其他东西能像 DataRobot 那样集成、易于使用、标准化和一体化。DataRobot 为我们提供了一个结构化框架,以确保每个人都有相同的标准。”

该平台通过提供可视化工具和编程接口,将不同的团队聚集在一起,包括数据科学家、开发人员、IT和InfoSec。其预建的 “AI 加速器” 加快了从实验到生产的过渡。通过统一工作流程、自动化复杂流程和轻松扩展,DataRobot 可帮助组织轻松实现企业级 AI 功能。

人工智能工作流程平台正在重塑组织从孤立实验向完全可操作的系统转变的方式。通过采用正确的平台,企业可以显著加快开发周期——有些企业报告说,创建代理工作流程所需的时间缩短了 75% 并将迭代周期缩短为 70% 使用专用 AI 平台。这些效率可以加快发布速度并提高投资回报率。

这些进步的关键在于三个主要优势: 互操作性, 自动化,以及 可扩展性。与各种模型和现有技术堆栈集成的平台可防止供应商锁定和不可预测的成本。协调层可确保系统可靠性并简化恢复流程,使团队能够专注于其核心目标。对于跨部门团队而言,共享工作空间和可视化生成器等工具有助于弥合技术用户和非技术用户之间的差距,而监管功能(例如审计跟踪和基于角色的访问控制)可确保工作流程保持安全和合规。

选择正确的平台对于解锁这些优势至关重要。选择符合您团队专业知识的解决方案,为非技术用户提供无代码接口,为开发人员提供API驱动的选项。寻找具有强大可观测性功能(例如节点级跟踪、成本指标和可搜索日志)的平台,以快速识别和解决生产问题。利用外部合作伙伴关系或专业的低代码 AI 工具的组织已经看到 成功率的两倍 与完全依赖内部资源的项目相比,在将项目从试点转向生产方面。

这些数字不言自明:使用人工智能自动化报告的公司 生产率最多可提高 35% 和 节省 25-50% 的成本。正如首席技术官安德烈斯·加西亚所解释的那样:

“对作为首席技术官的我来说,投资成熟的自动化可以让团队腾出时间进行创新。当基础设施已经到位时,我不希望我的团队建设连接、监视器或日志记录。”

从诸如数据充实之类的大容量、重复性任务开始,以快速获胜。确保该平台与您现有的 SaaS 和传统系统无缝集成,因为 46% 的产品团队 将整合不良列为采用人工智能的最大障碍。一个可以简化而不是增加复杂性的平台可确保您的团队能够专注于推动创新和交付有意义的业务成果。

AI 工作流程平台通过将工具、模型和数据管道整合到一个统一的、按使用量付费的系统中,提供了一种削减开支的明智方式。用户无需为不同的人工智能模型兼顾多个许可证,而是通过单一平台访问超过35种模型,只需为实际使用的计算能力付费。这种方法可以消除资源浪费,并确保没有容量闲置。

借助实时成本跟踪和治理工具,用户可以完全透明地了解其支出。这些功能与内置自动化功能相结合,可最大限度地减少手动任务,并有助于避免不必要的云成本。这些效率加在一起可以节省多达的成本 98% 相比之下,管理分散的多供应商设置效率低下。

Prompts.ai 旨在简化团队在单一安全的环境中处理和协调多个大型语言模型 (LLM) 的方式。可以访问超过 35 个顶级型号,包括 GPT-5, 克劳德,以及 Grok-4,用户可以在模型之间无缝切换或同时使用它们——所有这些都无需管理单独的账户或 API。

该平台包括 实时成本跟踪 以及灵活的即用即付信用体系,使团队更容易控制开支,同时降低与人工智能相关的成本。企业级安全性可确保数据受到保护,而集成的自动化工具则降低了设计、测试和部署 LLM 工作流程的复杂性。Prompts.ai 为组织在其 AI 计划中提高生产力和促进协作提供了一种简化、高效的方式。

人工智能工作流程平台非常重视 安全 和 合规,整合了基于角色的访问控制 (RBAC)、详细的审计日志和数据隐私保护等功能。这些功能使组织能够跟踪谁与模型进行交互、何时交互以及涉及哪些数据,从而确保每一步的问责制。

为了保护敏感信息,这些平台通常使用 加密 -既适用于静态数据,也适用于传输过程中的数据-以及沙盒环境和自动数据清理措施。他们还遵守严格的组织政策,规范与第三方提供商的连接,将未经授权的数据共享的风险降至最低。政策驱动的护栏和防篡改日志进一步增强了监管合规性,同时提高了运营透明度。

这些措施共同创建了一个安全可靠的框架,使组织能够自信地扩展其人工智能工作流程,同时维护隐私和合规标准。