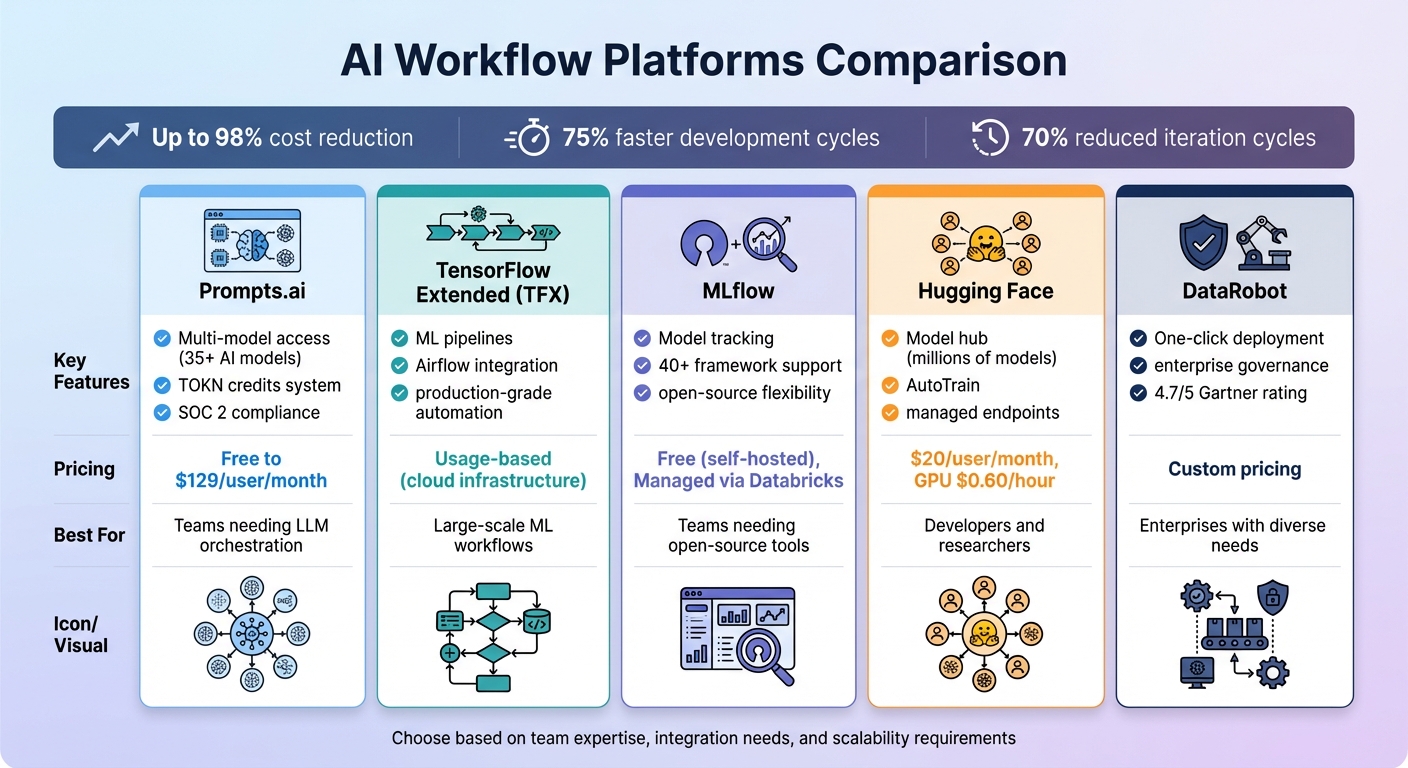

ترهق الشركات أدوات الذكاء الاصطناعي غير المتصلة، وارتفاع التكاليف، والمخاطر الأمنية. تعمل منصات سير العمل بالذكاء الاصطناعي على حل هذه المشكلة من خلال توحيد الأدوات وأتمتة المهام وتحسين العمليات. مع خفض التكاليف بنسبة تصل إلى 98% و دورات تطوير أسرع بنسبة 75%، تعمل هذه المنصات على تبسيط العمليات مع الحفاظ على الأمان والمرونة. فيما يلي خمس منصات متميزة لإدارة تدفقات عمل الذكاء الاصطناعي:

مقارنة سريعة:

توفر كل منصة نقاط قوة فريدة، من التوفير في التكاليف إلى قابلية التوسع، مما يضمن حلاً مصممًا لأي تحدٍ للذكاء الاصطناعي.

مقارنة منصات سير العمل بالذكاء الاصطناعي: الميزات والتسعير وأفضل حالات الاستخدام

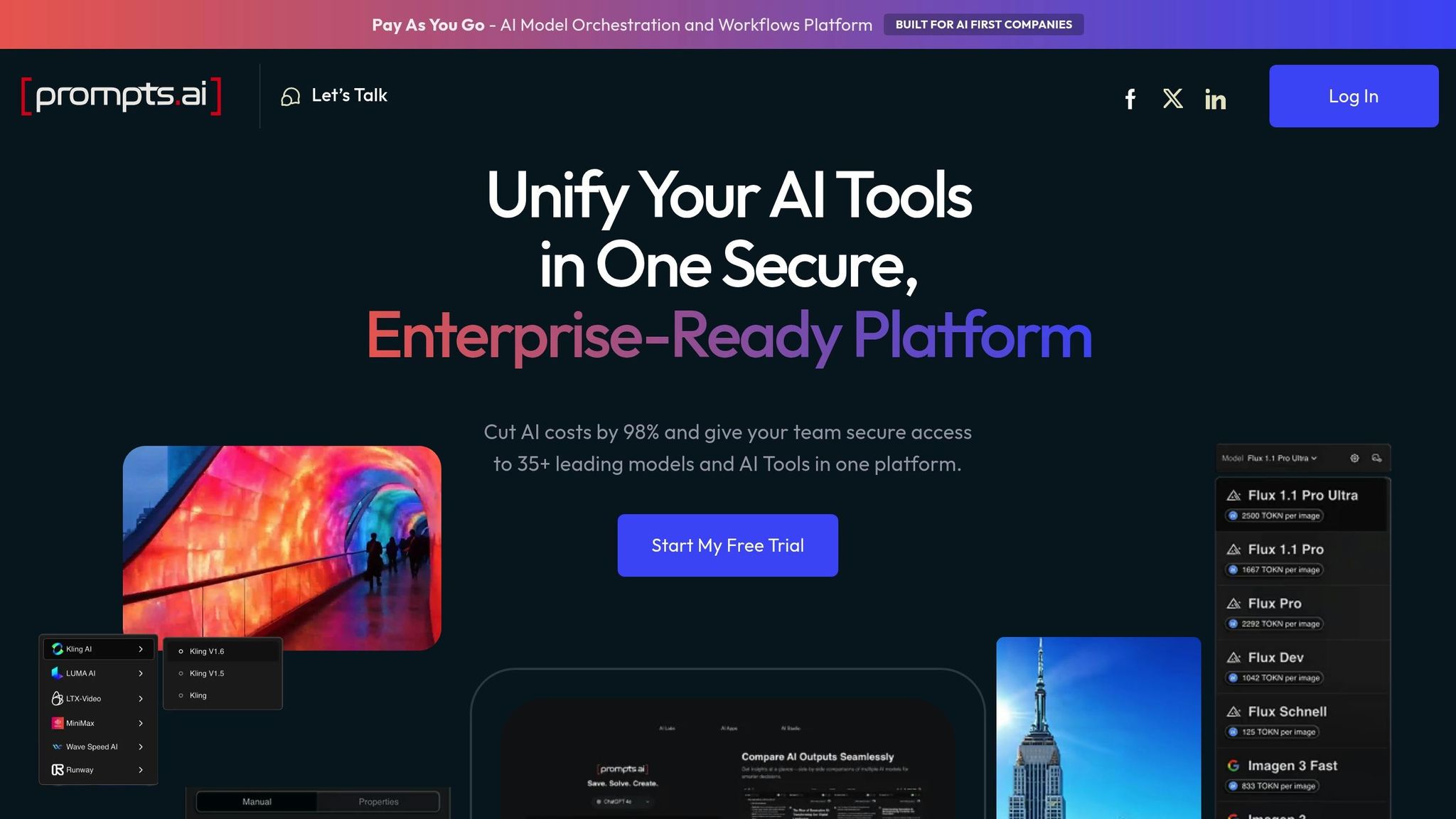

يجمع Prompts.ai إمكانية الوصول إلى أكثر من 35 نموذجًا من أفضل نماذج الذكاء الاصطناعي - بما في ذلك GPT و Claude و LLama و الجوزاء - في واجهة واحدة آمنة ومبسطة. بدلاً من التوفيق بين الاشتراكات المتعددة وعمليات تسجيل الدخول، يمكن للفرق مقارنة المخرجات من نماذج اللغات الكبيرة المختلفة جنبًا إلى جنب، مما يسهل تحديد الأنسب لمهام محددة. يعمل هذا الحل الشامل على التخلص من التجزئة التي تحدث غالبًا بسبب استخدام الكثير من الأدوات عبر الأقسام، مما يمهد الطريق للأتمتة السلسة وقابلية التوسع والتعاون.

باستخدام Prompts.ai، يمكن للمستخدمين الوصول إلى أكثر من 35 نموذجًا للذكاء الاصطناعي دون الحاجة إلى إدارة حسابات منفصلة أو تكامل API. يسمح هذا النظام الموحد بالمطالبات المتزامنة، مما يمكّن الفرق من تقييم الجودة والسرعة والملاءمة عبر النماذج في الوقت الفعلي. تأخذ خطط الأعمال خطوة إلى الأمام من خلال تقديم عمليات سير العمل القابلة للتشغيل المتبادل، والتي تتيح للمؤسسات إنشاء عمليات قابلة للتطوير والتكرار. على سبيل المثال، يمكن لنموذج واحد التعامل مع استفسارات العملاء، بينما يركز نموذج آخر على تحليل البيانات، وكل ذلك ضمن نفس النظام البيئي.

يقوم Prompts.ai بتحويل مهام الذكاء الاصطناعي اليدوية التي تتم لمرة واحدة إلى عمليات سير عمل آلية تعمل على مدار الساعة. تتكامل عمليات سير العمل هذه بسهولة مع أدوات مثل سلاك، Gmail، و تريلو، تبسيط الإنتاجية. على سبيل المثال، قام ستيفن سيمونز بتخفيض العرض ثلاثي الأبعاد وكتابة المقترحات لمدة أسابيع إلى يوم واحد فقط. وبالمثل، المهندس المعماري Ar. تستخدم June Chow ميزة مقارنة LLM جنبًا إلى جنب في المنصة لتجربة مفاهيم التصميم الإبداعي ومعالجة المشاريع المعقدة بسهولة.

تتضمن خطط الأعمال الخاصة بالمنصة مساحات عمل غير محدودة وخيارات تعاون، مما يجعلها مثالية للفرق الكبيرة. تسمح ميزات مثل TOKN Pooling و Storage Pooling للفرق بمشاركة الموارد بفعالية، بينما تضمن الحوكمة المركزية الرؤية الكاملة والمساءلة لجميع أنشطة الذكاء الاصطناعي. بدأت Prompts.ai أيضًا عملية تدقيق SOC 2 Type 2 اعتبارًا من 19 يونيو 2025، وتدمج أطر الامتثال من HIPAA و GDPR، مما يلبي احتياجات الأمان وحماية البيانات على مستوى المؤسسة. يمكن للفرق نشر نماذج جديدة وإضافة أعضاء وبدء عمليات سير العمل في أقل من 10 دقائق.

يعمل نظام TOKN الائتماني الخاص بـ Prompts.ai على تحويل نفقات البرامج الشهرية الثابتة إلى إنفاق مرن قائم على الاستخدام، مما يساعد المستخدمين على تحسين التكاليف. تدعي المنصة أنها تقلل النفقات المتعلقة بالذكاء الاصطناعي بنسبة تصل إلى 98٪ من خلال دمج أكثر من 35 أداة منفصلة في أداة واحدة. تتراوح خيارات التسعير من خطة Pay As You Go المجانية مع ائتمانات محدودة إلى خطة Business Elite بسعر 129 دولارًا لكل عضو شهريًا، والتي تتضمن 1،000،000 رصيد TOKN وأدوات إبداعية متقدمة. يسلط فرانك بوسكيمي، الرئيس التنفيذي والمدير التنفيذي لشركة CCO، الضوء على كيفية قيام المنصة بتبسيط إنشاء المحتوى وسير العمل الاستراتيجي الآلي، مما سمح لفريقه بالتركيز على المشاريع الإبداعية عالية المستوى بدلاً من المهام المتكررة.

تينسورفلو الموسع (TFX) هو منصة شاملة مصممة لنشر خطوط أنابيب التعلم الآلي (ML) على مستوى الإنتاج، تغطي كل شيء بدءًا من التحقق من صحة البيانات وحتى خدمة النموذج. في حين أن TFX مبنية بشكل أساسي حول TensorFlow، فإنها تدعم عمليات سير العمل التي تتضمن أطر عمل أخرى مثل PyTorch، سكيكيت ليرن، و إكس جي بوست من خلال النقل بالحاويات. تسمح هذه المرونة للفرق بإدارة مشاريع الإطار المختلط بسلاسة، خاصة في بيئات مثل فيرتيكس إيه آي. يمهد هيكلها الشامل الطريق لأتمتة مبسطة عبر إعدادات متنوعة.

تبسط TFX دورة حياة ML بأكملها من خلال بنيتها القابلة للتكيف. يقوم البرنامج بأتمتة عمليات سير العمل باستخدام مكونات تم إنشاؤها مسبقًا مثل ExampleGen وStatisticsGen والتحويل والمدرب والمقيم وPusher. تتكامل هذه المكونات مع أجهزة التنسيق مثل تدفق هواء أباتشي، خطوط أنابيب كوبيفلو، و اباتشي بيم، مما يجعل من السهل تضمين TFX في بيئات المؤسسات. على سبيل المثال، في أكتوبر 2023، سبوتيفي استفادت من وكلاء TFX و TF لمحاكاة سلوكيات الاستماع للتعلم المعزز، وتعزيز أنظمة التوصية الموسيقية الخاصة بهم بناءً على تفاعلات المستخدم. وبالمثل، فودافون اعتمدت التحقق من صحة بيانات TensorFlow (TFDV) في مارس 2023 للإشراف على إدارة البيانات عبر عمليات الاتصالات العالمية.

«عندما يتم تعريف عمليات سير العمل على أنها شفرة، فإنها تصبح أكثر قابلية للصيانة وقابلية للإصدار والاختبار والتعاون.» - Google Developers

تم تصميم TFX للتوسع باستخدام Apache Beam لمعالجة البيانات الموزعة عبر منصات مثل غوغل كلاود داتافلو، أباتشي فلينك، و أباتشي سبارك. كما أنه يتكامل مع أدوات المؤسسة مثل Vertex AI Pipelines و Vertex AI Training، مما يمكّن الفرق من معالجة مجموعات البيانات الضخمة وتدريب النماذج عبر العقد المتعددة مع تسريع GPU. شهد نظام Kubeflow البيئي، الذي يعمل بشكل متكرر على تشغيل خطوط أنابيب TFX، اعتمادًا كبيرًا، مع أكثر من 258 مليون عملية تنزيل لـ PyPI و 33100 نجمة GitHub. بالإضافة إلى ذلك، تقوم ML Metadata (MLMD) بتتبع نسب النموذج وتاريخ تنفيذ خطوط الأنابيب، وتسجيل العناصر والمعايير تلقائيًا لضمان الشفافية وإمكانية التتبع. إن قابلية التوسع هذه تجعل TFX أداة قوية لتوحيد عمليات سير عمل ML المعقدة في نظام فعال.

تساعد TFX المؤسسات على إدارة التكاليف باستخدام التخزين المؤقت لتجنب إعادة تنفيذ المكونات الزائدة، مما يوفر موارد الحوسبة أثناء التدريب التكراري. للفرق التي تعمل على جوجل كلاود، يمكن تصدير بيانات الفواتير إلى بيج كويري، مما يسمح بإجراء تحليل مفصل لتكاليف عمليات تشغيل خطوط الأنابيب الفردية. يوفر التصميم المعياري للمنصة أيضًا المرونة: يمكن للفرق استخدام المكتبات المستقلة مثل TFDV أو TFT دون نشر نظام TFX بالكامل، وتخصيص النظام الأساسي لاحتياجاتهم الخاصة.

MLFlow هي أداة متعددة الاستخدامات ومفتوحة المصدر تربط أكثر من 40 إطارًا للذكاء الاصطناعي، بما في ذلك PyTorch و TensorFlow و scikit-Learn، أوبن إيه آي، معانقة الوجه، و لانج تشين. كجزء من مؤسسة لينكس، فهي تسمح للفرق بتشغيل عمليات سير العمل محليًا أو داخليًا أو عبر منصات السحابة الرئيسية. مع أكثر من 20,000 من نجوم GitHub وأكثر من 50 مليون عملية تنزيل شهرية، أصبح MLFlow حلاً معتمدًا على نطاق واسع لإدارة تدفقات عمل الذكاء الاصطناعي. تشكل قدرات التكامل السلس أساس ميزاتها المتقدمة.

يبسط MLFlow 3 تتبع النموذج باستخدام نموذج URI الموحد (الموديلات:/<model_id>)، مما يدعم إدارة دورة الحياة عبر المراحل المختلفة. يمكن للمطورين استخدام واجهات برمجة تطبيقات Python و REST و R و Java لتسجيل المعلمات والمقاييس والتحف من أي بيئة تقريبًا. بالنسبة لسير عمل الذكاء الاصطناعي التوليدي (GenAI)، يتكامل MLFlow مع أكثر من 30 أداة، بما في ذلك أنثروبي، الجوزاء، بيدروك، مؤشر لاما، و الطاقم A. بالإضافة إلى ذلك، تتوافق قدرات التتبع الخاصة بها مع OpenTelemetry، مما يضمن أن بيانات قابلية المراقبة بالذكاء الاصطناعي تتناسب بسلاسة مع أنظمة مراقبة المؤسسة الحالية.

يزيل MLFlow التعقيد من إدارة سير العمل من خلال ميزات الأتمتة الخاصة به. ال mlflow.autolog () تعمل الوظيفة وسجل النموذج على تبسيط تسجيل المقاييس وأتمتة انتقالات الإصدار من التدريج إلى الإنتاج. بالنسبة لتطبيقات GenAI، يلتقط MLFlow عملية التنفيذ بأكملها - التي تغطي المطالبات والاسترجاع واستدعاءات الأدوات - مما يسهل تصحيح أخطاء سير العمل تلقائيًا.

يدعم MLFlow قابلية التوسع عن طريق فصل متجر Backend، الذي يستخدم قواعد بيانات SQL مثل PostgreSQL أو MySQL للبيانات الوصفية، عن متجر Artifact Store، الذي يدير الملفات الكبيرة من خلال خدمات مثل Amazon S3 أو Azure Blob Storage أو Google Cloud Storage. بالنسبة لملفات النماذج الضخمة، تعمل التحميلات متعددة الأجزاء على تقسيم القطع الأثرية إلى أجزاء بحجم 100 ميجابايت، متجاوزة خادم التتبع لتحسين سرعات التحميل وكفاءته. يمكن للفرق نشر مثيلات خادم التتبع في «وضع القطع الأثرية فقط» واستخدام استعلامات تشبه SQL لتحديد النماذج عالية الأداء بسرعة، مثل دقة المقاييس > 0.95.

MLFlow متاح مجانًا بموجب ترخيص Apache-2.0 لعمليات النشر المستضافة ذاتيًا. بالنسبة لأولئك الذين يبحثون عن حل مُدار، تتوفر نسخة مجانية، مع خيارات على مستوى المؤسسات يتم تقديمها من خلال Databricks. للتعامل مع النماذج الكبيرة بكفاءة، مما يتيح MLFLOW_ENABLE_PROXY_تحميل متعدد الأجزاء يسمح بالتحميلات المباشرة إلى التخزين السحابي، مما يقلل من حمل الخادم ويقلل تكاليف الحوسبة. من خلال الجمع بين إدارة النماذج الموحدة والأتمتة والبنية التحتية القابلة للتطوير، يعالج MLFlow التحديات الرئيسية لسير عمل الذكاء الاصطناعي الحديث بفعالية.

تُعد Huging Face بمثابة مركز مركزي لتطوير الذكاء الاصطناعي، حيث تقدم ملايين النماذج ومجموعات البيانات والتطبيقات التجريبية (Spaces). مع أكثر من 50,000 منظمة على متن الطائرة - بما في ذلك الشركات العملاقة مثل Google و Microsoft و Amazon و ميتا - تؤكد المنصة على نهج يحركه المجتمع للنهوض بالذكاء الاصطناعي. كما هو مذكور في وثائقهم:

«لن تتمكن أي شركة واحدة، بما في ذلك Tech Titans، من «حل الذكاء الاصطناعي» بمفردها - الطريقة الوحيدة لتحقيق ذلك هي من خلال مشاركة المعرفة والموارد في نهج يركز على المجتمع».

يضمن مستودع Huging Face الواسع التوافق السلس عبر مجموعة من نماذج الذكاء الاصطناعي. المكتبات الرئيسية مثل المتحولون و الناشرون توفير نماذج PyTorch المتطورة، بينما Transformers.js يتيح تنفيذ النموذج مباشرة في متصفحات الويب. باستخدام رمز Huging Face API واحد، يمكن للمستخدمين الوصول إلى أكثر من 45000 نموذج عبر أكثر من 10 شركاء للاستدلال - بما في ذلك الخدمات اللاسلكية المتقدمةو Azure و Google Cloud - بالمعدلات القياسية لمقدمي الخدمات. تتكامل المنصة أيضًا مع المكتبات المتخصصة مثل Asteroid و ESPNet، بالإضافة إلى أطر LLM المستخدمة على نطاق واسع مثل LangChain و LLAmaIndex و CreWai. أدوات مثل الأمثل تحسين أداء النموذج للأجهزة مثل AWS Trainium ووحدات معالجة الرسومات من Google، بينما تافت (الضبط الدقيق بكفاءة المعلمات) و قم بالتسريع تبسيط التدريب على إعدادات الأجهزة المتنوعة.

يعمل Hugging Face على تبسيط الضبط الدقيق للنموذج من خلال ميزة AutoTrain، التي تعمل على أتمتة العملية عبر واجهات برمجة التطبيقات وواجهة سهلة الاستخدام، مما يلغي الحاجة إلى الترميز اليدوي الشامل. تسمح روابط الويب على مستوى المستودع للمستخدمين بتشغيل إجراءات خارجية عند تحديث النماذج أو مجموعات البيانات أو المساحات. بالنسبة لتطوير وكلاء الذكاء الاصطناعي، فإن مواد الدخان تساعد مكتبة Python على تنسيق الأدوات وإدارة المهام المعقدة. تعمل نقاط نهاية الاستدلال المُدارة بالكامل على جعل نشر النماذج في الإنتاج أمرًا سهلاً، بينما يقوم إطار عمل Hub Jobs بأتمتة وجدولة مهام التعلم الآلي من خلال واجهات برمجة التطبيقات أو الواجهة المرئية. تدعم أدوات التشغيل الآلي هذه معًا عمليات سير العمل القابلة للتطوير والجاهزة للمؤسسات.

يوفر Huging Face ميزات على مستوى المؤسسات مثل تسجيل الدخول الأحادي (SSO) وسجلات التدقيق ومجموعات الموارد، مما يجعل من السهل على الفرق الكبيرة التعاون مع الحفاظ على الامتثال. تستخدم المنصة تقنية Xet للتخزين الفعال وإصدار الملفات الكبيرة داخل المستودعات القائمة على Git، وتبسيط إدارة النماذج الشاملة ومجموعات البيانات. يمكن للفرق تجميع الحسابات وتعيين أدوار تفصيلية للتحكم في الوصول وتركيز الفواتير لمجموعات البيانات والنماذج والمساحات. بالإضافة إلى ذلك، تدعم المنصة مجموعات البيانات بأكثر من 8000 لغة وتوفر نقاط نهاية الاستدلال المُدارة بالكامل والمتكاملة مع مزودي السحابة الرئيسيين.

تبدأ خطة الفريق في 20 دولارًا لكل مستخدم شهريًا، بما في ذلك ميزات مثل SSO وسجلات التدقيق ومجموعات الموارد. يتم تسعير استخدام GPU بـ 0.60 دولار في الساعة، وموفرو الاستدلال يفرضون رسومًا على المستخدمين مباشرةً بمعدلاتهم القياسية، دون أي علامات إضافية من Hugging Face. بالنسبة للتطبيقات التجريبية، تقوم ZeroGPU Spaces بتخصيص وحدات معالجة الرسومات NVIDIA H200 ديناميكيًا في الوقت الفعلي، مما يلغي الحاجة إلى أجهزة دائمة عالية التكلفة. تتوفر الأسعار المخصصة للمؤسسات التي تتطلب أمانًا متقدمًا ودعمًا مخصصًا وأدوات تحكم محسّنة في الوصول.

DataRobot عبارة عن منصة ذكاء اصطناعي شاملة مصممة للتعامل مع كل شيء بدءًا من التجريب وحتى نشر الإنتاج. حصلت على تصنيف 4.7/5 على Gartner Peer Insights ومعدل توصية المستخدم بنسبة 90٪، كما تم الاعتراف بها كشركة رائدة في Gartner Magic Quadrant لعلوم البيانات ومنصات التعلم الآلي. تركز المنصة على التكامل والأتمتة وقابلية التوسع، مما يسهل التنقل بين تعقيدات سير عمل الذكاء الاصطناعي. قال توم توماس، نائب رئيس استراتيجية البيانات والتحليلات وذكاء الأعمال في FordDirect:

«ما نجده قيمًا حقًا مع DataRobot هو وقت التقييم. تساعدنا DataRobot على نشر حلول الذكاء الاصطناعي في السوق في نصف الوقت الذي اعتدنا القيام به من قبل.»

يوفر السجل الحيادي النموذجي لـ DataRobot إدارة مركزية لحزم النماذج من أي مصدر. وهو يدعم كلاً من نماذج اللغات الكبيرة مفتوحة المصدر والملكية (LLMs) ونماذج اللغات الصغيرة (SLMs)، بغض النظر عن الموفر. مع عمليات تكامل أصلية لمنصات مثل ندفة الثلجو AWS و Azure و Google Cloud، تضمن المنصة اتصالات سلسة بمكدسات التكنولوجيا الحالية. توفر NextGen UI المرونة لكل من التطوير والحوكمة، مما يسمح للمستخدمين بالتبديل بين الواجهة الرسومية والأدوات البرمجية مثل REST API أو حزم عملاء Python. يمهد هذا التكامل السلس الطريق للأتمتة المتقدمة في عمليات سير العمل المستقبلية.

يعمل DataRobot على تبسيط الرحلة من التطوير إلى الإنتاج من خلال النشر بنقرة واحدة وإنشاء نقاط نهاية API وتكوين المراقبة تلقائيًا. تعمل عملية تنسيق الحوسبة الديناميكية الخاصة به على التخلص من متاعب الإدارة اليدوية للخوادم - يحدد المستخدمون احتياجات الحوسبة الخاصة بهم، ويهتم النظام بالتزويد وتوزيع عبء العمل. أكد بن دوبوا، مدير تحليلات البيانات في شركة Norfolk Iron & Metal، على فوائدها:

«الشيء الرئيسي الذي يجلبه DataRobot لفريقي هو القدرة على التكرار بسرعة. يمكننا تجربة أشياء جديدة ووضعها في الإنتاج بسرعة. هذه المرونة هي المفتاح - خاصة عند العمل مع الأنظمة القديمة.»

تقوم المنصة أيضًا بإنشاء وثائق الامتثال تلقائيًا، مع معالجة الحوكمة النموذجية والمعايير التنظيمية. تساعد حاويات «Use Case» في الحفاظ على تنظيم المشاريع وتجهيزها للتدقيق، مما يضمن بقاء عمليات سير العمل منظمة عبر بيئات المؤسسة.

يجعل DataRobot من السهل إدارة مجموعة واسعة من النماذج، من العشرات إلى المئات، من خلال نظام مركزي. وهو يدعم النشر عبر SaaS المُدارة أو VPC أو البنى التحتية المحلية. على سبيل المثال، حققت شركة طاقة عالمية عائد استثمار بقيمة 200 مليون دولار عبر أكثر من 600 حالة استخدام للذكاء الاصطناعي، بينما حقق أفضل 5 بنوك عالمية عائد استثمار قدره 70 مليون دولار من خلال أكثر من 40 تطبيقًا للذكاء الاصطناعي في جميع أنحاء المؤسسة. ثيبوت جونكيز، مدير علوم البيانات في تورو، سلط الضوء على قدرات التوحيد القياسي للمنصة:

«لا يوجد شيء آخر متكامل وسهل الاستخدام وموحد وشامل مثل DataRobot. لقد زودتنا DataRobot بإطار منظم لضمان حصول الجميع على نفس المعيار.»

تجمع المنصة فرقًا متنوعة - علماء البيانات والمطورين وتكنولوجيا المعلومات و InfoSec - من خلال تقديم كل من الأدوات المرئية والواجهات البرمجية. تعمل «مسرعات الذكاء الاصطناعي» المبنية مسبقًا على تسريع الانتقال من التجريب إلى الإنتاج. من خلال توحيد سير العمل وأتمتة العمليات المعقدة والتوسع دون عناء، تساعد DataRobot المؤسسات على تحقيق قدرات الذكاء الاصطناعي على مستوى المؤسسات بسهولة.

تعمل منصات سير العمل بالذكاء الاصطناعي على إعادة تشكيل كيفية انتقال المؤسسات من التجارب المعزولة إلى الأنظمة التي تعمل بكامل طاقتها. من خلال اعتماد النظام الأساسي الصحيح، يمكن للشركات تسريع دورات التطوير بشكل كبير - يفيد البعض بتقليل الوقت اللازم لإنشاء تدفقات عمل فعالة من خلال 75% وتقليل دورات التكرار من خلال 70% مع منصات الذكاء الاصطناعي المخصصة. تؤدي هذه الكفاءات إلى عمليات إطلاق أسرع وعوائد محسنة على الاستثمار.

يكمن مفتاح هذه التطورات في ثلاث مزايا رئيسية: قابلية التشغيل البيني، التشغيل الآلي، و القابلية للتطوير. تعمل المنصات التي تتكامل مع النماذج المختلفة والمكدسات التقنية الحالية على منع تقييد البائعين والتكاليف غير المتوقعة. تضمن طبقات التنسيق موثوقية النظام وتبسيط عمليات الاسترداد، مما يسمح للفرق بالتركيز على أهدافها الأساسية. بالنسبة للفرق المشتركة بين الأقسام، تساعد أدوات مثل مساحات العمل المشتركة وأدوات الإنشاء المرئية على سد الفجوة بين المستخدمين التقنيين وغير التقنيين، بينما تضمن ميزات الحوكمة - مثل مسارات التدقيق وعناصر التحكم في الوصول القائمة على الأدوار - أن تظل عمليات سير العمل آمنة ومتوافقة.

يعد اختيار النظام الأساسي المناسب أمرًا بالغ الأهمية لفتح هذه الفوائد. اختر الحلول التي تتوافق مع خبرة فريقك، حيث تقدم واجهات بدون تعليمات برمجية للمستخدمين غير التقنيين وخيارات تعتمد على واجهة برمجة التطبيقات للمطورين. ابحث عن الأنظمة الأساسية ذات ميزات المراقبة القوية - مثل عمليات التتبع على مستوى العقدة ومقاييس التكلفة والسجلات القابلة للبحث - لتحديد مشكلات الإنتاج وحلها بسرعة. شهدت المنظمات التي تستفيد من الشراكات الخارجية أو أدوات الذكاء الاصطناعي المتخصصة منخفضة التعليمات البرمجية مضاعفة معدلات النجاح في نقل المشاريع من التجربة إلى الإنتاج مقارنة بتلك التي تعتمد فقط على الموارد الداخلية.

الأرقام تتحدث عن نفسها: الشركات التي تستخدم تقرير التشغيل الآلي للذكاء الاصطناعي إنتاجية أعلى بنسبة تصل إلى 35% و وفورات في التكاليف بنسبة 25-50٪. كما يوضح أندريس غارسيا، كبير مسؤولي التكنولوجيا:

«بالنسبة لي بصفتي المدير التنفيذي للتكنولوجيا، فإن الاستثمار في الأتمتة المجربة يحرر الفرق للابتكار. لا أريد أن يقوم فريقي ببناء الاتصالات أو الشاشات أو تسجيل الدخول عندما تكون هناك بنية تحتية موجودة بالفعل.»

ابدأ بمهام متكررة كبيرة الحجم مثل إثراء البيانات لتحقيق مكاسب سريعة. تأكد من تكامل النظام الأساسي بسلاسة مع SaaS الحالية والأنظمة القديمة، مثل 46% من فرق المنتجات أشار إلى ضعف التكامل باعتباره العقبة الرئيسية أمام تبني الذكاء الاصطناعي. تضمن المنصة التي تبسط التعقيد بدلاً من الإضافة إليه أن فريقك يمكنه التركيز على قيادة الابتكار وتقديم نتائج أعمال ذات مغزى.

توفر منصات سير العمل بالذكاء الاصطناعي طريقة ذكية لخفض النفقات من خلال الجمع بين الأدوات والنماذج وخطوط أنابيب البيانات معًا في نظام واحد موحد للدفع أولاً بأول. بدلاً من التوفيق بين التراخيص المتعددة لنماذج الذكاء الاصطناعي المختلفة، يمكن للمستخدمين الوصول إلى أكثر من 35 نموذجًا من خلال منصة واحدة، ويدفعون فقط مقابل قوة الحوسبة التي يستخدمونها بالفعل. يعمل هذا النهج على التخلص من الموارد المهدرة ويضمن عدم وجود سعة خاملة.

من خلال أدوات تتبع التكاليف والحوكمة في الوقت الفعلي، يحصل المستخدمون على شفافية كاملة في إنفاقهم. وبالاقتران مع التشغيل الآلي المدمج، تعمل هذه الميزات على تقليل المهام اليدوية وتساعد على تجنب التكاليف السحابية غير الضرورية. يمكن أن تؤدي هذه الكفاءات معًا إلى توفير التكاليف بما يصل إلى 98% مقارنة بأوجه القصور في إدارة الإعدادات المجزأة والمتعددة البائعين.

تم تصميم Prompts.ai لتبسيط كيفية تعامل الفرق مع نماذج اللغات الكبيرة المتعددة وتنسيقها (LLMs) في بيئة واحدة آمنة. مع إمكانية الوصول إلى أكثر من 35 طرازًا من الدرجة الأولى، بما في ذلك جي بي تي -5، كلود، و جروك-4، يمكن للمستخدمين التبديل بسلاسة بين النماذج أو استخدامها في وقت واحد - كل ذلك دون متاعب إدارة حسابات منفصلة أو واجهات برمجة التطبيقات.

تتضمن المنصة تتبع التكلفة في الوقت الفعلي ونظام ائتماني مرن للدفع أولاً بأول، مما يسهل على الفرق إبقاء النفقات تحت السيطرة مع خفض التكاليف المتعلقة بالذكاء الاصطناعي. يضمن الأمان على مستوى المؤسسة أن تظل البيانات محمية، بينما تعمل أدوات التشغيل الآلي المتكاملة على التخلص من التعقيد في تصميم واختبار ونشر عمليات سير عمل LLM. يوفر Prompts.ai طريقة مبسطة وفعالة للمؤسسات لتعزيز الإنتاجية وتعزيز التعاون في مبادرات الذكاء الاصطناعي الخاصة بها.

تركز منصات سير العمل بالذكاء الاصطناعي بشدة على أمن و الالتزام، تتضمن ميزات مثل التحكم في الوصول المستند إلى الأدوار (RBAC) وسجلات التدقيق التفصيلية وضمانات خصوصية البيانات. تسمح هذه القدرات للمؤسسات بتتبع الأشخاص الذين يتفاعلون مع النماذج، ومتى يفعلون ذلك، والبيانات المتضمنة، مما يضمن المساءلة في كل خطوة.

لحماية المعلومات الحساسة، غالبًا ما تستخدم هذه المنصات التشفير - سواء بالنسبة للبيانات أثناء الراحة أو أثناء النقل - جنبًا إلى جنب مع البيئات المحمية وتدابير تنقية البيانات الآلية. كما أنها تلتزم بالسياسات التنظيمية الصارمة لتنظيم الاتصالات مع مزودي الطرف الثالث، مما يقلل من مخاطر مشاركة البيانات غير المصرح بها. تعمل حواجز الحماية القائمة على السياسات والسجلات التي تمنع التلاعب على تعزيز الامتثال التنظيمي مع تعزيز الشفافية التشغيلية.

تعمل هذه الإجراءات معًا على إنشاء إطار عمل آمن وموثوق، مما يمكّن المؤسسات من توسيع نطاق تدفقات عمل الذكاء الاصطناعي بثقة مع الحفاظ على معايير الخصوصية والامتثال.