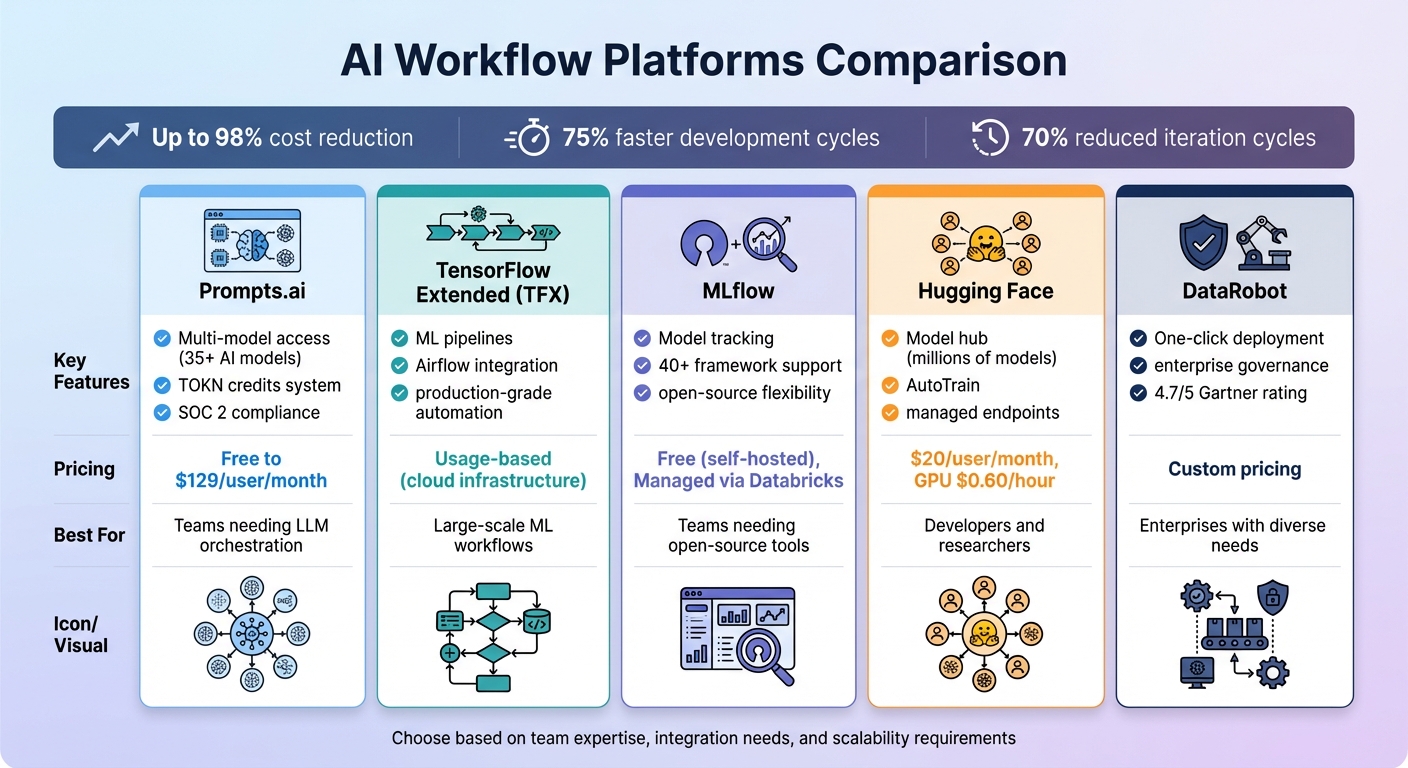

Les entreprises sont submergées par les outils d'IA déconnectés, la hausse des coûts et les risques de sécurité. Les plateformes de flux de travail basées sur l'IA résolvent ce problème en unifiant les outils, en automatisant les tâches et en optimisant les processus. Avec jusqu'à 98 % de réduction des coûts et Cycles de développement 75 % plus rapides, ces plateformes rationalisent les opérations tout en préservant la sécurité et la flexibilité. Vous trouverez ci-dessous cinq plateformes remarquables pour gérer les flux de travail liés à l'IA :

Comparaison rapide:

Chaque plateforme présente des atouts uniques, qu'il s'agisse de réduction des coûts ou d'évolutivité, garantissant ainsi une solution adaptée à tous les défis liés à l'IA.

Comparaison des plateformes de flux de travail IA : fonctionnalités, prix et meilleurs cas d'utilisation

Prompts.ai permet d'accéder à plus de 35 meilleurs modèles d'IA, dont GPT, Claude, LLama et Gémeaux - dans une interface sécurisée et rationalisée. Au lieu de jongler entre plusieurs abonnements et connexions, les équipes peuvent comparer les résultats de différents grands modèles linguistiques côte à côte, ce qui permet d'identifier plus facilement celui qui convient le mieux à des tâches spécifiques. Cette solution tout-en-un élimine la fragmentation souvent causée par l'utilisation d'un trop grand nombre d'outils dans les différents services, ouvrant ainsi la voie à une automatisation, une évolutivité et une collaboration fluides.

Avec Prompts.ai, les utilisateurs ont accès à plus de 35 modèles d'IA sans avoir à gérer des comptes séparés ou à intégrer des API. Ce système unifié permet des demandes simultanées, ce qui permet aux équipes d'évaluer la qualité, la rapidité et la pertinence des différents modèles en temps réel. Les plans d'affaires vont encore plus loin en proposant des flux de travail interopérables, qui permettent aux organisations de créer des processus évolutifs et reproductibles. Par exemple, un modèle peut traiter les demandes des clients, tandis qu'un autre se concentre sur l'analyse des données, le tout au sein du même écosystème.

Prompts.ai transforme les tâches d'IA manuelles et ponctuelles en flux de travail automatisés qui fonctionnent 24 heures sur 24. Ces flux de travail s'intègrent sans effort à des outils tels que Slack, Gmail, et Trello, rationalisant la productivité. Par exemple, Steven Simmons a réduit les semaines de rendu 3D et de rédaction de propositions à une seule journée. De même, l'architecte Ar. June Chow utilise la fonction de comparaison des LLM côte à côte de la plateforme pour expérimenter des concepts de design créatifs et aborder facilement des projets complexes.

Les plans Business de la plateforme incluent des espaces de travail illimités et des options de collaboration, ce qui la rend idéale pour les grandes équipes. Des fonctionnalités telles que TOKN Pooling et Storage Pooling permettent aux équipes de partager les ressources de manière efficace, tandis que la gouvernance centralisée garantit une visibilité et une responsabilité complètes pour toutes les activités d'IA. Prompts.ai a également entamé son processus d'audit SOC 2 de type 2 le 19 juin 2025 et intègre les cadres de conformité de la HIPAA et du RGPD, répondant ainsi aux besoins de sécurité et de protection des données au niveau de l'entreprise. Les équipes peuvent déployer de nouveaux modèles, ajouter des membres et lancer des flux de travail en moins de 10 minutes.

Le système de crédit TOKN de Prompts.ai transforme les dépenses logicielles mensuelles fixes en dépenses flexibles basées sur l'utilisation, aidant ainsi les utilisateurs à optimiser les coûts. La plateforme prétend réduire les dépenses liées à l'IA jusqu'à 98 % en consolidant plus de 35 outils distincts en un seul. Les options tarifaires vont d'un plan Pay As You Go gratuit avec des crédits limités au plan Business Elite à 129$ par membre et par mois, qui comprend 1 000 000 de crédits TOKN et des outils créatifs avancés. Frank Buscemi, PDG et CCO, explique comment la plateforme a rationalisé la création de contenu et automatisé les flux de travail stratégiques, permettant à son équipe de se concentrer sur des projets créatifs de haut niveau plutôt que sur des tâches répétitives.

TensorFlow Extended (TFX) est un plateforme de bout en bout conçue pour déployer des pipelines d'apprentissage automatique (ML) de niveau production, couvrant tout, de la validation des données à la diffusion de modèles. Bien que principalement construit autour de TensorFlow, TFX prend en charge les flux de travail qui incluent d'autres frameworks tels que PyTorch, SciKit Learn, et XG Boost grâce à la conteneurisation. Cette flexibilité permet aux équipes de gérer des projets à structure mixte de manière fluide, en particulier dans des environnements tels que Vertex AI. Sa structure complète ouvre la voie à une automatisation rationalisée dans diverses configurations.

TFX simplifie l'ensemble du cycle de vie du machine learning grâce à son architecture adaptable. Il automatise les flux de travail à l'aide de composants prédéfinis tels que ExampleGen, StatisticsGen, Transform, Trainer, Evaluator et Pusher. Ces composants s'intègrent à des orchestrateurs tels que Flux d'air Apache, Canalisations Kubeflow, et Faisceau Apache, ce qui facilite l'intégration de TFX dans les environnements d'entreprise. Par exemple, en octobre 2023, Spotify ont utilisé TFX et TF-Agents pour simuler les comportements d'écoute à des fins d'apprentissage par renforcement, améliorant ainsi leurs systèmes de recommandation musicale en fonction des interactions avec les utilisateurs. De même, Vodafone a adopté TensorFlow Data Validation (TFDV) en mars 2023 pour superviser la gouvernance des données dans l'ensemble de ses opérations de télécommunications mondiales.

« Lorsque les flux de travail sont définis comme du code, ils deviennent plus faciles à gérer, à versionner, à tester et à collaborer. » - Google Developers

TFX est conçu pour évoluer et utilise Apache Beam pour le traitement distribué des données sur des plateformes telles que Flux de données Google Cloud, Apache Flink, et Apache Spark. Il s'intègre également à des outils d'entreprise tels que Vertex AI Pipelines et Vertex AI Training, permettant aux équipes de traiter des ensembles de données volumineux et d'entraîner des modèles sur plusieurs nœuds grâce à l'accélération GPU. L'écosystème Kubeflow, qui alimente fréquemment les pipelines TFX, a connu une adoption significative, avec plus de 258 millions de téléchargements PyPI et 33 100 étoiles GitHub. En outre, ML Metadata (MLMD) suit le lignage des modèles et les historiques d'exécution des pipelines, en enregistrant automatiquement les artefacts et les paramètres pour garantir la transparence et la traçabilité. Cette évolutivité fait de TFX un outil puissant pour unifier les flux de travail ML complexes au sein d'un système efficace.

TFX aide les entreprises à gérer les coûts en utilisant la mise en cache pour éviter de réexécuter des composants redondants, ce qui permet d'économiser des ressources de calcul lors de la formation itérative. Pour les équipes qui courent sur Google Cloud, les données de facturation peuvent être exportées vers BigQuery, permettant une analyse détaillée des coûts des différents tronçons de pipeline. La conception modulaire de la plateforme offre également de la flexibilité : les équipes peuvent utiliser des bibliothèques autonomes telles que TFDV ou TFT sans déployer l'intégralité du système TFX, en adaptant la plateforme à leurs besoins spécifiques.

MLflow est un outil open source polyvalent qui connecte plus de 40 frameworks d'IA, dont PyTorch, TensorFlow, scikit-learn, IA ouverte, Hugging Face et Chaîne Lang. Dans le cadre du Fondation Linux, il permet aux équipes d'exécuter des flux de travail localement, sur site ou sur les principales plateformes cloud. Avec plus de 20 000 étoiles sur GitHub et plus de 50 millions de téléchargements mensuels, MLflow est devenue une solution largement adoptée pour gérer les flux de travail d'IA. Ses capacités d'intégration sans faille constituent la base de ses fonctionnalités avancées.

MLflow 3 simplifie le suivi des modèles grâce à son URI de modèle unifié (modèles :/<model_id>), en soutenant la gestion du cycle de vie à différentes étapes. Les développeurs peuvent utiliser les API Python, REST, R et Java pour enregistrer les paramètres, les métriques et les artefacts de presque tous les environnements. Pour les flux de travail d'IA générative (GenAI), MLflow s'intègre à plus de 30 outils, dont Anthropique, Gémeaux, Bedrock, Indice de lama, et IA de l'équipage. De plus, ses capacités de traçage s'alignent sur celles d'OpenTelemetry, garantissant que les données d'observabilité de l'IA s'intègrent parfaitement aux systèmes de surveillance d'entreprise existants.

MLflow simplifie la gestion des flux de travail grâce à ses fonctionnalités d'automatisation. Le mlflow.autologie () La fonction et le registre des modèles rationalisent la journalisation des métriques et automatisent les transitions de version de la phase de préparation à la production. Pour les applications GenAI, MLflow capture l'intégralité du processus d'exécution, y compris les invites, les extractions et les appels d'outils, ce qui facilite le débogage automatique des flux de travail.

MLflow favorise l'évolutivité en séparant le Backend Store, qui utilise des bases de données SQL telles que PostgreSQL ou MySQL pour les métadonnées, de l'Artifact Store, qui gère les fichiers volumineux via des services tels qu'Amazon S3, Azure Blob Storage ou Google Cloud Storage. Pour les fichiers de modèles volumineux, les téléchargements partitionnés divisent les artefacts en morceaux de 100 Mo, en contournant le serveur de suivi pour améliorer la vitesse et l'efficacité des téléchargements. Les équipes peuvent déployer des instances du serveur de suivi en « mode artefacts uniquement » et utiliser des requêtes de type SQL pour localiser rapidement les modèles les plus performants, tels que précision des métriques > 0,95.

MLflow est disponible gratuitement sous licence Apache-2.0 pour les déploiements auto-hébergés. Pour ceux qui recherchent une solution gérée, une version gratuite est disponible, avec des options de niveau entreprise proposées via Databricks. Pour gérer efficacement les grands modèles, en permettant MLFLOW_ENABLE_PROXY_MULTIPART_UPLOAD permet des téléchargements directs vers le stockage cloud, réduisant ainsi la charge du serveur et les coûts de calcul. En combinant la gestion unifiée des modèles avec l'automatisation et une infrastructure évolutive, MLflow répond efficacement aux principaux défis des flux de travail d'IA modernes.

Hugging Face sert de plaque tournante pour le développement de l'IA, proposant des millions de modèles, d'ensembles de données et d'applications de démonstration (Spaces). Avec plus de 50 000 organisations à son actif, dont des géants tels que Google, Microsoft, Amazon et Méta - la plateforme met l'accent sur une approche communautaire pour faire progresser l'IA. Comme indiqué dans leur documentation :

« Aucune entreprise, y compris les Tech Titans, ne sera capable de « résoudre l'IA » à elle seule. La seule façon d'y parvenir est de partager les connaissances et les ressources dans le cadre d'une approche centrée sur la communauté ».

Le vaste référentiel de Hugging Face garantit une compatibilité parfaite entre une gamme de modèles d'IA. Bibliothèques clés telles que Transformateurs et Diffuseurs fournir des modèles PyTorch de pointe, tandis que Transformers.js permet l'exécution de modèles directement dans les navigateurs Web. Avec un seul jeton d'API Hugging Face, les utilisateurs ont accès à plus de 45 000 modèles provenant de plus de 10 partenaires d'inférence, dont AWS, Azure et Google Cloud, aux tarifs standard des fournisseurs. La plateforme s'intègre également à des bibliothèques spécialisées telles qu'Asteroid et ESPNet, ainsi qu'à des frameworks LLM largement utilisés tels que LangChain, LLamaIndex et CrewAI. Des outils tels que Optimal améliorer les performances des modèles pour du matériel tel qu'AWS Trainium et Google TPU, tout en GAUCHE (Réglage fin efficace des paramètres) et Accélérez simplifiez la formation sur diverses configurations matérielles.

Hugging Face rationalise le réglage des modèles grâce à sa fonction AutoTrain, qui automatise le processus via des API et une interface conviviale, éliminant ainsi le besoin d'un codage manuel approfondi. Les webhooks au niveau du référentiel permettent aux utilisateurs de déclencher des actions externes lorsque des modèles, des ensembles de données ou des espaces sont mis à jour. Pour le développement d'agents d'IA, le agents anti-fumées La bibliothèque Python permet d'orchestrer des outils et de gérer des tâches complexes. Les points de terminaison d'inférence entièrement gérés simplifient le déploiement de modèles en production, tandis que le framework Hub Jobs automatise et planifie les tâches d'apprentissage automatique via des API ou une interface visuelle. Ensemble, ces outils d'automatisation prennent en charge des flux de travail évolutifs et adaptés à l'entreprise.

Hugging Face propose des fonctionnalités de niveau professionnel telles que Authentification unique (SSO), journaux d'audit et groupes de ressources, permettant aux grandes équipes de collaborer facilement tout en préservant la conformité. La plate-forme utilise la technologie Xet pour un stockage et une gestion des versions efficaces de fichiers volumineux dans des référentiels basés sur Git, rationalisant ainsi la gestion de modèles et de jeux de données étendus. Les équipes peuvent regrouper des comptes, attribuer des rôles granulaires pour le contrôle d'accès et centraliser la facturation pour les ensembles de données, les modèles et les espaces. En outre, la plateforme prend en charge des ensembles de données dans plus de 8 000 langues et fournit des points de terminaison d'inférence entièrement gérés intégrés aux principaux fournisseurs de cloud.

Le plan d'équipe commence à 20$ par utilisateur et par mois, y compris des fonctionnalités telles que le SSO, les journaux d'audit et les groupes de ressources. L'utilisation du GPU est facturée à 0,60$ par heure, et les fournisseurs d'inférence facturent les utilisateurs directement à leurs tarifs standard, sans aucune majoration supplémentaire de la part de Hugging Face. Pour les applications de démonstration, ZeroGPU Spaces alloue dynamiquement les GPU NVIDIA H200 en temps réel, éliminant ainsi le besoin de matériel permanent et coûteux. Une tarification personnalisée est disponible pour les entreprises qui ont besoin d'une sécurité avancée, d'un support dédié et de contrôles d'accès améliorés.

DataRobot est une plateforme d'IA complète conçue pour tout gérer, de l'expérimentation au déploiement en production. Avec une note de 4,7/5 sur Gartner Peer Insights et un taux de recommandation des utilisateurs de 90 %, elle a également été reconnue comme leader dans le Magic Quadrant de Gartner pour les plateformes de science des données et d'apprentissage automatique. La plateforme met l'accent sur l'intégration, l'automatisation et l'évolutivité, ce qui permet de naviguer plus facilement dans la complexité des flux de travail liés à l'IA. Tom Thomas, vice-président de la stratégie des données, de l'analyse et de l'intelligence d'affaires chez FordDirect, a déclaré :

« Ce que nous trouvons vraiment précieux avec DataRobot, c'est le temps de rentabilisation. DataRobot nous aide à déployer des solutions d'IA sur le marché en deux fois moins de temps qu'auparavant. »

Le registre indépendant des modèles de DataRobot fournit une gestion centralisée des packages de modèles provenant de n'importe quelle source. Il prend en charge les grands modèles de langage (LLM) et les modèles de langage restreint (SLM) open source et propriétaires, quel que soit le fournisseur. Avec des intégrations natives pour des plateformes telles que Flocon de neige, AWS, Azure et Google Cloud, la plateforme garantit des connexions fluides avec les technologies existantes. Son interface utilisateur NextGen offre une flexibilité à la fois pour le développement et la gouvernance, permettant aux utilisateurs de basculer entre une interface graphique et des outils de programmation tels que l'API REST ou les packages clients Python. Cette intégration transparente ouvre la voie à une automatisation avancée des futurs flux de travail.

DataRobot simplifie le passage du développement à la production grâce à un déploiement en un clic, à la création de points de terminaison d'API et à la configuration automatique de la surveillance. Son orchestration informatique dynamique élimine les tracas liés à la gestion manuelle des serveurs : les utilisateurs spécifient leurs besoins en matière de calcul et le système se charge du provisionnement et de la répartition de la charge de travail. Ben DuBois, directeur de l'analyse des données chez Norfolk Iron & Metal, a souligné ses avantages :

« Le principal avantage que DataRobot apporte à mon équipe est la capacité d'itérer rapidement. Nous pouvons essayer de nouvelles choses, les mettre en production rapidement. Cette flexibilité est essentielle, en particulier lorsque vous travaillez avec des systèmes existants. »

La plateforme génère également automatiquement des documents de conformité, en tenant compte de la gouvernance des modèles et des normes réglementaires. Les conteneurs « Use Case » permettent de garder les projets organisés et prêts pour les audits, garantissant ainsi que les flux de travail restent structurés dans les environnements de l'entreprise.

DataRobot facilite la gestion d'un large éventail de modèles, allant de dizaines à des centaines, via un système centralisé. Il prend en charge le déploiement sur des infrastructures SaaS, VPC ou sur site gérées. Par exemple, une société énergétique mondiale a réalisé un retour sur investissement de 200 millions de dollars dans plus de 600 cas d'utilisation de l'IA, tandis qu'une des cinq plus grandes banques mondiales a enregistré un retour sur investissement de 70 millions de dollars grâce à plus de 40 applications d'IA au sein de l'organisation. Thibaut Joncquez, directeur de la science des données chez Turo, a souligné les capacités de standardisation de la plateforme :

« Rien d'autre n'est aussi intégré, facile à utiliser, standardisé et tout-en-un que DataRobot. DataRobot nous a fourni un cadre structuré pour garantir que tout le monde applique les mêmes normes. »

La plateforme réunit diverses équipes (data scientists, développeurs, informatique et InfoSec) en proposant à la fois des outils visuels et des interfaces programmatiques. Ses « accélérateurs d'IA » préfabriqués accélèrent la transition de l'expérimentation à la production. En unifiant les flux de travail, en automatisant les processus complexes et en évoluant sans effort, DataRobot aide les organisations à mettre en place facilement des fonctionnalités d'IA de niveau entreprise.

Les plateformes de flux de travail basées sur l'IA redéfinissent la façon dont les entreprises passent d'expériences isolées à des systèmes pleinement opérationnels. En adoptant la bonne plateforme, les entreprises peuvent considérablement accélérer les cycles de développement. Certains signalent qu'ils ont réduit le temps nécessaire à la création de flux de travail pour les agences en 75 % et en réduisant les cycles d'itération en 70 % avec des plateformes d'IA dédiées. Ces gains d'efficacité permettent d'accélérer les lancements et d'améliorer le retour sur investissement.

La clé de ces avancées réside dans trois avantages principaux : interopérabilité, automatisation, et évolutivité. Les plateformes qui s'intègrent à différents modèles et aux technologies existantes évitent la dépendance vis-à-vis des fournisseurs et l'imprévisibilité des coûts. Les couches d'orchestration garantissent la fiabilité du système et rationalisent les processus de restauration, permettant aux équipes de se concentrer sur leurs objectifs principaux. Pour les équipes interservices, des outils tels que des espaces de travail partagés et des créateurs visuels aident à combler le fossé entre les utilisateurs techniques et non techniques, tandis que les fonctionnalités de gouvernance, telles que les pistes d'audit et les contrôles d'accès basés sur les rôles, garantissent la sécurité et la conformité des flux de travail.

Il est essentiel de choisir la bonne plateforme pour tirer parti de ces avantages. Optez pour des solutions qui correspondent à l'expertise de votre équipe, offrant des interfaces sans code pour les utilisateurs non techniques et des options pilotées par API pour les développeurs. Recherchez des plateformes dotées de fonctionnalités d'observabilité robustes, telles que des traces au niveau des nœuds, des indicateurs de coûts et des journaux consultables, afin d'identifier et de résoudre rapidement les problèmes de production. Les organisations qui tirent parti de partenariats externes ou d'outils d'IA spécialisés à faible code ont constaté deux fois plus de taux de réussite en faisant passer des projets pilotes à la production par rapport à ceux qui ne reposent que sur des ressources internes.

Les chiffres parlent d'eux-mêmes : rapport sur les entreprises utilisant l'automatisation de l'IA productivité jusqu'à 35 % supérieure et 25 à 50 % d'économies. Comme l'explique Andres Garcia, directeur de la technologie :

« En tant que directeur technique, investir dans une automatisation éprouvée permet aux équipes d'innover. Je ne veux pas que mon équipe établisse des connexions, surveille ou enregistre alors qu'une infrastructure est déjà en place. »

Commencez par des tâches répétitives et volumineuses, telles que l'enrichissement des données, pour obtenir des résultats rapides. Assurez-vous que la plateforme s'intègre parfaitement à vos systèmes SaaS et existants, car 46 % des équipes produit citent la faible intégration comme le principal obstacle à l'adoption de l'IA. Une plateforme qui simplifie la complexité au lieu d'y ajouter permet à votre équipe de se concentrer sur l'innovation et l'obtention de résultats commerciaux significatifs.

Les plateformes de flux de travail basées sur l'IA offrent un moyen intelligent de réduire les dépenses en regroupant des outils, des modèles et des pipelines de données dans un système unifié de paiement à l'utilisation. Au lieu de jongler entre plusieurs licences pour différents modèles d'IA, les utilisateurs ont accès à plus de 35 modèles via une seule plateforme, en ne payant que pour la puissance informatique qu'ils utilisent réellement. Cette approche élimine le gaspillage des ressources et garantit qu'aucune capacité ne reste inactive.

Grâce à des outils de suivi des coûts et de gouvernance en temps réel, les utilisateurs bénéficient d'une transparence totale sur leurs dépenses. Associées à l'automatisation intégrée, ces fonctionnalités minimisent les tâches manuelles et permettent d'éviter des coûts inutiles liés au cloud. Ensemble, ces gains d'efficacité peuvent permettre de réaliser des économies allant jusqu'à 98 % par rapport à l'inefficacité liée à la gestion de configurations fragmentées et multifournisseurs.

Prompts.ai est conçu pour simplifier la façon dont les équipes gèrent et coordonnent plusieurs grands modèles de langage (LLM) au sein d'un environnement sécurisé unique. Avec un accès à plus de 35 modèles haut de gamme, dont GPT-5, Claude, et Grok-4, les utilisateurs peuvent facilement passer d'un modèle à l'autre ou les utiliser simultanément, sans avoir à gérer des comptes ou des API distincts.

La plateforme comprend suivi des coûts en temps réel et un système de crédit flexible par répartition, qui permet aux équipes de contrôler plus facilement leurs dépenses tout en réduisant les coûts liés à l'IA. La sécurité au niveau de l'entreprise garantit la protection des données, tandis que les outils d'automatisation intégrés simplifient la conception, les tests et le déploiement des flux de travail LLM. Prompts.ai offre aux entreprises un moyen rationalisé et efficace d'améliorer leur productivité et de favoriser la collaboration dans le cadre de leurs initiatives d'IA.

Les plateformes de flux de travail basées sur l'IA mettent fortement l'accent sur sécurité et conformité, intégrant des fonctionnalités telles que le contrôle d'accès basé sur les rôles (RBAC), des journaux d'audit détaillés et des garanties de confidentialité des données. Ces fonctionnalités permettent aux organisations de suivre qui interagit avec les modèles, quand ils le font et quelles données sont impliquées, garantissant ainsi la responsabilité à chaque étape.

Pour protéger les informations sensibles, ces plateformes utilisent souvent chiffrement - à la fois pour les données au repos et en transit - ainsi que pour les environnements en bac à sable et les mesures automatisées de nettoyage des données. Ils adhèrent également à des politiques organisationnelles strictes pour réglementer les connexions avec des fournisseurs tiers, minimisant ainsi le risque de partage de données non autorisé. Les garde-corps et les registres d'inviolabilité dictés par des politiques améliorent encore la conformité réglementaire tout en promouvant la transparence opérationnelle.

Ensemble, ces mesures créent un cadre sécurisé et fiable, permettant aux organisations de faire évoluer leurs flux de travail d'IA en toute confiance tout en respectant les normes de confidentialité et de conformité.