Elegir la herramienta adecuada para comparar modelos lingüísticos de gran tamaño (LLMs) es fundamental para equilibrar el rendimiento, el costo y la eficiencia del flujo de trabajo. Con el aumento de los gastos de IA, las empresas necesitan plataformas confiables para evaluar modelos como GPT-4, Claudio, y Géminis. Esta guía desglosa siete herramientas que simplifican la selección de LLM analizando la calidad de la respuesta, los costos y el potencial de integración.

Para reducir costos y administrar varios modelos, Prompts.ai se destaca. Mientras tanto, MLFlow y Controles profundos atienden a los equipos técnicos que requieren un análisis en profundidad. Herramientas más sencillas como Scout LLM y Banco LLM se adaptan a las organizaciones que buscan facilidad de uso. Elija el plataforma que se alinea con sus objetivos, ya sea para ahorrar en gastos o mejorar la precisión de la evaluación de la IA.

Prompts.ai reúne más de 35 LLM líderes en una plataforma segura y unificada. De este modo, elimina la molestia de administrar varias suscripciones y aborda el creciente problema de la proliferación de herramientas de inteligencia artificial al que se enfrentan muchas empresas a medida que amplían sus operaciones de inteligencia artificial.

La plataforma está diseñada para empresas, agencias creativas y laboratorios de investigación de Fortune 500, lo que simplifica la gestión de las relaciones con los proveedores de IA. Con Prompts.ai, los equipos pueden comparar los resultados de los modelos en paralelo sin tener que hacer malabares con varias plataformas ni mantener claves de API independientes para cada proveedor.

Prompts.ai permite a los usuarios realizar comparaciones lado a lado del rendimiento de los modelos en su amplia biblioteca. Al enviar el mismo mensaje a varios modelos, los equipos pueden evaluar las respuestas en función de la precisión, la relevancia y los requisitos específicos de las tareas. Los registros detallados proporcionan un registro de auditoría, lo que ayuda a los usuarios a identificar los modelos con mejor rendimiento para sus necesidades.

La plataforma también incluye flujos de trabajo rápidos prediseñados creados por ingenieros expertos. Estas plantillas sirven como un punto de partida fiable para las tareas empresariales comunes, ya que garantizan resultados consistentes entre los miembros del equipo. Las organizaciones pueden personalizar aún más estos flujos de trabajo para alinearlos con sus necesidades y su marca únicas.

Más allá de las simples comparaciones de texto, Prompts.ai monitorea coherencia de respuesta a lo largo del tiempo. Esta función ayuda a los equipos a identificar cuándo los modelos comienzan a producir resultados inconsistentes para entradas similares, una capacidad fundamental para mantener flujos de trabajo confiables en los entornos de producción.

Estas características sientan las bases para un seguimiento sólido del rendimiento.

Prompts.ai ofrece una vista detallada de las métricas de rendimiento que van más allá de los tiempos de respuesta básicos. Los equipos pueden realizar un seguimiento uso, velocidad y disponibilidad de los tokens en todos los modelos integrados, lo que proporciona información valiosa sobre qué modelos ofrecen los mejores resultados para cargas de trabajo específicas.

La plataforma también analiza los patrones de uso tanto a nivel individual como de equipo, lo que ofrece una imagen más clara de cómo los distintos departamentos están aprovechando los modelos de IA. Este enfoque basado en datos permite a las organizaciones refinar sus estrategias de IA basándose en el uso real y no en suposiciones.

Además, la plataforma mide ganancias de productividad, con sus flujos de trabajo simplificados que generan mejoras notables. Los paneles de rendimiento proporcionan a los administradores métricas clave, lo que les permite supervisar el ROI e identificar las áreas que requieren una mayor optimización.

Además de la calidad y el rendimiento, Prompts.ai garantiza la claridad financiera.

Una característica destacada de Prompts.ai es su Capa FinOps, que ofrece una visibilidad completa de los gastos relacionados con la IA. Al eliminar las suscripciones redundantes y optimizar la selección de modelos en función del rendimiento real, la plataforma reduce significativamente los costos del software de IA.

El Créditos TOKN de pago por uso el sistema reemplaza las tarifas mensuales tradicionales, alineando los costos con el uso real. Las organizaciones solo pagan por los tokens que consumen, lo que facilita la predicción y el control de los gastos. Este modelo es especialmente beneficioso para las empresas con cargas de trabajo de IA fluctuantes o para aquellas que recién comienzan su viaje hacia la IA.

El seguimiento detallado de los costos muestra exactamente cuánto contribuye cada mensaje, proyecto o miembro del equipo a los gastos generales. Este nivel de transparencia ayuda a los equipos financieros a asignar los presupuestos de manera eficaz y permite a los directores de proyectos mantenerse al día. Al vincular el gasto directamente a los resultados empresariales, la plataforma facilita la justificación de las inversiones en IA y la demostración de su valor.

Prompts.ai está diseñado para ofrecer una escalabilidad perfecta. Las organizaciones pueden añada nuevos modelos, usuarios y equipos en cuestión de minutos, evitando procesos prolongados de adquisición e integración. Esta agilidad es esencial para las empresas que necesitan adaptarse rápidamente a la evolución de las demandas o a los últimos avances de la IA.

La plataforma se integra sin problemas con los sistemas empresariales existentes a través de API y webhooks, lo que permite a los equipos incorporar capacidades de IA en sus flujos de trabajo con una interrupción mínima. Su interfaz fácil de usar se adapta tanto a usuarios técnicos como no técnicos, lo que garantiza la accesibilidad para una variedad de funciones y casos de uso.

La escalabilidad también se extiende a la administración de modelos. Cuando hay nuevos LLM disponibles, Prompts.ai los integra rápidamente, lo que brinda a los usuarios acceso a capacidades de inteligencia artificial de vanguardia sin necesidad de establecer relaciones con los proveedores ni de establecer una configuración técnica adicional. Este proceso simplificado mejora el papel de la plataforma en la evaluación integral de la LLM.

Para las empresas, las operaciones de IA seguras y compatibles no son negociables. Prompts.ai ofrece funciones de seguridad de nivel empresarial para proteger los datos confidenciales durante todo el flujo de trabajo de la IA. La plataforma mantiene registros de auditoría para cada interacción, garantizando el cumplimiento de las normativas del sector. Las organizaciones pueden hacer un seguimiento de quién accedió a modelos específicos, qué indicaciones se utilizaron y cómo se aplicaron los resultados.

Las herramientas de gobierno permiten a los administradores definir las políticas de uso, los límites de gasto y los controles de acceso de forma granular. Estos controles permiten a las organizaciones aplicar prácticas de IA coherentes en todos los equipos y, al mismo tiempo, preservar la flexibilidad necesaria para la experimentación y la innovación.

Este sólido marco de seguridad permite a las empresas aprovechar las capacidades avanzadas de inteligencia artificial sin comprometer la privacidad de los datos ni los estándares de cumplimiento.

Deepchecks prioriza la protección de los datos confidenciales mediante medidas avanzadas como la anonimización (mediante enmascaramiento y seudonimización) y un cifrado sólido tanto para los datos almacenados como para los datos en tránsito. Estas medidas de seguridad están diseñadas para evitar el acceso no autorizado y las posibles infracciones.

Para garantizar aún más la seguridad de los datos, Deepchecks implementa controles de acceso basados en roles, restringiendo la visibilidad de los datos solo a quienes la necesitan. Se llevan a cabo auditorías periódicas para mantener el cumplimiento, descubrir posibles vulnerabilidades y mantener la seguridad del sistema. Además, Deepchecks aconseja crear un plan detallado de respuesta a los incidentes para abordar de forma rápida y eficaz cualquier infracción que pueda producirse. En conjunto, estas medidas no solo protegen la información crítica, sino que también refuerzan la confiabilidad de las evaluaciones de los modelos.

Este compromiso con una protección de datos rigurosa diferencia a Deepchecks de otras herramientas en el ámbito de la comparación de LLM.

LLMBench revela muy poco sobre sus metodologías y especificaciones, lo que deja muchos aspectos inciertos. A continuación, exploramos las áreas clave de LLMBench basándonos en la limitada información disponible.

Los detalles sobre cómo LLMBench evalúa el rendimiento son escasos. No proporciona puntos de referencia claros ni estándares de medición estructurados, lo que dificulta la evaluación de su marco de evaluación.

La plataforma no ofrece información sustancial sobre cómo se integra con los flujos de trabajo de IA o si puede gestionar evaluaciones de gran volumen a nivel empresarial. Esta falta de claridad plantea dudas sobre su adaptabilidad para operaciones a gran escala.

La información sobre las medidas de seguridad y las prácticas de gobierno de LLMBench es igualmente limitada. Es posible que los posibles usuarios deban realizar consultas adicionales para asegurarse de que cumple con los requisitos de protección de datos y cumplimiento.

La falta de transparencia de la plataforma la diferencia de otras, lo que destaca la importancia de una evaluación exhaustiva antes de considerar LLMBench para su flujo de trabajo.

MLFlow proporciona una solución de código abierto para el seguimiento de los experimentos y la gestión del ciclo de vida del aprendizaje automático, lo que la convierte en una herramienta valiosa para evaluar modelos lingüísticos de gran tamaño (LLM). Desarrollado originalmente por Ladrillos de datos, MLFlow simplifica el proceso de registro de experimentos, gestión de modelos y comparación de los resultados en varios sistemas de IA. Su diseño adaptable permite a los usuarios registrar métricas personalizadas y realizar un seguimiento detallado de los experimentos, lo que lo convierte en una opción práctica para evaluar los resultados de la LLM. Al ofrecer sólidas capacidades de seguimiento e integración, MLflow garantiza un enfoque más simplificado para comparar el rendimiento de la LLM.

MLFlow ofrece un marco claro para registrar y evaluar las métricas de rendimiento. Las medidas estándar, como las puntuaciones BLEU, las métricas ROUGE y los valores de perplejidad para las tareas de generación de texto, se pueden registrar fácilmente. Además, los usuarios pueden definir funciones de evaluación personalizadas para evaluar cualidades específicas, como la precisión de los hechos o la relevancia de la respuesta. La función de seguimiento de experimentos de la plataforma permite a los equipos registrar las métricas de varias ejecuciones de modelos, lo que resulta especialmente útil a la hora de probar varias estrategias rápidas. Estas métricas detalladas se integran sin problemas en los flujos de trabajo existentes y permiten realizar evaluaciones exhaustivas.

MLFlow está diseñado para funcionar sin problemas con los marcos de aprendizaje automático más populares, que incluyen TensorFlow, PyTorch, y Transformers Huggging Face, a través de su API REST y su SDK de Python. También es compatible con entornos de computación distribuidos como Apache Spark y Kubernetes, lo que lo hace idóneo para evaluaciones a gran escala. Para uso empresarial, el registro de modelos de MLFlow simplifica el control de versiones y la administración central de las diferentes implementaciones de modelos, lo que permite a los equipos realizar un seguimiento del rendimiento a lo largo del tiempo. Esta escalabilidad garantiza evaluaciones eficientes y, al mismo tiempo, mantiene la compatibilidad con las infraestructuras empresariales.

La seguridad empresarial es un enfoque clave para MLFlow, que incorpora controles de acceso basados en roles y registros de auditoría para cumplir con los requisitos de la organización. La plataforma se integra con los sistemas de autenticación existentes, como LDAP y OAuth, lo que garantiza la alineación con las políticas de seguridad.

MLFlow también apoya la gobernanza de modelos mediante el seguimiento del linaje y el mantenimiento de un historial de desarrollo de modelos. Esta transparencia es fundamental para el cumplimiento, ya que ofrece información clara sobre cómo se generan y validan los resultados de la LLM. Además, la flexibilidad de implementación de MLFlow permite a las organizaciones realizar evaluaciones completamente en su propia infraestructura, lo que aborda las preocupaciones sobre la privacidad de los datos y el manejo de la información confidencial.

La herramienta de comparación de modelos Scout LLM está diseñada para evaluar los resultados de los modelos lingüísticos en una variedad de casos de uso, diseñados específicamente para las necesidades empresariales. Permite a las organizaciones tomar decisiones informadas al analizar qué modelos son los más adecuados para tareas específicas. Con un fuerte enfoque en transparencia en la evaluación, Scout ofrece funciones de generación de informes detalladas que benefician tanto a los equipos técnicos como a las partes interesadas de la empresa, lo que facilita la comprensión de las diferencias en el rendimiento del modelo. Si bien la transparencia era un objetivo compartido con las herramientas anteriores, Scout destaca por su análisis detallado de los costos y el rendimiento.

Scout va más allá de las métricas convencionales a la hora de evaluar la calidad de la producción. Evalúa factores como la coherencia de las respuestas, la precisión de los hechos y la relevancia contextual mediante sistemas de puntuación automatizados, que se mejoran aún más con las revisiones humanas. Una característica clave es su análisis de similitud semántica, que mide en qué medida los resultados del modelo se alinean con los resultados esperados en varios dominios.

La herramienta desglosa la información de calidad para identificar dónde los modelos sobresalen o no. Para tareas como la creación de contenido, Scout evalúa la creatividad, la coherencia del tono y el cumplimiento de las pautas de estilo. Para las tareas analíticas, examina el razonamiento lógico, la precisión de la interpretación de los datos y la validez de las conclusiones. Estas evaluaciones detalladas brindan a los equipos una comprensión clara de las fortalezas y debilidades de cada modelo, no solo del rendimiento general.

Scout cuenta con un panel de métricas que rastrea los indicadores de rendimiento estándar y personalizados. Calcula automáticamente las métricas de PNL más utilizadas, como las puntuaciones de BLEU, ROUGE y F1, a la vez que se adapta a las necesidades de evaluación específicas de cada dominio. Además de esto, Scout monitorea los tiempos de respuesta, el consumo de fichas y el uso de recursos computacionales.

La plataforma incorpora pruebas de significación estadística para garantizar que las diferencias de rendimiento observadas entre los modelos sean significativas y no aleatorias. Con el análisis de tendencias, Scout destaca los cambios en el rendimiento a lo largo del tiempo, lo que ayuda a los equipos a identificar los patrones de mejora o degradación. Además, proporciona información sobre la eficiencia del modelo y ofrece una visión completa del rendimiento.

Las herramientas de análisis de costos de Scout ofrecen una visión clara de las implicaciones financieras vinculadas al uso del modelo. Realiza un seguimiento del consumo de tokens, la frecuencia de las llamadas a la API y los costos asociados, lo que permite a las organizaciones evaluar el impacto económico de sus elecciones. Las proyecciones de costos ayudan a estimar los gastos para escalar las implementaciones en función del uso actual.

La plataforma incluye herramientas de presupuestación que permiten a los equipos establecer límites de gasto y recibir alertas cuando el uso se acerca a estos umbrales. Scout también ofrece recomendaciones para la optimización de costos mediante el análisis de la relación rendimiento-precio en diferentes modelos.

Scout se integra sin esfuerzo con flujos de trabajo de desarrollo existentes a través de su API REST y su compatibilidad con SDK para lenguajes de programación populares. Se conecta con los principales proveedores de nube y plataformas de alojamiento modelo, lo que permite realizar evaluaciones independientemente del lugar de implementación. La integración con las canalizaciones de CI/CD permite integrar directamente las comparaciones automatizadas de modelos en los procesos de desarrollo.

Es arquitectura escalable admite evaluaciones simultáneas de varios modelos y conjuntos de datos. Con el procesamiento distribuido, Scout reduce el tiempo necesario para realizar comparaciones a gran escala. Puede gestionar entradas de datos estructurados y no estructurados, lo que lo hace altamente adaptable a diversas necesidades de evaluación. Esta sólida integración se complementa con estrictas funciones de seguridad.

Scout garantiza una seguridad de nivel empresarial con un cifrado de extremo a extremo para los datos tanto en tránsito como en reposo. Admite la integración del inicio de sesión único con los sistemas de identidad corporativos y proporciona registros de auditoría para todas las actividades de evaluación. Los controles de acceso basados en funciones restringen los datos y resultados confidenciales únicamente al personal autorizado.

El marco de gobierno de la plataforma incluye seguimiento del cumplimiento para ayudar a las organizaciones a cumplir los requisitos normativos de evaluación y documentación de la IA. Scout mantiene registros detallados de las metodologías, las fuentes de datos y los resultados, lo que garantiza la transparencia y la responsabilidad en la selección de modelos. Además, sus opciones de residencia de datos permiten a las organizaciones almacenar los datos de evaluación en regiones geográficas específicas o en una infraestructura local, abordando así los problemas de soberanía de los datos de manera eficaz.

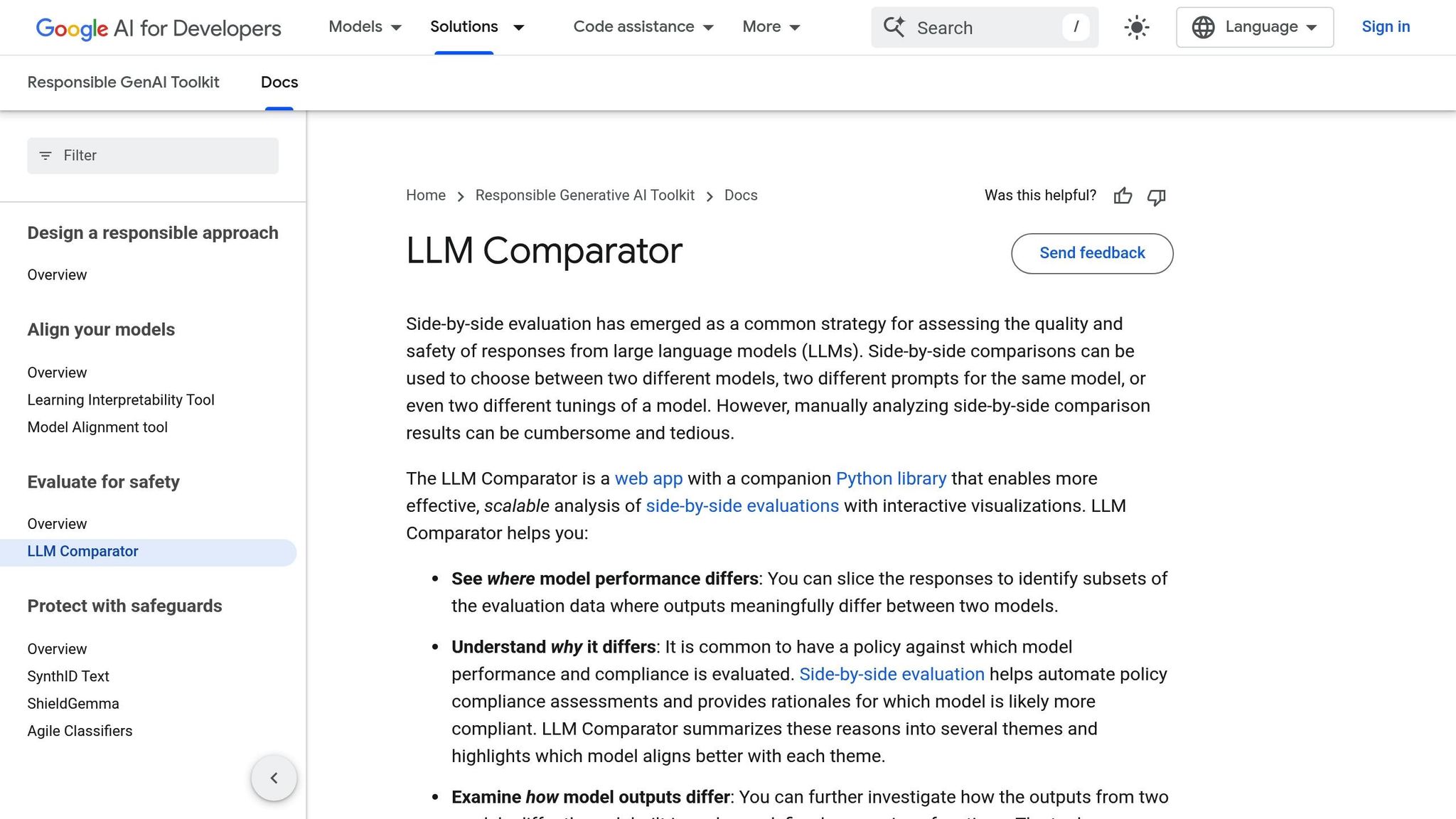

El comparador PAIR LLM simplifica el proceso de evaluación de los modelos lingüísticos, ofreciendo a los desarrolladores una herramienta eficiente y fácil de usar. Este sistema se integra directamente en los flujos de trabajo de la IA, lo que garantiza un funcionamiento sin problemas. En esencia, se encuentra una biblioteca de Python (comparador llm, disponible en PyPI) que funciona con entradas JSON estandarizadas. Esto permite a los usuarios cargar los resultados de su evaluación para una visualización y un análisis detallados.

La herramienta ofrece dos opciones principales: los usuarios pueden crear un archivo JSON completo con comparaciones de modelos en paralelo y clústeres de fundamentos agrupados o centrarse en los fundamentos de agrupamiento a partir de los resultados existentes. Esta flexibilidad facilita la realización de evaluaciones exhaustivas y escalables de los modelos lingüísticos, adaptándose a las diferentes necesidades de los proyectos.

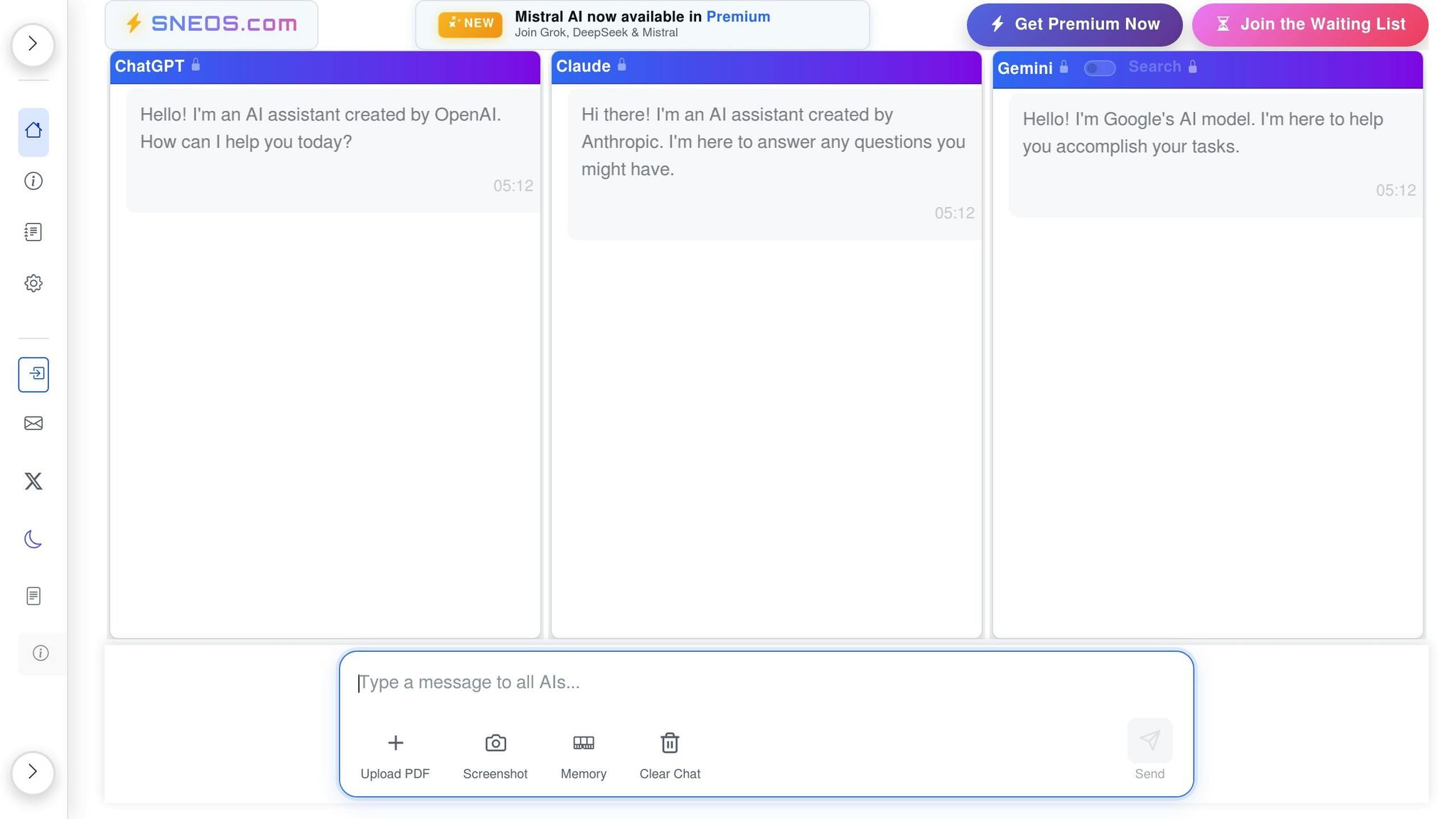

SNEOS no parece funcionar como una herramienta dedicada para comparar las salidas de LLM. Su falta de funciones y capacidades documentadas crea desafíos a la hora de evaluarlo junto con herramientas más establecidas.

No hay ninguna metodología publicada ni datos de SNEOS sobre cómo mide la calidad de los resultados del LLM. Por el contrario, los marcos ampliamente reconocidos se basan en métricas como las puntuaciones BLEU, las métricas ROUGE y las clasificaciones de preferencias humanas para evaluar el rendimiento. Sin esa información, resulta difícil evaluar la forma en que SNEOS gestiona la evaluación de la calidad o comparar su eficacia con otras herramientas que proporcionan un análisis detallado.

SNEOS no proporciona ninguna métrica de rendimiento, por lo que sus capacidades de evaluación son ambiguas. La ausencia de esta información hace que no quede claro qué tan bien funciona la herramienta ni si puede satisfacer las necesidades de los usuarios que buscan puntos de referencia confiables.

SNEOS no ofrece ninguna documentación técnica relacionada con la integración o la escalabilidad. Las plataformas establecidas suelen proporcionar acceso a las API, compatibilidad con varios formatos de modelos y una integración fluida en los flujos de trabajo existentes, todo lo cual es fundamental para gestionar operaciones a gran escala. Sin detalles similares, es imposible determinar si SNEOS puede satisfacer las demandas de nivel empresarial.

En comparación con las plataformas más transparentes y ricas en funciones analizadas anteriormente, la documentación limitada de SNEOS destaca la importancia de proporcionar información clara y detallada para una evaluación eficaz de la LLM.

Para complementar las revisiones detalladas de cada herramienta, he aquí una comparación concisa de sus puntos fuertes y desafíos. Cada herramienta ofrece distintos beneficios y desventajas, lo que las hace adecuadas para diferentes necesidades.

Prompts.ai ofrece un enfoque altamente eficiente para administrar los modelos y reducir los costos. Su capacidad para reducir los gastos de inteligencia artificial hasta en un 98% a través de una interfaz unificada supone un punto de inflexión para las organizaciones que tienen que hacer malabares con varias suscripciones de LLM. Además, es de pago por uso TOKEN El sistema de crédito elimina las tarifas recurrentes, ofreciendo flexibilidad y control de costos.

Controles profundos destaca por su capacidad de ofrecer una validación exhaustiva adaptada a los flujos de trabajo de aprendizaje automático. Se destaca en la detección de desviaciones de datos y en la supervisión del rendimiento de los modelos, a la vez que se integra perfectamente con las canalizaciones de MLOps existentes. Sin embargo, su pronunciada curva de aprendizaje y la necesidad de conocimientos técnicos pueden ser un obstáculo para algunos usuarios.

Banco LLM es ideal para equipos nuevos en las evaluaciones de LLM, gracias a su sencilla configuración de evaluación comparativa y a sus pruebas estándar. Proporciona un entorno de pruebas uniforme en todos los modelos, pero es posible que sus limitadas opciones de personalización no satisfagan a las organizaciones con necesidades de evaluación más especializadas.

MLFlow destaca por sus sólidas capacidades de seguimiento de experimentos y control de versiones de modelos. Como plataforma de código abierto, es una opción rentable para quienes cuentan con los recursos técnicos necesarios para gestionar la implementación y el mantenimiento. Sin embargo, sus amplios requisitos de configuración y mantenimiento pueden ser un inconveniente.

Herramienta de comparación de modelos Scout LLM prioriza la facilidad de uso con una interfaz fácil de usar y una configuración rápida. Sus potentes herramientas de visualización permiten comparar modelos en paralelo, pero es posible que carezca de la profundidad analítica y la escalabilidad necesarias para las operaciones de nivel empresarial.

Comparador PAIR LLM se centra en la evaluación ética de la IA, incorporando métricas de equidad y detección de sesgos. Esto la convierte en una opción valiosa para las organizaciones comprometidas con el despliegue responsable de la IA. Sin embargo, su enfoque más limitado puede requerir herramientas adicionales para un análisis de rendimiento más completo.

SNEOS enfrenta desafíos debido a la falta de documentación clara y características opacas. Sin metodologías transparentes o métricas de rendimiento establecidas, es difícil medir su eficacia o integrarla con confianza en los flujos de trabajo.

Esta es una vista resumida de las principales fortalezas, desafíos, claridad de costos y facilidad de integración de cada herramienta:

Esta descripción general proporciona una instantánea clara de las capacidades de cada herramienta, lo que le ayuda a alinear sus funciones con las prioridades de evaluación de la IA de su organización. Elige la que mejor se adapte a tus requisitos específicos.

La elección de la herramienta de comparación de resultados de LLM adecuada depende de alinear las características de la plataforma con las prioridades y los requisitos técnicos de su organización. Con muchas opciones disponibles, es crucial identificar qué es lo que mejor apoya tus objetivos en la evaluación y la gestión de la IA.

Para las organizaciones que se centran en reducir los costos y garantizar la seguridad a nivel empresarial, Prompts.ai ofrece una solución convincente. Al consolidar el acceso a más de 35 modelos dentro de una interfaz segura, elimina la necesidad de múltiples suscripciones y puede reducir los costos hasta en un 98%. Este enfoque simplificado garantiza el cumplimiento y la seguridad sin comprometer la funcionalidad.

Lo que diferencia a Prompts.ai es su capacidad para simplificar los flujos de trabajo y, al mismo tiempo, ofrecer resultados excepcionales. Como compartió un profesional del sector:

«Un arquitecto que combinaba la inteligencia artificial con una visión creativa, alguna vez tuvo que confiar en procesos de redacción que consumían mucho tiempo. Ahora, al comparar diferentes tipos de LLM en prompts.ai, puede dar vida a proyectos complejos y, al mismo tiempo, explorar conceptos innovadores y oníricos».

- Ar. June Chow, arquitecta

Sin embargo, las diferentes necesidades requieren herramientas diferentes. Para las organizaciones que hacen hincapié en la profundidad técnica y la personalización, plataformas como MLFlow ofrecen un seguimiento sólido de los experimentos, mientras Controles profundos proporciona flujos de trabajo de validación detallados. Estas opciones están dirigidas a equipos con experiencia técnica avanzada que buscan capacidades de evaluación granulares.

Para los equipos que buscan simplicidad o una implementación rápida, Banco LLM y Scout LLM ofrecen configuraciones fáciles de usar, lo que las hace ideales para los recién llegados a la evaluación de LLM. Además, las empresas que priorizan las prácticas responsables de inteligencia artificial pueden beneficiarse de Comparador PAIR LLM, que se centra en la detección de sesgos y las métricas de equidad. Dicho esto, es posible que se necesiten herramientas adicionales para un análisis integral del desempeño.

En última instancia, factores como la rentabilidad, el seguimiento del rendimiento y las capacidades de integración deben guiar su decisión. Tenga en cuenta qué tan bien se integra una herramienta con sus sistemas existentes, su facilidad de mantenimiento y su escalabilidad. Al seleccionar la plataforma adecuada, puede pasar de experimentos dispersos a procesos seguros y repetibles que ofrecen un valor constante.

Prompts.ai ofrece a las empresas una forma más inteligente de gestionar los gastos de software de IA con un plataforma centralizada que integra más de 35 modelos de IA. Utilizando precios transparentes de pago por uso impulsado por créditos TOKN, este sistema puede reducir los costos hasta en un 98%, haciendo que las herramientas avanzadas de inteligencia artificial sean asequibles y accesibles.

Las funciones clave, como el monitoreo en tiempo real, el seguimiento de costos y el control rápido de versiones, permiten a los usuarios: afinar su uso de la IA, elimine el despilfarro de gastos y simplifique los flujos de trabajo. Estas capacidades ayudan a las organizaciones a reducir los gastos operativos y, al mismo tiempo, garantizan que sus proyectos de IA sigan siendo eficientes y escalables.

Prompts.ai pone un gran énfasis en la protección de los datos y el cumplimiento de los requisitos de cumplimiento mediante el empleo de medidas como control de acceso basado en funciones (RBAC), monitoreo en tiempo real, y el estricto cumplimiento de las normas de privacidad, como GDPR y HIPAA. Estas medidas de seguridad están diseñadas para proteger la información confidencial y, al mismo tiempo, garantizar que las organizaciones cumplan con los mandatos reglamentarios.

Para mejorar aún más la seguridad, Prompts.ai integra herramientas de gobernanza de IA que promueven la gestión responsable de los datos y agilizan los flujos de trabajo, todo ello sin sacrificar la privacidad del usuario. Esta estrategia exhaustiva ayuda a las organizaciones a gestionar con confianza sus iniciativas impulsadas por la inteligencia artificial.

Prompts.ai refuerza la fiabilidad y la coherencia de los flujos de trabajo de IA con herramientas avanzadas de comparación de resultados. Estas herramientas permiten a los usuarios evaluar diferentes modelos y detectar variaciones en paralelo, lo que simplifica el proceso de identificar las configuraciones que ofrecen los resultados más estables y predecibles.

La plataforma también refuerza la confiabilidad del flujo de trabajo a través de funciones como herramientas de gobierno, pistas de auditoría y sistemas de control de versiones. Estos elementos promueven el cumplimiento, mejoran la transparencia y facilitan la gestión de los proyectos de IA, lo que permite a los equipos ofrecer mejores resultados con seguridad.