Choisir le bon outil pour comparer de grands modèles de langage (LLMs) est essentiel pour équilibrer les performances, les coûts et l'efficacité du flux de travail. Face à l'augmentation des dépenses liées à l'IA, les entreprises ont besoin de plateformes fiables pour évaluer des modèles tels que GPT-4, Claude, et Gémeaux. Ce guide présente sept outils qui simplifient la sélection du LLM en analysant la qualité des réponses, les coûts et le potentiel d'intégration.

Pour réduire les coûts et gérer plusieurs modèles, Prompts.ai se démarque. Entre-temps, Débit ML et Contrôles approfondis répondre aux besoins des équipes techniques nécessitant une analyse approfondie. Des outils plus simples tels que Scout LLM et Banc LLM convient aux organisations qui recherchent la facilité d'utilisation. Choisissez le une plateforme qui correspond à vos objectifs, qu'il s'agisse de réduire les dépenses ou d'améliorer la précision des évaluations de l'IA.

Prompts.ai réunit plus de 35 LLM de premier plan en une seule plateforme sécurisée et unifiée. Ce faisant, il élimine les tracas liés à la gestion de plusieurs abonnements et s'attaque au problème croissant de la prolifération des outils d'IA auquel de nombreuses entreprises sont confrontées lorsqu'elles développent leurs activités d'IA.

La plateforme est conçue pour les entreprises du Fortune 500, les agences de création et les laboratoires de recherche, simplifiant la gestion des relations avec les fournisseurs d'IA. Avec Prompts.ai, les équipes peuvent comparer les résultats des modèles côte à côte sans avoir à jongler avec différentes plateformes ou à gérer des clés d'API distinctes pour chaque fournisseur.

Prompts.ai permet aux utilisateurs de mener comparaisons côte à côte des performances des modèles dans sa vaste bibliothèque. En soumettant la même invite à plusieurs modèles, les équipes peuvent évaluer les réponses en fonction de la précision, de la pertinence et des exigences spécifiques des tâches. Les journaux détaillés fournissent une piste d'audit, aidant les utilisateurs à identifier les modèles les plus performants pour leurs besoins.

La plateforme comprend également flux de travail rapides prédéfinis créés par des ingénieurs experts. Ces modèles constituent un point de départ fiable pour les tâches commerciales courantes, garantissant des résultats cohérents entre les membres de l'équipe. Les organisations peuvent personnaliser davantage ces flux de travail pour les adapter à leurs besoins uniques et à leur image de marque.

Au-delà de simples comparaisons de textes, Prompts.ai surveille cohérence de la réponse au fil du temps. Cette fonctionnalité permet aux équipes d'identifier à quel moment les modèles commencent à produire des résultats incohérents pour des entrées similaires, une fonctionnalité essentielle pour maintenir des flux de travail fiables dans les environnements de production.

Ces fonctionnalités jettent les bases d'un suivi robuste des performances.

Prompts.ai offre une vue détaillée des indicateurs de performance qui vont au-delà des temps de réponse de base. Les équipes peuvent suivre utilisation, vitesse et disponibilité des jetons sur tous les modèles intégrés, fournissant des informations précieuses sur les modèles qui fournissent les meilleurs résultats pour des charges de travail spécifiques.

La plateforme analyse également les modèles d'utilisation au niveau individuel et au niveau de l'équipe, offrant une image plus claire de la manière dont les différents départements tirent parti des modèles d'IA. Cette approche axée sur les données permet aux organisations d'affiner leurs stratégies d'IA en fonction de l'utilisation réelle plutôt que des hypothèses.

De plus, la plateforme mesure gains de productivité, avec ses flux de travail rationalisés entraînant des améliorations notables. Les tableaux de bord de performance fournissent aux responsables des indicateurs clés, leur permettant de suivre le retour sur investissement et d'identifier les domaines nécessitant une optimisation supplémentaire.

En plus de la qualité et des performances, Prompts.ai garantit la clarté financière.

Une caractéristique remarquable de Prompts.ai est sa couche FinOps, offrant une visibilité complète sur les dépenses liées à l'IA. En éliminant les abonnements redondants et en optimisant la sélection des modèles en fonction des performances réelles, la plateforme réduit considérablement les coûts des logiciels d'IA.

Le Crédits TOKN payables à l'utilisation Le système remplace les frais mensuels traditionnels, en alignant les coûts sur l'utilisation réelle. Les organisations ne paient que pour les jetons qu'elles consomment, ce qui facilite la prévision et le contrôle des dépenses. Ce modèle est particulièrement avantageux pour les entreprises dont la charge de travail en IA fluctue ou celles qui commencent tout juste à se lancer dans l'IA.

Le suivi détaillé des coûts indique exactement dans quelle mesure chaque agent, projet ou membre de l'équipe contribue aux dépenses globales. Ce niveau de transparence aide les équipes financières à allouer les budgets de manière efficace et permet aux chefs de projet de rester sur la bonne voie. En liant directement les dépenses aux résultats commerciaux, la plateforme permet de justifier plus facilement les investissements dans l'IA et de démontrer leur valeur.

Prompts.ai est conçu pour une évolutivité sans faille. Les organisations peuvent ajoutez de nouveaux modèles, utilisateurs et équipes en quelques minutes, en évitant les longs processus d'approvisionnement et d'intégration. Cette agilité est essentielle pour les entreprises qui doivent s'adapter rapidement à l'évolution de la demande ou aux dernières avancées en matière d'IA.

La plateforme s'intègre parfaitement aux systèmes d'entreprise existants via des API et des webhooks, permettant aux équipes d'intégrer des fonctionnalités d'IA dans leurs flux de travail avec un minimum de perturbations. Son interface conviviale convient aux utilisateurs techniques et non techniques, garantissant l'accessibilité pour une variété de rôles et de cas d'utilisation.

L'évolutivité s'étend également à la gestion des modèles. Lorsque de nouveaux LLM sont disponibles, Prompts.ai les intègre rapidement, permettant aux utilisateurs d'accéder à des fonctionnalités d'IA de pointe sans nécessiter de relations avec les fournisseurs ou de configuration technique supplémentaires. Ce processus rationalisé renforce le rôle de la plateforme dans l'évaluation complète du LLM.

Pour les entreprises, des opérations d'IA sécurisées et conformes ne sont pas négociables. Prompts.ai propose des fonctionnalités de sécurité de niveau entreprise pour protéger les données sensibles tout au long du flux de travail de l'IA. La plateforme maintient pistes d'audit pour chaque interaction, en garantissant la conformité aux réglementations du secteur. Les organisations peuvent suivre qui a accédé à des modèles spécifiques, quelles instructions ont été utilisées et comment les résultats ont été appliqués.

Les outils de gouvernance permettent aux administrateurs de définir des politiques d'utilisation, des limites de dépenses et des contrôles d'accès à un niveau granulaire. Ces contrôles permettent aux organisations d'appliquer des pratiques d'IA cohérentes au sein de leurs équipes tout en préservant la flexibilité nécessaire à l'expérimentation et à l'innovation.

Ce cadre de sécurité robuste permet aux entreprises d'exploiter les fonctionnalités avancées de l'IA sans compromettre la confidentialité des données ou les normes de conformité.

Deepchecks donne la priorité à la protection des données sensibles grâce à des mesures avancées telles que l'anonymisation (masquage et pseudonymisation) et un cryptage robuste des données stockées et des données en transit. Ces mesures de protection sont conçues pour empêcher tout accès non autorisé et toute violation potentielle.

Pour garantir davantage la sécurité des données, Deepchecks met en œuvre des contrôles d'accès basés sur les rôles, limitant la visibilité des données aux seules personnes qui en ont besoin. Des audits réguliers sont effectués pour maintenir la conformité, découvrir les vulnérabilités potentielles et garantir la sécurité du système. En outre, Deepchecks conseille de créer un plan détaillé de réponse aux incidents afin de remédier rapidement et efficacement à toute violation susceptible de survenir. Ensemble, ces étapes permettent non seulement de sécuriser les informations critiques, mais également de renforcer la fiabilité des évaluations des modèles.

Cet engagement en faveur d'une protection rigoureuse des données distingue Deepchecks des autres outils de l'espace de comparaison LLM.

LLMbench dévoile très peu de choses sur ses méthodologies et ses spécifications, laissant de nombreux aspects incertains. Ci-dessous, nous explorons les principaux domaines de LLMbench sur la base des informations limitées disponibles.

Les détails sur la façon dont LLMBench évalue les performances sont rares. Il ne fournit pas de points de référence clairs ni de normes de mesure structurées, ce qui rend difficile l'évaluation de son cadre d'évaluation.

La plateforme ne fournit aucune information substantielle sur la manière dont elle s'intègre aux flux de travail d'IA ou sur sa capacité à gérer de gros volumes d'évaluations au niveau de l'entreprise. Ce manque de clarté soulève des questions quant à sa capacité d'adaptation aux opérations à plus grande échelle.

Les informations sur les mesures de sécurité et les pratiques de gouvernance de LLMbench sont également limitées. Les utilisateurs potentiels peuvent avoir besoin de mener des enquêtes supplémentaires pour s'assurer qu'il répond aux exigences de protection des données et de conformité.

Le manque de transparence de la plateforme la distingue des autres, ce qui souligne l'importance d'une évaluation approfondie avant d'envisager LLMBench pour votre flux de travail.

MLflow fournit une solution open source pour le suivi des expériences et la gestion du cycle de vie de l'apprentissage automatique, ce qui en fait un outil précieux pour évaluer les grands modèles de langage (LLM). Développé à l'origine par Databricks, MLflow simplifie le processus d'enregistrement des expériences, de gestion des modèles et de comparaison des résultats entre différents systèmes d'IA. Sa conception adaptable permet aux utilisateurs d'enregistrer des métriques personnalisées et de suivre les expériences en détail, ce qui en fait un choix pratique pour évaluer les résultats LLM. En offrant des fonctionnalités de suivi et d'intégration robustes, MLflow garantit une approche plus rationalisée pour comparer les performances du LLM.

MLflow offre un cadre clair pour la journalisation et l'évaluation des mesures de performance. Les mesures standard telles que les scores BLEU, les métriques ROUGE et les valeurs de perplexité pour les tâches de génération de texte peuvent être facilement enregistrées. En outre, les utilisateurs peuvent définir des fonctions d'évaluation personnalisées pour évaluer des qualités spécifiques telles que l'exactitude factuelle ou la pertinence des réponses. La fonction de suivi des expériences de la plateforme permet aux équipes d'enregistrer des métriques sur plusieurs exécutions de modèles, ce qui est particulièrement utile lors du test de diverses stratégies rapides. Ces mesures détaillées s'intègrent parfaitement aux flux de travail existants, ce qui permet des évaluations complètes.

MLflow est conçu pour fonctionner parfaitement avec les frameworks d'apprentissage automatique les plus courants, notamment TensorFlow, PyTorch, et Transformateurs Hugging Face, via son API REST et son SDK Python. Il prend également en charge les environnements informatiques distribués tels que Apache Spark et Kubernetes, ce qui le rend parfaitement adapté aux évaluations à grande échelle. Pour une utilisation en entreprise, le registre de modèles de MLflow simplifie le contrôle des versions et la gestion centralisée des différentes implémentations de modèles, permettant aux équipes de suivre les performances au fil du temps. Cette évolutivité garantit des évaluations efficaces tout en maintenant la compatibilité avec les infrastructures de l'entreprise.

La sécurité de l'entreprise est au cœur de MLflow, qui intègre des contrôles d'accès basés sur les rôles et une journalisation des audits pour répondre aux exigences de l'organisation. La plateforme s'intègre aux systèmes d'authentification existants, tels que LDAP et OAuth, garantissant ainsi l'alignement avec les politiques de sécurité.

MLflow prend également en charge la gouvernance des modèles en suivant le lignage et en conservant un historique du développement des modèles. Cette transparence est essentielle pour la conformité, car elle offre des informations claires sur la manière dont les sorties LLM sont générées et validées. En outre, la flexibilité de déploiement de MLflow permet aux entreprises d'effectuer des évaluations entièrement sur leur propre infrastructure, répondant ainsi aux préoccupations relatives à la confidentialité des données et au traitement des informations sensibles.

L'outil de comparaison de modèles Scout LLM est conçu pour évaluer les résultats des modèles de langage dans divers cas d'utilisation, spécifiquement adaptés aux besoins des entreprises. Il permet aux organisations de prendre des décisions éclairées en analysant les modèles les mieux adaptés à des tâches spécifiques. En mettant fortement l'accent sur transparence de l'évaluation, Scout propose des fonctionnalités de reporting détaillées qui profitent à la fois aux équipes techniques et aux parties prenantes commerciales, permettant de mieux comprendre les différences de performances des modèles. Alors que la transparence est un objectif partagé avec les outils précédents, Scout se distingue par son analyse détaillée des coûts et des performances.

Scout va au-delà des indicateurs classiques lorsqu'il s'agit d'évaluer la qualité des résultats. Il évalue des facteurs tels que la cohérence des réponses, l'exactitude des faits et la pertinence contextuelle à l'aide de systèmes de notation automatisés, qui sont encore améliorés par des évaluations humaines. L'une de ses principales caractéristiques est son analyse de similarité sémantique, qui mesure dans quelle mesure les résultats du modèle s'alignent sur les résultats attendus dans différents domaines.

L'outil analyse les informations relatives à la qualité pour identifier les domaines dans lesquels les modèles excellent ou échouent. Pour des tâches telles que la création de contenu, Scout évalue la créativité, la cohérence du ton et le respect des directives de style. Pour les tâches analytiques, il examine le raisonnement logique, la précision de l'interprétation des données et la validité des conclusions. Ces évaluations détaillées permettent aux équipes de bien comprendre les forces et les faiblesses de chaque modèle, et pas seulement les performances globales.

Scout dispose d'un tableau de bord des métriques qui permet de suivre à la fois les indicateurs de performance standard et personnalisés. Il calcule automatiquement les métriques PNL les plus utilisées, telles que les scores BLEU, ROUGE et F1, tout en répondant aux besoins d'évaluation spécifiques au domaine. En outre, Scout surveille les temps de réponse, la consommation de jetons et l'utilisation des ressources informatiques.

La plateforme intègre tests de signification statistique pour s'assurer que les différences de performance observées entre les modèles sont significatives et non aléatoires. Grâce à l'analyse des tendances, Scout met en évidence l'évolution des performances au fil du temps, aidant ainsi les équipes à identifier les modèles d'amélioration ou de dégradation. En outre, il fournit des informations sur l'efficacité des modèles, offrant une vision complète des performances.

Les outils d'analyse des coûts de Scout offrent une vision claire des implications financières liées à l'utilisation des modèles. Il suit la consommation de jetons, les fréquences d'appel des API et les coûts associés, permettant aux organisations d'évaluer l'impact économique de leurs choix. Les projections de coûts permettent d'estimer les dépenses liées à la mise à l'échelle des déploiements en fonction de l'utilisation actuelle.

La plateforme inclut des outils de budgétisation qui permettent aux équipes de fixer des limites de dépenses et de recevoir des alertes lorsque l'utilisation approche ces seuils. Scout fournit également des recommandations pour l'optimisation des coûts en analysant les ratios performances/prix de différents modèles.

Scout s'intègre sans effort à flux de développement existants grâce à son API REST et à la prise en charge de son SDK pour les langages de programmation les plus courants. Il se connecte aux principaux fournisseurs de cloud et aux principales plateformes d'hébergement de modèles, ce qui permet des évaluations quel que soit le lieu de déploiement. L'intégration avec les pipelines CI/CD permet d'intégrer des comparaisons de modèles automatisées directement dans les processus de développement.

C'est architecture évolutive prend en charge les évaluations simultanées de plusieurs modèles et ensembles de données. Grâce au traitement distribué, Scout réduit le temps nécessaire aux comparaisons à grande échelle. Il peut gérer des entrées de données structurées et non structurées, ce qui le rend hautement adaptable à divers besoins d'évaluation. Cette intégration robuste est complétée par des fonctionnalités de sécurité strictes.

Scout garantit une sécurité de niveau professionnel avec un cryptage de bout en bout pour les données en transit et au repos. Il prend en charge l'intégration de l'authentification unique aux systèmes d'identité d'entreprise et fournit des journaux d'audit pour toutes les activités d'évaluation. Les contrôles d'accès basés sur les rôles limitent les données et les résultats sensibles au personnel autorisé uniquement.

Le cadre de gouvernance de la plateforme comprend suivi de la conformité pour aider les organisations à répondre aux exigences réglementaires en matière d'évaluation et de documentation de l'IA. Scout tient à jour des registres détaillés des méthodologies, des sources de données et des résultats, garantissant ainsi la transparence et la responsabilité dans la sélection des modèles. En outre, ses options de résidence des données permettent aux organisations de stocker les données d'évaluation dans des régions géographiques spécifiques ou dans une infrastructure sur site, répondant ainsi efficacement aux problèmes de souveraineté des données.

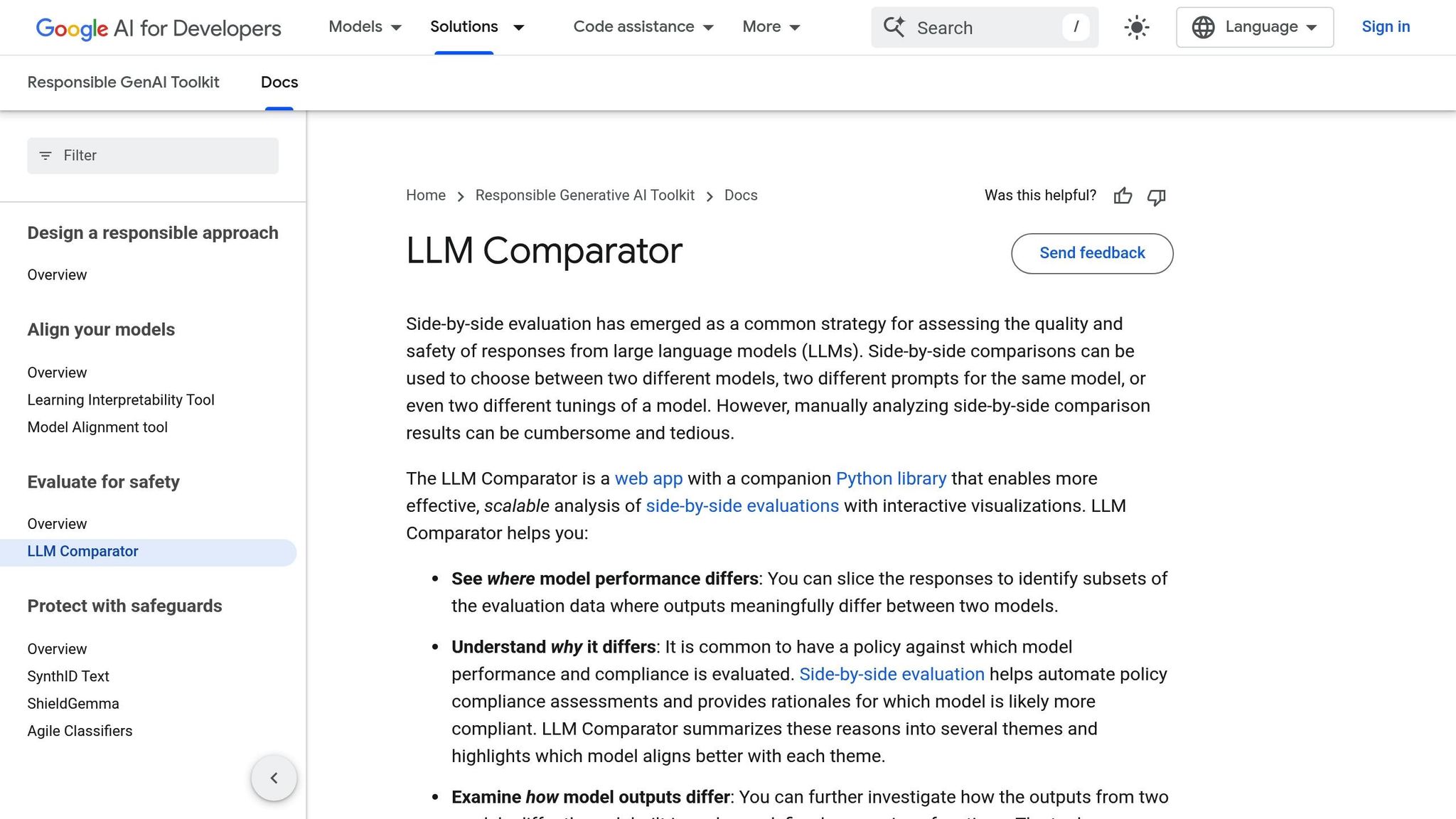

Le comparateur PAIR LLM simplifie le processus d'évaluation des modèles de langage, offrant aux développeurs un outil efficace et convivial. Ce système s'intègre directement aux flux de travail de l'IA, garantissant ainsi un fonctionnement fluide. À la base se trouve une bibliothèque Python (comparateur llm, disponible sur PyPI) qui fonctionne avec des entrées JSON standardisées. Cela permet aux utilisateurs de télécharger leurs résultats d'évaluation pour une visualisation et une analyse détaillées.

L'outil propose deux options principales : les utilisateurs peuvent soit créer un fichier JSON complet contenant des comparaisons de modèles côte à côte et des clusters de justifications groupés, soit se concentrer sur le regroupement des justifications à partir des sorties existantes. Cette flexibilité facilite la réalisation d'évaluations approfondies et évolutives des modèles de langage, en s'adaptant aux différents besoins des projets.

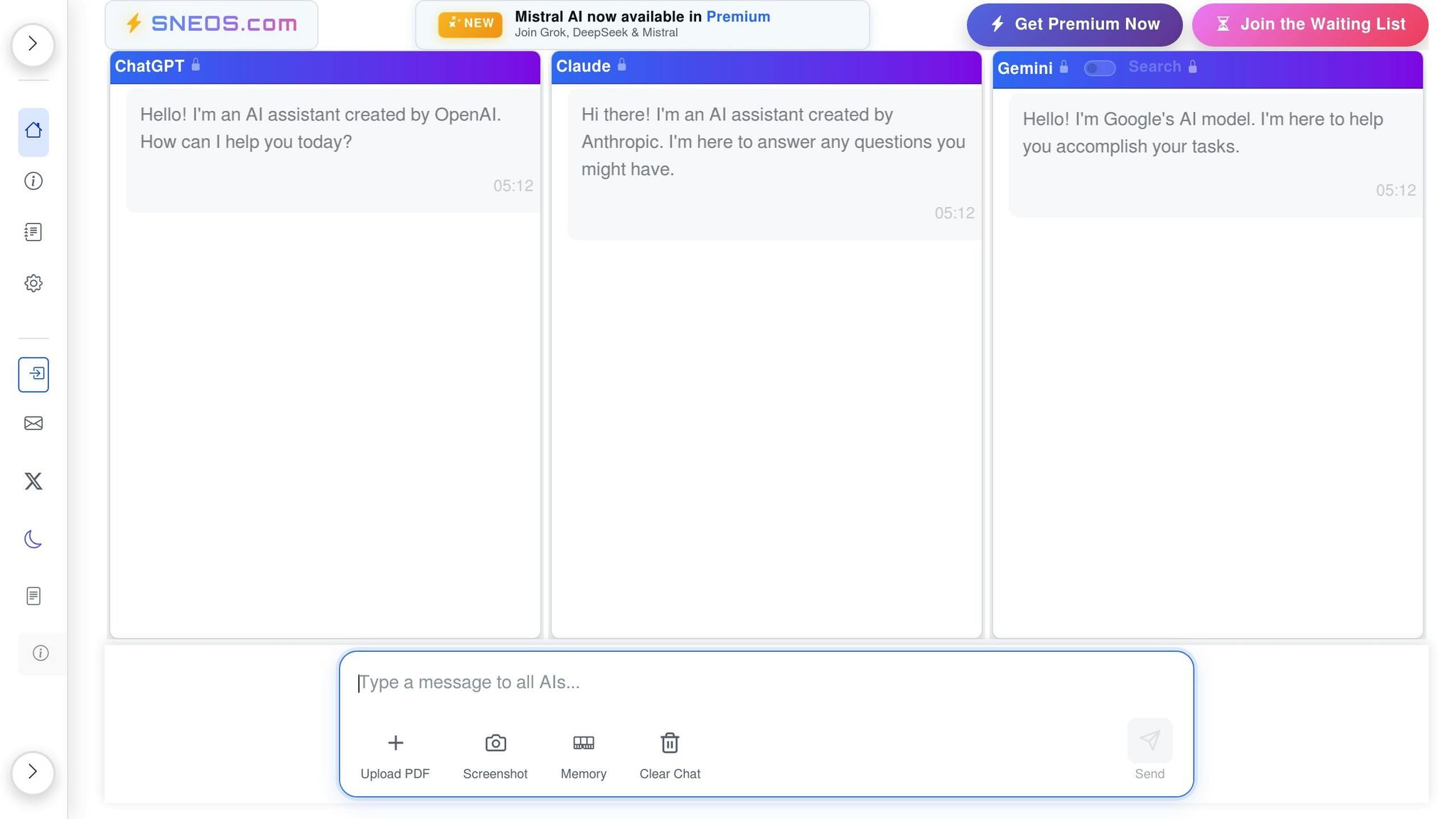

SNEOS ne semble pas fonctionner comme un outil dédié pour comparer les sorties LLM. Son manque de fonctionnalités et de capacités documentées crée des difficultés lorsqu'il s'agit de l'évaluer en parallèle avec des outils plus établis.

Il n'existe aucune méthodologie ou donnée publiée par le SNEOS concernant la façon dont il mesure la qualité des résultats du LLM. En revanche, les cadres largement reconnus s'appuient sur des indicateurs tels que les scores BLEU, les métriques ROUGE et les classements des préférences humaines pour évaluer les performances. Sans ces informations, il devient difficile d'évaluer la manière dont le SNEOS gère l'évaluation de la qualité ou de comparer son efficacité à d'autres outils fournissant une analyse détaillée.

SNEOS ne fournit aucune métrique de performance, ce qui laisse ses capacités d'évaluation ambiguës. L'absence de ces informations ne permet pas de savoir dans quelle mesure l'outil fonctionne ou s'il peut répondre aux besoins des utilisateurs à la recherche de repères fiables.

SNEOS ne propose aucune documentation technique concernant l'intégration ou l'évolutivité. Les plateformes établies fournissent généralement un accès aux API, une compatibilité avec plusieurs formats de modèles et une intégration fluide dans les flux de travail existants, autant de facteurs essentiels pour gérer des opérations à grande échelle. Sans détails similaires, il est impossible de déterminer si SNEOS peut répondre aux demandes des entreprises.

Par rapport aux plateformes plus transparentes et riches en fonctionnalités évoquées précédemment, la documentation limitée de SNEOS souligne l'importance de fournir des informations claires et détaillées pour une évaluation efficace du LLM.

Pour compléter les analyses détaillées de chaque outil, voici une comparaison concise de leurs points forts et de leurs défis. Chaque outil apporte des avantages et des compromis distincts, ce qui les rend adaptés à différents besoins.

Prompts.ai propose une approche hautement efficace pour gérer les modèles et réduire les coûts. Sa capacité à réduire les dépenses liées à l'IA jusqu'à 98 % grâce à une interface unifiée change la donne pour les organisations qui jonglent avec plusieurs abonnements LLM. De plus, il est payant à l'utilisation JETON le système de crédit élimine les frais récurrents, offrant flexibilité et contrôle des coûts.

Contrôles approfondis se distingue par sa capacité à proposer une validation complète adaptée aux flux de travail d'apprentissage automatique. Il excelle dans la détection de la dérive des données et la surveillance des performances des modèles, tout en s'intégrant parfaitement aux pipelines MLOps existants. Cependant, sa courbe d'apprentissage abrupte et le besoin d'expertise technique peuvent constituer un obstacle pour certains utilisateurs.

Banc LLM est idéal pour les équipes qui découvrent les évaluations LLM, grâce à sa configuration simple d'analyse comparative et à ses tests standard. Il fournit un environnement de test cohérent pour tous les modèles, mais ses options de personnalisation limitées peuvent ne pas satisfaire les organisations ayant des besoins d'évaluation plus spécialisés.

Débit ML se distingue par ses capacités robustes de suivi des expériences et de gestion des versions des modèles. En tant que plateforme open source, c'est une option rentable pour ceux qui disposent des ressources techniques nécessaires pour gérer le déploiement et la maintenance. Cependant, ses exigences de configuration et d'entretien étendues peuvent être un inconvénient.

Outil de comparaison des modèles Scout LLM privilégie la facilité d'utilisation avec une interface conviviale et une configuration rapide. Ses puissants outils de visualisation permettent de comparer des modèles côte à côte, mais il peut ne pas disposer de la profondeur analytique et de l'évolutivité nécessaires aux opérations au niveau de l'entreprise.

Comparateur PAIR LLM se concentre sur l'évaluation éthique de l'IA, en intégrant la détection des biais et des mesures d'équité. Cela en fait un choix précieux pour les organisations engagées dans un déploiement responsable de l'IA. Cependant, son objectif plus restreint peut nécessiter des outils supplémentaires pour une analyse des performances plus complète.

SNEOS fait face à des défis en raison d'un manque de documentation claire et de fonctionnalités opaques. Sans méthodologies transparentes ni indicateurs de performance établis, il est difficile d'évaluer son efficacité ou de l'intégrer en toute confiance aux flux de travail.

Voici un résumé des principaux points forts, des défis, de la clarté des coûts et de la facilité d'intégration de chaque outil :

Cette vue d'ensemble fournit un aperçu clair des capacités de chaque outil, vous aidant à aligner ses fonctionnalités sur les priorités d'évaluation de l'IA de votre organisation. Choisissez celui qui correspond le mieux à vos besoins spécifiques.

Le choix du bon outil de comparaison des résultats LLM dépend de l'alignement des fonctionnalités de la plateforme sur les priorités et les exigences techniques de votre organisation. Compte tenu des nombreuses options disponibles, il est essentiel d'identifier celle qui répond le mieux à vos objectifs en matière d'évaluation et de gestion de l'IA.

Pour les organisations soucieuses de réduire les coûts et de garantir une sécurité au niveau de l'entreprise, Prompts.ai propose une solution convaincante. En consolidant l'accès à plus de 35 modèles au sein d'une interface sécurisée, il élimine le besoin de souscrire plusieurs abonnements et peut réduire les coûts jusqu'à 98 %. Cette approche rationalisée garantit la conformité et la sécurité sans compromettre les fonctionnalités.

Ce qui distingue Prompts.ai, c'est sa capacité à simplifier les flux de travail tout en fournissant des résultats exceptionnels. Tel que partagé par un professionnel de l'industrie :

« Un architecte mêlant intelligence artificielle et vision créative devait autrefois s'appuyer sur des processus de rédaction fastidieux. Maintenant, en comparant différents LLM côte à côte sur prompts.ai, elle peut donner vie à des projets complexes tout en explorant des concepts innovants et oniriques. »

- Art. June Chow, architecte

Cependant, des besoins différents nécessitent des outils différents. Pour les organisations qui mettent l'accent sur la profondeur technique et la personnalisation, des plateformes telles que Débit ML offrent un suivi robuste des expériences, tandis que Contrôles approfondis fournit des flux de validation détaillés. Ces options s'adressent aux équipes dotées d'une expertise technique avancée qui recherchent des capacités d'évaluation granulaires.

Pour les équipes qui recherchent la simplicité ou une mise en œuvre rapide, Banc LLM et Scout LLM proposent des configurations conviviales, ce qui les rend idéales pour les débutants en matière d'évaluation LLM. En outre, les entreprises qui donnent la priorité à des pratiques d'IA responsables peuvent bénéficier de Comparateur PAIR LLM, qui met l'accent sur la détection des biais et les mesures d'équité. Cela dit, des outils supplémentaires peuvent être nécessaires pour une analyse complète des performances.

En fin de compte, des facteurs tels que la rentabilité, le suivi des performances et les capacités d'intégration devraient guider votre décision. Tenez compte de la capacité d'un outil à s'intégrer à vos systèmes existants, de sa facilité de maintenance et de son évolutivité. En choisissant la bonne plateforme, vous pouvez passer d'expériences éparpillées à des processus sécurisés et reproductibles offrant une valeur constante.

Prompts.ai offre aux entreprises un moyen plus intelligent de gérer les dépenses liées aux logiciels d'IA grâce à plateforme centralisée qui intègre plus de 35 modèles d'IA. En utilisant tarification transparente à l'utilisation alimenté par des crédits TOKN, ce système peut réduire les coûts de 98 %, rendant les outils d'IA avancés à la fois abordables et accessibles.

Les fonctionnalités clés telles que la surveillance en temps réel, le suivi des coûts et la gestion rapide des versions permettent aux utilisateurs de affiner leur utilisation de l'IA, éliminez les dépenses inutiles et simplifiez les flux de travail. Ces fonctionnalités aident les organisations à réduire leurs dépenses opérationnelles tout en garantissant l'efficacité et l'évolutivité de leurs projets d'IA.

Prompts.ai met l'accent sur la protection des données et le respect des exigences de conformité en utilisant des mesures telles que contrôle d'accès basé sur les rôles (RBAC), surveillance en temps réel, et le strict respect des normes de confidentialité telles que GDPR et HIPAA. Ces mesures de protection sont conçues pour protéger les informations sensibles tout en veillant à ce que les organisations restent en conformité avec les mandats réglementaires.

Pour renforcer encore la sécurité, Prompts.ai intègre des outils de gouvernance d'IA qui favorisent une gestion responsable des données et rationalisent les flux de travail, le tout sans sacrifier la confidentialité des utilisateurs. Cette stratégie complète aide les organisations à gérer en toute confiance leurs initiatives basées sur l'IA.

Prompts.ai renforce la fiabilité et la cohérence des flux de travail d'IA grâce à des outils avancés de comparaison des résultats. Ces outils permettent aux utilisateurs d'évaluer différents modèles et de proposer des variations côte à côte, simplifiant ainsi le processus d'identification des configurations qui fournissent les résultats les plus stables et les plus prévisibles.

La plateforme renforce également la fiabilité des flux de travail grâce à des fonctionnalités telles que des outils de gouvernance, des pistes d'audit et des systèmes de contrôle de version. Ces éléments favorisent la conformité, améliorent la transparence et simplifient la gestion des projets d'IA, permettant ainsi aux équipes d'obtenir de meilleurs résultats avec assurance.