Les outils d'orchestration de l'IA simplifient la gestion de plusieurs modèles, flux de travail et flux de données, mais une mauvaise gouvernance peut exposer votre organisation à de sérieux risques. Qu'il s'agisse de violations de données ou de sanctions de conformité, les enjeux sont considérables. La solution ? Des stratégies de gouvernance solides qui garantissent la sécurité, la conformité et l'efficacité opérationnelle.

Les principales stratégies sont les suivantes :

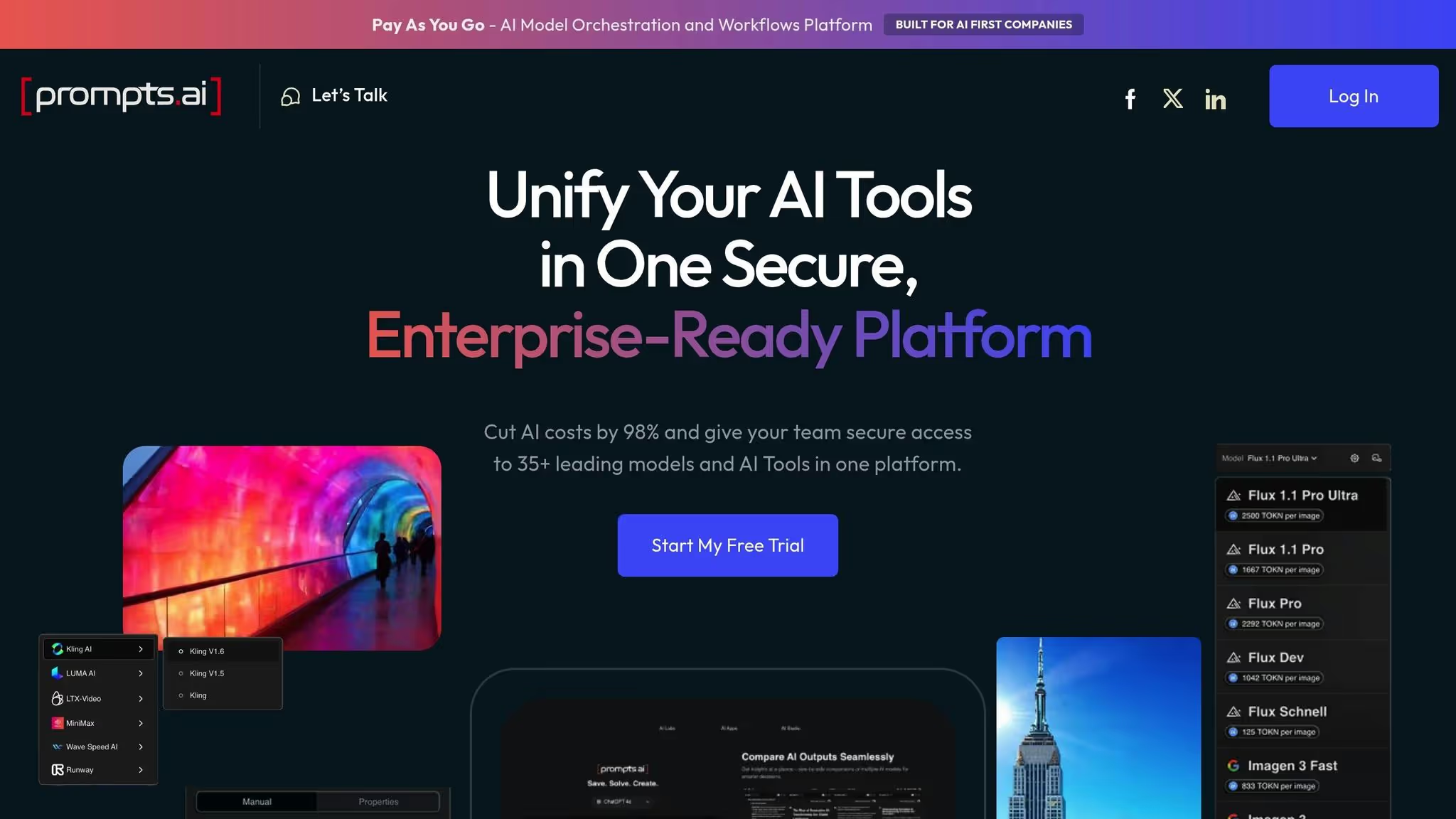

Prompts.ai propose une plateforme unifiée pour sécuriser, gérer et faire évoluer les flux de travail d'IA. Il intègre plus de 35 modèles (comme GPT-5 et Claude) avec des outils de gouvernance intégrés, une surveillance en temps réel et un contrôle des coûts. Qu'il s'agisse de sécuriser des données sensibles ou de rationaliser les opérations, cette plateforme transforme les défis de gouvernance en opportunités de croissance.

5 stratégies essentielles de gouvernance de l'IA pour les outils d'orchestration

La gestion des plateformes d'orchestration de l'IA comporte de nombreux obstacles éthiques, réglementaires et de sécurité. Brittany Woodsmall et Simon Fellows de Trace noire souligner le rythme d'adoption de l'IA :

L'adoption de l'IA est à la pointe du mouvement numérique dans les entreprises, dépassant le rythme auquel les professionnels de l'informatique et de la sécurité peuvent mettre en place des modèles de gouvernance et des paramètres de sécurité.

Chaque interaction avec l'IA peut présenter des risques tels que l'utilisation abusive d'identité, les fuites de données, l'exploitation de la logique des applications et les vulnérabilités de la chaîne d'approvisionnement. Pour résoudre ces problèmes, les cadres de gouvernance doivent être aussi agiles et adaptatifs que les systèmes d'IA qu'ils supervisent.

Les risques éthiques, tels que les préjugés et le manque de transparence, figurent parmi les défis les plus urgents. Les modèles d'IA comportent souvent des biais intégrés, qui peuvent conduire à des résultats discriminatoires. Cela a déjà valu à des institutions des amendes de plusieurs millions. Au-delà des sanctions financières, le recours à des systèmes biaisés peut éroder la confiance et la prise de décisions. Matthew DeChant, PDG de Security Counsel, met en garde :

Le recours excessif à l'orchestration de l'IA peut diminuer « l'élément humain essentiel de la pensée critique », entraînant une perte du commandement opérationnel.

Un autre problème est la nature de « boîte noire » de nombreux systèmes d'IA, qui masque leurs processus de prise de décision et augmente la probabilité de résultats non vérifiés. Cette opacité devient encore plus dangereuse lorsque l'IA générative produit des hallucinations, c'est-à-dire des résultats sûrs mais incorrects qui peuvent induire les entreprises en erreur. Sans supervision adéquate, ces systèmes peuvent également générer des contenus préjudiciables, tels que des contenus racistes ou sexistes, exposant ainsi les organisations à une atteinte à leur réputation.

Pour atténuer ces risques, les organisations devraient adopter protocoles HITL (human in-the-loop) pour les décisions critiques, utilisez des outils automatisés de détection des biais pour surveiller les résultats des modèles et mettez en place des comités d'évaluation éthique dotés d'une expertise diversifiée. Les exercices de Red Teaming permettent également de découvrir des vulnérabilités, telles que des attaques par injection rapide, avant qu'elles ne perturbent les flux de travail.

Le paysage réglementaire ajoute une couche de complexité supplémentaire à l'orchestration de l'IA. Par exemple, les violations du RGPD peuvent entraîner des amendes pouvant aller jusqu'à 20 millions d'euros ou 4 % du chiffre d'affaires annuel mondial, la valeur la plus élevée étant retenue. Ces réglementations exigent des politiques strictes de conservation des données, la possibilité de supprimer les données personnelles à la demande et des pistes d'audit détaillées pour toutes les interactions avec l'IA, y compris les invites, les réponses et les versions des modèles.

Lois sur la résidence et la souveraineté des données une orchestration encore plus complexe. Les outils d'IA doivent garantir que les temps d'exécution, les sources de données et les sorties restent dans des régions géographiques spécifiques, ce qui est particulièrement difficile dans les environnements basés sur le cloud. Les flux de données transfrontaliers ajoutent une difficulté supplémentaire, car ils nécessitent le respect de lois qui se chevauchent, comme la CCPA, le RGPD et le Loi sur l'IA de l'UE.

Avec de nouvelles normes telles que NORME ISO/IEC 42001 et le Cadre de gestion des risques liés à l'IA du NIST les organisations émergentes ont besoin d'outils d'orchestration capables d'adapter rapidement les flux de travail pour répondre à l'évolution des exigences. Mise en œuvre contrôle d'accès basé sur les rôles (RBAC) peut aider en limitant les personnes autorisées à créer et à déployer des agents d'IA, réduisant ainsi le risque de projets « d'IA parallèle » non autorisés.

Les outils d'orchestration de l'IA sont également confrontés à d'importantes menaces de sécurité. Des techniques telles que injection et jailbreak rapides - où les entrées sont conçues pour contourner les contrôles de sécurité - peuvent entraîner des actions non autorisées ou des fuites de données. Les attaques par empoisonnement des données, qui manipulent les ensembles d'apprentissage, et les techniques d'inversion de modèles, qui extraient des données sensibles des sorties, mettent en évidence ces vulnérabilités.

Les risques ne sont pas hypothétiques. En janvier 2026, plus de 500 organisations avaient été victimes de Ransomware Medusa, exploitant souvent les faiblesses des outils de gestion et d'orchestration à distance. L'essor des agents d'IA autonomes, capables de lancer des actions et d'interagir avec les systèmes de manière indépendante, a élargi la surface d'attaque. En outre, des journaux non sécurisés et des historiques rapides peuvent exposer des informations sensibles.

Pour faire face à ces risques, les organisations doivent appliquer l'accès au moindre privilège à l'aide d'identités gérées, appliquer un filtrage adaptatif des entrées/sorties avec une analyse contextuelle et établir des périmètres de service pour empêcher l'exfiltration de données. Des équipes contradictoires régulières peuvent simuler des attaques potentielles avant le déploiement, tandis que la journalisation centralisée garantit des pistes d'audit immuables capturant tous les détails pertinents, tels que les versions des modèles, les invites et les interactions des utilisateurs. Enfin, l'application de principes de minimisation des données, tels que le fait d'éviter la collecte de données sensibles inutiles et d'utiliser des données synthétiques ou anonymisées, peut limiter l'impact de toute violation.

Nous explorerons ensuite des stratégies permettant de relever efficacement ces défis.

Les défis liés aux outils d'orchestration de l'IA étant clairement identifiés, il est temps de se pencher sur des stratégies qui peuvent aider les organisations à créer des systèmes sécurisés, conformes et rentables. Ces stratégies constituent une feuille de route pour surmonter les obstacles décrits précédemment.

Chaque agent d'IA doit être traité comme une identité distincte, avec un accès adapté à des tâches spécifiques et accordé temporairement via des systèmes Just-In-Time (JIT). En utilisant des méthodes d'authentification multifactorielle (MFA) telles que des clés matérielles et des identités gérées, les entreprises peuvent réduire considérablement leur dépendance à l'égard des informations d'identification codées en dur. L'accès JIT garantit que les autorisations sont limitées à des lignes de données ou à des tableaux précis et ne sont valides que pour la durée de la tâche. Cette approche est particulièrement cruciale pour les agents autonomes qui agissent de manière indépendante.

Le MFA est une puissante mesure de sécurité qui bloque plus de 99 % des tentatives de compromission des comptes. Pour l'orchestration de l'IA, donnez la priorité aux options MFA résistantes au phishing, telles que les clés cryptographiques (FIDO2) ou Windows Hello pour les entreprises.

L'application des politiques doit être automatisée et immédiate. Des outils tels que l'accès conditionnel évaluent des facteurs tels que le groupe d'utilisateurs, la localisation et la sensibilité des applications en temps réel. Les violations devraient entraîner l'arrêt immédiat de l'exécution. BlackArc Systems met en avant cette approche :

la couche d'orchestration est l'endroit où ces problèmes doivent être résolus une fois et appliqués partout.

Pour éviter les fuites de données sensibles, appliquez des politiques de prévention de la perte de données (DLP) au niveau de la couche d'orchestration. Ces politiques peuvent empêcher les agents d'accéder à des informations sensibles, telles que les numéros de carte de crédit, ou de les transmettre dans leurs réponses.

Un inventaire centralisé de tous les modèles, ensembles de données et flux de travail d'IA, avec des métadonnées détaillées telles que la propriété, l'historique des versions et les dépendances, crée une source unique de vérité pour l'organisation.

En 2023, le Model Risk Office de Capital One a mis en place un tel inventaire parallèlement à des normes de documentation strictes, ce qui a entraîné une baisse de 45 % des conclusions réglementaires. Les outils automatisés de collecte de métadonnées tels que les « fiches d'information sur l'IA » ou les « fiches modèles » peuvent encore améliorer cet inventaire en capturant des détails clés tels que les mesures de performance des modèles, l'origine des données de formation et les cas d'utilisation prévus. Des audits réguliers de cet inventaire peuvent également empêcher les déploiements non autorisés de systèmes « d'IA fantôme ».

Les outils automatisés de détection des dérives peuvent identifier les problèmes 72 % plus rapidement que les processus manuels, ce qui permet de réagir plus rapidement. Plateformes d'observabilité centralisées telles que Azure Log Analytics surveillez en permanence le comportement des agents, les interactions avec les utilisateurs et les performances du système. Outils de protection contre les menaces spécifiques à l'IA tels que Microsoft Defender pour le cloud peut détecter les manipulations rapides, les tentatives de jailbreak et les accès non autorisés aux données.

Les garde-corps en temps réel constituent une autre couche de protection essentielle. Ces filtres automatisés bloquent les entrées contradictoires, empêchent les fuites de données sensibles et garantissent que les sorties restent appropriées. Par exemple, en 2024, Clinique Mayo a déployé un modèle de prédiction de l'insuffisance cardiaque avec une précision de 93 %, en s'appuyant sur un cadre d'évaluation de l'impact clinique pour surveiller les biais et garantir l'équité en temps réel. Définissez des seuils clairs pour les anomalies, telles que les pics de latence ou les modèles de sortie inhabituels, et acheminez les alertes directement vers le Security Operations Center (SOC). Comme Jeff Monnette, directeur principal de la gestion des livraisons chez ÉPAM, explique :

le plus grand défi auquel les organisations sont confrontées lorsqu'elles orchestrent des systèmes d'IA est de gérer leur non-déterminisme inhérent.

La conformité peut être rationalisée en automatisant la cartographie des cadres réglementaires tels que le NIST, la norme ISO/IEC 42001 et la loi européenne sur l'IA. Cela garantit que les contrôles techniques sont appliqués de manière cohérente à toutes les charges de travail d'IA. Les responsables de la conformité spécialisés peuvent traduire des exigences réglementaires abstraites en contrôles techniques exploitables pour les outils d'orchestration.

Par exemple, les règles de conservation des données du RGPD peuvent être appliquées par le biais de processus automatisés qui suppriment ou anonymisent les journaux après une période définie. Des outils de gouvernance tels que Politique Azure ou Contrôles du service Google Cloud VPC peuvent appliquer ces mesures de conformité de manière uniforme sur toutes les plateformes.

Les organisations qui utilisent des cadres de gouvernance hiérarchisés en fonction des risques enregistrent des taux de conformité 35 % plus élevés sans ralentir leurs opérations. Cette approche applique des contrôles rigoureux pour les applications à haut risque, telles que la santé ou la finance, tout en utilisant des contrôles plus légers pour les outils internes. Le suivi du lignage de bout en bout, qui documente les transformations des données et les versions des modèles, est essentiel pour répondre aux exigences d'audit en vertu de réglementations telles que le RGPD, HIPAAet CCPA. AWS souligne ce point :

Les cadres de gouvernance de l'IA créent des pratiques cohérentes au sein de l'organisation pour faire face aux risques organisationnels, au déploiement éthique, à la qualité et à l'utilisation des données, et même à la conformité réglementaire.

Les examens trimestriels garantissent que les cartographies de conformité restent à jour en fonction de l'évolution des réglementations. Au-delà des mesures réglementaires, la supervision financière ajoute une autre couche d'optimisation à l'orchestration de l'IA.

L'orchestration de l'IA peut devenir coûteuse sans une gestion financière adéquate. Les pratiques FinOps alignent les dépenses d'IA sur les objectifs commerciaux, garantissant ainsi la responsabilité et des rendements mesurables. La gouvernance automatisée peut réduire les coûts opérationnels jusqu'à 60 %, ce qui rend les investissements dans l'IA plus efficaces et plus efficaces.

La gestion efficace de la gouvernance de l'IA nécessite des outils capables de gérer la sécurité, de rationaliser diverses ressources et de maîtriser les coûts. Prompts.ai répond à ces besoins grâce à une plateforme unifiée qui intègre plus de 35 grands modèles de langage de premier plan, dont GPT-5, Claude, Lama, et Gémeaux. Cette interface sécurisée et adaptée aux entreprises simplifie l'orchestration de l'IA tout en mettant en œuvre directement des stratégies de gouvernance avancées.

Prompts.ai garantit une sécurité robuste grâce à contrôle d'accès basé sur les rôles (RBAC), qui limite les autorisations des utilisateurs aux seuls modèles et flux de travail correspondant à leurs rôles. Les données des flux de travail d'IA sont protégées par un cryptage puissant, et l'application automatisée des politiques garantit la conformité aux directives internes et aux réglementations externes en temps réel. Des fonctionnalités supplémentaires, telles que les contrôles d'autorisation en temps réel et les fonctionnalités de Red Teaming LLM, détectent et bloquent activement les menaces telles que l'injection rapide, les fuites de données et les accès non autorisés.

Pour simplifier la gouvernance, Prompts.ai regroupe plusieurs outils d'IA sur une seule plateforme, réduisant ainsi la complexité de la gestion des abonnements, des contrôles d'accès et des contrôles de conformité distincts. En fournissant un système centralisé, il élimine les risques tels que « l'IA fantôme » et offre une source unique de vérité pour suivre l'utilisation des modèles et garantir une supervision rationalisée.

Les outils FinOps intégrés à Prompts.ai offrent une visibilité complète des dépenses liées à l'IA dans tous les flux de travail. La plateforme suit les indicateurs d'utilisation du calcul tels que les heures GPU/CPU, la consommation de mémoire et les volumes de demandes. Grâce à la répartition des coûts basée sur des étiquettes, les organisations peuvent affecter les dépenses à des équipes ou à des projets spécifiques. Les contrôles automatisés des coûts, y compris les quotas visant à limiter les demandes simultanées, empêchent les augmentations inattendues des dépenses. Les alertes en temps réel aident également les équipes à réagir rapidement aux habitudes d'utilisation inhabituelles. Étant donné que les coûts d'inférence peuvent représenter jusqu'à 90 % des dépenses totales d'apprentissage automatique pour les déploiements d'IA à grande échelle, cette gestion granulaire des coûts est essentielle pour maintenir l'équilibre financier tout en développant les opérations.

Une gouvernance solide en matière d'IA garantit la conformité, renforce la confiance et rationalise les opérations. Pour y parvenir, les organisations doivent adopter des stratégies telles que le contrôle d'accès basé sur les rôles (RBAC), les inventaires centralisés des actifs, la surveillance des risques en temps réel, la cartographie automatisée de la conformité et l'intégration FinOps. Sans ces mesures, les risques sont importants : les violations de réglementations telles que le RGPD peuvent entraîner de lourdes amendes. Ces défis soulignent l'importance d'une solution globale.

Une plateforme unifiée devient essentielle pour faire face à ces risques. Prompts.ai regroupe plus de 35 grands modèles de langage de premier plan au sein d'un écosystème unique et sécurisé. La plateforme offre une automatisation intégrée des politiques, une gestion unifiée des flux de travail et un suivi détaillé des coûts. Des fonctionnalités telles que les contrôles d'accès basés sur les rôles, l'autorisation en temps réel et les tests contradictoires (red teaming) fournissent une protection contre les menaces telles que l'injection rapide et les fuites de données. La supervision centralisée empêche en outre les déploiements d'IA parallèle qui pourraient compromettre la sécurité et la conformité.

Ces capacités jettent les bases de solides pratiques de gouvernance. Les étapes clés incluent l'adoption d'un cadre de gestion des risques aligné sur des normes telles que le RMF NIST AI, la maintenance d'un inventaire des actifs d'IA et la mise en œuvre automatisée de l'application des politiques. Les organisations doivent également définir des protocoles de réponse aux incidents, utiliser des balises de centre de coûts pour surveiller l'utilisation des jetons et effectuer des tests contradictoires avant de déployer des systèmes.

L'évolution vers une application automatisée et des protocoles de gouvernance standardisés annonce l'avenir de la gestion de l'IA. Les leaders du secteur, tels que Microsoft, soulignent l'importance de ces mesures :

Sans une gouvernance adéquate, les agents d'IA peuvent introduire des risques liés à l'exposition de données sensibles, aux limites de conformité et aux failles de sécurité.

La plateforme unifiée de Prompts.ai transforme ces défis en processus structurés et vérifiables qui évoluent parallèlement aux initiatives d'IA de votre organisation.

Une supervision inadéquate des outils d'orchestration de l'IA peut ouvrir la voie à de graves risques. Sans gouvernance claire, les systèmes d'IA peuvent prendre des décisions contraires à l'éthique ou non conformes aux réglementations, ce qui peut entraîner des résultats biaisés, des violations de la loi ou de lourdes amendes. Les failles de sécurité, telles que la faiblesse de la protection des données ou l'accès non autorisé, peuvent également rendre les informations sensibles vulnérables aux violations et aux complications juridiques.

D'un point de vue opérationnel, une mauvaise gouvernance peut créer des problèmes tels que le manque de traçabilité, ce qui rend difficile l'audit ou la reproduction des résultats. Cela peut perturber les flux de travail, gaspiller des ressources et compromettre la continuité des activités. De plus, lorsque les actions de l'IA ne sont pas contrôlées, de petites erreurs peuvent se répercuter sur les systèmes interconnectés, ce qui augmente les coûts et nuit à la réputation de l'organisation. Une gouvernance efficace est essentielle pour garantir que les systèmes d'IA restent éthiques, sûrs et fiables.

Le contrôle d'accès basé sur les rôles (RBAC) joue un rôle crucial dans la gestion des systèmes d'IA en garantissant que les utilisateurs et les services ne peuvent accéder qu'aux outils, aux données ou aux modèles nécessaires à leurs rôles spécifiques. Par exemple, les administrateurs peuvent attribuer des rôles tels que chef de projet, développeur, ou correcteur, leur donnant accès exclusivement aux ressources nécessaires à l'exercice de leurs responsabilités. Cette approche permet d'atténuer les risques, tels que les abus accidentels ou intentionnels, et de vous protéger contre des problèmes tels que les violations de données ou les biais dans les flux de travail d'IA.

Le RBAC renforce également ses efforts de conformité en tenant à jour des journaux détaillés qui permettent de suivre qui a accédé à quoi, quand et dans quel but. Ces enregistrements sont essentiels pour répondre aux normes réglementaires américaines, notamment HIPAA et PCI-DSS, et sont d'une valeur inestimable lors des audits internes. Ce niveau de transparence rassure les parties prenantes en garantissant que seules les personnes autorisées peuvent influencer les décisions fondées sur l'IA.

En normalisant les autorisations et en automatisant leur application, le RBAC améliore l'efficacité opérationnelle. Elle élimine les accès inutiles, applique le contrôle des coûts et rationalise les flux de travail, tout en soutenant les objectifs plus généraux de la gouvernance de l'IA : conformité, confiance, et efficacité.

La surveillance des risques en temps réel joue un rôle clé dans le maintien flux de travail d'IA sécurisés, éthiques et fiables. En identifiant et en résolvant les problèmes tels que les biais, les dérives ou l'utilisation inattendue des ressources au fur et à mesure qu'ils surviennent, les organisations peuvent prévenir les dommages potentiels avant qu'ils ne s'aggravent. Cette méthode proactive favorise non seulement la conformité aux réglementations et aux politiques internes, mais améliore également les performances globales des systèmes d'IA.

Dans les environnements de production rapides, où les modèles et les agents d'IA fonctionnent de manière autonome, la surveillance en temps réel constitue une garantie essentielle. Il permet de détecter et de contrer les menaces telles que les failles de sécurité ou les tentatives de manipulation de modèles. Des fonctionnalités telles que les alertes automatisées, les pistes d'audit détaillées et les mesures de sécurité adaptatives garantissent que toutes les activités malveillantes sont identifiées et traitées rapidement, préservant ainsi l'intégrité de votre infrastructure d'IA.

L'évolution rapide de l'IA souligne encore l'importance d'une surveillance continue. Les examens périodiques ne peuvent tout simplement pas suivre le rythme des changements. Le suivi en temps réel garantit que les changements dans le comportement des modèles ou la qualité des données sont instantanément signalés, ce qui permet des réponses plus rapides, une meilleure supervision et des opérations d'IA plus fluides.