تعمل أدوات تنسيق الذكاء الاصطناعي على تبسيط إدارة النماذج المتعددة وسير العمل وتدفقات البيانات، ولكن الحوكمة السيئة يمكن أن تعرض مؤسستك لمخاطر جسيمة. من انتهاكات البيانات إلى عقوبات الامتثال، فإن المخاطر عالية. الحل؟ استراتيجيات حوكمة قوية تضمن الأمن والامتثال والكفاءة التشغيلية.

تشمل الاستراتيجيات الرئيسية ما يلي:

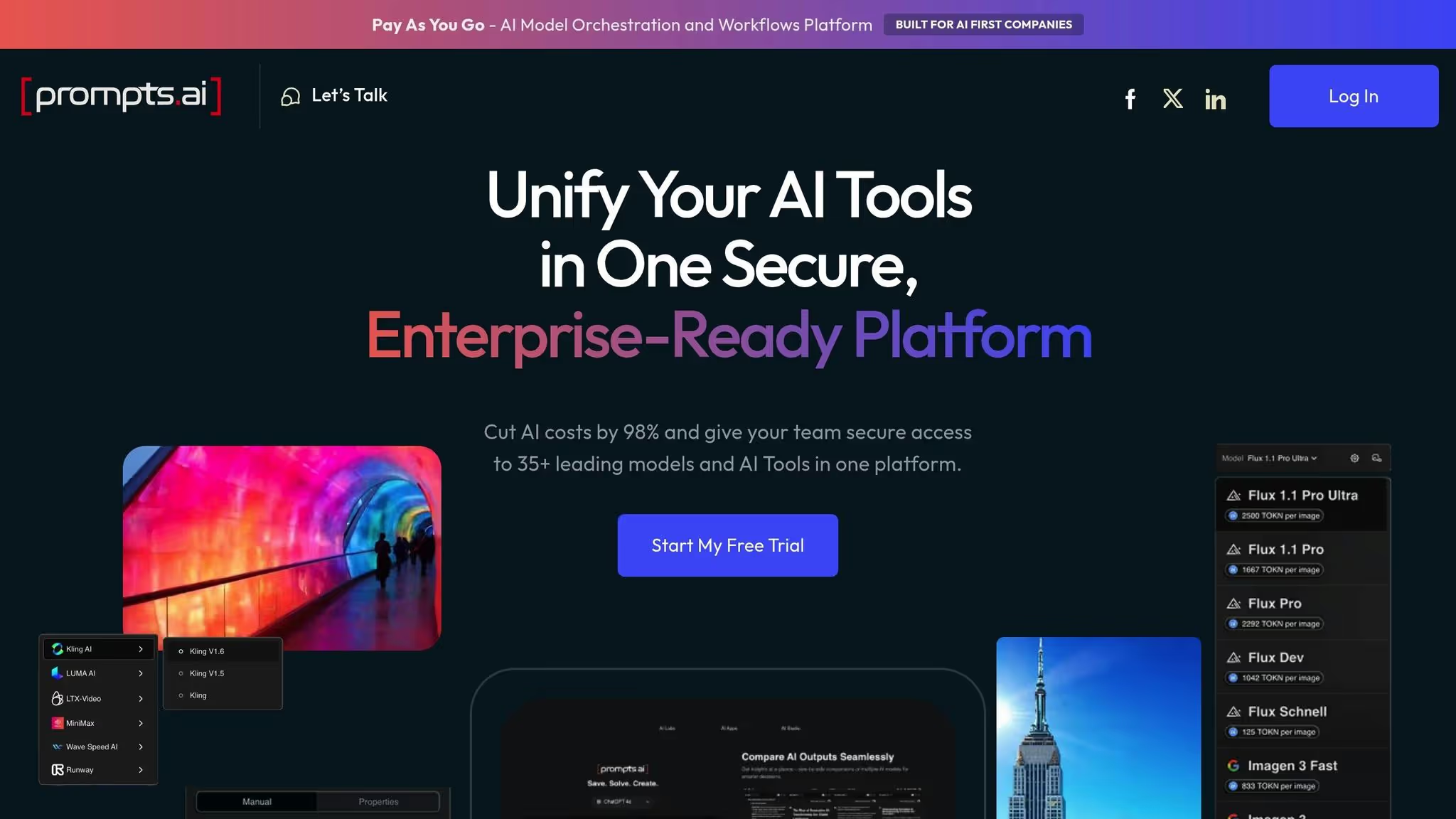

Prompts.ai يوفر نظامًا أساسيًا موحدًا لتأمين عمليات سير عمل الذكاء الاصطناعي وإدارتها وتوسيع نطاقها. إنه يدمج أكثر من 35 طرازًا (مثل جي بي تي -5 و كلود) مع أدوات الحوكمة المدمجة والمراقبة في الوقت الفعلي وضوابط التكلفة. سواء كنت تقوم بتأمين البيانات الحساسة أو تبسيط العمليات، فإن هذه المنصة تحول تحديات الحوكمة إلى فرص للنمو.

5 استراتيجيات أساسية لحوكمة الذكاء الاصطناعي لأدوات التنسيق

تأتي إدارة منصات تنسيق الذكاء الاصطناعي مع مجموعة من العقبات الأخلاقية والتنظيمية والأمنية. بريتاني وودسمول وسيمون فيلوز من أثر داكن تسليط الضوء على وتيرة اعتماد الذكاء الاصطناعي:

يأتي اعتماد الذكاء الاصطناعي في طليعة الحركة الرقمية في الشركات، حيث يتجاوز المعدل الذي يمكن لمتخصصي تكنولوجيا المعلومات والأمن من خلاله إعداد نماذج الحوكمة ومعايير الأمان.

يمكن أن يؤدي كل تفاعل للذكاء الاصطناعي إلى مخاطر مثل إساءة استخدام الهوية وتسريب البيانات واستغلال منطق التطبيقات ونقاط الضعف في سلسلة التوريد. لمعالجة هذه القضايا، يجب أن تكون أطر الحوكمة مرنة وقابلة للتكيف مثل أنظمة الذكاء الاصطناعي التي تشرف عليها.

تعد المخاطر الأخلاقية، مثل التحيز وانعدام الشفافية، من بين التحديات الأكثر إلحاحًا. غالبًا ما تحمل نماذج الذكاء الاصطناعي تحيزات مضمنة، مما قد يؤدي إلى نتائج تمييزية. وقد أدى ذلك بالفعل إلى مواجهة المؤسسات لغرامات بالملايين. وبالإضافة إلى العقوبات المالية، يمكن أن يؤدي الاعتماد على الأنظمة المتحيزة إلى تآكل الثقة وصنع القرار. يحذر ماثيو ديشانت، الرئيس التنفيذي لمستشار الأمن:

يمكن أن يؤدي الاعتماد المفرط على تنسيق الذكاء الاصطناعي إلى تقليل «العنصر البشري الأساسي للفكر النقدي»، مما يؤدي إلى فقدان القيادة التشغيلية.

هناك مشكلة أخرى تتمثل في طبيعة «الصندوق الأسود» للعديد من أنظمة الذكاء الاصطناعي، والتي تخفي عمليات صنع القرار الخاصة بها وتزيد من احتمالية المخرجات التي لم يتم التحقق منها. تصبح هذه العتامة أكثر خطورة عندما ينتج الذكاء الاصطناعي التوليدي الهلوسة - مخرجات واثقة ولكنها غير صحيحة يمكن أن تضلل الشركات. وبدون رقابة مناسبة، يمكن لهذه الأنظمة أيضًا إنشاء محتوى ضار، مثل المواد العنصرية أو الجنسية، مما يعرض المنظمات للضرر بالسمعة.

للتخفيف من هذه المخاطر، يجب على المنظمات اعتماد بروتوكولات الإنسان في الحلقة (HITL) لاتخاذ قرارات حاسمة، استخدم أدوات الكشف الآلي عن التحيز لمراقبة مخرجات النموذج، وإنشاء مجالس مراجعة الأخلاقيات التي تشمل خبرات متنوعة. يمكن أن يؤدي إجراء تمارين الفريق الأحمر أيضًا إلى الكشف عن نقاط الضعف، مثل هجمات الحقن الفوري، قبل أن تعطل سير العمل.

يضيف المشهد التنظيمي طبقة أخرى من التعقيد إلى تنسيق الذكاء الاصطناعي. على سبيل المثال، يمكن أن تؤدي انتهاكات اللائحة العامة لحماية البيانات إلى غرامات تصل إلى 20 مليون يورو أو 4٪ من الإيرادات السنوية العالمية، أيهما أعلى. تتطلب هذه اللوائح سياسات صارمة للاحتفاظ بالبيانات، والقدرة على حذف البيانات الشخصية عند الطلب، ومسارات التدقيق التفصيلية لجميع تفاعلات الذكاء الاصطناعي، بما في ذلك المطالبات والاستجابات وإصدارات النماذج.

قوانين إقامة البيانات وسيادتها يزيد من تعقيد التنسيق. يجب أن تضمن أدوات الذكاء الاصطناعي بقاء أوقات التشغيل ومصادر البيانات والمخرجات ضمن مناطق جغرافية محددة، وهو ما يمثل تحديًا خاصًا في البيئات القائمة على السحابة. تضيف تدفقات البيانات عبر الحدود طبقة أخرى من الصعوبة، مما يتطلب الامتثال للقوانين المتداخلة مثل CCPAواللائحة العامة لحماية البيانات (GDPR)، و قانون الاتحاد الأوروبي للذكاء الاصطناعي.

مع معايير جديدة مثل أيزو/إيك 42001 و ال إطار NIST لإدارة مخاطر الذكاء الاصطناعي تحتاج المؤسسات الناشئة إلى أدوات تنسيق يمكنها تكييف سير العمل بسرعة لتلبية المتطلبات المتطورة. تنفيذ التحكم في الوصول المستند إلى الأدوار (RBAC) يمكن أن يساعد من خلال تقييد من يمكنه إنشاء وكلاء الذكاء الاصطناعي ونشرهم، مما يقلل من مخاطر مشاريع «الظل للذكاء الاصطناعي» غير المصرح بها.

تواجه أدوات تنسيق الذكاء الاصطناعي أيضًا تهديدات أمنية كبيرة. تقنيات مثل الحقن الفوري وكسر السجن - حيث يتم تصميم المدخلات لتجاوز ضوابط السلامة - يمكن أن تؤدي إلى إجراءات غير مصرح بها أو تسرب البيانات. إن هجمات تسميم البيانات، التي تتلاعب بمجموعات التدريب، وتقنيات الانعكاس النموذجية، التي تستخرج البيانات الحساسة من المخرجات، تسلط الضوء بشكل أكبر على نقاط الضعف.

المخاطر ليست افتراضية. بحلول يناير 2026، وقعت أكثر من 500 منظمة ضحية لـ برنامج ميدوسا رانسوم وير، غالبًا ما تستغل نقاط الضعف في أدوات الإدارة والتنسيق عن بُعد. أدى ظهور وكلاء الذكاء الاصطناعي المستقلين، القادرين على بدء الإجراءات والتفاعل مع الأنظمة بشكل مستقل، إلى توسيع سطح الهجوم. بالإضافة إلى ذلك، يمكن أن تعرض السجلات غير الآمنة وسجلات المطالبة معلومات حساسة.

لمعالجة هذه المخاطر، يجب على المؤسسات فرض الوصول الأقل امتيازًا باستخدام الهويات المُدارة، وتطبيق تصفية الإدخال/الإخراج التكيفية مع التحليل السياقي، وإنشاء محيط الخدمة لمنع تسرب البيانات. يمكن للفرق الحمراء العدائية المنتظمة محاكاة الهجمات المحتملة قبل النشر، بينما يضمن التسجيل المركزي مسارات تدقيق غير قابلة للتغيير تلتقط جميع التفاصيل ذات الصلة، مثل إصدارات النماذج والمطالبات وتفاعلات المستخدم. أخيرًا، يمكن أن يؤدي تطبيق مبادئ تقليل البيانات - مثل تجنب جمع البيانات الحساسة غير الضرورية واستخدام بيانات اصطناعية أو مجهولة المصدر - إلى الحد من تأثير أي انتهاكات.

بعد ذلك، سنستكشف استراتيجيات لمواجهة هذه التحديات بفعالية.

مع تحديد تحديات أدوات تنسيق الذكاء الاصطناعي بوضوح، حان الوقت للتعمق في الاستراتيجيات التي يمكن أن تساعد المؤسسات على بناء أنظمة آمنة ومتوافقة وفعالة من حيث التكلفة. تعمل هذه الاستراتيجيات كخارطة طريق لمعالجة العقبات الموضحة سابقًا.

يجب التعامل مع كل وكيل للذكاء الاصطناعي على أنه هوية مميزة، مع إمكانية وصول مصممة خصيصًا لمهام محددة ومنحها مؤقتًا من خلال أنظمة Just-In-Time (JIT). من خلال استخدام أساليب المصادقة متعددة العوامل (MFA) مثل المفاتيح المدعومة بالأجهزة والهويات المُدارة، يمكن للمؤسسات تقليل الاعتماد بشكل كبير على بيانات الاعتماد المشفرة. يضمن الوصول إلى JIT أن الأذونات تقتصر على صفوف أو جداول البيانات الدقيقة وتكون صالحة فقط طوال مدة المهمة. هذا النهج مهم بشكل خاص للوكلاء المستقلين الذين يعملون بشكل مستقل.

يعد MFA إجراءً أمنيًا قويًا، حيث يحظر أكثر من 99٪ من محاولات اختراق الحساب. بالنسبة لتنسيق الذكاء الاصطناعي، حدد أولويات خيارات MFA المقاومة للتصيد الاحتيالي، مثل مفاتيح التشفير (FIDO2) أو ويندوز هيلو للأعمال.

يجب أن يكون تطبيق السياسة آليًا وفوريًا. تقوم أدوات مثل الوصول المشروط بتقييم عوامل مثل مجموعة المستخدمين والموقع وحساسية التطبيق في الوقت الفعلي. يجب أن تؤدي الانتهاكات إلى وقف فوري للتنفيذ. تسلط أنظمة BlackArc الضوء على هذا النهج:

طبقة التنسيق هي المكان الذي يجب فيه حل هذه المشكلات مرة واحدة وتطبيقها في كل مكان.

لمنع تسرب البيانات الحساسة، قم بتطبيق سياسات منع فقدان البيانات (DLP) في طبقة التنسيق. يمكن لهذه السياسات تقييد الوكلاء من الوصول إلى المعلومات الحساسة أو إخراجها، مثل أرقام بطاقات الائتمان، في ردودهم.

يؤدي الجرد المركزي لجميع نماذج الذكاء الاصطناعي ومجموعات البيانات وسير العمل، مع استكمال البيانات الوصفية التفصيلية مثل الملكية وسجل الإصدارات والتبعيات، إلى إنشاء مصدر واحد للحقيقة للمؤسسة.

في عام 2023، نفذ مكتب المخاطر النموذجي التابع لشركة Capital One مثل هذا المخزون جنبًا إلى جنب مع معايير التوثيق الصارمة، مما أدى إلى انخفاض بنسبة 45٪ في النتائج التنظيمية. يمكن لأدوات جمع البيانات الوصفية الآلية مثل «أوراق حقائق الذكاء الاصطناعي» أو «البطاقات النموذجية» زيادة تحسين هذا المخزون من خلال التقاط التفاصيل الأساسية مثل مقاييس أداء النموذج وأصول بيانات التدريب وحالات الاستخدام المقصودة. يمكن أن تؤدي عمليات التدقيق المنتظمة لهذا المخزون أيضًا إلى منع عمليات النشر غير المصرح بها لأنظمة «Shadow AI».

يمكن لأدوات اكتشاف الانجراف الآلي تحديد المشكلات بشكل أسرع بنسبة 72٪ من العمليات اليدوية، مما يتيح استجابات أسرع. منصات المراقبة المركزية مثل تحليلات سجل Azure راقب باستمرار سلوكيات الوكلاء وتفاعلات المستخدم وأداء النظام. أدوات الحماية من التهديدات الخاصة بالذكاء الاصطناعي مثل ميكروسوفت ديفندر للسحابة يمكنه اكتشاف التلاعب الفوري ومحاولات الهروب من السجن والوصول غير المصرح به إلى البيانات.

تعتبر حواجز الحماية في الوقت الفعلي طبقة أساسية أخرى من الحماية. تعمل هذه الفلاتر الآلية على حظر المدخلات العدائية ومنع تسرب البيانات الحساسة وضمان بقاء المخرجات مناسبة. على سبيل المثال، في عام 2024، عيادة مايو نشر نموذج التنبؤ بفشل القلب بدقة تصل إلى 93٪، بالاعتماد على إطار تقييم الأثر السريري لمراقبة التحيز وضمان العدالة في الوقت الفعلي. حدد حدودًا واضحة للحالات الشاذة - مثل ارتفاع وقت الاستجابة أو أنماط الإخراج غير العادية - وتوجيه التنبيهات مباشرةً إلى مركز عمليات الأمان (SOC). بصفته جيف مونيت، المدير الأول لإدارة التسليم في البريد المزعج، يوضح:

يتمثل التحدي الأكبر الذي تواجهه المنظمات عند تنسيق أنظمة الذكاء الاصطناعي في إدارة اللاحتمية المتأصلة فيها.

يمكن تبسيط الامتثال من خلال أتمتة رسم خرائط الأطر التنظيمية مثل NIST و ISO/IEC 42001 وقانون الاتحاد الأوروبي للذكاء الاصطناعي. وهذا يضمن تطبيق الضوابط الفنية باستمرار عبر أحمال عمل الذكاء الاصطناعي. يمكن لمديري الامتثال المتخصصين ترجمة المتطلبات التنظيمية المجردة إلى ضوابط فنية قابلة للتنفيذ لأدوات التنسيق.

على سبيل المثال، يمكن فرض قواعد الاحتفاظ بالبيانات في GDPR من خلال العمليات الآلية التي تحذف السجلات أو تخفي هويتها بعد فترة محددة. أدوات الحوكمة مثل سياسة أزور أو عناصر التحكم في خدمة Google Cloud VPC يمكن تطبيق تدابير الامتثال هذه بشكل موحد عبر المنصات.

تبلغ المؤسسات التي تستخدم أطر الحوكمة ذات المخاطر المرتفعة عن معدلات امتثال أعلى بنسبة 35% دون إبطاء العمليات. يطبق هذا النهج فحوصات صارمة للتطبيقات عالية المخاطر، مثل الرعاية الصحية أو التمويل، مع استخدام ضوابط أخف للأدوات الداخلية. يعد تتبع النسب من البداية إلى النهاية - توثيق تحويلات البيانات وإصدارات النماذج - أمرًا ضروريًا لتلبية متطلبات التدقيق بموجب لوائح مثل GDPR، هيبا، و CCPA. الخدمات اللاسلكية المتقدمة يؤكد هذه النقطة:

تعمل أطر حوكمة الذكاء الاصطناعي على إنشاء ممارسات متسقة في المؤسسة لمعالجة المخاطر التنظيمية والنشر الأخلاقي وجودة البيانات واستخدامها وحتى الامتثال التنظيمي.

تضمن المراجعات الفصلية تحديث تعيينات الامتثال باللوائح المتطورة. بالإضافة إلى التدابير التنظيمية، تضيف الرقابة المالية طبقة أخرى من التحسين إلى تنسيق الذكاء الاصطناعي.

يمكن أن يصبح تنسيق الذكاء الاصطناعي مكلفًا بدون إدارة مالية مناسبة. تعمل ممارسات FinOps على مواءمة الإنفاق على الذكاء الاصطناعي مع أهداف الأعمال، مما يضمن المساءلة والعوائد القابلة للقياس. يمكن للحوكمة الآلية تقليل التكاليف التشغيلية بنسبة تصل إلى 60٪، مما يجعل استثمارات الذكاء الاصطناعي أكثر كفاءة وتأثيرًا.

تتطلب إدارة حوكمة الذكاء الاصطناعي بفعالية أدوات يمكنها التعامل مع الأمن وتبسيط الموارد المتنوعة والحفاظ على التكاليف تحت السيطرة. يوفر Prompts.ai هذه الاحتياجات من خلال منصة موحدة تدمج أكثر من 35 نموذجًا رائدًا للغات الكبيرة، بما في ذلك GPT-5 و Claude و لاما، و الجوزاء. تعمل هذه الواجهة الآمنة والجاهزة للمؤسسات على تبسيط تنسيق الذكاء الاصطناعي مع التنفيذ المباشر لاستراتيجيات الحوكمة المتقدمة.

يضمن Prompts.ai أمانًا قويًا من خلال التحكم في الوصول المستند إلى الأدوار (RBAC)، مما يقصر أذونات المستخدم على النماذج وعمليات سير العمل ذات الصلة بأدوارهم فقط. تتم حماية البيانات داخل عمليات سير عمل الذكاء الاصطناعي بتشفير قوي، ويضمن تطبيق السياسة الآلي الامتثال لكل من الإرشادات الداخلية واللوائح الخارجية في الوقت الفعلي. تعمل الميزات الإضافية مثل عناصر التحكم في التفويض في الوقت الفعلي وقدرات LLM re-teaming على اكتشاف التهديدات وحظرها بشكل فعال مثل الحقن الفوري وتسريب البيانات والوصول غير المصرح به.

لتبسيط الحوكمة، تقوم Prompts.ai بدمج العديد من أدوات الذكاء الاصطناعي في منصة واحدة، مما يقلل من تعقيد إدارة الاشتراكات المنفصلة وضوابط الوصول وفحوصات الامتثال. من خلال توفير نظام مركزي، فإنه يزيل المخاطر مثل «Shadow AI» ويوفر مصدرًا واحدًا للحقيقة لتتبع استخدام النموذج وضمان الإشراف المبسط.

توفر أدوات FinOps المضمنة في Prompts.ai رؤية كاملة للإنفاق على الذكاء الاصطناعي عبر عمليات سير العمل. تتعقب المنصة مقاييس استخدام الحوسبة مثل ساعات GPU/CPU واستهلاك الذاكرة وأحجام الطلبات. من خلال تخصيص التكلفة المستند إلى التسمية، يمكن للمؤسسات تخصيص الإنفاق لفرق أو مشاريع محددة. تمنع ضوابط التكلفة الآلية، بما في ذلك الحصص للحد من الطلبات المتزامنة، الزيادات غير المتوقعة في النفقات. تساعد التنبيهات في الوقت الفعلي أيضًا الفرق على الاستجابة بسرعة لأنماط الاستخدام غير العادية. نظرًا لأن تكاليف الاستدلال يمكن أن تشكل ما يصل إلى 90٪ من إجمالي نفقات التعلم الآلي لعمليات نشر الذكاء الاصطناعي على نطاق واسع، فإن إدارة التكلفة الدقيقة هذه ضرورية للحفاظ على التوازن المالي أثناء توسيع العمليات.

تضمن حوكمة الذكاء الاصطناعي القوية الامتثال وبناء الثقة وتبسيط العمليات. ولتحقيق ذلك، يجب على المؤسسات اعتماد استراتيجيات مثل التحكم في الوصول القائم على الأدوار (RBAC)، وقوائم جرد الأصول المركزية، ومراقبة المخاطر في الوقت الفعلي، ورسم خرائط الامتثال الآلي، وتكامل FinOps. وبدون هذه التدابير، تكون المخاطر كبيرة - يمكن أن تؤدي انتهاكات اللوائح مثل اللائحة العامة لحماية البيانات إلى غرامات باهظة. تؤكد هذه التحديات على أهمية الحل الشامل.

تصبح المنصة الموحدة أمرًا بالغ الأهمية في معالجة هذه المخاطر. يدمج Prompts.ai أكثر من 35 نموذجًا رائدًا للغات الكبيرة في نظام بيئي واحد آمن. توفر المنصة أتمتة السياسات المضمنة وإدارة سير العمل الموحدة والتتبع التفصيلي للتكاليف. توفر ميزات مثل عناصر التحكم في الوصول القائمة على الأدوار والترخيص في الوقت الفعلي والاختبار العدائي (الفريق الأحمر) الحماية من التهديدات مثل الحقن الفوري وتسريب البيانات. كما تمنع الرقابة المركزية عمليات نشر الذكاء الاصطناعي الخفية التي يمكن أن تعرض الأمن والامتثال للخطر.

تضع هذه القدرات الأساس لممارسات الحوكمة القوية. تشمل الخطوات الرئيسية اعتماد إطار إدارة المخاطر المتوافق مع معايير مثل NIST AI RMF، والحفاظ على مخزون أصول الذكاء الاصطناعي، وتنفيذ تطبيق السياسة الآلي. يجب على المؤسسات أيضًا تحديد بروتوكولات الاستجابة للحوادث، واستخدام علامات مركز التكلفة لمراقبة استخدام الرمز المميز، وإجراء الاختبارات العدائية قبل نشر الأنظمة.

يشير التحرك نحو الإنفاذ الآلي وبروتوكولات الحوكمة الموحدة إلى مستقبل إدارة الذكاء الاصطناعي. يؤكد قادة الصناعة، مثل Microsoft، على أهمية هذه التدابير:

بدون حوكمة مناسبة، يمكن لوكلاء الذكاء الاصطناعي إدخال المخاطر المتعلقة بالتعرض للبيانات الحساسة وحدود الامتثال والثغرات الأمنية.

تعمل منصة Prompts.ai الموحدة على تحويل هذه التحديات إلى عمليات منظمة وقابلة للتدقيق تنمو جنبًا إلى جنب مع مبادرات الذكاء الاصطناعي في مؤسستك.

يمكن أن تؤدي الرقابة غير الكافية في أدوات تنسيق الذكاء الاصطناعي إلى فتح الباب لمخاطر جسيمة. بدون حوكمة واضحة، قد تتخذ أنظمة الذكاء الاصطناعي قرارات غير أخلاقية أو تفشل في الامتثال للوائح، مما قد يؤدي إلى نتائج متحيزة أو انتهاكات قانونية أو غرامات باهظة. كما يمكن للثغرات الأمنية، مثل الحماية الضعيفة للبيانات أو الوصول غير المصرح به، أن تترك المعلومات الحساسة عرضة للانتهاكات والتعقيدات القانونية.

من وجهة نظر تشغيلية، يمكن أن تخلق الحوكمة السيئة تحديات مثل عدم إمكانية التتبع، مما يجعل من الصعب تدقيق النتائج أو تكرارها. يمكن أن يؤدي ذلك إلى تعطيل سير العمل وإهدار الموارد وتعريض استمرارية الأعمال للخطر. علاوة على ذلك، عندما تمر إجراءات الذكاء الاصطناعي دون رادع، يمكن أن تنتشر الأخطاء الصغيرة عبر الأنظمة المترابطة، مما يؤدي إلى زيادة التكاليف وإلحاق الضرر بسمعة المؤسسة. تعد الحوكمة الفعالة أمرًا بالغ الأهمية لضمان بقاء أنظمة الذكاء الاصطناعي أخلاقية وآمنة ويمكن الاعتماد عليها.

يلعب التحكم في الوصول القائم على الأدوار (RBAC) دورًا مهمًا في إدارة أنظمة الذكاء الاصطناعي من خلال ضمان وصول المستخدمين والخدمات فقط إلى الأدوات أو البيانات أو النماذج اللازمة لأدوارهم المحددة. على سبيل المثال، يمكن للمسؤولين تعيين أدوار مثل مدير المشروع، المطور، أو مراجع, مما يتيح لهم الوصول حصريا إلى الموارد اللازمة لمسؤولياتهم. يساعد هذا النهج على تخفيف المخاطر، مثل سوء الاستخدام العرضي أو الإساءة المتعمدة، والحماية من مشاكل مثل خروقات البيانات أو التحيزات في عمليات سير عمل الذكاء الاصطناعي.

تعمل RBAC أيضًا على تعزيز جهود الامتثال من خلال الاحتفاظ بسجلات مفصلة تتعقب من قام بالوصول إلى ماذا ومتى ولأي غرض. هذه السجلات ضرورية لتلبية المعايير التنظيمية الأمريكية، بما في ذلك HIPAA و PCI-DSS، وهي لا تقدر بثمن أثناء عمليات التدقيق الداخلية. هذا المستوى من الشفافية يطمئن أصحاب المصلحة من خلال ضمان أن الأفراد المصرح لهم فقط يمكنهم التأثير على القرارات القائمة على الذكاء الاصطناعي.

من خلال توحيد الأذونات وأتمتة إنفاذها، تعمل RBAC على تعزيز الكفاءة التشغيلية. إنه يزيل الوصول غير الضروري، ويفرض ضوابط التكلفة، ويبسط سير العمل - كل ذلك مع دعم الأهداف الأوسع لحوكمة الذكاء الاصطناعي: الالتزام، ثقة، و الكفاءة.

تلعب مراقبة المخاطر في الوقت الفعلي دورًا رئيسيًا في الحفاظ عمليات سير عمل آمنة وأخلاقية وموثوقة للذكاء الاصطناعي. من خلال تحديد ومعالجة مشكلات مثل التحيز أو الانحراف أو الاستخدام غير المتوقع للموارد عند حدوثها، يمكن للمؤسسات منع الضرر المحتمل قبل تصاعده. لا تدعم هذه الطريقة الاستباقية الامتثال للوائح والسياسات الداخلية فحسب، بل تعزز أيضًا الأداء العام لأنظمة الذكاء الاصطناعي.

في بيئات الإنتاج سريعة الوتيرة، حيث تعمل نماذج الذكاء الاصطناعي ووكلائه بشكل مستقل، تعمل المراقبة في الوقت الفعلي كحماية مهمة. فهي تساعد على اكتشاف التهديدات والتصدي لها مثل الخروقات الأمنية أو محاولات التلاعب بالنماذج. تضمن الميزات مثل التنبيهات الآلية ومسارات التدقيق التفصيلية وإجراءات الأمان التكيفية تحديد أي أنشطة ضارة والتعامل معها بسرعة، مع الحفاظ على سلامة البنية التحتية للذكاء الاصطناعي لديك.

يؤكد التطور السريع للذكاء الاصطناعي على أهمية المراقبة المستمرة. لا تستطيع المراجعات الدورية ببساطة مواكبة وتيرة التغيير. يضمن التتبع في الوقت الفعلي وضع علامة على التحولات في سلوك النموذج أو جودة البيانات على الفور، مما يسمح باستجابات أسرع ورقابة أقوى وعمليات أكثر سلاسة للذكاء الاصطناعي.