La ingeniería rápida es vital para crear soluciones de IA eficaces, pero ampliarlas entre equipos y proyectos puede ser un desafío. Problemas como la incoherencia de los resultados, la falta de control de versiones y la falta de claridad de los costes suelen obstaculizar el éxito. Las herramientas modernas resuelven estos problemas al centralizar los flujos de trabajo, optimizar los costos y garantizar el cumplimiento para el uso de la IA a nivel empresarial.

Esta es una descripción general rápida de las seis herramientas principales para optimizar sus operaciones de IA:

Estas herramientas se adaptan a diferentes necesidades, desde desarrolladores individuales hasta equipos empresariales, lo que garantiza mejores resultados y ahorra tiempo y recursos.

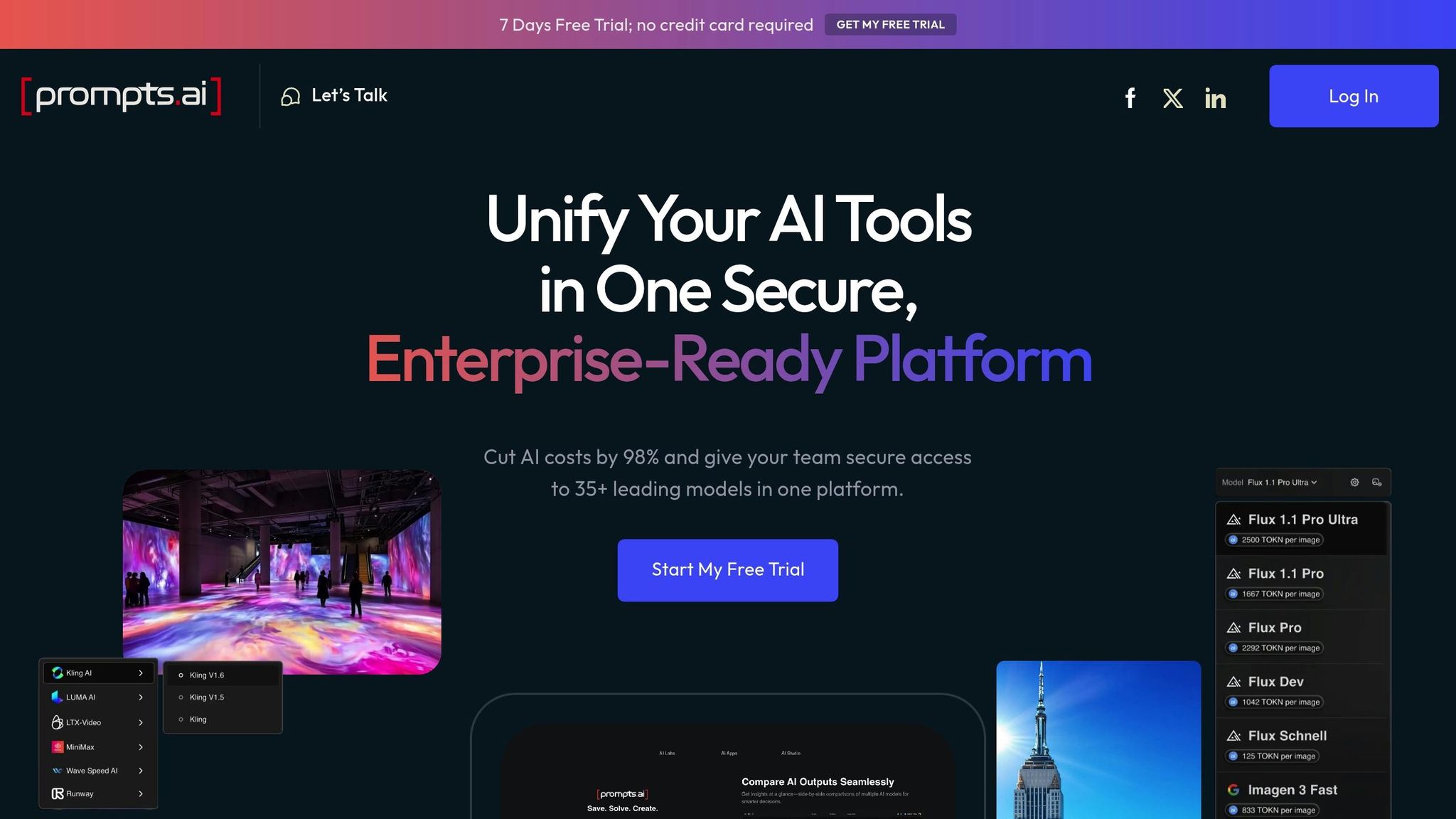

Prompts.ai es un plataforma de orquestación de IA de nivel empresarial que agiliza las operaciones de IA al integrar más de 35 modelos lingüísticos líderes en una única interfaz segura. Diseñado para hacer frente a los desafíos de escalar la IA, reduce la proliferación de herramientas, garantiza la gobernanza y reduce los costos del software de IA hasta 98%.

Prompts.ai reúne los principales modelos de lenguaje como GPT-4, Claudio, Llama, y Géminis bajo un mismo techo, lo que elimina la molestia de tener que hacer malabares con varias suscripciones. Este acceso centralizado permite a los equipos comparar el rendimiento de los modelos en paralelo, lo que les ayuda a elegir el que mejor se adapte a sus necesidades específicas, todo ello sin tener que cambiar de plataforma.

Esta función es especialmente valiosa para las empresas de Fortune 500, las agencias creativas y los laboratorios de investigación que han tenido dificultades para administrar varias herramientas de inteligencia artificial. Al consolidar el acceso, la plataforma permite a los equipos centrarse en obtener resultados en lugar de lidiar con sistemas fragmentados. También admite el seguimiento detallado y el control de versiones, lo que garantiza que las estrategias rápidas evolucionen sin problemas.

Prompts.ai presenta un Sistema similar a Git para una gestión rápida, que ofrece funciones como el historial rápido, el seguimiento de cambios y las anulaciones instantáneas. Esto elimina la confusión que supone gestionar versiones dispersas de forma manual.

«Administrar las instrucciones a mano es como programar sin Git. Diversión durante unos cinco minutos. Entonces es un caos». - Daniel Ostrovsky, experto en desarrollo web y gerente de equipos

La plataforma también simplifica Pruebas A/B de indicaciones, convirtiendo la experimentación en un proceso estructurado. En lugar de basarse en conjeturas, los equipos pueden desarrollar, probar e implementar las instrucciones de forma sistemática y con confianza.

Prompts.ai está diseñado tanto para ingenieros que trabajan en solitario como para grandes equipos empresariales, lo que permite flujos de trabajo colaborativos en todas las organizaciones. Su función «Ahorra tiempo» permite a los equipos compartir flujos de trabajo rápidos diseñados por expertos, lo que hace que las técnicas avanzadas sean accesibles para todos.

Además, la plataforma ofrece un Programa de certificación rápida de ingenieros, dotando a las organizaciones de las habilidades y las mejores prácticas necesarias para sobresalir. Al fomentar un enfoque impulsado por la comunidad, Prompts.ai garantiza que los equipos puedan aprovechar la experiencia compartida en lugar de empezar desde cero con cada nuevo proyecto.

Prompts.ai incluye un Capa FinOps que rastrea el uso de los tokens en todos los modelos y proporciona información en tiempo real sobre el gasto en IA. Esta transparencia permite a las organizaciones alinear los costos con los resultados empresariales y asignar los recursos de manera más eficaz.

Con su Sistema de créditos TOKN Pay-As-You-Go, la plataforma elimina las tarifas recurrentes y alinea los gastos con el uso real. Este enfoque no solo evita los altos costos de varias suscripciones, sino que también ofrece mejores resultados mediante la optimización de las indicaciones y la administración centralizada de los costos.

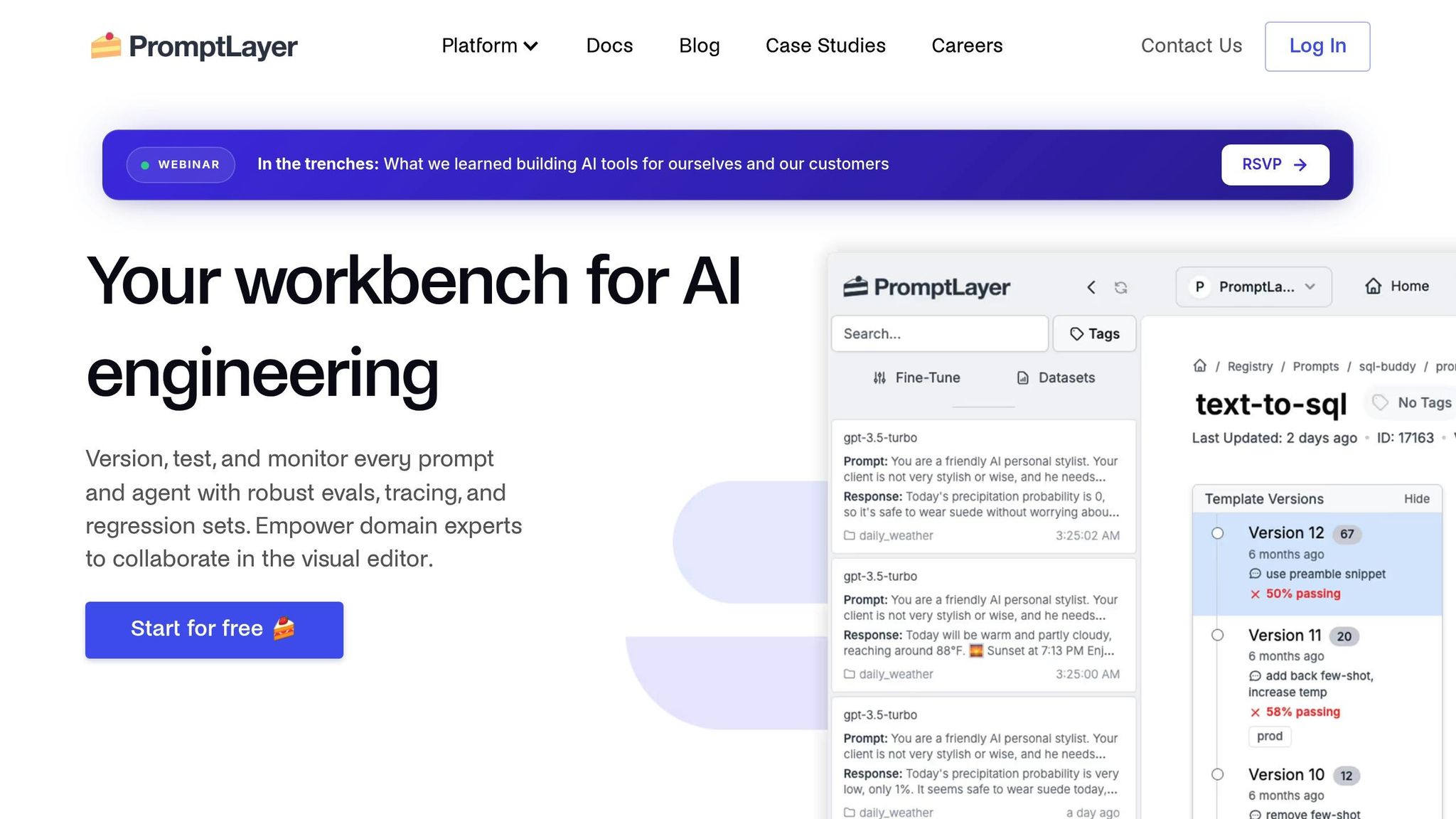

PromptLayer es un plataforma independiente del modelo diseñado para agilizar la ingeniería rápida en varios sistemas de IA, todo ello a través de un sistema unificado de plantillas de avisos.

Una de las principales fortalezas de PromptLayer es su capacidad de integrarse sin problemas con cualquier modelo de lenguaje de gran tamaño (LLM) mediante un sistema de plantilla de mensaje único. Esta flexibilidad permite a los equipos cambiar de proveedor de IA sin la molestia de tener que volver a escribir las instrucciones. Más allá de las interacciones basadas en texto, la plataforma también admite entradas multimodales, lo que permite el uso de datos basados en texto y visión. Es función de comparación directa es particularmente útil, ya que permite a los equipos evaluar diferentes LLM y sus parámetros uno al lado del otro. Esta capacidad ayuda a los desarrolladores a identificar los modelos más eficaces para tareas específicas, lo que garantiza un rendimiento óptimo durante el desarrollo rápido. Con estas funciones, PromptLayer proporciona un enfoque estructurado y eficiente para una administración rápida.

PromptLayer simplifica el proceso de optimización de las solicitudes con el control de versiones y las pruebas A/B integrados. Estas herramientas permiten a los equipos realizar un seguimiento de los cambios, supervisar el rendimiento y volver a versiones anteriores cuando sea necesario. El sistema de registro de la plataforma captura las métricas de ejecución esenciales, como los tiempos de respuesta, el uso de los tokens y la calidad de los resultados, lo que facilita el análisis de las tendencias y mejora el rendimiento general.

«Repetimos las instrucciones decenas de veces cada día. Sería imposible hacerlo de forma SEGURA sin PromptLayer». - Victor Duprez, director de ingeniería de Gorgias

El aumento de productividad que proporciona PromptLayer es sustancial. Seung Jae Cha, líder de producto de Habla, compartió cómo la plataforma les permitió completar meses de trabajo en solo una semana, escalando su proceso de creación de contenido desde esquemas simples hasta material completamente desarrollado y listo para el usuario.

PromptLayer ofrece tres opciones de precios: a Plan gratuito con un límite de 5000 solicitudes, un Plan Pro con un precio de 50 USD por usuario al mes y precios personalizados para el Plan empresarial. Con un fuerte 4.6/5 valoración global Con las mejores calificaciones en compatibilidad de modelos y soporte multimodal, PromptLayer se ha ganado su reputación como una herramienta confiable para la ingeniería rápida.

LangChain es un marco de código abierto diseñado para crear aplicaciones que utilizan modelos de lenguaje grandes (LLM). Va más allá de la ingeniería rápida básica, ya que ofrece un entorno flexible y modular para crear aplicaciones avanzadas Flujos de trabajo impulsados por IA.

La arquitectura independiente del proveedor de LangChain facilita la integración con varios proveedores de LLM mediante interfaces estandarizadas. Su diseño basado en cadenas conecta diferentes componentes a la perfección, por ejemplo, al combinar la generación de contenido con las tareas de refinamiento. El marco también admite la generación aumentada por recuperación, e incluye herramientas como cargadores de documentos, divisores de texto y opciones de almacenamiento vectorial. Estas funciones permiten que las aplicaciones funcionen de manera eficiente con amplias bases de conocimiento y, al mismo tiempo, mantienen un enfoque estructurado y modular que simplifica el seguimiento y la depuración.

Para garantizar la transparencia y la eficiencia, LangChain se integra con herramientas como LangSmith para rastrear la ejecución de flujos de trabajo rápidos. Esto permite a los desarrolladores supervisar el uso de los tokens, rastrear las rutas de ejecución e identificar los problemas en las diferentes etapas del flujo de trabajo, lo que facilita el proceso de depuración.

Como marco de código abierto, LangChain fomenta la colaboración a través de su amplia biblioteca de componentes y documentación detallada. Los equipos pueden compartir cadenas e integraciones personalizadas, mientras que su enfoque basado en agentes permite el desarrollo paralelo de diferentes módulos. Las contribuciones de la comunidad desempeñan un papel crucial a la hora de ampliar la biblioteca de integraciones prediseñadas, lo que permite a los equipos concentrarse en adaptar las aplicaciones a sus necesidades específicas. Este esfuerzo colectivo refuerza el desarrollo de flujos de trabajo de IA escalables y eficientes.

LangSmith sirve como una plataforma dedicada para probar y monitorear aplicaciones creadas con modelos de lenguaje de gran tamaño. Equipa a los desarrolladores con herramientas como métricas de rendimiento en tiempo real, registro de errores y funciones de depuración, lo que facilita el perfeccionamiento de las ejecuciones rápidas y la optimización de los flujos de trabajo. Al ofrecer información detallada, la plataforma ayuda a los equipos a identificar los cuellos de botella, analizar las tendencias de uso de los tokens y garantizar un rendimiento rápido y constante en varios entornos.

Diseñado para complementar el marco modular de LangChain, LangSmith refuerza las capacidades de monitoreo y prueba, garantizando que las estrategias rápidas sigan siendo confiables y efectivas.

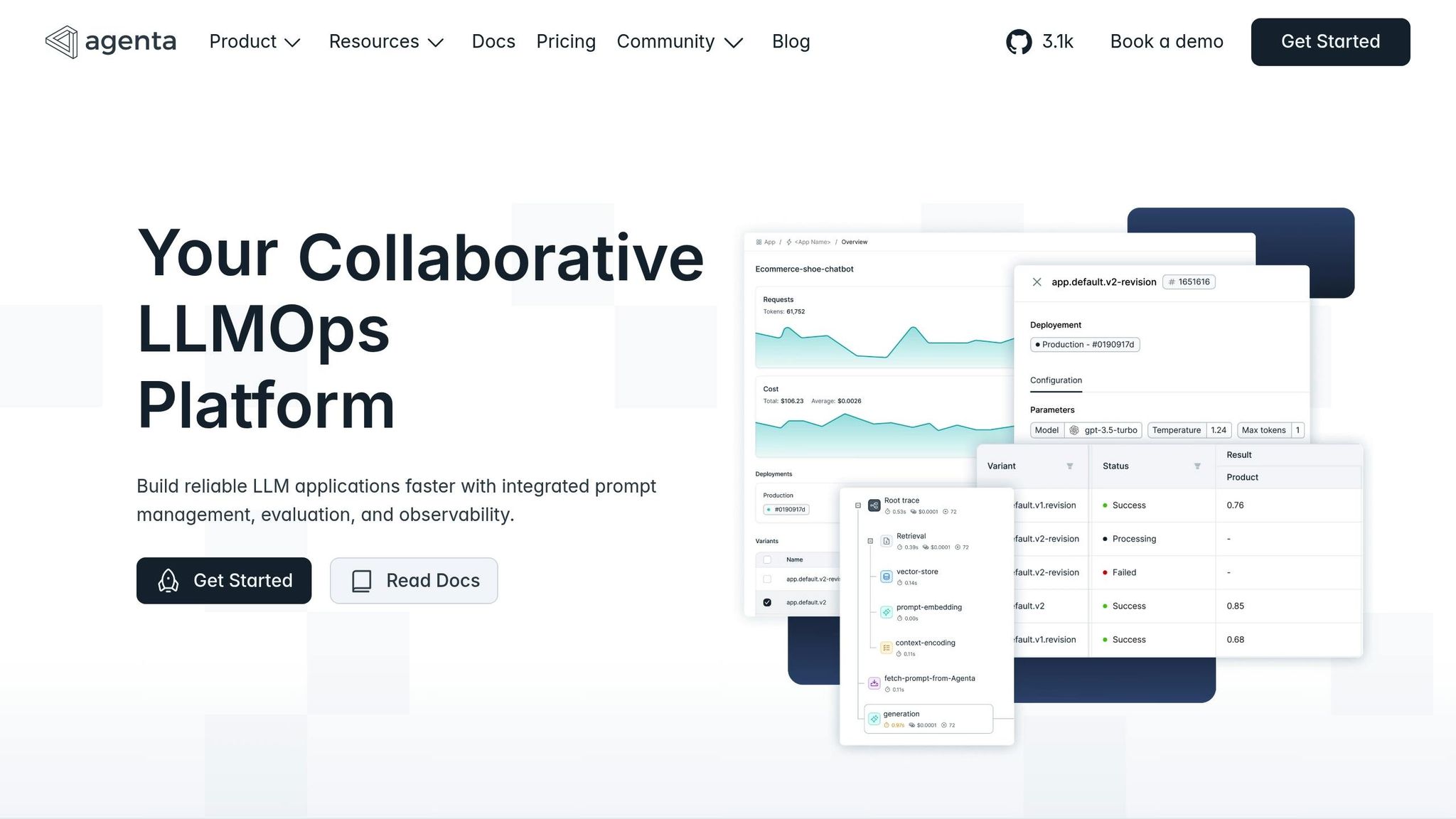

Agenta se basa en potentes herramientas de monitorización y pruebas para simplificar y mejorar la gestión rápida a lo largo de todo su ciclo de vida. Al actuar como una solución completa, apoya el desarrollo y la implementación de avisos con funciones como un sólido control de versiones.

Agenta se integra perfectamente con varios LLM y admite el control de versiones para configuraciones de aplicaciones completas, incluidos los flujos de trabajo complejos, como las canalizaciones de RAG. Esto permite a los equipos gestionar no solo las solicitudes individuales, sino también las configuraciones completas para sus aplicaciones de IA.

La plataforma ofrece un sistema todo en uno para crear, refinar y administrar versiones rápidas. Los usuarios pueden supervisar el rendimiento inmediato mediante un registro de auditoría que conecta los cambios con los resultados, garantizando la claridad y la responsabilidad. Funciones como la bifurcación, las opciones de reversión y las configuraciones del entorno, similares a los flujos de trabajo de desarrollo de software, añaden flexibilidad. Además, un área de juegos interactiva permite comparar en paralelo diferentes indicaciones con casos de prueba, lo que facilita la identificación de las versiones con mejor rendimiento.

Agenta vincula las indicaciones directamente a las evaluaciones, proporcionando pistas de auditoría detalladas y opciones de reversión para el cumplimiento y la garantía de calidad. Este nivel de control granular es particularmente valioso para las organizaciones que administran aplicaciones de LLM en evolución. Al ofrecer una plataforma unificada y apta para equipos, Agenta agiliza la gestión rápida de proyectos de IA colaborativos a gran escala.

Promptmetheus lleva la ingeniería rápida al siguiente nivel al centrarse en la experimentación fluida y la iteración rápida. Está diseñado para simplificar los flujos de trabajo, haciéndolo accesible tanto para expertos técnicos como para usuarios no técnicos.

Con sus análisis en tiempo real, Promptmetheus ofrece información sobre el rendimiento rápido a través de una interfaz fácil de usar. Los equipos pueden crear, probar e implementar indicaciones rápidamente sin la molestia de realizar configuraciones complejas. El generador de instrucciones de arrastrar y soltar facilita el ajuste de las instrucciones, mientras que su historial de versiones garantiza que se lleve un registro de todos los cambios, algo ideal para los equipos a los que les gusta experimentar rápidamente.

Una de sus características más destacadas son las pruebas automatizadas combinadas con herramientas de evaluación comparativa del rendimiento. Estas herramientas proporcionan comentarios instantáneos mediante métricas de evaluación integradas, lo que permite a los equipos identificar las mejores configuraciones en poco tiempo. El espacio de trabajo colaborativo mejora aún más la productividad al permitir que varios miembros del equipo trabajen simultáneamente según las instrucciones, y la sincronización en tiempo real mantiene a todos informados. Al combinar velocidad, automatización y trabajo en equipo, Promptmetheus se convierte en un poderoso aliado para las organizaciones que desean optimizar sus procesos de ingeniería rápidos.

Elija la herramienta adecuada evaluando las funciones, los precios y las capacidades clave.

La tabla ofrece una descripción general de las funciones principales, pero analicemos con más detalle los precios, las capacidades empresariales, la flexibilidad técnica y la colaboración para ayudar a identificar la que mejor se adapte a sus necesidades.

Administración de precios y costos

Prompts.ai destaca por su modelo de pago por uso, que puede reducir los costos hasta en un 98%, cobrando solo por el uso real de los tokens. Esto garantiza que las empresas paguen en función del uso, lo que evita el despilfarro de gastos. Sus funciones de nivel empresarial, que incluyen el seguimiento de los costes en tiempo real y una capa FinOps integrada, son especialmente valiosas para las grandes organizaciones que gestionan operaciones de IA de gran envergadura. Otras plataformas, como LangSmith y Promptmetheus, ofrecen precios por niveles, pero es posible que no ofrezcan el mismo nivel de transparencia u optimización de los costos.

Funciones empresariales y gobierno

Prompts.ai está diseñado para empresas y ofrece controles de gobierno sólidos, pistas de auditoría y funciones de cumplimiento diseñadas para las empresas de la lista Fortune 500. Estas herramientas son cruciales para las empresas que necesitan mantener una supervisión estricta de sus flujos de trabajo de inteligencia artificial. Si bien LangChain y LangSmith están dirigidos a desarrolladores con amplios recursos técnicos, carecen de las funciones de gobierno integrales que se encuentran en Prompts.ai.

Flexibilidad técnica

Para los equipos que se centran en crear aplicaciones de IA complejas, LangChain y LangSmith proporcionan herramientas avanzadas para la composición y depuración de cadenas. Sin embargo, estas plataformas suelen requerir una gran experiencia técnica. Por otro lado, Promptmetheus y Prompts.ai ofrecen interfaces fáciles de usar, con funciones como la creación de avisos mediante la función de arrastrar y soltar (Promptmetheus) y un ecosistema unificado para gestionar varios LLM (Prompts.ai). Esto hace que sean accesibles para una gama más amplia de usuarios, incluidos los equipos no técnicos.

Colaboración y trabajo en equipo

Las necesidades de colaboración varían ampliamente entre las organizaciones. Prompts.ai permite el trabajo en equipo en tiempo real con espacios de trabajo compartidos y acceso comunitario, lo que lo hace ideal para equipos más grandes. Promptmetheus también ofrece colaboración en tiempo real, pero es más adecuado para equipos más pequeños que se centran en la experimentación rápida. Plataformas como LangChain y LangSmith, si bien son potentes, se inclinan más hacia desarrolladores individuales o equipos altamente técnicos, con herramientas de colaboración menos completas.

Las herramientas mencionadas anteriormente se han convertido en la columna vertebral de una transformación estratégica en las operaciones de IA. Las plataformas especializadas de ingeniería rápida son ahora imprescindibles para las organizaciones que desean integrar la IA de manera eficaz. Estas herramientas no solo simplifican el proceso de creación de solicitudes, sino que también convierten la experimentación desorganizada en flujos de trabajo estructurados y repetibles que generan resultados mensurables.

Las ventajas financieras de invertir en herramientas especializadas son evidentes. Si bien los modelos de licencias tradicionales suelen sobrecargar los presupuestos con tarifas fijas independientemente del uso, los sistemas modernos de pago por uso ofrecen una mayor transparencia y eficiencia en los costos. Por ejemplo, los planes de nivel empresarial con funciones empresariales completas comienzan en 99$ por miembro al mes.

Para las empresas de los Estados Unidos, las funciones de cumplimiento y gobierno son especialmente críticas. Las soluciones de nivel empresarial incluyen la supervisión del cumplimiento, que ofrece la visibilidad y la auditabilidad necesarias para cumplir con los estándares reglamentarios y gestionar los riesgos de manera eficaz.

Más allá del ahorro de costos, estas plataformas mejoran las operaciones al agilizar los flujos de trabajo. La orquestación unificada de la IA elimina la proliferación de herramientas y centraliza la administración de modelos, lo que permite procesos más fluidos y eficientes. En conjunto, estos beneficios (rentabilidad, cumplimiento y optimización del flujo de trabajo) preparan a las organizaciones para alcanzar un éxito escalable.

La mejor plataforma depende de las prioridades técnicas y la escala de la organización. Los equipos centrados en los desarrolladores pueden preferir marcos de código abierto como LangChain por su flexibilidad. Por el contrario, las empresas que se centran en la gobernanza, el control de costes y la escalabilidad se beneficiarán más de las plataformas integrales que centralizan y organizan la adopción de la IA. A medida que el campo de la ingeniería rápida siga evolucionando con los nuevos modelos y la creciente adopción empresarial, las empresas que hoy inviertan en herramientas avanzadas estarán mejor preparadas para escalar sin problemas y mantener una ventaja competitiva en este panorama tecnológico acelerado.

«Descubra cómo las principales empresas, equipos creativos e instituciones académicas utilizan prompts.ai para implementar flujos de trabajo de IA seguros y compatibles, lo que ahorra tiempo, reduce costos y genera resultados reales». - prompts.ai

Prompts.ai permite a las grandes empresas reducir los gastos relacionados con la IA al optimizar el uso de los tokens y agilizar la administración rápida, lo que permite lograr posibles reducciones de costos de hasta 98%. Al ofrecer indicaciones personalizadas y una plataforma de inteligencia artificial centralizada, simplifica los flujos de trabajo complejos, refuerza la gobernanza y aumenta la rentabilidad. Esto la convierte en una solución esencial para gestionar eficazmente las operaciones de IA a gran escala.

Las herramientas de código abierto, como LangChain, ofrecen una gran cantidad de personalización y flexibilidad, lo que las convierte en una excelente opción para los equipos con las habilidades técnicas necesarias para adaptar las soluciones a sus necesidades únicas. Ofrecen espacio para la experimentación y las modificaciones extensas, pero a menudo exigen una inversión considerable de tiempo y recursos para implementarlas con éxito.

Por el contrario, las soluciones empresariales como Prompts.ai están diseñados para proporcionar flujos de trabajo optimizados, soporte dedicado y fácil integración. Estas plataformas están dirigidas a las organizaciones que valoran la eficiencia y la fiabilidad, y ofrecen funciones listas para usar sin necesidad de realizar grandes ajustes técnicos. Esto las convierte en una opción inteligente para las empresas que desean mejorar sus iniciativas de inteligencia artificial de manera rápida y eficiente.

Herramientas como Prompts.ai mejoran los resultados de los proyectos de IA al integrar varios LLM para impulsar precisión, confiabilidad y calidad de salida general. Al cotejar las respuestas en varios modelos, estas herramientas ayudan a reducir los errores y a limitar las alucinaciones, proporcionando resultados más fiables.

Características como la votación modelo, en la que varios LLM colaboran en la toma de decisiones, mejoran aún más la precisión y la coherencia de los resultados de la IA. Este enfoque permite a los usuarios crear soluciones más sólidas y confiables, lo que infunde una mayor confianza en sus sistemas de inteligencia artificial.