Une ingénierie rapide est vitale pour créer des solutions d'IA efficaces, mais leur mise à l'échelle entre les équipes et les projets peut être un défi. Des problèmes tels que des résultats incohérents, un manque de contrôle de version et des coûts imprécis entravent souvent la réussite. Les outils modernes résolvent ces problèmes en centralisant les flux de travail, en optimisant les coûts et en garantissant la conformité pour l'utilisation de l'IA au niveau de l'entreprise.

Voici un bref aperçu de six outils de pointe pour rationaliser vos opérations d'IA :

Ces outils répondent à différents besoins, des développeurs individuels aux équipes d'entreprise, garantissant de meilleurs résultats tout en économisant du temps et des ressources.

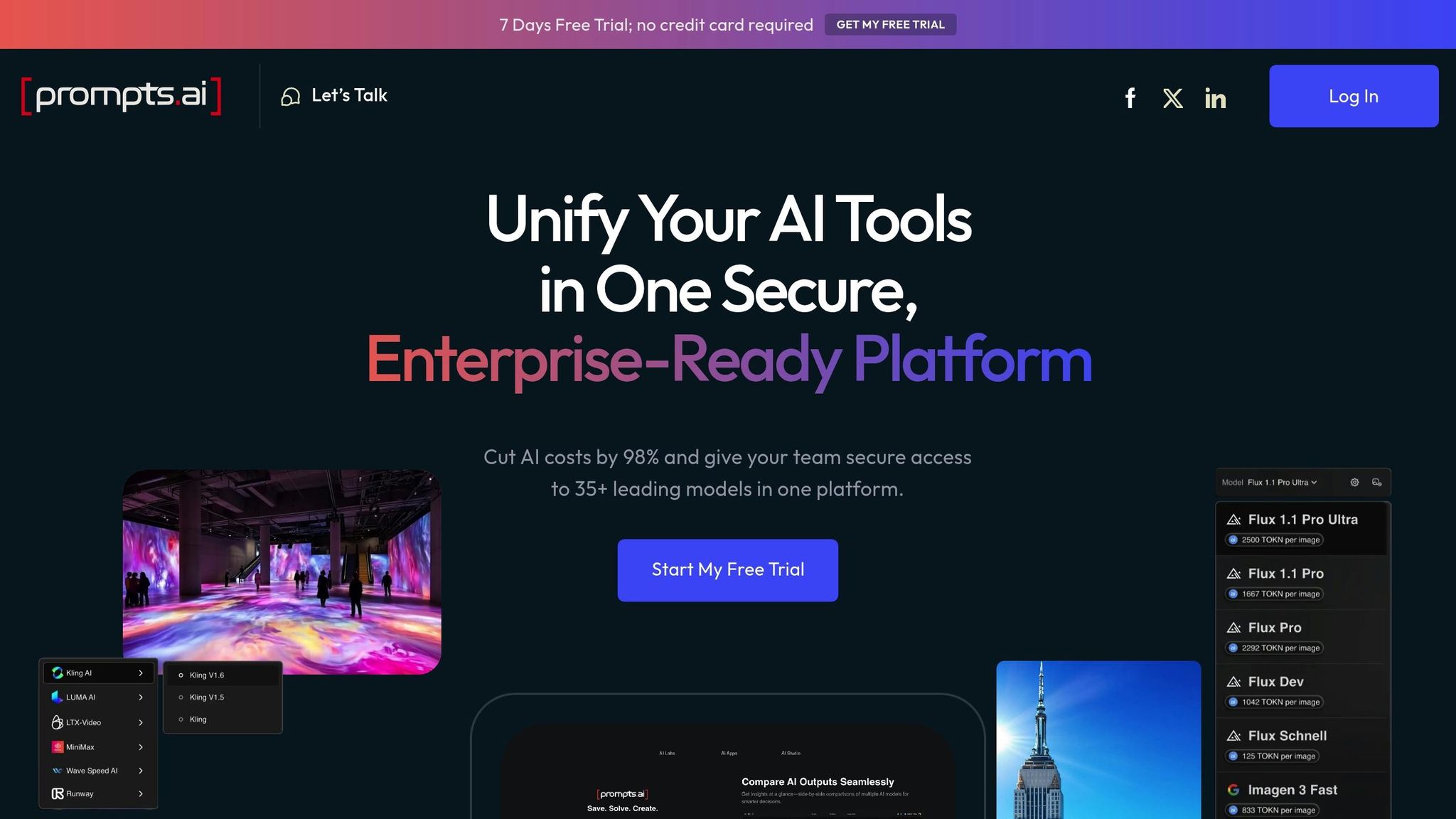

Prompts.ai est un plateforme d'orchestration d'IA de niveau entreprise qui rationalise les opérations d'IA en intégrant plus de 35 modèles linguistiques de pointe dans une interface unique et sécurisée. Conçu pour relever les défis liés à la mise à l'échelle de l'IA, il réduit la prolifération des outils, garantit la gouvernance et réduit les coûts des logiciels d'IA jusqu'à 98 %.

Prompts.ai regroupe les principaux modèles de langage tels que GPT-4, Claude, Lama, et Gémeaux sous un même toit, vous évitant ainsi de jongler avec plusieurs abonnements. Cet accès centralisé permet aux équipes de comparer les performances des modèles côte à côte, ce qui les aide à choisir celui qui convient le mieux à leurs besoins spécifiques, le tout sans passer d'une plateforme à l'autre.

Cette fonctionnalité est particulièrement utile pour les entreprises du Fortune 500, les agences de création et les laboratoires de recherche qui ont du mal à gérer divers outils d'IA. En consolidant l'accès, la plateforme permet aux équipes de se concentrer sur l'obtention de résultats plutôt que sur la gestion de systèmes fragmentés. Il prend également en charge le suivi détaillé et le contrôle des versions, garantissant ainsi une évolution fluide des stratégies rapides.

Prompts.ai introduit un Système de type Git pour une gestion rapide, offrant des fonctionnalités telles que l'historique rapide, le suivi des modifications et les annulations instantanées. Cela élimine la confusion liée à la gestion manuelle des versions éparpillées.

« Gérer les instructions manuellement, c'est comme coder sans Git. Amusez-vous pendant environ cinq minutes. Alors c'est le chaos. » - Daniel Ostrovsky, expert en développement Web et responsable des équipes

La plateforme simplifie également Test A/B des instructions, transformant l'expérimentation en un processus structuré. Au lieu de se fier à des conjectures, les équipes peuvent systématiquement développer, tester et déployer des instructions en toute confiance.

Prompts.ai est conçu à la fois pour les ingénieurs spécialisés en solo et pour les équipes de grandes entreprises, permettant flux de travail collaboratifs dans toutes les organisations. Sa fonctionnalité « Time Savers » permet aux équipes de partager des flux de travail rapides conçus par des experts, rendant ainsi les techniques avancées accessibles à tous.

De plus, la plateforme propose un Programme de certification Prompt Engineer, en dotant les organisations des compétences et des meilleures pratiques nécessaires pour exceller. En favorisant une approche axée sur la communauté, Prompts.ai permet aux équipes de tirer parti d'une expertise partagée plutôt que de repartir de zéro pour chaque nouveau projet.

Prompts.ai inclut un couche FinOps qui suit l'utilisation des jetons sur tous les modèles, fournissant des informations en temps réel sur les dépenses liées à l'IA. Cette transparence permet aux organisations d'aligner les coûts sur les résultats commerciaux et d'allouer les ressources de manière plus efficace.

Avec ses Système de crédits TOKN Pay-As-You-Go, la plateforme élimine les frais récurrents, alignant les dépenses sur l'utilisation réelle. Cette approche permet non seulement d'éviter les coûts élevés liés à plusieurs abonnements, mais elle permet également d'obtenir de meilleurs résultats grâce à des instructions optimisées et à une gestion centralisée des coûts.

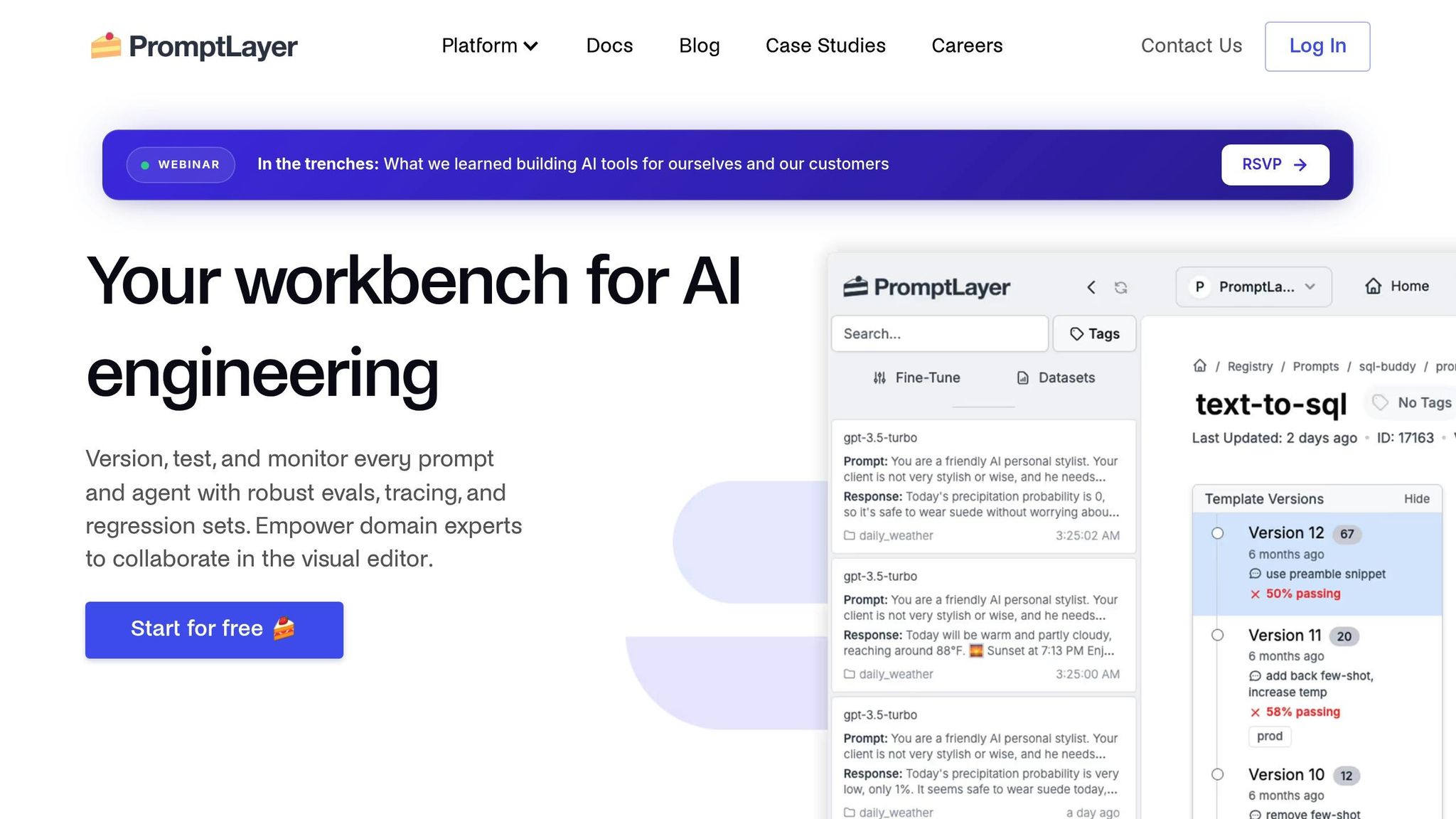

PromptLayer est un plateforme indépendante du modèle conçu pour rationaliser l'ingénierie rapide dans divers systèmes d'IA, le tout grâce à un système de modèles d'invite unifié.

L'un des principaux atouts de PromptLayer est sa capacité à s'intégrer parfaitement à n'importe quel grand modèle de langage (LLM) à l'aide d'un système de modèle à invite unique. Cette flexibilité permet aux équipes de passer d'un fournisseur d'IA à un autre sans avoir à réécrire les instructions. Au-delà des interactions textuelles, la plateforme prend également en charge entrées multimodales, permettant d'utiliser à la fois du texte et des données visuelles. C'est fonction de comparaison directe est particulièrement utile, car elle permet aux équipes d'évaluer les différents LLM et leurs paramètres côte à côte. Cette fonctionnalité aide les développeurs à identifier les modèles les plus efficaces pour des tâches spécifiques, garantissant ainsi des performances optimales lors d'un développement rapide. Grâce à ces fonctionnalités, PromptLayer propose une approche structurée et efficace de la gestion rapide.

PromptLayer simplifie le processus d'optimisation des invites grâce à un contrôle de version intégré et à des tests A/B. Ces outils permettent aux équipes de suivre les modifications, de surveiller les performances et de revenir aux versions précédentes si nécessaire. Le système de journalisation de la plateforme capture les indicateurs d'exécution essentiels, tels que les temps de réponse, l'utilisation des jetons et la qualité de sortie, ce qui facilite l'analyse des tendances et améliore les performances globales.

« Nous répétons les instructions des dizaines de fois par jour. Il serait impossible de le faire de manière SÛRE sans PromptLayer. » - Victor Duprez, directeur de l'ingénierie chez Gorgias

L'augmentation de productivité apportée par PromptLayer est substantielle. Seung Jae Cha, chef de produit chez Parlez, a expliqué comment la plateforme leur avait permis d'accomplir des mois de travail en une semaine seulement, en faisant évoluer leur processus de création de contenu, passant de simples plans à du matériel entièrement développé et prêt à être utilisé.

PromptLayer propose trois options de tarification : un Plan gratuit avec une limite de 5 000 demandes, Forfait Pro au prix de 50$ par utilisateur et par mois, et une tarification personnalisée pour Plan d'entreprise. Avec une forte Note globale 4,6/5 et les meilleures notes en matière de compatibilité des modèles et de support multimodal, PromptLayer a acquis sa réputation d'outil fiable pour une ingénierie rapide.

LangChain est un framework open source conçu pour créer des applications utilisant de grands modèles de langage (LLM). Il va au-delà de l'ingénierie rapide de base, offrant un environnement flexible et modulaire permettant de créer des Workflows pilotés par l'IA.

L'architecture indépendante des fournisseurs de LangChain facilite l'intégration avec divers fournisseurs LLM à l'aide d'interfaces standardisées. Sa conception basée sur la chaîne relie différents composants de manière fluide, tels que la combinaison de la génération de contenu avec des tâches de raffinement. Le framework prend également en charge la génération augmentée par récupération, avec des outils tels que des chargeurs de documents, des séparateurs de texte et des options de stockage vectoriel. Ces fonctionnalités permettent aux applications de fonctionner efficacement avec des bases de connaissances étendues tout en conservant une approche structurée et modulaire qui simplifie le suivi et le débogage.

Pour garantir transparence et efficacité, LangChain s'intègre à des outils tels que LangSmith pour suivre l'exécution de flux de travail rapides. Cela permet aux développeurs de surveiller l'utilisation des jetons, de suivre les chemins d'exécution et d'identifier les problèmes à différentes étapes du flux de travail, simplifiant ainsi le processus de débogage.

En tant que framework open source, LangChain encourage la collaboration grâce à sa vaste bibliothèque de composants et à sa documentation détaillée. Les équipes peuvent partager des chaînes et des intégrations personnalisées, tandis que son approche basée sur les agents permet le développement parallèle de différents modules. Les contributions de la communauté jouent un rôle crucial dans l'extension de la bibliothèque d'intégrations prédéfinies, permettant aux équipes de se concentrer sur l'adaptation des applications à leurs besoins spécifiques. Cet effort collectif renforce le développement de flux de travail d'IA évolutifs et efficaces.

LangSmith sert de plate-forme dédiée au test et à la surveillance des applications créées avec de grands modèles de langage. Il fournit aux développeurs des outils tels que des mesures de performance en temps réel, la journalisation des erreurs et des fonctionnalités de débogage, ce qui facilite l'affinement des exécutions rapides et l'optimisation des flux de travail. En fournissant des informations détaillées, la plateforme aide les équipes à identifier les goulots d'étranglement, à analyser les tendances d'utilisation des jetons et à garantir des performances rapides et constantes dans divers environnements.

Conçu pour compléter le cadre modulaire de LangChain, LangSmith renforce les capacités de surveillance et de test, garantissant ainsi la fiabilité et l'efficacité des stratégies rapides.

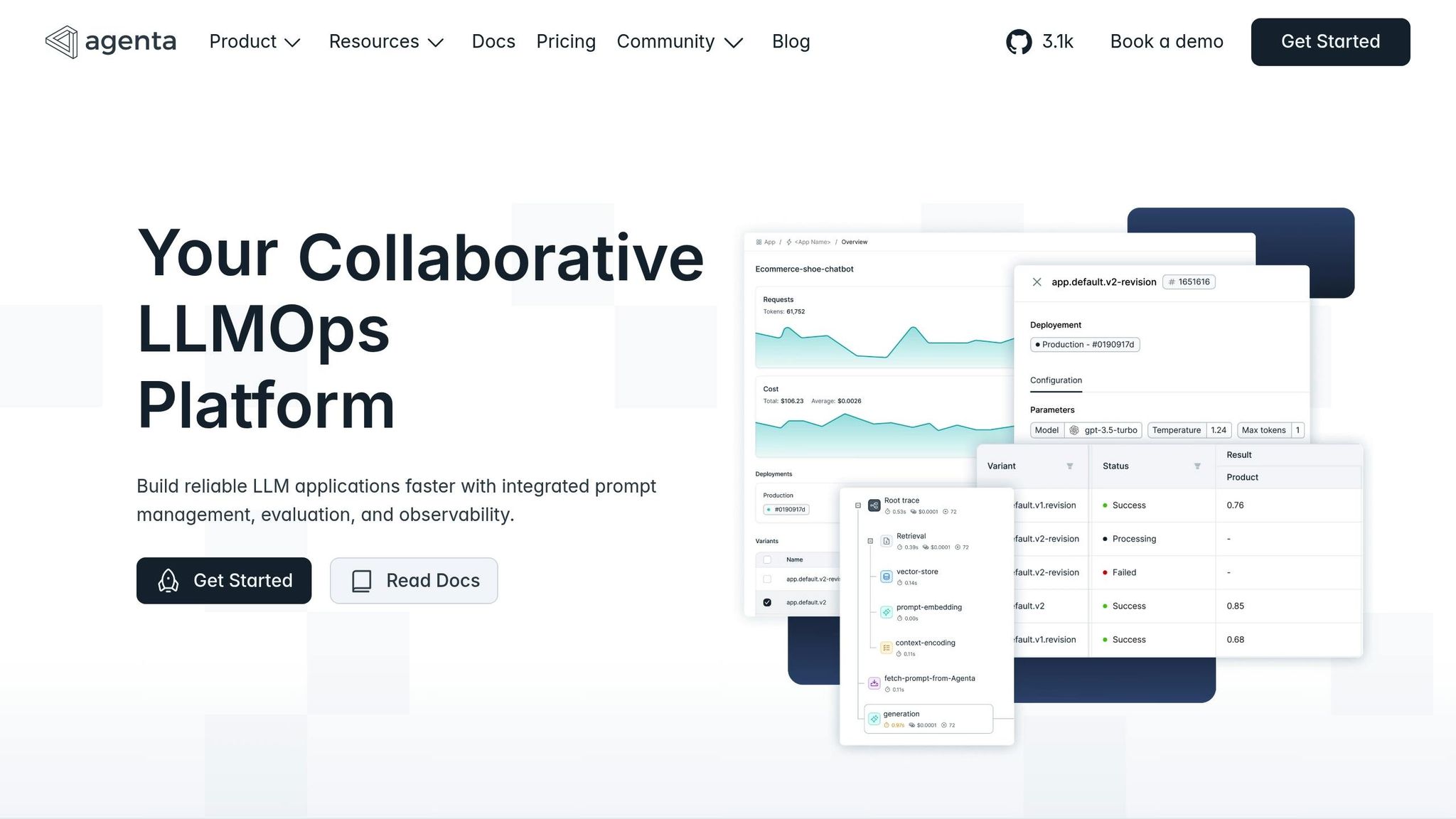

Agenta s'appuie sur de puissants outils de surveillance et de test pour simplifier et améliorer la gestion rapide tout au long de son cycle de vie. Agissant comme une solution complète, elle prend en charge le développement et le déploiement d'invites dotées de fonctionnalités telles qu'un contrôle de version robuste.

Agenta s'intègre parfaitement à divers LLM et prend en charge la gestion des versions pour des configurations d'applications complètes, y compris des flux de travail complexes tels que les pipelines RAG. Cela permet aux équipes de gérer non seulement les demandes individuelles, mais également les configurations complètes de leurs applications d'IA.

La plateforme propose un système tout-en-un pour créer, affiner et gérer des versions rapides. Les utilisateurs peuvent surveiller les performances rapides grâce à une piste d'audit qui relie les changements aux résultats, garantissant ainsi la clarté et la responsabilité. Des fonctionnalités telles que le branchement, les options de restauration et les configurations d'environnement, similaires aux flux de développement logiciel, apportent de la flexibilité. En outre, un terrain de jeu interactif permet de comparer côte à côte différentes instructions par rapport à des cas de test, ce qui facilite l'identification des versions les plus performantes.

Agenta relie les instructions directement aux évaluations, fournissant des pistes d'audit détaillées et des options d'annulation pour la conformité et l'assurance qualité. Ce niveau de contrôle granulaire est particulièrement utile pour les organisations qui gèrent des applications LLM en évolution. En proposant une plateforme unifiée et conviviale pour les équipes, Agenta rationalise la gestion rapide des projets d'IA collaboratifs à grande échelle.

Promptmetheus fait passer l'ingénierie rapide au niveau supérieur en se concentrant sur une expérimentation fluide et une itération rapide. Il est conçu pour simplifier les flux de travail, en le rendant accessible à la fois aux experts techniques et aux utilisateurs non techniques.

Grâce à ses analyses en temps réel, Promptmetheus fournit des informations sur les performances rapides via une interface facile à utiliser. Les équipes peuvent créer, tester et déployer rapidement des instructions sans avoir à se soucier de configurations complexes. Le générateur d'invites par glisser-déposer facilite la modification des invites, tandis que son historique des versions garantit le suivi de chaque modification, ce qui est idéal pour les équipes qui apprécient les expériences rapides.

L'une de ses caractéristiques les plus remarquables est l'automatisation des tests associés à des outils d'analyse comparative des performances. Ces outils fournissent un feedback instantané à l'aide de mesures d'évaluation intégrées, permettant aux équipes d'identifier les meilleures configurations en un rien de temps. L'espace de travail collaboratif améliore encore la productivité en permettant à plusieurs membres de l'équipe de travailler simultanément sur les instructions, la synchronisation en temps réel permettant à tout le monde de rester sur la même longueur d'onde. En combinant rapidité, automatisation et travail d'équipe, Promptmetheus devient un puissant allié pour les organisations qui souhaitent rationaliser leurs processus d'ingénierie rapides.

Choisissez le bon outil en évaluant les fonctionnalités, les prix et les fonctionnalités clés.

Le tableau donne un aperçu des principales fonctionnalités, mais examinons plus en détail la tarification, les fonctionnalités d'entreprise, la flexibilité technique et la collaboration afin de déterminer la solution la mieux adaptée à vos besoins.

Gestion des prix et des coûts

Prompts.ai se distingue par son modèle de paiement à l'utilisation, qui permet de réduire les coûts jusqu'à 98 %, en ne facturant que l'utilisation réelle des jetons. Cela garantit que les entreprises paient en fonction de leur utilisation, évitant ainsi des dépenses inutiles. Ses fonctionnalités destinées aux entreprises, notamment le suivi des coûts en temps réel et une couche FinOps intégrée, sont particulièrement utiles pour les grandes organisations qui gèrent de vastes opérations d'IA. D'autres plateformes, comme LangSmith et Promptmetheus, proposent une tarification échelonnée mais peuvent ne pas offrir le même niveau de transparence ou d'optimisation des coûts.

Fonctionnalités et gouvernance de l'entreprise

Prompts.ai est conçu pour les entreprises et propose des contrôles de gouvernance robustes, des pistes d'audit et des fonctionnalités de conformité adaptées aux entreprises du Fortune 500. Ces outils sont essentiels pour les entreprises qui doivent maintenir une surveillance stricte de leurs flux de travail d'IA. Bien que LangChain et LangSmith répondent aux besoins des développeurs disposant de ressources techniques approfondies, ils ne disposent pas des fonctionnalités de gouvernance complètes présentes dans Prompts.ai.

Flexibilité technique

Pour les équipes qui se concentrent sur la création d'applications d'IA complexes, LangChain et LangSmith fournissent des outils avancés pour la composition de chaînes et le débogage. Cependant, ces plateformes nécessitent souvent une expertise technique importante. D'autre part, Promptmetheus et Prompts.ai proposent des interfaces conviviales, avec des fonctionnalités telles que la création d'invites par glisser-déposer (Promptmetheus) et un écosystème unifié pour la gestion de plusieurs LLM (Prompts.ai). Cela les rend accessibles à un plus large éventail d'utilisateurs, y compris aux équipes non techniques.

Collaboration et travail d'équipe

Les besoins en matière de collaboration varient considérablement d'une organisation à l'autre. Prompts.ai prend en charge le travail d'équipe en temps réel avec des espaces de travail partagés et un accès communautaire, ce qui le rend idéal pour les grandes équipes. Promptmetheus propose également une collaboration en temps réel, mais convient mieux aux petites équipes axées sur des expérimentations rapides. Les plateformes telles que LangChain et LangSmith, bien que puissantes, s'adressent davantage à des développeurs individuels ou à des équipes hautement techniques, avec des outils de collaboration moins complets.

Les outils évoqués ci-dessus sont devenus l'épine dorsale d'une transformation stratégique des opérations d'IA. Les plateformes d'ingénierie rapide spécialisées sont désormais indispensables pour les organisations qui souhaitent intégrer efficacement l'IA. Ces outils simplifient non seulement le processus de création d'invites, mais transforment également les expériences désorganisées en flux de travail structurés et reproductibles qui génèrent des résultats mesurables.

Les avantages financiers liés à l'investissement dans des outils dédiés sont évidents. Alors que les modèles de licence traditionnels alourdissent souvent les budgets avec des frais fixes quelle que soit l'utilisation, les systèmes modernes de paiement à l'utilisation offrent une transparence des coûts et une efficacité accrues. Par exemple, les forfaits de niveau professionnel avec des fonctionnalités complètes pour les entreprises commencent à 99$ par membre et par mois.

Aux États-Unis, les fonctionnalités de conformité et de gouvernance sont particulièrement importantes pour les entreprises. Les solutions d'entreprise incluent la surveillance de la conformité, offrant la visibilité et l'auditabilité nécessaires pour respecter les normes réglementaires et gérer les risques efficacement.

Au-delà des économies de coûts, ces plateformes améliorent les opérations en rationalisant les flux de travail. L'orchestration unifiée de l'IA élimine la prolifération des outils et centralise la gestion des modèles, permettant ainsi des processus plus fluides et plus efficaces. Ensemble, ces avantages (rentabilité, conformité et optimisation des flux de travail) permettent aux entreprises de réussir sur une base évolutive.

La meilleure plateforme dépend des priorités techniques et de l'envergure de l'organisation. Les équipes centrées sur les développeurs peuvent préférer les frameworks open source tels que LangChain pour leur flexibilité. En revanche, les entreprises axées sur la gouvernance, le contrôle des coûts et l'évolutivité bénéficieront davantage de plateformes complètes qui centralisent et organisent l'adoption de l'IA. Alors que le domaine de l'ingénierie rapide continue d'évoluer avec de nouveaux modèles et une adoption croissante par les entreprises, les entreprises qui investissent aujourd'hui dans des outils avancés seront mieux équipées pour évoluer de manière fluide et conserver un avantage concurrentiel dans ce paysage technologique en évolution rapide.

« Découvrez comment les grandes entreprises, les équipes créatives et les institutions universitaires utilisent prompts.ai pour déployer des flux de travail d'IA sécurisés et conformes, ce qui permet de gagner du temps, de réduire les coûts et d'obtenir des résultats concrets. » - prompts.ai

Prompts.ai permet aux grandes entreprises de réduire les dépenses liées à l'IA en optimisant l'utilisation des jetons et en rationalisant la gestion rapide, ce qui permet de réaliser des réductions de coûts potentielles allant jusqu'à 98 %. En proposant des instructions personnalisées et une plateforme d'IA centralisée, elle simplifie les flux de travail complexes, renforce la gouvernance et améliore la rentabilité. Cela en fait une solution essentielle pour gérer efficacement les opérations d'IA à grande échelle.

Les outils open source, tels que LangChain, offrent beaucoup de personnalisation et de flexibilité, ce qui en fait une excellente option pour les équipes possédant les compétences techniques nécessaires pour adapter les solutions à leurs besoins uniques. Ils offrent une marge d'expérimentation et de modifications importantes, mais nécessitent souvent un investissement considérable en temps et en ressources pour être mis en œuvre avec succès.

En revanche, des solutions d'entreprise telles que Prompts.ai sont conçus pour fournir des flux de travail rationalisés, une assistance dédiée et une intégration facile. Ces plateformes s'adressent aux organisations qui valorisent l'efficacité et la fiabilité, en fournissant des fonctionnalités prêtes à l'emploi sans nécessiter d'ajustements techniques importants. Cela en fait un choix judicieux pour les entreprises qui souhaitent améliorer leurs initiatives d'IA rapidement et efficacement.

Des outils tels que Prompts.ai améliorent les résultats des projets d'IA en intégrant plusieurs LLM pour améliorer précision, fiabilité et qualité globale de sortie. En recoupant les réponses entre différents modèles, ces outils contribuent à réduire les erreurs et à limiter les hallucinations, fournissant ainsi des résultats plus fiables.

Des fonctionnalités telles que le vote par modèle, où plusieurs LLM collaborent à la prise de décision, améliorent encore la précision et la cohérence des résultats de l'IA. Cette approche permet aux utilisateurs de créer des solutions plus solides et plus fiables, renforçant ainsi la confiance dans leurs systèmes d'IA.