Estoy buscando herramientas para comparar los resultados de modelos de IA, como GPT-4, Claudio, o Llama? Esto es lo que necesitas saber:

Estas herramientas simplifican la toma de decisiones al ayudar a los usuarios a identificar los modelos más rentables y de mejor rendimiento para sus necesidades. A continuación se muestra una comparación rápida de sus funciones.

Elige en función del presupuesto, las necesidades de seguridad y las prioridades del flujo de trabajo de tu equipo.

Prompts.ai es una plataforma de nivel empresarial que reúne a más de 35 LLM líderes en una interfaz única y segura, lo que elimina la molestia de tener que hacer malabares con varias herramientas.

Diseñado para empresas, agencias y laboratorios de investigación de Fortune 500, Prompts.ai puede reducir los costos de IA hasta en un 98% y, al mismo tiempo, mantener una seguridad empresarial de primer nivel. Desde un panel unificado, los equipos pueden acceder a modelos como GPT-4, Claude, LLama y Géminis.

Una característica destacada de Prompts.ai es su comparación lado a lado herramienta. Esto permite a los usuarios ejecutar las mismas instrucciones en diferentes modelos simultáneamente, lo que facilita la identificación de la opción con mejor rendimiento sin necesidad de cambiar constantemente de plataforma ni de realizar un seguimiento manual de los resultados.

La plataforma también incluye cambio instantáneo de modelos, que conserva el contexto de su trabajo. Esto es especialmente útil para comprobar cómo diferentes modelos gestionan la misma tarea o para optimizar resultados específicos, como la creatividad, la precisión o la rentabilidad.

Otra característica poderosa es encadenamiento de agentes, donde la salida de un modelo puede alimentar a otro. Esto es ideal para crear flujos de trabajo complejos y probar el rendimiento conjunto de varias combinaciones de modelos para lograr objetivos específicos. Estas capacidades se integran perfectamente con la supervisión en tiempo real para agilizar el proceso de evaluación.

Prompts.ai ofrece comentarios en tiempo real sobre el rendimiento, lo que ayuda a los equipos a tomar decisiones más rápidas e informadas durante las evaluaciones.

La plataforma incluye un Capa FinOps que rastrea cada token utilizado en todos los modelos. Esta transparencia permite a los equipos comprender completamente sus costos de IA y asignar los recursos de manera más eficaz. Al proporcionar información detallada sobre los costos de tareas específicas, los equipos pueden equilibrar sus objetivos de rendimiento con las consideraciones presupuestarias.

Con análisis de uso en tiempo real, los equipos obtienen información útil sobre las tendencias de rendimiento de los modelos. Esto convierte lo que de otro modo serían pruebas ad hoc en un proceso de evaluación estructurado que contribuye a una mejor toma de decisiones a largo plazo. La combinación de estas características garantiza la transparencia y la eficiencia durante todo el proceso de evaluación.

Prompts.ai admite más de 35 LLM líderes y ofrece herramientas para tareas como la generación de código, la escritura creativa y el análisis de datos. La biblioteca de la plataforma se actualiza continuamente para garantizar el acceso a los modelos más recientes.

Esta amplia selección permite a los equipos comparar el rendimiento de varios proveedores y tipos de modelos de IA. Ya sea que se centre en tareas técnicas, proyectos creativos o necesidades analíticas, Prompts.ai proporciona las herramientas adecuadas para una evaluación exhaustiva.

Prompts.ai prioriza la seguridad de nivel empresarial, garantizando que los datos confidenciales permanezcan protegidos y reduciendo el riesgo de exposición de terceros.

La plataforma incluye herramientas de gobierno integradas y pistas de auditoría para cada flujo de trabajo, lo que simplifica el cumplimiento de los requisitos reglamentarios. Los equipos pueden hacer un seguimiento de los modelos a los que se accedió, las instrucciones utilizadas y los resultados generados, creando un registro detallado con fines normativos y de responsabilidad.

Con su Créditos TOKN de pago por uso, la plataforma elimina la necesidad de pagar cuotas de suscripción recurrentes. En cambio, los costos se alinean directamente con el uso real, lo que brinda a las organizaciones una mayor flexibilidad y control sobre sus gastos en inteligencia artificial. Este modelo permite a los equipos aumentar o reducir su uso en función de las necesidades de sus proyectos, lo que garantiza la rentabilidad y la adaptabilidad.

Deepchecks es una plataforma de código abierto diseñada para probar y monitorear continuamente los modelos de aprendizaje automático. Al aplicar los principios de las pruebas de software tradicionales, garantiza un enfoque estructurado para evaluar los resultados de los modelos lingüísticos de gran tamaño (LLM). Esta herramienta sirve como una opción de validación rigurosa, que complementa las plataformas empresariales como Prompts.ai.

A diferencia de las plataformas centradas en la empresa, Deepchecks prioriza la validación exhaustiva del modelo. Incluye suites de validación automatizadas que permiten a los usuarios comparar los resultados de los modelos en función de criterios personalizados y análisis por lotes. Con funciones como la detección de desviaciones y la capacidad de definir métricas personalizadas, ayuda a identificar las desviaciones del comportamiento esperado.

Deepchecks realiza un seguimiento activo del rendimiento de la producción mediante alertas automatizadas vinculadas a los umbrales de calidad. Sus sólidos sistemas de análisis y detección de anomalías facilitan la identificación y la solución rápida de los comportamientos inesperados.

Para proteger los datos confidenciales, Deepchecks admite la implementación local. Además, proporciona un registro de auditoría para documentar las actividades de prueba y garantizar la alineación con los requisitos de cumplimiento.

DeepEval es un marco de código abierto diseñado para evaluar los resultados de los modelos de lenguaje grande (LLM) y, al mismo tiempo, priorizar la privacidad de los datos. Sirve como una herramienta confiable para satisfacer la creciente necesidad de evaluaciones de LLM seguras y precisas.

DeepEval ofrece herramientas flexibles para comparar los resultados uno al lado del otro y establecer criterios de evaluación personalizados. Estas funciones ayudan a los equipos a evaluar las respuestas de los modelos con precisión, lo que satisface las diversas exigencias de la evaluación moderna de la IA.

El marco se integra perfectamente en los flujos de trabajo de desarrollo, lo que permite a los equipos supervisar el rendimiento en tiempo real y realizar los ajustes necesarios.

Al ejecutar las evaluaciones de forma local, DeepEval garantiza que los datos confidenciales permanezcan protegidos, lo que proporciona una capa adicional de seguridad para los usuarios.

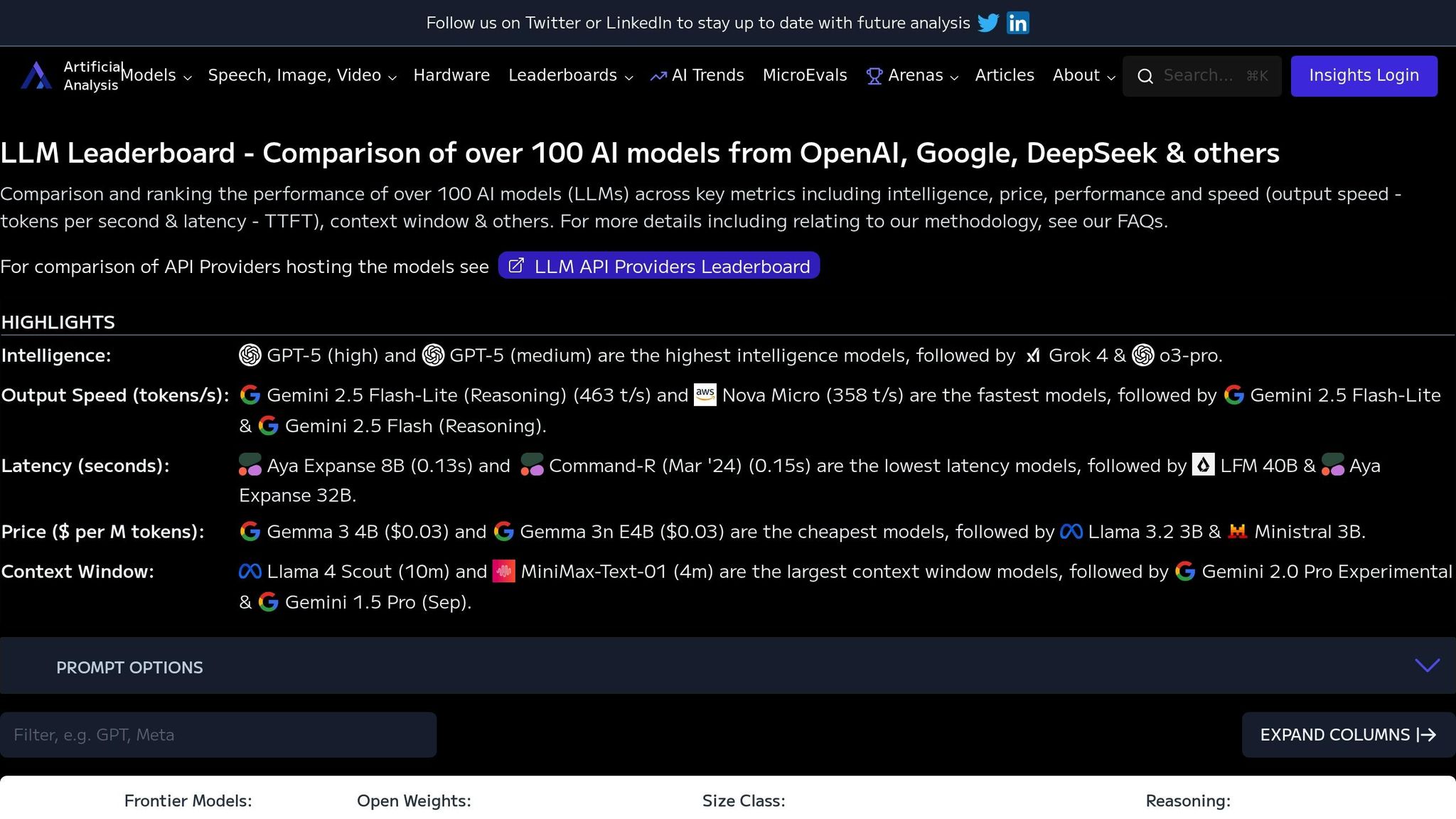

La tabla de clasificación de LLM de ArtificialAnalysis.ai sirve como centro de evaluación comparativa y compara el rendimiento de más de 100 modelos de IA. Utiliza un sistema de evaluación basado en datos con métricas estandarizadas, lo que brinda a los equipos la claridad que necesitan para tomar decisiones de implementación inteligentes. A continuación, analizamos sus características más destacadas.

La plataforma evalúa los modelos en función de tres áreas clave: inteligencia, coste, y velocidad de salida.

Estas métricas crean un marco compartido para comparar las capacidades de la IA, lo que permite a los equipos evaluar los modelos de manera objetiva y seleccionar el que mejor se adapte a sus necesidades.

La tabla de clasificación proporciona un seguimiento del rendimiento en vivo, lo que garantiza que los usuarios tengan acceso a los datos más actualizados. Las métricas se actualizan con frecuencia (ocho veces al día para las solicitudes individuales y dos veces al día para las solicitudes paralelas) utilizando los datos recopilados durante las últimas 72 horas. Esta supervisión en tiempo real garantiza que cualquier cambio en el rendimiento sea rápidamente visible, lo que ayuda a las organizaciones a tomar decisiones de implementación con confianza.

Al cubrir una amplia gama de modelos de IA, la plataforma ofrece una visión amplia del ecosistema de IA actual. Este amplio alcance no solo ayuda a los profesionales a identificar las soluciones más adecuadas, sino que también fomenta el progreso entre los desarrolladores al promover la transparencia y una competencia sana a través de métricas de rendimiento.

Después de examinar las herramientas en detalle, analicemos sus principales fortalezas y limitaciones. Cada plataforma tiene sus propias ventajas y desventajas, por lo que es esencial que los equipos sopesen sus necesidades específicas a la hora de elegir la herramienta de evaluación adecuada. A continuación se muestran más de cerca las características más destacadas y las áreas en las que estas herramientas pueden ser insuficientes.

Prompts.ai se destaca como una solución empresarial sólida, que ofrece una plataforma unificada para comparar más de 35 LLM líderes, todas accesibles a través de una única interfaz. Sus controles FinOps en tiempo real proporcionan información detallada sobre los costos, lo que ayuda a las organizaciones a reducir los gastos de software de IA hasta 98% mediante un seguimiento transparente de los tokens y un gasto optimizado. La plataforma también simplifica las complejas operaciones de inteligencia artificial mediante el encadenamiento de agentes y la gestión integrada del flujo de trabajo, lo que reduce la dependencia de múltiples herramientas. Sin embargo, estas funciones avanzadas son un bien escaso, lo que puede suponer un desafío para los equipos más pequeños con presupuestos limitados.

Otras plataformas se adaptan a necesidades más especializadas. Algunas priorizan la confiabilidad y la seguridad de los modelos y ofrecen herramientas para monitorear el rendimiento, mientras que otras se centran en la personalización, la facilidad de uso o la evaluación comparativa. Estas opciones, si bien son valiosas, pueden implicar una curva de aprendizaje más pronunciada o requerir importantes esfuerzos de configuración para cumplir con requisitos específicos.

He aquí una comparación rápida de sus funciones principales:

A la hora de tomar una decisión, ten en cuenta el presupuesto, la experiencia técnica y las exigencias del flujo de trabajo de tu equipo. Prompts.ai ofrece una solución empresarial comprobada con gestión de costes y flujos de trabajo optimizados, mientras que otras plataformas destacan en áreas como la seguridad, la flexibilidad de los desarrolladores o la profundidad de la evaluación comparativa. Cada herramienta aporta algo valioso, por lo que la elección depende, en última instancia, de tus prioridades específicas.

Tras evaluar las capacidades y desventajas de cada herramienta, es evidente que una solución supera al resto en lo que respecta a la orquestación de la IA empresarial. Prompts.ai ofrece una interfaz unificada que integra más de 35 modelos, incluidos GPT-4, Claude, LLama y Gemini, a la vez que proporciona controles de costos en tiempo real que pueden reducir los gastos de IA tanto como 98%. Es flexible. paga sobre la marcha El sistema de crédito TOKN elimina la carga de las tarifas de suscripción recurrentes, y sus funciones de gobierno integradas, que incluyen registros de auditoría detallados, garantizan el cumplimiento para organizaciones que van desde empresas de la lista Fortune 500 hasta agencias creativas y laboratorios de investigación.

Con Prompts.ai, los equipos obtienen una administración de costos transparente, una gobernanza sólida y operaciones de IA eficientes, todo en una sola plataforma. Al consolidar la evaluación y la orquestación de la IA en una solución única y potente, Prompts.ai satisface las exigencias de los flujos de trabajo a escala empresarial y, al mismo tiempo, simplifica las complejidades de la gestión de varios entornos de pruebas. Para los equipos que buscan optimizar sus operaciones y maximizar el valor, esta plataforma ofrece las herramientas y la confiabilidad que necesitan.

Prompts.ai permite a las empresas reducir los gastos de IA tanto como 98%, gracias a su plataforma optimizada que consolida las operaciones de IA en un sistema centralizado. Al ofrecer una interfaz unificada para realizar pruebas y evaluaciones rápidas, elimina la molestia de tener que hacer malabares con múltiples herramientas desconectadas, lo que ahorra tiempo y valiosos recursos.

Una característica clave de Prompts.ai es su almacenamiento en caché rápido sistema, que reutiliza solicitudes idénticas en lugar de procesarlas repetidamente. Esta estrategia inteligente reduce drásticamente los costos operativos, lo que permite a las empresas ajustar sus flujos de trabajo de inteligencia artificial sin gastar de más.

Prompts.ai prioriza la seguridad de primer nivel para cumplir con los estándares de nivel empresarial. Emplea cifrado de extremo a extremo para proteger los datos durante la transmisión, autenticación multifactorial (MFA) para una mayor seguridad de inicio de sesión, y inicio de sesión único (SSO) para simplificar y proteger la administración del acceso.

La plataforma también incluye registros de auditoría detallados para monitorear la actividad de manera integral y los usos anonimización de datos para proteger la información confidencial. Al cumplir con marcos de cumplimiento críticos como SOC 2 y GDPR, Prompts.ai garantiza que sus datos permanezcan protegidos y, al mismo tiempo, mantiene a su organización alineada con los requisitos reglamentarios.

El encadenamiento de agentes La función de Prompts.ai simplifica el proceso de evaluación de los modelos de IA al dividir las tareas complejas en pasos más pequeños y manejables. Este enfoque permite el procesamiento secuencial y las pruebas en varios pasos, lo que ofrece una forma detallada de evaluar el rendimiento del modelo.

Al automatizar estos pasos vinculados, el encadenamiento de agentes aumenta la confiabilidad y ofrece información más completa sobre cómo los modelos manejan flujos de trabajo complicados. Esto no solo mejora la calidad de las evaluaciones, sino que también ahorra a los equipos mucho tiempo y esfuerzo.