Vous recherchez des outils pour comparer les résultats de modèles d'IA tels que GPT-4, Claude, ou Lama? Voici ce que vous devez savoir :

Ces outils simplifient la prise de décision en aidant les utilisateurs à identifier les modèles les plus performants et les plus rentables pour leurs besoins. Vous trouverez ci-dessous une comparaison rapide de leurs fonctionnalités.

Choisissez en fonction du budget de votre équipe, des besoins de sécurité et des priorités en matière de flux de travail.

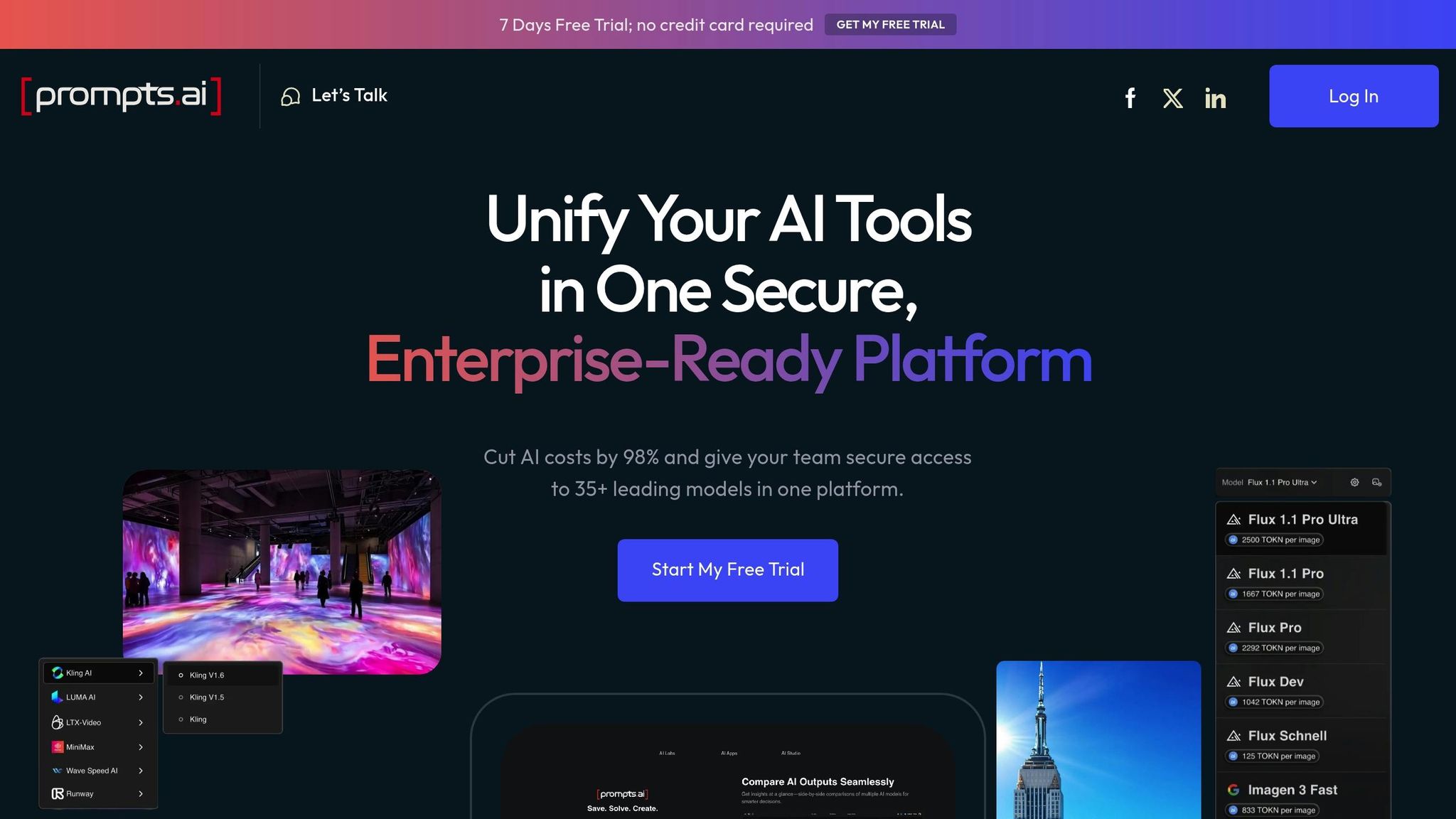

Prompts.ai est une plateforme d'entreprise qui réunit plus de 35 LLM de premier plan au sein d'une interface unique et sécurisée, éliminant ainsi les tracas liés à la jonglerie entre plusieurs outils.

Conçu pour les entreprises, les agences et les laboratoires de recherche du Fortune 500, Prompts.ai peut réduire les coûts liés à l'IA jusqu'à 98 % tout en maintenant une sécurité d'entreprise de premier plan. À partir d'un tableau de bord unifié, les équipes peuvent accéder à des modèles tels que GPT-4, Claude, LLama et Gémeaux.

L'une des caractéristiques remarquables de Prompts.ai est sa comparaison côte à côte outil. Cela permet aux utilisateurs d'exécuter simultanément les mêmes instructions sur différents modèles, ce qui permet d'identifier facilement l'option la plus performante sans avoir à passer constamment d'une plateforme à l'autre ou à suivre manuellement les résultats.

La plateforme comprend également basculement instantané du modèle, qui conserve le contexte de votre travail. Cela est particulièrement utile pour tester la manière dont différents modèles gèrent la même tâche ou pour optimiser des résultats spécifiques, tels que la créativité, la précision ou la rentabilité.

Une autre fonctionnalité puissante est chaînage d'agents, où les résultats d'un modèle peuvent être intégrés à un autre. C'est la solution idéale pour créer des flux de travail complexes et tester comment différentes combinaisons de modèles fonctionnent ensemble pour atteindre des objectifs spécifiques. Ces fonctionnalités s'intègrent parfaitement à la surveillance en temps réel pour rationaliser le processus d'évaluation.

Prompts.ai fournit des informations en temps réel sur les performances, aidant ainsi les équipes à prendre des décisions plus rapides et plus éclairées lors des évaluations.

La plateforme comprend un couche FinOps qui suit chaque jeton utilisé sur tous les modèles. Cette transparence permet aux équipes de bien comprendre leurs coûts d'IA et d'allouer les ressources de manière plus efficace. En fournissant des informations détaillées sur les coûts pour des tâches spécifiques, les équipes peuvent équilibrer leurs objectifs de performance avec des considérations budgétaires.

Avec analyses d'utilisation en temps réel, les équipes obtiennent des informations exploitables sur les tendances de performance des modèles. Cela transforme ce qui pourrait autrement être des tests ad hoc en un processus d'évaluation structuré qui favorise une meilleure prise de décision à long terme. La combinaison de ces caractéristiques garantit transparence et efficacité tout au long du processus d'évaluation.

Prompts.ai prend en charge plus de 35 LLM de premier plan et propose des outils pour des tâches telles que la génération de code, l'écriture créative et l'analyse de données. La bibliothèque de la plateforme est continuellement mise à jour pour garantir l'accès aux derniers modèles.

Cette vaste sélection permet aux équipes de comparer les performances de différents fournisseurs d'IA et de différents types de modèles. Que l'accent soit mis sur des tâches techniques, des projets créatifs ou des besoins analytiques, Prompts.ai fournit les bons outils pour une évaluation approfondie.

Prompts.ai donne la priorité à une sécurité de niveau professionnel, en garantissant la protection des données sensibles et en réduisant le risque d'exposition de tiers.

La plateforme inclut des outils de gouvernance intégrés et des pistes d'audit pour chaque flux de travail, simplifiant ainsi la conformité aux exigences réglementaires. Les équipes peuvent suivre les modèles qui ont été consultés, les instructions utilisées et les résultats générés, créant ainsi un enregistrement détaillé à des fins de responsabilisation et de réglementation.

Avec ses Crédits TOKN payables à l'utilisation, la plateforme élimine le besoin de frais d'abonnement récurrents. Au contraire, les coûts sont directement alignés sur l'utilisation réelle, ce qui donne aux organisations une plus grande flexibilité et un meilleur contrôle de leurs dépenses en matière d'IA. Ce modèle permet aux équipes d'augmenter ou de diminuer leur utilisation en fonction des besoins de leur projet, garantissant ainsi rentabilité et adaptabilité.

Deepchecks est une plateforme open source conçue pour tester et surveiller en continu les modèles d'apprentissage automatique. En appliquant les principes des tests logiciels traditionnels, il garantit une approche structurée de l'évaluation des résultats des grands modèles de langage (LLM). Cet outil constitue une option de validation rigoureuse, complétant les plateformes d'entreprise telles que Prompts.ai.

Contrairement aux plateformes destinées aux entreprises, Deepchecks donne la priorité à une validation approfondie des modèles. Il comprend des suites de validation automatisées qui permettent aux utilisateurs de comparer les résultats des modèles en fonction de critères personnalisés et d'analyses par lots. Grâce à des fonctionnalités telles que la détection des dérives et la possibilité de définir des mesures personnalisées, il permet d'identifier les écarts par rapport au comportement attendu.

Deepchecks suit activement les performances de production à l'aide d'alertes automatisées liées à des seuils de qualité. Ses systèmes robustes d'analyse et de détection des anomalies permettent d'identifier plus facilement et de traiter rapidement les comportements inattendus.

Pour protéger les données sensibles, Deepchecks prend en charge le déploiement sur site. En outre, il fournit une piste d'audit pour documenter les activités de test, garantissant ainsi la conformité avec les exigences de conformité.

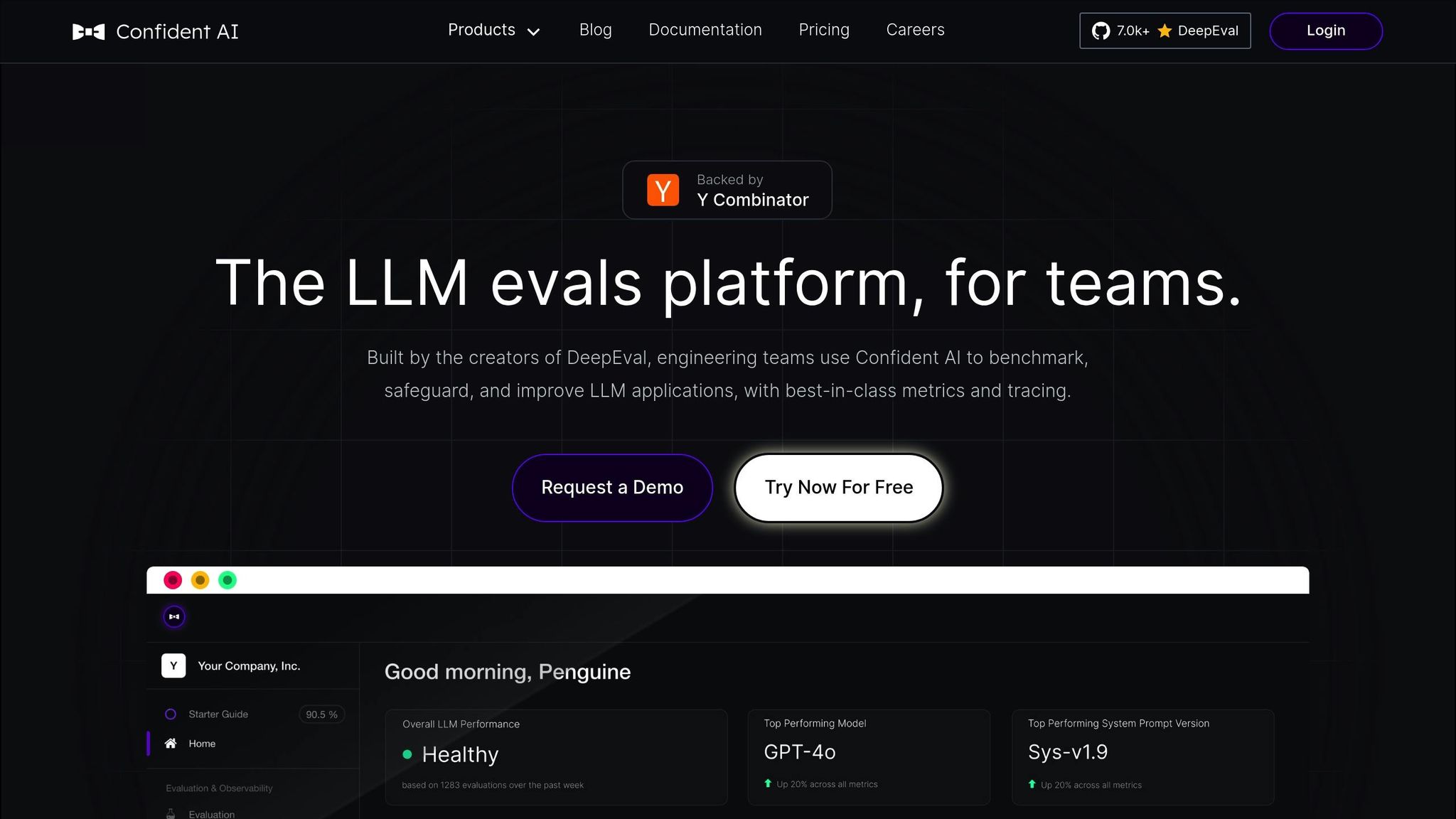

DeepEval est un framework open source conçu pour évaluer les sorties des grands modèles de langage (LLM) tout en donnant la priorité à la confidentialité des données. Il s'agit d'un outil fiable pour répondre au besoin croissant d'évaluations LLM sécurisées et précises.

DeepEval propose des outils flexibles pour comparer les résultats côte à côte et définir des critères d'évaluation personnalisés. Ces fonctionnalités aident les équipes à évaluer les réponses des modèles avec précision, répondant ainsi aux diverses exigences de l'évaluation moderne de l'IA.

Le framework s'intègre parfaitement aux flux de développement, permettant aux équipes de suivre les performances en temps réel et de procéder aux ajustements nécessaires.

En effectuant des évaluations localement, DeepEval garantit la protection des données sensibles, offrant ainsi une couche de sécurité supplémentaire aux utilisateurs.

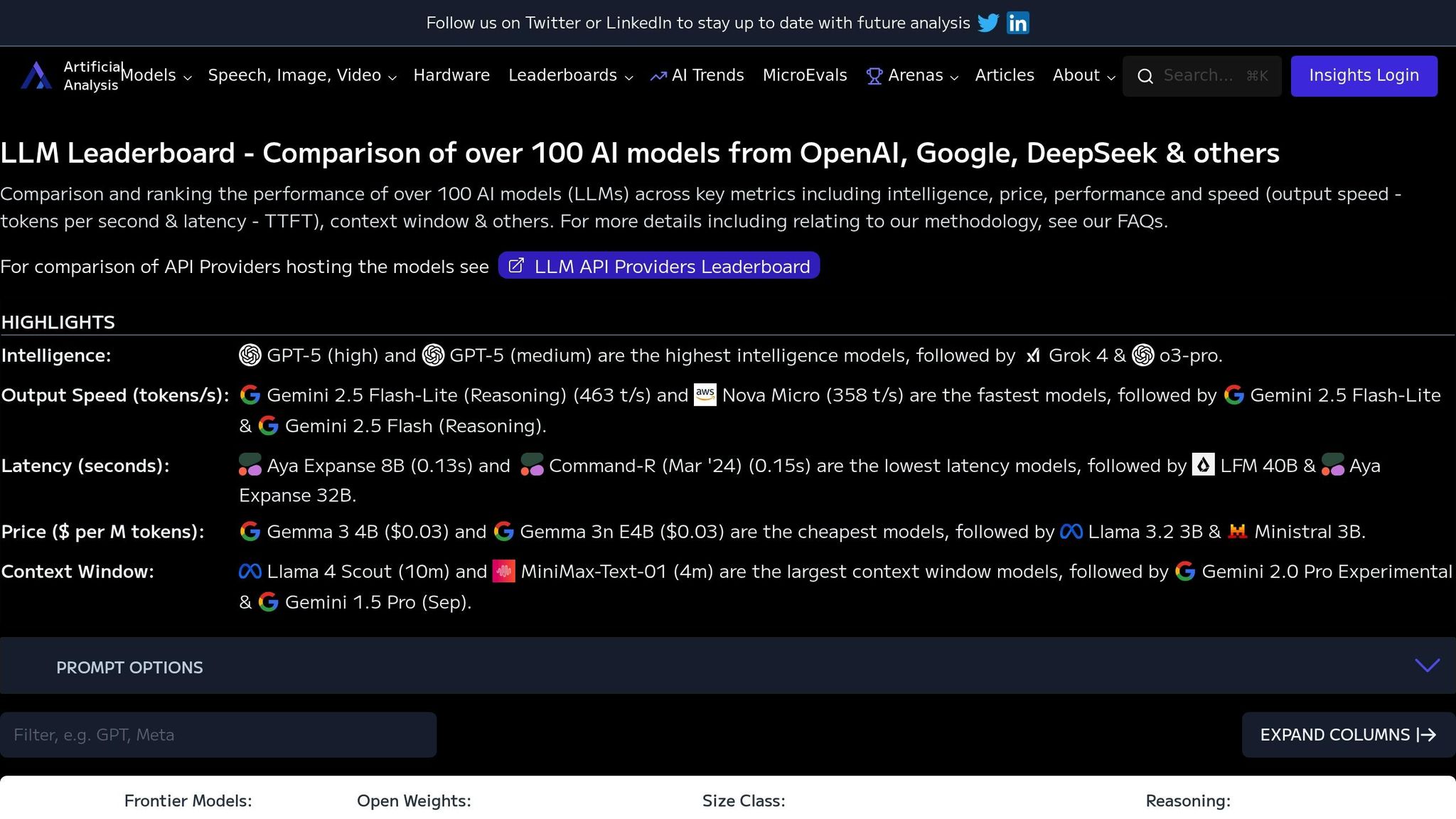

Le classement LLM de ArtificialAnalysis.ai sert de centre d'analyse comparative, comparant les performances de plus de 100 modèles d'IA. Il utilise un système d'évaluation basé sur les données avec des mesures standardisées, donnant aux équipes la clarté dont elles ont besoin pour faire des choix de déploiement intelligents. Ci-dessous, nous explorons ses caractéristiques remarquables.

La plateforme évalue les modèles en fonction de trois domaines clés : intelligence, coût, et vitesse de sortie.

Ces indicateurs créent un cadre partagé pour comparer les capacités de l'IA, permettant aux équipes d'évaluer les modèles de manière objective et de sélectionner celui qui correspond le mieux à leurs besoins.

Le classement fournit un suivi des performances en direct, garantissant aux utilisateurs l'accès aux données les plus récentes. Les statistiques sont actualisées fréquemment, huit fois par jour pour les demandes uniques et deux fois par jour pour les demandes parallèles, à l'aide des données collectées au cours des 72 dernières heures. Cette surveillance en temps réel garantit que tout changement de performance est rapidement visible, ce qui aide les entreprises à prendre des décisions de déploiement en toute confiance.

Couvrant un large éventail de modèles d'IA, la plateforme offre une vue complète de l'écosystème actuel de l'IA. Ce large champ d'application aide non seulement les professionnels à identifier les solutions les plus appropriées, mais encourage également les développeurs à progresser en promouvant la transparence et une saine concurrence grâce à des indicateurs de performance.

Après avoir examiné les outils en détail, analysons leurs principaux points forts et leurs principales limites. Chaque plateforme a ses propres compromis, il est donc essentiel que les équipes évaluent leurs besoins spécifiques au moment de choisir le bon outil d'évaluation. Vous trouverez ci-dessous un aperçu des fonctionnalités les plus remarquables et des domaines dans lesquels ces outils peuvent ne pas être à la hauteur.

Prompts.ai se distingue comme une solution d'entreprise robuste, offrant une plateforme unifiée permettant de comparer plus de 35 LLM de premier plan, toutes accessibles via une interface unique. Ses contrôles FinOps en temps réel fournissent des informations détaillées sur les coûts, aidant les organisations à réduire les dépenses liées aux logiciels d'IA jusqu'à 98 % grâce à un suivi transparent des jetons et à des dépenses optimisées. La plateforme simplifie également les opérations complexes d'IA grâce à l'enchaînement des agents et à la gestion intégrée des flux de travail, réduisant ainsi le recours à de multiples outils. Cependant, ces fonctionnalités avancées sont payantes, ce qui peut poser des problèmes aux petites équipes aux budgets limités.

D'autres plateformes répondent à des besoins plus spécifiques. Certains accordent la priorité à la fiabilité et à la sécurité des modèles en proposant des outils de surveillance des performances, tandis que d'autres se concentrent sur la personnalisation, la facilité d'utilisation ou l'analyse comparative. Ces options, bien qu'utiles, peuvent impliquer une courbe d'apprentissage plus abrupte ou nécessiter des efforts de configuration importants pour répondre à des exigences spécifiques.

Voici une comparaison rapide de leurs principales fonctionnalités :

Au moment de prendre une décision, tenez compte du budget, de l'expertise technique et des exigences de votre équipe en matière de flux de travail. Prompts.ai propose une solution d'entreprise éprouvée avec une gestion des coûts et des flux de travail rationalisés, tandis que d'autres plateformes brillent dans des domaines tels que la sécurité, la flexibilité des développeurs ou la profondeur des analyses comparatives. Chaque outil apporte quelque chose de précieux, de sorte que le choix dépend en fin de compte de vos priorités spécifiques.

Après avoir évalué les capacités et les compromis de chaque outil, une solution se démarque clairement des autres pour l'orchestration de l'IA en entreprise. Prompts.ai propose une interface unifiée qui intègre plus de 35 modèles, dont GPT-4, Claude, LLama et Gemini, tout en fournissant des contrôles des coûts en temps réel qui peuvent réduire les dépenses liées à l'IA de 98 %. C'est flexible. Payez à l'utilisation Le système de crédit TOKN élimine le fardeau des frais d'abonnement récurrents, et ses fonctionnalités de gouvernance intégrées, y compris des pistes d'audit détaillées, garantissent la conformité d'organisations allant des entreprises du Fortune 500 aux agences de création et aux laboratoires de recherche.

Avec Prompts.ai, les équipes bénéficient d'une gestion transparente des coûts, d'une gouvernance robuste et d'opérations d'IA efficaces, le tout sur une seule plateforme. En consolidant l'évaluation et l'orchestration de l'IA dans une solution unique et puissante, Prompts.ai répond aux exigences des flux de travail à l'échelle de l'entreprise tout en simplifiant la gestion de plusieurs environnements de test. Pour les équipes qui souhaitent rationaliser leurs opérations et maximiser la valeur, cette plateforme fournit les outils et la fiabilité dont elles ont besoin.

Prompts.ai permet aux entreprises de réduire leurs dépenses liées à l'IA jusqu'à 98 %, grâce à sa plateforme rationalisée qui regroupe les opérations d'IA dans un système centralisé. En proposant une interface unifiée pour des tests et des évaluations rapides, il élimine les tracas liés à la jonglerie entre plusieurs outils déconnectés, ce qui permet d'économiser du temps et des ressources précieuses.

Une caractéristique clé de Prompts.ai est sa mise en cache rapide système, qui réutilise des instructions identiques au lieu de les traiter à plusieurs reprises. Cette stratégie intelligente réduit considérablement les coûts opérationnels, permettant aux entreprises d'affiner leurs flux de travail d'IA sans trop dépenser.

Prompts.ai donne la priorité à une sécurité de haut niveau pour répondre aux normes de l'entreprise. Elle emploie chiffrement de bout en bout pour protéger les données pendant leur transmission, authentification multifactorielle (MFA) pour une sécurité de connexion accrue, et authentification unique (SSO) pour simplifier et sécuriser la gestion des accès.

La plateforme comprend également journaux d'audit détaillés pour surveiller l'activité de manière exhaustive et les utilisations anonymisation des données pour protéger les informations sensibles. En adhérant à des cadres de conformité critiques tels que SOC 2 et GDPR, Prompts.ai garantit la protection de vos données tout en maintenant la conformité de votre organisation aux exigences réglementaires.

Le chaînage d'agents La fonctionnalité de Prompts.ai simplifie le processus d'évaluation des modèles d'IA en divisant les tâches complexes en étapes plus petites et plus faciles à gérer. Cette approche permet un traitement séquentiel et des tests en plusieurs étapes, offrant ainsi un moyen détaillé d'évaluer les performances du modèle.

En automatisant ces étapes liées, le chaînage d'agents renforce la fiabilité et fournit des informations plus complètes sur la façon dont les modèles gèrent des flux de travail complexes. Cela améliore non seulement la qualité des évaluations, mais permet également aux équipes de gagner beaucoup de temps et d'efforts.