En 2026, gestionar varios modelos lingüísticos de gran tamaño (LLM), como GPT-5, Claudio, Géminis, y Llama es un desafío cada vez mayor para las empresas. Las herramientas de orquestación de la IA simplifican esto al unificar los flujos de trabajo, reducir los costos y mejorar la gobernanza. Este es un desglose rápido de las principales soluciones:

Cada herramienta tiene puntos fuertes únicos, desde la rentabilidad hasta la personalización avanzada. La elección de la plataforma adecuada depende de las prioridades de su organización, como el control de costos, la escalabilidad o la flexibilidad técnica.

Comparación rápida:

Seleccione la solución que se adapte a sus objetivos, ya sea para ahorrar costos, crear flujos de trabajo personalizados o automatizar procesos.

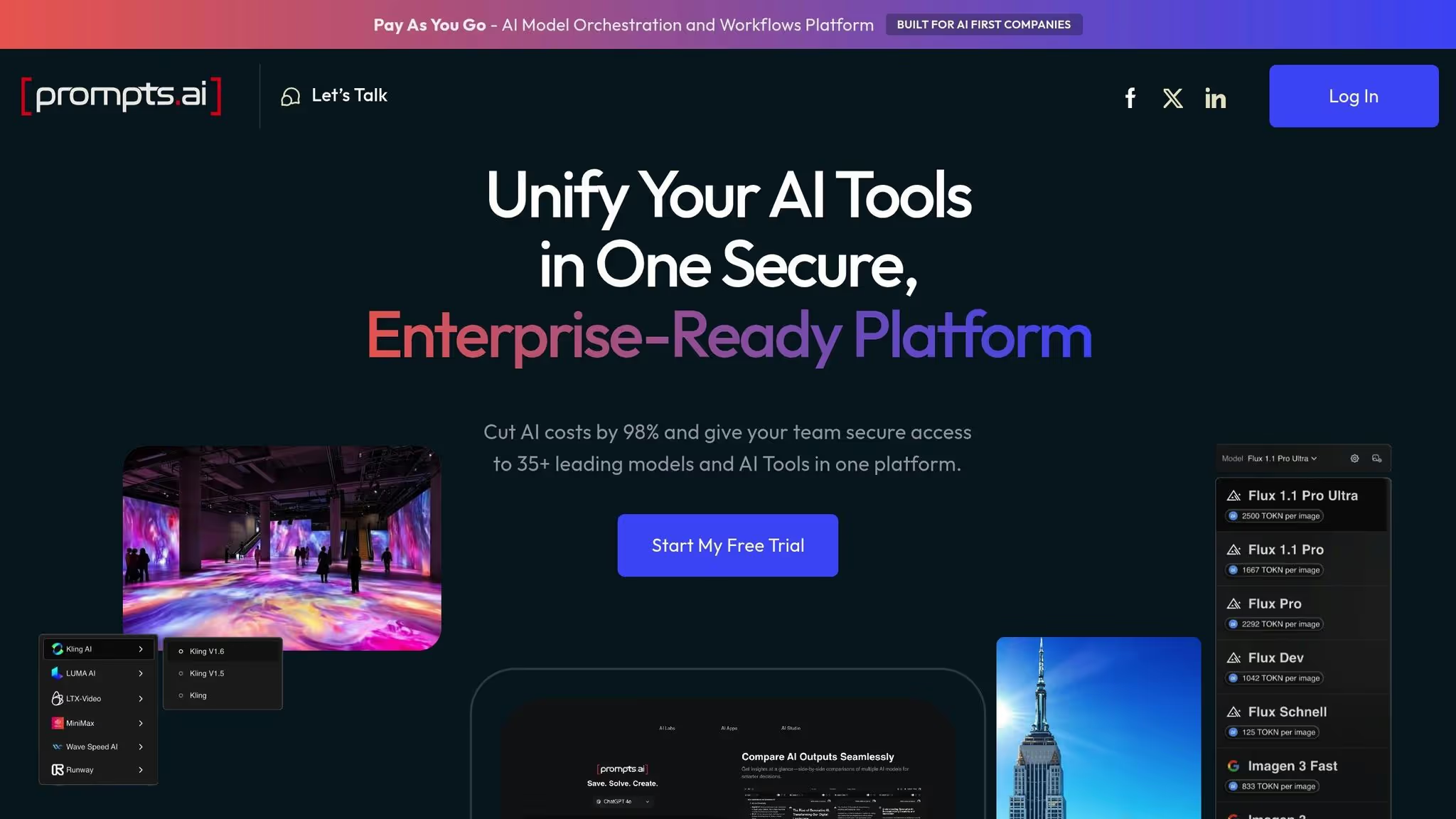

Prompts.ai reúne más de 35 modelos de IA, como GPT-5, Claude, LLama, Gemini, y herramientas especializadas como A mitad del viaje, Flux Pro, y Kling AI - en una plataforma única y optimizada. Esto elimina la molestia de administrar varias suscripciones, claves de API y sistemas de facturación. Al centralizar estas herramientas, los equipos pueden comparar los modelos en paralelo en tiempo real, elegir el mejor para cada tarea y convertir los flujos de trabajo en procesos auditables y repetibles.

La plataforma se integra perfectamente con herramientas empresariales como Slack, Gmail, y Trello, lo que permite Automatización impulsada por IA en varios departamentos. Los nuevos modelos se agregan de inmediato, lo que elimina la necesidad de integraciones personalizadas y garantiza que los usuarios siempre tengan acceso a las capacidades más recientes.

Este sistema unificado no solo simplifica el acceso, sino que también crea oportunidades para realizar evaluaciones multimodelo exhaustivas.

Prompts.ai admite una amplia gama de tareas, desde la generación de texto hasta la creación de imágenes. Los equipos pueden comparar directamente los modelos, como la destreza creativa del GPT-5 con la profundidad analítica de Claude, o la flexibilidad del código abierto de LLama con las funciones multimodales de Gemini, lo que ayuda a aumentar la productividad hasta 10 veces. La plataforma también incluye herramientas creativas como Midjourney para arte conceptual, Luma IA para el modelado 3D, y IA de Reve para aplicaciones específicas, todas accesibles a través de una única interfaz.

Además de unificar las herramientas, Prompts.ai ofrece un sólido control de costos. Su diseño, el primero en FinOps, hace un seguimiento de cada token utilizado en todos los modelos, lo que permite abordar los gastos impredecibles de forma frontal. La plataforma afirma que puede reducir los costos de inteligencia artificial hasta en un 98% en comparación con el mantenimiento de suscripciones a más de 35 herramientas, con la capacidad de reducir los gastos en un 95% en menos de 10 minutos.

Prompts.ai utiliza un sistema de crédito TOKN de pago por uso, que ofrece niveles de precios flexibles. Los usuarios pueden explorar la plataforma de forma gratuita, mientras que los planes para creadores comienzan en 29$ y 99$ para uso familiar. Los planes para empresas oscilan entre 99 y 129 dólares por miembro, y todos incluyen un seguimiento de los costes en tiempo real para garantizar la transparencia y el control.

Prompts.ai se adhiere a estrictos estándares de cumplimiento y cumple con los requisitos de SOC 2 tipo II, HIPAA y GDPR. Su auditoría del SOC 2 de tipo 2 comenzó el 19 de junio de 2025 y su monitoreo continuo se lleva a cabo a través de Vanta. Un centro de confianza dedicado proporciona una visión en tiempo real de las medidas de seguridad, las actualizaciones de las políticas y el progreso del cumplimiento, lo que lo hace ideal para los sectores con necesidades rigurosas de auditoría y gobierno de datos.

Los planes empresariales (Core, Pro y Elite) incluyen funciones especializadas para la supervisión del cumplimiento y la gobernanza, lo que garantiza que los datos confidenciales de la organización permanezcan seguros y bajo control.

Prompts.ai está diseñado para escalarse sin esfuerzo y es compatible con todo, desde equipos pequeños hasta empresas de la lista Fortune 500, sin necesidad de realizar cambios importantes en la infraestructura. Añadir nuevos modelos, usuarios o departamentos lleva minutos, no meses, lo que simplifica lo que suele ser un proceso complejo en la expansión de la IA empresarial.

Por ejemplo, los equipos globales de ciudades como Nueva York, San Francisco y Londres pueden colaborar sin problemas en la misma plataforma gobernada. La plataforma también ofrece una incorporación práctica, formación empresarial y un programa de certificación inmediata de ingenieros, lo que permite a los equipos disponer de flujos de trabajo expertos y fomentar una comunidad de ingenieros rápidos cualificados.

LangChain es un marco Python de código abierto diseñado para crear aplicaciones LLM. Simplifica la integración de modelos de incrustación, LLM y almacenes vectoriales al ofrecer interfaces estandarizadas, que agilizan el proceso de conexión de varios componentes de la IA en flujos de trabajo cohesivos. Con la impresionante cantidad de 116 000 estrellas de GitHub, LangChain se ha convertido en el marco de orquestación de referencia dentro de la comunidad de desarrollo de IA.

Sobre la base de LangChain, Gráfico de largo presenta flujos de trabajo de agentes basados en gráficos y con estado. Emplea máquinas de estados para gestionar patrones jerárquicos, colaborativos o secuenciales (de transferencia). Como señala el blog n8n.io, Gráfico de largo «cambia la complejidad del aprendizaje por un control preciso de los flujos de trabajo de los agentes».

Para dar vida a estas aplicaciones, LangServe gestiona la implementación de LangChain y LangGraph, mientras que LangSmith proporciona monitoreo y registro en tiempo real para garantizar un rendimiento fluido en los flujos de trabajo de varios pasos.

En conjunto, estas herramientas forman una canalización completa: LangChain sienta las bases, LangGraph organiza los flujos de trabajo de varios agentes, LangServe facilita la implementación en tiempo real y LangSmith garantiza un rendimiento de producción confiable. Esta combinación no solo permite crear aplicaciones sólidas, sino que también se integra perfectamente en entornos multimodelo.

Este ecosistema de código abierto se destaca por ofrecer un control preciso para aplicaciones especializadas, a diferencia de las plataformas todo en uno.

LangChain admite la generación aumentada de recuperación (RAG) y se conecta con varios componentes de LLM a través de interfaces estandarizadas. Esto permite a los desarrolladores cambiar de modelo sin tener que modificar flujos de trabajo completos. También implementa el paradigma ReAct, que permite a los agentes determinar de forma dinámica cuándo y cómo usar herramientas específicas.

LangGraph lleva esto más allá al permitir la orquestación de múltiples agentes. Los desarrolladores pueden diseñar flujos de trabajo en los que los LLM operen en estructuras jerárquicas (un modelo supervise a otros), trabajen de forma colaborativa en paralelo o pasen tareas de forma secuencial entre modelos especializados. Esta configuración permite a los equipos aprovechar los puntos fuertes únicos de los diferentes modelos, por ejemplo, usar uno para extraer datos, otro para analizarlos y un tercero para generar los resultados finales.

El ecosistema también incluye LangGraph Studio, un IDE dedicado que ofrece capacidades de visualización, depuración e interacción en tiempo real. Esta herramienta ayuda a los desarrolladores a comprender mejor cómo interactúan los modelos en los flujos de trabajo, lo que facilita la identificación de los cuellos de botella o los errores en las configuraciones multimodelo.

LangChain sigue una estructura de precios sencilla. Ofrece un plan gratuito para desarrolladores, un plan Paid Plus de 39$ al mes y opciones de precios personalizadas para los usuarios empresariales. Los servicios en la nube de LangSmith y LangGraph Platform también tienen un precio inicial de 39$ al mes para el plan Plus, y los precios para empresas están disponibles bajo petición. Para aquellos que buscan una opción más económica, hay disponible una implementación gratuita de Self-Hosted Lite, aunque con ciertas limitaciones. Más allá de estos niveles, la plataforma emplea precios basados en el uso y cobra solo por el consumo real.

LangSmith mejora la transparencia y la observabilidad con sus herramientas de seguimiento y rastreo. Registra las entradas y salidas de cada paso de los flujos de trabajo de varios pasos, lo que facilita la depuración y el análisis de la causa raíz. Estas funciones garantizan que incluso los flujos de trabajo más complejos sigan siendo transparentes y cumplan con los requisitos de cumplimiento. El registro detallado crea un registro de auditoría que puede ayudar a satisfacer las necesidades normativas, aunque las organizaciones deben implementar sus propias políticas de retención de datos y controles de acceso. Para las empresas con estándares de cumplimiento estrictos, las implementaciones autohospedadas brindan un control total sobre el almacenamiento de datos.

LangSmith Deployment ofrece una infraestructura de escalado automático diseñada para gestionar flujos de trabajo de larga duración que pueden funcionar durante horas o incluso días. Esto es particularmente beneficioso para los flujos de trabajo empresariales que requieren un procesamiento continuo.

LangGraph admite funciones como salidas de streaming, ejecuciones en segundo plano, gestión de ráfagas y gestión de interrupciones. Estas capacidades permiten que los flujos de trabajo se adapten a los picos repentinos de la demanda sin necesidad de intervención manual.

Si bien los sistemas basados en Langchain proporcionan un control granular sobre la arquitectura del flujo de trabajo, escalarlos de manera efectiva exige experiencia técnica. Los equipos deben optimizar las estructuras gráficas, administrar el estado de manera eficiente y configurar la infraestructura de implementación de manera adecuada. Para las organizaciones con sólidos recursos de ingeniería, esta profundidad técnica se convierte en una fortaleza, ya que permite estrategias de escalamiento personalizadas, una gestión avanzada de errores y sistemas de orquestación personalizados que abordan necesidades específicas. Esta flexibilidad convierte a LangChain en una opción sólida para los equipos que buscan superar las limitaciones de las plataformas únicas para todos los casos.

El ecosistema de agentes de Microsoft combina dos potentes marcos, cada uno de los cuales aborda aspectos únicos de la orquestación de la IA. AutoGen se especializa en la creación de sistemas de IA para un solo agente y para varios agentes, lo que agiliza las tareas de desarrollo de software, como la generación de código, la depuración y la automatización de la implementación. Es compatible con todo tipo de tareas, desde la creación rápida de prototipos hasta el desarrollo empresarial, lo que permite a los agentes conversacionales interactuar en varios turnos y tomar decisiones de forma autónoma basándose en datos de lenguaje natural. Al automatizar los pasos críticos, como la revisión del código y la implementación de funciones, AutoGen simplifica el proceso de entrega del software.

Por otro lado, Núcleo semántico funciona como un SDK de código abierto diseñado para conectar los LLM modernos con aplicaciones empresariales escritas en C#, Python y Java. Al actuar como un puente, integra las capacidades de inteligencia artificial en los sistemas empresariales existentes, lo que elimina la necesidad de una reforma tecnológica completa.

«Microsoft está fusionando marcos como AutoGen y Semantic Kernel en un Microsoft Agent Framework unificado. Estos marcos están diseñados para soluciones de nivel empresarial y se integran con los servicios de Azure» [2].

Esta integración sienta las bases para una coordinación multimodelo perfecta entre los servicios de IA de Microsoft.

El marco unificado mejora la interoperabilidad al integrarse estrechamente con los servicios de Azure. Esta configuración proporciona una interfaz única para acceder a una variedad de modelos de LLM e IA. La arquitectura de AutoGen permite a los agentes especializados colaborar, lo que garantiza que las tareas coincidan con modelos diseñados para lograr un rendimiento y una rentabilidad óptimos. Además, el ecosistema incorpora Protocolo de contexto modelo (MCP), un estándar para compartir herramientas y contexto de forma segura y versionada. Los servidores MCP personalizados, capaces de gestionar más de 1000 solicitudes por segundo, permiten una coordinación fiable entre varios LLM.

«MCP cuenta con algunos patrocinadores de peso pesado como Microsoft, Google e IBM».

Microsoft prioriza la gobernanza dentro de su ecosistema de agentes al aprovechar el Model Context Protocol para garantizar operaciones de IA seguras y eficaces.

«Una capa de orquestación con estas características es un requisito crucial para que los agentes de IA operen de forma segura en la producción».

El ecosistema está diseñado para escalar sin esfuerzo, abordando las crecientes necesidades de las empresas al aprovechar la infraestructura de Azure, que actualmente admite más del 60% de las implementaciones de IA empresarial [2]. La arquitectura basada en eventos de AutoGen gestiona de manera eficiente los flujos de trabajo distribuidos, lo que garantiza un funcionamiento fluido incluso a gran escala. Los datos del mercado ponen de manifiesto la creciente demanda de soluciones de IA escalables: se espera que el mercado de la orquestación de la IA alcance los 11.470 millones de dólares en 2025, lo que supone un crecimiento anual compuesto del 23%, Gartner prevé que para 2028, el 80% de los procesos orientados al cliente dependerán de sistemas de IA multiagente. Esto garantiza que las empresas puedan mantener flujos de trabajo eficientes en todos los equipos y adaptarse a la evolución de las demandas.

Las plataformas LLMOP están diseñadas para supervisar, evaluar y ajustar varios modelos lingüísticos grandes (LLM) una vez que están en producción. Se centran en las tareas posteriores a la implementación, como la supervisión del rendimiento, los controles de calidad y las mejoras continuas. El objetivo es garantizar que los modelos se mantengan confiables y ofrezcan resultados precisos a lo largo del tiempo.

Por ejemplo, Arize AI se especializa en detectar la deriva de datos, mientras que Weights & Biases se destaca en el seguimiento de experimentos. Al abordar estas necesidades operativas, estas plataformas hacen que la gestión de las configuraciones multimodelo sea más eficiente y eficaz.

Gestionar varios LLM simultáneamente es una fortaleza clave de estas plataformas. Por lo general, cuentan con paneles unificados que presentan métricas de rendimiento críticas para todos los modelos activos. Esta vista centralizada facilita a los equipos la identificación de los modelos con mejor rendimiento para tareas específicas. Las decisiones sobre la implementación pueden entonces guiarse por factores como la complejidad del modelo, la rentabilidad y la precisión.

Para mantener los gastos bajo control, las plataformas LLMops proporcionan desgloses detallados de los costos de la IA por modelo, usuario y aplicación. También permiten a los equipos analizar las compensaciones entre costes y rendimiento comparando el coste por solicitud con las métricas de calidad, lo que garantiza que los presupuestos se optimicen sin sacrificar la calidad de los resultados.

La gobernanza es la piedra angular de muchas plataformas de LLMOP. Mantienen registros de las interacciones entre modelos, que son vitales para cumplir con los requisitos normativos y de auditoría. Funciones como los controles de acceso basados en funciones y los exhaustivos registros de auditoría ayudan a las organizaciones a gestionar los permisos y a mantener los estándares de privacidad de los datos, lo que ofrece tranquilidad en los sectores en los que el cumplimiento es muy exigente.

Estas plataformas están diseñadas para gestionar despliegues empresariales a gran escala. Ofrecen capacidades de escalado automático y opciones de infraestructura flexibles, ya sea en la nube o en las instalaciones. La integración con las canalizaciones de DevOps y los flujos de trabajo de CI/CD simplifica aún más la implementación y la supervisión. Los sistemas de seguimiento y alerta del rendimiento en tiempo real garantizan que los equipos puedan abordar rápidamente los problemas a medida que surjan, lo que permite que las operaciones funcionen sin problemas.

Las plataformas de orquestación de agentes están diseñadas para hacerse cargo tanto del software como de los flujos de trabajo, y abarcan los sistemas heredados más antiguos y las aplicaciones más recientes. A diferencia de las herramientas que se limitan a observar los modelos en producción, estas plataformas automatizan activamente los procesos al interactuar directamente con el software empresarial clave. Caesr.ai es un buen ejemplo, ya que conecta los modelos de IA directamente con las herramientas empresariales esenciales, transformando la automatización en un motor práctico de las operaciones empresariales, en lugar de simplemente en una supervisión pasiva.

Estas plataformas también se destacan en la integración de varios modelos de IA. Al tratar los modelos como herramientas intercambiables, las empresas pueden seleccionar la mejor para una tarea específica, garantizando así que los flujos de trabajo se gestionen con precisión y experiencia personalizada.

La escalabilidad en las plataformas de orquestación de agentes gira en torno a la compatibilidad y la integración a nivel empresarial. Caesr.ai, por ejemplo, está diseñado para ofrecer compatibilidad universal, lo que permite a los agentes funcionar sin problemas en plataformas web, de escritorio, móviles, Android, macOS y Windows. Esta flexibilidad elimina los desafíos de implementación en una organización. Además, al interactuar directamente con las herramientas y las aplicaciones (sin depender únicamente de las API), la plataforma permite un funcionamiento fluido tanto con los sistemas modernos basados en la nube como con el software heredado más antiguo. Caesr.ai también cumple con los estrictos estándares de seguridad e infraestructura empresariales, lo que lo convierte en una opción confiable para despliegues a gran escala.

Elegir la herramienta de orquestación de IA adecuada significa sopesar sus beneficios con sus limitaciones. Cada plataforma ofrece distintas ventajas, pero entender sus ventajas y desventajas es esencial para alinearlas con los objetivos, las capacidades técnicas y el presupuesto de su organización.

Prompts.ai destaca por sus capacidades de ahorro de costes y su amplio acceso a los modelos. Con más de 35 de los principales programas de LLM consolidados en una sola interfaz, elimina la necesidad de múltiples suscripciones, lo que reduce los gastos de software de IA hasta en un 98%. Sus controles FinOps en tiempo real proporcionan a los equipos financieros una supervisión detallada del uso de los tokens, lo que simplifica la gestión del presupuesto. El sistema de crédito TOKN de pago por uso garantiza la flexibilidad y evita comisiones recurrentes innecesarias. Además, su biblioteca rápida y su programa de certificación facilitan la incorporación de usuarios sin conocimientos técnicos. Sin embargo, las organizaciones que invierten mucho en infraestructuras personalizadas pueden enfrentarse a dificultades a la hora de migrar, por lo que los equipos que necesitan marcos altamente especializados deben confirmar la compatibilidad con sus necesidades.

LangChain con LangServe y LangSmith ofrece una flexibilidad inigualable para los desarrolladores que buscan un control total sobre las canalizaciones de IA. Su base de código abierto permite una personalización profunda, mientras que su comunidad activa ofrece una gran cantidad de integraciones y extensiones. Las herramientas de depuración de LangSmith facilitan la identificación de los problemas de flujo de trabajo. Por el lado negativo, la complejidad de configurar sistemas listos para la producción exige una importante experiencia en ingeniería, lo que puede ser un obstáculo para los equipos más pequeños que no cuentan con un soporte dedicado de DevOps. Además, la falta de un seguimiento de costos integrado requiere herramientas independientes para monitorear los gastos de varios proveedores de modelos.

El ecosistema de agentes de Microsoft (AutoGen & Semantic Kernel) se integra perfectamente con los servicios de Azure, lo que lo hace ideal para las empresas que ya utilizan la infraestructura de Microsoft. AutoGen permite la colaboración entre varios agentes para tareas complejas, mientras que Semantic Kernel proporciona capacidades avanzadas de memoria y planificación. Sus funciones de seguridad y cumplimiento cumplen con los estándares empresariales desde el primer momento. Sin embargo, este ecosistema vincula en gran medida a los usuarios con Microsoft, lo que dificulta la migración y aumenta los costos a medida que aumenta el uso. Para las organizaciones que no pertenecen al grupo de Microsoft, la integración y la incorporación pueden resultar más difíciles.

Plataformas LLMops como Arize AI y Weights & Biases sobresalen en la observabilidad y el monitoreo del rendimiento. Realizan un seguimiento de métricas clave como la latencia, la variación de la precisión y el uso de tokens, y proporcionan a los equipos de ciencia de datos información para refinar los modelos de forma continua. Funciones como el seguimiento de experimentos y el control de versiones ayudan a gestionar varias iteraciones de modelos de forma eficiente. Sin embargo, estas plataformas se centran en la supervisión en lugar de en orquestar los flujos de trabajo o automatizar los procesos. Se necesitan herramientas adicionales para la ejecución, y los equipos necesitan experiencia en aprendizaje automático para aprovechar al máximo estas plataformas.

Plataformas de orquestación de agentes como caesr.ai, se especializan en automatizar los flujos de trabajo al interactuar directamente con el software empresarial en entornos web, de escritorio y móviles. Son compatibles tanto con las aplicaciones en la nube modernas como con los sistemas antiguos que carecen de API, lo que elimina las barreras de integración comunes. La compatibilidad universal en Windows, macOS y Android garantiza una implementación uniforme. Sin embargo, estas plataformas están diseñadas para la automatización y no para la experimentación o la ingeniería rápida, lo que las hace menos adecuadas para los equipos que se centran en las pruebas iterativas o en la comparación de modelos.

La mejor plataforma para su organización depende de sus necesidades específicas y de la etapa en la que se encuentre la IA. Los equipos que recién comienzan a trabajar en la coordinación multimodelo pueden beneficiarse de las herramientas que simplifican el acceso y reducen los costos. Los equipos con una gran cantidad de ingeniería pueden dar prioridad a las plataformas que ofrecen una amplia personalización. Las empresas con requisitos de cumplimiento estrictos requieren herramientas con una gobernanza integrada, mientras que las empresas que se centran en la automatización de los flujos de trabajo deben buscar plataformas que se integren perfectamente con los sistemas existentes. Estas consideraciones son cruciales para escalar los flujos de trabajo de la IA de manera eficaz.

La gestión de varios LLM en 2026 exige una plataforma que se alinee estrechamente con las prioridades de su organización, ya sea que busque ahorrar costos, flexibilidad técnica, integración perfecta, seguimiento del rendimiento o automatización del flujo de trabajo. Si bien ninguna herramienta puede hacerlo todo por sí sola, comprender los puntos fuertes de cada plataforma le ayudará a elegir la que mejor se adapte a sus necesidades específicas.

Para organizaciones preocupadas por los costos que buscan un acceso amplio a los modelos, destaca Prompts.ai. Consolida el acceso a más de 35 LLM líderes, lo que reduce los costos hasta en un 98%. Con su sistema de créditos TOKN de pago por uso y su amplia biblioteca rápida, simplifica la incorporación y la gestión de costos. Los equipos que valoran la experimentación sencilla en varios modelos encontrarán que esta plataforma es particularmente eficaz.

Equipos de desarrolladores que necesitan una personalización profunda debería considerar LangChain junto con LangServe y LangSmith. Basado en un marco de código abierto, ofrece amplias opciones de flexibilidad e integración, con el respaldo de una comunidad activa. Sin embargo, requiere sólidas capacidades de DevOps y herramientas externas para el seguimiento de los costos, ya que estas funciones no están incluidas.

Empresas centradas en Microsoft se beneficiará de AutoGen y Semantic Kernel, que se integran perfectamente con Azure y ofrecen seguridad de nivel empresarial. Estas herramientas son excelentes para la colaboración entre varios agentes para tareas complejas, aunque conllevan la posibilidad de depender de un proveedor y de aumentar los costos a medida que aumenta el uso. Los entornos que no son de Microsoft pueden enfrentarse a obstáculos de integración adicionales.

Para los equipos de ciencia de datos que priorizan las métricas de rendimiento, plataformas como Arize AI y Weights & Biases son ideales. Proporcionan una supervisión detallada, un seguimiento de experimentos y un control de versiones, lo que las hace excelentes para analizar la latencia, la variación de la precisión y el uso de los tokens. Sin embargo, estas plataformas se centran en la observación más que en la ejecución, por lo que requieren herramientas adicionales para la orquestación y la automatización del flujo de trabajo.

Empresas que buscan automatizar sistemas antiguos y modernos debería explorar plataformas de orquestación de agentes como caesr.ai. Estas herramientas pueden interactuar directamente con el software de Windows, macOS y Android, incluso cuando las API no están disponibles, lo que elimina las barreras de integración comunes. Sin embargo, son menos adecuadas para la creación rápida de prototipos o la ingeniería rápida iterativa.

La mejor opción depende de la madurez actual de la IA y de los desafíos a los que se enfrente. Los equipos que acaban de empezar a trabajar en la coordinación multimodelo suelen beneficiarse de plataformas que simplifican el acceso y ofrecen una transparencia de costes clara. Las organizaciones con un alto nivel de ingeniería pueden priorizar la personalización, mientras que las empresas con necesidades estrictas de cumplimiento deben centrarse en las funciones de gobierno. Las empresas impulsadas por las operaciones deben buscar herramientas que se integren sin esfuerzo con sus sistemas actuales. Al alinear su plataforma con sus requisitos de flujo de trabajo reales, puede escalar la IA de manera efectiva sin complejidad ni gastos innecesarios.

Prompts.ai reduce los costos al proporcionar información en tiempo real sobre el uso, los gastos y el retorno de la inversión (ROI) de la IA. Con acceso a más de 35 modelos lingüísticos de gran tamaño en una plataforma unificada, simplifica las comparaciones y agiliza los flujos de trabajo para lograr la máxima eficiencia.

Al ajustar la selección y el uso del modelo, Prompts.ai garantiza que extraiga el máximo valor de sus inversiones en IA y, al mismo tiempo, mantenga los gastos innecesarios bajo control.

Al elegir una plataforma de orquestación de IA, es importante tener en cuenta la facilidad con la que se integra con sus sistemas y flujos de trabajo actuales. Una plataforma que se conecta sin esfuerzo ahorra tiempo y evita interrupciones innecesarias.

Otro factor clave es escalabilidad - su plataforma debe ser capaz de gestionar las crecientes demandas y admitir varios modelos lingüísticos de gran tamaño (LLM) sin comprometer el rendimiento.

Busca plataformas con interfaces intuitivas y fáciles de usar que simplifican las operaciones y fomentan la adopción en todos los equipos. Fuerte interoperabilidad el soporte es igualmente crucial, ya que permite que diferentes modelos y herramientas de IA trabajen juntos sin problemas.

Finalmente, evalúe la plataforma capacidades de personalización y medidas de seguridad. Una plataforma flexible que se adapte a sus requisitos únicos y, al mismo tiempo, proteja los datos confidenciales le proporcionará tranquilidad y valor a largo plazo.

Las herramientas de orquestación de IA desempeñan un papel crucial en la protección de la información confidencial y en el cumplimiento de las políticas de gobierno empresarial. Lo logran mediante el empleo de medidas de seguridad clave, como autenticación, autorización y auditoría de actividades. Estas funciones funcionan en conjunto para proteger los datos del acceso no autorizado y, al mismo tiempo, mantener el cumplimiento de los estándares de la organización.

Muchas de estas plataformas también ofrecen sistemas de control centralizados, lo que permite a los administradores supervisar y regular el acceso de los usuarios. Al garantizar que solo las personas aprobadas puedan utilizar determinados modelos o conjuntos de datos, este enfoque reduce los riesgos potenciales. Al mismo tiempo, promueve un trabajo en equipo seguro y eficiente, incluso en entornos complejos de varios modelos.