En 2026, la gestion de plusieurs grands modèles linguistiques (LLM) tels que GPT-5, Claude, Gémeaux, et Lama représente un défi croissant pour les entreprises. Les outils d'orchestration de l'IA simplifient cela en unifiant les flux de travail, en réduisant les coûts et en améliorant la gouvernance. Voici un bref aperçu des meilleures solutions :

Chaque outil possède des atouts uniques, qu'il s'agisse de la rentabilité ou de la personnalisation avancée. Le choix de la bonne plateforme dépend des priorités de votre organisation, telles que le contrôle des coûts, l'évolutivité ou la flexibilité technique.

Comparaison rapide:

Sélectionnez la solution qui correspond à vos objectifs, qu'il s'agisse de réduire les coûts, de créer des flux de travail personnalisés ou d'automatiser des processus.

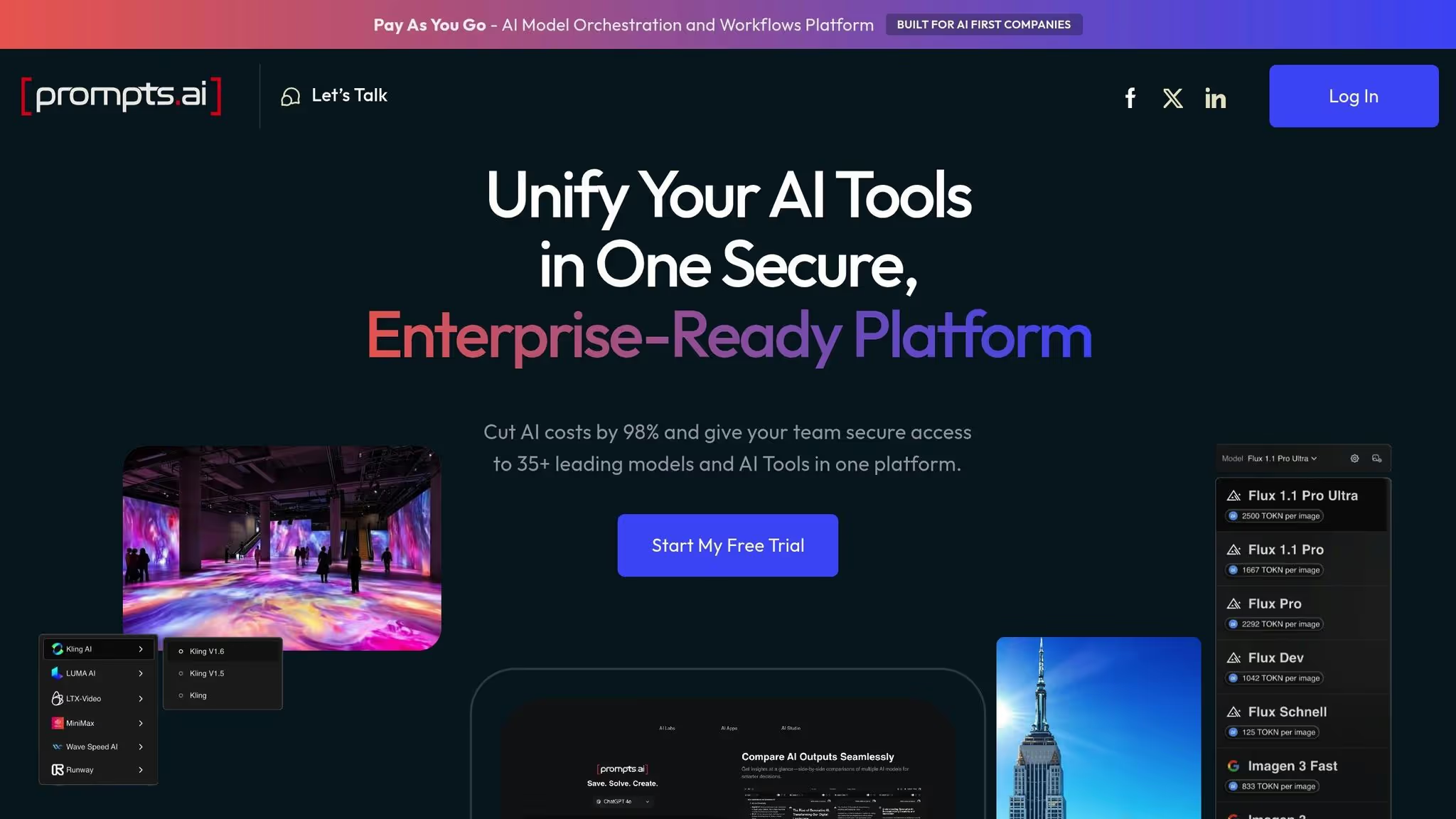

Prompts.ai regroupe plus de 35 modèles d'IA, tels que GPT-5, Claude, LLama, Gemini, et des outils spécialisés tels que À mi-parcours, Flux Pro, et IA Kling - en une plateforme unique et rationalisée. Cela élimine les tracas liés à la gestion de plusieurs abonnements, clés d'API et systèmes de facturation. En centralisant ces outils, les équipes peuvent comparer les modèles côte à côte en temps réel, choisir celui qui convient le mieux à chaque tâche et transformer les flux de travail en processus répétables et vérifiables.

La plateforme s'intègre parfaitement aux outils d'entreprise tels que Slack, Gmail, et Trello, permettant Automatisation pilotée par l'IA dans différents départements. De nouveaux modèles sont ajoutés immédiatement, ce qui élimine le besoin d'intégrations personnalisées et garantit aux utilisateurs un accès permanent aux dernières fonctionnalités.

Ce système unifié simplifie non seulement l'accès, mais crée également des opportunités pour des évaluations multimodèles approfondies.

Prompts.ai prend en charge un large éventail de tâches, de la génération de texte à la création d'images. Les équipes peuvent comparer directement les modèles, comme les prouesses créatives de GPT-5 par rapport à la profondeur analytique de Claude, ou la flexibilité open source de LLama par rapport aux fonctionnalités multimodales de Gemini, ce qui permet de multiplier par 10 la productivité. La plateforme comprend également des outils créatifs tels que Midjourney pour l'art conceptuel, Luma AI pour la modélisation 3D, et Reve AI pour des applications de niche, toutes accessibles via une interface unique.

En plus d'unifier les outils, Prompts.ai offre un contrôle des coûts robuste. Sa conception axée sur FinOps permet de suivre chaque jeton utilisé sur tous les modèles, en s'attaquant de front aux dépenses imprévisibles. La plateforme affirme qu'elle peut réduire les coûts liés à l'IA de 98 % par rapport au maintien des abonnements pour plus de 35 outils, avec la possibilité de réduire les dépenses de 95 % en moins de 10 minutes.

Prompts.ai utilise un système de crédit TOKN par paiement à l'utilisation, qui propose des niveaux de tarification flexibles. Les utilisateurs peuvent explorer la plateforme gratuitement, tandis que les forfaits Creator commencent à 29$ et à 99$ pour un usage familial. Les plans d'affaires vont de 99$ à 129$ par membre, tous dotés d'un suivi des coûts en temps réel pour plus de transparence et de contrôle.

Prompts.ai adhère à des normes de conformité strictes et répond aux exigences SOC 2 Type II, HIPAA et GDPR. Son audit SOC 2 de type 2 a débuté le 19 juin 2025 et un suivi continu est effectué par Vanta. Un centre de gestion de la confidentialité dédié fournit une vue en temps réel des mesures de sécurité, des mises à jour des politiques et des progrès en matière de conformité, ce qui en fait la solution idéale pour les secteurs ayant des besoins rigoureux en matière d'audit et de gouvernance des données.

Les plans d'affaires (Core, Pro et Elite) incluent des fonctionnalités spécialisées pour la surveillance de la conformité et la gouvernance, garantissant ainsi la sécurité et le contrôle des données organisationnelles sensibles.

Prompts.ai est conçu pour évoluer sans effort, prenant en charge tout, des petites équipes aux entreprises du Fortune 500, sans nécessiter de modifications majeures de l'infrastructure. L'ajout de nouveaux modèles, utilisateurs ou départements ne prend que quelques minutes, et non des mois, ce qui simplifie un processus souvent complexe d'expansion de l'IA en entreprise.

Par exemple, les équipes internationales de villes comme New York, San Francisco et Londres peuvent collaborer de manière fluide sur la même plateforme gouvernée. La plateforme propose également une intégration pratique, une formation en entreprise et un programme de certification Prompt Engineer, permettant aux équipes de disposer de flux de travail experts et favorisant une communauté d'ingénieurs rapides qualifiés.

LangChain est un framework Python open source conçu pour créer des applications LLM. Il simplifie l'intégration des modèles d'intégration, des LLM et des magasins vectoriels en proposant des interfaces standardisées, qui rationalisent le processus de connexion de divers composants d'IA dans des flux de travail cohérents. Avec 116 000 étoiles sur GitHub, LangChain est devenu un framework d'orchestration incontournable au sein de la communauté des développeurs d'IA.

En s'appuyant sur les fondations de LangChain, LangGraph introduit des flux de travail d'agents basés sur des graphiques avec état. Il utilise des machines à états pour gérer des modèles hiérarchiques, collaboratifs ou séquentiels (transfert). Comme l'indique le blog n8n.io, LangGraph « échange la complexité de l'apprentissage pour un contrôle précis des flux de travail des agents ».

Pour donner vie à ces applications, LangServe gère le déploiement de LangChain et LangGraph, tandis que LangSmith assure une surveillance et une journalisation en temps réel pour garantir des performances fluides sur les flux de travail en plusieurs étapes.

Ensemble, ces outils forment un pipeline complet : LangChain jette les bases, LangGraph orchestre les flux de travail multi-agents, LangServe facilite le déploiement en temps réel et LangSmith garantit des performances de production fiables. Cette combinaison permet non seulement de créer des applications robustes, mais s'intègre également parfaitement dans des environnements multimodèles.

Cet écosystème open source se distingue en offrant un contrôle précis pour les applications spécialisées, contrairement aux plateformes tout-en-un.

LangChain prend en charge la génération augmentée par extraction (RAG) et se connecte à plusieurs composants LLM via des interfaces standardisées. Cela permet aux développeurs de passer d'un modèle à l'autre sans devoir retravailler l'intégralité des flux de travail. Il met également en œuvre le paradigme ReAct, qui permet aux agents de déterminer dynamiquement quand et comment utiliser des outils spécifiques.

LangGraph va encore plus loin en permettant l'orchestration multi-agents. Les développeurs peuvent concevoir des flux de travail dans lesquels les LLM fonctionnent selon des structures hiérarchiques (un modèle supervisant les autres), travaillent en collaboration en parallèle ou transmettent des tâches de manière séquentielle entre des modèles spécialisés. Cette configuration permet aux équipes de tirer parti des atouts uniques de différents modèles, par exemple en utilisant l'un pour l'extraction des données, un autre pour l'analyse et un troisième pour la génération des résultats finaux.

L'écosystème inclut également LangGraph Studio, un IDE dédié qui offre des fonctionnalités de visualisation, de débogage et d'interaction en temps réel. Cet outil aide les développeurs à mieux comprendre comment les modèles interagissent au sein des flux de travail, ce qui facilite l'identification des goulots d'étranglement ou des erreurs dans les configurations multimodèles.

LangChain suit une structure de prix simple. Il propose un plan développeur gratuit, un niveau Paid Plus à 39$ par mois et des options de tarification personnalisées pour les utilisateurs Enterprise. Les services cloud de LangSmith et LangGraph Platform commencent également à 39$ par mois pour le plan Plus, les tarifs Enterprise étant disponibles sur demande. Pour ceux qui recherchent une option plus économique, un déploiement gratuit de Self-Hosted Lite est disponible, mais avec certaines limites. Au-delà de ces niveaux, la plateforme utilise une tarification basée sur l'utilisation, ne facturant que pour la consommation réelle.

LangSmith améliore la transparence et l'observabilité grâce à ses outils de surveillance et de traçage. Il enregistre les entrées et les sorties pour chaque étape des flux de travail en plusieurs étapes, ce qui facilite le débogage et l'analyse des causes profondes. Ces fonctionnalités garantissent que même les flux de travail les plus complexes restent transparents et répondent aux exigences de conformité. La journalisation détaillée crée une piste d'audit qui peut répondre aux besoins réglementaires, même si les organisations doivent mettre en œuvre leurs propres politiques de conservation des données et contrôles d'accès. Pour les entreprises qui appliquent des normes de conformité strictes, les déploiements auto-hébergés offrent un contrôle total sur le stockage des données.

LangSmith Deployment propose une infrastructure à mise à l'échelle automatique conçue pour gérer des flux de travail de longue durée qui peuvent fonctionner pendant des heures, voire des jours. Cela est particulièrement bénéfique pour les flux de travail d'entreprise nécessitant un traitement soutenu.

LangGraph prend en charge des fonctionnalités telles que les sorties de streaming, les exécutions en arrière-plan, la gestion des rafales et la gestion des interruptions. Ces fonctionnalités permettent aux flux de travail de s'adapter aux pics soudains de demande sans nécessiter d'intervention manuelle.

Alors que les systèmes basés sur Langchain fournissent un contrôle granulaire de l'architecture des flux de travail, leur mise à l'échelle efficace nécessite une expertise technique. Les équipes doivent optimiser les structures graphiques, gérer l'état de manière efficace et configurer correctement l'infrastructure de déploiement. Pour les organisations disposant de solides ressources d'ingénierie, cette profondeur technique devient un atout, car elle permet de mettre en place des stratégies de dimensionnement personnalisées, une gestion avancée des erreurs et des systèmes d'orchestration personnalisés répondant à des besoins spécifiques. Cette flexibilité fait de LangChain un choix judicieux pour les équipes qui cherchent à dépasser les limites des plateformes universelles.

L'écosystème d'agents de Microsoft combine deux frameworks puissants, chacun abordant des aspects uniques de l'orchestration de l'IA. AutoGen se spécialise dans la création de systèmes d'IA à agent unique et multi-agents, rationalisant les tâches de développement logiciel telles que la génération de code, le débogage et l'automatisation du déploiement. Il prend en charge tout, du prototypage rapide au développement au niveau de l'entreprise, en permettant des agents conversationnels capables d'interagir en plusieurs étapes et de prendre des décisions autonomes sur la base d'entrées en langage naturel. En automatisant les étapes critiques telles que la révision du code et la mise en œuvre des fonctionnalités, AutoGen simplifie le processus de livraison des logiciels.

D'autre part, Noyau sémantique sert de SDK open source conçu pour connecter des LLM modernes à des applications d'entreprise écrites en C#, Python et Java. Faisant office de passerelle, il intègre les capacités de l'IA dans les systèmes d'entreprise existants, éliminant ainsi la nécessité d'une refonte technologique complète.

« Microsoft fusionne des frameworks tels qu'AutoGen et Semantic Kernel au sein d'un Microsoft Agent Framework unifié. Ces frameworks sont conçus pour les solutions d'entreprise et s'intègrent aux services Azure. » [2]

Cette intégration jette les bases d'une coordination multimodèle fluide entre les services d'IA de Microsoft.

Le cadre unifié améliore l'interopérabilité en s'intégrant étroitement aux services Azure. Cette configuration fournit une interface unique pour accéder à une variété de LLM et de modèles d'IA. L'architecture d'AutoGen permet à des agents spécialisés de collaborer, en veillant à ce que les tâches soient associées à des modèles conçus pour des performances et une rentabilité optimales. De plus, l'écosystème intègre le Protocole de contexte modèle (MCP), une norme pour le partage sécurisé et versionné des outils et du contexte. Les serveurs MCP personnalisés, capables de gérer plus de 1 000 requêtes par seconde, permettent une coordination fiable entre plusieurs LLM.

« MCP bénéficie de soutiens importants tels que Microsoft, Google et IBM. »

Microsoft donne la priorité à la gouvernance au sein de son écosystème d'agents en s'appuyant sur le protocole Model Context pour garantir des opérations d'IA sûres et efficaces.

« Une couche d'orchestration dotée de telles caractéristiques est une exigence cruciale pour que les agents d'IA puissent fonctionner en toute sécurité en production. »

L'écosystème est conçu pour évoluer sans effort, répondant aux besoins croissants des entreprises en tirant parti de l'infrastructure d'Azure, qui prend actuellement en charge plus de 60 % des déploiements d'IA d'entreprise [2]. L'architecture événementielle d'AutoGen gère efficacement les flux de travail distribués, garantissant ainsi des opérations fluides, même à grande échelle. Les données de marché mettent en évidence la demande croissante de solutions d'IA évolutives : le marché de l'orchestration de l'IA devrait atteindre 11,47 milliards de dollars d'ici 2025, soit un taux de croissance annuel composé de 23 %, tandis que Gartner prévoit que d'ici 2028, 80 % des processus orientés vers les clients s'appuieront sur des systèmes d'IA multi-agents. Cela permet aux entreprises de maintenir des flux de travail efficaces entre les équipes et de s'adapter à l'évolution des demandes.

Les plateformes LLMops sont conçues pour superviser, évaluer et affiner plusieurs grands modèles de langage (LLM) une fois qu'ils sont en production. Ils se concentrent sur les tâches post-déploiement, telles que le suivi des performances, les contrôles de qualité et les améliorations continues. L'objectif est de garantir que les modèles restent fiables et fournissent des résultats précis au fil du temps.

Par exemple, Arize AI est spécialisée dans la détection de la dérive des données, tandis que Weights & Biases excelle dans le suivi des expériences. En répondant à ces besoins opérationnels, ces plateformes rendent la gestion des configurations multimodèles plus efficiente et plus efficace.

La gestion simultanée de plusieurs LLM est l'un des principaux atouts de ces plateformes. Ils comportent généralement des tableaux de bord unifiés qui présentent des mesures de performance critiques pour tous les modèles actifs. Cette vue centralisée permet aux équipes d'identifier plus facilement les modèles les plus performants pour des tâches spécifiques. Les décisions relatives au déploiement peuvent ensuite être guidées par des facteurs tels que la complexité, la rentabilité et la précision du modèle.

Pour maîtriser les dépenses, les plateformes LLMops fournissent une ventilation détaillée des coûts de l'IA par modèle, utilisateur et application. Ils permettent également aux équipes d'analyser les compromis coûts-performances en comparant le coût par demande à des indicateurs de qualité, garantissant ainsi l'optimisation des budgets sans sacrifier la qualité de la production.

La gouvernance est la pierre angulaire de nombreuses plateformes LLMops. Ils tiennent à jour des journaux des interactions entre les modèles, qui sont essentiels pour répondre aux exigences réglementaires et d'audit. Des fonctionnalités telles que les contrôles d'accès basés sur les rôles et les pistes d'audit exhaustives aident les entreprises à gérer les autorisations et à respecter les normes de confidentialité des données, offrant ainsi la tranquillité d'esprit dans les secteurs où la conformité est importante.

Ces plateformes sont conçues pour gérer les déploiements d'entreprise à grande échelle. Ils offrent des fonctionnalités de mise à l'échelle automatique et des options d'infrastructure flexibles, que ce soit dans le cloud ou sur site. L'intégration avec les pipelines DevOps et les flux de travail CI/CD simplifie encore le déploiement et la surveillance. Les systèmes de suivi des performances et d'alerte en temps réel permettent aux équipes de résoudre rapidement les problèmes dès qu'ils surviennent, garantissant ainsi le bon déroulement des opérations.

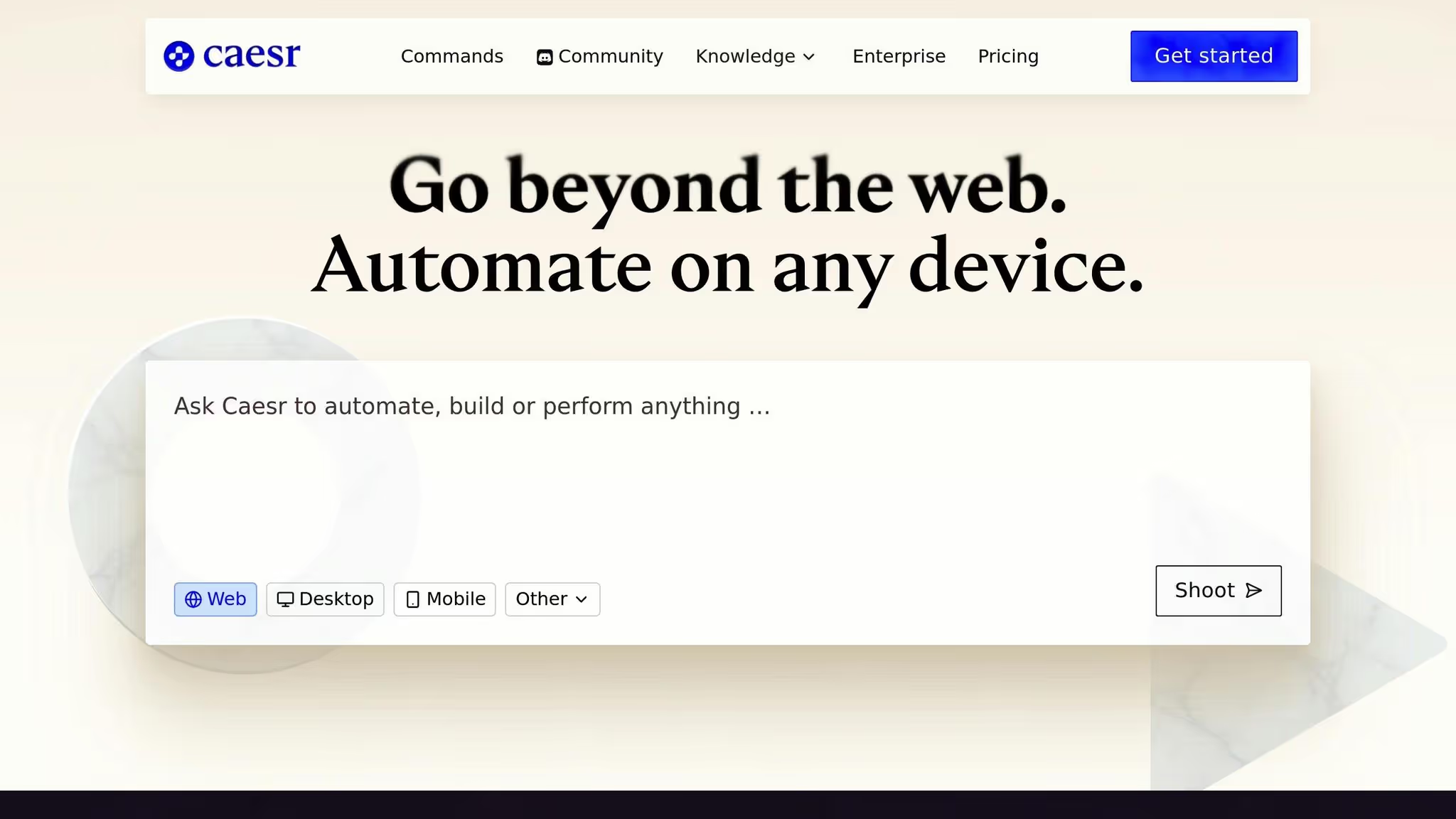

Les plateformes d'orchestration des agents sont conçues pour prendre en charge à la fois les logiciels et les flux de travail, en couvrant les anciens systèmes existants et les applications les plus récentes. Contrairement aux outils qui se contentent d'observer les modèles en production, ces plateformes automatisent activement les processus en interagissant directement avec les principaux logiciels métier. Caesr.ai en est un excellent exemple, car il connecte les modèles d'IA directement aux outils commerciaux essentiels, transformant ainsi l'automatisation en un moteur pratique des opérations commerciales plutôt qu'une simple supervision passive.

Ces plateformes excellent également dans l'intégration de plusieurs modèles d'IA. En traitant les modèles comme des outils interchangeables, les entreprises peuvent sélectionner celui qui convient le mieux à une tâche spécifique, garantissant ainsi une gestion précise des flux de travail et une expertise adaptée.

L'évolutivité des plateformes d'orchestration des agents repose sur la compatibilité et l'intégration au niveau de l'entreprise. Caesr.ai, par exemple, est conçu pour une compatibilité universelle, permettant aux agents de fonctionner de manière fluide sur les plateformes Web, de bureau, mobiles, Android, macOS et Windows. Cette flexibilité élimine les problèmes de déploiement au sein d'une organisation. De plus, en interagissant directement avec les outils et les applications, en évitant de se fier uniquement aux API, la plateforme permet des opérations fluides avec les systèmes modernes basés sur le cloud et les anciens logiciels existants. Caesr.ai respecte également des normes strictes de sécurité et d'infrastructure d'entreprise, ce qui en fait un choix fiable pour les déploiements à grande échelle.

Pour choisir le bon outil d'orchestration de l'IA, il faut évaluer ses avantages par rapport à ses limites. Chaque plateforme présente des avantages distincts, mais il est essentiel de comprendre leurs compromis pour les aligner sur les objectifs, les capacités techniques et le budget de votre organisation.

Prompts.ai se distingue par ses capacités de réduction des coûts et son accès étendu aux modèles. Avec plus de 35 LLM de premier plan consolidés en une seule interface, il élimine le besoin de plusieurs abonnements, réduisant ainsi les dépenses liées aux logiciels d'IA de 98 %. Ses contrôles FinOps en temps réel fournissent aux équipes financières une supervision détaillée de l'utilisation des jetons, simplifiant ainsi la gestion du budget. Le système de crédit TOKN pay-as-you-go garantit la flexibilité en évitant des frais récurrents inutiles. De plus, sa bibliothèque rapide et son programme de certification facilitent l'intégration des utilisateurs non techniques. Cependant, les organisations qui investissent massivement dans une infrastructure personnalisée peuvent être confrontées à des difficultés lors de la migration, et les équipes nécessitant des frameworks hautement spécialisés doivent confirmer la compatibilité avec leurs besoins.

LangChain avec LangServe et LangSmith offre une flexibilité inégalée aux développeurs qui recherchent un contrôle total sur les pipelines d'IA. Sa base open source permet une personnalisation approfondie, tandis que sa communauté active fournit une multitude d'intégrations et d'extensions. Les outils de débogage de LangSmith permettent d'identifier plus facilement les problèmes de flux de travail. En revanche, la complexité de la mise en place de systèmes prêts pour la production exige une expertise technique importante, ce qui peut constituer un obstacle pour les petites équipes qui ne disposent pas d'un support DevOps dédié. En outre, l'absence de suivi des coûts intégré nécessite des outils distincts pour surveiller les dépenses de plusieurs fournisseurs de modèles.

L'écosystème d'agents de Microsoft (AutoGen & Semantic Kernel) s'intègre parfaitement aux services Azure, ce qui en fait la solution idéale pour les entreprises qui utilisent déjà l'infrastructure Microsoft. AutoGen permet la collaboration multi-agents pour des tâches complexes, tandis que Semantic Kernel fournit des fonctionnalités avancées de mémoire et de planification. Ses fonctionnalités de sécurité et de conformité répondent dès le départ aux normes de l'entreprise. Cependant, cet écosystème lie étroitement les utilisateurs à Microsoft, ce qui rend la migration difficile et fait grimper les coûts à mesure que l'utilisation augmente. Pour les organisations ne faisant pas partie de la suite Microsoft, l'intégration et l'intégration peuvent s'avérer plus difficiles.

Plateformes LLMops comme Arize AI et Weights & Biases excellent en matière d'observabilité et de suivi des performances. Ils suivent des indicateurs clés tels que la latence, la dérive de précision et l'utilisation des jetons, fournissant aux équipes de science des données des informations leur permettant d'affiner en permanence les modèles. Des fonctionnalités telles que le suivi des expériences et le contrôle des versions permettent de gérer efficacement plusieurs itérations de modèles. Cependant, ces plateformes se concentrent sur la surveillance plutôt que sur l'orchestration des flux de travail ou l'automatisation des processus. Des outils supplémentaires sont nécessaires pour l'exécution, et les équipes ont besoin d'une expertise en matière d'apprentissage automatique pour tirer pleinement parti de ces plateformes.

Plateformes d'orchestration des agents tels que caesr.ai sont spécialisés dans l'automatisation des flux de travail en interagissant directement avec les logiciels d'entreprise sur le Web, les ordinateurs de bureau et les environnements mobiles. Ils sont compatibles à la fois avec les applications cloud modernes et les anciens systèmes existants dépourvus d'API, éliminant ainsi les obstacles d'intégration courants. La compatibilité universelle entre Windows, macOS et Android garantit un déploiement cohérent. Cependant, ces plateformes sont conçues pour l'automatisation plutôt que pour l'expérimentation ou l'ingénierie rapide, ce qui les rend moins adaptées aux équipes qui se concentrent sur les tests itératifs ou les comparaisons de modèles.

La meilleure plateforme pour votre organisation dépend de vos besoins spécifiques et de l'étape de votre parcours vers l'IA. Les équipes qui découvrent la coordination multimodèle peuvent bénéficier d'outils qui simplifient l'accès et réduisent les coûts. Les équipes à forte intensité d'ingénierie peuvent donner la priorité aux plateformes offrant une personnalisation poussée. Les entreprises soumises à des exigences de conformité strictes ont besoin d'outils dotés d'une gouvernance intégrée, tandis que les entreprises axées sur l'automatisation des flux de travail devraient rechercher des plateformes qui s'intègrent parfaitement aux systèmes existants. Ces considérations sont cruciales pour faire évoluer efficacement les flux de travail d'IA.

La gestion de plusieurs LLM en 2026 nécessite une plateforme étroitement alignée sur les priorités de votre organisation, que vous recherchiez des économies de coûts, une flexibilité technique, une intégration fluide, un suivi des performances ou l'automatisation des flux de travail. Bien qu'aucun outil ne puisse tout faire, comprendre les points forts de chaque plateforme vous aidera à choisir celle qui correspond à vos besoins spécifiques.

Pour les organisations soucieuses des coûts qui souhaitent accéder à un large éventail de modèles, Prompts.ai se démarque. Il consolide l'accès à plus de 35 LLM de premier plan, réduisant ainsi les coûts jusqu'à 98 %. Grâce à son système de crédit TOKN à paiement à l'utilisation et à sa vaste bibliothèque rapide, il simplifie l'intégration et la gestion des coûts. Les équipes qui apprécient la facilité d'expérimentation sur plusieurs modèles trouveront cette plateforme particulièrement efficace.

Les équipes de développeurs qui ont besoin d'une personnalisation approfondie devrait envisager LangChain associé à LangServe et LangSmith. Construit sur un framework open source, il offre une flexibilité et des options d'intégration étendues, soutenues par une communauté active. Cependant, cela nécessite de solides capacités DevOps et des outils externes pour le suivi des coûts, car ces fonctionnalités ne sont pas incluses.

Entreprises centrées sur Microsoft bénéficiera d'AutoGen et de Semantic Kernel, qui s'intègrent parfaitement à Azure et offrent une sécurité de niveau entreprise. Ces outils excellent en matière de collaboration multi-agents pour les tâches complexes, mais ils peuvent entraîner une dépendance vis-à-vis des fournisseurs et une hausse des coûts à mesure que leur utilisation augmente. Les environnements autres que Microsoft peuvent être confrontés à des obstacles d'intégration supplémentaires.

Pour les équipes de data science qui donnent la priorité aux mesures de performance, des plateformes comme Arize AI et Weights & Biases sont idéales. Ils fournissent une surveillance détaillée, un suivi des expériences et un contrôle de version, ce qui les rend excellents pour analyser la latence, la dérive de précision et l'utilisation des jetons. Cependant, ces plateformes se concentrent sur l'observation plutôt que sur l'exécution, nécessitant des outils supplémentaires pour l'orchestration et l'automatisation des flux de travail.

Les entreprises qui souhaitent automatiser leurs systèmes existants et modernes devrait explorer les plateformes d'orchestration des agents telles que caesr.ai. Ces outils peuvent interagir directement avec les logiciels sous Windows, macOS et Android, même lorsque les API ne sont pas disponibles, éliminant ainsi les obstacles d'intégration courants. Cependant, ils sont moins adaptés au prototypage rapide ou à l'ingénierie rapide itérative.

Le meilleur choix dépend de votre maturité actuelle en matière d'IA et des défis que vous devez relever. Les équipes qui découvrent la coordination multimodèle bénéficient souvent de plateformes qui simplifient l'accès et offrent une transparence claire des coûts. Les organisations à forte intensité d'ingénierie peuvent donner la priorité à la personnalisation, tandis que les entreprises ayant des besoins de conformité stricts devraient se concentrer sur les fonctionnalités de gouvernance. Les entreprises axées sur les opérations devraient rechercher des outils qui s'intègrent facilement à leurs systèmes existants. En alignant votre plateforme sur vos exigences réelles en matière de flux de travail, vous pouvez faire évoluer l'IA de manière efficace sans complexité ni dépenses inutiles.

Prompts.ai réduit les coûts en fournissant des informations en temps réel sur l'utilisation, les dépenses et le retour sur investissement (ROI) de votre IA. Avec l'accès à plus de 35 grands modèles linguistiques sur une seule plateforme unifiée, il simplifie les comparaisons et rationalise les flux de travail pour une efficacité maximale.

En ajustant la sélection et l'utilisation des modèles, Prompts.ai vous permet de tirer le meilleur parti de vos investissements dans l'IA tout en maîtrisant les dépenses inutiles.

Lorsque vous choisissez une plateforme d'orchestration d'IA, il est important de prendre en compte la facilité avec laquelle elle s'intègre à vos systèmes et flux de travail actuels. Une plateforme qui se connecte sans effort permet de gagner du temps et d'éviter les interruptions inutiles.

Un autre facteur clé est évolutivité - votre plateforme doit être capable de gérer des demandes croissantes et de prendre en charge plusieurs grands modèles de langage (LLM) sans compromettre les performances.

Recherchez des plateformes avec interfaces intuitives et conviviales qui simplifient les opérations et encouragent l'adoption par les équipes. Fort interopérabilité le support est tout aussi crucial, car il permet à différents modèles et outils d'IA de fonctionner ensemble de manière fluide.

Enfin, évaluez la plateforme capacités de personnalisation et mesures de sécurité. Une plateforme flexible qui s'adapte à vos besoins uniques tout en protégeant les données sensibles vous assurera la tranquillité d'esprit et une valeur à long terme.

Les outils d'orchestration de l'IA jouent un rôle crucial dans la protection des informations sensibles et le respect des politiques de gouvernance d'entreprise. Ils y parviennent en utilisant des mesures de sécurité clés telles que authentification, autorisation et audit des activités. Ces fonctionnalités fonctionnent ensemble pour protéger les données contre tout accès non autorisé tout en maintenant la conformité aux normes organisationnelles.

Nombre de ces plateformes proposent également des systèmes de contrôle centralisés, permettant aux administrateurs de superviser et de réguler l'accès des utilisateurs. En garantissant que seules les personnes autorisées peuvent utiliser certains modèles ou ensembles de données, cette approche réduit les risques potentiels. Dans le même temps, il favorise un travail d'équipe sûr et efficace, même dans des environnements multimodèles complexes.