La gestión de los modelos de IA es compleja y abarca el desarrollo, la implementación, la supervisión y la retirada. Las herramientas adecuadas pueden simplificar los flujos de trabajo, reducir los costos y garantizar la gobernanza. Esta es una descripción general rápida de las cinco plataformas principales:

Cada herramienta tiene puntos fuertes adaptados a las diferentes necesidades, desde la rentabilidad hasta las capacidades de integración. A continuación se muestra una comparación que le ayudará a decidir.

Elija la herramienta que se adapte a sus prioridades, ya sea para reducir los costos, escalar las operaciones o integrarse con los sistemas existentes.

Prompts.ai es un plataforma de orquestación de IA empresarial diseñado para unificar más de 35 de los principales modelos lingüísticos de gran tamaño (LLM) dentro de una interfaz segura y centralizada. Diseñada para diseñar y gestionar rápidamente los flujos de trabajo de la maestría, presta servicios a una amplia gama de clientes, desde empresas incluidas en la lista Fortune 500 hasta agencias creativas, ayudándoles a optimizar sus herramientas y, al mismo tiempo, a mantener el control sobre la gobernanza y los costos.

La plataforma se centra en etapas rápidas de ingeniería y experimentación del ciclo de vida del modelo de IA. Ayuda a los usuarios a diseñar, probar y perfeccionar las instrucciones, con funciones como el control de versiones y las pruebas A/B para garantizar la coherencia y la reproducibilidad a lo largo de los ciclos de desarrollo. Al centrarse en estas fases críticas, Prompts.ai aborda una necesidad clave de escalar los flujos de trabajo rápidos de forma eficaz.

Prompts.ai se conecta sin esfuerzo con los principales proveedores de LLM a través de puntos finales de API estandarizados, lo que simplifica la administración de múltiples conexiones y credenciales de API en todos los equipos. Este acceso unificado garantiza una integración fluida con sistemas de desarrollo de IA más amplios.

Si bien la plataforma está optimizada para los LLM basados en la nube, su dependencia de la infraestructura en la nube puede plantear desafíos para las empresas con requisitos estrictos de residencia de datos. Las organizaciones deben evaluar si su configuración se ajusta a sus necesidades de cumplimiento, especialmente si las soluciones locales son una prioridad.

Prompts.ai incluye una sólida suite de herramientas de supervisión y gobernanza diseñado para operaciones a escala empresarial. Es análisis en tiempo real proporcionan información sobre el rendimiento rápido, rastreando métricas como la calidad de la respuesta, la latencia y la participación de los usuarios. Estos conocimientos basados en datos permiten a los equipos ajustar sus estrategias en función de los resultados de rendimiento.

El marco de gobernanza ofrece pistas de auditoría para modificaciones rápidas, controles de acceso para administrar los permisos y funciones de cumplimiento compatibles con los estándares SOC 2 Type II, HIPAA y GDPR. Con una visibilidad total de las interacciones de la IA, la plataforma garantiza la transparencia y la responsabilidad, algo esencial para que las empresas equilibren la innovación con los requisitos reglamentarios. Esta combinación de supervisión y gobierno mejora tanto la eficiencia operativa como la supervisión.

Prompts.ai ofrece ahorros notables al reducir los costos relacionados con la LLM. Su iteración y pruebas rápidas y eficientes minimizan la cantidad de llamadas a la API y ejecuciones de modelos necesarias para lograr resultados. La plataforma incluye paneles de uso que muestran los costos en dólares estadounidenses, desglosados por equipo, proyecto o modelo, y ofrecen una visibilidad clara de los gastos.

El sistema de crédito TOKN de pago por uso elimina las tarifas de suscripción, vinculando los costos directamente al uso real. Este modelo puede ayudar a las organizaciones reducir los gastos de software de IA hasta en un 98%, especialmente si se compara con la administración de múltiples suscripciones y herramientas de LLM. Además, la capa FinOps integrada rastrea el uso de los tokens y vincula los gastos con los resultados, lo que brinda a los equipos financieros la transparencia que necesitan.

El enfoque específico de Prompts.ai en los flujos de trabajo rápidos lo diferencia, lo que lo convierte en un poderoso complemento para otras plataformas que pueden priorizar capacidades de IA más amplias.

MLFlow es un plataforma de código abierto diseñado para simplificar el ciclo de vida del aprendizaje automático. Proporciona un marco integral para la gestión y el seguimiento de los modelos, que abarca todo, desde la experimentación inicial hasta la implementación en producción.

MLFlow apoya las fases críticas del ciclo de vida de la IA al registrar automáticamente los parámetros, las versiones del código, las métricas y los artefactos durante el desarrollo.

Es Registro de modelos y estandarizado Proyectos simplifique tareas como el control de versiones, las transiciones de etapas y la reproducibilidad de los experimentos. Estas funciones garantizan una supervisión clara y unos procesos de implementación confiables.

MLFlow funciona a la perfección con una amplia gama de herramientas y plataformas. Se integra con AWS SageMaker, plataformas MLOps como Dag Huby admite varios entornos de programación, incluidas las API de Python, R, Java y REST. Esta flexibilidad permite a los equipos usar su infraestructura existente mientras implementan modelos en diversos entornos.

MLFlow rastrea automáticamente los parámetros, las métricas y los artefactos de entrenamiento, creando registros de auditoría detallados que ayudan en los esfuerzos de depuración y cumplimiento.

El Registro de modelos proporciona herramientas avanzadas de control de versiones y gestión de etapas. Los equipos pueden anotar los modelos con descripciones, etiquetas y metadatos para documentar su propósito y rendimiento. El registro también rastrea el linaje de los modelos, lo que facilita la supervisión y la gestión de la evolución de las versiones implementadas.

La reproducibilidad es una característica destacada de MLFlow. ¿Con Proyectos, empaqueta código, dependencias y configuraciones juntos, abordando el problema común de que «funciona en mi máquina» al hacer la transición de modelos del desarrollo a la producción.

Kubeflow es una colección de herramientas diseñadas para crear y administrar canales de aprendizaje automático en Kubernetes. Al utilizar despliegues en contenedores, garantiza la escalabilidad y la flexibilidad en varios entornos informáticos.

Kubeflow destaca en la gestión de las etapas de orquestación e implementación del ciclo de vida del modelo de IA. Programa las tareas de manera eficiente, garantizando que los procesos de aprendizaje automático sean confiables, reproducibles y optimizados. Basado en Kubernetes, ofrece la portabilidad y la escalabilidad necesarias para administrar sistemas complejos. Además, se integra perfectamente con las herramientas existentes para mejorar su funcionalidad.

Kubeflow admite la implementación en configuraciones híbridas, locales y en la nube, lo que lo hace adaptable a diversos entornos. A través de Kubeflow Pipelines, funciona con varios marcos de servicio, mientras que con herramientas como Tablero tensor permiten la supervisión del rendimiento del modelo en tiempo real. La inclusión de los metadatos de ML (MLMD) mejora aún más su funcionalidad al rastrear el linaje y los artefactos relacionados.

Kubeflow ofrece una supervisión sólida de los modelos de producción, lo que garantiza una supervisión continua del rendimiento. También incluye funciones de aislamiento multiusuario, que permiten a los administradores controlar el acceso y garantizar el cumplimiento. Estas herramientas de gobierno son particularmente útiles para administrar operaciones de aprendizaje automático complejas y a gran escala, ya que ayudan a las organizaciones a mantener el control y la responsabilidad a medida que crecen sus proyectos de IA.

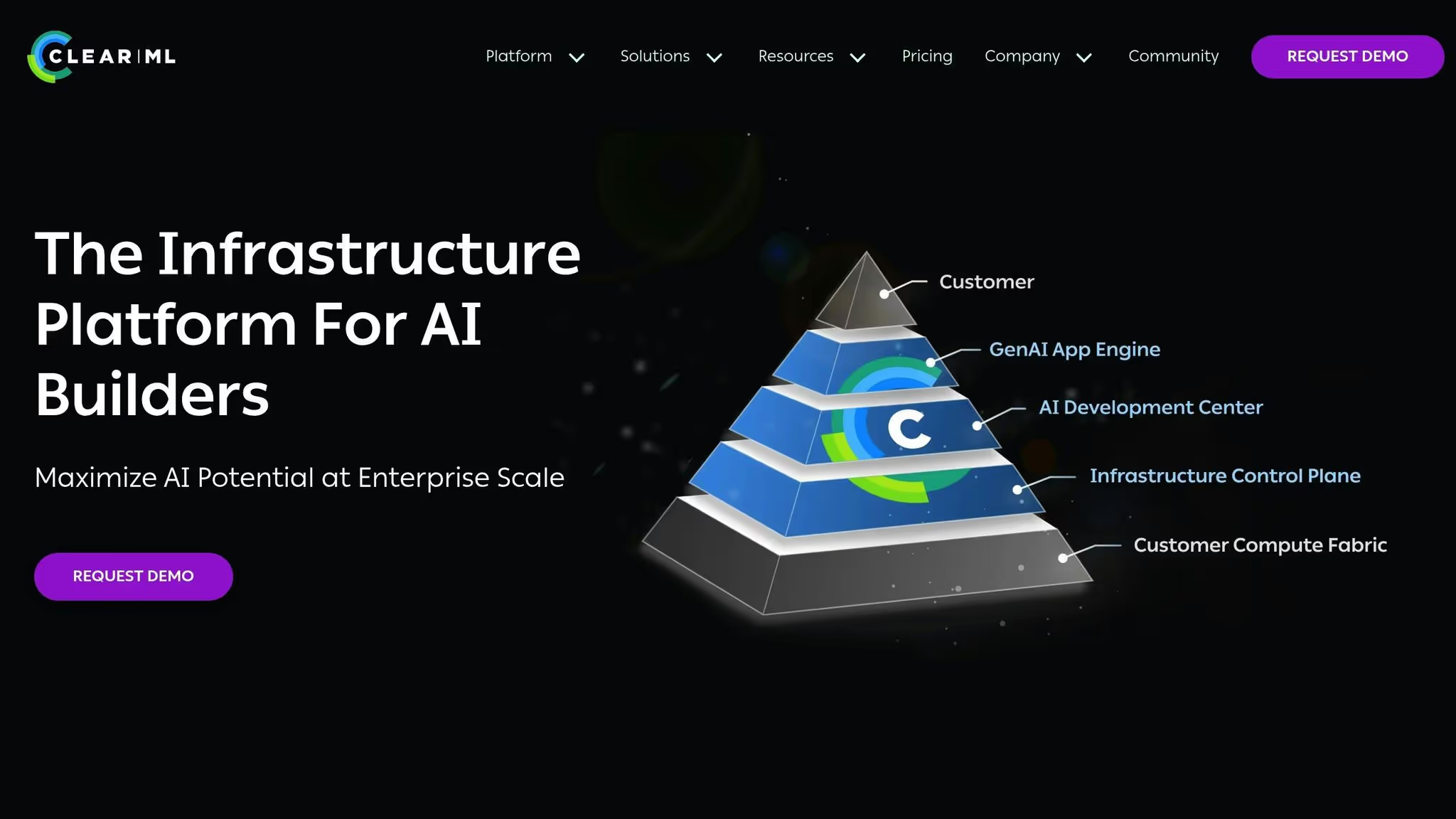

ClearML es una plataforma de código abierto diseñada para gestionar todo el ciclo de vida de la IA. Su naturaleza de código abierto permite la personalización para adaptarse a necesidades operativas específicas, aunque la disponibilidad de documentación pública detallada es algo limitada. Si está considerando usar ClearML, es esencial evaluar si se alinea con los objetivos y la infraestructura de su proyecto. Al igual que otras plataformas mencionadas, el marco flexible de ClearML podría ser una buena opción para abordar las demandas únicas de su flujo de trabajo de IA.

Google Cloud Vertex AI es una plataforma de aprendizaje automático totalmente gestionada de Google, diseñada para respaldar cada fase del ciclo de vida del aprendizaje automático dentro del ecosistema de Google Cloud. Reúne una variedad de herramientas y servicios de aprendizaje automático en una sola interfaz, lo que la convierte en la solución ideal para las organizaciones que ya utilizan Google Cloud.

La plataforma está diseñada para atender a una amplia gama de usuarios, desde científicos de datos que escriben código personalizado hasta analistas de negocios que buscan opciones de código bajo. Esta flexibilidad permite a los equipos trabajar de la manera que mejor se adapte a sus necesidades y, al mismo tiempo, mantener la uniformidad en todos los flujos de trabajo de aprendizaje automático de la organización.

Vertex AI proporciona un soporte integral para todo el ciclo de vida del modelo de IA y se integra perfectamente con los servicios de Google Cloud. Para los equipos que requieren un control total, ofrece formación de código personalizada. Al mismo tiempo, sus funciones de AutoML y sus terminales gestionados simplifican la escalabilidad y la gestión de la infraestructura para quienes prefieren la automatización [6,7]. Las canalizaciones de MLOps de la plataforma permiten una transición fluida del desarrollo a la producción, incluso para los equipos sin una amplia experiencia en DevOps. Además, los recursos informáticos se pueden ampliar o reducir en función de las exigencias del proyecto, lo que garantiza un uso eficiente de los recursos. Este soporte integral está estrechamente integrado con otras herramientas de Google Cloud, lo que permite agilizar el flujo de trabajo.

Lo que diferencia a Vertex AI es su profunda integración con otros servicios de Google Cloud Platform. Funciona sin esfuerzo con BigQuery para almacenamiento de datos y Mirador para inteligencia empresarial, que ofrece un entorno unificado para las tareas de ciencia de datos.

Esta estrecha integración elimina la necesidad de transferencias de datos complejas, ya que los científicos de datos pueden acceder directamente a los datos de la organización dentro del entorno de inteligencia artificial de Vertex. Una API unificada simplifica aún más las interacciones entre los servicios de Google Cloud, lo que ayuda a los usuarios a adaptarse rápidamente a la plataforma y acelerar el desarrollo.

Vertex AI va más allá de la gestión del ciclo de vida al ofrecer funciones sólidas de supervisión y gobierno. Al utilizar los metadatos de Vertex ML, rastrea las entradas, las salidas y otros componentes de la canalización para garantizar una auditabilidad integral. Esto es especialmente valioso para las organizaciones de sectores regulados o para aquellas que requieren un modelo de gobierno estricto. La plataforma registra automáticamente los detalles de los experimentos, las versiones de los modelos y las métricas de rendimiento, creando un registro de auditoría completo para respaldar los esfuerzos de cumplimiento.

Como servicio gestionado, Vertex AI puede reducir significativamente los costos al eliminar la necesidad de equipos de infraestructura dedicados. Su modelo de precios de pago por uso, combinado con la infraestructura global de Google, permite a las organizaciones escalar las operaciones de aprendizaje automático de manera eficiente y asignar los recursos donde más se necesitan. Para las organizaciones que ya utilizan Google Cloud, la IA de Vertex también ayuda a evitar los costos de salida de datos, ya que todos los datos permanecen en el ecosistema de Google Cloud durante todo el ciclo de vida del aprendizaje automático.

Cada una de las herramientas de gestión del ciclo de vida de los modelos de IA aporta sus propias fortalezas y debilidades. Al comprender estas ventajas y desventajas, las organizaciones pueden alinear sus elecciones con sus requisitos únicos, la infraestructura existente y la experiencia del equipo. A continuación se presenta un desglose conciso de las principales características y desafíos de las plataformas más populares.

Prompts.ai destaca por su capacidad de unificar más de 35 LLM en un sistema TOKN de pago por uso, lo que podría reducir los costos hasta en un 98%. Ofrece una gobernanza centrada en la empresa con controles FinOps en tiempo real, lo que garantiza la transparencia y el cumplimiento. Sin embargo, su especialización en flujos de trabajo de LLM puede limitar su atractivo a casos de uso de aprendizaje automático más amplios.

MLFlow, una plataforma de código abierto, proporciona componentes modulares que evitan la dependencia de un proveedor. Sus puntos fuertes radican en el seguimiento de los experimentos y en un registro de modelos sólido. Sin embargo, requiere una configuración y un mantenimiento importantes, lo que exige un equipo de DevOps dedicado para administrarlo de manera eficaz.

Kubeflow está diseñado para orquestar el entrenamiento distribuido y las canalizaciones de aprendizaje automático complejas mediante Kubernetes. Se destaca en el manejo de cargas de trabajo con gran cantidad de recursos informáticos, pero tiene una curva de aprendizaje pronunciada, lo que lo convierte en un desafío para los equipos que no tienen una sólida experiencia en Kubernetes.

Borrar ML simplifica la administración de experimentos al automatizar el seguimiento de los cambios de código, las dependencias y los entornos. Esto reduce el esfuerzo manual y fomenta la colaboración en equipo. Dicho esto, su ecosistema más pequeño puede restringir la gama de integraciones de terceros disponibles.

Vertex AI, profundamente integrado con Google Cloud, ofrece autoML y formación personalizada en un entorno totalmente gestionado. Su conexión perfecta con BigQuery y los servicios relacionados reduce la complejidad operativa. Sin embargo, conlleva el riesgo de la dependencia de un proveedor y de los posibles costos de salida de datos.

En la siguiente tabla se destacan las características principales de cada herramienta:

La elección de la herramienta adecuada depende de las prioridades de su organización. Si la rentabilidad y los flujos de trabajo de LLM son las principales preocupaciones, Prompts.ai es un fuerte contendiente. Para equipos que buscan flexibilidad, MLFlow ofrece soluciones independientes del proveedor. Las organizaciones que estén profundamente integradas con Google Cloud lo apreciarán Vertex AI, mientras que quienes tienen experiencia en Kubernetes pueden aprovechar Kubeflow para capacidades de orquestación avanzadas.

La selección de la herramienta adecuada para el ciclo de vida de la IA depende del tamaño, la infraestructura, el presupuesto y los casos de uso únicos de su organización. Así es como algunas de las plataformas líderes se alinean con las diferentes necesidades:

Dadas estas fortalezas, muchas organizaciones consideran que un enfoque híbrido es más efectivo que confiar en una sola plataforma. Por ejemplo, Prompts.ai puede gestionar la organización de la LLM y la optimización de costos, mientras que MLFlow hace un seguimiento de los modelos de aprendizaje automático tradicionales y las herramientas nativas de la nube supervisan la supervisión de la producción. Esta combinación garantiza una cobertura integral del ciclo de vida de la IA y, al mismo tiempo, aprovecha las ventajas de cada herramienta.

Para los equipos más pequeños, las herramientas con una configuración sencilla y precios transparentes son fundamentales. Las organizaciones medianas suelen necesitar soluciones escalables con sólidas funciones de gobierno, mientras que las grandes empresas dan prioridad a los registros de auditoría detallados y a una integración de TI perfecta.

A medida que las herramientas de IA sigan avanzando, concéntrese en plataformas con un desarrollo activo, un fuerte respaldo de la comunidad y planes claros para el futuro. Los flujos de trabajo interoperables siguen siendo cruciales para adaptarse a este panorama en constante cambio y lograr un despliegue efectivo de la IA.

Al elegir una herramienta para gestionar el ciclo de vida de los modelos de IA, es importante centrarse en las funciones que se ajusten a las necesidades específicas de la organización. Comience por identificar las herramientas que proporcionan potentes capacidades de servicio diseñado para su caso de uso particular, junto con opciones de implementación flexibles que pueden adaptarse a su configuración operativa. La integración perfecta con su infraestructura de aprendizaje automático actual es otro factor fundamental a tener en cuenta.

También es aconsejable seleccionar herramientas equipadas con funciones de monitoreo y observabilidad para ayudar a mantener el rendimiento y la confiabilidad del modelo a lo largo del tiempo. Busque soluciones que sean fáciles de usar para su equipo y que, al mismo tiempo, ofrezcan soluciones sólidas medidas de seguridad y gobernanza para garantizar el cumplimiento y proteger los datos confidenciales. La elección correcta puede simplificar sus flujos de trabajo, mejorar la eficiencia y generar mejores resultados en la gestión de sus modelos de IA.

Prompts.ai se adhiere a los marcos de cumplimiento de primer nivel, como SOC 2 tipo II, HIPAA, y GDPR, garantizando medidas sólidas de protección y gobernanza de los datos. La plataforma integra un monitoreo continuo a través de Vanta para mantener estándares de seguridad rigurosos.

El 19 de junio de 2025, Prompts.ai inició su Proceso de auditoría SOC 2 tipo II, reafirmando su dedicación a mantener los niveles más altos de seguridad de datos y cumplimiento para los clientes empresariales.

Las herramientas de gestión del ciclo de vida de la IA están diseñadas para funcionar sin esfuerzo con sus sistemas de TI actuales. Están diseñadas para conectarse con plataformas, bases de datos y servicios en la nube más utilizados, lo que garantiza que se adapten perfectamente a su configuración actual.

Estas herramientas se integran al vincularse a sus canalizaciones de datos, soluciones de almacenamiento y entornos de implementación. Muchas también vienen con API y flujos de trabajo flexibles, lo que permite una interacción perfecta entre los componentes. Esto garantiza una supervisión y un monitoreo efectivos de todas sus iniciativas de IA.