تعد إدارة نماذج الذكاء الاصطناعي أمرًا معقدًا، حيث يغطي التطوير والنشر والمراقبة والتقاعد. يمكن للأدوات المناسبة تبسيط سير العمل وخفض التكاليف وضمان الحوكمة. فيما يلي نظرة عامة سريعة على خمس منصات رائدة:

تحتوي كل أداة على نقاط قوة مصممة لتلبية الاحتياجات المختلفة، من كفاءة التكلفة إلى قدرات التكامل. فيما يلي مقارنة لمساعدتك على اتخاذ القرار.

اختر الأداة التي تتوافق مع أولوياتك، سواء كانت تعمل على خفض التكاليف أو توسيع نطاق العمليات أو التكامل مع الأنظمة الحالية.

ملف Prompts.ai عبارة عن منصة تنسيق الذكاء الاصطناعي للمؤسسات تم تصميمه لتوحيد أكثر من 35 نموذجًا من أفضل نماذج اللغات الكبيرة (LLMs) داخل واجهة مركزية آمنة. وهي مصممة خصيصًا للهندسة السريعة وإدارة تدفقات LLM، وهي تخدم مجموعة متنوعة من العملاء، من شركات Fortune 500 إلى الوكالات الإبداعية، مما يساعدهم على تبسيط أدواتهم مع الحفاظ على السيطرة على الحوكمة والتكاليف.

تركز المنصة على مراحل الهندسة والتجريب السريعة لدورة حياة نموذج الذكاء الاصطناعي. وهو يدعم المستخدمين في تصميم المطالبات واختبارها وتحسينها، مع ميزات مثل التحكم في الإصدار واختبار A/B لضمان الاتساق والاستنساخ خلال دورات التطوير. من خلال التركيز على هذه المراحل الحرجة، يعالج Prompts.ai حاجة أساسية لتوسيع نطاق سير العمل السريع بشكل فعال.

يتصل Prompts.ai بسهولة بموفري LLM الرئيسيين من خلال نقاط نهاية API الموحدة، مما يبسط إدارة اتصالات API المتعددة وبيانات الاعتماد عبر الفرق. يضمن هذا الوصول الموحد التكامل السلس مع مجموعات تطوير الذكاء الاصطناعي الأوسع.

في حين تم تحسين النظام الأساسي للشركات ذات المسؤولية المحدودة القائمة على السحابة، فإن اعتمادها على البنية التحتية السحابية قد يشكل تحديات للشركات ذات متطلبات الإقامة الصارمة للبيانات. يجب على المؤسسات تقييم ما إذا كان إعدادها يتوافق مع احتياجات الامتثال الخاصة بها، خاصة إذا كانت الحلول المحلية تمثل أولوية.

يتضمن Prompts.ai مجموعة قوية من أدوات المراقبة والحوكمة مصممة خصيصًا للعمليات على مستوى المؤسسة. إنها تحليلات في الوقت الفعلي تقديم رؤى حول الأداء السريع ومقاييس التتبع مثل جودة الاستجابة ووقت الاستجابة ومشاركة المستخدم. تمكّن هذه الرؤى المستندة إلى البيانات الفرق من ضبط استراتيجياتها بناءً على نتائج الأداء.

يقدم إطار الحوكمة مسارات التدقيق للتعديلات السريعةوعناصر التحكم في الوصول لإدارة الأذونات وميزات التوافق التي تدعم معايير SOC 2 من النوع الثاني وHIPAA وGDPR. من خلال الرؤية الكاملة لتفاعلات الذكاء الاصطناعي، تضمن المنصة الشفافية والمساءلة - وهي ضرورية للمؤسسات التي توازن الابتكار مع المتطلبات التنظيمية. هذا المزيج من المراقبة والحوكمة يعزز كلا من الكفاءة التشغيلية والرقابة.

يوفر Prompts.ai وفورات ملحوظة عن طريق تقليل التكاليف المتعلقة بـ LLM. يعمل التكرار السريع الفعال والاختبار على تقليل عدد مكالمات API وعمليات تشغيل النماذج اللازمة لتحقيق النتائج. تتضمن المنصة لوحات معلومات الاستخدام تعرض التكاليف بالدولار الأمريكي، مقسمة حسب الفريق أو المشروع أو النموذج، مما يوفر رؤية واضحة للإنفاق.

ال نظام ائتمان TOKN للدفع أولاً بأول يلغي رسوم الاشتراك، ويربط التكاليف مباشرة بالاستخدام الفعلي. يمكن أن يساعد هذا النموذج المنظمات تقليل نفقات برامج الذكاء الاصطناعي بنسبة تصل إلى 98٪، لا سيما عند مقارنتها بإدارة اشتراكات وأدوات LLM المتعددة. بالإضافة إلى ذلك، تتعقب طبقة FinOps المتكاملة استخدام الرموز وتربط الإنفاق بالنتائج، مما يوفر لفرق التمويل الشفافية التي تتطلبها.

إن تركيز Prompts.ai المستهدف على سير العمل السريع يميزها عن غيرها، مما يجعلها مكملاً قويًا للمنصات الأخرى التي قد تعطي الأولوية لقدرات الذكاء الاصطناعي الأوسع نطاقًا.

MLFlow هو منصة مفتوحة المصدر مصممة لتبسيط دورة حياة التعلم الآلي. يوفر إطارًا شاملاً لإدارة النماذج وتتبعها، ويغطي كل شيء بدءًا من التجارب الأولية وحتى النشر في الإنتاج.

يدعم MLFlow المراحل الحرجة من دورة حياة الذكاء الاصطناعي عن طريق تسجيل المعلمات وإصدارات التعليمات البرمجية والمقاييس والتحف تلقائيًا أثناء التطوير.

إنها سجل النموذج وموحدة المشاريع قم بتبسيط المهام مثل الإصدار وانتقالات المرحلة وإمكانية تكرار التجربة. تضمن هذه الميزات الإشراف الواضح وعمليات النشر التي يمكن الاعتماد عليها.

يعمل MLFlow بسلاسة مع مجموعة واسعة من الأدوات والمنصات. يتكامل مع AWS إيج ميكر، منصات MLOPS مثل داغشوب، ويدعم بيئات برمجة متعددة، بما في ذلك واجهات برمجة تطبيقات Python و R و Java و REST. تسمح هذه المرونة للفرق باستخدام البنية التحتية الحالية أثناء نشر النماذج عبر بيئات متنوعة.

يتتبع MLFlow تلقائيًا معايير التدريب والمقاييس والتحف، مما يؤدي إلى إنشاء مسارات تدقيق مفصلة تساعد في جهود تصحيح الأخطاء والامتثال.

ال سجل النموذج يوفر التحكم المتقدم في الإصدار وأدوات إدارة المرحلة. يمكن للفرق إضافة تعليقات توضيحية للنماذج باستخدام الأوصاف والعلامات والبيانات الوصفية لتوثيق الغرض منها وأدائها. كما يتتبع السجل نسب النماذج، مما يجعل من السهل مراقبة وإدارة تطور الإصدارات المنشورة.

تعد قابلية الاستنساخ ميزة بارزة لـ MLFlow. مع المشاريع، فهي تجمع التعليمات البرمجية والتبعيات والتكوينات معًا، وتعالج المشكلة الشائعة المتمثلة في «أنها تعمل على جهازي» عند نقل النماذج من التطوير إلى الإنتاج.

Kubeflow عبارة عن مجموعة من الأدوات المصممة لبناء وإدارة خطوط أنابيب التعلم الآلي على Kubernetes. ومن خلال استخدام عمليات النشر في حاويات، فإنها تضمن قابلية التوسع والمرونة عبر بيئات الحوسبة المختلفة.

يتألق Kubeflow في التعامل مع مراحل التنسيق والنشر لدورة حياة نموذج الذكاء الاصطناعي. فهي تقوم بجدولة المهام بكفاءة، مما يضمن أن عمليات التعلم الآلي موثوقة وقابلة للتكرار ومبسطة. تم تصميمه على Kubernetes، وهو يوفر قابلية النقل وقابلية التوسع اللازمة لإدارة الأنظمة المعقدة. بالإضافة إلى ذلك، فإنه يتكامل بسلاسة مع الأدوات الحالية لتحسين وظائفه.

يدعم Kubeflow النشر عبر الإعدادات السحابية والمحلية والمختلطة، مما يجعله قابلاً للتكيف مع البيئات المتنوعة. من خلال خطوط أنابيب Kubeflow، تعمل مع أطر خدمة مختلفة، في حين أن أدوات مثل لوحة تينسور تمكين مراقبة أداء النموذج في الوقت الفعلي. يؤدي تضمين بيانات ML الوصفية (MLMD) إلى تحسين وظائفها من خلال تتبع النسب والتحف ذات الصلة.

يوفر Kubeflow مراقبة قوية لنماذج الإنتاج، مما يضمن الإشراف المستمر على الأداء. كما يتضمن أيضًا ميزات عزل متعددة المستخدمين، مما يسمح للمسؤولين بالتحكم في الوصول وضمان الامتثال. أدوات الحوكمة هذه مفيدة بشكل خاص لإدارة عمليات التعلم الآلي المعقدة واسعة النطاق، مما يساعد المؤسسات على الحفاظ على السيطرة والمساءلة مع نمو مشاريع الذكاء الاصطناعي الخاصة بها.

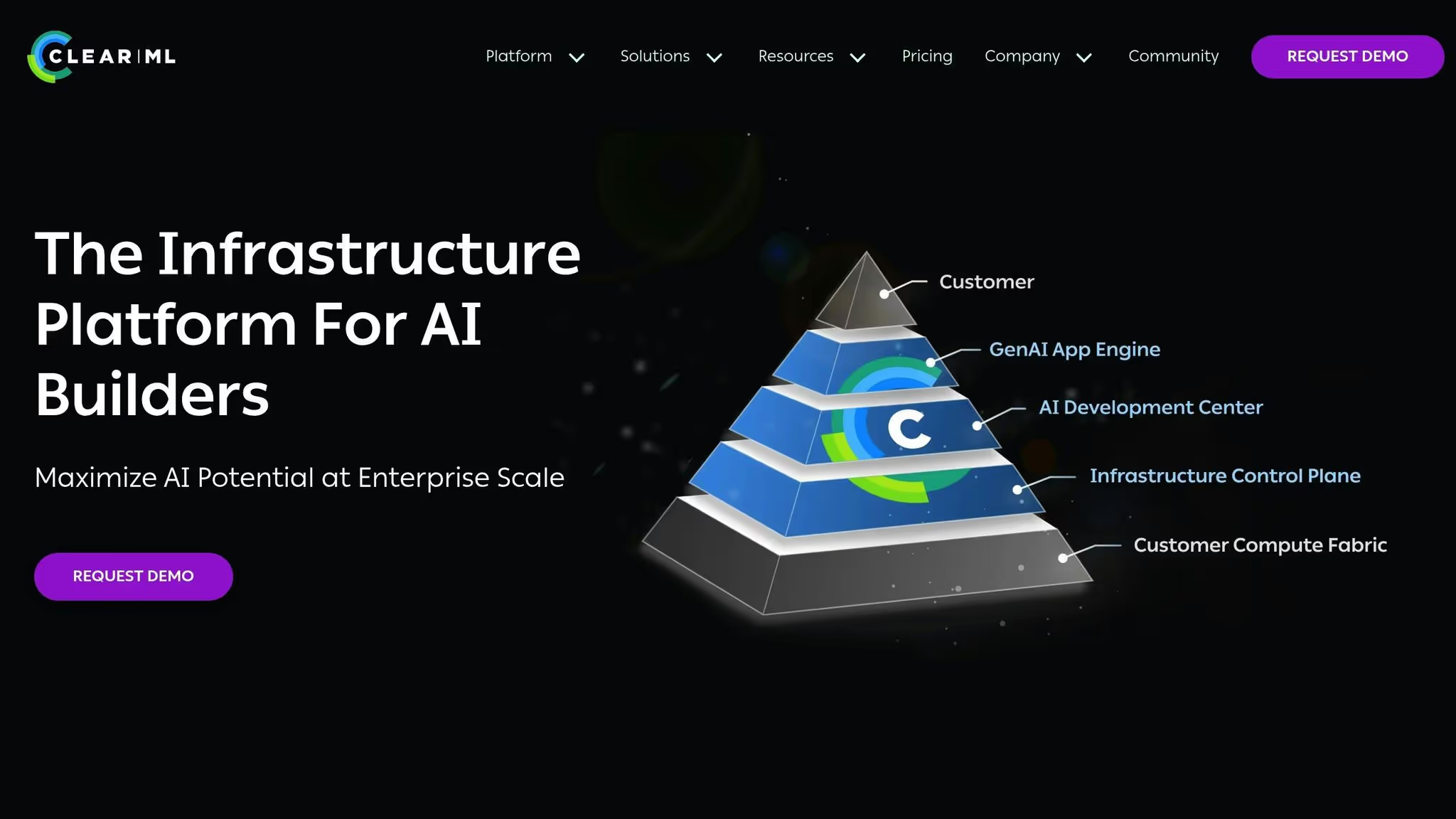

ClearML عبارة عن منصة مفتوحة المصدر مصممة لإدارة دورة حياة الذكاء الاصطناعي بأكملها. وتسمح طبيعته المفتوحة المصدر بالتخصيص ليناسب الاحتياجات التشغيلية المحددة، على الرغم من أن توافر الوثائق العامة المفصلة محدود إلى حد ما. إذا كنت تفكر في ClearML، فمن الضروري تقييم مدى توافقه مع أهداف مشروعك وبنيته التحتية. مثل المنصات الأخرى المذكورة، يمكن أن يكون إطار ClearML المرن مناسبًا تمامًا لتلبية المتطلبات الفريدة في سير عمل الذكاء الاصطناعي الخاص بك.

Google Cloud Vertex AI عبارة عن منصة تعلم آلي مُدارة بالكامل من Google، مصممة لدعم كل مرحلة من مراحل دورة حياة ML داخل نظام Google Cloud البيئي. فهو يجمع مجموعة متنوعة من أدوات وخدمات ML تحت واجهة واحدة، مما يجعله حلاً مثاليًا للمؤسسات التي تستفيد بالفعل من Google Cloud.

تم تصميم المنصة لتلبية احتياجات مجموعة واسعة من المستخدمين، من علماء البيانات الذين يكتبون تعليمات برمجية مخصصة إلى محللي الأعمال الذين يبحثون عن خيارات منخفضة التعليمات البرمجية. تسمح هذه المرونة للفرق بالعمل بطرق تناسب احتياجاتهم على أفضل وجه مع الحفاظ على التوحيد عبر عمليات سير عمل تعلم الآلة في المؤسسة.

يوفر Vertex AI دعمًا شاملاً لدورة حياة نموذج الذكاء الاصطناعي بالكامل، ويتكامل بسلاسة مع خدمات Google Cloud. بالنسبة للفرق التي تتطلب التحكم الكامل، فإنها تقدم تدريبًا مخصصًا على التعليمات البرمجية. في الوقت نفسه، تعمل ميزات AutoML ونقاط النهاية المُدارة على تبسيط التوسع وإدارة البنية التحتية لأولئك الذين يفضلون الأتمتة [6،7]. تتيح خطوط أنابيب MLops الخاصة بالمنصة الانتقال السلس من التطوير إلى الإنتاج، حتى بالنسبة للفرق التي ليس لديها خبرة واسعة في DevOps. بالإضافة إلى ذلك، يمكن توسيع نطاق موارد الحوسبة أو تقليلها بناءً على متطلبات المشروع، مما يضمن الاستخدام الفعال للموارد. تم دمج هذا الدعم الشامل بإحكام مع أدوات Google Cloud الأخرى، مما يؤدي إلى إنشاء سير عمل مبسط.

ما يميز Vertex AI هو تكاملها العميق مع خدمات Google Cloud Platform الأخرى. يعمل بدون عناء مع بيج كويري لتخزين البيانات و المتفرج من أجل ذكاء الأعمال، مما يوفر بيئة موحدة لمهام علوم البيانات.

يلغي هذا التكامل المحكم الحاجة إلى عمليات نقل البيانات المعقدة، حيث يمكن لعلماء البيانات الوصول مباشرة إلى البيانات التنظيمية داخل بيئة Vertex AI. تعمل واجهة برمجة التطبيقات الموحدة على تبسيط التفاعلات عبر خدمات Google Cloud، مما يساعد المستخدمين على التكيف بسرعة مع النظام الأساسي وتسريع عملية التطوير.

تتجاوز Vertex AI إدارة دورة الحياة من خلال تقديم ميزات مراقبة وحوكمة قوية. باستخدام Vertex ML Metadata، فإنه يتتبع المدخلات والمخرجات ومكونات خطوط الأنابيب الأخرى لضمان قابلية التدقيق الشاملة. هذا مهم بشكل خاص للمؤسسات في الصناعات المنظمة أو تلك التي تتطلب حوكمة نموذجية صارمة. تقوم المنصة تلقائيًا بتسجيل تفاصيل التجربة وإصدارات النماذج ومقاييس الأداء، مما يؤدي إلى إنشاء مسار تدقيق كامل لدعم جهود الامتثال.

كخدمة مُدارة، يمكن لـ Vertex AI تقليل التكاليف بشكل كبير عن طريق إزالة الحاجة إلى فرق البنية التحتية المخصصة. يمكّن نموذج التسعير بنظام الدفع حسب الاستخدام، جنبًا إلى جنب مع البنية التحتية العالمية لشركة Google، المؤسسات من توسيع نطاق عمليات التعلم الآلي بكفاءة وتخصيص الموارد حيث تشتد الحاجة إليها. بالنسبة للمؤسسات التي تستخدم Google Cloud بالفعل، تساعد Vertex AI أيضًا في تجنب تكاليف خروج البيانات، حيث تظل جميع البيانات داخل نظام Google Cloud البيئي طوال دورة حياة ML.

تجلب كل أدوات إدارة دورة حياة نموذج الذكاء الاصطناعي نقاط القوة والضعف الخاصة بها إلى الطاولة. من خلال فهم هذه المقايضات، يمكن للمؤسسات مواءمة خياراتها مع متطلباتها الفريدة والبنية التحتية الحالية وخبرة الفريق. فيما يلي تفصيل موجز للميزات والتحديات الرئيسية للمنصات الشعبية.

Prompts.ai تتميز بقدرتها على توحيد أكثر من 35 شركة LLM في إطار نظام TOKN للدفع أولاً بأول، مما قد يقلل التكاليف بنسبة تصل إلى 98٪. إنه يوفر حوكمة تركز على المؤسسة مع ضوابط FinOps في الوقت الفعلي، مما يضمن الشفافية والامتثال. ومع ذلك، فإن تخصصها في عمليات سير عمل LLM قد يحد من جاذبيتها لحالات استخدام ML الأوسع نطاقًا.

إم إل فلو، وهي منصة مفتوحة المصدر، توفر مكونات معيارية تتجنب حبس البائعين. تكمن نقاط قوتها في تتبع التجارب وسجل النموذج القوي. ومع ذلك، فإنه يتطلب إعدادًا وصيانة كبيرين، مما يتطلب فريقًا مخصصًا من DevOps للإدارة بفعالية.

كيوبيفلو تم تصميمه لتنظيم التدريب الموزع وخطوط أنابيب ML المعقدة باستخدام Kubernetes. إنها تتفوق في التعامل مع أعباء العمل الثقيلة على الكمبيوتر ولكن لديها منحنى تعليمي حاد، مما يجعل الأمر صعبًا للفرق التي ليس لديها خبرة قوية في Kubernetes.

ClearML يبسط إدارة التجربة من خلال التشغيل الآلي لتتبع تغييرات التعليمات البرمجية والتبعيات والبيئات. هذا يقلل من الجهد اليدوي ويعزز تعاون الفريق. ومع ذلك، فإن نظامها البيئي الأصغر قد يقيد نطاق عمليات تكامل الطرف الثالث المتاحة.

فيرتيكس إيه آي، الذي يتكامل بعمق مع Google Cloud، يوفر AutoML وتدريبًا مخصصًا في بيئة مُدارة بالكامل. يقلل اتصاله السلس بـ BigQuery والخدمات ذات الصلة من التعقيد التشغيلي. ومع ذلك، فإنه ينطوي على مخاطر تأمين البائع وتكاليف خروج البيانات المحتملة.

يوضح الجدول أدناه الميزات الأساسية لكل أداة:

يعتمد اختيار الأداة المناسبة على أولويات مؤسستك. إذا كانت كفاءة التكلفة وسير عمل LLM من أهم الاهتمامات، Prompts.ai هو منافس قوي. للفرق التي تبحث عن المرونة، إم إل فلو يقدم حلولًا محايدة للبائع. ستقدر المنظمات المدمجة بعمق مع Google Cloud فيرتيكس إيه آي، في حين يمكن لأولئك الذين لديهم خبرة Kubernetes الاستفادة كيوبيفلو لإمكانيات التنسيق المتقدمة.

يتوقف اختيار أداة دورة حياة الذكاء الاصطناعي المناسبة على حجم مؤسستك وبنيتها التحتية وميزانيتها وحالات الاستخدام الفريدة. فيما يلي كيفية توافق بعض المنصات الرائدة مع الاحتياجات المختلفة:

بالنظر إلى نقاط القوة هذه، تجد العديد من المؤسسات نهجًا مختلطًا أكثر فعالية من الاعتماد على منصة واحدة. على سبيل المثال، يمكن لـ Prompts.ai التعامل مع تنسيق LLM وتحسين التكلفة، بينما يتتبع MLFlow نماذج ML التقليدية، وتشرف الأدوات السحابية الأصلية على مراقبة الإنتاج. يضمن هذا المزيج تغطية شاملة لدورة حياة الذكاء الاصطناعي مع الاستفادة من مزايا كل أداة.

بالنسبة للفرق الصغيرة، تعد الأدوات ذات الإعداد السهل والتسعير الشفاف أمرًا أساسيًا. غالبًا ما تحتاج المؤسسات متوسطة الحجم إلى حلول قابلة للتطوير مع ميزات حوكمة قوية، بينما تعطي الشركات الكبيرة الأولوية لمسارات التدقيق التفصيلية والتكامل السلس لتكنولوجيا المعلومات.

مع استمرار تقدم أدوات الذكاء الاصطناعي، ركز على المنصات ذات التطوير النشط والدعم المجتمعي القوي والخطط الواضحة للمستقبل. تظل عمليات سير العمل القابلة للتشغيل البيني ضرورية للتكيف مع هذا المشهد المتغير باستمرار وتحقيق نشر فعال للذكاء الاصطناعي.

عند اختيار أداة لإدارة دورة حياة نماذج الذكاء الاصطناعي، من المهم التركيز على الميزات التي تتوافق مع الاحتياجات المحددة لمؤسستك. ابدأ بتحديد الأدوات التي توفر قدرات خدمة قوية مصممة لحالة الاستخدام الخاصة بك، إلى جانب خيارات نشر مرنة يمكن أن تتكيف مع الإعداد التشغيلي الخاص بك. يعد التكامل السلس مع البنية الأساسية الحالية للتعلم الآلي عاملاً مهمًا آخر يجب مراعاته.

من الحكمة أيضًا اختيار الأدوات المجهزة بـ ميزات المراقبة والمراقبة للمساعدة في الحفاظ على أداء النموذج وموثوقيته بمرور الوقت. ابحث عن حلول يسهل على فريقك استخدامها مع تقديم عروض قوية تدابير الأمن والحوكمة لضمان الامتثال وحماية البيانات الحساسة. يمكن أن يؤدي الاختيار الصحيح إلى تبسيط سير العمل وتحسين الكفاءة وتحقيق نتائج أفضل في إدارة نماذج الذكاء الاصطناعي الخاصة بك.

تلتزم Prompts.ai بأطر الامتثال من الدرجة الأولى مثل SOC 2 من النوع الثاني، هيبا، و GDPR، مما يضمن حماية البيانات القوية وتدابير الحوكمة. تدمج المنصة المراقبة المستمرة عبر فانتا للحفاظ على معايير الأمان الصارمة.

في 19 يونيو 2025، بدأت Prompts.ai عملها عملية تدقيق SOC 2 من النوع الثاني، مع التأكيد على تفانيها في الحفاظ على أعلى مستويات أمن البيانات والامتثال لعملاء المؤسسات.

تم تصميم أدوات إدارة دورة حياة الذكاء الاصطناعي للعمل دون عناء مع أنظمة تكنولوجيا المعلومات الحالية. لقد تم تصميمها للاتصال بالمنصات وقواعد البيانات والخدمات السحابية المستخدمة على نطاق واسع، مما يضمن ملاءمتها تمامًا لإعدادك الحالي.

تتكامل هذه الأدوات من خلال الارتباط بخطوط أنابيب البيانات وحلول التخزين وبيئات النشر. يأتي العديد منها أيضًا مع واجهات برمجة التطبيقات وعمليات سير العمل المرنة، مما يسمح بالتفاعل السلس بين المكونات. وهذا يضمن الإشراف الفعال والمراقبة عبر جميع مبادرات الذكاء الاصطناعي الخاصة بك.