La inteligencia artificial está remodelando las industrias, pero la gestión de sus riesgos requiere una gobernanza sólida. Las empresas que implementan la IA se enfrentan a desafíos como el cumplimiento, la supervisión de los sesgos y la supervisión operativa. Este artículo evalúa cinco plataformas líderes de gobierno de la IA: Credo IA, IBM WatsonX.Gobernanza, Aprendizaje automático de Microsoft Azure, Robot de datos, y Prompts.ai - para ayudarlo a encontrar la que mejor se adapte a sus necesidades. Esto es lo que ofrece cada uno:

Cada plataforma aborda el cumplimiento, la detección de sesgos, la integración y la escalabilidad, pero difieren en el enfoque y los puntos fuertes. Ya sea que esté gestionando un único ecosistema o haciendo malabares con varios modelos de IA, la elección correcta depende de sus necesidades operativas, los requisitos normativos y las prioridades presupuestarias.

Credo AI es una plataforma diseñada para simplificar la gobernanza, el cumplimiento y la supervisión de los sistemas de IA. Al traducir los complejos requisitos normativos en flujos de trabajo procesables, ayuda a las organizaciones a implementar la IA de manera responsable y eficaz. Las características clave incluyen la alineación del cumplimiento, la supervisión de los sesgos, la flexibilidad de la integración y la escalabilidad.

Superar los desafíos regulatorios puede resultar abrumador, pero Credo AI lo hace manejable con su motor de cumplimiento. Esta herramienta asigna los sistemas de inteligencia artificial a los principales marcos regulatorios, como el Ley de IA de la UE, Marco de gestión de riesgos de IA del NIST, y estándares específicos de la industria en sectores como la salud y las finanzas. En lugar de confiar en la interpretación manual de las normativas, los equipos pueden utilizar plantillas de evaluación prediseñadas y adaptadas a estos marcos. Esto garantiza que las organizaciones documenten sus prácticas de IA en el formato que esperan los auditores y los reguladores, lo que ahorra tiempo y esfuerzo durante las revisiones de cumplimiento.

Para las empresas que operan en varias jurisdicciones, Credo AI ofrece una biblioteca reguladora automatizada que se mantiene actualizada. Señala los modelos afectados por las nuevas reglas y guía a los equipos a través del proceso de documentación necesario. Esto es particularmente crucial para las industrias en las que el incumplimiento puede conllevar importantes sanciones financieras.

Credo AI va más allá de las verificaciones de sesgo a nivel superficial al evaluar los modelos comparándolos con métricas de equidad como la igualdad de oportunidades, la paridad predictiva y el impacto dispar. Los usuarios pueden establecer umbrales de sesgo específicos, y la plataforma proporciona alertas cuando los modelos superan estos límites.

Lo que diferencia a Credo AI es su enfoque de monitoreo continuo. A medida que los modelos interactúan con los nuevos datos en producción, la plataforma rastrea el rendimiento en todos los grupos demográficos y casos de uso. Esto ayuda a identificar los sesgos que pueden surgir con el tiempo debido a factores como la desviación de los datos o los cambios en las poblaciones de usuarios. Los informes detallados destacan exactamente dónde se producen los problemas de equidad, lo que facilita rastrear los problemas hasta su origen, ya sean los datos de entrenamiento, la selección de funciones o el diseño del modelo.

Credo AI se integra a la perfección con las ya existentes Cadenas de herramientas MLOps, lo que elimina la necesidad de que las organizaciones rediseñen su infraestructura. Se conecta con los registros de modelos, las canalizaciones de datos y las plataformas de implementación más populares mediante API y conectores prediseñados. Esto permite a los científicos de datos seguir trabajando con sus herramientas preferidas mientras los procesos de gobierno se ejecutan en segundo plano.

La plataforma extrae información clave, como los metadatos del modelo, el linaje de los datos de entrenamiento y las métricas de rendimiento, directamente en sus flujos de trabajo. Al evitar la duplicación de la documentación y las transferencias manuales de datos, Credo AI minimiza la fricción y garantiza que se sigan las prácticas de gobernanza sin que se considere una carga burocrática.

A medida que crecen las carteras de IA, Credo AI ayuda a mantener el orden al organizar los modelos en capas de gobierno estructuradas en función de factores como la unidad de negocio, el nivel de riesgo o los requisitos reglamentarios. Esto evita que la supervisión se vuelva inmanejable.

Con los controles de acceso basados en roles, los oficiales de cumplimiento pueden centrarse en las auditorías y los mapeos regulatorios, mientras que los científicos de datos se concentran en el rendimiento técnico. Esta división de responsabilidades garantiza que la gobernanza pueda ampliarse de manera eficiente en equipos grandes y distribuidos sin causar cuellos de botella ni demoras.

IBM WatsonX.Governance aplica las políticas de gobierno de la IA sin problemas en los sistemas de IBM y de terceros en configuraciones multinube. Es compatible con los modelos propios de IBM y con los alojados en AWS o plataformas Microsoft, lo que garantiza una integración fluida. El sistema automatiza los flujos de trabajo de cumplimiento y mantiene la transparencia durante todo el ciclo de vida de la IA. Gracias a sus capacidades generativas de inteligencia artificial, simplifica las evaluaciones de riesgos y los resúmenes de auditoría, y ofrece una base sólida para gestionar el cumplimiento, la integración y la escalabilidad.

IBM WatsonX.Governance proporciona acceso directo a marcos de cumplimiento globales, como el Ley de IA de la UE, Marco de gestión de riesgos de IA del NIST (AI RMF), y ISO 42001. Su biblioteca normativa integrada elimina la necesidad de interpretar manualmente documentos normativos complejos. Al aprovechar el aprendizaje automático, la plataforma ofrece recomendaciones inteligentes, alineando las tendencias emergentes con los requisitos reglamentarios específicos y sugiriendo medidas prácticas. Este enfoque acelera los esfuerzos de cumplimiento y reduce las cargas de trabajo manuales.

Al comprender la necesidad de flexibilidad en los entornos de varios proveedores, WatsonX.Governance garantiza la aplicación coherente de las políticas en todas las plataformas, incluidas IBM, AWS y Microsoft Azure. Aplica automáticamente las políticas de gobernanza, lo que permite a los científicos de datos seguir utilizando sus herramientas preferidas sin interrupciones. Al separar la gobernanza del desarrollo, la plataforma garantiza que los procesos de cumplimiento no obstaculicen la innovación o la creatividad.

Para satisfacer las crecientes demandas de las organizaciones que implementan numerosos modelos de IA, IBM WatsonX.Governance amplía sus capacidades de supervisión y seguridad para incluir agentes de IA generativa. Esto garantiza una supervisión integral de los modelos autónomos y tradicionales. Con flujos de trabajo automatizados y recomendaciones inteligentes, la plataforma ayuda a los equipos a gestionar operaciones complejas al tiempo que proporciona la transparencia y la documentación requeridas por los reguladores.

Microsoft Azure Machine Learning proporciona una base sólida para administrar todo el ciclo de vida de la IA, ya que combina una infraestructura potente con herramientas de gobierno integradas. Su panel de control de inteligencia artificial responsable actúa como un centro central donde los equipos pueden evaluar el comportamiento de los modelos, detectar posibles problemas y documentar las iniciativas de cumplimiento. Esta configuración garantiza que las organizaciones mantengan el control sobre sus sistemas de inteligencia artificial y, al mismo tiempo, amplíen las operaciones en diversos equipos y entornos. A continuación, se muestra con más detalle cómo Azure apoya el cumplimiento, la supervisión de sesgos, la administración de costos, la integración y la escalabilidad dentro de su marco de gobierno.

Azure Machine Learning simplifica el cumplimiento normativo al ofrecer plantillas que se alinean con marcos como GDPR, HIPAA, y las nuevas regulaciones centradas en la IA. La plataforma crea automáticamente registros de auditoría detallados y captura elementos clave, como las iteraciones de los modelos, los datos de entrenamiento y las decisiones de implementación, lo que ayuda a los equipos a cumplir con facilidad los requisitos de documentación.

UN modelo de registro rastrea el linaje de datos, muestra cómo fluyen a través de las canalizaciones y anota cualquier transformación que se haya aplicado a lo largo del camino. Esta transparencia permite a las organizaciones responder con rapidez a las consultas normativas, lo que proporciona una visión clara del proceso de desarrollo. Además, los informes de cumplimiento se pueden exportar en formatos estandarizados, lo que reduce considerablemente el tiempo necesario para prepararse para las auditorías.

El panel de control de IA responsable incluye herramientas para evaluar la equidad en los diferentes grupos demográficos. Estas herramientas miden las disparidades en los resultados e identifican los escenarios en los que las predicciones pueden perjudicar injustamente a ciertas poblaciones. La plataforma admite una variedad de métricas de equidad, lo que permite realizar evaluaciones en profundidad adaptadas a necesidades específicas.

De Azure Análisis de errores La herramienta profundiza en el rendimiento del modelo y lo desglosa por subgrupos para descubrir patrones que las métricas más amplias podrían pasar por alto. Este nivel de detalle ayuda a los equipos a identificar dónde los modelos pueden tener un rendimiento inferior y qué grupos se ven afectados. Los gráficos interactivos facilitan el intercambio de estos hallazgos con las partes interesadas que no tienen conocimientos técnicos, lo que garantiza la transparencia en todos los ámbitos.

Para mantener la equidad, las organizaciones pueden establecer umbrales que activan alertas cuando los modelos superan los niveles de sesgo aceptables. Estas comprobaciones automatizadas supervisan continuamente el comportamiento de los modelos y se adaptan a medida que las distribuciones de datos cambian con el tiempo. Las notificaciones se envían cuando es necesaria una intervención, lo que evita que las predicciones sesgadas lleguen a los entornos de producción.

Azure Machine Learning ofrece un seguimiento completo de los costos, lo que brinda a los equipos una visión clara de los gastos en experimentos, modelos y espacios de trabajo. Este panel unificado destaca los patrones del uso de la computación, el almacenamiento y las llamadas a las API, lo que ayuda a las organizaciones a asignar los presupuestos de manera inteligente. Las alertas presupuestarias notifican a los administradores cuando los gastos se acercan a los límites predefinidos, lo que evita excesos inesperados.

La plataforma también admite el escalado automatizado de los recursos, ajustando la capacidad en función de las demandas de la carga de trabajo. Para aumentar la rentabilidad, los trabajos de formación pueden utilizar instancias puntuales, que son considerablemente más baratas que las opciones informáticas dedicadas. Si la capacidad puntual deja de estar disponible, el sistema cambia automáticamente a instancias estándar, lo que garantiza la confiabilidad. Estas medidas de ahorro de costos se integran perfectamente en los flujos de trabajo, equilibrando la eficiencia con las necesidades operativas.

Azure Machine Learning integra la gobernanza en los flujos de trabajo diarios y admite marcos populares como TensorFlow, PyTorch, scikit-learn y XGBoost. También proporciona SDK para las interfaces Python, R y CLI. La plataforma funciona a la perfección con Azure DevOps, Acciones de GitHub, y API REST, lo que permite canalizaciones de CI/CD automatizadas que incluyen revisiones de gobierno antes de implementar los modelos.

Esta flexibilidad se extiende a las arquitecturas híbridas, lo que permite que algunos componentes se ejecuten en Azure mientras que otros funcionan en las instalaciones o en otros entornos de nube. Independientemente de dónde se implementen los modelos, se mantienen políticas de gobierno consistentes, lo que garantiza operaciones fluidas y seguras.

Azure Machine Learning está diseñado para gestionar todo, desde pequeños experimentos hasta implementaciones a gran escala con miles de modelos. Esta escalabilidad garantiza que incluso las carteras de IA más amplias permanezcan bajo una estricta gobernanza, lo que aborda problemas como el control de versiones de los modelos y la gestión de riesgos.

La plataforma capacidades de formación distribuidas divida los trabajos de gran tamaño en varios nodos, lo que acelera el proceso de formación para modelos complejos. Los recursos se asignan de forma dinámica en función de los requisitos del trabajo, lo que garantiza la eficiencia.

Para el despliegue, puntos finales gestionados escale automáticamente para gestionar los picos de tráfico y las inferencias de lotes grandes, lo que elimina la necesidad de gestionar la infraestructura de forma manual. Canalizaciones de inferencia por lotes puede procesar millones de predicciones y, al mismo tiempo, mantener registros de auditoría, ajustando dinámicamente los recursos informáticos para equilibrar la velocidad y el costo a medida que evolucionan las cargas de trabajo.

DataRobot proporciona una plataforma sólida para gestionar la gobernanza de la IA a nivel empresarial. Simplifica el cumplimiento, monitorea el rendimiento del modelo y documenta todo el ciclo de vida de la IA. Al abordar los principales desafíos de gobernanza, garantiza la transparencia en la forma en que funcionan los modelos en la producción y, al mismo tiempo, cumple con los estándares normativos y éticos. Diseñada tanto para expertos técnicos como para profesionales empresariales, la plataforma minimiza los desafíos que suelen estar relacionados con el mantenimiento de prácticas de IA responsables. A continuación se muestra más de cerca cómo DataRobot gestiona el cumplimiento, la parcialidad, la integración y la escalabilidad en la gobernanza de la IA.

DataRobot mantiene registros de auditoría detallados que documentan cada paso del proceso de desarrollo del modelo. Desde las fuentes de datos de entrenamiento hasta la configuración de implementación, cada decisión se registra automáticamente, lo que hace que las revisiones reglamentarias sean más rápidas y eficientes.

La plataforma ofrece plantillas de cumplimiento prediseñadas adaptado a industrias y normativas específicas. Por ejemplo, los equipos de servicios financieros pueden usar plantillas alineadas con SR 11-7 pautas de la Reserva Federal, mientras que las organizaciones de salud se benefician de los marcos diseñados para HIPAA cumplimiento. Estas plantillas simplifican el proceso de convertir los requisitos reglamentarios en tareas técnicas procesables.

Con sus modelos de tarjetas, DataRobot proporciona un recurso centralizado para los equipos legales, técnicos y de cumplimiento. Estas tarjetas consolidan toda la información relacionada con la gobernanza, lo que garantiza que las partes interesadas puedan generar informes completos para los auditores sin tener que extraer manualmente los datos de varios sistemas.

La plataforma también impone el cumplimiento mediante reglas automatizadas. Las organizaciones pueden establecer criterios como los niveles mínimos de precisión, el sesgo máximo permitido o la documentación requerida. Los modelos que no cumplen con estos estándares se marcan automáticamente, lo que impide que los modelos no conformes entren en producción y garantiza una gobernanza uniforme en todos los proyectos.

DataRobot incluye herramientas de evaluación de equidad que evalúan los modelos para detectar posibles sesgos en los atributos protegidos. Durante la validación del modelo, la plataforma calcula automáticamente las métricas de equidad, como el impacto dispar, y compara los resultados entre grupos demográficos para identificar posibles problemas. Los equipos pueden personalizar estas métricas para que se ajusten a sus casos de uso y necesidades de cumplimiento específicos.

Características de la plataforma visualizaciones interactivas que facilitan el análisis del rendimiento del modelo en diferentes subgrupos. Los gráficos que muestran las distribuciones de predicción, las tasas de error y los límites de decisión ayudan a los equipos a identificar patrones que podrían indicar un sesgo. Estas herramientas son accesibles para las partes interesadas que no tienen conocimientos técnicos, lo que permite entablar debates significativos sobre la equidad en varios departamentos.

La supervisión continua garantiza que cualquier cambio en las métricas de equidad se detecte a medida que evolucionan las distribuciones de datos. Las alertas se pueden configurar para que notifiquen a los equipos por correo electrónico, Slack o herramientas de gestión de incidentes, lo que garantiza una respuesta oportuna a los problemas emergentes.

Para abordar el sesgo detectado, DataRobot ofrece estrategias de mitigación integradas. Los equipos pueden probar técnicas como volver a ponderar los datos de entrenamiento, ajustar los umbrales de decisión o aplicar correcciones posteriores al procesamiento directamente desde la plataforma. Al comparar las ventajas y desventajas entre equidad y precisión, los equipos pueden elegir la solución más eficaz para sus necesidades específicas. Estas características destacan el compromiso de DataRobot de hacer que la gobernanza de la IA sea rigurosa y fácil de usar.

DataRobot está diseñado para integrarse a la perfección con una amplia gama de herramientas y sistemas. Funciona de forma nativa con Copo de nieve, Databricks, Amazon Redshift, Google BigQueryy otras bases de datos SQL, lo que permite a los equipos utilizar los datos directamente donde residen. Las opciones de implementación incluyen API REST para predicciones en tiempo real, puntuación por lotes para grandes conjuntos de datos y servidores de predicción integrados. La plataforma también se integra con herramientas de desarrollo como Jenkins, CI/CD de GitLab, y Azure DevOps, integrando las comprobaciones de gobernanza directamente en el flujo de trabajo de desarrollo.

Para los científicos de datos, DataRobot ofrece SDK para Python, R y Java, lo que les permite interactuar con la plataforma utilizando sus lenguajes de programación preferidos. Estos SDK conservan todas las capacidades de gobernanza, lo que garantiza una supervisión coherente de los modelos desarrollados mediante el código o la interfaz visual de la plataforma.

DataRobot está diseñado para gestionar carteras que van desde unos pocos modelos hasta miles, sin comprometer la gobernanza. Su arquitectura distribuye las cargas de trabajo de manera eficiente y se escala automáticamente para satisfacer las crecientes demandas. Esto permite a las organizaciones monitorear cientos de modelos de producción simultáneamente, y cada modelo recibe una supervisión continua.

La plataforma modelo de registro actúa como un eje central, organizando los modelos por proyecto, unidad de negocio o caso de uso. Esta estructura tiene un valor incalculable a medida que crecen las carteras, ya que permite a los equipos localizar rápidamente modelos específicos y comprender sus conexiones con otros componentes. El control de versiones está integrado, lo que facilita volver a las iteraciones anteriores si es necesario.

Las predicciones por lotes están optimizadas para escalar, distribuir las cargas de trabajo y almacenar en caché los datos para mantener los registros de auditoría y, al mismo tiempo, garantizar una finalización eficiente del trabajo. Las organizaciones que realizan trabajos diarios de puntuación a gran escala, como en las bases de datos de clientes, se benefician considerablemente de estas capacidades.

DataRobot también es compatible tenencia múltiple, lo que permite a diferentes equipos o unidades de negocio operar en espacios de trabajo aislados con sus propias políticas de gobierno. Esto garantiza que los modelos desarrollados para distintos propósitos o en diferentes entornos normativos permanezcan separados. Los administradores mantienen la visibilidad de toda la organización, mientras que los equipos individuales mantienen el control sobre sus proyectos específicos.

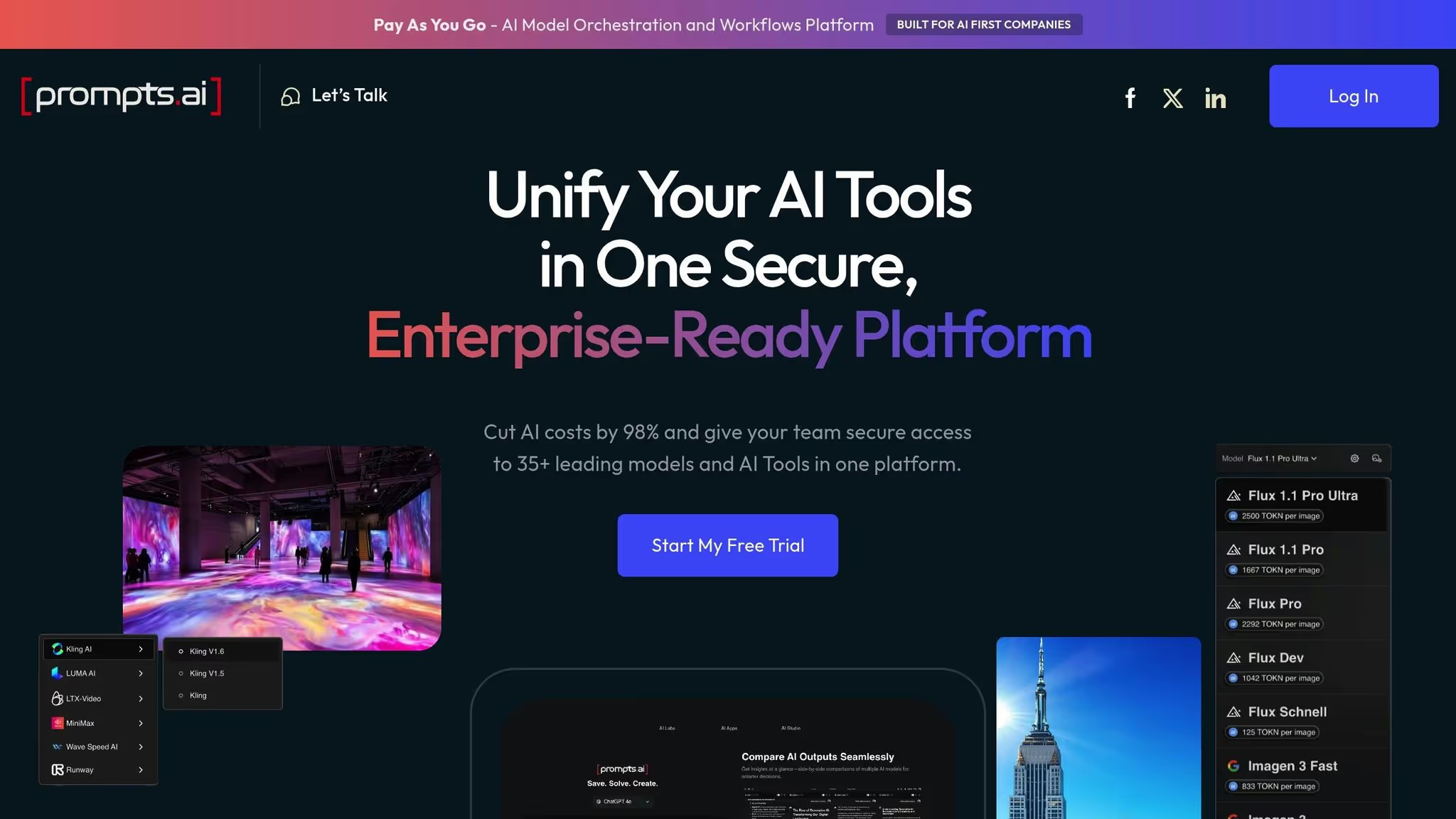

Prompts.ai ofrece un nuevo enfoque para gestionar los modelos de IA, centrándose en la capa de orquestación en la que las organizaciones interactúan con más de 35 modelos lingüísticos de gran tamaño líderes. En lugar de abordar las complejidades del ciclo de vida de un único modelo, la plataforma aborda los desafíos de gobernanza que surgen cuando se implementan varios modelos de IA en varios casos de uso. Al proporcionar un acceso unificado a modelos como GPT-5, Claude, LLama y Gemini, Prompts.ai cierra las brechas de gobernanza, rastrea las interacciones, gestiona los costos y garantiza que el cumplimiento sea coherente. Este enfoque elimina la necesidad de suscripciones, controles de acceso y registros de auditoría independientes para cada proveedor de modelos, lo que brinda a las organizaciones un punto de supervisión único y simplificado. Este sistema unificado sienta las bases para el debate sobre áreas críticas como el cumplimiento, la parcialidad, la administración de costos, la integración y la escalabilidad.

Prompts.ai integra el cumplimiento en su núcleo, siguiendo las mejores prácticas descritas en SOC 2 tipo II, HIPAA, y GDPR marcos. La plataforma inició su SOC 2 tipo 2 proceso de auditoría en 19 de junio de 2025, lo que demuestra la seguridad de nivel empresarial. A través del Trust Center en https://trust.prompts.ai/, las organizaciones pueden supervisar su estado de cumplimiento en tiempo real y acceder a información sobre las políticas de seguridad, los controles y el progreso.

Los registros de auditoría detallados capturan cada interacción de la IA y documentan los modelos utilizados, las solicitudes enviadas y los resultados generados. Este nivel de transparencia es particularmente valioso para sectores como los servicios financieros y la atención médica, donde demostrar el uso responsable de la IA suele ser un requisito reglamentario.

Ambos Planes personales y empresariales incluyen funciones de supervisión del cumplimiento, lo que garantiza la accesibilidad para organizaciones de todos los tamaños. El sistema funciona a la perfección con Vanta para un monitoreo continuo del control, manteniendo las medidas de seguridad efectivas a medida que la plataforma evoluciona. Esta supervisión automatizada reduce la necesidad de intervención manual, lo que ayuda a las empresas a mantener su postura de cumplimiento sin esfuerzo.

En el caso de las aplicaciones de IA orientadas al cliente, Prompts.ai minimiza los riesgos normativos al supervisar las solicitudes de información confidencial, como la información de identificación personal (PII), las credenciales y los datos de propiedad exclusiva. Este filtrado previo al envío actúa como medida de protección, ya que evita que los datos queden expuestos, lo que podría dar lugar a infracciones del RGPD o la HIPAA.

Prompts.ai rastrea activamente los datos de entrada y salida para detectar y abordar los sesgos en las respuestas de la IA. Al analizar cómo las diferentes indicaciones generan resultados variados en función del grupo demográfico, la plataforma ayuda a los equipos a identificar inconsistencias o tendencias discriminatorias en el comportamiento de la IA. Esta capacidad es especialmente importante para aplicaciones como el servicio de atención al cliente o la contratación, donde los resultados sesgados pueden generar riesgos legales o de reputación.

Los equipos pueden revisar los datos históricos para determinar si una redacción específica genera respuestas problemáticas. Por ejemplo, si una consulta de atención al cliente genera respuestas menos útiles en función de cómo está redactada, los equipos pueden ajustar las plantillas para garantizar una calidad de servicio uniforme. Este enfoque proactivo permite a las organizaciones abordar los prejuicios antes de que se conviertan en problemas mayores.

Los paneles de control en tiempo real proporcionan visibilidad de las métricas de sesgo, lo que permite a los oficiales de cumplimiento y a los equipos de ciencia de datos intervenir rápidamente. Las alertas notifican a los miembros designados del equipo cuando las respuestas muestran un tratamiento incoherente en función de las características protegidas, lo que garantiza la adopción de medidas oportunas para mitigar los sesgos en los entornos de producción.

La administración de los gastos es un desafío clave en las implementaciones de IA multimodelo, y Prompts.ai se destaca en el control de los costos entre proveedores con diferentes estructuras de precios. El Capa FinOps rastrea el uso de los tokens en más de 35 modelos, atribuyendo los costos a equipos y proyectos específicos para una presupuestación precisa.

La plataforma Sistema de crédito TOKN Pay-As-You-Go reemplaza las cuotas mensuales tradicionales, lo que reduce los costos hasta 98%. Este modelo basado en el uso garantiza que las organizaciones solo paguen por lo que usan, lo que hace que las implementaciones de IA sean más eficientes.

Prompts.ai identifica las ineficiencias, como las solicitudes demasiado largas que inflan los costos innecesariamente. Señala estos patrones y sugiere optimizaciones, como usar indicaciones más cortas o cambiar a modelos menos costosos para determinadas tareas. Estos pequeños ajustes pueden generar ahorros significativos, especialmente para las organizaciones con un elevado número de interacciones diarias con la IA.

Las alertas presupuestarias ayudan a prevenir gastos inesperados al notificar a los administradores cuando los gastos se acercan a los umbrales establecidos. Los equipos pueden establecer límites en varios niveles (organización, departamento o proyecto) para garantizar que las iniciativas experimentales no agoten los recursos destinados a las aplicaciones críticas.

Prompts.ai se integra a la perfección con los principales proveedores de nube, como LEYES, Google Cloud Platform, y Microsoft Azure, lo que permite a las organizaciones mantener su infraestructura actual y, al mismo tiempo, añadir una gobernanza centralizada de la IA. Su arquitectura basada en las API admite integraciones personalizadas con sistemas propietarios, lo que garantiza que los flujos de trabajo de gobierno se alineen con los procesos de TI establecidos.

Para los desarrolladores, SDK de Python proporcionan acceso programático a las funciones de gobierno, lo que permite comprobar el cumplimiento, el seguimiento de los costes y la supervisión de los sesgos directamente en su código. Esto garantiza que la supervisión de la gobernanza no impida que los equipos técnicos trabajen en aplicaciones de IA personalizadas.

La plataforma también se conecta con la empresa Sistemas SIEM (información de seguridad y gestión de eventos), centralizando la supervisión de la seguridad. Los equipos de seguridad pueden correlacionar los eventos de gobernanza de la IA con datos de seguridad más amplios, identificando rápidamente las posibles amenazas. Por ejemplo, los patrones de respuesta sospechosos se pueden marcar junto con otros indicadores de seguridad, lo que permite responder con mayor rapidez.

Prompts.ai admite varios proveedores de LLM, incluidos IA abierta y Antrópico, con un marco de gobierno único. Esto elimina la necesidad de crear políticas independientes para cada proveedor, lo que simplifica la gestión del cumplimiento y reduce las cargas administrativas.

Prompts.ai está diseñado para crecer junto con las crecientes iniciativas de IA, proporcionando una visibilidad y auditabilidad completas de cada interacción. Su arquitectura admite volúmenes cada vez mayores de usuarios y solicitudes sin comprometer el rendimiento, por lo que es adecuada tanto para empresas medianas como para grandes empresas.

Controles de acceso basados en funciones asegúrese de que los miembros del equipo interactúen con las funciones de gobierno relevantes para sus funciones. Los científicos de datos pueden acceder a las métricas y los datos de costes de sus proyectos, los responsables de cumplimiento pueden supervisar el cumplimiento en toda la organización y los usuarios empresariales pueden centrarse en los resultados sin tener que preocuparse por los detalles técnicos. Los administradores supervisan todo el sistema para garantizar un funcionamiento fluido.

El registro modelo centralizado organiza las políticas de gobierno por departamento, caso de uso o requisito reglamentario. Los equipos que operan bajo diferentes marcos de cumplimiento pueden trabajar en entornos aislados con sus propias reglas, mientras que los administradores conservan la capacidad de supervisar todas las actividades. Esta configuración evita los conflictos entre las políticas de las unidades de negocio.

A medida que los nuevos equipos adoptan modelos de IA, los administradores pueden proporcionar rápidamente el acceso y aplicar políticas de gobierno, lo que permite una incorporación rápida. Este proceso simplificado ayuda a las organizaciones que buscan expandir el uso de la IA y, al mismo tiempo, mantener un control centralizado sobre el cumplimiento, la seguridad y los costos. Al escalar horizontalmente, Prompts.ai garantiza que la gobernanza siga siendo efectiva, sin importar qué tan amplia sea la adopción de la IA por parte de la organización.

Cada una de las plataformas de gobierno de la IA aporta sus propias ventajas y limitaciones, y se adapta a las diferentes necesidades organizativas. La siguiente tabla resume un análisis en profundidad de cinco criterios de evaluación críticos.

Esta comparación destaca la importancia de equilibrar las fortalezas y las limitaciones en función de las necesidades organizacionales específicas. Plataformas como IBM WatsonX.Governance y Microsoft Azure Machine Learning ofrecen una integración perfecta dentro de sus ecosistemas, mientras que Credo AI y DataRobot se centran en las capacidades de gobierno especializadas.

Prompts.ai ofrece una solución distinta al unificar las operaciones en más de 35 modelos de lenguaje, lo que reduce la fragmentación que se suele observar en varios servicios. Su modelo de precios basado en el uso y su integración optimizada lo hacen especialmente valioso para las organizaciones que gestionan diversos flujos de trabajo de IA.

Al evaluar estas plataformas, tenga en cuenta su configuración operativa. Los equipos que ya están profundamente integrados con un único proveedor de nube pueden beneficiarse más de las herramientas nativas, mientras que los que gestionan varios modelos de IA podrían darse cuenta de que la plataforma unificada de Prompts.ai reduce la complejidad administrativa y mejora la flexibilidad. Al sopesar estos factores, las organizaciones pueden implementar estrategias de gobierno que se alineen con sus objetivos y demandas operativas.

La selección del servicio de gobierno del modelo de IA adecuado es crucial para satisfacer las necesidades únicas de su organización. Opciones como IBM WatsonX.Governance y Microsoft Azure Machine Learning ofrecen una integración perfecta en sus ecosistemas, mientras que plataformas como Credo AI y DataRobot se adaptan a los requisitos específicos de cumplimiento y documentación.

Las consideraciones presupuestarias desempeñan un papel importante en esta decisión. Los modelos de precios fijos son ideales para cargas de trabajo predecibles, mientras que los planes basados en el uso son más adecuados para las organizaciones con demandas fluctuantes o con operaciones que abarcan varios departamentos. Estos factores financieros resaltan la importancia de las soluciones unificadas, especialmente cuando se administran numerosos modelos en varios equipos.

Para las organizaciones que manejan diversos flujos de trabajo de IA, hacer malabares con múltiples marcos de gobierno puede generar una complejidad y una carga administrativa innecesarias. Prompts.ai simplifica esta tarea al proporcionar acceso a más de 35 modelos lingüísticos líderes dentro de un único sistema de gobierno. Su estructura crediticia TOKN de pago por uso garantiza que los costos se alineen directamente con el uso, al tiempo que mantiene la seguridad y el cumplimiento a nivel empresarial.

Las industrias con regulaciones estrictas requieren soluciones de gobierno que ofrezcan pistas de auditoría detalladas y garanticen un cumplimiento riguroso. Por el contrario, los sectores con un ritmo acelerado necesitan herramientas que permitan una iteración rápida de los modelos sin introducir demoras. En función de sus prioridades, es posible que necesite una supervisión exhaustiva de los sesgos en las aplicaciones orientadas al cliente o que ponga más énfasis en el control de versiones y la gestión de riesgos.

A medida que las necesidades de la industria y la tecnología siguen evolucionando, concéntrese en plataformas que aborden los desafíos actuales y, al mismo tiempo, dejen espacio para el crecimiento futuro. Ya sea que elija herramientas de ecosistema nativas, plataformas de gobierno especializadas o soluciones de orquestación unificadas, su decisión debe respaldar los requisitos de cumplimiento y la eficiencia operativa. Un marco de gobierno sólido no solo mitiga el riesgo, sino que también permite un despliegue seguro de la IA y allana el camino para un progreso sostenible.

Prompts.ai sigue estándares de primer nivel como SOC 2 tipo II, HIPAA y GDPR para proporcionar una protección de datos sólida y cumplir con los requisitos reglamentarios. Estos marcos están establecidos para proteger la información confidencial y, al mismo tiempo, promover la transparencia en las operaciones de inteligencia artificial.

Para fortalecer la confianza y la responsabilidad, Prompts.ai colabora con Vanta para monitoreo de control continuo y comenzó oficialmente su proceso de auditoría SOC 2 Tipo II el 19 de junio de 2025. Esta estrategia con visión de futuro garantiza que Prompts.ai se mantenga al día con las cambiantes necesidades de cumplimiento y, al mismo tiempo, ofrezca soluciones de inteligencia artificial responsables.

Prompts.ai permite a las organizaciones reducir drásticamente los gastos al fusionar más de 35 herramientas de inteligencia artificial en una plataforma única y eficiente, lo que reduce los costos tanto como 95%. Con su capa FinOps integrada, obtiene información en tiempo real sobre el uso, el gasto y el ROI, lo que garantiza que cada interacción esté rastreada y optimizada. Este nivel de transparencia facilita la gestión de los presupuestos y, al mismo tiempo, aprovecha al máximo los flujos de trabajo de IA.

Prompts.ai desempeña un papel activo en la identificación y reducción de los sesgos en los modelos de IA para promover la equidad y la toma de decisiones éticas. Mediante algoritmos avanzados y métodos de evaluación continua, la plataforma examina cuidadosamente los conjuntos de datos, las predicciones de los modelos y los flujos de trabajo de toma de decisiones para identificar posibles sesgos.

Para combatir estos desafíos, Prompts.ai emplea métodos como equilibrar conjuntos de datos, implementar herramientas de detección de sesgos y brindar transparencia a través de informes detallados. Estas medidas ayudan a garantizar que los modelos de IA cumplan con las directrices éticas y, al mismo tiempo, produzcan resultados precisos y justos en una amplia gama de usos.