La orquestación de la IA garantiza una colaboración fluida entre múltiples herramientas y flujos de trabajo de IA, lo que ahorra tiempo y reduce los costos. Esta guía cubre los 11 mejores marcos para gestionar los procesos de IA, desde herramientas de nivel empresarial hasta opciones de código abierto. Ya sea que esté racionalizando Flujos de trabajo de LLM, automatizando canalizaciones de datos, o administrar ciclos de vida de aprendizaje automático, hay una solución para cada necesidad. Los marcos clave incluyen:

Consejo rápido: Elija en función de la experiencia, la complejidad del flujo de trabajo y las necesidades de integración de su equipo. Para la orquestación del LLM, Prompts.ai sobresale. Para canalizaciones de datos, Flujo de aire Apache es fiable. Para el aprendizaje automático, Kubeflow o Flyte son opciones sólidas.

Profundice para encontrar el marco adecuado para su equipo y sus flujos de trabajo.

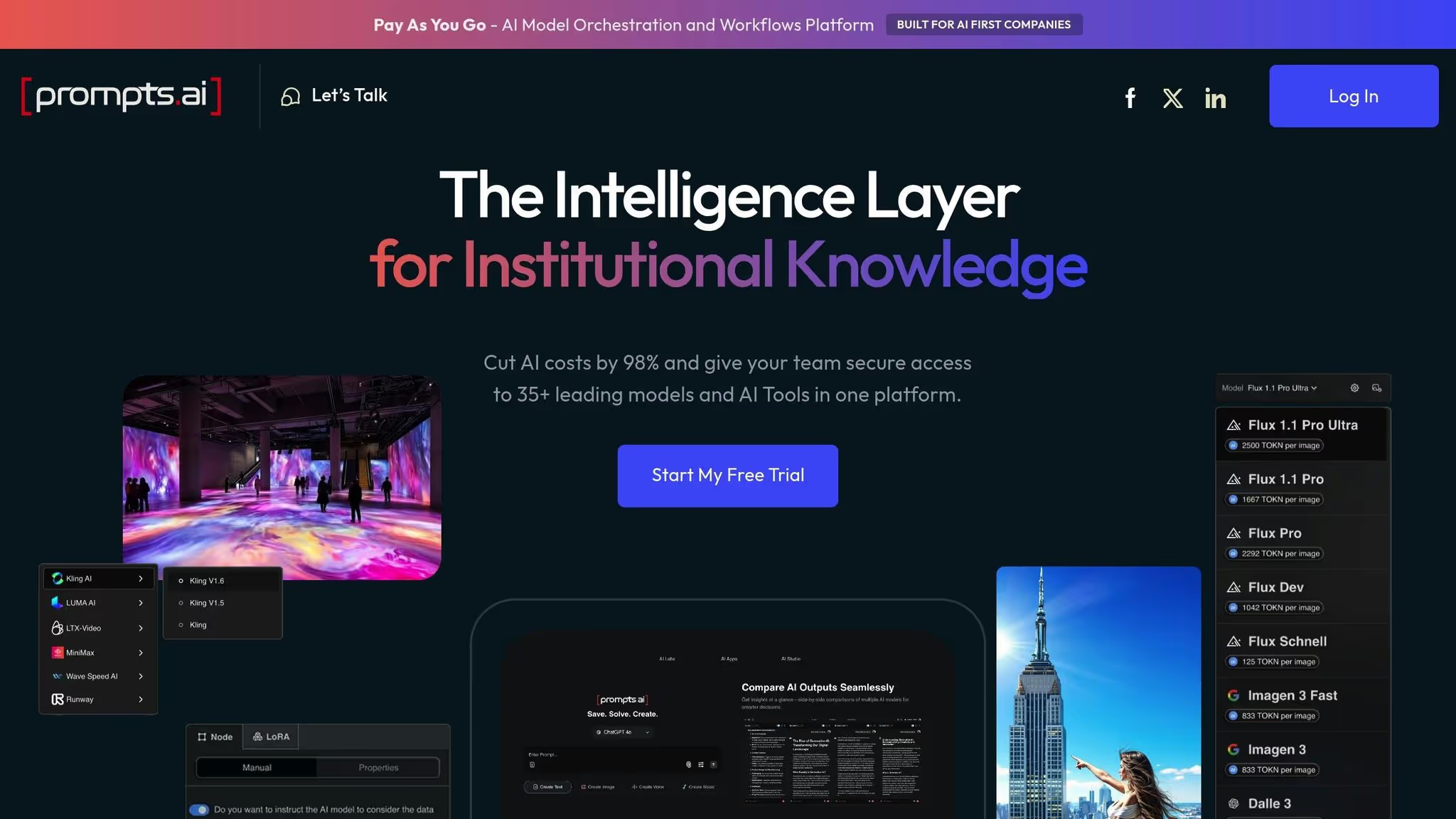

Prompts.ai funciona como una plataforma centralizada basada en la nube que conecta a los usuarios empresariales con más de 35 modelos de IA líderes, incluidos GPT-5, Claude, LLama, Gemini, Grok-4, Flux Pro y Kling, todos accesibles a través de una única interfaz. No es necesario instalar ningún software, lo que facilita a los equipos de cualquier tamaño la incorporación de la inteligencia artificial en sus flujos de trabajo.

La plataforma aborda un desafío importante en la adopción de la IA: expansión de herramientas. Al proporcionar un entorno unificado, consolida la selección de modelos, los flujos de trabajo rápidos y el seguimiento del rendimiento en un solo sistema. Este enfoque hace que el uso de la IA pase de ser experimentos puntuales y dispersos a procesos consistentes y escalables que las organizaciones pueden implementar fácilmente en todos los departamentos.

Prompts.ai se centra en la automatización flujos de trabajo de IA empresariales, ayudando a las organizaciones a reducir los costos innecesarios y, al mismo tiempo, a abordar los problemas de gobierno. Desde las empresas incluidas en la lista Fortune 500 hasta las agencias creativas y los laboratorios de investigación, los usuarios pueden crear flujos de trabajo auditables que cumplan con las normas sin correr el riesgo de exponer sus datos confidenciales a varios servicios de terceros.

La plataforma ha sido reconocida por Genai.works como la mejor solución de IA para la automatización y la resolución de problemas empresariales, con una impresionante valoración de los usuarios de 4,8 sobre 5. Las empresas confían en Prompts.ai para tareas como agilizar la creación de contenido, automatizar los flujos de trabajo estratégicos y acelerar el desarrollo de propuestas. En algunos casos, los proyectos que solían tardar semanas se han reducido a un solo día.

Un ejemplo notable es el de mayo de 2025, cuando el director independiente de IA Johannes Vorillon utilizó la plataforma para integrarse sin problemas Google DeepMind Veo2 animaciones en un vídeo promocional para Breitling y la Fuerza Aérea Francesa. Este proyecto puso de relieve cómo Prompts.ai permite una orquestación fluida de múltiples herramientas de inteligencia artificial.

Prompts.ai simplifica la forma en que los equipos trabajan con la IA al integrar el acceso a más de 35 modelos de idiomas e imágenes a través de un interfaz única. Esto elimina la molestia de administrar varias suscripciones, claves de API y sistemas de facturación. Los usuarios pueden combinar diferentes modelos para tareas específicas dentro de un único flujo de trabajo, creando canales de orquestación sin interrupciones.

La plataforma funciona en un Sistema de crédito TOKN, que estandariza el uso en todos los modelos, lo que facilita el seguimiento de los costos y la asignación de recursos. Los equipos pueden cambiar de modelo según sea necesario, en función de los requisitos de rendimiento. Los planes empresariales incluyen espacios de trabajo y colaboradores ilimitados, lo que facilita a las organizaciones ampliar la adopción de la IA.

Con un modelo de precios de pago por uso, Prompts.ai alinea los costos con el uso real, a partir de 0 USD al mes para la exploración inicial. Los planes empresariales, que oscilan entre 99 y 129 dólares por miembro al mes, ofrecen distintos niveles de créditos TOKN (de 250 000 a 1 000 000 000) y 10 GB de almacenamiento en la nube en todos los niveles.

Prompts.ai está diseñado para la seguridad y el cumplimiento a nivel empresarial, y cumple con los estándares SOC 2 tipo II, HIPAA y GDPR. La plataforma comenzó su auditoría del SOC 2 de tipo II el 19 de junio de 2025 y utiliza un monitoreo continuo a través de Vanta. Los usuarios pueden acceder a actualizaciones en tiempo real sobre el estado de seguridad y cumplimiento de la plataforma a través de un centro de confianza dedicado en trust.prompts.ai.

Los planes empresariales (Core, Pro y Elite) incluyen herramientas para supervisión del cumplimiento y administración de la gobernanza, que ofrece una visibilidad total de las interacciones de la IA y mantiene registros de auditoría detallados para cumplir con los requisitos reglamentarios. Incluso los equipos más pequeños y los profesionales individuales que utilizan los planes Personal Creator y Family se benefician de estas funciones de gobierno de nivel empresarial.

Los datos confidenciales se guardan dentro de un entorno centralizado y controlado, lo que reduce los riesgos asociados con la difusión de información en varios servicios de terceros. Esta arquitectura segura no solo minimiza las posibles vulnerabilidades, sino que también simplifica la gestión del cumplimiento para las organizaciones que operan bajo normas estrictas.

Diseñado con un arquitectura nativa de la nube, Prompts.ai permite a las organizaciones escalar sin esfuerzo. Los equipos pueden agregar nuevos miembros, ampliar los espacios de trabajo y acceder a modelos adicionales en cuestión de minutos, lo que garantiza que la adopción de la IA pueda crecer tan rápido como sea necesario.

La plataforma controles de costos en tiempo real vinculan el uso de los tokens directamente con los resultados empresariales, ofreciendo transparencia en el gasto y ayudando a las organizaciones a optimizar sus inversiones en IA. Los usuarios pueden comparar los resultados de los modelos en paralelo, lo que permite tomar decisiones informadas sobre qué modelos son los más adecuados para tareas específicas.

Prompts.ai también proporciona análisis de uso detallados, que ofrecen información sobre el rendimiento del equipo y el consumo de recursos. Estos análisis ayudan a las organizaciones a identificar las áreas de mejora y a justificar sus inversiones en inteligencia artificial con aumentos de productividad mensurables. Los usuarios han registrado un aumento de hasta 10 veces en la productividad al aprovechar las herramientas de automatización del flujo de trabajo de la plataforma, lo que demuestra su capacidad para generar resultados significativos.

Kubiya AI ofrece una solución de automatización del flujo de trabajo basada en interfaces conversacionales. Si bien los detalles específicos sobre su arquitectura de despliegue y sus métodos de organización no están a disposición del público, su énfasis en las interfaces conversacionales pone de manifiesto una perspectiva única a la hora de agilizar la automatización del flujo de trabajo.

IBM watsonx Orchestrate ofrece Automatización impulsada por IA a las operaciones empresariales, centrándose en hacer que la automatización sea accesible para los profesionales empresariales y no solo para los desarrolladores. Al permitir a los usuarios emitir comandos en lenguaje natural, la plataforma simplifica las tareas complejas para los equipos no técnicos de recursos humanos, finanzas, ventas, atención al cliente y compras. Este enfoque elimina la necesidad de tener experiencia en codificación, lo que permite a los equipos empresariales automatizar los procesos de forma independiente.

La plataforma destaca por la automatización de tareas repetitivas que a menudo consumen tiempo de los empleados. Con comandos de lenguaje sencillos, los usuarios pueden iniciar flujos de trabajo para tareas como programar entrevistas, resumir los perfiles de los candidatos, procesar préstamos y generar informes. watsonx Orchestrate gestiona estas actividades en varios sistemas de backend, al tiempo que cumple con los estándares de seguridad de nivel empresarial.

Por ejemplo, una importante institución financiera implementó watsonx Orchestrate para optimizar la atención al cliente y las funciones administrativas. Los empleados utilizaron datos de lenguaje natural para automatizar los flujos de trabajo relacionados con el procesamiento de préstamos y las solicitudes de servicio. La plataforma se integró a la perfección con los sistemas de respaldo, mantuvo el cumplimiento mediante una gobernanza integrada y proporcionó mejoras notables: tiempos de procesamiento más rápidos, menos errores manuales y una mayor satisfacción de los clientes. Este ejemplo destaca la capacidad de la plataforma para transformar las tareas empresariales rutinarias en procesos eficientes y automatizados.

IBM watsonx Orchestrate ofrece opciones de despliegue de nube híbrida, lo que permite que los flujos de trabajo se ejecuten en la nube, en las instalaciones o en ambas. Esta flexibilidad es particularmente valiosa para las organizaciones con políticas estrictas de residencia de datos o infraestructuras heredadas. La plataforma aprovecha los modelos lingüísticos extensos (LLM), las API y las aplicaciones empresariales para ejecutar las tareas de forma segura y garantizar la compatibilidad con varios entornos operativos.

watsonx Orchestrate se integra perfectamente con diversos sistemas, lo que lo convierte en una solución sólida para la automatización empresarial. Se conecta a plataformas de CRM, ERP y en la nube, como AWS y Azure, mediante conectores visuales y API. Además, trabaja en estrecha colaboración con los servicios de IBM Watson y otros modelos de IA de IBM, ampliando sus capacidades más allá de la automatización básica del flujo de trabajo. Para los usuarios avanzados, el acceso programático a la API permite una mayor personalización e integración con las herramientas existentes.

«IBM watsonx Orchestrate está diseñado para llevar la automatización basada en inteligencia artificial directamente a los flujos de trabajo empresariales. A diferencia de las herramientas centradas en los desarrolladores, watsonx Orchestrate se dirige a profesionales de RRHH, finanzas, ventas y atención al cliente que desean simplificar las tareas sin necesidad de programar demasiado». - Domo

La plataforma también incluye aplicaciones de IA prediseñadas y conjuntos de habilidades específicas de la industria, lo que permite una implementación más rápida para casos de uso comunes. Sin embargo, las organizaciones deben tener en cuenta que su funcionalidad puede ser más limitada fuera del ecosistema de IBM en comparación con las plataformas con opciones de integración más amplias.

IBM watsonx Orchestrate destaca por su sólido marco de gobierno, lo que lo convierte en la opción preferida para los sectores regulados. Los controles de acceso basados en roles garantizan que el acceso a los datos esté restringido a los usuarios autorizados y a funcionalidades específicas.

Las opciones de implementación híbrida de la plataforma abordan los problemas de privacidad al permitir a las organizaciones mantener los datos confidenciales en las instalaciones y, al mismo tiempo, utilizar los recursos de la nube para operaciones menos críticas. Sus funciones de cumplimiento la hacen especialmente adecuada para sectores como el financiero y el sanitario, donde la seguridad, la transparencia y el cumplimiento de las normativas son fundamentales.

Diseñado para escalar en entornos híbridos, watsonx Orchestrate es compatible tanto con equipos pequeños como con grandes empresas. Mejora la eficiencia operativa, garantiza el cumplimiento de las políticas, mitiga los riesgos y aumenta la productividad de los empleados. Las organizaciones pueden empezar con algo pequeño (centrándose en departamentos específicos) y ampliar gradualmente las capacidades de automatización a medida que obtienen resultados y adquieren experiencia interna.

Apache Airflow es una plataforma de código abierto creada para organizar flujos de trabajo de datos complejos mediante gráficos acíclicos dirigidos (DAG). Desarrollado inicialmente por Airbnb y ahora bajo el Fundación Apache Software, se ha convertido en una opción popular para programar, supervisar y gestionar las canalizaciones de datos. A diferencia de las herramientas de automatización diseñadas para usuarios empresariales, Airflow está diseñado pensando en los ingenieros y desarrolladores de datos, y ofrece un control programático sobre la ejecución del flujo de trabajo.

Airflow destaca en la gestión de canalizaciones de datos que implican dependencias complejas, tareas programadas y lógica de transformación. Los equipos de datos confían en él para diversos fines, como coordinar los procesos de ETL (extracción, transformación y carga), entrenar modelos de aprendizaje automático, ejecutar trabajos de procesamiento por lotes, incorporar datos de varias fuentes, transformar conjuntos de datos y generar informes según un cronograma. Al definir los flujos de trabajo en Python, los desarrolladores obtienen una amplia flexibilidad para implementar una lógica personalizada y gestionar los errores de forma eficaz.

La plataforma incluye una interfaz visual que proporciona información sobre el estado del flujo de trabajo, las dependencias de las tareas y el historial de ejecución. Esto facilita la supervisión del rendimiento y la resolución de errores. Por ejemplo, si una tarea falla, Airflow puede volver a intentarlo automáticamente, enviar alertas u omitir tareas posteriores para evitar problemas en cascada. Esta funcionalidad la convierte en una opción versátil para diferentes necesidades de implementación.

Airflow puede implementarse como una configuración de servidor único o escalarse a clústeres distribuidos, donde el programador, los trabajadores y el servidor web funcionan en máquinas independientes. La arquitectura se compone de varios componentes clave: un planificador que activa las tareas en función de los cronogramas definidos, los trabajadores que ejecutan las tareas, un servidor web para la interfaz de usuario y una base de datos de metadatos que almacena las definiciones de los flujos de trabajo y el historial de ejecución.

Este diseño modular permite a las organizaciones escalar la capacidad de los trabajadores de forma independiente, en función de las demandas de carga de trabajo. En los entornos nativos de la nube, con frecuencia se usa Kubernetes para implementar Airflow, y el KubernetesExecutor crea módulos aislados para tareas individuales. Esta configuración mejora el aislamiento de los recursos y permite a los equipos asignar recursos informáticos específicos para cada tarea. Para quienes buscan reducir los gastos generales de administración de la infraestructura, están disponibles los servicios gestionados de Airflow, aunque estos conllevan costos operativos adicionales.

Las amplias capacidades de integración de Airflow lo hacen altamente adaptable. Ofrece conectores prediseñados para bases de datos, plataformas en la nube, almacenes de datos y sistemas de mensajería, además de la capacidad de crear operadores personalizados con Python. Esta flexibilidad garantiza que Airflow pueda cumplir con diversos requisitos organizativos.

El rico ecosistema de bibliotecas de Python también se puede aprovechar en los flujos de trabajo, lo que permite realizar transformaciones y análisis de datos avanzados directamente en las definiciones de canalización. En el caso de las aplicaciones de inteligencia artificial y aprendizaje automático, Airflow se integra perfectamente con marcos como TensorFlow, PyTorch, y scikit-learn. Estas integraciones ayudan a los científicos de datos a organizar los flujos de trabajo para tareas como la obtención de datos, el preprocesamiento de funciones, el entrenamiento de modelos, la evaluación del rendimiento y la implementación de modelos en la producción.

Airflow incluye un control de acceso basado en roles (RBAC) para administrar los permisos de los usuarios en todos los flujos de trabajo y funciones administrativas. Los administradores pueden definir las funciones con privilegios específicos, garantizando que solo los usuarios autorizados puedan ver, editar o ejecutar determinados DAG. Este control granular ayuda a mantener la integridad del flujo de trabajo y evita los cambios no autorizados.

Las opciones de autenticación incluyen el inicio de sesión basado en contraseñas, la integración de LDAP y los proveedores de OAuth. Las credenciales confidenciales se administran por separado a través del sistema de conexiones y variables de Airflow. Para mejorar la seguridad, se utilizan herramientas externas de administración de secretos, como Bóveda de HashiCorp o Administrador de secretos de AWS se puede integrar.

El registro de auditoría es otra característica clave, que rastrea las acciones de los usuarios y las ejecuciones del flujo de trabajo. Esto crea un registro detallado de la actividad, que es inestimable para fines de cumplimiento y solución de problemas.

El flujo de aire se amplía horizontalmente al agregar más nodos de trabajo para gestionar el aumento de las cargas de trabajo. La plataforma admite varios tipos de ejecutores para distribuir las tareas de manera eficaz: el LocalExecutor ejecuta las tareas en la misma máquina que el programador, el CeleryExecutor distribuye las tareas entre varios equipos de trabajo mediante una cola de mensajes y el KubernetesExecutor crea módulos aislados para cada tarea.

Para optimizar el rendimiento, es esencial un diseño cuidadoso del DAG y la asignación de recursos. Los grandes volúmenes de tareas pueden sobrecargar al programador, por lo que los equipos suelen dividir los DAG grandes, ajustar la configuración del programador y asegurarse de que el almacén de metadatos cuente con recursos suficientes.

Airflow también gestiona los rellenamientos de manera eficiente, lo que permite a los equipos volver a procesar los datos históricos cuando cambia la lógica del flujo de trabajo. Si bien el relleno agiliza las actualizaciones, puede consumir importantes recursos computacionales, lo que requiere una planificación cuidadosa para evitar interrupciones en las cargas de trabajo de producción.

Al ser de código abierto, Airflow brinda a las organizaciones un control total sobre sus despliegues. Sin embargo, esto también significa que deben administrar la infraestructura, la supervisión y las actualizaciones, lo que requiere recursos de ingeniería dedicados para mantener la confiabilidad y el rendimiento a gran escala.

Kubeflow se destaca como una plataforma dedicada para administrar los flujos de trabajo de aprendizaje automático, a diferencia de las herramientas de flujo de trabajo de uso más general. Diseñada específicamente para Kubernetes, esta solución de código abierto es compatible con todo el ciclo de vida del aprendizaje automático y brinda a los científicos de datos y a los ingenieros de aprendizaje automático las herramientas que necesitan para crear, implementar y administrar modelos listos para la producción utilizando las capacidades nativas de Kubernetes.

Kubeflow está diseñado para organizar flujos de trabajo completos de aprendizaje automático en entornos de Kubernetes. Abarca todas las etapas del ciclo de vida del aprendizaje automático, incluido el preprocesamiento de datos, la ingeniería de funciones, el entrenamiento de modelos, la validación, la implementación y la supervisión. Al permitir a los equipos crear canalizaciones modulares y reutilizables, Kubeflow simplifica la administración de las cargas de trabajo de aprendizaje automático distribuidas. Su enfoque centralizado también ayuda al seguimiento de los experimentos y a la supervisión de los modelos en varios proyectos. Además, Kubeflow puede automatizar los flujos de trabajo de reentrenamiento cuando se introducen nuevos datos, lo que garantiza que los modelos se mantengan actualizados y relevantes.

Basado en Kubernetes, Kubeflow aprovecha la orquestación de contenedores, el escalado dinámico y la administración de recursos para optimizar los flujos de trabajo de aprendizaje automático. Los usuarios pueden interactuar con la plataforma a través de una interfaz basada en la web para la administración visual o una interfaz de línea de comandos para la automatización. En función de la carga de trabajo, Kubeflow asigna los recursos de forma dinámica, como el aprovisionamiento de GPU para las tareas de entrenamiento y de las CPU para la inferencia. Su flexibilidad permite la implementación en cualquier clúster de Kubernetes, ya sea local, en la nube o en configuraciones híbridas, lo que garantiza la adaptabilidad en todos los entornos.

Kubeflow se integra perfectamente con los marcos de aprendizaje automático populares, como TensorFlow, PyTorch y XGBoost, y también admite marcos personalizados a través de su diseño extensible. Además de los marcos de aprendizaje automático, se conecta con varios servicios en la nube y soluciones de almacenamiento, lo que permite a las canalizaciones acceder al almacenamiento de datos en objetos, a los almacenes de datos para recuperar funciones y a las herramientas de supervisión para realizar un seguimiento del rendimiento. Su compatibilidad con las bibliotecas de Python agiliza aún más la transición de la experimentación a la producción.

Kubeflow utiliza las capacidades de escalado inherentes de Kubernetes para distribuir las cargas de trabajo entre los recursos del clúster, lo que lo hace ideal para tareas de procesamiento de datos y entrenamiento a gran escala. Esto garantiza un uso eficiente de los recursos y admite operaciones de aprendizaje automático de alto rendimiento. Como Akka afirmó acertadamente:

«Kubeflow proporciona una sólida orquestación de los ciclos de vida completos del aprendizaje automático en los entornos de Kubernetes para garantizar la portabilidad, la escalabilidad y la administración eficiente de los modelos de aprendizaje automático distribuidos». — Akka

Gracias a su capacidad de asignar recursos de forma independiente, Kubeflow cierra la brecha entre la experimentación y la producción, ofreciendo flexibilidad y rendimiento.

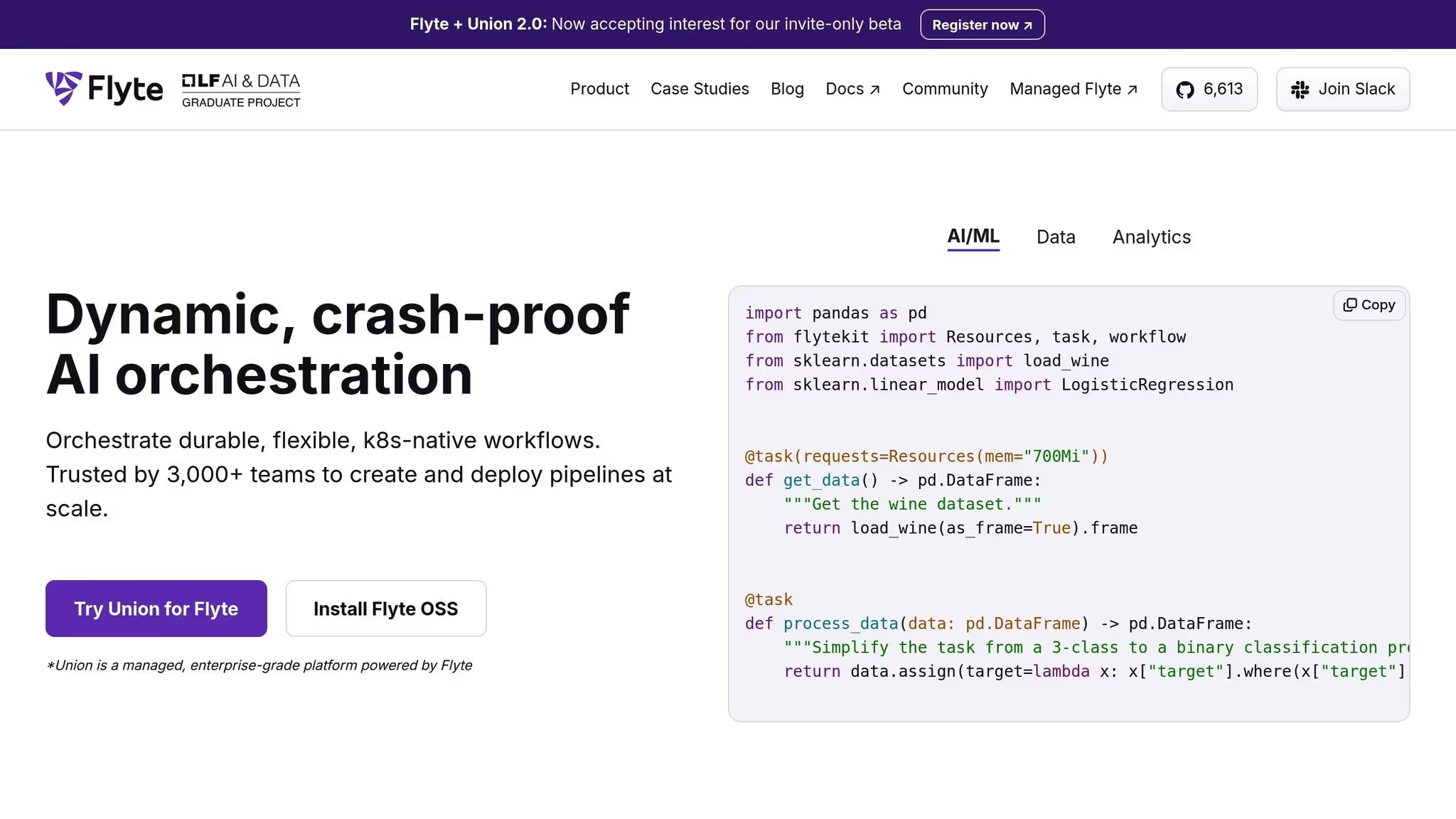

Flyte es una plataforma de orquestación nativa de la nube diseñada para optimizar la administración de los flujos de trabajo de aprendizaje automático (ML) en contenedores mediante Kubernetes. Elimina la complejidad de la implementación de canalizaciones de aprendizaje automático al distribuir los recursos de manera eficiente en los entornos de nube. Este enfoque garantiza una escalabilidad fluida y un rendimiento uniforme, independientemente del tamaño de la implementación.

Flyte está diseñado para gestionar flujos de trabajo de aprendizaje automático de cualquier escala, asignando recursos de forma dinámica para satisfacer las diferentes demandas. Su sólida arquitectura garantiza que las cargas de trabajo se gestionen de forma eficiente, lo que la convierte en una opción fiable para una amplia gama de tareas de aprendizaje automático en infraestructuras basadas en la nube.

Prefect es una plataforma de orquestación basada en Python diseñada para simplificar la administración de flujos de datos complejos y flujos de trabajo de aprendizaje automático. Se centra en la facilidad de uso, la supervisión clara y la minimización de los obstáculos operativos, lo que permite a los científicos e ingenieros de datos concentrarse en crear flujos de trabajo en lugar de preocuparse por la infraestructura.

Prefect destaca en la automatización de las canalizaciones de aprendizaje automático, los flujos de trabajo en la nube y los procesos de transformación de datos. Es especialmente adecuado para gestionar tareas de ETL y flujos de trabajo intrincados de aprendizaje automático que implican múltiples dependencias, ejecuciones paralelas y procesamiento en tiempo real. Su sistema de programación flexible permite que las tareas se activen en función de intervalos de tiempo, eventos específicos o llamadas a la API, lo que lo hace adaptable a una variedad de necesidades de automatización.

Prefect está optimizado para entornos de nube, lo que garantiza que pueda escalar y adaptarse a las demandas de infraestructura moderna. Creado de forma nativa en Python, se integra perfectamente con los ecosistemas de datos basados en Python, lo que elimina la necesidad de aprender nuevos lenguajes o herramientas de programación.

Prefect ofrece una compatibilidad perfecta con una amplia gama de herramientas y plataformas de datos. Se integra sin esfuerzo con herramientas populares como deuda, PostgreSQL, Copo de nieve, y Mirador, al mismo tiempo que admite sistemas en tiempo real como Apache Kafka. Para entornos de nube, funciona con los principales proveedores, como Amazon Web Services (COMO), Google Cloud Platform (GCP) y Microsoft Azure, lo que brinda a los equipos la flexibilidad necesaria para optimizar las cargas de trabajo en función del costo y el rendimiento. Además, Prefect admite herramientas de contenedorización como Estibador y Kubernetes y funciona con marcos de procesamiento distribuidos como Dask y Apache Spark. Para mantener informados a los equipos, también proporciona notificaciones de Slack sobre las actualizaciones del flujo de trabajo.

Prefect está diseñado para gestionar con facilidad los crecientes volúmenes de datos y la creciente complejidad del flujo de trabajo. Su motor tolerante a fallos garantiza que los flujos de trabajo puedan recuperarse de los errores reintentando las tareas fallidas o evitando los problemas, lo que lo hace altamente fiable en los entornos de producción. La supervisión en tiempo real ofrece información detallada sobre la ejecución del flujo de trabajo, lo que ayuda a los equipos a identificar y resolver los problemas rápidamente. Gracias a su capacidad para escalar de manera eficiente, las principales empresas de tecnología confían en Prefect para gestionar flujos de trabajo dinámicos. Para los equipos que recién comienzan, Prefect ofrece un plan gratuito, mientras que hay precios personalizados disponibles para despliegues más grandes que requieren funciones y soporte adicionales.

Metaflow es una plataforma de infraestructura de aprendizaje automático desarrollada inicialmente por Netflix para abordar los desafíos de escalar los flujos de trabajo de aprendizaje automático. Se centra en hacer que los procesos sean fáciles de usar y eficientes, ayudando a los científicos de datos a pasar sin problemas de los prototipos a la producción sin tener que trabajar con una infraestructura compleja.

Metaflow está diseñado para gestionar flujos de trabajo de aprendizaje automático escalables a nivel de producción. Simplifica el proceso desde el análisis exploratorio de datos y el entrenamiento de modelos hasta la implementación. Los científicos de datos pueden escribir flujos de trabajo en Python utilizando bibliotecas conocidas, mientras que la plataforma se encarga del control de versiones, la gestión de las dependencias y la asignación automática de los recursos informáticos.

La plataforma elimina la necesidad de una administración manual de la infraestructura al aprovisionar automáticamente los recursos informáticos necesarios. Esto permite pasar sin problemas del desarrollo local a la producción en la nube sin necesidad de modificar el código.

«Metaflow organiza los flujos de trabajo de aprendizaje automático escalables con sencillez al ofrecer integraciones optimizadas en la nube, un control de versiones sólido y una abstracción de la infraestructura para una implementación lista para la producción». - Akka.io

El proceso de implementación de Metaflow se complementa con su capacidad de integrarse fácilmente con los servicios en la nube y las plataformas de datos. Su diseño nativo de Python garantiza la compatibilidad con las bibliotecas más utilizadas para el aprendizaje automático, el procesamiento de datos y la visualización, lo que permite a los equipos maximizar las herramientas en las que ya confían.

Creado originalmente por Netflix para soportar amplias operaciones de aprendizaje automático, Metaflow cuenta con un potente sistema de control de versiones. Este sistema realiza un seguimiento de los experimentos, los conjuntos de datos y las versiones de los modelos, lo que garantiza que los experimentos sean reproducibles y permite revertirlos fácilmente cuando sea necesario.

Dagster se suma a la gama de marcos de orquestación al centrarse en mantener la integridad de los datos y, al mismo tiempo, ofrecer una gestión de canalización adaptable. Esta herramienta de código abierto está diseñada para mejorar la calidad, rastrear el linaje de datos y garantizar la visibilidad en los flujos de trabajo de aprendizaje automático (ML). En esencia, Dagster se especializa en crear canales de datos confiables y seguros que mantengan altos estándares de integridad de los datos y proporcionen información clara sobre las transformaciones.

Dagster es particularmente eficaz para gestionar los flujos de trabajo de aprendizaje automático en los que la calidad y la precisión de los datos no son negociables. Está diseñado para equipos que necesitan una validación integrada, un seguimiento sólido de los metadatos y una capacidad de observación completa a lo largo de sus procesos. Un ejemplo práctico de su utilidad es el sector sanitario, donde las organizaciones confían en Dagster para procesar los datos sanitarios confidenciales con el nivel de integridad necesario para cumplir con los estrictos parámetros de calidad y cumplimiento.

Dagster permite a los desarrolladores definir flujos de trabajo complejos directamente en el código, una función esencial para escalar las operaciones de IA. Su estructura modular permite encadenar modelos y agentes para crear flujos de trabajo avanzados, con una gestión de dependencias automatizada, mecanismos de reintento y ejecución en paralelo. Además, Dagster se integra perfectamente con varias plataformas en la nube, API y bases de datos vectoriales, lo que lo hace ideal para gestionar tareas de IA y datos a gran escala.

Esta arquitectura flexible garantiza una integración fluida con diversos sistemas.

La verdadera fortaleza de Dagster reside en su capacidad para gestionar y supervisar los datos que fluyen entre sistemas interconectados. Realiza un seguimiento meticuloso de cada transformación de datos y ofrece a los equipos la precisión que necesitan. Muchos equipos técnicos eligen Dagster para crear pilas de MLOps personalizadas o implementar capas de control detalladas para aplicaciones de modelos lingüísticos (LLM) de gran tamaño. Su transparencia y adaptabilidad permiten a las organizaciones crear sistemas de inteligencia artificial propios y experimentar a la vanguardia, sin dejar de mantener el control sobre la calidad de los datos y el rendimiento de los procesos.

El marco de gobierno de Dagster hace hincapié en el linaje de datos y la garantía de calidad. Sus herramientas integradas detectan y solucionan los errores en cada etapa de un proceso, lo que minimiza el riesgo de que los datos incorrectos se propaguen por el sistema. Al priorizar la precisión y la trazabilidad de los datos, Dagster ayuda a los equipos a garantizar que sus datos cumplen con los estándares requeridos antes de que lleguen a la producción, respaldando los esfuerzos de cumplimiento con registros claros y confiables.

El diseño modular de Dagster es ideal para gestionar flujos de trabajo de IA complejos en entornos de gran escala. Gestiona automáticamente las dependencias, los reintentos y la ejecución en paralelo, lo que simplifica la organización de los sistemas de IA avanzados. Esto lo convierte en una opción confiable para las organizaciones que necesitan una lógica de orquestación personalizada para respaldar operaciones sofisticadas de inteligencia artificial.

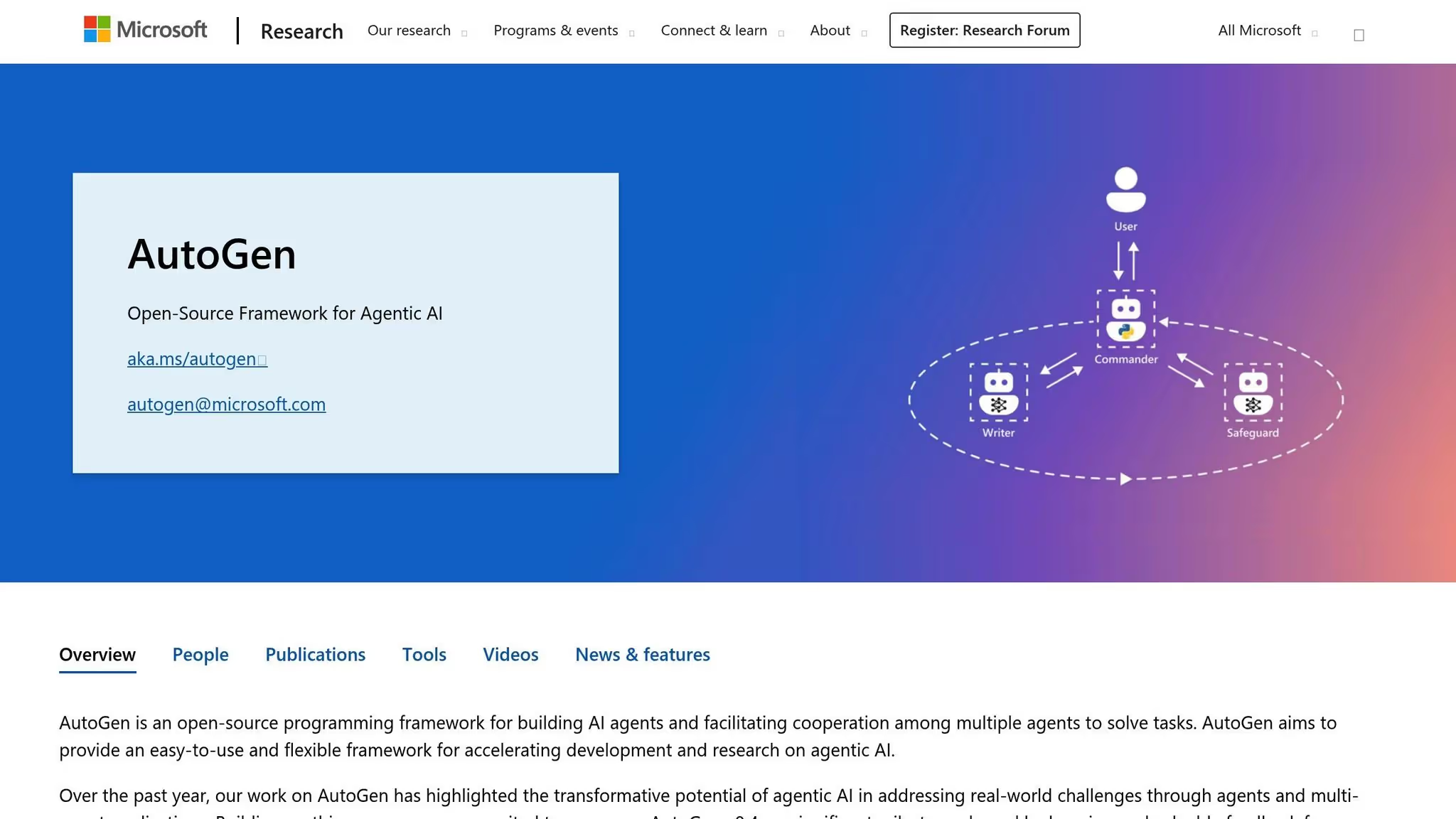

Microsoft AutoGen es un marco de código abierto desarrollado por Investigación de Microsoft que permite que varios agentes de IA colaboren a través de una conversación para abordar tareas complejas. Este sistema permite a los desarrolladores crear aplicaciones en las que los agentes especializados trabajan juntos, cada uno de los cuales aporta su experiencia única para lograr objetivos compartidos. Al introducir una interfaz conversacional, AutoGen simplifica el proceso, a menudo complejo, de coordinar varios componentes de la IA.

AutoGen presenta un nuevo enfoque para la orquestación de múltiples agentes al aprovechar el diálogo como medio de colaboración. Este marco es particularmente eficaz en escenarios de resolución de problemas que requieren que varios agentes trabajen juntos de forma dinámica. Por ejemplo, en el desarrollo de software, un agente puede generar código mientras que otro se centra en las pruebas y la validación, y ambos agentes realizan iteraciones para refinar el resultado. Este modelo conversacional es ideal para tareas como la automatización de los flujos de trabajo del software, la asistencia en la investigación y la gestión de procesos complejos de toma de decisiones en los que la diversidad de perspectivas o habilidades mejoran los resultados.

Equipos que buscan mejora iterativa en sus flujos de trabajo encuentran que AutoGen es especialmente atractivo. Su capacidad para facilitar los intercambios de ida y vuelta entre agentes refleja la colaboración humana, lo que facilita a los desarrolladores el diseño de sistemas que evolucionen y mejoren mediante el diálogo y la retroalimentación continuos.

AutoGen hace hincapié en la modularidad a la vez que destaca por su diseño de agente conversacional. Cada agente opera con funciones e instrucciones específicas, que pueden incluir el acceso a herramientas, API externas o modelos lingüísticos. El marco admite tanto a los agentes autónomos como a los agentes proxy de usuario que incorporan aportaciones humanas, lo que ofrece flexibilidad a la hora de gestionar los flujos de trabajo.

El sistema puede ejecutarse localmente durante el desarrollo y escalar a entornos de nube para la producción. Los desarrolladores pueden definir la forma en que interactúan los agentes, ya sea mediante flujos de trabajo secuenciales en los que los agentes se turnan o mediante patrones más complejos en los que varios agentes contribuyen simultáneamente. Al utilizar configuraciones basadas en Python, los equipos obtienen un control total sobre la lógica de orquestación sin sacrificar la legibilidad, lo que agiliza el proceso de gestión de las interacciones entre varios agentes.

AutoGen gestiona las complejidades de gestionar múltiples modelos de llamadas y conversaciones con agentes, lo que permite a los desarrolladores centrarse en diseñar la lógica y el comportamiento de sus sistemas en lugar de preocuparse por la infraestructura.

AutoGen se integra perfectamente con Servicio Azure OpenAI y otros modelos mediante llamadas a funciones, lo que brinda a los desarrolladores flexibilidad a la hora de seleccionar los backends de IA. También permite conectar a los agentes con herramientas y servicios externos, lo que les permite recuperar datos, ejecutar código o interactuar con API de terceros durante sus conversaciones.

El marco permite a los desarrolladores crear tipos de agentes personalizados, patrones de conversación reutilizables y plantillas de orquestación. Esta flexibilidad significa que los equipos pueden aprovechar los patrones preexistentes para tareas comunes y, al mismo tiempo, personalizarlos en profundidad para satisfacer necesidades especializadas.

Para las organizaciones que ya utilizan las herramientas de Microsoft, AutoGen proporciona una fácil integración con los servicios de Azure, Código de Visual Studio, y otras plataformas de desarrollo. A pesar de esta alineación con el ecosistema de Microsoft, el marco es independiente de la plataforma y funciona bien en una variedad de entornos tecnológicos.

AutoGen pone un fuerte énfasis en controlar las capacidades de los agentes y gestionar el acceso a los recursos externos. Los desarrolladores definen permisos específicos para cada agente, como las API a las que pueden acceder o los datos que pueden recuperar. Este enfoque granular garantiza que los agentes operen según los principios de mínimos privilegios y realicen solo las tareas necesarias para sus funciones.

La naturaleza conversacional del marco crea inherentemente pistas de auditoría, registrando las interacciones entre los agentes y los procesos de toma de decisiones. Estos registros proporcionan transparencia sobre la forma en que se generan los resultados, lo que contribuye a los esfuerzos de cumplimiento y depuración. Los equipos pueden revisar estos registros para analizar el comportamiento de los agentes e identificar las áreas que deben perfeccionarse.

Las capacidades human-in-the-loop mejoran la supervisión al permitir que los flujos de trabajo se detengan para su revisión humana en los puntos de decisión críticos. Esta función garantiza que las acciones delicadas puedan evaluarse antes de continuar, equilibrando la eficiencia de la automatización con la gobernanza y el control.

La escalabilidad de AutoGen depende en gran medida de los modelos lingüísticos subyacentes y de la infraestructura que respalda a los agentes. El marco en sí mismo presenta una sobrecarga mínima, y el rendimiento depende principalmente de los tiempos de inferencia de los modelos y la latencia de las llamadas a la API. En el caso de los flujos de trabajo que implican múltiples intercambios secuenciales de agentes, el tiempo total de ejecución se acumula a lo largo de estas interacciones.

Las organizaciones pueden mejorar el rendimiento de la siguiente manera: almacenar en caché el contexto de la conversación, utilizando modelos más rápidos para las tareas rutinarias y reservando modelos más avanzados para el razonamiento complejo. Diseñar patrones de conversación para minimizar los intercambios innecesarios también mejora la eficiencia. Cuando es apropiado, el marco admite la ejecución de agentes en paralelo, lo que permite que las tareas independientes se ejecuten de forma simultánea en lugar de secuencial.

Para gestionar grandes cargas de trabajo, AutoGen se puede implementar en una infraestructura de nube con escalamiento automático, lo que garantiza que el sistema pueda gestionar las diferentes demandas y, al mismo tiempo, mantener los costos bajo control. Las interacciones entre agentes sin estado simplifican el escalado horizontal, aunque mantener el contexto en todos los intercambios requiere una planificación cuidadosa de la arquitectura.

Basándose en los marcos de orquestación que hemos explorado, SuperAGI presenta una nueva forma de gestionar la colaboración entre múltiples agentes. Esta plataforma de código abierto está diseñada para coordinar agentes de IA autónomos, lo que permite a los desarrolladores crear, implementar y supervisar agentes que puedan planificar, ejecutar y adaptarse a las tareas mediante el aprendizaje continuo. SuperAgi permite que varios agentes trabajen juntos sin problemas, delegando tareas de forma dinámica y colaborando para abordar desafíos complejos. Combina la gestión adaptativa de tareas con el trabajo en equipo con varios agentes, lo que la distingue como una poderosa herramienta para la orquestación avanzada de la IA.

SuperAgi destaca en la automatización de tareas complejas y en evolución para las empresas. Sus redes de agentes destacan en la planificación y ejecución avanzadas de tareas, y mejoran continuamente mediante ciclos de aprendizaje y retroalimentación reforzados. Esto hace que sea particularmente útil para las organizaciones que gestionan operaciones a gran escala, donde la coordinación inteligente es clave. Los agentes de la plataforma aprenden de sus interacciones y resultados, lo que les permite refinar su comportamiento con el tiempo.

La característica más destacada de la plataforma es su delegación dinámica de tareas. En lugar de ceñirse a flujos de trabajo rígidos, los agentes evalúan las situaciones en tiempo real, identifican las tareas prioritarias y las asignan a los miembros de la red más adecuados. Esta flexibilidad garantiza que los recursos se asignen de manera eficiente, incluso en escenarios complejos.

La arquitectura de SuperAgi está diseñada con la escalabilidad y la modularidad en su núcleo. Los desarrolladores pueden ampliar fácilmente las redes de agentes y las cargas de trabajo para satisfacer una variedad de necesidades de aplicaciones. Cada agente opera de forma independiente, pero se comunican sin problemas, lo que garantiza una colaboración fluida.

Una interfaz gráfica fácil de usar permite a los equipos visualizar las interacciones de los agentes y ajustar las configuraciones. Los paneles de supervisión proporcionan información sobre el rendimiento de los agentes, lo que ayuda a los desarrolladores a identificar y abordar las ineficiencias. La plataforma también admite la ejecución en paralelo, lo que permite a varios agentes gestionar tareas independientes de forma simultánea. Este diseño aumenta significativamente el rendimiento, especialmente en entornos de alta demanda.

SuperAGI cuenta con un sistema de complementos extensible que se integra con API, herramientas de flujo de trabajo y módulos personalizados de terceros. Esta flexibilidad acelera el desarrollo y fomenta las contribuciones de la comunidad de desarrolladores en general, lo que enriquece las capacidades de la plataforma.

La arquitectura modular y distribuida de la plataforma admite el escalado horizontal, lo que la hace adaptable para implementaciones a gran escala. Su uso de circuitos de aprendizaje por refuerzo y retroalimentación mejora el rendimiento general y garantiza que las tareas se asignen de manera eficiente. Al permitir una colaboración eficaz y un alto rendimiento, SuperAGI es ideal para las organizaciones que exigen un rendimiento sólido en escenarios complejos y de gran volumen.

Elegir el marco de orquestación de IA adecuado significa comprender los puntos fuertes y las limitaciones de cada opción. Estas plataformas se diseñan teniendo en cuenta diferentes prioridades y se adaptan a necesidades como la seguridad de nivel empresarial, la adaptabilidad de los desarrolladores o los flujos de trabajo especializados, como los procesos de aprendizaje automático. Cada marco refleja su filosofía de diseño única y sus casos de uso objetivo.

Por ejemplo, plataformas como Prompts.ai sobresalen a la hora de centralizar el acceso a grandes modelos lingüísticos (LLM), mientras que herramientas como Flujo de aire Apache y Prefecto centrarse en la automatización general del flujo de trabajo. Por otro lado, Kubeflow y Flyte están diseñados para procesos de aprendizaje automático y marcos como SuperAGI y AutoGen de Microsoft amplíe los límites de la colaboración de inteligencia artificial entre múltiples agentes al permitir que los sistemas autónomos gestionen tareas complejas de forma conjunta.

En última instancia, la decisión depende de las necesidades específicas de su organización. Una empresa emergente que cree su primera aplicación de inteligencia artificial tendrá requisitos muy diferentes a los de una gran empresa que gestione cientos de flujos de trabajo. Factores como el presupuesto, la experiencia del equipo y la infraestructura existente juegan un papel importante. A continuación, una tabla describe las principales ventajas y desventajas de algunos de los marcos más populares:

Estructuras de costos: Las plataformas tradicionales suelen cobrar por usuario o por ejecución, lo que puede generar costos más altos a medida que aumentan las operaciones. Por el contrario, Prompts.ai utiliza un modelo de pago por uso con créditos TOKN, que vincula los gastos directamente con el uso. Este enfoque es particularmente útil cuando se experimenta con diferentes modelos o se gestionan cargas de trabajo fluctuantes.

Seguridad y cumplimiento: Para sectores como el de la salud o las finanzas, es esencial contar con medidas de seguridad sólidas. Plataformas como Prompts.ai, IBM watsonx Orchestrate, y Prefecto proporcionan herramientas de cumplimiento integradas, como registros de auditoría y controles de acceso basados en funciones. Opciones de código abierto como Flujo de aire Apache, sin embargo, requieren una configuración adicional para cumplir con los estrictos estándares de cumplimiento.

Curva de aprendizaje: La usabilidad varía mucho. Plataformas como Prefecto y Daga son más aptos para principiantes y ofrecen API de Python intuitivas y útiles mensajes de error. Mientras tanto, Flujo de aire Apache y Kubeflow exigen una mayor experiencia técnica y habilidades de gestión de infraestructuras. Prompts.ai simplifica aún más esta tarea con una interfaz unificada que equilibra la facilidad de uso con funciones avanzadas para los usuarios avanzados.

Apoyo comunitario: El tamaño y la participación de la comunidad de una plataforma pueden influir en gran medida en tu experiencia. Flujo de aire Apache se beneficia de una base de usuarios masiva, lo que garantiza la disponibilidad inmediata de muchos recursos y soluciones. Las plataformas más nuevas, como Flyte y Daga tienen comunidades más pequeñas pero activas, aunque es posible que te encuentres con escenarios menos documentados.

Ecosistema de integración: La integración perfecta con las herramientas existentes es fundamental. Flujo de aire Apache lidera con cientos de complementos para servicios en la nube, bases de datos y herramientas de monitoreo. Prompts.ai, por otro lado, se centra específicamente en los LLM y ofrece un acceso simplificado a docenas de modelos a través de una sola API.

Escalabilidad: Plataformas como Kubeflow y Flyte están diseñados para el escalado horizontal y aprovechan Kubernetes para la distribución de la carga de trabajo. Metaflow utiliza los servicios de AWS para un escalado elástico, mientras Prefecto admite opciones de escalado autohospedadas y administradas en la nube. SuperAGI emplea una arquitectura de agentes distribuidos, lo que permite la ejecución en paralelo, aunque esto requiere una coordinación cuidadosa.

El mejor marco para ti depende de tus flujos de trabajo específicos. Para la orquestación de un LLM, Prompts.ai destaca por su modelo de acceso centralizado y su rentabilidad. Los equipos de ingeniería de datos pueden inclinarse por la confiabilidad de Flujo de aire Apache, mientras que los equipos de aprendizaje automático que trabajan en la capacitación y el despliegue a gran escala podrían beneficiarse de Kubeflow o Flyte. Si te centras en crear sistemas de IA autónomos, SuperAGI o AutoGen de Microsoft podría ser la opción correcta.

La elección de un marco de orquestación de IA no consiste en encontrar una solución universal, sino en alinear los puntos fuertes del marco con los flujos de trabajo, las habilidades técnicas y los objetivos a largo plazo de su organización. Cada uno de los marcos que se analizan aquí responde a necesidades diferentes, desde la automatización de los flujos de trabajo hasta la gestión de los procesos de aprendizaje automático o la habilitación de la colaboración entre varios agentes.

Por ejemplo, los equipos que dan prioridad a la orquestación de LLM pueden encontrar Prompts.ai particularmente atractivo. Proporciona acceso centralizado a más de 35 modelos, como el GPT-5, el Claude y el Gemini, todo ello a través de una interfaz unificada. El sistema de crédito TOKN de pago por uso elimina las tarifas de suscripción y ofrece un seguimiento de los costos en tiempo real. Con funciones como los controles de acceso basados en roles y los registros de auditoría, Prompts.ai es una opción sólida para los sectores que requieren una gobernanza estricta sin comprometer la velocidad.

Los equipos de ingeniería de datos que trabajan con canalizaciones de ETL complejas pueden inclinarse por Apache Airflow por su sólido ecosistema de complementos y escalabilidad, aunque requiere conocimientos más avanzados. Por otro lado, Prefect ofrece un enfoque nativo de Python con un manejo de errores fácil de usar, lo que lo convierte en una excelente opción para una incorporación más rápida de los equipos.

Para los profesionales del aprendizaje automático, los marcos como Kubeflow y Flyte brillan a la hora de gestionar tareas de capacitación e implementación a gran escala. El diseño nativo de Kubernetes de Kubeflow admite la computación distribuida, mientras que Flyte proporciona un control de versiones avanzado y flujos de trabajo con seguridad de tipos. Sin embargo, ambos exigen un conocimiento significativo de la infraestructura. Para los equipos que ya han invertido en AWS, Metaflow ofrece una alternativa más sencilla adaptada a los flujos de trabajo de la ciencia de datos.

Las organizaciones que exploran sistemas de IA autónomos podrían considerar Microsoft AutoGen para sus funciones de colaboración entre múltiples agentes o SuperAGI para la delegación dinámica de tareas. Estas herramientas son ideales para casos de uso especializados o de investigación, pero a menudo requieren conocimientos avanzados de codificación, lo que las hace menos adecuadas para las necesidades de producción inmediatas.

En última instancia, la selección del marco adecuado implica evaluar factores como la modularidad, la extensibilidad, la observabilidad y las funciones de gobierno, como los controles de acceso basados en roles y las certificaciones de cumplimiento. La flexibilidad de implementación y la integración con las herramientas existentes son igualmente importantes. Más allá de la funcionalidad, considere la experiencia del desarrollador, incluidos los SDK, la documentación y el costo total de propiedad. La complejidad de sus flujos de trabajo, ya sean tareas sencillas para un solo agente o sistemas complejos con varios agentes con memoria persistente, también debería guiar su decisión.

La industria tiende hacia sistemas de IA escalables e integrados, con marcos de código abierto que impulsan la mayoría de las cargas de trabajo empresariales, mientras que los tiempos de ejecución gestionados por los proveedores simplifican los desafíos operativos.

Comience por definir su caso de uso específico, ya sea que se trate de LLM, canalizaciones de datos o flujos de trabajo de entrenamiento de aprendizaje automático. Evalúe la experiencia técnica y la infraestructura actual de su equipo. Realizar pruebas de concepto con marcos seleccionados puede ayudar a identificar soluciones que reduzcan la complejidad y permitan a su equipo centrarse en impulsar la innovación.

Al elegir un marco de orquestación de IA, es fundamental tener en cuenta qué tan bien se integra con sus herramientas y sistemas actuales. Un marco con un sólido capacidades de integración garantiza que todo funcione en conjunto sin complicaciones innecesarias.

Presta atención a su funciones de automatización, como la programación del flujo de trabajo y la administración de tareas, ya que pueden simplificar las operaciones y ahorrar tiempo. Igualmente importantes son seguridad y gobierno medidas que protegen los datos confidenciales y le ayudan a cumplir con las normativas.

Opte por un marco que ofrezca modularidad y escalabilidad, para que pueda crecer y adaptarse a la evolución de sus requisitos. Por último, dé prioridad a una solución que sea intuitiva y se adapte al nivel de habilidad técnica de su equipo, lo que simplifique tanto la configuración como el uso diario.

Prompts.ai simplifica el desafío de combinar múltiples herramientas de inteligencia artificial al reunir más de 35 modelos de lenguaje de gran tamaño en una plataforma unificada. Con esta configuración, los usuarios pueden comparar fácilmente los modelos en paralelo y, al mismo tiempo, controlar por completo sus rápidos flujos de trabajo, la calidad de los resultados y el rendimiento general.

Además de su eficiencia, Prompts.ai cuenta con una capa FinOps integrada diseñada para optimizar los costos. Esta herramienta proporciona información en tiempo real sobre el uso, el gasto y el retorno de la inversión (ROI), lo que permite a las organizaciones administrar sus recursos de manera efectiva y aprovechar al máximo sus presupuestos de inteligencia artificial.

Prompts.ai prioriza seguridad y cumplimiento de nivel empresarial, alineándose con los estándares de la industria como SOC 2 tipo II, HIPAA, y GDPR para proteger sus datos en cada etapa.

Para mantener el monitoreo y el cumplimiento continuos, Prompts.ai colabora con Vanta y comenzó su Proceso de auditoría SOC 2 tipo II el 19 de junio de 2025. Estas medidas garantizan que sus flujos de trabajo se mantengan seguros, conformes y confiables para las operaciones empresariales.