يضمن تنسيق الذكاء الاصطناعي التعاون السلس بين أدوات الذكاء الاصطناعي المتعددة وسير العمل، مما يوفر الوقت ويقلل التكاليف. يغطي هذا الدليل أفضل 11 إطارًا لإدارة عمليات الذكاء الاصطناعي، من الأدوات على مستوى المؤسسات إلى خيارات المصدر المفتوح. سواء كنت تقوم بالتبسيط سير عمل LLM، التشغيل الآلي خطوط أنابيب البيانات، أو الإدارة دورات حياة التعلم الآلي، هناك حل لكل حاجة. تشمل الأطر الرئيسية ما يلي:

نصيحة سريعة: اختر استنادًا إلى خبرة فريقك وتعقيد سير العمل واحتياجات التكامل. لتنسيق LLM، Prompts.ai يتفوق. بالنسبة لخطوط أنابيب البيانات، تدفق هواء أباتشي يمكن الاعتماد عليها. للتعلم الآلي، كيوبيفلو أو فلايت هي خيارات قوية.

تعمق أكثر للعثور على الإطار المناسب لفريقك وسير العمل.

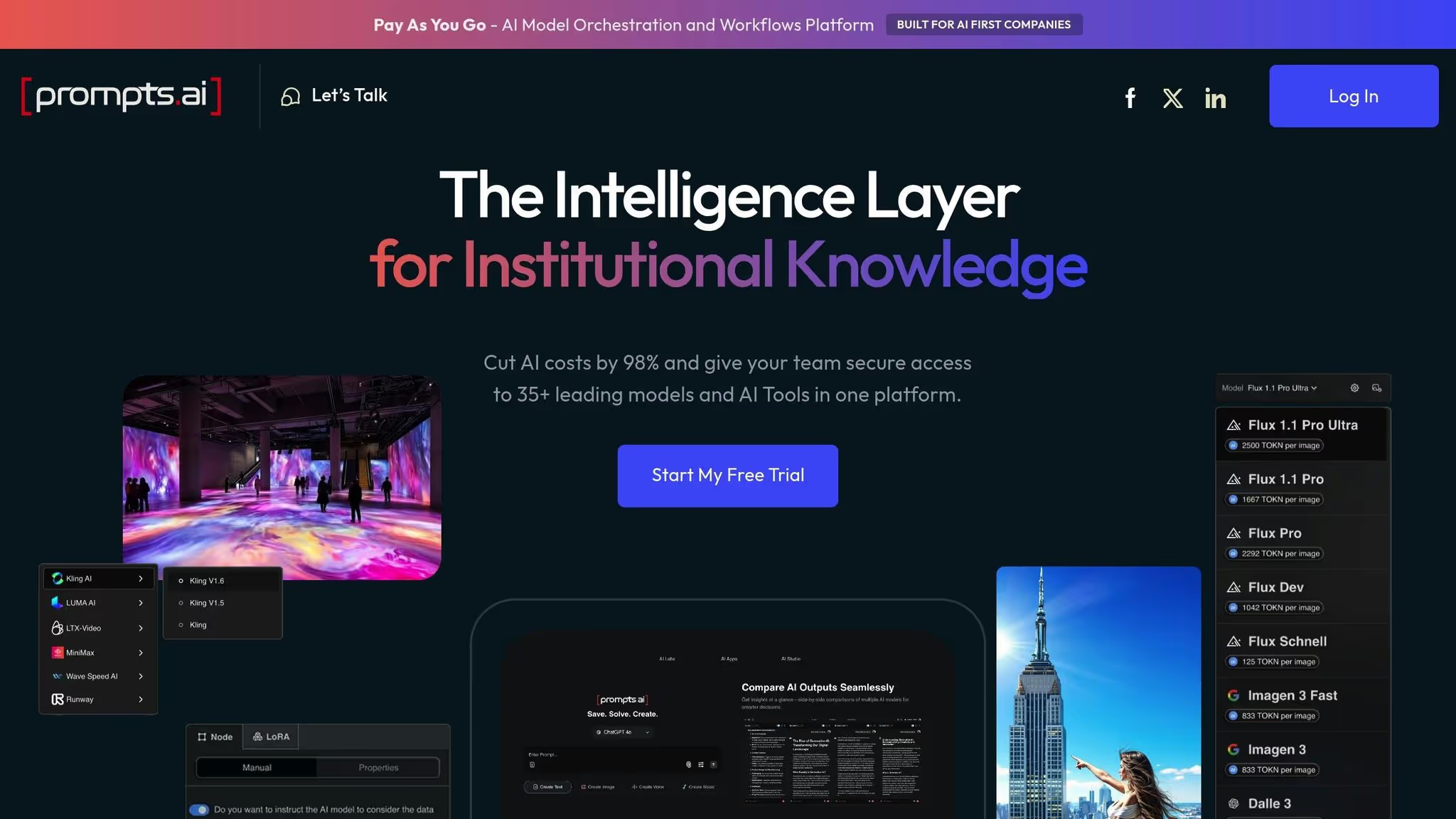

تعمل Prompts.ai كمنصة مركزية قائمة على السحابة تربط مستخدمي المؤسسات بأكثر من 35 نموذجًا رائدًا للذكاء الاصطناعي، بما في ذلك GPT-5 و Claude و LLama و Gemini و Grok-4 و Flux Pro و Kling - يمكن الوصول إليها جميعًا من خلال واجهة واحدة. لا يلزم تثبيت أي برنامج، مما يجعل من السهل على الفرق من أي حجم دمج الذكاء الاصطناعي في سير العمل.

تعالج المنصة تحديًا كبيرًا في تبني الذكاء الاصطناعي: تمدد الأدوات. من خلال توفير بيئة موحدة، فإنها تدمج اختيار النموذج وسير العمل السريع وتتبع الأداء في نظام واحد. يعمل هذا النهج على تحويل استخدام الذكاء الاصطناعي من تجارب متفرقة لمرة واحدة إلى عمليات متسقة وقابلة للتطوير يمكن للمؤسسات نشرها عبر الأقسام بسهولة.

يركز Prompts.ai على التشغيل الآلي عمليات سير عمل الذكاء الاصطناعي للمؤسسات، مما يساعد المنظمات على خفض التكاليف غير الضرورية مع معالجة الشواغل المتعلقة بالحوكمة. من شركات Fortune 500 إلى الوكالات الإبداعية ومختبرات الأبحاث، يمكن للمستخدمين إنشاء تدفقات عمل متوافقة وقابلة للتدقيق دون المخاطرة بالتعرض للبيانات الحساسة لخدمات متعددة تابعة لجهات خارجية.

تم التعرف على المنصة من قبل جيناي. ووركس كأفضل حل للذكاء الاصطناعي لحل مشكلات المؤسسات والأتمتة، مع تصنيف مستخدم مثير للإعجاب يبلغ 4.8 من أصل 5. تعتمد الشركات على Prompts.ai لمهام مثل تبسيط إنشاء المحتوى وأتمتة سير العمل الاستراتيجي وتسريع تطوير المقترحات. في بعض الحالات، تم تخفيض المشاريع التي كانت تستغرق أسابيع إلى يوم واحد فقط.

يأتي أحد الأمثلة البارزة في مايو 2025، عندما استخدم مدير الذكاء الاصطناعي المستقل يوهانس فوريلون المنصة للتكامل بسلاسة. جوجل ديب مايند Veo2 الرسوم المتحركة في فيديو ترويجي لـ بريتلينغ والقوات الجوية الفرنسية. سلط هذا المشروع الضوء على كيفية تمكين Prompts.ai من التنسيق السلس لأدوات الذكاء الاصطناعي المتعددة.

يبسط Prompts.ai كيفية عمل الفرق مع الذكاء الاصطناعي من خلال دمج الوصول إلى أكثر من 35 نموذجًا للغة والصور من خلال واجهة واحدة. هذا يزيل متاعب إدارة الاشتراكات المتعددة ومفاتيح API وأنظمة الفواتير. يمكن للمستخدمين الجمع بين نماذج مختلفة لمهام محددة ضمن سير عمل واحد، وإنشاء خطوط أنابيب تنسيق سلسة.

تعمل المنصة على نظام ائتمان TOKN، الذي يعمل على توحيد الاستخدام في جميع النماذج، مما يجعل تتبع التكاليف وتخصيص الموارد أمرًا سهلاً. يمكن للفرق التبديل بين النماذج حسب الحاجة، بناءً على متطلبات الأداء. تتضمن خطط الأعمال مساحات عمل غير محدودة ومتعاونين، مما يسهل على المؤسسات توسيع نطاق اعتماد الذكاء الاصطناعي.

مع نموذج تسعير الدفع أولاً بأول، يقوم Prompts.ai بمواءمة التكاليف مع الاستخدام الفعلي، بدءًا من 0 دولار شهريًا للاستكشاف الأولي. تقدم خطط الأعمال، التي تتراوح من 99 دولارًا إلى 129 دولارًا لكل عضو شهريًا، مستويات مختلفة من أرصدة TOKN (250,000 إلى 1,000,000) و 10 جيجابايت من التخزين السحابي عبر جميع المستويات.

تم تصميم Prompts.ai للأمان والامتثال على مستوى المؤسسة، مع الالتزام بمعايير SOC 2 من النوع الثاني و HIPAA و GDPR. بدأت المنصة تدقيق SOC 2 Type II في 19 يونيو 2025، وتستخدم المراقبة المستمرة من خلال فانتا. يمكن للمستخدمين الوصول إلى تحديثات في الوقت الفعلي حول أمان النظام الأساسي وحالة الامتثال عبر مركز ثقة مخصص على trust.prompts.ai.

تتضمن خطط الأعمال (الأساسية والمحترفة والنخبة) أدوات لـ مراقبة الامتثال وإدارة الحوكمة، مما يوفر رؤية كاملة لتفاعلات الذكاء الاصطناعي والحفاظ على مسارات التدقيق التفصيلية لتلبية المتطلبات التنظيمية. حتى الفرق الصغيرة والمهنيين الأفراد الذين يستخدمون خطط Personal Creator وFamily يستفيدون من ميزات الحوكمة على مستوى المؤسسة هذه.

يتم الاحتفاظ بالبيانات الحساسة داخل بيئة مركزية وخاضعة للرقابة، مما يقلل من المخاطر المرتبطة بنشر المعلومات عبر خدمات متعددة تابعة لجهات خارجية. لا تقلل هذه البنية الآمنة من نقاط الضعف المحتملة فحسب، بل تبسط أيضًا إدارة الامتثال للمؤسسات التي تعمل بموجب لوائح صارمة.

تم تصميمه باستخدام بنية سحابية أصلية، يمكّن Prompts.ai المؤسسات من التوسع دون عناء. يمكن للفرق إضافة أعضاء جدد وتوسيع مساحات العمل والوصول إلى نماذج إضافية في غضون دقائق، مما يضمن نمو اعتماد الذكاء الاصطناعي بالسرعة المطلوبة.

المنصة ضوابط التكلفة في الوقت الفعلي ربط استخدام الرمز المميز مباشرةً بنتائج الأعمال، مما يوفر الشفافية في الإنفاق ويساعد المؤسسات على تحسين استثماراتها في الذكاء الاصطناعي. يمكن للمستخدمين مقارنة مخرجات النموذج جنبًا إلى جنب، مما يسمح باتخاذ قرارات مستنيرة حول النماذج الأنسب لمهام محددة.

يوفر Prompts.ai أيضًا تحليلات استخدام مفصلة، ويقدم رؤى حول أداء الفريق واستهلاك الموارد. تساعد هذه التحليلات المؤسسات على تحديد مجالات التحسين وتبرير استثماراتها في الذكاء الاصطناعي بمكاسب إنتاجية قابلة للقياس. أبلغ المستخدمون عن زيادة تصل إلى 10 أضعاف في الإنتاجية عند الاستفادة من أدوات التشغيل الآلي لسير العمل في المنصة، مما يدل على قدرتها على تحقيق نتائج ذات مغزى.

تقدم Kubiya AI حلاً لأتمتة سير العمل مدعومًا بواجهات المحادثة. في حين أن التفاصيل المحددة حول بنية النشر وأساليب التنسيق ليست متاحة للجمهور، فإن تركيزها على واجهات المحادثة يسلط الضوء على زاوية فريدة في تبسيط التشغيل الآلي لسير العمل.

تقدم شركة آي بي إم واتسون إكس أوركسترات التشغيل الآلي القائم على الذكاء الاصطناعي إلى عمليات المؤسسة، مع التركيز على جعل الأتمتة متاحة لمحترفي الأعمال بدلاً من المطورين فقط. من خلال تمكين المستخدمين من إصدار أوامر بلغة طبيعية، تعمل المنصة على تبسيط المهام المعقدة للفرق غير الفنية في الموارد البشرية والتمويل والمبيعات ودعم العملاء والمشتريات. يزيل هذا النهج الحاجة إلى خبرة الترميز، مما يمكّن فرق العمل من أتمتة العمليات بشكل مستقل.

تتألق المنصة في أتمتة المهام المتكررة التي غالبًا ما تستنزف وقت الموظف. باستخدام أوامر اللغة البسيطة، يمكن للمستخدمين بدء سير العمل لمهام مثل جدولة المقابلات وتلخيص ملفات تعريف المرشحين ومعالجة القروض وإنشاء التقارير. يتعامل watsonx Orchestrate مع هذه الأنشطة عبر أنظمة خلفية متعددة مع الالتزام بمعايير الأمان على مستوى المؤسسة.

على سبيل المثال، قامت مؤسسة مالية كبرى بتطبيق watsonx Orchestrate لتبسيط دعم العملاء ووظائف المكتب الخلفي. استخدم الموظفون مدخلات اللغة الطبيعية لأتمتة سير العمل لمعالجة القروض وطلبات الخدمة. تم دمج النظام الأساسي بسلاسة مع أنظمة الواجهة الخلفية، وحافظت على الامتثال من خلال الحوكمة المدمجة، وقدمت تحسينات ملحوظة: أوقات معالجة أسرع، وأخطاء يدوية أقل، ورضا أعلى للعملاء. يسلط هذا المثال الضوء على قدرة النظام الأساسي على تحويل مهام المؤسسة الروتينية إلى عمليات فعالة ومؤتمتة.

يوفر IBM watsonx Orchestrate خيارات نشر السحابة المختلطة، مما يسمح بتشغيل عمليات سير العمل في السحابة أو في مكان العمل أو عبر كليهما. تعتبر هذه المرونة ذات قيمة خاصة للمؤسسات التي لديها سياسات صارمة لوضع البيانات أو البنية التحتية القديمة. تستفيد المنصة من نماذج اللغات الكبيرة (LLMs) وواجهات برمجة التطبيقات وتطبيقات المؤسسات لتنفيذ المهام بأمان، مما يضمن التوافق مع البيئات التشغيلية المختلفة.

يتكامل watsonx Orchestrate بسلاسة مع الأنظمة المتنوعة، مما يجعله حلاً قويًا لأتمتة المؤسسات. وهو يتصل بـ CRM و ERP والمنصات السحابية مثل AWS و Azure باستخدام الموصلات المرئية وواجهات برمجة التطبيقات. بالإضافة إلى ذلك، فإنه يعمل بشكل وثيق مع خدمات IBM Watson ونماذج IBM AI الأخرى، مما يوسع قدراته بما يتجاوز التشغيل الآلي الأساسي لسير العمل. بالنسبة للمستخدمين المتقدمين، يتيح الوصول البرمجي لواجهة برمجة التطبيقات مزيدًا من التخصيص والتكامل مع الأدوات الحالية.

«تم تصميم IBM watsonx Orchestrate لجلب الأتمتة المدعومة بالذكاء الاصطناعي مباشرة إلى عمليات سير العمل. على عكس الأدوات التي تركز على المطورين، تستهدف watsonx Orchestrate المتخصصين في الموارد البشرية والتمويل والمبيعات ودعم العملاء الذين يرغبون في تبسيط المهام دون الحاجة إلى ترميز ثقيل.» - Domo

تتضمن المنصة أيضًا تطبيقات الذكاء الاصطناعي التي تم إنشاؤها مسبقًا ومجموعات المهارات الخاصة بالصناعة، مما يتيح التنفيذ السريع لحالات الاستخدام الشائعة. ومع ذلك، يجب على المؤسسات ملاحظة أن وظائفها قد تكون محدودة أكثر خارج نظام IBM البيئي مقارنة بالمنصات ذات خيارات التكامل الأوسع.

تتميز IBM watsonx Orchestrate بإطار الحوكمة القوي، مما يجعلها الخيار المفضل للصناعات المنظمة. تضمن ضوابط الوصول القائمة على الأدوار أن الوصول إلى البيانات يقتصر على المستخدمين المصرح لهم والوظائف المحددة.

تعالج خيارات النشر المختلطة للمنصة مخاوف الخصوصية من خلال تمكين المؤسسات من الاحتفاظ بالبيانات الحساسة في أماكن العمل مع استخدام الموارد السحابية للعمليات الأقل أهمية. إن ميزات الامتثال الخاصة بها تجعلها مناسبة بشكل خاص لصناعات مثل التمويل والرعاية الصحية، حيث يعد الأمان والشفافية والالتزام التنظيمي أمرًا بالغ الأهمية.

تم تصميم watsonx Orchestrate للتوسع عبر البيئات الهجينة، وهو يدعم كلاً من الفرق الصغيرة والمؤسسات الكبيرة. إنه يعزز الكفاءة التشغيلية ويضمن الامتثال للسياسات ويخفف المخاطر ويعزز إنتاجية الموظفين. يمكن للمؤسسات البدء على نطاق صغير - مع التركيز على أقسام محددة - وتوسيع قدرات الأتمتة تدريجيًا عندما ترى النتائج وتطور الخبرة الداخلية.

Apache Airflow عبارة عن منصة مفتوحة المصدر مصممة لتنظيم عمليات سير عمل البيانات المعقدة باستخدام الرسوم البيانية غير الدورية الموجهة (DAGs). تم تطويره في البداية بواسطة Airbnb والآن تحت مؤسسة أباتشي للبرمجيات، فقد أصبح خيارًا شائعًا لجدولة خطوط أنابيب البيانات ومراقبتها وإدارتها. على عكس أدوات التشغيل الآلي المصممة خصيصًا لمستخدمي الأعمال، تم تصميم Airflow مع وضع مهندسي البيانات والمطورين في الاعتبار، مما يوفر تحكمًا برمجيًا في تنفيذ سير العمل.

يتألق Airflow في إدارة خطوط أنابيب البيانات التي تتضمن التبعيات المعقدة والمهام المجدولة ومنطق التحويل. تعتمد فرق البيانات عليها لمجموعة متنوعة من الأغراض، بما في ذلك تنسيق عمليات ETL (الاستخراج والتحويل والتحميل)، وتدريب نماذج التعلم الآلي، وتشغيل مهام المعالجة المجمعة، واستيعاب البيانات من مصادر متعددة، وتحويل مجموعات البيانات، وإنشاء التقارير وفقًا لجدول زمني. من خلال تحديد عمليات سير العمل في Python، يكتسب المطورون مرونة كبيرة لتنفيذ المنطق المخصص ومعالجة الأخطاء بفعالية.

تتضمن المنصة واجهة مرئية توفر رؤى حول حالة سير العمل وتبعيات المهام وسجل التنفيذ. هذا يجعل من السهل مراقبة الأداء واستكشاف الأعطال وإصلاحها. على سبيل المثال، في حالة فشل إحدى المهام، يمكن لـ Airflow إعادة المحاولة تلقائيًا أو إرسال تنبيهات أو تخطي المهام اللاحقة لمنع المشكلات المتتالية. هذه الوظيفة تجعلها خيارًا متعدد الاستخدامات لاحتياجات النشر المختلفة.

يمكن نشر Airflow كإعداد خادم واحد أو تغيير حجمه إلى مجموعات موزعة، حيث يعمل المجدول والعمال وخادم الويب على أجهزة منفصلة. وتتكون البنية من عدة مكونات أساسية: برنامج جدولة يقوم بتشغيل المهام استنادًا إلى جداول محددة، والعاملين الذين يقومون بتنفيذ المهام، وخادم الويب لواجهة المستخدم، وقاعدة بيانات التعريف التي تخزن تعريفات سير العمل وسجل التنفيذ.

يسمح هذا التصميم المعياري للمؤسسات بتوسيع قدرة العمال بشكل مستقل، اعتمادًا على متطلبات عبء العمل. في البيئات السحابية الأصلية، غالبًا ما يتم استخدام Kubernetes لنشر Airflow، حيث يقوم KubernetExecutor بإنشاء كبسولات معزولة للمهام الفردية. يعمل هذا الإعداد على تحسين عزل الموارد ويتيح للفرق تخصيص موارد حسابية محددة لكل مهمة. بالنسبة لأولئك الذين يتطلعون إلى تقليل النفقات العامة لإدارة البنية التحتية، تتوفر خدمات Airflow المُدارة، على الرغم من أنها تأتي بتكاليف تشغيلية إضافية.

إن إمكانات التكامل الواسعة لـ Airflow تجعلها قابلة للتكيف بدرجة كبيرة. إنه يوفر موصلات مسبقة الصنع لقواعد البيانات والأنظمة الأساسية السحابية ومستودعات البيانات وأنظمة المراسلة، إلى جانب القدرة على إنشاء مشغلين مخصصين باستخدام Python. تضمن هذه المرونة قدرة Airflow على تلبية المتطلبات التنظيمية المتنوعة.

يمكن أيضًا الاستفادة من النظام البيئي الغني لمكتبة Python في عمليات سير العمل، مما يتيح تحويلات البيانات المتقدمة والتحليل مباشرة في تعريفات خطوط الأنابيب. بالنسبة لتطبيقات الذكاء الاصطناعي والتعلم الآلي، يتكامل Airflow بسلاسة مع أطر مثل تينسورفلو، PyTorch، وتعلم سكيكيت. تساعد عمليات الدمج هذه علماء البيانات على تنسيق عمليات سير العمل لمهام مثل جلب البيانات وميزات المعالجة المسبقة ونماذج التدريب وتقييم الأداء ونشر النماذج في الإنتاج.

يتضمن Airflow التحكم في الوصول المستند إلى الأدوار (RBAC) لإدارة أذونات المستخدم عبر عمليات سير العمل والوظائف الإدارية. يمكن للمسؤولين تحديد الأدوار بامتيازات محددة، مما يضمن أن المستخدمين المصرح لهم فقط يمكنهم عرض أو تحرير أو تنفيذ DAG معينة. يساعد عنصر التحكم الدقيق هذا في الحفاظ على تكامل سير العمل ومنع التغييرات غير المصرح بها.

تتضمن خيارات المصادقة تسجيل الدخول المستند إلى كلمة المرور وتكامل LDAP وموفري OAuth. تتم إدارة بيانات الاعتماد الحساسة بشكل منفصل من خلال نظام اتصالات ومتغيرات Airflow. للحصول على أمان محسّن، فإن أدوات إدارة الأسرار الخارجية مثل خزينة هاشي كورب أو مدير أسرار AWS يمكن دمجها.

يعد تسجيل التدقيق ميزة رئيسية أخرى، حيث يتتبع إجراءات المستخدم وعمليات تنفيذ سير العمل. يؤدي هذا إلى إنشاء سجل مفصل للنشاط، وهو أمر لا يقدر بثمن لأغراض الامتثال واستكشاف الأخطاء وإصلاحها.

يتم توسيع تدفق الهواء أفقيًا عن طريق إضافة المزيد من العقد العاملة للتعامل مع أعباء العمل المتزايدة. تدعم المنصة العديد من أنواع المنفذين لتوزيع المهام بفعالية: يقوم LocalExecutor بتشغيل المهام على نفس الجهاز مثل المجدول، ويقوم CeleryExecutor بنشر المهام عبر أجهزة عاملة متعددة باستخدام قائمة انتظار الرسائل، ويقوم KubernetExecutor بتدوير البودات المعزولة لكل مهمة.

لتحسين الأداء، يعد تصميم DAG الدقيق وتخصيص الموارد أمرًا ضروريًا. يمكن أن تؤدي أحجام المهام الكبيرة إلى إجهاد المجدول، لذلك غالبًا ما تقوم الفرق بتقسيم DAG الكبيرة وضبط إعدادات المجدول والتأكد من أن مخزن البيانات الوصفية يحتوي على موارد كافية.

يعالج Airflow أيضًا عمليات الردم بكفاءة، مما يسمح للفرق بإعادة معالجة البيانات التاريخية عندما يتغير منطق سير العمل. وفي حين تعمل عمليات إعادة التعبئة على تبسيط التحديثات، فإنها يمكن أن تستهلك موارد حسابية كبيرة، مما يتطلب تخطيطًا دقيقًا لتجنب حدوث اضطرابات في أعباء العمل الإنتاجية.

نظرًا لكونه مفتوح المصدر، فإن Airflow يمنح المؤسسات التحكم الكامل في عمليات النشر الخاصة بها. ومع ذلك، فإن هذا يعني أيضًا أنه يجب عليهم إدارة البنية التحتية والمراقبة والترقيات، الأمر الذي يتطلب موارد هندسية مخصصة للحفاظ على الموثوقية والأداء على نطاق واسع.

تبرز Kubeflow كمنصة مخصصة لإدارة سير عمل التعلم الآلي، متميزة عن أدوات سير العمل ذات الأغراض العامة. تم تصميم هذا الحل مفتوح المصدر خصيصًا لـ Kubernetes، وهو يدعم دورة حياة التعلم الآلي الكاملة، مما يمنح علماء البيانات ومهندسي التعلم الآلي الأدوات التي يحتاجون إليها لبناء النماذج الجاهزة للإنتاج ونشرها وإدارتها باستخدام إمكانات Kubernetes الأصلية.

تم تصميم Kubeflow لتنظيم سير عمل التعلم الآلي الكامل داخل بيئات Kubernetes. وهي تغطي كل مرحلة من مراحل دورة حياة التعلم الآلي، بما في ذلك المعالجة المسبقة للبيانات وهندسة الميزات والتدريب على النماذج والتحقق والنشر والمراقبة. من خلال تمكين الفرق من إنشاء خطوط أنابيب معيارية وقابلة لإعادة الاستخدام، يبسط Kubeflow إدارة أحمال عمل ML الموزعة. كما يساعد نهجها المركزي في تتبع التجارب والإشراف على النماذج عبر مختلف المشاريع. بالإضافة إلى ذلك، يمكن لـ Kubeflow أتمتة عمليات إعادة التدريب عند تقديم بيانات جديدة، مما يضمن بقاء النماذج محدثة وذات صلة.

يعتمد Kubeflow على Kubernetes، وهو يستفيد من تنسيق الحاويات والتحجيم الديناميكي وإدارة الموارد لتحسين سير عمل ML. يمكن للمستخدمين التفاعل مع النظام الأساسي من خلال واجهة قائمة على الويب للإدارة المرئية أو واجهة سطر أوامر للأتمتة. اعتمادًا على عبء العمل، يقوم Kubeflow بتخصيص الموارد ديناميكيًا - مثل توفير وحدات معالجة الرسومات لمهام التدريب ووحدات المعالجة المركزية للاستدلال. تسمح مرونتها بالنشر على أي مجموعة Kubernetes، سواء كانت محلية أو في السحابة أو في إعدادات مختلطة، مما يضمن القدرة على التكيف عبر البيئات.

يتكامل Kubeflow بسلاسة مع أطر التعلم الآلي الشائعة مثل TensorFlow و PyTorch و XGBoost، بينما يدعم أيضًا الأطر المخصصة من خلال تصميمه القابل للتوسيع. بالإضافة إلى أطر التعلم الآلي، فإنه يتصل بالعديد من الخدمات السحابية وحلول التخزين، مما يمكّن خطوط الأنابيب من الوصول إلى تخزين الكائنات للبيانات، ومستودعات البيانات لاسترجاع الميزات، وأدوات المراقبة لتتبع الأداء. يعمل توافقه مع مكتبات Python على تبسيط الانتقال من التجريب إلى الإنتاج.

تستخدم Kubeflow قدرات التوسع المتأصلة في Kubernetes لتوزيع أعباء العمل عبر موارد المجموعة، مما يجعلها مناسبة تمامًا للتدريب على نطاق واسع ومهام معالجة البيانات. هذا يضمن الاستخدام الفعال للموارد ويدعم عمليات ML عالية الأداء. كما قال عكا بجدارة:

«يوفر Kubeflow تنسيقًا قويًا لدورات حياة ML بأكملها في بيئات Kubernetes لضمان قابلية النقل وقابلية التوسع والإدارة الفعالة لنماذج التعلم الآلي الموزعة.» - Akka

بفضل قدرتها على تخصيص الموارد بشكل مستقل، تعمل Kubeflow على سد الفجوة بين التجريب والإنتاج، مما يوفر المرونة والأداء.

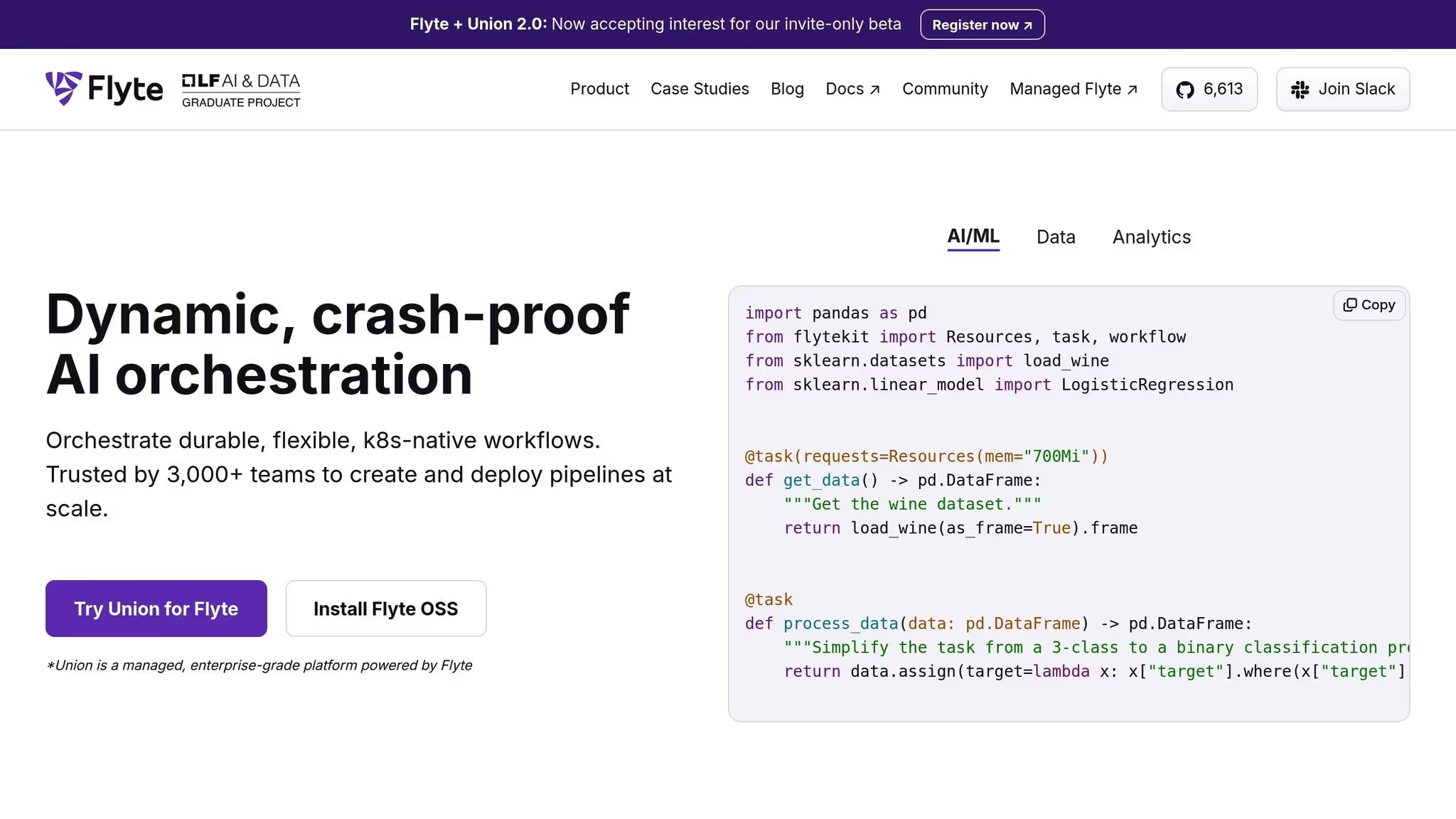

Flyte عبارة عن منصة تنسيق سحابية أصلية مصممة لتبسيط إدارة تدفقات عمل التعلم الآلي في الحاويات (ML) باستخدام Kubernetes. إنه يزيل التعقيد عند نشر خطوط أنابيب ML من خلال توزيع الموارد بكفاءة عبر البيئات السحابية. يضمن هذا الأسلوب التوسع السلس والأداء المتسق، بغض النظر عن حجم النشر.

تم تصميم Flyte للتعامل مع تدفقات عمل ML على أي نطاق، وتخصيص الموارد ديناميكيًا لتلبية المتطلبات المختلفة. تضمن بنيتها القوية إدارة أعباء العمل بكفاءة، مما يجعلها خيارًا موثوقًا لمجموعة واسعة من مهام التعلم الآلي عبر البنى التحتية القائمة على السحابة.

Prefect عبارة عن منصة تنسيق قائمة على Python مصممة لتسهيل إدارة خطوط أنابيب البيانات المعقدة وسير عمل التعلم الآلي. وهو يركز على سهولة الاستخدام والمراقبة الواضحة وتقليل العقبات التشغيلية، مما يسمح لعلماء البيانات والمهندسين بالتركيز على إنشاء عمليات سير العمل بدلاً من القلق بشأن البنية التحتية.

يتألق Prefect في التشغيل الآلي لخطوط أنابيب التعلم الآلي وسير العمل السحابي وعمليات تحويل البيانات. إنه مناسب بشكل خاص للتعامل مع مهام ETL وعمليات سير عمل التعلم الآلي المعقدة التي تتضمن تبعيات متعددة وعمليات تنفيذ متوازية ومعالجة في الوقت الفعلي. يتيح نظام الجدولة المرن الخاص به تشغيل المهام بناءً على فترات زمنية أو أحداث محددة أو مكالمات API، مما يجعلها قابلة للتكيف مع مجموعة متنوعة من احتياجات الأتمتة.

تم تحسين Prefect لبيئات السحابة، مما يضمن قدرتها على التوسع والتكيف مع متطلبات البنية التحتية الحديثة. تم تصميمه محليًا في Python، وهو يتكامل بسلاسة مع النظم البيئية للبيانات المستندة إلى Python، مما يلغي الحاجة إلى تعلم لغات أو أدوات برمجة جديدة.

يوفر Prefect توافقًا سلسًا مع مجموعة واسعة من أدوات البيانات والأنظمة الأساسية. يتكامل بسهولة مع الأدوات الشائعة مثل دين، نظام إدارة البيانات، ندفة الثلج، و المتفرج، مع دعم أنظمة الوقت الفعلي مثل أباتشي كافكا. بالنسبة للبيئات السحابية، فهي تعمل مع مزودي خدمات رئيسيين مثل خدمات أمازون ويب (القوانين)، منصة جوجل كلاود (GCP)، و ميكروسوفت أزور، مما يمنح الفرق المرونة اللازمة لتحسين أعباء العمل استنادًا إلى التكلفة والأداء. بالإضافة إلى ذلك، يدعم Prefect أدوات النقل بالحاويات مثل عامل ميناء و Kubernetes ويعمل مع أطر المعالجة الموزعة مثل داسك و أباتشي سبارك. لإبقاء الفرق على اطلاع، فإنه يوفر أيضًا إشعارات Slack لتحديثات سير العمل.

تم تصميم Prefect للتعامل مع أحجام البيانات المتزايدة وزيادة تعقيد سير العمل بسهولة. يضمن محركها الذي يتحمل الأخطاء أن عمليات سير العمل يمكن أن تتعافى من الأخطاء عن طريق إعادة محاولة المهام الفاشلة أو تجاوز المشكلات، مما يجعلها موثوقة للغاية في بيئات الإنتاج. توفر المراقبة في الوقت الفعلي رؤى تفصيلية حول تنفيذ سير العمل، مما يساعد الفرق على تحديد المشكلات وحلها بسرعة. بفضل قدرتها على التوسع بكفاءة، تثق شركات التكنولوجيا الكبرى في Prefect لإدارة تدفقات العمل الديناميكية. بالنسبة للفرق التي بدأت للتو، تقدم Prefect خطة مجانية، بينما تتوفر الأسعار المخصصة لعمليات النشر الأكبر التي تتطلب ميزات إضافية ودعمًا.

Metaflow عبارة عن منصة بنية تحتية للتعلم الآلي تم تطويرها في البداية بواسطة نيتفليكس لمواجهة تحديات توسيع نطاق سير عمل التعلم الآلي. وهي تركز على جعل العمليات سهلة الاستخدام وفعالة، مما يساعد علماء البيانات على الانتقال بسلاسة من النماذج الأولية إلى الإنتاج دون التعامل مع البنية التحتية المعقدة.

تم تصميم Metaflow لإدارة عمليات سير عمل التعلم الآلي القابلة للتطوير على مستوى الإنتاج. إنه يبسط الرحلة من تحليل البيانات الاستكشافية والتدريب النموذجي إلى النشر. يمكن لعلماء البيانات كتابة عمليات سير العمل في Python باستخدام مكتبات مألوفة، بينما تهتم المنصة بالإصدار وإدارة التبعية وتخصيص موارد الحوسبة تلقائيًا.

تزيل المنصة الحاجة إلى إدارة البنية التحتية اليدوية من خلال توفير موارد الحوسبة المطلوبة تلقائيًا. يتيح ذلك الانتقال السلس من التطوير المحلي إلى الإنتاج السحابي دون الحاجة إلى أي تعديلات على التعليمات البرمجية.

«تنظم Metaflow عمليات سير عمل ML القابلة للتطوير مع البساطة من خلال تقديم عمليات تكامل سحابية مبسطة وإصدار قوي وتجريد البنية التحتية للنشر الجاهز للإنتاج.» - Akka.io

تُستكمل عملية نشر Metaflow بقدرتها على الاندماج بسهولة مع الخدمات السحابية ومنصات البيانات. يضمن تصميمها الأصلي بلغة Python التوافق مع المكتبات المستخدمة على نطاق واسع للتعلم الآلي ومعالجة البيانات والتصور، مما يسمح للفرق بتعظيم الأدوات التي يعتمدون عليها بالفعل.

تم إنشاء Metaflow في الأصل بواسطة Netflix لدعم عمليات التعلم الآلي المكثفة، ويتميز بنظام إصدار قوي. يتتبع هذا النظام التجارب ومجموعات البيانات وإصدارات النماذج، مما يضمن إمكانية تكرار التجارب وتمكين عمليات التراجع السهلة عند الحاجة.

يضيف Dagster إلى مجموعة أطر التنسيق من خلال التركيز على الحفاظ على سلامة البيانات مع تقديم إدارة خطوط الأنابيب القابلة للتكيف. تم تصميم هذه الأداة مفتوحة المصدر لتحسين الجودة وتتبع نسب البيانات وضمان الرؤية في عمليات سير عمل التعلم الآلي (ML). تتخصص Dagster في جوهرها في بناء خطوط بيانات موثوقة وآمنة من النوع تدعم المعايير العالية لسلامة البيانات وتوفر رؤى واضحة للتحولات.

تعتبر Dagster فعالة بشكل خاص لإدارة عمليات سير عمل ML حيث تكون جودة البيانات ودقتها غير قابلة للتفاوض. تم تصميمه للفرق التي تحتاج إلى التحقق المدمج وتتبع البيانات الوصفية القوي والمراقبة الشاملة طوال عملياتها. يمكن رؤية مثال عملي على فائدتها في قطاع الرعاية الصحية، حيث تعتمد المنظمات على Dagster لمعالجة بيانات الرعاية الصحية الحساسة بمستوى النزاهة المطلوب لتلبية معايير الامتثال الصارمة والجودة.

يمكّن Dagster المطورين من تحديد عمليات سير العمل المعقدة مباشرةً في التعليمات البرمجية، وهي ميزة أساسية لتوسيع نطاق عمليات الذكاء الاصطناعي. يدعم هيكلها المعياري نماذج التسلسل والوكلاء لإنشاء تدفقات عمل متقدمة، كاملة مع إدارة التبعية الآلية وآليات إعادة المحاولة والتنفيذ المتوازي. بالإضافة إلى ذلك، تتكامل Dagster بسلاسة مع العديد من المنصات السحابية وواجهات برمجة التطبيقات وقواعد البيانات المتجهة، مما يجعلها مناسبة تمامًا للتعامل مع البيانات واسعة النطاق ومهام الذكاء الاصطناعي.

تضمن هذه البنية المرنة التكامل السلس مع الأنظمة المتنوعة.

تكمن قوة Dagster الحقيقية في قدرتها على إدارة ومراقبة البيانات التي تتدفق بين الأنظمة المترابطة. فهو يتتبع بدقة كل عملية تحويل للبيانات، مما يوفر للفرق الدقة التي تحتاجها. تختار العديد من الفرق الفنية Dagster لإنشاء مكدسات MLOPs مخصصة أو تنفيذ طبقات تحكم مفصلة لتطبيقات نماذج اللغة الكبيرة (LLM). تسمح شفافيتها وقدرتها على التكيف للمؤسسات بإنشاء أنظمة ذكاء اصطناعي خاصة وتجربة أحدث التقنيات، كل ذلك مع الحفاظ على التحكم في جودة البيانات وأداء خطوط الأنابيب.

يؤكد إطار حوكمة Dagster على نسب البيانات وضمان الجودة. تقوم أدواته المدمجة بالتقاط الأخطاء ومعالجتها في كل مرحلة من مراحل خط الأنابيب، مما يقلل من مخاطر انتشار البيانات السيئة عبر النظام. من خلال إعطاء الأولوية لدقة البيانات وإمكانية التتبع، تساعد Dagster الفرق على ضمان تلبية بياناتها للمعايير المطلوبة قبل وصولها إلى الإنتاج، ودعم جهود الامتثال بسجلات واضحة وموثوقة.

يعد التصميم المعياري لـ Dagster مثاليًا لإدارة تدفقات عمل الذكاء الاصطناعي المعقدة في إعدادات واسعة النطاق. إنه يتعامل تلقائيًا مع التبعيات وعمليات إعادة المحاولة والتنفيذ المتوازي، مما يبسط تنسيق أنظمة الذكاء الاصطناعي المتقدمة. وهذا يجعله خيارًا يمكن الاعتماد عليه للمؤسسات التي تحتاج إلى منطق تنسيق مخصص لدعم عمليات الذكاء الاصطناعي المتطورة.

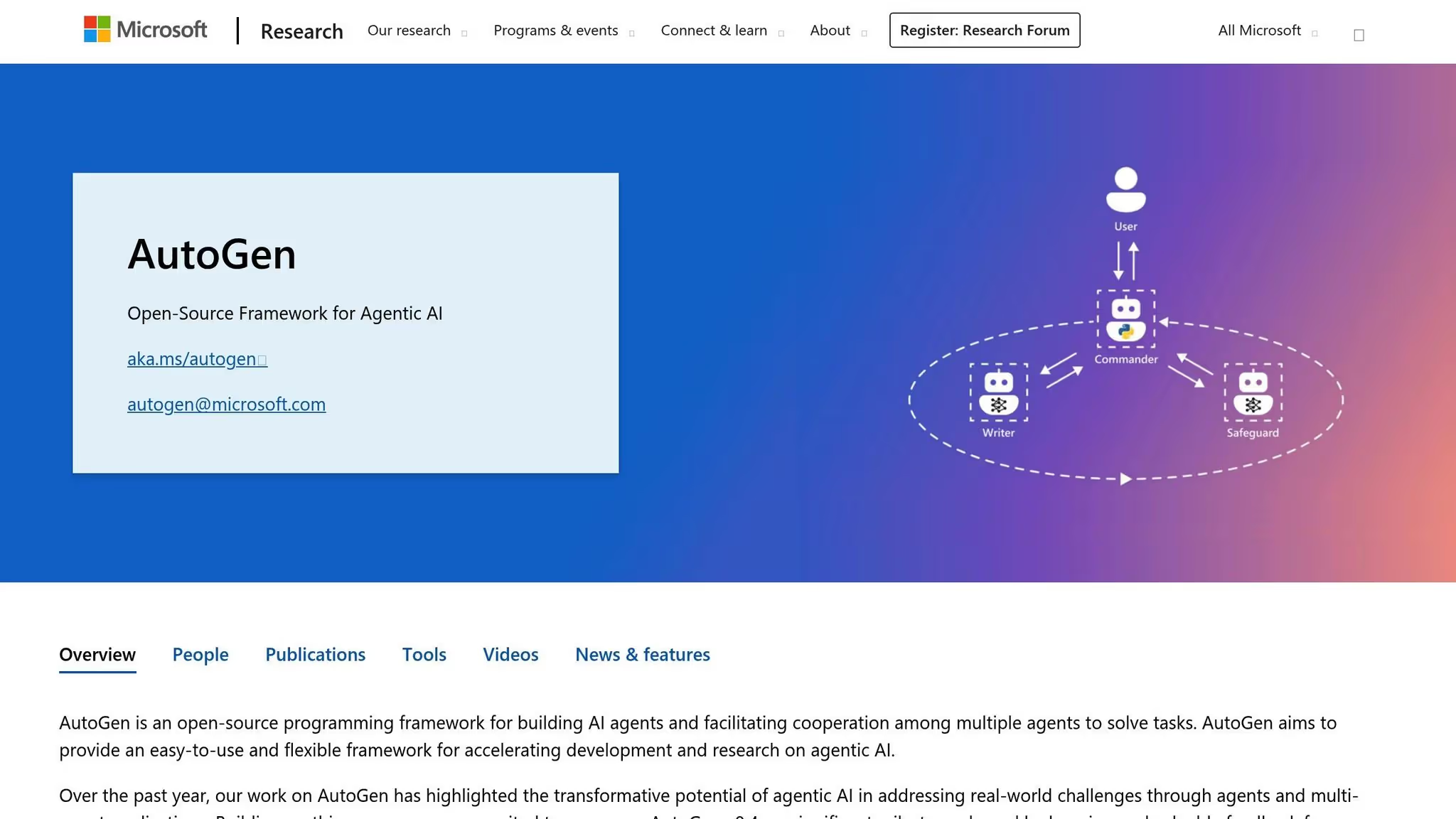

Microsoft AutoGen هو إطار مفتوح المصدر تم تطويره بواسطة أبحاث مايكروسوفت يمكّن العديد من وكلاء الذكاء الاصطناعي من التعاون من خلال المحادثة لمعالجة المهام المعقدة. يسمح هذا النظام للمطورين بإنشاء تطبيقات حيث يعمل الوكلاء المتخصصون معًا، ويساهم كل منهم بخبرته الفريدة لتحقيق الأهداف المشتركة. من خلال تقديم واجهة محادثة، يبسط AutoGen العملية المعقدة غالبًا لتنسيق مكونات الذكاء الاصطناعي المتعددة.

تقدم AutoGen نهجًا جديدًا للتنسيق متعدد الوكلاء من خلال الاستفادة من الحوار كوسيلة للتعاون. هذا الإطار فعال بشكل خاص في سيناريوهات حل المشكلات التي تتطلب وكلاء متعددين للعمل معًا بشكل ديناميكي. على سبيل المثال، في تطوير البرامج، قد يقوم أحد الوكلاء بإنشاء كود بينما يركز آخر على الاختبار والتحقق من الصحة، مع تكرار كلا الوكلاء لتحسين المخرجات. يعد نموذج المحادثة هذا مناسبًا بشكل طبيعي لمهام مثل أتمتة سير عمل البرامج، والمساعدة في البحث، والتعامل مع عمليات صنع القرار المعقدة حيث تعمل وجهات النظر أو المهارات المتنوعة على تحسين النتائج.

الفرق التي تهدف إلى تحسين تكراري في عمليات سير العمل الخاصة بهم يجدون AutoGen جذابًا بشكل خاص. تعكس قدرتها على تسهيل التبادلات ذهابًا وإيابًا بين الوكلاء التعاون البشري، مما يسهل على المطورين تصميم أنظمة تتطور وتتحسن من خلال الحوار المستمر والتغذية الراجعة.

يؤكد AutoGen على الوحدات النمطية بينما يتميز بتصميم وكيل المحادثة الخاص به. يعمل كل وكيل بأدوار وإرشادات محددة، والتي يمكن أن تتضمن الوصول إلى الأدوات أو واجهات برمجة التطبيقات الخارجية أو نماذج اللغة. يدعم إطار العمل كلاً من الوكلاء المستقلين ووكلاء وكيل المستخدم الذين يدمجون المدخلات البشرية، مما يوفر المرونة في إدارة سير العمل.

يمكن تشغيل النظام محليًا أثناء التطوير والتوسع إلى البيئات السحابية للإنتاج. يمكن للمطورين تحديد كيفية تفاعل الوكلاء - سواء من خلال عمليات سير العمل المتسلسلة حيث يتناوب الوكلاء أو الأنماط الأكثر تعقيدًا حيث يساهم العديد من الوكلاء في وقت واحد. باستخدام التكوينات المستندة إلى Python، تكتسب الفرق التحكم الكامل في منطق التنسيق دون التضحية بقابلية القراءة، مما يبسط عملية إدارة التفاعلات متعددة الوكلاء.

يتعامل AutoGen مع تعقيدات إدارة مكالمات النماذج المتعددة ومحادثات الوكلاء، مما يسمح للمطورين بالتركيز على صياغة منطق وسلوك أنظمتهم بدلاً من القلق بشأن البنية التحتية.

يتكامل AutoGen بسلاسة مع خدمة أزور أوبن إيه آي ونماذج أخرى عبر مكالمات الوظائف، مما يمنح المطورين المرونة في اختيار الخلفيات الخلفية للذكاء الاصطناعي. كما أنه يدعم ربط الوكلاء بالأدوات والخدمات الخارجية، مما يمكنهم من استرداد البيانات أو تنفيذ التعليمات البرمجية أو التفاعل مع واجهات برمجة التطبيقات التابعة لجهات خارجية أثناء محادثاتهم.

يسمح الإطار للمطورين بإنشاء أنواع وكلاء مخصصة وأنماط محادثة قابلة لإعادة الاستخدام وقوالب التنسيق. تعني هذه المرونة أن الفرق يمكنها الاستفادة من الأنماط الموجودة مسبقًا للمهام الشائعة مع التخصيص العميق للاحتياجات المتخصصة.

بالنسبة للمؤسسات التي تستخدم أدوات Microsoft بالفعل، يوفر AutoGen تكاملاً سهلاً مع خدمات Azure، كود فيسوال ستوديو، ومنصات التطوير الأخرى. على الرغم من هذا التوافق مع نظام Microsoft البيئي، فإن إطار العمل لا يعتمد على النظام الأساسي ويعمل بشكل جيد في مجموعة متنوعة من بيئات التكنولوجيا.

يركز AutoGen بشدة على قدرات وكيل التحكم وإدارة الوصول إلى الموارد الخارجية. يحدد المطورون أذونات محددة لكل وكيل، مثل واجهات برمجة التطبيقات التي يمكنهم الوصول إليها أو البيانات المسموح لهم باستردادها. يضمن هذا النهج الدقيق أن يعمل الوكلاء وفقًا لمبادئ أقل الامتيازات، ويؤدون فقط المهام اللازمة لأدوارهم.

وتؤدي الطبيعة التحادثية للإطار بطبيعتها إلى إنشاء مسارات التدقيق وتسجيل تفاعلات الوكلاء وعمليات صنع القرار. توفر هذه السجلات الشفافية في كيفية إنشاء المخرجات، مما يساعد في جهود الامتثال وتصحيح الأخطاء. يمكن للفرق مراجعة هذه السجلات لتحليل سلوك الوكيل وتحديد مجالات التحسين.

تعمل قدرات Human-in-the-Loop على تعزيز الإشراف من خلال السماح لعمليات سير العمل بالتوقف مؤقتًا للمراجعة البشرية في نقاط القرار الحرجة. تضمن هذه الميزة إمكانية تقييم الإجراءات الحساسة قبل المتابعة، وتحقيق التوازن بين كفاءة الأتمتة والحوكمة والتحكم.

تعتمد قابلية تطوير AutoGen بشكل كبير على نماذج اللغة الأساسية والبنية التحتية التي تدعم الوكلاء. يقدم الإطار نفسه الحد الأدنى من النفقات العامة، حيث يتأثر الأداء بشكل أساسي بأوقات استدلال النموذج ووقت استجابة استدعاء API. بالنسبة لعمليات سير العمل التي تتضمن عمليات تبادل وكلاء متسلسلة متعددة، يتراكم وقت التنفيذ الإجمالي عبر هذه التفاعلات.

يمكن للمؤسسات تحسين الأداء من خلال سياق المحادثة في التخزين المؤقت، واستخدام نماذج أسرع للمهام الروتينية، وحجز نماذج أكثر تقدمًا للتفكير المعقد. كما أن تصميم أنماط المحادثة لتقليل التبادلات غير الضرورية يعزز الكفاءة. عند الاقتضاء، يدعم الإطار تنفيذ الوكيل المتوازي، مما يتيح تشغيل المهام المستقلة في وقت واحد بدلاً من التسلسل.

للتعامل مع أعباء العمل المرتفعة، يمكن نشر AutoGen على البنية التحتية السحابية القابلة للتوسعة التلقائية، مما يضمن قدرة النظام على إدارة الطلبات المختلفة مع الحفاظ على التكاليف تحت السيطرة. تعمل تفاعلات العوامل عديمة الجنسية على تبسيط التوسع الأفقي، على الرغم من أن الحفاظ على السياق عبر التبادلات يتطلب تخطيطًا معماريًا مدروسًا.

بناءً على أطر التنسيق التي استكشفناها، تقدم SuperAGI طريقة جديدة لإدارة التعاون متعدد الوكلاء. تم تصميم هذه المنصة مفتوحة المصدر لتنسيق وكلاء الذكاء الاصطناعي المستقلين، وتمكين المطورين من إنشاء ونشر والإشراف على وكلاء يمكنهم التخطيط للمهام وتنفيذها والتكيف معها من خلال التعلم المستمر. يمكّن SuperAgi العديد من الوكلاء من العمل معًا بسلاسة وتفويض المهام بشكل ديناميكي والتعاون لمواجهة التحديات المعقدة. فهي تدمج إدارة المهام التكيفية مع العمل الجماعي متعدد الوكلاء، مما يميزها كأداة قوية للتنسيق المتقدم للذكاء الاصطناعي.

تتفوق SuperAgi في أتمتة المهام المعقدة والمتطورة للمؤسسات. تتفوق شبكات الوكلاء التابعة لها في التخطيط المتقدم للمهام وتنفيذها، وتتحسن باستمرار من خلال التعلم المعزز وحلقات التغذية الراجعة. وهذا يجعلها مفيدة بشكل خاص للمؤسسات التي تتعامل مع العمليات واسعة النطاق، حيث يكون التنسيق الذكي هو المفتاح. يتعلم الوكلاء داخل المنصة من تفاعلاتهم ونتائجهم، مما يسمح لهم بتحسين سلوكهم بمرور الوقت.

الميزة البارزة للمنصة هي تفويض المهام الديناميكي. بدلاً من الالتزام بعمليات سير العمل الصارمة، يقوم الوكلاء بتقييم المواقف في الوقت الفعلي، وتحديد المهام ذات الأولوية، وتعيينها لأعضاء الشبكة الأكثر ملاءمة. تضمن هذه المرونة تخصيص الموارد بكفاءة، حتى في السيناريوهات المعقدة.

تم تصميم بنية SuperAgi مع قابلية التوسع والنمطية في جوهرها. يمكن للمطورين توسيع شبكات الوكلاء وأحمال العمل بسهولة لتلبية مجموعة متنوعة من احتياجات التطبيقات. يعمل كل وكيل بشكل مستقل، ومع ذلك يتواصل بسلاسة، مما يضمن التعاون السلس.

تسمح الواجهة الرسومية سهلة الاستخدام للفرق بتصور تفاعلات الوكلاء وضبط التكوينات. توفر لوحات معلومات المراقبة رؤى حول أداء الوكيل، مما يساعد المطورين على تحديد أوجه القصور ومعالجتها. تدعم المنصة أيضًا التنفيذ المتوازي، مما يتيح للعديد من الوكلاء التعامل مع المهام المستقلة في وقت واحد. يعزز هذا التصميم الإنتاجية بشكل كبير، خاصة في البيئات عالية الطلب.

يتميز SuperAgi بنظام مكون إضافي قابل للتوسيع يتكامل مع واجهات برمجة التطبيقات التابعة لجهات خارجية وأدوات سير العمل والوحدات المخصصة. تعمل هذه المرونة على تسريع عملية التطوير وتشجيع المساهمات من مجتمع المطورين الأوسع، مما يثري قدرات المنصة.

تدعم البنية المعيارية الموزعة للمنصة التحجيم الأفقي، مما يجعلها قابلة للتكيف مع التطبيقات واسعة النطاق. إن استخدامها للتعلم المعزز وحلقات التغذية الراجعة يعزز الأداء العام، مما يضمن تخصيص المهام بكفاءة. من خلال تمكين التعاون الفعال والإنتاجية العالية، يعد SuperAgi مناسبًا تمامًا للمؤسسات التي تتطلب أداءً قويًا في السيناريوهات المعقدة ذات الحجم الكبير.

اختيار إطار تنسيق الذكاء الاصطناعي الصحيح يعني فهم نقاط القوة والقيود لكل خيار. تم تصميم هذه المنصات مع وضع أولويات مختلفة في الاعتبار، حيث تلبي احتياجات مثل الأمان على مستوى المؤسسة، أو قدرة المطور على التكيف، أو عمليات سير العمل المتخصصة مثل خطوط أنابيب التعلم الآلي. يعكس كل إطار فلسفة التصميم الفريدة وحالات الاستخدام المستهدفة.

على سبيل المثال، منصات مثل Prompts.ai تتفوق في الوصول المركزي إلى نماذج اللغات الكبيرة (LLMs)، في حين أن الأدوات مثل تدفق هواء أباتشي و حاكم التركيز على التشغيل الآلي لسير العمل العام. من ناحية أخرى، كيوبيفلو و فلايت مصممة خصيصًا لخطوط أنابيب التعلم الآلي وأطر مثل سوبيراجي و ميكروسوفت أوتوجين دفع حدود التعاون في مجال الذكاء الاصطناعي متعدد الوكلاء من خلال تمكين الأنظمة الذاتية من التعامل مع المهام المعقدة معًا.

يعود القرار في النهاية إلى الاحتياجات المحددة لمؤسستك. ستكون لدى الشركة الناشئة التي تبني أول تطبيق للذكاء الاصطناعي متطلبات مختلفة جدًا مقارنة بمؤسسة كبيرة تدير مئات عمليات سير العمل. تلعب عوامل مثل الميزانية وخبرة الفريق والبنية التحتية الحالية دورًا. أدناه، يوضح الجدول المقايضات الرئيسية لبعض الأطر الأكثر شيوعًا:

هياكل التكلفة: غالبًا ما تتقاضى المنصات التقليدية رسومًا لكل مستخدم أو تنفيذ، مما قد يؤدي إلى ارتفاع التكاليف مع نمو العمليات. في المقابل، Prompts.ai يستخدم نموذج الدفع أولاً بأول مع أرصدة TOKN، ويربط النفقات مباشرة بالاستخدام. هذا النهج مفيد بشكل خاص عند تجربة نماذج مختلفة أو إدارة أعباء العمل المتقلبة.

الأمان والامتثال: بالنسبة لصناعات مثل الرعاية الصحية أو التمويل، تعد التدابير الأمنية القوية ضرورية. منصات مثل Prompts.ai، أوركسترا آي بي إم واتسون، و حاكم توفير أدوات الامتثال المضمنة مثل مسارات التدقيق وعناصر التحكم في الوصول القائمة على الأدوار. خيارات مفتوحة المصدر مثل تدفق هواء أباتشيومع ذلك، تتطلب تكوينًا إضافيًا لتلبية معايير الامتثال الصارمة.

منحنى التعلم: تختلف قابلية الاستخدام على نطاق واسع. منصات مثل حاكم و داجستر أكثر ملاءمة للمبتدئين، حيث تقدم واجهات برمجة تطبيقات Python سهلة الاستخدام ورسائل خطأ مفيدة. وفي الوقت نفسه، تدفق هواء أباتشي و كيوبيفلو تتطلب خبرة فنية أعمق ومهارات إدارة البنية التحتية. Prompts.ai يبسط هذا الأمر بشكل أكبر من خلال واجهة موحدة توازن بين سهولة الاستخدام والميزات المتقدمة للمستخدمين المحترفين.

دعم المجتمع: يمكن أن يؤثر حجم ومشاركة مجتمع المنصة بشكل كبير على تجربتك. تدفق هواء أباتشي يستفيد من قاعدة مستخدمين ضخمة، مما يضمن توفر الكثير من الموارد والحلول بسهولة. منصات أحدث مثل فلايت و داجستر لديك مجتمعات أصغر ولكنها نشطة، على الرغم من أنك قد تواجه سيناريوهات أقل توثيقًا.

النظام البيئي للتكامل: يعد التكامل السلس مع الأدوات الحالية أمرًا بالغ الأهمية. تدفق هواء أباتشي العملاء المحتملين بمئات المكونات الإضافية للخدمات السحابية وقواعد البيانات وأدوات المراقبة. Prompts.ai، من ناحية أخرى، يركز بشكل خاص على LLMs، مما يوفر وصولاً مبسطًا إلى عشرات النماذج عبر واجهة برمجة تطبيقات واحدة.

قابلية التوسع: منصات مثل كيوبيفلو و فلايت تم تصميمها للتوسع الأفقي، والاستفادة من Kubernetes لتوزيع عبء العمل. ميتافلو يستخدم خدمات AWS للتوسع المرن، بينما حاكم يدعم كلاً من خيارات التحجيم المُدارة عبر السحابة والمستضافة ذاتيًا. سوبيراجي يستخدم بنية الوكيل الموزع، مما يتيح التنفيذ المتوازي، على الرغم من أن هذا يتطلب تنسيقًا دقيقًا.

يعتمد أفضل إطار لك على عمليات سير العمل المحددة. لتنسيق LLM، Prompts.ai تتميز بإمكانية الوصول إلى النموذج المركزي وكفاءة التكلفة. قد تميل فرق هندسة البيانات نحو موثوقية تدفق هواء أباتشي، في حين أن فرق تعلم الآلة التي تعمل على التدريب والنشر على نطاق واسع يمكن أن تستفيد من كيوبيفلو أو فلايت. إذا كان تركيزك على بناء أنظمة الذكاء الاصطناعي المستقلة، سوبيراجي أو ميكروسوفت أوتوجين قد يكون مناسبًا تمامًا.

لا يتعلق اختيار إطار تنسيق الذكاء الاصطناعي بإيجاد حل عالمي - بل يتعلق بمواءمة نقاط قوة الإطار مع سير العمل في مؤسستك والمهارات التقنية والأهداف طويلة المدى. يلبي كل إطار من الأطر التي تمت مناقشتها هنا الاحتياجات المختلفة، بدءًا من التشغيل الآلي لسير العمل إلى إدارة خطوط أنابيب التعلم الآلي أو تمكين التعاون متعدد الوكلاء.

على سبيل المثال، قد تجد الفرق التي تعطي الأولوية لتنسيق LLM أن Prompts.ai جذابة بشكل خاص. يوفر وصولاً مركزيًا إلى أكثر من 35 طرازًا، مثل GPT-5 و Claude و Gemini، كل ذلك من خلال واجهة موحدة. يزيل نظام TOKN الائتماني للدفع أولاً بأول رسوم الاشتراك مع تقديم تتبع التكلفة في الوقت الفعلي. بفضل ميزات مثل عناصر التحكم في الوصول القائمة على الأدوار ومسارات التدقيق، يعد Prompts.ai خيارًا قويًا للصناعات التي تتطلب حوكمة صارمة دون المساس بالسرعة.

قد تنجذب فرق هندسة البيانات التي تعمل مع خطوط أنابيب ETL المعقدة نحو Apache Airflow بسبب نظامها البيئي القوي للمكونات الإضافية وقابلية التوسع، على الرغم من أنها تتطلب المزيد من الخبرة المتقدمة. من ناحية أخرى، تقدم Prefect نهجًا أصليًا بلغة Python مع معالجة الأخطاء سهلة الاستخدام، مما يجعلها خيارًا ممتازًا لإعداد الفريق بشكل أسرع.

بالنسبة لممارسي التعلم الآلي، تتألق أطر مثل Kubeflow و Flyte في التعامل مع مهام التدريب والنشر واسعة النطاق. يدعم تصميم Kubernetes الأصلي من Kubeflow الحوسبة الموزعة، بينما يوفر Flyte إصدارًا متقدمًا وعمليات سير عمل آمنة من النوع. ومع ذلك، يتطلب كلاهما معرفة كبيرة بالبنية التحتية. بالنسبة للفرق المستثمرة بالفعل في AWS، تقدم Metaflow بديلاً أبسط مصممًا خصيصًا لسير عمل علوم البيانات.

قد تنظر المؤسسات التي تستكشف أنظمة الذكاء الاصطناعي المستقلة في Microsoft AutoGen لميزات التعاون متعددة الوكلاء أو SuperAGI لتفويض المهام الديناميكي. هذه الأدوات مثالية للبحث أو حالات الاستخدام المتخصصة ولكنها تتطلب غالبًا مهارات ترميز متقدمة، مما يجعلها أقل ملاءمة لاحتياجات الإنتاج الفورية.

في نهاية المطاف، يتضمن اختيار الإطار الصحيح تقييم عوامل مثل الوحدات النمطية وقابلية التوسعة وقابلية الملاحظة وميزات الحوكمة مثل ضوابط الوصول القائمة على الأدوار وشهادات الامتثال. تتسم مرونة النشر والتكامل مع الأدوات الموجودة بنفس القدر من الأهمية. بالإضافة إلى الوظائف، ضع في اعتبارك تجربة المطور، بما في ذلك حزم SDK والوثائق والتكلفة الإجمالية للملكية. إن تعقيد عمليات سير العمل - سواء كانت مهام بسيطة أحادية الوكيل أو أنظمة معقدة متعددة الوكلاء ذات ذاكرة ثابتة - يجب أن يوجه قرارك أيضًا.

تتجه الصناعة نحو أنظمة الذكاء الاصطناعي القابلة للتطوير والمتكاملة، مع أطر مفتوحة المصدر تقود غالبية أعباء العمل في المؤسسة بينما تعمل أوقات التشغيل التي يديرها الموردون على تبسيط التحديات التشغيلية.

ابدأ بتحديد حالة الاستخدام المحددة الخاصة بك، سواء كانت تتضمن LLMs أو خطوط أنابيب البيانات أو عمليات سير عمل التدريب على التعلم الآلي. قم بتقييم الخبرة الفنية لفريقك والبنية التحتية الحالية. يمكن أن يساعد إجراء تجارب إثبات المفهوم مع أطر عمل محددة في تحديد الحلول التي تقلل التعقيد، مما يمكّن فريقك من التركيز على قيادة الابتكار.

عند اختيار إطار تنسيق الذكاء الاصطناعي، من الضروري التفكير في مدى تكامله مع أدواتك وأنظمتك الحالية. إطار قوي قدرات التكامل يضمن أن كل شيء يعمل معًا دون تعقيدات غير ضرورية.

انتبه إلى ذلك ميزات التشغيل الآلي، مثل جدولة سير العمل وإدارة المهام، حيث يمكن لهذه الإجراءات تبسيط العمليات وتوفير الوقت. بنفس القدر من الأهمية هي الأمن والحوكمة التدابير التي تحمي البيانات الحساسة وتساعدك على البقاء متوافقًا مع اللوائح.

اختر إطارًا يقدم النمطية وقابلية التوسع، حتى تتمكن من النمو والتكيف جنبًا إلى جنب مع متطلباتك المتطورة. أخيرًا، حدد أولويات الحل البديهي والمتوافق مع مستوى المهارة الفنية لفريقك، مما يجعل الإعداد والاستخدام اليومي أمرًا سهلاً.

يبسط Prompts.ai التحدي المتمثل في التوفيق بين أدوات الذكاء الاصطناعي المتعددة من خلال الجمع بين أكثر من 35 نموذجًا لغويًا كبيرًا داخل منصة موحدة. باستخدام هذا الإعداد، يمكن للمستخدمين مقارنة النماذج جنبًا إلى جنب بسهولة مع الاحتفاظ بالإشراف الكامل على سير العمل السريع وجودة المخرجات والأداء العام.

إضافة إلى كفاءتها، تتميز Prompts.ai بطبقة FinOps متكاملة مصممة لتحسين التكاليف. توفر هذه الأداة رؤى في الوقت الفعلي حول الاستخدام والإنفاق وعائد الاستثمار (ROI)، مما يمكّن المؤسسات من إدارة مواردها بفعالية وتحقيق أقصى استفادة من ميزانيات الذكاء الاصطناعي الخاصة بها.

يعطي Prompts.ai الأولوية الأمان والتوافق على مستوى المؤسسة، بما يتماشى مع معايير الصناعة مثل SOC 2 من النوع الثاني، هيبا، و GDPR لحماية بياناتك في كل مرحلة.

لدعم المراقبة المستمرة والامتثال، تتعاون Prompts.ai مع Vanta وبدأت عملية تدقيق SOC 2 من النوع الثاني في 19 يونيو 2025. تضمن هذه الخطوات بقاء عمليات سير العمل الخاصة بك آمنة ومتوافقة ويمكن الاعتماد عليها لعمليات المؤسسة.