Les flux de travail d'IA peuvent être rationalisés, sécurisés et rentables avec les bons outils. Ce guide présente dix plateformes conçues pour optimiser les flux de travail des modèles d'IA, de l'orchestration au déploiement. Chaque outil répond à des défis tels que la fragmentation des outils, la hausse des coûts et les risques de sécurité, en proposant des solutions aux équipes qui souhaitent faire évoluer efficacement les systèmes d'IA.

Explorez ces plateformes pour trouver la solution la mieux adaptée aux besoins de votre équipe, qu'il s'agisse de dimensionner les flux de travail, de gérer les coûts ou de garantir la conformité.

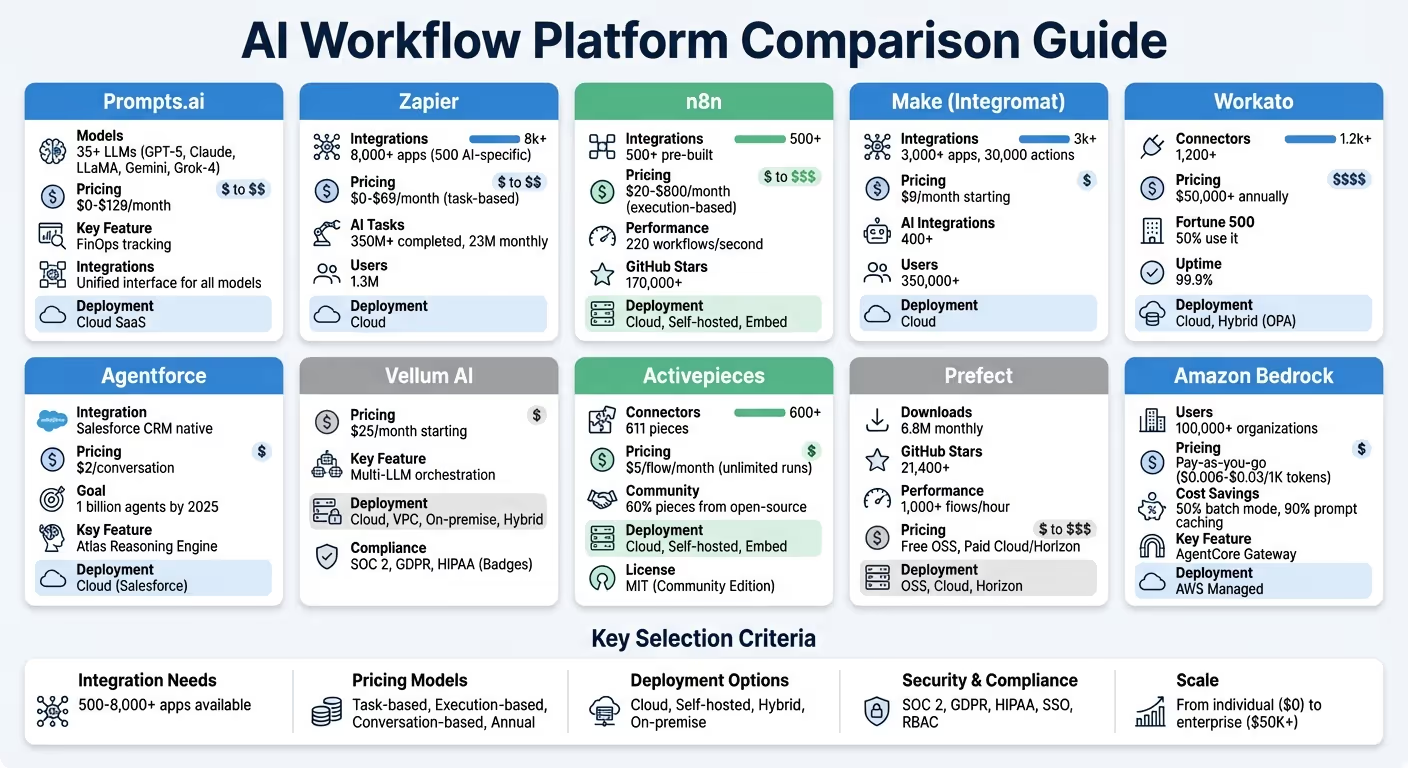

Comparaison des plateformes de flux de travail IA : fonctionnalités, prix et capacités d'intégration

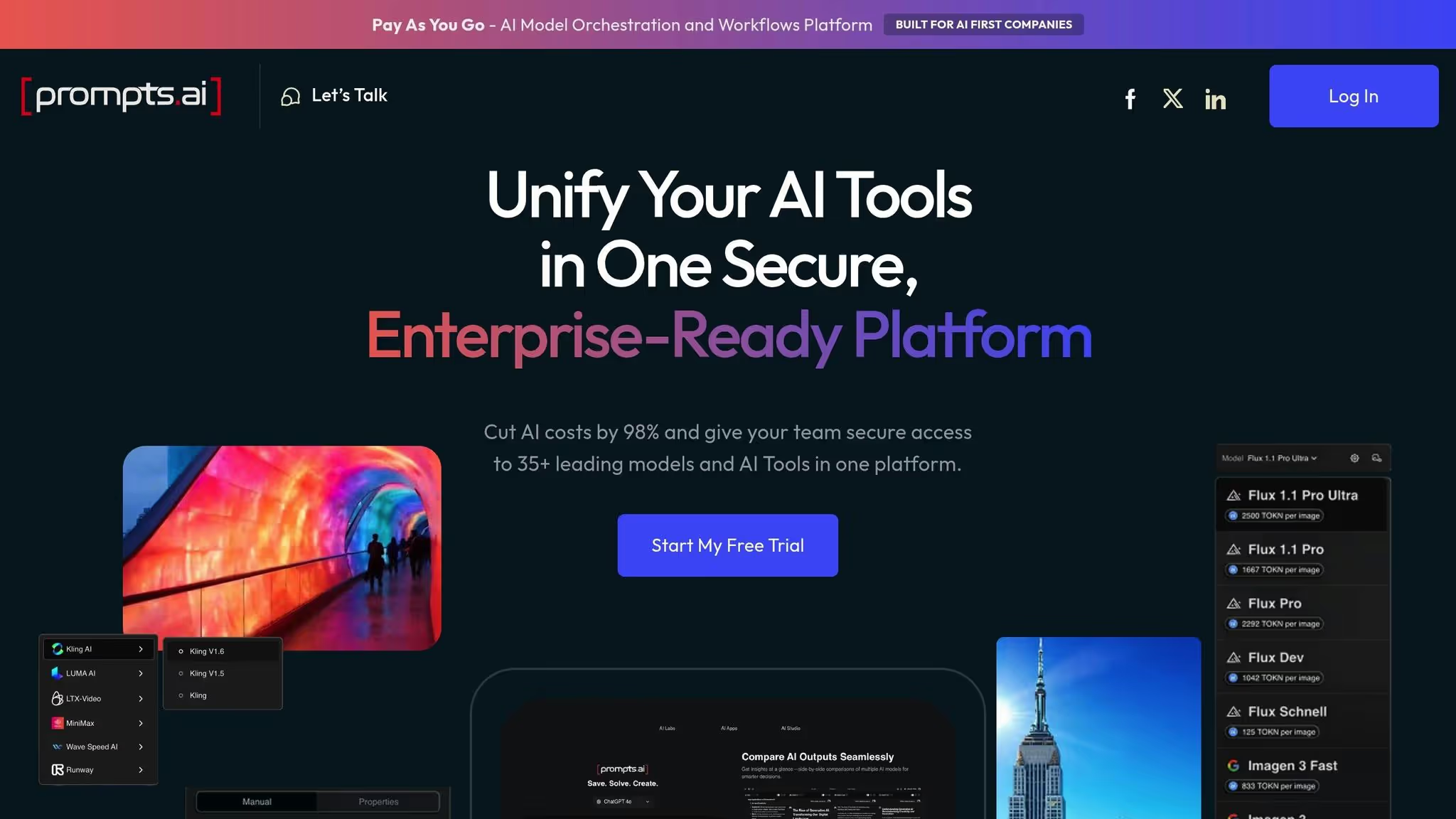

Prompts.ai constitue une puissante plateforme d'orchestration d'IA, réunissant plus de 35 grands modèles de langage (LLM) de premier plan, dont GPT‑5, Claude, LLama, Gemini, Grok‑4, Flux Pro et Kling, au sein d'une interface unique et sécurisée. En consolidant l'accès à ces modèles, la plateforme aide les organisations à éliminer le chaos lié à la jonglerie entre plusieurs outils et rationalise les flux de travail liés à l'IA pour une plus grande efficacité. Cette solution tout-en-un ouvre également la voie à une intégration fluide entre différents systèmes.

Prompts.ai connecte un large éventail d'utilisateurs, des entreprises du Fortune 500 aux agences de création et aux instituts de recherche, grâce à sa suite unifiée de principaux LLM. L'interface de la plateforme permet aux équipes de comparer les performances des modèles côte à côte, ce qui facilite l'évaluation et le choix de la solution la mieux adaptée à leurs besoins. En outre, Prompts.ai favorise la collaboration grâce à son programme de certification Prompt Engineer, qui partage des flux de travail rapides testés pour aider les équipes à démarrer. Ces intégrations sont conçues pour un déploiement rapide dans différents environnements.

Prompts.ai est disponible en tant que plateforme SaaS basée sur le cloud, garantissant une mise en œuvre rapide avec des exigences d'infrastructure minimales. Grâce à une assistance complète à l'intégration et à une formation d'entreprise personnalisée, les équipes peuvent intégrer facilement la plateforme à leurs flux de travail existants. Sa conception native du cloud garantit des mises à jour automatiques, de sorte que les utilisateurs ont toujours accès aux derniers modèles et fonctionnalités sans effort supplémentaire.

La plateforme propose une gamme d'options de tarification adaptées à différents besoins. Les forfaits commencent par un niveau gratuit de 0$, suivis des forfaits personnels à 29$ par mois, des forfaits familiaux à 99$ par mois et des plans d'affaires allant de 99$ à 129$ par membre par mois. Une couche FinOps intégrée fournit un suivi en temps réel de l'utilisation des jetons, permettant aux organisations de lier leurs dépenses directement à des résultats mesurables. Cette approche permet aux entreprises de réduire de manière significative les dépenses liées aux logiciels d'IA.

Prompts.ai fournit des fonctionnalités de gouvernance de niveau entreprise pour garantir la sécurité des données et la conformité réglementaire. Des contrôles d'accès centralisés, des pistes d'audit détaillées et un cadre de conformité robuste protègent les informations sensibles. Les autorisations basées sur les rôles limitent l'accès à des modèles ou à des flux de travail spécifiques, tandis que les tableaux de bord en temps réel offrent aux équipes une visibilité complète de leurs opérations. Cette structure sécurisée et centralisée permet aux industries soumises à des réglementations strictes de développer plus facilement leurs initiatives d'IA en toute confiance.

Zapier regroupe plus de 8 000 applications sur une seule plateforme d'automatisation fluide, dont 500 intégrations spécifiques à l'IA. Ces connexions s'étendent à des outils tels que ChatGPT, Claude, Gemini et Perplexity. Grâce à sa fonctionnalité intégrée « AI by Zapier », les utilisateurs peuvent exploiter directement de grands modèles linguistiques dans les flux de travail, sans avoir à gérer les clés d'API. À ce jour, Zapier a géré plus de 350 millions de tâches d'IA pour ses 1,3 million d'utilisateurs, dont 23 millions de tâches pilotées par l'IA exécutées chaque mois.

Le protocole Model Context de Zapier permet aux plateformes d'IA, telles que Claude, d'exécuter plus de 30 000 actions spécifiques dans son écosystème. Toile Zapier fournit une mise en page visuelle pour identifier les goulots d'étranglement du flux de travail, tandis que Tables Zapier consolide les données dans un hub central pour les modèles d'IA. Pour des besoins plus dynamiques, Agents Zapier effectuez des recherches autonomes sur le Web et adaptez-vous à l'évolution des entrées. Les options intégrées, telles que les approbations basées sur Slack, permettent aux équipes d'examiner les résultats générés par l'IA avant de poursuivre.

En avril 2025, Jacob Sirrs, spécialiste des opérations marketing chez Vendasta, a créé un système d'enrichissement du plomb alimenté par l'IA à l'aide de Zapier. Ce système a capturé les prospects à partir de formulaires, les a enrichis avec Apollo et Clay et a résumé les données pour le CRM à l'aide de l'IA. Le résultat ? Une augmentation de 1 million de dollars du chiffre d'affaires potentiel et 282 jours de travail récupérés par an pour l'équipe commerciale. Comme Sirrs l'a partagé :

Grâce à l'automatisation, nous avons constaté une augmentation d'environ 1 million de dollars des revenus potentiels. Nos représentants peuvent désormais se concentrer uniquement sur la conclusion de transactions, et non sur l'administration.

Ces puissantes intégrations sont associées à une tarification claire et basée sur les tâches pour garantir que les utilisateurs savent exactement ce pour quoi ils paient.

Le modèle de tarification de Zapier est basé sur les tâches : chaque action réussie compte pour une seule tâche. Les forfaits de niveau supérieur réduisent le coût par tâche et les utilisateurs reçoivent des notifications automatiques lorsqu'ils approchent de la limite des tâches. Si les limites sont dépassées, les flux de travail se poursuivent selon un modèle de paiement par tâche à 1,25 fois le coût de base, évitant ainsi les interruptions. Notamment, les outils intégrés tels que les tableaux, les formulaires, les filtres et le formateur ne sont pas pris en compte dans les allocations de tâches mensuelles. Le prix commence à 0$ pour 100 tâches par mois, le plan Professional à 19,99$ par mois, le plan Team (pour un maximum de 25 utilisateurs) à 69$ par mois et la tarification Enterprise personnalisée disponible pour les périodes de forte demande.

Au-delà de la rentabilité, Zapier donne également la priorité à la sécurité et à la gouvernance pour des opérations fluides et conformes.

Zapier fournit un contrôle au niveau de l'entreprise, permettant aux administrateurs de restreindre ou de désactiver complètement les intégrations d'IA tierces. Les entreprises clientes sont automatiquement exclues de la formation sur les modèles. La plateforme est conforme aux normes SOC 2 Type II, SOC 3, GDPR et CCPA, en utilisant le cryptage AES-256 et TLS 1.2 pour la protection des données. Des fonctionnalités telles que les journaux d'audit, les autorisations granulaires et la gestion centralisée des accès garantissent une visibilité opérationnelle totale.

Marcus Saito, responsable de l'informatique et de l'automatisation de l'IA chez Remote.com, a mis en place un service d'assistance piloté par l'IA via Zapier qui résout désormais 28 % des tickets informatiques de manière autonome, économisant 500 000 dollars par an en coûts de recrutement. Comme l'a dit Saito :

Zapier fait passer notre équipe de trois pour une équipe de dix.

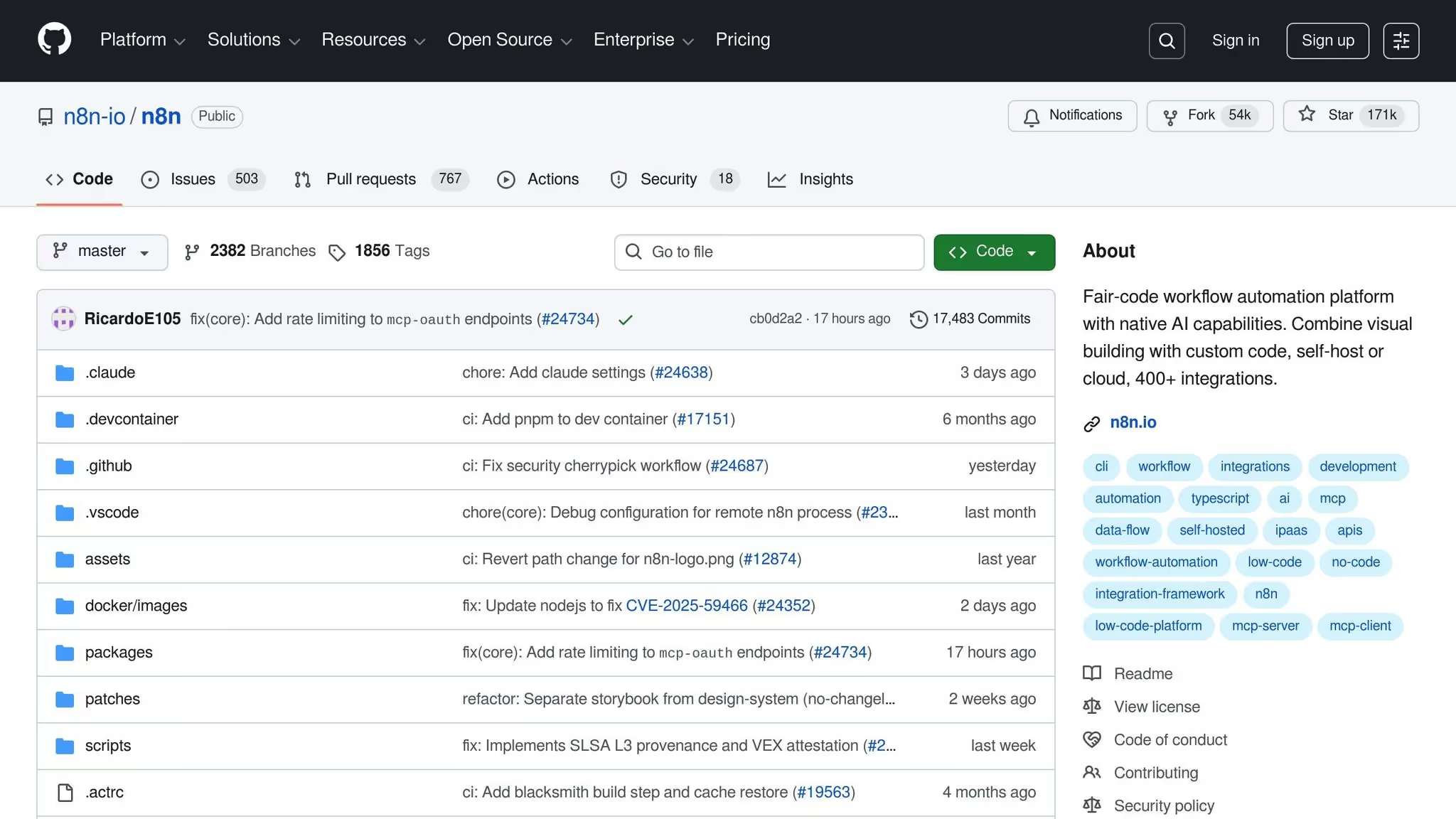

Lorsqu'il s'agit d'optimiser les flux de travail liés à l'IA, n8n se distingue en combinant intégration, évolutivité et rapidité. Avec plus de 500 intégrations prédéfinies et Plus de 1 700 modèles de flux de travail, il connecte de manière fluide les applications professionnelles et les outils d'IA. La plateforme comprend des Agent d'IA et Nœuds de cluster, permettant aux utilisateurs de créer des applications d'IA modulaires basées sur LangChain. Il offre également un support natif pour les principaux LLM tels qu'OpenAI, Anthropic, DeepSeek, Google Gemini, Groq et Azure. Pour les autres services, les utilisateurs peuvent utiliser le nœud de requête HTTP ou même importer des commandes cURL. Impressionnant, n8n peut exécuter jusqu'à 220 flux de travail par seconde sur une seule instance et a gagné plus de 170 000 étoiles sur GitHub, ce qui le place parmi les 50 meilleurs projets au monde.

n8n permet aux utilisateurs d'aller au-delà des nœuds standard, offrant la flexibilité d'injecter du code JavaScript ou Python personnalisé pour des transformations de données avancées. Il s'intègre parfaitement aux magasins vectoriels, aux serveurs MCP et aux systèmes d'IA externes à l'aide du MCP Server Trigger. Des entreprises comme SanctiFai et StepStone ont tiré parti des capacités de n8n. Par exemple, le PDG de SanctiFai, Nathaniel Gates, a déclaré avoir créé son premier flux de travail en seulement deux heures pour plus de 400 employés, atteignant Développement 3 fois plus rapide. De même, Luka Pilic, responsable technique du marché chez StepStone, a réduit deux semaines de codage manuel à deux heures seulement, accélérant ainsi l'intégration des données du marché en 25X. Ces exemples montrent comment les capacités d'intégration de n8n fournissent une base solide pour des déploiements flexibles et efficaces.

n8n propose trois options de déploiement pour répondre à divers besoins : Cloud (géré) pour des lancements rapides, auto-hébergé (via Docker, npm ou Kubernetes) pour un contrôle total, et Intégrer pour les intégrations en marque blanche. L'édition communautaire auto-hébergée est entièrement gratuite, disponible sur GitHub, et permet des exécutions illimitées ainsi qu'un contrôle total de l'infrastructure et du flux de données.

Le modèle de tarification de n8n est simple, facturant en fonction de l'exécution complète du flux de travail. Cela signifie que les utilisateurs peuvent traiter des flux de travail même complexes en un nombre illimité d'étapes sans se soucier des coûts imprévisibles. Tous les forfaits payants incluent un nombre illimité d'utilisateurs et des flux de travail actifs. Les niveaux de tarification incluent :

Les flux de travail continuent de fonctionner même si les quotas sont dépassés, avec des coûts excédentaires de 4 000 dollars pour 300 000 exécutions supplémentaires dans le cadre des plans Business. Les startups de moins de 20 employés peuvent postuler au Plan de démarrage, qui offre une réduction de 50 % sur le niveau Business.

n8n donne la priorité à la sécurité et à la conformité, en répondant Normes SOC 2 et des fonctionnalités de support telles que le SSO (SAML/LDAP), le RBAC et le stockage crypté des informations d'identification via AWS Secrets Manager ou HashiCorp Vault. Le Tableau de bord Insights fournit un suivi détaillé de l'exécution, tandis que les utilisateurs du plan Business reçoivent des rapports d'utilisation hebdomadaires et des notifications proactives lorsqu'ils approchent de 80 % de leur quota annuel.

Chez Delivery Hero, n8n a prouvé qu'il pouvait changer la donne. Dennis Zahrt, directeur de la prestation de services informatiques mondiaux, a déclaré que la mise en œuvre de n8n pour la gestion des utilisateurs et les opérations informatiques avait sauvé l'entreprise 200 heures par mois. Réfléchissant à cette expérience, il a déclaré :

Nous avons constaté des améliorations d'efficacité drastiques depuis que nous avons commencé à utiliser n8n pour la gestion des utilisateurs. Il est incroyablement puissant, mais aussi simple à utiliser. - Dennis Zahrt, directeur de la prestation de services informatiques mondiaux, Delivery Hero

Dans le monde en rapide évolution de l'automatisation des flux de travail par IA, Fabriquer se distingue par son offre impressionnante de plus de 3 000 intégrations d'applications et 30 000 actions. Elle renforce encore ses capacités avec Plus de 400 intégrations d'applications spécifiques à l'IA, connectant les utilisateurs à des services majeurs tels qu'OpenAI (ChatGPT, Sora, DALL-E, Whisper), Anthropic Claude, Google Vertex AI (Gemini), Azure OpenAI, Perplexity AI, DeepSeek AI, Mistral AI, ElevenLabs, Synthesia et Hugging Face. Grâce à ces outils, les utilisateurs peuvent créer Agents d'IA pour réutiliser les flux de travail existants pour des tâches telles que la récupération et l'exécution de données. Pour les systèmes propriétaires, la plateforme fournit un générateur d'applications personnalisé et des modules HTTP/Webhook pour se connecter aux API publiques.

Les capacités d'intégration de Make sont complétées par des outils avancés pour la conception de flux de travail. Son générateur visuel prend en charge des fonctionnalités telles que le routage multi-branches, les itérateurs et les agrégateurs, ce qui facilite la gestion des tâches de données complexes. La plateforme comprend également Maia, un assistant d'intelligence artificielle qui aide les utilisateurs à créer et à dépanner des flux de travail à l'aide de commandes en langage naturel, et Créer une grille, qui fournit une représentation visuelle des performances d'automatisation.

Philipp Weidenbach, responsable des opérations chez Teleclinic, a souligné l'impact de la plateforme :

Make nous a vraiment aidés à développer nos opérations, à simplifier nos processus, à réduire les coûts et à soulager notre équipe d'assistance.

De même, Cayden Phipps, directeur des opérations de Shop Accelerator Martech, a décrit les gains d'efficacité comme transformateurs :

Make apporte une efficacité sans précédent au sein de notre entreprise d'une manière que nous n'aurions jamais imaginée. C'est avoir un employé supplémentaire (ou 10) pour une fraction du coût.

Ces fonctionnalités font de la plateforme un choix puissant pour les entreprises qui cherchent à optimiser et à faire évoluer leurs opérations.

Make fonctionne comme une plateforme basée sur le cloud, permettant aux utilisateurs de faire évoluer les flux de travail sans avoir besoin d'une expertise en matière de codage. Ses agents d'IA sont conçus pour être axés sur des objectifs, s'appuyant sur le langage naturel pour interpréter les tâches et sélectionner dynamiquement les meilleurs outils dans la vaste bibliothèque de Make. Ces agents sont réutilisables dans tous les flux de travail, ce qui réduit la redondance et simplifie la gestion.

Faites des offres niveau gratuit, avec des forfaits payants à partir de 9$ par mois. Pour les grandes organisations nécessitant une gouvernance et un support avancés, des tarifs d'entreprise sont disponibles. Les agents IA sont inclus dans tous les forfaits, garantissant ainsi l'accessibilité pour tous les utilisateurs. La plate-forme dessert une vaste base d'utilisateurs de plus de 350 000 clients et reçoit d'excellents commentaires, avec des évaluations telles que 4.8/5 sur Capterra (404 commentaires), 4.7/5 sur G2 (238 critiques), et 4.8/5 sur GetApp (404 commentaires).

Make donne la priorité à la sécurité et à la conformité, en maintenant SOC 2 Type II et Conformité au RGPD. Il offre un cryptage robuste, une authentification unique (SSO) et un contrôle d'accès basé sur les rôles (RBAC) pour gérer les opérations de flux de travail entre les équipes. Bien que la flexibilité de la plate-forme pour la création d'automatisations complexes soit largement appréciée, certains utilisateurs ont remarqué que l'interface peut être difficile pour des tâches plus simples, nécessitant un certain apprentissage.

Travaillez à gère les flux de travail d'IA avec plus de 1 200 connecteurs, reliant de manière fluide les plateformes SaaS, les systèmes sur site et les bases de données. Ses intégrations natives avec les principaux fournisseurs de LLM, tels qu'OpenAI, Anthropic, Google Gemini, Amazon Bedrock, Azure OpenAI, Mistral AI et Perplexity, en font un choix exceptionnel pour les flux de travail des modèles d'IA. En outre, la plate-forme prend en charge les bases de données vectorielles telles que Pinecone et Qdrant, et fonctionne avec des protocoles compatibles avec Langchain, notamment le Model Context Protocol (MCP). Reconnu comme leader dans le Magic Quadrant de Gartner pour la plate-forme d'intégration en tant que service (iPaaS) pour 7 années consécutives, Workato bénéficie de la confiance de 50 % des entreprises du Fortune 500.

Workato propose trois niveaux d'intégration : des connecteurs prédéfinis, des protocoles universels (HTTP, OpenAPI, GraphQL, SOAP) et des options proposées par la communauté. C'est « L'IA par Workato » connector simplifie des tâches telles que l'analyse de texte, la rédaction d'e-mails, la traduction et la catégorisation, en s'appuyant sur les modèles d'Anthropic et d'OpenAI. En gérant les clés d'API de plusieurs fournisseurs LLM, cela élimine les tracas liés à la configuration manuelle. Pour les systèmes sans connecteurs existants, le connecteur universel permet une intégration fluide avec des modèles d'IA propriétaires ou des infrastructures plus anciennes utilisant des protocoles standard. Cette approche à plusieurs niveaux garantit flexibilité et efficacité dans la gestion des flux de travail complexes liés à l'IA.

Workato fonctionne sur une architecture évolutive sans serveur qui garantit une évolutivité automatique et des mises à niveau sans interruption de service, avec Garantie de disponibilité de 99,9 %. Pour les entreprises nécessitant des solutions hybrides, les agents sur site (OPA) permettent des connexions sécurisées entre les bases de données locales ou les systèmes existants et les modèles d'IA basés sur le cloud, sans exposer les données sensibles à l'Internet public. Cette architecture garantit une exécution isolée pour chaque automatisation, tout en maintenant des normes de performance et de sécurité élevées.

Workato donne la priorité à la sécurité grâce à des certifications telles que SOC 2 Type II, ISO 27001, PCI DSS et conformité au RGPD. Des fonctionnalités telles que le BYOK (Bring Your Own Key) avec rotation horaire des touches et pistes d'audit immuables améliorent la protection des données. Le Couche MCP d'entreprise garantit la gouvernance, l'authentification et l'auditabilité des agents d'IA, en garantissant une exécution cohérente sur tous les systèmes de l'entreprise. Travaillez chez Aegis fournit aux équipes informatiques une visibilité sur l'activité des utilisateurs, les modèles d'utilisation et les flux de travail d'intégration, leur permettant de mettre en œuvre des politiques visant à atténuer les risques, telles que l' « IA fantôme ». Le contrôle d'accès basé sur les rôles (RBAC) et l'application de la résidence des données au sein du connecteur « AI by Workato » garantissent que le traitement des données reste localisé, que ce soit aux États-Unis, dans la région EMEA ou dans la région APAC. Ces mesures robustes permettent de minimiser les interruptions tout en maintenant le contrôle des coûts opérationnels.

« Les utilisateurs professionnels ont commencé à utiliser Workato de manière organique. Une fois que nous avons identifié ces utilisateurs professionnels, nous les élevons au rang de champions afin de responsabiliser d'autres équipes ou d'autres personnes, et nous les utilisons pour passer à la prochaine vague d'échelle. » - Mohit Rao, responsable de l'automatisation intelligente

Workato utilise un modèle de tarification basé sur l'utilisation avec quatre niveaux : Standard, Business, Enterprise et Travaillez en un, ce dernier étant conçu pour une orchestration pilotée par l'IA. La tarification est déterminée par les « tâches » (chaque étape de la recette ou chaque enregistrement traité), les recettes et les connecteurs, les déploiements d'entreprise typiques commençant à 50 000$ par année. Un tableau de bord centralisé fournit des informations sur la facturation en temps réel, des journaux de tâches et des alertes budgétaires, aidant les entreprises à éviter les dépenses imprévues lors de la mise à l'échelle. Les fonctionnalités d'IA nécessitent la signature d'un addendum et sont incluses dans certains plans tarifaires. En combinant des fonctionnalités avancées de flux de travail d'IA avec une sécurité et une évolutivité robustes, Workato garantit une expérience rationalisée pour la gestion des intégrations complexes.

Force d'agent est la plateforme basée sur l'IA de Salesforce conçue pour récupérer des données, les analyser et effectuer des tâches de manière autonome. Entièrement intégré à Salesforce CRM, il tire parti des Moteur de raisonnement Atlas pour ancrer les réponses sur des données d'entreprise fiables, réduisant ainsi de manière significative les inexactitudes. Le PDG de Salesforce, Marc Benioff, l'appelle « la troisième vague de l'IA », marquant le passage de simples copilotes à des agents intelligents visant à fournir des résultats précis et exploitables qui améliorent la réussite des clients. Salesforce s'est fixé l'objectif ambitieux de déployer un milliard d'agents via Agentforce d'ici la fin de 2025, dans le but de redéfinir l'efficacité opérationnelle au sein de son écosystème.

Agentforce est profondément intégré à l'écosystème Salesforce et se connecte à des outils tels que Cloud de données, MuleSoft, et Salesforce Flow. À travers Connecteurs API MuleSoft, la plateforme peut interagir avec les systèmes existants et les applications externes, même dans des configurations d'entreprise complexes. Le Réseau de partenaires Agentforce étend ses capacités en s'intégrant à des acteurs majeurs tels qu'AWS, Google, IBM, Workday et Box. Une caractéristique hors du commun, « Zéro copie » intégration, permet aux agents d'analyser des lacs de données externes tels que Snowflake en temps réel sans dupliquer les données. Cette approche garantit la précision tout en minimisant les coûts de stockage.

Agentforce est exclusivement proposé en tant que solution SaaS basée sur le cloud au sein de l'infrastructure de Salesforce, garantissant l'évolutivité et une collaboration fluide avec les équipes humaines. Par exemple, lors de la période de pointe de la rentrée scolaire en septembre 2024, le géant de l'édition Wiley a mis en œuvre Agentforce pour rationaliser l'accès aux comptes, l'enregistrement et les problèmes de paiement. Supervisée par Kevin Quigley, responsable principal de l'amélioration continue, la configuration sans code s'est intégrée à la base de connaissances Salesforce existante de Wiley. Le résultat ? UNE Amélioration de 40 % des taux de résolution des cas par rapport à leur robot précédent, libérant ainsi des agents humains pour répondre aux besoins plus complexes des clients.

Agentforce garantit la conformité et la sécurité grâce à Salesforce Couche de confiance, qui applique les autorisations des utilisateurs, protège les données sensibles et signale les sorties inappropriées. Le Moteur de raisonnement Atlas valide les réponses pour s'assurer qu'elles sont exactes et fondées sur des données fiables, évitant ainsi les hallucinations. Les garanties supplémentaires incluent protection rapide contre les injections, qui atténue les risques avant que les réponses ne soient apportées, et filtrage conditionnel, qui bloque les actions non autorisées, telles que l'interdiction du traitement des paiements jusqu'à ce qu'un utilisateur soit vérifié. L'audit suit le comportement des agents de documentation à des fins de conformité, tandis que Intégration de Data 360 alimente la génération sécurisée par extraction augmentée (RAG) dans l'environnement Salesforce.

La tarification d'Agentforce commence à 2$ par conversation pour une utilisation standard. Pour les déploiements au niveau de l'entreprise, Crédits Flex sont disponibles, à partir de 500$ pour 100 000 crédits, avec des remises proposées pour les volumes plus importants. Des fonctionnalités supplémentaires, telles que les fonctionnalités d'indexation et d'analyse de Data 360, sont gérées via un système de portefeuille numérique. Cette configuration fournit une visibilité claire sur l'utilisation des ressources et les coûts associés, ce qui permet aux entreprises de suivre et de gérer leurs dépenses de manière efficace.

Vélin AI constitue une plate-forme d'orchestration polyvalente, permettant une utilisation fluide de plusieurs LLM sans que les utilisateurs ne soient liés à un seul fournisseur. Il comble le fossé entre les chefs de produit et les ingénieurs en synchronisant les modifications sans code avec le code de la CLI, créant ainsi un flux de travail unifié. Cette intégration jette les bases des capacités techniques avancées de Vellum.

Vellum prend en charge un large éventail de types de nœuds, tels que API, Exécution de code (Python/TypeScript), Rechercher (RAG) et Nœuds d'agent - permettant aux utilisateurs de créer des systèmes d'IA complexes. La plateforme prend également en charge L'humain au cœur de la boucle flux de travail, en interrompant l'exécution pour permettre une saisie externe ou des approbations manuelles avant de continuer. En outre, Nœuds de sous-flux simplifiez la gestion de projet en permettant aux équipes de créer des composants réutilisables, garantissant ainsi la cohérence entre les différentes applications. Comme l'a souligné Jordan Nemrow, cofondateur et directeur technique de Woflow :

Nous avons accéléré le développement de l'IA de 50 % et découplé les mises à jour des versions avec Vellum.

Vellum propose une gamme de méthodes de déploiement pour répondre à divers besoins opérationnels, notamment cloud géré, VPC privé, hybride, et sur site environnements. Pour les organisations ayant des exigences strictes en matière de résidence des données, des configurations ventilées sont également disponibles. L'option d'auto-hébergement permet aux entreprises d'exécuter des flux de travail au sein de leur propre infrastructure, garantissant ainsi un contrôle total des données. Max Bryan, vice-président de la technologie et du design, a déclaré :

Nous avons réduit de moitié un délai de 9 mois tout en améliorant de manière significative la précision de l'assistant virtuel.

Vellum propose une tarification simple, en commençant par niveau gratuit idéal pour les tests ou les projets à petite échelle. Les forfaits payants commencent à 25$ par mois, tandis que les forfaits d'entreprise proposent une tarification adaptée aux besoins de grande envergure. La plateforme comprend un suivi détaillé de l'utilisation des jetons et des modèles d'appels, ainsi que des garde-fous budgétaires intégrés et une régulation automatique pour éviter les dépenses excessives. Notamment, Vellum charge pas de frais d'hébergement pour les flux de travail exécutés sur leur plateforme, aidant ainsi les équipes à éviter des coûts d'infrastructure imprévus.

La sécurité et la conformité sont au cœur de la conception de Vellum. Des fonctionnalités telles que RBAC, SSO/SCIM, journaux d'audit, et API sécurisées par HMAC garantir la sécurité des opérations. Révisions intégrées des versions et Nœuds de garde-corps aider à auditer les modifications et à signaler les sorties non conformes. Le vélin est conforme à SOC 2, GDPR, et HIPAA normes, offrant ainsi la tranquillité d'esprit aux industries réglementées. Les vues de trace avancées et les intégrations Datadog offrent une observabilité de bout en bout, permettant aux équipes de résoudre les problèmes et de suivre les tendances de production en temps réel sans compromettre l'efficacité.

Pièces actives est une plateforme d'automatisation open source conçue pour les flux de travail d'IA. Il possède une bibliothèque de 611 connecteurs préfabriqués, appelées « pièces », qui s'intègrent parfaitement à des applications populaires telles que Gmail, Slack et Salesforce. Ces pièces, écrites en Tapez Script et distribués sous forme de packages npm, offrent aux développeurs la possibilité de modifier ou de créer des connecteurs. De plus, la plateforme prend en charge le Protocole de contexte modèle (MCP), permettant à ses pièces de servir d'outils à des agents d'IA externes tels que Claude ou Cursor, élargissant ainsi ses fonctionnalités au-delà de son générateur natif.

Activepieces propose une variété d'actions natives, notamment l'analyse, la génération d'images, la synthèse et la classification. Il se distingue par l'extraction de données structurées à partir de sources non structurées, telles que des e-mails, des factures et des documents numérisés. Pour des flux de travail plus complexes, Exécuter l'agent l'action gère le raisonnement en plusieurs étapes et l'utilisation des outils, tandis que le AI SDK permet aux équipes de développer des agents personnalisés. La plateforme comprend également Tableaux, une banque de données centralisée qui connecte les agents et les flux de travail, servant de hub de mémoire pour les processus d'automatisation. Impressionnant, à propos de 60 % des pièces de la plateforme proviennent de sa communauté open source active, qui présente un écosystème florissant de contributeurs.

Activepieces offre une flexibilité de déploiement avec à la fois un service cloud géré et un option auto-hébergée à l'aide de Docker. Pour les organisations nécessitant un contrôle strict des données, il prend en charge environnements présentant des lacunes en matière de réseau. En outre, les éditeurs de logiciels peuvent tirer parti de Activepieces Intégrer, qui leur permet d'intégrer le générateur d'automatisation directement dans leurs produits SaaS, en fournissant des fonctionnalités de flux de travail en marque blanche à leurs utilisateurs.

Activepieces utilise une approche claire et directe modèle de tarification basé sur les flux. Contrairement aux plateformes qui facturent par tâche ou exécution, Activepieces facture 5$ par flux actif par mois dans ses Niveau cloud standard, les 10 premiers flux étant inclus gratuitement et courses illimitées. Cette structure tarifaire est particulièrement avantageuse pour les flux de travail d'IA qui impliquent des sondages fréquents ou des processus complexes en plusieurs étapes. Pour ceux qui préfèrent l'auto-hébergement, le Édition communautaire est disponible gratuitement sous la licence MIT, bien que sa gestion nécessite une expertise technique. Les entreprises clientes qui recherchent des fonctionnalités avancées telles que le SSO, le RBAC et les journaux d'audit peuvent opter pour Niveau ultime, disponible par le biais de contrats annuels avec une tarification personnalisée.

Activepieces c'est Conforme à la norme SOC 2 Type II et propose des outils de gestion de niveau professionnel. Les administrateurs peuvent contrôler la visibilité des pièces par utilisateur ou par client et personnaliser le générateur avec une marque blanche. Les principales fonctionnalités incluent historique des versions pour rétablir les flux, nouvelle tentative automatique pour les étapes ayant échoué, et des outils de débogage robustes pour analyser l'historique des exécutions. Pour les flux de travail nécessitant une intervention manuelle, la plateforme inclut L'humain au cœur de la boucle fonctionnalité, permettant aux processus de faire une pause pour les approbations ou les commentaires avant de continuer. Cela garantit que les décisions critiques sont examinées avec soin et précision.

Préfet est une plateforme d'orchestration native de Python conçue pour transformer n'importe quelle fonction Python en un flux de travail avec une seule @flow décorateur. Avec 6,8 millions de téléchargements mensuels et plus de 21 400 étoiles sur GitHub, il a gagné en popularité auprès des développeurs. Contrairement aux orchestrateurs traditionnels qui s'appuient sur des structures DAG rigides, Prefect utilise le flux de contrôle natif de Python, les astuces de type et les modèles async/wait. Cette flexibilité en fait un excellent choix pour les flux de travail dynamiques des modèles d'IA qui doivent être ajustés en temps réel.

Prefect propose une plateforme gérée appelée Horizon préfet, adapté à l'infrastructure d'IA. Il inclut des fonctionnalités telles qu'une passerelle MCP (Model Context Protocol) et un registre de serveurs, permettant aux assistants IA de surveiller les déploiements, les exécutions de débogage et l'infrastructure de requêtes sans effort. La plateforme s'intègre parfaitement aux principaux fournisseurs de cloud, aux outils de données tels que Snowflake, Databricks, dbt et Fivetran, ainsi qu'aux frameworks de calcul tels que Ray, Dask et Kubernetes. Prefect prend également en charge les cas d'utilisation spécifiques à l'IA via des packages tels que hex parfait. Les flux de travail peuvent être déclenchés par des événements externes, des webhooks ou des événements cloud, ce qui permet aux systèmes d'IA de réagir de manière dynamique aux modifications de données en temps réel.

« Nous avons multiplié par 20 le débit grâce à Prefect. C'est notre outil de travail en matière de traitement asynchrone : un couteau suisse. » - Smit Shah, directeur de l'ingénierie, Snorkel AI

Ces intégrations constituent la base de modèles de déploiement extrêmement flexibles.

Prefect propose trois modes de déploiement pour répondre à différents besoins :

Du préfet Piscines de travail Cette fonctionnalité sépare le code du flux de travail des environnements d'exécution. Cela permet aux flux de travail de passer facilement du développement local à Docker, Kubernetes, AWS ECS, Google Cloud Run et Azure ACI sans nécessiter de modifications de code. Par exemple, Snorkel AI utilise Prefect OSS sur Kubernetes pour gérer plus de 1 000 flux par heure.

Prefect OSS est entièrement gratuit pour les déploiements auto-hébergés. Prefect Cloud inclut un niveau gratuit pour les particuliers et les petites équipes, tandis que des niveaux payants au niveau de l'entreprise offrent des fonctionnalités de gouvernance avancées. Prefect Horizon, destiné aux infrastructures d'IA à l'échelle de l'entreprise, nécessite généralement une consultation directe pour la tarification. L'efficacité de la plateforme est un atout majeur : Prefect 3.0, sorti en 2024, a réduit les frais d'exécution de 90 % par rapport à ses versions précédentes.

Prefect Cloud et Horizon sont Conforme à la norme SOC 2 Type II, offrant des fonctionnalités de sécurité de niveau professionnel telles que l'authentification unique (SSO) et le contrôle d'accès basé sur les rôles (RBAC). Prefect Horizon régit également l'accès des agents d'IA aux systèmes de l'entreprise via sa passerelle MCP et son registre de serveurs. Pour les flux de travail nécessitant une supervision humaine, Prefect prend en charge l'humain au courant fait des pauses, permettant la révision ou l'approbation manuelles avant que les tâches ne se poursuivent. Des fonctionnalités supplémentaires telles que le suivi automatique de l'état, la surveillance en temps réel et les journaux persistants garantissent une piste d'audit complète pour chaque tâche. Pour les organisations ayant des exigences de sécurité strictes, la version OSS offre un contrôle total au sein de leur VPC privé.

« Horizon est le meilleur moyen de déployer MCP au sein de notre organisation. Prends mon dépôt GitHub prêt à l'emploi, lance-le et tout fonctionne pour nous. » - James Brink, trader en chef, Nitorum Capital

Substrat rocheux d'Amazon sert de passerelle d'API gérée par AWS pour les modèles de base, offrant un accès à des outils de pointe de fournisseurs tels que AI21 Labs, Anthropic, Cohere, Meta, Mistral AI, Stability AI et Amazon lui-même. Avec plus de 100 000 organisations qui font confiance à ses services, Bedrock inclut des fonctionnalités innovantes telles que Flux rocheux, un constructeur visuel sans code permettant de créer des flux de travail d'IA génératifs en plusieurs étapes, et Agent Core, une plateforme flexible pour créer et gérer des agents d'IA à l'aide de frameworks tels que LangGraph ou CrewAI.

Bedrock se distingue par ses capacités d'intégration sans faille. C'est Passerelle AgentCore transforme les API et les fonctions Lambda en outils compatibles MCP, simplifiant ainsi les connexions aux systèmes d'entreprise tels que Salesforce, Slack et Jira. La plateforme prend également en charge la collaboration multi-agents, permettant à des agents spécialisés de travailler ensemble sous la supervision d'un agent de supervision pour gérer des processus métier complexes.

Entre 2023 et 2024, Robinhood a considérablement étendu ses opérations avec Bedrock, augmentant l'utilisation de jetons de 500 millions à 5 milliards par jour. Cette expansion a entraîné une réduction de 80 % des coûts de l'IA et une réduction de 50 % du temps de développement, grâce au leadership de Dev Tagare, responsable de l'IA chez Robinhood.

« Les principaux services d'AgentCore (Runtime pour les déploiements sécurisés, Observabilité pour la surveillance et Identité pour l'authentification) permettent à nos équipes de développer et de tester ces agents efficacement alors que nous déployons l'IA à l'échelle de l'entreprise. » — Marianne Johnson, vice-présidente exécutive et directrice des produits, Cox Automotive

Un autre exemple de réussite provient de Appareils Amazon L'équipe des opérations et de la chaîne d'approvisionnement, qui a utilisé AgentCore pour automatiser la formation sur les modèles de vision robotique. Cette innovation a permis de réduire le temps de réglage de plusieurs jours à moins d'une heure en 2024.

Bedrock propose une infrastructure sans serveur entièrement gérée, ce qui simplifie la gestion de l'infrastructure. Il prend en charge la connectivité privée via Lien privé AWS et Amazon VPC, garantissant que les données sensibles ne traversent jamais l'Internet public. Toutes les données des clients sont cryptées à la fois au repos et en transit à l'aide de Service de gestion des clés AWS (KMS). En outre, AWS garantit que les données des clients ne sont jamais partagées avec des fournisseurs de modèles tiers ni utilisées pour former des modèles de base.

Bedrock fonctionne selon un modèle de tarification à l'utilisation, éliminant ainsi les engagements initiaux. Les coûts varient selon le modèle ; par exemple, l'utilisation d'Anthropic Claude 3.5 Sonnet v2 coûte 0,006$ pour 1 000 jetons d'entrée et 0,03$ pour 1 000 jetons de sortie. Bedrock propose trois niveaux de tarification :

Les fonctionnalités supplémentaires permettant de réduire les coûts incluent :

En 2024, Epsilon a utilisé ces fonctionnalités pour réduire le temps de configuration des campagnes de 30 % et faire gagner aux équipes environ 8 heures par semaine.

Bedrock repose sur la sécurité et la conformité, répondant à des normes telles que ISO, SOC, CSA STAR niveau 2, GDPR, FedRAMP High et l'éligibilité HIPAA. Les principales caractéristiques sont les suivantes :

La plateforme s'intègre parfaitement à ÉTAIT UN OBJECTIF, Cloud Trail, et CloudWatch pour la surveillance. En outre, Agent Core améliore la sécurité grâce à l'isolation des sessions et à la gestion des identités, en prenant en charge la compatibilité OIDC/SAML grâce aux politiques Cedar.

« Les fonctionnalités de diversité des modèles, de sécurité et de conformité d'Amazon Bedrock sont spécialement conçues pour les secteurs réglementés. » — Dev Tagare, responsable de l'IA chez Robinhood

Le choix de la bonne plateforme peut faire toute la différence lorsqu'il s'agit de réduire les coûts opérationnels et d'améliorer la sécurité des flux de travail. Voici une comparaison de certaines plateformes clés et de leurs fonctionnalités remarquables.

Prompts.ai réunit plus de 35 modèles haut de gamme, dont GPT-5, Claude, LLama et Gemini, dans une interface rationalisée. Il offre un suivi FinOps en temps réel, ce qui réduit considérablement les dépenses liées à l'IA. Grâce à ses crédits TOKN payables à l'utilisation, les utilisateurs peuvent éviter les frais d'abonnement récurrents tout en bénéficiant d'un accès centralisé aux modèles sans être liés à un seul fournisseur.

Kubeflow, quant à elle, est une plateforme native de Kubernetes conçue pour la formation distribuée. Il est hautement modulaire et bénéficie d'un solide soutien de la communauté. Entre-temps, Préfet brille dans la gestion dynamique des flux de travail, en particulier pour les flux de travail natifs Python. Ses agents d'IA peuvent prendre des décisions d'exécution, offrant flexibilité et efficacité. Par exemple, le passage d'astronome à préfet a entraîné une baisse de 73,78 % des coûts de facturation pour Endpoint.

Substrat rocheux d'Amazon se distingue en fournissant un accès géré et basé sur le cloud aux modèles de base. Cela en fait une excellente option pour les organisations qui souhaitent faire évoluer des applications d'IA génératives sans se soucier de la gestion de l'infrastructure.

Chaque plateforme a ses propres objectifs, qu'il s'agisse d'un accès unifié aux modèles, d'une orchestration dynamique ou d'une gestion évolutive basée sur le cloud. La plupart des plateformes proposent également à la fois des versions open source auto-hébergées (qui sont gratuites mais nécessitent des ressources internes) et des solutions cloud gérées dotées de fonctionnalités de niveau entreprise telles que l'authentification unique (SSO) et le contrôle d'accès basé sur les rôles (RBAC). L'industrie s'oriente également vers l'orchestration dynamique de l'IA, en abandonnant les graphes acycliques orientés statiques (DAG) au profit de machines à états adaptatives, qui permettent des approbations humaines et des ajustements logiques en temps réel.

Pour choisir la bonne plateforme de flux de travail IA, il faut aligner ses fonctionnalités sur les exigences uniques de votre organisation. Chaque plateforme présentée ici présente des avantages distincts, qu'il s'agisse de fournir un accès unifié aux modèles, de permettre une orchestration flexible ou de garantir une sécurité au niveau de l'entreprise. Cet alignement jette les bases de l'évaluation de l'intégration, de la tarification, de la sécurité et de l'évolutivité.

Capacités d'intégration sont essentiels pour connecter les flux de travail d'IA à votre infrastructure technologique existante. Comme le souligne Nicolas Zeeb :

L'automatisation des flux de travail basés sur l'IA à faible code ne remplace pas votre stack existant.

Une intégration fluide garantit que les initiatives d'IA améliorent les opérations commerciales au sens large au lieu de rester déconnectées. Sans cela, l'IA risque de devenir cloisonnée, un défi cité par 46 % des équipes produit comme le principal obstacle à l'adoption.

Clarté des prix est un autre facteur crucial, notamment en ce qui concerne les échelles d'utilisation. Bien que certaines plateformes proposent des prix d'entrée de gamme attractifs, les coûts peuvent augmenter en cas d'utilisation accrue. Les modèles de tarification basés sur l'exécution offrent souvent une plus grande prévisibilité par rapport aux systèmes de crédit par étape, dans lesquels chaque action de l'IA consomme des quantités variables de crédits. L'estimation des coûts pour les scénarios à volume élevé, tels que plus de 100 000 actions par mois, est essentielle avant de prendre un engagement.

Robuste contrôles de sécurité sont indispensables pour les environnements de production. Recherchez des fonctionnalités telles que la conformité SOC 2 Type II, le contrôle d'accès basé sur les rôles (RBAC) et les journaux d'audit détaillés. Pour les secteurs soumis à des réglementations strictes, assurez-vous que la plateforme offre la conformité HIPAA et un cryptage dédié aux locataires. Lorsque les agents d'IA traitent des données commerciales sensibles, une gouvernance solide n'est pas négociable.

Enfin, considérez la capacité de la plateforme à prendre en charge croissance à long terme. Cela inclut non seulement les performances techniques, mais également les fonctionnalités qui permettent l'évolutivité organisationnelle. La plateforme doit gérer une complexité croissante sans compromettre les performances et proposer des outils de gouvernance tels que le contrôle des versions et les tests côte à côte. Les plateformes externes de flux de travail basées sur l'IA fournissent souvent de meilleurs résultats de production que les solutions conçues en interne, mais uniquement si elles peuvent évoluer efficacement en fonction de vos objectifs.

Lorsque vous choisissez une plateforme de flux de travail basée sur l'IA, vous devez évaluer certains aspects essentiels pour vous assurer qu'elle correspond à vos besoins. Commencez par compatibilité des modèles - confirmez que la plateforme prend en charge un large éventail de modèles d'IA et permet une intégration fluide dans vos systèmes existants. Cette flexibilité vous permet de tirer parti des meilleurs outils pour vos tâches spécifiques.

Ensuite, évaluez la plateforme fonctionnalités d'automatisation et d'orchestration. Recherchez des fonctionnalités capables de gérer des flux de travail complexes, notamment ceux utilisant une logique conditionnelle ou des processus humains intégrés. Ces fonctionnalités sont essentielles pour rationaliser les opérations et améliorer l'efficacité.

Sécurité et conformité des données devrait également être une priorité absolue, en particulier si vous gérez des données sensibles ou si vous devez respecter des normes réglementaires strictes. Une plateforme dotée de solides mesures de sécurité et d'options de conformité peut contribuer à protéger vos opérations et à maintenir la confiance.

Enfin, considérez la plateforme évolutivité et le niveau de soutien communautaire disponible. Une solution évolutive garantit qu'elle peut évoluer en fonction de vos besoins, tandis qu'une solide communauté d'assistance peut fournir des ressources précieuses et une assistance en matière de dépannage. L'évaluation de ces facteurs vous aidera à sélectionner une plateforme qui améliore vos flux de travail d'IA et soutient vos objectifs à long terme.

La tarification basée sur l'exécution dans les plateformes d'IA signifie que vos coûts sont déterminés par la quantité que vous utilisez réellement, qu'il s'agisse du nombre de modèles d'appels, du volume de données traitées ou des tâches effectuées. Au lieu de vous limiter à un abonnement fixe ou à une capacité de préachat, cette approche aligne les dépenses directement sur votre consommation.

Ce modèle de tarification est particulièrement utile pour les entreprises qui cherchent à faire évoluer les flux de travail liés à l'IA. Il vous permet d'ajuster les dépenses en temps réel en fonction de vos besoins actuels, ce qui vous permet d'éviter de payer pour des ressources inutilisées ou de dépenser trop. Que vous augmentiez ou réduisiez votre capacité, vous ne payez que pour ce que vous consommez, éliminant ainsi le fardeau des coûts initiaux ou du gaspillage de capacité.

Lors de la sélection d'une plateforme de flux de travail IA, sécurité doit toujours être à l'avant-garde pour protéger les informations sensibles, protéger les algorithmes propriétaires et répondre aux exigences réglementaires. Voici quelques caractéristiques de sécurité essentielles à prendre en compte :

Ces fonctionnalités fonctionnent ensemble pour assurer la sécurité de vos données, préserver leur intégrité et leur confidentialité, et s'aligner sur les normes de sécurité strictes requises dans des secteurs tels que la finance et la santé.