AI workflows can be streamlined, secure, and cost-effective with the right tools. This guide highlights ten platforms designed to optimize AI model workflows, from orchestration to deployment. Each tool addresses challenges like fragmented tools, rising costs, and security risks, offering solutions for teams aiming to scale AI systems efficiently.

Explore these platforms to find the best fit for your team's needs, whether you're scaling workflows, managing costs, or ensuring compliance.

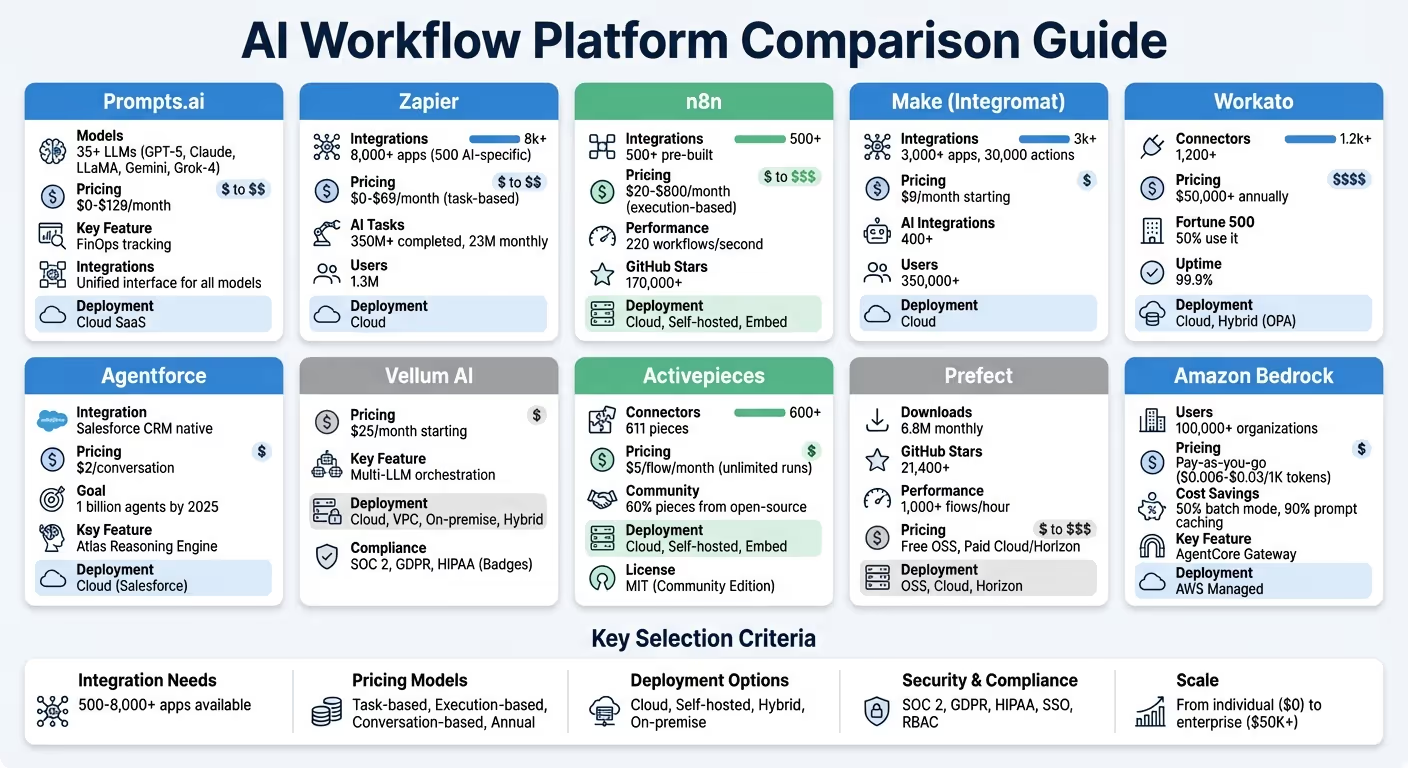

AI Workflow Platform Comparison: Features, Pricing, and Integration Capabilities

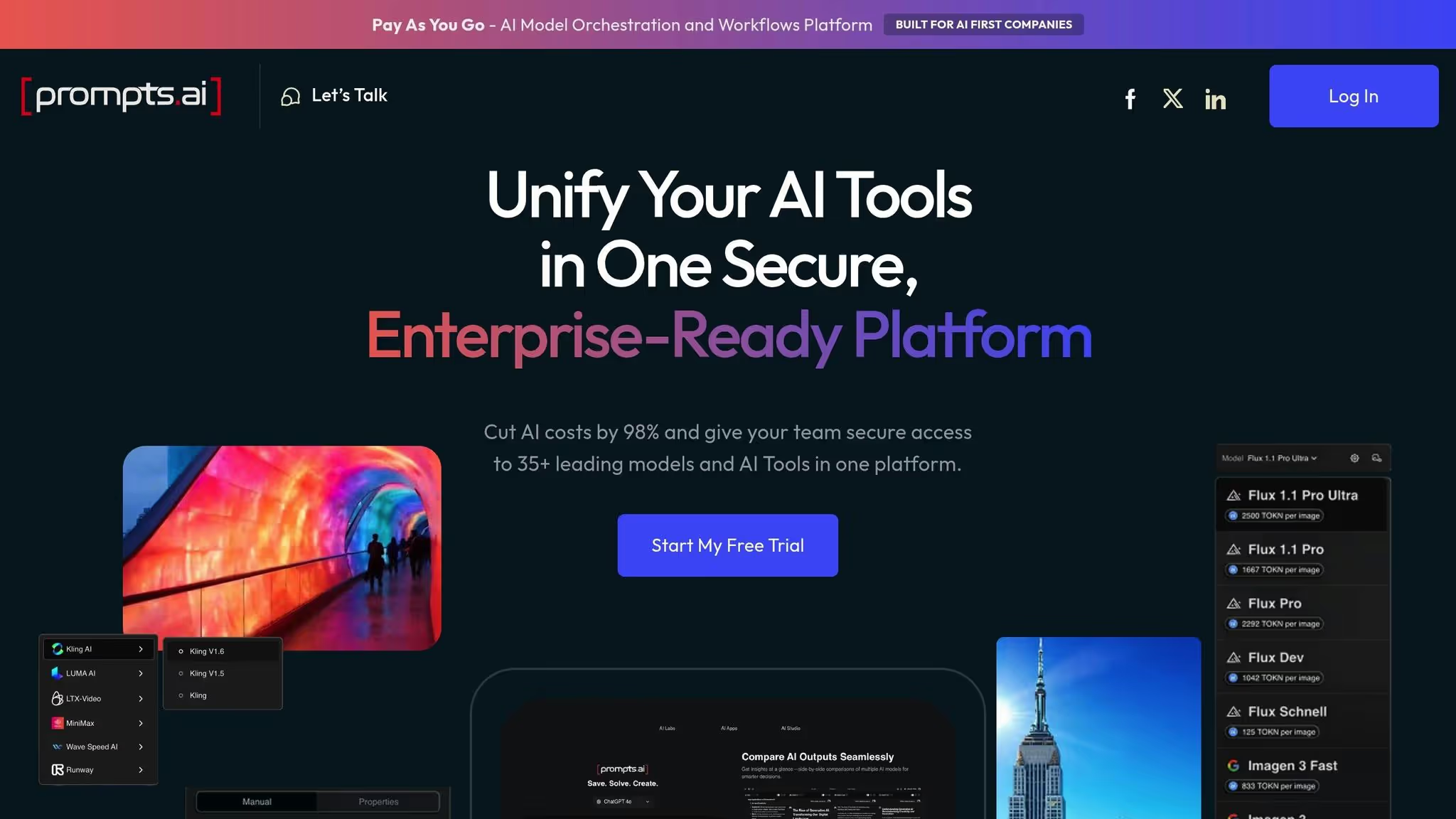

Prompts.ai serves as a powerful AI orchestration platform, uniting over 35 top-tier large language models (LLMs) - including GPT‑5, Claude, LLaMA, Gemini, Grok‑4, Flux Pro, and Kling - within a single, secure interface. By consolidating access to these models, the platform helps organizations eliminate the chaos of juggling multiple tools and streamlines AI workflows for greater efficiency. This all-in-one solution also opens the door to seamless integration across various systems.

Prompts.ai connects a diverse range of users, from Fortune 500 companies to creative agencies and research institutions, through its unified suite of leading LLMs. The platform’s interface allows teams to compare model performance side by side, making it easier to assess and choose the best fit for their needs. Additionally, Prompts.ai fosters collaboration through its Prompt Engineer Certification program, which shares tested prompt workflows to help teams hit the ground running. These integrations are designed for quick deployment across different environments.

Prompts.ai is available as a cloud-based SaaS platform, ensuring fast implementation with minimal infrastructure requirements. With comprehensive onboarding support and tailored enterprise training, teams can seamlessly integrate the platform into their existing workflows. Its cloud-native design ensures automatic updates, so users always have access to the latest models and features without additional effort.

The platform offers a range of pricing options to suit different needs. Plans start with a free $0 tier, followed by personal plans at $29/month, family plans at $99/month, and business plans ranging from $99 to $129 per member monthly. A built-in FinOps layer provides real-time tracking of token usage, enabling organizations to link their spending directly to measurable outcomes. This approach allows businesses to significantly cut AI software expenses.

Prompts.ai provides enterprise-grade governance features to ensure data security and regulatory compliance. Centralized access controls, detailed audit trails, and a robust compliance framework safeguard sensitive information. Role-based permissions restrict access to specific models or workflows, while real-time dashboards give teams full visibility into their operations. This secure, centralized structure makes it easier for industries with strict regulations to scale their AI initiatives confidently.

Zapier brings together over 8,000 applications into one seamless automation platform, including 500 AI-specific integrations. These connections extend to tools like ChatGPT, Claude, Gemini, and Perplexity. With its built-in "AI by Zapier" feature, users can directly leverage large language models within workflows, bypassing the need to manage API keys. To date, Zapier has handled over 350 million AI tasks for its 1.3 million users, with 23 million AI-driven tasks running every month.

Zapier’s Model Context Protocol allows AI platforms, such as Claude, to execute over 30,000 specific actions across its ecosystem. Zapier Canvas provides a visual layout to pinpoint workflow bottlenecks, while Zapier Tables consolidates data into a central hub for AI models. For more dynamic needs, Zapier Agents autonomously search the web and adapt to changing inputs. Human-in-the-loop options, like Slack-based approvals, ensure teams can review AI-generated outputs before they move forward.

In April 2025, Jacob Sirrs, a Marketing Operations Specialist at Vendasta, created an AI-powered lead enrichment system using Zapier. This system captured leads from forms, enriched them with Apollo and Clay, and summarized the data for the CRM using AI. The result? A $1 million boost in potential revenue and 282 reclaimed workdays annually for the sales team. As Sirrs shared:

Because of automation, we've seen about a $1 million increase in potential revenue. Our reps can now focus purely on closing deals - not admin.

These powerful integrations are paired with clear, task-based pricing to ensure users know exactly what they’re paying for.

Zapier’s pricing model is based on tasks - each successful action counts as one task. Higher-tier plans lower the per-task cost, and users receive automated notifications when nearing task limits. If limits are exceeded, workflows continue under a pay-per-task model at 1.25x the base cost, avoiding interruptions. Notably, built-in tools like Tables, Forms, Filter, and Formatter don’t count toward monthly task allowances. Pricing starts at $0 for 100 tasks per month, with the Professional plan at $19.99/month, the Team plan (for up to 25 users) at $69/month, and custom Enterprise pricing available for high-demand periods.

Beyond cost efficiency, Zapier also prioritizes security and governance for smooth and compliant operations.

Zapier provides enterprise-level control, allowing administrators to restrict or disable third-party AI integrations entirely. Enterprise customers are automatically opted out of model training. The platform adheres to SOC 2 Type II, SOC 3, GDPR, and CCPA standards, using AES-256 encryption and TLS 1.2 for data protection. Features like audit logs, granular permissions, and centralized access management ensure full operational visibility.

Marcus Saito, Head of IT and AI Automation at Remote.com, implemented an AI-driven helpdesk through Zapier that now resolves 28% of IT tickets autonomously, saving $500,000 annually in hiring costs. As Saito put it:

Zapier makes our team of three seem like a team of ten.

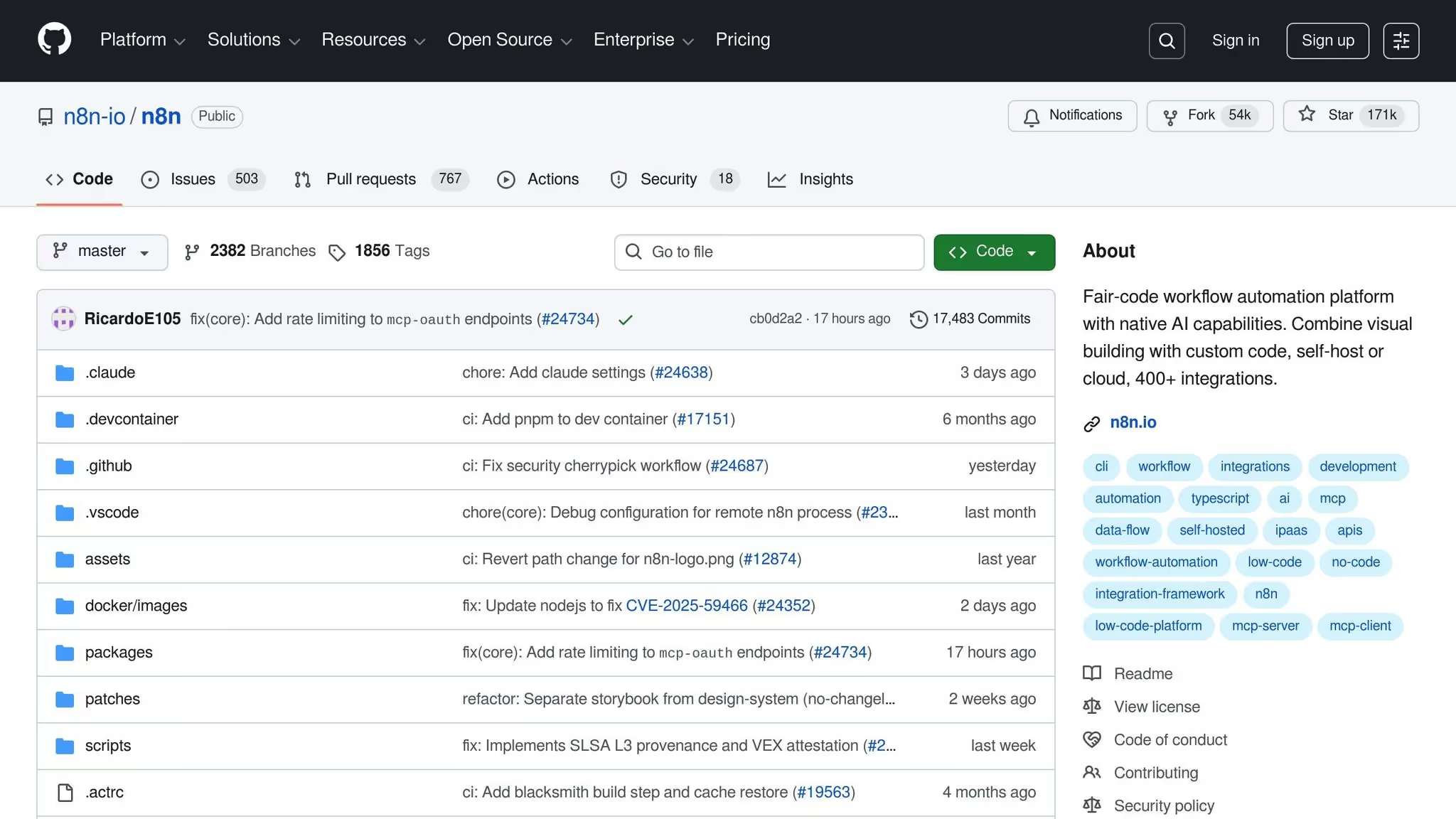

When it comes to optimizing AI workflows, n8n stands out by combining integration, scalability, and speed. With over 500 pre-built integrations and 1,700+ workflow templates, it connects business apps and AI tools seamlessly. The platform includes specialized AI Agent and Cluster nodes, enabling users to create modular AI applications built on LangChain. It also offers native support for leading LLMs like OpenAI, Anthropic, DeepSeek, Google Gemini, Groq, and Azure. For other services, users can utilize the HTTP Request node or even import cURL commands. Impressively, n8n can execute up to 220 workflows per second on a single instance and has earned over 170,000 stars on GitHub, placing it among the top 50 projects globally.

n8n allows users to go beyond standard nodes, offering the flexibility to inject custom JavaScript or Python code for advanced data transformations. It integrates seamlessly with vector stores, MCP servers, and external AI systems using the MCP Server Trigger. Companies like SanctifAI and StepStone have reaped the benefits of n8n’s capabilities. For instance, SanctifAI’s CEO, Nathaniel Gates, shared that they built their first workflow in just two hours for over 400 employees, achieving 3X faster development. Similarly, Luka Pilic, Marketplace Tech Lead at StepStone, reduced two weeks of manual coding to just two hours, speeding up marketplace data integration by 25X. These examples highlight how n8n’s integration capabilities provide a solid foundation for flexible and efficient deployments.

n8n offers three deployment options to suit diverse needs: Cloud (managed) for quick launches, self-hosted (via Docker, npm, or Kubernetes) for complete control, and Embed for white-labeled integrations. The self-hosted Community Edition is entirely free, available on GitHub, and provides unlimited executions along with full control over infrastructure and data flow.

n8n’s pricing model is straightforward, charging per full workflow execution. This means users can process even complex workflows with unlimited steps without worrying about unpredictable costs. All paid plans come with unlimited users and active workflows. Pricing tiers include:

Workflows continue running even if quotas are exceeded, with overage costs at $4,000 for an additional 300,000 executions on Business plans. Startups with fewer than 20 employees can apply for the Startup Plan, which offers a 50% discount on the Business tier.

n8n prioritizes security and compliance, meeting SOC 2 standards and supporting features like SSO (SAML/LDAP), RBAC, and encrypted credential storage through AWS Secrets Manager or HashiCorp Vault. The Insights Dashboard provides detailed execution tracking, while Business plan users receive weekly usage reports and proactive notifications when nearing 80% of their annual quota.

At Delivery Hero, n8n has proven to be a game-changer. Dennis Zahrt, Director of Global IT Service Delivery, shared that implementing n8n for user management and IT operations saved the company 200 hours per month. Reflecting on the experience, he stated:

We have seen drastic efficiency improvements since we started using n8n for user management. It's incredibly powerful, but also simple to use. - Dennis Zahrt, Director of Global IT Service Delivery, Delivery Hero

In the rapidly advancing world of AI workflow automation, Make stands out with its impressive offering of over 3,000 app integrations and 30,000 actions. It further strengthens its capabilities with 400+ AI-specific app integrations, connecting users to major services like OpenAI (ChatGPT, Sora, DALL-E, Whisper), Anthropic Claude, Google Vertex AI (Gemini), Azure OpenAI, Perplexity AI, DeepSeek AI, Mistral AI, ElevenLabs, Synthesia, and Hugging Face. With these tools, users can create AI Agents to repurpose existing workflows for tasks like data retrieval and execution. For proprietary systems, the platform provides a Custom App builder and HTTP/Webhook modules to connect with public APIs.

Make’s integration capabilities are complemented by advanced tools for designing workflows. Its visual builder supports features like multi-branch routing, iterators, and aggregators, making it easier to handle complex data tasks. The platform also includes Maia, an AI assistant that helps users build and troubleshoot workflows using natural language commands, and Make Grid, which provides a visual representation of automation performance.

Philipp Weidenbach, Head of Operations at Teleclinic, highlighted the platform’s impact:

Make really helped us to scale our operations, take the friction out of our processes, reduce costs, and relieved our support team.

Similarly, Cayden Phipps, COO of Shop Accelerator Martech, described the efficiency gains as transformative:

Make drives unprecedented efficiency within our business in ways we never imagined. It's having an extra employee (or 10) for a fraction of the cost.

These features make the platform a powerful choice for businesses looking to optimize and scale their operations.

Make operates as a cloud-based platform, enabling users to scale workflows without the need for coding expertise. Its AI Agents are designed to be goal-driven, relying on natural language to interpret tasks and dynamically select the best tools from Make’s extensive library. These agents are reusable across workflows, reducing redundancy and simplifying management.

Make offers a free tier, with paid plans starting at $9 per month. For larger organizations requiring advanced governance and support, enterprise pricing is available. AI Agents are included in all plans, ensuring accessibility for all users. The platform serves a vast user base of over 350,000 customers and receives excellent feedback, with ratings such as 4.8/5 on Capterra (404 reviews), 4.7/5 on G2 (238 reviews), and 4.8/5 on GetApp (404 reviews).

Make prioritizes security and compliance, maintaining SOC 2 Type II and GDPR compliance. It offers robust encryption, Single Sign-On (SSO), and role-based access control (RBAC) to manage workflow operations across teams. While the platform’s flexibility for building complex automations is widely appreciated, some users have noted that the interface can be challenging for simpler tasks, requiring a bit of a learning curve.

Workato drives AI workflows with over 1,200 connectors, seamlessly linking SaaS platforms, on-premises systems, and databases. Its native integrations with leading LLM providers - such as OpenAI, Anthropic, Google Gemini, Amazon Bedrock, Azure OpenAI, Mistral AI, and Perplexity - make it a standout choice for AI model workflows. Additionally, the platform supports vector databases like Pinecone and Qdrant, and works with LangChain-compatible protocols, including the Model Context Protocol (MCP). Recognized as a Leader in the Gartner Magic Quadrant for Integration Platform as a Service (iPaaS) for 7 consecutive years, Workato is trusted by 50% of the Fortune 500.

تقدم Workato ثلاثة مستويات من التكامل: الموصلات المبنية مسبقًا والبروتوكولات العالمية (HTTP و OpenAPI و GraphQL و SOAP) والخيارات التي يساهم بها المجتمع. إنها «الذكاء الاصطناعي من Workato» يعمل الموصل على تبسيط المهام مثل تحليل النص وصياغة البريد الإلكتروني والترجمة والتصنيف والاستفادة من النماذج من Anthropic و OpenAI. من خلال إدارة مفاتيح API عبر العديد من موفري LLM، فإنه يزيل متاعب التكوين اليدوي. بالنسبة للأنظمة التي لا تحتوي على موصلات موجودة، يتيح Universal Connector التكامل السلس مع نماذج الذكاء الاصطناعي الخاصة أو البنى التحتية القديمة باستخدام البروتوكولات القياسية. يضمن هذا النهج متعدد الطبقات المرونة والكفاءة في إدارة تدفقات عمل الذكاء الاصطناعي المعقدة.

تعمل Workato على بنية قابلة للتطوير بدون خادم تضمن التوسع التلقائي والترقيات بدون توقف، مع ضمان وقت التشغيل بنسبة 99.9٪. بالنسبة للشركات التي تتطلب حلولًا مختلطة، يسمح On-Premise Agents (OPA) بالاتصالات الآمنة بين قواعد البيانات المحلية أو الأنظمة القديمة ونماذج الذكاء الاصطناعي القائمة على السحابة - دون تعريض البيانات الحساسة للإنترنت العام. تضمن هذه البنية التنفيذ المعزول لكل عملية تلقائية، مع الحفاظ على الأداء العالي ومعايير الأمان.

تعطي Workato الأولوية للأمان من خلال شهادات مثل SOC 2 من النوع الثاني وISO 27001 وPCI DSS والتوافق مع GDPR. تعمل ميزات مثل BYOK (إحضار مفتاحك الخاص) مع تدوير المفاتيح كل ساعة ومسارات التدقيق غير القابلة للتغيير على تعزيز حماية البيانات. ال طبقة MCP الخاصة بالمؤسسات يضمن الحوكمة والمصادقة وقابلية التدقيق لوكلاء الذكاء الاصطناعي، مما يوفر تنفيذًا متسقًا عبر أنظمة المؤسسة. العمل إلى شركة أيجيس يوفر لفرق تكنولوجيا المعلومات رؤية لنشاط المستخدم وأنماط الاستخدام وسير عمل التكامل، مما يمكنهم من تنفيذ السياسات التي تخفف من المخاطر مثل «Shadow AI». يضمن التحكم في الوصول المستند إلى الأدوار (RBAC) وإنفاذ وضع البيانات داخل موصل «AI by Workato» أن تظل معالجة البيانات محلية، سواء في الولايات المتحدة أو أوروبا والشرق الأوسط وإفريقيا أو مناطق آسيا والمحيط الهادئ. تساعد هذه الإجراءات القوية على تقليل الاضطرابات مع الحفاظ على التحكم في التكاليف التشغيلية.

«بدأ مستخدمو الأعمال بشكل طبيعي في استخدام Workato. بمجرد تحديد مستخدمي الأعمال هؤلاء، نرتقي بهم ليكونوا أبطالًا لتمكين الفرق الأخرى أو الأشخاص الآخرين، ونستخدمهم للحصول على الموجة التالية من التوسع.» - موهيت راو، رئيس الأتمتة الذكية

تستخدم Workato نموذج تسعير قائم على الاستخدام بأربعة مستويات: المستوى القياسي، ومستوى الأعمال، ومستوى المؤسسة، Workto One، تم تصميم هذا الأخير للتنسيق القائم على الذكاء الاصطناعي. يتم تحديد الأسعار من خلال «المهام» (كل خطوة من خطوات الوصفة أو السجل المعالج) والوصفات والموصلات، مع بدء عمليات النشر النموذجية للمؤسسات من 50,000 دولار سنويًا. توفر لوحة المعلومات المركزية رؤى الفواتير في الوقت الفعلي وسجلات المهام وتنبيهات الميزانية، مما يساعد الشركات على تجنب النفقات غير المتوقعة أثناء التوسع. تتطلب ميزات الذكاء الاصطناعي التوقيع على إضافة ميزة AI ويتم تضمينها في خطط التسعير المحددة. من خلال الجمع بين إمكانات سير عمل الذكاء الاصطناعي المتقدمة والأمان القوي وقابلية التوسع، يضمن Workato تجربة مبسطة لإدارة عمليات الدمج المعقدة.

قوة الوكيل هي منصة Salesforce المدعومة بالذكاء الاصطناعي والمصممة لاسترداد البيانات بشكل مستقل وتحليلها وتنفيذ المهام. تتكامل تمامًا مع Salesforce CRM، وهي تستفيد من محرك أطلس للاستدلال للاستجابات الأرضية في بيانات المؤسسة الموثوقة، مما يقلل بشكل كبير من عدم الدقة. يطلق مارك بينيوف، الرئيس التنفيذي لشركة Salesforce، على ذلك اسم «الموجة الثالثة من الذكاء الاصطناعي»، مما يمثل تحولًا من الطيارين البسطاء إلى الوكلاء الأذكياء الذين يركزون على تقديم نتائج دقيقة وقابلة للتنفيذ تعزز نجاح العملاء. وضعت Salesforce هدفًا طموحًا للنشر مليار وكيل من خلال Agentforce بحلول نهاية عام 2025، بهدف إعادة تعريف الكفاءة التشغيلية داخل نظامها البيئي.

Agentforce جزء لا يتجزأ من نظام Salesforce البيئي، ويتصل بأدوات مثل سحابة البيانات، مول سوفت، و تدفق ساليسفورس. من خلال موصلات MuleSoft API، يمكن للمنصة التفاعل مع الأنظمة القديمة والتطبيقات الخارجية، حتى في إعدادات المؤسسة المعقدة. ال شبكة شركاء Agentforce يوسع قدراته من خلال الاندماج مع اللاعبين الرئيسيين مثل AWS و Google و IBM و Workday و Box. ميزة بارزة، «نسخة زيرو» التكامل، يسمح للوكلاء بتحليل بحيرات البيانات الخارجية مثل Snowflake في الوقت الفعلي دون تكرار البيانات. يضمن هذا الأسلوب الدقة مع تقليل تكاليف التخزين.

يتم تقديم Agentforce حصريًا كملف حل SaaS المستند إلى السحابة ضمن البنية التحتية لـ Salesforce، مما يضمن قابلية التوسع والتعاون السلس مع الفرق البشرية. على سبيل المثال، خلال ذروة العودة إلى المدرسة في سبتمبر 2024، قامت شركة النشر العملاقة Wiley بتطبيق Agentforce لتبسيط الوصول إلى الحساب والتسجيل ومشكلات الدفع. تحت إشراف كيفن كويغلي، المدير الأول للتحسين المستمر، تم دمج الإعداد بدون تعليمات برمجية مع قاعدة معارف Salesforce الحالية لشركة Wiley. النتيجة؟ أ تحسن بنسبة 40% في معدلات حل الحالات مقارنة بالروبوت السابق الخاص بهم، مما أدى إلى تحرير الوكلاء البشريين للتعامل مع احتياجات العملاء الأكثر تعقيدًا.

تضمن Agentforce الامتثال والأمان من خلال Salesforce طبقة الثقة، الذي يفرض أذونات المستخدم ويحمي البيانات الحساسة ويضع علامة على المخرجات غير المناسبة. ال محرك أطلس للاستدلال يتحقق من صحة الردود للتأكد من أنها دقيقة ومستندة إلى بيانات موثوقة، وتجنب الهلوسة. تشمل الضمانات الإضافية حماية سريعة من الحقن، الذي يخفف المخاطر قبل تقديم الاستجابات، و تصفية شرطية، الذي يحظر الإجراءات غير المصرح بها - مثل منع معالجة الدفع حتى يتم التحقق من المستخدم. توثق مسارات التدقيق سلوك الوكيل للامتثال، بينما تكامل البيانات 360 يعمل على تشغيل الجيل المعزز للاسترداد الآمن (RAG) داخل بيئة Salesforce.

يبدأ تسعير Agentforce من 2 دولار لكل محادثة للاستخدام القياسي. لعمليات النشر على مستوى المؤسسة، قروض فليكس متوفرة، بدءًا من 500 دولار مقابل 100,000 نقطة ائتمان، مع تقديم خصومات للأحجام الكبيرة. تتم إدارة الميزات الإضافية، مثل إمكانات Data 360 للفهرسة والتحليلات، من خلال نظام المحفظة الرقمية. يوفر هذا الإعداد رؤية واضحة لاستخدام الموارد والتكاليف المرتبطة بها، مما يضمن قدرة الشركات على تتبع وإدارة النفقات بفعالية.

فيلوم AI يعمل كمنصة تنسيق متعددة الاستخدامات، مما يتيح الاستخدام السلس للعديد من LLMs دون تقييد المستخدمين في بائع واحد. إنه يسد الفجوة بين مديري المنتجات والمهندسين من خلال مزامنة عمليات التحرير بدون تعليمات برمجية مع كود CLI، مما يؤدي إلى إنشاء سير عمل موحد. يضع هذا التكامل الأساس للقدرات التقنية المتقدمة لشركة Vellum.

يدعم Vellum مجموعة واسعة من أنواع العقد - مثل API، تنفيذ التعليمات البرمجية (بايثون/تيبسكريبت)، ابحث (RAG)، و عُقَد الوكيل - السماح للمستخدمين ببناء أنظمة الذكاء الاصطناعي المعقدة. تدعم المنصة أيضًا الإنسان في الحلقة سير العمل، وإيقاف التنفيذ مؤقتًا لاستيعاب المدخلات الخارجية أو الموافقات اليدوية قبل المتابعة. بالإضافة إلى ذلك، عُقد سير العمل الفرعي تبسيط إدارة المشروع من خلال تمكين الفرق من إنشاء مكونات قابلة لإعادة الاستخدام، وضمان الاتساق عبر التطبيقات المختلفة. كما أوضح جوردان نيمرو، المؤسس المشارك والرئيس التنفيذي للتكنولوجيا في Woflow:

قمنا بتسريع تطوير الذكاء الاصطناعي بنسبة 50 بالمائة وفصلنا التحديثات عن الإصدارات باستخدام Vellum.

تقدم Vellum مجموعة من طرق النشر لتناسب الاحتياجات التشغيلية المتنوعة، بما في ذلك سحابة مُدارة، VPC خاص، هجين، و داخل المبنى البيئات. بالنسبة للمؤسسات التي لديها متطلبات صارمة لوضع البيانات، تتوفر أيضًا الإعدادات ذات الفجوات الهوائية. يعمل خيار الاستضافة الذاتية على تمكين الشركات من تشغيل عمليات سير العمل داخل البنية التحتية الخاصة بها، مما يضمن التحكم الكامل في البيانات. قال ماكس برايان، نائب رئيس التكنولوجيا والتصميم:

لقد خفضنا الجدول الزمني لمدة 9 أشهر إلى النصف مع تحسين دقة المساعد الافتراضي بشكل كبير.

يوفر Vellum أسعارًا مباشرة، بدءًا من فئة مجانية مثالية للاختبار أو المشاريع الصغيرة. تبدأ الخطط المدفوعة في 25 دولارًا في الشهر، في حين تقدم خطط المؤسسات أسعارًا مصممة خصيصًا لتلبية الاحتياجات واسعة النطاق. تتضمن المنصة تتبعًا تفصيليًا لاستخدام الرمز المميز والمكالمات النموذجية، إلى جانب حواجز حماية مدمجة للميزانية والاختناق التلقائي لمنع الإنفاق الزائد. والجدير بالذكر أن رسوم فيلوم لا توجد رسوم استضافة لعمليات سير العمل التي يتم تشغيلها على النظام الأساسي الخاص بهم، مما يساعد الفرق على تجنب تكاليف البنية التحتية غير المتوقعة.

يعد الأمان والامتثال في صميم تصميم Vellum. ميزات مثل رباك، SSO/سيم، سجلات التدقيق، و واجهات برمجة التطبيقات المؤمنة من HMAC ضمان عمليات آمنة. مراجعات الإصدار المتكاملة و عُقد الدرابزين المساعدة في تدقيق التغييرات وتحديد المخرجات غير المتوافقة. يتوافق Vellum مع سوك 2، GDPR، و هيبا المعايير التي توفر راحة البال للصناعات المنظمة. توفر طرق عرض التتبع المتقدمة وتكامل Datadog إمكانية المراقبة من البداية إلى النهاية، مما يمكّن الفرق من تصحيح المشكلات ومراقبة اتجاهات الإنتاج في الوقت الفعلي دون المساس بالكفاءة.

قطع نشطة هي عبارة عن منصة أتمتة مفتوحة المصدر مصممة لسير عمل الذكاء الاصطناعي. يضم مكتبة تضم 611 موصلات مسبقة الصنع، والمعروفة باسم «القطع»، والتي تتكامل بسلاسة مع التطبيقات الشائعة مثل Gmail وSlack وSalesforce. هذه القطع مكتوبة بـ تيبسكريبت ويتم توزيعها كحزم npm، مما يوفر للمطورين المرونة لتعديل الروابط أو إنشائها. بالإضافة إلى ذلك، تدعم المنصة بروتوكول السياق النموذجي (MCP)، مما يمكّن أجزائه من العمل كأدوات لوكلاء الذكاء الاصطناعي الخارجيين مثل Claude أو Cursor، مما يوسع وظائفه بما يتجاوز منشئه الأصلي.

تقدم Activopieces مجموعة متنوعة من الإجراءات الأصلية، بما في ذلك التحليل وتوليد الصور والتلخيص والتصنيف. إنه يتألق في استخراج البيانات المنظمة من مصادر غير منظمة، مثل رسائل البريد الإلكتروني والفواتير والمستندات الممسوحة ضوئيًا. لمزيد من عمليات سير العمل المعقدة، فإن تشغيل الوكيل يتعامل الإجراء مع التفكير متعدد الخطوات واستخدام الأداة، بينما حزمة الذكاء الاصطناعي يمكّن الفرق من تطوير وكلاء مخصصين. تتضمن المنصة أيضًا الجداول، وهو مخزن بيانات مركزي يربط الوكلاء وعمليات سير العمل، ويعمل كمحور ذاكرة لعمليات التشغيل الآلي. بشكل مثير للإعجاب، حول 60% من قطع المنصة تأتي من مجتمعها النشط مفتوح المصدر، الذي يعرض نظامًا بيئيًا مزدهرًا من المساهمين.

توفر Activepieces المرونة في النشر مع كل من خدمة السحابة المُدارة و خيار الاستضافة الذاتية باستخدام دوكر. بالنسبة للمؤسسات التي تتطلب رقابة صارمة على البيانات، فإنها تدعم البيئات التي تعاني من فجوات في الشبكة. بالإضافة إلى ذلك، يمكن لشركات البرمجيات الاستفادة من تضمين القطع النشطة، مما يسمح لهم بدمج أداة إنشاء الأتمتة مباشرةً في منتجات SaaS الخاصة بهم، مما يوفر وظائف سير العمل ذات العلامة البيضاء لمستخدميهم.

تستخدم Activepieces نهجًا واضحًا ومباشرًا نموذج التسعير القائم على التدفق. على عكس المنصات التي تتقاضى رسومًا لكل مهمة أو تنفيذ، تتقاضى Activipeeces رسومًا 5 دولارات لكل تدفق نشط شهريًا في ITS الطبقة السحابية القياسية، مع تضمين التدفقات العشرة الأولى مجانًا و أشواط غير محدودة. يعد هيكل التسعير هذا مفيدًا بشكل خاص لسير عمل الذكاء الاصطناعي الذي يتضمن الاقتراع المتكرر أو العمليات المعقدة متعددة الخطوات. بالنسبة لأولئك الذين يفضلون الاستضافة الذاتية، فإن إصدار المجتمع متاح بموجب ترخيص MIT بدون تكلفة، على الرغم من أنه يتطلب خبرة فنية لإدارته. يمكن لعملاء المؤسسات الذين يبحثون عن ميزات متقدمة مثل SSO و RBAC وسجلات التدقيق اختيار المستوى النهائي، متاح من خلال عقود سنوية بأسعار مخصصة.

القطع النشطة هي متوافق مع SOC 2 من النوع الثاني ويقدم أدوات إدارة على مستوى المؤسسة. يمكن للمسؤولين التحكم في رؤية القطعة من قبل المستخدم أو العميل وتخصيص المنشئ باستخدام العلامة التجارية ذات العلامة البيضاء. تشمل الميزات الرئيسية سجل الإصدارات لاستعادة التدفقات، إعادة المحاولة التلقائية للخطوات الفاشلة وأدوات تصحيح الأخطاء القوية لتحليل سجل التشغيل. بالنسبة لعمليات سير العمل التي تتطلب تدخلًا يدويًا، تتضمن المنصة الإنسان في الحلقة الوظيفة، مما يسمح للعمليات بالتوقف مؤقتًا للحصول على الموافقات أو التعليقات قبل المتابعة. وهذا يضمن مراجعة القرارات الحاسمة بعناية ودقة.

حاكم عبارة عن منصة تنسيق أصلية من Python مصممة لتحويل أي وظيفة Python إلى سير عمل باستخدام وظيفة واحدة فقط @flow مصمم ديكور. مع 6.8 مليون عملية تنزيل شهرية وأكثر من 21400 نجمة على GitHub، اكتسب التطبيق جاذبية كبيرة بين المطورين. على عكس أجهزة التنسيق التقليدية التي تعتمد على هياكل DAG الصلبة، يتبنى Prefect تدفق التحكم الأصلي في Python وتلميحات الكتابة وأنماط عدم التزامن/الانتظار. هذه المرونة تجعلها خيارًا ممتازًا لسير عمل نموذج الذكاء الاصطناعي الديناميكي الذي يحتاج إلى التعديل في الوقت الفعلي.

تقدم Prefect منصة مُدارة تسمى بريفكت هورايزن، مصممة للبنية التحتية للذكاء الاصطناعي. يتضمن ميزات مثل بوابة MCP (بروتوكول السياق النموذجي) وسجل الخادم، مما يمكّن مساعدي الذكاء الاصطناعي من مراقبة عمليات النشر وعمليات التصحيح والاستعلام عن البنية التحتية دون عناء. تتكامل المنصة بسلاسة مع مزودي السحابة الرئيسيين وأدوات البيانات مثل Snowflake و Databricks و dbt و Fivetran، بالإضافة إلى أطر الحوسبة مثل Ray و Dask و Kubernetes. يدعم Prefect أيضًا حالات الاستخدام الخاصة بالذكاء الاصطناعي من خلال حزم مثل ريفيكت-هيكسس. يمكن تشغيل عمليات سير العمل من خلال الأحداث الخارجية أو روابط الويب أو الأحداث السحابية، مما يسمح لأنظمة الذكاء الاصطناعي بالاستجابة ديناميكيًا لتغييرات البيانات في الوقت الفعلي.

«لقد قمنا بتحسين الإنتاجية بمقدار 20 ضعفًا باستخدام Prefect. إنه العمود الفقري لدينا للمعالجة غير المتزامنة - سكين الجيش السويسري.» - سميت شاه، مدير الهندسة في Snorkel AI

توفر عمليات الدمج هذه الأساس لنماذج النشر عالية المرونة.

تقدم Prefect ثلاثة مسارات نشر لتناسب الاحتياجات المختلفة:

Prefect’s Work Pools feature separates workflow code from execution environments. This allows workflows to move seamlessly between local development, Docker, Kubernetes, AWS ECS, Google Cloud Run, and Azure ACI without requiring code changes. For example, Snorkel AI uses Prefect OSS on Kubernetes to manage over 1,000 flows per hour.

Prefect OSS is entirely free for self-hosted deployments. Prefect Cloud includes a free tier for individuals and small teams, with enterprise-level paid tiers offering advanced governance capabilities. Prefect Horizon, aimed at enterprise-scale AI infrastructure, typically requires direct consultation for pricing. The platform’s efficiency is a major draw - Prefect 3.0, released in 2024, reduced runtime overhead by an impressive 90% compared to its earlier versions.

Prefect Cloud and Horizon are SOC 2 Type II compliant, offering enterprise-grade security features like Single Sign-On (SSO) and Role-Based Access Control (RBAC). Prefect Horizon also governs AI agent access to business systems through its MCP Gateway and Server Registry. For workflows requiring human oversight, Prefect supports human-in-the-loop pauses, enabling manual review or approval before tasks proceed. Additional features like automatic state tracking, real-time monitoring, and persistent logs ensure a complete audit trail for every task. For organizations with strict security requirements, the OSS version offers full control within their private VPC.

"Horizon is the avenue by which we can best deploy MCP within our organization. Out of the box, take my GitHub repo, launch it, and it just works for us." - James Brink, Head Trader, Nitorum Capital

Amazon Bedrock serves as AWS's managed API gateway for foundation models, offering access to cutting-edge tools from providers like AI21 Labs, Anthropic, Cohere, Meta, Mistral AI, Stability AI, and Amazon itself. With over 100,000 organizations relying on its services, Bedrock includes innovative features like Bedrock Flows, a no-code, visual builder for creating multi-step generative AI workflows, and AgentCore, a flexible platform for building and managing AI agents using frameworks like LangGraph or CrewAI.

Bedrock stands out for its seamless integration capabilities. Its AgentCore Gateway transforms APIs and Lambda functions into MCP-compatible tools, simplifying connections to enterprise systems like Salesforce, Slack, and Jira. The platform also supports multi-agent collaboration, enabling specialized agents to work together under a supervisory agent for handling complex business processes.

Between 2023 and 2024, Robinhood dramatically scaled its operations with Bedrock, increasing token usage from 500 million to 5 billion daily. This expansion resulted in an 80% reduction in AI costs and a 50% cut in development time, thanks to leadership from Dev Tagare, Robinhood’s Head of AI.

"AgentCore's key services – Runtime for secured deployments, Observability for monitoring, and Identity for authentication – are enabling our teams to develop and test these agents efficiently as we scale AI across the enterprise." – Marianne Johnson, EVP & Chief Product Officer, Cox Automotive

Another success story comes from the Amazon Devices Operations & Supply Chain team, which used AgentCore to automate robotic vision model training. This innovation reduced fine-tuning time from several days to under an hour in 2024.

Bedrock offers a fully managed, serverless infrastructure, removing the burden of infrastructure management. It supports private connectivity through AWS PrivateLink and Amazon VPC, ensuring sensitive data never traverses the public internet. All customer data is encrypted both at rest and in transit using AWS Key Management Service (KMS). Moreover, AWS guarantees that customer data is never shared with third-party model providers or used to train base foundation models.

Bedrock operates on a pay-as-you-go pricing model, eliminating upfront commitments. Costs vary by model; for instance, using Anthropic Claude 3.5 Sonnet v2 costs $0.006 per 1,000 input tokens and $0.03 per 1,000 output tokens. Bedrock offers three pricing tiers:

Additional cost-saving features include:

In 2024, Epsilon utilized these features to reduce campaign setup time by 30% and save teams approximately 8 hours per week.

Bedrock is built with security and compliance at its core, meeting standards such as ISO, SOC, CSA STAR Level 2, GDPR, FedRAMP High, and HIPAA eligibility. Key features include:

The platform integrates seamlessly with AWS IAM, CloudTrail, and CloudWatch for monitoring. Additionally, AgentCore enhances security with session isolation and identity management, supporting OIDC/SAML compatibility through Cedar policies.

"Amazon Bedrock's model diversity, security, and compliance features are purpose-built for regulated industries." – Dev Tagare, Head of AI, Robinhood

يمكن أن يؤدي اختيار النظام الأساسي المناسب إلى إحداث فرق كبير عندما يتعلق الأمر بخفض التكاليف التشغيلية وتحسين أمان سير العمل. فيما يلي مقارنة بين بعض المنصات الرئيسية وميزاتها البارزة.

Prompts.ai يجمع أكثر من 35 طرازًا من الدرجة الأولى - بما في ذلك GPT-5 وكلود ولاما وجيميني - في واجهة واحدة مبسطة. إنه يوفر تتبع FinOps في الوقت الفعلي، مما يقلل بشكل كبير من النفقات المتعلقة بالذكاء الاصطناعي. من خلال أرصدة TOKN للدفع أولاً بأول، يمكن للمستخدمين تجنب رسوم الاشتراك المتكررة مع الاستمتاع بالوصول المركزي إلى النماذج دون الارتباط ببائع واحد.

كيوبيفلو، من ناحية أخرى، هي عبارة عن منصة Kubernetes الأصلية مصممة للتدريب الموزع. إنه معياري للغاية ويستفيد من الدعم المجتمعي القوي. وفي الوقت نفسه، حاكم يتألق في إدارة سير العمل الديناميكي، خاصة بالنسبة لعمليات سير العمل الأصلية في Python. يمكن لوكلاء الذكاء الاصطناعي اتخاذ قرارات وقت التشغيل، مما يوفر المرونة والكفاءة. على سبيل المثال، أدى التحول من Astronomer إلى Prefect إلى انخفاض بنسبة 73.78٪ في تكاليف الفواتير لـ Endpoint.

أمازون بيدروك تبرز من خلال توفير وصول مُدار قائم على السحابة إلى النماذج الأساسية. هذا يجعله خيارًا ممتازًا للمؤسسات التي ترغب في توسيع نطاق تطبيقات الذكاء الاصطناعي المولدة دون القلق بشأن إدارة البنية التحتية.

كل منصة لها تركيزها الخاص، سواء كان الوصول إلى النموذج الموحد أو التنسيق الديناميكي أو الإدارة المستندة إلى السحابة القابلة للتطوير. تقدم معظم المنصات أيضًا إصدارات مفتوحة المصدر مستضافة ذاتيًا (وهي مجانية ولكنها تتطلب موارد داخلية) وحلول السحابة المُدارة مع ميزات على مستوى المؤسسات مثل تسجيل الدخول الأحادي (SSO) والتحكم في الوصول المستند إلى الأدوار (RBAC). تتجه الصناعة أيضًا نحو التنسيق الديناميكي للذكاء الاصطناعي، والتحول من الرسوم البيانية غير الدورية الموجهة الثابتة (DAGs) إلى أجهزة الحالة التكيفية، والتي تسمح بالموافقات البشرية في الحلقة والتعديلات المنطقية في الوقت الفعلي.

يتطلب اختيار النظام الأساسي المناسب لسير عمل الذكاء الاصطناعي مواءمة ميزاته مع المتطلبات الفريدة لمؤسستك. تقدم كل منصة تمت مناقشتها هنا مزايا مميزة، سواء كانت توفر وصولاً موحدًا إلى النماذج، أو تتيح التنسيق المرن، أو تضمن الأمان على مستوى المؤسسة. تضع هذه المحاذاة الأساس لتقييم التكامل والتسعير والأمان وقابلية التوسع.

قدرات التكامل هي المفتاح لربط عمليات سير عمل الذكاء الاصطناعي بمجموعة التكنولوجيا الحالية لديك. كما يوضح نيكولا زيب:

لا تحل ميزة التشغيل التلقائي لسير العمل بالذكاء الاصطناعي ذات التعليمات البرمجية المنخفضة محل مجموعتك الحالية.

يضمن التكامل السلس أن مبادرات الذكاء الاصطناعي تعزز العمليات التجارية الأوسع بدلاً من البقاء غير متصلة. وبدون ذلك، قد يصبح الذكاء الاصطناعي معزولاً - وهو التحدي الذي أشار إليه 46٪ من فرق المنتجات باعتباره العائق الأساسي أمام التبني.

وضوح التسعير هو عامل حاسم آخر، خاصة كمقاييس الاستخدام. في حين أن بعض المنصات تقدم أسعارًا جذابة للمبتدئين، يمكن أن ترتفع التكاليف مع زيادة الاستخدام. غالبًا ما توفر نماذج التسعير القائمة على التنفيذ مزيدًا من القدرة على التنبؤ مقارنة بأنظمة الائتمان لكل خطوة، حيث يستهلك كل إجراء من إجراءات الذكاء الاصطناعي كميات متفاوتة من الائتمانات. يُعد تقدير التكاليف للسيناريوهات ذات الحجم الكبير، مثل أكثر من 100,000 إجراء شهريًا، أمرًا ضروريًا قبل الالتزام.

متين عناصر التحكم في الأمان لا غنى عنها لبيئات الإنتاج. ابحث عن ميزات مثل التوافق مع SOC 2 Type II والتحكم في الوصول المستند إلى الأدوار (RBAC) وسجلات التدقيق التفصيلية. بالنسبة للصناعات ذات اللوائح الصارمة، تأكد من أن المنصة توفر الامتثال لـ HIPAA والتشفير المخصص للمستأجر. عندما يتعامل وكلاء الذكاء الاصطناعي مع بيانات الأعمال الحساسة، فإن الحوكمة القوية غير قابلة للتفاوض.

أخيرًا، ضع في اعتبارك قدرة المنصة على الدعم نمو طويل الأجل. لا يشمل ذلك الأداء الفني فحسب، بل يشمل أيضًا الميزات التي تتيح قابلية التوسع التنظيمي. يجب أن تدير المنصة التعقيد المتزايد دون المساس بالأداء وأن تقدم أدوات الحوكمة مثل التحكم في الإصدار والاختبار جنبًا إلى جنب. غالبًا ما تقدم منصات سير العمل الخارجية للذكاء الاصطناعي نتائج إنتاج أفضل من الحلول المبنية داخليًا، ولكن فقط إذا تمكنت من التوسع بفعالية جنبًا إلى جنب مع أهدافك.

عند اختيار منصة سير العمل بالذكاء الاصطناعي، هناك بعض الجوانب الهامة التي يجب تقييمها لضمان توافقها مع متطلباتك. ابدأ بـ توافق النموذج - تأكد من أن النظام الأساسي يدعم مجموعة واسعة من نماذج الذكاء الاصطناعي ويسمح بالاندماج السلس في أنظمتك الحالية. تضمن هذه المرونة إمكانية الاستفادة من أفضل الأدوات لمهامك المحددة.

بعد ذلك، قم بتقييم المنصة قدرات الأتمتة والتنسيق. ابحث عن الميزات التي يمكنها إدارة عمليات سير العمل المعقدة، بما في ذلك تلك التي تحتوي على المنطق الشرطي أو العمليات البشرية في الحلقة. هذه القدرات ضرورية لتبسيط العمليات وتحسين الكفاءة.

أمان البيانات والامتثال يجب أن تكون أيضًا أولوية قصوى، خاصة إذا كنت تتعامل مع بيانات حساسة أو تحتاج إلى تلبية معايير تنظيمية صارمة. يمكن أن تساعد المنصة ذات الإجراءات الأمنية القوية وخيارات الامتثال في حماية عملياتك والحفاظ على الثقة.

أخيرًا، ضع في اعتبارك المنصة القابلية للتطوير ومستوى دعم المجتمع متاح. يضمن الحل القابل للتطوير إمكانية نموه جنبًا إلى جنب مع احتياجاتك، بينما يمكن لمجتمع الدعم القوي توفير موارد قيمة ومساعدة في استكشاف الأخطاء وإصلاحها. سيساعدك تقييم هذه العوامل على اختيار منصة تعزز سير عمل الذكاء الاصطناعي وتدعم أهدافك طويلة المدى.

التسعير القائم على التنفيذ في منصات الذكاء الاصطناعي يعني أن تكاليفك يتم تحديدها من خلال المبلغ الذي تستخدمه فعليًا - سواء كان ذلك عدد المكالمات النموذجية أو حجم البيانات التي تمت معالجتها أو المهام المكتملة. بدلاً من تقييد نفسك باشتراك ثابت أو قدرة شراء مسبقة، يعمل هذا الأسلوب على مواءمة النفقات مباشرةً مع استخدامك.

يعد نموذج التسعير هذا مفيدًا بشكل خاص للشركات التي تتطلع إلى توسيع نطاق سير عمل الذكاء الاصطناعي. يتيح لك ضبط الإنفاق في الوقت الفعلي بناءً على احتياجاتك الحالية، مما يساعدك على تجنب الدفع مقابل الموارد غير المستخدمة أو الإنفاق الزائد. سواء أكنت تقوم بالتكبير أو التقليص، فإنك تدفع فقط مقابل ما تستخدمه، مما يزيل عبء التكاليف الأولية أو السعة المهدرة.

عند اختيار منصة سير عمل AI، أمن يجب أن تكون دائمًا في المقدمة لحماية المعلومات الحساسة وحماية خوارزميات الملكية وتلبية المتطلبات التنظيمية. فيما يلي بعض ميزات الأمان الأساسية التي يجب وضعها في الاعتبار:

تعمل هذه الميزات معًا للحفاظ على أمان بياناتك، والحفاظ على سلامتها وسريتها، والتوافق مع معايير الأمان الصارمة المطلوبة في صناعات مثل التمويل والرعاية الصحية.