L'évaluation des résultats des grands modèles linguistiques (LLM) garantit précision, minimise les risques et aligne les résultats sur les besoins de l'entreprise. Une mauvaise évaluation peut entraîner des erreurs, des problèmes de conformité et des résultats biaisés. Voici comment évaluer efficacement les performances du LLM :

Astuce rapide: Combinez des outils automatisés avec une supervision humaine et suivez les résultats pour affiner les processus en permanence. Cette approche garantit des résultats fiables et de haute qualité tout en réduisant les risques.

L'établissement de critères standardisés transforme le processus d'évaluation des grands modèles linguistiques (LLM) en un effort structuré et objectif. Cela élimine les conjectures et les arguments subjectifs, en mettant l'accent sur des résultats mesurables qui correspondent à vos objectifs.

Commencez par définir en quoi consiste le succès de votre application spécifique. Un chatbot de service client, par exemple, exigera des normes d'évaluation différentes de celles d'un outil de création de contenu ou d'un assistant de code. Personnalisez vos critères pour refléter les exigences réelles de votre cas d'utilisation.

Gartner a indiqué que 85 % des projets GenAI échouaient en raison de données erronées ou de tests de modèles inappropriés.

Cela souligne l'importance de consacrer du temps et des ressources à la création de cadres d'évaluation avant de déployer un modèle.

Indicateurs de performance de base constituent la base de tout système d'évaluation LLM, offrant des moyens objectifs de mesurer la qualité des résultats. Les indicateurs clés incluent Exactitude, qui évalue l'exactitude des faits (par exemple, en s'assurant de la précision des calculs financiers), et Pertinence, qui évalue dans quelle mesure les réponses correspondent aux requêtes des utilisateurs.

Pour une approche équilibrée, combinez 1 à 2 mesures personnalisées adaptées à votre cas d'utilisation avec 2 à 3 mesures générales du système. Ces mesures doivent être quantitatives, fiables et conçues pour refléter le jugement humain.

Bien que ces indicateurs de base fournissent un cadre solide, complétez-les par des outils personnalisés pour répondre aux nuances spécifiques de votre application.

Les indicateurs génériques fournissent une vue d'ensemble, mais des listes de contrôle personnalisées sont essentielles pour répondre aux aspects uniques des besoins de votre organisation. Par exemple, dans les tâches de synthèse, les mesures personnalisées peuvent se concentrer sur la manière dont le résumé inclut les informations clés et évite les contradictions.

Les listes de contrôle efficaces combinent une notation automatique avec des alertes pour signaler les sorties inférieures aux seuils acceptables. Des mises à jour régulières de ces listes de contrôle, basées sur des données de performance réelles, garantissent qu'elles restent pertinentes et continuent de répondre à l'évolution des demandes. En affinant ces outils au fil du temps, vous pouvez maintenir l'alignement sur vos objectifs et améliorer les performances globales du modèle.

L'établissement de normes d'évaluation et de listes de contrôle personnalisées n'est qu'un début. Les outils automatisés font passer le processus à un niveau supérieur. Ces outils transforment la tâche traditionnellement lente et manuelle d'évaluation des modèles linguistiques en un système rationalisé piloté par les données. Leur capacité à gérer des évaluations à grande échelle avec rapidité et uniformité est inestimable, en particulier lorsqu'il s'agit de comparer plusieurs modèles ou d'analyser de grands volumes de contenu.

En s'appuyant sur des algorithmes avancés, ces outils évaluent le sens, la cohérence et le contexte, obtenant souvent des résultats comparables au jugement humain. Cette approche garantit des évaluations non seulement précises, mais également évolutives et reproductibles.

Perplexité évalue la capacité d'un modèle de langage à prédire des séquences de mots en mesurant son incertitude au cours de la génération. Un score de perplexité plus faible indique une plus grande confiance dans les prévisions. Elle est calculée comme l'exponentielle de la log-vraisemblance négative moyenne des probabilités prédites pour chaque mot. Par exemple, un score de perplexité de 2,275 reflète une confiance élevée dans le choix des mots. L'un des principaux avantages de Perplexity est qu'il ne repose pas sur des textes de référence, ce qui le rend particulièrement utile pour les tâches créatives. Il convient toutefois de noter que certains modèles basés sur des API ne donnent pas accès aux probabilités de prédiction, ce qui peut limiter l'utilisation de la perplexité dans certains scénarios.

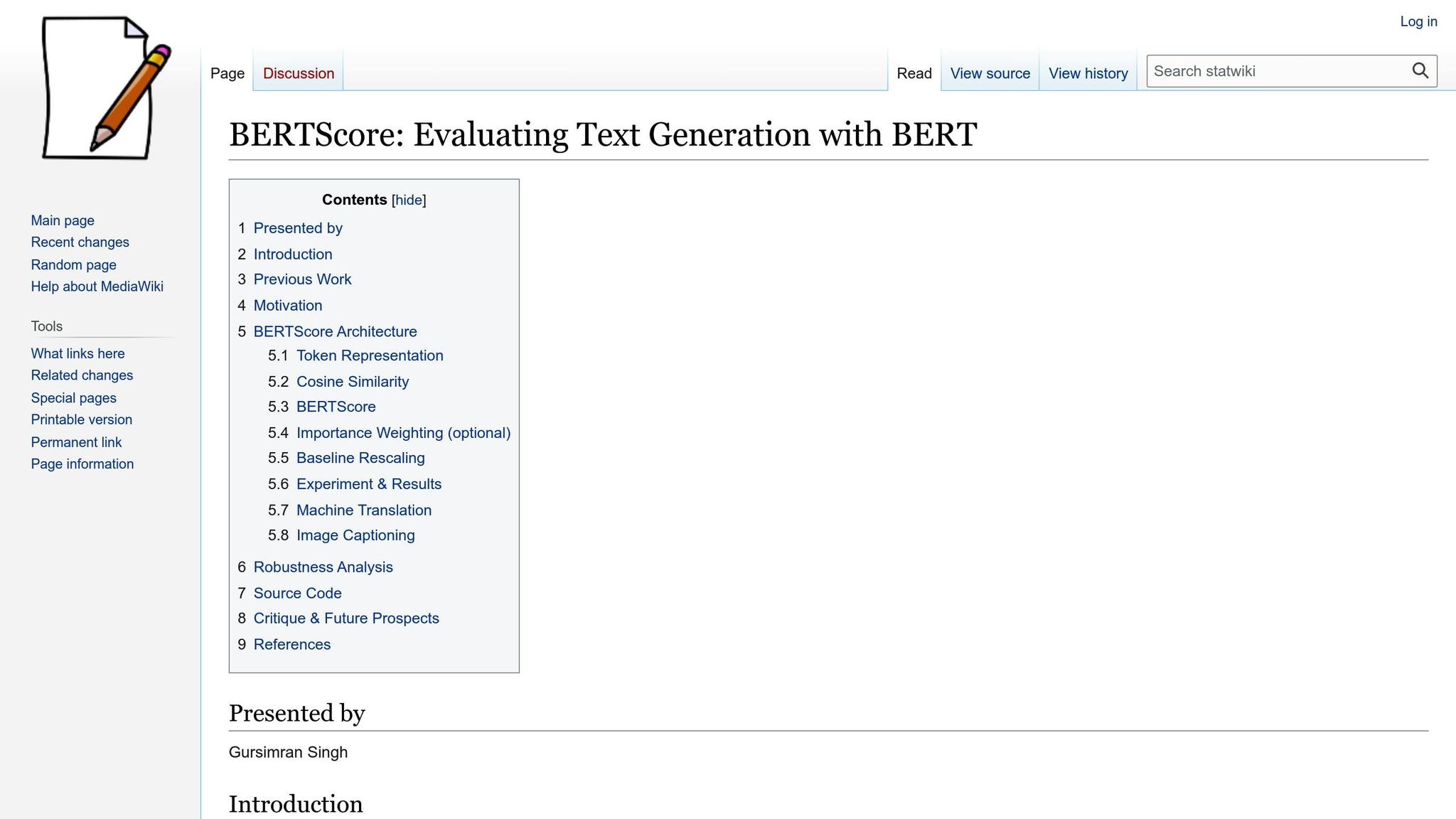

Score Bert, d'autre part, évalue la similitude sémantique entre les textes générés et les textes de référence à l'aide d'intégrations BERT pré-entraînées. Contrairement aux métriques qui reposent sur des correspondances de mots exactes, BertScore capture une signification contextuelle plus profonde. Il permet de tokeniser les deux textes, de générer des intégrations et de calculer la similitude en cosinus entre les jetons correspondants. Par exemple, en comparant « Le chat était assis sur le tapis » à « Un chat était assis sur le tapis », BertScore reconnaît la similitude sémantique entre « assis » et « était assis ».

BLEU (Bilingual Evaluation Understudy) mesure dans quelle mesure le texte généré s'aligne avec les textes de référence en analysant les n-grammes qui se chevauchent. Il applique également une pénalité de brièveté pour décourager les sorties trop courtes.

ROUGE (Recall-Oriented Understudy for Gisting Evaluation) se concentre sur le rappel, en évaluant la part du contenu de référence reflétée dans le texte généré. Des variantes telles que ROUGE-1 (chevauchement d'unigrammes), ROUGE-2 (chevauchement de bigrammes) et ROUGE-L (sous-séquence commune la plus longue) permettent une analyse nuancée de la similitude.

BLEU et ROUGE exigent tous deux des textes de référence, ce qui limite leur applicabilité à l'évaluation de résultats créatifs ou ouverts.

Pour garantir des évaluations fiables, des systèmes de notation peuvent être intégrés aux flux de travail. La notation catégorique fonctionne bien pour les décisions binaires, par exemple pour déterminer si une sortie répond aux normes de qualité ou doit être révisée. La notation multiclasse, quant à elle, permet des évaluations plus détaillées, telles que l'évaluation des résultats sur une échelle de 1 à 5 selon différentes dimensions de qualité.

Lorsque les systèmes de notation automatisés sont associés à des flux de travail, ils peuvent déclencher des actions spécifiques. Par exemple, les sorties inférieures à un seuil défini peuvent être signalées pour être examinées par un humain, tandis que le contenu le plus performant peut être directement transféré au stade du déploiement. Le suivi de la distribution des scores et des évaluations des évaluateurs peut également mettre en évidence des incohérences. Par exemple, si un évaluateur attribue régulièrement des notes plus élevées que les autres, cela peut indiquer la nécessité d'un étalonnage ou d'une formation supplémentaire. L'analyse de ces modèles renforce non seulement la cohérence, mais révèle également des informations qui peuvent orienter les futures améliorations des modèles et des flux de travail. La combinaison de la notation automatisée et de la supervision humaine garantit une assurance qualité complète.

Bien que les outils automatisés excellent dans l'analyse des modèles linguistiques, ils ne parviennent souvent pas à saisir des subtilités telles que le ton, l'adéquation culturelle et la précision spécifique au domaine. Les évaluateurs humains comblent cette lacune en évaluant le contenu par rapport à des normes contextuelles et professionnelles. Ce partenariat entre la compréhension humaine et l'automatisation crée un processus de contrôle qualité plus complet et plus efficace, alliant rapidité et profondeur.

Pour garantir des évaluations complètes, formez une équipe composée d'experts en la matière, d'utilisateurs finaux et de spécialistes linguistiques. Les experts du domaine apportent des connaissances essentielles que les systèmes automatisés ne peuvent pas reproduire. Par exemple, un professionnel de la santé peut détecter des inexactitudes cliniques qui pourraient échapper à un examinateur général, tandis qu'un expert juridique peut identifier les problèmes de conformité dans les contrats ou les politiques.

Cette approche collaborative garantit des résultats à la fois précis et faciles à utiliser. Les équipes qui définissent dès le départ des rubriques d'évaluation claires, couvrant des aspects tels que la précision, la pertinence, le ton et l'exhaustivité, ont tendance à fournir des commentaires plus cohérents et exploitables. Évaluations à l'aveugle peut encore améliorer l'objectivité, en permettant aux évaluateurs d'évaluer les résultats de manière indépendante et sans parti pris. Des sessions d'étalonnage régulières permettent également d'aligner les normes, garantissant ainsi la cohérence dans le temps. Ces sessions sont particulièrement utiles pour discuter de cas difficiles et affiner les critères sur la base d'exemples concrets et des tendances émergentes dans les résultats des modèles.

L'utilisation d'un modèle de langage « juge » (LLM) pour évaluer les résultats constitue une autre stratégie efficace. Cela implique le déploiement d'un LLM distinct, souvent plus avancé ou spécialisé, pour évaluer les résultats de votre modèle principal. Ces modèles d'évaluation excellent dans l'analyse simultanée de plusieurs dimensions, telles que l'exactitude factuelle, la cohérence stylistique et le ton, tout en fournissant un raisonnement détaillé pour leurs évaluations.

Cette méthode est idéale pour les évaluations à grande échelle, car les modèles d'évaluation peuvent traiter efficacement des milliers de résultats, offrant un feedback structuré sur les dimensions clés. En gérant la sélection initiale, ces modèles permettent aux évaluateurs humains de se concentrer sur des cas plus complexes ou ambigus qui nécessitent un jugement plus approfondi.

Pour tirer le meilleur parti de cette approche, rédigez des instructions d'évaluation précises qui décrivent clairement les critères et la structure attendue du feedback. Évitez les simples jugements « oui ou non » ; demandez plutôt des analyses détaillées qui répartissent les performances en catégories spécifiques. Les évaluations comparatives peuvent également être utiles : en classant plusieurs résultats pour la même tâche, les modèles d'évaluation peuvent mettre en évidence de subtiles différences de qualité et expliquer leurs préférences.

Une fois les évaluations terminées, il est essentiel de documenter les résultats pour les affiner à long terme. Enregistrez les détails clés tels que les configurations des modèles, les entrées, les scores et les commentaires des évaluateurs pour permettre une analyse des tendances significative et orienter les améliorations des invites, des modèles et des processus.

Au fil du temps, ces données deviennent un outil puissant pour identifier des modèles. Par exemple, les équipes peuvent déterminer si les performances des modèles s'améliorent ou identifier les problèmes récurrents nécessitant une attention particulière. L'analyse des tendances peut également révéler quelles tâches donnent régulièrement des résultats de haute qualité et celles où une formation supplémentaire ou des ajustements peuvent être nécessaires.

En outre, le suivi des indicateurs de fiabilité inter-évaluateurs, c'est-à-dire la mesure de l'accord entre les évaluateurs, peut fournir des informations précieuses. Un faible accord peut indiquer des critères d'évaluation peu clairs ou des cas ambigus nécessitant un examen plus approfondi, tandis qu'un accord élevé suggère des normes bien définies et une application cohérente.

Enfin, l'intégration du feedback dans le processus de développement garantit que les informations issues de l'évaluation mènent à des améliorations tangibles. Des équipes qui examinent régulièrement les données d'évaluation et ajustent leurs approches, que ce soit en instructions d'affinage, le changement de modèle ou la mise à jour des flux de travail, permettent souvent de constater des gains notables en termes de qualité de sortie. En considérant l'évaluation comme un processus continu plutôt que comme un point de contrôle ponctuel, les organisations peuvent transformer le contrôle qualité en un puissant moteur d'amélioration continue.

En s'appuyant sur les évaluations des performances et de la qualité, il est essentiel d'identifier et de corriger les biais de sortie pour garantir la fiabilité des grands modèles linguistiques (LLM). La détection des biais est différente de l'évaluation de paramètres techniques tels que la qualité linguistique ; elle vise à déterminer si les résultats traitent tous les groupes de manière équitable et évitent de renforcer les stéréotypes néfastes. Cela nécessite des méthodes systématiques pour découvrir des modèles, même subtils, dans de grands ensembles de données.

Pour identifier les biais, examinez les résultats issus d'un large éventail de données démographiques, de sujets et de scénarios. Cela va au-delà de la détection de cas évidents de discrimination et vise à révéler des préjugés plus nuancés susceptibles d'affecter la prise de décision ou de perpétuer des stéréotypes.

Commencez par créer divers ensembles de données de test qui reflètent la diversité des utilisateurs desservis par votre application. Par exemple, les plateformes de recrutement peuvent inclure des CV dont les noms sont liés à différentes origines ethniques, tandis que les scénarios de service client peuvent impliquer des utilisateurs de différents âges, lieux et styles de communication. L'objectif est de s'assurer que vos ensembles de données représentent un large éventail de points de vue.

Test de parité démographique peut aider à déterminer si le modèle traite les différents groupes de manière cohérente. Par exemple, lancez des instructions similaires avec différents marqueurs démographiques et comparez le ton, la qualité et les recommandations des résultats. La détection de différences significatives dans le traitement peut indiquer des biais sous-jacents qui doivent être corrigés.

Testez également pour biais intersectionnels en combinant des variables démographiques, telles que l'évaluation des résultats pour les femmes de couleur ou les personnes âgées immigrées. Un modèle peut traiter les préjugés sexistes et raciaux séparément, mais échouer lorsque ces facteurs se recoupent. Ces complexités du monde réel nécessitent des scénarios de test personnalisés pour découvrir les problèmes cachés.

Utiliser cadres d'analyse de contenu pour examiner systématiquement les résultats. Recherchez des modèles tels que l'association de professions spécifiques à des sexes particuliers, la promotion de certains groupes ou le recours à des approches étroites de résolution de problèmes. Le suivi de ces tendances au fil du temps révélera si vos interventions font une différence ou si les biais persistent.

Pensez à adopter protocoles d'évaluation à l'aveugle, où les évaluateurs évaluent les résultats sans connaître le contexte démographique des entrées. Cela peut aider à isoler les biais dans les résultats eux-mêmes, minimisant ainsi l'influence des idées préconçues des évaluateurs.

Une fois les modèles de biais identifiés, les outils de transparence peuvent aider à retracer leur origine et à orienter les actions correctives.

Les outils de transparence mettent en lumière la façon dont les biais se développent en révélant les processus décisionnels internes du modèle. Ces outils sont d'une valeur inestimable pour identifier et traiter les causes profondes des résultats biaisés.

Outils de visualisation de l'attention vous permettent de voir sur quelles parties de l'entrée le modèle se concentre lors de la génération de réponses. Cela peut révéler si le modèle est trop influencé par des indices démographiques non pertinents. La comparaison des modèles d'attention entre les groupes peut mettre en évidence des domaines d'intérêt inappropriés.

Méthodes d'attribution basées sur les dégradés identifier les éléments d'entrée qui ont le plus d'impact sur des sorties spécifiques. Par exemple, si la recommandation d'un modèle pour un rôle de leadership est davantage influencée par les pronoms sexospécifiques que par les qualifications, cette technique révélera le problème.

Analyse contrefactuelle implique de modifier systématiquement les entrées pour observer les changements dans les sorties. Par exemple, créez des invites qui ne diffèrent que par les détails démographiques et analysez les réponses qui en résultent. Cette approche fournit des preuves concrètes de partialité et permet d'en mesurer l'impact.

Analyse de l'espace intégré examine la manière dont le modèle représente les concepts en interne. En visualisant les intégrations de mots, vous pouvez identifier les associations problématiques, telles que le fait d'associer certaines professions principalement à un seul sexe.

Algorithme de détection de biais peut automatiser certaines parties de ce processus en analysant les résultats à la recherche d'indicateurs tels que le langage sexospécifique dans des contextes neutres ou les hypothèses culturelles dans les applications mondiales. Bien que ces outils ne soient pas infaillibles, ils permettent de signaler les problèmes potentiels pour un examen humain plus approfondi.

Enfin, suivi de l'influence des données peut retracer les sorties biaisées jusqu'à des parties spécifiques des données d'entraînement. Comprendre ces liens aide les équipes à affiner la curation des données, à ajuster le réglage des modèles ou à repenser les stratégies d'ingénierie rapides.

Les plateformes centralisées font passer les stratégies d'évaluation et d'atténuation des biais à un niveau supérieur en simplifiant et en unifiant les processus. Après avoir corrigé les biais, ces plateformes vous permettent de rationaliser les évaluations en consolidant les outils dans un seul système. Cette approche élimine les inefficacités, garantit la cohérence des normes et comble les lacunes en matière de visibilité.

Les flux de travail fragmentés, en revanche, compliquent la comparaison des résultats, le suivi des progrès au fil du temps ou le maintien de normes d'évaluation uniformes entre les équipes. Des plateformes telles que Prompts.ai résolvent ces problèmes en réunissant plus de 35 modèles de langage, dont GPT-4, Claude, Lama, et Gémeaux - dans une interface unique conçue pour une évaluation et une gouvernance systématiques.

Une plateforme centralisée ne se contente pas de combiner des outils. Il offre un suivi des coûts en temps réel, donnant aux organisations une vision claire de l'impact financier de leurs efforts d'évaluation. Les contrôles de gouvernance intégrés garantissent que les évaluations sont conformes aux protocoles établis et aux exigences de conformité. Cette combinaison de supervision et de fonctionnalité transforme les tests irréguliers en processus répétables et vérifiables. La possibilité de comparer directement les modèles et de suivre les coûts améliore encore le flux de travail d'évaluation.

La comparaison directe des modèles est essentielle pour une évaluation LLM efficace, mais le faire manuellement sur différents systèmes est à la fois chronophage et source d'erreurs. Les plateformes centralisées simplifient ce processus en permettant une visualisation des performances côte à côte, ce qui permet d'identifier plus facilement les différences significatives entre les modèles sans avoir à gérer plusieurs intégrations.

Par exemple, vous pouvez exécuter simultanément des instructions identiques sur différents LLM et comparer leurs résultats en temps réel. Cela permet d'éliminer des variables telles que le calendrier ou les incohérences rapides qui pourraient fausser les résultats lors du test des modèles séparément. Les comparaisons visuelles mettent en évidence des modèles de qualité, de cohérence et de pertinence entre différentes architectures.

Les tableaux de bord de performance fournissent une vue claire des indicateurs clés tels que le temps de réponse, l'utilisation des jetons et les scores de qualité pour tous les modèles testés. Au lieu de jongler avec des feuilles de calcul, les équipes peuvent accéder à des rapports automatisés qui mettent en lumière les tendances et les modèles les plus performants pour des tâches spécifiques. Ces tableaux de bord incluent souvent des filtres permettant d'accéder à des périodes spécifiques, à des groupes d'utilisateurs ou à des catégories d'invites.

La transparence des coûts constitue un autre avantage majeur. Des plateformes comme Prompts.ai proposent un suivi FinOps en temps réel, indiquant le coût réel par évaluation. Cette clarté aide les organisations à équilibrer les performances avec les considérations budgétaires, ce qui leur permet de prendre des décisions éclairées quant aux modèles qui répondent le mieux à leurs besoins.

Les tests A/B permettent de valider davantage les performances du modèle en utilisant des données utilisateur réelles. Cette méthode fournit des informations concrètes sur les modèles les plus performants dans des scénarios réels, orientant ainsi les décisions de sélection des modèles.

Les plateformes centralisées simplifient également le suivi des versions. Lorsque les fournisseurs publient des mises à jour, ces systèmes peuvent automatiquement tester les nouvelles versions par rapport aux valeurs de référence établies, alertant les équipes de tout changement significatif en termes de performances ou de comportement. Cela garantit une qualité de service constante à mesure que le paysage de l'IA évolue, aidant ainsi les organisations à maintenir des normes élevées et à prendre de meilleures décisions.

L'évaluation efficace des LLM nécessite la contribution de diverses parties prenantes, telles que les équipes techniques, les experts du domaine et les responsables de la conformité. Les plateformes centralisées facilitent cette collaboration grâce à des flux de travail structurés qui capturent et documentent tous les points de vue au cours du processus d'évaluation.

Les contrôles d'accès basés sur les rôles permettent aux organisations de définir qui peut consulter, modifier ou approuver les différents aspects de l'évaluation. Par exemple, les équipes techniques peuvent se concentrer sur les paramètres de performance et les configurations, tandis que les parties prenantes commerciales évaluent la qualité des résultats et leur adéquation avec les objectifs. Cette segmentation garantit que chacun apporte son expertise sans surcharger les autres de détails inutiles.

Les pistes d'audit permettent de suivre qui a effectué les tests, quand des modifications ont été apportées et les décisions prises. Ces enregistrements garantissent la conformité réglementaire et favorisent l'amélioration continue. Ils fournissent également un contexte précieux lors de la révision de décisions ou de critères antérieurs.

Les outils d'annotation collaboratifs permettent à plusieurs réviseurs d'évaluer les mêmes résultats et de comparer leurs évaluations. Ce processus permet d'identifier les biais subjectifs et d'établir des normes de qualité fiables par consensus. Le suivi de la fiabilité entre les évaluateurs met également en évidence les domaines dans lesquels les processus d'évaluation peuvent nécessiter des ajustements.

Les fonctionnalités de reporting transparentes consolident les mesures techniques, les évaluations humaines et les analyses de coûts dans des résumés qui peuvent être partagés avec la direction, les équipes de conformité ou les auditeurs externes. Ces rapports automatisés fournissent des mises à jour régulières sur les performances des modèles et les activités d'évaluation, ce qui permet de tenir les parties prenantes informées plus facilement.

Les systèmes de notification permettent aux équipes de rester informées des principales étapes, des problèmes de qualité ou des changements de performances sans surveillance manuelle constante. Les alertes peuvent être configurées pour des seuils spécifiques, tels que des baisses des scores de qualité ou des augmentations des indicateurs de biais, afin de garantir une action rapide en cas de besoin.

Enfin, l'intégration avec des outils tels que Slack, Microsoft Teams, ou les plateformes de gestion de projet intègrent l'évaluation LLM dans les flux de travail existants. En diffusant des mises à jour et des alertes via des outils familiers, les plateformes centralisées minimisent les perturbations et permettent aux équipes de rester alignées et informées plus facilement.

Pour créer des systèmes de sortie LLM fiables, il est essentiel de combiner des mesures automatisées avec une supervision humaine, des normes de performance bien définies et une surveillance continue des biais. Cette approche équilibrée garantit à la fois efficacité et responsabilité.

Le processus commence par l'établissement des critères d'évaluation clairs adaptés à des besoins spécifiques. Qu'il s'agisse de rédiger des réponses au service client ou de produire de la documentation technique, définir ce qui constitue un « bon » résultat dès le départ permet de réduire les désaccords subjectifs. Les indicateurs objectifs tels que BLEU et la perplexité fournissent des points de référence mesurables, mais ils sont plus brillants lorsqu'ils sont associés à des avis d'experts qui tiennent compte du contexte et des nuances subtiles.

Des audits réguliers axés sur l'équité, la représentation et la transparence sont essentiels pour établir et maintenir la confiance. Cela est particulièrement important lorsque les LLM sont employés dans des domaines sensibles tels que la santé, la finance ou les services juridiques, où les enjeux sont élevés et la précision n'est pas négociable.

La centralisation des flux de travail est une autre pierre angulaire d'une gestion efficace du système LLM. Au lieu de gérer des outils, des API et des méthodes d'évaluation éparpillés, les plateformes telles que Prompts.ai consolident le tout dans une interface unique et rationalisée. Cela permet aux entreprises de comparer plus de 35 modèles linguistiques côte à côte, de surveiller les coûts en temps réel et d'appliquer des contrôles de gouvernance. De plus, un accès centralisé et un suivi FinOps transparent peuvent réduire les dépenses liées aux logiciels d'IA jusqu'à 98 %.

Collaboration entre les équipes améliore encore le processus d'évaluation. Lorsque les experts techniques, les spécialistes du domaine et les responsables de la conformité travaillent ensemble à l'aide de flux de travail structurés avec un accès basé sur les rôles et des pistes d'audit, les résultats sont plus complets et plus défendables. Des fonctionnalités telles que le partage des résultats, des annotations collaboratives et des normes cohérentes entre les services transforment les efforts de test fragmentés en processus fiables et reproductibles.

En fin de compte, le succès de la mise en place de systèmes de sortie LLM fiables ne dépend pas de la taille du budget mais de la solidité du cadre d'évaluation. Des processus évolutifs et axés sur la qualité qui offrent de la transparence et favorisent l'amélioration continue transforment l'évaluation d'un obstacle en un avantage stratégique. En intégrant ces éléments, les organisations peuvent s'assurer que leurs systèmes LLM fournissent des résultats cohérents et fiables tout en restant adaptables à l'évolution des défis.

Pour trouver le juste équilibre entre les outils automatisés et la supervision humaine, commencez par tirer parti Outils d'IA pour des tâches telles que le filtrage préliminaire, la détection de problèmes potentiels et la réalisation d'évaluations de routine. Ces outils excellent dans le traitement rapide et cohérent de grands ensembles de données.

Dans le même temps, supervision humaine joue un rôle crucial dans les domaines qui exigent un jugement nuancé, tels que la découverte de biais subtils, la validation de l'exactitude des faits et la garantie que les résultats répondent aux normes éthiques et contextuelles. Cette approche collaborative allie rapidité et précision, fournissant des résultats à la fois efficaces et soigneusement affinés pour répondre à vos besoins uniques.

Les grands modèles linguistiques (LLM) peuvent parfois refléter des préjugés liés au sexe, à la race, aux normes sociales ou à d'autres aspects culturels. Ces biais sont souvent dus à des déséquilibres dans les données utilisées pour entraîner ces modèles, ce qui entraîne des stéréotypes ou une distorsion des points de vue dans leurs réponses.

L'identification de tels biais implique d'examiner les résultats pour détecter des modèles récurrents d'injustice, d'utiliser des outils spécialisés de détection des biais ou d'appliquer des critères d'équité établis. Pour résoudre ces problèmes, il faut combiner plusieurs approches : intégrer des ensembles de données diversifiés et équilibrés, invites d'artisanat qui favorisent la neutralité et utilisent des outils automatisés spécialement conçus pour minimiser les biais dans les résultats de l'IA. Un examen et des tests cohérents du contenu généré sont tout aussi importants pour s'assurer qu'il est conforme aux normes éthiques et aux objectifs visés.

Une plate-forme centralisée joue un rôle clé dans l'évaluation des résultats du LLM en garantissant une évaluation cohérente et efficace des performances du modèle. Tous les outils et processus d'évaluation étant regroupés au même endroit, il devient plus facile d'identifier et de résoudre les problèmes tels que les biais, les inexactitudes ou les hallucinations. Cette approche permet de garantir la fiabilité et la qualité des résultats.

De plus, le fait de tout regrouper simplifie les flux de travail en automatisation des tâches de routine, fournissant des informations en temps réel et favorisant une validation continue. Ces fonctionnalités permettent non seulement de gagner du temps, mais également de garantir que les modèles restent alignés sur l'évolution des objectifs et des normes, renforçant ainsi la confiance et la fiabilité dans les solutions basées sur l'IA.