Les plateformes d'orchestration du machine learning simplifient flux de travail complexes tels que le prétraitement des données, la formation de modèles et le déploiement. Pour les entreprises américaines, la gestion d'outils fragmentés et le contrôle des coûts liés à l'IA constituent des défis pressants. Ce guide compare quatre plateformes les mieux notées : prompts.ai, Poignard, Kubeflow, et Métaflow - sur leur capacité à rationalisez les opérations, adaptez les flux de travail et garantissez la transparence des coûts.

Chaque plateforme répond à des besoins différents, qu'il s'agisse d'entreprises soucieuses des coûts, d'équipes privilégiant l'évolutivité ou d'outils adaptés aux développeurs. Vous trouverez ci-dessous une comparaison rapide pour vous aider à choisir la bonne solution.

Choisissez une plateforme qui correspond à votre expertise technique, à votre budget et à vos exigences en matière de flux de travail liés à l'IA.

Prompts.ai est une plateforme d'orchestration d'IA de pointe conçue pour relever les défis liés à la prolifération des outils et à l'incertitude des coûts. Il connecte les utilisateurs à plus de 35 grands modèles linguistiques les plus performants, tels que GPT-4, Claude, Lama, et Gémeaux - le tout via une interface sécurisée. Conçu pour les entreprises du Fortune 500, les agences de création et les laboratoires de recherche, il simplifie les flux de travail d'IA pour une efficacité maximale.

Prompts.ai élimine les tracas liés à la jonglerie entre plusieurs outils en proposant une interface unifiée. Cette conception rationalisée favorise une collaboration fluide, permettant aux data scientists et aux ingénieurs MLOps de travailler avec un ensemble cohérent de ressources sans avoir à se heurter à des chaînes d'outils fragmentées.

La plateforme transforme des expériences ponctuelles en flux de travail structurés et reproductibles à l'aide de son pré-construit Gains de temps. Ces outils accélèrent les délais de production et rendent les processus plus efficaces. Les équipes peuvent également comparer les modèles côte à côte, en tirant parti des indicateurs de performance pour prendre des décisions éclairées quant au modèle le mieux adapté à leurs cas d'utilisation spécifiques.

Prompts.ai est construit avec gouvernance au niveau de l'entreprise à l'esprit. Il comprend des pistes d'audit pour chaque interaction avec l'IA, ainsi que des flux de travail d'approbation et des contrôles d'accès. Ces fonctionnalités fournissent aux chefs d'entreprise la supervision dont ils ont besoin pour garantir déploiement sécurisé et conforme de l'IA.

Que vous lanciez un petit projet pilote ou que vous déployiez l'IA dans l'ensemble d'une organisation, Prompts.ai est conçu pour évoluer avec vous. Son système de crédits TOKN flexible et payant à l'utilisation garantit que l'utilisation correspond à vos besoins et à vos résultats opérationnels.

Prompts.ai répond aux problèmes budgétaires grâce à des outils FinOps en temps réel qui acheminent les demandes vers des modèles rentables. Cette approche peut réduire les dépenses liées à l'IA de 98 %, aidant ainsi les entreprises à gérer les coûts cachés et à réduire l'incertitude financière. Cette forte focalisation sur le contrôle des coûts jette les bases de l'évaluation d'autres solutions d'orchestration.

Dagster est une plateforme d'orchestration de données qui adopte une approche unique en se concentrant sur gestion des flux de travail centrée sur les actifs. Contrairement aux systèmes traditionnels centrés sur les pipelines, il organise les flux de travail autour des actifs de données, ce qui facilite la compréhension des dépendances et le suivi du lignage des données tout au long des processus d'apprentissage automatique.

Dagster s'intègre parfaitement à un large éventail d'outils de données et de plateformes cloud, notamment Apache Spark, dbt, Pandas, AWS, Google Cloud et Azure. Sa conception native de Python garantit une compatibilité fluide avec les frameworks d'apprentissage automatique tels que TensorFlow, PyTorch, et scikit-learn.

L'une des caractéristiques les plus remarquables de Dagster est sa actifs définis par logiciel (SDA), qui permettent aux équipes de définir les actifs de données sous forme de code. Cela simplifie l'intégration de divers outils dans des piles de machine learning complexes, réduisant ainsi les défis liés à la connexion de systèmes disparates.

Avec Dagster's modèle déclaratif, les équipes peuvent se concentrer sur la définition des résultats dont elles ont besoin plutôt que sur les étapes spécifiques pour les atteindre. Cela réduit le code standard, ce qui facilite la gestion des flux de travail. La plateforme automatise également la résolution des dépendances et prend en charge l'exécution parallèle pour un traitement plus rapide.

Le Interface Web Dagit améliore l'efficacité en fournissant des informations en temps réel sur l'exécution du pipeline, les sorties de données et les contrôles de qualité. Les équipes peuvent suivre l'avancement des tâches, corriger les échecs et explorer le lignage des données via une interface visuelle intuitive. Cette approche graphique réduit le temps de dépannage et rationalise la résolution des problèmes.

Dagster dispose d'un suivi intégré du lignage des données, garantissant que chaque transformation est automatiquement documentée. Cela crée un piste d'audit détaillée, démontrant comment les données circulent dans le système et prenant en charge conformité aux règles de gouvernance.

La plateforme comprend également tests de qualité des données, permettant aux équipes de définir leurs attentes en matière de données à chaque étape du pipeline. Des alertes sont déclenchées lorsque les données ne répondent pas à des critères spécifiques, ce qui permet d'éviter les problèmes en aval et de préserver l'intégrité des flux de travail d'apprentissage automatique.

Dagster est conçu pour gérer une gamme d'environnements d'exécution, des configurations locales aux déploiements cloud à grande échelle. Il peut échelle horizontale sur les clusters Kubernetes et s'intègre à des moteurs de flux de travail tels que Céleri pour une exécution distribuée. Cette évolutivité permet aux équipes de commencer modestement et de se développer en fonction de l'évolution de leurs besoins.

C'est capacités de remblayage sont particulièrement utiles, car ils permettent un retraitement efficace des données historiques lorsque la logique du pipeline change. En identifiant et en recalculant uniquement les actifs nécessaires, Dagster économise du temps et des ressources.

Dagster permet de contrôler les dépenses liées au cloud en suivant l'utilisation des ressources et en évitant les calculs redondants. Cet accent mis sur l'efficacité, combiné à ses fonctionnalités robustes de conformité et de gestion des flux de travail, fait de Dagster un outil puissant pour orchestrer les flux de travail d'IA modernes.

Kubeflow, une plateforme open source développée par Google, transforme les clusters Kubernetes en de puissants environnements d'apprentissage automatique (ML). Il fournit un ensemble robuste d'outils pour développer, former et déployer des modèles de machine learning à grande échelle.

Conçu selon des principes natifs du cloud, Kubeflow fonctionne parfaitement sur les clusters Kubernetes hébergés par les principaux fournisseurs de cloud tels que Google Cloud Platform, Amazon Web Services et Microsoft Azure. Il prend en charge les frameworks ML largement utilisés, notamment TensorFlow et PyTorch, ce qui le rend polyvalent pour divers flux de travail. Grâce au SDK Pipelines, les data scientists peuvent définir des flux de travail en Python sans avoir à se plonger dans les complexités de Kubernetes. La plateforme s'intègre également à des outils de suivi des expériences et de diffusion de modèles, ajoutant ainsi de la flexibilité à ses fonctionnalités. Ses serveurs portables, tels que Jupiter et JupyterLab proposent des environnements d'expérimentation familiers, tandis que l'intégration avec des outils de traitement de données à grande échelle et de gestion avancée des services garantit des flux de travail fluides et reproductibles.

Les pipelines Kubeflow sont conçus pour améliorer l'efficacité en garantissant une exécution de flux de travail reproductible et conteneurisée. Chaque étape du flux de travail fonctionne dans son propre conteneur, garantissant ainsi la cohérence entre les environnements. Katib, une autre fonctionnalité de Kubeflow, automatise le réglage des hyperparamètres par le biais d'expériences parallèles, ce qui permet d'économiser du temps et des efforts. En outre, Kubeflow prend en charge la multilocation, ce qui permet à plusieurs équipes de travailler sur le même cluster Kubernetes tout en isolant leurs charges de travail en toute sécurité.

Kubeflow tire parti de Kubernetes mise à l'échelle automatique de la capsule horizontale pour ajuster dynamiquement les allocations de ressources en fonction des demandes de charge de travail, garantissant ainsi une mise à l'échelle efficace lors de la formation des modèles. Il prend également en charge l'entraînement distribué grâce au parallélisme des données et des modèles, ce qui accélère l'entraînement de modèles complexes. Pour rationaliser davantage le développement, Kubeflow inclut une fonctionnalité de mise en cache des pipelines qui stocke les résultats intermédiaires, ce qui permet aux exécutions suivantes d'ignorer les étapes inchangées et d'accélérer les itérations.

Bien que Kubeflow ne gère pas directement la facturation, il s'intègre à des outils de surveillance tels que Prométhée et Grafana pour fournir des informations détaillées sur l'utilisation des ressources. Ces outils suivent l'utilisation du processeur, de la mémoire et du GPU au cours des expériences, aidant les équipes à prendre des décisions éclairées en matière d'allocation des ressources et de gestion des coûts. Les quotas et les limites de ressources garantissent en outre qu'aucune charge de travail ne domine les ressources du cluster, ce qui favorise une utilisation équitable et une efficacité.

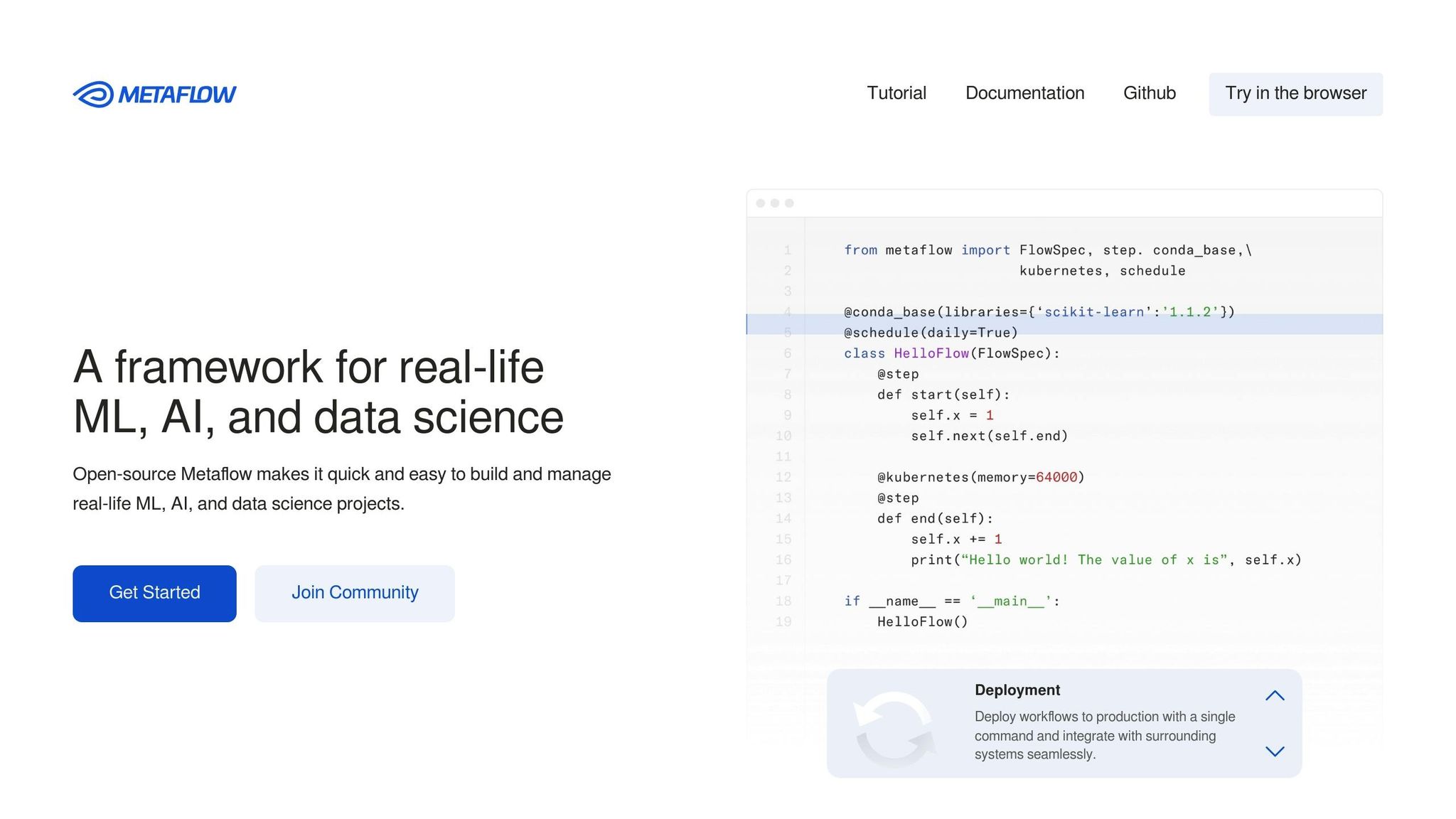

Metaflow, initialement créé par Netflix et plus tard open source, a été conçu pour rendre les flux de travail d'apprentissage automatique plus accessibles, même pour ceux qui ne disposent pas d'une expertise technique approfondie. En mettant l'accent sur une approche conviviale et centrée sur l'humain, il permet aux praticiens de créer et de faire évoluer des flux de travail d'apprentissage automatique en utilisant une syntaxe Python familière tout en gérant les détails complexes de l'informatique distribuée en arrière-plan. À l'instar d'autres plateformes d'orchestration de premier plan, elle simplifie la complexité des flux de travail liés à l'IA.

Metaflow s'intègre parfaitement aux outils de science des données largement utilisés et à l'infrastructure cloud, ce qui en fait un choix polyvalent pour les data scientists. Il fonctionne de manière native avec les principaux services AWS tels que S3 pour le stockage des données, EC2 pour la puissance de calcul et AWS Batch pour la planification des tâches. En outre, il prend en charge les bibliothèques Python les plus populaires telles que pandas, scikit-learn et TensorFlow, garantissant ainsi un environnement cohérent et familier aux utilisateurs. Sa conception basée sur un décorateur permet de transformer les fonctions Python standard en étapes de flux de travail évolutives avec un minimum d'effort de codage. De plus, sa compatibilité avec les ordinateurs portables Jupyter permet le prototypage local avant de passer à la production, créant ainsi un pipeline de développement fluide et efficace.

Metaflow simplifie le développement de l'apprentissage automatique en automatisant des tâches telles que la gestion des versions, la gestion des artefacts et le stockage des données, garantissant ainsi la reproductibilité et l'efficacité des flux de travail. Chaque exécution produit des instantanés immuables du code, des données et des paramètres, fournissant un enregistrement clair des expériences et permettant la reproductibilité. Sa fonction de reprise est particulièrement utile, car elle permet aux utilisateurs de redémarrer les flux de travail à n'importe quelle étape, ce qui permet de gagner beaucoup de temps et d'efforts en matière de développement.

Conçu dans un souci d'évolutivité, Metaflow est optimisé pour les environnements cloud et automatise la mise à l'échelle des ressources. En utilisant de simples décorateurs Python, les data scientists peuvent définir les besoins en ressources, et la plateforme se charge de fournir la puissance de calcul nécessaire. Qu'il s'agisse d'une mise à l'échelle verticale pour les tâches gourmandes en mémoire ou d'une mise à l'échelle horizontale pour le traitement parallèle, Metaflow alloue les ressources de manière dynamique en fonction des besoins de chaque flux de travail. Cette flexibilité garantit une transition fluide entre le développement local et l'exécution à grande échelle dans le cloud, permettant aux utilisateurs de gérer facilement des projets de complexité variable.

Choisir la bonne plateforme d'orchestration de machine learning revient souvent à évaluer les avantages et les inconvénients de chaque option. En comprenant ces distinctions, les organisations peuvent adapter leur choix à leurs besoins techniques, à leurs objectifs opérationnels et aux ressources disponibles.

Voici un aperçu de la comparaison entre certaines des principales plateformes :

Prompts.ai se distingue pour les environnements d'entreprise où gestion des coûts et gouvernance occupent le devant de la scène. Son interface unifiée simplifie la gestion de plusieurs outils d'IA, et le suivi des coûts en temps réel garantit une visibilité claire des dépenses liées à l'IA. Le système de crédit TOKN lie les coûts directement à l'utilisation, ce qui en fait une solution idéale pour les organisations qui cherchent à éviter les frais d'abonnement permanents. Cependant, l'accent mis sur les modèles de langage peut limiter son utilité pour les flux de travail nécessitant un prétraitement approfondi des données ou une formation à des modèles personnalisés.

Poignard brille avec ses approche centrée sur le génie logiciel à l'orchestration des données. Son modèle basé sur les actifs et sa saisie robuste en font un favori pour les équipes qui mettent l'accent sur la qualité du code et la maintenance des flux de travail. Des fonctionnalités telles que des tests complets et le suivi de la lignée améliorent le débogage et la surveillance. En revanche, sa courbe d'apprentissage abrupte peut entraver son adoption, en particulier pour les équipes qui n'ont pas de solides connaissances en génie logiciel ou celles qui recherchent une mise en œuvre rapide.

Kubeflow des offres sans précédent flexibilité et personnalisation pour les organisations ayant des besoins variés et complexes en matière d'apprentissage automatique. Sa conception native du cloud et son riche écosystème de composants le rendent adaptable à presque tous les cas d'utilisation du machine learning. Grâce à l'intégration de Kubernetes, il offre une évolutivité et une gestion des ressources robustes. Cependant, cette flexibilité s'accompagne d'une complexité considérable, nécessitant une expertise DevOps considérable et une maintenance continue, des défis que les petites équipes peuvent trouver redoutables.

Métaflow donne la priorité facilité d'utilisation et expérience pour les développeurs, destiné aux data scientists qui préfèrent se concentrer sur le développement de modèles plutôt que sur l'infrastructure. Sa conception basée sur un décorateur permet une mise à l'échelle fluide des environnements locaux au cloud avec un minimum d'ajustements de code. Le contrôle automatique des versions et la gestion des artefacts réduisent encore les problèmes opérationnels. La principale limite est son intégration étroite avec AWS, qui peut ne pas convenir aux organisations qui mettent en œuvre des stratégies multicloud ou qui s'appuient sur d'autres fournisseurs de cloud.

Vous trouverez ci-dessous un tableau de référence rapide résumant ces comparaisons :

Interopérabilité varie considérablement d'une plateforme à l'autre, chacune offrant différents niveaux d'intégration et de compatibilité avec les écosystèmes. De même, efficacité du flux de travail va de la gestion rationalisée de Prompts.ai aux fonctionnalités avancées de pipeline de Kubeflow. Évolutivité les approches diffèrent également, qu'il s'agisse de l'accès au modèle unifié de Prompts.ai ou de la gestion des ressources basée sur Kubernetes de Kubeflow.

En fin de compte, le choix de la bonne plateforme nécessite un examen attentif de facteurs tels que l'expertise technique, le budget et l'évolutivité à long terme. Chaque plateforme présente des atouts uniques, et le meilleur choix dépendra des besoins spécifiques de votre organisation en matière de flux de travail en matière d'IA.

Lorsque vous choisissez une plateforme, concentrez-vous sur vos priorités et votre expertise technique, car chaque option apporte des atouts uniques et répond aux besoins spécifiques de l'entreprise.

Pour les entreprises soucieuses de leur budget qui accordent la priorité à la gouvernance et à la rationalisation des flux de travail LLM, prompts.ai sort du lot. Il propose une interface unifiée prenant en charge plus de 35 modèles linguistiques, un suivi des coûts en temps réel et un système de crédit TOKN qui réduit considérablement les dépenses liées à l'IA. Ses outils de gouvernance de niveau entreprise, notamment des pistes d'audit et un cadre FinOps transparent, le rendent particulièrement attrayant pour les entreprises du Fortune 500 qui gèrent des déploiements d'IA à grande échelle ou pour les organisations qui gèrent des données sensibles dans le cadre d'exigences réglementaires strictes.

Bien que prompts.ai soit exceptionnel en termes de gestion des coûts et de gouvernance, d'autres plateformes brillent dans différents domaines. Entreprises dotées de solides équipes d'ingénierie pourrait trouver Dagster plus approprié. En mettant l'accent sur la qualité du code, des tests complets et un suivi détaillé du lignage, Dagster est idéal pour créer des flux de travail maintenables et prêts pour la production. Cependant, sa courbe d'apprentissage abrupte signifie que les équipes doivent prévoir une formation et une intégration supplémentaires.

Pour les grandes entreprises ayant des besoins variés en matière d'apprentissage automatique, l'architecture native du cloud de Kubeflow basée sur Kubernetes offre une évolutivité et une personnalisation inégalées. Cette plateforme convient parfaitement aux organisations dotées d'équipes DevOps dédiées capables de gérer sa complexité et de tirer parti de sa flexibilité pour répondre à des exigences variées.

Des équipes de data science à la recherche de solutions de déploiement rapide Je préfèrerais peut-être Metaflow. Ses fonctionnalités conviviales pour les développeurs, telles que la conception basée sur un décorateur et la mise à l'échelle automatique, permettent aux équipes de se concentrer sur le développement de modèles plutôt que sur l'infrastructure. Cependant, sa dépendance à AWS pourrait poser des défis aux organisations qui mettent en œuvre des stratégies multicloud.

Chaque plateforme s'intègre également bien aux écosystèmes existants, un facteur clé à prendre en compte. Prompts.ai fournit une connectivité fluide avec plusieurs fournisseurs de LLM, tandis que Kubeflow prend en charge un large éventail d'outils et de frameworks d'apprentissage automatique. Évaluez votre infrastructure technologique actuelle pour vous assurer de sa compatibilité.

Un autre avantage de prompts.ai est son modèle de tarification à l'utilisation, qui élimine les frais d'abonnement récurrents. Cela en fait un excellent choix pour les organisations dont l'utilisation de l'IA fluctue. En revanche, les plateformes traditionnelles nécessitent souvent des investissements initiaux importants et des coûts opérationnels permanents.

Pour faire le meilleur choix, commencez par identifier votre principal cas d'utilisation, évaluez les capacités techniques de votre équipe et alignez les fonctionnalités de la plateforme sur votre stratégie d'IA à long terme. Testez la plateforme que vous avez sélectionnée sur un projet de moindre envergure afin d'évaluer son adéquation avant de l'étendre à l'ensemble de votre entreprise.

Lors du choix d'une plateforme d'orchestration d'apprentissage automatique, il est essentiel d'évaluer l'efficacité de sa gestion flux de travail complexes. Cela inclut des fonctionnalités telles que la gestion des dépendances entre les tâches et l'automatisation des transformations de données. La capacité de la plateforme à déployer, gérer et surveiller des modèles à grande échelle, garantissant le bon déroulement et l'efficacité des opérations d'IA.

Recherchez des fonctionnalités qui mettent l'accent intégration sans faille avec vos outils existants, évolutivité pour répondre à la demande croissante et soutenir simplification des déploiements. Une plateforme conçue pour rationaliser ces tâches peut permettre de gagner du temps, de minimiser les erreurs et d'améliorer la productivité dans les flux de travail d'IA.

L'interopérabilité est essentielle pour que les systèmes d'orchestration d'apprentissage automatique s'intègrent parfaitement aux flux de travail d'IA existants. En permettant un échange de données et une communication fluides entre divers outils, plateformes et environnements cloud, ces systèmes réduisent les tâches manuelles et contribuent à minimiser les erreurs.

Grâce à ce type d'intégration, les modèles d'IA, les pipelines de données et les composants d'infrastructure peuvent collaborer plus efficacement. Cela permet non seulement de renforcer l'évolutivité et d'optimiser l'utilisation des ressources, mais aussi d'accélérer le déploiement, de garantir des performances constantes et de simplifier la gestion de flux de travail complexes.

Les entreprises sont confrontées à de nombreux défis lors de la mise en œuvre et de l'extension de systèmes d'orchestration d'apprentissage automatique. L'un des problèmes les plus urgents est le maintien qualité et cohérence des données, car des données peu fiables ou incomplètes peuvent entraîner des résultats de modèle erronés. Un autre obstacle réside dans la gestion dépendances complexes entre les données tout en veillant à ce que les modèles restent à jour pour refléter les changements en temps réel.

La mise à l'échelle de ces systèmes introduit des obstacles supplémentaires, tels que la résolution restrictions en matière de ressources, notamment une capacité de calcul insuffisante ou une pénurie de professionnels qualifiés. Encourager une collaboration fluide entre les équipes est tout aussi essentiel, mais cela peut s'avérer difficile. La résistance interne au changement ou les blocages organisationnels compliquent souvent davantage le processus d'adoption. Sur le plan technique, des problèmes tels que gestion des versions du modèle, latence, et l'application de cadres de gouvernance robustes ajoutent à la complexité de la mise à l'échelle efficace des systèmes d'apprentissage automatique.