Las plataformas de orquestación de aprendizaje automático simplifican flujos de trabajo complejos como el preprocesamiento de datos, el entrenamiento de modelos y la implementación. Para las empresas estadounidenses, la administración de herramientas fragmentadas y el control de los costos de la IA son desafíos urgentes. En esta guía se comparan las cuatro plataformas mejor valoradas: prompts.ai, Daga, Kubeflow, y Metaflow - sobre su capacidad para optimice las operaciones, escale los flujos de trabajo y garantice la transparencia de los costos.

Cada plataforma satisface diferentes necesidades, desde empresas que se preocupan por los costos hasta equipos que priorizan la escalabilidad o herramientas fáciles de usar para los desarrolladores. A continuación se muestra una comparación rápida que le ayudará a elegir la solución adecuada.

Elija una plataforma que se adapte a sus requisitos de experiencia técnica, presupuesto y flujo de trabajo de IA.

Prompts.ai es una plataforma de orquestación de inteligencia artificial de vanguardia diseñada para abordar los desafíos de la proliferación de herramientas y los costos poco claros. Conecta a los usuarios con más de 35 modelos lingüísticos de gran tamaño de alto rendimiento, como GPT-4, Claudio, Llama, y Géminis - todo a través de una interfaz segura. Diseñado para empresas, agencias creativas y laboratorios de investigación de la lista Fortune 500, simplifica los flujos de trabajo de la IA para lograr la máxima eficiencia.

Prompts.ai elimina la molestia de tener que hacer malabares con varias herramientas al ofrecer una interfaz unificada. Este diseño optimizado fomenta una colaboración fluida, lo que permite a los científicos de datos y a los ingenieros de MLOps trabajar con un conjunto uniforme de recursos sin la fricción de cadenas de herramientas fragmentadas.

La plataforma convierte los experimentos puntuales en flujos de trabajo estructurados y repetibles usando su versión preconstruida Ahorradores de tiempo. Estas herramientas aceleran los plazos de producción y hacen que los procesos sean más eficientes. Los equipos también pueden comparar los modelos uno al lado del otro, aprovechando las métricas de rendimiento para tomar decisiones informadas sobre qué modelo se adapta mejor a sus casos de uso específicos.

Prompts.ai está construido con gobierno a nivel empresarial en mente. Incluye registros de auditoría para cada interacción de la IA, junto con los flujos de trabajo de aprobación y los controles de acceso. Estas funciones proporcionan a los líderes empresariales la supervisión que necesitan garantizar despliegue de IA seguro y compatible.

Ya sea que esté lanzando un pequeño proyecto piloto o implementando la IA en toda una organización, Prompts.ai está diseñado para crecer con usted. Su sistema de créditos TOKN, flexible y de pago por uso, garantiza que el uso se alinee con sus necesidades y resultados operativos.

Prompts.ai aborda las preocupaciones presupuestarias con herramientas FinOps en tiempo real que dirigen las solicitudes a modelos rentables. Este enfoque puede reducir los gastos de inteligencia artificial hasta en un 98%, lo que ayuda a las empresas a gestionar los costes ocultos y reducir la incertidumbre financiera. Este fuerte enfoque en el control de costos sienta las bases para evaluar otras soluciones de orquestación.

Dagster es una plataforma de orquestación de datos que adopta un enfoque único al centrarse en gestión del flujo de trabajo centrada en los activos. A diferencia de los sistemas tradicionales centrados en canalizaciones, organiza los flujos de trabajo en torno a los activos de datos, lo que facilita la comprensión de las dependencias y el seguimiento del linaje de datos a lo largo de los procesos de aprendizaje automático.

Dagster se integra a la perfección con una amplia gama de herramientas de datos y plataformas en la nube, que incluyen Apache Spark, deuda, Pandas, AWS, Google Cloud y Azure. Su diseño nativo de Python garantiza una compatibilidad fluida con marcos de aprendizaje automático como TensorFlow, PyTorch, y scikit-learn.

Una de las características más destacadas de Dagster es su activos definidos por software (SDA), que permiten a los equipos definir los activos de datos como código. Esto simplifica la integración de varias herramientas en paquetes complejos de aprendizaje automático, lo que reduce los desafíos de conectar sistemas dispares.

Con Dagster's modelo declarativo, los equipos pueden centrarse en definir los resultados que necesitan en lugar de en los pasos específicos para lograrlos. Esto reduce el código repetitivo, lo que facilita el mantenimiento de los flujos de trabajo. La plataforma también automatiza la resolución de dependencias y admite la ejecución en paralelo para un procesamiento más rápido.

El Interfaz web Dagit mejora la eficiencia al ofrecer información en tiempo real sobre la ejecución de los oleoductos, los resultados de datos y los controles de calidad. Los equipos pueden supervisar el progreso de los trabajos, corregir los errores y explorar el linaje de datos a través de una interfaz visual intuitiva. Este enfoque gráfico reduce el tiempo de resolución de problemas y agiliza la resolución de problemas.

Dagster tiene un seguimiento del linaje de datos incorporado, lo que garantiza que cada transformación se documente automáticamente. Esto crea un registro de auditoría detallado, que demuestra cómo fluyen los datos a través del sistema y apoya cumplimiento de las normas de gobierno.

La plataforma también incluye pruebas de calidad de datos, lo que permite a los equipos establecer expectativas de datos en cada etapa del proceso. Las alertas se activan cuando los datos no cumplen los criterios especificados, lo que ayuda a evitar problemas posteriores y a mantener la integridad de los flujos de trabajo de aprendizaje automático.

Dagster está diseñado para gestionar una variedad de entornos de ejecución, desde configuraciones locales hasta despliegues en la nube a gran escala. Puede escalar horizontalmente en clústeres de Kubernetes y se integra con motores de flujo de trabajo como Apio para ejecución distribuida. Esta escalabilidad permite a los equipos empezar de a poco y expandirse a medida que evolucionan sus necesidades.

Es capacidades de relleno son particularmente útiles, ya que permiten el reprocesamiento eficiente de los datos históricos cuando cambia la lógica del oleoducto. Al identificar y recalcular solo los activos necesarios, Dagster ahorra tiempo y recursos.

Dagster ayuda a controlar los gastos de la nube al rastrear el uso de los recursos y omitir los cálculos redundantes. Este enfoque en la eficiencia, combinado con sus sólidas funciones de cumplimiento y gestión del flujo de trabajo, convierte a Dagster en una poderosa herramienta para organizar los flujos de trabajo de inteligencia artificial modernos.

Kubeflow, una plataforma de código abierto desarrollada por Google, transforma los clústeres de Kubernetes en potentes entornos de aprendizaje automático (ML). Proporciona un conjunto sólido de herramientas para desarrollar, entrenar e implementar modelos de aprendizaje automático a escala.

Diseñado con principios nativos de la nube, Kubeflow funciona a la perfección en los clústeres de Kubernetes alojados por los principales proveedores de nube, como Google Cloud Platform, Amazon Web Services y Microsoft Azure. Es compatible con los marcos de aprendizaje automático más utilizados, incluidos TensorFlow y PyTorch, lo que lo hace versátil para varios flujos de trabajo. Con el SDK de Pipelines, los científicos de datos pueden definir los flujos de trabajo en Python sin necesidad de profundizar en las complejidades de Kubernetes. La plataforma también se integra con herramientas para el seguimiento de experimentos y la publicación de modelos, lo que añade flexibilidad a sus capacidades. Sus servidores portátiles, como Júpiter y JupyterLab, ofrecen entornos familiares para la experimentación, mientras que la integración con herramientas para el procesamiento de datos a gran escala y la gestión avanzada de servicios garantiza flujos de trabajo fluidos y reproducibles.

Las canalizaciones de Kubeflow están diseñadas para mejorar la eficiencia al garantizar una ejecución reproducible y en contenedores del flujo de trabajo. Cada paso del flujo de trabajo funciona en su propio contenedor, lo que mantiene la coherencia en todos los entornos. Katib, otra función de Kubeflow, automatiza el ajuste de los hiperparámetros mediante experimentos paralelos, lo que ahorra tiempo y esfuerzo. Además, Kubeflow admite el uso de múltiples usuarios, lo que permite que varios equipos trabajen en el mismo clúster de Kubernetes y, al mismo tiempo, mantener sus cargas de trabajo aisladas de forma segura.

Kubeflow aprovecha las ventajas de Kubernetes escalado automático del pod horizontal para ajustar dinámicamente las asignaciones de recursos en función de las demandas de carga de trabajo, garantizando un escalado eficiente durante la capacitación del modelo. También admite el entrenamiento distribuido mediante el paralelismo de datos y modelos, lo que acelera el entrenamiento de modelos complejos. Para agilizar aún más el desarrollo, Kubeflow incluye una función de almacenamiento en caché de canalización que almacena los resultados intermedios, lo que permite que las ejecuciones posteriores omitan los pasos sin cambios y permite una iteración más rápida.

Si bien Kubeflow no gestiona la facturación directamente, se integra con herramientas de monitoreo como Prometeo y Grafana para proporcionar información detallada sobre el uso de los recursos. Estas herramientas rastrean el uso de la CPU, la memoria y la GPU en los experimentos, lo que ayuda a los equipos a tomar decisiones informadas sobre la asignación de recursos y la administración de costos. Las cuotas y los límites de recursos garantizan además que ninguna carga de trabajo domine los recursos del clúster, lo que promueve el uso justo y la eficiencia.

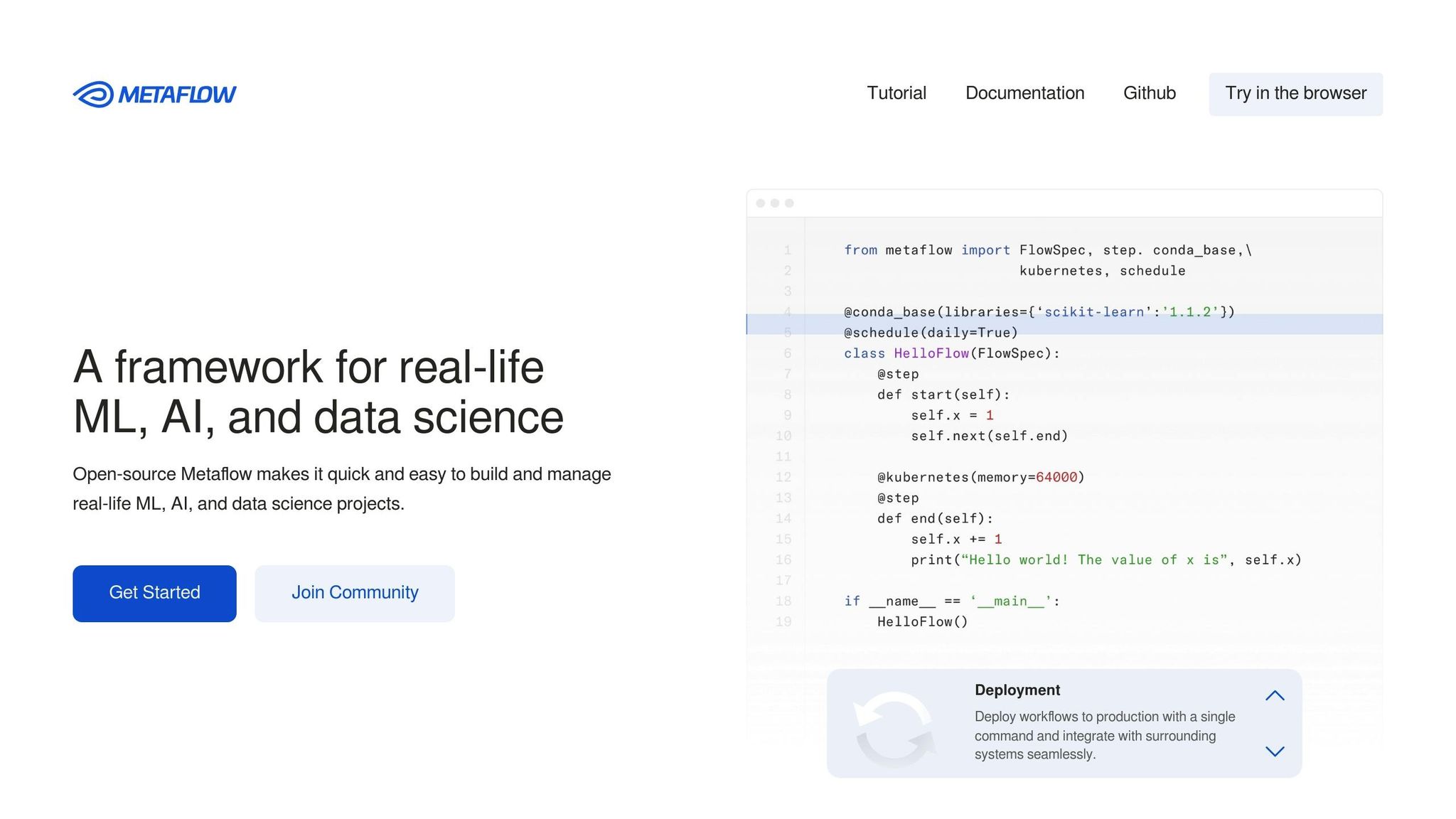

Metaflow, creado inicialmente por Netflix y más tarde de código abierto, se diseñó para hacer que los flujos de trabajo de aprendizaje automático fueran más accesibles, incluso para quienes no tenían una amplia experiencia técnica. Al centrarse en un enfoque fácil de usar y centrado en las personas, permite a los profesionales crear y escalar flujos de trabajo de aprendizaje automático utilizando la conocida sintaxis de Python y, al mismo tiempo, gestionar los intrincados detalles de la computación distribuida en segundo plano. Al igual que otras de las principales plataformas de orquestación, simplifica las complejidades de los flujos de trabajo de la IA.

Metaflow se integra perfectamente con las herramientas de ciencia de datos y la infraestructura de nube más utilizadas, lo que lo convierte en una opción versátil para los científicos de datos. Funciona de forma nativa con los principales servicios de AWS, como S3 para el almacenamiento de datos, EC2 para la potencia informática y AWS Batch para la programación de trabajos. Además, es compatible con bibliotecas populares de Python, como pandas, scikit-learn y TensorFlow, lo que garantiza un entorno uniforme y familiar para los usuarios. Su diseño basado en decoradores permite transformar las funciones estándar de Python en pasos de flujo de trabajo escalables con un mínimo esfuerzo de codificación. Además, su compatibilidad con los portátiles Jupyter permite la creación local de prototipos antes de pasar a la producción, lo que crea una línea de desarrollo fluida y eficiente.

Metaflow simplifica el desarrollo del aprendizaje automático al automatizar tareas como el control de versiones, la administración de artefactos y el almacenamiento de datos, lo que garantiza que los flujos de trabajo sean reproducibles y eficientes. Cada ejecución produce instantáneas inmutables de código, datos y parámetros, lo que proporciona un registro claro de los experimentos y permite la reproducibilidad. Su función de reanudación es particularmente útil, ya que permite a los usuarios reiniciar los flujos de trabajo desde cualquier paso, lo que puede ahorrar mucho tiempo y esfuerzo de desarrollo.

Creado pensando en la escalabilidad, Metaflow está optimizado para entornos de nube y automatiza el escalado de recursos. Mediante el uso de decoradores sencillos de Python, los científicos de datos pueden definir los requisitos de recursos y la plataforma se encarga de aprovisionar la potencia informática necesaria. Ya sea mediante el escalado vertical para tareas que consumen mucha memoria o el escalado horizontal para el procesamiento paralelo, Metaflow asigna los recursos de forma dinámica en función de las necesidades de cada flujo de trabajo. Esta flexibilidad garantiza una transición fluida del desarrollo local a la ejecución en la nube a gran escala, lo que permite a los usuarios gestionar proyectos de diversa complejidad con facilidad.

La elección de la plataforma de orquestación de aprendizaje automático adecuada a menudo se reduce a sopesar las ventajas y desventajas de cada opción. Al comprender estas distinciones, las organizaciones pueden alinear su elección con sus necesidades técnicas, objetivos operativos y recursos disponibles.

He aquí un análisis más detallado de cómo se comparan algunas de las principales plataformas:

Prompts.ai destaca para entornos empresariales en los que administración de costos y gobierno tomar el centro del escenario. Su interfaz unificada simplifica la administración de múltiples herramientas de inteligencia artificial, y el seguimiento de los costos en tiempo real garantiza una visibilidad clara del gasto en inteligencia artificial. El sistema de crédito TOKN vincula los costos directamente con el uso, por lo que es ideal para las organizaciones que buscan evitar las continuas tarifas de suscripción. Sin embargo, su enfoque en los modelos lingüísticos puede limitar su utilidad para los flujos de trabajo que requieren un preprocesamiento de datos exhaustivo o una formación en modelos personalizados.

Daga brilla con su enfoque centrado en la ingeniería de software a la orquestación de datos. Su modelo basado en activos y su excelente capacidad de escritura la convierten en una de las favoritas de los equipos que hacen hincapié en la calidad del código y en los flujos de trabajo fáciles de mantener. Funciones como las pruebas exhaustivas y el seguimiento del linaje mejoran la depuración y la supervisión. Por el lado negativo, su pronunciada curva de aprendizaje puede dificultar la adopción, especialmente para los equipos sin una sólida formación en ingeniería de software o para aquellos que buscan una implementación rápida.

Kubeflow ofertas incomparables flexibilidad y personalización para organizaciones con necesidades de aprendizaje automático diversas y complejas. Su diseño nativo de la nube y su rico ecosistema de componentes hacen que se adapte a casi cualquier caso de uso de aprendizaje automático. Con la integración con Kubernetes, ofrece una sólida escalabilidad y gestión de recursos. Sin embargo, esta flexibilidad conlleva una complejidad considerable, ya que exige una experiencia considerable en DevOps y un mantenimiento continuo, desafíos que los equipos más pequeños pueden encontrar abrumadores.

Metaflow prioriza facilidad de uso y experiencia de desarrollador, dirigido a científicos de datos que prefieren centrarse en el desarrollo de modelos en lugar de en la infraestructura. Su diseño basado en decoradores permite escalar sin problemas desde entornos locales a la nube con ajustes mínimos de código. El control automático de versiones y la administración de artefactos reducen aún más los problemas operativos. La principal limitación es su estrecha integración con AWS, que puede no ser adecuada para las organizaciones que buscan estrategias de nube múltiple o que dependen de otros proveedores de nube.

A continuación se muestra una tabla de referencia rápida en la que se resumen estas comparaciones:

Interoperabilidad varía ampliamente entre estas plataformas, y cada una ofrece diferentes niveles de integración y compatibilidad con los ecosistemas. Del mismo modo, eficiencia del flujo de trabajo abarca desde la administración optimizada de Prompts.ai hasta las capacidades avanzadas de canalización de Kubeflow. Escalabilidad los enfoques también difieren, desde el modelo de acceso unificado de Prompts.ai hasta la administración de recursos basada en Kubernetes de Kubeflow.

En última instancia, la selección de la plataforma adecuada requiere una consideración cuidadosa de factores como la experiencia técnica, el presupuesto y la escalabilidad a largo plazo. Cada plataforma ofrece puntos fuertes únicos, y la mejor elección dependerá de las necesidades específicas de flujo de trabajo de IA de su organización.

Al seleccionar una plataforma, céntrese en sus prioridades y experiencia técnica, ya que cada opción aporta puntos fuertes únicos y satisface las necesidades empresariales específicas.

Para empresas que se preocupan por su presupuesto y que priorizan la gobernanza y los flujos de trabajo de LLM simplificados, destaca prompts.ai. Ofrece una interfaz unificada que admite más de 35 modelos lingüísticos, un seguimiento de los costos en tiempo real y un sistema de crédito TOKN que reduce drásticamente los gastos de inteligencia artificial. Sus herramientas de gobierno de nivel empresarial, que incluyen registros de auditoría y un marco transparente de FinOps, lo hacen especialmente atractivo para las empresas de la lista Fortune 500 que gestionan despliegues de IA a gran escala o para las organizaciones que gestionan datos confidenciales con arreglo a estrictos requisitos normativos.

Si bien prompts.ai es excepcional para la gestión de costes y la gobernanza, otras plataformas brillan en diferentes áreas. Empresas con equipos de ingeniería sólidos puede que Dagster sea más adecuado. Al centrarse en la calidad del código, las pruebas exhaustivas y el seguimiento detallado del linaje, Dagster es ideal para crear flujos de trabajo fáciles de mantener y listos para la producción. Sin embargo, su pronunciada curva de aprendizaje significa que los equipos deben planificar la formación y la incorporación adicionales.

Para grandes empresas con diversas necesidades de aprendizaje automático, la arquitectura basada en Kubernetes y nativa de la nube de Kubeflow ofrece una escalabilidad y una personalización incomparables. Esta plataforma es la más adecuada para las organizaciones con equipos de DevOps dedicados, capaces de gestionar su complejidad y aprovechar su flexibilidad para cumplir con diversos requisitos.

Equipos de ciencia de datos que buscan soluciones de implementación rápida podría preferir Metaflow. Sus funciones fáciles de usar para los desarrolladores, como el diseño basado en decoradores y el escalado automático, permiten a los equipos concentrarse en el desarrollo de modelos en lugar de en la infraestructura. Sin embargo, su confianza en AWS podría plantear desafíos para las organizaciones que buscan estrategias de nube múltiple.

Cada plataforma también se integra bien con los ecosistemas existentes, un factor clave a tener en cuenta. Prompts.ai proporciona una conectividad perfecta con varios proveedores de LLM, mientras que Kubeflow admite una amplia gama de herramientas y marcos de aprendizaje automático. Evalúe su paquete tecnológico actual para garantizar la compatibilidad.

Otra ventaja de prompts.ai es su modelo de precios de pago por uso, que elimina las tarifas de suscripción recurrentes. Esto lo convierte en una excelente opción para las organizaciones con un uso fluctuante de la IA. Por el contrario, las plataformas tradicionales suelen requerir importantes inversiones iniciales y costes operativos continuos.

Para tomar la mejor decisión, comience por identificar su caso de uso principal, evalúe las capacidades técnicas de su equipo y alinee las funciones de la plataforma con su estrategia de IA a largo plazo. Pon a prueba la plataforma que has seleccionado en un proyecto más pequeño para evaluar si es adecuada antes de ampliarla en toda la empresa.

Al elegir una plataforma de orquestación de aprendizaje automático, es fundamental evaluar la eficacia con la que se gestiona flujos de trabajo complejos. Esto incluye capacidades como la gestión de las dependencias de las tareas y la automatización de las transformaciones de datos. Igualmente importante es la capacidad de la plataforma para despliegue, gestione y supervise modelos a escala, garantizando que las operaciones de IA se desarrollen sin problemas y de manera eficiente.

Busque características que enfaticen integración perfecta con tus herramientas actuales, escalabilidad para adaptarse a las crecientes demandas y apoyar a simplificación de las implementaciones. Una plataforma diseñada para agilizar estas tareas puede ayudar a ahorrar tiempo, minimizar los errores y aumentar la productividad en los flujos de trabajo de IA.

La interoperabilidad es clave para que los sistemas de orquestación del aprendizaje automático se adapten perfectamente a los flujos de trabajo de IA existentes. Al permitir un intercambio de datos y una comunicación fluidos entre diversas herramientas, plataformas y entornos de nube, estos sistemas reducen las tareas manuales y ayudan a minimizar los errores.

Con este tipo de integración, los modelos de IA, las canalizaciones de datos y los componentes de infraestructura pueden colaborar de manera más eficaz. Esto no solo aumenta la escalabilidad y optimiza el uso de los recursos, sino que también acelera la implementación, garantiza un rendimiento uniforme y simplifica la administración de flujos de trabajo complejos.

Las empresas se enfrentan a una variedad de desafíos a la hora de implementar y expandir los sistemas de orquestación de aprendizaje automático. Uno de los problemas más apremiantes es el mantenimiento calidad y coherencia de los datos, ya que los datos poco fiables o incompletos pueden dar lugar a resultados de modelos defectuosos. Otro obstáculo reside en la gestión dependencias de datos complejas garantizando al mismo tiempo que los modelos se mantengan actualizados para reflejar los cambios en tiempo real.

La ampliación de estos sistemas presenta obstáculos adicionales, como la superación limitaciones de recursos, incluida una capacidad computacional insuficiente o una escasez de profesionales calificados. Fomentar una colaboración fluida entre los equipos es igualmente fundamental, pero puede resultar difícil. La resistencia interna al cambio o los obstáculos organizativos suelen complicar aún más el proceso de adopción. Desde el punto de vista técnico, cuestiones como control de versiones de modelos, latencia, y la aplicación de marcos de gobierno sólidos aumentan la complejidad de escalar los sistemas de aprendizaje automático de manera efectiva.