बड़े भाषा मॉडल (एलएलएम) से आउटपुट का मूल्यांकन करना सुनिश्चित करता है शुद्धता, जोखिमों को कम करता है, और व्यावसायिक आवश्यकताओं के साथ परिणामों को संरेखित करता है। खराब मूल्यांकन से त्रुटियां, अनुपालन संबंधी समस्याएं और पक्षपाती परिणाम हो सकते हैं। एलएलएम के प्रदर्शन का प्रभावी ढंग से आकलन करने का तरीका यहां दिया गया है:

क्विक टिप: प्रक्रियाओं को लगातार परिष्कृत करने के लिए स्वचालित टूल को मानव निरीक्षण के साथ मिलाएं और परिणामों को ट्रैक करें। यह दृष्टिकोण जोखिमों को कम करते हुए विश्वसनीय, उच्च-गुणवत्ता वाले आउटपुट को सुनिश्चित करता है।

मानकीकृत मानदंड स्थापित करने से बड़े भाषा मॉडल (एलएलएम) के मूल्यांकन की प्रक्रिया एक संरचित और वस्तुनिष्ठ प्रयास में बदल जाती है। यह अनुमान लगाने और व्यक्तिपरक तर्कों को समाप्त करता है, जिससे आपका ध्यान मापने योग्य परिणामों पर केंद्रित होता है जो आपके लक्ष्यों के अनुरूप होते हैं।

यह परिभाषित करके प्रारंभ करें कि आपके विशिष्ट अनुप्रयोग के लिए सफलता कैसी दिखती है। उदाहरण के लिए, एक ग्राहक सेवा चैटबॉट, सामग्री निर्माण उपकरण या कोड सहायक की तुलना में अलग-अलग मूल्यांकन मानकों की मांग करेगा। अपने उपयोग के मामले की वास्तविक दुनिया की मांगों को दर्शाने के लिए अपने मानदंडों को अनुकूलित करें।

गार्टनर बताया कि खराब डेटा या अनुचित मॉडल परीक्षण के कारण 85% GenAI प्रोजेक्ट विफल हो जाते हैं।

यह किसी भी मॉडल को लागू करने से पहले मूल्यांकन ढांचे के निर्माण के लिए समय और संसाधनों को समर्पित करने के महत्व पर प्रकाश डालता है।

कोर परफ़ॉर्मेंस मेट्रिक्स किसी भी एलएलएम मूल्यांकन प्रणाली की नींव तैयार करें, जो आउटपुट गुणवत्ता को मापने के लिए वस्तुनिष्ठ तरीके पेश करती है। मुख्य मैट्रिक्स में शामिल हैं सटीकता, जो तथ्यात्मक शुद्धता का आकलन करता है (उदाहरण के लिए, यह सुनिश्चित करना कि वित्तीय गणना सटीक हो), और प्रासंगिकता, जो मूल्यांकन करता है कि उपयोगकर्ता प्रश्नों के साथ प्रतिक्रियाएँ कितनी अच्छी तरह संरेखित होती हैं।

संतुलित दृष्टिकोण के लिए, अपने उपयोग के मामले के अनुरूप 1—2 कस्टम मेट्रिक्स को 2—3 सामान्य सिस्टम मेट्रिक्स के साथ मिलाएं। ये मेट्रिक्स मात्रात्मक, भरोसेमंद और मानवीय निर्णय को दर्शाने के लिए डिज़ाइन किए जाने चाहिए।

हालांकि ये मुख्य मेट्रिक्स एक ठोस ढांचा प्रदान करते हैं, लेकिन अपने आवेदन की विशिष्ट बारीकियों को दूर करने के लिए उन्हें कस्टम टूल के साथ पूरक करें।

जेनेरिक मेट्रिक्स एक व्यापक अवलोकन प्रदान करते हैं, लेकिन कस्टम चेकलिस्ट आपके संगठन की ज़रूरतों के अनूठे पहलुओं को संबोधित करने के लिए आवश्यक हैं। उदाहरण के लिए, सारांशीकरण कार्यों में, कस्टम मेट्रिक्स इस बात पर ध्यान केंद्रित कर सकते हैं कि सारांश में मुख्य जानकारी कितनी अच्छी तरह शामिल है और विरोधाभासों से बचा जाता है।

प्रभावी चेकलिस्ट स्वचालित स्कोरिंग को अलर्ट के साथ जोड़कर आउटपुट को फ़्लैग करने के लिए करती हैं जो स्वीकार्य थ्रेसहोल्ड से नीचे आते हैं। वास्तविक दुनिया के प्रदर्शन डेटा के आधार पर इन चेकलिस्ट के नियमित अपडेट, यह सुनिश्चित करते हैं कि वे प्रासंगिक बने रहें और उभरती मांगों को पूरा करते रहें। समय के साथ इन टूल को परिष्कृत करके, आप अपने लक्ष्यों के साथ तालमेल बनाए रख सकते हैं और मॉडल के समग्र प्रदर्शन में सुधार कर सकते हैं।

मूल्यांकन मानकों और कस्टम चेकलिस्ट को स्थापित करना सिर्फ शुरुआत है - स्वचालित उपकरण प्रक्रिया को अगले स्तर तक ले जाते हैं। ये उपकरण भाषा मॉडल का मूल्यांकन करने के पारंपरिक रूप से धीमे और मैन्युअल कार्य को एक सुव्यवस्थित, डेटा-संचालित प्रणाली में बदल देते हैं। गति और एकरूपता के साथ बड़े पैमाने पर आकलन को संभालने की उनकी क्षमता अमूल्य है, खासकर जब कई मॉडलों की तुलना की जाती है या व्यापक मात्रा में सामग्री का विश्लेषण किया जाता है।

उन्नत एल्गोरिदम का लाभ उठाकर, ये उपकरण अर्थ, सुसंगतता और संदर्भ का मूल्यांकन करते हैं, जो अक्सर मानवीय निर्णय की तुलना में परिणाम प्राप्त करते हैं। यह दृष्टिकोण उन आकलनों को सुनिश्चित करता है जो न केवल सटीक हैं, बल्कि मापनीय और दोहराए जाने योग्य भी हैं।

विकलता मूल्यांकन करता है कि एक भाषा मॉडल पीढ़ी के दौरान अपनी अनिश्चितता को मापकर शब्दों के अनुक्रमों की कितनी अच्छी तरह भविष्यवाणी करता है। कम पेलेक्सिटी स्कोर भविष्यवाणियों में अधिक आत्मविश्वास दर्शाता है। इसकी गणना प्रत्येक शब्द के लिए अनुमानित संभावनाओं की औसत नकारात्मक लॉग-संभावना के घातांक के रूप में की जाती है। उदाहरण के लिए, 2.275 का पेलेक्सिटी स्कोर शब्द विकल्पों में उच्च आत्मविश्वास को दर्शाता है। चिंता का एक प्रमुख लाभ यह है कि यह संदर्भ ग्रंथों पर निर्भर नहीं करता है, जिससे यह रचनात्मक कार्यों के लिए विशेष रूप से उपयोगी हो जाता है। हालांकि, यह ध्यान देने योग्य है कि कुछ एपीआई-आधारित मॉडल भविष्यवाणी की संभावनाओं तक पहुंच प्रदान नहीं करते हैं, जो कुछ परिदृश्यों में परेशानी के उपयोग को सीमित कर सकते हैं।

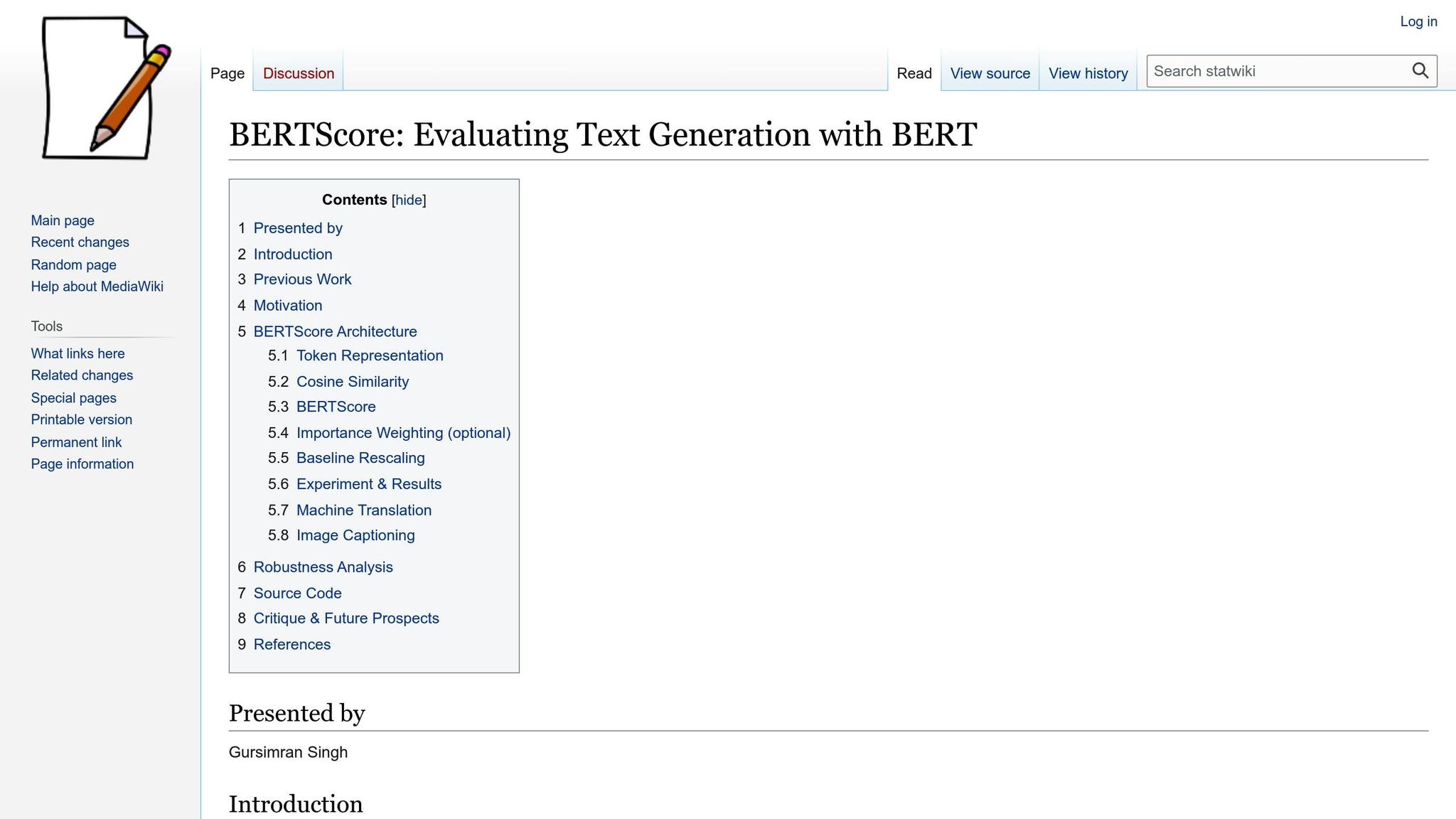

बर्ट स्कोरदूसरी ओर, पूर्व-प्रशिक्षित BERT एम्बेडिंग का उपयोग करके उत्पन्न और संदर्भ ग्रंथों के बीच शब्दार्थ समानता का मूल्यांकन करता है। सटीक शब्द मिलान पर निर्भर करने वाले मेट्रिक्स के विपरीत, BERTScore गहरे प्रासंगिक अर्थ को कैप्चर करता है। यह दोनों टेक्स्ट को टोकन करता है, एम्बेडिंग बनाता है, और संबंधित टोकन के बीच कोसाइन समानता की गणना करता है। उदाहरण के लिए, जब “बिल्ली चटाई पर बैठी थी” की तुलना “एक बिल्ली चटाई पर बैठी थी” से की जाती है, तो बर्टस्कोर “बैठा” और “बैठा था” के बीच शब्दार्थ समानता को पहचानता है।

नीला (द्विभाषी मूल्यांकन अंडरस्टडी) यह मापता है कि ओवरलैपिंग एन-ग्राम का विश्लेषण करके संदर्भ ग्रंथों के साथ उत्पन्न पाठ कितनी बारीकी से संरेखित होता है। यह अत्यधिक छोटे आउटपुट को हतोत्साहित करने के लिए एक संक्षिप्तता दंड भी लागू करता है।

लाली (रिकॉल-ओरिएंटेड अंडरस्टडी फॉर गिस्टिंग इवैल्यूएशन) रिकॉल पर केंद्रित है, यह मूल्यांकन करता है कि जेनरेट किए गए टेक्स्ट में संदर्भ सामग्री कितनी दिखाई देती है। ROUGE-1 (यूनिग्राम ओवरलैप), ROUGE-2 (बिग्राम ओवरलैप), और ROUGE-L (सबसे लंबा सामान्य परिणाम) जैसे वेरिएंट समानता के सूक्ष्म विश्लेषण की अनुमति देते हैं।

BLEU और ROUGE दोनों को संदर्भ ग्रंथों की आवश्यकता होती है, जो रचनात्मक या ओपन-एंडेड आउटपुट के मूल्यांकन के लिए उनकी प्रयोज्यता को सीमित करता है।

विश्वसनीय मूल्यांकन सुनिश्चित करने के लिए, स्कोरिंग सिस्टम को वर्कफ़्लो में एकीकृत किया जा सकता है। श्रेणीबद्ध स्कोरिंग द्विआधारी निर्णयों के लिए अच्छी तरह से काम करती है, जैसे कि यह निर्धारित करना कि क्या आउटपुट गुणवत्ता मानकों को पूरा करता है या संशोधन की आवश्यकता है। दूसरी ओर, मल्टी-क्लास स्कोरिंग अधिक विस्तृत आकलन की अनुमति देता है, जैसे कि विभिन्न गुणवत्ता आयामों में 1 से 5 के पैमाने पर रेटिंग आउटपुट।

जब स्वचालित स्कोरिंग सिस्टम को वर्कफ़्लो के साथ जोड़ा जाता है, तो वे विशिष्ट क्रियाओं को ट्रिगर कर सकते हैं। उदाहरण के लिए, एक निर्धारित सीमा से नीचे के आउटपुट को मानव समीक्षा के लिए फ़्लैग किया जा सकता है, जबकि उच्च प्रदर्शन करने वाली सामग्री सीधे परिनियोजन में ले जा सकती है। स्कोर वितरण और मूल्यांकनकर्ता रेटिंग की निगरानी करना भी विसंगतियों को उजागर कर सकता है। उदाहरण के लिए, यदि एक समीक्षक लगातार दूसरों की तुलना में उच्च स्कोर देता है, तो यह कैलिब्रेशन या अतिरिक्त प्रशिक्षण की आवश्यकता का संकेत दे सकता है। इन पैटर्नों का विश्लेषण करने से न केवल स्थिरता बढ़ती है, बल्कि ऐसी अंतर्दृष्टि भी सामने आती है जो भविष्य के मॉडल सुधारों और वर्कफ़्लो को बेहतर बनाने में मार्गदर्शन कर सकती हैं। मानव निरीक्षण के साथ स्वचालित स्कोरिंग का संयोजन पूरी तरह से गुणवत्ता आश्वासन सुनिश्चित करता है।

हालांकि स्वचालित टूल भाषाई पैटर्न का विश्लेषण करने में उत्कृष्ट होते हैं, लेकिन वे अक्सर टोन, सांस्कृतिक उपयुक्तता और डोमेन-विशिष्ट सटीकता जैसी सूक्ष्मताओं को कैप्चर करने में विफल होते हैं। मानव समीक्षक प्रासंगिक और पेशेवर मानकों के विरुद्ध सामग्री का मूल्यांकन करके इस अंतर को पाटते हैं। मानव अंतर्दृष्टि और स्वचालन के बीच यह साझेदारी अधिक गहन और प्रभावी गुणवत्ता नियंत्रण प्रक्रिया बनाती है, जो गति को गहराई के साथ संतुलित करती है।

व्यापक मूल्यांकन सुनिश्चित करने के लिए, एक टीम इकट्ठा करें जिसमें विषय विशेषज्ञ, अंतिम उपयोगकर्ता और भाषा विशेषज्ञ शामिल हों। डोमेन विशेषज्ञ ऐसी महत्वपूर्ण जानकारी देते हैं जिसे स्वचालित सिस्टम दोहरा नहीं सकते। उदाहरण के लिए, एक चिकित्सा पेशेवर नैदानिक अशुद्धियाँ पकड़ सकता है, जो सामान्य समीक्षक से बच सकती हैं, जबकि एक कानूनी विशेषज्ञ अनुबंध या नीतियों में अनुपालन समस्याओं की पहचान कर सकता है।

यह सहयोगात्मक दृष्टिकोण सुनिश्चित करता है कि आउटपुट सटीक और उपयोगकर्ता के अनुकूल दोनों हों। ऐसी टीमें जो स्पष्ट मूल्यांकन रूब्रिक को पहले से परिभाषित करती हैं - सटीकता, प्रासंगिकता, टोन और पूर्णता जैसे पहलुओं को कवर करती हैं - अधिक सुसंगत और कार्रवाई योग्य फ़ीडबैक देती हैं। अंधा मूल्यांकन निष्पक्षता को और बढ़ा सकते हैं, जिससे समीक्षक बिना किसी पूर्वाग्रह के स्वतंत्र रूप से आउटपुट का आकलन कर सकते हैं। नियमित कैलिब्रेशन सत्र मानकों को संरेखित करने में भी मदद करते हैं, जिससे समय के साथ स्थिरता सुनिश्चित होती है। ये सत्र मुश्किल मामलों पर चर्चा करने और वास्तविक दुनिया के उदाहरणों और मॉडल आउटपुट में उभरते रुझानों के आधार पर मानदंडों को परिष्कृत करने के लिए विशेष रूप से उपयोगी होते हैं।

आउटपुट का मूल्यांकन करने के लिए “जज” भाषा मॉडल (एलएलएम) का उपयोग करना एक और प्रभावी रणनीति है। इसमें आपके प्राथमिक मॉडल के आउटपुट का आकलन करने के लिए एक अलग, अक्सर अधिक उन्नत या विशिष्ट, LLM को तैनात करना शामिल है। ये जज मॉडल एक साथ कई आयामों का विश्लेषण करने में उत्कृष्ट हैं, जैसे कि तथ्यात्मक सटीकता, शैलीगत स्थिरता और टोन, जबकि उनके मूल्यांकन के लिए विस्तृत तर्क प्रदान करते हैं।

यह विधि बड़े पैमाने पर मूल्यांकन के लिए आदर्श है, क्योंकि जज मॉडल हजारों आउटपुट को कुशलतापूर्वक संसाधित कर सकते हैं, जो प्रमुख आयामों में संरचित फ़ीडबैक प्रदान करते हैं। शुरुआती स्क्रीनिंग को हैंडल करके, ये मॉडल मानव समीक्षकों को अधिक जटिल या अस्पष्ट मामलों पर ध्यान केंद्रित करने के लिए मुक्त करते हैं, जिनके लिए गहन निर्णय की आवश्यकता होती है।

इस दृष्टिकोण का अधिकतम लाभ उठाने के लिए, सटीक मूल्यांकन संकेतों को तैयार करें जो फीडबैक के मानदंडों और अपेक्षित संरचना को स्पष्ट रूप से रेखांकित करते हैं। सरल “हां या नहीं” निर्णयों से बचें; इसके बजाय, ऐसे विस्तृत विश्लेषणों का अनुरोध करें, जो प्रदर्शन को विशिष्ट श्रेणियों में विभाजित करते हैं। तुलनात्मक मूल्यांकन भी मूल्यवान हो सकते हैं - एक ही कार्य के लिए कई आउटपुट को रैंक करके, जज मॉडल सूक्ष्म गुणवत्ता अंतरों को उजागर कर सकते हैं और उनकी प्राथमिकताओं के लिए स्पष्टीकरण प्रदान कर सकते हैं।

एक बार मूल्यांकन पूरा हो जाने के बाद, निष्कर्षों का दस्तावेजीकरण दीर्घकालिक परिशोधन के लिए आवश्यक है। सार्थक रुझान विश्लेषण को सक्षम करने और संकेतों, मॉडलों और प्रक्रियाओं में सुधार का मार्गदर्शन करने के लिए मॉडल कॉन्फ़िगरेशन, इनपुट, स्कोर और समीक्षक टिप्पणियों जैसे मुख्य विवरण रिकॉर्ड करें।

समय के साथ, यह डेटा पैटर्न की पहचान करने के लिए एक शक्तिशाली उपकरण बन जाता है। उदाहरण के लिए, टीमें ट्रैक कर सकती हैं कि मॉडल के प्रदर्शन में सुधार हो रहा है या बार-बार आने वाली समस्याओं की पहचान कर सकती हैं जिन पर ध्यान देने की आवश्यकता है। रुझान विश्लेषण से यह भी पता चल सकता है कि कौन से कार्य लगातार उच्च-गुणवत्ता वाले परिणाम देते हैं और कहाँ अतिरिक्त प्रशिक्षण या फ़ाइन-ट्यूनिंग आवश्यक हो सकती है।

इसके अतिरिक्त, इंटर-रेटर विश्वसनीयता मेट्रिक्स को ट्रैक करना - समीक्षकों के बीच समझौते को मापना - मूल्यवान अंतर्दृष्टि प्रदान कर सकता है। निम्न अनुबंध अस्पष्ट मूल्यांकन मानदंडों या अस्पष्ट मामलों का संकेत दे सकता है, जिनकी आगे की जांच की आवश्यकता है, जबकि उच्च अनुबंध अच्छी तरह से परिभाषित मानकों और सुसंगत अनुप्रयोग का सुझाव देता है।

अंत में, फीडबैक को विकास प्रक्रिया में एकीकृत करने से यह सुनिश्चित होता है कि मूल्यांकन अंतर्दृष्टि से ठोस सुधार हो। ऐसी टीमें जो नियमित रूप से मूल्यांकन डेटा की समीक्षा करती हैं और अपने दृष्टिकोण को समायोजित करती हैं - चाहे वे रिफाइनिंग प्रॉम्प्ट, मॉडल बदलना, या वर्कफ़्लो अपडेट करना - अक्सर आउटपुट गुणवत्ता में ध्यान देने योग्य लाभ दिखाई देते हैं। मूल्यांकन को एक बार के चेकपॉइंट के बजाय एक सतत प्रक्रिया मानकर, संगठन निरंतर सुधार के लिए गुणवत्ता नियंत्रण को एक शक्तिशाली इंजन में बदल सकते हैं।

बड़े भाषा मॉडल (एलएलएम) की विश्वसनीयता सुनिश्चित करने के लिए प्रदर्शन और गुणवत्ता आकलन का निर्माण करना, आउटपुट पूर्वाग्रहों की पहचान करना और उन्हें दूर करना आवश्यक है। पूर्वाग्रह का पता लगाना भाषाई गुणवत्ता जैसे तकनीकी मैट्रिक्स का मूल्यांकन करने से अलग है; यह इस बात पर केंद्रित है कि क्या आउटपुट सभी समूहों के साथ समान व्यवहार करते हैं और हानिकारक रूढ़ियों को मजबूत करने से बचते हैं। इसके लिए बड़े डेटासेट में सूक्ष्म पैटर्न को भी उजागर करने के लिए व्यवस्थित तरीकों की आवश्यकता होती है।

पूर्वाग्रहों की पहचान करने के लिए, जनसांख्यिकी, विषयों और परिदृश्यों की एक विस्तृत श्रृंखला में आउटपुट की जांच करें। यह भेदभाव के स्पष्ट मामलों का पता लगाने से परे है और इसका उद्देश्य अधिक सूक्ष्म पूर्वाग्रहों को प्रकट करना है जो निर्णय लेने को प्रभावित कर सकते हैं या रूढ़िवादिता को कायम रख सकते हैं।

अलग-अलग टेस्ट डेटासेट बनाकर शुरू करें, जो आपके ऐप्लिकेशन में काम करने वाले यूज़र की विविधता को दर्शाते हैं। उदाहरण के लिए, हायरिंग प्लेटफ़ॉर्म में अलग-अलग जातीय पृष्ठभूमि से जुड़े नामों वाले रिज्यूमे शामिल हो सकते हैं, जबकि ग्राहक सेवा परिदृश्यों में विभिन्न आयु, स्थान और संचार शैलियों के यूज़र शामिल हो सकते हैं। लक्ष्य यह सुनिश्चित करना है कि आपके डेटासेट दृष्टिकोण के व्यापक स्पेक्ट्रम का प्रतिनिधित्व करते हैं।

जनसांख्यिकीय समता परीक्षण यह निर्धारित करने में मदद कर सकता है कि मॉडल विभिन्न समूहों के साथ लगातार व्यवहार करता है या नहीं। उदाहरण के लिए, अलग-अलग जनसांख्यिकीय मार्करों के साथ समान प्रॉम्प्ट चलाएँ और आउटपुट के टोन, गुणवत्ता और अनुशंसाओं की तुलना करें। उपचार में महत्वपूर्ण अंतर का पता लगाना अंतर्निहित पूर्वाग्रहों को इंगित कर सकता है जिनमें सुधार की आवश्यकता है।

इसके अलावा, के लिए परीक्षण करें अंतर्विभाजक पूर्वाग्रह जनसांख्यिकीय चर के संयोजन से, जैसे कि रंगीन महिलाओं या बुजुर्ग आप्रवासियों के लिए आउटपुट का मूल्यांकन करना। एक मॉडल लिंग और नस्लीय पूर्वाग्रहों को अलग-अलग संभाल सकता है, लेकिन जब ये कारक आपस में टकराते हैं तो वह विफल हो जाता है। वास्तविक दुनिया की इन जटिलताओं के लिए छिपे हुए मुद्दों को उजागर करने के लिए अनुरूप परीक्षण परिदृश्यों की आवश्यकता होती है।

उपयोग करें सामग्री विश्लेषण ढांचे व्यवस्थित रूप से आउटपुट की समीक्षा करने के लिए। विशिष्ट व्यवसायों को विशिष्ट लिंग के साथ जोड़ना, कुछ समूहों का पक्ष लेना, या समस्या-समाधान के संकीर्ण तरीकों पर भरोसा करने जैसे पैटर्न देखें। समय के साथ इन रुझानों पर नज़र रखने से पता चलेगा कि क्या आपके हस्तक्षेपों से कोई फर्क पड़ रहा है या पूर्वाग्रह बने रहते हैं।

अपनाने पर विचार करें ब्लाइंड इवैल्यूएशन प्रोटोकॉल, जहां समीक्षक इनपुट के जनसांख्यिकीय संदर्भ को जाने बिना आउटपुट का आकलन करते हैं। यह समीक्षकों की पूर्व धारणाओं के प्रभाव को कम करते हुए, आउटपुट में पूर्वाग्रहों को अलग करने में मदद कर सकता है।

एक बार पूर्वाग्रह पैटर्न की पहचान हो जाने के बाद, पारदर्शिता उपकरण उनकी उत्पत्ति का पता लगाने और सुधारात्मक कार्रवाइयों का मार्गदर्शन करने में मदद कर सकते हैं।

पारदर्शिता उपकरण इस बात पर प्रकाश डालते हैं कि मॉडल की आंतरिक निर्णय लेने की प्रक्रियाओं को प्रकट करके पूर्वाग्रह कैसे विकसित होते हैं। ये उपकरण पक्षपाती आउटपुट के मूल कारणों की पहचान करने और उनका समाधान करने के लिए अमूल्य हैं।

विज़ुअलाइज़ेशन टूल पर ध्यान दें आपको यह देखने की अनुमति देता है कि प्रतिक्रियाएँ उत्पन्न करते समय मॉडल इनपुट के किन हिस्सों पर ध्यान केंद्रित करता है। इससे पता चल सकता है कि मॉडल अप्रासंगिक जनसांख्यिकीय संकेतों से अत्यधिक प्रभावित है या नहीं। समूहों में ध्यान देने के पैटर्न की तुलना करना अनुचित फ़ोकस क्षेत्रों को उजागर कर सकता है।

ग्रेडिएंट-आधारित एट्रिब्यूशन विधियाँ इंगित करें कि किन इनपुट तत्वों का विशिष्ट आउटपुट पर सबसे अधिक प्रभाव पड़ता है। उदाहरण के लिए, यदि नेतृत्व की भूमिका के लिए किसी मॉडल की सिफारिश योग्यता की तुलना में लैंगिक सर्वनामों से अधिक प्रभावित होती है, तो यह तकनीक समस्या को उजागर करेगी।

प्रतितथ्यात्मक विश्लेषण आउटपुट में बदलावों का निरीक्षण करने के लिए व्यवस्थित रूप से इनपुट बदलना शामिल है। उदाहरण के लिए, ऐसे संकेत बनाएं जो केवल जनसांख्यिकीय विवरणों में भिन्न हों और परिणामी प्रतिक्रियाओं का विश्लेषण करें। यह दृष्टिकोण पूर्वाग्रह के ठोस प्रमाण प्रदान करता है और इसके प्रभाव को मापने में मदद करता है।

अंतरिक्ष विश्लेषण को एम्बेड करना जांच करता है कि मॉडल आंतरिक रूप से अवधारणाओं का प्रतिनिधित्व कैसे करता है। शब्द एम्बेडिंग की कल्पना करके, आप समस्याग्रस्त संगठनों की पहचान कर सकते हैं, जैसे कि कुछ व्यवसायों को मुख्य रूप से एक लिंग से जोड़ना।

बायस डिटेक्शन एल्गोरिदम तटस्थ संदर्भों में लैंगिक भाषा या वैश्विक अनुप्रयोगों में सांस्कृतिक मान्यताओं जैसे संकेतकों के लिए आउटपुट स्कैन करके इस प्रक्रिया के कुछ हिस्सों को स्वचालित कर सकते हैं। हालांकि ये टूल आसान नहीं हैं, लेकिन ये आगे की मानवीय समीक्षा के लिए संभावित मुद्दों को चिह्नित करने में मदद करते हैं।

आखिरकार, डेटा प्रभाव ट्रैकिंग प्रशिक्षण डेटा के विशिष्ट भागों में वापस पक्षपाती आउटपुट का पता लगा सकते हैं। इन कनेक्शनों को समझने से टीमों को डेटा क्यूरेशन को परिष्कृत करने, मॉडल फाइन-ट्यूनिंग को समायोजित करने या प्रॉम्प्ट इंजीनियरिंग रणनीतियों पर फिर से विचार करने में मदद मिलती है।

केंद्रीकृत प्लेटफ़ॉर्म प्रक्रियाओं को सरल और एकीकृत करके मूल्यांकन और पूर्वाग्रह शमन रणनीतियों को एक नए स्तर पर ले जाते हैं। पूर्वाग्रहों को दूर करने के बाद, ये प्लेटफ़ॉर्म आपको टूल को एक सिस्टम में समेकित करके मूल्यांकन को सरल बनाने की अनुमति देते हैं। यह दृष्टिकोण अक्षमताओं को दूर करता है, सुसंगत मानकों को सुनिश्चित करता है, और दृश्यता अंतराल को बंद करता है।

दूसरी ओर, खंडित वर्कफ़्लोज़, परिणामों की तुलना करना, समय के साथ प्रगति को ट्रैक करना, या टीमों में समान मूल्यांकन मानकों को बनाए रखना चुनौतीपूर्ण बनाते हैं। Prompts.ai जैसे प्लेटफ़ॉर्म 35 से अधिक भाषा मॉडल को एक साथ लाकर इन समस्याओं का समाधान करते हैं - जिनमें शामिल हैं जीपीटी-4, क्लाउड, लामा, और युग्म - व्यवस्थित मूल्यांकन और शासन के लिए डिज़ाइन किए गए एकल इंटरफ़ेस में।

एक केंद्रीकृत प्लेटफ़ॉर्म केवल टूल को मिलाने के अलावा और भी बहुत कुछ करता है। यह रियल-टाइम कॉस्ट ट्रैकिंग प्रदान करता है, जिससे संगठनों को उनके मूल्यांकन प्रयासों के वित्तीय प्रभाव के बारे में स्पष्ट जानकारी मिलती है। अंतर्निहित गवर्नेंस नियंत्रण यह सुनिश्चित करते हैं कि आकलन स्थापित प्रोटोकॉल और अनुपालन आवश्यकताओं के अनुरूप हों। निरीक्षण और कार्यक्षमता का यह संयोजन अनियमित परीक्षण को दोहराए जाने योग्य, ऑडिट करने योग्य प्रक्रियाओं में बदल देता है। मॉडल की सीधे तुलना करने और लागतों को ट्रैक करने की क्षमता मूल्यांकन वर्कफ़्लो को और बढ़ाती है।

प्रभावी एलएलएम मूल्यांकन के लिए मॉडल की सीधे तुलना करना आवश्यक है, लेकिन अलग-अलग प्रणालियों में मैन्युअल रूप से ऐसा करना समय लेने वाली और त्रुटि-प्रवण दोनों है। केंद्रीकृत प्लेटफ़ॉर्म साइड-बाय-साइड परफ़ॉर्मेंस विज़ुअलाइज़ेशन को सक्षम करके इस प्रक्रिया को सरल बनाते हैं, जिससे कई इंटीग्रेशन को प्रबंधित करने की परेशानी के बिना मॉडल के बीच सार्थक अंतर की पहचान करना आसान हो जाता है।

उदाहरण के लिए, आप विभिन्न एलएलएम में एक साथ समान प्रॉम्प्ट चला सकते हैं और वास्तविक समय में उनके आउटपुट की तुलना कर सकते हैं। यह समय या तत्काल विसंगतियों जैसे चर को समाप्त करता है, जो मॉडल का अलग-अलग परीक्षण करते समय परिणामों को तिरछा कर सकते हैं। दृश्य तुलनाएं विभिन्न आर्किटेक्चर में गुणवत्ता, स्थिरता और प्रासंगिकता के पैटर्न को उजागर करती हैं।

प्रदर्शन डैशबोर्ड सभी परीक्षण किए गए मॉडल के लिए प्रतिक्रिया समय, टोकन उपयोग और गुणवत्ता स्कोर जैसे प्रमुख मैट्रिक्स का स्पष्ट दृश्य प्रदान करते हैं। स्प्रेडशीट की बाजीगरी करने के बजाय, टीमें स्वचालित रिपोर्टों तक पहुंच सकती हैं, जो रुझानों को उजागर करती हैं और विशिष्ट कार्यों के लिए सबसे अच्छा प्रदर्शन करने वाले मॉडल हैं। इन डैशबोर्ड्स में अक्सर विशिष्ट समय-सीमा, उपयोगकर्ता समूहों या प्रॉम्प्ट श्रेणियों में ड्रिल करने के लिए फ़िल्टर शामिल होते हैं।

लागत पारदर्शिता एक और बड़ा फायदा है। Prompts.ai जैसे प्लेटफ़ॉर्म में रियल-टाइम FinOps ट्रैकिंग की सुविधा है, जो प्रति मूल्यांकन की वास्तविक लागत दिखाती है। यह स्पष्टता संगठनों को बजट संबंधी विचारों के साथ प्रदर्शन को संतुलित करने में मदद करती है, जिससे यह सूचित किया जा सकता है कि कौन से मॉडल अपनी आवश्यकताओं के लिए सर्वोत्तम मूल्य प्रदान करते हैं।

A/B परीक्षण वास्तविक दुनिया के उपयोगकर्ता डेटा का उपयोग करके मॉडल के प्रदर्शन को और अधिक मान्य करता है। यह विधि ठोस जानकारी प्रदान करती है कि कौन से मॉडल वास्तविक परिदृश्यों में सर्वश्रेष्ठ प्रदर्शन करते हैं, मॉडल चयन निर्णयों का मार्गदर्शन करते हैं।

केंद्रीकृत प्लेटफ़ॉर्म संस्करण ट्रैकिंग को भी सरल बनाते हैं। जब प्रदाता अपडेट जारी करते हैं, तो ये सिस्टम स्वचालित रूप से स्थापित बेसलाइन के विरुद्ध नए संस्करणों का परीक्षण कर सकते हैं, प्रदर्शन या व्यवहार में किसी भी महत्वपूर्ण बदलाव के लिए टीमों को सचेत कर सकते हैं। यह AI परिदृश्य के विकसित होने के साथ-साथ सेवा की गुणवत्ता को निरंतर सुनिश्चित करता है, जिससे संगठनों को उच्च मानकों को बनाए रखने और बेहतर निर्णय लेने में मदद मिलती है।

एलएलएम का प्रभावी ढंग से मूल्यांकन करने के लिए तकनीकी टीमों, डोमेन विशेषज्ञों और अनुपालन अधिकारियों जैसे विभिन्न हितधारकों से इनपुट की आवश्यकता होती है। केंद्रीकृत प्लेटफ़ॉर्म संरचित वर्कफ़्लो के माध्यम से इस सहयोग को सुविधाजनक बनाते हैं, जो मूल्यांकन प्रक्रिया के दौरान सभी दृष्टिकोणों को कैप्चर और दस्तावेजीकरण करते हैं।

भूमिका-आधारित पहुँच नियंत्रण संगठनों को यह परिभाषित करने की अनुमति देते हैं कि मूल्यांकन के विभिन्न पहलुओं को कौन देख सकता है, संशोधित कर सकता है या उन्हें अनुमोदित कर सकता है। उदाहरण के लिए, तकनीकी टीमें प्रदर्शन मेट्रिक्स और कॉन्फ़िगरेशन पर ध्यान केंद्रित कर सकती हैं, जबकि व्यावसायिक हितधारक आउटपुट गुणवत्ता और लक्ष्यों के साथ संरेखण का मूल्यांकन करते हैं। यह सेगमेंटेशन यह सुनिश्चित करता है कि हर कोई अनावश्यक विवरणों से दूसरों को परेशान किए बिना अपनी विशेषज्ञता का योगदान दे।

ऑडिट ट्रेल्स ट्रैक करते हैं कि किसने परीक्षण किए, कब परिवर्तन किए गए और निर्णय लिए गए। ये रिकॉर्ड विनियामक अनुपालन सुनिश्चित करते हैं और निरंतर सुधार का समर्थन करते हैं। पिछले निर्णयों या मानदंडों पर दोबारा गौर करते समय वे मूल्यवान संदर्भ भी प्रदान करते हैं।

सहयोगात्मक एनोटेशन टूल कई समीक्षकों को समान आउटपुट का आकलन करने और उनके मूल्यांकन की तुलना करने की अनुमति देते हैं। यह प्रक्रिया व्यक्तिपरक पूर्वाग्रहों की पहचान करने और आम सहमति के माध्यम से विश्वसनीय गुणवत्ता मानक स्थापित करने में मदद करती है। अंतर-रेटर विश्वसनीयता पर नज़र रखने से उन क्षेत्रों पर भी प्रकाश पड़ता है जहाँ मूल्यांकन प्रक्रियाओं में समायोजन की आवश्यकता हो सकती है।

पारदर्शी रिपोर्टिंग में तकनीकी मेट्रिक्स, मानव मूल्यांकन और लागत विश्लेषण को सारांश में समेकित किया जाता है जिसे नेतृत्व, अनुपालन टीमों या बाहरी लेखा परीक्षकों के साथ साझा किया जा सकता है। ये स्वचालित रिपोर्ट मॉडल के प्रदर्शन और मूल्यांकन गतिविधियों पर नियमित अपडेट प्रदान करती हैं, जिससे हितधारकों को सूचित रखना आसान हो जाता है।

सूचना प्रणालियां यह सुनिश्चित करती हैं कि टीमें लगातार मैन्युअल निगरानी के बिना प्रमुख मील के पत्थर, गुणवत्ता के मुद्दों या प्रदर्शन में बदलाव पर अपडेट रहें। अलर्ट को विशिष्ट थ्रेसहोल्ड के लिए कॉन्फ़िगर किया जा सकता है, जैसे कि गुणवत्ता स्कोर में गिरावट या बायस संकेतकों में वृद्धि, जरूरत पड़ने पर त्वरित कार्रवाई सुनिश्चित करना।

अंत में, जैसे उपकरणों के साथ एकीकरण स्लैक, माइक्रोसॉफ्ट टीम्स, या प्रोजेक्ट प्रबंधन प्लेटफ़ॉर्म मौजूदा वर्कफ़्लो में एलएलएम मूल्यांकन को एम्बेड करता है। परिचित टूल के माध्यम से अपडेट और अलर्ट देने से, केंद्रीकृत प्लेटफ़ॉर्म व्यवधान को कम करते हैं और टीमों के लिए गठबंधन और सूचित रहना आसान बनाते हैं।

भरोसेमंद एलएलएम आउटपुट सिस्टम बनाने के लिए, स्वचालित मेट्रिक्स को मानव निरीक्षण, अच्छी तरह से परिभाषित प्रदर्शन मानकों और चल रही पूर्वाग्रह निगरानी के साथ जोड़ना आवश्यक है। यह संतुलित दृष्टिकोण दक्षता और जवाबदेही दोनों को सुनिश्चित करता है।

प्रक्रिया स्थापना के साथ शुरू होती है स्पष्ट मूल्यांकन मानदंड विशिष्ट आवश्यकताओं के अनुरूप। चाहे ग्राहक सहायता के जवाबों को तैयार करना हो या तकनीकी दस्तावेज़ तैयार करना हो, यह परिभाषित करना कि शुरू से ही “अच्छा” आउटपुट क्या है, व्यक्तिपरक असहमतियों को कम करता है। BLEU और perplexity जैसे ऑब्जेक्टिव मेट्रिक्स मापने योग्य बेंचमार्क प्रदान करते हैं, लेकिन जब उन्हें संदर्भ और सूक्ष्म बारीकियों के लिए जिम्मेदार विशेषज्ञ समीक्षाओं के साथ जोड़ा जाता है, तो वे सबसे अधिक चमकते हैं।

निष्पक्षता, प्रतिनिधित्व और पारदर्शिता पर ध्यान केंद्रित करने वाले नियमित ऑडिट विश्वास बनाने और बनाए रखने के लिए महत्वपूर्ण हैं। यह विशेष रूप से तब महत्वपूर्ण होता है जब एलएलएम स्वास्थ्य सेवा, वित्त, या कानूनी सेवाओं जैसे संवेदनशील क्षेत्रों में कार्यरत होते हैं, जहां दांव ऊंचे होते हैं, और सटीकता पर कोई समझौता नहीं किया जा सकता है।

वर्कफ़्लो को केंद्रीकृत करना प्रभावी एलएलएम सिस्टम प्रबंधन की एक और आधारशिला है। बिखरे हुए टूल, API और मूल्यांकन विधियों को प्रबंधित करने के बजाय, Prompts.ai जैसे प्लेटफ़ॉर्म सब कुछ एक एकल, सुव्यवस्थित इंटरफ़ेस में समेकित करते हैं। इससे संगठन 35 से अधिक भाषा मॉडलों की साथ-साथ तुलना कर सकते हैं, रीयल-टाइम लागतों की निगरानी कर सकते हैं और शासन नियंत्रण लागू कर सकते हैं। इसके अलावा, केंद्रीकृत पहुंच और पारदर्शी FinOps ट्रैकिंग AI सॉफ़्टवेयर के खर्चों को 98% तक कम कर सकती है।

टीमों के बीच सहयोग मूल्यांकन प्रक्रिया को और बढ़ाता है। जब तकनीकी विशेषज्ञ, डोमेन विशेषज्ञ और अनुपालन अधिकारी भूमिका-आधारित एक्सेस और ऑडिट ट्रेल्स के साथ स्ट्रक्चर्ड वर्कफ़्लो का उपयोग करके एक साथ काम करते हैं, तो परिणाम अधिक व्यापक और रक्षात्मक होते हैं। सभी विभागों में साझा निष्कर्ष, सहयोगात्मक टिप्पणियां और सुसंगत मानक जैसी सुविधाएँ, खंडित परीक्षण प्रयासों को विश्वसनीय, दोहराने योग्य प्रक्रियाओं में बदल देती हैं।

अंततः, विश्वसनीय एलएलएम आउटपुट सिस्टम बनाने में सफलता बजट के आकार पर नहीं बल्कि मूल्यांकन ढांचे की ताकत पर निर्भर करती है। स्केलेबल, गुणवत्ता-संचालित प्रक्रियाएँ जो पारदर्शिता प्रदान करती हैं और निरंतर सुधार को बढ़ावा देती हैं, मूल्यांकन को एक बाधा से रणनीतिक लाभ में बदल देती हैं। इन तत्वों को एकीकृत करके, संगठन यह सुनिश्चित कर सकते हैं कि उनके एलएलएम सिस्टम लगातार, भरोसेमंद परिणाम प्रदान करें, जबकि वे उभरती चुनौतियों के अनुकूल रहें।

स्वचालित टूल और मानव निरीक्षण के बीच सही संतुलन बनाने के लिए, लीवरेजिंग से शुरुआत करें AI टूल्स प्रारंभिक फ़िल्टरिंग, संभावित समस्याओं का पता लगाने और नियमित मूल्यांकन करने जैसे कार्यों के लिए। ये टूल बड़े डेटासेट को तेज़ी से और लगातार प्रोसेस करने में उत्कृष्ट हैं।

एक ही समय पर, मानव निरीक्षण उन क्षेत्रों में महत्वपूर्ण भूमिका निभाता है जो सूक्ष्म निर्णय की मांग करते हैं - जैसे कि सूक्ष्म पूर्वाग्रहों को उजागर करना, तथ्यात्मक सटीकता को मान्य करना, और यह सुनिश्चित करना कि आउटपुट नैतिक और प्रासंगिक मानकों को पूरा करते हैं। यह सहयोगात्मक दृष्टिकोण गति और सटीकता को जोड़ता है, जिससे ऐसे परिणाम मिलते हैं जो आपकी विशिष्ट आवश्यकताओं के अनुरूप कुशल और सावधानीपूर्वक परिष्कृत दोनों होते हैं।

बड़े भाषा मॉडल (एलएलएम) कभी-कभी लिंग, नस्ल, सामाजिक मानदंडों या अन्य सांस्कृतिक पहलुओं से जुड़े पूर्वाग्रहों को प्रतिबिंबित कर सकते हैं। ये पूर्वाग्रह अक्सर इन मॉडलों को प्रशिक्षित करने के लिए उपयोग किए जाने वाले डेटा के भीतर असंतुलन के कारण उत्पन्न होते हैं, जिससे उनकी प्रतिक्रियाओं में रूढ़िवादिता या विकृत दृष्टिकोण पैदा होते हैं।

ऐसे पूर्वाग्रहों की पहचान करने में अनुचितता के पुनरावर्ती पैटर्न के लिए आउटपुट की जांच करना, विशेष पूर्वाग्रह पहचान टूल का उपयोग करना या स्थापित निष्पक्षता बेंचमार्क लागू करना शामिल है। इन समस्याओं को हल करने के लिए दृष्टिकोणों के संयोजन की आवश्यकता होती है: विविध और संतुलित डेटासेट को शामिल करना, क्राफ्टिंग प्रॉम्प्ट जो तटस्थता को बढ़ावा देते हैं, और विशेष रूप से AI आउटपुट में पूर्वाग्रह को कम करने के लिए डिज़ाइन किए गए स्वचालित टूल का उपयोग करते हैं। जनरेट की गई सामग्री की लगातार समीक्षा और परीक्षण यह सुनिश्चित करने के लिए भी उतना ही महत्वपूर्ण है कि यह नैतिक मानकों और इच्छित उद्देश्यों के अनुरूप हो।

मॉडल प्रदर्शन के निरंतर और कुशल मूल्यांकन को सुनिश्चित करके एलएलएम आउटपुट का आकलन करने में एक केंद्रीकृत मंच महत्वपूर्ण भूमिका निभाता है। सभी मूल्यांकन उपकरणों और प्रक्रियाओं को एक ही स्थान पर रखने के साथ, पूर्वाग्रहों, अशुद्धियों या मतिभ्रम जैसी चुनौतियों की पहचान करना और उनका समाधान करना अधिक सरल हो जाता है। यह दृष्टिकोण आउटपुट की विश्वसनीयता और गुणवत्ता को बनाए रखने में मदद करता है।

इसके अलावा, सब कुछ एक साथ लाने से वर्कफ़्लो सरल हो जाते हैं नियमित कार्यों को स्वचालित करना, वास्तविक समय की जानकारी प्रदान करना, और चल रहे सत्यापन का समर्थन करना। ये क्षमताएं न केवल समय बचाती हैं बल्कि यह भी सुनिश्चित करती हैं कि मॉडल बदलते उद्देश्यों और मानकों के अनुरूप रहें, एआई-संचालित समाधानों में विश्वास और निर्भरता को मजबूत करें।