Les outils d'orchestration de l'IA simplifient la gestion des systèmes d'IA complexes, permettent de gagner du temps, de réduire les coûts et de garantir des opérations sécurisées et évolutives. Avec des options allant de Prompts.ai, qui unifie plus de 35 LLM et réduit les coûts d'IA jusqu'à 98 %, pour Flux d'air Apache, leader de l'open source en matière de flux de travail personnalisés, il existe un outil pour chaque besoin. Que vous souhaitiez développer l'apprentissage automatique avec Kubeflow, en gérant les pipelines avec Préfet, ou en garantissant le respect de IBM Watsonx Orchestrate, ces plateformes rationalisent efficacement les flux de travail liés à l'IA. Voici un bref aperçu des principaux outils :

Chaque outil possède des atouts uniques, qu'il s'agisse d'économies de coûts ou de gouvernance avancée, ce qui fait que le choix dépend de l'expertise, de l'infrastructure et des objectifs en matière d'IA de votre équipe.

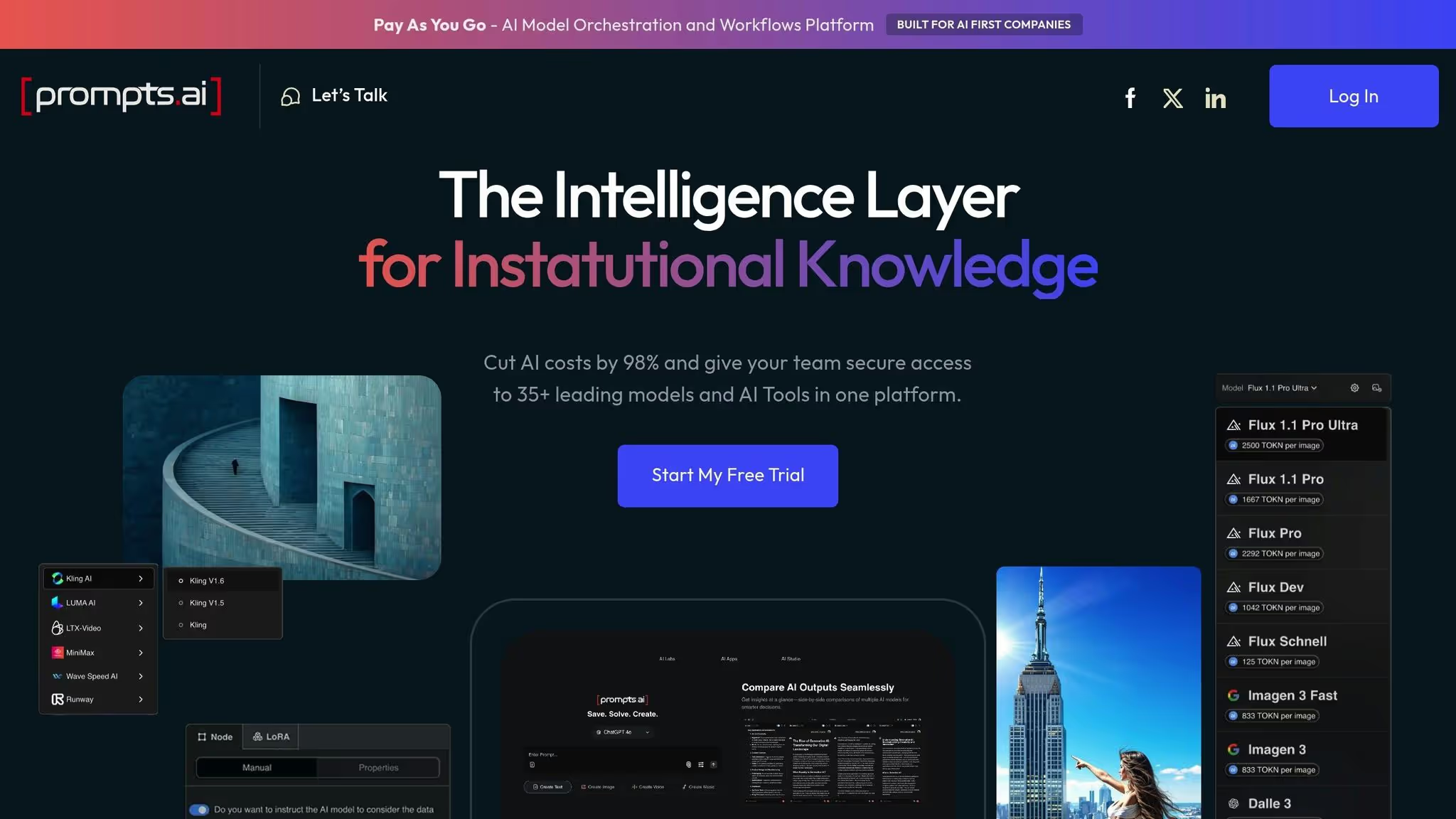

Prompts.ai est une puissante plateforme d'orchestration d'IA conçue pour une utilisation en entreprise, réunissant plus de 35 LLM de premier plan, dont GPT-5, Claude, Lama, et Gémeaux - dans une interface unique et sécurisée. En consolidant l'accès à ces modèles avancés, la plateforme aide les organisations à éliminer le chaos lié à la gestion de plusieurs outils d'IA, garantit une gouvernance solide et réduit les dépenses liées à l'IA jusqu'à 98 %. Il transforme des expériences ponctuelles et éparses en flux de travail efficaces et évolutifs. Ci-dessous, nous explorons comment Prompts.ai simplifie l'intégration, la mise à l'échelle et la gouvernance des modèles.

L'interface unifiée de Prompts.ai facilite la gestion et la sélection de modèles sans avoir à gérer plusieurs clés d'API ou à entretenir des relations avec différents fournisseurs. Les équipes peuvent comparer directement les performances des modèles au sein de la plateforme, ce qui leur permet de choisir celui qui correspond le mieux à leurs besoins. Le système de crédit TOKN par paiement à l'utilisation simplifie encore davantage la budgétisation en liant les coûts directement à l'utilisation, offrant ainsi une approche transparente et flexible de la gestion des dépenses.

L'évolutivité fluide de la plateforme permet aux utilisateurs d'ajouter rapidement des modèles, de développer des équipes et d'allouer des ressources selon les besoins. Cette architecture transforme les coûts fixes en une structure à la demande plus flexible, permettant aux petites équipes de passer à des opérations au niveau de l'entreprise sans les inefficacités et les frais généraux habituels liés à la gestion d'outils fragmentés.

Prompts.ai donne la priorité à la sécurité et à la conformité, conformément aux critères de référence du secteur tels que SOC 2 Type II, HIPAA et GDPR. Il fournit une visibilité et une auditabilité complètes pour chaque interaction avec l'IA, ce qui permet aux organisations de répondre aux exigences réglementaires sans avoir recours à des outils supplémentaires. Ce cadre de gouvernance intégré rationalise les processus de conformité, ce qui permet de démontrer plus facilement le respect des normes.

La tarification de Prompts.ai est conçue pour s'aligner sur son engagement en matière d'accessibilité et d'évolutivité, en utilisant un système de crédit TOKN payant à l'utilisation qui adapte les coûts en fonction de l'utilisation réelle. Cette approche transparente élimine le besoin de plusieurs abonnements, optimisant ainsi les investissements dans l'IA.

Plans personnels :

Plans d'affaires :

Cette structure tarifaire simple garantit que les utilisateurs ne paient que pour ce dont ils ont besoin, ce qui facilite la gestion des coûts tout en maximisant la valeur de leurs opérations d'IA.

Apache Airflow est une plateforme open source conçue pour orchestrer les flux de travail et gérer des pipelines de données complexes. Il est devenu un outil incontournable pour la planification et la surveillance des flux de travail dans les domaines de l'ingénierie des données et des opérations d'IA. En utilisant Python pour définir les flux de travail sous forme de graphes acycliques dirigés (DAG), Airflow permet aux équipes de créer, de planifier et de surveiller facilement des pipelines d'IA sophistiqués.

Airflow propose une variété de méthodes de déploiement pour répondre à différents besoins. Pour les équipes qui préfèrent un contrôle total, il peut être déployé sur leur propre infrastructure, qu'il s'agisse de serveurs bare-metal, de machines virtuelles ou de configurations conteneurisées à l'aide de Docker ou Kubernetes. Bien que cette approche auto-hébergée apporte de la flexibilité, elle nécessite des ressources dédiées et une maintenance continue.

Pour les entreprises qui souhaitent se décharger de la gestion de l'infrastructure, plusieurs fournisseurs de cloud proposent des services Airflow gérés. Des options telles que Flux de travail gérés par Amazon pour Apache Airflow (MAAA), Compositeur Google Cloud, et Astronome fournir des environnements entièrement gérés, en gérant les frais d'exploitation. Ces services sont généralement facturés en fonction de paramètres d'utilisation tels que le nombre de DAG, les exécutions de tâches et les ressources de calcul, les coûts variant en fonction de la taille de la charge de travail et de l'emplacement.

Cette flexibilité de déploiement permet à Airflow de s'intégrer sans effort à un large éventail d'outils et d'environnements d'IA.

La vaste bibliothèque d'opérateurs d'Airflow facilite la connexion aux frameworks d'IA. Les équipes peuvent orchestrer des tâches telles que la formation des modèles, le prétraitement des données et les flux de travail d'inférence à l'aide de ses opérateurs et crochets intégrés. Pour des besoins plus spécialisés, des opérateurs personnalisés peuvent être créés pour s'intégrer parfaitement aux frameworks d'apprentissage automatique les plus courants et aux services d'IA basés sur le cloud.

L'architecture d'Airflow est conçue pour évoluer horizontalement, ce qui la rend parfaitement adaptée à la gestion d'opérations d'IA exigeantes. Des exécuteurs tels que CeleryExecutor et KubernetesExecutor permettent l'exécution distribuée des tâches sur plusieurs nœuds de travail. Cela est particulièrement utile lors de la gestion de projets à grande échelle, tels que la formation simultanée de plusieurs modèles ou le traitement de grands ensembles de données. Cependant, une mise à l'échelle efficace nécessite une configuration minutieuse. La base de données de métadonnées, par exemple, peut devenir un goulot d'étranglement à mesure que le nombre de DAG et d'instances de tâches augmente. Pour y remédier, les équipes peuvent avoir besoin de mettre en œuvre des stratégies telles que le réglage des bases de données, le regroupement des connexions, la sérialisation des DAG et l'optimisation des ressources.

Airflow inclut un contrôle d'accès basé sur les rôles (RBAC) pour gérer les autorisations, garantir une séparation appropriée des tâches et un accès sécurisé aux flux de travail. La plateforme enregistre également toutes les exécutions de tâches, les échecs et les nouvelles tentatives, créant ainsi une piste d'audit détaillée. Ces journaux peuvent être intégrés à des systèmes de surveillance et de journalisation externes pour centraliser les rapports de conformité. Pour renforcer la sécurité, les organisations doivent mettre en œuvre les meilleures pratiques en matière de gestion des informations d'identification, de protection des clés d'API et des mots de passe de base de données utilisés dans les flux de travail.

En tant qu'outil open source, Apache Airflow lui-même est gratuit. Les principaux coûts proviennent de l'infrastructure requise pour le faire fonctionner, que ce soit sur site ou dans le cloud. Pour les configurations auto-hébergées, les dépenses dépendent de facteurs tels que le nombre de travailleurs, la taille du déploiement et les ressources de calcul. Les services gérés, tout en éliminant la nécessité de gérer l'infrastructure, sont assortis de frais permanents en fonction de la taille de l'environnement et de l'utilisation des ressources. Les organisations doivent soigneusement évaluer ces coûts par rapport à leurs besoins opérationnels afin de déterminer la meilleure solution.

Kubeflow est une plateforme open source conçue pour simplifier et adapter les flux de travail d'apprentissage automatique (ML) sur Kubernetes. Il prend en charge le cycle de vie complet des modèles de machine learning et propose des outils pour le déploiement, la gestion et la surveillance des modèles prêts pour la production. Compatible avec les frameworks populaires tels que TensorFlow, PyTorch, et XG Boost, Kubeflow propose une approche centralisée de la gestion des projets de machine learning.

Kubeflow fonctionne parfaitement dans tous les environnements dans lesquels Kubernetes est exécuté. Qu'il s'agisse d'une configuration sur site ou d'un service Kubernetes géré, la plateforme garantit des flux de travail ML cohérents et portables.

Grâce aux pipelines de machine learning modulaires de Kubeflow, les équipes peuvent créer et gérer facilement des flux de travail complexes. La plate-forme propose à la fois une interface utilisateur Web et une interface de ligne de commande (CLI) pour contrôler et automatiser les pipelines. Cette flexibilité permet aux utilisateurs d'intégrer leurs frameworks préférés sans être liés à une seule pile technologique, ce qui la rend adaptable à un large éventail de projets de machine learning.

Kubeflow exploite les puissantes capacités d'orchestration de conteneurs de Kubernetes pour gérer les ressources de manière efficace. Cela permet une formation distribuée et une diffusion de modèles, garantissant que la plate-forme peut gérer des projets nécessitant une puissance de calcul et une échelle importantes.

En centralisant la gestion du cycle de vie du machine learning, Kubeflow simplifie les processus de supervision et de conformité. Son architecture extensible prend en charge les opérateurs personnalisés, les plug-ins et l'intégration aux services cloud, ce qui permet aux équipes de personnaliser la plateforme pour répondre à des exigences spécifiques en matière de gouvernance et de conformité. Cette flexibilité permet à Kubeflow de s'adapter aux divers besoins organisationnels.

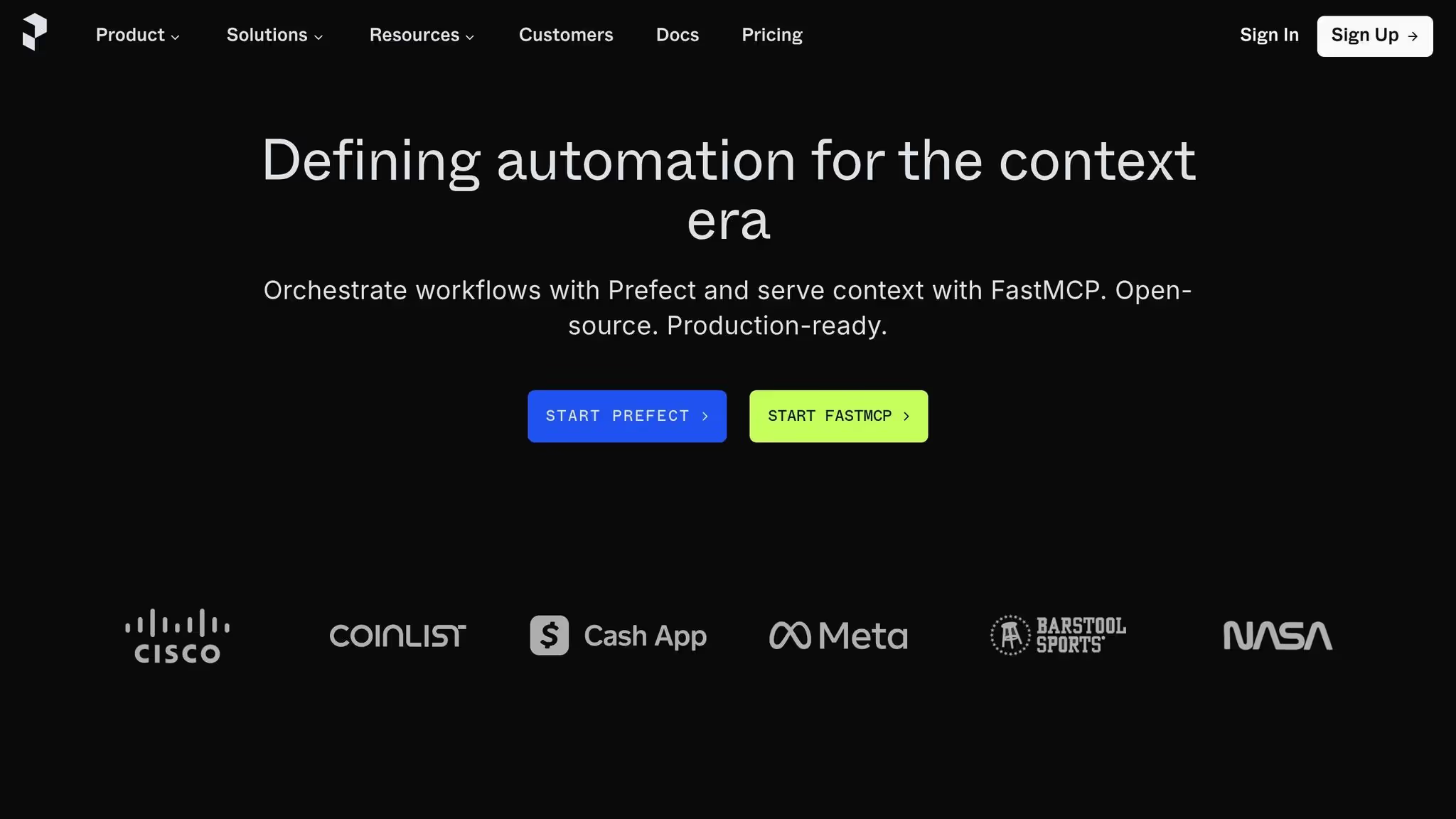

Prefect s'appuie sur le concept de pipelines de machine learning conteneurisés, un peu comme Kubeflow, mais se concentre sur la fourniture d'un moyen efficace et convivial pour le cloud de gérer les flux de données d'IA.

Avec Prefect, la gestion des flux de travail d'IA devient plus facile grâce à ses capacités d'automatisation et à ses puissants outils de surveillance. Sa principale force réside dans l'automatisation et le suivi des pipelines de données, garantissant ainsi des transitions de données fluides et ininterrompues, ce qui est essentiel pour les projets pilotés par l'IA. La plateforme dispose également d'une interface facile à naviguer qui fournit des mises à jour en temps réel, permettant aux équipes d'identifier et de résoudre rapidement tout problème.

Prefect prend en charge divers environnements de déploiement, ce qui le rend hautement adaptable aux différents besoins. Il s'intègre sans effort aux principaux services cloud tels que AWS, Plateforme Google Cloud, et Microsoft Azure, tout en fonctionnant bien avec des outils de conteneurisation tels que Docker et Kubernetes. Cette polyvalence permet à Prefect de s'intégrer dans un large éventail d'écosystèmes d'IA.

Prefect améliore l'orchestration des flux de travail liés à l'IA en se connectant à des outils puissants tels que Dask et Apache Spark. Son planificateur flexible prend en charge à la fois le traitement par lots et les opérations en temps réel, offrant aux équipes l'adaptabilité dont elles ont besoin pour diverses tâches d'IA.

Le moteur tolérant aux pannes et les capacités de traitement distribué de la plateforme en font un choix fiable pour faire évoluer les flux de travail d'IA. Même en cas d'erreur, le préfet veille à ce que les opérations restent stables et efficaces.

Prefect propose un plan gratuit qui inclut les fonctionnalités d'orchestration de base, tandis que des fonctionnalités avancées sont disponibles via des options tarifaires pour les entreprises.

IBM Watsonx Orchestrate est conçu pour répondre aux demandes complexes des secteurs réglementés, en proposant une orchestration des flux de travail d'IA de niveau entreprise en mettant l'accent sur la gouvernance et la sécurité. Conçu spécifiquement pour des secteurs tels que la finance, la santé et le gouvernement, il garantit la conformité à des exigences réglementaires et de protection des données strictes, se démarquant des plateformes centrées sur les développeurs.

La plateforme propose une gamme de choix de déploiement, notamment des configurations cloud, sur site et hybrides, adaptées à divers environnements informatiques. L'option cloud hybride est particulièrement avantageuse pour les secteurs réglementés, car elle permet aux organisations d'automatiser efficacement les processus au sein d'infrastructures hybrides tout en préservant la conformité et l'évolutivité. Ces options de déploiement s'intègrent parfaitement à des protocoles de gouvernance et de sécurité stricts.

IBM Watsonx Orchestrate intègre des contrôles d'accès basés sur les rôles (RBAC), permettant aux administrateurs de gérer les autorisations pour les flux de travail, les données et les modèles d'IA avec précision. Ses fonctionnalités de conformité sont conçues pour répondre aux normes rigoureuses des secteurs fortement réglementés. Grâce à ses fonctionnalités RBAC robustes, à ses fonctionnalités de cloud hybride et à son engagement en matière de conformité réglementaire, la plateforme garantit à la fois la sécurité et la transparence opérationnelle aux entreprises confrontées à des exigences de gouvernance complexes.

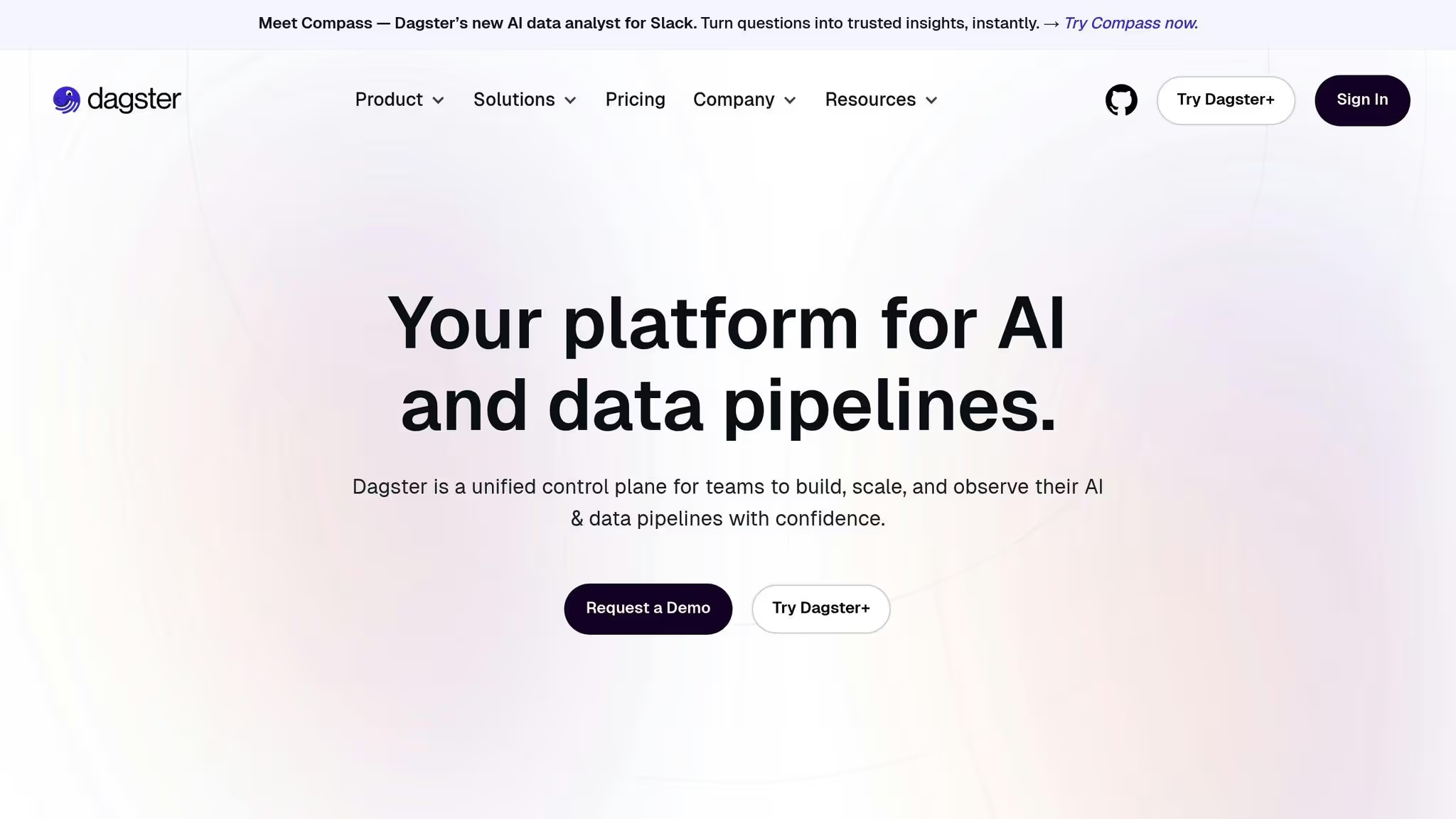

Dagster adopte une approche unique de l'orchestration en se concentrant sur les données en tant qu'élément central des flux de travail. Contrairement aux orchestrateurs traditionnels qui hiérarchisent les tâches, Dagster met l'accent sur les actifs de données en fournissant une vue complète des pipelines, des tableaux, des modèles d'apprentissage automatique (ML) et d'autres composants clés du flux de travail via son interface intuitive. Explorons ce qui distingue Dagster, notamment en ce qui concerne son intégration aux modèles d'IA.

Dagster simplifie la gestion des flux de travail de machine learning en intégrant le suivi des actifs et des fonctionnalités en libre-service. Il prend en charge les pipelines créés à l'aide de frameworks tels que Spark, SQL et DBT, garantissant la compatibilité avec vos outils existants. Son interface, Dagit, fournit une visibilité détaillée des tâches et des dépendances tout en isolant les bases de code pour éviter les interférences entre les processus. En outre, Dagster peut fonctionner conjointement avec d'autres outils d'orchestration en permettant des appels d'API personnalisés, ce qui facilite l'intégration du contrôle de version des données dans vos flux de travail.

Conçue pour les flux de travail d'IA exigeants, l'architecture de Dagster garantit la fiabilité même lorsque les pipelines deviennent de plus en plus complexes. Des fonctionnalités telles que la validation intégrée, l'observabilité et la gestion des métadonnées permettent de maintenir une qualité et une supervision élevées des données à mesure que vos opérations se développent.

Dagster propose un déploiement flexible pour répondre à divers besoins d'infrastructure. Que vous l'exécutiez localement pour le développement, sur Kubernetes ou que vous utilisiez une configuration personnalisée, Dagster s'adapte parfaitement à votre environnement.

CrewAI est une plateforme open source conçue pour coordonner les agents LLM spécialisés, leur permettant de gérer des tâches complexes grâce à la collaboration et à la délégation. Cette configuration le rend particulièrement efficace pour les flux de travail structurés qui nécessitent l'apport de plusieurs points de vue d'experts.

CrewAI décompose les tâches complexes en parties plus petites et faciles à gérer, en attribuant chaque segment à des agents spécialisés. Ces agents travaillent ensuite ensemble pour fournir des résultats cohérents et complets.

« CrewAI orchestre des équipes d'agents LLM spécialisés pour faciliter la décomposition des tâches, la délégation et la collaboration. C'est la solution idéale pour les flux de travail structurés nécessitant plusieurs profils d'experts. » - akka.io

Cette approche modulaire garantit l'adaptabilité à différents scénarios de déploiement.

Le cadre collaboratif de CrewAI offre une flexibilité et une personnalisation étendues en matière de déploiement. Sa base open source fournit un accès complet à la base de code, permettant aux développeurs d'adapter parfaitement la plateforme aux systèmes existants. Cette ouverture encourage également les contributions de la communauté, ce qui se traduit par des améliorations continues et de nouvelles fonctionnalités. Pour les organisations possédant une expertise technique, le déploiement de CrewAI peut s'avérer rentable. Grâce à l'auto-hébergement, les équipes conservent le contrôle total de leurs données et évitent d'être liées à des fournisseurs spécifiques, une fonctionnalité essentielle pour celles qui ont des exigences strictes en matière de résidence des données.

Metaflow, une plateforme de science des données open source développée par Netflix, simplifie le processus de création de modèles d'apprentissage automatique (ML) en gérant les complexités de l'infrastructure, permettant aux data scientists de se concentrer sur leurs tâches principales : les données et les algorithmes.

L'objectif principal de la plateforme est de minimiser les obstacles techniques liés à la gestion de l'infrastructure afin que les équipes puissent passer en douceur de l'expérimentation à la production sans dépendre fortement du support DevOps.

Metaflow propose une API intuitive conçue pour aider les data scientists à définir et à gérer facilement les flux de travail de machine learning. En orchestrant des flux de travail évolutifs, les équipes n'ont plus à se perdre dans la gestion des pipelines. Les principales fonctionnalités incluent la gestion intégrée des versions des données et le suivi du lignage, garantissant que chaque expérience et chaque itération du modèle sont bien documentées et reproductibles. En outre, son intégration fluide avec des services cloud tels qu'AWS permet aux équipes de tirer parti de puissantes ressources informatiques, ce qui rend plus efficace le passage à un déploiement prêt pour la production.

L'une des fonctionnalités les plus remarquables de Metaflow est sa capacité à adapter automatiquement les ressources de calcul pour des tâches exigeantes. Cette fonctionnalité garantit l'allocation de ressources supplémentaires en cas de besoin, ce qui la rend particulièrement utile pour les équipes qui travaillent avec de grands ensembles de données ou qui entraînent des modèles complexes. En automatisant la mise à l'échelle des ressources, les entreprises peuvent étendre leurs efforts en matière d'IA sans augmenter de manière significative les efforts de gestion de l'infrastructure. Cette évolutivité va de pair avec les options de déploiement flexibles de la plateforme.

Metaflow prend en charge les flux de travail low-code et no-code, ce qui le rend accessible aux data scientists ayant différents niveaux d'expertise en programmation. En tant que plateforme open source, elle propose des configurations de déploiement personnalisables, permettant aux organisations d'adapter l'outil à leurs besoins spécifiques. Grâce à une intégration fluide dans le cloud et à la prise en charge des environnements hybrides, les équipes peuvent maintenir des flux de travail cohérents dans les configurations sur site et dans le cloud. Cette flexibilité garantit que Metaflow peut s'intégrer dans divers écosystèmes opérationnels.

Cette section propose une comparaison côte à côte de différents outils, en mettant en évidence leurs principaux atouts et leurs principaux compromis afin de vous aider à choisir celui qui répond le mieux à vos besoins en matière de flux de travail d'IA. En examinant ces options, vous pouvez adapter votre sélection aux priorités, à l'expertise technique et aux ressources de votre organisation.

prompts.ai se distingue par sa capacité à unifier plus de 35 modèles linguistiques de premier plan en une seule plateforme sécurisée. Cela élimine les tracas liés à la gestion de plusieurs abonnements à l'IA, offrant une expérience rationalisée. Son système de crédit TOKN par paiement à l'utilisation peut réduire les coûts des logiciels d'IA jusqu'à 98 %, tandis que les contrôles FinOps intégrés offrent une transparence totale sur les dépenses. En outre, ses fonctionnalités de gouvernance de niveau entreprise et ses pistes d'audit garantissent la conformité et la sécurité des données. Cependant, l'accent mis sur la gestion de grands modèles de langage (LLM) peut limiter son utilité pour les pipelines de données hautement spécialisés.

Flux d'air Apache est un excellent choix pour créer des pipelines personnalisés, grâce à son framework basé sur Python et à son vaste écosystème de plugins. En tant qu'outil open source, il ne comporte aucun frais de licence et bénéficie d'une large communauté de contributeurs. Cependant, l'utilisation d'Airflow nécessite une expertise technique importante et un support DevOps continu pour la configuration, la maintenance et le débogage.

Kubeflow est idéal pour les organisations qui ont déjà investi dans l'infrastructure Kubernetes. Il propose une suite complète d'outils pour gérer l'ensemble du cycle de vie de l'apprentissage automatique, avec un support robuste pour la formation distribuée. Cependant, sa complexité et ses exigences élevées en matière de ressources peuvent le rendre moins adapté aux petites équipes ou aux budgets limités.

Préfet propose une approche moderne et native de Python pour l'orchestration des flux de travail, excellant en matière de gestion des erreurs et d'observabilité. Son modèle d'exécution hybride facilite la transition du développement local à la production dans le cloud. Cela dit, son écosystème d'intégrations et d'exemples prêts à être mis en production est encore en train de mûrir par rapport à des alternatives plus établies.

IBM Watsonx Orchestrate fournit un support de niveau professionnel avec une intégration transparente dans l'écosystème d'IA plus large d'IBM. Les modèles d'automatisation prédéfinis accélèrent le déploiement pour les tâches commerciales courantes. Cependant, son coût plus élevé et sa flexibilité limitée en dehors de l'écosystème IBM peuvent présenter des inconvénients pour certaines organisations.

Poignard se concentre sur la gestion des actifs de données avec des fonctionnalités telles que la saisie et les tests puissants, ce qui la rend particulièrement attrayante pour les équipes de génie logiciel. Ces outils contribuent à préserver la clarté et la stabilité des pipelines de données. En revanche, ses modèles de flux de travail uniques nécessitent une courbe d'apprentissage, et sa petite communauté peut limiter les intégrations disponibles et les ressources tierces.

IA de l'équipage est spécialisé dans les flux de travail d'IA multi-agents, offrant une délégation de tâches intégrée et une collaboration optimisée entre les agents. Cependant, sa focalisation étroite sur les systèmes multi-agents le rend moins adapté aux flux de travail généraux ou aux pipelines de données traditionnels.

Métaflow simplifie le passage de l'expérimentation à la production pour les équipes de data science. Des fonctionnalités telles que la gestion automatique des versions, le suivi du lignage et l'intégration fluide d'AWS réduisent la complexité de l'infrastructure. Cependant, ce n'est peut-être pas la solution idéale pour les équipes qui ont besoin d'un contrôle précis de l'infrastructure ou qui travaillent en dehors des environnements AWS.

Le meilleur outil pour votre organisation dépend de plusieurs facteurs, notamment de votre infrastructure existante, de l'expertise de votre équipe et de cas d'utilisation spécifiques. Par exemple :

Les considérations budgétaires sont également cruciales. Les outils open source permettent d'économiser sur les frais de licence mais nécessitent davantage de ressources internes pour la maintenance, tandis que les plateformes commerciales comme prompts.ai et IBM Watson X proposer des solutions gérées avec des structures de prix distinctes.

Lorsque vous choisissez un outil d'orchestration d'IA, il est essentiel d'aligner votre sélection sur les besoins spécifiques, l'expertise technique et la stratégie globale de votre équipe. Le marché actuel offre une grande variété d'options, allant des outils adaptés à la gestion des modèles de langage aux plateformes complètes de cycle de vie de l'apprentissage automatique. Voici une ventilation qui vous aidera à prendre une décision :

En fin de compte, le bon choix dépend des compétences techniques de votre équipe, de l'infrastructure existante et des besoins spécifiques en matière de flux de travail. Pour garantir une transition en douceur, envisagez de commencer par un projet pilote pour tester la compatibilité de l'outil avec votre environnement avant de passer à un déploiement complet.

Prompts.ai réduit les dépenses opérationnelles liées à l'IA en simplifiant les flux de travail et en automatisant les tâches répétitives, réduisant ainsi les efforts manuels. En réunissant divers outils déconnectés sur une seule plateforme cohérente, il élimine les inefficacités et réduit les frais généraux.

La plateforme fournit également des informations en temps réel sur l'utilisation des ressources, les dépenses et le retour sur investissement. Cela permet aux entreprises de prendre des décisions éclairées et fondées sur des données et d'affiner leurs stratégies d'IA pour une rentabilité maximale. Grâce à ces outils, les équipes peuvent consacrer leur énergie à l'innovation au lieu de se débattre avec des processus complexes.

Les outils d'orchestration d'IA open source permettent aux utilisateurs d'adapter le logiciel à leurs besoins uniques en modifiant le code source. Ce niveau de personnalisation peut être un avantage considérable, mais il s'accompagne souvent d'une courbe d'apprentissage plus abrupte. La configuration et la maintenance de ces outils nécessitent généralement un niveau d'expertise technique plus élevé, car les mises à jour et le support dépendent souvent des contributions de la communauté des utilisateurs plutôt que d'une équipe de support dédiée.

D'autre part, les outils commerciaux sont conçus pour simplifier le processus. Ils permettent un déploiement plus fluide, des mises à jour régulières et un accès à un support client professionnel pour le dépannage. Bien que ces outils soient assortis de frais de licence, ils peuvent aider les organisations à économiser du temps et des efforts en minimisant la complexité technique. Ils sont donc particulièrement intéressants pour les équipes disposant de ressources techniques limitées ou pour celles qui privilégient la commodité et la facilité d'utilisation.

Pour les équipes qui utilisent déjà Kubernetes, Kubeflow se distingue comme une option puissante. Cette plateforme open source est conçue pour créer, gérer et dimensionner des flux de travail d'apprentissage automatique directement sur Kubernetes. En tirant parti des capacités inhérentes à Kubernetes, Kubeflow simplifie considérablement le déploiement de modèles d'IA, garantissant une intégration fluide et une capacité d'évolution efficace.

Cette plateforme est particulièrement utile pour les équipes qui cherchent à simplifier les flux de travail complexes liés à l'IA tout en préservant la flexibilité nécessaire pour fonctionner dans différents environnements. Son alignement parfait avec Kubernetes en fait une solution idéale pour les organisations déjà engagées dans les systèmes conteneurisés.