Les outils de flux de travail basés sur l'IA transforment les entreprises en connectant des outils courants tels que Slack, Gmail et HubSpot à de puissants modèles linguistiques (LLM). Ces plateformes automatisent les tâches complexes, permettent de gagner du temps, de réduire les coûts et d'améliorer la productivité.

Voici ce que vous devez savoir :

Les principaux avantages sont les suivants :

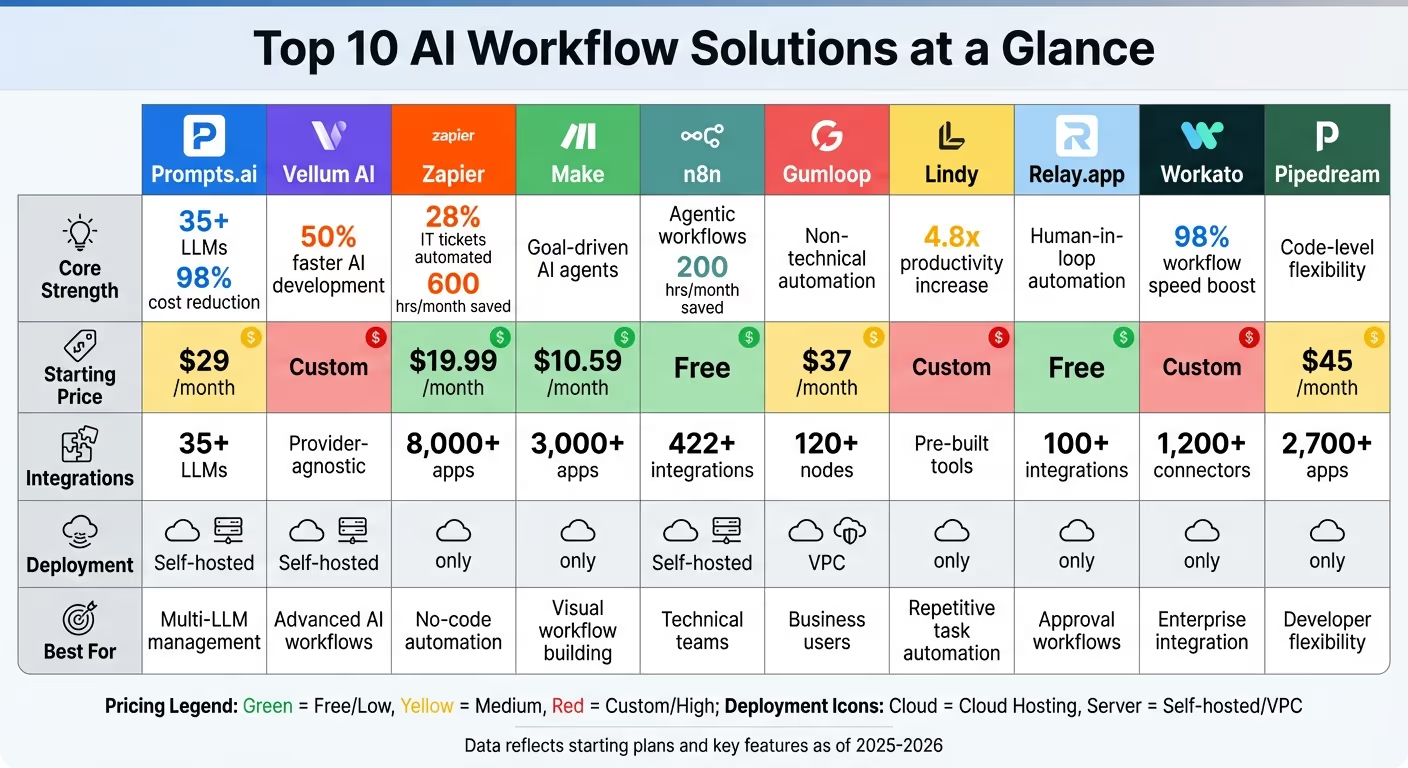

Comparaison rapide

Chaque plateforme possède des atouts uniques, que vous recherchiez une simplicité sans code, une flexibilité technique ou une gouvernance de niveau entreprise. Commencez modestement, automatisez les principaux flux de travail et suivez des indicateurs tels que le temps gagné et la réduction des coûts pour obtenir une valeur immédiate.

Comparaison des plateformes de flux de travail IA : fonctionnalités, prix et intégrations

Prompts.ai est une plate-forme puissante conçue pour l'orchestration de l'IA au niveau de l'entreprise. Il simplifie l'accès à plus de 35 grands modèles linguistiques de premier plan, notamment GPT-5, Claude, Lama, Gémeaux, Grok-4, Flux Pro, et Kling. En réunissant ces modèles dans une interface sécurisée, Prompts.ai répond à un défi majeur pour les organisations : la gestion de plusieurs outils d'IA. Au lieu de jongler entre différents abonnements et interfaces, les équipes peuvent utiliser un tableau de bord unique et rationalisé qui fournit une supervision claire de l'utilisation, des coûts et de la conformité. Voici ce qui distingue Prompts.ai en tant que solution incontournable pour les flux de travail d'IA.

Prompts.ai est conçu pour les organisations qui ont besoin d'un contrôle centralisé de leurs opérations d'IA. Il permet aux équipes de comparer les performances des modèles côte à côte et de déployer des flux de travail rapides conçus par des experts. Cela élimine la confusion causée par les outils déconnectés, tout en réduisant les coûts des logiciels d'IA jusqu'à 98 %. La plateforme utilise un système de paiement à l'utilisation Système de crédit TOKN, remplaçant les frais d'abonnement traditionnels par une tarification flexible basée sur l'utilisation, une configuration idéale pour les entreprises confrontées à des demandes fluctuantes en matière d'IA.

Prompts.ai facilite l'accès à sa vaste bibliothèque de modèles sans nécessiter d'intégrations individuelles. Les équipes peuvent passer facilement d'un modèle à l'autre, qu'il s'agisse d'utiliser GPT-5 pour raisonner, Claude pour des tâches à long contexte, ou des modèles spécialisés tels que Kling - le tout au sein d'un seul flux de travail unifié. Cette approche simplifie non seulement les opérations, mais fournit également des mesures de performance en temps réel, ce qui réduit considérablement la complexité opérationnelle.

La plateforme intègre des contrôles de niveau professionnel dans tous les aspects de ses flux de travail. Un intégré couche FinOps surveille l'utilisation des jetons, applique les limites de dépenses et lie les coûts de l'IA à des équipes ou à des projets spécifiques. Les entreprises ont accès à des pistes d'audit détaillées en matière de conformité et peuvent utiliser des contrôles d'accès basés sur les rôles pour protéger les données sensibles. En outre, Prompts.ai propose un Programme de certification Prompt Engineer, en dotant les membres de l'équipe des compétences et des meilleures pratiques nécessaires à des déploiements de haute qualité.

Prompts.ai propose une tarification flexible pour répondre à de nombreux besoins :

Vellum AI fait le pont entre les équipes techniques et non techniques, leur permettant de concevoir et de déployer des systèmes d'IA complexes. Qu'il s'agisse de chaînes rapides en plusieurs étapes, de chatbots RAG ou de traitements automatisés de documents, Vellum AI fournit les outils nécessaires pour gérer des flux de travail complexes. Sa fonction de synchronisation bidirectionnelle permet des transitions fluides entre les éditeurs visuels et les éditeurs basés sur le code sans perte de progression. Voyons comment Vellum simplifie la création et la gestion de flux de travail avancés.

Vellum AI est conçu pour alimenter des agents d'IA sophistiqués capables d'exécuter des outils, des boucles et des branches parallèles, favorisant ainsi une automatisation efficace. Redfin en est un exemple remarquable : en 2024, elle a doublé sa vitesse opérationnelle et introduit un assistant virtuel sur 14 marchés américains, démontrant ainsi l'efficacité de Vellum. Les équipes produit créent souvent des preuves de concept en une semaine à peine.

L'intégration indépendante des fournisseurs de Vellum prend en charge une variété de modèles LLM et permet de créer du code Python ou TypeScript personnalisé via des nœuds spécialisés. Ces nœuds gèrent des tâches telles que les requêtes HTTP, les pipelines RAG et la logique personnalisée, offrant flexibilité et rapidité. Les utilisateurs font état d'un processus de développement de l'IA 50 % plus rapide, ainsi que d'une résolution immédiate des erreurs, quelle que soit la disponibilité de l'infrastructure. La plateforme comprend également L'humain au cœur de la boucle nœuds, qui interrompent les flux de travail pour saisie ou approbation manuelle avant de reprendre l'exécution.

Grâce à des cadres de contrôle de version et de tests quantitatifs intégrés, appelés « évaluations », les équipes peuvent tester les flux de travail dans différentes conditions avant le déploiement. Le débogage devient plus simple grâce aux vues de trace avancées et à la capture instantanée de l'état. En outre, les nœuds Guardrail effectuent des évaluations en ligne, garantissant ainsi que les flux de travail répondent aux normes de qualité.

Vellum AI propose des options de déploiement flexibles, notamment le déploiement dans le cloud en un clic via une API ou l'auto-hébergement avec le SDK Vellum Workflows et des environnements d'exécution Docker personnalisés. Ses flux de travail composables permettent aux équipes de sauvegarder et de réutiliser les processus sous forme de nœuds modulaires, tandis que les nœuds de sortie finale garantissent une intégration précise des données dans les systèmes en aval.

Zapier simplifie l'automatisation pour les équipes grâce à sa plateforme conviviale et sans code. Bénéficiant d'un écosystème impressionnant de plus de 8 000 intégrations d'applications, y compris des outils populaires tels que Google Workspace, Salesforce, Slack et HubSpot, il permet des connexions fluides sur de multiples plateformes. Son interface intuitive par glisser-déposer permet aux utilisateurs non techniques de créer des flux de travail complexes à l'aide d'instructions en langage naturel, éliminant ainsi le besoin d'assistance technique. Cette accessibilité a ouvert la voie à des solutions d'automatisation efficaces.

Zapier se distingue dans la gestion d'automatisations simples et pilotées par des événements, telles que la synthèse du contenu, la classification des prospects et les réponses automatisées aux e-mails. Un exemple convaincant remonte à 2025, lorsque Marcus Saito, responsable de l'informatique et de l'automatisation de l'IA chez Remote, a dirigé une petite équipe de trois personnes pour intégrer Zapier à ChatGPT. Cette configuration a automatiquement classé et hiérarchisé 28 % des tickets informatiques, ce qui a permis à l'équipe de gagner plus de 600 heures par mois. Cela montre comment Zapier peut rationaliser les opérations sans s'appuyer sur une expertise technique approfondie.

Zapier va au-delà des flux de travail basiques à déclenchement et propose près de 500 intégrations spécifiques à l'IA. Il s'agit notamment de connexions fluides à des modèles tels que ChatGPT, Claude et Gemini, permettant aux utilisateurs d'intégrer l'IA directement dans leurs automatisations. La prise en charge par la plateforme du Model Context Protocol (MCP) permet aux modèles d'IA d'accéder à plus de 30 000 actions dans son écosystème. Ces intégrations ont aidé les organisations à réduire leurs coûts et à améliorer leur efficacité. De plus, les fonctionnalités d'interfaces et de tables de Zapier permettent aux équipes de créer des applications alimentées par l'IA sans avoir besoin de développeurs. Outre ses capacités d'intégration, Zapier donne la priorité à des opérations sécurisées et conformes.

Zapier inclut des outils de gouvernance robustes pour gérer les applications connectées, maintenir la conformité SOC 2 Type II et sécuriser les données grâce au cryptage AES-256. Alors que les connexions et les secrets d'API personnalisés doivent être configurés individuellement pour chaque flux de travail, la plateforme compense par des fonctionnalités telles que le contrôle d'accès basé sur les rôles (RBAC), l'authentification unique (SSO/SAML) et des journaux d'audit en temps réel. Les entreprises clientes sont automatiquement exclues des données de formation des modèles d'IA, et les administrateurs peuvent restreindre les intégrations d'applications d'IA tierces. Par exemple, Jacob Sirrs, spécialiste des opérations marketing chez Vendasta, a utilisé ces fonctionnalités de gouvernance pour implémenter l'automatisation de l'IA qui a permis de récupérer environ 1 million de dollars de revenus potentiels et d'éliminer 282 jours de travail manuel par an.

Zapier fonctionne comme un service cloud entièrement géré, ne nécessitant aucune infrastructure supplémentaire. Le niveau gratuit comprend 100 tâches par mois, tandis que les plans professionnels, allant de 19,99$ à 29,99$ par mois (facturés annuellement), proposent 750 tâches et des flux de travail en plusieurs étapes. Pour les entreprises qui ont besoin de connexions sécurisées à leurs données internes, Zapier propose le peering VPC et la liste des adresses IP autorisées. Les évaluations constamment élevées de la plateforme par les utilisateurs soulignent sa fiabilité et son efficacité dans la fourniture de solutions d'automatisation.

Faites des offres interface axée sur le visuel pour créer des flux de travail d'IA, en simplifiant la création d'automatisations complexes grâce à la fonctionnalité glisser-déposer. Contrairement aux outils d'automatisation traditionnels qui reposent sur des règles rigides, Make permet aux équipes de concevoir agents d'IA axés sur les objectifs. Ces agents déterminent de manière dynamique les étapes nécessaires pour atteindre un objectif spécifique à l'aide de grands modèles linguistiques. Cette flexibilité fait de Make un excellent choix pour des tâches telles que la gestion de l'inventaire des magasins, le tri des tickets d'assistance client, la génération de mots clés de référencement et l'automatisation des appels de prospects.

Réussissez en orchestrant des agents d'IA adaptatifs et axés sur les objectifs, qui s'ajustent en temps réel pour atteindre les objectifs commerciaux. Tout au long de 2024, l'utilisation de l'IA dans les flux de travail de Make a été multipliée par quatre, mettant en évidence une demande croissante d'automatisation autonome. Sa capacité à fournir des résultats commerciaux mesurables en a fait un outil précieux dans divers secteurs, consolidant ainsi sa position de leader en matière d'automatisation des flux de travail en temps réel.

La plateforme s'intègre parfaitement à Plus de 3 000 applications prédéfinies et propose plus de 30 000 actions, qui couvre des outils tels que Salesforce, HubSpot, Slack, monday.com et NetSuite. Pour les flux de travail spécifiques à l'IA, Make fournit Plus de 400 intégrations avec des modèles tels que OpenAI (ChatGPT, Sora, DALL-E), Anthropic Claude, Google Vertex AI (Gemini), Perplexity AI, DeepSeek AI et Mistral AI. Les utilisateurs peuvent également tirer parti d'une boîte à outils HTTP/Webhook et d'une API flexible pour connecter des systèmes propriétaires. En outre, Make dispose d'un serveur Model Context Protocol hébergé dans le cloud, permettant d'accéder aux scénarios depuis n'importe quelle interface d'IA. Ces options d'intégration étendues sont complétées par des contrôles de gouvernance robustes pour préserver l'intégrité du flux de travail.

Make garantit la qualité et la sécurité grâce à des fonctionnalités telles que contrôle d'accès basé sur les rôles (RBAC), des limites d'utilisation spécifiques à l'équipe et un tableau de bord d'analyse pour suivre les performances. C'est « L'humain au courant » cette fonctionnalité ajoute un niveau de supervision supplémentaire, en permettant aux utilisateurs d'examiner et d'approuver les résultats générés par l'IA avant de passer à l'étape suivante du flux de travail. Cette fonctionnalité constitue une garantie essentielle pour maintenir une automatisation de haute qualité.

Make est disponible en tant que service cloud entièrement géré, doté d'une interface visuelle conviviale. Il est amélioré par « Maïa », un assistant d'intelligence artificielle qui permet de créer des flux de travail à l'aide de commandes en langage naturel, et « Créer une grille », qui fournit une vue d'ensemble de toutes les automatisations. La tarification commence par un niveau gratuit offrant 1 000 crédits par mois, avec des forfaits payants allant de 10,59$ par mois pour 34,12 $/mois, ainsi que des options d'entreprise personnalisées. La plateforme bénéficie d'une grande satisfaction des utilisateurs, avec 4.8/5 sur Capterra à partir de 404 commentaires et 4.7/5 sur G2 basé sur 238 avis.

n8n est une plateforme conçue pour les utilisateurs techniques qui souhaitent créer des flux de travail d'IA autonomes. Contrairement aux processus linéaires traditionnels, n8n se concentre sur « flux de travail agentiques » - où les agents d'IA peuvent prendre des décisions de manière indépendante, utiliser des outils et effectuer des tâches en plusieurs étapes. Il est donc idéal pour les configurations complexes telles que l'enchaînement de demandes d'IA pour du contenu multimodal, la gestion des interactions de chat dynamiques ou la coordination d'équipes multi-agents. Par exemple, un agent « contrôleur d'accès » peut acheminer intelligemment des tâches vers des agents spécialisés, tels que ceux qui gèrent le support technique ou les demandes de facturation.

n8n brille lorsque les équipes techniques doivent concevoir des flux de travail complexes et axés sur des objectifs qui vont au-delà de l'automatisation de base. Sa capacité à traiter des données non structurées et à favoriser la prise de décision autonome a donné des résultats impressionnants. À Delivery Hero, Dennis Zahrt, directeur de la prestation de services informatiques mondiaux, a introduit un flux de travail ITOps unique pour la gestion des utilisateurs, permettant ainsi d'économiser 200 heures par mois. De même, StepStones Luka Pilic, responsable technique de Marketplace, a utilisé n8n pour accélérer de 25 fois l'intégration des données de la place de marché, réduisant à deux heures seulement les tâches qui prenaient autrefois deux semaines.

La plateforme propose Plus de 422 intégrations prédéfinies et inclut des nœuds LangChain natifs pour des fonctionnalités d'IA avancées. C'est « Les nœuds en tant qu'outils » simplifie les connexions à une vingtaine de services populaires, tels que Telegram et Google Calendar, grâce à la fonction $fromAI (), éliminant ainsi le besoin d'une configuration complexe. Avec plus de 1 700 modèles de flux de travail, les équipes peuvent rapidement démarrer de nouveaux projets. De plus, n8n prend en charge jusqu'à 220 exécutions de flux de travail par seconde sur une seule instance, ce qui en fait un choix judicieux pour les opérations à volume élevé. Ces intégrations sont associées à de solides mesures de sécurité et de contrôle pour garantir la fiabilité.

n8n donne la priorité à la sécurité et à la conformité, en proposant des fonctionnalités de niveau professionnel telles que SSO (SAML/LDAP), un contrôle d'accès avancé basé sur les rôles (RBAC), des magasins secrets cryptés et Conformité SOC 2. Il prend également en charge le contrôle des sources basé sur GIT, permettant aux équipes de déplacer en toute sécurité les flux de travail entre la préparation et la production, de suivre les modifications et de revenir en arrière si nécessaire. Pour les agents conversationnels, la fonction « Window Buffer Memory » permet de conserver le contexte de multiples interactions en utilisant des clés de session liées aux identifiants utilisateur, garantissant ainsi une expérience utilisateur fluide.

n8n propose des options d'hébergement flexibles pour répondre aux différents besoins organisationnels. Les équipes peuvent opter pour service cloud géré, hébergez-les vous-même via Docker ou Kubernetes pour un meilleur contrôle des données, ou déployez des configurations entièrement sur site et ventilées pour une confidentialité maximale. Le Édition communautaire est gratuit, tandis que les forfaits Cloud et Enterprise incluent des fonctionnalités avancées telles que la gestion externe des secrets via AWS Secrets Manager ou HashiCorp Vault. Avec un Évaluation de 4,9/5 sur G2 et avec plus de 170 000 étoiles sur GitHub, n8n s'est taillée une place de choix en tant que solution de premier plan pour les flux de travail pilotés par l'IA.

Gumloop permet aux équipes du marketing, des ventes, des ressources humaines et des opérations de créer des flux de travail pilotés par l'IA sans avoir à écrire une seule ligne de code. En connectant l'IA à diverses applications, la plateforme permet aux utilisateurs d'automatiser même les tâches les plus complexes. Ce qui distingue Gumloop, c'est flux de travail dynamiques, où l'IA détermine la meilleure étape suivante d'un processus. Cette flexibilité en fait la solution idéale pour les équipes qui comprennent leurs flux de travail mais ne possèdent pas d'expertise technique en matière de codage.

Gumloop se distingue en mettant l'automatisation directement entre les mains des utilisateurs professionnels. Instacart Le PDG Fidji Simo a partagé :

Gumloop a joué un rôle essentiel en aidant toutes les équipes d'Instacart, y compris celles qui n'ont pas de compétences techniques, à adopter l'IA et à automatiser leurs flux de travail.

De même, Bryant Chou, cofondateur de Flux Web, a souligné :

Gumloop permet de gagner du temps au sein d'une organisation. Il met les outils entre les mains de personnes qui comprennent une tâche et leur permet de l'automatiser.

Une caractéristique remarquable, « Interfaces », permet aux utilisateurs de transformer des flux de travail automatisés en applications destinées aux utilisateurs. Cela signifie que les membres de l'équipe ou les clients peuvent bénéficier directement de l'automatisation sans avoir à se plonger dans la configuration technique.

L'écosystème de Gumloop comprend plus de 120 nœuds natifs qui s'intègrent à des outils populaires tels que Salesforce, Airtable, Apollo, Slack, Gmail, Stripe et Zendesk. Il prend en charge plusieurs LLM premium, tels que OpenAI GPT-O3-Pro, Anthropic Claude 4 Sonnet, Deepseek V3 R1, Gemini 2.5 Pro et Perplexity, le tout sous un seul abonnement. La plateforme Protocole de contexte modèle (MCP), baptisé « GumCP », permet de se connecter à des milliers d'outils et d'API supplémentaires.

L'assistant IA intégré, « Gummie », simplifie la création de flux de travail en utilisant des instructions en langage naturel pour créer ou suggérer des configurations automatiquement. Une extension Chrome est encore plus pratique en permettant aux utilisateurs de gérer les flux de travail directement depuis leur navigateur.

Gumloop donne la priorité à une sécurité de niveau professionnel avec Conformité au SOC 2 et au RGPD, des contrôles d'accès détaillés, des rôles utilisateur personnalisés et des journaux d'audit. Les équipes peuvent gérer les modèles d'IA accessibles via Gouvernance des modèles d'IA paramètres. En outre, le Prise en charge d'AI Proxy Cette fonctionnalité permet aux entreprises d'utiliser leurs propres clés d'API et d'acheminer les demandes via des proxys privés, ajoutant ainsi une couche de sécurité supplémentaire. Les options de tarification incluent :

Gumloop propose des modèles de déploiement flexibles pour répondre à différents besoins. La norme hébergement cloud L'option avec calcul de mise à l'échelle automatique est idéale pour une configuration rapide. Pour les entreprises clientes qui ont besoin de plus de contrôle, Déploiements de cloud privé virtuel (VPC) conserver les données au sein de leur infrastructure. Les flux de travail à volume élevé bénéficient d'une exécution parallèle, tandis que l'accès par programmation est disponible via des webhooks, des API REST et des kits de développement logiciel Python/TypeScript. Pour les organisations soumises à des exigences strictes en matière de résidence des données, installations sur site sont disponibles, ainsi qu'une connectivité hybride pour les bases de données internes telles qu'Amazon RDS via des nœuds personnalisés.

Lindy se distingue en tant que plateforme d'agents d'IA conçue pour créer des « coéquipiers IA » capables de s'attaquer à des tâches répétitives qui occupent souvent jusqu'à 40 % du temps d'un travailleur du savoir. Ces agents s'appuient sur « Étapes de l'agent » pour gérer des flux de travail complexes de manière autonome. Lindy est donc particulièrement efficace pour des tâches telles que la gestion du courrier électronique, la planification de réunions, le support client et la génération de prospects, des domaines qui nécessitent un jugement nuancé plutôt que des règles basiques du « si alors ». Cette approche s'inscrit dans la tendance croissante à utiliser l'IA pour simplifier et automatiser le travail répétitif.

Lindy s'adresse aux organisations qui souhaitent automatiser les processus manuels en flux de travail fluides, 24 heures sur 24, 7 jours sur 7. En adoptant Lindy, les entreprises peuvent multipliez par 4,8 la productivité et réduisez les délais de traitement en 67 %, délivrant un 30 À 200 % DE RETOUR SUR INVESTISSEMENT au cours de la première année. Flo Crivello, fondatrice et PDG de Lindy, souligne l'accent mis par la plateforme sur les intégrations :

La qualité des agents d'IA dépend de leurs intégrations. C'est toute la thèse de Lindy.

Les agents de Lindy combinent des instructions avancées, des modèles tels que GPT-4 ou Claude, des compétences spécialisées et des conditions de sortie claires pour améliorer l'efficacité du flux de travail. Ils s'améliorent également au fil du temps en mémorisant les interactions passées, offrant ainsi une expérience plus intelligente et plus personnalisée.

Lindy fournit un écosystème d'intégration robuste avec des connexions prédéfinies à des outils tels que Gmail, HubSpot et Salesforce. Ces intégrations sont alimentées par des partenariats qui étendent considérablement les capacités de la plateforme. Grâce à une interface sans code, les utilisateurs peuvent définir des « déclencheurs » (événements qui activent un agent) et des « actions » (réponses effectuées par l'agent). L'utilisation de clients OAuth pré-approuvés garantit une intégration rapide et fluide aux technologies existantes, éliminant ainsi les longs délais d'approbation.

Lindy donne la priorité à la sécurité et à la conformité avec des certifications telles que RGPD, SOC 2, HIPAA et PIPEDA. La plateforme comprend une surveillance automatisée, des rapports détaillés et des pistes d'audit pour répondre aux exigences réglementaires strictes. Pour les flux de travail impliquant des décisions critiques, les utilisateurs peuvent implémenter « L'humain au courant » étapes, permettant un examen humain avant que l'IA ne procède. Des fonctionnalités supplémentaires telles que le cryptage, les contrôles d'accès et la surveillance automatisée de la conformité garantissent les plus hauts niveaux de sécurité, ce qui le rend adapté aux environnements d'entreprise sensibles.

Lindy fonctionne en tant que plateforme Web sans code où les utilisateurs peuvent décrire les agents en langage clair. Les flux de travail simples peuvent être automatisés en quelques jours, tandis que les processus d'entreprise plus complexes prennent généralement 2 à 8 semaines pour une intégration et des tests complets. Pour aider les nouveaux utilisateurs à démarrer, Lindy propose 400 crédits/tâches gratuits, avec des solutions d'entreprise disponibles via un modèle « Talk to Sales » pour une configuration et une évolutivité personnalisées. Des modèles d'agents prédéfinis sont également disponibles, permettant aux utilisateurs de déployer des agents entièrement fonctionnels en quelques minutes seulement.

Relay.app se démarque en mettant l'accent automatisation axée sur l'humain, en veillant à ce que les flux de travail ne fonctionnent pas entièrement en mode pilote automatique. Cette approche permet aux équipes d'insérer des points de contrôle pour les approbations, la saisie manuelle ou la prise de décision dans le cadre de processus pilotés par l'IA. Il est particulièrement utile pour les tâches à enjeux élevés, telles que la génération de contrats avec les clients, pour lesquelles la supervision humaine n'est pas négociable.

Relay.app permet la création de mini-agents IA qui fonctionnent de manière semi-indépendante dans le cadre de flux de travail plus importants. Ces agents analysent les instructions et le contexte pour décider des mesures à prendre et gèrent efficacement les sous-flux de travail adaptés à des scénarios spécifiques. En outre, la plateforme propose des actions d'IA préconfigurées pour les tâches courantes, accélérant ainsi la mise en œuvre. Benjamin Borowski, pompier/développeur, a partagé son point de vue :

Le modèle « humain dans la boucle » de Relay est très efficace pour les équipes. Non seulement c'est l'interface utilisateur la mieux conçue du marché pour l'automatisation des bâtiments, mais ils ont vraiment réfléchi à la façon dont tout ne peut pas être automatisé.

Cet équilibre entre automatisation et supervision s'intègre parfaitement à un écosystème d'outils robuste.

Relay.app prend en charge plus de 100 intégrations et fonctionnalités capacités d'IA multimodèles, permettant aux utilisateurs de combiner des modèles tels qu'OpenAI (GPT-4o, GPT-4o mini), Anthropic (Claude 3.5 Sonnet), Google (Gemini 1.5 Pro), Groq (LLama 3) et Perplexity au sein d'un seul flux de travail. Pour simplifier le traitement des données, la plateforme utilise « objets liés », permettant aux utilisateurs d'accéder aux ressources associées (par exemple, naviguer d'une offre CRM à son contact associé) sans plusieurs appels d'API. Grâce à la synchronisation des données en temps réel, les informations restent à jour, ce qui élimine le besoin de récupérer les données de manière répétitive. Pour les outils dépourvus d'intégrations natives, Relay.app prend en charge les webhooks et les requêtes HTTP personnalisées.

Relay.app est Conforme aux normes SOC 2 et inclut des contrôles administratifs robustes pour le partage de l'espace de travail, les autorisations et des journaux d'audit détaillés. La plate-forme garantit la cohérence des données grâce à la transmission sécurisée des données, en appliquant les formats correspondants (par exemple, URL, e-mail, fichier) pour éviter les erreurs de configuration lors des intégrations. Les points de contrôle humains peuvent être intégrés directement dans les flux de travail automatisés via Slack ou par e-mail, garantissant ainsi la révision des décisions critiques avant de poursuivre.

Relay.app fonctionne comme plateforme SaaS basée sur le cloud, proposant un plan gratuit qui inclut toutes les intégrations, un espace de travail collaboratif pour deux utilisateurs et un accès raisonnable à GPT-4o et GPT-4o mini. Les forfaits payants offrent des limites d'utilisation de l'IA nettement plus élevées, réinitialisées tous les mois, tandis que le plan Enterprise ajoute un support spécialisé. La plateforme est exclusivement hébergée dans le cloud, sans options d'auto-hébergement ni d'options open source, offrant une expérience entièrement gérée adaptée aux entreprises comptant de 1 à 500 employés.

Workato se distingue en tant que plateforme conçue pour répondre au besoin croissant de solutions de flux de travail basées sur l'IA au niveau des entreprises. Il s'agit d'une centrale d'intégration conçue pour connecter les capacités d'IA aux systèmes d'entreprise critiques, ce qui en fait la solution idéale pour les organisations qui gèrent des processus complexes en plusieurs étapes dans tous les départements. De la rationalisation de l'intégration des ressources humaines à l'optimisation des opérations commerciales, Workato propose une automatisation adaptée aux flux de travail complexes. La plateforme a déjà permis aux utilisateurs d'économiser plus de 100 000 heures, une mise en œuvre ayant permis d'augmenter de 98 % la vitesse de traitement des demandes de relocalisation des employés.

L'une des fonctionnalités les plus remarquables de Workato est Travaillez chez Genies - des agents IA prêts à l'emploi pour des tâches telles que l'intégration des ressources humaines, le support informatique, les mises à jour du CRM commercial et l'identification des prospects marketing. Pour les entreprises qui souhaitent personnaliser leurs solutions, Studio d'agent fournit un environnement low-code pour créer, tester et déployer des agents adaptés à des besoins spécifiques. Mohit Rao, responsable de l'automatisation intelligente, souligne l'adoption organique de la plateforme :

Les utilisateurs professionnels ont commencé à utiliser Workato de manière organique. Une fois que nous avons identifié ces utilisateurs professionnels, nous les élevons au rang de champions afin de responsabiliser d'autres équipes ou d'autres personnes, et nous les utilisons pour passer à la prochaine vague d'échelle.

Le AI par Workato Le connecteur est livré avec des actions préconfigurées telles que l'analyse de texte, la rédaction et la synthèse d'e-mails, en s'appuyant sur des modèles d'Anthropic et d'OpenAI. Il prend en charge jusqu'à 60 demandes par minute pour les espaces de travail destinés aux clients directs. En outre, Workbot intègre les flux de travail d'IA directement dans Slack et Microsoft Teams, permettant aux employés d'interagir avec les agents sans changer d'application.

Workato possède une vaste bibliothèque de plus de 1 200 connecteurs prédéfinis, couvrant les plateformes SaaS modernes, les systèmes sur site et même les sources de données existantes. Il s'intègre parfaitement aux outils d'entreprise populaires tels que Salesforce, HubSpot, Workday, NetSuite, Snowflake et aux principaux modèles d'IA d'OpenAI, Anthropic, Google Gemini, AWS Bedrock, Azure OpenAI, DeepSeek et Mistral AI. Pour les systèmes sans connecteurs natifs, Workato propose des options d'intégration universelles via HTTP, des SDK et des analyseurs de données pour JSON, XML et CSV. C'est Protocole de contexte modèle (MCP) garantit que les grands modèles de langage (LLM) fonctionnent avec un contexte de niveau professionnel et une précision transactionnelle sur tous les systèmes.

La sécurité et la conformité sont au cœur de la conception de Workato. La plateforme est conforme aux normes SOC 2 Type II, ISO 27001, PCI DSS et GDPR, offrant des contrôles robustes tels que le SSO SAML, le SCIM, le provisionnement juste à temps et l'authentification à deux facteurs. Avec Apportez votre propre clé (BYOK), les utilisateurs bénéficient d'une rotation horaire des touches et d'un masquage des données sensibles pour une couche de protection supplémentaire. Travaillez chez Aegis fournit une visibilité complète sur les utilisateurs, les processus et les applications connectées, aidant ainsi les entreprises à appliquer efficacement les politiques de sécurité. La passerelle MCP garantit que les agents d'IA opèrent dans des limites régies, empêchant ainsi les actions non autorisées et éliminant le risque d' « IA fantôme ».

En tant que plateforme SaaS native du cloud, Workato utilise une architecture conteneurisée sans serveur qui prend en charge une évolutivité élastique et offre une disponibilité impressionnante de 99,9 %. Il garantit la résidence des données aux États-Unis et dans la zone EMEA, en traitant les données d'IA dans la même région que son centre de données source. Reconnu comme leader dans le Magic Quadrant™ de Gartner® pour la plate-forme d'intégration en tant que service (iPaaS) pendant sept années consécutives, Workato continue de démontrer sa capacité à évoluer et à prendre en charge des besoins d'automatisation complexes. Ses dernières avancées renforcent encore sa position de solution incontournable pour l'orchestration des flux de travail basés sur l'IA.

Pipedream trouve un équilibre entre la commodité du no-code et le contrôle du codage personnalisé, ce qui en fait un excellent choix pour les équipes qui ont besoin flexibilité au niveau du code ainsi que des outils de flux de travail visuels conviviaux. En janvier 2026, Pipedream a étendu sa portée d'entreprise en s'intégrant à Workday. Avec plus de 11 019 étoiles sur GitHub, il bénéficie d'un solide soutien de la part de la communauté des développeurs, notamment pour sa capacité à gérer des flux de travail d'IA complexes. Cette combinaison d'adaptabilité et de reconnaissance communautaire en fait une option convaincante pour de nombreux cas d'utilisation.

Pipedream brille en matière de course logique personnalisée dans les flux de travail, prenant en charge Node.js v20, Python, Go et Bash. Cela le rend particulièrement utile pour des tâches telles que le formatage des données pour les entrées AI ou l'affinement des sorties. L'assistant « Build with AI » de la plateforme simplifie le codage en générant des extraits de code. Il suffit d'appuyer Ctrl+I dans l'éditeur pour commencer. Avec plus de 10 000 déclencheurs et actions prédéfinis, les développeurs peuvent accélérer leurs flux de travail et ajouter du code personnalisé uniquement lorsque cela est nécessaire. Pipedream soutient également le Protocole de contexte modèle (MCP), qui normalise la communication entre les modèles d'IA et les sources de données externes, garantissant ainsi une intégration fluide.

Pipedream se connecte à plus de 2 700 applications, dont OpenAI, AWS, Salesforce, Slack, HubSpot, Notion et Airtable. Sa fonction « Authentification unique » simplifie la gestion des informations d'identification des API, en gérant en toute sécurité les clés sur plusieurs flux de travail. Pour les tâches spécifiques à l'IA, les développeurs peuvent utiliser des étapes de code personnalisées pour envoyer des requêtes d'API à de grands modèles de langage, avec des en-têtes, des paramètres et des structures d'invite personnalisés. Ce niveau de précision dépasse souvent ce que les actions prédéfinies peuvent atteindre. En combinant une vaste bibliothèque d'intégrations avec la possibilité de personnaliser au niveau du code, Pipedream offre une alternative plus rapide à la création de flux de travail à partir de zéro sur des plateformes comme AWS Lambda. Il garantit également la fiabilité grâce à de solides mesures de sécurité.

Pipedream s'aligne sur SOC 2 Type II, HIPAA, et GDPR normes, ce qui le rend adapté aux entreprises qui gèrent des informations sensibles. La plateforme fournit des accords DPA, garantissant la conformité des flux de travail qui traitent des informations de santé protégées ou des informations personnelles identifiables. Ces certifications garantissent une sécurité de niveau professionnel sans nécessiter de configuration supplémentaire, ce qui permet aux organisations de traiter des données critiques en toute tranquillité.

Pipedream fonctionne comme plateforme cloud gérée avec une exécution sans serveur, adaptant automatiquement les flux de travail pour répondre à la demande. Les flux de travail peuvent être déclenchés par le biais de HTTP/Webhooks, d'appels au SDK ou d'événements d'application, et ils prennent en charge des exécutions planifiées allant de toutes les secondes à des intervalles trimestriels. Cette conception sans serveur élimine le besoin de gestion de l'infrastructure, garantissant ainsi que les flux de travail ne s'exécutent que lorsque cela est nécessaire. En minimisant les frais généraux et en fournissant une orchestration efficace de l'IA, Pipedream offre une solution efficace aux équipes qui cherchent à rationaliser leurs opérations.

Lors de la sélection d'une plateforme de flux de travail d'IA, il est essentiel de prendre en compte quatre facteurs clés : le niveau de compétence technique de votre équipe, la complexité de vos cas d'utilisation de l'IA, vos besoins en matière de gouvernance et votre préférence pour la commodité des solutions basées sur le cloud ou le contrôle d'options auto-hébergées. Les dix plateformes décrites ici répondent à un large éventail de demandes organisationnelles, chacune offrant des fonctionnalités uniques pour répondre à des exigences spécifiques.

Des plateformes natives d'IA telles que Vélin AI, Gumloop, et Lindy sont spécialement conçus pour l'orchestration de grands modèles de langage. Ces plateformes excellent dans la fourniture d'outils avancés pour les tests, la gestion des versions et les comparaisons de performances, parfaits pour les organisations qui gèrent des agents d'IA complexes. D'autre part, les outils d'automatisation traditionnels tels que Zapier et Fabriquer ont intégré des fonctionnalités d'IA à leurs systèmes, ce qui en fait une solution idéale pour les équipes qui souhaitent intégrer des modèles d'IA à des milliers d'applications SaaS. Par exemple, Zapier a automatisé plus de 200 millions de tâches d'IA, tandis que Make possède une impressionnante bibliothèque de plus de 7 500 modèles.

En ce qui concerne le déploiement, les plateformes sont divisées entre les solutions exclusivement basées sur le cloud et les solutions auto-hébergées. Zapier, Fabriquer, Gumloop, Relay.app, Lindy, et Pipedream proposent des configurations sans serveur basées sur le cloud. Entre-temps, n8n fournit à la fois des options cloud et auto-hébergées, et Vélin AI prend en charge les installations de cloud privé virtuel (VPC), répondant aux besoins des entreprises qui ont besoin d'environnements isolés pour gérer des données sensibles. Ces options de déploiement flexibles sont conçues pour améliorer les résultats de production.

Les fonctionnalités de gouvernance constituent un autre domaine dans lequel les plateformes diffèrent. Des outils de niveau professionnel tels que Travaillez à et Vélin AI mettre l'accent sur le contrôle d'accès basé sur les rôles (RBAC), garantissant une transition en douceur du prototype à la production. Des plateformes telles que Relay.app se concentrer sur les flux de travail intégrés à l'humain, permettant aux responsables de revoir et d'approuver les décisions relatives à l'IA avant qu'elles ne soient exécutées. Par exemple, le robot d'escalade personnalisé Slack d'Okta a permis de réduire considérablement les temps d'assistance, de 10 minutes à quelques secondes seulement, tout en gérant efficacement 13 % des escalades.

Les structures de prix varient considérablement d'une plateforme à l'autre. Fabriquer propose un plan Core à partir d'environ 9$ par mois, tandis que Travaillez à suit un modèle de tarification personnalisé pour les entreprises. Des solutions axées sur les développeurs, telles que n8n fournir des versions auto-hébergées gratuites, et Pipedream inclut 20 millions de jetons AI dans son plan de base à 45$ par mois. Gumloop, d'autre part, regroupe des clés d'API premium dans son abonnement de 37$ par mois. Les utilisateurs signalent une réduction de 80 % du traitement manuel et une augmentation de 90 % de la précision. Ces différents modèles de tarification reflètent le large éventail d'options disponibles pour répondre à différents budgets et besoins.

Lors de la sélection d'une plateforme de flux de travail basée sur l'IA, il est essentiel d'aligner le choix sur l'expertise technique, les exigences de gouvernance et les objectifs à long terme de votre équipe. Que vous ayez besoin d'une plateforme sans code pour des raisons de simplicité ou d'une solution dotée d'outils de développement avancés tels que des kits de développement Python et des fonctionnalités d'auto-hébergement, il existe une option adaptée à vos besoins.

Pour prendre la meilleure décision, concentrez-vous sur quatre aspects clés : si la plateforme est native à l'IA ou ancrée dans l'automatisation traditionnelle, le choix entre un déploiement basé sur le cloud ou auto-hébergé, le niveau de supervision humaine requis et votre budget. Ces considérations mettent en évidence la manière dont la bonne plateforme peut remodeler vos opérations.

« Je n'ai pas besoin d'une équipe hautement technique, j'ai juste besoin des bons outils. » - Korey Marciniak, responsable senior de la stratégie et des opérations de support client, Okta

Commencez par identifier une ou deux tâches répétitives qui impliquent un certain niveau de raisonnement humain, par exemple le triage des tickets informatiques, le routage des prospects ou la révision de documents. Cartographiez ces flux de travail avant de les automatiser. Pour mesurer le succès au fil du temps, suivez quatre indicateurs critiques : les tâches exécutées, les heures économisées, les taux de précision et le coût par tâche.

La bonne orchestration de l'IA peut améliorer considérablement l'efficacité. Que vous optiez pour une solution d'entreprise dotée de contrôles d'accès robustes ou pour une plateforme rationalisée pour des gains rapides, l'objectif ultime est de minimiser les efforts manuels tout en maintenant des normes élevées. Testez les plateformes avec des pilotes à petite échelle, évaluez leurs performances et développez ce qui donne des résultats.

Les solutions de flux de travail basées sur l'IA sont conçues pour s'intégrer facilement aux outils et processus que les entreprises utilisent déjà. En reliant les fonctionnalités d'IA, telles que l'automatisation des tâches et l'analyse des données, directement aux flux de travail existants, ces solutions éliminent le besoin d'efforts de codage majeurs ou de refonte de l'infrastructure. Les plateformes d'automatisation font souvent office de passerelle, rendant l'intégration simple et efficace.

L'intégration de l'IA dans les systèmes actuels permet aux entreprises de rationaliser les tâches répétitives, de prendre des décisions plus intelligentes et d'améliorer la productivité globale. Ces solutions sont conçues pour fonctionner au sein de votre infrastructure existante tout en donnant la priorité à la sécurité et à la conformité, garantissant ainsi une transition fluide vers des opérations pilotées par l'IA.

Lorsque vous choisissez une plateforme de flux de travail basée sur l'IA, plusieurs facteurs doivent guider votre décision afin de vous assurer qu'elle correspond aux objectifs de votre organisation. Commencez par évaluer intégration et compatibilité - la plateforme devrait fonctionner sans effort avec les outils et les systèmes sur lesquels vous comptez déjà. Cela garantit une transition en douceur et minimise les interruptions.

Ensuite, évaluez la plateforme évolutivité et adaptabilité. Il doit être capable de se développer parallèlement à votre entreprise et de s'adapter à l'évolution des flux de travail au fil du temps. Il est tout aussi important de savoir comment convivial la plateforme l'est. Une interface simple peut permettre aux membres de l'équipe non techniques d'automatiser les processus sans avoir besoin d'un support informatique important, ce qui permet d'économiser du temps et des ressources.

Ne négligez pas sécurité et conformité, en particulier si votre organisation gère des données sensibles dans des secteurs tels que la santé ou la finance. La plateforme doit protéger vos informations et répondre à toutes les exigences réglementaires. Enfin, concentrez-vous sur les plateformes qui ont déjà produit des résultats mesurables, tels que l'amélioration de l'efficacité ou la réduction des coûts, afin de garantir un solide retour sur investissement.

Les plateformes de flux de travail basées sur l'IA transforment le mode de fonctionnement des entreprises en rationalisant les tâches et en réduisant les dépenses. En automatisant les processus de routine et en simplifiant les systèmes complexes, ces outils réduisent la nécessité d'une supervision humaine constante, ce qui permet de minimiser les erreurs et de gagner un temps précieux. Des tâches telles que le support informatique ou la gestion des données, par exemple, peuvent être gérées plus efficacement, ce qui permet aux équipes de se concentrer sur des projets stratégiques à fort impact.

Ces solutions offrent également la flexibilité nécessaire pour s'adapter à l'ensemble de l'organisation, répondant ainsi facilement à l'évolution des demandes commerciales. Cette adaptabilité permet non seulement d'améliorer l'efficacité opérationnelle, mais également de réduire les coûts de main-d'œuvre et d'améliorer la précision. Prenons l'exemple du service client : l'automatisation peut accélérer les temps de réponse et améliorer l'expérience utilisateur, tout en maîtrisant les coûts opérationnels. En intégrant l'IA dans les flux de travail quotidiens, les entreprises peuvent travailler de manière plus intelligente, innover plus rapidement et réaliser des économies substantielles.