La gestión rápida de la IA ya no es opcional para las empresas. Ya sea que esté escalando los flujos de trabajo de la IA, controlando los costos o garantizando el cumplimiento, es esencial contar con las herramientas adecuadas para probar y versionar las solicitudes. Las solicitudes mal administradas pueden provocar un rendimiento incoherente y un aumento vertiginoso de los gastos. En esta guía se destacan siete plataformas que simplifican las pruebas rápidas, el control de versiones y la gobernanza, lo que ayuda a las empresas estadounidenses a lograr operaciones de IA fiables, eficientes y conformes con las normas.

Exploremos cómo estas plataformas pueden transformar sus flujos de trabajo de IA.

Al seleccionar una plataforma para realizar pruebas y versiones con rapidez, es fundamental evaluar tanto las capacidades técnicas como la adecuación operativa. El objetivo no es solo encontrar una herramienta con muchas funciones, sino una que se integre sin problemas con los sistemas existentes y, al mismo tiempo, satisfaga las exigencias de las operaciones comerciales de EE. UU.

Compatibilidad de modelos es un factor clave. La plataforma debe ser compatible con varios proveedores de modelos lingüísticos de gran tamaño, lo que te permitirá probar las indicaciones en diferentes modelos sin tener que volver a escribir el código. Los sistemas que permiten comparar paralelamente el mismo indicador entre modelos pueden ahorrar un valioso tiempo de desarrollo y ayudar a identificar el modelo que ofrece los mejores resultados para su caso de uso específico.

Capacidades de control de versiones son indispensables para gestionar iteraciones rápidas. Una plataforma sólida mantiene un historial detallado de los cambios, incluido quién realizó las actualizaciones, cuándo se produjeron (DD/MM/AAAA) y los motivos que los motivaron. Esta funcionalidad no solo ayuda a volver a las versiones anteriores, sino que también proporciona la documentación que a menudo se requiere para las revisiones de cumplimiento.

Metodologías de prueba diferencian las plataformas avanzadas. Funciones como las pruebas A/B te permiten comparar varias versiones rápidas con consultas de usuarios reales o conjuntos de datos de referencia. Las pruebas de regresión automatizadas garantizan que las nuevas iteraciones se evalúen comparándolas con los casos de prueba históricos, mientras que los flujos de trabajo de revisión humana ayudan a abordar los casos extremos o el contenido confidencial antes de la implementación.

Seguimiento de costos y administración de tokens son cruciales para la gestión de los presupuestos. La plataforma debería monitorear el uso de los tokens, mostrar los costos en USD y permitirle establecer límites de gasto. Las alertas cuando se aproximan los umbrales presupuestarios ayudan a evitar gastos inesperados e identificar las señales que hacen que se consuman cantidades excesivas de fichas.

Funciones de cumplimiento y seguridad no son negociables para las empresas estadounidenses, especialmente en las industrias reguladas. Como Alfabín observado en 2025, las pruebas centradas en el cumplimiento (que abarcan los estándares SOC 2, GDPR e HIPAA) se han vuelto esenciales en sectores como la tecnología financiera, la atención médica y el SaaS, donde los resultados de IA inseguros o sesgados pueden provocar graves daños financieros y de reputación. Una plataforma sólida debe ofrecer controles de acceso, registros de auditoría detallados y documentación para cumplir con las necesidades normativas. Por ejemplo, AlfabínEl estudio de caso sobre las solicitudes de asistencia sanitaria que cumplen con el RGPD ilustra cómo las pruebas rápidas pueden garantizar el cumplimiento legal y proporcionar pruebas auditables.

Capacidades de integración determine qué tan bien se ajusta la plataforma a su oferta tecnológica. Busque opciones que proporcionen API REST, SDK en lenguajes de programación comunes y webhooks para activar acciones en función de los resultados de las pruebas. La capacidad de exportar datos en formatos estándar e integrarlos con las canalizaciones de CI/CD puede hacer que las pruebas rápidas sean una parte integral del proceso de implementación.

Análisis de rendimiento debería ir más allá de las tasas de éxito básicas y ofrecer información como la latencia, la eficiencia de los tokens, las puntuaciones de similitud semántica y las calificaciones de satisfacción de los usuarios. La capacidad de filtrar los resultados por fecha, tipo de modelo o versión inmediata, combinada con los informes exportables, garantiza que pueda comunicar las métricas de rendimiento de manera eficaz a las partes interesadas, tanto técnicas como no técnicas.

Herramientas de colaboración son esenciales para los equipos que trabajan en la ingeniería rápida. Funciones como los comentarios, las solicitudes de cambio y los flujos de trabajo de aprobación reducen los conflictos y garantizan una revisión adecuada antes de la implementación. La compatibilidad con entornos de desarrollo, puesta en escena y producción independientes permite a los equipos experimentar sin poner en riesgo los sistemas en funcionamiento.

Para las empresas de EE. UU., detalles de localización asunto. Los informes y los paneles deben ajustarse a las convenciones habituales, como el uso de un formato de 12 horas con AM/PM, las comas como separadores de mil (por ejemplo, 1000) y el formato de moneda con el formato X, XXX.XX $.

Prompts.ai es una plataforma versátil diseñada para probar, versionar e implementar indicaciones en más de 35 modelos líderes, incluidos GPT-5, Claudio, Llama, y Géminis - todo dentro de un panel de control seguro y unificado. Al reunir las herramientas esenciales en un solo lugar, agiliza los flujos de trabajo de la IA y aborda desafíos comunes como la confiabilidad, la gestión de costos y el cumplimiento.

Prompts.ai aborda los problemas de interoperabilidad al permitir realizar pruebas simultáneas en varios modelos a través de una única interfaz. En lugar de combinar varias plataformas de proveedores con API, sistemas de facturación e interfaces independientes, los usuarios obtienen un acceso centralizado a todos los modelos en un solo panel.

Una característica destacada es la capacidad de comparar las salidas una al lado de la otra. Por ejemplo, puede probar el mismo indicador en GPT-5, Claude y LLama simultáneamente, lo que facilita la determinación de qué modelo ofrece los resultados más precisos, relevantes o rentables para sus necesidades. Esto elimina la molestia de copiar manualmente las solicitudes de una plataforma a otra, hacer un seguimiento de los resultados en hojas de cálculo o escribir código personalizado para las pruebas con varios modelos.

Más allá de la generación de texto, la plataforma también admite herramientas para crear imágenes y animaciones. Esta flexibilidad es especialmente útil para los equipos que trabajan en proyectos que requieren tanto contenido escrito como elementos visuales, como las campañas de marketing que combinan el texto de los anuncios con los gráficos.

Los flujos de trabajo interoperables están integrados en todos los planes empresariales. Los usuarios pueden crear secuencias que prueben automáticamente las indicaciones en varios modelos, recopilen datos de rendimiento y registren los resultados, todo ello sin esfuerzo manual.

Prompts.ai trata las solicitudes como si fueran código y aplica los principios de desarrollo de software para administrarlas de manera eficaz. Cada cambio crea una nueva versión con un registro de auditoría completo, en el que se documenta quién hizo el cambio, cuándo se produjo (MM/DD/AAAA) y qué se modificó. Esto es particularmente valioso para los equipos de cumplimiento, que necesitan rastrear los resultados de la IA hasta las versiones rápidas específicas.

La plataforma conserva un historial completo de iteraciones rápidas, lo que permite a los equipos volver fácilmente a versiones anteriores si los nuevos cambios provocan problemas inesperados. También recoge el razonamiento que subyace a las modificaciones, lo que ayuda a los equipos a entender no solo qué se modificó, sino también por qué. Este nivel de documentación es especialmente útil a la hora de incorporar a nuevos miembros del equipo o analizar el desempeño en diferentes departamentos.

Se mantienen historiales de versiones separados para los entornos de desarrollo, preparación y producción, lo que garantiza un flujo de trabajo claro y organizado.

Probar las indicaciones a escala requiere más que unas pocas comprobaciones manuales, y Prompts.ai ofrece herramientas de evaluación estructuradas que generan métricas mensurables. Estas herramientas permiten a los usuarios comparar objetivamente el rendimiento rápido y hacer un seguimiento de las mejoras a lo largo del tiempo.

La plataforma admite pruebas automatizadas con conjuntos de datos de referencia, lo que permite evaluar las indicaciones en cientos o miles de casos de prueba. Esto es particularmente útil para las pruebas de regresión, donde puedes asegurarte de que las actualizaciones destinadas a mejorar un área no afecten negativamente a otra. Los conjuntos de pruebas se pueden ejecutar automáticamente cada vez que se actualiza una solicitud, lo que permite detectar cualquier cambio significativo en la precisión, la relevancia u otras métricas clave antes de la implementación.

Las métricas de rendimiento van más allá de los resultados aprobados o rechazados. La plataforma registra detalles como la latencia (el tiempo de respuesta de cada modelo), la eficiencia de los tokens (número de tokens utilizados por consulta) y las puntuaciones de similitud semántica (el grado de alineación de los resultados con los resultados esperados).

Para las solicitudes que requieren el juicio humano, como las que generan contenido orientado al cliente o tratan temas delicados, la plataforma incluye flujos de trabajo para la revisión humana. Los casos de prueba específicos se pueden enviar a los revisores para que les den su opinión, combinando información cualitativa con métricas automatizadas.

Estas métricas de prueba se integran perfectamente con las herramientas más amplias de la plataforma, lo que garantiza un flujo de trabajo coherente.

Prompts.ai se integra con las herramientas en las que ya confían los equipos de ingeniería de EE. UU. y utiliza las API y los SDK de REST para conectarse con las canalizaciones de CI/CD. Esto convierte a las pruebas rápidas en una parte estándar del proceso de implementación.

El seguimiento de costos está integrado en la plataforma a través de su capa FinOps, que monitorea el uso de los tokens en tiempo real y muestra los costos en USD. Los usuarios pueden establecer límites de gasto a nivel de equipo, proyecto o solicitud individual, con alertas para evitar gastos excesivos. Al eliminar las herramientas redundantes y optimizar la selección de modelos en función de los datos de rendimiento y costes, las empresas pueden reducir los gastos de IA hasta en un 98%.

Para la colaboración, la plataforma ofrece funciones como comentarios, solicitudes de cambio y flujos de trabajo de aprobación, que reflejan los procesos de revisión de código conocidos. Un ingeniero rápido puede proponer actualizaciones, etiquetar a las partes interesadas para que las revisen y obtener la aprobación de un gerente de producto o un oficial de cumplimiento antes de implementar los cambios.

El sistema de créditos TOKN Pay-As-You-Go de la plataforma alinea los costos con el uso real, evitando suscripciones mensuales fijas. Los precios comienzan en 99$ por miembro y mes para el nivel Core, 119$ para el Pro y 129$ para el Elite, todos los cuales incluyen flujos de trabajo interoperables y acceso a la biblioteca completa de modelos.

Para ayudar a los equipos a empezar, Prompts.ai proporciona formación empresarial y asistencia para la incorporación. Esto incluye sesiones prácticas y un programa rápido de certificación de ingeniería, que dota a las organizaciones de expertos internos que pueden impulsar la adopción y las mejores prácticas.

Para las empresas preocupadas por la seguridad de los datos, la plataforma ofrece controles de gobierno de nivel empresarial y pistas de auditoría detalladas, lo que garantiza que los datos confidenciales permanezcan protegidos. Estas funciones son especialmente importantes para sectores como el sanitario y el financiero, en los que el cumplimiento no es negociable.

PromptLayer sirve como una herramienta de registro y observabilidad que registra cada interacción entre los modelos de aplicación y lenguaje. Al integrar PromptLayer, los equipos de desarrollo pueden registrar automáticamente las indicaciones, las respuestas y los metadatos para su posterior análisis. Esto permite a los equipos supervisar el rendimiento de las solicitudes en entornos reales y determinar las áreas en las que se pueden mejorar.

PromptLayer proporciona un registro en el que los equipos pueden almacenar y administrar varias versiones de sus indicaciones. A cada mensaje se le asigna un identificador único, lo que facilita la referencia a versiones específicas sin incrustarlas directamente en el código. Esta separación permite actualizar las solicitudes sin tener que volver a implementar la aplicación.

La plataforma mantiene un historial detallado de los cambios, rastreando quién modificó un mensaje y cuándo. Los equipos pueden comparar las versiones una al lado de la otra para ver cómo afectan las actualizaciones a la calidad de los resultados. Si una nueva versión presenta problemas, volver a una versión anterior es tan sencillo como actualizar la referencia de la aplicación.

El control de versiones también se aplica a las plantillas de mensajes con variables. Por ejemplo, un mensaje de atención al cliente puede incluir marcadores de posición para el nombre del cliente, el tipo de problema o el historial de conversaciones. PromptLayer almacena estas plantillas y realiza un seguimiento de los cambios, lo que garantiza la coherencia y permite una experimentación controlada.

PromptLayer ofrece herramientas para evaluar el rendimiento inmediato mediante métricas automatizadas y comentarios humanos. Las solicitudes registradas de producción se pueden etiquetar para su revisión, creando un conjunto de datos de ejemplos del mundo real. Estos ejemplos ayudan a refinar las solicitudes en función de los patrones de uso reales.

La plataforma admite pruebas A/B, lo que permite a los equipos ejecutar varias versiones rápidas simultáneamente y comparar los resultados. Por ejemplo, puede comprobar si las instrucciones detalladas producen mejores resultados que las más sencillas. PromptLayer hace un seguimiento de métricas como el tiempo de respuesta y el uso de los tokens, lo que te ayuda a equilibrar la calidad con la rentabilidad.

Para las pruebas estructuradas, PromptLayer se integra con marcos que permiten definir los comportamientos esperados y las indicaciones de prueba en casos específicos. Esto es especialmente útil para las pruebas de regresión, ya que garantiza que las actualizaciones no interrumpan la funcionalidad existente. El seguimiento de los costos se muestra en USD, lo que facilita la comprensión del impacto financiero de las diferentes estrategias rápidas.

Estas herramientas de prueba se integran perfectamente con su proceso de desarrollo, lo que permite una colaboración fluida entre los equipos.

PromptLayer simplifica la integración con sus flujos de trabajo existentes. Sus SDK de Python y JavaScript empaquetan las llamadas de API estándar a los modelos de lenguaje, por lo que solo se necesitan unas pocas líneas de código para empezar. Esta configuración ligera permite a los equipos empezar a registrar las interacciones sin tener que revisar sus aplicaciones.

La plataforma se integra con herramientas de desarrollo populares y canales de CI/CD, lo que convierte las pruebas rápidas en una parte natural del proceso de implementación. Los flujos de trabajo automatizados pueden probar nuevas versiones rápidas comparándolas con datos históricos antes de lanzarlas a la producción.

Para la colaboración, la interfaz web permite a los miembros del equipo revisar, comentar y compartir las interacciones registradas a través de enlaces rápidos. Las opciones avanzadas de filtrado (por fecha, tipo de modelo, versión inmediata o etiquetas personalizadas) facilitan la identificación de patrones. Los gerentes de producto pueden revisar las interacciones reales de los usuarios sin necesidad de acceder directamente a las bases de datos, mientras que los ingenieros pueden compartir casos específicos para solucionar problemas o iterarlos.

Esta funcionalidad es particularmente útil para analizar casos extremos o comprender cómo funcionan las solicitudes en los diferentes grupos de usuarios.

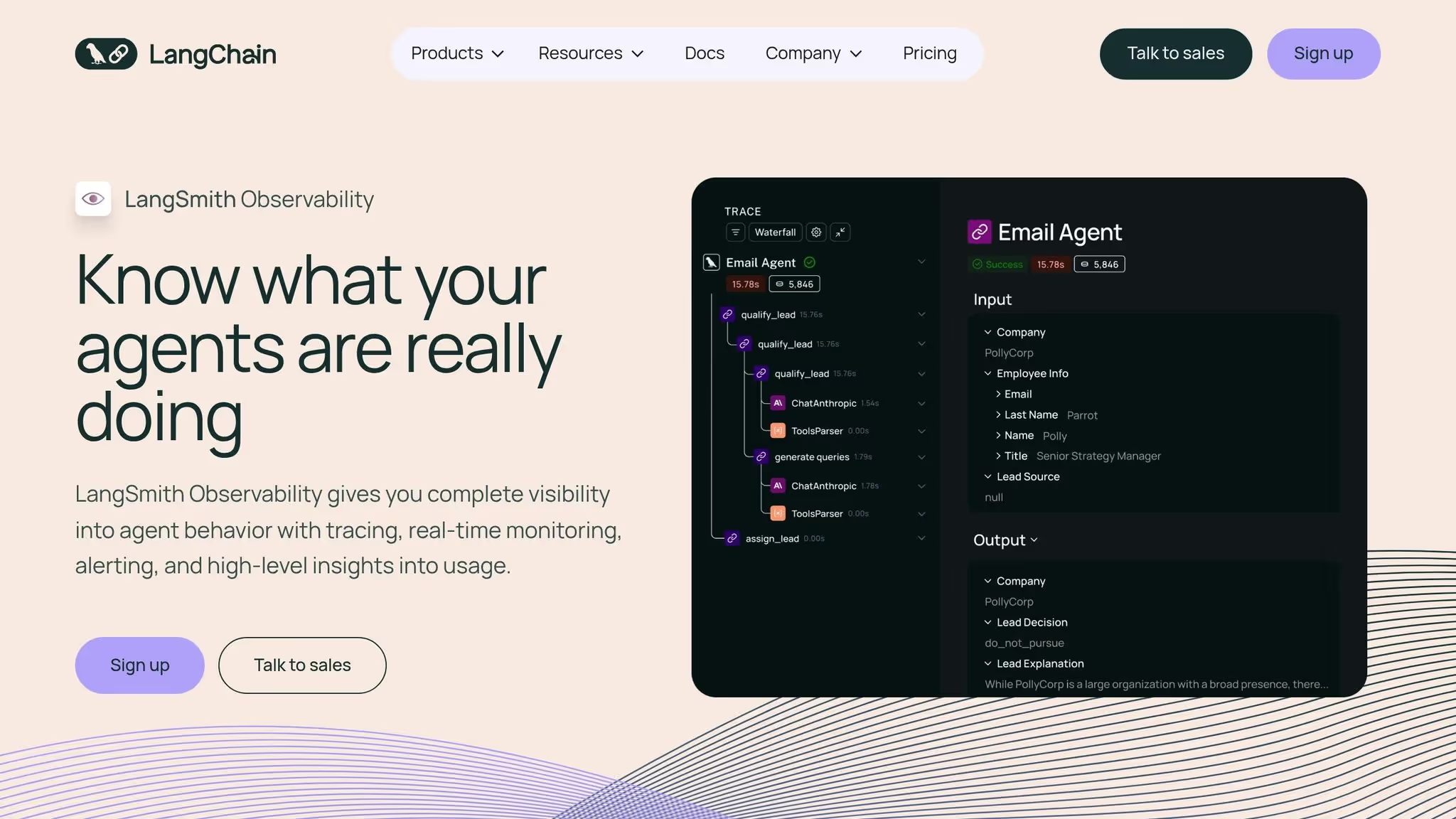

LangSmith es una plataforma de observabilidad diseñada sobre Cadena LANG, que ofrece herramientas integradas para el control rápido de versiones, rastreo y depuración. Gracias a su perfecta integración, Cadena LANG los usuarios pueden acceder al seguimiento de versiones nada más sacarlo de la caja, lo que elimina la necesidad de una configuración adicional. Esto crea una base simplificada para una interoperabilidad eficaz de los modelos.

LangSmith funciona sin esfuerzo dentro del ecosistema de LangChain, lo que permite la carga rápida y directa desde LangSmith Hub al código de LangChain con sincronización automática de versiones. Esto elimina los problemas de configuración para los equipos que ya utilizan LangChain. Sin embargo, los equipos trabajan con marcos alternativos como Índice Llama o Núcleo semántico tendrá que crear integraciones personalizadas para beneficiarse de las capacidades de seguimiento de versiones de LangSmith.

LangSmith simplifica la administración inmediata mediante el seguimiento automático de los cambios y la vinculación de cada versión a los registros de ejecución como parte de su funcionalidad de seguimiento. A través del Prompt Hub, los equipos pueden explorar, bifurcar y reutilizar las solicitudes de la comunidad sin dejar de mantener un historial de versiones completo. Si bien la plataforma prioriza la observabilidad, se hace menos hincapié en funciones como las comparaciones paralelas y los registros de cambios detallados.

LangSmith combina el control rápido de versiones con un marco de evaluación que gestiona los conjuntos de datos y visualiza los resultados. No solo rastrea los resultados finales, sino también los pasos intermedios, lo que ayuda a los equipos a identificar y abordar los problemas relacionados con las solicitudes, las entradas o el comportamiento de los modelos. La plataforma ofrece un nivel gratuito que permite realizar hasta 5000 rastreos al mes, mientras que el plan para desarrolladores cuesta 39 dólares al mes por 50 000 rastreos. Hay opciones de precios personalizadas para los planes Team o Enterprise. Tenga en cuenta que las implementaciones por etapas requieren una configuración manual.

Para los usuarios de LangChain, LangSmith proporciona una integración perfecta con la sincronización automática de las indicaciones y el seguimiento de versiones. La colaboración se apoya mediante funciones como las colas de anotación y los conjuntos de datos compartidos a través del Prompt Hub, lo que facilita la detección y la reutilización rápidas. Sin embargo, la edición colaborativa en tiempo real y las comparaciones detalladas de versiones son limitadas, y los equipos que utilizan marcos ajenos a LangChain deben implementar sus propias integraciones.

PromptFlow de Azure OpenAI es una herramienta empresarial dedicada dentro de Azure, diseñada para simplificar y optimizar los flujos de trabajo de IA impulsados por indicaciones. Si bien la información pública sobre funciones como el control rápido de versiones y las pruebas es algo escasa, es evidente que la plataforma está diseñada para los equipos que ya trabajan en Microsoft Azure ecosistema. Para obtener un desglose completo de sus capacidades, consulte la documentación oficial de Microsoft. PromptFlow refleja el creciente movimiento hacia la integración de herramientas de administración rápida en las infraestructuras de nube existentes, alineándolas perfectamente con las soluciones más detalladas que se analizarán más adelante.

Weights & Biases ha ampliado su conocida plataforma de seguimiento de experimentos de aprendizaje automático al ámbito de los grandes modelos lingüísticos (LLM) con Indicaciones de W&B. Esta nueva función se basa en sus herramientas establecidas para el control de versiones y la colaboración, que ahora están diseñadas para respaldar los flujos de trabajo para la ingeniería y las pruebas rápidas. Para los equipos que ya trabajan en el ecosistema de W&B, esta incorporación parece una evolución natural, ya que se integra perfectamente con sus procesos actuales de desarrollo de aprendizaje automático tradicional.

En esencia, la plataforma sobresale en seguimiento unificado del flujo de trabajo. Con W&B Prompts, puede gestionar las versiones rápidas junto con las versiones de los modelos, las ejecuciones de entrenamiento, los hiperparámetros y las métricas de evaluación, todo ello desde una única interfaz. Esta completa configuración resulta especialmente útil a la hora de solucionar problemas complejos derivados de la interacción entre las indicaciones, las configuraciones de los modelos y la calidad de los datos. Al igual que otras plataformas de primer nivel, W&B Prompts reúne el control de versiones, la evaluación y la colaboración en un sistema coherente para gestionar las solicitudes.

W&B Prompts es compatible con una variedad de proveedores de LLM, lo que garantiza la flexibilidad sin tener que depender de un solo proveedor. Su sistema de seguimiento de artefactos va más allá de simplemente guardar el texto del mensaje: captura metadatos como los hiperparámetros, las selecciones de modelos y los resultados relacionados, y ofrece un registro exhaustivo de cada experimento.

El sistema de control de versiones de W&B Prompts refleja el enfoque comprobado de la plataforma para el seguimiento de experimentos. Cada iteración de un mensaje se registra con metadatos detallados e información contextual. Si bien este enfoque proporciona capacidades de seguimiento sólidas, conlleva una curva de aprendizaje. Los usuarios que no estén familiarizados con términos específicos de W&B, como «ejecutar», «artefactos» y «barrer», pueden considerar que el sistema es menos intuitivo en comparación con las plataformas diseñadas exclusivamente para una administración rápida.

Las pruebas y la evaluación se integran perfectamente en el espacio de trabajo. W&B Prompts le permite comparar el rendimiento rápido entre las distintas versiones, analizar los resultados en paralelo y supervisar las métricas clave. El sistema de seguimiento de artefactos guarda no solo los resultados, sino también el contexto completo de cada prueba, lo que garantiza la reproducibilidad de los experimentos y la comprensión clara de los cambios.

La colaboración es uno de los principales objetivos de W&B Prompts. Los espacios de trabajo compartidos permiten a los miembros del equipo colaborar en proyectos, dejar comentarios sobre versiones específicas de Prompt y crear informes que resuman los hallazgos experimentales. Creadas originalmente para la investigación sobre aprendizaje automático, estas herramientas se traducen eficazmente en flujos de trabajo de LLM, lo que agiliza el trabajo en equipo.

Dicho esto, hay una curva de aprendizaje. Los usuarios nuevos en los conceptos de seguimiento de experimentos de W&B pueden necesitar algo de tiempo para ponerse al día. Además, los flujos de trabajo específicos de la ingeniería rápida (como la implementación basada en entornos, las pruebas en entornos y la colaboración entre los gerentes de producto y los ingenieros) están menos desarrollados que los de las plataformas diseñadas exclusivamente para la administración rápida.

En cuanto a los precios, W&B Prompts ofrece un nivel gratuito para individuos y equipos pequeños, lo que lo hace accesible para las pruebas iniciales. Los planes para equipos comienzan en 200 dólares al mes para un máximo de cinco puestos, con precios empresariales personalizados disponibles para las organizaciones más grandes. Para los equipos que combinan los flujos de trabajo tradicionales de aprendizaje automático con los de LLM, esta estructura de precios ofrece una forma eficaz de consolidar las herramientas en una única plataforma.

La herramienta Eval de OpenAI está diseñada para ayudar a los desarrolladores a evaluar la eficacia de las indicaciones. Si bien desempeña un papel dentro del ecosistema de OpenAI, la información sobre sus características específicas, métodos de prueba y opciones de integración es escasa. Para una comprensión más profunda y una visión más profunda de cómo se adapta a los flujos de trabajo prácticos, consulta la documentación oficial de OpenAI.

LLM Prompt Studio de Hugging Face forma parte del conocido ecosistema Hugging Face, famoso por su extensa biblioteca de modelos de código abierto y su vibrante comunidad colaborativa. Sin embargo, la información disponible públicamente sobre las funciones específicas del estudio, como las herramientas de prueba, control de versiones y colaboración, sigue siendo limitada.

Aunque las descripciones detalladas de las funciones de LLM Prompt Studio son escasas, el ecosistema más amplio de Hugging Face brinda acceso a una amplia gama de modelos de código abierto a través del Hugging Face Hub. Este acceso permite a los usuarios experimentar con una variedad de arquitecturas de modelos, lo que lo convierte en un recurso valioso para quienes buscan flexibilidad en las pruebas y el desarrollo. Para obtener la información más actualizada, los usuarios deben consultar la documentación oficial de Hugging Face. Estas capacidades se relacionan con el enfoque general de la plataforma en la interoperabilidad y la evaluación de modelos.

Si bien el estudio se basa en el acceso modelo de Hugging Face, las herramientas de evaluación específicas de LLM Prompt Studio no están bien documentadas. Los usuarios suelen confiar en las herramientas generales y los puntos de referencia proporcionados por la comunidad para realizar pruebas. Se recomienda consultar la documentación más reciente de Hugging Face para mantenerse informado sobre cualquier actualización o mejora en esta área.

Hugging Face es ampliamente reconocida por su sólida comunidad y su eficiente infraestructura para compartir modelos. Sin embargo, los detalles sobre las funciones específicas de integración y colaboración de LLM Prompt Studio no están disponibles con facilidad. Los equipos interesados en aprovechar estas herramientas deben explorar los recursos más recientes de Hugging Face para comprender mejor las capacidades y ofertas actuales.

A la hora de decidir cuál es la plataforma adecuada, es fundamental centrarse en los aspectos que influyen directamente en el flujo de trabajo y los costes. A continuación, te explicamos cómo desglosarlo:

Compatibilidad de modelos

El primer paso es confirmar que la plataforma es compatible con los modelos que ya utilizas. Debe integrarse sin problemas en su flujo de trabajo actual sin requerir ajustes significativos. Además, tenga en cuenta la forma en que la plataforma gestiona la supervisión de la producción y gestiona los cambios en las solicitudes.

Supervisión y gobierno de la producción

En el caso de las plataformas destinadas al uso en producción, priorice funciones como el seguimiento en tiempo real y las herramientas para gestionar la gobernanza. Las sólidas capacidades de gobierno, como el control de versiones, la ramificación y los permisos de acceso, son fundamentales para ampliar sus operaciones de manera eficiente.

Transparencia de costos

Comprender la estructura de costos es crucial. Los precios de los modelos de IA suelen depender de la cantidad de fichas procesadas, con tasas en USD por millón de fichas tanto para la entrada como para la salida. Algunas plataformas también pueden cobrar por los datos en caché, el almacenamiento u otros servicios. Ten en cuenta que los modelos más avanzados suelen tener tarifas por token más altas. Comparar los costos con el rendimiento y la confiabilidad es esencial para encontrar el equilibrio adecuado para sus necesidades de producción.

Cómo organizar su evaluación

Para simplificar la comparación, considera la posibilidad de crear una tabla en la que se destaquen las características principales:

Tenga cuidado con los costos ocultos. Algunas plataformas pueden cobrar por separado las llamadas a la API, los recursos informáticos, el almacenamiento o el soporte premium, mientras que otras ofrecen precios combinados. Para obtener una estimación realista de los costos, calcula el uso mensual esperado de los tokens, aplica la tarifa por token e incluye cualquier tarifa fija.

Consideraciones sobre las pruebas y el equipo

Aproveche las pruebas gratuitas o los entornos sandbox para probar las funciones y asegurarse de que se alinean con las habilidades técnicas de su equipo. Las plataformas que requieren una configuración compleja pueden reducir la flexibilidad de tu equipo. Elige una plataforma en función de la experiencia de tu equipo: aquellas con opciones avanzadas de acceso a la API y de personalización son ideales para los ingenieros de aprendizaje automático con experiencia, mientras que una interfaz fácil de usar con visualizaciones claras puede resultar mejor cuando se trata de partes interesadas sin conocimientos técnicos.

Tras evaluar y comparar las principales plataformas, queda claro que elegir la solución de control de versiones y pruebas rápidas adecuada es más que una decisión técnica: es un movimiento estratégico que puede mejorar sus operaciones de IA. Para los equipos que implementan modelos lingüísticos de gran tamaño a escala, las herramientas adecuadas pueden transformar la experimentación desorganizada en un progreso estructurado y mensurable.

Al centralizar la gestión rápida, la productividad mejora significativamente. La optimización del control de versiones y las pruebas rápidas minimiza las ineficiencias relacionadas con las herramientas, acorta los ciclos de desarrollo y reduce la carga mental de los equipos.

La gobernanza se vuelve mucho más sencilla con funciones como el control de versiones y registros de auditoría detallados. Estas capacidades garantizan el cumplimiento de los estándares del sector y evitan que los cambios no autorizados interrumpan los sistemas de producción.

A medida que la adopción de la IA se expande en todos los departamentos, la administración de costos se vuelve crítica. La optimización de las indicaciones ayuda a reducir el desperdicio de fichas, a mantener los costos bajo control y a evitar que las ineficiencias se conviertan en gastos significativos con el tiempo.

Al seleccionar una plataforma, priorice una que se adapte a las necesidades de producción y experiencia de su equipo. Aprovecha las pruebas gratuitas para evaluar la experiencia del usuario y medir los costos de los tokens, asegurándote de que la plataforma sea compatible con operaciones de IA escalables y a largo plazo. La alineación con estas prioridades sentará las bases para flujos de trabajo eficientes, que cumplan con las normas y que tengan en cuenta los costes.

Al seleccionar una plataforma para probar y administrar versiones rápidas, es esencial priorizar las funciones que mejoran eficiencia y colaboración en equipo. Esto es lo que debes tener en cuenta:

Al centrarse en estos elementos, puede ajustar sus indicaciones para obtener un mejor rendimiento y mantener resultados consistentes en sus proyectos de IA.

Las plataformas de pruebas rápidas son esenciales para garantizar el cumplimiento de normas como GDPR y HIPAA, gracias a su fuerte enfoque en la seguridad y la gestión de datos. Estas plataformas suelen venir equipadas con funciones como cifrado de datos, controles de acceso, y canales de comunicación seguros, todo ello diseñado para proteger la información confidencial.

Muchas plataformas también incluyen herramientas para desidentificación de datos, registros de auditoría, y presentación de informes, que ayudan a promover la transparencia y la rendición de cuentas. En el caso de los sectores con requisitos reglamentarios estrictos, como la sanidad y las finanzas, algunas plataformas incluso se integran con Sistemas EHR y apoyamos la firma de Acuerdos de asociación comercial (BaaS), lo que los convierte en una opción fiable para gestionar el cumplimiento.

La integración de una plataforma que funcione sin esfuerzo con su tecnología actual puede hacer que la administración de los flujos de trabajo de IA sea mucho más eficiente. Al consolidar tareas como la administración rápida, las pruebas y el control de versiones en un entorno unificado, se elimina la molestia de tener que cambiar de una herramienta a otra. Esto no solo ahorra tiempo, sino que también reduce la probabilidad de errores.

Esta integración fluida también garantiza que sus sistemas funcionen en armonía, lo que permite despliegues más rápidos y una mejor colaboración en equipo. ¿El resultado? Un flujo de trabajo más uniforme y un camino más sencillo para perfeccionar las aplicaciones impulsadas por la inteligencia artificial.

{» @context «:» https://schema.org","@type":"FAQPage","mainEntity":[{"@type":"Question","name":"What ¿debo buscar en una plataforma para probar y administrar las versiones rápidas de manera efectiva?» <strong><strong>, "acceptedAnswer»: {» @type «:"Answer», "text»:» Al seleccionar una plataforma para probar y administrar las versiones rápidas, es fundamental priorizar las funciones que mejoran la eficiencia y la colaboración en equipo.</strong></strong> <p> Esto es lo que debes tener en cuenta:</p> <ul><li><strong>Capacidades de integración</strong>: elige una plataforma que se conecte sin esfuerzo con tus herramientas de implementación y evaluación existentes</li>, garantizando un flujo de trabajo fluido. <li><strong>Administración de versiones</strong>: opte por herramientas que le permitan realizar un seguimiento de los cambios, comparar diferentes versiones y volver fácilmente a las iteraciones anteriores cuando sea necesario.</li> </ul><li><strong>Diseño fácil</strong> de usar: una interfaz sencilla e intuitiva puede reducir significativamente el tiempo dedicado a navegar por la plataforma, lo que aumenta la productividad general.</li> <p>Al centrarse en estos elementos, puede ajustar sus instrucciones para obtener un mejor rendimiento y mantener resultados consistentes en sus proyectos de IA.</p> «}}, {» @type «:"Question», "name» :"¿ Cómo ayudan las plataformas de pruebas rápidas al cumplimiento de normativas como el RGPD y la HIPAA?» <strong>, "acceptedAnswer»: {» @type «:"Answer», "text»:» Las plataformas de pruebas rápidas son esenciales para garantizar el cumplimiento de normativas como el <strong>RGPD</strong> y la HIPAA, ya que se centran principalmente en la seguridad y la gestión de los datos.</strong> <p> Estas plataformas suelen estar equipadas con funciones como el <strong>cifrado de datos</strong>, los <strong>controles de acceso</strong> y los <strong>canales de comunicación seguros, todas ellas diseñadas para proteger la</strong></p> información confidencial. <p>Muchas plataformas también incluyen herramientas para la <strong>desidentificación de los datos</strong>, los registros de <strong>auditoría</strong> y la presentación de <strong>informes</strong>, que ayudan a promover la transparencia y la responsabilidad. En el caso de los sectores con requisitos normativos estrictos, como el sanitario y el financiero, algunas plataformas incluso se integran con <strong>los sistemas de registro electrónico</strong> electrónico y permiten la firma de <strong>acuerdos de asociación comercial (BaaS)</strong>, lo que las convierte en una opción fiable para gestionar</p> el cumplimiento. «}}, {» @type «:"Question», "name» :"¿ Cuáles son las ventajas de utilizar una plataforma que funcione a la perfección con la tecnología actual para los flujos de trabajo de IA?» , "acceptedAnswer»: {» @type «:"Answer», "text»:» La <p>integración de una plataforma que funcione sin esfuerzo con su tecnología actual puede hacer que la gestión de los flujos de trabajo de la IA sea mucho más eficiente. Al consolidar tareas como la administración rápida, las pruebas y el control de versiones en un entorno unificado, se elimina la molestia de tener que cambiar de una herramienta a otra. Esto no solo ahorra tiempo, sino que también reduce la probabilidad de errores</p>. <p>Esta integración fluida también garantiza que sus sistemas funcionen en armonía, lo que permite despliegues más rápidos y una mejor colaboración en equipo. ¿El resultado? Un flujo de trabajo más uniforme y un camino más sencillo para perfeccionar las aplicaciones impulsadas por la inteligencia artificial</p>. «}}]}