La gestion rapide de l'IA n'est plus facultative pour les entreprises. Qu'il s'agisse de faire évoluer les flux de travail d'IA, de contrôler les coûts ou de garantir la conformité, les bons outils pour les tests et les instructions de version sont essentiels. Des instructions mal gérées peuvent entraîner des performances inégales et une hausse des dépenses. Ce guide présente sept plateformes qui simplifient les tests rapides, la gestion des versions et la gouvernance, aidant ainsi les entreprises américaines à réaliser des opérations d'IA fiables, efficaces et conformes.

Explorons comment ces plateformes peuvent transformer vos flux de travail d'IA.

Lors de la sélection d'une plate-forme pour des tests et une gestion des versions rapides, il est essentiel d'évaluer à la fois les capacités techniques et l'adéquation opérationnelle. L'objectif n'est pas simplement de trouver un outil riche en fonctionnalités, mais aussi un outil qui s'intègre parfaitement à vos systèmes existants tout en répondant aux exigences des opérations commerciales américaines.

Compatibilité des modèles est un facteur clé. La plateforme devrait prendre en charge plusieurs grands fournisseurs de modèles linguistiques, ce qui vous permettra de tester les instructions sur différents modèles sans avoir à réécrire le code. Les systèmes qui permettent de comparer côte à côte la même invite entre différents modèles peuvent vous faire gagner un temps de développement précieux et vous aider à identifier le modèle qui fournit les meilleurs résultats pour votre cas d'utilisation spécifique.

Capacités de contrôle de version sont indispensables pour gérer les itérations rapides. Une plate-forme robuste conserve un historique détaillé des modifications, y compris qui a effectué les mises à jour, quand elles se sont produites (MM/JJ/AAAA) et les raisons qui les ont motivées. Cette fonctionnalité permet non seulement de revenir aux versions précédentes, mais fournit également la documentation souvent requise pour les examens de conformité.

Méthodologies de test distinguez les plateformes avancées. Des fonctionnalités telles que les tests A/B vous permettent de comparer plusieurs versions rapides à des requêtes réelles d'utilisateurs ou à des ensembles de données de référence. Les tests de régression automatisés garantissent que les nouvelles itérations sont évaluées par rapport à des cas de test historiques, tandis que les flux de travail d'évaluation humaine aident à résoudre les cas extrêmes ou les contenus sensibles avant le déploiement.

Suivi des coûts et gestion des jetons sont essentiels à la gestion des budgets. La plateforme doit surveiller l'utilisation des jetons, afficher les coûts en dollars américains et vous permettre de définir des limites de dépenses. Les alertes en cas d'approche des seuils budgétaires permettent d'éviter les dépenses imprévues et d'identifier les invites qui consomment trop de jetons.

Caractéristiques de conformité et de sécurité ne sont pas négociables pour les entreprises américaines, en particulier dans les secteurs réglementés. Comme Alphabin Comme indiqué en 2025, les tests axés sur la conformité, couvrant les normes SOC 2, GDPR et HIPAA, sont devenus essentiels dans des secteurs tels que la fintech, la santé et le SaaS, où des résultats d'IA dangereux ou biaisés peuvent entraîner de graves dommages financiers et de réputation. Une plateforme solide doit proposer des contrôles d'accès, des journaux d'audit détaillés et une documentation répondant aux besoins réglementaires. Par exemple, AlphabinL'étude de cas sur les applications de santé conformes au RGPD montre comment des tests rapides peuvent garantir le respect de la législation et fournir des preuves vérifiables.

Capacités d'intégration déterminez dans quelle mesure la plateforme s'intègre à votre infrastructure technologique. Recherchez les options qui fournissent des API REST, des SDK dans les langages de programmation courants et des webhooks pour déclencher des actions en fonction des résultats des tests. La possibilité d'exporter des données dans des formats standard et de les intégrer aux pipelines CI/CD peut faire des tests rapides une partie intégrante de votre processus de déploiement.

Analyse des performances devrait aller au-delà des taux de réussite de base, en offrant des informations telles que la latence, l'efficacité des jetons, les scores de similarité sémantique et les taux de satisfaction des utilisateurs. La possibilité de filtrer les résultats par date, type de modèle ou version rapide, associée à des rapports exportables, vous permet de communiquer efficacement les indicateurs de performance aux parties prenantes techniques et non techniques.

Outils de collaboration sont essentiels pour les équipes qui travaillent sur une ingénierie rapide. Des fonctionnalités telles que les commentaires, les demandes de modification et les flux de travail d'approbation réduisent les conflits et garantissent un examen approprié avant le déploiement. La prise en charge d'environnements de développement, de mise en scène et de production distincts permet aux équipes d'expérimenter sans risquer de mettre en danger les systèmes actifs.

Pour les entreprises américaines, détails de localisation matière. Les rapports et les tableaux de bord doivent être conformes aux conventions habituelles, telles que l'utilisation d'un format sur 12 heures avec AM/PM, des virgules comme séparateurs de milliers (par exemple, 1 000) et une devise au format $X, XXX.XX.

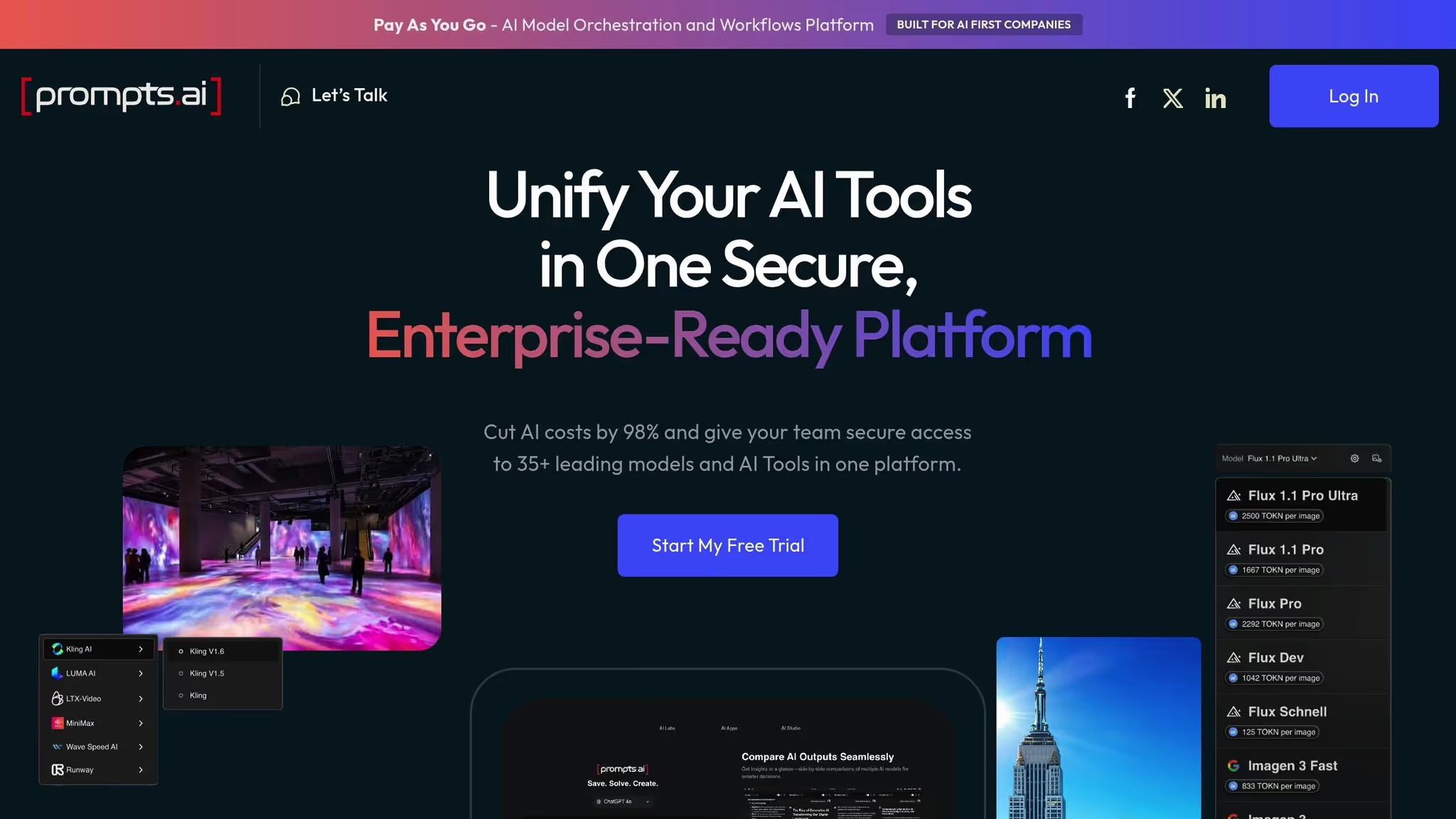

Prompts.ai est une plateforme polyvalente conçue pour tester, modifier et déployer des instructions sur plus de 35 modèles de pointe, notamment GPT-5, Claude, Lama, et Gémeaux - le tout au sein d'un tableau de bord unifié et sécurisé. En regroupant les outils essentiels en un seul endroit, elle rationalise les flux de travail liés à l'IA et permet de relever des défis courants tels que la fiabilité, la gestion des coûts et la conformité.

Prompts.ai résout les problèmes d'interopérabilité en permettant des tests simultanés sur plusieurs modèles via une interface unique. Au lieu de jongler entre différentes plateformes de fournisseurs avec des API, des systèmes de facturation et des interfaces distincts, les utilisateurs bénéficient d'un accès centralisé à tous les modèles sur un seul tableau de bord.

Une caractéristique remarquable est la possibilité de comparer les sorties côte à côte. Par exemple, vous pouvez tester simultanément la même invite sur GPT-5, Claude et LLama, afin de déterminer plus facilement quel modèle fournit les résultats les plus précis, pertinents ou rentables pour vos besoins. Cela élimine les tracas liés à la copie manuelle des instructions entre les plateformes, au suivi des résultats dans des feuilles de calcul ou à la rédaction de code personnalisé pour les tests multimodèles.

Au-delà de la génération de texte, la plateforme prend également en charge des outils de création d'images et d'animations. Cette flexibilité est particulièrement utile pour les équipes qui travaillent sur des projets nécessitant à la fois du contenu écrit et des éléments visuels, tels que les campagnes marketing qui combinent du texte publicitaire avec des graphiques.

Des flux de travail interopérables sont intégrés à chaque plan d'affaires. Les utilisateurs peuvent créer des séquences qui testent automatiquement les instructions sur plusieurs modèles, collectent des données de performance et enregistrent les résultats, le tout sans effort manuel.

Prompts.ai traite les instructions comme du code, en appliquant les principes du développement logiciel pour les gérer efficacement. Chaque modification crée une nouvelle version avec une piste d'audit complète, documentant qui a effectué la modification, quand elle s'est produite (MM/JJ/AAAA) et ce qui a été modifié. Cela est particulièrement utile pour les équipes de conformité qui ont besoin de retracer les sorties de l'IA jusqu'à des versions d'invite spécifiques.

La plateforme conserve un historique complet des itérations rapides, ce qui permet aux équipes de revenir facilement aux versions précédentes si de nouvelles modifications entraînent des problèmes inattendus. Il capture également le raisonnement qui sous-tend les modifications, aidant les équipes à comprendre non seulement ce qui a été modifié, mais aussi pourquoi. Ce niveau de documentation est particulièrement utile lors de l'intégration de nouveaux membres de l'équipe ou de l'analyse des performances de différents services.

Des historiques de versions distincts sont conservés pour les environnements de développement, de préparation et de production, garantissant ainsi un flux de travail clair et organisé.

Les tests à grande échelle nécessitent bien plus que quelques vérifications manuelles, et Prompts.ai propose des outils d'évaluation structurés qui génèrent des mesures mesurables. Ces outils permettent aux utilisateurs de comparer objectivement les performances rapides et de suivre les améliorations au fil du temps.

La plateforme prend en charge les tests automatisés par rapport à des ensembles de données de référence, ce qui permet d'évaluer les invites sur des centaines ou des milliers de cas de test. Cela est particulièrement utile pour les tests de régression, où vous pouvez vous assurer que les mises à jour destinées à améliorer un domaine n'ont pas d'incidence négative sur un autre. Les suites de tests peuvent être exécutées automatiquement chaque fois qu'une invite est mise à jour, signalant tout changement significatif en termes de précision, de pertinence ou d'autres indicateurs clés avant le déploiement.

Les indicateurs de performance vont au-delà des résultats de réussite/échec. La plateforme suit des détails tels que la latence (temps de réponse pour chaque modèle), l'efficacité des jetons (nombre de jetons utilisés par requête) et les scores de similarité sémantique (dans quelle mesure les sorties s'alignent sur les résultats attendus).

Pour les questions nécessitant un jugement humain, telles que celles qui génèrent du contenu destiné aux clients ou traitent de sujets sensibles, la plateforme inclut des flux de travail pour une évaluation humaine. Des cas de test spécifiques peuvent être transmis aux réviseurs pour obtenir des commentaires, en combinant des informations qualitatives avec des mesures automatisées.

Ces indicateurs de test s'intègrent parfaitement aux outils plus larges de la plateforme, garantissant ainsi un flux de travail cohérent.

Prompts.ai s'intègre aux outils sur lesquels les équipes d'ingénierie américaines s'appuient déjà, en utilisant des API REST et des SDK pour se connecter aux pipelines CI/CD. Les tests rapides font donc partie intégrante du processus de déploiement.

Le suivi des coûts est intégré à la plateforme via sa couche FinOps, qui surveille l'utilisation des jetons en temps réel et affiche les coûts en dollars américains. Les utilisateurs peuvent définir des limites de dépenses au niveau de l'équipe, du projet ou de l'invite individuelle, avec des alertes pour éviter les dépenses excessives. En éliminant les outils redondants et en optimisant la sélection des modèles en fonction des données de performance et de coûts, les entreprises peuvent réduire les dépenses liées à l'IA jusqu'à 98 %.

Pour la collaboration, la plateforme propose des fonctionnalités telles que les commentaires, les demandes de modification et les flux de travail d'approbation, reflétant des processus de révision de code familiers. Un ingénieur rapide peut proposer des mises à jour, étiqueter les parties prenantes pour examen et obtenir l'approbation d'un chef de produit ou d'un responsable de la conformité avant la mise en œuvre des modifications.

Le système de crédits TOKN Pay-As-You-Go de la plateforme aligne les coûts sur l'utilisation réelle, évitant ainsi les abonnements mensuels fixes. Les tarifs commencent à 99$ par membre et par mois pour le niveau Core, 119$ pour Pro et 129$ pour Elite, le tout comprenant des flux de travail interopérables et l'accès à la bibliothèque complète de modèles.

Pour aider les équipes à démarrer, Prompts.ai propose une formation aux entreprises et une assistance à l'intégration. Cela comprend des sessions pratiques et un programme de certification Prompt Engineer, fournissant aux organisations des experts internes capables de favoriser l'adoption et les meilleures pratiques.

Pour les entreprises soucieuses de la sécurité des données, la plateforme propose des contrôles de gouvernance de niveau entreprise et des pistes d'audit détaillées, garantissant ainsi la protection des données sensibles. Ces caractéristiques sont particulièrement importantes pour des secteurs tels que la santé et la finance, où la conformité n'est pas négociable.

PromptLayer est un outil de journalisation et d'observabilité qui enregistre chaque interaction entre votre application et les modèles de langage. En intégrant PromptLayer, les équipes de développement peuvent enregistrer automatiquement les invites, les réponses et les métadonnées pour une analyse ultérieure. Cela permet aux équipes de suivre les performances des instructions dans des conditions réelles et d'identifier les domaines à améliorer.

PromptLayer fournit un registre dans lequel les équipes peuvent stocker et gérer plusieurs versions de leurs invites. Un identifiant unique est attribué à chaque invite, ce qui permet de référencer facilement des versions spécifiques sans les intégrer directement dans votre code. Cette séparation vous permet de mettre à jour les instructions sans avoir à redéployer votre application.

La plateforme conserve un historique détaillé des modifications, permettant de savoir qui a modifié une invite et à quel moment. Les équipes peuvent comparer les versions côte à côte pour voir l'impact des mises à jour sur la qualité des résultats. Si une nouvelle version pose des problèmes, revenir à une version antérieure est aussi simple que de mettre à jour la référence dans votre application.

Le contrôle de version s'applique également aux modèles d'invite contenant des variables. Par exemple, une invite d'assistance client peut inclure des espaces réservés pour le nom du client, le type de problème ou l'historique des conversations. PromptLayer stocke ces modèles et suit les modifications, garantissant ainsi la cohérence tout en permettant des expérimentations contrôlées.

PromptLayer propose des outils permettant d'évaluer les performances rapides à l'aide de métriques automatisées et de commentaires humains. Les demandes enregistrées provenant de la production peuvent être balisées pour être examinées, créant ainsi un ensemble de données d'exemples concrets. Ces exemples permettent d'affiner les instructions en fonction des modèles d'utilisation réels.

La plateforme prend en charge les tests A/B, permettant aux équipes d'exécuter plusieurs versions rapides simultanément et de comparer les résultats. Par exemple, vous pouvez tester si des instructions détaillées donnent de meilleurs résultats que des instructions plus simples. PromptLayer suit des indicateurs tels que le temps de réponse et l'utilisation des jetons, vous aidant ainsi à trouver un équilibre entre qualité et rentabilité.

Pour les tests structurés, PromptLayer s'intègre à des frameworks qui vous permettent de définir les comportements attendus et de tester les invites par rapport à des cas spécifiques. Cela est particulièrement utile pour les tests de régression, afin de garantir que les mises à jour ne perturbent pas les fonctionnalités existantes. Le suivi des coûts est affiché en dollars américains, ce qui permet de comprendre facilement l'impact financier des différentes stratégies rapides.

Ces outils de test s'intègrent parfaitement à votre pipeline de développement, ce qui permet une collaboration fluide entre les équipes.

PromptLayer simplifie l'intégration à vos flux de travail existants. Ses SDK Python et JavaScript encapsulent les appels d'API standard aux modèles de langage, ne nécessitant que quelques lignes de code pour démarrer. Cette configuration légère permet aux équipes de commencer à enregistrer les interactions sans avoir à remanier leurs applications.

La plateforme s'intègre aux outils de développement et aux pipelines CI/CD les plus courants, ce qui fait des tests rapides une partie naturelle de votre processus de déploiement. Les flux de travail automatisés peuvent tester les nouvelles versions rapides par rapport aux données historiques avant leur déploiement en production.

À des fins de collaboration, l'interface Web permet aux membres de l'équipe de consulter, de commenter et de partager les interactions enregistrées via des liens rapides. Les options de filtrage avancées (par date, type de modèle, version rapide ou balises personnalisées) facilitent l'identification des modèles. Les chefs de produit peuvent examiner les interactions réelles entre les utilisateurs sans avoir besoin d'accéder directement aux bases de données, tandis que les ingénieurs peuvent partager des cas spécifiques à des fins de dépannage ou d'itération.

Cette fonctionnalité est particulièrement utile pour analyser les cas extrêmes ou comprendre comment les invites fonctionnent dans différents groupes d'utilisateurs.

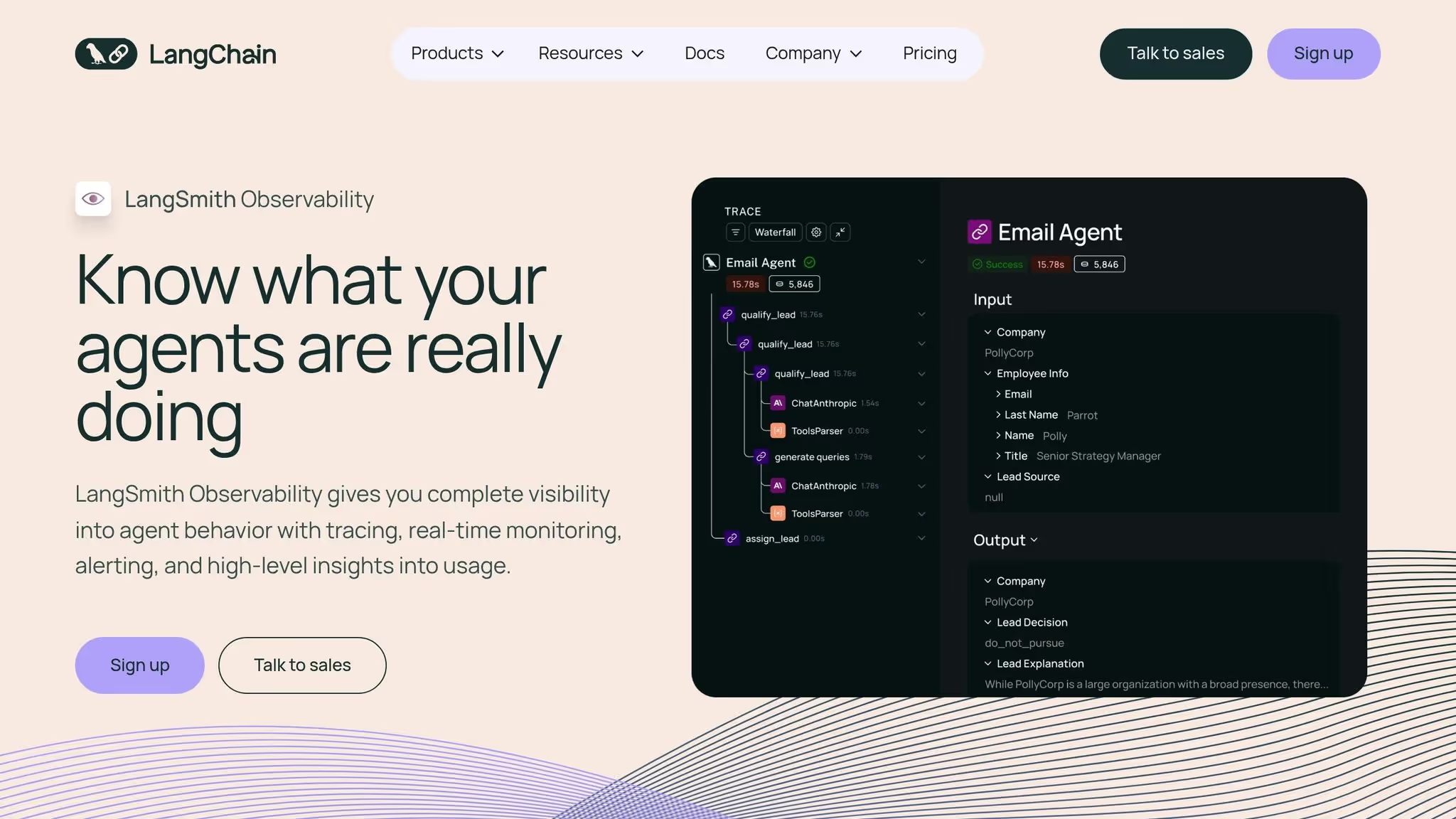

LangSmith est une plateforme d'observabilité conçue sur la base de Chaîne Lang, qui propose des outils intégrés pour une gestion rapide des versions, un traçage et un débogage. Grâce à son intégration parfaite, Chaîne Lang les utilisateurs peuvent accéder au suivi des versions dès la sortie de la boîte, ce qui élimine la nécessité d'une configuration supplémentaire. Cela crée une base rationalisée pour une interopérabilité efficace des modèles.

LangSmith fonctionne sans effort au sein de l'écosystème LangChain, permettant un chargement rapide et direct depuis le hub LangSmith dans le code LangChain avec synchronisation automatique des versions. Cela élimine les problèmes de configuration pour les équipes qui utilisent déjà LangChain. Cependant, les équipes travaillant avec des frameworks alternatifs tels que Indice de lama ou Noyau sémantique devra créer des intégrations personnalisées pour bénéficier des capacités de suivi des versions de LangSmith.

LangSmith simplifie la gestion rapide en suivant automatiquement les modifications et en liant chaque version aux journaux d'exécution dans le cadre de sa fonctionnalité de suivi. Grâce au Prompt Hub, les équipes peuvent explorer, bifurquer et réutiliser les invites de la communauté tout en conservant un historique complet des versions. Bien que la plateforme donne la priorité à l'observabilité, les fonctionnalités telles que les comparaisons côte à côte et les journaux de modifications détaillés sont moins soulignées.

LangSmith associe un contrôle de version rapide à un cadre d'évaluation qui gère les ensembles de données et visualise les résultats. Il retrace non seulement les résultats finaux, mais également les étapes intermédiaires, aidant les équipes à identifier et à résoudre les problèmes liés aux instructions, aux entrées ou aux modèles de comportement. La plateforme propose un niveau gratuit permettant jusqu'à 5 000 traces par mois, tandis que le plan Developer coûte 39$ par mois pour 50 000 traces. Des options de tarification personnalisées sont disponibles pour les forfaits Team ou Enterprise. Notez que les déploiements par étapes nécessitent une configuration manuelle.

Pour les utilisateurs de LangChain, LangSmith offre une intégration transparente avec la synchronisation automatique des invites et le suivi des versions. La collaboration est facilitée par des fonctionnalités telles que les files d'annotations et les ensembles de données partagés via le Prompt Hub, qui facilite la découverte et la réutilisation rapides. Cependant, l'édition collaborative en temps réel et les comparaisons de versions détaillées sont limitées, et les équipes utilisant des frameworks extérieurs à LangChain doivent implémenter leurs propres intégrations.

PromptFlow by Azure OpenAI est un outil d'entreprise dédié au sein d'Azure, conçu pour simplifier et optimiser les flux de travail d'IA pilotés par des invites. Bien que les informations publiques sur des fonctionnalités telles que la gestion rapide des versions et les tests soient assez rares, la plate-forme est clairement adaptée aux équipes opérant déjà au sein du Microsoft Azure écosystème. Pour une description complète de ses fonctionnalités, consultez la documentation officielle de Microsoft. PromptFlow reflète le mouvement croissant vers l'intégration d'outils de gestion rapide dans les infrastructures cloud existantes, en s'alignant parfaitement sur les solutions plus détaillées abordées plus loin.

Weights & Biases a étendu sa célèbre plateforme de suivi des expériences d'apprentissage automatique au domaine des grands modèles de langage (LLM) avec Invitations W&B. Cette nouvelle fonctionnalité s'appuie sur ses outils établis de gestion des versions et de collaboration, désormais conçus pour prendre en charge les flux de travail afin d'accélérer l'ingénierie et les tests. Pour les équipes travaillant déjà au sein de l'écosystème W&B, cet ajout constitue une évolution naturelle, puisqu'il s'intègre parfaitement à leurs processus existants de développement de machine learning traditionnel.

À la base, la plateforme excelle dans suivi unifié des flux de travail. Avec W&B Prompts, vous pouvez gérer les versions des invites ainsi que les versions des modèles, les cycles d'entraînement, les hyperparamètres et les mesures d'évaluation, le tout dans une interface unique. Cette configuration complète est particulièrement utile pour résoudre des problèmes complexes liés à l'interaction entre les instructions, les configurations des modèles et la qualité des données. Tout comme les autres plateformes de premier plan, W&B Prompts réunit la gestion des versions, l'évaluation et la collaboration dans un système cohérent de gestion des invites.

W&B Prompts prend en charge une variété de fournisseurs de LLM, garantissant ainsi la flexibilité sans vous enfermer dans un seul fournisseur. Son système de suivi des artefacts va au-delà de la simple sauvegarde de texte d'invite : il capture des métadonnées telles que les hyperparamètres, les sélections de modèles et les résultats associés, fournissant un enregistrement complet de chaque expérience.

Le système de gestion des versions de W&B Prompts reflète l'approche éprouvée de la plateforme en matière de suivi des expériences. Chaque itération rapide est enregistrée avec des métadonnées détaillées et des informations contextuelles. Bien que cette approche offre de solides capacités de suivi, elle s'accompagne d'une courbe d'apprentissage. Les utilisateurs qui ne connaissent pas les termes spécifiques à W&B tels que « courses », « artefacts » et « balayages » peuvent trouver le système moins intuitif que les plateformes conçues uniquement pour une gestion rapide.

Les tests et les évaluations sont parfaitement intégrés à l'espace de travail. W&B Prompts vous permet de comparer les performances rapides entre les versions, d'analyser les résultats côte à côte et de surveiller les indicateurs clés. Le système de suivi des artefacts enregistre non seulement les résultats, mais également le contexte complet de chaque test, garantissant ainsi la reproductibilité des expériences et la compréhension claire des changements.

La collaboration est au cœur des préoccupations de W&B Prompts. Les espaces de travail partagés permettent aux membres de l'équipe de collaborer sur des projets, de laisser des commentaires sur des versions d'invite spécifiques et de créer des rapports résumant les résultats expérimentaux. Conçus à l'origine pour la recherche sur l'apprentissage automatique, ces outils se traduisent efficacement dans les flux de travail LLM, rationalisant ainsi le travail d'équipe.

Cela dit, il y a une courbe d'apprentissage. Les utilisateurs qui découvrent les concepts de suivi des expériences de W&B peuvent avoir besoin d'un certain temps pour se familiariser. En outre, les flux de travail spécifiques à l'ingénierie rapide, tels que le déploiement basé sur l'environnement, les tests sur le terrain de jeu et la collaboration entre les chefs de produit et les ingénieurs, sont moins développés que les plateformes conçues exclusivement pour une gestion rapide.

En ce qui concerne la tarification, W&B Prompts propose un niveau gratuit pour les individus et les petites équipes, le rendant accessible pour les tests initiaux. Les forfaits d'équipe commencent à 200$ par mois pour un maximum de cinq sièges, avec des tarifs d'entreprise personnalisés disponibles pour les grandes organisations. Pour les équipes qui jonglent à la fois avec les flux de travail traditionnels de ML et de LLM, cette structure tarifaire constitue un moyen efficace de regrouper les outils sur une seule plateforme.

L'outil Eval d'OpenAI est conçu pour aider les développeurs à évaluer l'efficacité des invites. Bien qu'il joue un rôle au sein de l'écosystème OpenAI, les informations sur ses fonctionnalités spécifiques, ses méthodes de test et ses options d'intégration sont rares. Pour mieux comprendre et comprendre comment il s'intègre dans les flux de travail pratiques, consultez la documentation officielle d'OpenAI.

LLM Prompt Studio de Hugging Face fait partie du célèbre écosystème Hugging Face, célèbre pour sa vaste bibliothèque de modèles open source et sa communauté dynamique et collaborative. Cependant, les informations accessibles au public sur les fonctionnalités spécifiques du studio, telles que les tests, la gestion des versions et les outils de collaboration, restent limitées.

Bien que les descriptions détaillées des fonctionnalités du LLM Prompt Studio soient rares, l'écosystème plus large de Hugging Face donne accès à une vaste gamme de modèles open source via le Hugging Face Hub. Cet accès permet aux utilisateurs d'expérimenter diverses architectures de modèles, ce qui en fait une ressource précieuse pour ceux qui recherchent une flexibilité dans les tests et le développement. Pour obtenir les informations les plus récentes, les utilisateurs sont invités à consulter la documentation officielle de Hugging Face. Ces fonctionnalités s'inscrivent dans la focalisation générale de la plateforme sur l'interopérabilité et l'évaluation des modèles.

Bien que le studio soit construit sur la base de l'accès au modèle de Hugging Face, les outils d'évaluation spécifiques du LLM Prompt Studio ne sont pas bien documentés. Les utilisateurs s'appuient souvent sur des outils généraux et des benchmarks fournis par la communauté à des fins de test. Il est recommandé de consulter la documentation la plus récente de Hugging Face pour rester informé des mises à jour ou des améliorations dans ce domaine.

Hugging Face est largement reconnue pour sa communauté robuste et son infrastructure de partage de modèles efficace. Cependant, les détails sur les fonctionnalités d'intégration et de collaboration spécifiques de LLM Prompt Studio ne sont pas facilement disponibles. Les équipes qui souhaitent tirer parti de ces outils devraient explorer les dernières ressources de Hugging Face afin de mieux comprendre les fonctionnalités et les offres actuelles.

Lorsque vous choisissez la bonne plateforme, il est essentiel de vous concentrer sur les aspects qui influencent directement votre flux de travail et vos coûts. Voici comment le décomposer :

Compatibilité des modèles

La première étape consiste à confirmer que la plateforme prend en charge les modèles que vous utilisez déjà. Il devrait s'intégrer parfaitement à votre flux de travail existant sans nécessiter d'ajustements importants. En outre, réfléchissez à la manière dont la plateforme gère le suivi de la production et gère les modifications apportées aux invites.

Surveillance et gouvernance de la production

Pour les plateformes destinées à une utilisation en production, priorisez les fonctionnalités telles que le suivi en temps réel et les outils de gestion de la gouvernance. De solides capacités de gouvernance, telles que le contrôle des versions, les branchements et les autorisations d'accès, sont essentielles pour développer efficacement vos opérations.

Transparence des coûts

Il est essentiel de comprendre la structure des coûts. La tarification des modèles d'IA dépend généralement du nombre de jetons traités, avec des taux en dollars américains par million de jetons en entrée et en sortie. Certaines plateformes peuvent également facturer les données mises en cache, le stockage ou d'autres services. Gardez à l'esprit que les modèles les plus avancés entraînent généralement des frais par jeton plus élevés. L'analyse comparative des coûts par rapport aux performances et à la fiabilité est essentielle pour trouver le juste équilibre pour vos besoins de production.

Organisation de votre évaluation

Pour simplifier votre comparaison, pensez à créer un tableau mettant en évidence les principales caractéristiques :

Méfiez-vous des coûts cachés. Certaines plateformes peuvent facturer séparément les appels d'API, les ressources de calcul, le stockage ou l'assistance premium, tandis que d'autres proposent des tarifs groupés. Pour obtenir une estimation réaliste des coûts, calculez votre utilisation mensuelle prévue de jetons, appliquez le taux par jeton et incluez les frais fixes éventuels.

Tests et considérations relatives à l'équipe

Profitez des essais gratuits ou des environnements sandbox pour tester les fonctionnalités et vous assurer qu'elles correspondent aux compétences techniques de votre équipe. Les plateformes qui nécessitent une configuration complexe peuvent nuire à la flexibilité de votre équipe. Choisissez une plateforme en fonction de l'expertise de votre équipe : celles qui disposent d'un accès avancé à l'API et d'options de personnalisation sont idéales pour les ingénieurs ML expérimentés, tandis qu'une interface conviviale avec des visualisations claires peut être préférable lorsque des parties prenantes non techniques sont impliquées.

Après avoir évalué et comparé les principales plateformes, il est clair que le choix de la bonne solution de tests rapides et de versionnage n'est pas qu'une décision technique, c'est une décision stratégique qui peut améliorer vos opérations d'IA. Pour les équipes qui déploient de grands modèles de langage à grande échelle, les bons outils peuvent transformer des expériences désorganisées en progrès structurés et mesurables.

En centralisant la gestion rapide, la productivité s'améliore de manière significative. La rationalisation de la gestion rapide des versions et des tests permet de minimiser les inefficacités liées aux outils, de raccourcir les cycles de développement et de réduire la charge mentale des équipes.

La gouvernance devient beaucoup plus simple avec des fonctionnalités telles que le contrôle des versions et des pistes d'audit détaillées. Ces fonctionnalités garantissent la conformité aux normes de l'industrie et empêchent les modifications non autorisées susceptibles de perturber les systèmes de production.

Alors que l'adoption de l'IA se développe dans tous les départements, la gestion des coûts devient essentielle. L'optimisation des instructions permet de réduire le gaspillage de jetons, de maîtriser les coûts et d'empêcher les inefficacités de se transformer en dépenses importantes au fil du temps.

Lorsque vous sélectionnez une plateforme, priorisez celle qui correspond à l'expertise et aux besoins de production de votre équipe. Profitez des essais gratuits pour évaluer l'expérience utilisateur et mesurer les coûts des jetons, afin de vous assurer que la plateforme prend en charge des opérations d'IA évolutives et à long terme. L'alignement sur ces priorités ouvrira la voie à des flux de travail efficaces, conformes et soucieux des coûts.

Lors de la sélection d'une plateforme pour tester et gérer les versions rapides, il est essentiel de hiérarchiser les fonctionnalités qui améliorent efficacité et collaboration en équipe. Voici ce qu'il faut garder à l'esprit :

En vous concentrant sur ces éléments, vous pouvez affiner vos instructions pour améliorer les performances et maintenir des résultats cohérents dans vos projets d'IA.

Les plateformes de test rapides sont essentielles pour garantir le respect des réglementations telles que GDPR et HIPAA, grâce à l'accent mis sur la sécurité et la gestion des données. Ces plateformes sont souvent équipées de fonctionnalités telles que chiffrement des données, contrôles d'accès, et canaux de communication sécurisés, tous conçus pour protéger les informations sensibles.

De nombreuses plateformes incluent également des outils pour anonymisation des données, pistes d'audit, et rapports, qui contribuent à promouvoir la transparence et la responsabilité. Pour les secteurs soumis à des exigences réglementaires strictes, tels que la santé et la finance, certaines plateformes s'intègrent même à Systèmes EHR et soutenez la signature de Contrats de partenariat commercial (BaaS), ce qui en fait un choix fiable pour gérer la conformité.

L'intégration d'une plateforme qui fonctionne sans effort avec votre infrastructure technologique actuelle peut rendre la gestion des flux de travail d'IA beaucoup plus efficace. En consolidant des tâches telles que la gestion rapide, les tests et la gestion des versions dans un environnement unifié, vous n'avez plus à passer d'un outil à l'autre. Cela permet non seulement de gagner du temps, mais également de réduire le risque d'erreurs.

Cette intégration fluide garantit également que vos systèmes fonctionnent en harmonie, ce qui permet des déploiements plus rapides et une meilleure collaboration d'équipe. Le résultat ? Un flux de travail plus cohérent et une voie plus facile pour affiner les applications basées sur l'IA.

{» @context « : » https://schema.org","@type":"FAQPage","mainEntity":[{"@type":"Question","name":"What dois-je rechercher une plateforme pour tester et gérer efficacement les versions rapides ? » <strong><strong>, « AcceptedAnswer » : {» @type « :"Answer », "text » : » Lorsque vous sélectionnez une plateforme pour tester et gérer les versions rapides, il est essentiel de donner la priorité aux fonctionnalités qui améliorent l'efficacité et la collaboration en équipe.</strong></strong> <p> Voici ce qu'il faut garder à l'esprit :</p> <ul><li><strong>Capacités d'intégration</strong> : choisissez une plateforme qui se connecte facilement à vos outils de déploiement et d'évaluation existants, garantissant ainsi un flux de travail fluide</li>. <li><strong>Gestion des versions</strong> : optez pour des outils qui vous permettent de suivre les modifications, de comparer différentes versions et de revenir facilement aux itérations précédentes si nécessaire.</li> </ul><li><strong>Conception conviviale</strong> : une interface simple et intuitive permet de réduire considérablement le temps passé à naviguer sur la plateforme, augmentant ainsi la productivité globale.</li> <p>En vous concentrant sur ces éléments, vous pouvez affiner vos instructions pour améliorer les performances et maintenir des résultats cohérents dans vos projets d'IA.</p> «}}, {» @type « :"Question », "name » :"Comment les plateformes de tests rapides permettent-elles de se conformer à des réglementations telles que le RGPD et la HIPAA ? » , « AcceptedAnswer » : {» @type « :"Answer », "text » : « <p>Les plateformes de test rapides sont essentielles pour garantir le respect des réglementations telles que le <strong>RGPD</strong> et la <strong>HIPAA</strong>, car elles mettent l'accent sur la sécurité et la gestion des données. Ces plateformes sont souvent équipées de fonctionnalités telles que le <strong>cryptage des données</strong>, les <strong>contrôles d'accès</strong> et les <strong>canaux de communication sécurisés</strong>, toutes conçues pour protéger les informations sensibles.</p> <p>De nombreuses plateformes incluent également des outils de <strong>désidentification des données</strong>, de <strong>pistes d'audit</strong> et de <strong>reporting</strong>, qui contribuent à promouvoir la transparence et la responsabilité. Pour les secteurs soumis à des exigences réglementaires strictes, tels que la santé et la finance, certaines plateformes s'intègrent même aux <strong>systèmes EHR</strong> et prennent en charge la signature de <strong>contrats d'association commerciale (BaaS)</strong>, ce qui en fait un choix fiable pour gérer la conformité</p>. «}}, {» @type « :"Question », "name » :"Quels sont les avantages d'utiliser une plateforme qui fonctionne parfaitement avec votre infrastructure technologique actuelle pour les flux de travail liés à l'IA ? » , « AcceptedAnswer » : {» @type « :"Answer », "text » : » <p>L'intégration d'une plateforme qui fonctionne sans effort avec votre infrastructure technologique actuelle peut rendre la gestion des flux de travail d'IA beaucoup plus efficace. En consolidant des tâches telles que la gestion rapide, les tests et la gestion des versions dans un environnement unifié, vous n'avez plus à passer d'un outil à l'autre. Cela permet non seulement de gagner du temps, mais également de réduire le risque d'erreurs.</p> <p>Cette intégration fluide garantit également que vos systèmes fonctionnent en harmonie, ce qui permet des déploiements plus rapides et une meilleure collaboration d'équipe. Le résultat ? Un flux de travail plus cohérent et une voie plus facile pour affiner les applications basées sur l'IA.</p> «}}]}