Gestión de varios modelos lingüísticos de gran tamaño (LLM) como GPT-4, Claudio, Géminis, y Llama puede convertirse rápidamente en una carga logística y financiera. Desde llamadas redundantes a la API hasta costos impredecibles de los tokens, estas ineficiencias interrumpen los flujos de trabajo e inflan los presupuestos. Plataformas como Prompts.ai simplifique este proceso al consolidar el acceso a más de 35 LLM, ofreciendo un seguimiento detallado de los costos, análisis en tiempo real y enrutamiento de modelos automatizados. Este es un desglose rápido de las principales plataformas incluidas:

Para los equipos que gestionan varios LLM, Prompts.ai ofrece ahorros de costos incomparables, flujos de trabajo optimizados y funciones de gobierno, lo que la convierte en la opción ideal para operaciones de IA escalables.

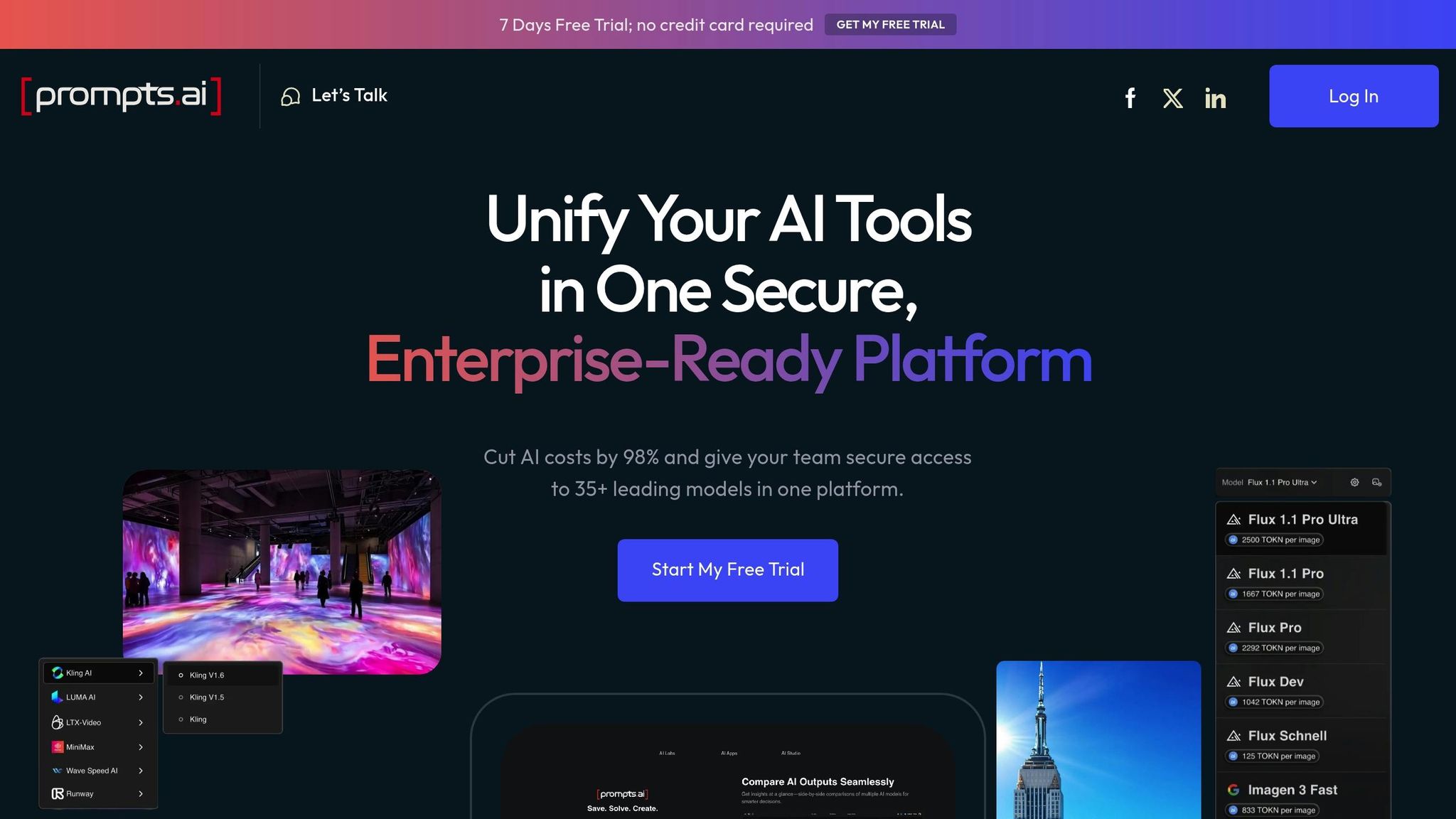

Prompts.ai simplifica los flujos de trabajo de la IA al integrar el acceso a más de 35 modelos en un único espacio de trabajo de nivel empresarial. Esta plataforma elimina la necesidad de combinar varias herramientas y ofrece una supervisión total de los costos, el rendimiento y la gobernanza. Con ella, las empresas pueden reducir los gastos de software de inteligencia artificial hasta en un 98% y multiplicar por diez la productividad de los equipos. Así es como prompts.ai transforma la gestión del flujo de trabajo de la IA:

Una característica destacada de prompts.ai es su seguimiento detallado del gasto en tokens. Esta herramienta funciona a nivel de agente, modelo y proyecto, lo que brinda a los equipos una visión clara de la procedencia de sus costos. Ayuda a identificar qué solicitudes son las más costosas, identifica los modelos más caros para tareas específicas y compara el uso de los tokens en varios proyectos.

Para los equipos que experimentan con varios modelos, como el GPT-4 y el Claude, este nivel de seguimiento tiene un valor incalculable. Las comparaciones de costos en tiempo real para las interacciones rápidas individuales permiten tomar decisiones informadas. Además, el seguimiento a nivel de proyecto simplifica las auditorías internas, lo que permite a los equipos financieros asignar los gastos de inteligencia artificial a productos, clientes o departamentos específicos sin la molestia de realizar cálculos manuales.

Prompts.ai incluye una sólida función de análisis que ofrece información inmediata sobre el gasto a nivel de acción. Esto permite a los equipos identificar las tendencias de gasto, comprender las ineficiencias y realizar ajustes rápidos. Al proporcionar datos en tiempo real, la plataforma ayuda a los usuarios a evitar sorpresas al final de los ciclos de facturación y a anticiparse a los posibles problemas.

La plataforma también cuenta con un modelo de enrutamiento automatizado, que redirige de forma inteligente las solicitudes a puntos finales modelo más rentables cuando es adecuado. Esto garantiza que las tareas se gestionen con el modelo que mejor se adapte al trabajo y, al mismo tiempo, se mantienen los gastos bajo control. Con el tiempo, el sistema adapta sus decisiones de enrutamiento en función de los patrones de uso observados, lo que mejora aún más la eficiencia.

Prompts.ai proporciona herramientas para establecer límites de gastos y alertas para los usuarios o espacios de trabajo completos. También incluye registros de auditoría exhaustivos que rastrean cada solicitud, lo que ofrece transparencia y evita los sobrecostos presupuestarios. Estos controles son especialmente valiosos para las organizaciones que necesitan cumplir con estrictos requisitos de seguridad y cumplimiento.

A diferencia de las funciones integrales de prompts.ai, la plataforma B se centra en supervisar el uso de los tokens. Ofrece métricas en tiempo real y desgloses detallados del consumo de tokens en varios entornos e interfaces de LLM. Este enfoque basado en datos está diseñado para respaldar decisiones de administración de costos rápidas e informadas, principalmente para los equipos financieros que buscan optimizar los gastos. Al especializarse en esta área, la Plataforma B crea su propio nicho, diferenciándolo de las soluciones más amplias.

La plataforma C adopta un enfoque centrado en el flujo de trabajo, ya que integra las canalizaciones de desarrollo con los entornos de producción y, al mismo tiempo, hace hincapié en la facilidad de uso para los desarrolladores y en las herramientas de supervisión esenciales. Si bien prompts.ai destaca en el análisis financiero, la plataforma C centra sus esfuerzos en garantizar un rendimiento operativo sólido dentro de los flujos de trabajo de desarrollo. A continuación, se muestran más de cerca sus capacidades de seguimiento de tokens, análisis operativo, enrutamiento y gobernanza.

La plataforma C ofrece métricas para el uso de tokens en los puntos finales de LLM conectados, lo que proporciona una visión del consumo a nivel de aplicación. Esto facilita a los equipos de desarrollo la identificación de los proyectos que utilizan más tokens. Sin embargo, la plataforma no permite obtener información detallada sobre el rendimiento puntual individual o los costos específicos de los agentes, lo que puede dificultar la optimización de los flujos de trabajo de varios agentes.

El panel proporciona resúmenes diarios y mensuales del uso de los tokens por parte de los proveedores, pero carece de las herramientas avanzadas de atribución de costos que los equipos financieros suelen necesitar para los procesos granulares de presupuestación o devolución de cargos.

Los análisis de la plataforma se centran en métricas de salud operativa en lugar de información financiera detallada. Proporciona visibilidad de los tiempos de respuesta, las tasas de error y el rendimiento en varios puntos finales de LLM. Esto permite a los equipos de desarrollo identificar y abordar rápidamente los problemas de latencia o las altas tasas de error en los sistemas de producción.

Los datos operativos incluyen los códigos de respuesta de la API, los tiempos de procesamiento promedio y la profundidad de las colas, lo que brinda a los equipos de DevOps las herramientas que necesitan para mantener la confiabilidad del sistema. Sin embargo, los análisis no son suficientes cuando se trata del análisis del coste por solicitud o de la comparación de la eficiencia de los diferentes modelos.

La plataforma C prioriza rendimiento y confiabilidad por encima de las consideraciones de costo en sus funciones de enrutamiento. La plataforma redirige automáticamente el tráfico a puntos finales alternativos si los servicios principales no funcionan y utiliza el equilibrio de carga para mantener un rendimiento constante.

Permite equilibrar el tráfico en varias instancias del mismo modelo y ofrece estrategias como la distribución por turnos o ponderada para garantizar operaciones estables. Sin embargo, no incorpora un enrutamiento rentable, lo que podría ser un inconveniente para las organizaciones que buscan optimizar los gastos.

La plataforma C incluye herramientas de gobierno básicas, como los controles de acceso de los usuarios, los presupuestos mensuales de tokens a nivel de proyecto, las alertas por correo electrónico para las infracciones de los umbrales y los registros de auditoría para fines de cumplimiento.

Si bien estas funciones proporcionan una base sólida para la supervisión, el marco de gobierno no incluye opciones más avanzadas, como los flujos de trabajo de aprobación para actividades de alto costo o las asignaciones detalladas de los centros de costos. Estas suelen ser fundamentales para las empresas más grandes que gestionan presupuestos complejos de inteligencia artificial. Aun así, los sencillos controles de la plataforma facilitan a los equipos la gestión de entornos de varios LLM con confianza y eficiencia.

Prompts.ai se destaca por aportar claridad y rentabilidad a las configuraciones de varios LLM. Sus controles FinOps proporcionan información detallada y en tiempo real sobre el uso de los tokens entre agentes, modelos y proyectos, lo que permite abordar la imprevisibilidad financiera que suele afectar a los entornos con múltiples LLM. Este enfoque simplificado de gestión de los tokens garantiza una mejor supervisión y, al mismo tiempo, sienta las bases para una gobernanza sólida y unas operaciones escalables.

Con acceso a más de 35 modelos lingüísticos de gran tamaño, Prompts.ai consolida los flujos de trabajo de IA en una plataforma única y centralizada. Incorpora la gobernanza y el cumplimiento a nivel empresarial en cada interacción, lo que garantiza la seguridad y la fiabilidad. El sistema de crédito TOKN de pago por uso de la plataforma elimina las comisiones recurrentes, lo que reduce los costos de inteligencia artificial hasta en un 98%.

Diseñado para el crecimiento y la eficiencia, Prompts.ai simplifica la experimentación con IA, mejora el análisis de costos y optimiza las solicitudes, todo dentro de un marco seguro. Esto permite a los equipos centrarse en impulsar la innovación sin la molestia de tener que hacer malabares con herramientas desconectadas, lo que permite abordar los desafíos de gestionar varios LLM de forma eficaz, que se analizan en este análisis.

La gestión eficaz de múltiples LLM exige una plataforma que reúna orquestación centralizada y gestión precisa de costes. El éxito depende de las herramientas que proporcionan información en tiempo real sobre el uso de los tokens, automatizan las decisiones de enrutamiento y aplican los marcos de gobierno que crecen con su organización.

Prompts.ai se perfila como una solución ideal para organizaciones que abordan la gestión de múltiples LLM. Con acceso a más de 35 modelos integrados, controles financieros en tiempo real y funciones de gobierno de nivel empresarial, sienta las bases para operaciones de IA escalables y, al mismo tiempo, ofrece la transparencia necesaria para optimizar los costos y el rendimiento.

El sistema de crédito TOKN de pago por uso transforma la forma en que las organizaciones abordan los presupuestos de IA. Al eliminar las tarifas de suscripción recurrentes, los equipos pueden probar e innovar libremente sin preocuparse por los gastos desorbitados. Este modelo es particularmente beneficioso para quienes realizan experimentos multimodelo con proveedores como IA abierta y Claude, donde los costos impredecibles a menudo obstaculizan el progreso.

Más allá de la administración de costos, la gobernanza desempeña un papel vital en los entornos empresariales. Las funciones de cumplimiento integradas en la plataforma garantizan el cumplimiento de los requisitos de seguridad sin sacrificar la eficiencia operativa. La lógica de enrutamiento automatizada aumenta aún más el valor al alejar a los equipos de terminales de modelos costosos cuando las alternativas menos costosas pueden lograr los mismos resultados, abordando el problema común de la proliferación de modelos en flujos de trabajo complejos.

Para los equipos que se encargan de las auditorías internas, la plataforma ofrece ventajas adicionales. Funciones como las alertas y los límites de gastos a nivel del espacio de trabajo permiten un seguimiento preciso de los costos. Los controles granulares (organizados por usuario, proyecto o cliente) garantizan que los presupuestos se mantengan bajo control, lo que evita que se superen antes de que se produzcan.

Al consolidar las operaciones en una interfaz única y segura, la plataforma elimina el caos de tener que hacer malabares con varias herramientas. Este enfoque simplificado no solo reduce la complejidad, sino que también permite comparar el rendimiento en paralelo entre los distintos modelos, lo que allana el camino para una toma de decisiones más fundamentada.

Para las organizaciones comprometidas con ampliar las operaciones de IA y, al mismo tiempo, controlar los costos y mantener la seguridad, Prompts.ai proporciona la infraestructura necesaria para convertir los flujos de trabajo experimentales en procesos gobernados y listos para la producción. Su enfoque unificado lo posiciona como una herramienta esencial para administrar entornos de múltiples LLM de manera efectiva.

Prompts.ai reduce los costos hasta en 98% con su eficiente sistema de pago por uso, impulsado por Créditos TOKN. Al reunir más de 35 LLM en una sola plataforma, garantiza que se optimice el uso de los tokens, elimina las llamadas innecesarias a modelos y simplifica la gestión rápida para reducir el desperdicio.

La plataforma también emplea una lógica de enrutamiento inteligente para evitar los costosos puntos finales de los modelos y ofrece análisis detallados para monitorear el uso de los tokens en todos los agentes, modelos y proyectos. Esto permite a los equipos tomar decisiones informadas, detectar anomalías en los costos y mantener una supervisión completa de sus presupuestos de LLM.

Prompts.ai transforma la forma en que los equipos gestionan los flujos de trabajo de la IA, agilizando los procesos y mejorando la productividad. Con funciones como coedición en tiempo real, lógica de mensajes compartida y permisos multiusuario, la colaboración se hace sencilla. El control de versiones integrado mantiene las actualizaciones organizadas y elimina cualquier posible confusión.

La plataforma también ofrece gestión centralizada del flujo de trabajo de IA, que proporciona información detallada sobre el uso y los costos de los tokens. Al aprovechar herramientas como el análisis preciso del uso y un enrutamiento basado en modelos más inteligentes, los equipos pueden reducir los gastos innecesarios y concentrarse en lograr resultados impactantes.

El modelo de enrutamiento automatizado de Prompts.ai está diseñado para reducir los gastos al asignar tareas más simples a modelos menos costosos, lo que permite ahorrar hasta 85%. Este sistema funciona analizando las tareas en tiempo real y eligiendo los modelos más económicos, al tiempo que garantiza que el rendimiento siga siendo de primera categoría.

Además de eso, los equipos pueden realizar un seguimiento de las tendencias de uso y establecer límites de gasto para evitar costos innecesarios. Esta función ayuda a las empresas a ahorrar un extra 20— 40% en los gastos relacionados con la IA, a la vez que se obtienen resultados fiables y de alta calidad.