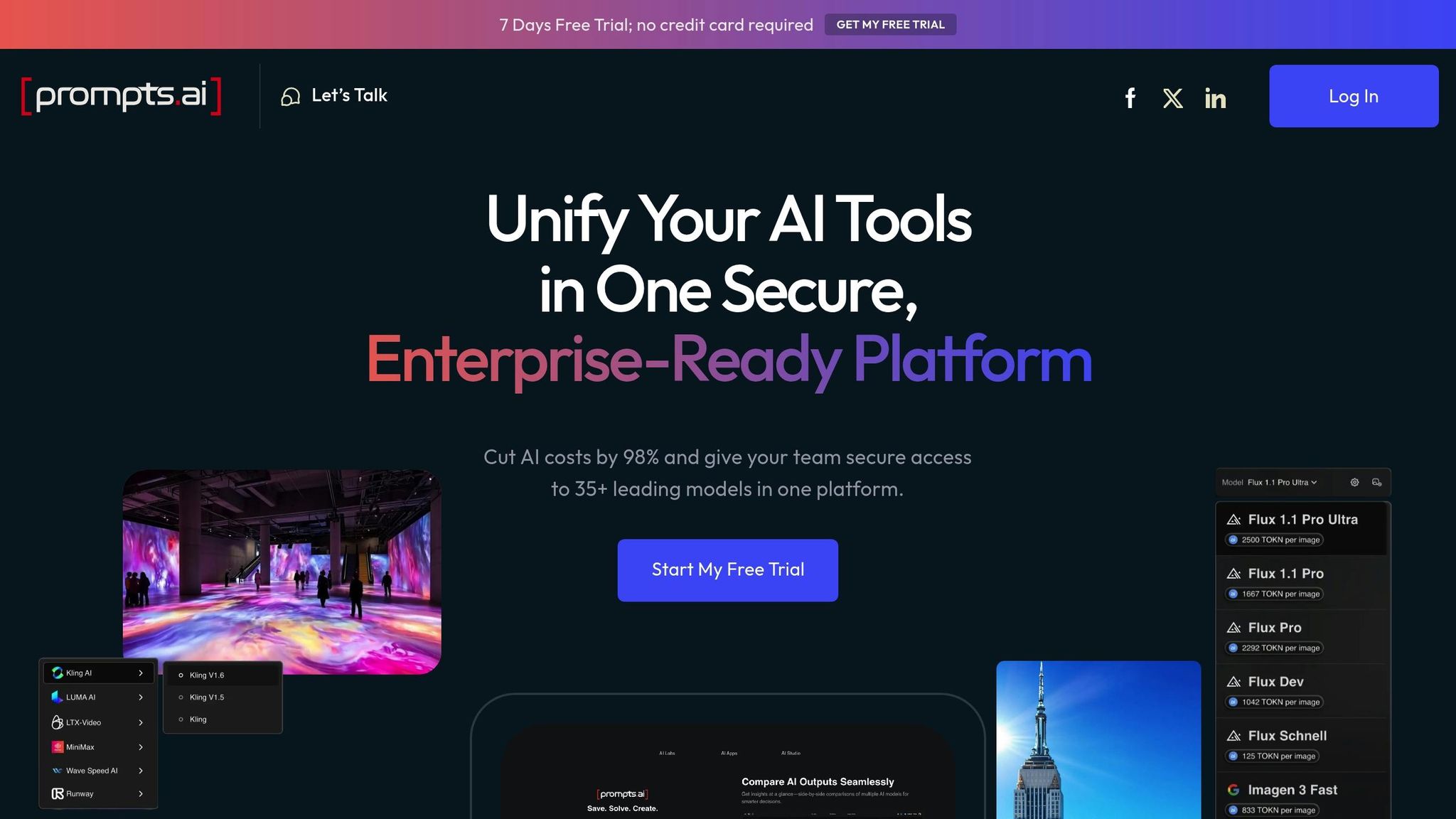

إدارة العديد من نماذج اللغات الكبيرة (LLMs) مثل جي بي تي -4، كلود، الجوزاء، و لاما يمكن أن تصبح بسرعة عبئًا لوجستيًا وماليًا. من مكالمات API المتكررة إلى تكاليف الرموز غير المتوقعة، تؤدي أوجه القصور هذه إلى تعطيل سير العمل وتضخيم الميزانيات. منصات مثل Prompts.ai قم بتبسيط هذه العملية من خلال دمج الوصول إلى أكثر من 35 شركة LLM، وتقديم تتبع مفصل للتكاليف وتحليلات في الوقت الفعلي وتوجيه تلقائي للنماذج. فيما يلي تفصيل سريع للمنصات الرئيسية التي تمت تغطيتها:

بالنسبة للفرق التي تدير العديد من LLMs، Prompts.ai يوفر توفيرًا لا مثيل له في التكاليف وسير عمل مبسط وميزات حوكمة، مما يجعله الخيار المفضل لعمليات الذكاء الاصطناعي القابلة للتطوير.

يعمل Prompts.ai على تبسيط عمليات سير عمل الذكاء الاصطناعي من خلال دمج الوصول إلى أكثر من 35 نموذجًا في مساحة عمل واحدة على مستوى المؤسسة. تلغي هذه المنصة الحاجة إلى التوفيق بين أدوات متعددة، وتوفر الإشراف الكامل على التكاليف والأداء والحوكمة. باستخدامه، يمكن للشركات خفض نفقات برامج الذكاء الاصطناعي بنسبة تصل إلى 98٪ وزيادة إنتاجية الفريق بعشرة أضعاف. فيما يلي كيفية قيام prompts.ai بتحويل إدارة سير عمل الذكاء الاصطناعي:

إحدى الميزات البارزة لـ prompts.ai هي التتبع التفصيلي لإنفاق الرموز. تعمل هذه الأداة على مستويات الوكيل والنموذج والمشروع، مما يمنح الفرق رؤية واضحة لمصدر تكاليفها. فهي تساعد في تحديد المطالبات الأكثر تكلفة، وتحدد النماذج الأكثر تكلفة لمهام محددة، وتقارن استخدام الرمز المميز عبر مختلف المشاريع.

بالنسبة للفرق التي تجرب نماذج متعددة، مثل GPT-4 و Claude، فإن هذا المستوى من التتبع لا يقدر بثمن. تسمح مقارنات التكلفة في الوقت الفعلي للتفاعلات الفردية السريعة باتخاذ قرارات مستنيرة. بالإضافة إلى ذلك، يعمل التتبع على مستوى المشروع على تبسيط عمليات التدقيق الداخلية، مما يسمح لفرق التمويل بتخصيص نفقات الذكاء الاصطناعي لمنتجات أو عملاء أو أقسام محددة دون متاعب الحسابات اليدوية.

يتضمن Prompts.ai ميزة تحليلات قوية تقدم رؤى فورية حول الإنفاق على مستوى الإجراءات. يتيح ذلك للفرق تحديد اتجاهات الإنفاق وفهم أوجه القصور وإجراء تعديلات سريعة. من خلال توفير البيانات في الوقت الفعلي، تساعد المنصة المستخدمين على تجنب المفاجآت في نهاية دورات الفواتير والبقاء في طليعة المشكلات المحتملة.

تتميز المنصة أيضًا بالتوجيه الآلي للنماذج، والذي يعيد توجيه الطلبات بذكاء إلى نقاط نهاية نموذجية أكثر فعالية من حيث التكلفة عندما يكون ذلك مناسبًا. هذا يضمن التعامل مع المهام من خلال النموذج الأنسب للوظيفة مع الحفاظ على النفقات تحت السيطرة. وبمرور الوقت، يقوم النظام بتكييف قرارات التوجيه الخاصة به بناءً على أنماط الاستخدام الملاحظة، مما يزيد من تحسين الكفاءة.

يوفر Prompts.ai أدوات لتعيين حدود الإنفاق والتنبيهات للمستخدمين أو مساحات العمل بأكملها. كما يتضمن أيضًا مسارات تدقيق شاملة تتعقب كل مطالبة، وتوفر الشفافية وتمنع تجاوزات الميزانية. تعتبر عناصر التحكم هذه ذات قيمة خاصة للمؤسسات التي تحتاج إلى الالتزام بمتطلبات الأمان والامتثال الصارمة.

على عكس الميزات الشاملة لـ prompts.ai، تعمل المنصة B على تضييق تركيزها على مراقبة استخدام الرمز المميز. إنه يوفر مقاييس في الوقت الفعلي وتفصيلًا تفصيليًا لاستهلاك الرموز عبر بيئات وواجهات LLM المختلفة. تم تصميم هذا النهج القائم على البيانات لدعم قرارات إدارة التكاليف السريعة والمستنيرة، والتي تلبي في المقام الأول فرق التمويل التي تتطلع إلى تحسين النفقات. من خلال التخصص في هذا المجال، تحدد Platform B مكانتها الخاصة المتميزة عن الحلول الأوسع.

تتبنى المنصة C نهجًا يركز على سير العمل، حيث تدمج خطوط أنابيب التطوير مع بيئات الإنتاج مع التأكيد على سهولة الاستخدام للمطورين وأدوات المراقبة الأساسية. بينما تتألق prompts.ai في التحليلات المالية، تركز Platform C جهودها على ضمان الأداء التشغيلي القوي ضمن تدفقات عمل التطوير. فيما يلي نظرة فاحصة على إمكانات تتبع الرموز والتحليلات التشغيلية والتوجيه والحوكمة.

توفر المنصة C مقاييس لاستخدام الرمز المميز عبر نقاط نهاية LLM المتصلة، مما يوفر عرضًا على مستوى التطبيق للاستهلاك. هذا يجعل من السهل على فرق التطوير تحديد المشاريع التي تستخدم معظم الرموز. ومع ذلك، لا تسمح المنصة بإحصاءات تفصيلية حول الأداء السريع الفردي أو التكاليف الخاصة بالوكيل، مما قد يجعل من الصعب ضبط تدفقات العمل متعددة الوكلاء.

توفر لوحة المعلومات ملخصات يومية وشهرية لاستخدام الرمز المميز عبر مقدمي الخدمة، ولكنها تفتقر إلى أدوات إحالة التكلفة المتقدمة التي تحتاجها فرق التمويل غالبًا لإعداد الميزانية الدقيقة أو عمليات رد المبالغ المدفوعة.

تركز تحليلات المنصة على مقاييس الصحة التشغيلية بدلاً من الرؤى المالية التفصيلية. يوفر رؤية لأوقات الاستجابة ومعدلات الخطأ والإنتاجية عبر نقاط نهاية LLM المختلفة. يتيح ذلك لفرق التطوير تحديد ومعالجة مشكلات وقت الاستجابة أو معدلات الفشل العالية في أنظمة الإنتاج بسرعة.

تتضمن البيانات التشغيلية رموز استجابة API ومتوسط أوقات المعالجة وأعماق قائمة الانتظار، مما يمنح فرق DevOps الأدوات التي يحتاجونها للحفاظ على موثوقية النظام. ومع ذلك، فإن التحليلات تقصر عندما يتعلق الأمر بتحليل التكلفة لكل طلب أو مقارنة كفاءة النماذج المختلفة.

النظام الأساسي C يعطي الأولوية الأداء والموثوقية مقارنة باعتبارات التكلفة في ميزات التوجيه الخاصة به. تقوم المنصة تلقائيًا بإعادة توجيه حركة المرور إلى نقاط النهاية البديلة في حالة تعطل الخدمات الأساسية واستخدام موازنة التحميل للحفاظ على الأداء المتسق.

وهو يدعم موازنة حركة المرور عبر مثيلات متعددة من نفس النموذج ويقدم استراتيجيات مثل التوزيع الدائري أو التوزيع المرجح لضمان عمليات ثابتة. ومع ذلك، فإنه لا يتضمن التوجيه المدرك للتكلفة، والذي قد يكون عيبًا للمؤسسات التي تتطلع إلى تحسين النفقات.

تتضمن المنصة C أدوات الحوكمة الأساسية، مثل عناصر التحكم في وصول المستخدم، وميزانيات الرموز الشهرية على مستوى المشروع، وتنبيهات البريد الإلكتروني لانتهاكات الحد الأدنى، وسجلات التدقيق لأغراض الامتثال.

على الرغم من أن هذه الميزات توفر أساسًا متينًا للرقابة، إلا أن إطار الحوكمة لا يتضمن خيارات أكثر تقدمًا مثل تدفقات الموافقة للأنشطة عالية التكلفة أو تخصيصات مركز التكلفة التفصيلية. غالبًا ما تكون هذه الأمور بالغة الأهمية للمؤسسات الكبيرة التي تدير ميزانيات الذكاء الاصطناعي المعقدة. ومع ذلك، فإن الضوابط المباشرة للمنصة تجعل من السهل على الفرق إدارة بيئات LLM المتعددة بثقة وكفاءة.

تبرز Prompts.ai من خلال توفير الوضوح والكفاءة من حيث التكلفة لإعدادات LLM المتعددة. توفر ضوابط FinOps الخاصة بها رؤى تفصيلية في الوقت الفعلي حول استخدام الرموز عبر الوكلاء والنماذج والمشاريع، وتعالج عدم القدرة على التنبؤ المالي الذي غالبًا ما تصيب بيئات Multi-LLM. يضمن نهج إدارة الرموز المبسط هذا إشرافًا أفضل مع وضع الأساس لحوكمة قوية وعمليات قابلة للتطوير.

من خلال الوصول إلى أكثر من 35 نموذجًا لغويًا كبيرًا، تدمج Prompts.ai تدفقات عمل الذكاء الاصطناعي في منصة مركزية واحدة. فهو يدمج الحوكمة والامتثال على مستوى المؤسسة في كل تفاعل، مما يضمن الأمان والموثوقية. يعمل نظام TOKN الائتماني للدفع أولاً بأول على المنصة على التخلص من الرسوم المتكررة، مما يقلل تكاليف الذكاء الاصطناعي بنسبة تصل إلى 98٪.

تم تصميم Prompts.ai لتحقيق النمو والكفاءة، وهو يبسط تجارب الذكاء الاصطناعي، ويعزز تحليلات التكلفة، ويحسن المطالبات - كل ذلك ضمن إطار آمن. يتيح ذلك للفرق التركيز على قيادة الابتكار دون متاعب التوفيق بين الأدوات غير المتصلة، ومعالجة تحديات إدارة LLMs المتعددة التي تمت مناقشتها بفعالية في هذا التحليل.

تتطلب الإدارة الفعالة للعديد من LLMs منصة تجمع معًا تزامن مركزي و إدارة التكلفة الدقيقة. يتوقف النجاح على الأدوات التي توفر رؤى في الوقت الفعلي حول استخدام الرموز، وأتمتة قرارات التوجيه، وفرض أطر الحوكمة التي تنمو مع مؤسستك.

يظهر Prompts.ai كحل مثالي للمؤسسات التي تتعامل مع إدارة LLM المتعددة. من خلال الوصول إلى أكثر من 35 نموذجًا مدمجًا، والضوابط المالية في الوقت الفعلي، وميزات الحوكمة على مستوى المؤسسة، فإنها تمهد الطريق لعمليات الذكاء الاصطناعي القابلة للتطوير مع توفير الشفافية اللازمة لتحسين التكاليف والأداء.

ال نظام ائتمان TOKN للدفع أولاً بأول يعمل على تغيير طريقة تعامل المؤسسات مع ميزانيات الذكاء الاصطناعي. من خلال إلغاء رسوم الاشتراك المتكررة، يمكن للفرق الاختبار والابتكار بحرية دون القلق بشأن النفقات الباهظة. هذا النموذج مفيد بشكل خاص لأولئك الذين يجرون تجارب متعددة النماذج مع مزودي خدمات مثل أوبن إيه آي وكلود، حيث غالبًا ما تعيق التكاليف غير المتوقعة التقدم.

بالإضافة إلى إدارة التكاليف، تلعب الحوكمة دورًا حيويًا في بيئات المؤسسات. تضمن ميزات التوافق المضمنة في النظام الأساسي تلبية متطلبات الأمان دون التضحية بالكفاءة التشغيلية. يعمل منطق التوجيه الآلي على زيادة القيمة من خلال توجيه الفرق بعيدًا عن نقاط نهاية النموذج باهظة الثمن عندما تتمكن البدائل الأقل تكلفة من تحقيق نفس النتائج، ومعالجة المشكلة الشائعة المتمثلة في تمدد النموذج في عمليات سير العمل المعقدة.

بالنسبة للفرق التي تتعامل مع عمليات التدقيق الداخلية، توفر المنصة مزايا إضافية. تسمح ميزات مثل حدود الإنفاق على مستوى مساحة العمل والتنبيهات بتتبع التكلفة بدقة. تضمن الضوابط الدقيقة - التي يتم تنظيمها بواسطة المستخدم أو المشروع أو العميل - بقاء الميزانيات تحت السيطرة، مما يمنع التجاوزات قبل حدوثها.

من خلال دمج العمليات في واجهة واحدة آمنة، تقضي المنصة على فوضى التلاعب بأدوات متعددة. لا يقلل هذا النهج المبسط من التعقيد فحسب، بل يتيح أيضًا مقارنات الأداء جنبًا إلى جنب عبر النماذج، مما يمهد الطريق لاتخاذ قرارات أكثر استنارة.

بالنسبة للمؤسسات الملتزمة بتوسيع عمليات الذكاء الاصطناعي مع التحكم في التكاليف والحفاظ على الأمن، يوفر Prompts.ai البنية التحتية اللازمة لتحويل سير العمل التجريبي إلى عمليات محكومة وجاهزة للإنتاج. نهجها الموحد يضعها كأداة أساسية لإدارة بيئات LLM المتعددة بفعالية.

يخفض Prompts.ai التكاليف بنسبة تصل إلى 98% مع نظام الدفع لكل استخدام الفعال، والمدعوم من ائتمانات توكن. من خلال الجمع بين أكثر من 35 LLMs على منصة واحدة، فإنه يضمن تحسين استخدام الرمز المميز، ويزيل مكالمات النماذج غير الضرورية، ويبسط الإدارة السريعة لتقليل الفاقد.

تستخدم المنصة أيضًا منطق التوجيه الذكي لتجاوز نقاط نهاية النموذج المكلفة وتقدم تحليلات مفصلة لمراقبة استخدام الرمز المميز عبر الوكلاء والنماذج والمشاريع. هذا يمكّن الفرق من اتخاذ قرارات مستنيرة، وتحديد الانحرافات في التكاليف، والحفاظ على الإشراف الكامل على ميزانيات LLM الخاصة بهم.

تعمل Prompts.ai على تحويل كيفية تعامل الفرق مع تدفقات عمل الذكاء الاصطناعي وتبسيط العمليات وتحسين الإنتاجية. مع ميزات مثل التحرير المشترك في الوقت الفعلي، ومنطق المطالبة المشترك، و أذونات متعددة المستخدمين، يصبح التعاون سهلاً. يحافظ التحكم المتكامل في الإصدار على تنظيم التحديثات ويزيل أي ارتباك محتمل.

تقدم المنصة أيضًا إدارة سير عمل الذكاء الاصطناعي المركزية، مما يوفر رؤى تفصيلية حول استخدام الرمز المميز وتكاليفه. من خلال الاستفادة من أدوات مثل تحليلات الاستخدام الدقيقة وتوجيه النماذج الأكثر ذكاءً، يمكن للفرق خفض النفقات غير الضرورية والتركيز على تحقيق نتائج مؤثرة.

تم تصميم التوجيه الآلي للنموذج الخاص بـ Prompts.ai لتقليل النفقات عن طريق تعيين مهام أبسط لنماذج أقل تكلفة، وتحقيق وفورات تصل إلى 85%. يعمل هذا النظام من خلال تحليل المهام في الوقت الفعلي واختيار النماذج الأكثر اقتصادا، كل ذلك مع ضمان بقاء الأداء من الدرجة الأولى.

علاوة على ذلك، يمكن للفرق تتبع اتجاهات الاستخدام وتعيين حدود الإنفاق لتجنب التكاليف غير الضرورية. تساعد هذه الميزة الشركات على توفير المزيد 20-40% على النفقات المتعلقة بالذكاء الاصطناعي، كل ذلك مع تقديم نتائج موثوقة وعالية الجودة.