管理多个大型语言模型 (LLM)像 GPT-4, 克劳德, 双子座,以及 美洲驼 可能很快成为后勤和财务负担。从冗余的 API 调用到不可预测的代币成本,这些效率低下会干扰工作流程并膨胀预算。像这样的平台 Prompts.ai 通过整合对 35 多个 LLM 的访问权限来简化此流程,提供详细的成本跟踪、实时分析和自动模型路由。以下是所涵盖的关键平台的简要分类:

对于管理多个 LLM 的团队, Prompts.ai 提供无与伦比的成本节约、简化的工作流程和治理功能,使其成为可扩展的人工智能运营的首选。

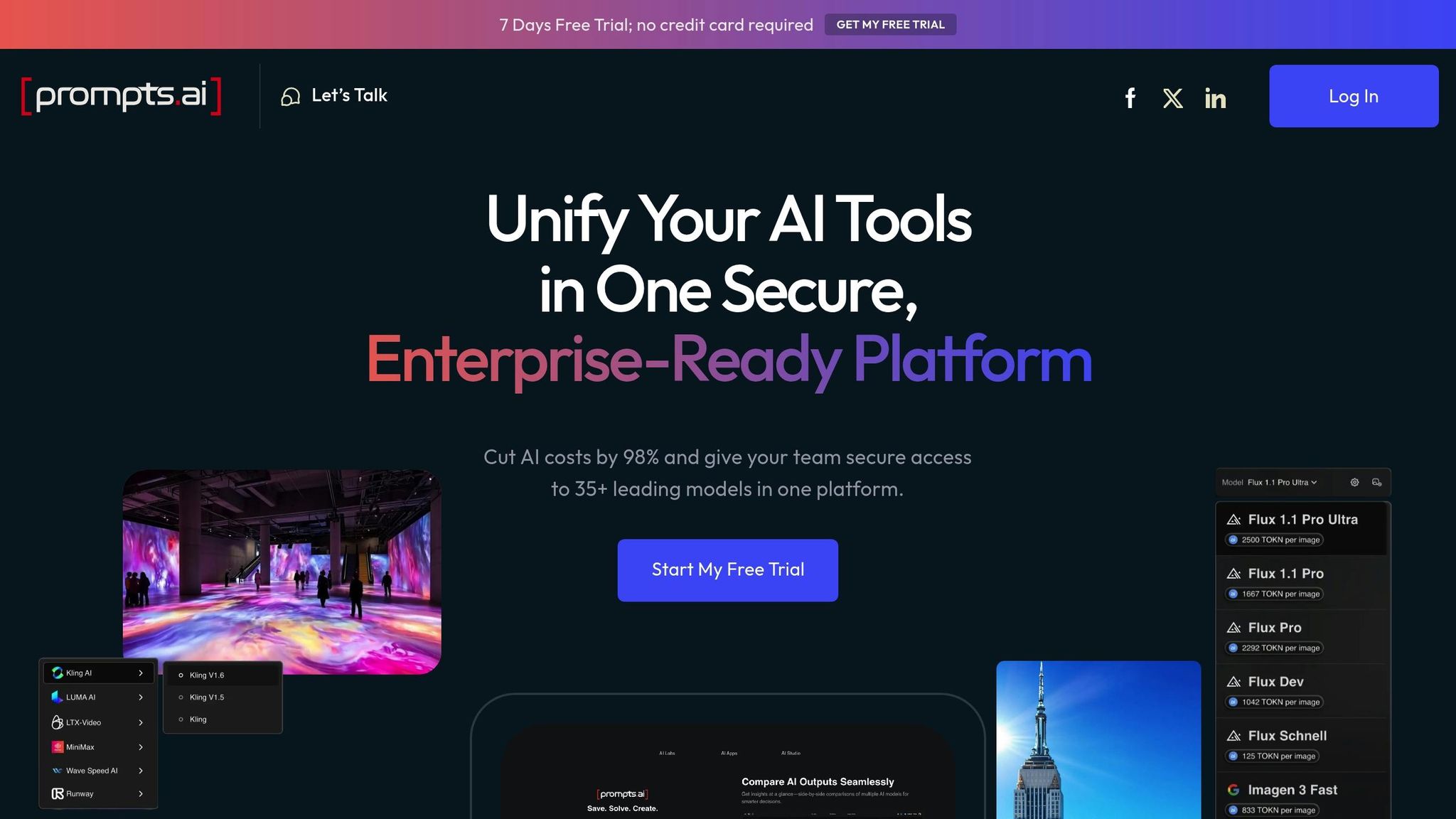

Prompts.ai 将对超过 35 个模型的访问权限集成到一个企业级工作空间中,从而简化了 AI 工作流程。该平台无需兼顾多种工具,可以全面监督成本、性能和治理。有了它,公司可以将人工智能软件费用削减多达98%,并将团队生产力提高十倍。以下是 prompts.ai 如何改变 AI 工作流程管理:

prompts.ai 的一个突出特点是其详细的代币支出跟踪。该工具在代理、模型和项目层面上运行,使团队可以清楚地了解其成本来源。它有助于确定哪些提示成本最高,为特定任务找出最昂贵的模型,并比较不同项目的代币使用情况。

对于尝试多种模型(例如 GPT-4 和 Claude)的团队来说,这种跟踪水平非常宝贵。对个人即时互动进行实时成本比较可以做出明智的决策。此外,项目级跟踪简化了内部审计,使财务团队无需手动计算即可将人工智能费用分配给特定的产品、客户或部门。

Prompts.ai 包含强大的分析功能,可即时洞察行动层面的支出。这使团队能够识别支出趋势,了解效率低下并快速进行调整。通过提供实时数据,该平台可帮助用户避免在计费周期结束时出现意外情况,并提前解决潜在问题。

该平台还具有自动模型路由功能,可在适当时智能地将请求重定向到更具成本效益的模型端点。这样可以确保由最适合工作的模型来处理任务,同时控制开支。随着时间的推移,系统会根据观察到的使用模式调整其路由决策,从而进一步提高效率。

Prompts.ai 提供了为用户或整个工作空间设置支出限额和提醒的工具。它还包括跟踪每条提示的全面审计记录,提供透明度并防止预算超支。这些控制措施对于需要遵守严格的安全和合规性要求的组织尤其有价值。

与 prompts.ai 的包罗万象的功能不同,平台 B 将其重点缩小到监控代币使用情况。它提供了各种 LLM 环境和接口中代币消费的实时指标和详细明细。这种数据驱动的方法旨在支持快速、明智的成本管理决策,主要满足希望优化支出的财务团队的需求。通过专注于该领域,Platform B开拓了自己的利基市场,这与更广泛的解决方案截然不同。

Platform C 采用以工作流程为中心的方法,将开发管道与生产环境集成在一起,同时强调开发人员和基本监控工具的易用性。尽管 prompts.ai 在财务分析方面大放异彩,但 Platform C 的重点是确保开发工作流程中的强劲运营绩效。以下是其代币跟踪、运营分析、路由和治理能力的详细介绍。

平台 C 提供互联的 LLM 端点的代币使用量指标,提供应用程序级别的消费视图。这使开发团队更容易确定哪些项目使用了最多的代币。但是,该平台无法详细了解个人即时性能或代理特定成本,这可能会使微调多代理工作流程变得更加困难。

该仪表板提供各提供商的代币使用情况的每日和每月摘要,但它缺少财务团队在精细预算或退款流程中经常需要的高级成本归因工具。

该平台的分析重点是 运营健康指标,而不是详细的财务见解。它提供了对各种 LLM 端点的响应时间、错误率和吞吐量的可见性。这使开发团队能够快速识别和解决生产系统中的延迟问题或高故障率。

操作数据包括 API 响应代码、平均处理时间和队列深度,为 DevOps 团队提供了维护系统可靠性所需的工具。但是,当涉及到每个请求的费用分析或比较不同模型的效率时,分析是不够的。

平台 C 优先考虑 性能和可靠性优先于成本考虑 在其路由功能中。如果主要服务出现故障,该平台会自动将流量重定向到备用端点,并使用负载平衡来保持稳定的性能。

它支持在同一模型的多个实例之间平衡流量,并提供循环或加权分配等策略来确保稳定运行。但是,它不包含成本感知路由,这对于希望优化开支的组织来说可能是一个缺点。

平台 C 包括基本的治理工具,例如用户访问控制、项目级别的每月代币预算、违反阈值的电子邮件警报以及用于合规目的的审计日志。

尽管这些功能为监督提供了坚实的基础,但治理框架不包括更高级的选项,例如高成本活动的审批工作流程或详细的成本中心分配。这些通常对于管理复杂人工智能预算的大型企业至关重要。尽管如此,该平台的简单控制使团队可以更轻松地自信和高效地管理多 LLM 环境。

Prompts.ai 通过为多 LLM 设置带来清晰度和成本效益而脱颖而出。其FinOps控制措施提供了对代理、模型和项目中代币使用情况的实时、详细的见解,从而解决了经常困扰多LLM环境的财务不可预测性。这种简化的代币管理方法可确保更好的监督,同时为强有力的治理和可扩展的运营奠定基础。

Prompts.ai 可以访问超过 35 种大型语言模型,将 AI 工作流程整合到一个集中式平台中。它将企业级治理和合规性纳入每一次互动,确保安全性和可靠性。该平台的即用即付TOKN信用系统消除了经常性费用,将人工智能成本削减了多达98%。

Prompts.ai 专为增长和提高效率而设计,可简化 AI 实验、增强成本分析并优化提示——所有这些都在安全的框架内完成。这使团队可以专注于推动创新,而不必费力处理互不关联的工具,从而解决本分析中有效讨论的管理多个 LLM 所面临的挑战。

有效管理多个 LLM 需要一个汇集在一起的平台 集中式编排 和 精确的成本管理。成功取决于能够实时洞察代币使用情况、自动执行路由决策以及执行与组织共同成长的治理框架的工具。

Prompts.ai 成为理想的解决方案 适用于处理多 LLM 管理的组织。它可以访问35多个集成模型、实时财务控制和企业级治理功能,为可扩展的人工智能运营奠定了基础,同时提供了优化成本和性能所需的透明度。

这个 即用即付 TOKN 积分系统 改变组织处理 AI 预算的方式。通过取消经常性订阅费,团队可以自由地进行测试和创新,而不必担心支出失控。该模型对于那些与提供商进行多模型实验的人特别有益,例如 OpenAI 还有克劳德,不可预测的成本往往会阻碍进展。

除了成本管理,治理在企业环境中也起着至关重要的作用。该平台的内置合规性功能可确保在不牺牲运营效率的情况下满足安全要求。当成本较低的替代方案可以获得相同的结果时,自动路由逻辑可引导团队远离昂贵的模型端点,从而进一步提高价值,从而解决复杂工作流程中模型蔓延的常见问题。

对于处理内部审计的团队来说,该平台提供了额外的优势。工作空间级支出限额和警报等功能可实现精确的成本跟踪。由用户、项目或客户组织的精细控制措施可确保预算得到控制,在超支发生之前防止超支。

通过将操作整合到一个安全的界面中,该平台消除了兼顾多个工具的混乱局面。这种简化的方法不仅可以降低复杂性,还可以实现模型间的并行性能比较,为更明智的决策铺平道路。

对于致力于在控制成本和维护安全的同时扩大人工智能运营规模的组织, Prompts.ai 提供了将实验工作流程转变为受管控的、可随时投入生产的流程所需的基础架构。其统一方法将其定位为有效管理多 LLM 环境的必备工具。

Prompts.ai 最多可削减成本 98% 凭借其高效的按使用付费系统,由 代币积分。通过在单个平台上整合超过35个LLM,它确保了代币的使用得到优化,消除了不必要的模型调用,并简化了即时管理以减少浪费。

该平台还采用智能路由逻辑来绕过昂贵的模型端点,并提供详细的分析,以监控代理、模型和项目的代币使用情况。这使团队能够做出明智的决策,发现成本异常,并全面监督其LLM预算。

Prompts.ai 改变了团队处理 AI 工作流程的方式,简化了流程并提高了生产力。具有诸如此类的功能 实时共同编辑、共享提示逻辑,以及 多用户权限,协作变得毫不费力。集成的版本控制使更新井井有条,并消除了任何潜在的混乱。

该平台还提供 集中式 AI 工作流程管理,提供有关代币使用和成本的详细见解。通过利用精确的使用分析和更智能的模型路由等工具,团队可以减少不必要的开支,专注于取得有影响力的结果。

Prompts.ai 的自动模型路由旨在通过将更简单的任务分配给成本较低的模型来减少开支,从而节省高达 85%。该系统的工作原理是实时分析任务并选择最经济的模型,同时确保性能保持一流水平。

最重要的是,团队可以跟踪使用趋势并设置支出限额以避免不必要的成本。此功能可帮助企业节省额外费用 20— 40% 在与人工智能相关的费用上,同时提供可靠、高质量的结果。