Orquestación del flujo de trabajo con IA es la columna vertebral de los sistemas modernos de inteligencia artificial, que garantiza una integración perfecta entre modelos, fuentes de datos y procesos. A diferencia de los rígidos flujos de trabajo tradicionales, la orquestación de la IA se adapta de forma dinámica, automatizando las tareas, conectando sistemas y optimizando la toma de decisiones. A continuación se muestran 9 plataformas líderes para la orquestación del flujo de trabajo de IA, cada una de las cuales ofrece funciones únicas para satisfacer las necesidades organizativas específicas:

Estas plataformas se adaptan a diversas necesidades, desde el ahorro de costos y la gobernanza hasta la escalabilidad y la integración. Elija en función de los objetivos, la experiencia técnica y la infraestructura existente de su organización.

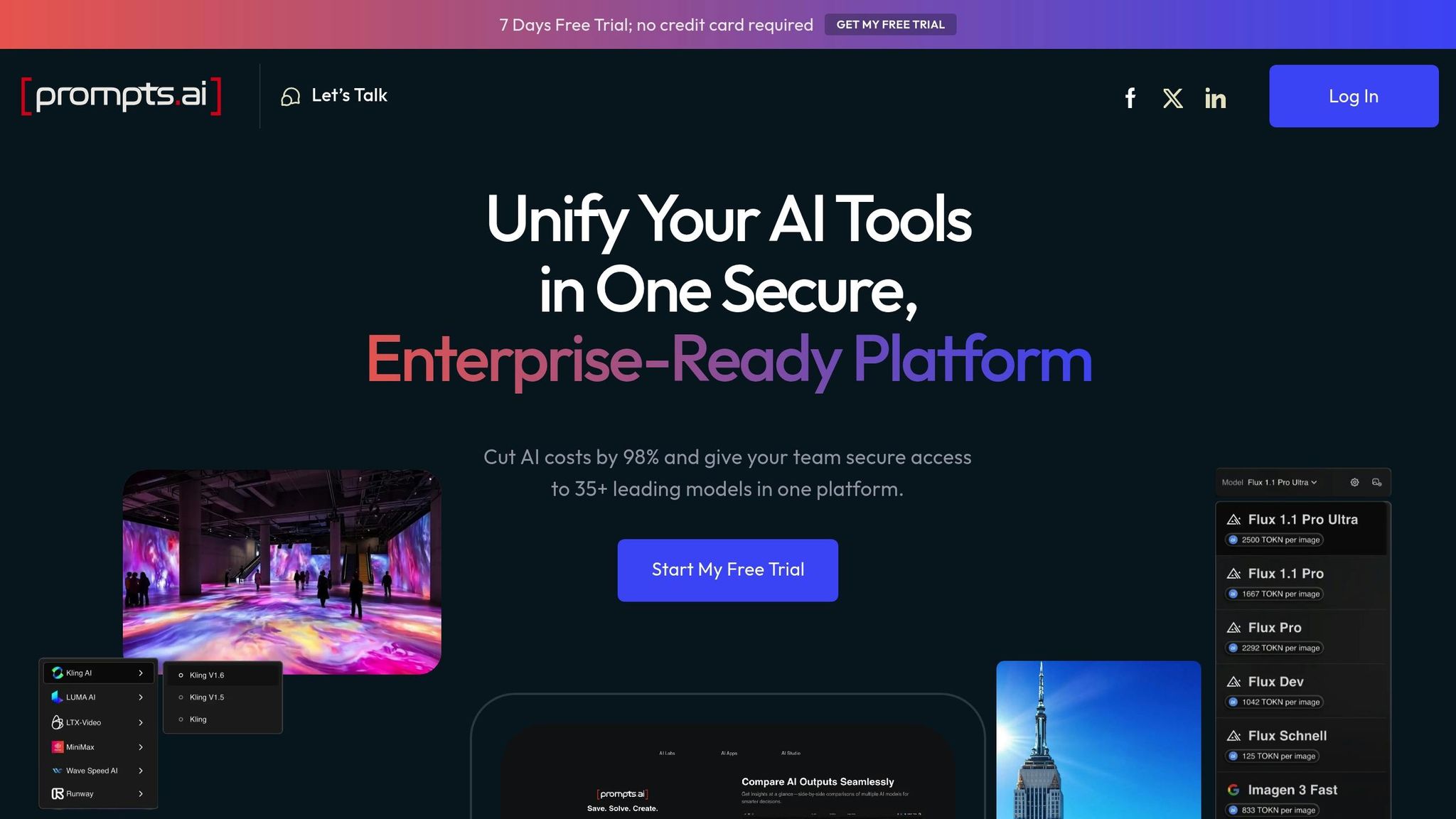

Prompts.ai reúne más de 35 modelos lingüísticos de gran tamaño de primer nivel, incluidos GPT-4, Claude, LLama y Gemini, en una interfaz segura y unificada. Al abordar el desafío de la proliferación de herramientas, la plataforma garantiza flujos de trabajo de inteligencia artificial simplificados y, al mismo tiempo, prioriza la gobernanza y la rentabilidad.

Una de las características más destacadas de Prompts.ai es su capacidad para integrar diversos modelos de IA en una sola plataforma. En lugar de tener que hacer malabares con múltiples suscripciones e interfaces, las organizaciones pueden acceder a modelos como GPT-4, Claude y Gemini desde un solo lugar. Esto elimina la molestia de cambiar de una herramienta a otra y garantiza un flujo de trabajo más fluido.

La plataforma también admite pruebas de rendimiento en paralelo, donde los equipos pueden ejecutar el mismo mensaje en varios modelos simultáneamente. Esta función tiene un valor incalculable para determinar qué modelo funciona mejor para tareas específicas sin la carga de administrar plataformas independientes. Esta configuración unificada simplifica la automatización y sienta las bases para escalar las operaciones de IA sin esfuerzo.

Prompts.ai transforma los esfuerzos experimentales de IA en flujos de trabajo uniformes y estandarizados. Los equipos pueden crear flujos de trabajo repetibles que aporten uniformidad a todos los proyectos y departamentos. Esta coherencia se vuelve esencial a medida que las organizaciones amplían sus iniciativas de IA, pasando de las pruebas a pequeña escala a las implementaciones en toda la empresa.

El diseño de la plataforma admite un escalado rápido, lo que permite a las organizaciones agregar nuevos modelos, usuarios o equipos en cuestión de minutos. Con su Créditos TOKN de pago por uso sistema, Prompts.ai elimina la necesidad de tarifas de suscripción fijas, lo que permite a las empresas alinear los costos con el uso real. Esta flexibilidad facilita la ampliación o la reducción en función de las necesidades cambiantes, lo que evita gastos innecesarios.

La gobernanza está en el centro del marco de Prompts.ai. La plataforma ofrece visibilidad y control completos sobre todas las interacciones de la IA, con registros de auditoría detallados que rastrean el uso en todos los modelos, equipos y aplicaciones. Esta transparencia es crucial para cumplir los requisitos de cumplimiento a gran escala.

Para abordar los problemas de seguridad, la plataforma garantiza que los datos confidenciales permanecen bajo el control de la organización. Con las funciones de seguridad y las herramientas de cumplimiento integradas, las empresas pueden implementar flujos de trabajo de IA con confianza y, al mismo tiempo, cumplir con sus protocolos de seguridad y estándares reglamentarios.

Prompts.ai aborda los costos ocultos de la IA con su capa FinOps integrada, que rastrea cada token, proporciona un monitoreo de costos en tiempo real y conecta los gastos con los resultados empresariales. Esta transparencia ayuda a las organizaciones a entender sus gastos en inteligencia artificial y a ajustarlos cuando sea necesario.

Al consolidar varias herramientas de IA en una sola plataforma con precios basados en el uso, Prompts.ai puede reducir los costos de software de IA hasta en un 98%. Este enfoque no solo ahorra dinero, sino que también garantiza el acceso a una amplia gama de modelos de IA líderes sin la complejidad de gestionar suscripciones independientes.

Prompts.ai apoya una próspera comunidad de ingenieros rápidos y ofrece amplios recursos de formación. Los equipos pueden aprovechar las ventajas de los sistemas prediseñados «Ahorradores de tiempo», que son herramientas listas para usar diseñadas para aumentar la eficiencia.

La plataforma Programa de certificación rápida de ingenieros ayuda a las organizaciones a formar expertos internos en IA que pueden guiar a los equipos en la adopción de las mejores prácticas. Combinado con la incorporación y la formación prácticas, este enfoque impulsado por la comunidad garantiza que las empresas puedan aprovechar al máximo sus inversiones en IA y, al mismo tiempo, mejorar continuamente sus flujos de trabajo.

Kubeflow es una plataforma de código abierto diseñada para simplificar y escalar los flujos de trabajo de aprendizaje automático (ML), aprovechando la potencia de Kubernetes. Optimiza la implementación y la administración de las canalizaciones de aprendizaje automático en los entornos de producción mediante el uso de las capacidades de orquestación de contenedores de Kubernetes.

Kubeflow se integra a la perfección con la infraestructura de Kubernetes existente y las herramientas nativas de la nube, y ofrece soporte para una variedad de marcos de aprendizaje automático, como TensorFlow, PyTorch, XGBoost y scikit-learn. Esto elimina la preocupación por la dependencia de un solo proveedor, lo que brinda a los equipos la libertad de trabajar con las herramientas que prefieran.

Con Kubeflow Pipelines, las organizaciones pueden crear flujos de trabajo de aprendizaje automático que sean portátiles en entornos locales y en la nube. Esta flexibilidad es particularmente útil para las empresas que operan en configuraciones de múltiples nubes o que planifican migraciones de infraestructura. Los equipos pueden definir los flujos de trabajo una vez e implementarlos de manera uniforme en los entornos de desarrollo, preparación y producción, lo que garantiza la uniformidad y la confiabilidad.

Los servidores portátiles de la plataforma, que funcionan sin esfuerzo con herramientas como Júpiter, proporcionan una interfaz intuitiva para los científicos de datos. Estos servidores aprovechan las capacidades de administración de recursos de Kubernetes, lo que permite a los usuarios crear prototipos localmente y escalar experimentos sin cambiar sus flujos de trabajo de desarrollo. Esta estrecha integración sienta las bases para los procesos de aprendizaje automático automatizados y escalables.

Kubeflow transforma los flujos de trabajo de aprendizaje automático en canalizaciones automatizadas y repetibles. Al usar un lenguaje específico para un dominio, los equipos pueden definir flujos de trabajo que incluyan dependencias, lógica condicional y procesamiento paralelo, lo que facilita la administración de tareas complejas.

El escalado horizontal nativo de Kubernetes garantiza que los trabajos de formación puedan acceder de forma dinámica a recursos computacionales adicionales cuando sea necesario. Kubeflow puede implementar módulos adicionales en los nodos, distribuyendo las cargas de trabajo de manera eficiente y, al mismo tiempo, optimizando el uso de los recursos y controlando los costos.

El componente Katib mejora aún más la eficiencia al automatizar el ajuste de los hiperparámetros. Al ejecutar varios experimentos simultáneamente, Katib minimiza el tiempo dedicado a la optimización manual, lo que permite a los equipos centrarse en perfeccionar la arquitectura del modelo y la ingeniería de funciones.

Kubeflow prioriza los flujos de trabajo seguros y gobernados, esenciales para los entornos de producción. Al aprovechar el control de acceso basado en roles (RBAC) de Kubernetes, la plataforma proporciona una configuración de permisos detallada, lo que permite a las organizaciones definir quién puede acceder a espacios de nombres específicos, crear canalizaciones o modificar experimentos. Esto garantiza una gobernanza adecuada en todos los flujos de trabajo de aprendizaje automático.

Además, Kubeflow ofrece pistas de auditoría para las ejecuciones de canalizaciones, las ejecuciones de entrenamiento de modelos y los patrones de acceso a los datos. Estas funciones ayudan a las organizaciones a cumplir los requisitos reglamentarios y a simplificar la solución de problemas. Soporte para múltiples inquilinos permite que diferentes equipos o proyectos operen dentro de espacios de nombres aislados, cada uno con sus propios recursos y controles de acceso, lo que garantiza tanto la seguridad como la eficiencia.

Kubeflow incluye herramientas para administrar y controlar los costos de manera efectiva. Las cuotas de recursos a nivel de espacio de nombres ayudan a limitar el gasto de procesamiento, mientras que el uso de instancias puntuales o recursos informáticos que puedan interrumpirse de los principales proveedores de nube puede reducir los costos de capacitación para tareas no críticas que pueden tolerar interrupciones.

El almacenamiento en caché de canalización es otra función que ahorra costos, ya que reutiliza las salidas generadas anteriormente cuando las entradas permanecen sin cambios, lo que reduce tanto el tiempo de ejecución como el consumo de recursos.

Kubeflow promueve el trabajo en equipo a través de entornos de cuadernos compartidos y repositorios de canalización centralizados. Estas funciones permiten a los equipos compartir experimentos y reproducir los resultados, lo que fomenta la colaboración. Los científicos de datos con experiencia pueden crear plantillas que los miembros del equipo con menos experiencia pueden adaptar a necesidades específicas, lo que mejora la productividad en general.

La plataforma se beneficia de una próspera comunidad de código abierto, con contribuciones de organizaciones importantes como Google, IBM y Microsoft. Las reuniones comunitarias periódicas, los grupos de intereses especiales y la documentación detallada garantizan el apoyo continuo a los usuarios de todos los niveles de experiencia.

Kubeflow también se integra con herramientas como MLFlow, lo que permite a los equipos mantener sus flujos de trabajo actuales y, al mismo tiempo, aprovechar las capacidades de orquestación de Kubeflow. Esto facilita a las organizaciones la transición desde otras plataformas de aprendizaje automático sin interrumpir sus procesos.

Las funciones integrales de Kubeflow, desde la integración hasta la gobernanza, destacan cómo simplifica y agiliza los flujos de trabajo de la IA, lo que la convierte en una poderosa herramienta para las operaciones modernas de aprendizaje automático.

Apache Airflow es una plataforma de código abierto diseñada para crear, programar y monitorear flujos de trabajo mediante gráficos acíclicos dirigidos (DAG). Con el tiempo, se ha convertido en una solución de referencia para gestionar procesos complejos de inteligencia artificial y aprendizaje automático en una variedad de entornos.

Airflow destaca por su capacidad de conectar diferentes sistemas sin problemas. Con un amplio conjunto de operadores y enlaces, se integra sin esfuerzo con servicios populares como AWS, Google Cloud Platform, Azure, Copo de nieve, y Ladrillos de datos. Esta compatibilidad es particularmente valiosa para los flujos de trabajo de IA que dependen de varios proveedores de nube y diversas fuentes de datos.

El marco basado en Python de la plataforma permite a los usuarios definir los flujos de trabajo como código Python. Esta flexibilidad permite la creación dinámica de canalizaciones y la inclusión de una lógica condicional compleja, lo que resulta ideal para las canalizaciones de entrenamiento de modelos de IA que necesitan adaptarse en función de características de datos específicas.

El sistema XCom (comunicación cruzada) de Airflow facilita la transferencia de datos entre tareas, lo que crea transiciones fluidas entre pasos como el preprocesamiento de datos, el entrenamiento de modelos, la validación y la implementación. Los equipos también pueden desarrollar operadores personalizados para adaptarse a marcos de IA específicos, como TensorFlow, PyTorch o scikit-learn, lo que la convierte en una herramienta altamente adaptable para una amplia gama de proyectos de IA.

El planificador de Airflow automatiza los flujos de trabajo con precisión, gestionando los requisitos de tiempo y dependencia estándar e intrincados. Esto lo convierte en una opción excelente para tareas como el reentrenamiento regular de modelos o la inferencia por lotes.

Para aumentar la escalabilidad, Airflow ofrece opciones como CeleryExecutor y KubernetesExecutor, que distribuyen las cargas de trabajo entre varios nodos de trabajo. Esta configuración permite que los recursos informáticos se escalen de forma dinámica en función de la demanda de las tareas, lo que permite el procesamiento simultáneo de varios experimentos sin supervisión manual.

La ejecución de tareas en paralelo es otra característica clave, especialmente útil para los flujos de trabajo de IA que implican operaciones independientes. Las tareas como la ingeniería de funciones, el ajuste de hiperparámetros y la validación de modelos pueden ejecutarse de forma simultánea, lo que reduce considerablemente los tiempos generales de ejecución del proceso.

Para mejorar la confiabilidad, los usuarios pueden configurar las tareas con funciones como el retroceso exponencial, la lógica de reintento personalizada y las notificaciones de errores, lo que garantiza que los flujos de trabajo se mantengan sólidos incluso cuando surjan problemas de infraestructura.

Airflow proporciona un registro detallado de las tareas, un control de acceso basado en roles (RBAC) para permisos granulares y la integración con sistemas de administración secretos para proteger los datos confidenciales. Estas funciones no solo mejoran la seguridad, sino que también ayudan a los equipos a rastrear el origen de los procesos de formación modelo, garantizando el cumplimiento de las normas reglamentarias.

La plataforma admite conexiones cifradas y se integra con herramientas como Bóveda de HashiCorp o almacenes secretos nativos de la nube para proteger la información crítica, como las credenciales de bases de datos y las claves de API. Además, sus funciones de seguimiento del linaje de datos permiten a las organizaciones rastrear cómo se mueven los datos a través de las canalizaciones de IA, lo que contribuye tanto a los esfuerzos de depuración como a las auditorías de cumplimiento.

La programación basada en los recursos de Airflow ayuda a optimizar los costos de procesamiento al distribuir las tareas de manera eficiente en la infraestructura disponible. Permite el uso de opciones rentables, como las instancias puntuales y las que pueden interrumpirse, lo que la convierte en una opción económica para los flujos de trabajo intensivos de IA.

La agrupación de tareas mejora aún más la administración de recursos al limitar la cantidad de ejecuciones simultáneas para las operaciones que consumen muchos recursos. Esto resulta especialmente beneficioso cuando se ejecutan varios trabajos de entrenamiento de IA que exigen importantes recursos de GPU o memoria.

Las funciones de monitoreo y alerta de la plataforma brindan visibilidad del uso de los recursos, lo que ayuda a los equipos a identificar las áreas de optimización. Las métricas como la duración de las tareas, el consumo de recursos y la profundidad de las colas ofrecen información valiosa para ajustar los flujos de trabajo.

Airflow fomenta la colaboración al fomentar las definiciones del flujo de trabajo en el código, lo que permite a los equipos aprovechar prácticas como el control de versiones y las revisiones de código. Este enfoque garantiza la transparencia y la coherencia en el desarrollo del flujo de trabajo.

La plataforma cuenta con el respaldo de una próspera comunidad de colaboradores. Las reuniones periódicas de la comunidad, la documentación detallada y los extensos repositorios de ejemplos facilitan a las organizaciones la adopción e implementación de la orquestación del flujo de trabajo mediante IA con Airflow.

Los desarrolladores pueden compartir plantillas para casos de uso comunes de la IA, como el entrenamiento, la validación y la implementación de modelos, promoviendo las mejores prácticas reutilizables. Además, la arquitectura de complementos permite a los equipos crear extensiones personalizadas y, al mismo tiempo, mantener la compatibilidad con las funciones principales de Airflow, lo que añade aún más flexibilidad a esta potente herramienta.

El prefecto Orion sigue un modelo de responsabilidad compartida. En esta configuración, Prefect se encarga del plano de control de la orquestación, que incluye la gestión del almacenamiento de metadatos, la programación, los servicios de API, la autenticación y la administración de usuarios. Este enfoque garantiza una alta disponibilidad constante, un escalado automático y una prestación de servicios fiable. Al alinearse con las funciones de automatización avanzadas mencionadas anteriormente, este marco de gobierno mejora la eficiencia operativa de la plataforma.

Flyte es una plataforma totalmente de código abierto diseñada para organizar los flujos de trabajo, especialmente para proyectos de aprendizaje automático y ciencia de datos. Su gestión por parte de una fundación de código abierto garantiza que siga siendo una herramienta centrada en la comunidad.

La estructura de gobierno de Flyte, mantenida por su Fundación de código abierto, ofrece una supervisión transparente y funciones como el control de versiones nativo para registros de auditoría confiables. Sus interfaces altamente tipadas protegen la integridad de los datos y documentan automáticamente su procedencia, lo que las convierte en una opción fiable para las organizaciones que priorizan la seguridad y la responsabilidad. Estas funciones también mejoran la capacidad de la plataforma para automatizar los procesos de manera eficaz.

La arquitectura de seguridad de tipos de la plataforma está diseñada para detectar los desajustes de tipos y los errores de formato de datos antes de que se ejecuten los flujos de trabajo. Este método preventivo detección de errores garantiza una ejecución más fluida de las canalizaciones de IA complejas, lo que reduce la necesidad de correcciones manuales y aumenta la confiabilidad general. Esta fiabilidad técnica facilita a los equipos la escalar sus operaciones de manera eficiente.

Flyte prospera bajo la gobernanza de su Fundación de código abierto, que fomenta una comunidad activa y diversa de colaboradores de varias organizaciones. Su enfoque en la reproducibilidad garantiza que los flujos de trabajo sean consistentes, lo que simplifica la colaboración en equipo y facilita el proceso de incorporación de nuevos miembros.

CrewAI es un marco de Python independiente diseñado para coordinar varios agentes de IA, lo que ofrece una ejecución más rápida y resultados confiables para flujos de trabajo complejos.

La arquitectura de CrewAI garantiza una integración fluida en varios ecosistemas de IA. Funciona con cualquier modelo lingüístico o plataforma en la nube de gran tamaño, y también admite modelos locales a través de herramientas como Ollama y Estudio LM. Esta flexibilidad permite a las organizaciones seguir con sus modelos preferidos. Sus interfaces RESTful y sus configuraciones de webhooks simplifican las conexiones de sistemas externos al administrar automáticamente la autenticación, los límites de velocidad y la recuperación de errores. Los flujos de CrewAI mejoran aún más la integración al conectarse con bases de datos, API e interfaces de usuario. Combinan diferentes patrones de interacción de la IA, como los equipos de agentes colaborativos, las llamadas directas de LLM y la lógica procedimental.

Por ejemplo, Nodo latente se ha integrado con éxito con CrewAI, vinculando a los agentes con sistemas empresariales como CRM, bases de datos y herramientas de comunicación a través de su generador de flujo de trabajo visual y más de 300 integraciones prediseñadas. Esta configuración permitía realizar tareas como sincronizar los resultados con las hojas de cálculo de Google o activar las notificaciones de Slack en función de los eventos del flujo de trabajo. Esta integración perfecta allana el camino para una automatización eficiente y soluciones escalables.

CrewAI lleva la automatización y la escalabilidad al siguiente nivel, aprovechando sus funciones de interoperabilidad. Su arquitectura optimizada y su base de código optimizada permiten una ejecución 1,76 veces más rápida de las tareas de control de calidad. La plataforma también incluye herramientas integradas para el raspado web, el procesamiento de archivos y las interacciones de API, lo que reduce la necesidad de dependencias adicionales y simplifica la administración del flujo de trabajo. Los equipos pueden definir procesos empresariales complejos mediante archivos de configuración YAML o scripts de Python, lo que permite crear interacciones entre agentes, flujos de datos y árboles de decisión detallados. Este enfoque permite a las organizaciones gestionar flujos de trabajo escalables sin necesidad de conocimientos avanzados de programación.

La comunidad CrewAI continúa expandiéndose, obteniendo el reconocimiento de los líderes de la industria. Ben Tossell, fundador de Ben's Bites, elogió el marco diciendo:

«Es el mejor marco de agentes que existe y se están introduciendo mejoras como ninguna otra que haya visto antes».

Los desarrolladores pueden mejorar CrewAI creando agentes Python personalizados o diseñando cuadrillas y flujos estructurados, lo que facilita la gestión de las interacciones entre los agentes a mayor escala.

IBM watsonx Orchestrate es una potente herramienta empresarial diseñada para agilizar y automatizar los flujos de trabajo de IA complejos, conectando sin problemas varias aplicaciones empresariales.

Al utilizar API REST y conectores personalizados, IBM watsonx Orchestrate cierra la brecha entre los sistemas más antiguos y las plataformas modernas. Es compatible con despliegues locales y basados en la nube, y ofrece flexibilidad para adaptarse a las diferentes necesidades operativas.

La plataforma proporciona una interfaz intuitiva que simplifica la creación y el despliegue de flujos de trabajo automatizados, incluso para usuarios con conocimientos técnicos limitados. Está diseñada para gestionar cargas de trabajo fluctuantes y garantizar un rendimiento fiable durante las horas punta.

IBM watsonx Orchestrate prioriza la seguridad de nivel empresarial con controles de acceso avanzados, medidas sólidas de protección de datos y una supervisión exhaustiva. Estas funciones garantizan el cumplimiento y mantienen la transparencia en todas las operaciones.

Con herramientas para el seguimiento de los recursos en tiempo real y la optimización de costos, la plataforma permite a las empresas realizar ajustes informados en los flujos de trabajo. Estas capacidades se integran sin esfuerzo con los sistemas empresariales, lo que ayuda a las empresas a mantener operaciones de inteligencia artificial eficientes y escalables.

Workato proporciona una plataforma potente que conecta varios sistemas y simplifica la automatización del flujo de trabajo de la IA. Al actuar como un enlace vital entre las aplicaciones empresariales y los procesos impulsados por la inteligencia artificial, garantiza una integración perfecta y un rendimiento fiable, al tiempo que admite la escalabilidad necesaria para satisfacer las crecientes demandas.

Workato destaca por su capacidad de conectar diversos sistemas mediante una amplia biblioteca de más de 1000 conectores prediseñados, junto con la compatibilidad con API REST, webhooks e integraciones personalizadas. Facilita el intercambio fluido de datos entre los sistemas antiguos, las aplicaciones en la nube y las herramientas de inteligencia artificial modernas, eliminando de forma eficaz los silos de datos que a menudo interrumpen los flujos de trabajo de la IA. Gracias a su estructura de conectores universales, las empresas pueden integrar casi cualquier sistema, desde herramientas de CRM como Fuerza de ventas a almacenes de datos y puntos finales de modelos de IA, lo que permite canalizaciones de datos consistentes que impulsan los procesos de IA de manera eficiente.

Workato simplifica la creación de flujos de trabajo de IA avanzados mediante su generador visual de recetas, lo que permite a los usuarios diseñar una lógica de orquestación compleja sin necesidad de contar con una amplia experiencia en codificación. La plataforma gestiona las dependencias en las distintas etapas de los flujos de trabajo de la IA, como el preprocesamiento de datos, el entrenamiento de modelos y la implementación, al tiempo que escala los recursos de forma dinámica para cumplir con los requisitos de la carga de trabajo. Su infraestructura de nivel empresarial admite el procesamiento de grandes volúmenes de datos y gestiona miles de flujos de trabajo que se ejecutan simultáneamente, lo que la convierte en una excelente opción para las organizaciones que gestionan varios proyectos de IA en distintos departamentos y casos de uso.

Las herramientas de orquestación nativas de la nube de los principales proveedores, como AWS, Azure y Google, ofrecen flujos de trabajo escalables y sin problemas adaptados a sus ecosistemas. Estas plataformas optimizan todo el ciclo de vida del aprendizaje automático, desde la preparación de los datos hasta la implementación del modelo, lo que las convierte en un valor incalculable para las empresas que buscan soluciones integradas.

Cada plataforma se destaca por su conexión con su ecosistema más amplio y por su compatibilidad con diversos marcos de aprendizaje automático:

Estas integraciones no solo agilizan los procesos, sino que también permiten el escalado dinámico, lo que garantiza la flexibilidad y la eficiencia en el manejo de diversas cargas de trabajo.

La automatización y la escalabilidad son la base de estas plataformas, lo que permite a las organizaciones gestionar flujos de trabajo complejos de IA con facilidad:

Esta sección profundiza en las ventajas y limitaciones únicas de cada plataforma, y ofrece una comprensión clara de cómo se comparan entre sí. Al examinar estas diferencias, las organizaciones pueden alinear sus elecciones con objetivos, necesidades técnicas y presupuestos específicos. La siguiente descripción general proporciona el contexto para una comparación detallada en paralelo de las características clave.

Prompts.ai ofrece una solución simplificada para el desafío de administrar múltiples herramientas de IA. Con acceso a más de 35 modelos lingüísticos a través de una interfaz unificada, elimina la necesidad de tener que hacer malabares con numerosas suscripciones. Sus capacidades FinOps integradas permiten el seguimiento y la optimización de los costos en tiempo real, con el potencial de reducir los gastos de software de inteligencia artificial hasta en un 98%. Sin embargo, para las organizaciones que invierten mucho en entornos de nube específicos, las soluciones nativas de la nube pueden proporcionar una integración más fluida con los sistemas existentes.

Kubeflow brilla en las configuraciones nativas de Kubernetes, ya que ofrece sólidas capacidades de MLOps y se beneficia del sólido apoyo de la comunidad. Su diseño modular permite a los equipos seleccionar y elegir los componentes según sea necesario. Por el lado negativo, Kubeflow exige conocimientos avanzados de Kubernetes, lo que puede ser un obstáculo para los equipos más pequeños que carecen de recursos de DevOps dedicados.

Flujo de aire Apache es un nombre confiable en la gestión de flujos de trabajo, conocido por su amplio ecosistema de complementos y su confiabilidad comprobada en varios sectores. Su marco basado en Python atrae tanto a los científicos de datos como a los ingenieros. Dicho esto, puede tener dificultades con el procesamiento en tiempo real y puede consumir muchos recursos a medida que los flujos de trabajo se amplíen, lo que requiere una planificación cuidadosa de los recursos.

Prefecto Orión aborda algunas de las limitaciones de Airflow, especialmente en las implementaciones de nube híbrida. Su arquitectura moderna, su interfaz fácil de usar y su gestión de errores mejorada facilitan su uso. Sin embargo, como plataforma más nueva, ofrece menos integraciones de terceros y una comunidad más pequeña en comparación con las opciones más establecidas.

Flyte destaca por sus sólidas funciones de reproducibilidad y seguimiento del linaje de datos, lo que la convierte en una opción sólida para las organizaciones centradas en la investigación. Su enfoque basado en la seguridad de tipos minimiza los errores de ejecución y aumenta la confiabilidad del flujo de trabajo. Sin embargo, conlleva una curva de aprendizaje más pronunciada, especialmente para los equipos que no están familiarizados con sus paradigmas únicos.

Tripulación AI simplifica los flujos de trabajo de IA de múltiples agentes, proporcionando un marco intuitivo para coordinar varios agentes de IA. Si bien funciona bien en casos de uso específicos relacionados con la colaboración de agentes, es posible que carezca de la profundidad de orquestación necesaria para los flujos de trabajo empresariales más complejos.

IBM watsonx Orchestrate se integra a la perfección con el ecosistema de IA de IBM y ofrece sólidas funciones de gobierno adaptadas a las necesidades empresariales. Sin embargo, su atractivo puede ser limitado para las organizaciones que aún no han invertido en el conjunto de tecnologías de IBM, especialmente si se compara con las alternativas independientes de los proveedores.

Trabaja en sobresale en la automatización de los procesos empresariales, ya que ofrece más de 1000 conectores prediseñados. Si bien es muy eficaz para los flujos de trabajo tradicionales, es posible que sus capacidades no se extiendan tan bien a la gestión de modelos de IA complejos.

Esta es una tabla comparativa que resume los diferenciadores clave:

En lo que respecta a los costos, las plataformas nativas de la nube generalmente funcionan con precios de pago por uso y se escalan con el uso. Por el contrario, las plataformas empresariales como IBM watsonx Orchestrate suelen implicar importantes tarifas de licencia iniciales.

La selección de la plataforma adecuada a menudo implica equilibrar las necesidades de gobierno con la complejidad de la implementación. Los equipos que priorizan la rentabilidad y la flexibilidad en varios modelos pueden inclinarse por Prompts.ai, mientras que aquellos que están profundamente integrados en ecosistemas de nube específicos pueden encontrar más prácticas las plataformas nativas de la nube, a pesar de los gastos a largo plazo potencialmente más altos.

La organización eficaz de los flujos de trabajo de la IA es clave para sincronizar procesos complejos y lograr resultados significativos. La selección de la plataforma adecuada depende de las necesidades específicas, la experiencia técnica y los objetivos a largo plazo de su organización. El mercado actual ofrece una variedad de opciones, desde plataformas empresariales integrales hasta servicios nativos de la nube, cada una de las cuales se adapta a requisitos únicos.

Para las empresas que hacen malabares con múltiples herramientas de IA y el aumento de los costos, Prompts.ai se destaca como una solución para la administración centralizada y la rentabilidad. Si su equipo conoce bien Kubernetes, Kubeflow proporciona un marco modular diseñado para flujos de trabajo con muchos MLOPS. Sin embargo, los equipos más pequeños sin recursos de DevOps dedicados pueden encontrar que su complejidad es un desafío. Por otro lado, Flujo de aire Apache sigue siendo una opción ideal para los equipos de datos establecidos debido a su confiabilidad y su amplio ecosistema de complementos, aunque escalar los flujos de trabajo con Airflow exige una asignación cuidadosa de los recursos. Para las organizaciones que se centran en la arquitectura moderna, Prefecto Orión ofrece una alternativa fácil de usar que aborda algunas de las limitaciones de Airflow. Mientras tanto, los equipos que se dedican a la investigación pueden beneficiarse de Flyte, que destaca por sus capacidades especializadas, pero requiere tiempo para dominar su enfoque único.

Al abordar la orquestación del flujo de trabajo de la IA, es crucial tener en cuenta la gobernanza, la facilidad de implementación y la estructura de costos. Las plataformas unificadas como Prompts.ai son ideales para los equipos que necesitan flexibilidad en varios modelos de IA y, al mismo tiempo, mantener los gastos bajo control. Por el contrario, las organizaciones que ya están integradas en ecosistemas de nube específicos pueden optar por opciones nativas de la nube, incluso si conllevan costos más altos a largo plazo.

En última instancia, el éxito en la orquestación de la IA radica en alinear las funciones de la plataforma con los objetivos y la preparación técnica de su organización. Empieza por identificar tus puntos débiles y evaluar la capacidad de tu equipo. Después, elige una plataforma que pueda evolucionar junto con tus iniciativas de IA.

Al elegir una plataforma de orquestación de flujos de trabajo de IA, es crucial sopesar varios factores importantes. Comience por evaluar la plataforma escalabilidad, garantizando que pueda crecer a la par de sus necesidades. Comprueba su compatibilidad con sus herramientas y sistemas actuales, ya que una integración perfecta minimiza las interrupciones. Además, busque funciones que se adapten a sus necesidades requisitos específicos de la industria, lo que puede marcar una diferencia significativa a la hora de hacer frente a desafíos únicos.

Otro aspecto crítico es qué tan bien se maneja la plataforma integración de datos, gestión de modelos, y gobernanza. Estas capacidades garantizan un funcionamiento fluido, una mejor supervisión y el cumplimiento de las normativas necesarias. No olvide alinear su elección con los recursos técnicos y los planes de expansión futuros de su organización. Una plataforma completa debería simplificar los flujos de trabajo, mejorar la eficiencia operativa y respaldar el crecimiento a largo plazo. Al centrarse en estos factores, puede seleccionar una solución que refuerce sus flujos de trabajo de IA y se alinee con sus objetivos estratégicos.

Prompts.ai reduce los gastos de software de IA en automatizar los flujos de trabajo y consolidar el acceso a los modelos de IA, lo que ayuda a las empresas a reducir drásticamente los costos operativos. Al reducir la necesidad de intervenciones manuales y simplificar los procesos, las organizaciones pueden aumentar la eficiencia y ahorrar hasta un 98%.

Este enfoque simplificado no solo reduce los costos, sino que también optimiza los presupuestos de los proyectos de IA, lo que permite una asignación de recursos más inteligente. Con estos ahorros, los equipos pueden ampliar sus esfuerzos de inteligencia artificial de manera más rentable y, al mismo tiempo, garantizar un rendimiento y una fiabilidad de primer nivel.

Las soluciones nativas de la nube destacan por su escalabilidad gracias a funciones como la asignación elástica de recursos, el escalado automático y los servicios sin estado. Estas herramientas permiten a los sistemas gestionar el aumento de las cargas de trabajo de forma eficaz y, al mismo tiempo, mantener la resiliencia. Además, se integran sin problemas con los servicios y microservicios en la nube, lo que permite despliegues más rápidos y una mejor compatibilidad entre plataformas.

Por el contrario, las plataformas tradicionales suelen depender de escalado vertical, lo que implica aumentar los recursos de los servidores existentes. Este método tiene sus límites, tanto físicos como en términos de flexibilidad, lo que a menudo conlleva un sobreaprovisionamiento y desafíos a la hora de integrarse con sistemas distribuidos modernos. Para las empresas que buscan optimizar los flujos de trabajo de inteligencia artificial, las soluciones nativas de la nube ofrecen una base más flexible y con visión de futuro.