Orchestration des flux de travail basés sur l'IA est l'épine dorsale des systèmes d'intelligence artificielle modernes, garantissant une intégration fluide entre les modèles, les sources de données et les processus. Contrairement aux flux de travail traditionnels rigides, l'orchestration de l'IA s'adapte de manière dynamique, automatise les tâches, connecte les systèmes et optimise la prise de décision. Vous trouverez ci-dessous 9 plateformes de premier plan pour l'orchestration des flux de travail basés sur l'IA, chacun offrant des fonctionnalités uniques pour répondre à des besoins organisationnels spécifiques :

Ces plateformes répondent à des besoins variés, qu'il s'agisse d'économies de coûts, de gouvernance, d'évolutivité et d'intégration. Choisissez en fonction des objectifs, de l'expertise technique et de l'infrastructure existante de votre organisation.

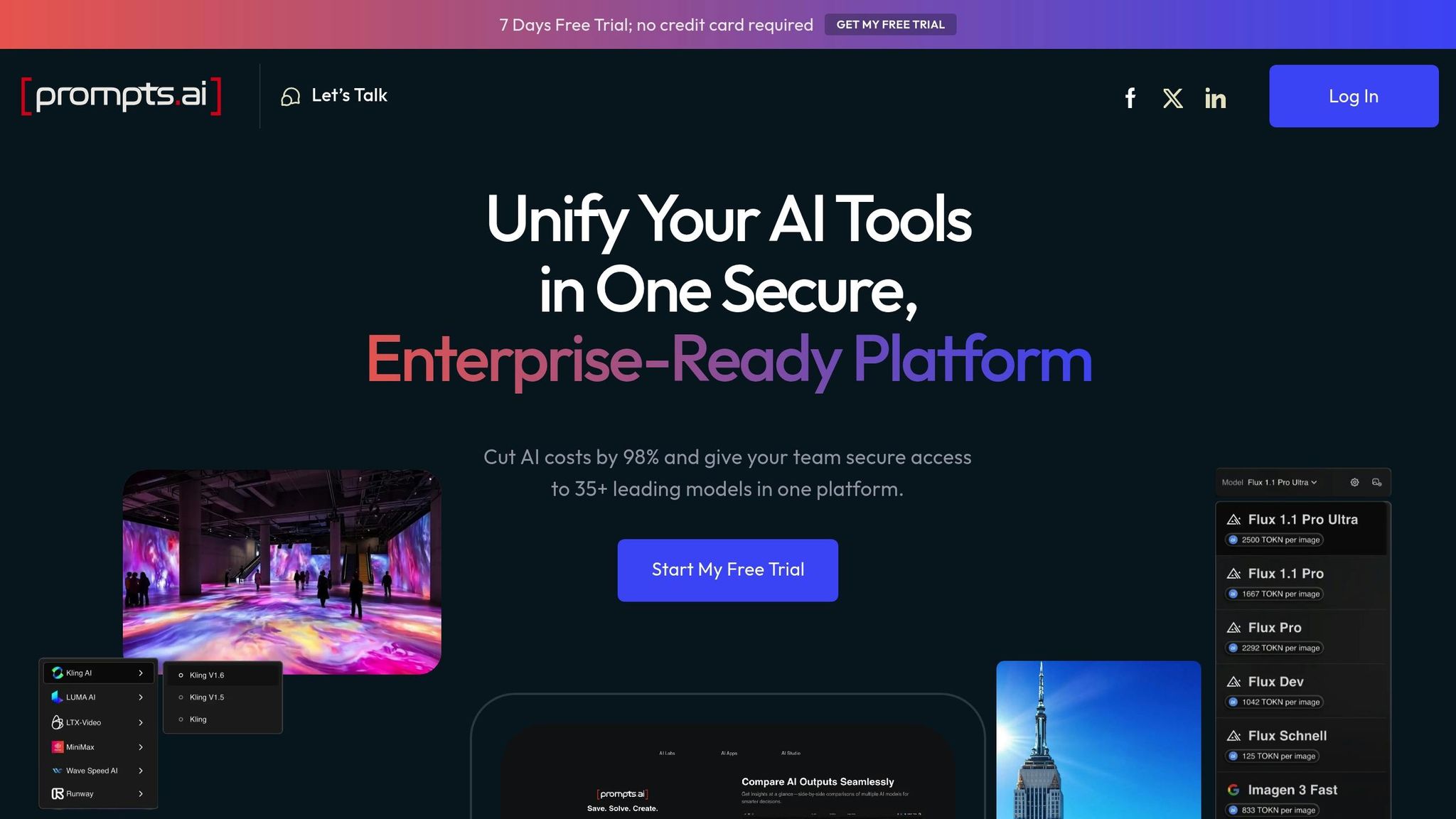

Prompts.ai réunit plus de 35 grands modèles de langage de premier plan, dont GPT-4, Claude, LLama et Gemini, au sein d'une interface sécurisée et unifiée. En relevant le défi de la prolifération des outils, la plateforme garantit des flux de travail d'IA rationalisés tout en donnant la priorité à la gouvernance et à la rentabilité.

L'une des caractéristiques les plus remarquables de Prompts.ai est sa capacité à intégrer divers modèles d'IA sur une plateforme unique. Au lieu de jongler entre plusieurs abonnements et interfaces, les organisations peuvent accéder à des modèles tels que GPT-4, Claude et Gemini en un seul endroit. Cela élimine les tracas liés au passage d'un outil à l'autre et garantit un flux de travail plus fluide.

La plateforme prend également en charge tests de performance côte à côte, où les équipes peuvent exécuter la même invite sur plusieurs modèles simultanément. Cette fonctionnalité est précieuse pour déterminer quel modèle convient le mieux à des tâches spécifiques sans avoir à gérer des plateformes distinctes. Cette configuration unifiée simplifie l'automatisation et ouvre la voie à une mise à l'échelle des opérations d'IA sans effort.

Prompts.ai transforme les efforts expérimentaux en matière d'IA en flux de travail cohérents et standardisés. Les équipes peuvent créer des flux de travail reproductibles qui uniformisent les projets et les départements. Cette cohérence devient essentielle à mesure que les organisations étendent leurs initiatives d'IA, qu'il s'agisse d'essais à petite échelle ou de déploiements à l'échelle de l'entreprise.

La conception de la plateforme permet une mise à l'échelle rapide, permettant aux organisations d'ajouter de nouveaux modèles, utilisateurs ou équipes en quelques minutes seulement. Avec ses Crédits TOKN payables à l'utilisation système, Prompts.ai élimine le besoin de frais d'abonnement fixes, permettant aux entreprises d'aligner les coûts sur l'utilisation réelle. Cette flexibilité permet d'augmenter ou de réduire facilement l'échelle en fonction de l'évolution des besoins, évitant ainsi des dépenses inutiles.

La gouvernance est au cœur du framework de Prompts.ai. La plateforme propose visibilité et contrôle complets sur toutes les interactions avec l'IA, avec des pistes d'audit détaillées qui suivent l'utilisation des modèles, des équipes et des applications. Cette transparence est cruciale pour répondre aux exigences de conformité à grande échelle.

Pour répondre aux problèmes de sécurité, la plateforme garantit que les données sensibles restent sous le contrôle de l'organisation. Grâce à des fonctionnalités de sécurité et à des outils de conformité intégrés, les entreprises peuvent déployer en toute confiance des flux de travail d'IA tout en respectant leurs protocoles de sécurité et leurs normes réglementaires.

Prompts.ai s'attaque aux coûts cachés de l'IA grâce à son couche FinOps intégrée, qui suit chaque jeton, fournit un suivi des coûts en temps réel et relie les dépenses aux résultats commerciaux. Cette transparence aide les organisations à comprendre leurs dépenses en matière d'IA et à ajuster les dépenses si nécessaire.

En consolidant plusieurs outils d'IA sur une seule plateforme avec une tarification basée sur l'utilisation, Prompts.ai peut réduire les coûts des logiciels d'IA jusqu'à 98 %. Cette approche permet non seulement d'économiser de l'argent, mais garantit également l'accès à un large éventail de modèles d'IA de pointe sans avoir à gérer des abonnements distincts.

Prompts.ai soutient une entreprise florissante communauté d'ingénieurs rapides et propose de nombreuses ressources de formation. Les équipes peuvent tirer parti de fonctionnalités prédéfinies « Des gains de temps », qui sont des outils prêts à l'emploi conçus pour améliorer l'efficacité.

La plateforme Programme de certification Prompt Engineer aide les organisations à former des experts internes en IA capables de guider les équipes dans l'adoption des meilleures pratiques. Combinée à une intégration et à une formation pratiques, cette approche axée sur la communauté permet aux entreprises de tirer pleinement parti de leurs investissements dans l'IA tout en améliorant continuellement leurs flux de travail.

Kubeflow est une plateforme open source conçue pour simplifier et faire évoluer les flux de travail d'apprentissage automatique (ML), en tirant parti de la puissance de Kubernetes. Il rationalise le déploiement et la gestion des pipelines de machine learning dans les environnements de production en utilisant les fonctionnalités d'orchestration de conteneurs de Kubernetes.

Kubeflow s'intègre parfaitement à l'infrastructure Kubernetes existante et aux outils natifs du cloud, offrant une prise en charge de divers frameworks de machine learning tels que TensorFlow, PyTorch, XGBoost et scikit-learn. Cela élimine les problèmes liés à la dépendance vis-à-vis des fournisseurs, donnant aux équipes la liberté de travailler avec les outils qu'elles préfèrent.

Avec Kubeflow Pipelines, les entreprises peuvent créer des flux de travail de machine learning portables dans des environnements cloud et sur site. Cette flexibilité est particulièrement utile pour les entreprises opérant dans des configurations multicloud ou planifiant des migrations d'infrastructures. Les équipes peuvent définir les flux de travail une seule fois et les déployer de manière cohérente dans les environnements de développement, de préparation et de production, garantissant ainsi uniformité et fiabilité.

Les serveurs portables de la plateforme, qui fonctionnent sans effort avec des outils tels que Jupiter, fournissent une interface intuitive aux data scientists. Ces serveurs exploitent les fonctionnalités de gestion des ressources de Kubernetes, permettant aux utilisateurs de prototyper localement et de développer des expériences sans modifier leurs flux de travail de développement. Cette intégration étroite jette les bases de processus de machine learning automatisés et évolutifs.

Kubeflow transforme les flux de travail ML en pipelines automatisés et répétables. À l'aide d'un langage spécifique au domaine, les équipes peuvent définir des flux de travail qui incluent des dépendances, une logique conditionnelle et un traitement parallèle, ce qui facilite la gestion des tâches complexes.

La mise à l'échelle horizontale native de Kubernetes garantit que les tâches de formation peuvent accéder dynamiquement à des ressources de calcul supplémentaires en cas de besoin. Kubeflow peut déployer des pods supplémentaires sur les nœuds, distribuant ainsi efficacement les charges de travail tout en optimisant l'utilisation des ressources et en contrôlant les coûts.

Le composant Katib améliore encore l'efficacité en automatisant le réglage des hyperparamètres. En exécutant plusieurs expériences simultanément, Katib réduit le temps consacré à l'optimisation manuelle, ce qui permet aux équipes de se concentrer sur l'amélioration de l'architecture des modèles et de l'ingénierie des fonctionnalités.

Kubeflow donne la priorité aux flux de travail sécurisés et gérés, essentiels pour les environnements de production. En tirant parti du contrôle d'accès basé sur les rôles (RBAC) de Kubernetes, la plateforme fournit des paramètres d'autorisation détaillés, permettant aux organisations de définir qui peut accéder à des espaces de noms spécifiques, créer des pipelines ou modifier des expériences. Cela garantit une gouvernance adéquate des flux de travail de machine learning.

En outre, Kubeflow propose des pistes d'audit pour les exécutions de pipelines, les cycles d'entraînement des modèles et les modèles d'accès aux données. Ces fonctionnalités aident les entreprises à respecter les exigences réglementaires et à simplifier le dépannage. Prise en charge de plusieurs locataires permet à différentes équipes ou projets de fonctionner dans des espaces de noms isolés, chacun disposant de ses propres ressources et contrôles d'accès, garantissant à la fois sécurité et efficacité.

Kubeflow inclut des outils permettant de gérer et de contrôler les coûts de manière efficace. Les quotas de ressources au niveau de l'espace de noms permettent de limiter les dépenses de calcul, tandis que l'utilisation d'instances ponctuelles ou de ressources de calcul préemptives provenant des principaux fournisseurs de cloud peut réduire les coûts de formation pour les tâches non critiques qui peuvent tolérer des interruptions.

La mise en cache des pipelines est une autre fonctionnalité permettant de réaliser des économies, car elle permet de réutiliser les sorties précédemment générées lorsque les entrées restent inchangées, ce qui réduit à la fois le temps d'exécution et la consommation de ressources.

Kubeflow favorise le travail d'équipe grâce à des environnements de blocs-notes partagés et à des référentiels de pipelines centralisés. Ces fonctionnalités permettent aux équipes de partager des expériences et de reproduire les résultats, favorisant ainsi la collaboration. Les data scientists expérimentés peuvent créer des modèles que les membres les moins expérimentés de l'équipe peuvent adapter à des besoins spécifiques, améliorant ainsi la productivité à tous les niveaux.

La plateforme bénéficie d'une communauté open source florissante, avec la contribution de grandes organisations telles que Google, IBM et Microsoft. Des réunions communautaires régulières, des groupes d'intérêts spéciaux et une documentation détaillée garantissent un soutien continu aux utilisateurs de tous niveaux d'expérience.

Kubeflow s'intègre également à des outils tels que Débit ML, permettant aux équipes de maintenir leurs flux de travail existants tout en tirant parti des capacités d'orchestration de Kubeflow. Cela permet aux organisations de passer plus facilement d'autres plateformes de machine learning sans perturber leurs processus.

Les fonctionnalités complètes de Kubeflow, de l'intégration à la gouvernance, mettent en évidence la façon dont il simplifie et rationalise les flux de travail d'IA, ce qui en fait un outil puissant pour les opérations de machine learning modernes.

Apache Airflow est une plateforme open source conçue pour créer, planifier et surveiller des flux de travail à l'aide de graphes acycliques dirigés (DAG). Au fil du temps, elle est devenue une solution incontournable pour gérer des pipelines complexes d'IA et d'apprentissage automatique dans divers environnements.

Airflow se distingue par sa capacité à connecter différents systèmes de manière fluide. Grâce à un riche ensemble d'opérateurs et de crochets, il s'intègre facilement à des services populaires tels qu'AWS, Google Cloud Platform, Azure, Flocon de neige, et Databricks. Cette compatibilité est particulièrement utile pour les flux de travail d'IA qui s'appuient sur plusieurs fournisseurs de cloud et diverses sources de données.

Le framework basé sur Python de la plateforme permet aux utilisateurs de définir des flux de travail sous forme de code Python. Cette flexibilité permet de créer des pipelines dynamiques et d'inclure une logique conditionnelle complexe, ce qui est idéal pour les pipelines d'entraînement de modèles d'IA qui doivent s'adapter en fonction de caractéristiques de données spécifiques.

Le système XCom (communication croisée) d'Airflow facilite le transfert de données entre les tâches, créant ainsi des transitions fluides entre les étapes telles que le prétraitement des données, la formation des modèles, la validation et le déploiement. Les équipes peuvent également développer des opérateurs personnalisés adaptés à des frameworks d'IA spécifiques, tels que TensorFlow, PyTorch ou scikit-learn, ce qui en fait un outil hautement adaptable pour un large éventail de projets d'IA.

Le planificateur d'Airflow automatise les flux de travail avec précision, en gérant à la fois les exigences de synchronisation et de dépendance standard et complexes. Cela en fait un excellent choix pour des tâches telles que la reconversion régulière de modèles ou l'inférence par lots.

Pour des raisons d'évolutivité, Airflow propose des options telles que CeleryExecutor et KubernetesExecutor, qui répartissent les charges de travail sur plusieurs nœuds de travail. Cette configuration permet aux ressources de calcul d'évoluer de manière dynamique en fonction de la demande des tâches, ce qui permet le traitement simultané de plusieurs expériences sans supervision manuelle.

L'exécution de tâches en parallèle est une autre caractéristique clé, particulièrement utile pour les flux de travail d'IA impliquant des opérations indépendantes. Des tâches telles que l'ingénierie des fonctionnalités, le réglage des hyperparamètres et la validation des modèles peuvent être exécutées simultanément, ce qui réduit considérablement les temps d'exécution globaux du pipeline.

Pour améliorer la fiabilité, les utilisateurs peuvent configurer les tâches à l'aide de fonctionnalités telles que l'arrêt exponentiel, la logique de nouvelle tentative personnalisée et les notifications d'échec, garantissant ainsi la robustesse des flux de travail même en cas de problèmes d'infrastructure.

Airflow fournit une journalisation détaillée des tâches, un contrôle d'accès basé sur les rôles (RBAC) pour des autorisations granulaires et une intégration avec des systèmes de gestion des secrets pour sécuriser les données sensibles. Ces fonctionnalités améliorent non seulement la sécurité, mais aident également les équipes à suivre l'origine des modèles de processus de formation, garantissant ainsi la conformité aux normes réglementaires.

La plateforme prend en charge les connexions cryptées et s'intègre à des outils tels que Coffre-fort HashiCorp ou des magasins secrets natifs du cloud pour protéger les informations critiques, telles que les informations d'identification de base de données et les clés d'API. En outre, ses fonctionnalités de suivi du lignage des données permettent aux entreprises de suivre la façon dont les données circulent dans les pipelines d'IA, ce qui facilite à la fois les efforts de débogage et les audits de conformité.

La planification adaptée aux ressources d'Airflow permet d'optimiser les coûts de calcul en répartissant efficacement les tâches sur l'infrastructure disponible. Il prend en charge l'utilisation d'options rentables telles que les instances ponctuelles et préemptives, ce qui en fait un choix économique pour les flux de travail d'IA intensifs.

Le regroupement des tâches améliore encore la gestion des ressources en limitant le nombre d'exécutions simultanées pour les opérations gourmandes en ressources. Cela est particulièrement utile lorsque vous exécutez plusieurs tâches de formation à l'IA qui nécessitent des ressources GPU ou mémoire importantes.

Les fonctionnalités de surveillance et d'alerte de la plateforme fournissent une visibilité sur l'utilisation des ressources, aidant les équipes à identifier les domaines à optimiser. Des indicateurs tels que la durée des tâches, la consommation de ressources et la profondeur des files d'attente fournissent des informations précieuses pour affiner les flux de travail.

Airflow favorise la collaboration en encourageant la définition des flux de travail dans le code, ce qui permet aux équipes de tirer parti de pratiques telles que le contrôle des versions et les révisions de code. Cette approche garantit la transparence et la cohérence du développement des flux de travail.

La plateforme est soutenue par une communauté florissante de contributeurs. Des réunions communautaires régulières, une documentation détaillée et de nombreux référentiels d'exemples permettent aux organisations d'adopter et de mettre en œuvre plus facilement l'orchestration des flux de travail basés sur l'IA avec Airflow.

Les développeurs peuvent partager des modèles pour des cas d'utilisation courants de l'IA, tels que la formation, la validation et le déploiement de modèles, afin de promouvoir les meilleures pratiques réutilisables. De plus, l'architecture du plugin permet aux équipes de créer des extensions personnalisées tout en préservant la compatibilité avec les fonctionnalités principales d'Airflow, ce qui confère encore plus de flexibilité à ce puissant outil.

Le préfet Orion suit un modèle de responsabilité partagée. Dans cette configuration, Prefect prend en charge le plan de contrôle de l'orchestration, qui comprend la gestion du stockage des métadonnées, la planification, les services API, l'authentification et la gestion des utilisateurs. Cette approche garantit une haute disponibilité constante, une évolutivité automatique et une prestation de services fiable. En s'alignant sur les fonctionnalités d'automatisation avancées mentionnées précédemment, ce cadre de gouvernance améliore l'efficacité opérationnelle de la plateforme.

Flyte est une plateforme entièrement open source conçue pour orchestrer les flux de travail, en particulier pour les projets d'apprentissage automatique et de science des données. Sa gestion par une fondation open source garantit qu'il reste un outil axé sur la communauté.

La structure de gouvernance de Flyte, maintenue par sa fondation open source, offre une supervision transparente et des fonctionnalités telles que la gestion des versions native pour des pistes d'audit fiables. Ses interfaces fortement typées protègent l'intégrité des données et documentent automatiquement leur provenance, ce qui en fait un choix fiable pour les organisations qui accordent la priorité à la sécurité et à la responsabilité. Ces fonctionnalités améliorent également la capacité de la plateforme à automatiser efficacement les processus.

L'architecture sécurisée de la plateforme est conçue pour détecter les incohérences de type et les erreurs de format de données avant l'exécution des flux de travail. Cette mesure préventive détection d'erreurs garantit une exécution plus fluide des pipelines d'IA complexes, réduisant ainsi le besoin de corrections manuelles et augmentant la fiabilité globale. Cette fiabilité technique permet aux équipes de dimensionner leurs opérations de manière efficace.

Flyte prospère grâce à sa gouvernance de fondation open source, qui nourrit une communauté active et diversifiée de contributeurs issus de diverses organisations. L'accent mis sur la reproductibilité garantit la cohérence des flux de travail, simplifie la collaboration au sein de l'équipe et facilite le processus d'intégration des nouveaux membres.

CrewAI est un framework Python indépendant conçu pour coordonner plusieurs agents d'IA, offrant une exécution plus rapide et des résultats fiables pour des flux de travail complexes.

L'architecture de CrewAI garantit une intégration fluide entre les différents écosystèmes d'IA. Il fonctionne avec n'importe quel grand modèle linguistique ou plate-forme cloud, et il prend également en charge les modèles locaux grâce à des outils tels que Ollama et Studio LM. Cette flexibilité permet aux organisations de s'en tenir à leurs modèles préférés. Ses interfaces RESTful et ses configurations de webhook simplifient les connexions au système externe en gérant automatiquement l'authentification, les limites de débit et la restauration des erreurs. CrewAI Flows améliore encore l'intégration en se connectant aux bases de données, aux API et aux interfaces utilisateur. Ils combinent différents modèles d'interaction avec l'IA, tels que des équipes d'agents collaboratives, des appels LLM directs et une logique procédurale.

Par exemple, Nœud de latence s'est intégré avec succès à CrewAI, reliant les agents aux systèmes d'entreprise tels que les CRM, les bases de données et les outils de communication via son générateur de flux de travail visuel et plus de 300 intégrations prédéfinies. Cette configuration a permis d'effectuer des tâches telles que la synchronisation des résultats avec Google Sheets ou le déclenchement de notifications Slack en fonction des événements du flux de travail. Cette intégration transparente ouvre la voie à une automatisation efficace et à des solutions évolutives.

CrewAI fait passer l'automatisation et l'évolutivité à un niveau supérieur en tirant parti de ses fonctionnalités d'interopérabilité. Son architecture rationalisée et sa base de code optimisée permettent une exécution 1,76 fois plus rapide des tâches d'assurance qualité. La plateforme comprend également des outils intégrés pour le web scraping, le traitement de fichiers et les interactions avec les API, réduisant ainsi le besoin de dépendances supplémentaires et simplifiant la gestion des flux de travail. Les équipes peuvent définir des processus métier complexes à l'aide de fichiers de configuration YAML ou de scripts Python, ce qui permet de créer des interactions détaillées entre les agents, des flux de données et des arbres de décision. Cette approche permet aux organisations de gérer des flux de travail évolutifs sans avoir besoin de compétences avancées en programmation.

La communauté CrewAI continue de s'étendre et est reconnue par les leaders du secteur. Ben Tossell, fondateur de Ben's Bites, a fait l'éloge du cadre en déclarant :

« C'est le meilleur framework d'agent du marché et des améliorations sont apportées comme je n'en ai jamais vu auparavant ! »

Les développeurs peuvent améliorer CrewAI en créant des agents Python personnalisés ou en concevant des équipes et des flux structurés, ce qui facilite la gestion des interactions entre agents à plus grande échelle.

IBM Watsonx Orchestrate est un puissant outil d'entreprise conçu pour rationaliser et automatiser les flux de travail complexes d'IA, en connectant de manière fluide diverses applications métier.

À l'aide d'API REST et de connecteurs personnalisés, IBM Watsonx Orchestrate comble le fossé entre les anciens systèmes et les plateformes modernes. Il prend en charge les déploiements sur site et dans le cloud, offrant la flexibilité nécessaire pour répondre aux différents besoins opérationnels.

La plateforme fournit une interface intuitive qui simplifie la création et le déploiement de flux de travail automatisés, même pour les utilisateurs ayant des compétences techniques limitées. Il est conçu pour gérer les fluctuations des charges de travail, garantissant ainsi des performances fiables pendant les périodes de pointe.

IBM Watsonx Orchestrate donne la priorité à la sécurité au niveau de l'entreprise grâce à des contrôles d'accès avancés, des mesures robustes de protection des données et une surveillance approfondie. Ces fonctionnalités garantissent la conformité et assurent la transparence de toutes les opérations.

Grâce à des outils de suivi des ressources en temps réel et d'optimisation des coûts, la plateforme permet aux entreprises d'ajuster leurs flux de travail en toute connaissance de cause. Ces fonctionnalités s'intègrent sans effort aux systèmes d'entreprise, aidant les entreprises à maintenir des opérations d'IA efficaces et évolutives.

Workato fournit une plate-forme puissante qui connecte différents systèmes et simplifie l'automatisation des flux de travail basés sur l'IA. En tant que lien vital entre les applications d'entreprise et les processus pilotés par l'IA, il garantit une intégration fluide et des performances fiables tout en prenant en charge l'évolutivité nécessaire pour répondre à des demandes croissantes.

Workato se distingue par sa capacité à connecter divers systèmes à l'aide d'une bibliothèque complète de plus de 1 000 connecteurs prédéfinis, ainsi que par la prise en charge des API REST, des webhooks et des intégrations personnalisées. Il facilite l'échange de données entre les systèmes existants, les applications cloud et les outils d'IA modernes, éliminant ainsi efficacement les silos de données qui perturbent souvent les flux de travail de l'IA. Grâce à sa structure de connecteurs universels, les entreprises peuvent intégrer presque tous les systèmes, à partir d'outils CRM tels que Salesforce aux entrepôts de données et aux points de terminaison des modèles d'IA, permettant ainsi des pipelines de données cohérents qui alimentent efficacement les processus d'IA.

Workato simplifie la création de flux de travail d'IA avancés à l'aide de son générateur de recettes visuelles, permettant aux utilisateurs de concevoir une logique d'orchestration complexe sans avoir besoin d'une expertise approfondie en matière de codage. La plateforme gère les dépendances entre les différentes étapes des flux de travail d'IA, telles que le prétraitement des données, la formation des modèles et le déploiement, tout en adaptant dynamiquement les ressources pour répondre aux exigences de charge de travail. Son infrastructure au niveau de l'entreprise prend en charge le traitement de gros volumes de données et gère des milliers de flux de travail exécutés simultanément, ce qui en fait un excellent choix pour les organisations qui gèrent plusieurs projets d'IA dans différents départements et cas d'utilisation.

Les outils d'orchestration natifs du cloud des principaux fournisseurs tels qu'AWS, Azure et Google proposent des flux de travail fluides et évolutifs adaptés à leurs écosystèmes. Ces plateformes rationalisent l'ensemble du cycle de vie de l'apprentissage automatique, de la préparation des données au déploiement des modèles, ce qui les rend inestimables pour les entreprises à la recherche de solutions intégrées.

Chaque plateforme excelle dans la connexion à son écosystème élargi et dans la prise en charge de divers cadres d'apprentissage automatique :

Ces intégrations rationalisent non seulement les processus, mais permettent également une mise à l'échelle dynamique, garantissant flexibilité et efficacité dans la gestion de diverses charges de travail.

L'automatisation et l'évolutivité sont au cœur de ces plateformes, permettant aux organisations de gérer facilement des flux de travail complexes liés à l'IA :

Cette section explore les avantages et les limites uniques de chaque plateforme, en offrant une compréhension claire de la façon dont elles se comparent les unes aux autres. En examinant ces différences, les organisations peuvent aligner leurs choix sur des objectifs, des besoins techniques et des budgets spécifiques. L'aperçu suivant fournit le contexte pour une comparaison détaillée côte à côte des principales fonctionnalités.

Prompts.ai propose une solution rationalisée au défi que représente la gestion de plusieurs outils d'IA. Avec l'accès à plus de 35 modèles linguistiques via une interface unifiée, il n'est plus nécessaire de jongler avec de nombreux abonnements. Ses fonctionnalités FinOps intégrées permettent le suivi et l'optimisation des coûts en temps réel, avec la possibilité de réduire les dépenses liées aux logiciels d'IA jusqu'à 98 %. Toutefois, pour les organisations fortement investies dans des environnements cloud spécifiques, les solutions cloud natives peuvent permettre une intégration plus fluide avec les systèmes existants.

Kubeflow brille dans les configurations natives de Kubernetes, offrant de solides fonctionnalités MLOps et bénéficiant d'un solide soutien de la communauté. Sa conception modulaire permet aux équipes de sélectionner les composants selon leurs besoins. En revanche, Kubeflow exige une expertise avancée de Kubernetes, ce qui peut constituer un obstacle pour les petites équipes qui ne disposent pas de ressources DevOps dédiées.

Flux d'air Apache est un nom de confiance dans le domaine de la gestion des flux de travail, connu pour son vaste écosystème de plugins et sa fiabilité éprouvée dans divers secteurs. Son framework basé sur Python attire à la fois les data scientists et les ingénieurs. Cela dit, il peut avoir des difficultés avec le traitement en temps réel et peut devenir gourmande en ressources à mesure que les flux de travail évoluent, ce qui nécessite une planification minutieuse des ressources.

Préfet Orion répond à certaines limites d'Airflow, en particulier dans les déploiements de cloud hybride. Son architecture moderne, son interface conviviale et sa gestion améliorée des erreurs en facilitent l'utilisation. Cependant, en tant que plate-forme plus récente, elle propose moins d'intégrations tierces et une communauté plus restreinte par rapport aux options plus établies.

Flûte se distingue par ses fonctionnalités robustes de suivi du lignage des données et de reproductibilité, ce qui en fait un choix judicieux pour les organisations axées sur la recherche. Son approche sécurisée minimise les erreurs d'exécution et améliore la fiabilité du flux de travail. Cependant, il s'accompagne d'une courbe d'apprentissage plus abrupte, en particulier pour les équipes qui ne connaissent pas ses paradigmes uniques.

IA de l'équipage simplifie les flux de travail d'IA multi-agents, en fournissant un cadre intuitif pour coordonner les différents agents d'IA. Bien qu'il fonctionne bien pour des cas d'utilisation spécifiques impliquant la collaboration entre agents, il peut ne pas disposer de la profondeur d'orchestration requise pour des flux de travail d'entreprise plus complexes.

IBM Watsonx Orchestrate s'intègre parfaitement à l'écosystème d'IA d'IBM et fournit de solides fonctionnalités de gouvernance adaptées aux besoins des entreprises. Cependant, son attrait peut être limité pour les organisations qui n'ont pas encore investi dans la technologie d'IBM, en particulier par rapport à des alternatives indépendantes des fournisseurs.

Travaillez à excelle dans l'automatisation des processus métier, proposant plus de 1 000 connecteurs prédéfinis. Bien qu'il soit très efficace pour les flux de travail traditionnels, ses fonctionnalités peuvent ne pas s'étendre aussi bien à la gestion de modèles d'IA complexes.

Voici un tableau comparatif résumant les principaux facteurs de différenciation :

En ce qui concerne les coûts, les plateformes cloud natives fonctionnent généralement selon une tarification à l'utilisation, qui évolue en fonction de l'utilisation. En revanche, les plateformes d'entreprise comme IBM Watsonx Orchestrate impliquent souvent des frais de licence initiaux importants.

Choisir la bonne plateforme implique souvent de trouver un équilibre entre les besoins de gouvernance et la complexité de la mise en œuvre. Les équipes qui accordent la priorité à la rentabilité et à la flexibilité sur plusieurs modèles peuvent se tourner vers Prompts.ai, tandis que ceux qui sont profondément intégrés dans des écosystèmes cloud spécifiques peuvent trouver les plateformes cloud natives plus pratiques, malgré des dépenses potentiellement plus élevées à long terme.

L'orchestration efficace des flux de travail d'IA est essentielle pour synchroniser des processus complexes et obtenir des résultats significatifs. Le choix de la bonne plateforme dépend des besoins spécifiques de votre organisation, de son expertise technique et de ses objectifs à long terme. Le marché actuel offre une variété d'options, allant des plateformes d'entreprise complètes aux services natifs du cloud, chacune répondant à des exigences uniques.

Pour les entreprises qui jonglent entre plusieurs outils d'IA et la hausse des coûts, Prompts.ai se distingue comme une solution de gestion centralisée et de rentabilité. Si votre équipe connaît bien Kubernetes, Kubeflow fournit un cadre modulaire adapté aux flux de travail nécessitant beaucoup de MLOPS. Cependant, les petites équipes ne disposant pas de ressources DevOps dédiées peuvent trouver sa complexité difficile. D'autre part, Flux d'air Apache reste un choix incontournable pour les équipes de données établies en raison de sa fiabilité et de son vaste écosystème de plugins, bien que la mise à l'échelle des flux de travail avec Airflow nécessite une allocation des ressources minutieuse. Pour les organisations axées sur l'architecture moderne, Préfet Orion propose une alternative conviviale qui répond à certaines des limites d'Airflow. Dans le même temps, les équipes axées sur la recherche peuvent bénéficier de Flûte, qui excelle dans ses capacités spécialisées, mais qui a besoin de temps pour maîtriser son approche unique.

Lorsque vous abordez l'orchestration des flux de travail liés à l'IA, il est essentiel de prendre en compte la gouvernance, la facilité de mise en œuvre et la structure des coûts. Les plateformes unifiées telles que Prompts.ai sont idéales pour les équipes qui ont besoin de flexibilité entre différents modèles d'IA tout en maîtrisant leurs dépenses. À l'inverse, les entreprises déjà intégrées dans des écosystèmes cloud spécifiques peuvent se tourner vers des options cloud natives, même si elles entraînent des coûts à long terme plus élevés.

En fin de compte, le succès de l'orchestration de l'IA réside dans l'alignement des fonctionnalités de la plateforme sur les objectifs et la préparation technique de votre organisation. Commencez par identifier vos points faibles et évaluez les capacités de votre équipe, puis choisissez une plateforme capable d'évoluer parallèlement à vos initiatives en matière d'IA.

Lors du choix d'une plateforme d'orchestration des flux de travail basés sur l'IA, il est essentiel de prendre en compte plusieurs facteurs importants. Commencez par évaluer la plateforme évolutivité, en veillant à ce qu'il puisse évoluer en fonction de vos besoins. Vérifiez-le compatibilité avec vos outils et systèmes actuels, car une intégration fluide minimise les interruptions. En outre, recherchez des fonctionnalités adaptées à votre exigences spécifiques à l'industrie, ce qui peut faire toute la différence pour relever des défis uniques.

Un autre aspect critique est la gestion de la plateforme. intégration des données, gestion de modèles, et gouvernance. Ces fonctionnalités garantissent le bon déroulement des opérations, une meilleure supervision et le respect des réglementations nécessaires. N'oubliez pas d'aligner votre choix sur les ressources techniques de votre organisation et ses futurs plans d'expansion. Une plateforme complète devrait simplifier les flux de travail, améliorer l'efficacité opérationnelle et soutenir la croissance à long terme. En vous concentrant sur ces facteurs, vous pouvez sélectionner une solution qui renforce vos flux de travail d'IA et s'aligne sur vos objectifs stratégiques.

Prompts.ai réduit les dépenses liées aux logiciels d'IA en automatisation des flux de travail et consolidation de l'accès aux modèles d'IA, aidant les entreprises à réduire considérablement leurs coûts d'exploitation. En réduisant le besoin d'interventions manuelles et en simplifiant les processus, les organisations peuvent améliorer leur efficacité et économiser jusqu'à 98 %.

Cette approche rationalisée permet non seulement de réduire les coûts, mais aussi d'optimiser les budgets des projets d'IA, permettant ainsi une allocation des ressources plus intelligente. Grâce à ces économies, les équipes peuvent développer leurs efforts d'IA de manière plus rentable tout en garantissant des performances et une fiabilité de premier ordre.

Les solutions cloud natives excellent en termes d'évolutivité grâce à des fonctionnalités telles que l'allocation élastique des ressources, la mise à l'échelle automatique et les services sans état. Ces outils permettent aux systèmes de gérer efficacement des charges de travail croissantes tout en restant résilients. En outre, ils s'intègrent parfaitement aux services cloud et aux microservices, ce qui permet des déploiements plus rapides et une meilleure compatibilité entre les plateformes.

En revanche, les plateformes traditionnelles dépendent souvent de mise à l'échelle verticale, ce qui implique d'augmenter les ressources des serveurs existants. Cette méthode a ses limites, à la fois physiquement et en termes de flexibilité, ce qui entraîne souvent un surprovisionnement et des difficultés lors de l'intégration à des systèmes distribués modernes. Pour les entreprises qui cherchent à rationaliser les flux de travail liés à l'IA, les solutions cloud natives offrent une base plus flexible et plus avant-gardiste.