Reduzca los costos de la IA y aumente la eficiencia

Los sistemas de IA dependen de los tokens para cada interacción, y administrar su uso es fundamental para controlar los gastos. Sin supervisión, los costos de los tokens pueden aumentar vertiginosamente, especialmente para las empresas que amplían sus operaciones de inteligencia artificial. A continuación, se explica cómo mantener los costos bajo control y, al mismo tiempo, mantener el rendimiento:

¿Qué hay para ti?

Controle los costos de los tokens con herramientas y estrategias más inteligentes, reduzca el desperdicio y asegúrese de que sus iniciativas de IA impulsen el crecimiento, no los gastos.

La gestión de los gastos simbólicos es un obstáculo importante para las organizaciones que implementan sistemas de IA. Estos desafíos suelen deberse a cargas de trabajo impredecibles y a estructuras de precios variables. Abordar estos problemas es esencial para mantener la eficiencia de los flujos de trabajo de la IA y los presupuestos bajo control.

El uso de los tokens puede ser muy irregular, lo que dificulta la planificación eficaz de los presupuestos. Por ejemplo, los chatbots de servicio al cliente basados en inteligencia artificial suelen experimentar picos de interacción durante el lanzamiento de productos o las interrupciones del servicio, lo que provoca un aumento del consumo de tokens. Del mismo modo, las empresas de temporada que confían en la IA para obtener recomendaciones o atención al cliente pueden experimentar un fuerte aumento durante los períodos de mayor actividad. Sin las herramientas de previsión adecuadas, estas fluctuaciones pueden provocar una asignación presupuestaria desigual en los distintos plazos. El problema se agrava cuando varias aplicaciones de IA comparten el mismo presupuesto: el uso excesivo en un área puede consumir recursos de otras, lo que dificulta el cálculo del costo por usuario o el retorno de la inversión. Estos desafíos se complican aún más debido a la variedad de modelos de precios que ofrecen los proveedores de inteligencia artificial.

Falta de transparencia en el uso de los tokens es otro problema común. Muchas organizaciones se esfuerzan por monitorear los patrones de consumo, lo que genera costos inesperados y la pérdida de oportunidades de optimización. Herramientas de monitoreo tradicionales a menudo no gestionan los precios basados en fichas, lo que hace que el exceso de uso pase desapercibido hasta que llegue la facturación. Sin un seguimiento detallado, es difícil determinar qué indicaciones, usuarios o aplicaciones están aumentando los costos. Este problema es especialmente pronunciado en las organizaciones en las que varios equipos (como los de marketing, ventas y servicio al cliente) comparten recursos simbólicos. En estos casos, atribuir los costos con precisión y hacer que los equipos rindan cuentas se convierte en un desafío. Las demoras en la presentación de informes agravan el problema y permiten que los costos se disparen antes de que se puedan tomar medidas correctivas. Estas brechas de visibilidad se agravan aún más cuando se trabaja con varios proveedores de IA.

Las estructuras de precios de la IA añaden otro nivel de dificultad. Los proveedores ofrecen una combinación de pago por token, precios escalonados y límites basados en suscripciones, lo que dificulta la comparación de los costos directos. Las diferencias en la forma en que los proveedores cuentan los tokens también pueden provocar variaciones inesperadas en los costos, que a menudo solo se revelan después de la implementación a gran escala. Los contratos empresariales aportan una complejidad adicional debido a sus descuentos por volumen, niveles de compromiso y acuerdos de precios personalizados, todos los cuales pueden variar considerablemente. Los equipos financieros suelen enfrentarse a la tediosa tarea de administrar varios sistemas de facturación y conciliar las diferentes métricas de uso, lo que aumenta la sobrecarga administrativa. Abordar estos desafíos requiere sistemas sólidos para monitorear y administrar los costos en los diferentes proveedores y modelos de precios.

La gestión eficaz del uso de los tokens requiere herramientas de supervisión sólidas y medidas de control proactivas. Al implementar sistemas que proporcionan una visibilidad clara de los patrones de consumo y las medidas de seguridad automatizadas, las organizaciones pueden evitar los sobrecostos presupuestarios y mantener el control sobre sus gastos en inteligencia artificial.

La supervisión en tiempo real transforma la administración de tokens de un proceso reactivo a uno proactivo. Las plataformas modernas de administración de inteligencia artificial cuentan con paneles detallados que rastrean el consumo de tokens en todos los modelos, usuarios y aplicaciones en tiempo real. Estos paneles muestran métricas esenciales, como las tasas de uso actuales, las asignaciones presupuestarias restantes y los costos mensuales proyectados en función de las tendencias de consumo actuales.

Para proporcionar información útil, estas herramientas suelen segmentar los datos por equipo, modelo, flujo de trabajo o períodos de tiempo específicos. Por ejemplo, pueden ayudar a identificar qué departamentos o usuarios están impulsando un mayor uso de los tokens, por ejemplo, si un centro de soporte experimenta un aumento repentino durante una actualización importante. Los datos históricos también tienen un valor incalculable, ya que destacan las tendencias estacionales y los picos de uso.

Los equipos financieros se benefician especialmente de los paneles de control que convierten el uso de los tokens en montos en dólares en tiempo real, lo que simplifica el proceso de seguimiento de los gastos en comparación con los presupuestos asignados. Además, la integración con las herramientas de gestión financiera garantiza que los costos relacionados con la IA se controlen junto con otros gastos operativos, lo que proporciona una visión integral de los gastos.

Los controles presupuestarios proactivos son esenciales para evitar gastos excesivos inesperados. Muchas organizaciones confían en sistemas de alerta de varios niveles y límites automatizados para administrar sus presupuestos de manera eficaz. Estos incluyen los límites flexibles, cuya superación requiere la aprobación de la gerencia, y los límites estrictos, que suspenden el uso una vez que se agotan los presupuestos.

La segmentación del presupuesto añade otra capa de control, lo que permite a las organizaciones asignar presupuestos simbólicos específicos a diferentes equipos o proyectos. Esta segmentación garantiza que el uso elevado en un área no afecte a las demás. También se pueden establecer límites temporales para evitar que los presupuestos se agoten demasiado rápido.

Los sistemas de alerta personalizables notifican a las partes interesadas adecuadas en el momento adecuado. Por ejemplo, los directores financieros pueden recibir resúmenes de gastos periódicos, mientras que los líderes de los equipos reciben una alerta inmediata cuando sus asignaciones se acercan a los umbrales críticos. Las notificaciones se pueden enviar por correo electrónico, plataformas de mensajería o SMS, lo que permite actuar con rapidez cuando sea necesario.

Si se superan los controles proactivos, los mecanismos alternativos garantizan la continuidad del servicio sin comprometer la rentabilidad.

Las estrategias alternativas ayudan a mantener las operaciones incluso cuando los presupuestos se reducen. Un enfoque común consiste en cambiar de jerarquías de modelos, en las que las solicitudes se redirigen a modelos menos costosos cuando las principales alcanzan sus límites de gasto. Por ejemplo, un sistema puede comenzar con un modelo premium, pero cambiar a una alternativa rentable a medida que los presupuestos son limitados.

Las estrategias de respaldo basadas en la calidad evalúan la complejidad de las solicitudes entrantes. Las tareas más sencillas se pueden asignar a modelos más asequibles, mientras que los modelos premium gestionan las consultas avanzadas, manteniendo la calidad del servicio y gestionando los costes.

Las restricciones basadas en el tiempo ofrecen otra solución, ya que redirigen las solicitudes no críticas a opciones económicas durante los períodos de alta demanda y vuelven a las operaciones estándar cuando la demanda disminuye.

Los sistemas de priorización de usuarios garantizan que los usuarios de alta prioridad o las aplicaciones críticas conserven el acceso a todas las capacidades incluso durante las restricciones presupuestarias. Este enfoque protege las operaciones esenciales y, al mismo tiempo, mantiene bajo control el consumo de fichas.

Por último, las anulaciones de emergencia brindan flexibilidad para situaciones críticas. Los usuarios autorizados pueden eludir temporalmente los controles presupuestarios para acceder a todas las capacidades de la IA cuando sea necesario. Las notificaciones se envían a los equipos financieros para que las revisen, lo que garantiza la rendición de cuentas y permite realizar los ajustes necesarios.

Para lograr una mejor rentabilidad, reducir el uso de tokens es el siguiente paso natural después de implementar estrategias presupuestarias sólidas. Si nos centramos en un diseño rápido e inteligente, una gestión eficiente de las solicitudes y una recuperación de datos específica, es posible reducir los costos sin sacrificar la calidad de los resultados.

Cada token es importante, por lo que es esencial simplificar las instrucciones. Simplifique las instrucciones eliminando palabras innecesarias y sustituyendo las largas explicaciones por un lenguaje claro y directo. Esto no solo ahorra fichas, sino que también garantiza que el mensaje se mantenga enfocado.

La reducción del contexto lleva esto un paso más allá al eliminar los detalles irrelevantes de las indicaciones y, al mismo tiempo, mantener intacta la información crucial. Este enfoque es especialmente útil cuando se trata de historiales de conversaciones o resúmenes de documentos. En lugar de incluir hilos de conversación completos, los equipos pueden extraer las decisiones clave y los aspectos más destacados para minimizar el uso de los tokens.

La estandarización de las plantillas y el resumen de las conversaciones prolongadas pueden reducir aún más el consumo de tokens. Por ejemplo, los equipos de marketing, atención al cliente y desarrollo de productos se benefician del uso de plantillas concisas y prediseñadas que evitan redundancias, como la configuración repetitiva del contexto o la orientación demasiado detallada. Estas plantillas simplifican los procesos y conducen a reducciones notables en el uso de los tokens.

Además de refinar las indicaciones, las estrategias como la agrupación de tareas y la reutilización de los resultados pueden amplificar los ahorros.

El procesamiento por lotes consolida varias llamadas a la API en una sola solicitud agrupada, lo que reduce los gastos generales y mejora la rentabilidad. La gestión conjunta de tareas similares permite compartir el contexto y optimizar la reutilización rápida, lo que reduce el consumo de tokens.

El almacenamiento en caché de las respuestas es otro método eficaz. Al almacenar los resultados generados por la IA para las preguntas frecuentes o las consultas recurrentes, los equipos (como los departamentos de servicio al cliente) pueden evitar consumir fichas de forma repetida para tareas similares. La implementación del almacenamiento en caché en escenarios comunes puede reducir significativamente el uso general de los tokens.

La reutilización del contexto en las operaciones por lotes también aumenta la eficiencia. Por ejemplo, al analizar varios documentos del mismo proyecto, los equipos pueden establecer el contexto una vez y hacer referencia a él en las consultas relacionadas, lo que elimina la necesidad de volver a introducir los mismos detalles repetidamente.

Además, la agrupación inteligente de tareas permite a los equipos combinar los objetivos relacionados en una sola llamada a la API. En lugar de solicitar revisiones gramaticales, ajustes de tono y formato por separado, las instrucciones unificadas pueden abordar todas estas necesidades a la vez, lo que reduce el uso total de fichas y, al mismo tiempo, mantiene unos resultados de alta calidad.

La generación aumentada por recuperación (RAG) es una forma poderosa de controlar los costos de los tokens al obtener solo el contexto más relevante. En lugar de proporcionar a los modelos lingüísticos amplias secciones de un documento, los sistemas RAG recuperan detalles específicos de las bases de conocimiento, lo que garantiza que el modelo procese solo lo necesario para obtener respuestas precisas.

Al igual que la reducción del contexto, RAG se centra en eliminar la información innecesaria. Sin embargo, lo hace recuperando de forma dinámica y precisa lo que se necesita. Los sistemas RAG eficaces dan prioridad a la precisión y extraen solo los fragmentos de información más relevantes en lugar de secciones enteras del documento. Este enfoque específico reduce el uso de los tokens y, al mismo tiempo, mantiene la calidad de la respuesta.

La carga dinámica de contexto añade más flexibilidad al adaptar la cantidad de información recuperada a la complejidad de cada consulta. Las solicitudes simples reciben un contexto mínimo, mientras que las preguntas más detalladas se combinan con información básica adicional. Este método adaptativo garantiza un uso eficiente de los tokens en cada escenario.

La fragmentación inteligente dentro de los sistemas RAG mejora aún más la eficiencia. Al dividir la información en partes más pequeñas y muy relevantes, como párrafos u oraciones específicos, los equipos pueden evitar recuperar secciones de texto grandes e innecesarias. Esto reduce el consumo de fichas y, al mismo tiempo, garantiza que las respuestas sigan siendo precisas y centradas.

Además, los sistemas RAG admiten el reciclaje de contextos, donde la información recuperada se puede reutilizar en varias consultas relacionadas en la misma sesión. Esto reduce las recuperaciones redundantes y minimiza el consumo repetido de tokens para obtener detalles en segundo plano que siguen siendo relevantes durante las interacciones en curso.

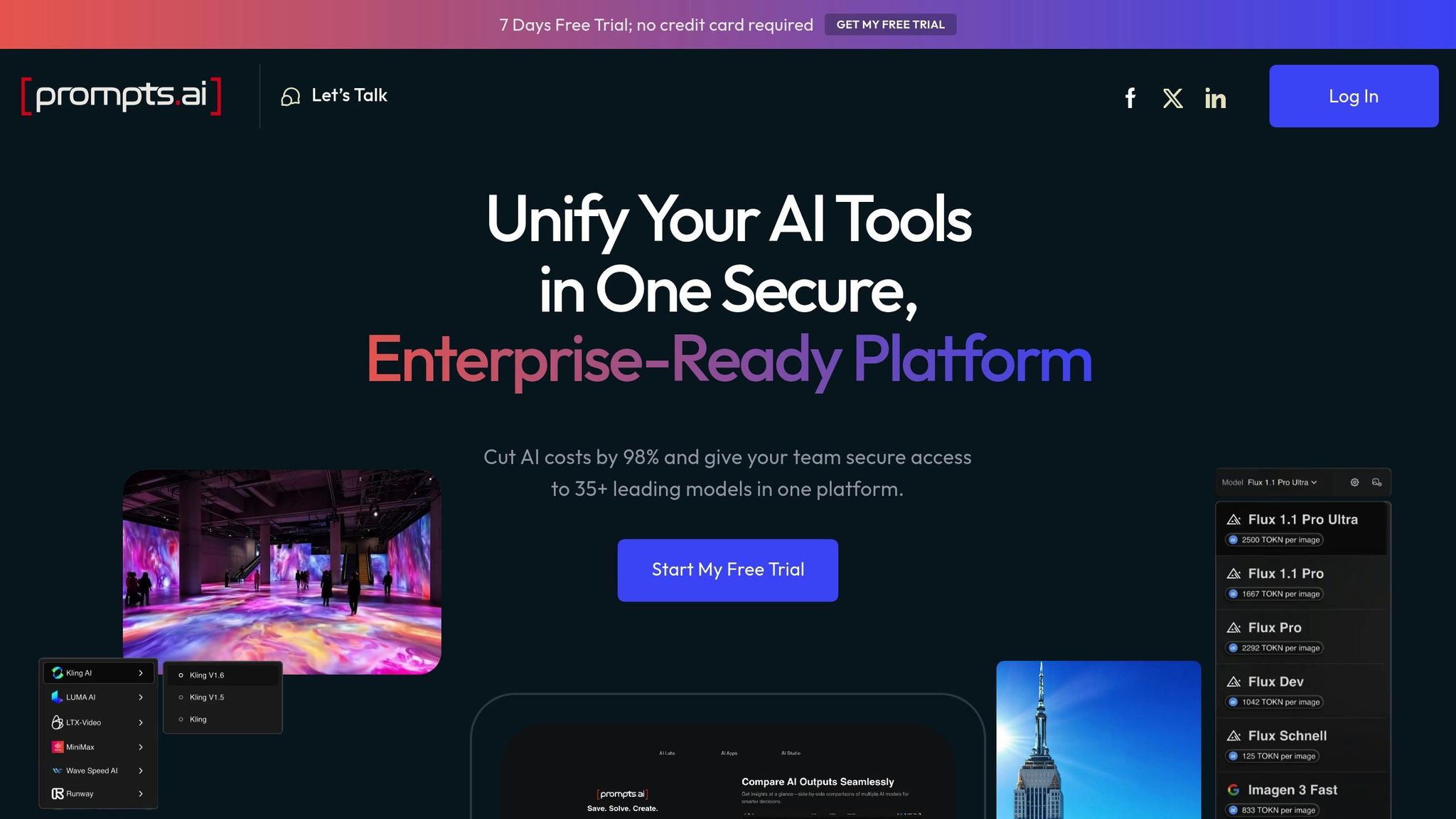

La gestión eficaz de los costes de los tokens exige una plataforma que pueda supervisar el uso, controlar los gastos y agilizar los flujos de trabajo. Las herramientas fragmentadas y las tarifas ocultas a menudo dificultan este proceso. Prompts.ai aborda estos problemas con una plataforma de administración unificada diseñada para simplificar y optimizar la administración de los costos de los tokens.

Prompts.ai se basa en estrategias comprobadas de supervisión y presupuestación para ofrecer una solución única y optimizada. Al reunir más de 35 de los principales modelos lingüísticos de gran tamaño en una interfaz segura, elimina las ineficiencias de herramientas dispares que, a menudo, generan gastos impredecibles y una visibilidad limitada.

Con el seguimiento de FinOps en tiempo real, los equipos obtienen información inmediata sobre el consumo de tokens en todos los modelos y proyectos. Esta transparencia permite tomar decisiones informadas, lo que garantiza que los presupuestos de IA se gestionen de forma eficaz en tiempo real.

Los paneles integrados de la plataforma proporcionan desgloses detallados de los costos de los tokens por equipo, proyecto y modelo. Este nivel de transparencia va más allá de las herramientas de seguimiento estándar, ya que ayuda a las organizaciones a determinar qué flujos de trabajo consumen más recursos y dónde los ajustes pueden generar mayores ahorros.

Prompts.ai también ofrece funciones avanzadas de optimización de costes que pueden reducir los gastos de IA hasta en un 98%. Mediante un modelo de enrutamiento inteligente, selección automatizada de modelos para tareas específicas, y la eliminación de las suscripciones redundantes, la plataforma garantiza un uso eficiente de los recursos.

Prompts.ai presenta un sistema de créditos TOKN de pago por uso, que elimina las tarifas de suscripción recurrentes y vincula los costos directamente al uso real. La selección automatizada de modelos reduce aún más los gastos al asignar las tareas al modelo más rentable capaz de gestionarlas. Para tareas más sencillas, el sistema opta por modelos más ligeros y económicos, y reserva los modelos premium para operaciones más complejas.

Las herramientas de gobierno integrales proporcionan un control de costos adicional. Estas incluyen los límites de gastos, los requisitos de aprobación para tareas de alto costo y los registros de auditoría para garantizar el cumplimiento. Estas medidas evitan los sobrecostos presupuestarios y, al mismo tiempo, mantienen el uso de la IA alineado con las políticas y regulaciones de la organización.

La plataforma también ofrece comparaciones de modelos en paralelo, lo que permite a los equipos seleccionar opciones rentables sin sacrificar el rendimiento. Esta función garantiza que las organizaciones puedan equilibrar el costo y la calidad para cada caso de uso específico, evitando gastos innecesarios y manteniendo altos estándares para las tareas exigentes.

Prompts.ai va más allá del control de costos al simplificar los flujos de trabajo e integrar la gobernanza con la eficiencia operativa. Al consolidar varias herramientas de inteligencia artificial en una sola plataforma, elimina las suscripciones redundantes y centraliza el seguimiento de los costos, lo que permite ahorrar tiempo y dinero.

La plataforma funciones de gestión de costes incluyen alertas automatizadas para los umbrales de gasto, aprobaciones obligatorias para operaciones de alto costo e informes detallados que vinculan los gastos de IA con los resultados empresariales. Estas herramientas garantizan que el consumo de fichas se mantenga dentro del presupuesto y se alinee con las prioridades de la organización.

Las plantillas estandarizadas y las bibliotecas de avisos reutilizables reducen aún más el desperdicio de fichas y promueven la coherencia entre los equipos. En lugar de que cada equipo cree sus propios flujos de trabajo, las organizaciones pueden confiar en plantillas diseñadas por expertos y optimizadas tanto para el rendimiento como para la rentabilidad.

Las funciones impulsadas por la comunidad, como el programa de certificación Prompt Engineer, ayudan a los usuarios a adoptar prácticas rentables y a evitar errores comunes que generan gastos innecesarios. Al aprender de los usuarios experimentados, los equipos pueden implementar rápidamente estrategias que maximicen la eficiencia.

Con el acceso unificado al modelo, el seguimiento de los costos en tiempo real y la optimización automatizada, Prompts.ai transforma la administración de costos de los tokens en una estrategia proactiva. No solo reduce los gastos, sino que también permite la adopción escalable y eficiente de la IA en todas las organizaciones.

Las implementaciones eficaces de IA van más allá de la simple reducción de los costos simbólicos: su objetivo es ofrecer resultados significativos. Centrarse demasiado en reducir los gastos puede llevar a que los sistemas sean económicos pero que no funcionen. El verdadero desafío radica en medir las métricas correctas y tomar decisiones informadas y basadas en datos para maximizar el impacto. Una métrica crucial es la coste por resultado, lo que ayuda a equilibrar el rendimiento y la eficiencia.

Confiar únicamente en el recuento de fichas puede resultar engañoso. Por ejemplo, un modelo de alto rendimiento puede usar más fichas para realizar una tarea compleja, pero ofrecer resultados mucho mejores que una alternativa más barata que produzca resultados insatisfactorios. Al centrarse en la costo por resultado exitoso en lugar de limitarse al uso de fichas, las organizaciones pueden evaluar mejor la eficiencia de sus sistemas de IA.

Tomemos el ejemplo de un modelo avanzado: puede costar más al principio, pero resuelve las consultas de los clientes de manera más eficaz, lo que reduce la necesidad de intervención humana. Métricas como tasas de finalización, puntuaciones de precisión, y tiempo de resolución, cuando se analizan junto con los gastos simbólicos, proporcionan una imagen más clara del ROI general. Para tareas como la detección del fraude, en las que la precisión es fundamental, tiene sentido invertir en un modelo de mayor coste. Por otro lado, las tareas más sencillas, como la categorización del correo electrónico, a menudo se pueden gestionar con opciones más rentables.

La adopción de un enfoque de tareas específicas es clave. Los modelos rentables pueden ser suficientes para generar contenido de forma sencilla, mientras que las tareas más complejas con mayores riesgos se benefician de los modelos premium. La alineación de las capacidades del modelo con los requisitos de las tareas garantiza que las organizaciones eviten gastar de más en el trabajo rutinario y, al mismo tiempo, mantengan un alto rendimiento para las operaciones críticas. Estas métricas también guían los ajustes continuos de los flujos de trabajo y las estrategias.

Basándose en información específica de cada tarea, las revisiones periódicas son esenciales para optimizar el rendimiento y los costos de la IA a lo largo del tiempo. La gestión de costes de la IA no es un proceso único, sino que requiere una supervisión y un ajuste continuos. A medida que cambian los patrones de uso, surgen nuevos modelos y evolucionan las prioridades empresariales, las organizaciones que evalúan periódicamente sus gastos en IA se anticipan a las ineficiencias.

Las revisiones frecuentes pueden ayudar a detectar anticipadamente los picos de gastos inesperados, lo que evita los sobrecostos presupuestarios. Por ejemplo, los departamentos de marketing pueden experimentar costos de IA más altos durante el lanzamiento de los productos, lo que indica la necesidad de perfeccionar las estrategias rápidas. Las evaluaciones periódicas garantizan que las empresas se adapten a los cambios en el rendimiento del modelo y los precios, lo que permite aprovechar las oportunidades para mejorar la eficiencia.

La optimización rápida es otra área en la que las reseñas dan sus frutos. Eliminar el contexto redundante, simplificar las instrucciones o reestructurar las solicitudes puede reducir considerablemente el uso de los tokens. Los ajustes estacionales también desempeñan un papel en la administración de los costos. Una empresa de comercio electrónico, por ejemplo, podría asignar más recursos de IA durante las temporadas de mayor volumen de compras y reducirlos durante los períodos más lentos, manteniendo el rendimiento y manteniendo los gastos bajo control.

Además de las revisiones periódicas, los sistemas de enrutamiento inteligentes pueden mejorar aún más la rentabilidad. Estos sistemas asignan automáticamente las tareas a los modelos más adecuados en función de factores como la complejidad, la urgencia y el costo. Las tareas rutinarias se pueden dirigir a modelos rentables, mientras que los trabajos más exigentes se gestionan con opciones premium. Este enfoque específico reduce los costos generales al evitar la dependencia innecesaria de modelos más caros para cada tarea.

Los marcos de gobierno añaden otro nivel de control, imponiendo límites de gasto y exigiendo aprobaciones para operaciones de alto costo. Los equipos operan dentro de presupuestos predefinidos, con la supervisión gerencial de tareas costosas para garantizar tanto la eficiencia como la responsabilidad.

Las funciones avanzadas, como las puertas de calidad y la aplicación del presupuesto en tiempo real, ayudan a mantener una alta calidad de producción sin gastar de más. Por ejemplo, los sistemas pueden reducir automáticamente el uso cuando los costos superan los umbrales establecidos. Algunas plataformas incluso utilizan el aprendizaje automático para refinar las decisiones de enrutamiento a lo largo del tiempo, lo que mejora continuamente el equilibrio entre el costo y el rendimiento. Estas herramientas, combinadas con el seguimiento en tiempo real y las alertas automatizadas, garantizan que las organizaciones maximicen sus inversiones en inteligencia artificial sin salirse del presupuesto.

La gestión eficaz de los costes a nivel de fichas es esencial para crear flujos de trabajo de IA que sean eficientes y escalables y, en última instancia, generen un mayor valor empresarial. Al centrarse en estrategias que equilibren el rendimiento con el control de los costes, las organizaciones pueden aprovechar todo el potencial de la IA sin gastar de más.

Visibilidad en tiempo real constituye la columna vertebral de la gestión de costes. Los paneles proporcionan información útil, lo que permite a los equipos tomar decisiones informadas y evitar los sobrecostos presupuestarios antes de que se produzcan.

Técnicas de ahorro de costes como indicaciones optimizadas, procesamiento por lotes, y almacenamiento en caché ayudan a reducir el uso de los tokens a la vez que mantienen la calidad de los resultados. El éxito radica en identificar cuándo son necesarios los modelos premium y cuándo bastarán las opciones más económicas.

Sistemas de gobierno automatizados desempeñan un papel fundamental en los despliegues de IA a gran escala. Herramientas como los controles presupuestarios, las alertas de gastos y los modelos inteligentes de enrutamiento garantizan que los costos sigan siendo manejables y, al mismo tiempo, brindan a los equipos acceso a las capacidades de inteligencia artificial que necesitan. Estas medidas de protección se vuelven cada vez más importantes a medida que las organizaciones amplían las iniciativas de IA en todos los departamentos y casos de uso.

En lugar de centrarse únicamente en el recuento de tokens sin procesar, las organizaciones deberían considerar la coste por resultado. Los modelos que consumen más tokens aún pueden ofrecer un mejor ROI si reducen la necesidad de introducir datos manualmente o agilizan los flujos de trabajo. Esta perspectiva basada en los resultados permite a las empresas asignar los presupuestos de IA de forma más estratégica.

Plataformas unificadas, como Prompts.ai, reúnen las herramientas de inteligencia artificial y los controles de gestión en un solo lugar, lo que reduce significativamente los costos y, al mismo tiempo, mantiene la transparencia y el control operativos.

Por último, evaluación continua garantiza que las estrategias de costes se adapten a las cambiantes necesidades empresariales y a la evolución de las tecnologías de IA. Las revisiones y actualizaciones periódicas de las prácticas de gestión de costes permiten a las organizaciones mantenerse a la vanguardia y aprovechar las nuevas oportunidades para mejorar la eficiencia y el rendimiento. La optimización de costos de la IA es un proceso continuo, no un esfuerzo puntual.

Para hacer frente a los picos repentinos en el uso de los tokens, las empresas deben confiar en herramientas de monitoreo en tiempo real para vigilar de cerca el consumo y establecer límites de gasto. Al analizar los datos históricos, análisis predictivo y los modelos de previsión de la demanda pueden ayudar a anticipar los períodos de mayor demanda, lo que permite una mejor preparación y asignación de recursos.

Además, estrategias como límite de velocidad y acceso por niveles proporcionan flexibilidad mediante la gestión dinámica de los niveles de uso. Esto garantiza que el rendimiento se mantenga estable y, al mismo tiempo, mantenga los gastos bajo control. En conjunto, estos enfoques permiten a las empresas operar de manera eficiente sin sobrepasar sus presupuestos.

Prompts.ai ofrece herramientas sólidas para monitorear y ajustar el uso de los tokens en tiempo real, lo que permite a las organizaciones reducir los gastos tanto como 50%. Las funciones clave, como la limitación de velocidad simbólica y los controles de acceso escalonados, ayudan a reducir los costos inesperados y, al mismo tiempo, garantizan que los recursos se distribuyan de manera efectiva.

Con información detallada sobre el consumo de tokens y estrategias de uso más inteligentes, Prompts.ai elimina la complejidad de la administración de costos. Aporta mayor claridad, agiliza las operaciones y mejora la eficiencia general de los flujos de trabajo de la IA.

La generación aumentada por recuperación (RAG) ayuda a reducir los costos de los tokens al obtener información relevante de bases de datos externas antes de elaborar una respuesta. De este modo, reduce la carga de trabajo del modelo lingüístico, lo que requiere que procese menos datos internamente, lo que se traduce en un menor uso de los tokens y una mayor eficiencia.

RAG también mejora la calidad de la respuesta al centrarse en datos precisos y apropiados para el contexto. Este enfoque evita desperdiciar fichas en detalles irrelevantes o excesivos, y logra un equilibrio entre el ahorro de costos y un rendimiento confiable.