La ingeniería rápida de la IA es fundamental para las empresas que buscan maximizar la eficiencia de herramientas como GPT-4, Claudio, y Géminis. El software adecuado puede simplificar los flujos de trabajo, reducir los costos y mejorar los resultados. Estas son cinco herramientas destacadas diseñadas para optimizar las operaciones de inteligencia artificial:

Estas herramientas abordan desafíos comunes, como los altos costos, los flujos de trabajo fragmentados y los resultados inconsistentes, y ayudan a los equipos a escalar las operaciones de IA de manera efectiva. Elija en función de sus necesidades específicas, ya sea que se trate del control de costos, el análisis detallado o la simple experimentación.

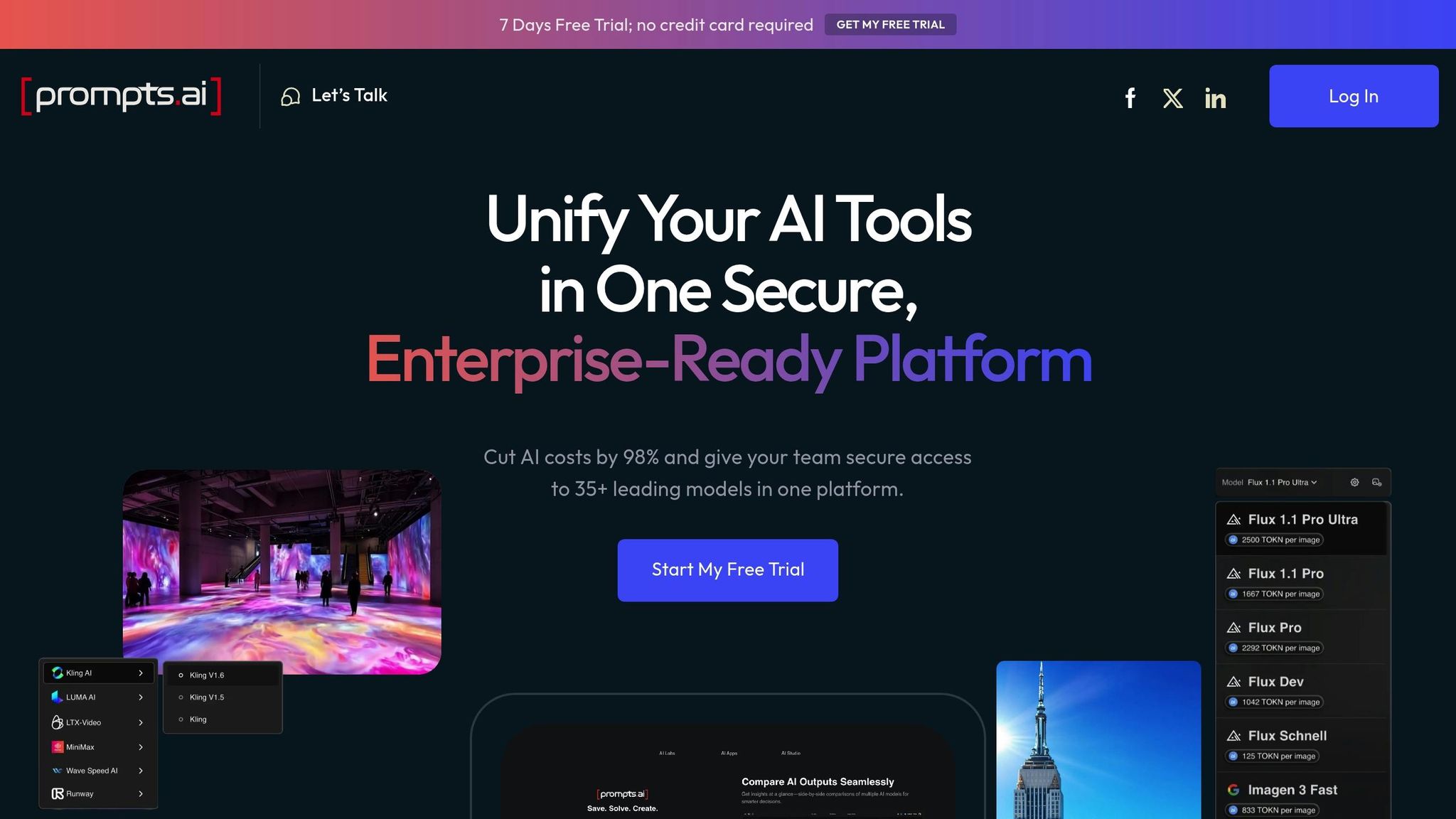

Prompts.ai es una plataforma de nivel empresarial diseñada para simplificar y unificar las operaciones de IA para las organizaciones. Al reunir más de 35 modelos lingüísticos de gran tamaño de primer nivel (incluidos GPT-4, Claude, LLama y Gemini) en una interfaz única y segura, elimina las ineficiencias que implica hacer malabares con múltiples herramientas. Este sistema centralizado prioriza la seguridad, la gobernanza y la administración de costos, lo que permite a los equipos probar, refinar y optimizar las instrucciones con facilidad.

Prompts.ai proporciona acceso a una amplia gama de modelos de IA, lo que resuelve el desafío de administrar varios proveedores. La plataforma se mantiene a la vanguardia al integrar modelos emergentes como GPT-5, Grok-4, Flux Pro y Kling, lo que garantiza que los equipos puedan explorar rápidamente los últimos avances. Este amplio acceso sienta las bases para una optimización rápida y mejorada, lo que brinda a los usuarios la flexibilidad necesaria para experimentar e innovar.

La función de comparación en paralelo de la plataforma permite a los equipos probar simultáneamente indicaciones idénticas en diferentes modelos, lo que ayuda a identificar la que mejor se adapta a necesidades específicas, ya sea la creación de contenido, el análisis de datos o la automatización de las interacciones con los clientes. Para agilizar aún más los flujos de trabajo, Prompts.ai ofrece plantillas de mensajes prediseñadas creadas por expertos, lo que reduce considerablemente el tiempo necesario para el desarrollo.

Prompts.ai incluye una capa FinOps integrada que rastrea el uso en tiempo real, lo que garantiza que las organizaciones controlen sus gastos y eviten costos inesperados. El sistema de crédito TOKN de la plataforma reemplaza las tarifas de suscripción tradicionales y ofrece una forma más flexible y predecible de gestionar los gastos de inteligencia artificial. Este enfoque puede ayudar a las empresas a reducir los costos de software hasta en un 98%.

Con herramientas de gobierno de nivel empresarial, Prompts.ai garantiza el cumplimiento sin sacrificar la flexibilidad. Cada flujo de trabajo incluye registros de auditoría y medidas de seguridad estrictas, lo que facilita la administración de los datos confidenciales. La plataforma también admite espacios de trabajo compartidos con controles de acceso detallados, lo que fomenta la colaboración entre los equipos y, al mismo tiempo, mantiene una estricta seguridad de los datos. Para empoderar aún más a las organizaciones, Prompts.ai ofrece programas de incorporación y formación que ayudan a los equipos a adquirir experiencia y adoptar las mejores prácticas para ampliar la IA de forma eficaz.

PromptPerfect está diseñado para refinar y mejorar las indicaciones existentes, garantizando que produzcan resultados de IA más precisos y detallados. De este modo, le ayuda a aprovechar al máximo sus inversiones rápidas. Esta herramienta funciona a la perfección con las plataformas que centralizan las operaciones de inteligencia artificial, lo que le permite hacerse un hueco en la optimización en función de cada solicitud.

PromptPerfect admite una variedad de modelos, incluidos los basados en texto e imágenes, lo que lo convierte en una herramienta versátil para la solicitud multimodal. Ajusta automáticamente las indicaciones para que se ajusten a los requisitos de los diferentes modelos lingüísticos de gran tamaño. Gracias a la integración de la API, es sencillo incorporar esta herramienta de optimización a los flujos de trabajo existentes, lo que agiliza el proceso.

El núcleo de PromptPerfect reside en su sistema automático de refinamiento rápido. Toma las indicaciones básicas y las transforma en versiones más eficaces analizando las entradas y sugiriendo mejoras. Esto da como resultado resultados más detallados, precisos y alineados contextualmente. Además, proporciona información sobre por qué ciertas indicaciones funcionan mejor, lo que te ayuda a crear indicaciones más potentes en el futuro.

PromptPerfect ofrece una estructura de precios clara y sencilla basada en los límites de solicitudes diarias, lo que garantiza que pueda predecir los costos con facilidad. Siempre ha obtenido altas calificaciones por su transparencia de costos, lograr una calificación perfecta de 5/5 en las evaluaciones de herramientas de ingeniería rápidas.

El plan Pro, con un precio de 19,99$ al mes, es ideal para los usuarios que necesitan hasta 500 solicitudes diarias y acceso a funciones avanzadas. Para las organizaciones con mayores exigencias, el El plan Pro Max incluye acceso a la API y límites de solicitud ampliados, lo que la convierte en una opción sólida. El El plan empresarial ofrece soluciones personalizadas para empresas con necesidades únicas.

OpenAI Playground es el entorno de pruebas ideal para experimentar con los modelos de lenguaje de OpenAI. Esta herramienta basada en la web proporciona información en tiempo real sobre el funcionamiento de las indicaciones, lo que la hace inestimable para explorar el comportamiento y las respuestas de los modelos. A diferencia de las plataformas de optimización avanzadas, Playground se centra en la experimentación y el descubrimiento sencillos.

Playground ofrece acceso al conjunto completo de modelos de OpenAI, que incluye GPT-4, GPT-3.5 Turbo, Davinci, y Curie. Los usuarios pueden ajustar parámetros como fiebre, número máximo de fichas, y recarga para personalizar las salidas. El cambio entre modelos es perfecto, lo que le permite probar el mismo indicador en diferentes modelos y comparar sus resultados uno al lado del otro.

La interfaz admite interacciones basadas en el chat y en el estilo de finalización, lo que le brinda la flexibilidad de estructurar sus entradas como prefiera. Además, conserva tu historial de mensajes, lo que resulta especialmente útil para refinar e iterar tus experimentos.

El diseño intuitivo del Playground facilita el refinamiento de las indicaciones de forma iterativa. Puedes modificar los mensajes del sistema, ajustar las entradas de los usuarios y analizar las respuestas para ver cómo los pequeños cambios influyen en el resultado. Controles avanzados como penalizaciones de frecuencia, sanciones de presencia, y detener secuencias permiten un ajuste preciso de los resultados.

Para aquellos que buscan una ventaja inicial, la plataforma incluye una biblioteca preestablecida con configuraciones adaptadas a tareas comunes como la escritura creativa, la codificación o la resolución de problemas analíticos. Estos ajustes preestablecidos ofrecen una base sólida para sumergirse en la ingeniería rápida.

La administración de costos en Playground es sencilla y transparente. La plataforma funciona con un modelo de precios de pago por uso basado en fichas. Cada solicitud muestra claramente la cantidad de fichas utilizadas tanto para la entrada como para la salida, lo que permite calcular los costos en tiempo real. Por ejemplo:

Un rastreador de uso integrado lo ayuda a monitorear el consumo de fichas, lo que garantiza mantenerse dentro del presupuesto y evitar cargos inesperados. Los nuevos usuarios suelen recibir créditos gratuitos para que exploren las funciones de la plataforma antes de comprometerse a usarla de pago.

PromptLayer sirve como un sólido sistema de administración de mensajes, que funciona como un control de versiones para sus mensajes. Captura todas las interacciones entre las solicitudes y los modelos (rastreando la latencia, el uso de los tokens y las respuestas), lo que le brinda una visión clara de su flujo de trabajo.

La arquitectura flexible de PromptLayer le permite usar una única plantilla de mensajes en varios modelos de IA sin necesidad de ajustes. Se conecta directamente a los principales modelos lingüísticos de gran tamaño, como los modelos GPT de OpenAI, Antrópico Claude, los modelos de Google y Mistral LLM. También se integra a la perfección con los marcos de IA más utilizados, como Cadena LANG.

Más allá de las opciones convencionales, PromptLayer admite LLM de código abierto personalizadas y alojadas localmente, lo que ofrece una adaptabilidad inigualable para su configuración de IA. Puede ajustar la configuración del modelo, elegir proveedores y ajustar los parámetros a través de la interfaz de usuario o mediante programación. Esta amplia compatibilidad garantiza una base sólida para refinar sus instrucciones.

PromptLayer combina el control de versiones con análisis exhaustivos para mejorar su proceso de administración inmediata. Su interfaz fácil de usar le permite editar e implementar diferentes versiones de las indicaciones sin necesidad de escribir código. Al capturar los metadatos clave, como los tiempos de respuesta, el uso de los tokens y la calidad de los resultados, puede identificar las tendencias y ajustar el rendimiento con confianza.

La plataforma también admite pruebas A/B, lo que le permite comparar modelos y evaluar la eficacia inmediata en escenarios del mundo real. Los análisis detallados, que incluyen métricas como la latencia media, los costes totales, los volúmenes de solicitudes y los patrones de uso de los tokens, proporcionan información valiosa sobre el rendimiento de las solicitudes en los entornos de producción.

Con el control de versiones, puede supervisar los cambios rápidos a lo largo del tiempo, volver a versiones anteriores o analizar el impacto de las actualizaciones en el rendimiento. Esto facilita el mantenimiento y la mejora de la calidad de las actualizaciones a largo plazo.

LangSmith ofrece herramientas versátiles para una ingeniería rápida, que funcionan a la perfección con los principales modelos de IA. Soporta la integración con OpenAI (como gpt-4o), Crecer (llama 3-8b-8192 y llama 3-70b-8192), Anthropic y Mistral, lo que simplifica el proceso de incorporación de estos modelos en sus flujos de trabajo.

Cada plataforma tiene su propio conjunto de puntos fuertes y limitaciones, por lo que la elección depende de sus requisitos de flujo de trabajo específicos.

A continuación se muestra un resumen de las características más destacadas y los inconvenientes de cada herramienta:

Prompts.ai es una solución empresarial sólida que consolida más de 35 modelos de IA líderes en una sola interfaz. Su característica más destacada es la rentabilidad, con un ahorro potencial de hasta el 98% gracias a su sistema de crédito TOKN de pago por uso y a la transparencia de sus precios. Sin embargo, su naturaleza integral y su seguridad de nivel empresarial pueden resultar excesivas para los usuarios que solo necesitan capacidades básicas de prueba rápidas.

RápidoPerfecto está diseñado para la optimización automatizada y aprovecha los algoritmos de aprendizaje automático para refinar las indicaciones. Sus funciones de prueba, como las pruebas A/B y la medición de la calidad de los resultados, lo convierten en una opción ideal para los equipos que se centran en una mejora rápida y sistemática. La compatibilidad multiplataforma de la plataforma garantiza una integración fluida con varios modelos lingüísticos. Por el lado negativo, su enfoque limitado en la optimización puede requerir que los usuarios la complementen con otras herramientas para una gestión más amplia del flujo de trabajo de la IA.

Área de juegos OpenAI proporciona una interfaz fácil de usar y acceso directo a la familia de modelos de OpenAI, lo que la convierte en una excelente opción para realizar pruebas y aprender rápidamente. Su simplicidad es su punto fuerte, ya que permite la experimentación inmediata sin la necesidad de una configuración compleja. Sin embargo, esta simplicidad se consigue a costa de funciones avanzadas como el control de versiones, la colaboración en equipo y el análisis, que las organizaciones más grandes pueden considerar indispensables.

Capa Prompt sobresale en la observabilidad y el seguimiento del rendimiento, ya que ofrece registros y análisis detallados en todos los modelos. Estos conocimientos permiten a los equipos optimizar las indicaciones mediante la toma de decisiones basada en datos. Si bien se integra perfectamente con los flujos de trabajo de desarrollo, exige un cierto nivel de experiencia técnica, lo que podría disuadir a los usuarios no técnicos.

Lang Smith destaca por su flexibilidad a la hora de integrar varios modelos y ofrece una interfaz unificada para probar las instrucciones en diferentes arquitecturas. Esto la convierte en una herramienta valiosa para identificar las combinaciones óptimas de modelos e indicaciones. Sin embargo, su flexibilidad puede generar desafíos en la configuración de la API y la fijación de precios, lo que podría complicar la adopción.

Al seleccionar una herramienta, ten en cuenta cómo se alinea con el flujo de trabajo y las necesidades de tu equipo. Los sectores en los que hay mucho en juego, los equipos creativos y las instituciones educativas suelen beneficiarse de las herramientas que ofrecen funciones rápidas estructuradas y adaptables.

Las tendencias emergentes indican que estas plataformas están avanzando hacia el soporte de IA multimodal, lo que permite la generación de texto, imágenes y videos, al tiempo que incorpora la optimización automatizada para reducir el esfuerzo manual. Funciones como las sugerencias inteligentes y el seguimiento continuo del rendimiento se están convirtiendo en estándar, junto con opciones de personalización avanzadas que adaptan las instrucciones a sectores y contextos de usuario específicos.

Para tomar una decisión informada, evalúe las plataformas utilizando métricas cuantitativas (por ejemplo, precisión, tasas de finalización de tareas) y factores cualitativos (por ejemplo, satisfacción del usuario, legibilidad). Esto garantiza que la herramienta que elija no solo cumpla con las exigencias técnicas, sino que también mejore la colaboración en equipo y la eficiencia del flujo de trabajo. Las indicaciones bien diseñadas desempeñan un papel estratégico a la hora de lograr operaciones de IA eficaces y optimizadas.

Al elegir la herramienta adecuada, ten en cuenta el tamaño del equipo, el presupuesto y las necesidades específicas del flujo de trabajo. Este es un desglose de nuestras recomendaciones en función de los distintos casos de uso:

A medida que la industria avanza hacia las capacidades multimodales y la automatización avanzada, es fundamental seleccionar una herramienta que satisfaga sus necesidades actuales y, al mismo tiempo, se adapte a los avances futuros, como la integración de imágenes y vídeos.

Para tomar la mejor decisión, considera no solo el rendimiento técnico, sino también qué tan bien se alinea la plataforma con el flujo de trabajo y la satisfacción de tu equipo. La herramienta adecuada debería ofrecer resultados mensurables y, al mismo tiempo, simplificar la colaboración y los procesos.

Al elegir un software para la ingeniería rápida de IA, busque herramientas que simplifiquen la creación de indicaciones precisas y detalladas. El software ideal debería ser compatible pruebas e iteración rápidas, lo que facilita el refinamiento de las indicaciones para mejorar los resultados de la IA. Entre las principales características a tener en cuenta se encuentran las opciones de ajuste contenido y estructura, como el ajuste preciso de las instrucciones, el suministro de contexto y la gestión eficaz de los datos de entrada.

Igualmente importante es seleccionar un software que funcione a la perfección con los últimos modelos de IA, lo que garantiza una integración fluida y un rendimiento de alta calidad. Céntrese en las herramientas que simplifican los flujos de trabajo y mejoran la calidad general del contenido generado por IA.

El sistema de crédito TOKN de Prompts.ai funciona en un paga sobre la marcha de forma básica, asegurándote de que solo pagas por lo que realmente utilizas. Este enfoque elimina la carga de las costosas suscripciones de tarifa plana que a menudo incluyen funciones o servicios innecesarios.

Al alinear los costos con el uso real, el sistema TOKN puede reducir los gastos hasta en 98%, que ofrece una solución inteligente y rentable para gestionar las tareas rápidas de ingeniería de la IA.

Herramientas como LangSmith proporcionan información en tiempo real en un rendimiento rápido, respuestas de modelos y uso de recursos, lo que facilita la supervisión y la depuración de los flujos de trabajo. Esto agiliza los procesos y mejora la eficiencia general.

Estas herramientas también simplifican el proceso de probar y refinar las variaciones rápidas de manera metódica. Al adoptar este enfoque estructurado, los desarrolladores pueden lograr una mayor precisión, una mayor confiabilidad y ciclos de desarrollo más rápidos para las aplicaciones impulsadas por la inteligencia artificial.