L'ingénierie rapide de l'IA est essentielle pour les entreprises qui souhaitent maximiser l'efficacité d'outils tels que GPT-4, Claude, et Gémeaux. Le bon logiciel peut simplifier les flux de travail, réduire les coûts et améliorer les résultats. Voici cinq outils remarquables conçus pour optimiser les opérations d'IA :

Ces outils permettent de relever des défis courants tels que les coûts élevés, la fragmentation des flux de travail et l'incohérence des résultats, en aidant les équipes à faire évoluer efficacement les opérations d'IA. Choisissez en fonction de vos besoins spécifiques, qu'il s'agisse de contrôle des coûts, d'analyses détaillées ou de simples expériences.

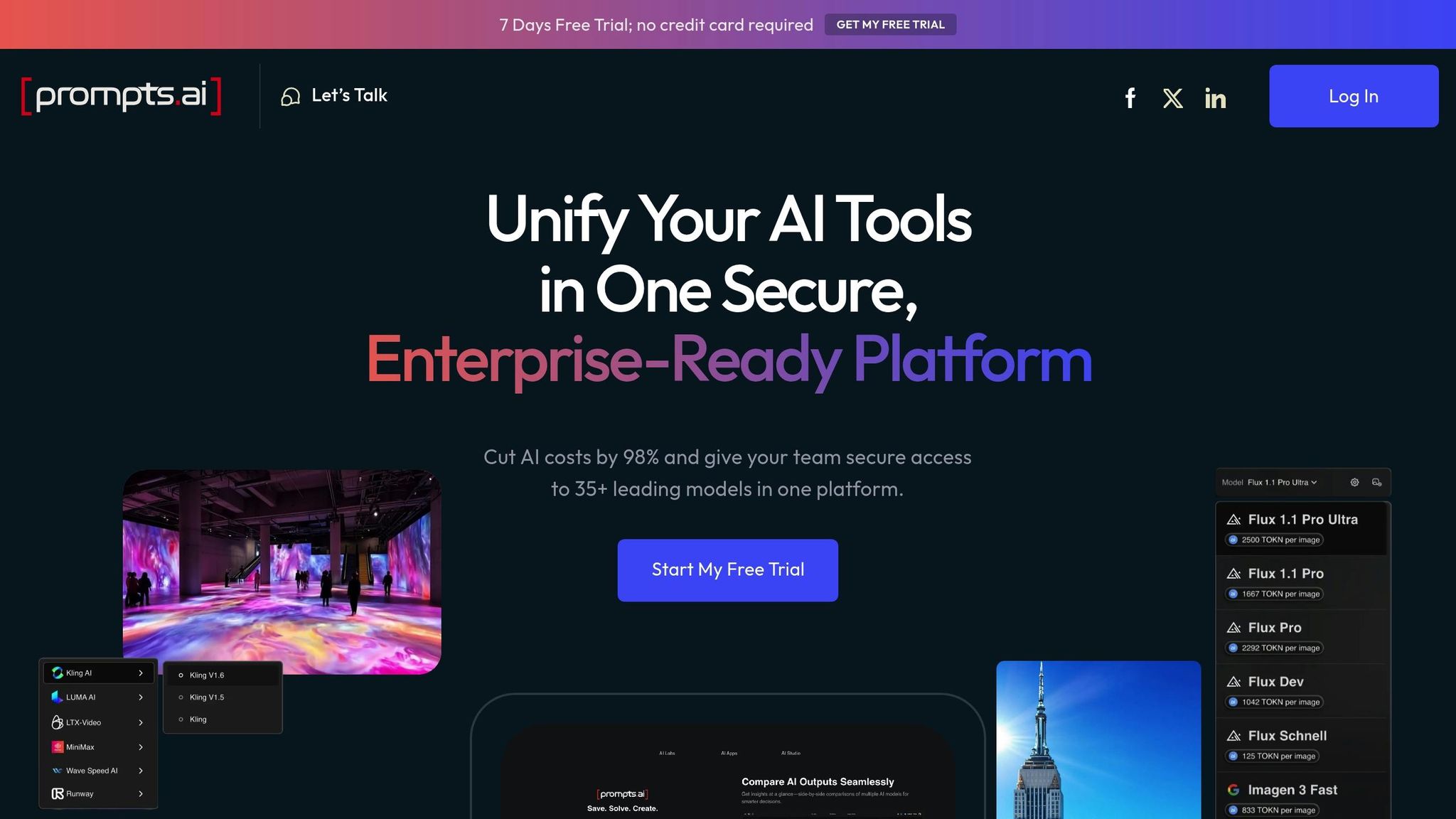

Prompts.ai est une plateforme d'entreprise conçue pour simplifier et unifier les opérations d'IA des organisations. En réunissant plus de 35 grands modèles de langage de premier plan, dont GPT-4, Claude, LLama et Gemini, dans une interface unique et sécurisée, il élimine les inefficacités liées à la jonglerie entre plusieurs outils. Ce système centralisé donne la priorité à la sécurité, à la gouvernance et à la gestion des coûts, permettant aux équipes de tester, d'affiner et d'optimiser les instructions en toute simplicité.

Prompts.ai donne accès à une gamme complète de modèles d'IA, ce qui permet de résoudre le problème de la gestion de plusieurs fournisseurs. La plateforme garde une longueur d'avance en intégrant des modèles émergents tels que GPT-5, Grok-4, Flux Pro et Kling, permettant aux équipes d'explorer rapidement les dernières avancées. Ce large accès jette les bases d'une optimisation rapide améliorée, offrant aux utilisateurs la flexibilité nécessaire pour expérimenter et innover.

La fonction de comparaison côte à côte de la plateforme permet aux équipes de tester simultanément des instructions identiques sur différents modèles, ce qui permet d'identifier la solution la mieux adaptée à des besoins spécifiques, qu'il s'agisse de création de contenu, d'analyse de données ou d'automatisation des interactions avec les clients. Pour rationaliser davantage les flux de travail, Prompts.ai propose des modèles d'invite préconçus créés par des experts, ce qui réduit considérablement le temps nécessaire au développement.

Prompts.ai inclut une couche FinOps intégrée qui suit l'utilisation en temps réel, ce qui permet aux organisations de maîtriser leurs dépenses et d'éviter des coûts imprévus. Le système de crédit TOKN de la plateforme remplace les frais d'abonnement traditionnels, offrant un moyen plus flexible et prévisible de gérer les dépenses liées à l'IA. Cette approche peut aider les entreprises à réduire les coûts des logiciels jusqu'à 98 %.

Grâce à des outils de gouvernance de niveau entreprise, Prompts.ai garantit la conformité sans sacrifier la flexibilité. Chaque flux de travail comprend des pistes d'audit et des mesures de sécurité strictes, ce qui facilite la gestion des données sensibles. La plateforme prend également en charge les espaces de travail partagés avec des contrôles d'accès détaillés, ce qui favorise la collaboration entre les équipes tout en maintenant une sécurité des données stricte. Pour renforcer les capacités des organisations, Prompts.ai propose des programmes d'intégration et de formation, aidant les équipes à développer leur expertise et à adopter les meilleures pratiques pour faire évoluer efficacement l'IA.

PromptPerfect est conçu pour affiner et améliorer vos invites existantes, en veillant à ce qu'elles produisent des résultats d'IA plus précis et plus détaillés. Ce faisant, il vous aide à tirer le meilleur parti de vos investissements rapides. Cet outil fonctionne parfaitement avec les plateformes qui centralisent les opérations d'IA, se taillant ainsi une place dans l'optimisation spécifique aux rapides.

PromptPerfect prend en charge une variété de modèles, y compris ceux basés sur du texte et des images, ce qui en fait un outil polyvalent pour les demandes multimodales. Il ajuste automatiquement les instructions pour les aligner sur les exigences des différents modèles de langage de grande taille. Grâce à l'intégration des API, il est facile d'intégrer cet outil d'optimisation à vos flux de travail existants, afin de rationaliser le processus.

Le cœur de PromptPerfect réside dans son système automatique de raffinement rapide. Il prend les instructions de base et les transforme en versions plus efficaces en analysant vos entrées et en suggérant des améliorations. Il en résulte des résultats plus détaillés, plus précis et plus adaptés au contexte. En outre, il fournit des informations sur les raisons pour lesquelles certaines invites fonctionnent mieux, ce qui vous aidera à créer des invites plus efficaces à l'avenir.

PromptPerfect propose une structure tarifaire claire et simple basée sur les limites de demandes quotidiennes, ce qui vous permet de prévoir facilement les coûts. Il a toujours obtenu des notes élevées en matière de transparence des coûts, obtenir une note parfaite de 5/5 dans les évaluations d'outils d'ingénierie rapides.

Le plan Pro, au prix de 19,99$ par mois, est idéal pour les utilisateurs qui ont besoin de 500 demandes quotidiennes et d'un accès à des fonctionnalités avancées. Pour les organisations les plus exigeantes, le Le plan Pro Max inclut l'accès à l'API et des limites de demandes étendues, ce qui en fait un choix robuste. Le Le plan d'entreprise propose des solutions personnalisées pour les entreprises ayant des besoins uniques.

OpenAI Playground est l'environnement de test idéal pour expérimenter les modèles de langage d'OpenAI. Cet outil Web fournit des informations en temps réel sur les performances des invites, ce qui en fait un outil précieux pour explorer le comportement et les réponses des modèles. Contrairement aux plateformes d'optimisation avancées, le Playground se concentre sur l'expérimentation et la découverte simples.

Le Playground donne accès à la suite complète de modèles d'OpenAI, y compris GPT-4, GPT-3.5 Turbo, Davinci, et Curie. Les utilisateurs peuvent ajuster des paramètres tels que température, nombre maximum de jetons, et rechargez pour personnaliser les sorties. Le passage d'un modèle à l'autre est fluide, ce qui vous permet de tester la même invite sur différents modèles et de comparer leurs résultats côte à côte.

L'interface prend en charge à la fois les interactions basées sur le chat et les interactions de type complétion, ce qui vous permet de structurer vos entrées comme vous le souhaitez. En outre, il conserve l'historique de vos demandes, ce qui est particulièrement utile pour affiner et itérer vos expériences.

La conception intuitive du Playground permet d'affiner facilement les instructions de manière itérative. Vous pouvez modifier les messages du système, ajuster les entrées utilisateur et analyser les réponses pour voir comment de petits changements influencent la sortie. Contrôles avancés tels que pénalités de fréquence, pénalités de présence, et séquences d'arrêt permettent un réglage précis des résultats.

Pour ceux qui recherchent une longueur d'avance, la plateforme comprend une bibliothèque prédéfinie avec des configurations adaptées à des tâches courantes telles que l'écriture créative, le codage ou la résolution analytique de problèmes. Ces préréglages constituent une base solide pour se lancer dans l'ingénierie rapide.

La gestion des coûts sur le Playground est simple et transparente. La plateforme fonctionne selon un modèle de tarification basé sur le paiement à l'utilisation et basé sur des jetons. Chaque demande affiche clairement le nombre de jetons utilisés à la fois en entrée et en sortie, ce qui permet de calculer les coûts en temps réel. Par exemple :

Un outil de suivi de l'utilisation intégré vous aide à surveiller la consommation de jetons, ce qui vous permet de respecter votre budget et d'éviter des frais imprévus. Les nouveaux utilisateurs reçoivent souvent des crédits gratuits pour explorer les fonctionnalités de la plateforme avant de s'engager à une utilisation payante.

PromptLayer est un système de gestion des invites robuste, fonctionnant comme un contrôle de version pour vos invites. Il capture toutes les interactions entre les invites et les modèles (suivi de la latence, de l'utilisation des jetons et des réponses) pour vous donner une vision claire de votre flux de travail.

L'architecture flexible de PromptLayer vous permet d'utiliser un modèle d'invite unique pour différents modèles d'IA sans avoir besoin d'ajustements. Il se connecte directement aux principaux grands modèles de langage, tels que les modèles GPT d'OpenAI, Anthropique Claude, les modèles de Google, et Mistral LLM. Il s'intègre également parfaitement aux frameworks d'IA largement utilisés tels que Chaîne Lang.

Au-delà des options classiques, PromptLayer prend en charge les LLM open source personnalisés et hébergés localement, offrant une adaptabilité inégalée pour votre configuration d'IA. Vous pouvez affiner les paramètres du modèle, choisir les fournisseurs et ajuster les paramètres via l'interface utilisateur ou par programmation. Cette compatibilité étendue garantit une base solide pour affiner vos instructions.

PromptLayer associe le contrôle de version à des analyses approfondies pour améliorer votre processus de gestion rapide. Son interface conviviale vous permet de modifier et de déployer différentes versions des invites sans avoir à écrire de code. En capturant des métadonnées clés, telles que les temps de réponse, l'utilisation des jetons et la qualité de sortie, vous pouvez identifier les tendances et affiner les performances en toute confiance.

La plateforme prend également en charge les tests A/B, ce qui vous permet de comparer des modèles et d'évaluer rapidement leur efficacité dans des scénarios réels. Des analyses détaillées, notamment des mesures telles que la latence moyenne, les coûts totaux, les volumes de demandes et les modèles d'utilisation des jetons, fournissent des informations précieuses sur les performances des invites dans les environnements de production.

Grâce au contrôle de version, vous pouvez suivre les modifications rapides au fil du temps, revenir aux versions précédentes ou analyser l'impact des mises à jour sur les performances. Cela facilite le maintien et l'amélioration de la qualité rapide sur le long terme.

LangSmith propose des outils polyvalents pour une ingénierie rapide, fonctionnant de manière fluide avec les principaux modèles d'IA. Il prend en charge l'intégration avec OpenAI (comme gpt-4o), Croissance (llama3-8b-8192 et llama3-70b-8192), Anthropic et Mistral, simplifiant ainsi le processus d'intégration de ces modèles dans vos flux de travail.

Chaque plateforme possède ses propres forces et limites, ce qui fait que le choix dépend de vos exigences spécifiques en matière de flux de travail.

Vous trouverez ci-dessous un résumé des caractéristiques et des inconvénients remarquables de chaque outil :

Prompts.ai est une solution d'entreprise robuste qui regroupe plus de 35 principaux modèles d'IA en une seule interface. Sa caractéristique la plus remarquable est la rentabilité, avec des économies potentielles allant jusqu'à 98 % grâce à son système de crédit TOKN par paiement à l'utilisation et à une tarification transparente. Cependant, sa nature complète et sa sécurité au niveau de l'entreprise peuvent sembler excessives pour les utilisateurs qui n'ont besoin que de fonctionnalités de test rapides de base.

Parfait et rapide est conçu pour une optimisation automatisée, en s'appuyant sur des algorithmes d'apprentissage automatique pour affiner les instructions. Ses fonctionnalités de test, telles que les tests A/B et la mesure de la qualité de sortie, en font un outil idéal pour les équipes qui se concentrent sur une amélioration rapide et systématique. La compatibilité multiplateforme de la plateforme garantit une intégration fluide avec les différents modèles linguistiques. En revanche, sa focalisation étroite sur l'optimisation peut obliger les utilisateurs à le compléter par d'autres outils pour une gestion plus large des flux de travail liés à l'IA.

Terrain de jeu OpenAI fournit une interface facile à utiliser et un accès direct à la famille de modèles d'OpenAI, ce qui en fait une excellente option pour des tests et un apprentissage rapides. Sa simplicité fait sa force, permettant une expérimentation immédiate sans nécessiter de configuration complexe. Cependant, cette simplicité se fait au détriment de fonctionnalités avancées telles que le contrôle des versions, la collaboration en équipe et les analyses, que les grandes entreprises peuvent juger indispensables.

couche rapide excelle en matière d'observabilité et de suivi des performances, en proposant des journaux et des analyses détaillés sur tous les modèles. Ces informations permettent aux équipes d'optimiser les instructions grâce à une prise de décision basée sur les données. Bien qu'il s'intègre parfaitement aux flux de développement, il exige un certain niveau d'expertise technique, ce qui pourrait décourager les utilisateurs non techniques.

Lang Smith se distingue par sa flexibilité dans l'intégration de plusieurs modèles, offrant une interface unifiée pour tester les instructions sur différentes architectures. Cela en fait un outil précieux pour identifier le modèle optimal et les combinaisons rapides. Cependant, sa flexibilité peut entraîner des difficultés en termes de configuration de l'API et de tarification, ce qui peut compliquer son adoption.

Lorsque vous choisissez un outil, réfléchissez à la manière dont il correspond à votre flux de travail et aux besoins de votre équipe. Les industries aux enjeux élevés, les équipes créatives et les établissements d'enseignement bénéficient souvent d'outils offrant des fonctionnalités rapides structurées et adaptables.

Les tendances émergentes indiquent que ces plateformes s'orientent vers une prise en charge multimodale de l'IA, permettant la génération de texte, d'images et de vidéos, tout en intégrant une optimisation automatisée pour réduire les efforts manuels. Des fonctionnalités telles que les suggestions intelligentes et le suivi continu des performances deviennent standard, ainsi que des options de personnalisation avancées qui adaptent les instructions à des secteurs d'activité et à des contextes utilisateurs spécifiques.

Pour prendre une décision éclairée, évaluez les plateformes en utilisant à la fois des mesures quantitatives (par exemple, la précision, les taux d'achèvement des tâches) et des facteurs qualitatifs (par exemple, la satisfaction des utilisateurs, la lisibilité). Cela garantit que l'outil que vous choisissez répond non seulement aux exigences techniques, mais améliore également la collaboration entre les équipes et l'efficacité du flux de travail. Des instructions bien conçues jouent un rôle stratégique dans la réalisation d'opérations d'IA efficaces et rationalisées.

Lorsque vous choisissez le bon outil, tenez compte de la taille de votre équipe, de votre budget et de vos besoins spécifiques en matière de flux de travail. Voici une ventilation de nos recommandations basées sur des cas d'utilisation distincts :

Alors que le secteur évolue vers des fonctionnalités multimodales et une automatisation avancée, il est essentiel de sélectionner un outil qui répond à vos besoins actuels tout en étant adaptable aux avancées futures, telles que l'intégration de l'image et de la vidéo.

Pour faire le meilleur choix, tenez compte non seulement des performances techniques, mais également de l'adéquation de la plateforme au flux de travail et à la satisfaction de votre équipe. Le bon outil doit fournir des résultats mesurables tout en simplifiant la collaboration et les processus.

Lorsque vous choisissez un logiciel pour l'ingénierie rapide de l'IA, optez pour des outils qui simplifient la création de des instructions précises et détaillées. Le logiciel idéal devrait prendre en charge tests et itérations rapides, ce qui permet d'affiner plus facilement les instructions pour améliorer les résultats de l'IA. Les principales caractéristiques à rechercher incluent des options de réglage contenu et structure, tels que le réglage des instructions, la mise en contexte et la gestion efficace des données d'entrée.

Il est tout aussi important de sélectionner un logiciel qui fonctionne parfaitement avec les derniers modèles d'IA, garantissant une intégration fluide et des performances de haute qualité. Concentrez-vous sur des outils qui rationalisent les flux de travail et améliorent la qualité globale de votre contenu généré par l'IA.

Le système de crédit TOKN sur Prompts.ai fonctionne sur un Payez à l'utilisation base, en vous assurant de ne payer que pour ce que vous utilisez réellement. Cette approche élimine le fardeau des abonnements forfaitaires coûteux qui incluent souvent des fonctionnalités ou des services inutiles.

En alignant les coûts sur l'utilisation réelle, le système TOKN peut réduire les dépenses jusqu'à 98 %, offrant une solution intelligente et rentable pour gérer les tâches d'ingénierie rapides de l'IA.

Des outils tels que LangSmith fournissent informations en temps réel en termes de performances rapides, de réponses des modèles et d'utilisation des ressources, ce qui facilite la surveillance et le débogage des flux de travail. Cela rationalise les processus et améliore l'efficacité globale.

Ces outils simplifient également le processus de test et d'affinement des variations rapides de manière méthodique. En adoptant cette approche structurée, les développeurs peuvent obtenir une meilleure précision, une plus grande fiabilité et des cycles de développement plus rapides pour les applications alimentées par l'IA.